И индустрия постепенно движется в этом направлении, занимаясь приоритизацией показателя энергоэффективности в общем процессе обслуживания дата-центров. По этой причине классические серверные помещения с традиционными системами охлаждения становятся все более редким выбором для компаний, что объясняется экономическими соображениями: в отчете IEEE от первого квартала 2016 года описано распределение энергопотребления между различными компонентами дата-центров — на долю систем охлаждения приходится 50% потребляемой энергии.

В связи с этим компании начали искать новые методы и решения охлаждения ЦОД, о которых мы хотим поговорить в этом материале.

/ фото Rob Fahey CC

/ фото Rob Fahey CCВ работе Марка Миллса (Mark Mills) под названием «Облака начинаются с угля» делается следующий вывод: основываясь на усредненной оценке, экосистема информационно-коммуникационных технологий (ИКТ) ежегодно потребляет 1500 ТВт·ч электроэнергии, что составляет 10% от её мирового производства.

По данным Intel, c 2002 года расходы на электроэнергию ежегодно возрастают примерно на 5,5%. Организации тратят около $0,50 на электроэнергию и охлаждение с каждого доллара, направленного на обслуживание аппаратной части.

Чтобы минимизировать вероятность повышения температуры ЦОДов предприятия часто используют коридорные механизмы у стоек дата-центров с воздуховодами для горячих и холодных потоков. В этом случае применяются системы организации, управления и сдерживания воздушных потоков, которые захватывают горячий «отработанный» воздух, пропускают его через устройства кондиционирования и подают охлажденным непосредственно на воздухозаборники серверного оборудования.

Некоторые системы используют жидкости для поглощения и переноса тепла из аппаратной части. Как правило, жидкости выполняют эту функцию более эффективно, чем воздух. Распространены такие системы, как охлаждение путем контакта жидкости с радиатором и иммерсионное охлаждение (непрямое и прямое), при котором отдельные компоненты погружаются в непроводящую жидкость.

Хотя водяное охлаждение в своем традиционном виде является более экономичным методом, на сегодняшний день оно по-прежнему остается вторичным, сталкиваясь с рядом препятствий на пути к массовому внедрению. Существуют следующие замедляющие распространение факторы:

- Физические ограничения. В отличие от стоек, доступ к емкости для погружения серверов открывается только сверху, что усложняет масштабирование инфраструктуры.

- Безопасность. Любое техническое обслуживание требует контакта со специальной жидкостью.

- Стоимость развертывания системы. Проектирование нового ЦОДа на основе водяного охлаждения менее трудоемко, чем модернизация существующей инфраструктуры.

- Дефицит ресурса. На обслуживание крупного дата-центра требуется такое количество воды, что целесообразность охлаждения серверов в засушливых районах ставится под сомнение как с экономической, так и с экологической точки зрения.

Альтернативные решения для охлаждения дата-центров

Рост затрат на энергию и определенные недостатки классических методов охлаждения побудили ЦОД-индустрию обратиться к поиску инновационных решений, в том числе связанных с «естественным» охлаждением.

Миграция ЦОДов

На планете есть ряд регионов, климат которых естественным образом позволяет экономить до 100% энергии, затрачиваемой на обслуживание охлаждающих систем. Такими климатическими зонами, к примеру, являются северная часть Европы, России и несколько зон на севере США.

В подтверждение тому в 2013 году компания Facebook построила свой первый дата-центр за пределами Соединенных Штатов в шведском городе Лулео со среднегодовой температурой в 1,3 °C, а компания Google вложила миллиард долларов в строительство крупного ЦОДа на территории Финляндии.

Холодный климат позволяет сократить эксплуатационные расходы, из-за низких температур воздуха и воды, запускаемых в дата-центры. По словам Эндрю Донохью из исследовательской компании 451 Research, естественное воздушное охлаждение позволяет строителям отказаться от механических охладителей, сократив до 40% капитальных затрат на объект.

Естественные формы охлаждения

Как логичное продолжение предыдущего решения следует рассматривать естественное охлаждение. Существует три формы его реализации: воздушное, адиабатическое и водяное.

Воздушная форма естественного охлаждения отличается от классического кондиционирования тем, что горячий воздух рядом с серверами отправляется в окружающую среду (полностью или частично), и его место занимает охлажденный воздух извне.

Еще в 2008 году в компании Intel провели десятимесячный тест для оценки эффективности использования исключительно внешнего воздуха для охлаждения ЦОДа. В итоге зафиксировать увеличение частоты отказов серверов из-за колебаний температуры и влажности не удалось. Диапазон изменений температуры в машинном зале составлял 30 градусов, при этом использовался только стандартный бытовой воздушный фильтр, удаляющий лишь крупные частицы из поступающего воздуха.

В результате влажность в дата-центре колебалась от 4 до 90%, а серверы покрылись тонким слоем пыли. Несмотря на это, частота отказов в испытательной зоне составила 4,46%, что не сильно отличалось от показателя в 3,83%, достигнутого в главном дата-центре Intel за тот же период.

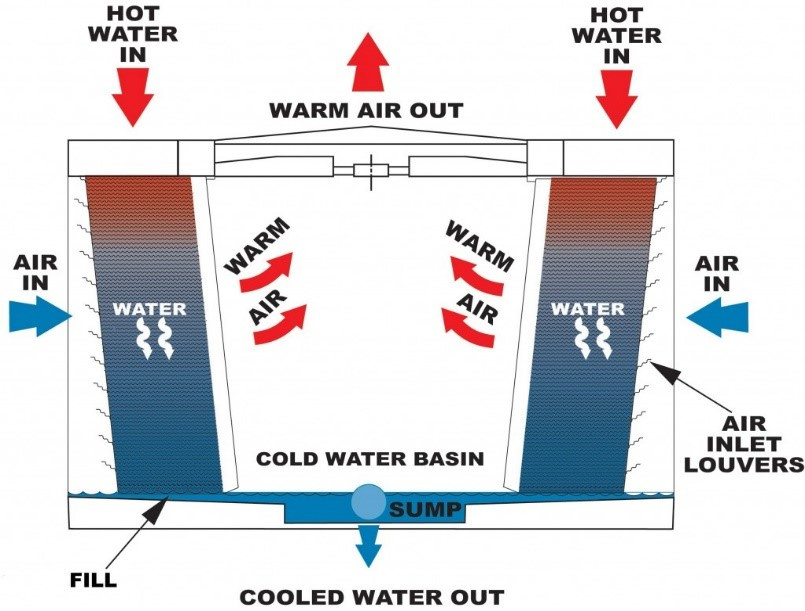

Вторая форма — это адиабатическое охлаждение, которое часто называется испарительным. Чтобы охладить дата-центр, маломощный вентилятор подает воздух на орошаемые поверхности, испаряя часть воды. Полученный воздух оказывается намного холоднее, чем пропускаемый вентилятором.

Еще одним решением для адиабатического охлаждения является так называемое колесо высокой температуры. Такое колесо входит в состав системы охлаждения Kyoto, используемой в Швейцарии. Гибридная установка мощностью 9 МВт использует охлажденную воду замкнутого адиабатического сухого вентилятора, соединенного с водоохлаждающим устройством с компрессорами.

Колесо представляет собой большой, медленно вращающийся алюминиевый диск, пришедший в индустрию ЦОДов из промышленного кондиционирования. Вместо того чтобы вводить внешний воздух напрямую в серверную, оно смешивает наружный воздух с вытяжным, формируя теплообмен. Колесо совершает от 3 до 10 оборотов в минуту и требует минимум энергии для поворота.

Утверждается, что этот тип охлаждения требует только 8–25% мощности, затрачиваемой при механическом охлаждении. Согласно независимому отчету, система на основе «колеса», установленная в Монтане, США, снижает стоимость затрат на охлаждение до 5 центов с каждого доллара, потраченного на энергию.

Что касается водяной формы естественного охлаждения, в реальном исполнении ее иллюстрирует принцип работы дата-центра Green Mountain, который расположен в одном из фьордов в Норвегии. Водоем обеспечивает бесперебойную подачу воды при температуре 8 °C, которая является оптимальной для систем охлаждения ЦОДов.

На более «глубокую» эксплуатацию водных ресурсов нацелен проект Microsoft Natick — реализующий идею подводного дата-центра. Предполагается, что на дне океана на глубине от 50 до 200 метров будут размещены капсулы, содержащие несколько тысяч серверов. Внутренняя часть блока состоит из стандартных стоек с теплообменниками, которые переносят тепло от воздуха к воде.

Затем жидкость попадает в теплообменники снаружи капсул, которые, в свою очередь, перенаправляют тепло в океан. Во время эксперимента прототип был погружен близ берегов Калифорнии на 105 дней. Температура воды колебалась в диапазоне от 14 до 18 °C. Затраты на охлаждение оказались существенно меньшими в сравнении с механическими способами охлаждения.

Похожую концепцию разрабатывает компания Google, однако ученые ИТ-гиганта предлагают размещать дата-центры на баржах. По данным Nautilus Data Technologies, занимающейся разработкой похожей технологии, такой подход позволяет экономить до 30% энергии за счет естественного охлаждения.

Другим воплощением концепции эксплуатации «природных охладителей» являются подземные дата-центры, а также ЦОДы, базирующиеся в пещерах естественного происхождения. В сравнении с идеей погружения серверов под воду подземные объекты имеют преимущество с точки зрения доступа к оборудованию. В качестве примеров реализации можно привести пещеру в городе Тампере, Финляндия, которую арендует Aiber Networks.

Также стоит отметить дата-центр Iron Mountain расположенный в бывшей шахте в Пенсильвании на глубине 67 метров. Утверждается, что постоянная температура объекта поддерживается на уровне 11 °C естественным образом — это обеспечивает «одни из самых низких показателей энергоэффективности [по состоянию на 2014 год]».

Альтернативные системы охлаждения на основе жидкостей

Основываясь на принципе погружения в жидкость, система Iceotope от компании 2bm покрывает электронику непроводящей охлаждающей жидкостью, тепло от которой транслируется к радиатору. Вода проходит через стойку и может быть повторно использована для других целей, например в центральном отоплении. По данным 2bm, эта система позволяет сэкономить до 40% от общей стоимости обслуживания ЦОДа.

В 2014 году ресурс Data Center Knowledge также представил отчет об оптимизации процесса охлаждения дата-центра Агентства национальной безопасности США посредством погружения серверов в нефтяные масла. Этот подход также позволил отказаться от охлаждения с помощью вентиляторов.

Охлаждение с использованием искусственного интеллекта

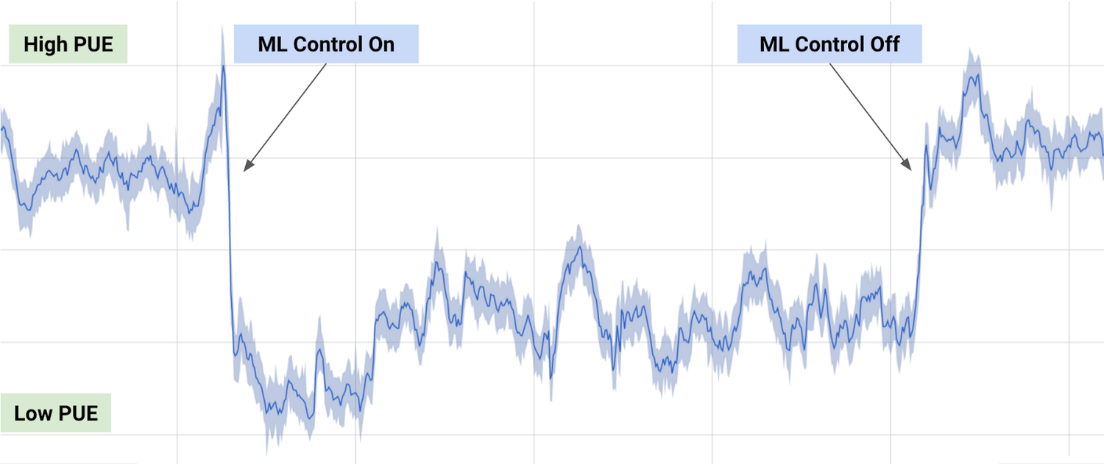

В 2014 году Google приобрели компанию DeepMind, специализирующуюся на разработке систем искусственного интеллекта. Ряд тестов ИИ корпорации был связан с оценкой энергоэффективности ее собственных дата-центров. По результатам исследования, Google удалось достичь снижения энергопотребления в части охлаждения на 40%.

Для этого данные, собранные тысячами сенсоров и термодатчиков в ЦОДах, были использованы для обучения нейронных сетей. Сети научились предсказывать температуру и давление в дата-центре в ближайший час и предпринимали необходимые действия по обеспечению заданных температурных порогов. Результаты оптимизации представлены на следующем графике.

Лазер с прямой модуляцией на кремниевой подложке

Метод находится на ранних стадиях развития и реализуется в рамках проекта известного как DIMENSION. Группа ученых из Кардиффского и Шэффилдского университетов создали лазер на кремниевой подложке, способный работать 100 тыс. часов при температуре до 120 °C.

По мнению ученых, такая технология позволит объединить два направления: электронику и фотонику. Лазеры с прямой модуляцией на кремниевой подложке обеспечивают огромную скорость передачи данных в электронных системах и хотя не имеют прямого отношения к охлаждению дата-центра, способны снизить затраты на электроэнергию.

Перспективы инновационных систем охлаждения

Акцент на оптимизации энергоемких систем ЦОДов привел к возникновению различных концептов, которые могут стать реальностью в будущем. Один из таких примеров — проект 65-этажного дата-центра в Исландии, который, по словам архитекторов, представляет собой «гигантскую башню данных», достигающую в высоту 50 метров и содержащую сотни тысяч серверов, обслуживаемых за счет «чистой» энергии. Учитывая близость выбранного местоположения к Северному полярному кругу, здание будет обеспечено средствами для естественного охлаждения.

Однако более перспективным направлением в развертывании инновационных систем выступает комбинация решений естественного охлаждения с повторным использованием генерируемой в результате функционирования дата-центров энергии. Так, британская телекоммуникационная компания aql в декабре прошлого года официально открыла новый центр обработки данных, который направляет «отработанное» тепло в систему централизованного теплоснабжения, обслуживающего местные жилые и коммерческие здания.

Альфонсо Капоццоли (Alfonso Capozzoli) утверждает, что сбор и повторное использование отработанного тепла, производимого ИТ-оборудованием, является следующим шагом в стратегии энергоэффективности. Реализация соответствующих мер, кроме всего прочего, может значительно повлиять на сокращение выбросов CO2. В качестве возможных сфер использования отработанного тепла, помимо центрального отопления, также числятся абсорбционное охлаждение, цикл Ренкина и опреснение воды.

Таким образом, ЦОД-индустрия в настоящее время сосредоточена на использовании естественных источников охлаждения, комбинируемых с интеллектуальными системами, оптимизирующими эффективность расходования энергии. Концепты, пребывающие сегодня на стадии прототипа, могут коренным образом изменить подход к применяемым способам охлаждения в будущем.

Комментарии (13)

VMichael

09.06.2017 11:52Использовать ЦОД вместо ТЭЦ, быть может рядом с теплицами или еще где то, где нужен обогрев, не вариант?

zedroid

09.06.2017 12:21Одно дело рассеивать тепло, совсем другое использовать для выполнения работы.

VMichael

09.06.2017 12:27Ну как.

Есть ресурс (тепло). Чешут репу, куда его девать.

Вот бери и используй.

А то в море погружать, Антарктиду отапливать.

Вопрос в том, что бы найти потребителя и согласовать условия.

Получается единый комплекс.

Но тут вопросы «не профильного бизнеса» возникают, взаимозависимости, в общем, скорее политические, чем экономические (хотя политика она же экономика) или технологические.

У нас в стране когда то на северах газоперекачивающие станции грели выхлопами турбин теплицы.

Потом это стало не профильным бизнесом, закрыли.

Отапливают атмосферу, овощи завозят с югов.

Igor_O

09.06.2017 12:52С теплом ЦОД есть ряд проблем.

1. Чтобы его как-то полезно использовать, нужно из 30-40 градусов получить 80-90. На это тоже требуется затратить энергию.

2. Энергопотребление (и следовательно тепловыделение) ЦОД могут достаточно сильно меняться во времени и не всегда эти колебания коррелируют с погодой.

В результате, кроме ЦОД должен быть другой источник тепла. Например, обычный бойлер… И вылезают гигантские затраты на увязывание этих систем, обеспечение готовности резервных мощностей, диспетчеризацию и т.п. Окупаются все эти затраты по расчетам — 15-20 лет типично. На практике — никогда, т.к. за 10-15 лет ЦОД меняется практически полностью и всю систему нужно переделывать.

У нас в стране когда то на северах газоперекачивающие станции грели выхлопами турбин теплицы.

Потом это стало не профильным бизнесом, закрыли.

Это как раз из той же оперы. Да, здорово греть выхлопом турбин что-нибудь полезное. Но для этого нужны специальные теплообменники, насосы, трубы и куча инфраструктуры, которую надо несколько раз в год обслуживать, раз в пять лет серьезно ремонтировать, а раз в 10-15 лет — капитально ремонтировать (не считая зарплаты обслуживающего персонала и прочих овощеводов). И вдруг оказывается, что дешевле все сдать в металлолом, чем поддерживать в рабочем состоянии.

VMichael

09.06.2017 12:591. Чтобы его как-то полезно использовать, нужно из 30-40 градусов получить 80-90.

Откуда такие цифры, про 80-90?

В результате, кроме ЦОД должен быть другой источник тепла. Например, обычный бойлер… И вылезают гигантские затраты на увязывание этих систем, обеспечение готовности резервных мощностей, диспетчеризацию и т.п. Окупаются все эти затраты по расчетам — ...

Это все на поверхности.

А как окупаются затраты на опускание ЦОД под воду, например?

Кстати, откуда данные про расчеты окупаемости?

И вдруг оказывается, что дешевле все сдать в металлолом, чем поддерживать в рабочем состоянии.

Угу, особенно когда ты с газа рубишь капусты столько, что заморачиваться на «непрофильные бизнесы» с низкой рентабельностью никакого желания нет.

Igor_O

09.06.2017 14:41Откуда такие цифры, про 80-90?

Это температура воды, поступающей от ТЭЦ в ИТП. В отопительных приборах на поверхности должна быть температура выше 55 градусов, иначе та самая знаменитая легионелла плодится и размножается.

А как окупаются затраты на опускание ЦОД под воду, например?

То же самое — никак. Вся возможная экономия уйдет на прокладку силового кабеля до этого ЦОД, ну и оптики тоже.

Кстати, откуда данные про расчеты окупаемости?

Считал окупаемость для кучи разных объектов в своей жизни. ГПГУ с тригенерацией и без нее для разных объектов, системы адиабатического охлаждения для ЦОД, системы фрикулинга для ЦОД, сравнивал ДГУ+ИБП против ДДИБП, пытался придумать способ утилизации 2.5 МВт тепловыделения суперкомпьютера Ломоносов, проектировал систему водяного охлаждения с температурой воды 55 градусов… И засада практически со всеми системами утилизации тепла, адиабатики и фрикулинга — почти для всех из них окупаемость железа — от 10 лет. Добавляем трубы, работы, обслуживание — и получаем 15-20 лет. Добавляем системы резервирования для, например, обеспечения отопления во время обслуживания суперкомпьютера, и получаем окупаемость 30-40 лет, а еще можно нарваться на всякие штрафы, типа как у Газпрома когда-то было, что если тебе выделили 1000 кубов в день, а ты использовал только 300… заплатишь все равно за 1000.

Угу, особенно когда ты с газа рубишь капусты столько, что заморачиваться на «непрофильные бизнесы» с низкой рентабельностью никакого желания нет.

Так если бы такое только в России происходило! Куча примеров было, когда какую-нибудь энергосберегающую хрень торжественно сдавали под речи политиков, через пару лет из-за проблем разных оно отключалось, еще через пару лет это все втихую пилили на металлолом. За 10 лет до потенциальной окупаемости…

VMichael

09.06.2017 14:54Ваш опыт внушает доверие.

Эх. Жаль тепло уходит зазря.

Я сам сталкивался. Когда работал по пусконаладке спорткомплекса, где холодильные машины ледовой арены охлаждались воздухом наружным через калориферы. Вроде 2 в одном, нагрев воздуха и охлаждение машин.

Только что то не срослось, в первую зиму калориферы замерзли, полопались.

И охлаждение перевели на градирьни на крыше, а калориферы из обычной системы отопления запитали.

Но есть и другие примеры.

Когда люди утилизируют (не тепло правда), а опилки, на отопление сушилок дерева.

Собственно я комментарий писал в сравнении с морскими проектами.

Мне показалось, что под водой будет не дешевле, чем отапливать, что либо на суше.

zedroid

09.06.2017 14:20Я не имею степени в термодинамике, поэтому не смогу привести глубокого теоретического обоснования.

Когда мы греем атмосферу/море мы выбрасываем тепло в систему практически не влияя на нее (в короткой перспективе). Можно отдать сколько угодно тепла и думать только хорошем канале теплопередачи.

В случае с теплицами, мы меняем параметры системы, в которую передаем энергию. При какой-то температуре система хорошо примет тепло, а при какой-то нам придется передавать его с силой. Это усложняет поставленную задачу и уменьшает эффективность такого метода теплоотвода.

Igor_O

09.06.2017 15:03практически не влияя на нее (в короткой перспективе).

Да и в далекой перспективе тоже не влияем. Все тепловыделение всего человечества с очень большим запасом укладывается в погрешность измерения теплопритоков от солнечного света. И с еще большим запасом укладывается во флуктуации этих теплопритоков от изменения солнечной активности. (Общие теплопритоки на Землю от Солнца по разным оценкам получаются что-то от 80000 ТВт до 130000 ТВт, а общее тепловыделение человечества целиком — в пределах 20 ТВт в среднем по году. Т.е. пиково мы выделяем в районе 0.03%, даже для оценки снизу теплопритоков от Солнца...)

Igor_O

09.06.2017 13:12на сокращение выбросов CO2

Трамп же уже отменил глобальное потепление и вредность CO2. Сказал, что это операция китайских спецслужб против экономики США.

сбор и повторное использование отработанного тепла, производимого ИТ-оборудованием, является следующим шагом в стратегии энергоэффективности.

Это не следующий шаг, а давняя несбыточная мечта. Пока максимум, что удалось реализовать в реальной жизни — обогрев пола в фойе суперкомпьютерного центра в Швейцарии. Гораздо эффективнее, как оказалось, греть соседнее озеро. (по случайности дало положительный экономический эффект — у местных рыбозаводчиков и рыбаков «урожаи» выросли очень сильно).

Главная проблема — стоимость обвязки и резервирующей инфраструктуры таковы, что окупаемость — в лучшем случае 15 лет. За 15 лет большинство ЦОДов реконструируется. Это значит, что срок окупаемости системы снова отодвигается на 15 лет. Т.е. появиться в реальных не показушных проектах все это может только в том случае, если хотя бы в пять раз снизятся цены на оборудование.

открыла новый центр обработки данных, который направляет «отработанное» тепло в систему централизованного теплоснабжения

Ну не то, чтобы открыла, а политики «надеются, что ЦОД будет вносить свой вклад в подогрев воды в бассейне»…

Когда это будет и будет ли когда-нибудь — что-то молчат…

Водяное охлаждение, погружное охлаждение и прочие изыски — хорошо для выпендрежа и демонстрации технологий. Реального задокументированного снижения PUE, повышения плотности мощности, снижения затрат на обслуживание, пока ни одна такая система не продемонстрировала.

А пока идут заявления типа:

эта система позволяет сэкономить до 40% от общей стоимости обслуживания ЦОДа

При том, что просто фрикулинг с обычным воздушным охлаждением уже реально позволяет Фэйсбуку экономить гигантские деньги (ну кроме тех моментов, когда у них из-за сбоев в системе управления дождь в ЦОДе идет).

Про Microsoft Natick вообще все грустно… Красивый концепт для плавучих городов будущего. А пока… Элементарно подача в эту фигню электричества и прокладка туда оптики съест всю возможную экономию и еще раз пять по столько…

И да, картинка к «адиабатическому охлаждению» — обычная мокрая градирня, которые используются уже лет 200, наверное, если не больше. Под адиабатикой, обычно, понимаются немного другие вещи.

Kolegg

Почему бы не поставить цод рядом с приемными терминалами сжиженного газа в качестве источника тепла? Тут 2 зайца убиваются — и газ испаряется и цод охлаждается.

alinatestova

А что с территориальной удаленностью?

Kolegg

Обычно они стоят в регионах с развитой инфраструктурой — европа-япония-корея.