В статье приведён анализ решений в сфере IDS и систем обработки траффика, краткий анализ атак и разбор принципов функционирования IDS. После чего сделана попытка разработки модуля для обнаружения аномалий в сети, на основе нейросетевого метода анализа сетевой активности, со следующими целями:

- Обнаружение вторжений в вычислительную сеть.

- Получения данных о перегрузках и критических режимах работы сети.

- Обнаружение проблем с сетью и сбоев в работе сети.

Цели и задачи статьи

Целью статьи является попытка применения аппарата нейронных сетей в прикладной области, в основном ради изучения вопроса.

Задачей, реализующей цель, будет построение нейросетевого модуля обнаружения отклонений в работе сети передачи данных от её нормальных режимов.

Структура статьи

Исследование и обоснование:

- Типы систем обнаружения вторжений.

- Краткое исследование рынка существующих решений.

- Краткое исследование работ в области нейросетевых решений.

Разработка:

- Требования к модулю и выполняемые им задачи.

- Проектирование модуля.

- Реализация концепта.

- Заключение:

- Тестирование концепта.

- Возможности по улучшению.

- Использованные материалы.

Типы систем обнаружения вторжений

Существует классическое деление СОВ на [11]:

- Системы уровня сети, на которые отводится трафик с маршрутизатора (Network-based).

- Системы уровня хоста, которые обнаруживают изменения на отдельно взятой машине, например анализируя журналы или сетевую активность (Host-based).

- Системы, основанные на оценке уязвимостей (Vulnerability-assessment).

В данной статье я хочу несколько расширить это деление.

Собственно, целью любой такой системы является ответ на вопрос: есть ли проблемы и какие?

Решение выносится на основе полученных данных.

Т.е. задачи системы состоят из:

- Получения данных.

- Интерпретации полученных данных.

- Представления результата.

Соответственно, все системы возможно позиционировать по значениям следующих признаков:

- Тип собираемых данных.

- Метод получения данных.

- Метод интерпретации данных

- Метод представления результата.

Внесистемной характеристикой я считаю тип реакции на результат:

- Информационный.

- Активный.

В первом случае, производится информирование заинтересованных лиц.

Во втором — активные действия, например блокирование диапазона адресов атакующего.

По этому признаку данные системы обычно искусственно разделяются на IDS и IPS.

Характеристика эта внесистемная, потому что я предполагаю разбиение системы

на "разведывательную" и "силовую" части. И любая IDS может быть включена в состав IPS.

Далее, к этому вопросу я не буду возвращаться.

Классы типа собираемых данных

Следуя классическому делению, я введу два класса и добавлю третий, чтобы возможно было представить класс, как "координату в конфигурационном пространстве" (просто для того, чтобы позже все перестановки быстро получить):

- Данные, собираемые об узле сети.

- Данные, собираемые обо всей сети.

- Гибридная система.

Типы данных, собираемые об узле сети — это данные, которые касаются только одного узла и частично тех, кто с ним взаимодействует.

Анализ таких данных позволяет ответить на вопрос: "Идёт ли атака на данный хост?"

Как правило, удобнее собирать эти данные непосредственно на узле, но это не обязательно.

Например, сетевые сканеры могут получить список открытых портов на конкретном узле извне, не имея возможности запускать там код.

Этот класс включает данные следующих типов (к каждому из которых относятся конкретные собираемые показатели):

- Сетевая активность узла.

- Сетевые настройки узла.

- Данные о файлах (списки и контрольные суммы, метаданные, действия с файлами и т.п..).

- Данные о процессах.

При этом, узлы могут быть как рабочими станциями, не предполагающими их использования в качестве серверов, предоставляющих службы, так и серверами.

Я разделяю хосты на типы, потому что хочу выделить отдельный случай: хост может быть специально сделан уязвимым, с целью изучения методов атак (в том числе дообучения нейронных сетей) и выявления атакующих узлов.

Возможно предполагать, что любое взаимодействие с данным узлом будет являться попыткой атаки.

Данные, собираемые о сети — это цельная картина сетевого взаимодействия.

Как правило, полные сетевые данные не собираются, т.к. это ресурсоёмко и считается, что нарушитель либо не может находиться внутри сети, либо ему обязательно нужна связь с внешним миром (что, конечно, не обязательно так, ведь провести атаку возможно и на физически изолированную сеть, для чего существуют техники "преодоления воздушного зазора").

В этом случае, IDS анализирует трафик, идущий через маршрутизатор, для чего в маршрутизаторе имеется SPAN порт, с которого трафик перенаправляется в IDS.

В принципе, ничего не мешает собирать данные с узла, на котором работает IDS, это даже полезно и привносит дополнительный контроль.

Также возможно собирать трафик сети на её узлах. Но это заставляет сетевой адаптер узла работать в режиме захвата всего трафика, чего обычно не предполагается при штатной работе, плюс это явно избыточно (единственный вариант, когда это может быть полезно, с большой натяжкой, — распределённый анализ потока).

Классы методов получения данных

Классы методов получения данных:

- Пассивный. Система не влияет напрямую на работоспособность сети. Она просто производит анализ трафика.

- Активный. Система пытается провести "разведку боем", активно воздействуя на сеть, например с целью найти знакомые сигнатуры в ответном трафике.

- Смешанный. Используются оба вышеуказанных класса.

Пассивное обнаружение

При пассивном обнаружении, система просто наблюдает за обстановкой. Большинство IDS используют данный класс методов. Системы уровня хоста также, обычно используют данный класс методов. Например, они не пытаются удалить системный файл из под пользователя и проверить, что он был удалён, а просто оценивают соответствие прав на данный файл, шаблону в базе, и если соответствие не наблюдается, выдают предупреждение.

Активный поиск уязвимостей

В данном классе методов ошибки провоцируются путём некоторых действий, как известных, так и неизвестных (fuzzy системы).

После этого, по базе анализируется реакция на данные действия. Данный класс методов характерен для сканеров уязвимостей.

Для интерпретации результатов применимы оба класса методов:

- Есть вариант анализа ответов по базе (например, характерные ответы на типичные шаблоны SQL инъекций), либо поведенческий анализ (как себя стала после этого цель вести и как отвечает на следующие запросы).

Например, посылка некорректно составленного IP пакета должна привести к падению уязвимого сервера, после чего он перестанет отвечать. - Есть вариант обнаружения аномальной активности.

Например, если после посылки ICMP пакета размером 777 байт с заполнением 0xDEADBEEF, в сети резко возрастает уровень сетевой активности, а затем падает — это аномалия (нормальная ситуация — уровень сетевой активности не меняется).

Плюсы очевидны:

- Превентивное обнаружение вторжений.

Какая-либо атака может ни разу не произойти, но сеть будет оставаться к ней уязвимой.

Данный класс методов выявит потенциальные уязвимости. - Проверка сети аналогично атакующему, что повышает шансы обнаружить уязвимости.

Минусы:

- Дополнительная нагрузка на сеть.

- Возможность реализовать успешную атаку в процессе сканирования, например DoS некоторых сервисов.

- Как правило, зависимость от базы атак, которая устаревает.

- Неочевидный минус — иллюзия безопасности. Может возникнуть ощущение, что "если сканер ничего не нашёл, то всё ok".

При этом, риски направленных атак всё-равно остаются. Этот риск, возможно в меньшей степени, имеет место быть и для других классов методов.

Классы методов интерпретации данных

Возможно выделить следующие классы, каждый из которых может включать несколько методов:

- Методы обнаружения известных нарушений.

- Методы обнаружения аномалий.

- Смешанный метод, включающий оба вышеназванных.

Обнаружение известных нарушений

Сводится к поиску признаков уже известных атак.

Преимущества:

- Методы почти не подвержены ложным срабатываниям.

- Методы, реализованные как сопоставление с образцом, как правило выполняются достаточно быстро и не требуют больших затрат ресурсов.

Недостатком этих методов является невозможность обнаруживать неизвестные системе атаки.

В классическом варианте реализация предполагает сравнение сигнатур пакетов с сигнатурами в базе. Сравнение может быть, как точное, так и с шаблоном или по регулярному выражению.

Большинство известных IDS используют методы данного класса.

Сюда же возможно отнести методы нечёткого сравнения:

- Обученный перцептрон.

- Методы сравнения с нечёткой логикой.

Обнаружение аномалий

Суть в том, чтобы записать шаблон нормальной активности сети и реагировать на отклонения от этого шаблона.

Возможен вариант реализации в виде базы сигнатур "нормальных" пакетов в сети

и статистической системы обнаружения отклонений, когда анализатор ищет какие-то редкие действия, или активности. События в системе исследуются статистически, чтобы найти те из них, проявление которых выглядит аномальным.

Представленный ниже детектор будет пытаться обнаружить аномалии.

Методы представления результата

Как показал анализ существующих решений, обычно используются два типа методов:

- Двуклассовый. Система отвечает на вопрос "Есть ли проблемы?", ответом "да/нет".

Данный способ характерен для академических статей и исследований, но он может быть применим для написания модулей или датчиков реальных СОВ. - Многоклассовый. Система отвечает на вопрос "Какие сейчас есть проблемы?". Если проблем нет, то "никакие".

Результат также может быть представлен с определённым уровнем достоверности. И любая нейросеть представляет результат, не как "да" или "нет", а как множество вероятностей результатов.

В существующих подходах вероятность аппроксимируется к единичной или нулевой (например, изо всех возможных атак на выходе сети, выбирается первая с самой высокой вероятностью) и нигде дальше не учитывается.

Типы IDS

На данном этапе параметр "Метод представления результата" не представляет интереса (он был введён для разделения детекторов).

from itertools import product

data_type_class = ('host_data', 'net_data', 'hybrid_data')

analyzer_type_class = ('passive_analyzer', 'active_analyzer', 'mixed_analyzer')

detector_type_class = ('known_issues_detector', 'anomaly_detector', 'mixed_detector')

liter = list(product(data_type_class, analyzer_type_class, detector_type_class))

print(len(liter))

for n, i in enumerate(liter):

print('Type {}:\ndata_type_class = {}, analyzer_type_class = {}, detector_type_class = {}.'.format(n, i[0], i[1], i[2]))

print('-' * 10)Далее, я сведу их в меньшее количество типов:

- Типы: 0, 1, 2. IDS уровня узла, основанная на поиске сигнатур, обнаруживающая аномальное поведение, либо гибридная. Подобных IDS существует достаточно много. Сюда же возможно отнести антивирусы.

- Типы: 3, 4, 5. Сканер уязвимостей уровня узла, основанный на поиске сигнатур, обнаруживающий аномальное поведение, либо гибридный. Сканеры незакрытых уязвимостей. Функционал встроен в антивирусы. С натяжкой в качестве представителя группы возможно выделить AVZ. Далее я этот тип отдельно не разбираю.

- Типы: 6, 7, 8. Гибридные IDS уровня узла, как отслеживающие атаки пассивно, так и позволяющие провести активное сканирование.

- Типы: 9, 10, 11. IDS уровня сети, основанная на поиске сигнатур, обнаруживающая аномальное поведение, либо гибридная.

- Типы: 12, 13, 14. Сканер уязвимостей уровня сети, основанный на поиске сигнатур, обнаруживающий аномальные реакции, либо гибридный.

- Типы: 15, 16, 17. Гибридная IDS уровня сети, обнаруживающая аномальное поведение, либо гибридная. Должна позволять, как проводить сканирование, так и обнаруживать проблемы в пассивном режиме. Это комплексные решения уровня сети. Обычно, они не существуют в таком виде и сливаются со следующим типом.

- Тип 26 (типы 18-25 обычно не имеют смысла по отдельности и сводятся к данному типу). Гибридная система, основанная на агентах, каждый из которых может иметь один из вышеперечисленных типов.

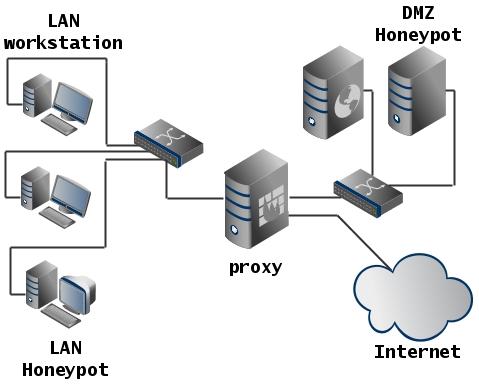

- Отдельным пунктом, который не попадает в классификацию, потому что не является IDS, но имеет место быть как вспомогательная система, является honeypot.

Ниже указаны примеры существующих решений, попадающие в вышеназванные группы.

Существующие решения

Действующие системы

Snort

Snort является классической IDS уровня сети и анализирует трафик на совпадение с базой правил (фактически с базой сигнатур). Т.е., данная система ищет известные нарушения. Для Snort возможно несложно реализовать свой модуль, что и было сделано в одной из работ. На базе Snort реализовано много известных коммерческих решений, в том числе русских.

Помимо работы с базой сигнатур, построенная на базе Snort IDS, вполне может иметь в своём составе эвристические, нейросетевые и подобные модули обнаружения. Как минимум, существует в рабочем виде статистический детектор аномалий для Snort.

Suricata

Suricata также, как и Snort является системой уровня сети.

У данной системы есть несколько особенностей:

- Базы сигнатур совместимы со Snort.

- Оценивает не только сетевой/транспортный уровень, но работает и на уровне прикладных протоколов.

- Есть возможность реализовывать правила на Lua, интерпретируемом языке, что расширяет диапазон возможностей.

- Может анализировать трафик между двумя хостами, в целом, а не только отдельные пакеты/соединения. Это позволяет, например, обнаруживать попытки подбора паролей.

- Есть подсистема IP reputation, позволяющая присваивать "уровень репутации" каждому IP адресу.

Т.е., эта система, хотя и обнаруживают известные нарушения, также как предыдущая, обладает большей адаптивностью и возможностью обучаться (уровень репутации хоста может изменяться в процессе работы системы и влиять на принятие ей решения).

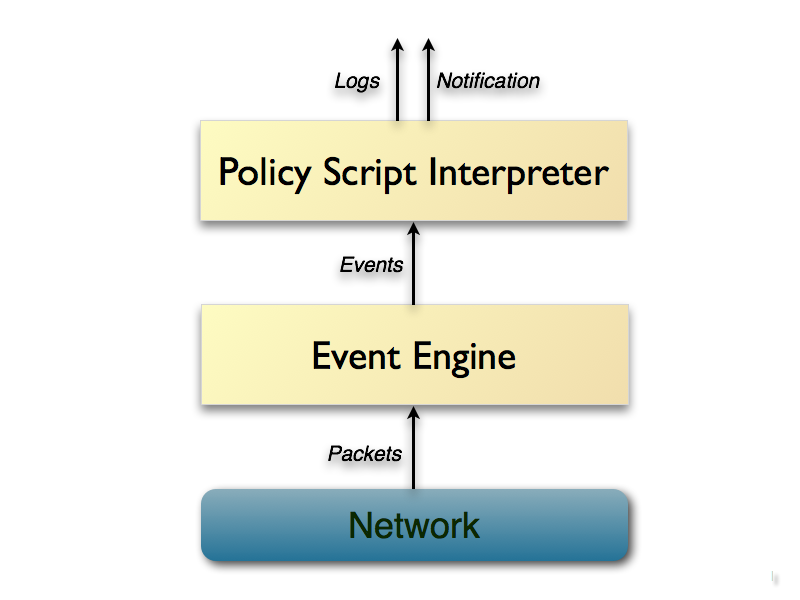

Bro

Платформа для создания IDS уровня сети. Является гибридной системой, с упором на обнаружение известных нарушений. Работает на транспортном, сетевом уровне и уровне приложений. Поддерживает свой язык сценариев.

Имеется возможность обнаружения аномалий, например, множественное подключение к сервисам на разных портах — не свойственное для нормального узла поведение, которое будет обнаружено.

Это реализовано, во-первых, на основе на основе проверок передаваемых данных на нормальность (например, TCP-пакет со всеми установленными флагами, наверное тут что-то не то, несмотря на то, что он корректен).

Во-вторых, на базе политик, описывающих как должна функционировать сеть в норме.

Bro не только обнаруживает атаки, но также помогает при диагностике сетевых проблем (заявленный функционал).

Технически Bro реализован достаточно интересно: он не производит анализ трафика напрямую по признакам, а прогоняет пакеты на "событийной машине", которая преобразует поток пакетов в серию высокоуровневых событий.

Эту машину возможно считать дополнительным уровнем абстракции, позволяющим отобразить сетевую (как правило, хотя и не обязательно) активность в терминах нейтральных относительно политик (события просто сигнализируют, о том, что нечто произошло, но о том почему, событийный движок ничего не говорит, т.к. это задача интерпретатора политик).

Например, HTTP запрос будет преобразован в событие http_request с соответствующими параметрами, которое передаётся на уровень анализа.

Интерпретатор политик выполняет сценарий, в котором устанавливаются обработчики событий. В данных обработчиках могут рассчитываться статистические параметры трафика. При этом, обработчики могут сохранять контекст, а не просто реагировать на отдельно взятый пакет.

Т.е., учитывается временная динамика, "история" потока.

Краткая схема работы ядра Bro:

TripWire, OSSEC, Samhain

По классической терминологии, это представители систем уровня хоста.

Совмещают в себе методы обнаружения известных нарушений и методы поиска аномальной активности.

Механизм поиска аномалий основан на том, что при установке, система сохраняет в базе хэши системных файлов и метаинформацию о них. При обновлении пакетов операционной системы, хэши пересчитываются.

В случае неконтролируемого изменения какого-либо наблюдаемого файла, через некоторое время система даст об этом знать (как правило, сканирование запускается планировщиком, хотя возможны системы, реагирующие на события ФС).

Помимо наблюдения за файлами, данные системы могут наблюдать за процессами, соединениями и анализировать системные журналы.

Также, ими может использоваться база известных нарушений, которая периодически обновляется.

Некоторые имеют централизованный интерфейс, который позволяет анализировать данные одновременно на многих узлах.

Неплохо суть описана на сайте Samhain:

The Samhain host-based intrusion detection system (HIDS) provides file integrity checking and log file monitoring/analysis, as well as rootkit detection, port monitoring, detection of rogue SUID executables, and hidden processes.

Samhain been designed to monitor multiple hosts with potentially different operating systems, providing centralized logging and maintenance, although it can also be used as standalone application on a single host.

Пример развёртывания OSSEC:

Prelude SIEM, OSSIM

Это гибридные системы, позиционируемые, как SIEM. Prelude сочетает в себе сенсорную сеть и анализатор. Заявлено, что данная система обеспечивает повышенный уровень безопасности, поскольку взломщик может обойти одну IDS, но сложность обхода многочисленных механизмов защиты возрастает экспоненциально.

Система хорошо масштабируется: по заявлениям разработчиков, сенсорная сеть может покрывать континент или даже мир.

Система совместима со многими существующими IDS по формату данных (IDMEF) в том числе с: AuditD, Nepenthes, NuFW, OSSEC, Pam, Samhain, Sancp, Snort, Suricata, Kismet и т.д..

Примерно тоже самое возможно сказать про OSSIM.

Сканеры уязвимостей

Это системы, которые занимаются активным поиском уязвимостей на узле, либо в сети.

Самые простые ищут только известные проблемы, которые есть в базе, более серьёзные системы могут совмещать в себе как методы обнаружения известных нарушений, так и аномальной активности.

Сканеры уязвимостей появились давно и наделать их успели достаточно много.

Приведу только несколько известных продуктов, которые представлены на рынке:

- Nmap — бесплатный сетевой сканер, который используют скорее, как вспомогательный инструмент: он позволяет определить ОС, получить список открытых портов и сервисов, которые их открыли, и т.п… При этом, включает Netmap Scripting Engine, что позволяет на его основе строить автоматизированные решения (например, совместить сканирование с запуском брутфосера на нужных портах).

- XSpider — классический сканер уязвимостей с базой, эвристиками, поиском аномального поведения и т.д..

- Metasploit — фреймворк, содержащий наборы эксплоитов, сканеры, готовые нагрузки, запускаемые на атакуемом узле и т.п… Позволяет провести исследование узла или группы узлов на подверженность известным уязвимостям.

- OpenVAS — фреймворк, сочетающий в себе сканер и решение для управления уязвимостями. Содержит базу с более чем 50000 уязвимостями, опознаёт указанные цели и проверяет их реакцию на применение соответствующих эксплоитов.

Возможности данных систем на примере вышеприведённого XSpider:

- Идентификация сервисов на случайных портах для выявления уязвимостей серверов с нестандартной конфигурацией.

- Эвристический метод определения типов и имен сервисов (HTTP, FTP, SMTP, POP3, DNS, SSH и др.) для определения настоящего имени сервера и корректной работы проверок.

- Обработка RPC-сервисов (Windows и *nix) с полной идентификацией, включая определение детальной конфигурации компьютера.

- Проверка слабости парольной защиты: оптимизированный подбор паролей практически во всех сервисах, требующих аутентификации.

- Глубокий анализ контента веб-сайтов, включая выявление уязвимостей в скриптах: SQLi, XSS, запуск произвольных программ и др.

- Анализ структуры HTTP-серверов для поиск слабых мест в конфигурации.

- Расширенная проверка узлов под управлением Windows.

- Проведение проверок на нестандартные DoS-атаки.

- Возможность автоматизации.

Honeypot

Системы специально сделанные уязвимыми, с целью привлечения к ним атак. Могут быть использованы для исследования действий атакующего.

Пример развёртывания:

- HoneyWeb — honeypot, запускающий WEB сервисы.

- Honeyd — позволяет создавать виртуальные хосты, на которых работают сервисы. Может эмулировать разные ОС.

Вообще, готовых honeypot решений достаточно много.

Сюда же могут относиться ловушки типа tarpits, замедляющие атаку (повышает требования к ресурсам атакующего, даёт время на реагирование), которые возможно считать "активным" вариантом honeypot.

Варианты подходов к решению задачи и нейросетевые решения

В работе [14] проведён анализ упоминаний широко используемой базы KDD.

- Машины опорных векторов — 24.

- Решающие деревья — 19.

- Генетические алгоритмы — 16.

- Метод главных компонент — 13.

- Метод роя частиц — 9.

- Поиск k-ближайших соседей — 9.

- Кластеризация по k-значениям — 9.

- Наивные Байесовские классификаторы — 9.

- Нейросети, многослойный перцептрон — 8.

- Генетическое программирование — 6.

- Грубые множества — 6.

- Байесовы сети — 5.

- Лес случайных деревьев — 5.

- Искусственная имунная система — 5.

- Использование нечётких правил (Fuzzy Rules Mining) — 4.

- Нейронные сети (самоорганизующиеся карты) — 4.

Как видно, нейронные сети в работах за 2015-2016 годы представлены не столь широко, к тому же, это как правило, сети прямого распространения.

На практике же, решения, в том числе и приведённые выше, в основном опираются на следующие технологии анализа:

- Методы обнаружения известных нарушений:

- Сигнатурный анализ. Сравнение сигнатуры данных, либо сигнатуры поведения с сигнатурой в обновляемой базе. Сигнатура может быть представлена также шаблоном или регулярным выражением.

- Экспертные системы на основе правил [1] .

- Методы обнаружения аномалий:

- Пороговые детекторы (реагирующие, например, на стабильное превышение загрузки CPU на сервере) [1] .

- Статистические системы (например, Байесовские классификаторы, либо системы обучаемых классификаторов).

- Поведенческий анализ (возможно отнести к нечётким правилам).

- Использование модели "искусственная имунная система".

Про некоторые варианты решений, которых я не коснулся, возможно также посмотреть здесь.

У данных решений есть свои проблемы:

- Сигнатурный поиск не реагирует на неизвестные атаки, и достаточно не сильно больших изменений сигнатуры атаки, для того, чтобы детектор её более не обнаружил.

- Для экспертных систем, основанных на правилах, также как и для сигнатурного поиска, требуется поддерживать актуальность базы.

- Для систем основанных на правилах, незначительные вариации в последовательности действий при атаке могут повлиять на процесс сравнения "деятельность-правило" до такой степени, что атака не обнаруживается соответствующим механизмом обнаружения. Увеличение уровня отвлеченности у таких систем предоставляет частичное решение этой задачи, однако это сильно увеличивает число ложных срабатываний [10].

- Системы на основе правил зачастую не обладают достаточной гибкостью в структуре правил.

- Статистические системы не чувствительны к порядку следования событий (что верно не для всех существующих систем).

- Для них и для пороговых детекторов трудно задать пороговые значения отслеживаемых системой обнаружения атак характеристик.

- С течением времени, статистические системы могут быть переобучены нарушителями так, чтобы атакующие действия рассматривались как нормальные.

Нейронные сети, прежде всего стоит рассматривать, в качестве замены статистических детекторов аномалий, либо дополнения к ним, но в какой-то мере, они могут заменить сигнатурный поиск и прочие методы.

Кроме того, гибридные системы, скорее всего будут применяться в ближайшем будущем.

Нейронные сети имеют, как свои преимущества:

- Возможность анализа неполных входных данных или зашумлённого сигнала.

- Отсутствие необходимости формализации знаний (заменяется обучением).

- Отказоустойчивость: выход из строя некоторых элементов сети или разрушение связи не всегда делает сеть полностью неработоспособной.

- Возможность простого распараллеливания работы.

- Нейронные сети требуют меньшего вмешательства оператора.

- Существует вероятность обнаружения неизвестных атак.

- Сеть способна обучаться автоматически и в процессе работы.

- Возможность обработки многомерных данных без сильного увеличения трудоемкости.

Так и недостатки:

- Большинство подходов являются эвристическими и часто не приводят к однозначным решениям.

- Для построения модели объекта на основе нейростей требуется предварительное обучение сети, что требует вычислительных и временных затрат.

- Для того, чтобы обучить сеть, надо подготовить обучающую и тестовую выборки, что не всегда просто.

- Обучение сети в ряде случаев приводит к тупиковым ситуациям: сети могут быть подвержены переобучению, либо не сходиться.

- Поведение сети не всегда может быть однозначно предсказуемо, что вносит риски ложных срабатываний, либо пропуска инцидентов.

- Трудно объяснить, почему сеть приняла то или иное решение (проблема вербализации).

- Следовательно невозможно гарантировать повторяемость и однозначность получения результатов.

Существующие решения и предложения, основанные на нейронных сетях

Обобщу подходы, описанные в литературе:

- В работах Мустафаева [2], Жигулина и Подворчана [6], Halenar [7] предлагается использовать многослойный перцептрон, предварительно обученный на базе атак (например, KDD).

- В работе Haibo Zhang [3] и соавторов предлагается использовать нейронную сеть и вэйвлет-преобразование.

- Min-Joo Kang [4] и соавторы используют глубокое обучение для обнаружения проблем в бортовой CAN сети автомобиля.

- Талалаев и соавторы [8] предлагают использовать рециркуляционную нейронную сеть или метод главных компонент для сжатия пространства признаков, после чего исследуют применение как двуслойного перцептрона, так и карты Кохонена.

- Балахонцев и соавторы [10] используют трёхслойный перцептрон.

- Корнев и Пылькин [13] исследуют существующие подходы и указывают на возможность применения перцептронов с разным количеством слоёв, однослойных классификаторов для детектирования нормального состояния, а также гибридной сети, состоящей из карты Кохонена и перцептрона.

И практически используемые:

- Компания DeepInstinct предлагает решения с использованием глубокого обучения, но деталей технологии, которую они используют, и каких-либо сравнений я не не нашёл. Судя по тому, что у них представлено на сайте, они используют обучение с учителем.

- По неофициальным данным, разработка нейросетевых детекторов активно ведётся компаниями, в том числе и несколькими российскими.

Выводы по существующим решениям

Средства управления и мониторинга СПД эволюционируют в сторону комплексных решений.

Современные системы, в целом стремятся к тому, чтобы не только выполнять узкую задачу обнаружения вторжений, но и помогать в диагностике неисправностей сети, при этом реализуя как методы обнаружения аномалий, так и методы обнаружения известных нарушений.

В состав такой комплексной системы входят различные распределённые по сети сенсоры, которые могут быть, как пассивными, так и активными. Используя данные сенсоров, которыми могут являться целые экземпляры IDS, центральный коррелятор (в терминологии Prelude SIEM) анализирует общее состояние сети.

При этом, возрастают объёмы данных, которые требуется обработать, и их размерность.

В литературе, в основном, рассмотрены нейросетевые методы, основанные на перцептронах, либо картах Кохонена. Есть не заполненная ниша в виде разработок, на базе последних исследований, касающихся соревновательных нейросетей или свёрточных сетей. Хотя данные методы хорошо себя зарекомендовали в смежных областях, где требуется сложный анализ.

Явно наблюдается разрыв между потребностями рынка и предложением в виде существующих решений.

Поэтому, имеет смысл проводить исследования в данном направлении.

Проектирование модуля

Возможные атаки

Чтобы понять от чего надо защищаться, стоит определиться, где искать атаки, и что они из себя вообще представляют [16].

Во-первых, рассматривать канальный уровень и ниже я не буду, поскольку его протоколы специфичны для оборудования и большинство IDS не работает на данном уровне (здесь есть, разве что обнаружение ARP спуфинга, специфичного для Ethernet, про обнаружение же атак на PPP и подобные протоколы, я недостаточно знаю).

Если смотреть на динамику атак по уровням, видно что с сетевого и транспортного в конце 90-х — начале 2000-х, они смещаются в сторону прикладного уровня.

Ранее были популярны атаки типа Ping of the Death, IP Spoofing, SYN flood или ARP cache poison, а сейчас нижний уровень начинается где-то в районе DNS.

От атак типа инъекций кода (например, SQL injection или PHP injection), которые ещё изредка встречаются, атакующие перешли к XSS и CSRF, которые они могут использовать для получения учётных данных, либо для выполнения неавторизованных запросов на серверах внутри сети.

Сейчас кроссайтовый скриптинг закрыт в большинстве фрэймворков. Но может оставаться в самописных сайтах (в том числе, прошивках устройств).

Активно проводятся атаки на Active Directory, из относительно свежих "олд-скул" атак на протоколы известна атака на SMB.

Пока не завершён переход на HTTPS с HSTS, могут встречаться атаки типа SSL stripping.

Также, могут быть использованы эксплоиты для устаревших версий ПО (например, тот же, наделавший много шуму HeartBleed), от чего может помочь сканирование сети.

Эти атаки проводятся, прежде всего с целью перехвата управления или раскрытия данных.

Отдельно стоит выделить DoS атаки, которые как правило, проводятся на конкретный сервер.

Прежде они могли реализовываться на транспортном уровне (например, SYN Flood) и ниже, теперь же, чаще всего реализуются на прикладном (например, посылкой большого количества HTTP запросов) в виде DDoS.

Фишинговые атаки также пока не потеряли своей актуальности.

Во-вторых, рассматривать только сетевые атаки было бы наивно. В конечном итоге, не имеет значения, как будет осуществлён DoS: атакой на канал сервера, либо через взлом Windows-машины администратора сети, хранящей SSH ключи. Мало того, атака на целевые узлы сети часто начинается с захвата наиболее уязвимых пользовательских узлов.

Кроме того, "классические" атаки прикладного уровня (например, на сервисы, такие как ftpd, либо дырявый sendmail), также уступают место атакам на уровне хоста. Причём, многие из них сейчас требуют тех или иных действий пользователя: просмотра каталога, открытия pdf документа, перехода на сайт и т.п..

Обнаружение атак уровня хоста IDS уровня сети не столь эффективно: как правило, атакующий рассчитывает на то, что сообщения будут проверены. Потому могут быть использованы обфускация, шифрование, либо внесение атакующего агента через сторонние каналы, в обход сети.

С задачами обнаружения таких атак справляется антивирус. Но антивирус, без централизованного управления и анализа данных способен только лишь распознать локальную угрозу и устранить её.

Он не способен определить, что это: случайно попавший файл, неудачная попытка целевой атаки с использованием плохо обфусцированного агента, либо начало проникновения червя в сеть.

Также, использование буткитов, как правило, сводит функционирование антивируса на нет.

В-третьих, для осуществления почти любой атаки требуется знание о сети (пример, когда не требуется: физическое отключение сегмента, — и то здесь надо быть уверенным, что канал связи с внешним миром только один). Это знание возможно получить прямо или косвенно (кражей данных о топологии, например). Прямое получение данных о сети и её узлах осуществляется за счёт сканирования.

Сканирование подразделяется на следующие типы:

- Поиск узлов сети посредством сканирования диапазона адресов.

- Обнаружение сервисов, предоставляемых узлом, посредством сканирования диапазона портов.

- Обнаружение узлов, предоставляющих сервисы, например посылая широковещательные запросы.

Сканирование диапазона адресов может быть совмещено со сканированием портов для поиска сервисов, которые могут оказаться уязвимыми.

Сканирование может производиться "наивным методом", к примеру используя посылку ICMP ping. Но может быть замаскировано.

Пример маскировки — посылка TCP SYN на указанные порты без последующего установления соединения.

Как правило, современные IDS могут отловить оба варианта. Маскировка сканирования также может осуществляться разнесением его на длительное время, либо выполнением с нескольких узлов.

Помимо сканирования, топология сети может быть определена менее точно, но более скрытно:

- Обнаружением узлов, рассылающих широковещательные запросы. Обнаружить такое практически невозможно: машина работает в обычном режиме.

- Прослушиванием трафика. Может быть обнаружено, кроме того современные топологии сетей препятствуют данной атаке (физическая общая шина редко используется).

Теперь возможно выделить типы атак для каждого класса.

Атаки уровня узла

Несколько примеров типов атак:

- Несанкционированная попытка повышения привилегий.

- Несанкционированный запуск кода с привилегиями зарегистрированного пользователя.

- Несанкционированный запуск кода с привилегиями демона/службы.

- Попытка изменения учётных данных (например, регистрации нового пользователя).

- Попытка прямой записи в дисковое устройство в обход драйверов ФС.

- Несанкционированное изменение файлов (в том числе массовое, либо изменение исполняемых модулей).

- Несанкционированное изменение системных настроек (например, с целью вывода системы из строя).

Конечно, большинство из этих атак также возможно маскировать, но при этом, возможно обнаружить попытку маскировки и также её интерпретировать, как атаку (самый простой пример: многие антивирусы обнаруживают такую технику маскировки, как внедрение в процесс, считая её за вредоносную активность).

Некоторые атаки на хост возможно распознать по изменению потребления ресурсов. Запуск дополнительного кода, как правило, ведёт к повышению потребления памяти, увеличению частоты обращения к диску и увеличению использования CPU.

Обычно данные аспекты не маскируют, т.к. они являются незначительными. Однако, при поражении большого количества узлов, возможно выделить характерные паттерны.

Часто, начиная с какого-то момента, хост начинает проявлять нетипичную для него сетевую активность, например попытку регулярного обращения к сайтам, на которые ранее обращений не было, либо к сайтам, доменные имена которых не разбиваются на словарные слова (ну или имеют высокую энтропию относительно "нормальных" имён). На стороне узла данная активность, как правило успешно маскируется (поскольку, если был антивирус, он её пропустил), но она может быть видна сетевой IDS.

Атаки уровня сети

Типы атак:

- Отказ в обслуживании: DoS/DDoS.

- Перехват управления.

- Несанкционированное получение данных пользователя. Как пассивное, так и активное.

Про конкретные атаки подробнее было написано выше.

Сканирование

Подразделяется на:

- Поиск узлов: n узлов будут отправлять m узлам сходные запросы. При этом, я считаю, что узел не будет отправлять запрос сам себе.

- Поиск сервисов узла: n узлов обращаются к m узлам на p портов.

Первый вариант атаки проще обнаружить сетевой IDS: трафик сканирования будет заметен, если он компактно расположен во времени.

В ином случае, следует использовать методы слабо чувствительные к временным разрывам.

Второй вариант проще всего обнаружить с использованием данных, полученных непосредственно с узла.

Собираемые данные

Данные узла

Считая, что вышеназванные атаки вызовут отклонения в использовании ресурсов, будут собираться следующие параметры:

- Загрузка CPU (процентов).

- Дисковые IO операции (операций в секунду).

- Потребление памяти (в процентах).

- Сетевая активность (МБит в секунду).

Параметры узлов объединяются в вектор.

Данные сети

В работе [12] предлагается собирать следующие сетевые параметры:

- Последовательность TCP пакетов, флаги, номера портов отправителя и получателя и IP адрес отправителя.

- Последовательность ICMP пакетов, IP адрес отправителя,

ICMP_ID. - IP адрес источника, длину пакета и UDP порты источника и получателя.

В работе [6] представлен обширный список параметров, взятый из базы NSL-KDD.

duration— продолжительность соединения в секундах.protocol_type— тип используемого протокола: TCP, UDP и пр..service— тип используемого обслуживания: HTTP, FTP, TELNET и пр..flag— флаг соединения: норма или ошибка.scr_bytes— число байт данных от источника к получателю.dst_bytes— число байт данных от получателя к источнику.land— 1 если соединение из/на таком же хосте/порте.wrong_fragments— количество "неверных" фрагментов.urgent— количество срочных (urgent) пакетов.hot— число "горячих" индикаторов.num_failed_logins— число ошибочных попыток входа.logged_in— 1 — успешный вход, 0 в противном случае.num_compromised— число скомпрометированных условий.root_shell— 1 — если получена корневая оболочка, 0 — в противном случае.su_attempted— 1 — если была попытка выполнить "su root", 0 — в др. случае.num_root— число доступов типа "root".num_file_creations— число операций создания файла.num_shells— число "подсказок оболочки".num_access_files— число получений доступа к контролю над файлами.num_outbound_cmds— количество исходящих команд через ftp сессию.is_host_login— 1 — если логин принадлежит к "host" списку.is_quest_login— 1 — если подключение типа "гость".count— число подключений к этому хосту за последние 2 секунды.srv_count— число подключений к этому сервису за последние 2 сек..serror_rate— процент подключений с syn ошибками.srv_serror_rate— процент подключений к сервису с syn ошибками.rerror_rate— процент подключений с rej ошибками.srv_rerror_rate— процент подключений к сервису с rej ошибками.same_srv_rate— процент подключений к такому сервису.diff_srv_rate— процент подключений к различным сервисам.srv_diff_hast_rate— процент подключений к различным хостам.dst_host_count— количество соединений к локальному хосту, установленных удаленной стороной.dst_host_srv_count— количество соединений к локальному хосту, установленных удаленной стороной и использующих одну и ту же службу.dst_host_same_srv_rate— процентное число соединений к локальному хосту, установленных удаленной стороной и использующих одну и ту же службу.dst_host_diff_srv_rate— процентное число соединений к локальному хосту, установленных удаленной стороной и использующих различные службы.dst_host_same_src_port_rate— процентное число соединений к данному хосту при текущем номере порта источника.dst_host_srv_diff_host_rate— процентное число соединений к службе разных хостов.dst_host_serror_rate— процентное число соединений c ошибкой типа syn для данного хоста-приемника.dst_host_srv_serror_rate— процентное число соединений c ошибкой типа syn для данной службы приемника.dst_host_rerror_rate— процентное число соединений c ошибкой типа rej для данного хоста-приемника.dst_host_srv_rerror_rate— процентное число соединений c ошибкой типа rej для данной службы приемника.

duration— длительность соединения (секунды).protocol_type— тип протокола (TCP, UDP, и др.).service— сетевая служба получателя (HTTP, TELNET и др.).flag— cостояние соединения.src_bytes— число байтов переданных от источника получателю.dst_bytes— число байтов переданных от получателя источнику.land— 1 если соединение по идентичным портам; 0 в других случаях.wrong_fragment— количество "неверных" пакетов.urgent— количество пакетов с флагом URG.

Одной из интересных особенностей в данной работе является то, что признаки нейросети могут настраиваться пользователем.

Хотя это и не актуально для концепта в данной статье, но может быть учтено при разработке законченного продукта.

- ID protocol — тип протокола, ассоциированный с пакетом.

- Source port — номер порта отправителя TCP или UDP.

- Destination port — номер порта получателя TCP или UDP.

- Source Address — IP адрес отправителя.

- Destination Address — IP адрес получателя.

- ICMP type — тип ICMP пакета.

- Length of data transferred — размер пакета данных в байтах.

- FLAGS — флаги в заголовке протокола.

- TCP window size — размер TCP окна.

Номер порта отправителя, как правило, не имеет смысла учитывать, поскольку он генерируется автоматически.

При разработке концепта, я буду использовать базу NSL-KDD для эмуляции сетевой активности, поскольку с ней удобно работать. Соответственно, параметры будут взяты оттуда. В реальной же системе, как следует из обзора, желательно подробно разбирать пакеты прикладных протоколов.

Я выбрал параметры, отталкиваясь от работы [6] и несколько дополнив их.

duration— длительность соединения.protocol_type— тип протокола (TCP, UDP, и др.).service— сетевая служба получателя (HTTP, TELNET и др.).flag— cостояние соединения.src_bytes— число байтов переданных от источника получателю.dst_bytes— число байтов переданных от получателя источнику.land— 1 если соединение по идентичным портам; 0 в других случаях.wrong_fragment— количество "неверных" пакетов.urgent— количество пакетов с флагом URG.count— число подключений к этому хосту за последние 2 сек..srv_count— число подключений к этому сервису за последние 2 сек..serror_rate— процент подключений с syn ошибками.diff_srv_rate— процент подключений к различным сервисам.srv_diff_host_rate— процент подключений к различным хостам.dst_host_srv_count— количество соединений к локальному хосту, установленных удаленной стороной и использующих одну и ту же службу.

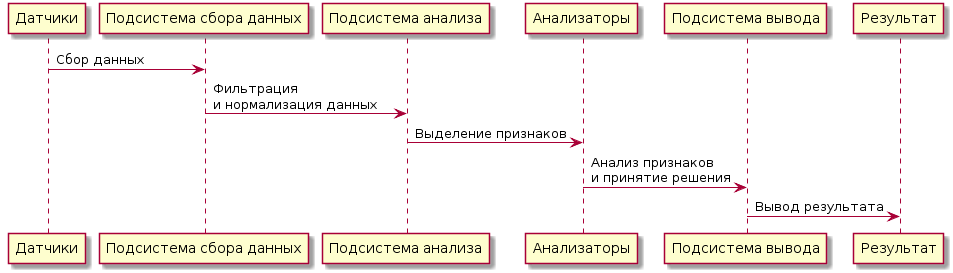

Описание типовой архитектуры IDS

Типичная IDS состоит из следующих компонентов:

Датчики:

- Модули захвата.

- Модуль сбора.

- Модуль сопряжения.

Подсистема анализа:

- Модули декодирования.

- Модули обнаружения.

- Подсистема вывода:

- Модули реагирования.

- Модули вывода.

Датчиков в современных IDS, как правило несколько, и они могут быть распределены по машинам пользователя. Лучше всего это видно на примерах Prelude SIEM и OSSIM, описанных выше. Задачей датчиков является захват данных, их накопление и отправка центральной системе.

- Датчики приложений – предоставляют данные о работе конкретного программного обеспечения защищаемой системы.

- Датчики хоста – предоставляют данные о функционировании отдельной рабочей станции защищаемой системы.

- Датчики сети – отвечают за сбор данных для оценки сетевого трафика.

- Межсетевые датчики – содержат характеристики данных, циркулирующих между сетями.

Полученная от датчиков информация декодируется в набор признаков и проводится через цепочку модулей анализа.

Модуль анализа принимает информацию из источника данных и анализирует данные на наличие признаков атак или нарушений политики безопасности. Он может использоваться, как для обнаружения вторжений, эксплуатирующих известные шаблоны атак, так и для обнаружения аномальной активности.

Анализаторы известных атак могут опираться на обновляемую базу сигнатур, либо быть реализованы на основе сети прямого распространения, обученной на примерах атак.

Анализаторы аномалий могут учитывать не только состояние датчиков, но и результаты работы предыдущих анализаторов.

После того, как анализаторы отработали, в том или ином виде выводится их совокупное состояние. Это может быть, как вывод данных пользователю через один из интерфейсов, за что отвечают модули вывода, так и указание цели активной системе защиты (например, брандмауэру на блокирование соединения), за что отвечают модули реагирования.

Кратко это выглядит так:

Датчики -> "Подсистема сбора данных": Сбор данных

"Подсистема сбора данных" -> "Подсистема анализа": Фильтрация\nи нормализация данных

"Подсистема анализа" -> "Анализаторы": Выделение признаков

"Анализаторы" -> "Подсистема вывода": Анализ признаков\nи принятие решения

"Подсистема вывода" -> Результат: Вывод результатаОписание принципа построения нейросетевого анализатора

Изо всего вышесказанного следует, что детектор должен быть комбинированным: обнаруживать аномалии и известные атаки. Либо это должно быть несколько разных детекторов в цепи. Кроме того, желательно чтобы IDS периодически запускала активное сканирование с целью обнаружения потенциальных уязвимостей.

В связи с объёмом работы, требуемой для реализации полноценного детектора, в данной статье я решаю ограниченную задачу построения концепта модуля обнаружения аномалий. Предполагается, что данные мне поставлены модулем декодирования в понятной форме, в виде набора признаков, которые я могу подать на входы сети (это база NSL-KDD). Данные хостов будут сгенерированы.

С учётом предпосылки в начале статьи, метод представления результатов детектора желательно реализовать многоклассовым (чтобы не только обнаруживать наличие аномальной активности, но и определять её тип), но с целью упрощения будет реализован двуклассовый детектор.

Все детекторы аномалий, независимо от модели использованной при их построении, действуют по принципу сравнения данных эталона с текущей обстановкой и сигнализации, при выходе за указанный порог.

Любая модель от статистической, до искусственной имунной системы должна иметь такой эталон.

В случае нейросети, эталон создаётся в процессе обучения во время нормальной работы сети передачи данных (СПД), затем сеть, функционируя, выявляет отклонения, выходящие за указанные границы.

Сложности данного подхода заключаются в том, что:

Сеть надо обучить при нормальном функционировании СПД, но нельзя быть уверенным, что в данный момент не ведётся атака, и сеть не обучится на "аномальной активности".

Остановить СПД или отключить её от внешних сетей тоже нельзя: даже если возможно прервать её работу, в будущем активность подключенной СПД будет трактоваться, как аномальная.

- Объём данных, следовательно и период обучения, должен быть достаточно большим: функционирование СПД почти гарантированно различается в разные периоды суток и даже может отличаться в разные кварталы года.

От проблемы обучения на при нормальном функционировании уйти не представляется возможным (её решают написанием правил, описывающих функционирование СПД в нормальном режиме, но здесь это не применимо).

Проблему большого объёма данных, разнесённого во времени, возможно смягчить, используя адаптивную подстройку.

Как возможно видеть на визуализации ниже, сетевая активность при атаках отлична от нормальной активности сети (данные взяты из NSL-KDD):

Т.е., возможно увидеть аномальную активность атаки на фоне нормальной активности сети:

import hypertools as hyp

from collections import OrderedDict

import csv

def read_ids_data(data_file, is_normal=True, labels_file='NSL_KDD/Field Names.csv', with_host=False):

selected_parameters = ['duration', 'protocol_type', 'service', 'flag', 'src_bytes', 'dst_bytes', 'land', 'wrong_fragment', 'urgent']

# "Label" - "converter function" dictionary.

label_dict = OrderedDict()

result = []

with open(labels_file) as lf:

labels = csv.reader(lf)

for label in labels:

if len(label) == 1 or label[1] == 'continuous':

label_dict[label[0]] = lambda l: np.float64(l)

elif label[1] == 'symbolic':

label_dict[label[0]] = lambda l: sh(l)

f_list = [i for i in label_dict.values()]

n_list = [i for i in label_dict.keys()]

data_type = lambda t: t == 'normal' if is_normal else t != 'normal'

with open(data_file) as df:

# data = csv.DictReader(df, label_dict.keys())

data = csv.reader(df)

for d in data:

if data_type(d[-2]):

# Skip last two fields and add only specified fields.

net_params = tuple(f_list[n](i) for n, i in enumerate(d[:-2]) if n_list[n] in selected_parameters)

if with_host:

host_params = generate_host_activity(is_normal)

result.append(net_params + host_params)

else:

result.append(net_params)

hyp.plot(np.array(result), '.', normalize='across', reduce='UMAP', ndims=3,

n_clusters=10, animate='spin', palette='viridis',

title='Growing Neural Gas on the NSL-KDD [normal={}]'.format(is_normal),

# vectorizer='TfidfVectorizer',

# precog=False, bullettime=True, chemtrails=True, tail_duration=100,

duration=3, rotations=1, legend=False, explore=False, show=True,

save_path='./video.mp4')

read_ids_data('NSL_KDD/20 Percent Training Set.csv')

read_ids_data('NSL_KDD/20 Percent Training Set.csv', is_normal=False)Потому, обнаруживать аномалии предлагается с помощью кластеризации "картины сетевой активности".

Как правило, задача кластеризации в рамках нейросетевого подхода решается с использованием самоорганизующихся карт Кохонена.

Дополнительными проблемами, которые вносит данный подход, являются:

- Необходимость задания количества кластеров.

- Необходимость переобучать детектор, при изменении топологии СПД.

Чтобы исключить данные проблемы, для построения детектора аномалий, я решил обратиться к адаптивным нейросетевым алгоритмам кластеризации.

Идея обнаружения такова: сеть учится в режиме нормального функционирования СПД в течение некоторого времени. При этом, образуется некоторое количество кластеров данных, которые при правильной настройке сети, полностью характеризуют нормальное функционирование СПД.

Есть следующие варианты обнаружения:

- Обучение сети на поступающих данных. В случае появления аномалий, структура и количество кластеров начинают изменяться.

- Предоставление поступивших данных обученной сети и проверка того, насколько близко они подходят одному из кластеров.

В первом случае, аномалии возможно обнаружить по:

- Изменению количества кластеров.

- Динамике скорости создания и удаления новых нейронов и связей.

Во втором случае аномалии обнаруживаются по отклонению значения новых измерений от среднего для данных, на которых сеть обучена.

В сетевых алгоритмах расчёт динамики выполнить сложно: сеть может изменять количество нейронов и связей на каждой итерации, при том что некоторые алгоритмы создают и удаляют фиксированное количество нейронов на каждой итерации.

Изменение количества кластеров не является надёжным показателем. Кроме того, обучение сети в процессе обнаружения ставит несколько других проблем (таких, как переобучение, например).

Достаточно надёжным вариантом является измерение отклонений. Именно этот вариант будет применён.

Архитектура модуля

Данные с узлов пересылаются агентами и для каждого параметра вычисляется среднее. Эти данные объединяются в один вектор с данными сетевой активности, получаемыми от IDS.

В прототипе данные хостов генерируются функцией, которая увеличивает потребление ресурсов в определённом проценте атак (на данный момент, выбрано 25%).

Данные сети предоставляются модулю IDS в стандартизованном виде. В прототипе это записи NSL-KDD.

Реализован будет алгоритм обнаружения отклонений от среднего:

@startuml

start

partition Обучение {

: Обучить сеть на нормальных данных;

: Рассчитать среднеквадратическое отклонение\nмежду измерениями и ближайшими к ним узлами;

}

partition Обнаружение {

: Поступило новое измерение;

: Получить ближайший к нему узел;

if (Разница выходит за стандартное отклонение) then (Нет)

-[#blue]->

: Считать данные нормальными;

if (Требуется дообучение) then (Да)

-[#green]->

: Добавить данные в граф и запустить\nпроход обучения сети.;

else (Нет)

-[#blue]->

endif

else (Да)

-[#green]->

: Увеличить значение\nсуммарного отклонения;

if (Суммарное отклонение превышает порог) then (Да)

-[#green]->

: Сигнализировать об аномалии;

else (Нет)

-[#blue]->

: Продолжить;

endif

endif

}

stop

@endumlКак видно из диаграммы, в данном алгоритме может быть использована адаптивная подстройка, напоминающая метод обучения с частичным привлечением учителя.

С целью улучшения качества обнаружения, считается не одно отклонение, а средние отклонения для лучше всего подходящих нейронов.

Потом для кластера вычисляется корень из среднего арифметического всех значений отклонений, входящих в него нейронов.

Для поданного на проверку сэмпла данных ищется ближайший нейрон, считается расстояние между ними и сравнивается с посчитанным среднеквадратическим отклонением для кластера, в который входит нейрон.

Если расстояние между сэмплом и нейроном больше отклонения по кластеру, данный сэмпл считается аномальным.

Это гибрид метода классификации по среднему расстоянию, который используется для определения класса нейронов, в статье 20 и метода по классификации по минимальному расстоянию.

Сначала используется первый: выбирается лучший нейрон. Затем, считается разница между средним отклонением по кластеру.

Ещё один вариант — классификация по методу большинства, когда нейрон получает класс по максимальному количеству точек в его области Вороного здесь не применим.

Ядро детектора представляет собой объект, реализующий один из алгоритмов "растущего нейронного газа" или GNG, который обучен на сетевой активности во время нормального функционирования СПД.

GNG позволяет кластеризовать данные, самостоятельно определяя необходимое количество кластеров.

В частности, это может быть один из следующих алгоритмов:

- GNG [18] — классический растущий нейронный газ, о котором подробнее здесь, либо в работе [17], где он впервые описан.

- IGNG [19] — инкрементальный растущий нейронный газ. Достаточно сильно отличается от классического. Имеет более высокую скорость сходимости. В статье 20 он называется "Быстрорастущий GNG", а зрелые и зародышевые нейроны называются фиксированными и нефиксированными, соответственно (авторы использовали в своей работе оригинальную статью [19]).

Модуль хранит данные, на которых он обучался, в виде структуры сети и получает новые данные во время работы.

На выходе модуль должен постоянно выводить результат: есть аномальная активность, либо нет, либо вероятность наличия данной активности.

На следующем рисунке показан пример кластеризации, с использованием GNG (на ограниченном подмножестве, с целью наглядности), где ясно видно, как алгоритм сходится.

Реализация модуля

Существует несколько реализаций GNG, как минимум:

Реализация на MQL-5 в вышеприведённой статье [18]. Язык сильно похож на C++ и легко понимается. В целом, общий стиль данной реализации мне не понравился.

- На R. И там же есть реализация на C++.

- На MATLAB.

- На Go.

- На JavaScript. Симулятор многих алгоритмов.

- И две реализации на Python из которых я взял вторую, т.к. она заработала сразу после установки зависимостей.

Соответственно, в качестве языка реализации прототипа используется Python. С реализациями IGNG дело обстоит хуже, и я не нашёл ни одной, хотя конечно же они есть, т.к. авторы статьи получали результаты для своего алгоритма. В результате, IGNG реализацию пришлось реализовывать полностью самостоятельно.

Краткое описание кода

Точкой входа является функция main(), которая устанавливает параметры и вызывает функцию test_detector(), гоняющую детектор так, как задумано.

В функции test_detector() предварительно загружаются данные для обучения детектора.

Затем, производится обучение, используя метод train(), и вызывается обнаружение на разных наборах данных, используя метод detect_anomalies().

Все данные загружаются функцией read_ids_data().

Функция читает данные из базы NSL-KDD с использованием стандартного модуля csv. Какие данные будут прочитаны: нормальные, аномальные или полные, задаётся параметром activity_type.

Также функция, если было запрошено, может сгенерировать активность хостов, вызвав generate_host_activity(), и добавить полученные данные к данным сети.

Функция вернёт результат в виде ненормализованного массива Numpy.

После возврата из функции, данные будут нормализованы, используя функцию normalize() модуля preprocessing библиотеки Scikit-Learn. Далее, вся работа производится только с нормализованными данными.

На прочитанных данных строится ненаправленный граф, как объект класса Graph библиотеки NetworkX через вызов функции create_data_graph().

Этот граф нужен только для визуализации.

Данные передаются конструктору класса детектора. В конструкторе данные запоминаются во внутренний атрибут класса и создаётся пустой граф, в который будут добавляться нейроны и связи.

Основным классом детектора является GNG или IGNG, в зависимости от реализованного алгоритма. Эти классы являются наследниками абстрактного класса NeuralGas, в котором реализованы общие методы.

В методе train() многократно вызывается кластеризующий метод и периодически сохраняется картинка с визуализацией через вызов метода __save_img().

Кластеризующему методу передаётся одно из значений, которое представляет собой набор координат точки данных в многомерном пространстве.

Получая данные этой точки, кластеризующий метод выбирает наиболее близкие нейроны внутреннего графа (того, который был создан в конструкторе) и, если они не удовлетворительны, создаёт новые нейроны и связи.

В методе __save_img() для формирования картинки используются функции draw_dots3d(), либо draw_graph3d(), который вызывается два раза: сначала для отрисовки данных, затем для отрисовки нейронной сети поверх данных.

Внутри визуализация реализована с помощью библиотеки Mayavi и основной вызов, рисующий точки — это mayavi.points3d().

После завершения обучения, сохранённые картинки сшиваются в GIF, используя модуль ImageIO.

Полный исходный код находится здесь:

https://github.com/artiomn/GNG

Код сначала был адаптирован для многомерных данных и частично переписан. По ходу этого, выяснилось, что код индусский, и алгоритм вообще реализован некорректно (см. например на использование переменной i в методе train оригинала: благодаря этому багу, код работал). Затем, в связи с низкой скоростью работы, был реализован алгоритм IGNG.

На всякий случай (потому что неизвестно, что будет с Github в течение ближайшего года) продублирую здесь код прототипа.

#!/usr/bin/env python

# -*- coding: utf-8 -*-

from abc import ABCMeta, abstractmethod

from math import sqrt

from mayavi import mlab

import operator

import imageio

from collections import OrderedDict

from scipy.spatial.distance import euclidean

from sklearn import preprocessing

import csv

import numpy as np

import networkx as nx

import re

import os

import shutil

import sys

import glob

from past.builtins import xrange

from future.utils import iteritems

import time

def sh(s):

sum = 0

for i, c in enumerate(s):

sum += i * ord(c)

return sum

def create_data_graph(dots):

"""Create the graph and returns the networkx version of it 'G'."""

count = 0

G = nx.Graph()

for i in dots:

G.add_node(count, pos=(i))

count += 1

return G

def get_ra(ra=0, ra_step=0.3):

while True:

if ra >= 360:

ra = 0

else:

ra += ra_step

yield ra

def shrink_to_3d(data):

result = []

for i in data:

depth = len(i)

if depth <= 3:

result.append(i)

else:

sm = np.sum([(n) * v for n, v in enumerate(i[2:])])

if sm == 0:

sm = 1

r = np.array([i[0], i[1], i[2]])

r *= sm

r /= np.sum(r)

result.append(r)

return preprocessing.normalize(result, axis=0, norm='max')

def draw_dots3d(dots, edges, fignum, clear=True,

title='',

size=(1024, 768), graph_colormap='viridis',

bgcolor=(1, 1, 1),

node_color=(0.3, 0.65, 0.3), node_size=0.01,

edge_color=(0.3, 0.3, 0.9), edge_size=0.003,

text_size=0.14, text_color=(0, 0, 0), text_coords=[0.84, 0.75], text={},

title_size=0.3,

angle=get_ra()):

# https://stackoverflow.com/questions/17751552/drawing-multiplex-graphs-with-networkx

# numpy array of x, y, z positions in sorted node order

xyz = shrink_to_3d(dots)

if fignum == 0:

mlab.figure(fignum, bgcolor=bgcolor, fgcolor=text_color, size=size)

# Mayavi is buggy, and following code causes sockets leak.

#if mlab.options.offscreen:

# mlab.figure(fignum, bgcolor=bgcolor, fgcolor=text_color, size=size)

#elif fignum == 0:

# mlab.figure(fignum, bgcolor=bgcolor, fgcolor=text_color, size=size)

if clear:

mlab.clf()

# the x,y, and z co-ordinates are here

# manipulate them to obtain the desired projection perspective

pts = mlab.points3d(xyz[:, 0], xyz[:, 1], xyz[:, 2],

scale_factor=node_size,

scale_mode='none',

color=node_color,

#colormap=graph_colormap,

resolution=20,

transparent=False)

mlab.text(text_coords[0], text_coords[1], '\n'.join(['{} = {}'.format(n, v) for n, v in text.items()]), width=text_size)

if clear:

mlab.title(title, height=0.95)

mlab.roll(next(angle))

mlab.orientation_axes(pts)

mlab.outline(pts)

"""

for i, (x, y, z) in enumerate(xyz):

label = mlab.text(x, y, str(i), z=z,

width=text_size, name=str(i), color=text_color)

label.property.shadow = True

"""

pts.mlab_source.dataset.lines = edges

tube = mlab.pipeline.tube(pts, tube_radius=edge_size)

mlab.pipeline.surface(tube, color=edge_color)

#mlab.show() # interactive window

def draw_graph3d(graph, fignum, *args, **kwargs):

graph_pos = nx.get_node_attributes(graph, 'pos')

edges = np.array([e for e in graph.edges()])

dots = np.array([graph_pos[v] for v in sorted(graph)], dtype='float64')

draw_dots3d(dots, edges, fignum, *args, **kwargs)

def generate_host_activity(is_normal):

# Host loads is changed only in 25% cases.

attack_percent = 25

up_level = (20, 30)

# CPU load in percent.

cpu_load = (10, 30)

# Disk IO per second.

iops = (10, 50)

# Memory consumption in percent.

mem_cons = (30, 60)

# Memory consumption in Mb/s.

netw_act = (10, 50)

cur_up_level = 0

if not is_normal and np.random.randint(0, 100) < attack_percent:

cur_up_level = np.random.randint(*up_level)

cpu_load = np.random.randint(cur_up_level + cpu_load[0], cur_up_level + cpu_load[1])

iops = np.random.randint(cur_up_level + iops[0], cur_up_level + iops[1])

mem_cons = np.random.randint(cur_up_level + mem_cons[0], cur_up_level + mem_cons[1])

netw_act = np.random.randint(cur_up_level + netw_act[0], cur_up_level + netw_act[1])

return cpu_load, iops, mem_cons, netw_act

def read_ids_data(data_file, activity_type='normal', labels_file='NSL_KDD/Field Names.csv', with_host=False):

selected_parameters = ['duration', 'protocol_type', 'service', 'flag', 'src_bytes', 'dst_bytes', 'land', 'wrong_fragment', 'urgent', 'serror_rate',

'diff_srv_rate', 'srv_diff_host_rate', 'dst_host_srv_count', 'count']

# "Label" - "converter function" dictionary.

label_dict = OrderedDict()

result = []

with open(labels_file) as lf:

labels = csv.reader(lf)

for label in labels:

if len(label) == 1 or label[1] == 'continuous':

label_dict[label[0]] = lambda l: np.float64(l)

elif label[1] == 'symbolic':

label_dict[label[0]] = lambda l: sh(l)

f_list = [i for i in label_dict.values()]

n_list = [i for i in label_dict.keys()]

if activity_type == 'normal':

data_type = lambda t: t == 'normal'

elif activity_type == 'abnormal':

data_type = lambda t: t != 'normal'

elif activity_type == 'full':

data_type = lambda t: True

else:

raise ValueError('`activity_type` must be "normal", "abnormal" or "full"')

print('Reading {} activity from the file "{}" [generated host data {} included]...'.

format(activity_type, data_file, 'was' if with_host else 'was not'))

with open(data_file) as df:

# data = csv.DictReader(df, label_dict.keys())

data = csv.reader(df)

for d in data:

if data_type(d[-2]):

# Skip last two fields and add only specified fields.

net_params = tuple(f_list[n](i) for n, i in enumerate(d[:-2]) if n_list[n] in selected_parameters)

if with_host:

host_params = generate_host_activity(activity_type != 'abnormal')

result.append(net_params + host_params)

else:

result.append(net_params)

print('Records count: {}'.format(len(result)))

return result

class NeuralGas():

__metaclass__ = ABCMeta

def __init__(self, data, surface_graph=None, output_images_dir='images'):

self._graph = nx.Graph()

self._data = data

self._surface_graph = surface_graph

# Deviation parameters.

self._dev_params = None

self._output_images_dir = output_images_dir

# Nodes count.

self._count = 0

if os.path.isdir(output_images_dir):

shutil.rmtree('{}'.format(output_images_dir))

print("Ouput images will be saved in: {0}".format(output_images_dir))

os.makedirs(output_images_dir)

self._start_time = time.time()

@abstractmethod

def train(self, max_iterations=100, save_step=0):

raise NotImplementedError()

def number_of_clusters(self):

return nx.number_connected_components(self._graph)

def detect_anomalies(self, data, threshold=5, train=False, save_step=100):

anomalies_counter, anomaly_records_counter, normal_records_counter = 0, 0, 0

anomaly_level = 0

start_time = self._start_time = time.time()

for i, d in enumerate(data):

risk_level = self.test_node(d, train)

if risk_level != 0:

anomaly_records_counter += 1

anomaly_level += risk_level

if anomaly_level > threshold:

anomalies_counter += 1

#print('Anomaly was detected [count = {}]!'.format(anomalies_counter))

anomaly_level = 0

else:

normal_records_counter += 1

if i % save_step == 0:

tm = time.time() - start_time

print('Abnormal records = {}, Normal records = {}, Detection time = {} s, Time per record = {} s'.

format(anomaly_records_counter, normal_records_counter, round(tm, 2), tm / i if i else 0))

tm = time.time() - start_time

print('{} [abnormal records = {}, normal records = {}, detection time = {} s, time per record = {} s]'.

format('Anomalies were detected (count = {})'.format(anomalies_counter) if anomalies_counter else 'Anomalies weren\'t detected',

anomaly_records_counter, normal_records_counter, round(tm, 2), tm / len(data)))

return anomalies_counter > 0

def test_node(self, node, train=False):

n, dist = self._determine_closest_vertice(node)

dev = self._calculate_deviation_params()

dev = dev.get(frozenset(nx.node_connected_component(self._graph, n)), dist + 1)

dist_sub_dev = dist - dev

if dist_sub_dev > 0:

return dist_sub_dev

if train:

self._dev_params = None

self._train_on_data_item(node)

return 0

@abstractmethod

def _train_on_data_item(self, data_item):

raise NotImplementedError()

@abstractmethod

def _save_img(self, fignum, training_step):

"""."""

raise NotImplementedError()

def _calculate_deviation_params(self, distance_function_params={}):

if self._dev_params is not None:

return self._dev_params

clusters = {}

dcvd = self._determine_closest_vertice

dlen = len(self._data)

#dmean = np.mean(self._data, axis=1)

#deviation = 0

for node in self._data:

n = dcvd(node, **distance_function_params)

cluster = clusters.setdefault(frozenset(nx.node_connected_component(self._graph, n[0])), [0, 0])

cluster[0] += n[1]

cluster[1] += 1

clusters = {k: sqrt(v[0]/v[1]) for k, v in clusters.items()}

self._dev_params = clusters

return clusters

def _determine_closest_vertice(self, curnode):

"""."""

pos = nx.get_node_attributes(self._graph, 'pos')

kv = zip(*pos.items())

distances = np.linalg.norm(kv[1] - curnode, ord=2, axis=1)

i0 = np.argsort(distances)[0]

return kv[0][i0], distances[i0]

def _determine_2closest_vertices(self, curnode):

"""Where this curnode is actually the x,y index of the data we want to analyze."""

pos = nx.get_node_attributes(self._graph, 'pos')

l_pos = len(pos)

if l_pos == 0:

return None, None

elif l_pos == 1:

return pos[0], None

kv = zip(*pos.items())

# Calculate Euclidean distance (2-norm of difference vectors) and get first two indexes of the sorted array.

# Or a Euclidean-closest nodes index.

distances = np.linalg.norm(kv[1] - curnode, ord=2, axis=1)

i0, i1 = np.argsort(distances)[0:2]

winner1 = tuple((kv[0][i0], distances[i0]))

winner2 = tuple((kv[0][i1], distances[i1]))

return winner1, winner2

class IGNG(NeuralGas):

"""Incremental Growing Neural Gas multidimensional implementation"""

def __init__(self, data, surface_graph=None, eps_b=0.05, eps_n=0.0005, max_age=10,

a_mature=1, output_images_dir='images'):

"""."""

NeuralGas.__init__(self, data, surface_graph, output_images_dir)

self._eps_b = eps_b

self._eps_n = eps_n

self._max_age = max_age

self._a_mature = a_mature

self._num_of_input_signals = 0

self._fignum = 0

self._max_train_iters = 0

# Initial value is a standard deviation of the data.

self._d = np.std(data)

def train(self, max_iterations=100, save_step=0):

"""IGNG training method"""

self._dev_params = None

self._max_train_iters = max_iterations

fignum = self._fignum

self._save_img(fignum, 0)

CHS = self.__calinski_harabaz_score

igng = self.__igng

data = self._data

if save_step < 1:

save_step = max_iterations

old = 0

calin = CHS()

i_count = 0

start_time = self._start_time = time.time()

while old - calin <= 0:

print('Iteration {0:d}...'.format(i_count))

i_count += 1

steps = 1

while steps <= max_iterations:

for i, x in enumerate(data):

igng(x)

if i % save_step == 0:

tm = time.time() - start_time

print('Training time = {} s, Time per record = {} s, Training step = {}, Clusters count = {}, Neurons = {}, CHI = {}'.

format(round(tm, 2),

tm / (i if i and i_count == 0 else len(data)),

i_count,

self.number_of_clusters(),

len(self._graph),

old - calin)

)

self._save_img(fignum, i_count)

fignum += 1

steps += 1

self._d -= 0.1 * self._d

old = calin

calin = CHS()

print('Training complete, clusters count = {}, training time = {} s'.format(self.number_of_clusters(), round(time.time() - start_time, 2)))

self._fignum = fignum

def _train_on_data_item(self, data_item):

steps = 0

igng = self.__igng

# while steps < self._max_train_iters:

while steps < 5:

igng(data_item)

steps += 1

def __long_train_on_data_item(self, data_item):

"""."""

np.append(self._data, data_item)

self._dev_params = None

CHS = self.__calinski_harabaz_score

igng = self.__igng

data = self._data

max_iterations = self._max_train_iters

old = 0

calin = CHS()

i_count = 0

# Strictly less.

while old - calin < 0:

print('Training with new normal node, step {0:d}...'.format(i_count))

i_count += 1

steps = 0

if i_count > 100:

print('BUG', old, calin)

break

while steps < max_iterations:

igng(data_item)

steps += 1

self._d -= 0.1 * self._d

old = calin

calin = CHS()

def _calculate_deviation_params(self, skip_embryo=True):

return super(IGNG, self)._calculate_deviation_params(distance_function_params={'skip_embryo': skip_embryo})

def __calinski_harabaz_score(self, skip_embryo=True):

graph = self._graph

nodes = graph.nodes

extra_disp, intra_disp = 0., 0.

# CHI = [B / (c - 1)]/[W / (n - c)]

# Total numb er of neurons.

#ns = nx.get_node_attributes(self._graph, 'n_type')

c = len([v for v in nodes.values() if v['n_type'] == 1]) if skip_embryo else len(nodes)

# Total number of data.

n = len(self._data)

# Mean of the all data.

mean = np.mean(self._data, axis=1)

pos = nx.get_node_attributes(self._graph, 'pos')

for node, k in pos.items():

if skip_embryo and nodes[node]['n_type'] == 0:

# Skip embryo neurons.

continue

mean_k = np.mean(k)

extra_disp += len(k) * np.sum((mean_k - mean) ** 2)

intra_disp += np.sum((k - mean_k) ** 2)

return (1. if intra_disp == 0. else

extra_disp * (n - c) /

(intra_disp * (c - 1.)))

def _determine_closest_vertice(self, curnode, skip_embryo=True):

"""Where this curnode is actually the x,y index of the data we want to analyze."""

pos = nx.get_node_attributes(self._graph, 'pos')

nodes = self._graph.nodes

distance = sys.maxint

for node, position in pos.items():

if skip_embryo and nodes[node]['n_type'] == 0:

# Skip embryo neurons.

continue

dist = euclidean(curnode, position)

if dist < distance:

distance = dist

return node, distance

def __get_specific_nodes(self, n_type):

return [n for n, p in nx.get_node_attributes(self._graph, 'n_type').items() if p == n_type]

def __igng(self, cur_node):

"""Main IGNG training subroutine"""

# find nearest unit and second nearest unit

winner1, winner2 = self._determine_2closest_vertices(cur_node)

graph = self._graph

nodes = graph.nodes

d = self._d

# Second list element is a distance.

if winner1 is None or winner1[1] >= d:

# 0 - is an embryo type.

graph.add_node(self._count, pos=cur_node, n_type=0, age=0)

winner_node1 = self._count

self._count += 1

return

else:

winner_node1 = winner1[0]

# Second list element is a distance.

if winner2 is None or winner2[1] >= d:

# 0 - is an embryo type.

graph.add_node(self._count, pos=cur_node, n_type=0, age=0)

winner_node2 = self._count

self._count += 1

graph.add_edge(winner_node1, winner_node2, age=0)

return

else:

winner_node2 = winner2[0]

# Increment the age of all edges, emanating from the winner.

for e in graph.edges(winner_node1, data=True):

e[2]['age'] += 1

w_node = nodes[winner_node1]

# Move the winner node towards current node.

w_node['pos'] += self._eps_b * (cur_node - w_node['pos'])

neighbors = nx.all_neighbors(graph, winner_node1)

a_mature = self._a_mature

for n in neighbors:

c_node = nodes[n]

# Move all direct neighbors of the winner.

c_node['pos'] += self._eps_n * (cur_node - c_node['pos'])

# Increment the age of all direct neighbors of the winner.

c_node['age'] += 1

if c_node['n_type'] == 0 and c_node['age'] >= a_mature:

# Now, it's a mature neuron.

c_node['n_type'] = 1

# Create connection with age == 0 between two winners.

graph.add_edge(winner_node1, winner_node2, age=0)

max_age = self._max_age

# If there are ages more than maximum allowed age, remove them.

age_of_edges = nx.get_edge_attributes(graph, 'age')

for edge, age in iteritems(age_of_edges):

if age >= max_age:

graph.remove_edge(edge[0], edge[1])

# If it causes isolated vertix, remove that vertex as well.

#graph.remove_nodes_from(nx.isolates(graph))

for node, v in nodes.items():

if v['n_type'] == 0:

# Skip embryo neurons.

continue

if not graph.neighbors(node):

graph.remove_node(node)

def _save_img(self, fignum, training_step):

"""."""

title='Incremental Growing Neural Gas for the network anomalies detection'

if self._surface_graph is not None:

text = OrderedDict([

('Image', fignum),

('Training step', training_step),

('Time', '{} s'.format(round(time.time() - self._start_time, 2))),

('Clusters count', self.number_of_clusters()),

('Neurons', len(self._graph)),

(' Mature', len(self.__get_specific_nodes(1))),

(' Embryo', len(self.__get_specific_nodes(0))),

('Connections', len(self._graph.edges)),

('Data records', len(self._data))

])

draw_graph3d(self._surface_graph, fignum, title=title)

graph = self._graph

if len(graph) > 0:

#graph_pos = nx.get_node_attributes(graph, 'pos')

#nodes = sorted(self.get_specific_nodes(1))

#dots = np.array([graph_pos[v] for v in nodes], dtype='float64')

#edges = np.array([e for e in graph.edges(nodes) if e[0] in nodes and e[1] in nodes])

#draw_dots3d(dots, edges, fignum, clear=False, node_color=(1, 0, 0))

draw_graph3d(graph, fignum, clear=False, node_color=(1, 0, 0), title=title,

text=text)

mlab.savefig("{0}/{1}.png".format(self._output_images_dir, str(fignum)))

#mlab.close(fignum)

class GNG(NeuralGas):

"""Growing Neural Gas multidimensional implementation"""

def __init__(self, data, surface_graph=None, eps_b=0.05, eps_n=0.0006, max_age=15,

lambda_=20, alpha=0.5, d=0.005, max_nodes=1000,

output_images_dir='images'):

"""."""

NeuralGas.__init__(self, data, surface_graph, output_images_dir)

self._eps_b = eps_b

self._eps_n = eps_n

self._max_age = max_age

self._lambda = lambda_

self._alpha = alpha

self._d = d

self._max_nodes = max_nodes

self._fignum = 0