В этой статье мы хотим рассказать о новом этапе эволюции SSD — очередном повышении уровня записи данных в NAND: о четырехуровневых ячейках, хранящих по 4 бита, или QLC (Quad-Level Cell). Накопители, сделанные по этой технологии имеют большую плотность записи, это упрощает увеличение их объема, а стоимость оказывается меньше, чем у SSD с «традиционными» ячейками MLC и TLC.

Как и следовало ожидать, в процессе разработки потребовалось решить множество задач, связанных с переходом на новую технологию. Компании-гиганты успешно с ними справляются, а небольшие китайские фирмы ещё отстают, их накопители менее технологичны, но дешевле.

Как это происходило, появился ли новый «убийца HDD» и надо ли бежать в магазины, меняя все HDD и SSD прошлых поколений на новые — расскажем ниже.

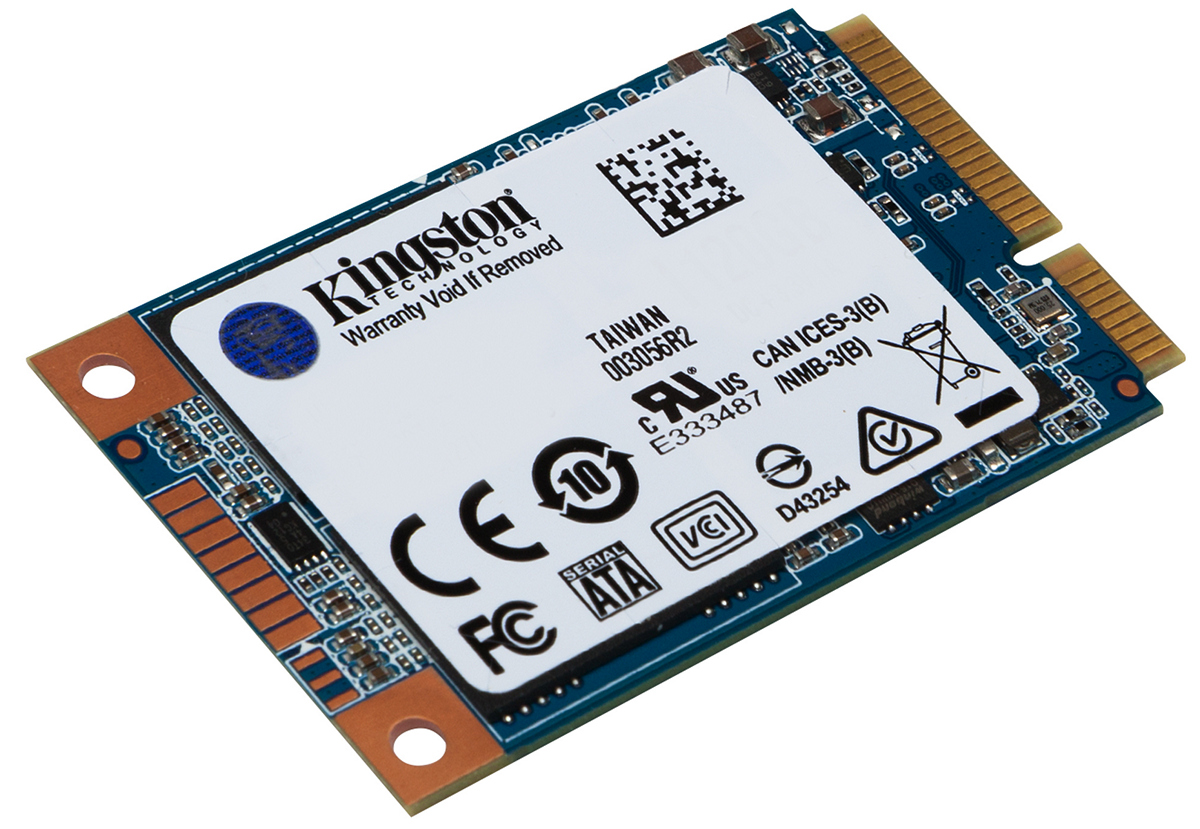

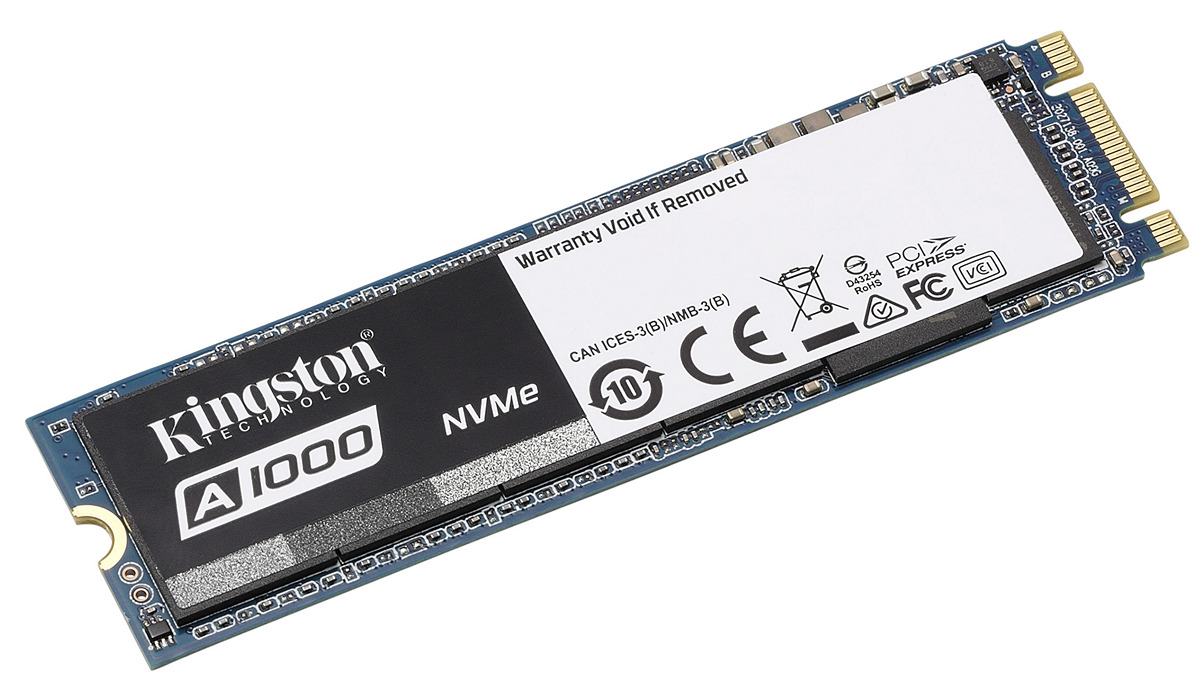

В процессе эволюции накопителей менялся способ хранения информации, техпроцесс становился всё более тонким, увеличивалась плотность записи как в единичную ячейку, так и на чип. В контроллерах совершенствовались алгоритмы, скорость записи приближалась к скорости чтения, а затем они стали быстро расти. Сегодня равномерность распределения обращений к ячейкам памяти NAND достигла некоего оптимума, надежность хранения информации многократно выросла и почти сравнялась с этим показателем у традиционных HDD. В процессе стремительного развития технологий, SSD стали выпускаться в самых разных форм-факторах.

Сейчас на рынке представлен огромный выбор накопителей от самых разных компаний, как первого эшелона А-брендов, так и от китайских фирм, которые постарались, чтобы SSD хватило на всех

Что нам предлагает технология QLC?

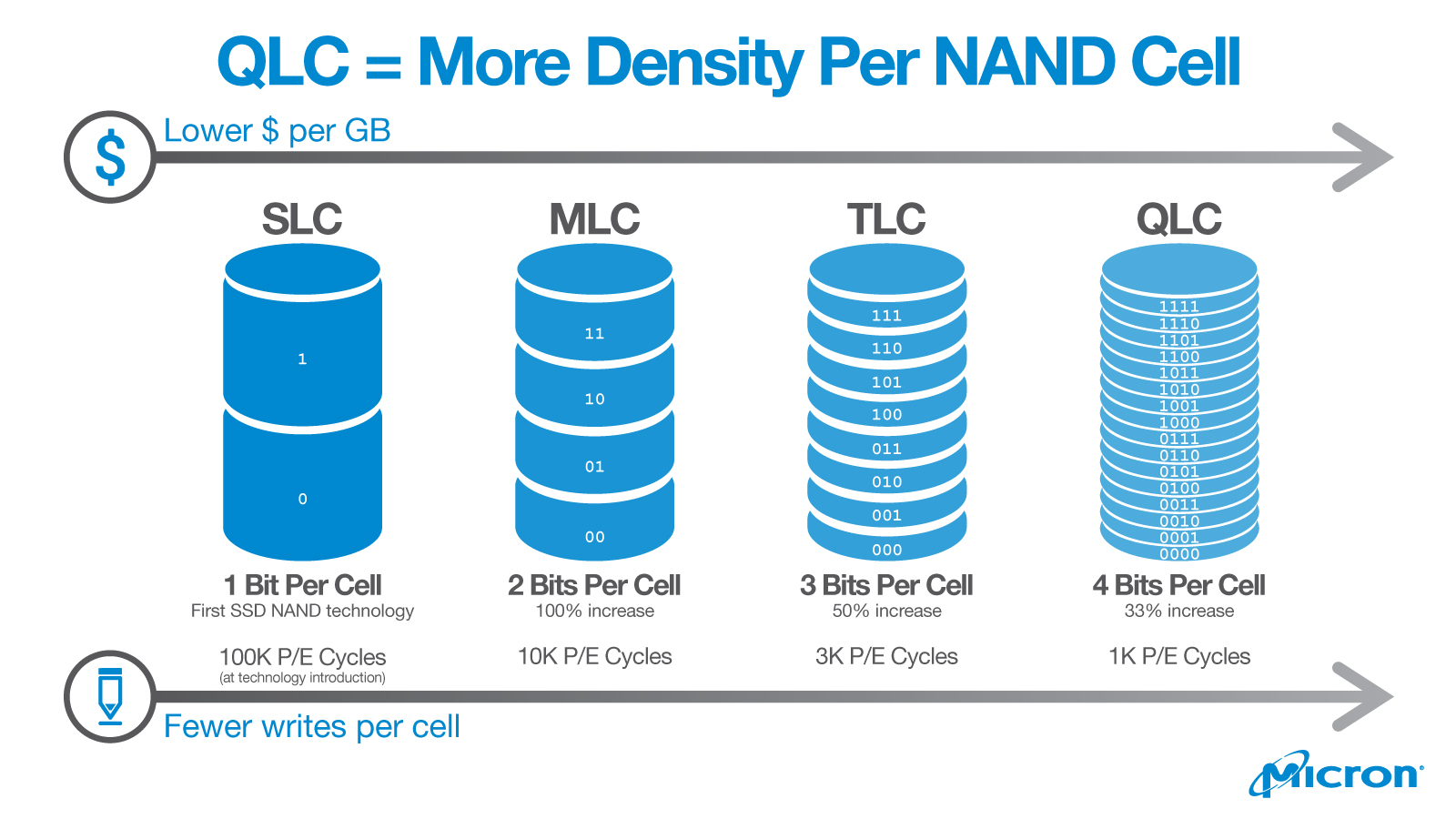

Количество битов, записанных в одной ячейке NAND, определяется тем, сколько уровней заряда находится в транзисторе с плавающим затвором. Чем их больше, тем больше битов может хранить один транзистор. В этом и заключается главное отличие технологии QLC от «предыдущей» TLC — количество битов в одной ячейке выросло с трёх до четырёх.

С увеличением количества уровней заряда очень сильно меняются характеристики накопителя: падает скорость доступа, уменьшается надежность хранения информации, но при этом возрастает ёмкость, а соотношение цена/объем становится привлекательнее для покупателей. Соответственно, чипы, построенные по технологии QLC, дешевле, чем предыдущее поколение TLC, в которых хранится по три бита в одной ячейке. В то же время QLC менее надежны, потому что вероятность выхода ячейки из строя существенно увеличивается с каждым новым уровнем.

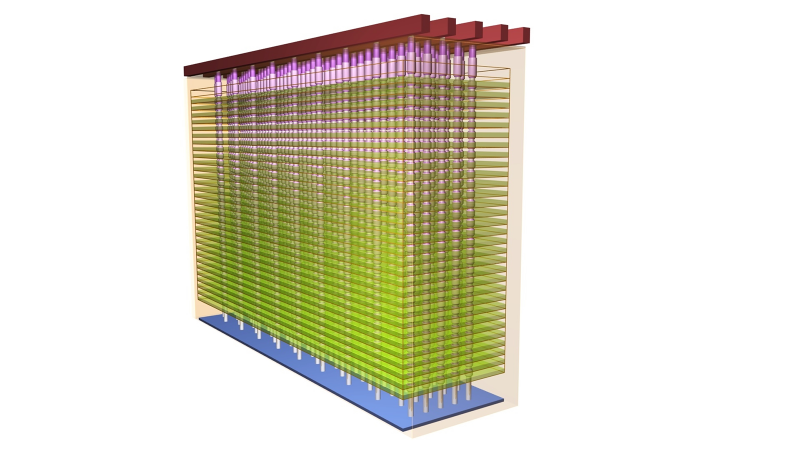

В дополнение к сложностям одной отдельно взятой ячейки, возникают другие. Вследствие того, что чипы памяти делаются по технологии 3D NAND, они представляют собой трехмерные массивы ячеек, плотно упакованных один над другим, и ячейки в соседних «этажах» взаимно влияют друг на друга, портя жизнь своим соседям. К тому же современные чипы содержат больше слоев, чем изделия предыдущих поколений. Например, одна из технологий повышения плотности памяти подразумевает увеличение количества слоёв в кристалле с 48 до 64. В рамках другой технологии производится «спайка» двух 48-слойных кристаллов, доводя общее количество до 96, что налагает очень высокие требования к совмещению границ в этом «бутерброде», становится больше точек отказа и растёт доля брака. Несмотря на сложность процесса, такая технология получается выгоднее, чем пытаться наращивать слои в одном кристалле, потому что отбраковка при увеличении числа слоев растет нелинейно, и невысокий выход пригодных чипов обошелся бы слишком дорого. Справедливости ради надо заметить, что только компании высшего эшелона могут позволить себе такие разработки. Некоторые китайские фирмы, производящие чипы, так и не перешли на 64-слойные кристаллы, а технологией «склеивания» двух 48-слойных кристаллов пока обладают только такие гиганты электроники, как Intel и Micron.

3D NAND

Еще одна новинка, используемая в накопителях нового поколения А-брендов — перенос управляющей и питающей обвязки под массив ячеек. Благодаря этому уменьшилась площадь кристаллов и стало возможно размещать по четыре банка памяти там, где раньше помещалось только два. А это, в свою очередь, позволило распараллелить запросы и увеличить скорость работы с памятью. Кроме того, меньшая площадь кристаллов позволила увеличить емкость накопителей.

Возросшая плотность ячеек помогает бороться и с более быстрой деградацией памяти. С этой задачей разобрались «в лоб», с помощью еще большей избыточности массива ячеек.

Прототипы QLC-чипов показали прошлым летом, а первые обещания о выпуске SSD по новой технологии прозвучали в начале этого года. Летом практически все фирмы производящие накопители, сообщили о том, что они уже готовы к массовому выпуску, озвучили названия новых моделей, их цены и характеристики. Сейчас уже можно приобрести SSD с QLC-чипами. Большинство моделей выпускается в форм-факторе M.2 и 2.5", с емкостями 512 гигабайт, 1 и 2 терабайта.

Позиционирование QLC-накопителей

Для начала стоит честно признать, что накопители, созданные по новой технологии QLC, категорически не годятся для серьёзных/критических задач. И причиной тому целый ряд технических трудностей, которые приходится решать инженерам как крупных корпораций-изобретателей, так и китайских «последователей».

К примеру, на сайте Intel новые SSD предлагаются только в сегменте для домашних компьютеров среднего уровня. Особенно оправдано их применение в малопроизводительных нетбуках, в чьи задачи не входят игры или работа с базами данных, а стоимость, наоборот, очень важна. Подобные «печатные машинки» становятся всё более востребованы. Для работы в сегменте «энтерпрайз» предлагаются исключительно накопители с чипами MLC и TLC.

Если сравнивать характеристики брендовых SSD (дешёвые китайские рассматривать нет смысла, недорогие контроллеры убивают все характеристики), то средняя цена QLC-накопителей примерно на 20-30 % ниже MLC, при одинаковом форм-факторе и объёме.

Скорость доступа. Для модели с чипами QLC она составляет: на чтение до 1500 Мб/сек, на запись до 1000 Мб/сек. Для модели на чипах TLC — 3210 Мб/сек и 1625 Мб/сек соответственно. Скорость записи у QLC-накопителя в полтора раза ниже, а чтения — в два. Разница существенная, но для серфинга в инете и редактирования текстов — более чем достаточная.

TBW (Total Bytes Written). Критичный параметр, характеризующий ресурс SSD. Он говорит о том, какое максимальной количество терабайтов можно записать на накопитель. Чем TBW выше, тем более живучий диск и тем дольше он сможет проработать без сбоев. У всех моделей серии 760p ресурс составляет 288 TBW, а у 660p — всего 100 TBW. Практически трехкратная разница.

DWPD (Drive Writes Per Day). Этот показатель надёжности говорит о том, сколько раз в день можно перезаписать весь накопитель целиком, и рассчитывается по формуле:

DWPD = TBW / 0,512 * 365 * 5где 0,512 — объем накопителя в терабайтах;

365 — количество дней в году;

5 — количество лет гарантии.

DWPD более объективен, потому что при расчете учитывается время, в течение которого производитель обязуется бесплатно решать проблемы с накопителем. Для QLC-модели DWPD равен 0,1, а для TLC-моделей — 0,32. Другими словами, в данном примере каждый день QLC может полностью перезаписывать 50 Гб — это его штатный режим работы. Учитывая, что при той же цене ёмкость QLC-накопителей выше MLC, то средний пользователь «печатной машинки с интернетом» вряд ли успеет выработать этот ресурс.

Эти два устройства — яркий пример того, как инженерам приходится решать множество технических сложностей, которые в QLC проявились ярче, чем в TLC. В частности, у QLC ниже скорость доступа на запись и чтение, ниже ресурс, выше коэффициент WAF (подробнее о нём — ниже). Давайте рассмотрим подробнее основные трудности и методы их решения.

Скорость доступа

Начнём с одной из наиболее заметных для пользователя особенностей QLC SSD — снижения скорости записи при заполнении кэша накопителя. Поскольку скорость доступа у QLC и так сравнительно невысокая, то производители стараются увеличить её с помощью кэширования. В SSD для этого используется собственный массив ячеек диска, которые переводятся в однобитный режим работы — SLC.

Существует несколько алгоритмов кэширования. Зачастую под кэш выделяется небольшая часть ёмкости самого накопителя — в среднем, от 2 до 16 Гб, в некоторых моделях может быть до нескольких десятков гигабайтов. Недостаток метода в том, что если при работе компьютера идет интенсивный обмен данными, то небольшой объем кэша может быстро заполнится и скорость чтения/записи резко упадет.

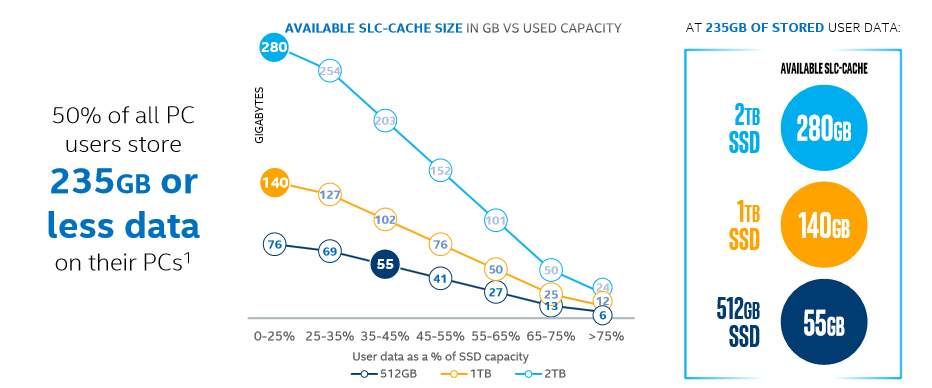

Более технологичные компании используют продвинутые контроллеры, которые умеют динамически переводить часть ячеек в быстрый режим SLC, в этом случае объем кэша зависит от общего объема накопителя и может достигать 10 %. В современных SSD используются оба метода: сравнительно небольшое количество статического кэша дополняется динамически выделяемым объемом, который получается в разы больше. Чем больше свободного места, тем больше размер кэша и тем сложнее исчерпать его объем. Логично, что более объемный накопитель имеет кэш большего размера, а значит в нем динамический кэш будет работать эффективнее.

Наглядная зависимость размера SLC-кэша от объема накопителя и свободного места на нем.

Ошибки чтения

Усложнение архитектуры QLC по сравнению с TLC привело и к росту количества ошибок чтения данных. Для их исправления потребовалось внедрить принудительное использование алгоритмов ECC (Error correction code, коды коррекции ошибок). С их помощью контроллер самостоятельно исправляет почти все ошибки чтения данных. И разработка эффективных алгоритмов коррекции — одна из сложнейших задач при создании QLC-накопителей, поскольку требуется не только обеспечить высокую эффективность коррекции (выражается в количестве исправленных битов на 1 Кб данных), но и как можно меньше обращаться к ячейкам памяти, чтобы экономить их ресурс. Для этого производители внедряют более производительные контроллеры, но главное — задействуют мощные научно-статистические аппараты для создания и совершенствования алгоритмов.

Ресурс

Особенности архитектуры QLC не только снижают надёжность, но и приводит к явлению «усиления записи» (Write amplification, WA). Хотя корректнее было бы говорить «умножение записи», однако вариант «усиление» пока что больше распространён в Рунете.

В чём суть WA? В SSD физически с ячейками выполняется гораздо больше операций чтения/записи, чем требуется для того объёма данных, непосредственно принятого от операционной системы. В отличие от традиционных HDD, у которых очень небольшой «квант» перезаписываемых данных, данные на SSD хранятся довольно большими «страницами», обычно по 4 КБ каждая. Также есть понятие «блок» — минимальное количество страниц, которые могут быть перезаписаны. Обычно блок содержит от 128 до 512 страниц.

Например, цикл перезаписи в SSD состоит из нескольких операций:

- переместить страницы из стираемого блока в место временного хранения,

- очистить место занимаемое блоком,

- переписать временный блок, добавив новые страницы,

- записать обновленный блок на старое место,

- очистить место, используемое для временного хранения.

Как видите, при этой операции происходит многократное чтение и стирание сравнительно больших объемов данных в нескольких разных областях накопителя, даже если операционная система хочет изменить всего несколько байтов. Это серьезно повышает износ ячеек. Кроме того, «лишние» операции чтения/записи заметно снижают пропускную способность флеш-памяти.

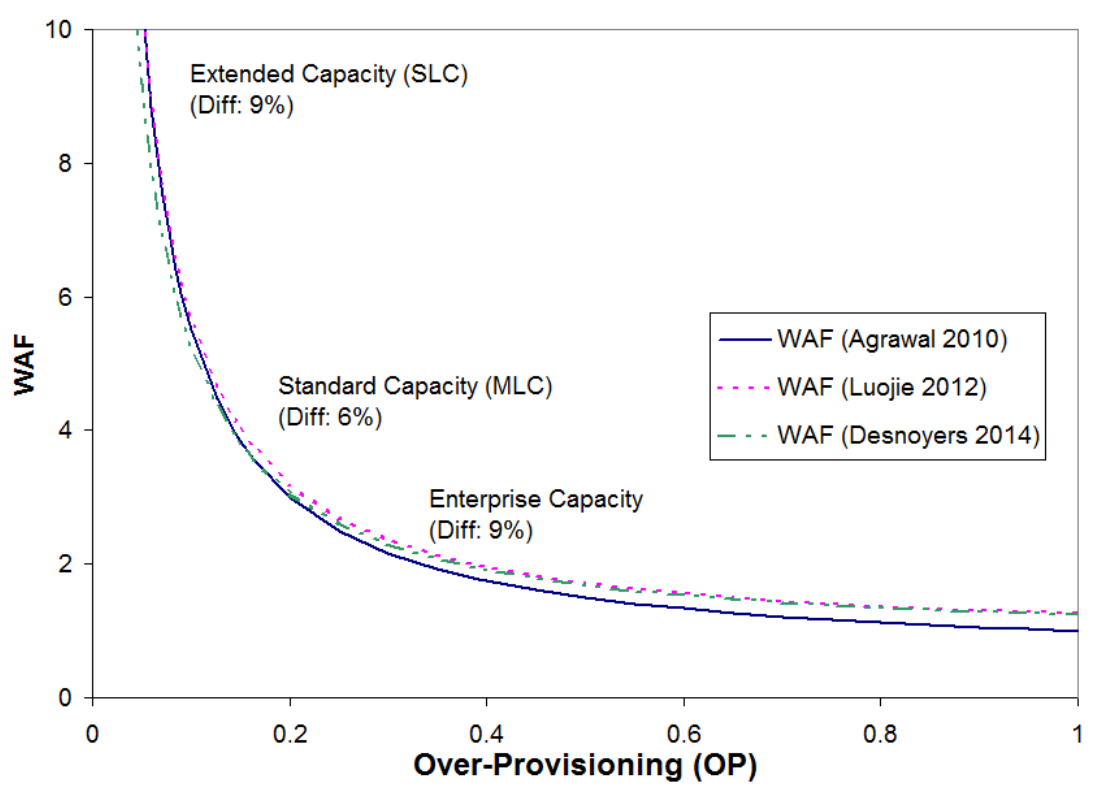

Степень «усиления записи» выражается коэффициентом WAF (Write amplification factor): отношение фактически перезаписываемого объёма данных к объёму, который требуется перезаписать. В идеале, когда не используется компрессия, WAF равен 1. Реальные же значения очень сильно зависят от разных факторов, например, от размера перезаписываемых блоков и алгоритмов используемых в контроллерах.

А поскольку ячейки QLC гораздо чувствительнее к количеству циклов перезаписи, то размер WAF стал намного важнее, чем для TLC и MLC.

Какие ещё факторы негативно влияют на WAF в QLC-накопителях?

- Алгоритм «сборки мусора», который ищет неравномерно заполненные блоки, которые одновременно содержат пустые и заполненные страницы, перезаписывая их таким образом, чтобы блоки содержали только пустые или только заполненные страницы, что, в дальнейшем, уменьшает количество операций, приводящих к WA.

- Wear leveling (Равномерное распределение нагрузки). Блоки, к которым система обращается часто, регулярно перемещаются в ячейки вместо блоков, которые менее востребованы. Это сделано для того, чтобы в накопителе все ячейки памяти изнашивались равномерно. Но в результате общий ресурс накопителя постепенно снижается, даже если вы используете его как архивное хранилище.

Вот пример «усиления записи» из-за работы механизмов wear leveling и сборки мусора:

- Также на величину WAF влияет работа механизма коррекции ошибок (ECC). Как уже говорилось, снизить его вклад в «умножение записи» можно с помощью совершенствования алгоритмов, в том числе LDPC.

- При достаточном количестве свободного места на SSD, некоторые контроллеры могут переводить часть ячеек NAND в режим с меньшим количеством уровней записи: из QLC в SLC. Это очень существенно ускоряет работу накопителя и повышает его надежность. Но, при уменьшении свободного места, ячейки снова будут перезаписываться в режиме с максимальным количеством уровней. Чем больше свободного места на SSD, тем быстрее и эффективнее он будет работать, при условии, что его контроллер достаточно продвинутый и поддерживает эту функцию. Если часть самых активно используемых ячеек держать в режиме SLC, это повышает общий WAF, но снижает износ.

С ростом WAF в QLC борются различными методами.

Например, с помощью over-provisioning (OP) — выделяя для служебных нужд часть объёма, который не доступен пользователю.

OP = (физическая ёмкость — доступная пользователю ёмкость) / доступная пользователю ёмкостьЧем больше выделяемая область, тем больше свободы у контроллера и быстрее работа его алгоритмов. Например, раньше под OP выделяли разницу между «реальным» и «маркетинговым» гигабайтом, то есть между 109 = 1 000 000 000 байтов и 230 = 1 073 741 824 байтов и, что равняется 7,37 % от общего объёма накопителя. Есть и ряд других ухищрений для выделения служебного пространства. Например современные контроллеры позволяют динамически задействовать под OP весь текущий свободный объём накопителя.

Примерная зависимость WAF от размера OP:

Позволяет снизить WAF и алгоритм разделения статических и динамических данных (Separating static and dynamic data). Контроллер вычисляет, какие данные перезаписываются часто, а какие преимущественно читаются, или вообще не изменяются, и соответствующим образом группирует блоки данных на диске.

К прочим инструментам уменьшения WAF в QLC-накопителях относятся методики последовательной записи (очень примерно это можно сравнить с привычной нам дефрагментацией HDD). Алгоритм определяет блоки, которые могут принадлежать одному большому файлу и не требуют обработки сборщиком мусора. Если операционная система даст команду на удаление или изменение этого файла, то его блоки будут стираться или перезаписываться целиком, не включаясь в цикл WA, что повышает скорость и меньше изнашивает ячейки памяти. Наконец, свой вклад в борьбу с WA вносит компрессия данных перед записью и дедупликация.

Как вы уже поняли, надёжность и ресурс QLC-накопителей зависит далеко не только от используемых чипов памяти, но и от производительности контроллера, а главное — от продвинутости всевозможных алгоритмов, заложенных в контроллер. Многие компании, даже крупные, покупают контроллеры у других фирм, специализирующихся на их выпуске. Небольшие китайские фирмы пользуются недорогими и простыми контроллерами прошлых поколений, руководствуясь не качеством и новизной алгоритмов, а ценой. Крупные компании не экономят на железе для своих SSD и выбирают контроллеры, обеспечивающие накопителю долгую жизнь и бо?льшую скорость работы. Лидеры среди производителей контроллеров для SSD постоянно меняются. А ведь кроме сложных контроллеров огромную роль играют и алгоритмы прошивок, которые крупные производители разрабатывают самостоятельно, не доверяя это важное дело сторонним компаниям.

Выводы

Главное преимущество QLC перед накопителями на TLC- и MLC-чипах заключается в том, что в тот же физический объём удалось поместить ещё больше памяти. Так что QLC не вытеснят с рынка предыдущие технологии, и уж тем более не станут конкурентами для HDD.

Разница между QLC и TLC по скорости будет заметна при запуске тяжелых программ и при интенсивном обмене данными. Но обычный пользователь этого может не заметить, потому что в компьютерах того уровня, для которых рекомендуются QLC-накопители, программа дольше ожидает действий пользователя, чем работает с данными.

Можно смело сказать, что ниша недорогих накопителей для компьютеров небольшой производительности, когда не имеет смысла переплачивать за повышенную надежность или максимальные скорости записи и чтения, успешно занята. В таких компьютерах QLC SSD может быть единственным накопителем, на котором будут установлены система и необходимые программы, а также храниться данные пользователя. А в энтерпрайзе — революции не произошло, здесь по прежнему пока будут отдавать предпочтение более надёжным TLC и медленным, но неприхотливым HDD.

Однако технологии не стоят на месте, уже в этом году производители обещают начать переход на техпроцесс в 7 нм, а в перспективе, в 2021 году и позже — грядут техпроцессы 5 и 3 нм. Совершенствуются алгоритмы контроллеров, некоторые фирмы обещают «умные» SSD-накопители, которые будут в несколько раз быстрее, при некоторых специфичных сценариях использования, планируется развитие технологий 3D NAND.

Так что, подождем пару лет и посмотрим, что ещё смогут нам предложить производители.

Для получения дополнительной информации о продукции Kingston обращайтесь на официальный сайт компании.

Комментарии (103)

KYuri

08.02.2019 18:53Учитывая, что при той же цене ёмкость QLC-накопителей выше MLC, то средний пользователь «печатной машинки с интернетом» вряд ли успеет выработать этот ресурс.

Заявление одновременно неверное и с точки зрения логики (чтобы сделать заявление о том, хватит ли среднему пользователю ресурса QLC-накопителя, нужно как минимум привести данные о том, какой процент ресурса TLC-накопителя успевает выработать этот самый средний пользователь), и по смыслу.

Простая прикидка: предполагаем, что «неизменность цены» = «неизменность количества ячеек». Тогда рост объема при сохранении цены составит 33% (раньше ячейка хранила 3 бита, стала — 4). Однако надёжность упала на 300% (DWPD был 0.32, а стал 0.1). Таким образом, если на условный 100ГБ TLC-диск «средний пользователь» мог писать 32ГБ/день, то на QLC-диск той же цены (133ГБ) сможет писать 13.3ГБ, т.е. в два с лишним раза меньше.

Однако и предположение «неизменность цены» = «неизменность количества ячеек» неверное.

Цена накопителя складывается не только из ячеек памяти, но ещё из стоимости разработки (QLC — более «продвинутая» технология, и разработки для неё, вероятно, будут более дорогими), стоимости платы/контроллера/корпуса/работ по сборке (примем, что на это всё цена не меняется). Поэтому реальный рост объема накопителя «за ту же цену» будет не 33%, а меньше (и чем меньше объём накопителя, тем меньший «дополнительный объем за ту же цену» будет получен)

А ещё у ячеек есть такой параметр, как «время удержания данных», который при переходе от TLC к QLC должен снизиться.

Совершенно непонятно, кому нужна новая технология, если про неё писать не маркетинговый булшит вроде этой статьи, а факты («вы можете получить накопитель большОго объема по меньшей цене, чем раньше, но он будет гораздо менее ненадёжным», и «накопитель маленького объема будет гораздо менее ненадёжным, и стоить он будет лишь незначительно меньше»)

Cenzo

09.02.2019 00:55-1Только небольшой хинт, 3->4 бита это не 33%. 2^3 == 8 а 2^4==16.

Так что на выходе +50% объёма.

picul

08.02.2019 19:07Забавляет позиционирование новых дисков для недорогих печатных машинок. На недорогой печатной машинке никогда не понадобится 512Gb и больше свободного места, 256 хватит за глаза. А если уж совсем честно, то и 128 для текстов вполне достаточно. Так что как раз для этого сектора лучше взять 128-256Gb TLC, и сэкономить >=50% по сравнению с минимальным QLC диском.

Victor_koly

08.02.2019 20:13Если у Вас минимальный набор софта — Вам много на диске C: не нужно будет, скажем на 64 ГБ берите. Вот скажем удивился сейчас — мой любимый Office 2007 в объеме W + E + PP весит на диске 264 МБ. Последние 6 обнов за этот год не поставил права ещё (4 из них от 10 апреля, поддержка потом закончилась?).

А если у Вас Фотошоп из сетапа весом 1.63 ГБ — он займет не очень много? Может у Вы программист, и у Вас IDE + что-то для тестирования (локальный веб-сервер + сервер приложений)?

Ну а самый тяжелый случай — у Вас на компе HDD, т.к. нужно протестить софт на виртуалках — Win (7+8.1+10)*2 разрядности. Ещё скажем Вы прогаете на .Net и нужно иметь самые свежие обновы в каждой из систем.

edogs

08.02.2019 20:2664гб мало, вычтите из них резервную область, место для апдейтов с 1903 версии виндов, файл свопа и гибернации и у Вас останется дай бог 10гб, что как бы вообще ни о чем. Так что надо брать 128гб, тем более они не сильно дороже.

А вот макс. размер это дело сугубо индивидуальное. Нам пришлось взять 750гб + 1тб, ибо базы данных много занимают, бакапы проектов и прочее.

Victor_koly

08.02.2019 21:14-1Если я прочитал фразу про «1000 циклов» — я гибернацию при SSD не включу, так как не привык покупать новый винт каждые 2-3 года.

место для апдейтов с 1903 версии виндов

Я понял, что MS создало какой-то бред. Будь у меня лишний комп — поставил бы скачанную 1809_Oct_Russian_x64 на скромный тестовый хард на 50 миллиардов байт и оценил бы, как быстро она забьется при настройках:

— защита системы (такое ещё есть в 10ке?) — 9% раздела;

— pagefile 4 ГБ — если Вы смогли установить Винду 10 на 1.5-2 ГБ оперативки, Вам без подкачки будет сложно жить даже на «условно рассчитанной под гаджеты» операционке.

Брат поставил на новый ноут 2016 LTSB, качает только секурные обновы.

edogs

08.02.2019 22:06+2Если я прочитал фразу про «1000 циклов» — я гибернацию при SSD не включу, так как не привык покупать новый винт каждые 2-3 года.

Гибернация даже 3 раза в день съест у Вас 24гб от объема диска (условно) за 3 года. Вряд ли именно гибернация будет самой большой проблемой, что-то еще все же будет на компе делаться?:)

поставил бы скачанную 1809_Oct_Russian_x64 на скромный тестовый хард на 50 миллиардов байт

У нас свежая 10-ка со всеми апдейтами и минимумом софта (пара браузеров, скайп, far, ssh, еще по мелочи — не больше 500мб) занимает 52гб (после установки новой системы обычно делаем бакап) — это вместе с гибернацией и т.д., но без резервации места под апдейты и свободного метса на ссд — с ними были бы все 64гб.

p.s.: Вообще конечно дичь с ресурсом ssd происходит. Мы брали как-то 320 ssd intel еще когда он только вышел (больше 5 лет точно), не так давно продали его — там еще 99% ресурса было. А диск использовался в хвост и гриву — и торренты и свапы и гибернация и базы данных нагруженные. А последний взяли tlc (mlc хотели, но их уже не было в продаже), так блин меньше чем за год уже 89% осталось, при чем эксплуатируем менее жестко.

С другой стороны учитывая как растут размеры ссд — следующий апгрейд у нас будет скорее всего через годик, старый можно будет продать, у него еще 3 года гарантии останется, так что скорее всего надо просто принять текущую ситуацию.

Victor_koly

08.02.2019 23:06занимает 52гб

А ведь когда-то Win 10 (только это x32 у меня на виртуалках Винда) весила 10 ГБ, могу глянуть объем образов виртуалок для точности.

edogs

08.02.2019 23:34+1Посмотрели из чего состоит (win 10 home SL 64 bit).

25.4gb — windows.

8.3gb — Programm Files

4.4gb — в корне диска, гибернация и прочее.

4.4gb — Programm Data

4.2gb — Programm Files (x86)

3.8gb — Users (из них около 1гб кэши файрфокса, хрома и т.д.).

3.1gb — Recovery

2.8gb — eSupport (файлы дров производителя ноута, на ноуте без них никак).

WinDirStat по факту показывает 56.7gb

Можно выкинуть рековери, почистить изначальные файлы драйверов, сжать диск (винда обещает +13гб), убрать своп и гибернацию — но это уже не айс. Да и придется добавить на резервную область для апдейтов и для ссд. Так что 64гб не вариант вообще.

p.s.: первый раз не все файлы подсчитали, отредактировали.

sumanai

09.02.2019 16:23У меня х64 10 весила, в редакции с долговременной поддержкой. Нынешняя 1809 LTSC 11гб скушала.

DarkWood

09.02.2019 20:33Увидев цифру в 52 ГБ, полез посмотреть свою «несколько неофициальную» версию. Собственно: Win 10 Pro 1809, After Effects, Audition, Bridge, Illustrator, Media Encoder, Photoshop, Premiere, Affinity Designer, Corel Draw, Libre Office, Opera, Vivaldi, пак стандартных игр из семерки, ещё какая-то мелочь; файл подкачки и гибернация отключены — вот это всё занимает 43 ГБ. Из них папка Windows — 11,8 ГБ.

На более официальной семерке (образ MSDN) дела обстояли хуже. Тот же набор оставлял свободными всего около 5 ГБ от 64-гигабайтного SSD.

Massacre

08.02.2019 23:26Жесть. Win7 x64 с набором софта занимает не более 10гб (правда, часть браузеров с кэшами — на другом разделе).

Victor_koly

08.02.2019 23:52Win7 x64 с набором софта занимает не более 10гб

Ну не знаю. У меня 1 папка winsxs весит 13.7 ГБ («на диске», 13.5 инфы).

Наверное это фейковые ГБ, но там кажется в «чистой» Винде папка Win весит 20 ГБ (конечно это сборка, так что не очень чистая).

А потом все растет. \SoftwareDistribution\DataStore висит спец-файл 1 с каплей ГБ.

Про явно «полезный» объем:

System32 — 4.51 ГБ;

SysWOW64 — 1.42 ГБ.

Вспомнил, что нужно чистить.

C:\Windows\Installer — куча сетапов через неё ставятся и не удаляют потом:) Сейчас там 3.33 ГБ.

Massacre

09.02.2019 00:46winsxs у меня 7.6гб. Там действительно в основном хард линки, т.е. дополнительного места не занимает.

Да, там В DataStore файл занимает 16мб. Но я не пользуюсь автоматическими обновлениями — думаю, это именно из-за них.

В Windows\Installer вполне можно удалить все большие файлы, там некоторый софт зачем-то размещает свои полные установщики (у меня там сейчас 49мб).

System32/SysWOW64: 3.9/1.3гб, ну тут разница небольшая. Там ещё в System32\DriverStore\FileRepository хранятся предыдущие версии драйверов, если обновлялись (например, видео) — тоже можно почистить (предпочтительней через pnputil).

Victor_koly

09.02.2019 01:17У меня сейчас на GF 710M драйвер скажем стоит предложенный самим WinUp-te — 376.54. Вероятно — самый новый, который лично протестили Майки под этот Fermi.

nidalee

09.02.2019 14:21+1Вспомнил, что нужно чистить.

Только специальным софтом, а то потом замучаетесь с сообщениями «вставьте установочный диск чтобы продолжить» при удалении или обновлении софта. MSI-установщики — дело гиблое.

C:\Windows\Installer

0xd34df00d

09.02.2019 04:12Сорри, что я тут со своим невиндоусом, но это реально жесть.

% df -h / Файловая система Размер Использовано Дост Использовано% Cмонтировано в /dev/sda2 59G 22G 35G 38% /

На этом разделе всё, кроме

/home, включая инструменты для разработки, CUDA, интеловские тулзы и даже копию дерева исходников clang и llvm.

Massacre

09.02.2019 04:32Так у юзера выше по любому десяток ГБ Windows — кэш апдейтов 10ки и инсталляторов, и ещё ~10гб под аналогом /home (users+programdata) + windows\winsxs ещё накручивает объём, содержа в основном hard links.

Ну и софт в Program Files ставится в основном сторонний, к системе не относящийся, это ещё ~12гб у него…

Victor_koly

09.02.2019 16:27Ну и софт в Program Files ставится в основном сторонний

Из всех прог только для Офиса кажется не сразу нашел, что можно выбрать и не ставить в C:\Program Files (x86).

Почему-то Мозила стала в C:\Program Files. По дефолту Хром себя пихает в C:\Program Files (x86)\Google\Chrome — лень было качать сборки, которые дают выбрать место установки. О ужас — там папка весит 427 МБ.

Нужно почистить файл Application\71.0.3578.98\Installer\chrome.7z весом 212 МБ.

mspain

09.02.2019 19:13>Сорри, что я тут со своим невиндоусом, но это реально жесть.

>Использовано 22G

У тебя тоже жесть :) Linux с Windowmaker или XFCE занимает пару гигабайт. Причём все драйверы, браузеры, шмофисы уже внутри. Это особенно смешно. 15 лет назад надо было железо тщательно выбирать, чтобы оно работало в linux. Сейчас всё из коробки взлетает, а узеры вантуза должны тщательно выбирать. Плюс при установке изрядно поприседать.

0xd34df00d

09.02.2019 20:11Запустил filelight. Самое интересное:

/opt/cuda— 2.9 гигабайта.

/opt/intel— 1.8 гигабайта (там amplxe и ещё ерунда по мелочи).

/opt/clion— 0.8 гига.

/usr/lib64/ghc*— 0.8 гига. Хаскелятина тяжёлая.

/usr/portage/distfiles— 1.6 гига. Там те самые clang и llvm.

/usr/src— 1.7 гига. Недавние скомпилированные ядра.

/usr/local— 0.8 гига. Один мой опенсорс-проект, который я пилю.

gwathedhel

09.02.2019 11:06У нас образ, который раскатывается на компы — вин10 и основной софт (офис, антивирус и по мелочи) около 35гб. Как у вас 50 набирается?

edogs

09.02.2019 14:14Чуть выше писали в деталях habr.com/en/company/kingston_technology/blog/439568/#comment_19732982

Если 35гб из образа достать — будет побольше уже, плюс рековери 3гб + родные дрова 3гб + временные файлы 1гб + хибернация и своп 5гб = вот уже 47гб наберется. Если это ноут и не хочется заморочек, то отказываться от рекавери и родных дров не вариант, а своп и хибернация на рабочей винде сами материализуются.

gwathedhel

09.02.2019 14:18+1Черт с ними с гибернацией и свопом. Но дрова то вам чем не угодили? Или вам нужно, чтобы они кучкой лежали обязательно рядом? Так же, как и бестолковый рекавери раздел.

Я привет пример образа, в котором уже включены точки восстановления, в котором уже есть дрова для нескольких моделей ноутбуков. Этот образ раскатывается на многие типы компьютеров, которые потом себя прекрасно чувствуют. И весит уже после раскатки все равно <40гб.

Victor_koly

09.02.2019 19:00Запишите дрова на диск D:, главное — чтобы объем образа влез на тот винт, на который записывать будете.

Но так как в любом случае Вы ставите образ конкретной разрядности (скажем на 6 ГБ ОП ставите x64) — и установщики дров ставьте под ту разрядность, что будет ОС. Более полезная для универсальности штука — сетап «усредненных» дров видяхи (скажем условно стабильные nVidia 376.54 пойдут без проблем даже на 730M, но на ноут 1050M может не станет ни ОС, ни дрова эти). Каталист — тоже какой-то «усредненный» сетап.

После установки скажем дров видяхи может даже «Центр обновлений» найдет более новые — именно подходящие под конкретную модель.

edogs

09.02.2019 21:06Но дрова то вам чем не угодили? Или вам нужно, чтобы они кучкой лежали обязательно рядом? Так же, как и бестолковый рекавери раздел.

Так мы со своей колокольни обычного юзерского ноута, на котором в случае факапа и рековери пригодится и дрова родные лишними не будут и одновременно с этим не хочется тратить время на спец сборку для экономии места.

Наверное, нас сейчас сожгут, но так-то по современным меркам не видим разницы +-10гб, что бы из-за нее как-то специально напрягаться. Взять 128гб вместо 64гб и закрыть тем самым все вопросы с нехваткой места невелика проблема.

p.s.: Энтерпрайз это несколько другое, к тому же нам в принципе не вполне понятно на кой черт в энтерпрайзе сейчас 10-ка, 7-ка еще пару лет вполне может пожить.

gwathedhel

09.02.2019 21:13-1Так и я не вижу беды в лишних гигабайтах, мне просто непонятно было нафига это все хранить. Дрова качаются с сайта (а в идеале самой виндой), мы в 2019 или как?

А про 7ку не надо петь песни — поддержка уже почти все, да и кто видел как 10ка воспринимает перенос с одного железа на другое, совсем отличное — тот семёрку уже не поставит никогда. Ну и ещё куча всего, особенно в энтерпрайзе.

edogs

09.02.2019 21:29+1Так и я не вижу беды в лишних гигабайтах, мне просто непонятно было нафига это все хранить

Потому что это не проблема вот вообще, настолько, что мы заметили хранение этого, только во время обсуждения в этом топике, когда пошли смотреть куда место уходит, хотя ноуту уже год скоро будет:)

Дрова качаются с сайта (а в идеале самой виндой), мы в 2019 или как?

Что бы их скачать надо сначала (из своего опыта на своем ноуте) а) поставить винду, для чего нужен оригинальный драйвер юсб и тачпада б) выйти в эти ваши интернеты. для чего нужен драйвер вай-фай карты в) если ставишь на м.2 диск (основной мсата), то нужен еще родной драйвер чипсета, иначе bsod при попытке загрузиться постоянный.

И ни один из этих 4 драйверов с дефолтовой флэшки с просто виндой не будет работать (добро пожаловать в 2019 ***), зато из рекавери все на раз-два ставится.

Что характерно (как уже выше подметили кстати) убунта заводится без проблем с дефолтного инсталлятора, хотя драйвер вайфай и приходится потом заменять для поддержки 5ггц, но это единственная проблема. Правда убунта адски жрет батарею, 1.5 часа максимум в режиме экономии против 4.5 часов на винде не особо напрягаясь.

gwathedhel

09.02.2019 21:32Жесть… Это какой ноут, если не секрет, таких танцев требует от владельца с вин10? У нас hp пробуки, пара моделей вайо и фуджиков — такого даже близко нет.

edogs

09.02.2019 21:55Да не особо жесть. Родная же винда без проблем, рековери тоже без проблем. А если какой-то извращенец хочет накатить винду непременно из пробирки, то ССЗБ:)

Ноут asus n705un, как по нам — эта линейка асусов (начиная с появления в ней kaby lake-r) не просто шикарна, а безальтернативна, пусть и есть там пара нюансов.

Victor_koly

09.02.2019 21:26+17-ка проживет на десктопах поколения Skylake и ниже (про мои проблемы ноутов на поколение ниже уже писал) — пока дрова на видяхи не перестанут выходить, а старые дрова не перестанут поддерживать новые видяхи (что может случится сразу, то есть «зеленые» или «красные» введут новую фичу и скажем все видяхи с поддержкой только DX10-11).

Совсем плохо будет, если у Вас видяха старее, чем поколение R-n 5870/G-e 480. На 10ке дрова к ним ещё нормально работают?

Про организации с чипсетом G31/945 вместо видеокарты я говорить не буду. Хотя узнал, что и на них 10ка ставится.

DistortNeo

09.02.2019 11:45На самом деле гибернация, торренты, файл подкачки имеют несущественное потребление ресурса. Всё дело в том, что данные там, как правило, пишутся большими непрерывными блоками, из-за чего практически не происходит Write Amplification.

А вот постоянный фоновый срач операционной системы и сервисов (логи, журналы), несмотря на малый объём данных, из-за высокого коэффицента Write Amplification приводят к большему расходу ресурса, чем вё вышеописанное.

У меня был момент, когда я разворачивал тяжёлые виртуалки (правда, сами виртуальные диски были на HDD) — своп на 16 гигов на SSD использовался почти полностью. Так вот скорость износа диска (количество записанных данных с учётом WA) выросла только в 1.5 раза по сравнению с обычным режимом работы без свопа и виртуалок.

Mad__Max

10.02.2019 04:58По-моему опыту при нормальном объеме оперативки (при малом — на 1м месте будет своп, но при достаточном на него совсем мало приходится) из хододового/общеупотребимого софта больше всего «гадят» браузеры типа Хрома и особенно ФФ своими кэшами, куками и постоянно обновляемыми базами состояний (у них свои встроенные мини СУБД) — при активной работе в интернете от них на диск постоянно льются десятки тысяч мелких записываемых/перезаписыемых файлов ежедневно.

Хотя гибернация при большой объеме памяти тоже приличный вклад дает. Запись-то линейная и WA почти не дает, но все-равно это сразу по 8-16 ГБ записанных данных при каждом уходе компьютера в спячку даже при идеальном WA=1.

edogs

10.02.2019 05:15+1На самом деле не обязательно 8-16гб, файл гибернации нередко оказывается меньше оперативки. То что в виндах 10 оперативка все время 100% занята, так там достаточно много кэша. У нас обычно 3-4гб гибернация, при 8гб оперативы.

DistortNeo

10.02.2019 10:54Жалко не столько ресурс, сколько место на диске. К тому же гибернацией можно просто не пользоваться. Зачем она нужна, когда есть простой Sleep?

edogs

10.02.2019 13:41Гибернация нужна когда это ноут и надолго уходишь от розетки. В спящем режиме батарейка все же поджирается.

Кстати 10-ка по умолчанию с какой-то версии использует Hybrid Shutdown при выключении, что почти аналогично гибернации.

DistortNeo

10.02.2019 13:55Да, поджирается, но очень медленно. Например, мой ноут в спящем режиме живёт около недели. А потом просыпается от низкого уровня заряда батареи и делает shut down.

edogs

10.02.2019 15:29Это Вам кажется медленным потому что Вы далеко от розетки не уходите. Пара суток в спящем режиме, на 10% ноут уже пытается отключаться, изначально был на 90% заряжен и вот уже у ноута 50% зарядки, а розетки рядом нет и Вы на нервах. И ради чего? Могли бы выключить или в гибернацию и не париться.

Victor_koly

10.02.2019 15:42Условный i3-6006U без дискретки протянет достаточно долго.

И конечно после «просыпания» (на 5-10%) ноут должен делать процесс сохранения в hiberfil.sys.

Если у Вас SSD — можете рискнуть и использовать такую функцию только при сильном разряде батареи, а в прочих случаях юзать «Сон» или «Завершение работы».

edogs

10.02.2019 15:55Нам так кажется что это второй виток паранойи по поводу ресурса ссд. То интернет пестрел инструкциями по переносу своп файла с ссд и т.д., потом подуспокоились, т.к. ни у кого с ссд ничего не случилось. Теперь блин хибернатофобия продвигается в массы. Да не случится ничего с ссд от нескольких лишних гибернаций, а запас батарейки 10-20% в ноуте может выручить.

Victor_koly

10.02.2019 16:47Я именно говорю, что гибернации нужны только «лишние». На 10% батареи пускай делает, а так — нет.

pagefile мы себе перенесли на винт и оставили минимальные 2 ГБ (в основном рассчитывали, что для x86 процессов, которые не более 2 ГБ оперативки смогут потратить, а вот page хоть 4095 МБ может быть).

DistortNeo

10.02.2019 17:10А зачем pagefile переносить на винт? Если его размещать на SSD, то производительность системы станет существенно выше при забитой памяти. Это как раз тот случай, когда не стоит жалеть ресурс SSD — ведь SSD покупают ради ускорения системы.

Другое дело — гибернация. Система резервирует под неё кучу места, которое не используется в процессе работы и лежит мёртвым грузом.

DistortNeo

10.02.2019 17:07Дело не в ресурсе SSD, а тупо в количестве места, которое этот hiberfil.sys занимает на диске. Я ещё 7 лет назад воткнул в ноут 16 гигов памяти и небольшой SSD, и мириться с потерей 16 гигов на системном разделе ради этого файла я не планировал.

Да не случится ничего с ссд от нескольких лишних гибернаций, а запас батарейки 10-20% в ноуте может выручить.

Вообще, всё это индивидуально. Например, у меня зарядка всегда с собой. Если нет розетки — беру ещё повербанк, который даёт ещё около 2-3 часов работы ноутбука. Сценарий, когда ноутбук несколько суток может оказаться без возможности зарядки, вообще считаю невозможным.

Плюс после засыпания ноутбук просыпается мгновенно, а из гибернации выходит примерно полминуты, ибо legacy BIOS, а не UEFI.

edogs

10.02.2019 17:14Я ещё 7 лет назад воткнул в ноут 16 гигов памяти и небольшой SSD, и мириться с потерей 16 гигов на системном разделе ради этого файла я не планировал.

Ну за 7 летний то ссд можно наверное и на более большой поменять, не? Там же небось еще сата-2 вообще.

DistortNeo

10.02.2019 19:03А зачем, если всё нормально работает?

Там же небось еще сата-2 вообще.

Ну да, а какое это имеет значение?

edogs

10.02.2019 22:23А зачем, если всё нормально работает? Ну да, а какое это имеет значение?

Речь о том, что в топике обсуждается свежие qlc. Со скоростью под 1000мб и объемами под 1000гб. А Вы аргументируете «16гб места не хватает» в диске на протоколе который больше 300мб в принципе выжать не может.

Т.е. мы в принципе с Вами согласны — работает не трогай, но в контексте топика вроде не очень в тему.

Начиная с Windows 8.

Taciturn да, сорри, имели ввиду автозагрузку программ.

CactusKnight

09.02.2019 14:24У супргуги есть виндовый планшет с клавиатурой и диском (точнее, еММС) аж на 32 гб. Несколько месяцев назад ставил Win10 с нуля (через стандартное мс-ное ПО для этого дела) — свежеустановленная ОС заняла около 14 Гб

picul

09.02.2019 04:50BTW, а откуда инфа про 1000 циклов? ЕМНИП вроде ~1000 циклов было у TLC.

Mad__Max

09.02.2019 11:181000 циклов, а потом и того хуже (500, а самой дешевой/некачественной 300...) было у простой «плоской» (планарной) TLC изготовленный по самым «тонким» техпроцессам.

Потом производители стали переходить на 3х мерную многослойную флэш-память (типа V-NAND и аналогов), заодно откатились на использование более «грубых» тех. процессов и более крупными элементами (зато расположенными в много слоев). Заодно внедрили продвинутые коды коррекции ошибок (позволяющие работать на более «убитых» ячейках без потерь пользовательской информации). Все эти 3 изменения позволяют увеличить ресурс/надежность.

В результате ресурс подобной TLC подпрыгнул где-то до 3-15 тыс. циклов в зависимости от разновидности памяти и производителя.

Правда после этого в погоне за плотностью и удешевлением стали наращивать количество слоев(32-48-64-96) и снова мигрировать на более тонкие/плотные тех. процессы и ресурс стал опять постепенно снижаться.

QLC по-моему все изначально только в 3D делают. Без него был бы совсем мрак с надежностью — что-нибудь в районе 100 циклов.

picul

08.02.2019 21:02Если мне нужен Фотошоп и 6 виртуалок, то мне печатной машинки не хватит — придется покупать машину выше среднего, в такой ситуации переплата за более надежный SSD будет мизером по сравнению со стоимостью остальных компонентов.

Victor_koly

08.02.2019 21:32Это да. У меня i5-4670, 8 ГБ ОП часто не хватало даже на банальную комбинацию Windows Server (2008/12 R2 — отводил тогда кажется скромно — 1.5 или 2 ГБ) + «машинка в домене» (7/10 — для 7ки давал 2 ГБ, но ту виртуалку уже лишил диска — было именно 2 оси) + «смотрю в Хроме Ютуб про эту область сис. админства».

Ещё 1 раз случайно разместил диск Virtual Box (именно этого условного DHCP/DNS/DC на Win 2008) на самой SSD, а как поменять конфиг и перенести диск только недавно освоил.

Кто-то проверял такую идею, что работа связки виртуалок «Клиент + сервер» реально ускоряется при переносе образа диска (ну и всего конфига) сервера на SSD (но без переноса клиента)?

P.S. Конечно обычно фотошоп и виртуалки не нужны на 1 машине. Если ты кроме «тестировщика ПО/Веб» стал заодно дизайнером своего сайта — юзайте PS или хотя бы Paint.NET.

noanswer

10.02.2019 11:50я знаю несколько человек, кто использует свой комп как печатную машинку, годами… и имеют терабайты текстов у себя на компе…

тексты это же не только plaintext, а документы с форматированием (ворд и подобные ему), иногда с картинками, а так-же пдфки…

так-же те ко серьезно работает с текстами в той или иной форме хранят версии, это или отдельные файлики, или теневое копирование винды.

mrigi

08.02.2019 19:21-1Старые SSD не жили вообще, хоть и хранили меньше данных на ячейку. Значит дело не только в этом. Тот же самсунговый v-nand был вообще как глоток свежего воздуха, повысив и плотность и надежность. Так что всё будет хорошо.

inkvizitor68sl

08.02.2019 19:25OCZ Vertex первого поколения жив и поныне (тьфу-тьфу). Ubuntu, noatime, nodiratime, а так всё стандартно.

Смотря что с ними делать, даже 10 тысяч циклов — это очень много, не все диски столько переживали по механическим причинам.

ShadowMaster

08.02.2019 20:04Старые SSD прекрасно живут и проживут еще 50-100 лет, судя по остаточному ресурсу. А учитывая что закладывался этот ресурс весьма пессимистично, то реальной жизни там еще несколько сот лет. Другое дело, что скорость у них по нынешним временам не очень и при замене на новые прирост производительности видно.

Быстро дохли поделки на SandForce, а также продукция OCZ, у которой одно время возврат достигал 20 процентов.

Alexsandr_SE

08.02.2019 21:53+4Ничего. Производители выпустили QLS и со скоростью у старых дисков теперь полный порядок.

Victor_koly

08.02.2019 19:23Для начала стоит честно признать, что накопители, созданные по новой технологии QLC, категорически не годятся для серьёзных/критических задач.

1000 циклов говорите? Тогда наверное сначала спрошу, есть ли на такой технологии малого объема накопители, скажем no-name 60 ГБ?

Если Вы на такой диск поставите Win 8.1-10, она много лет протянет? Конечно без всяких «Точек восстановления» и для pagefile купить хард на 1 ТБ хотя бы.

vconst

08.02.2019 19:38+1Если и есть, то очень китайские. То есть, чипы там qlc, а контроллер старый — то есть ssd с ним быстро деградирует и умрёт. Уязвимые чипы требуют хорошего контроллера.

Alexsandr_SE

08.02.2019 21:59Вопрос не совсем правильный. В реальной машине никто не будет отключать точки отката и файл подкачки. Так же на бюджетку не будут покупать и SSD+HDD. Скорее уже только HDD (можно больше ОЗУ докупить_.

Вот и интересно сколько протянет QLS именно как чистый, системный.

Victor_koly

08.02.2019 23:38В реальной машине никто не будет отключать точки отката и файл подкачки. Так же на бюджетку не будут покупать и SSD+HDD.

Так по Вашему на реальной казенной машине админ купит сотруднику не SSD, а HDD на 1 ТБ. Условно — самый дешевый Тошиба на 1 ТБ у нас стоит 1136 грн. Пускай я куплю SSD на 240 ГБ за 956 грн. На «разницу» в 180 денег с каждого компа (N штук) мне нужно будет собрать сервер с портом 1 Гбит/с и установить на нем SMB для общественной работы типа «файлопомойка» на N*760 «фальшивых ГБ».

Правда будут накладные расходы — желательно на каждые 8 компов взять свич типа «8 портов + ап-линк 1 Гбит/с». А так как число N логично стремится к 100 и далее (чисти из бюджета, я не соберу все это на 18к наших денег), то на каждые 80 компов (10 свичей) желательно гнать оптический канал 10 Гбит/с.

Либо же таки не SSD, а винт + 8-12 ГБ ОП:) Главное — запретить юзать гибернацию, т.к. убрать hyber с диска C: — это кажется верный путь к сносу Винды, а про место на диске мы уже обсудили. Либо даем 1/4 объема HDD (того, что 1 ТБ) под Винду + «диск №0».

Alexsandr_SE

09.02.2019 00:17Недавно отключил машину с зеркалом на старых SAS винтах. Скорость порядка 40-60 мегабайт/с там был потолок. И этой машины хватало на 50 человек для документов аж бегом. И вы путаете покупку с созданием всей инфраструктуры и добавление в существующую.

Еще раз. Смысла SSD+HDD для контор практически нет. Или то или другое. Получается SSD должен надежно заменить HDD без отключения и переноса всего что можно на HDD. Бюджетные SSD QLS? В лес. По ним пока очень много вопросов. Даже более продвинутые вылетают бывает из-за памяти или контроллера. А тут технология новая.

Если по вашему, то купить обычный HDD и расшарить по сети для сотрудников калог с документами к котором нужен доступ. Сразу предусмотреть отдельный раздел для бекапа от другого сотрудника, будет такой себе бекап на 1 или и больше копий. Извращаться можно долго. Главное HDD скорее всего будет надежнее QLS во времени. И Если купить SSD+HDD, то сеть не нужна???

Victor_koly

09.02.2019 01:11У меня у самого дома SSD на 240. Технологии не знаю, но куплена около сентября 14 года.

Главное HDD скорее всего будет надежнее QLS во времени.

Я с этим согласен. А про 40-60 МБайт/с винт под шару — значит даем порт 1 Гбит и вполне хватит людям (не будут 50 человек ведь сразу качать/записывать документы?). Главное — найти лишний (не очень загруженный сервер) с местом под винты. И скажем раздел 500 ГБ, 50 человек — каждому даю квоту 10 ГБ на разделе.

Xaliuss

08.02.2019 23:07QLC будет идти от 480 ГБ и выше, так как только при таких объёмах достигается достаточный параллелизм для нормальной скорости работы, и можно выделить SLC кеш для закрытия проблем скорости при повседневных операциях. У TLC 240 ещё делать имеет смысл, а 120 уже крайне редкое явление в новых моделях.

Обычная работа Винды SSD на предел выносливости флеш-памяти не должна, скорее выйдет из строя контролер.

lelik363

08.02.2019 20:58а технологией «склеивания» двух 48-слойных кристаллов пока обладают только такие гиганты электроники, как Intel и Micron

Почему в этом списке производителей 3DNAND отсутствует Toshiba?

Некоторые китайские фирмы, производящие чипы

О ком речь идёт?

arthi7471

08.02.2019 21:34На моем опыте ссд вылетают не от плохой памяти а от галимых контроллеров. И не забывайте что вытянуть данные с ссд та еще затея.

ClearAirTurbulence

09.02.2019 05:02+1Данные надо вытягивать из бэкапов.

А за контроллеры, вместо перевода диска в ридонли уходящие в нирвану, по идее нужно их разработчикам %бесчеловечно_жесткое_наказание% устраивать.

Mad__Max

09.02.2019 11:27+1При детальной проверки эти «сдохшие контроллеры» обычно оказываются вполне живыми. А то что реально сдохло — это блок памяти в котором у контроллера лежала прошивка, таблица трансляции блоков или еще какая служебная информация без которой он не может работать.

DistortNeo

09.02.2019 16:55+1И хорошо, если память просто сдыхает. В моём случае у самого первого SSD просто начали портиться данные без всяких CRC error. Заметить было сложно, т.к. была примерно 1 ошибка на мегабайт данных. И вся эта гадость ещё и в бэкап ушла.

Mad__Max

10.02.2019 04:17Да, тоже с таким уже несколько раз сталкивался. Хотя до такой жести как по ошибке в среднем на 1 МБ не доходило. А вот по несколько штук на 1 ГБ — такое было.

HDD себе такого не позволяли. Либо читается нормально, либо читается медленно из деградировавшего сектора (диск может автоматически десятки попыток чтения подряд делать), но если все-таки прочиталось с -дцатой попытки — то считанные данные будут корректные. Либо если не прочиталось несмотря на все усилия (и повторные попытки и ЕСС коды не помогли) — и тогда ошибка чтения и ты сразу знаешь, что

1 — у тебя проблемы и надо принимать меры

2 — ГДЕ ИМЕННО эти проблемы (какие конкретно данные пострадали)

А с SSD иногда бывает — вроде все прочиталось без особых проблем. А потом — ОПА, а контрольные суммы у некоторых считанный файлов не совпадают или видео на каком-то месте «залипает» или хрюкает (случается при отдельных битых кадрах) или какой-то артефакт на фото появился — один из секторов файла прочитался некорректно.

Раньше (когда-то очень давно) с таким только на бракованных CD-приводах сталкивался, когда они могли молча мусора в содержимое файла вывалить при чтении с поцарапанного/загрязненного/помутневшего диска вместо выдачи ошибки чтения.

Victor_koly

10.02.2019 12:14HDD себе такого не позволяли. Либо читается нормально, либо читается медленно из деградировавшего сектора (диск может автоматически десятки попыток чтения подряд делать), но если все-таки прочиталось с -дцатой попытки — то считанные данные будут корректные.

Была такая ситуация на ноуте. Винда не грузится, в безопасном режиме зависает на каком-то драйвере. Как объяснил чуть более опытный чувак — это значит Винда не дождалась нужного числа попыток чтобы за -дцать раз прочитать. Когда скопировали винт на новый (500 вроде брали, хотя нет — там был 9.5 мм и на 1 ТБ взяли) Винда загрузилась без проблем.

Heian

09.02.2019 00:55+2Естественно, нет. Чем выше плотность — тем выше вероятность отказов и нестабильности работы, поэтому SSD на базе SLC до сих пор самые лучшие. А если вспомнить, что потерянная информация на SSD теряется, как правило, навсегда, то выводы весьма очевидны.

lelik363

09.02.2019 19:20Небольшие китайские фирмы пользуются недорогими и простыми контроллерами прошлых поколений, руководствуясь не качеством и новизной алгоритмов, а ценой. Крупные компании не экономят на железе для своих SSD и выбирают контроллеры, обеспечивающие накопителю долгую жизнь и бо?льшую скорость работы.

Kingston_Technology, можете привести пример?

Mad__Max

10.02.2019 04:05Скорость доступа. Для модели с чипами QLC она составляет: на чтение до 1500 Мб/сек, на запись до 1000 Мб/сек. Для модели на чипах TLC — 3210 Мб/сек и 1625 Мб/сек соответственно.

Это где такие «шикарные» QLC бывают, которые «всего» в ~2 раза медленнее TLC?

Или же это выдача скорости псевдо-SLC кэша под видом скорости работы QLC?

Или же результат для каких-то топовых 4 ТБ моделей, в которых такую скорость можно натянуть огромным количеством параллельно работающих ядер памяти?

Потому как у ходовых 0.5ТБ — 1 ТБ моделей на QLC судя по появившимся тестам/обзорам скорость записи просто мрак — даже на линейной записи всего порядка 100-200 МБ/с. Т.е. на порядок (в 5-10-15 раз) хуже чем у TLC и даже медленнее чем у современных механических HDD!

А так же причина почему <0.5 ТБ моделей нет и большинство производителей выпускать не планирует — слишком уж сложно будет скрывать низкую скорость и надежность самой QLC.

edogs

10.02.2019 04:48Интел www.intel.ru/content/www/ru/ru/products/memory-storage/solid-state-drives/consumer-ssds/660p-series/660p-series-512-gb-m-2-80mm-3d2.html заявляет 1000Мб/сек у 512гб, у 1тб уже 1800.

Терабайтник интела в тестах вполне достойно и на уровне себя показывает.

Правда при цене в 130 баксов за 1тб — не очень понятно зачем qlc, тогда как за те же деньги можно более ресурсоемкий tlc взять или даже на старенький mlc покусится если поискать такие в продаже.

Mad__Max

10.02.2019 05:18Так это как раз «маркетинговая» скорость — указана только скорость работы SLC кэша, который у TLC и QLC дисков не различается и по-идее должен выдавать ~одинаковые результаты. И то что даже при работе в кэше скорость у QLC дисков умудряется оказываться существенно ниже чем у TLC дисков — вообще фейл полный.

А вот когда SLC кэш заканчивается (при большом объеме записи данных или когда на диске мало свободного места остается) и начинает работать собственно QLC память, то не просто медленнее, происходит вообще подобная жесть:

Результаты теста 500-1000 ГБ QLC

После удаления файлов при «расчистке» свободного места тоже жесть — скорость падает так, что становится на порядок хуже даже жестких дисков — это заметно даже без всяких тестов, все начинает тупить и лагать при любом обращении к диску до тех пор пока он не закончит чистку освободившегося места.

Источник — 3dnews.ru/981785/obzor-nvmenakopitelya-intel-ssd-660p-umestna-li-qlcpamyat-v-ssd-dlya-pci-express

iproger

10.02.2019 04:54Нет вроде hdd в потребительском сегменте с чтением/записью выше ~150 мб.

Mad__Max

10.02.2019 05:32Ну если по средней скорости по всему объему диска, выше наверно нет или немного выше, т.к. у механических дисков она довольно сильно меняется от начала диска к концу (от внешних краев к центру в физическом выражении).

Но в начале диска даже «потребительские» 7к модели уже уже за 200 МБ/с шагнули. Даже мой старенький (~5 лет с момента выпуска, ~25 тыс. часов наработки) диск из эконом серии (но на 7200 rpm) на 1м логическом разделе выдает:

Sequential Read: 196.633 MB/s

Sequential Write: 184.630 MB/s

Тогда как у QLC «небольших» объемов линейная скорость вообще ниже 100 МБ/с падает когда идет работа с ней напрямую (а не с кэшем) — см. графики выложил выше.

Victor_koly

10.02.2019 12:201й раздел — это тот, что 100-549 МБ или диск C:? Его (начало жесткого диска) именно помещают в более быструю часть, а за ним уже диск C:?

inkvizitor68sl

Пока на промежутке 512G->1TB и дальше цена не будет расти по экспоненте — ни о какой замене hdd на ssd повсеместной речи идти не будет. Так и будут их ставить бок о бок, один для «программ», второй для данных.

И в серверах тоже всё не так радужно — и там самый ходовой товар пятисотки, а не террабайтники.

springimport

Несколько месяцев назад взял 860 evo 1tb за ~$130 как замену hdd. Потом еще один чтобы уже поставить в raid 0. Чем не замена.

inkvizitor68sl

Meh, 1 TB стоит 30$ там, где вы покупали ево за 130 =) А локально он и вовсе 200 стоит (хотя ssd в целом можно по почте заказывать, а диск не хочется, да).

springimport

Вот самый обычный wd blue за $49.99. Не слышал чтобы появились hdd 1tb 7200 за $30.

inkvizitor68sl

Промахнулся слегка, $40.

Но и Evo сейчас 150 стоит.

edogs

Имхо — корректнее сравнивать не цену хдд с ценой ссд, а цену хдд+небольшой ссд с ценой ссд. Под систему все берут, хотя бы 128гб. Так что разница не 100 баксов, а около 50 пожалуй.

Так же имхо, 1тб это ни рыба ни мясо. Под систему и необходимый софт достаточно 256гб с одной стороны, с другой стороны хранить архив фото и видео за 10 лет да еще игрухи — тут и терабайта не хватит. Поэтому стоит сравнивать 512гб ссд с 128гб ссд + скажем 320гб хдд. От чего разница становится еще меньше.

Прибавим к этому ту уберфичу, о которой редко говорят. Скорость ссд при бакапах. На хдд у нас бакап делался 4-6 часов, на ссд делается 20-40 минут. Бакапы стали делаться чаще и веселее, а это зачастую даже важнее чем скорость работы диска ежеминутно.

В общем и целом на потребительском рынке, если пользователь хоть немного в теме, просто для компьютера он хдд уже не возьмет. Если у него большие объемы фото/фидео — он возьмет отдельный внешний хдд (небольшие влезут и на ссд). Если же речь о том, что компьютер нужен для работы, то там вообще вопроса нет хоть 2 ссд по 1тб воткнуть, это себя окупает.

inkvizitor68sl

> Так и будут их ставить бок о бок, один для «программ», второй для данных.

Тред начался вот с этого )

Само собой, 1ТБ неинтересен, самые ходовые hdd — 2ТБ.

> Поэтому стоит сравнивать 512гб ссд с 128гб ссд + скажем 320гб хдд. От чего разница становится еще меньше.

Ага, или сравнивать 2 ТБ ssd vs 2 ТБ hdd + 128G ssd, тогда разница в другую сторону убегает.

Проблема именно в переломе цен вокруг террабайтных SSD. 512 стоит ~6 тысяч (в среднем), террабайт — ОТ 12 тысяч, а за 2 террабайта просят космические деньги (на российском рынке).

У hdd этого перелома нет, цена гигабайта при росте объёмов наоборот снижается (хотя тренд и ломается где-то в районе 12ТБ на 3.5'').

edogs

Если надо больше, то Вы или профи для которого и 2тб ссд (1+1 для экономии) не проблема купить или же нуждаетесь в файлопомойке (для которой ссд вообще не годятся), но обе эти аудитории не массовая ЦА.

inkvizitor68sl

Вы как-то странно оцениваете потребности современных пользователей в месте на диске.

У меня жена не напрягаясь загадила 2ТБ-hdd за пару лет =)

Ну а вообще в эпоху игр по 200Гб диск на 512 выглядит смешным.

А вот мне по работе как раз хватает ssd на 128 и файлопомойки на 500 в raid1 для бэкапов и фильмов/музыки.

edogs

Это не мэинстрим. И опять же — если 2тб именно «загажено», то вопрос решается чисткой и выносом «мусора» на внешний носитель (хдд разумеется) и на основном компе вряд ли больше 1тб останется.

pikul с самой первой картинки. Там у TLC написано 3к p/e циклов, а у qlc 1к p/e циклов.

DistortNeo

Среди TLC встречаются как экземпляры с заявленными 1к, так и 3к.

inkvizitor68sl

> По рынку ноутбуков, как самых популярных устройств.

Ноутбук редко у кого является единственным устройством хранения — обычно к нему есть десктоп или, хотя бы, внешний hdd.

Так что не совсем показательно.

> выносом «мусора» на внешний носитель

Чем это отличается от парадигмы «ssd под систему/программы + hdd для жирных данных»?

> чисткой

Не, вы точно с обычными пользователями не общаетесь. Они ж реально покупают новый диск, когда старый кончается, потому что так проще.

nidalee

inkvizitor68sl

Выгоднее — 4 ТБ, но покупают — 2 ТБ =)

Victor_koly

GPT/UEFI у всех есть (это в смысле установки Винды на диск 3 ТБ и более)? И никто не пользуется комбинацией 2 идей:

1. Для установки Винды на GPT, ЕМНИП, нужна флешка с FAT32.

2. Кроме rufus есть странная прога, она копирует ISO на диск. То есть тупо лежит файл — в FAT32 ограничение его объема на 4 ГБ.

Если пользоваться, то на флешку гарантированно влезет только образ Win7 (MSDN + SP1) — не сборка со свежими обновами, не 2 разрядности сразу и куча редакций — 3 ГБ файл для x64, влезет на флешку «фальшивые 4 ГБ» даже. Не влезут — 8.1 или 10 (смотрю на примере Win10_1809_Oct_Russian_x64). Может старее версия 10ки влезет.

inkvizitor68sl

GPT здесь не при чём, просто психологический потолок в 5т.р. за диск. Да и не настолько там выгоднее покупать 4Т, честно говоря.

Victor_koly

Кажется нашел способы шаманства:

habr.com/ru/post/240793

Без шаманства выходит такое:

Но есть и метод решения проблемы

Garrett

Чаще всего, но не всегда, сейчас например Seagate Ironwolf:

4TB — €28.50 за ТБ

8TB — €28.24 за ТБ

Firz

www.amazon.com/gp/product/B076MPMZDV — раз в месяц-два на неделю цена становится 100$

Внутри WD Red

Alexsandr_SE

Нет смысла смотреть на 128гб ссд + скажем 320гб хдд. цена ёмкость в таком случае отвратительная. Сейчас 1тб HDD это если прижимает совсем, а так 2Тб тамое то. + под систему 256. 256, что бы кроме системы еще и игру второю поставить можно было. НО свободного места при этом для QLS явно маловато, начнет задыхаться.

Для бекапа, часто ограниченим сеть выступает.