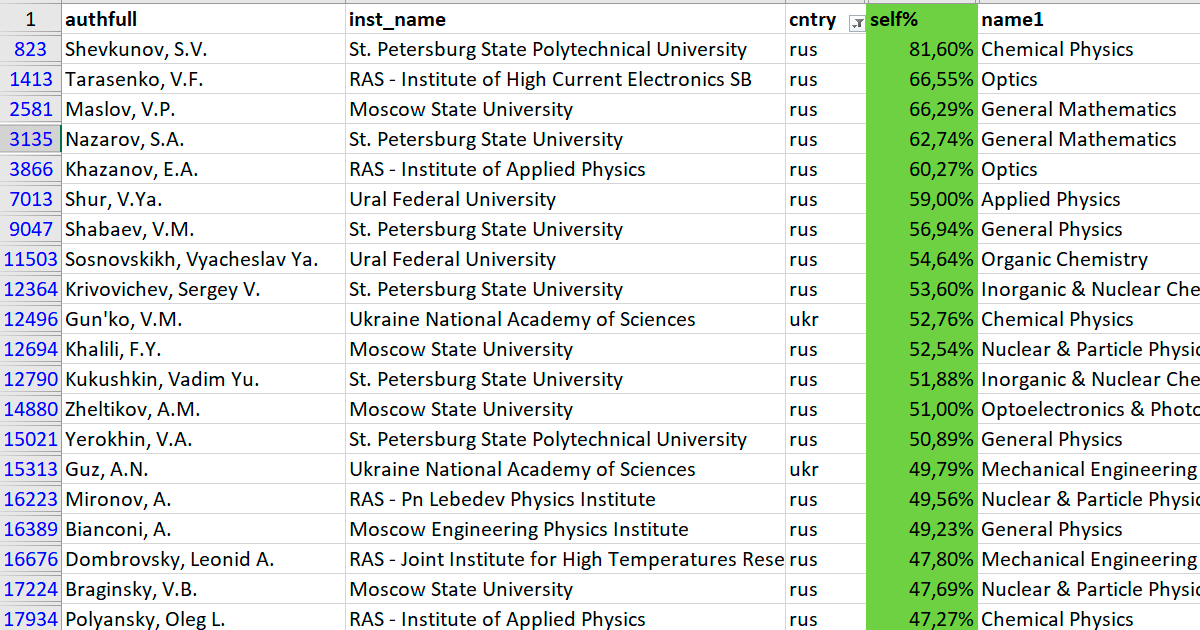

Российские и украинские лидеры в рейтинге самоцитирования

Авторитет в научном сообществе определяется количеством ссылок в научных статьях (индекс цитирования). Самые цитируемые в мире — небольшая группа учёных, в которую входят нобелевские лауреаты и выдающиеся исследователи. Однако к ним примыкает ряд менее известных персонажей. Например, Сундарапандиан Вайдьянатан из Индии.

Этот исследователь в области теории хаоса, декан R&D частного технологического института Vel Tech в Ченнае — соавтор сотен научных работ и абсолютный мировой рекордсмен по саморекламе: 94% (!) ссылок на его научные статьи поставлены им самим или соавторами, пишет Nature.

Он не одинок. Недавно в журнале PLOS Biology опубликован набор данных по 100 тыс. учёным со всего мира. Как показал анализ, у более чем 250 человек доля цитат от себя и соавторов превышает 50%. Средний уровень самоцитирования составляет 12,7%.

Исследование поможет выявить тех, кто злоупотребляет цитированием для повышения рейтинга, а также потенциальные «цитатные фермы», в которых кластеры учёных массово цитируют друг друга, говорят исследователи: «Я думаю, что фермы самоцитирования гораздо более распространены, чем мы полагаем, —считает Джон Иоаннидис (John Ioannidis) из Стэнфордского университета, ведущий автор научной работы. — Те, у кого самоцитирование превышает 25%, не обязательно участвуют в неэтичном поведении, но может потребоваться более тщательное их изучение».

На сегодняшний день это самая большая коллекция показателей самоцитирования из когда-либо опубликованных. И она опубликована как раз вовремя, потому что сейчас финансирующие агентства и научные журналы уделяют больше внимания потенциальным проблемам из-за чрезмерного самоцитирования. В июле Комитет по этике научных публикаций (Committee on Publication Ethics, COPE), консультативный орган для научных издательств, назвал экстремальное самоцитирование одной из основных форм манипуляций.

Хороший показатель цитирования помогает учёному привлечь финансирование и помогает в карьерном росте. Но слишком большое внимание к этой метрике представляет собой проблему, потому что такое отношение стимулирует самоцитирование.

В прошлом году министр образования Индии вручил Вайдьянатану премию в размере 20 000 рупий (280 долларов США) как одному из лучших исследователей страны по показателям производительности и цитируемости. Сам учёный, декан научно-исследовательского центра Vel Tech, в комментариях на Quora отрицал факт умышленной накрутки метрик для себя и своего института.

Многие учёные согласны, что чрезмерное самоцитирование является проблемой, но нет единого мнения, что с этим делать. И вообще, какой показатель самоцитирования считать нормальным. У исследователей действительно много законных оснований ссылаться на собственные работы и работы соавторов. Иоаннидис предупреждает, что его исследование не призвано очернить конкретных исследователей, потому что показатели самоцитирования сильно варьируются между разными научными дисциплинами и этапами карьеры: «Оно просто даёт полную, прозрачную информацию. На его основании нельзя выносить вердикт, кто плохой учёный», — говорит он.

Рейтинг самоцитирования — лишь часть исследования, которое провели Иоаннидис с соавторами. Оно включает в себя множество стандартизированных показателей для 100 000 наиболее цитируемых исследователей за 1996?2017 годы в 176 научных областях. Данные получены из базы Scopus издательского дома Elsevier.

Но метрики самоцитирования — самая интересная часть работы. В принципе, количество ссылок на собственные работы учёного и так можно посмотреть в специализированных базах, таких как Scopus и Web of Science. Но данное исследование позволяет провести более глубокий анализ, сравнивая учёных и выявляя неочевидные схемы, похожие на умышленные манипуляции.

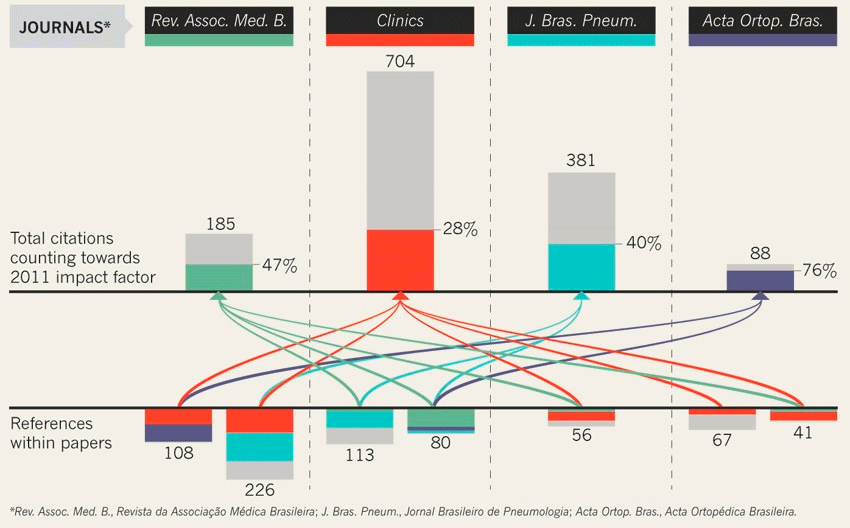

В 2011 году четыре бразильских научных журнала опубликовали семь научных статей с сотнями ссылок на предыдущие исследования (2009-2010 гг) друг у друга. Это повысило рейтинг каждого журнала. Описание «бразильский схемы» см. здесь

Кроме декана индийского частного института, в топ по самоцитированию вошли:

- Теодор Симос (Theodore Simos), математик, на сайте которого указана работа в Университете Короля Сауда (Эр-Рияд, Саудовская Аравия), Уральском федеральном университете (Екатеринбург) и Университете Фракии им. Демокрита (Комотини, Греция) — 76% самоцитат;

- Клаудиу Супуран (Claudiu Supuran), медицинский химик из Университета Флоренции, Италия, который тоже указал принадлежность к Университету Короля Сауда — 62% самоцитат.

Оба учёных в прошлом году вошли в список 6000 «исследователей мирового класса, отобранных за выдающуюся исследовательскую работу»: список составлен американской аналитической компанией Clarivate Analytics, которая ведёт базу Web of Science. Сейчас компания заявила, что знает о проблеме и собирается скорректировать методологию для расчёта.

Проблема самоцитирования изучается давно. В последние годы проведён ряд исследований. Например, в 2016 году выяснилось, что мужчины цитируют собственные статьи, в среднем, на 56% больше, чем женщины. Хотя последующий анализ позволяет предположить, что это может быть следствием более высокого самоцитирования среди продуктивных авторов любого пола, у которых больше прошлых работ для цитирования.

В 2017 году исследование показало, что итальянские учёные стали более активно ссылаться друг на друга после введения в 2010 году спорных правил, которые требуют от учёных соответствовать пороговым показателям производительности, чтобы иметь право на повышение научного звания.

А в прошлом году министерство исследований Индонезии, которое использует формулу на основе цитирования для выделения средств на исследования и стипендии, заявило, что некоторые учёные манипулируют метриками, используя неэтичные методы, включая чрезмерное самоцитирование и цитирование друг друга. Министерство заявило, что прекратило финансирование 15 исследователей и планирует исключить из формулы ссылки на собственные статьи (источники Nature говорят, что этого ещё не произошло).

В 2017 году Джастин Флатт из Цюрихского университета предлагал публиковать индекс самоцитирования учёных (s-индекс), по аналогии со стандартным показателем производительности (h-индекс). Формула такая же: индекс 20 означает, что исследователь опубликовал 20 работ с не менее чем 20 цитатами. Смысл в том, чтобы публиковать эти индексы параллельно для более объективной оценки.

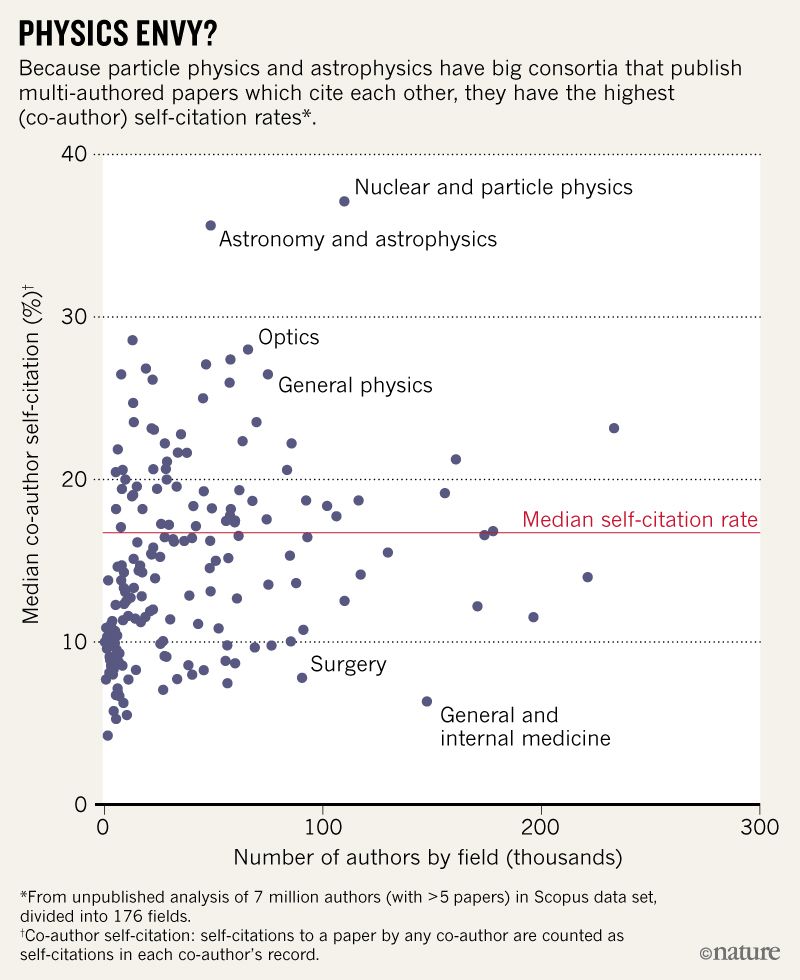

Важно отметить, что в нынешнем исследовании учитываются ссылки не только на собственные работы учёного, но и на работы соавторов, чтобы более эффективно выявлять «цитатные фермы», хотя такой подход и раздувает оценку. Например, в физике элементарных частиц и астрономии часто встречаются статьи с сотнями или даже тысячами соавторов, что сильно повышает средний показатель самоцитирования в конкретной научной дисциплине.

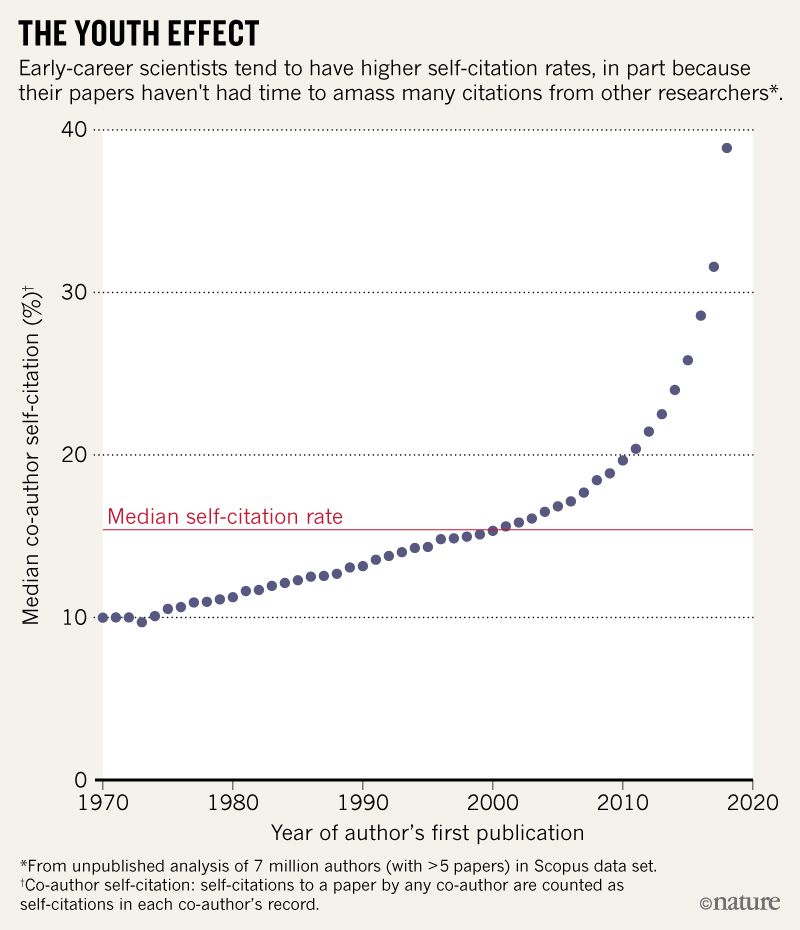

Некоторые перекосы можно объяснить, сравнивая исследователей со средним показателем по стране, по этапу карьеры и дисциплине. Например, на раннем этапе карьеры у исследователей часто повышенный процент самоцитирования: их работы ещё не успели достаточно распространиться, чтобы их заметили коллеги (см. диаграмму ниже).

Так, директор по аналитике издательского дома Elsevier Йерун Баас (Jeroen Baas) провёл похожее исследование (ещё не опубликовано) для 7 млн авторов, то есть для всех, кто опубликовал более пяти работ. Оказалось, что у них показатели самоцитирования выше: 15,5%, а у 7% авторов — более 40%, потому что у многих из этих 7 миллионов исследователей всего только несколько цитат в целом или они находятся в начале своей карьеры.

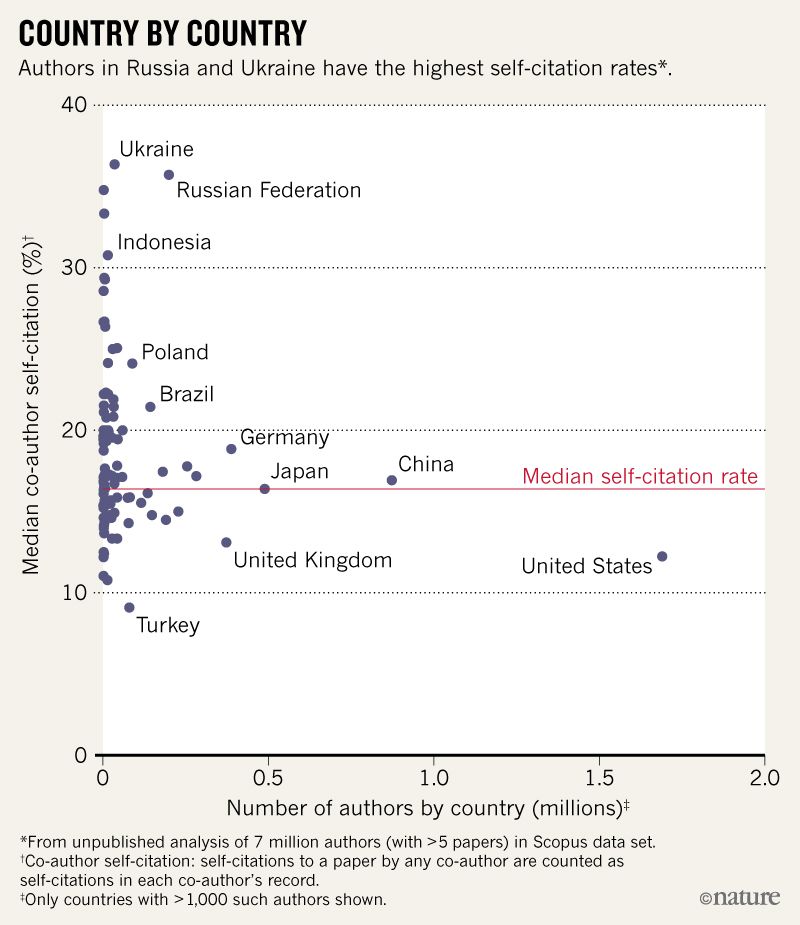

Йерун Баас отметил, что высокими медианными показателями самоцитирования отличаются Россия и Украина (1 и 2 место в мире). На иллюстрации ниже видно, что в этих странах индекс гораздо выше среднего.

По индексу сильно выделяются некоторые научные дисциплины, такие как ядерная физика, физика элементарных частиц, астрономия и астрофизика, благодаря большому количеству соавторов.

Джон Иоаннидис считает, что его работа полезна и вообще необходимо часто проводить такие исследования: «Люди в любом случае сильно полагаются на индивидуальные метрики, — говорит он. — Вопрос в том, как сделать их максимально точными и тщательно, систематически собирать информацию. Показатели цитирования не могут и не должны исчезать. Следует наилучшим образом использовать их, полностью признав многочисленные ограничения».

База данных в формате .xlsx (34,2 МБ) опубликована 6 июля 2019 года в онлайновой версии журнала PLoS Biology (doi:10.17632/btchxktzyw.1).

Комментарии (69)

rboots

21.08.2019 18:25+3Пожалуй, вполне логично, что люди цитируют свои работы. Если раньше человек делал исследование на определённую тему, а потом развил её, то имеет смысл сослаться на то, откуда у исследования корни растут. Другое дело, что не нужно самоцитирование в рейтинге учитывать, не понятно почему это до сих пор не сделали.

DSolodukhin

21.08.2019 18:38+1Индексы цитирования, как и любой другой KPI приводит к тому, что система начинает работать на этот самый KPI.

За публикацию в журнале с определенным импакт-фактором выплачивается премия (зависит от ВУЗа), за высокий индекс Хирша тоже могут выплачивать премии, вот люди и стараются повысить свой KPI.

С самоцитированием тоже не всё так просто, аспиранты цитируют работы своих научных руководителей, и как правило добавляют их в соавторы. Можно устраивать «договорные» цитирования, я цитирую твои работы, ты цитируешь мои. Вариантов, как обойти правила масса.

Проблема, как обычно в системе, ориентированной на количественные показатели. Многое в карьере ученого зависит от количественных оценок, хочешь звание профессора — нужно защитить определенное количество аспирантов и докторантов, написать нужное количество статей и научных пособий за последние пять лет. Хочешь получить грант, то же самое — статьи, аспиранты и пр. Вот и стараются, берут количеством, а не качеством.

Hardcoin

21.08.2019 18:49+1Да, вариантов, как обойти правила — масса. Но не видно ни одной причины, зачем нужно учитывать в рейтинге цитирования ссылки на самого себя.

Захотел — процитировал, но при расчете рейтинга-то зачем учитывать? Выглядит как баг, который просто годами не могут исправить из-за инерции.

pewpew

21.08.2019 20:05+1Так достаточно попросить коллегу Петю. Петя, давай махнёмся, у нас всё равно работы смежные. Я тебя процитирую, ты — меня?

И всё, уже не сам себя цитируешь.

Может быть дело в самом рейтингекармод...цитирования?

Hardcoin

21.08.2019 20:29+1Что бы обмануть рейтинг, да, достаточно. Но это не отвечает на вопрос, зачем в рейтинге засчитывается самоцитирование. Или вы имеете ввиду, что всё равно обманут, какая разница, давайте засчитывать? Так себе причина.

А проблема в рейтинге цитирования очевидна — не используют pagerank. Не самый крутой алгоритм по нынешним меркам, но на голову выше того, что сейчас используется.

pewpew

21.08.2019 20:43Вообще, зачем нужен этот рейтинг? Если дело в публикациях в научных журналах, так сделать бесплатную публикацию в общедоступных изданиях не имея никаких рейтингов. А если журналы ставят условия, то наверное не нужны такие журналы и пора пересмотреть ценность публикаций в них.

Алгоритмы ранжирования есть и по Байесу и по Вильсону. И вообще, об этом регулярно пишут на хабре. Но пока в научном мире никто не договорился ни о каких алгоритмах просто потому что для этого придётся признать факт, что ценность работы определяется «лайками».

Goodkat

21.08.2019 21:35сделать бесплатную публикацию в общедоступных изданиях не имея никаких рейтингов

Кто ж вас неизвестного бесплатно опубликует в журнале? Две-пять тысяч долларов за публикацию извольте заплатить.

pewpew

21.08.2019 21:46-4На хабре бесплатно можно и ценность публикаций регулируется сообществом. Так отчего журналам тек не делать? И печатать не надо.

Goodkat

21.08.2019 22:18+3Ну вот вам и идея для стартапа — сделать бесплатный научный журнал.

Ценность научного журнала — в отборе и рецензировании статей. Оплата за публикацию — это не только и не столько оплата работы редакторов и рецензентов, сколько спам-фильтр.

Для нерецензируемых препринтов есть архив.орг — там все могут публиковаться бесплатно.

striver

21.08.2019 22:19+1Так себе идея. Есть альтернативные академии наук, что уж там какой-то журнал.

koreec

22.08.2019 04:07Ну вот, опять. В мире огромное количество бесплатных журналов. 2-5 тысяч просят за open access, который совсем не обязателен. Индийские журналы, к которых фейковый импакт-фактор, обычно просят на порядок меньше — долларов 200-500 ща публикацию в течение 2 недель.

VIPDC

22.08.2019 04:46Уберем, это подстроятся. Вырастут «фермы» цитирования. Проблема в наличии рейтингов, пока они есть люди найдут лазейку.

Hardcoin

22.08.2019 15:12Логика в стиле "зачем улучшать законы, всё равно найдут лазейку, давайте их отменим".

VIPDC

23.08.2019 08:50Зря вы передергиваете. Не отменим, а не будем усложнять разные вещи.

Усложнение и бюрократизация, делают хуже честным людям и облегчают жизнь тем кто старается обмануть.

В результате тем кто жульничает будет проще защищаться, говоря о том что система модернизирована, а честные просто не будут проходить бюрократический ад.

Например защита диссертации: сейчас нужен пакет из 200-300 документов (у меня было 247 шт.), раньше было 20. Стало ли сейчас меньше проходимцев?

Просто стало дороже для таких людей.

Hardcoin

23.08.2019 12:09Передёргивать стал не я. Это вы сказали "проблема в наличии рейтингов". Рейтинг — это решение проблемы, кому выдать денег на исследования.

Если у вас есть другое, не субъективное, расскажите. Но в любом случае это будет либо рейтинг, либо баллы, либо оценка от других высокооцененных людей, как ещё?

А если рейтинг у нас всё равно есть, то зачем в нём учитывать ссылки на себя? Это разве уменьшает бюрократию?

magiavr

21.08.2019 23:56В этом и зло таких KPI. Так если у сотрудника ДПС зарплата зависит от количества выписанных штрафов, то он будет всячески увеличивать их количество, но вот безопасность дорожного движения никак не улучшиться, что вообще-то и есть их главная функция. Так и с учеными: они будут всячески накручивать свою цитируемость, публиковать откровенную ненужную хрень, но не заниматься непосредственно наукой.

pomponchik

21.08.2019 18:37+3Для меня тоже не очевидно, что мешает игнорировать в рейтингах цитируемости работа самоссылки. Они отсеиваются одной строчкой кода.

Если сейчас кто-то из научного руководства посчитает высокий показатель самоссылок меткой недобросовестного ученого, под удар могут попасть вполне ни в чем не виновные сотрудники. Человек, скажем, может заниматься очень узкой проблематикой и быть таким одним на весь мир, ему просто не на кого будет ссылаться, кроме себя.

naething

21.08.2019 19:50Судя по тексту статьи, под «самоцитированием» понимается не только прямое цитирование своих статей, но и цитирование двумя или более авторами друг друга по кругу для накручивания показателей.

BlackMokona

21.08.2019 19:55Это уже не самоцитирование, а другая проблема. Так сказать фермы рейтинга, или медоносы как их нередко зовут на сайтах с рейтинговой системой. Например мы собёрем 20 человек и начнём приплюсовать все комментарии друг друга, и будем иметь отличный рейтинг на ресурсе.

Goodkat

21.08.2019 21:38+1Ну так это ж элементарно фильтруется — учитывать в рейтинге не более одного плюса от одного человека.

tmin10

22.08.2019 01:04Так будет 20 плюсов от 20 разных людей. И у всех из этих 20 будет повышенный рейтинг.

anton19286

22.08.2019 06:17-1Обычно в любой конкретной фундаментальной области (речь не про ML, конечно) в мире есть только 3-5 научных групп, работающих на прилично уровне. Кого цитировать-то?

nitrosbase

21.08.2019 20:32+1Они отсеиваются одной строчкой кода.

Я вижу небольшую проблему в том, что статьи нынче пишутся авторскими коллективами. Если совсем не учитывать статьи, имеющие хотя бы минимальное пересечение по авторам, то окажется не учтено, как мне кажется, достаточно много добросовестных цитирований.

Во-вторых, если сети цитирований хранятся в БД (а они хранятся), то расчет показателей «на лету» с учетом добавляемого ограничения становится немного более проблематичным.

В других комментариях уже написали про круговые цитирования. Тут, с одной стороны, все не безнадежно: вон, Stack Overflow довольно успешно борется с vote rings. С другой, феномен невидимого колледжа лежит в основании нынешней науки, можно с водой выплеснуть и ребенка.

Кстати, попиарю, можно сказать, коллегу по одному совсем-совсем невидимому колледжу: там, конечно, не про наукометрию, но тоже графы, сети...

nitrosbase

21.08.2019 18:39+1Из нашумевшей лет пять назад статьи Соколов М. М., Титаев К. Д. Провинциальная и туземная наука:

Доминирующей формой цитирования в этой ситуации становится самоцитирование.

Получается, все-таки туземная…

Краткое содержание всей статьиГрубо говоря, если провинциальная наука — это карго-аэропорт, подающий сигналы настоящим самолетам, которые этих сигналов не слышат и никогда на него не садятся, то туземная — это аэропорт, который подает сигналы самолетам воображаемым, и эти самолеты регулярно на такой аэродром садятся.

AntonSor

21.08.2019 19:08Ну все же понятно с этими правилами, как говорится, в соревновании по бегу в мешках побеждают не те, кто лучше умеют бегать, а те, кто лучше умеют бегать в мешках

planx

21.08.2019 19:31+2Ситуация безвыходная. Нет простого и эффективного способа измерения производительности учёного. Или просто, но не точно или точно, но сложно.

red_andr

21.08.2019 19:59Причём способ «точно, но сложно» ещё не придуман. Это как с теорией всего, она как бы должна быть, но пока не открыта.

ReklatsMasters

21.08.2019 19:35Другая важная проблема современной науки это пи-хакинг. Из-за этого появляются исследования вроде "Шоколад помогает в борьбе с раком" и т.п.

striver

21.08.2019 19:49Если не ты, то кто. Как говорила одна знакомая… нужно себя хвалить, автор забудется, а слова останутся…

spirit1984

21.08.2019 20:06Даже если убрать самоцитирование, и оставить цитирование, нельзя забывать нашего самого знаменитого соавтора, получившего Шнобеля по литературе: www.ig-nobel.ru/a1992lit.php.

red_andr

21.08.2019 23:06Тут всё-таки число публикаций, а не цитат. У отечественных учёных зачастую первых даже больше, чем вторых. Просто потому, что пишут никому не нужную ерунду, так как отчитывались в советской науке традиционно только публикациями.

red_andr

21.08.2019 20:09+2На самом деле учёные ведь люди умные, очень умные. Даже те, которые симулируют научную деятельность. Поэтому самоцитаты уже пройденный этап. Так попадаются совсем уж бездельники и пофигисты из развивающихся стран, где проверка реальности научной деятельности ещё на зачаточном этапе. Сейчас в моде перекрёстные цитаты. Грубо говоря, два учёных договариваются усиленно цитировать друг друга. На самом деле, конечно ещё сложнее. Обычно это целые группы и кластеры учёных. И выявить их очень сложно, так как они имитируют реально существующие закономерности, когда работающие в одной области вполне логично цитируют друг друга. То есть, понять где цитата поставлена «по дружбе», а где по реальной необходимости малореально. Хотя, бывает, конечно, когда цитируют совсем уж неподходящие по тематике источники.

mikeee1

22.08.2019 06:45На деле так и есть, но эти связи могут образовываться естественным образом. Например, в моей прошлой области работало около 15-20 групп во всем мире, ясен перец все цитируют друг друга по кругу без каких либо договоренностей, т.к. цитировать больше некого…

В России есть еще другая проблема, что для допуска статьи к публикации, ее одобряет науч совет. Во многих институтах без цитирования босса/друга босса совет тупо не допускает статью к публикации.

anton19286

22.08.2019 07:30А ещё, если в статье нет ссылок на публикации в этом же журнале, отказывают, как не соответствующей тематике.

pewpew

22.08.2019 12:22Какой смысл в одобрении кучки людей, если ты точно знаешь, что правда на твоей стороне? И да, как эта кучка людей способна повлиять на обнародование/публикацию работы? У них есть интеллектуальные права на научную работу / они могут подать в суд?

Если все с этим согласны, то значит хотят, чтобы так было и всех устраивает система.

Хотя подозреваю, что дело в нагретых местах. Все за них трепещут и на самом деле не очень хотят заниматься наукой. Хотят быть как все и не выделяться. Бизнес, как обычно важнее пользы человечеству.

DSolodukhin

22.08.2019 13:13правда на твоей стороне

«Правда» может под грифом. У нас при публикации статьи надо было получить отзыв эксперта, что в статье нет сведений представляющих гос. тайну и завизировать его в первом отделе.

Вот, кстати, цитата из правил одного из журналов РАН:

Кроме того, если исследования, результаты которых описаны в статье, выполнялись в российских учреждениях, нужно приложить направление от одного из этих учреждений и акт-экспертизы о возможности опубликования статьи в открытой печати.

pewpew

22.08.2019 13:30Ну это пережиток прошлого, от которого следует избавляться. Какие могут быть тайны во славу человечества? И почему кто-то имеет право решать, какие сведения общедоступны, а какие — нет? Все эти шпионские страсти призваны лишь укрепить позиции зашоривания одних групп лиц от других под прикрытием государств.

Вот только представим, что изобрели новый до одури простой тип генератора энергии, скажем из вакуума. С одной стороны — надо бы держать в тайне. Мы же страна нефти и газа и разбазаривания всех этих богатств. А с другой — в перспективе, отказавшись от ДВС, человечество только выйграет, пусть по началу это сильно шатнёт баланс. Ну и что с того? Пусть шатнёт.

А если тайна военная — тем более. Если у сторон нет возможности быть на шаг впереди, то нет рычага давления. Изобрели ядерное оружие — теперь все одинаково боятся его применить, потому что дальнейшая гонка разрушений бессмысленна. Никому война не нужна кроме тех, кто на ней зарабатывает. И уж особенно она не нужна человечеству в подавляющем большинстве.

Am0ralist

24.08.2019 11:15Изобрели ядерное оружие — теперь все одинаково боятся его применить, потому что дальнейшая гонка разрушений бессмысленна.

Именно поэтому технологии данные под запретом распространения, да? Потому что никто не боится попадания данного типа оружия в руки фанатиков, которые с радостью?

red_andr

22.08.2019 17:00для допуска статьи к публикации, ее одобряет науч совет

Это относится только к публикациям в российских журналах. Ну, по крайней мере раньше. Публиковаться в которых, скажу откровенно, смысла нет никакого, кроме как просто поднять число собственно публикаций. Журналы эти никто не читает, даже в самой России.

CactusKnight

22.08.2019 20:53В ряде институтов разрешение нужно получать на любую статью — просто потому, что этого прямо требуют правила самого института

saipr

21.08.2019 21:03И вообще, какой показатель самоцитирования считать нормальным.

И кто даст ответ на этот вопрос?

У исследователей действительно много законных оснований ссылаться на собственные работы и работы соавторов.

А вот и ответ

nitrosbase

22.08.2019 00:54+1Например, Сундарапандиан Вайдьянатан из Индии.

У вас скриншот из таблички 2017 года, но в табличке 2018 один наш соотечественник его уже обогнал (и в табличке за 2017 год у ряда соотечественников поле со страной не было заполнено).

Бегло посмотрел на Google Scholar и пр. соотечественников — лидеров рейтинга. Особо криминального ничего не увидел. Появились даже некоторые сомнения в полноте данных, собранных авторами статьи, и в методике расчета этого %self.

chersanya

22.08.2019 01:06Ну, судя по графикам в посте, ситуация с большим средним показателем самоцитируемости в России и Украине может частично быть вызвана перекосом по наукам (явно доля астрофизиков из РФ среди мировых больше, чем учёных-хирургов) и по возрасту/этапу карьеры. Причём сходу неясно, насколько сильны эти эффекты.

strcpy

22.08.2019 01:32+1Еще один аспект, который кажется не обсуждался в каментах — берут то что должно было бы поместиться в одну статью, режут на 3-4 куска и публикуют по кусочкам. Иногда делают небольшие ошибки, на которые ссылаются другие, а дальше их исправляют. Насколько я понимаю, до 90 годов вообще никаких индексов цитирования особо не было, а до 70 годов ученые сами отлично знали все новации в их области, скажем можно было легко прочитать все журналы по математике, их было не так много, а материал был содержательный. После 40ых годов и атомного проекта в науку хлынули деньги, потому что промышленность и правительства поняли, что институты могут в некоторой степепени работать как завод. А чтобы как-то контролировать ученых, их заставили писать статьи. По статьям же стали распиливать бабло, что привело к увеличению потока бессмысленных статей и никчемных журналов. До 30ых годов в науке денег особо не было, люди преимущественно занимались этим for fun, наример Эйнштейн после создания теории относительности продолжал работать в патентном бюро.

akhalat

22.08.2019 07:46берут то что должно было бы поместиться в одну статью, режут на 3-4 куска и публикуют по кусочкам

называется «salami slicing»

Lex20

22.08.2019 06:12Какой идиот придумал поощрять учёных за индекс цитирования? Учёные не индекс цитирования производят

Lord_Ahriman

22.08.2019 08:05У указанных ученых специализации такие, что грех так делать. А вот я, например, в свое время при написании диссертации по узкой теме столкнулся с тем, что вопросом вплотную занимались только три исследователя — итальянец, немец из Siemens и я, так что самоцитирования были просто вынужденные.

Часто так делают, потому что на ВУЗы спущен план из минобра по «эффективности», в которую входят эти самые цитирования (а еще, например, непонятно почему — стаж работы, в итоге я, когда преподавал, имел кучу статей, методичек, конференций, патентов, но эффективность ниже, чем профессор под 80, который ничерта не делал и выезжал только за счет стажа и вот этих самых цитирований), вот их и накручивают

Xander_Vi

22.08.2019 09:57Грустно это, конечно. А корень проблемы в том, что для умных людей (ученых) KPI ставят менее умные люди (чиновки, предположительно).

lolhunter

22.08.2019 08:13-1Мне одному режет глаз заголовок?

Россия и Украина В ЛИДЕРАХ!!!

Первый ученый из России на 822 строке.

Первый ученый из Украины на 12495 строке.

trolley813

22.08.2019 08:26+2Так номер строки — это же просто id, а не позиция в рейтинге. Здесь специально показали список

ORDER BY self_citation DESCENDING

lolhunter

22.08.2019 09:43-1Эмм. Это обычная экселевская таблица. Отсортированная по проценту цитирования. Из которой ФИЛЬТРОМ выбраны страны rus и ukr. То есть номер строки по факту это номер по порядку -1 на заголовок. Над 823 строкой с российским ученым в этой таблице 822 строки -1 на заголовок итого 821 ученый.

Под табличкой собственно надпись гласит в пользу того, что я говорю.

Российские и украинские лидеры в рейтинге самоцитирования. Российский ЛИДЕР на 822 строке… Украинский на 12495.

Заголовок

«Украина и Россия в лидерах»

Я не очень хочу брать статистику по ученым на население и как-то еще считать, но чисто визуально 822 место ПЕРВОГО ученого ну никак не лидерство. А уж 12495 — ну вообще никак…

И каким образом можно попать с ЛИДЕРЫ рейтинга с первым участником на 822 месте — я честно говоря не представляю. Разве что 821 участник из 1 страны получается? А между 823 и 12495 тоже та же загадочная страна? Тогда получится Россия на втором, Украина на третьем? И топ 822 ученых — ученые одной страны? А топ 12495 — из двух — РФ и загадочной?

P.S. уже и в карму насрали… Хабр такой хабр.

anton19286

22.08.2019 12:01Так номер строки — это же просто id

Точно нет, потому что и id и числа в колонке self% упорядочены.

PS. Глянул файлик за 17 год. Из 100000 имеют индекс самоцитирования выше 50% меньше 300 человек. Из них русских 13, потенциальных (не указана страна) ещё 6. 9 австралийцев, 12 китайцев, 15 немцев, 18 англичан, 14 итальянцев, 18 японцев, 1 украинец и 44 американца. Расходимся?

lolhunter

22.08.2019 12:10Посмотрел еще раз. Не думал, что кому-то, кто хоть пару раз работал с фильтрами в Excel в принципе может показаться неочевидным явно нисходящее количество процентов цитирования и значок фильтра, включенный на колонке cntry…

20 ученых на почти 18 тысяч (последняя строка 17934 — сколько после нее не известно, хотя написано в статье про 100.000)…

Вообще никак не стоит статьи на хабре и уж тем более явно желтушного заголовка «Украина и Россия в лидерах».

lolhunter

22.08.2019 12:17Видимо для кого-то неочевидно…

Как так получается, что ID идет так же вниз как и индекс самоцитирования? Вот все 20 ученых в списке отсортировались по ID И по индексу одновременно?

И оформление табличного редактора…

И двойные строки слева, между строками, которые показывают скрытые…

Это не выборка из базы. Это экселевская табличка с автофильтром и сортировкой по полю самоцитирование и выборкой по странам rus и ukr. Не более того.

achekalin

22.08.2019 09:12-1Опубликована база учёных,

Увидев такой заголовок, подумал было, что случайно на lenta.ru зашел.

Кем опубликована? Ок, читаем текст. И видим заслуживающее доверия пояснение:

Недавно в журнале PLOS Biology опубликован набор данных по 100 тыс. учёным со всего мира.

Этак Ализар сам на себя будет ссылаться, и то, только с тем, чтобы его посты не выглядели просто вольными переводами одной публикации (тогда получается как бы цельнотянутый контент), а именно постом по нескольким источникам, где один из источников расписан чуть более подробно.

Одно обидно — даже при таком самоцитировании в описанный здесь непонятного доверия рейтинг не попасть, т.к. Хабр не является «научным» изданием.

Victor_koly

22.08.2019 15:55Конечно в физике частиц могут быть разные случаи. Скажем статья:

arxiv.org/pdf/1901.00174.pdf

Автор «The CMS Collaboration» считается за самоцитирование? Число ссылок на этого автора в статье — 18 и ещё на «ATLAS Collaboration» — 10 раз (из 95 ссылок).

Если кто-то не в курсе, то речь идет о 2 основных коллаборациях (оно же детекторах) на LHC. Ну может не основных, скажем последняя (ЕМНИП) открытая частица была открыта LHCb.

maxgorbunov

23.08.2019 13:49А я правильно понимаю, что Я.Б. Зельдович воскресе и сделал за 2017 год 2.65% самоцитирований?

(таблица Table-S2-singleyr-2017, строка 105342)

Fedorkov