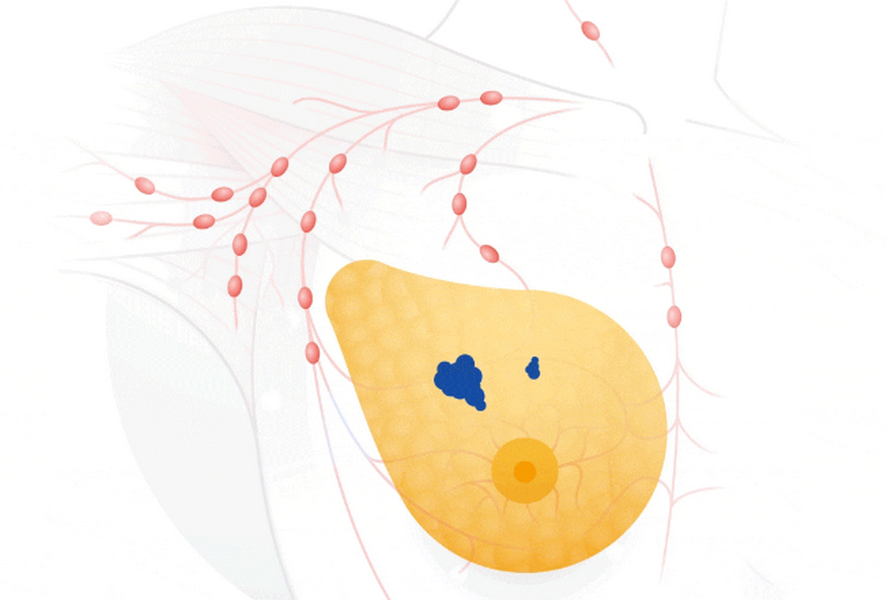

Исследование, которое опубликовали в журнале Nature, посвящено способности ИИ DeepMind повысить точность скрининга рака молочной железы. Искусственный интеллект смог идентифицировать рак с такой же степенью точности, что и опытные рентгенологи, но число ложноположительных результатов снизилось на 5,7% в группе из США и на 1,2% в группе из Великобритании, а ложнооотрицательных — на 9,4% в США и на 2,7% в Великобритании.

Американское онкологическое общество заявляет, что рентгенологи упускают около 20% случаев рака молочной железы, а половине всех женщин, которые прошли скрининг в течение 10 лет, он показал ложноположительный результат. После того, как систему ИИ обучили выявлению рака молочной железы с помощью анонимных маммограмм от более чем 76 000 женщин в США и более 15 000 женщин в Великобритании, проведенный ею анализ сравнили с фактическими результатами 25 856 маммограмм в Британии и 3097 в США.

В отдельном тесте система ИИ превзошла итоги исследования шести рентгенологов.

Конни Леман, начальник отдела визуализации молочной железы в Массачусетской больнице общего профиля в Гарварде, отмечает, что система компьютерной диагностики (Computer-aided diagnosis, CAD) широко распространена в клиниках, но ее программы обучены распознавать то, что могут видеть врачи, в то время как искусственный интеллект учится распознавать рак на основе фактических результатов тысяч маммограмм.

Теперь для внедрения ИИ в методики определения рака потребуются дополнительные исследования, а также разрешение от регулирующих органов.

Как отметили в Google, при исследовании ИИ получал меньше информации, чем врачи-эксперты, так как те имели доступ к истории болезни и предыдущим маммограммам, а модель обрабатывала только самые последние анонимные маммограммы.

В Google считают, что этот проект может помочь рентгенологам, но не заменит их: «Есть ряд случаев, когда врачи улавливают то, что пропускает модель, и наоборот. Объединение этих двух факторов может улучшить общие результаты».

Ранее СМИ выяснили, что Google уже год идет сбор персональных данных миллионов американских пациентов для своего секретного проекта под кодовым названием «Project Nightingale». Данный проект реализуется совместно с крупнейшей в США медицинской некоммерческой организацией Ascension из Сент-Луиса, которая предоставляет Google доступ к данным о здоровье жителей из двадцати одного штата США. Сейчас в базе данных медицинского проекта компании есть данные по пациентам из почти трех тысяч лечебных учреждений. При этом доктора и пациенты не были поставлены в известность, что их медицинская информация будет доступна третьим лицам.

Медицинская программа была запущена Google в 2018 году, а любая информация о ней до сих пор держались в строгом секрете. В рамках проекта корпорация создает глобальную базу данных с медицинскими картами миллионов пациентов, в которой есть информация об их лабораторных исследованиях и анализах, диагнозах врачей и записях о госпитализации, полные истории болезней с именами пациентов и датами рождения.

Минздрав США объявил о начале расследования.

Комментарии (9)

ra3vdx

02.01.2020 18:15Не всякая опухоль — это рак. Бывают фиброаденомы, например, которые оперируются налево и направо.

И польза подобных скриннингов довольно сомнительна: высок риск гипердиагностики и ненужного лечения.

Elmot

02.01.2020 20:55Ну так эти ребята с первой попытки на небольшой выборке добились статистически значимого улучшения диагностики, в частности некоторое снижение ложноположительных результатов. Так что в конечном итоге вопросов к качеству скрининга должно стать куда меньше.

ZlodeiBaal

02.01.2020 23:15Они не первые. Я писал статью, где рассматривал прошлую подобную работу -https://habr.com/ru/company/recognitor/blog/474674/

Проблема этого подхода, что в маммографии нет диагноза «рак/не рак» по рентгену.

Есть сильно более обширное дерево решений, в рамках которого пока что не существуют размеченных датасетов. Когда врач однозначно говорит «рак», то обычно там уже всё плохо.

Процентах в 20 вообще по мамограмме нельзя ничего сказать, в таком случае скрининг идёт через УЗИ.

Не сказать что нельзя применять результат обучения нейронной сети в реальном скрининге. Но надо очень много думать над тем как внедрять в существующие стандарты метрику которая написана вне их рамок.

Кстати, если я правильно понимаю что Google сделал, то они сильно по более простому датасету обучали чем та работа которую упоминал я.

chapai22

03.01.2020 02:20Так добавят УЗИ и потребные тесты. Наверняка маркеры то се тоже никто не отменял, как и корреляции с gentest. 23&me у них не просто так существует. Опять же историю болезни научится читать — тексты давно распознают по смыслу.

Цель то в пределе массовый прескрининг делать совсем автоматом без врача а привлекать когда посложней или всплывает что.

Для всех манипуляций изначально же техник требуется и оборудование -а это другие деньги нежели врач. И страховкам попроще -а значит дешевле.

Причем она не зрением может понимать, а посложней, просто по данным,- оптическое представление ей не требуется и данных у нее больше чем у врача с глазами. Наверняка тонкие перепады на фотке вообще не визуализируются ввиду малых отличий. Самолет же не машет крыльями — ну и здесь будет так же. Причем наверняка приборы можно подточить для нейросети (и то что врачу с глазами не годно -или он для них не годен) — либо мерять станут невидимое, либо мерять станет дешевле, так как лишнего не надо и часть оборудования отбрасывается.

Ryppka

03.01.2020 10:07Имея непосредственное отношение к рентег-диагностике, я бы сильно удивился, если бы нейронные сети не показали результат лучше людей. Классификация картинок по типу «можешь гулять»/«требуется дальнейшее исследование» — не самая сложная задача. Даже устранение естественных для людей причин невнимательности должно дать заметный результат.

Вот только неверно говорить, что у сетки меньше информации, чем у людей. Не совсем так — сетке во время обучения скармливали данные из будущего, а вот получает ли их человек и насколько вообще средний специалист в состоянии их эффективно накапливать — вопрос.

Focushift

Опять тренированную нейросеть называют ИИ?

Barabek

Расскажите заодно в двух словах, в чем разница. Для тех, кто не настолько в теме

(серьёзно)

Pyhesty

тренированная нейросеть — это апроксимация, а ИИ — это нечеткая логика, выборка решений из дерева с подключением апроксимации при необходимости, в ИИ — сеть только часть

sergehog

Один профессор, на лекции которого я имел честь присутствовать, рассказал отличный принцип как отличать ML от AI: если система принимает сложные решения без участия человека, то это AI. Если просто предсказывает/классифицирует, но при этом не делает ничего рискованного, то это ML.

Это помогает хоть как-то различать эти два термина, которые иначе размазаны маркетологами.

В данном случае я бы лично хотел чтобы последнее слово всегда оставалось за врачем. Т.е. чтоб описанная система была бы ML, которая помогает врачу принять правильное решение.

Хотя кто знает, может лет через 10, когда доказательная медицина докажет что нейросеть лечит лучше чем обычный врач, то может я и доверю свое здоровье такому ИИ. А ренгенологи станут младшим медицинским персоналом ))))