Сегодня речь пойдет о том, как быстро и достаточно просто на одном физическом сервере развернуть несколько виртуальных серверов с разными операционными системами. Любому системному администратору это позволит централизованно управлять всей IT-инфраструктурой компании и экономить огромное количество ресурсов. Использование виртуализации помогает максимально абстрагироваться от физического серверного оборудования, защитить критичные сервисы и легко восстановить их работу даже в случае очень серьезных сбоев.

Без всякого сомнения, большинству системных администраторов знакомы приемы работы с виртуальной средой и для них эта статья не станет каким-либо открытием. Несмотря на это, есть компании, которые не используют гибкость и скорость работы виртуальных решений из-за недостатка точной информации о них. Мы надеемся, что наша статья поможет на примере понять, что гораздо проще один раз начать использовать виртуализацию, чем испытывать неудобства и недостатки физической инфраструктуры.

К счастью, попробовать как работает виртуализация достаточно просто. Мы покажем, как создать сервер в виртуальной среде, например, для переноса CRM-системы, используемой в компании. Практически любой физический сервер можно превратить в виртуальный, но вначале необходимо освоить базовые приемы работы. Об этом и пойдет речь ниже.

Как это устроено

Когда речь идет о виртуализации, многим начинающим специалистам сложно разобраться в терминологии, поэтому поясним несколько базовых понятий:

- Гипервизор – специальное программное обеспечение, которое позволяет создавать виртуальные машины и управлять ими;

- Виртуальная машина (далее VM) – это система, представляющая собой логический сервер внутри физического со своим набором характеристик, накопителями и операционной системой;

- Хост виртуализации — физический сервер с запущенным на нем гипервизором.

Для того чтобы сервер мог работать полноценным хостом виртуализации, его процессор должен поддерживать одну из двух технологий – либо Intel® VT, либо AMD-V™. Обе технологии выполняют важнейшую задачу — предоставление аппаратных ресурсов сервера виртуальным машинам.

Ключевой особенностью является то, что любые действия виртуальных машин исполняются напрямую на уровне оборудования. При этом они друг от друга изолированы, что достаточно легко позволяет управлять ими по отдельности. Сам же гипервизор играет роль контролирующего органа, распределяя ресурсы, роли и приоритеты между ними. Также гипервизор занимается эмуляцией той части аппаратного обеспечения, которая необходима для корректной работы операционной системы.

Внедрение виртуализации дает возможность иметь в наличии несколько запущенных копий одного сервера. Критический сбой или ошибка, в процессе внесения изменений в такую копию, никак не повлияет на работу текущего сервиса или приложения. При этом также снимаются две основные проблемы – масштабирование и возможность держать «зоопарк» разных операционных систем на одном оборудовании. Это идеальная возможность совмещения самых разных сервисов без необходимости приобретения отдельного оборудования для каждого из них.

Виртуализация повышает отказоустойчивость сервисов и развернутых приложений. Даже если физический сервер вышел из строя и его необходимо заменить на другой, то вся виртуальная инфраструктура останется полностью работоспособной, при условии сохранности дисковых носителей. При этом физический сервер может быть вообще другого производителя. Это особенно актуально для компаний, которые используют серверы, производство которых прекращено и потребуется осуществить переход на другие модели.

Теперь перечислим самые популярные гипервизоры, существующие на текущий день:

- VMware ESXi

- Microsoft Hyper-V

- Open Virtualization Alliance KVM

- Oracle VM VirtualBox

Они все достаточно универсальны, однако, у каждого из них имеются определенные особенности, которые следует всегда учитывать на этапе выбора: стоимость развёртывания/обслуживания и технические характеристики. Стоимость коммерческих лицензий VMware и Hyper-V весьма высока, а в случае возникновения сбоев, решить проблему с этими системами собственными силами очень непросто.

KVM же напротив, полностью бесплатен и достаточно прост в работе, особенно в составе готового решения на базе Debian Linux под названием Proxmox Virtual Environment. Именно эту систему мы можем порекомендовать для первоначального знакомства с миром виртуальной инфраструктуры.

Как быстро развернуть гипервизор Proxmox VE

Установка чаще всего не вызывает никаких вопросов. Скачиваем актуальную версию образа с официального сайта и записываем его на любой внешний носитель с помощью утилиты Win32DiskImager (в Linux используется команда dd), после чего загружаем сервер непосредственно с этого носителя. Наши клиенты, арендующие у нас выделенные серверы, могут воспользоваться двумя еще более простыми путями – просто смонтировав нужный образ непосредственно из KVM-консоли, либо используя наш PXE-сервер.

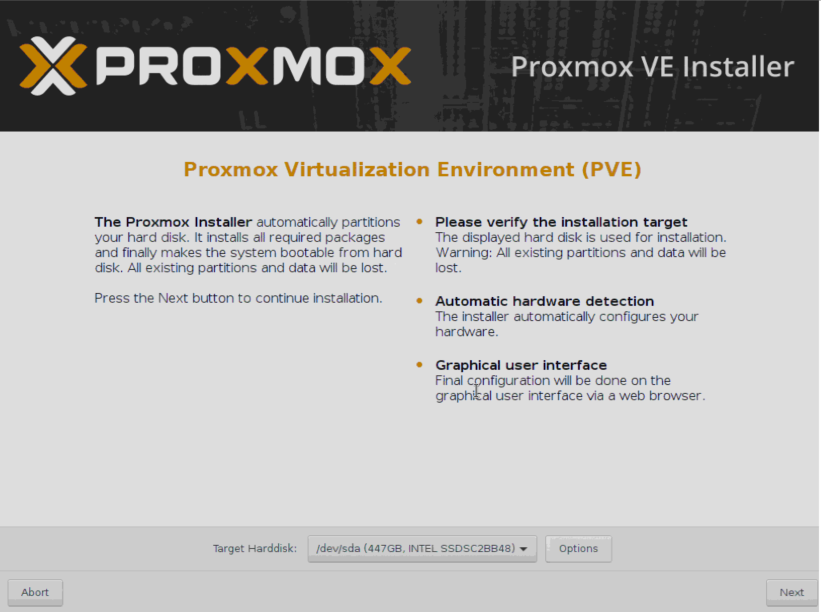

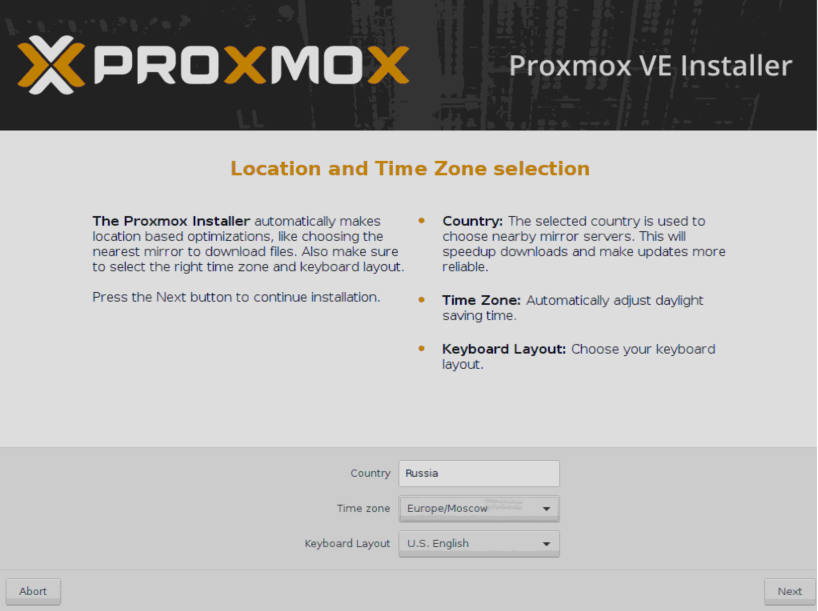

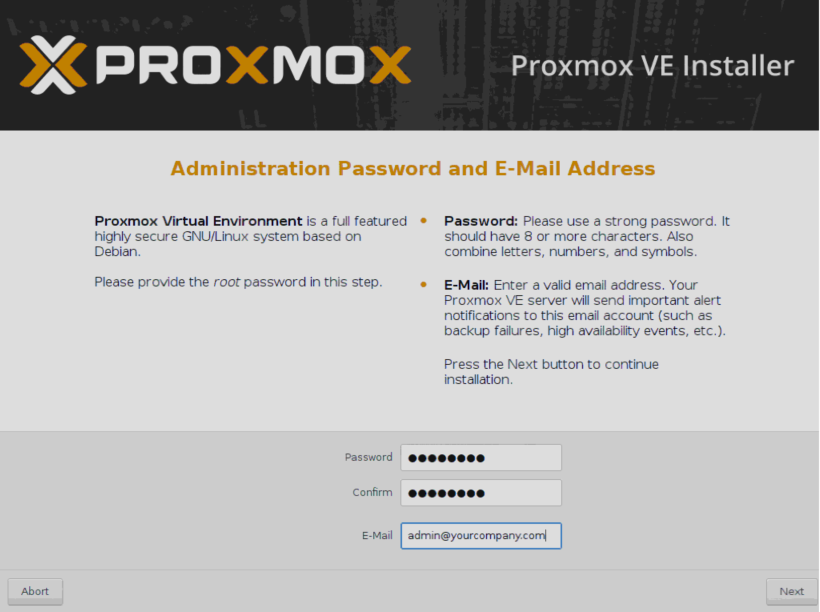

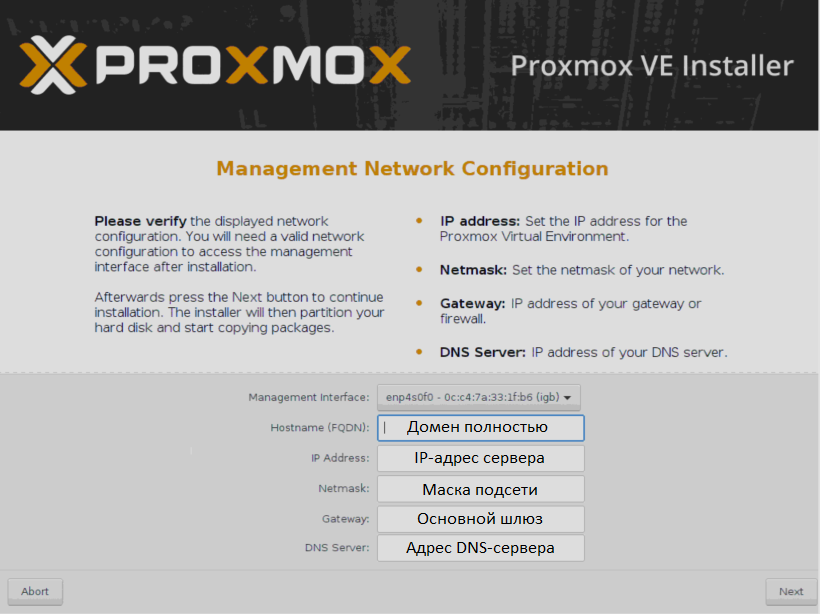

Программа установки имеет графический интерфейс и задаст всего лишь несколько вопросов.

- Выбираем диск, на который будет выполнена установка. В разделе Options можно также задать дополнительные параметры разметки.

- Указываем региональные настройки.

- Указываем пароль, который будет использоваться для авторизации суперпользователя root и E-mail адрес администратора.

- Указываем сетевые настройки. FQDN обозначает полностью определенное имя домена, например, node01.yourcompany.com.

- После завершения установки, сервер можно отправить в перезагрузку с помощью кнопки Reboot.

Веб-интерфейс управления станет доступен по адресу

https://IP_адрес_сервера:8006

Что нужно сделать после установки

Есть несколько важных вещей, которые следует выполнить после установки Proxmox. Расскажем о каждой из них подробнее.

Обновить систему до актуальной версии

Для этого зайдем в консоль нашего сервера и отключим платный репозиторий (доступен только тем, кто купил платную поддержку). Если этого не сделать — apt сообщит об ошибке при обновлении источников пакетов.

- Открываем консоль и редактируем конфигурационный файл apt:

nano /etc/apt/sources.list.d/pve-enterprise.list - В этом файле будет всего одна строка. Ставим перед ней символ #, чтобы отключить получение обновлений из платного репозитория:

#deb https://enterprise.proxmox.com/debian/pve stretch pve-enterprise - Сочетанием клавиш Ctrl + X выполняем выход из редактора, отвечая Y на вопрос системы о сохранении файла.

- Выполняем команду обновления источников пакетов и обновления системы:

apt update && apt -y upgrade

Позаботиться о безопасности

Мы можем порекомендовать установить популярнейшую утилиту Fail2Ban, защищающую от атак методом перебора паролей (брутфорс). Принцип ее работы заключается в том, что если злоумышленник превысит определенное количество попыток входа за указанное время с неверным логином/паролем, то его IP-адрес будет заблокирован. Срок блокировки и количество попыток можно указать в конфигурационном файле.

Исходя из практического опыта, за неделю работы сервера с открытым ssh-портом 22 и внешним статическим IPv4-адресом, было более 5000 попыток подобрать пароль. И около 1500 адресов утилита успешно заблокировала.Для выполнения установки приводим небольшую инструкцию:

- Открываем консоль сервера через веб-интерфейс или SSH.

- Обновляем источники пакетов:

apt update - Устанавливаем Fail2Ban:

apt install fail2ban - Открываем конфигурацию утилиты на редактирование:

nano /etc/fail2ban/jail.conf - Изменяем переменные bantime (количество секунд на которые будет блокироваться злоумышленник) и maxretry (количество попыток ввода логина/пароля) для каждого отдельного сервиса.

- Сочетанием клавиш Ctrl + X выполняем выход из редактора, отвечая Y на вопрос системы о сохранении файла.

- Перезапускаем службу:

systemctl restart fail2ban

Проверить статус работы утилиты, например, снять статистику блокировок заблокированных IP-адресов с которых были попытки перебора паролей SSH, можно одной простой командой:

fail2ban-client -v status sshdОтвет утилиты будет выглядеть примерно так:

root@hypervisor:~# fail2ban-client -v status sshd

INFO Loading configs for fail2ban under /etc/fail2ban

INFO Loading files: ['/etc/fail2ban/fail2ban.conf']

INFO Loading files: ['/etc/fail2ban/fail2ban.conf']

INFO Using socket file /var/run/fail2ban/fail2ban.sock

Status for the jail: sshd

|- Filter

| |- Currently failed: 3

| |- Total failed: 4249

| `- File list: /var/log/auth.log

`- Actions

|- Currently banned: 0

|- Total banned: 410

`- Banned IP list:Аналогичным способом можно закрыть от подобных атак Web-интерфейс, создав соответствующее правило. Пример такого правила для Fail2Ban можно найти в официальном руководстве.

Начало работы

Хочется обратить внимание на то, что Proxmox готов к созданию новых машин сразу после установки. Тем не менее, рекомендуем выполнить предварительные настройки, чтобы в дальнейшем системой было легко управлять. Практика показывает, что гипервизор и виртуальные машины стоит разнести по разным физическим носителям. О том, как это сделать и пойдет речь ниже.

Настроить дисковые накопители

Следующим этапом следует настроить хранилище, которое можно будет использовать для сохранения данных виртуальных машин и резервных копий.

ВНИМАНИЕ! Приведенный ниже пример дисковой разметки можно использовать только для тестовых целей. Для эксплуатации в реальных условиях мы настоятельно рекомендуем использовать программный или аппаратный RAID-массив, чтобы исключить потерю данных при выходе дисков из строя. О том, как правильно приготовить дисковый массив к работе и как действовать в случае аварийной ситуации мы расскажем в одной из следующих статейПредположим, что физический сервер имеет два диска — /dev/sda, на который установлен гипервизор и пустой диск /dev/sdb, который планируется использовать для хранения данных виртуальных машин. Чтобы система смогла увидеть новое хранилище, можно воспользоваться самым простым и эффективным методом — подключить его как обычную директорию. Но перед этим следует выполнить некоторые подготовительные действия. В качестве примера посмотрим, как подключить новый диск /dev/sdb, любого размера, отформатировав его в файловую систему ext4.

- Размечаем диск, создавая новый раздел:

fdisk /dev/sdb - Нажимаем клавишу o или g (разметить диск в MBR или GPT).

- Далее нажимаем клавишу n (создать новый раздел).

- И наконец w (для сохранения изменений).

- Создаем файловую систему ext4:

mkfs.ext4 /dev/sdb1 - Создаем директорию, куда будем монтировать раздел:

mkdir /mnt/storage - Открываем конфигурационный файл на редактирование:

nano /etc/fstab - Добавляем туда новую строку:

/dev/sdb1 /mnt/storage ext4 defaults 0 0 - После внесения изменений сохраняем их сочетанием клавиш Ctrl + X, отвечая Y на вопрос редактора.

- Для проверки, что все работает, отправляем сервер в перезагрузку:

shutdown -r now - После перезагрузки проверяем смонтированные разделы:

df -H

Вывод команды должен показать, что /dev/sdb1 смонтирован в директорию /mnt/storage. Это значит, что наш накопитель готов к работе.

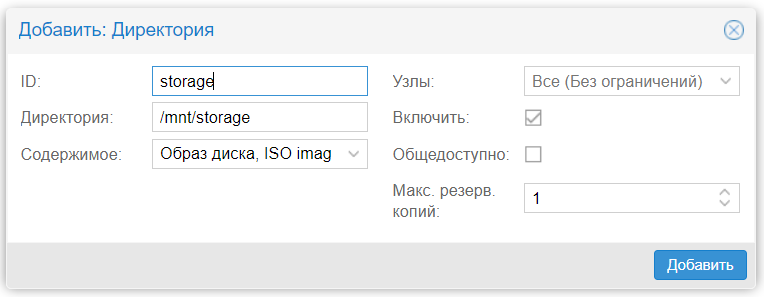

Добавить новое хранилище в Proxmox

Авторизуемся в панели управления и заходим в разделы Датацентр ? Хранилище ? Добавить ? Директория.

В открывшемся окне заполняем следующие поля:

- ID — название будущего хранилища;

- Директория — /mnt/storage;

- Содержимое — выделяем все варианты (поочередно щелкая на каждом варианте).

После этого нажимаем кнопку Добавить. На этом настройка завершена.

Создать виртуальную машину

Для создания виртуальной машины выполняем следующую последовательность действий:

- Определяемся с версией операционной системы.

- Заранее закачиваем ISO-образ.

- Выбираем в меню Хранилище только что созданное хранилище.

- Нажимаем Содержимое ? Загрузить.

- Выбираем из списка ISO-образ и подтверждаем выбор нажатием кнопки Загрузить.

После завершения операции образ будет отображен в списке доступных.

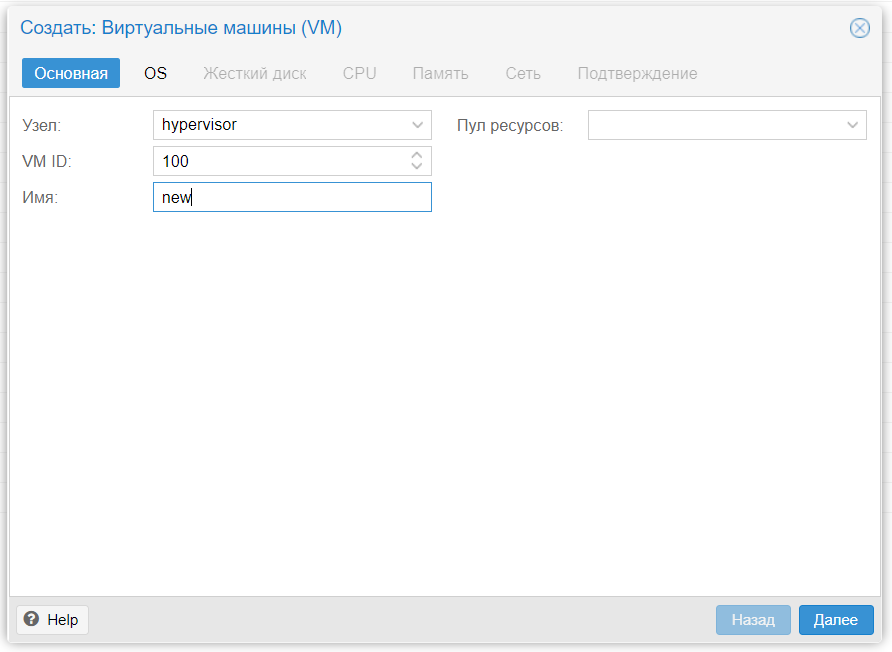

Создаем нашу первую виртуальную машину:

- Нажимаем Создать VM.

- Заполняем поочередно параметры: Имя ? ISO-Image ? Размер и тип жесткого диска ? Количество процессоров ? Объем оперативной памяти ? Сетевой адаптер.

- Выбрав все желаемые параметры нажимаем Завершить. Созданная машина будет отображена в меню панели управления.

- Выбираем ее и нажимаем Запуск.

- Переходим в пункт Консоль и выполняем установку операционной системы точно таким же образом, как и на обычный физический сервер.

Если необходимо создать еще одну машину — повторяем вышеуказанные операции. После того как все они будут готовы, с ними можно работать одновременно, открывая несколько окон консоли.

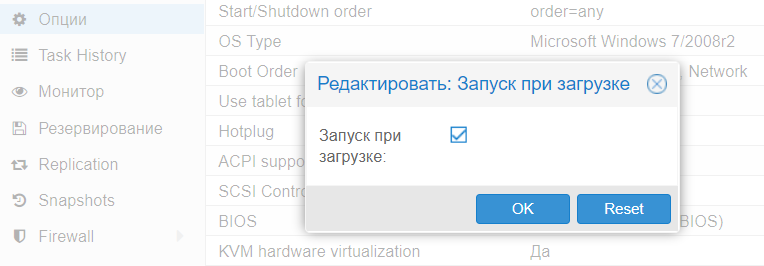

Настроить автозапуск

По умолчанию Proxmox автоматически не запускает машины, но это легко решается буквально двумя щелчками мыши:

- Щелкаем по названию нужной машины.

- Выбираем вкладку Опции ? Запуск при загрузке.

- Ставим галочку напротив одноименной надписи.

Теперь, в случае перезагрузки физического сервера, VM будет запущена автоматически.

Для продвинутых администраторов имеется еще и возможность указать дополнительные параметры запуска в разделе Start/Shutdown order. Можно явным образом указать в каком порядке следует запускать машины. Также можно указать время, которое должно пройти до старта следующей VM и время задержки выключения (если операционная система не успеет завершить работу, гипервизор принудительно ее выключит через определенное количество секунд).

Заключение

В этой статье были изложены основы того, как можно начать работать с Proxmox VE и мы надеемся, что она поможет начинающим специалистам сделать первый шаг и попробовать виртуализацию в действии.

Proxmox VE — это действительно очень мощный и удобный инструмент для любого системного администратора; главное не бояться экспериментировать и понять, как это действительно работает.

Если у вас появились вопросы, добро пожаловать в комментарии.

Комментарии (29)

VGusev2007

09.01.2020 15:42Использую proxmox порядка пяти лет, на десятке серверов и с полтинничком вирт. машин. Пока, всё здорово. :)

denaspireone

09.01.2020 16:42+1Darksa — запилите пост приводящий более частые конфиги vlan стандартными решениями бриджей и в ru.wikipedia.org/wiki/Open_vSwitch

iwram

09.01.2020 17:10Понимаю, что статья расчитана на новичков. Но все же:

1. Монтирование диска лучше делать по uuid, например, предварительно узнал uuid командой blkid и добавляем в /etc/fstab

UUID=6d466180-9997-4d1d-aa61-2aad160b5478 /mnt/storage ext4 defaults 0 0

ведь когда попадаешь в ситуацию после добавления диска и сменой sdb на sdc например — неприятно.

2. Исходя из того, что пост пишет провайдер предоставляющий хостинг. Можно было вкратце написать как организовать сеть между своими гипервизорами в рамках дата центра и сколько это будет стоить с вопросами, которые часто задают клиенты:

— можно ли сделать vlan для своих виртуалок используя ваши коммутаторы (QinQ включить по желанию клиента, а для этого надо купить «Локальный порт» на каждый хост).

— Возможность миграции виртуалок в другой дата центр.

— VXLAN и т.п.

3. Ну и напоследок указать «Типовые конфигурации». А также, как вы проводите тесты аппаратной части (Ведь тестируете? -Ну наверное не всегда и клиентам приходится терять время?)

Буду рад читать ваши статьи, которые будут соответствовать вашему техническому уровню, а не чтобы было.

Darksa Автор

09.01.2020 17:32Абсолютно с вами согласен, что монтирование на «боевой» системе нужно делать только по UUID. Я посчитал, что для объяснения базовых принципов достаточно просто указать /dev/sdX, поскольку так начинающим пользователям будет проще сориентироваться. В остальном — спасибо за пожелания.

Shakhmin

09.01.2020 19:29+1Не настолько сложно понимание uuid, как неприятны разборки "что пошло не так" при /dev/sdx

Тем более uuid уже много лет стандарт де-факто

Лучше сразу давать неупрощенные рекомендации. Если понимание будет сложно, то дообьяснить можно и в комментах и в отдельной статье (или посмотреть в Гугле)

PS — Жду продолжений

Vasily_Pechersky

10.01.2020 00:52Очень классная фишка прокса zfs с ssd кэшэм. Если в цикле это опишите — начинающим будет полезно.

numbernot

10.01.2020 07:47Если будет продолжение статей неплохо бы видеть описание реализации Open vSwitch https://pve.proxmox.com/wiki/Open_vSwitch

Очень хорошим ресурсом информации по Proxmox является книга Proxmox Cookbook от Wasim Ahmed

deCristo

10.01.2020 11:13Недавно пробовал Proxmox на своем домашнем Microserver Gen8, из того что понравилось: есть удобная функция запуска контейнеров с готовыми шаблонами почти под любую Linux подобную ОС чего я пока не встречал ни в ESXi ни в Hyper-V, по сравнению с полноценной ОС хорошо экономит ресурсы, имеет правда ограничения по настройкам, но там где мало ОЗУ, как в моем случае просто удобно пользоваться. Хотя я приверженец все же использования ESXi но все же в не которых случаях ProxMox удобен и эффективен будет.

DaemonGloom

10.01.2020 12:25Есть vSphere Integrated Containers, есть docker в windows server. Возможностей по настройке — вагон. Хотя ничего не подскажу по лицензированию первого — в своей аналогичной конфигурации мне оказалось проще поднять виртуальную машину с контейнерами.

multed

10.01.2020 14:03А что с лимитами? Умеет ли Proxmox ограничивать IOPSы и трафик? Перенастройку виртуальной машины по памяти/ядрам/диску на лету?

Darksa Автор

10.01.2020 14:29Лимиты следующие — 12 Tb ОЗУ и 768 логических CPU на хост.

Proxmox умеет гибко управлять ресурсами как по трафику, так и по IOPS.

Перенастройку ВМ выполнять можно «на лету» с помощью опций HotPlug, однако там есть определенные нюансы, связанные с версиями гостевых ОС. Где-то заработает «из коробки», где-то придется подкинуть пару модулей в ядро ОС.

really4g

11.01.2020 02:13Тут вот отписались мол зачем вот этот колхоз с proxmox. Esxi и hyper-v наше все.

А я не согласен что все.

И имею ввиду несколько причин почему proxmox предпочтительнее:

- Наличие бэкапа из коробки без лишнего геморроя.

- Наличие удобных средств для конфигурирования vlan (этот камень в большей степени касается hyper-v, хотя не скажу что VMware удобно так же как в proxmox)

- Удобная консоль управления. Она не такая запутанная как у конкурентов.

- Есть из коробки возможность конфигурировать ha. До версии proxmox 5 включительно входило в community версию точно.

Можно все хосты объединить в одну консоль управления. До версии proxmox 5 включительно входило в community версию точно.

По поводу esxi. Может система по производительности в определенных конфигурациях и уделает proxmox, в частности по сетевым коммуникациям, но из своего опыта не смогу сказать что в схожих ситуациях есть видимый эффект

Hyper-v… Я с ним работал начиная с 2008r2, и длительное время эксплуатировались базе win2012r2. Неоднократно сталкивался что зависшую машину не могу прибить и приходилось перезагружать весь сервер.

В винде нет встроенных нормальных средств резервного копирования виртуалок. По крайней мере по 2012r2 включительно.

По поводу статьи.

Если "копирование" мануала с официального сайта можно назвать статьей. Гораздо интереснее было бы увидеть тонкости настройки. Зачем здесь содержимое которого полно в интернете.

С точки зрения новичка конечно неплохой материал на русском языке.

werter78

13.01.2020 14:36Пользую PVE еще с версии 2.х.

Перед этимпрошел все круги адаперепробовал: Xen (еще от Citrix) -> Vmware ESXi -> MS Hyper-V.

В хоз-ве полтора десятка PVE. Обновлялся последовательно c 4.х -> 6.х. Рекомендую. И только на ZFS, к-ую PVE умеет «из коробки».

Зы. Моя небольшая э-э-э «вики» — forum.netgate.com/topic/120102/proxmox-ceph-zfs-pfsense-и-все-все-все. Периодически обновляю.

Всем добра )

Sergey-S-Kovalev

Вот взрослые люди, блог компании прямо связанной с виртуализацией. А прям сходу наглая ложь, потому что статью писал наверняка очередной студентик на стажировке:

VMware ESXi и Microsoft Hyper-V Server абсолютно бесплатны. Весьма платны средства комплексного централизованного управления хостами и виртуалкми в лице vCenter и VMM соответственно.К тому же «полностью бесплатный» Proxmox совершенно не избавляет Вас от требования лицензировать тот же Microsoft Windows Server располагающийся в виртуальных машинах, а бесплатные линуксы и на бесплатных esxi\hyper-v бесплатны.

Там взрослые коммерческие системы, где проблемы возникают столь редко, что к моменту, когда вы на них натолкнетесь в интернетах будут уже тонны мануалов, как это чинить, или пояснения почему вы делаете неправильно.

Ну это заметно по куче консольных команд в статье.

Когда у тебя условно три хоста и 10 виртуалок на них — esxi/hyper-v/kvm — пофиг. Когда у тебя десятки хостов и сотни виртуалок больше значения уже имеет не сама система виртуализации, а то как ты обеспечишь управление, HA/DRS, репликацию на другие площадки или в облако, мониторинг и бэкап. И в зависимости что тебе нужнее и важнее уже и приходишь к тому, какая виртуализация будет использоваться.

Daar

Согласен насчет ESXi и Hyper-V, сам давно использую для небольших проектов и даже покрупней, есть недорогие альтернативы VMM. А перешел на эти продукты как раз с Proxmox… Давным давно, когда трава была зеленее и забористей этот продукт реально был бесплатным, ну а потом как обычно, самое вкусное и другое сладенькое переложили в коробочки и закрыли замками, а ключики начали продавать за твердые и конвертируемые валюты. Можно зайти в раздел «Pricing» и увидеть волшебную строчку «All paying subscriptions come with exclusive access to the enterprise repository, stable updates and enhanced security.».

И насчет: «а в случае возникновения сбоев, решить проблему с этими системами собственными силами очень непросто». Тоже ересь несусветная, тот же Hyper-V имеет практически нулевое вхождение. Если он упал, или померло что-то, то с диска сервера нужно скопировать файлик с конфигом ВМ и файлик образа диска (если нет бэкапов). На новом сервере развернуть Hyper-V, это буквально занимает 5 минут если ставить чистый Hyper-V Server, подсунуть эти файлики, несколько строк в powershell и вуаля… 15-20 минут и все пашет! Ну если ставить граф.интерфейсы и вытягивать из бэкапов то немного подольше.

И предвидя вопросы по админству через вебморду а не через великий powershell. Мелкомягкие сделали бесплатный продукт Windows Admin Center, позволяющий рулить всеми серверами и их сервисами через вебморду, Hyper-V уже входит туда, и можно тычками мышки творить магию с вашими виртуальными машинами.

Sergey-S-Kovalev

Я просто никогда не обращал внимания на этот enterprise repository, для чего он нужен то?

Andrusha

Для получения апдейтов из стабильной ветки при наличии подписки. При отсутствии можно обновляться из тестового (заменить pve-enterprise на pve-no-subscription), но там, понятное дело, в теории может что-то сломаться.

vasilisc

Зачем людей в заблуждение вводите? Тестовый != без подписки

Есть платный Proxmox VE Enterprise Repository

deb enterprise.proxmox.com/debian/pve buster pve-enterprise

Без подписки Proxmox VE No-Subscription Repository

deb download.proxmox.com/debian/pve buster pve-no-subscription

Есть тестовый Proxmox VE Test Repository

deb download.proxmox.com/debian/pve buster pvetest

pve.proxmox.com/wiki/Package_Repositories

Andrusha

Пардон, не выспался после праздников :)

Darksa Автор

Спасибо за здравую критику и замечания. Полагаю, что это хороший повод обратить внимание на текущие преимущества и недостатки Hyper-V в связке с WAC.

Sergey-S-Kovalev

Ох, отхвачу минусов то, ну да ладно. Плата за минутку вспыльчивости :/

denaspireone

VMvare hypervizor — www.nakivo.com/blog/free-vmware-esxi-restrictions-limitations

слишком мало, потому мимоHyper-V — да бесплатен, но вроде как чисто core, без gui, вместо bash — powershell — если хочется кактусов, то можно и чистый KVM поставить, особой разницы кроме как большего кол-ва решений по вопросам на просторах интернета.

proxmox — свобода действий, да perl — но ведь не powershell

я бы посоветовал OpenNebula — но это тоже на любителя, правда kvaps чуть ли не профи, который даже чат в телеграме завел по ней для RU сегмента

Daar

Это да, если чисто на сервере работать. А так на любой винде (7 — 8 нужно скачать) а в 10 уже встроен Диспетчер Hyper-V, и можно мышкой в окошках все точить.

И да, насчет 10. Там уже встроен hyper-v сервер, можно на домашнем компе поднять виртуалку, а потом тем же методом переноса папочки перенести так сказать её в продакшн.

На OpenNebula смотрел когда её выкатили, но как-то в то время все показалось очень монструозно, насколько помню там на 1 сервере даже нельзя все развернуть, сразу все на «кластера» рассчитано. Не знаю как сейчас, может уже все красивее стало.

denaspireone

Но речь идет о сервере для работы компании/etc, по вашему совету, можно и virtualbox поставить. Это немного не тот случай, речь об enterprise сегменте интернета.

Andrusha

Sergey-S-Kovalev

Vasily_Pechersky

Вот тут и оно, когда смотришь цены на VMware с возможностями онлайн миграции, и больше трёх хостов… Тихонько спрашиваешь — за что десятки тысяч зелёных. А про гемор с бэкапом и цены на решения для этого… Когда в проксе всё встроено.

К тому же — цены на VMware v-san впечатляют даже бывалых, когда интерфейс управления ceph в проксе интегрирован.

Я администрирую кластеры Proxmox более 3х лет и могу сказать, что количество «проблем в год» между VMware и Proxmox примерно одинаковое…