Кроме того что я айтишник, я ещё и историк техники, и именно этим обусловлена моя реакция на новости об очередных достижениях в области цифровых технологий. Месяц назад я принял решение начать писать книжку для людей далёких от IT и близких к историческим исследованиям и источникам («Цифровое источниковедение — специфические проблемы» — пишется на сайтах книжных черновиков ), в которой расскажу им о том, чем для них обернулось развитие цифровых технологий.

Через пару дней после этого по интернету пронеслась новость « «Прибытие поезда» улучшили с помощью нейросетей — фильм 1896 года теперь можно посмотреть в 4K и 60 кадрах в секунду », и это хороший повод рассказать айтишникам о том же самом.

Исходного фильма «Прибытие поезда» у меня нет, поэтому в качестве тестовых образцов я использовал современные фотографии (уменьшенные или обесцвеченные) + фото из 1930-х (предположительно)

Проблема, о которой пойдёт речь, возникает из-за того, как именно работают реальные историки и нейросети.

В представлении обывателя, идеальный историк сидит исключительно в архивах и работает с официальными и хорошо сохранившимися документами. В реальности же, историки работают с теми источниками которые у них есть и в том виде в котором они к ним попали.

В реальности, кроме официальных документов в государственных архивах, в качестве источников могут выступать личные фотографии, письма, воспоминания и т. п. К сожалению, очень часто историки работают не с исходными документами, а с различными копиями.

Вы когда-нибудь слышали фразу о том, что различные иконы и тексты «дошли до нас в списках»? В данном случае, слово «список» означает не каталог в котором упомянуто какое-то произведение, а копию этого самого произведения. Происходит этот термин от слова «списать».

Многие из текстов, фотографий и фильмов дошли до нас именно в виде копий, и нет никакой гарантии, что единственной копией фильма «Семнадцать мгновений весны» дошедшей до историков будущего не окажется именно раскрашенная и кадрированная версия. Ибо пути исторического источника неисповедимы.

С другой стороны, существует множество новостей о том, что нейросеть что-то восстановила или улучшила. Это звучит как некая магия и у многих создаётся ощущение, что некий искусственный интеллект действительно может что-то восстановить.

На самом деле, ни о каком восстановлении цвета или деталей на маленьких картинках речи не идёт и идти не может. Программа просто добавляет в фото или видео элементы, которые её алгоритмы определяют как подходящие.

К сожалению, в реальности невозможно восстановить утраченное изображение, потому что операция обесцвечивания необратима, а если на какой-то фотографии нет части изображения, то его нельзя восстановить лишь на основании этой же фотографии.

Поэтому нейросети делают ровно то же самое, что делают в таких случаях люди — фантазируют на основании имеющегося у них опыта.

И сейчас я покажу, то что получается в результате этих фантазий.

Хотя раскрашивание фотографий и фильмов не является совсем уж новым явлением, сейчас оно доступно всем, у кого есть доступ в интернет, и многие люди пользуются новой возможностью.

Мы уже живём в мире, где существует много раскрашенных фотографий солдат Великой отечественной войны, интерьеров «Титаника», царской семьи и многих других.

Непосвящённому человеку может показаться, что речь идёт именно о восстановлении исходного цвета, и что колоризованная фотография показывает нам то, как на самом деле выглядели люди и предметы столетней давности. Кто-нибудь на основании этих фотографий может начать делать выводы о жизни людей в прошлом, анализировать различные события и ситуации.

И хотя я понимаю невозможность восстановления реального цвета с чёрно-белой фотографии, как исследователь я обязан проверить и убедиться в собственной правоте.

Для проверки этой идеи я взял две современные цветные фотографии, обесцветил их в графическом редакторе и прогнал через онлайн-сервисы колоризации.

В данном случае была использована фотография, сделанная мной в конце января 2020 года в московском аэропорту «Домодедово». Я не знаю, насколько раскраска этих автомобилей соответствует их первоначальному цвету, но это не важно. В данном эксперименте мы проверяем то, насколько точно будет восстановлен цвет обесцвеченной фотографии.

Я провёл этот опыт на фотографиях разных автомобилей и результат неизменен: все сервисы раскрашивают реальные автомобили по-разному, но правильно не раскрашивает никто.

При этом лично мне больше нравится не оригинальный вариант, а результат раскрашивания от deepai.org – спокойный цвет кузова с синими боковинами крыши. (А вот в этом варианте исходный цвет показан в полосках под номерами 2 и 7, но мне больше нравится полоска 5, раскрашенная algorithmia.com, где часть раскрашена жёлтым, а часть — красным).

Проблема с раскрашиванием автомобилей объясняется очень просто — данными, заложенными в каждую нейросеть. И точно так же, как при ручном раскрашивании, автоматическое раскрашивание говорит именно о том, на основании какого опыта производилось раскрашивание.

То есть, ни о каком восстановлении исходного цвета речи не идёт и идти не может.

Конечно же, найдутся люди которые скажут, что в нейросеть надо загрузить ещё больше фотографий и тогда всё будет хорошо, но это противоречит самому принципу работы нейросетей — они просто усредняют загруженные в них данные и не способны выйти за рамки полученного таким образом «опыта».

Следующий эксперимент был поставлен с фотографией, на которой показана архитектура и много людей в цветной одежде. Исходная фотография была кадрирована, обесцвечена и загружена в сервисы для колоризации.

Из-за большого количества раскрашиваемых объектов результат не столь однозначный, как было в случае с раскрашиванием Ford A Phaeton.

Да, ни один из сервисов не раскрасил статуи в золотистый цвет, красные тюльпаны в нижней части снимка, и ярко зелёную и ярко синюю футболки. Однако все сервисы блестяще справились с раскрашиванием белой футболки мужчины сидящего на парапете фонтана и белой блузки женщины идущей справа налево с сумочкой на боку.

Таким образом, мы снова имеем вполне предсказуемый результат — сервисы колоризации не способны восстановить реальный цвет.

Но польза этого примера не в том, чтобы ещё раз повторить очевидный факт. Конечно, повторять очевидные факты — это нужно и очень правильно, но есть ещё один момент.

Кроме раскрашивания, сервис 9may.mail.ru проводит операцию «устранение дефектов». Если сравнить просто раскрашенную фотографию и раскрашенную фотографию, с которой были удалены дефекты, то обнаружится очень интересная особенность.

На данной иллюстрации показан увеличенный фрагмент правого края фотографии с фонтаном. Как хорошо видно, при «устранении дефектов», был удалён скульптурный элемент (я не возьму на себя смелость сказать его название :) )

Подобные же «устранения дефектов» были замечены и на других фотографиях, колоризованных сервисом 9may.mail.ru, но там это были не настолько большие удаления.

Таким образом, исторический источник был не только неправильно раскрашен, а ещё и имеет «потёртости», уничтожившие часть изображения (что снова возвращает нас к вопросу о «Цифровом износе» )

Этот пример позволяет плавно перейти к следующей части рассказа о влиянии «улучшения» фотографий нейросетями на исторические источники.

Так же как и раскрашивание, увеличение фотографий существовало и в доцифровую эпоху.

Результат для обоих случаев один, мы начинаем видеть минимальный элемент фотографии. В аналоговой фотографии это было «зерно», сейчас его место занял «пиксель», но суть у них одна — это минимальный неделимый элемент (очень хочется сказать «атомарный», но несмотря на своё название — атом не неделим :) )

Если мы смотрим на шахматную доску в увеличивающий оптический прибор (телескоп, бинокль и т. п.), то мы можем «приблизить» её и разглядеть детали, которые раньше были не видны.

Но если мы сфотографировали шахматную доску, так, что она уместилась в одно зерно/пиксель, то не существует возможности «приблизить» и разглядеть каждую клетку в отдельности. При увеличении такого снимка мы будем видеть большое одноцветное пятно там, где должна быть шахматная доска.

Ровно та же ситуация будет, если мы изменим пиксельный размер цифровой фотографии шахматной доски — информация о клетках на доске будет потеряна, и не существует никакой возможности восстановить её лишь на основании этой же фотографии.

Вообще, я испытываю неловкость, говоря эту банальную идею, но, как показывает практика, мысль о необратимости уменьшения цифровой фотографии очевидна не для всех.

Периодически появляются новости о том, что какая-то нейросеть увеличила и улучшила старую фотографию, так что теперь мы можем увидеть детали, которые раньше видеть не могли.

Так же как в случае с раскрашиванием, я попытался применить онлайн-сервисы к реальным фотографиям.

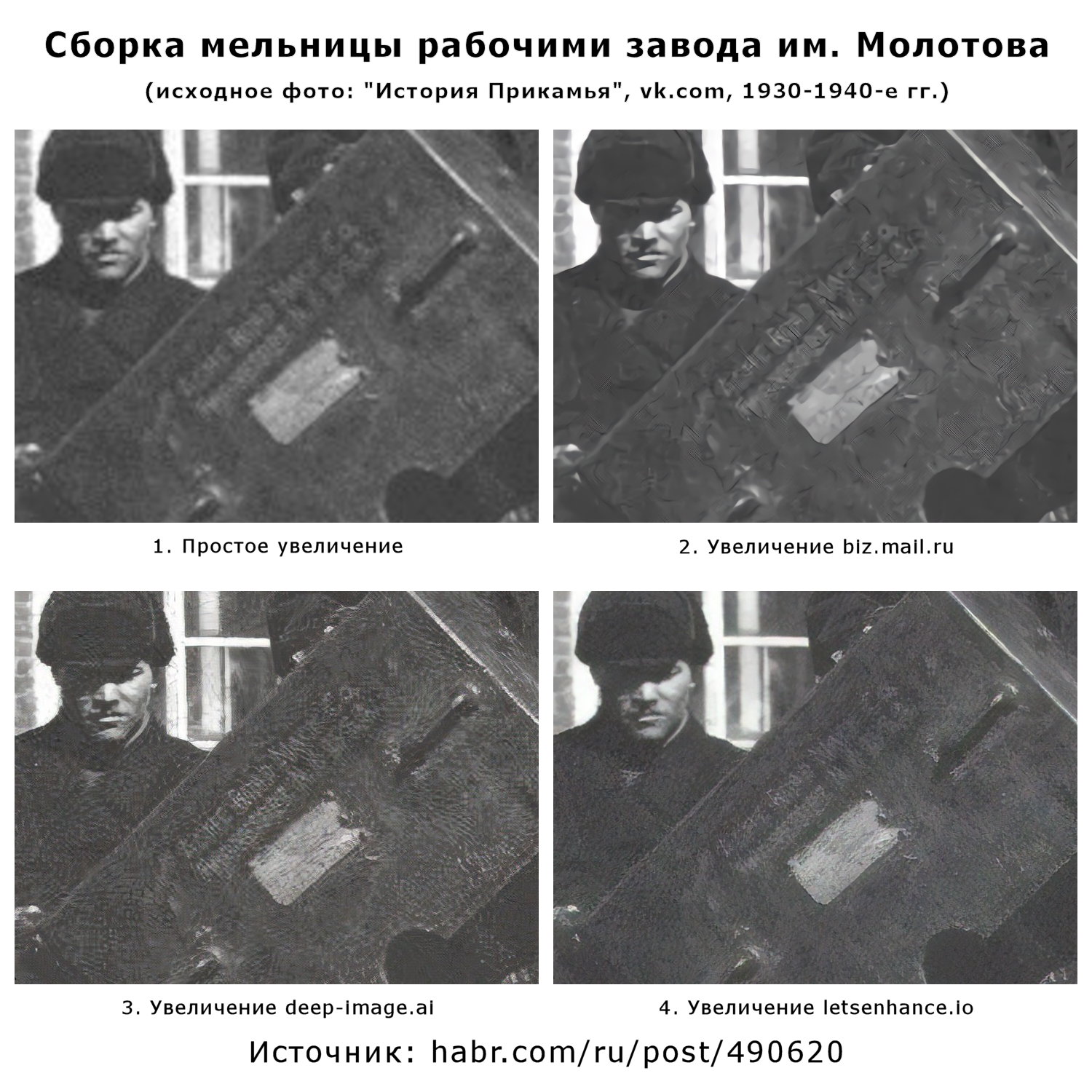

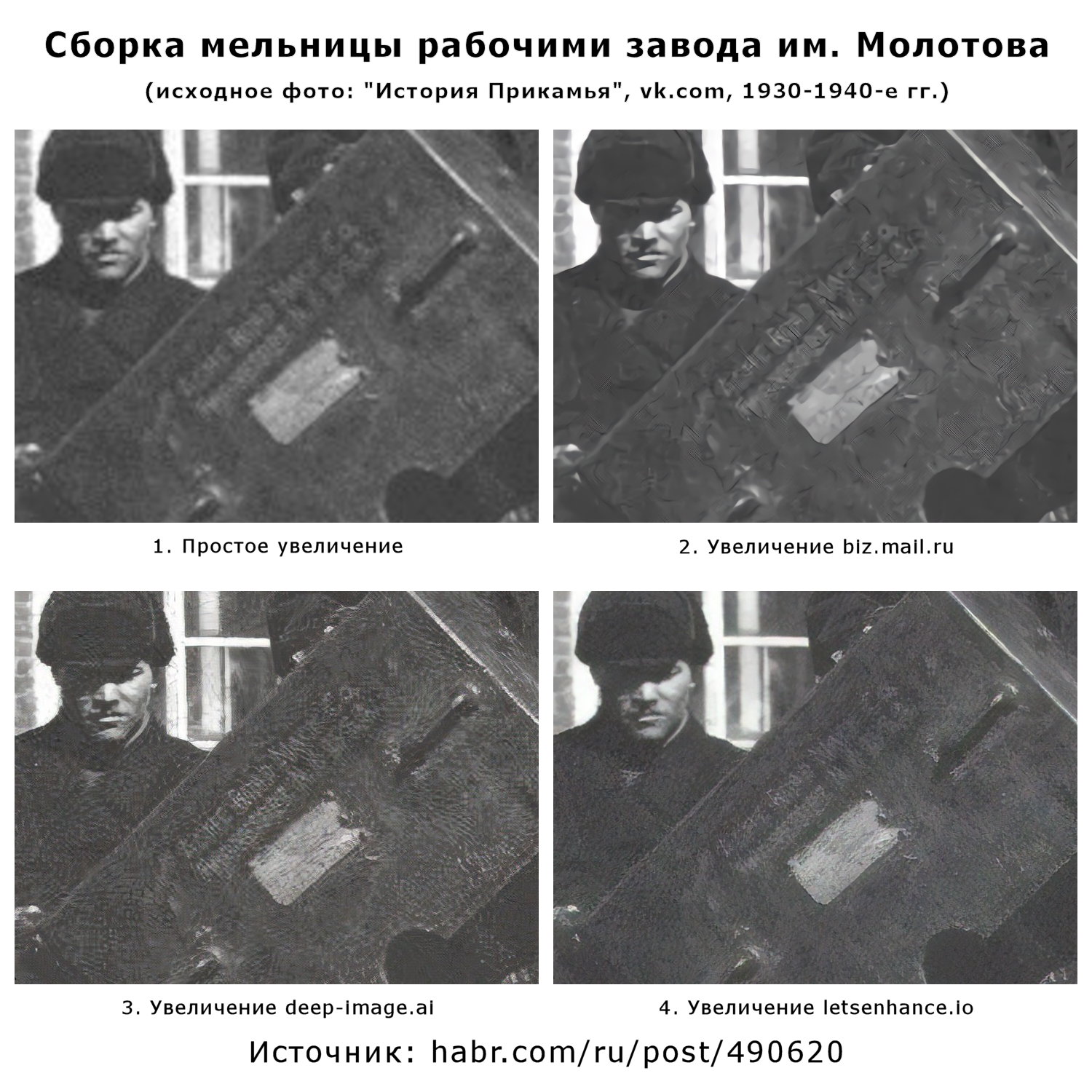

Однажды, в субботу вечером, коллега прислал мне ссылку на фотографию на странице Пермского Госархива в Вконтакте. 1024 на 705 пикселей несколько раз прошедших JPEG-сжатие, с плохо читаемой надписью.

Мы отлично провели время, разгадали эту загадку и в понедельник он подтвердил наши выводы сходив в архив и изучив оригинал фотографии.

Это позволило мне провести эксперимент и посмотреть на что способны нейросети

В результате, самым читаемым оказался вариант «простое увеличение» (вообще, я прочитал эту надпись просто увеличив её на экране смартфона).

biz.mail.ru сделал надпись нечитаемой при большом масштабировании, но строчка «Acme Road Mach Co» остаётся частично читаемой при определённом масштабе.

Остальные претенденты зашумили картинку настолько, что надпись перестала читаться вообще. Хотя и осталась частично узнаваемой.

То есть сервисы для «улучшения фотографий» сделали прямо противоположное — ухудшили реальную фотографию.

И если вы скажете, что улучшение надписей на старых фотографиях не является задачей для таких сервисов, то я соглашусь, ибо именно в этом и состоит проблема. Дело в том, что эти сервисы есть, они позиционируются как сервисы для «реставрации» и «восстановления», не объясняя пользователям риски и последствия, связанные с используемой технологией. Люди, изучающие историю своей семьи или своего населённого пункта, могут подвергать «улучшению» имеющиеся у них цифровые фотографии.

И у меня есть большие сомнения в том, что все они будут заботливо хранить исходную неулучшенную фотографию.

У меня есть ещё один пример, связанный с пермским архивом и атрибутированием фотографий, но он будет в следующем обновлении «Цифрового источниковедения», а сейчас я предпочту вернуться к машинам, сфотографированным мной в «Домодедово».

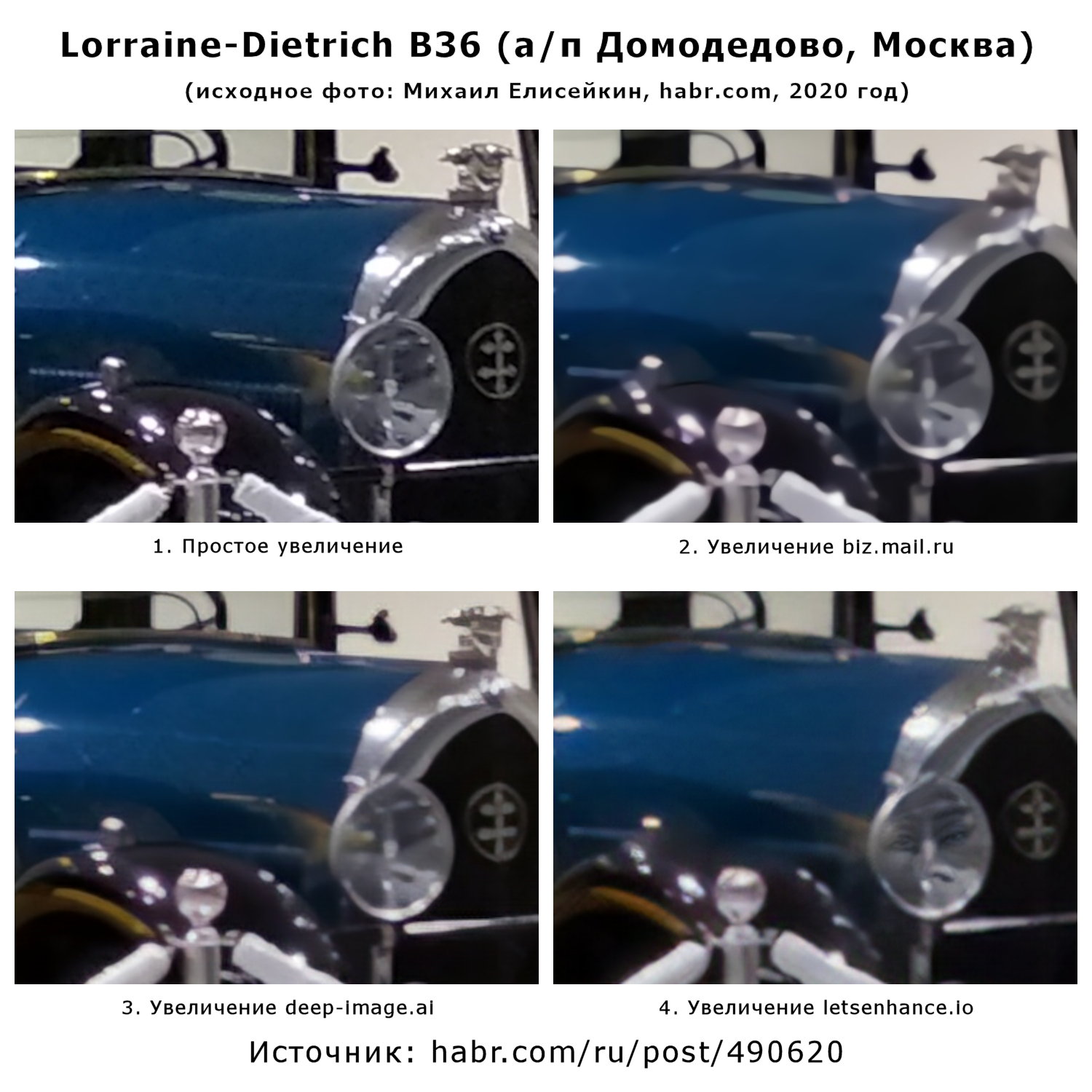

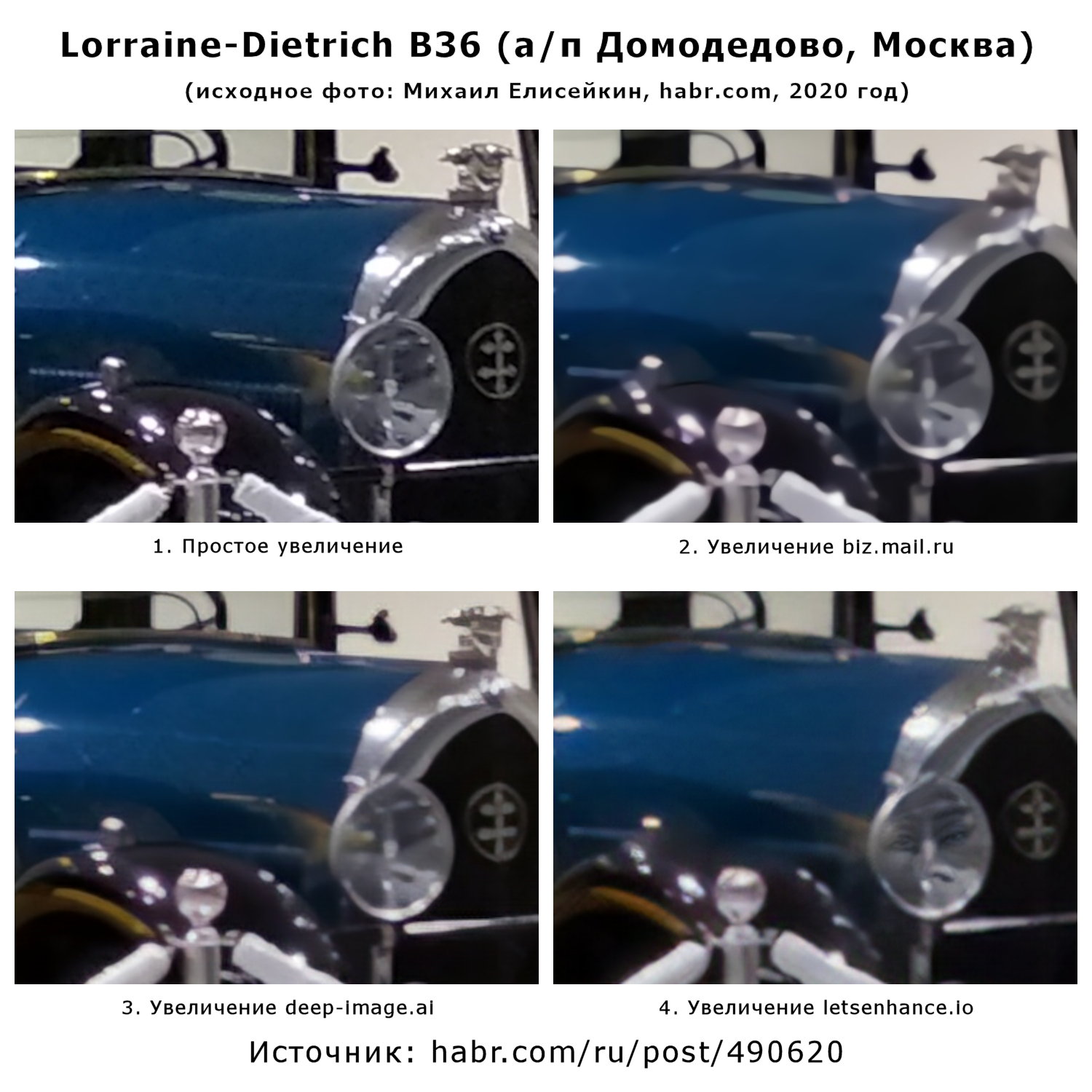

Для проверки возможностей по увеличению фотографий, я взял одну из своих фотографий, уменьшил пиксельный размер с 4000 на 3000 до 1024 на 768, и прогнал через те же сервисы что и в случае с фотографией мельницы из предыдущего примера.

И если обычный зритель таких «улучшенных» картинок не особо в них вглядывается, то меня интересовали мелкие детали.

Результат оказался предсказуем.

Логотип на решётке радиатора узнаваем, но искажён — линии стали ровными.

Боковые отверстия для вентиляции разгладились и не отличимы от бликов на капоте.

Вполне ожидаемо пропали многие мелкие детали, но этот пример здесь совсем не для того, чтобы в очередной раз подтвердить идею о необратимости потери информации с цифровой фотографии при уменьшении её пиксельного размера.

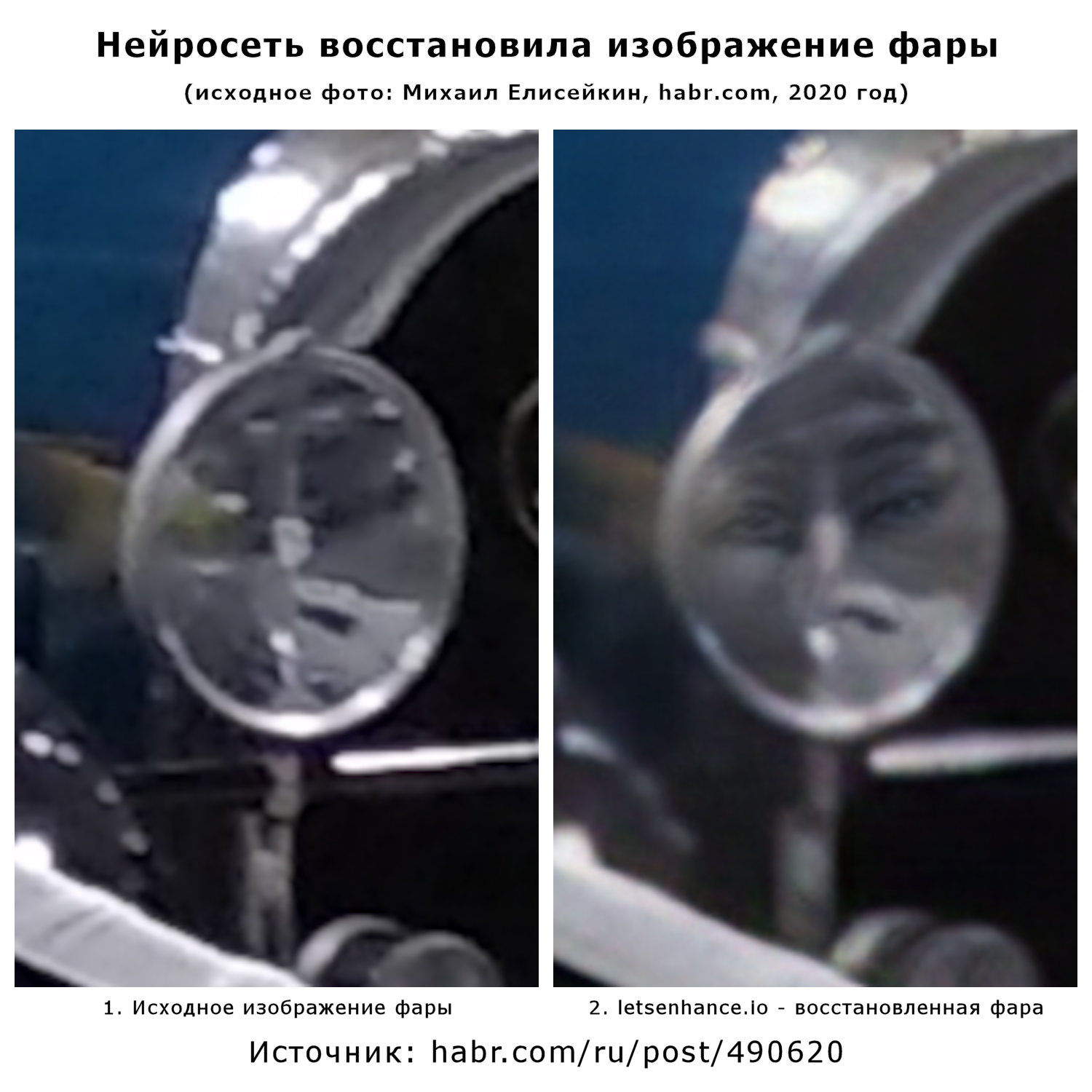

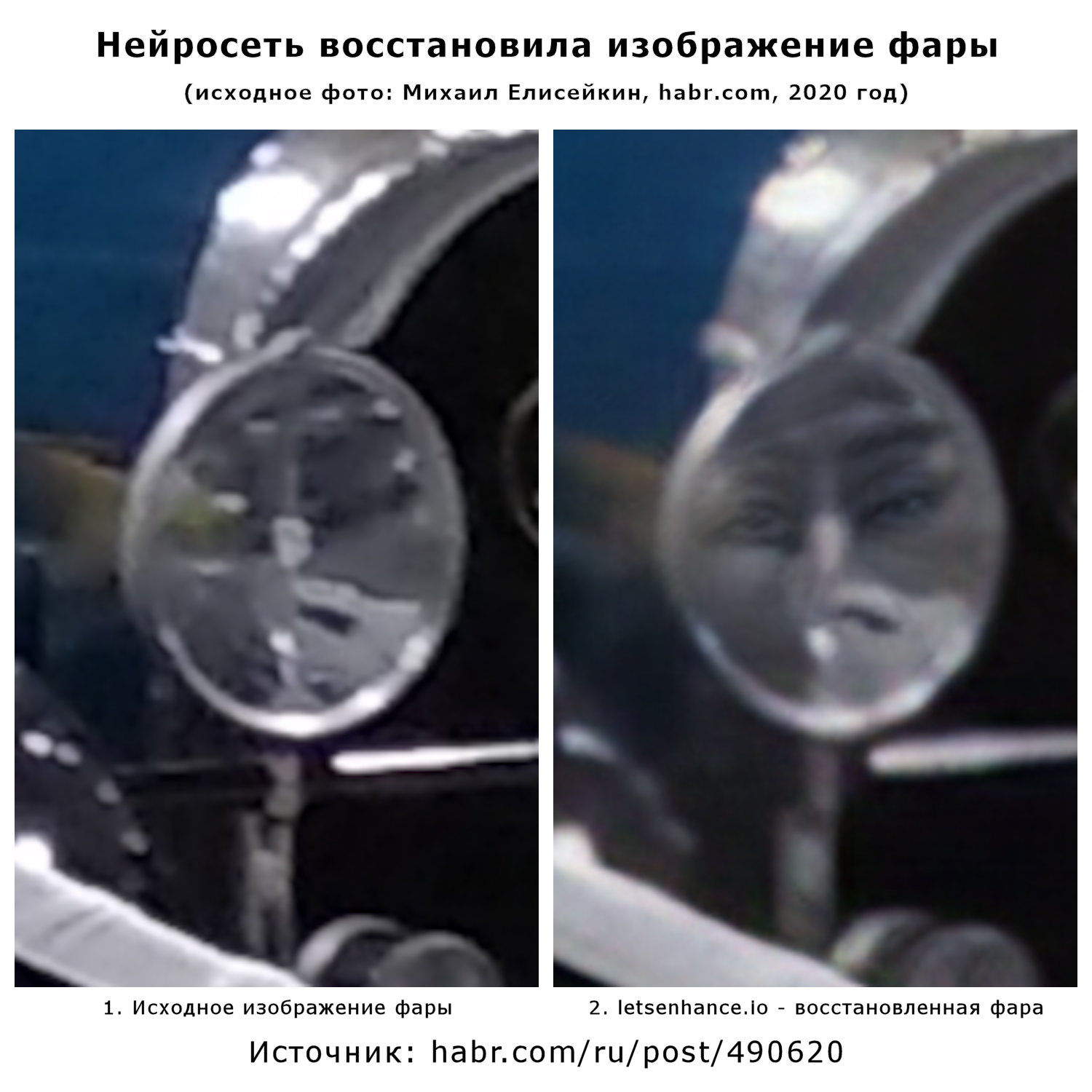

Если вы внимательно смотрели на фотографии, то уже увидели признаки того, что тут поработала нейросеть.

Тут самое время напомнить о том, как работают нейросети — подбирает подходящие варианты из собственного «опыта», полученного в результате обучения.

И сейчас я покажу, как именно letsenhance.io увеличил в 4 раза фотографию, которую я предварительно уменьшил в 4 раза.

Слева вы видите исходную фотографию до уменьшения, справа — полученную после увеличения. (Промежуточная уменьшенная фотография не показана)

Да, всё верно — это морда обезьяны.

И если вы видите в этом забавный случай, проблему обучения нейросети или её нецелевого использования, то я вижу совсем иное. А именно, огромное множество цифровых фотографий, которые были и будут «улучшены» нейросетью и попадут в оборот. Часть из них заменит собой оригиналы в силу их утраты.

И если до начала написания этой статьи я просто осознавал проблемы, связанные с модой на улучшение/восстановление изображений с помощью нейросетей, то теперь эта проблема обрела своё конкретное лицо.

Но и это ещё не конец истории.

Для того, чтобы получить кино, мало иметь одну большую и красочную картинку. Таких картинок должно быть много и они должны очень быстро сменять друг друга.

Одним из направлений по улучшению фильмов является повышение скорости, с которой эти картинки сменяют друг друга. Или, как это правильно называть, «увеличение частоты кадров».

И в этом случае, так же, нет ничего нового. Точно так же как в случае с обесцвечиванием и уменьшением пиксельного размера, не существует никакой возможности получить информацию о том, что было между кадрами.

Можно предположить, как двигался предмет в кадре и дорисовать его на вновь добавленных кадрах, но, как и в случае с колоризацией и увеличением, это будет именно дорисовывание новых деталей, а не восстановление того что было на самом деле.

Лучше всего это иллюстрирует кадр из демонстрационного ролика нейросети DAIN. (Судя по описанию к упомянутому ранее ролику «Прибытие поезда», именно эта нейросеть была использована его авторами для увеличения частоты кадров)

Тут приведено сравнение 3 вариантов повышения частоты кадров с 12 fps до 24 fps.

Верхний левый кадр — исходное видео.

Нижний правый — результат работы DAIN

Оставшиеся два — решения с которыми себя сравнивают создатели DAIN

Как видно, во всех трёх вариантах повышения частоты кадров, речь идёт попытке найти среднее состояние между двумя кадрами. Не смотря на то, что вариант DAIN (нижний правый кадр) выглядит более чётким, чем варианты SepConv и ToFlow, в нём всё равно видно как размазалась майка на спине и голова.

И даже когда технологии продвинутся вперёд и таких размазываний не станет, это не изменит ситуации с тем, что восстановить происходившее между кадрами невозможно, и всё что нам остаётся — дорисовывать некое усреднённое состояние.

Как айтишник, я понимаю, что данные технологии не предназначены для корректного сохранения цифровых источников. Нейросети нужны для того, чтобы произвести красивый и легко проскальзываемый контент.

Поэтому, фильмы раскрашиваются, кадрируются и им повышают частоту кадров.

Это просто шоу-бизнес, и авторов технологии не должно заботить то как пользователи используют их разработку.

Но, как историк, я вижу результаты использования этих технологий. Рост числа «улучшенных нейросетями» фотографий и фильмов приведёт к попаданию их в материалы используемые как исторические источники в различных исследованиях. Сопутствующие явления будут приводить к вымыванию старых вариантов файлов и превращению «улучшенных» копий в единственно доступные (привет, «Цифровой износ»).

Остановить этот процесс нельзя, но можно вырабатывать подходы позволяющие минимизировать ущерб. Собственно, этому и посвящена книга про цифровое источниковедение, и направлена она именно на моих коллег по историческому цеху, а не на специалистов IT-отрасли.

Хотя, есть способ доступный всем людям, независимо от профессии — перестать называть процесс создания легкоусвояемого медийного контента словами «восстановление» и «реставрация», чтобы не создавать у непосвящённых ложного впечатления о сути этого процесса и получаемого в результате продукта.

Для этого есть другое слово:

(выделение болдом — моё).

Энциклопедический словарь Брокгауза и Ефрона: Том XXVIА, стр. 624

Опубликовано в ТЫСЯЧА ВОСЕМЬСОТ ДЕВЯНОСТО ДЕВЯТОМ году.

Как видим, эта проблема известна не первое тысячелетие и была актуальна уже во времена появления оригинального фильма «Прибытие поезда».

Через пару дней после этого по интернету пронеслась новость « «Прибытие поезда» улучшили с помощью нейросетей — фильм 1896 года теперь можно посмотреть в 4K и 60 кадрах в секунду », и это хороший повод рассказать айтишникам о том же самом.

Исходного фильма «Прибытие поезда» у меня нет, поэтому в качестве тестовых образцов я использовал современные фотографии (уменьшенные или обесцвеченные) + фото из 1930-х (предположительно)

0. В чём проблема?

Проблема, о которой пойдёт речь, возникает из-за того, как именно работают реальные историки и нейросети.

В представлении обывателя, идеальный историк сидит исключительно в архивах и работает с официальными и хорошо сохранившимися документами. В реальности же, историки работают с теми источниками которые у них есть и в том виде в котором они к ним попали.

В реальности, кроме официальных документов в государственных архивах, в качестве источников могут выступать личные фотографии, письма, воспоминания и т. п. К сожалению, очень часто историки работают не с исходными документами, а с различными копиями.

Вы когда-нибудь слышали фразу о том, что различные иконы и тексты «дошли до нас в списках»? В данном случае, слово «список» означает не каталог в котором упомянуто какое-то произведение, а копию этого самого произведения. Происходит этот термин от слова «списать».

Многие из текстов, фотографий и фильмов дошли до нас именно в виде копий, и нет никакой гарантии, что единственной копией фильма «Семнадцать мгновений весны» дошедшей до историков будущего не окажется именно раскрашенная и кадрированная версия. Ибо пути исторического источника неисповедимы.

С другой стороны, существует множество новостей о том, что нейросеть что-то восстановила или улучшила. Это звучит как некая магия и у многих создаётся ощущение, что некий искусственный интеллект действительно может что-то восстановить.

На самом деле, ни о каком восстановлении цвета или деталей на маленьких картинках речи не идёт и идти не может. Программа просто добавляет в фото или видео элементы, которые её алгоритмы определяют как подходящие.

К сожалению, в реальности невозможно восстановить утраченное изображение, потому что операция обесцвечивания необратима, а если на какой-то фотографии нет части изображения, то его нельзя восстановить лишь на основании этой же фотографии.

Поэтому нейросети делают ровно то же самое, что делают в таких случаях люди — фантазируют на основании имеющегося у них опыта.

И сейчас я покажу, то что получается в результате этих фантазий.

1. Сравнение разных сервисов колоризации

Хотя раскрашивание фотографий и фильмов не является совсем уж новым явлением, сейчас оно доступно всем, у кого есть доступ в интернет, и многие люди пользуются новой возможностью.

Мы уже живём в мире, где существует много раскрашенных фотографий солдат Великой отечественной войны, интерьеров «Титаника», царской семьи и многих других.

Непосвящённому человеку может показаться, что речь идёт именно о восстановлении исходного цвета, и что колоризованная фотография показывает нам то, как на самом деле выглядели люди и предметы столетней давности. Кто-нибудь на основании этих фотографий может начать делать выводы о жизни людей в прошлом, анализировать различные события и ситуации.

И хотя я понимаю невозможность восстановления реального цвета с чёрно-белой фотографии, как исследователь я обязан проверить и убедиться в собственной правоте.

Для проверки этой идеи я взял две современные цветные фотографии, обесцветил их в графическом редакторе и прогнал через онлайн-сервисы колоризации.

1.1 Колоризация автомобиля Ford A Phaeton

В данном случае была использована фотография, сделанная мной в конце января 2020 года в московском аэропорту «Домодедово». Я не знаю, насколько раскраска этих автомобилей соответствует их первоначальному цвету, но это не важно. В данном эксперименте мы проверяем то, насколько точно будет восстановлен цвет обесцвеченной фотографии.

Я провёл этот опыт на фотографиях разных автомобилей и результат неизменен: все сервисы раскрашивают реальные автомобили по-разному, но правильно не раскрашивает никто.

При этом лично мне больше нравится не оригинальный вариант, а результат раскрашивания от deepai.org – спокойный цвет кузова с синими боковинами крыши. (А вот в этом варианте исходный цвет показан в полосках под номерами 2 и 7, но мне больше нравится полоска 5, раскрашенная algorithmia.com, где часть раскрашена жёлтым, а часть — красным).

Проблема с раскрашиванием автомобилей объясняется очень просто — данными, заложенными в каждую нейросеть. И точно так же, как при ручном раскрашивании, автоматическое раскрашивание говорит именно о том, на основании какого опыта производилось раскрашивание.

То есть, ни о каком восстановлении исходного цвета речи не идёт и идти не может.

Конечно же, найдутся люди которые скажут, что в нейросеть надо загрузить ещё больше фотографий и тогда всё будет хорошо, но это противоречит самому принципу работы нейросетей — они просто усредняют загруженные в них данные и не способны выйти за рамки полученного таким образом «опыта».

1.2 Колоризация фонтана на ВДНХ

Следующий эксперимент был поставлен с фотографией, на которой показана архитектура и много людей в цветной одежде. Исходная фотография была кадрирована, обесцвечена и загружена в сервисы для колоризации.

Из-за большого количества раскрашиваемых объектов результат не столь однозначный, как было в случае с раскрашиванием Ford A Phaeton.

Да, ни один из сервисов не раскрасил статуи в золотистый цвет, красные тюльпаны в нижней части снимка, и ярко зелёную и ярко синюю футболки. Однако все сервисы блестяще справились с раскрашиванием белой футболки мужчины сидящего на парапете фонтана и белой блузки женщины идущей справа налево с сумочкой на боку.

Таким образом, мы снова имеем вполне предсказуемый результат — сервисы колоризации не способны восстановить реальный цвет.

Но польза этого примера не в том, чтобы ещё раз повторить очевидный факт. Конечно, повторять очевидные факты — это нужно и очень правильно, но есть ещё один момент.

Бонус от 9may.mail.ru

Кроме раскрашивания, сервис 9may.mail.ru проводит операцию «устранение дефектов». Если сравнить просто раскрашенную фотографию и раскрашенную фотографию, с которой были удалены дефекты, то обнаружится очень интересная особенность.

На данной иллюстрации показан увеличенный фрагмент правого края фотографии с фонтаном. Как хорошо видно, при «устранении дефектов», был удалён скульптурный элемент (я не возьму на себя смелость сказать его название :) )

Подобные же «устранения дефектов» были замечены и на других фотографиях, колоризованных сервисом 9may.mail.ru, но там это были не настолько большие удаления.

Таким образом, исторический источник был не только неправильно раскрашен, а ещё и имеет «потёртости», уничтожившие часть изображения (что снова возвращает нас к вопросу о «Цифровом износе» )

Этот пример позволяет плавно перейти к следующей части рассказа о влиянии «улучшения» фотографий нейросетями на исторические источники.

2. Увеличение размера фотографии

Так же как и раскрашивание, увеличение фотографий существовало и в доцифровую эпоху.

Результат для обоих случаев один, мы начинаем видеть минимальный элемент фотографии. В аналоговой фотографии это было «зерно», сейчас его место занял «пиксель», но суть у них одна — это минимальный неделимый элемент (очень хочется сказать «атомарный», но несмотря на своё название — атом не неделим :) )

Если мы смотрим на шахматную доску в увеличивающий оптический прибор (телескоп, бинокль и т. п.), то мы можем «приблизить» её и разглядеть детали, которые раньше были не видны.

Но если мы сфотографировали шахматную доску, так, что она уместилась в одно зерно/пиксель, то не существует возможности «приблизить» и разглядеть каждую клетку в отдельности. При увеличении такого снимка мы будем видеть большое одноцветное пятно там, где должна быть шахматная доска.

Ровно та же ситуация будет, если мы изменим пиксельный размер цифровой фотографии шахматной доски — информация о клетках на доске будет потеряна, и не существует никакой возможности восстановить её лишь на основании этой же фотографии.

Вообще, я испытываю неловкость, говоря эту банальную идею, но, как показывает практика, мысль о необратимости уменьшения цифровой фотографии очевидна не для всех.

Периодически появляются новости о том, что какая-то нейросеть увеличила и улучшила старую фотографию, так что теперь мы можем увидеть детали, которые раньше видеть не могли.

Так же как в случае с раскрашиванием, я попытался применить онлайн-сервисы к реальным фотографиям.

2.1 Неизвестная мельница из 1930-х

Однажды, в субботу вечером, коллега прислал мне ссылку на фотографию на странице Пермского Госархива в Вконтакте. 1024 на 705 пикселей несколько раз прошедших JPEG-сжатие, с плохо читаемой надписью.

Мы отлично провели время, разгадали эту загадку и в понедельник он подтвердил наши выводы сходив в архив и изучив оригинал фотографии.

Это позволило мне провести эксперимент и посмотреть на что способны нейросети

В результате, самым читаемым оказался вариант «простое увеличение» (вообще, я прочитал эту надпись просто увеличив её на экране смартфона).

biz.mail.ru сделал надпись нечитаемой при большом масштабировании, но строчка «Acme Road Mach Co» остаётся частично читаемой при определённом масштабе.

Остальные претенденты зашумили картинку настолько, что надпись перестала читаться вообще. Хотя и осталась частично узнаваемой.

То есть сервисы для «улучшения фотографий» сделали прямо противоположное — ухудшили реальную фотографию.

И если вы скажете, что улучшение надписей на старых фотографиях не является задачей для таких сервисов, то я соглашусь, ибо именно в этом и состоит проблема. Дело в том, что эти сервисы есть, они позиционируются как сервисы для «реставрации» и «восстановления», не объясняя пользователям риски и последствия, связанные с используемой технологией. Люди, изучающие историю своей семьи или своего населённого пункта, могут подвергать «улучшению» имеющиеся у них цифровые фотографии.

И у меня есть большие сомнения в том, что все они будут заботливо хранить исходную неулучшенную фотографию.

У меня есть ещё один пример, связанный с пермским архивом и атрибутированием фотографий, но он будет в следующем обновлении «Цифрового источниковедения», а сейчас я предпочту вернуться к машинам, сфотографированным мной в «Домодедово».

2.2 Капот Lorraine-Dietrich B36

Для проверки возможностей по увеличению фотографий, я взял одну из своих фотографий, уменьшил пиксельный размер с 4000 на 3000 до 1024 на 768, и прогнал через те же сервисы что и в случае с фотографией мельницы из предыдущего примера.

И если обычный зритель таких «улучшенных» картинок не особо в них вглядывается, то меня интересовали мелкие детали.

Результат оказался предсказуем.

Логотип на решётке радиатора узнаваем, но искажён — линии стали ровными.

Боковые отверстия для вентиляции разгладились и не отличимы от бликов на капоте.

Вполне ожидаемо пропали многие мелкие детали, но этот пример здесь совсем не для того, чтобы в очередной раз подтвердить идею о необратимости потери информации с цифровой фотографии при уменьшении её пиксельного размера.

Если вы внимательно смотрели на фотографии, то уже увидели признаки того, что тут поработала нейросеть.

Бонус от letsenhance.io

Тут самое время напомнить о том, как работают нейросети — подбирает подходящие варианты из собственного «опыта», полученного в результате обучения.

И сейчас я покажу, как именно letsenhance.io увеличил в 4 раза фотографию, которую я предварительно уменьшил в 4 раза.

Слева вы видите исходную фотографию до уменьшения, справа — полученную после увеличения. (Промежуточная уменьшенная фотография не показана)

Да, всё верно — это морда обезьяны.

И если вы видите в этом забавный случай, проблему обучения нейросети или её нецелевого использования, то я вижу совсем иное. А именно, огромное множество цифровых фотографий, которые были и будут «улучшены» нейросетью и попадут в оборот. Часть из них заменит собой оригиналы в силу их утраты.

И если до начала написания этой статьи я просто осознавал проблемы, связанные с модой на улучшение/восстановление изображений с помощью нейросетей, то теперь эта проблема обрела своё конкретное лицо.

Но и это ещё не конец истории.

3. Увеличение числа кадров в видео

Для того, чтобы получить кино, мало иметь одну большую и красочную картинку. Таких картинок должно быть много и они должны очень быстро сменять друг друга.

Одним из направлений по улучшению фильмов является повышение скорости, с которой эти картинки сменяют друг друга. Или, как это правильно называть, «увеличение частоты кадров».

И в этом случае, так же, нет ничего нового. Точно так же как в случае с обесцвечиванием и уменьшением пиксельного размера, не существует никакой возможности получить информацию о том, что было между кадрами.

Можно предположить, как двигался предмет в кадре и дорисовать его на вновь добавленных кадрах, но, как и в случае с колоризацией и увеличением, это будет именно дорисовывание новых деталей, а не восстановление того что было на самом деле.

Лучше всего это иллюстрирует кадр из демонстрационного ролика нейросети DAIN. (Судя по описанию к упомянутому ранее ролику «Прибытие поезда», именно эта нейросеть была использована его авторами для увеличения частоты кадров)

Тут приведено сравнение 3 вариантов повышения частоты кадров с 12 fps до 24 fps.

Верхний левый кадр — исходное видео.

Нижний правый — результат работы DAIN

Оставшиеся два — решения с которыми себя сравнивают создатели DAIN

Как видно, во всех трёх вариантах повышения частоты кадров, речь идёт попытке найти среднее состояние между двумя кадрами. Не смотря на то, что вариант DAIN (нижний правый кадр) выглядит более чётким, чем варианты SepConv и ToFlow, в нём всё равно видно как размазалась майка на спине и голова.

И даже когда технологии продвинутся вперёд и таких размазываний не станет, это не изменит ситуации с тем, что восстановить происходившее между кадрами невозможно, и всё что нам остаётся — дорисовывать некое усреднённое состояние.

Вывод

Как айтишник, я понимаю, что данные технологии не предназначены для корректного сохранения цифровых источников. Нейросети нужны для того, чтобы произвести красивый и легко проскальзываемый контент.

Поэтому, фильмы раскрашиваются, кадрируются и им повышают частоту кадров.

Это просто шоу-бизнес, и авторов технологии не должно заботить то как пользователи используют их разработку.

Но, как историк, я вижу результаты использования этих технологий. Рост числа «улучшенных нейросетями» фотографий и фильмов приведёт к попаданию их в материалы используемые как исторические источники в различных исследованиях. Сопутствующие явления будут приводить к вымыванию старых вариантов файлов и превращению «улучшенных» копий в единственно доступные (привет, «Цифровой износ»).

Остановить этот процесс нельзя, но можно вырабатывать подходы позволяющие минимизировать ущерб. Собственно, этому и посвящена книга про цифровое источниковедение, и направлена она именно на моих коллег по историческому цеху, а не на специалистов IT-отрасли.

Хотя, есть способ доступный всем людям, независимо от профессии — перестать называть процесс создания легкоусвояемого медийного контента словами «восстановление» и «реставрация», чтобы не создавать у непосвящённых ложного впечатления о сути этого процесса и получаемого в результате продукта.

Для этого есть другое слово:

Ретуширование или ретушь фотографических позитивов и негативов — имеет целью уничтожение некоторых их недостатков, в особенности пятен и резких теней на портретах и различных царапин и точек, происшедших от пыли и других случайностей фотографических процессов. В руках фотографов-промышленников, в особенности при снимании портретов, Р. обратилась в средство угождать различным мелочным требованиям публики (например, для уничтожения морщин лица); но кроме того, Р. имеет в своей основе и вполне, так сказать, законные требования глаза и впечатления. Дело в том, что наиболее распространенные на практике способы фотографирования на обыкновенных (не ортохроматических) пластинках передают снимаемый предмет с распределением ярких и темных его оттенков, значительно отличным от того, которое представляется глазу. В то время как глаз наиболее чувствителен к желтым, красновато-желтым и желто-зеленым лучам — фотографический слой обыкновенной негативной пластинки к ним почти нечувствителен, наиболее сильно изменяясь под влиянием синих и фиолетовых лучей (см. Ортохроматическая фотография). Вследствие этого почти незаметные для глаза и сливающиеся с общим световым фоном лица небольшие желтоватые пятнышки выходят на фотографии почти черными, а синеватые отливы кожи, часто оттеняющие лицевые очертания, совершенно пропадают, передаваясь на снимки гораздо более светлыми. Если бы Р. ограничивалась исправлением только этой дисгармонии, то роль ее следовало бы признать весьма желательной и полезной.

(выделение болдом — моё).

Энциклопедический словарь Брокгауза и Ефрона: Том XXVIА, стр. 624

Опубликовано в ТЫСЯЧА ВОСЕМЬСОТ ДЕВЯНОСТО ДЕВЯТОМ году.

Как видим, эта проблема известна не первое тысячелетие и была актуальна уже во времена появления оригинального фильма «Прибытие поезда».

Alcpp

Спасибо за статью, но что-то мне подсказывает, что ЧБ на тогдашней фотографии и ЧБ в фотошопе дадут разный результат.

Плюс со временем часть фотографий желтеют и это тоже вносит свой вклад.

Celsius

Да, ЧБ это совсем не простой эффект, в цифре куча способов его получить. PAL, HDTV и усреднение RGB «в лоб» дадут совершенно разные оттенки серого, а нейросеть «восстановит» совершенно разные цвета.

В аналоге нюансов бесконечно больше, там и свойства пленки, и используемые реактивы, и даже условия хранения дают свой эффект. Я много занимался восстановлением старых фотографий и колоризацией, на большинстве снимков даже один тон неконтролируемо «плавает».

К тому-же нейросети не для дилетантов, это вполне обычные программы, которые созданы решать некоторую определенную задачу. Если задача не определена, то и результат получаем соответствующий. Сотворить и обучить нейросеть может любая обезьяна, тут знаний надо меньше чем для веб-программирования. Большинство начинаний идут от студентов, которым нужен не продукт, а хотя-бы какой-то результат, чтобы запостить публикацию и получить зачет. И делается это все на паре десятков «позвоночников», предобученных на условном ImageNet.

Если нам надо раскрашивать машины, то мы берем фотографии машин до «состаривания» фотографии и после, обучаем раскрашивающий фильтр. Если нам надо раскрашивать обезьян, фотографии машин нам уже не годятся, так же как не годится троллейбус из хлеба для полетов в космос.

LibrarianOok

Но дрессированых обезьян от использования тяп-ляп-ретуширования на скверно обученных нейросетях это не отвратит.

Spaceoddity

Ч/Б — это совсем простой эффект. Вся разница лишь в процентном соотношении каждого из каналов. Считается что для максимально корректное распределение световой характеристики даёт зелёный канал. Красный выглядит очень непривычно. А синий — самый шумный. Поэтому для «правильного» перевода в чб берётся либо формула G-60 R-30 B-10, либо просто яркостный канал из модели Lab.

Ну а теперь вопрос — какая нейросети разница какой оптической плотностью передан на моей фотографии тот или иной оттенок? Машина может быть изначально зелёного цвета, а может я просто переэкспонировал кадр.

Больше удивило то, как некоторые сервис крайне неаккуратно «раскрашивают» — постоянно вылезая за границы контура. Я-то кажется понимаю откуда растут ноги — и это удивляет ещё больше. Аккуратно «раскрасить» используя только цветовые каналы Lab и кривые/уровни — вообще не проблема. Но кто-то, видимо, решил подрубить и blur.

alliumnsk

Если нужно имитировать совсем старое монохромное фото, берем только B.

Osnovjansky

ЧБ на черно-белой пленке образовано не только монохромными RGB, но и остальными частями видимого спектра и кусочками ИК и УФ, причем для разных пленок с несколько различающимися кривыми чувствительности.

Так что, как могут предлагать "универсальную" раскрашивающую нейросеть — хз.

muxa_ru Автор

Я список сервисов для теста по интернету собирал. В разных обсуждениях и обзорах.

Нигде не пишут "Эта нейросеть предназначена только для раскрашивания цветочков. Не используйте её для раскрашивания лиц."

Просто рассказывают о прелестях новых технологий.

muxa_ru Автор

Именно.

У людей ровно то же самое

Беда, коль пироги начнёт печи сапожник,

А сапоги тачать пирожник,

И дело не пойдёт на лад.

Но среди не-айтишников это не все понимают.

Многим кажется, что волшебная нейросеть универсальна и может всё.

Zolg

Вы это к тому, что будь нейросети тренированы по ЧБ в фотошопе (они, кстати, скорее всего были тренированы по "ЧБ в фотошопе", ибо откуда еще взять нужное для тренировки число пар "ЧБ"-цвет), то результат был бы принципиально иным? Сильно сомневаюсь.

Задачи, затронутые автором статьи, на 100% не способна решить даже лучшая из известных на данный момент нейросетей — ваш мозг. И это при том, что ему доступны такие инструменты, как "поискать в архивах, каких цветов выпускались Ford A в 1920 году.

На самом деле проблема-то довольно похожа на давнешнюю историю с улучшайзерами в звукозаписи/воспроизведении.

Arech

> И это при том, что ему доступны такие инструменты, как «поискать в архивах, каких цветов выпускались Ford A в 1920 году

И вот что-то мне смутно подсказывает, что в 1920 цвета „глубокий зеленый металлик“, в которой раскрасили Ford самые настоящие

ковжаные ублюдки„реставраторы“, еще не было… А еще что-то тут на искусственные нейросети пеняем (это последнее не к Вам или автору статьи, есичо, — он-то использовал и предлагает ввести в обиход корректную терминологию и я всеми конечностями за)Zolg

По мне так это не металлик, а просто хорошая глянцевая эмаль.

Вот, кстати, реаламная брошюрка тех времен:

Arech

Пруф засчитан) Возможно и не металлик, по фото я, например, не особо понимаю. Буду в DME, гляну вживую.

muxa_ru Автор

Да, Вы правы.

Есть несколько формул обесцвечивания. Я в PaintShopPro делал и просто перевод в оттенки серого и перевод в чёрно-белую фотографию. Результаты разные.

И разница будет и и при аналоговой фотографии. Разная плёнка. Разная бумага. Недосветил фотоувеличителем. Передержал в проявителе.

В данной ситуации, для меня важным было не только то что сервисы в реальный цвет не попадают, а ещё и то что они все дают разные результаты.

Но всё очень правдоподобно смотрится.

Иногда, раскрашенные машинки выглядят интересней чем оригинальные.

engine9

Человечеству свойственно извлекать краткосрочные выгоды из технологий, взамен получая сложноустранимые долгосрочные последствия. Какой сферы жизни не коснись, всюду мы устраиваем бардак. Придумали антибиотики, стали пичкать их везде получая полирезистентную флору. Придумали пластик, стали экономить и делать из него вообще всё (дешево же) и получили планетарное загрязнение, которое непонятно как аукнется. Придумали как удешевлять программирование через фреймворки и получили современный веб или драйвера для видеокарт объемом в гигабайт. На очереди применение нейросетей в целях пропаганды и мы получим веб в виде гигантской помойки.

yurisv3

Тут вы явно ошибаетесь.

Этот вывод может быть корректным лишь «задним числом». Когда данное оружие исчезнет со сцены не будучи использованным.

А на данный момент и то, и другое вполне налицо, и как чеховское ружье на стене лишь ждет своего момента.

adictive_max

yurisv3

Какое поразительное невежество…

Оно не только не «покрывается пылью», но непрерывно совершенствуется — в сторону ПОНИЖЕНИЯ порога применения.

Что еще как бы пол-беды. Настоящая беда — оно РАСПОЛЗАЕТСЯ. Попадая в руки, в которых прямо скажем очень не хочется видеть. Опять же дело не столько в пакистанцах или северных корейцах как таковых, как например в недееспособности пакистанского государства. В силу чего очень велика вероятность попадания ЯО в руки группы фанатиков или уголовников.

GM-2

А тут пишут что последняя производившаяся в США спец-БЧ — боеголовка для Трайдент-2 и ее производство завершено 31 год назад.

Верхушка хоть фанатиков хоть уголовников — люди прагматичные и с айку выше среднего ибо другие в конкурентной борьбе не выживают. И она прекрасно понимает что от применения одиночной бомбы будет хуже им же ибо карательная экспедиция после Хиросимы-2 начнет применять методы времен Киплинга, а не как сейчас.

AndrewRo

Историю с Аум Синрикё или Храмом народов знаете?

GM-2

Знаю. О применении теми и другими ядерного оружия как-то не слышал.

AndrewRo

Аум Синрикё пытались достать ядерное оружие, естественно, не получилось, пришлось обходиться химическим. Но речь не об этом, а о том, что ни Сёко Асахара, ни Джим Джонс не производят впечатления прагматичных людей. Конечно, среди лидеров сект есть люди вроде Хаббарда, но далеко не все они такие.

GM-2

ОК, надо было написать «верхушка опасных ОПГ и сект, а не заканчивающихся на первой же акции».

Zolg

Оно может исчезнуть со сцены только после появления оружия аннигиляционного (примерно, как исчезли луки, арбалеты и конница)

Технологии нельзя закопать и забыть (без уничтожения их носителей, естественно)

xsevenbeta

В 2020ом часы судного дня снова вперёд вроде переводили. Ядерный арсенал никуда не делся и как мы знаем из истории, как минимум один раз мы были близки к очень большой беде.

Yuriy_krd

Немного поправлю: именно сейчас мы ближе всего к этой самой Ж… беде. (100 секунд до полуночи). Предыдущее значение в 2 минуты было в 1953 году и в 2018.

Sychuan

Жаль только что эти часы никогда не реагируют на реальные опасности, о которых их авторы часто не знают, зато любят реагировать на правильные политические события вроде избрания Трампа

TheGodfather

А что было в 2018?

Yuriy_krd

Повышенная активность ядерных испытаний Северной Кореей.

Spaceoddity

Т.е. во время Карибского кризиса всё спокойненько в мире было?

Yuriy_krd

Ну, я тоже удивлен, что это событие никак не повлияло на Часы, но вот как есть.

TimsTims

Они просто не хотели подливать масла в огонь) всеобщая паника им не нужна… По крайней мере у себя)

Sychuan

Еще человечеству свойственно сводить сложные проблемы к простым однобоким схемам, подчерпнутым из истерической желтой прессы

Заодно делая, мясо дешевым и доступным. Я уже не говорю, о том факте, что многое в истории про «пичкание» животных на фермах «немного» преувеличено. См. например

Никак скорее всего не аукнется. Самое худшее что может случится, это то что у нас закончасться углеводороды. И придется делать изоляцию для кабелей из ткани или бумаги, как это было на заре развития техники.

И чем вам так плох современный веб? Странно, но мне он гораздо приятнее и удобнее, чем веб без фреймворков 20 лет назад, когда про всякие GeForce Now, dropbox или googledox можно было только мечтать

Нейросети в целях пропоганды применяются уже лет 3000, как минимум. Не думаю, что мы увидим что-то ужасное в ближайшие годы

Arech

> dropbox

О, это мое любимое! Сраный клиент для винды, следящий за изменениями файлов запускает порядка 5 процессов, выжирает для себя полгига ОЗУ и суммарно под 200 (!!! прописью: двести) потоков.

Newbilius

Цифры конечно ужасают, но при этом на практике dropbox с ~2013 года, и ни на одном из компьютеров конкретно он не становился причиной тормозов. Включая машинки с HDD. Так может и фиг с ним, пускай кушает, если это позволяет ему быстрее отслеживать изменения и заливать их в облако/из облака, а мне не доставляет проблем?

Stalker_RED

О отличный аргумент «у меня все работает». А у меня становился источником проблем, и не раз. Когда на глаз видно что комп тупит, открываешь список процессов, а там в топе дропбокс, причем сразу на нескольких ядрах. Причем я понимаю, что у него на попечении гигов этак 10-12, и я их с недельку не трогал, но дропбоксу вот захотелось пару ядер загрузить под соточку, и хеши все пересчитать. Причем не в фоне, и не в минуты простоя, а вот прямо внаглую отжирая ресурсы.

Потому что… хз почему. Потому что может!

tangro

Вопрос в том, нафига они такое нагородили. Это всё можно было бы уложить в системный сервис + утилитку в трее с контекстным меню на 2 пункта. Но нет! Мы притащим сюда весь Qt5 (включая 70-мегабайтный Qt5WebEngineCore.dll), Питон с кучей пэкэджей, компилятор шейдеров от Хромиума, либу OpenGL, редистрибьютабл С++, отдельный UI для WindowsXP и ещё кучу-кучу всяких костылей и велосипедов. И это для утилиты, которая 10 лет назад весила мегабайтов 5, помещалась вся в три бинарника, создавали три потока — и делала то-же самое, что и сейчас!

Alcpp

Да, неплохо. У меня 3 процесса.

Судя по командной строке: Основной, крашхендлер и exit-monitor.

180+ потоков суммарно.

namikiri

Тем, что если раньше разработчики страдали во благо пользователей, то теперь пользователи страдают «во благо» разработчиков. А именно — ценой тормозов, нервов и потраченных на апгрейд денег. А апгрейд ради чего? Что функционально изменится? Ничего, просто это апгрейд в угоду ленивому разработчику, который без фреймворка уже и лендинг сделать не сможет.

Sychuan

Ну вот я не страдаю. Ноутбук у меня не самый новый. Мне кажется вы преувеличиваете масштаб проблемы. Фреймворки позволяют за меньшее время делать более сложные вещи, и облегчают разработку. Это позволяет делать веб разнообразнее и создание сайтов дешевле. Во всех вещах есть недостатки. Одежда сшитая хорошим мастером на заказ лучше будет сидеть, чем сделанная на фабрике под средние параметры сферического человека. Только и ходить тогда придется в одной паре ботинок по 5 лет многим.

namikiri

Разрешите поинтересоваться, каков объём оперативной памяти у Вашего компьютера?

По поводу фреймворков — удешевление и упрощение разработки заставляет разработчиков меньше думать о потребляемых ресурсов вообще и о памяти в частности. В итоге имеем т.н. Пейсбук, от главной страницы которого мой ноутбук пытается улететь в стратосферу на вентиляторе, имеем Инстаграм, который на самом деле веб-сайт и от которого мой телефон ощутимо нагревается просто при редактировании статичной картинки в сториз.

Да, современная разработка дешевле, потому что компании переложили стоимость разработки на стоимость оборудования, способного вытянуть современные поделия.

Zolg

Если бы закон Мура не компенсировался законом Вирта, то во вселенной начались бы уменьшение энтропии, всеобщее благоденствие и прочие недопустимые вещи

Sychuan

8 Гб

Я не уверен, что это плохо. Это бывает неприятно, но не факт, что альтернативы лучше, или возможны.

namikiri

Почему раньше работало, а сейчас перестало? Иногда в качестве контраргумента приводят довод о том, что, дескать, раньше веб-страницы были проще и вообще приложениями не считались. Так вот, неправда, вспомните панели управления WordPress, phpMyAdmin, DLE, простиг-споди 1С: Битрикс — они достаточно сложны, на порядок сложнее, чем Инстаграм или Фейсбук, но при этом они работают в разы быстрее. Внешний вид? Так это решается средствами CSS, а не фреймворками.

tonad

Что мешает установить ХР и работать на старом софте?

GM-2

Хипстограмм и пейсбук просто уникальные в своем роде. Тот же вконтактик работает вполне шустро. А на битриксе написан сайт и форум журнала «Новости космонавтики», который пару лет назад регулярно выпадал в осадок при появлении этих самых новостей. Сейчас работает стабильней, но, подозреваю, потому что на него забили все кроме завсегдатаев.

chersanya

Пока не захочешь достаточно далеко отлистать ленту/историю сообщений.

Sychuan

Я не уверен, что панель управления вордпресс сложнее, чем фейсбук. Скажем через фейсбук я могу звонить, используя видео, вставлять в посты 360градусные фотографии и анимированные картинки, и так далее. Там довольно широкий функционал на самом деле. Я не говорю, что фейсбук идеален. Наверняка можно сделать намного лучше. Просто я уверен, что и 15 лет назад были плохие сайты, загруженные тяжелым контентом (скажем, плохо сжатыми гифками). Были всякие кривые джаваплеты. Флеш-сайты, которые долго грузились и были дико неудобными. Но в тем времена я проводил очень мало времени в интернете. Мог просто почитать новости или запостить что-то на форум. Сегодня я работаю постоянно в гугловских сервисах. У меня там почта и совместно редактируемые документы, и диск с кучей всего, и даже пдф-файлы открываются прямо в браузере. Интернет стал намного сложнее и намного шире. В этом случае деградация общего технического уровня среднего пользователя и создателя контента неизбежна. Вы знаете, что самые красивые надписи и каллиграфия, были распространены именно в самые безграмотные и темные времена? Когда ирландский монах многие годы вырисовывал и выписывал какое-нибудь келлское Евангелие — оно было просто замечательным с точки зрения каллиграфии и дизайна—только 90% населения его прочитать не могли.

Apazhe

Так его и сейчас 90% населения прочесть не смогут.

Потому что TL;DR.

Cerberuser

Вопрос соотношения необходимых усилий. Тогда их требовалось больше, чем имелось в наличии, а сейчас — всего лишь больше, чем люди считают нужным выделять. Иначе говоря, сейчас эти самые 90% населения технически могут, но им это на фиг не сдалось, а тогда 90% населения действительно не могли.

SantaCluster

фб — единая распределённая система. админки сайтов или майадмина сами по себе. и вряд ли они смогли бы так же шустро работать при сопоставимых нагрузках.

хотя да, монстры типа фб, джимэйла и прочих "богатых сетевых приложений" ;) жрут много память на свои свистелки-перделки. а интерфейс фб так вообще ужасен генетически. но нагрузку держит

namikiri

Не путайте, пожалуйста, фронтенд и бэкенд. Говоря о тормозах, я имел ввиду банальную прокрутку ленты, открытие модальных окон, открытие просмотрщика фотографий — всё это дико нагружает процессор, и запросы к бэкенду тут не при чём.

lspci

Про атомное я согласен. Но биологическое… ТВ не смотрите?

Zolg

вы с информационным не путаете ?

perfect_genius

Думаете, коронавирус не мог быть пущен умышленно?

Zolg

Я думаю, что в коронавирусе примерно 1% вируса и 99% информационного сопровождения, раздуваемого для решения своих внутренних политических и экономических задач

SantaCluster

согласен. ёмко сказано

madCreator

Биологическое (как и химическое) просто оказалось неэффективным. С атмомным — никакого «стопа» нет и близко. Думаю, скоро увидим применение его как тактического. Увы.

Странно, что ты не написал про современную концепцию сверхпотребления вообще, когда вся промышленность, производящая товары народного потребления, фактически работает сразу на свалку, настолько мало живут эти товары у пользователя.

Пока на планете доминирует общественно-экономическая формация, главной целью которой является извлечение максимальной прибыли любой ценой, человечество и будет вести себя как подростки.

lspci

Я в общем обременён аналогичными мыслями о потребительстве, индустрии «говна» и прочих прелестях современности. Однако до вашего поста эта тема была вне контекста. Хотя на мой взгляд опасности от описанных «экономических эффектов» ни то чтоб меньше… по моему скромному мнению ориентация на экономический аспект общественной жизни от человека как существа живого, одушевлённого, осознающего ни останется и пустого места.

Больше того кажется мне, что для этого и увели на экономико-демократический, вместо социально-политического, фронт народы современного мира.

catharsis

Ничего особенно современного в этом нет

perfect_genius

GM-2

Химическое широко и успешно применяли до конца ПМВ при наличии противогазов. Хинт — противогаз еще надо успеть одеть. С биологическим да — не взлетело.

Настолько нет и близко что последнее боевое применение в 1945?

И какие тактические задачи сейчас решаются только тактическим ядерным оружием и ни каким другим?

Мой предыдущий смартфон прожил 4 года без единого ремонта, предыдущая персоналка — 9 лет и пошла в отставку только потому что мне хотелось в одну современную игру погонять. ЧЯДНТ?

Уже давно не доминирует и не факт что вообще доминировала. Если капиталист будет максимизировать прибыль любой ценой — он прогорит ибо не делал инвестиций в развитие.

Как будто что-то плохое.

Alexey2005

GM-2

До Боинга в США было много других аэрокосмических корпораций вроде Convair. Почему-то их государство не спасало. Ну и чистая прибыль Боинга 5 миллиардов при обороте почти в 100 — как-то не похоже на максимизацию прибыли.

OasisInDesert

Спасибо за детальный обзор возможностей нейросетей.

Arech

Г-ди, да где ж вы тут «обзор возможностей нейросетей»-то увидели? Разжевывание до состояния химуса тривиальных знаний, обретаемых еще детьми 3-4 лет, что утеря чего угодно (времени, товаров, денег, информации) не может быть восстановлена, она может быть только заменена чем-то новым. И похожесть этого нового на оригинал может быть вообще любой, начиная с никакой. При чем тут нейросети? Тем более «обзор возможностей..»

Читал статью с недоумением, а теперь вижу, что ой не зря ее автор написал…

OasisInDesert

Подразумевалось в рамках обсуждаемого контекста. Спасибо за поправку.

Arech

Спасибо и Вам, что правильно поняли.

wladyspb

Вспомнилось, как один вроде бы неглупый человек доказывал мне, что музыку можно сжать а потом разжать без потери качества. И да, он имел в виду mp3 128 и ниже, а не современные форматы сжатия без потерь, которые хоть и позволяют сократить занимаемое место, но не до бесконечности, а в довольно узких рамках.

yefrem

кмк, музыку как раз расжимать более-менее реально, тк алгоритмы сжатия известны. Другое дело, что непонятно, зачем это вообще нужно.

Spaceoddity

Нельзя. Там верхняя граница в 8-10 кГц. Выше просто нет никакой информации.

wladyspb

Разжимать реально. Разжимать без потерь музыку, сжатую с потерями — нереально.

yefrem

ну я имел в виду задачу «сделать чтоб звучало похоже на лосслесс». Понятно, что, если информации нет, то ее не родить, но и «морда обезьяны» тоже скорее всего не появится.

muxa_ru Автор

Велкам ту зэ клаб :)

Almatyn

Обезьяна в фаре — отлично демонстрирует работу нейросетей. Как только им доверяют вождение автомобилей и другие сложные задачи.

Vkuvaev

Это шедевр, я согласен, эта обезьяна — “Simia ex Machina” сделала мое утро!

sergeaunt

Нейросеть за рулем — усредненная обезьяна

с гранатой.Eldhenn

Обезьяна в фаре — это то, как на самом деле работает CSI zoom.

ainoneko

«теперь эта проблема обрела своё конкретное лицо».

Cerberuser

Обезьяна в фаре — это нечто ещё более страшное, чем обезьяна в vim-е.

john_2013

для сложных задач не используют такие обобщённые нейросети

4ITEP

Но ведь от этих «увеличителей fps», как мне казалось, никто и не ждал появления новых деталей. Просто увеличится комфорт от просмотра фильмов

adictive_max

Может и не «новых» деталей, но как минимум, что новая картинка будет достаточно естественной, то есть поверит ли мозг, что так изначально и было. Как показывает практика, верит не у всех и не всегда.

maaGames

Пробовал смотреть фильмы с «увеличивалкой фпс», но основанную на свойствах алгоритмов сжатия видео. Там «всё очень просто». Соседние кадры разбиваются на блоки и каждому блоку задаётся вектор перемещения, куда этот блок поместить в следующем кадре. Этот блок сохраняется один раз сразу для последовательности кадров и получается сжать видео. Так вот при увеличении фпс этот блок сдвигают вдоль вектора на меньшее расстояние (масштабируют вектор). В зависимости от видеоряда и качества видео, результат бывает вполне смотрибельный.

Было бы интересно, чтобы нейронная сеть «улучшала» промежуточные кадры на основе соседних, имеющихся в видео. Но в реал-тайме вряд ли сейчас такой объём вычислений возможен.

muxa_ru Автор

Я не уверен в слове "никто".

Люди далёкие от технологий не понимают что происходит.

Им говорят "нейросеть восстановила цвет" и они считают что перед ними изначальный цвет, который был во времена создания исходной фотографии.

Так же и с размерами и с дополнительными кадрами.

В оптических приборах можно увеличить и рассмотреть детали. Так почему тут нельзя?

Вот и приходится объяснять, почему именно нельзя.

Я поэтому и начал писать книжку в среде максимально далёкой от профессионального IT-сообщества, ибо это разные аудитории с которыми надо разговаривать разным языком.

laisan

> Им говорят «нейросеть восстановила цвет» и они считают что перед ними изначальный цвет, который был во времена создания исходной фотографии.

Да, да — все дело в подборе слов. Если бы говорили «нейросеть _добавила_ цвет» — это было бы ближе к истине. Хотя все равно нашлись бы люди, которые бы поняли как то, что это изначальный цвет.

Shultz

Все дело в обучающей выборке. Как написал первый комментатор, разница между современными фото и реально старыми, для нейросетей очень велика. Отсюда и большая ошибка на результате предсказания. Можно и цветную попробовать туда загрузить или черно-белый комикс и сетовать на плохой результат. Все зависит от данных, на которых сеть обучалась. Нейросеть может быть «умной» исключительно на этих данных. Любое даже незначительное отклонение от этих данных приведёт к высокому значению ошибки.

wladyspb

Ну, то есть, идеальную сферическую нейросеть в вакууме надо было обучать на не на рандомном датасете, а на конкретной фотографии «до»\«после» — и тогда бы она эту фотографию раскрасила идеально, ага.

HaZeR

Не совсем так. Если надо раскрасить фото природы, то и обучать надо на фотках природы. Если городской пейзаж, то на фотках города. Если дать слишком разнообразный датасет, нейронка сможет раскрасить любое фото, но хуже чем тренированная под конкретику.

wladyspb

Ну, окей, обучим мы нейросетку тому, каких цветов бывают автомобили. Допустим, даже конкретным автомобилем обучим — скормим ей кучу фоток форда фаэтона из примера выше. И(допустим), в одном и том-же чб оттенке у нас в этом датасете есть 5000 зелёных и 500 синих фордов. В какой цвет эта нейронка раскрасит чб фотографию синего форда?

HaZeR

С таким перекосом датасета в сторону зеленых, скорее всего зеленым.

wladyspb

Ну окей, а с равномерным распределением зелёных и синих — с 50% вероятностью в зелёный. Это, получается, по идеальному датасету(для этой фотографии). Но ведь может быть в производстве разное распределение цветов? Например, 50% выпускаемых машин чёрные, 20% белые, 20% зелёные, и по 5% на остальные, менее популярные цвета включая синий. Какой датасет считается правильным — тот где равномерное распределение всех возможных вариантов, или тот где распределение возможных вариантов сделано на основе их веса? Допустим, нам надо раскрасить тигра. Должны ли мы в датасете дать одинаковое количество обычных тигров и тигров альбиносов? Ведь тогда наша нейронка будет ошибаться и неправильно раскрашивать половину тиргов? Или мы должны представить альбиносов минимальным количеством фото в датасете, а то и вообще убрать их? Тогда наша нейросетка будет правильно раскрашивать 99% тигров… Но будет давать ошибку на альбиносах.

HaZeR

Интересный вопрос. Идеального датасета не существует :) Есть тот, который позволит добиться от нейронки результата, который бы нас устроил. Где то можно добавить на вход нейронки доп. данные или параметр. Делаем вариационный автокодировщик и сами задаем цвет тигра, как дополнительный входной параметр. Может будет лучше работать, если обучить на обычных тиграх, а потом дообучить на небольшой подборке 50\50 с альбиносами. Это все зависит от конкретной задачи. Иногда можно выкинуть что-то из выборки, иногда ее сбалансировать по другому. Если шаблон и есть, то я про него не знаю. Каждый раз эксперименты…

muxa_ru Автор

Есть идея, которая звучит в комментариях со стороны фанатов ненейросетей, но не всего её понимают.

Эта идея о том, что нейросеть строит модель.

Набираем примером полёта камня у поверхности Земли, нейросеть строит модель и способна дальше с этой моделью работать.

То же самое, с распространением эпидемий, сейсморазведкой полезных ископаемых и пр.

Но в случае с преобразованием чб->цвет не существует возможности построить модель.

Не "сложно", а именно что "невозможно".

А если нельзя построить модель, то это не моделирование, а фантазирование.

kryvichh

Что касается цвета машин, если они дают близкий оттенок на чёрно-белых фото, то точное восстановление цвета невозможно впринципе. Это не сможет сделать и человек. Если же есть хоть какие-то мелкие зацепки, детали, по которым эксперт может высказать мнение о цвете определённых элементов, то это сможет сделать и большая, хорошо обученная нейросеть. Как в примере тигров, если на основе ширины и формы полос, разности интенсивности оттенков эксперт сможет сказать, это альбинос или нет, то и нейросеть сможет.

Или возьмём пример из обработки текстов (мне это ближе). Вот цитата из Чайковского, слегка упрощённая и изменённая:

Мы хотим её перевести на английский язык. В подавляющем большинстве случаев слово «для» переводится как предлог «for». Но человек, хорошо владеющий русским языком, поймёт, что в данном случае оно использовано как деепричастие от глагола «длить». Потому что обстоятельство времени «до бесконечности» хорошо сочетается с глаголом «длить». Тем не менее, все нейросетевые переводчики переводят в этой фразе «для» как «for»:

Это значит, что у них два пути:

Zolg

Так вот, значит, откуда ноги у градиентной колоризации от mail.ru

alliumnsk

Поддерживаю. Я как-то загружал старое ч/б фото в нейросеть. На фото из-за дефекта проявки (неоднородность температуры, перемешивания или чего там еще) был слабый градиент, который сводил нейросеть с ума, потому что в ее обучащаем наборе из цифровых фотографий такого не было и не могло быть.

kryvichh

Та же самая ерунда случается с сервисами переводов, основанными на нейросетях. Особенно если выбрать два достаточно близких языка, но для которых во время обучения сеть не тренировалась на прямых переводах.

Например, если взять польский текст и перевести на белорусский язык. Иногда получается перевод надуманный, в котором вроде и слова примерно правильные используются, но в целом получается нелепица, а то и полностью "ортогональный" смысл. Такое происходит и в Гугл Транслейт, и в Яндекс. Потому что не имея достаточно опыта разбора готовых прямых польско-белорусских переводов, они внутренне гоняют текст через английский и русский, по дороге теряя оригинальные детали, и приобретая элементы этих промежуточных языков.

flyingpandasdiyingslow

Попробуйте DeepL, будете приятно удивлены

kryvichh

Да, я читал новость, слежу за разработкой. Жаль, пока там только 9 самых распространённых языков. На этих языках много параллельных текстов, поэтому качество перевода для них и в Гугле и в Яндексе тоже получше, чем для менее распространённых.

alliumnsk

а у кого-нибудь есть граф по которому гоняет GT?

Насколько я знаю, некоторые пары языков она переводит не через английский (скажем ру-укр)

GM-2

Давно ли мы над ПРОМТ с английского на русский «когда вы упретесь в мертвый конец — давите космическую преграду» ржали?

muxa_ru Автор

А мы не переставали — Гугл Транслейт достойно принял эстафету компьютерного перевода и радует нас раз за разом :)

GM-2

Смеяться над ГТ после ПРОМТ — это

muxa_ru Автор

Гуртовщики мыши — навечно в моём сердце, и никакой Гугл Транслейт их не заменит :)

GM-2

В русефикацию Alpha Centauri (оригинальной) играли?

muxa_ru Автор

Нет.

И вообще, меня русифицированные игры не привлекали.

Привыкнув разок к англоязычным обозначениям, я так и не смог переучиться на русифицированных Героев.

JerleShannara

Охлаждение траханья потрачено!

vlivyur

Вдруг кому-то будет интересно что такое «гениталий на гусеничном ходу» — это trackball, а «сапог-полено» — bootlog.

kryvichh

Я к тому написал, что если нейросеть не тренировать на данных, на которых она потом будет работать, то она будет додумывать детали, взятые из тех данных, на которых её тренировали. И это не зависит от области применения, будь-то восстановление фотографий, или компьютерный перевод.

muxa_ru Автор

Она всегда будет додумывать детали. :(

Но если её тенировали на правильном датасете, то это просто не будет бросаться в глаза.

Это одновременно является и плюсом для кинозрителя, и минусом для историка.

SantaCluster

а нейросеть неспособна определить, какие данные ей подсунули, какой из известных ей датасетов применять в конкретном случае? (понимаю, что зависит от реализации. но есть такие или нет?)

muxa_ru Автор

А вот это одна из главных проблем использования нейросетей.

Человек-аналитик или компьютерная программа выполняющая строгий математический расчёт скажут "данных для расчёта недостаточно".

Нейросеть же свою работу сделает независимо от количества данных в датасете и того подходит ли датасет в конкретном случае.

И если несуразность результата не будет бросаться в глаза (как в случае с лицом в фаре или раскрашиванием от mail.ru ), то у нас нет возможности проверить полученный результат.

v1000

после прочтения захотелось, чтобы на таких обработанных фотографиях обязательно добавлялся текст об обработке. другой вопрос что в современных фотокамерах обработка начинается на этапе самой фотографии. интересно, а «обезьяны» будут появляться на современных SpaceZoom и прочем?

Osnovjansky

Где-то в обзорах телефонов в прошлом (или поза-прошлом) году, при обзоре камеры демонстрировали, что нейросеть в телефоне улучшила резкость окон дома, где-то на заднем плане. Форма окон при этом изменилась на другую )

stalinets

Проблема ещё в том, что современные фотографии в самом фотоаппарате/смартфоне зачастую прогоняются через неотключаемый улучшайзер. Потом, на Хабре несколько лет назад была статья на Хабре про слишком умные копиры, которые в процессе копирования документов с мелкими цифрами вносят критические ошибки, например, рисуют цифру 1 вместо буквы I или l или наоборот. Или путают 1 и 7. Понятно, какие последствия это может иметь — любые, и в том числе очень печальные. Например, если в самолёт зальют не 4740 кг топлива, а 4140 и самолёт не долетит. Или будет ошибка в площади продаваемой недвижимости в нотариально заверенных бумагах, что повлечёт годы судебных разбирательств.

muxa_ru Автор

Да, это история очень показательная во многих отношениях. Проблема была известна за несколько лет до того как о неё громко заговорили.

А в моём случае всё гораздо хуже — речь об использовании популярного алгоритма сжатия, который активно использовали для сохранения отсканированных письменных источников. И до сих пор используют.

И когда этот алгоритм путает "и" и "н" это не так страшно, хотя и затрудняет поиск по тексту.

Но когда перепутаны "6" и "8" — это уже проблема.

Jamon

Касательно улучшения видео без нейросетей:

Увеличение частоты кадров можно делать через SVP.

Далее, рендерер можно использовать madVR, вот здесь:

https://yabb.jriver.com/interact/index.php?topic=110989.0

описываются настройки SVP с madVR'ом для получения качественного улучшения картинки («киношное» видео с увеличенным fps).

Все вышеперечисленное — без нейросетей, ну и результат мне нравится.

JerleShannara

У меня умный телевизор (LG образца 2013 или 2012 года — не помню) умеет делать схожий «улучшайзинг» — но вот его результат мне совершенно не нравится(особенно на динамичных сценах, в гонках так вообще противно всё выглядит).

Jamon

Именно, в телевизорах — как раз, «как делать не надо», или SVP с базовыми настройками (мне результат не нравился). А вот то что я скинул — там как раз и делается то, что нужно (ну, на мой взгляд).

И в динамических сценах тоже все хорошо (на это я обращал внимание в первую очередь), если видеокарта и процессор позволяют.

alliumnsk

SVP хорошо работает только на небольшом подмножестве задач.

Jamon

А на каких задача очевидно плохо? (интересно проверить)

В стоке, как я выше написал, мне не очень нравился результат.

nidalee

Быстрое движение объекта на сложном или активном фоне. Вокруг объекта будут расползаться волны, либо он сам будет на них разваливаться. Также регулярный фон SVP дается плохо.

Наверное, один из самых плохих кадров, который мог выдать SVP, зато хорошо видно проблему. Идеальной интерполяции кадров я пока не видел.

Jamon

Я записал два видео, сравните (нужно скачать и посмотреть локально, тк google drive плеер пережимает):

SVP в стоке

SVP + madVR

На мой взгляд, качество разительно отличается.

nidalee

Конечно отличается. Но SVP в стоке в принципе достаточно плохо работает, надо подкручивать. Как сконфигурирован madVR, кстати?

Jamon

Да, там и настройки SVP меняются. Все здесь описано:

https://yabb.jriver.com/interact/index.php?topic=110989.0

sergeaunt

Кажется, эти умники забыли (или не знали), что человеческий мозг постоянно занимается заполнением пробелов (все видели, как колесо якобы крутится в обратном направлении), и делает это на основе такого количества информации (как жизненного опыта самого человека, так и тысяч поколений предков), которое их искусственному идиоту не переварить, и отточенных за миллионы лет алгоритмов. Почему они думали, что мозгу нужно усреднение и аппроксимация кадров, сделанных грубой моделью мозга первого порядка?

EvilBeaver

Да ладно, я сто раз в кино видел, как читают надписи на визитке, увеличивая картинку с камеры наблюдения за три квартала!

AllexIn

Это вполне технически реализуемо.

И на хабре статья проскакивала, кстати.

Алгоритм пишет все цифры в нужно плоскости, а потом ухудшает изображение цифр до исходника.

И смотрит какие цифры какие результаты дали. Иными словами — каждая цифра дает свой достаточно уникальный отпечаток и по этому отпечатку алгоритм способен её узнать.

В некоторых случаях, даже если цифра деградировала до одного пикселя — восстановление возможно.

Основная проблема в подборе параметров сжатия. Т.к. надо учитывать множество параметров которые влияли на данные в процессе записи(освещение, шумы, пространственные искажения и т.п.)

gekt0r

Весьма любопытно узнать про эти «некоторые случаи», когда восстановление возможно из 1 пикселя

Zolg

Эти некоторые случаи называются "переобученная нейросеть".

Если ей подсовывать те пиксели, на которых ее обучали — будет прям удивительно хорошо "восстанавливать информацию".

Если другие, то тоже будет "восстанавливать", но ту же самую информацию, что и в предыдущем случае

AllexIn

Там вообще нейросеть не используется.

Zolg

суть не меняется

заточенный на восстановление цифр из пикселей алгоритм прекрасно восстановит в цифру 8 пиксель, в молодости бывший буквой ё

AllexIn

Верно. Поэтому речь и идет о восстановлении цифр(читай фиксированного и очень ограниченного набора символов).

А еще она не сможет восстановить цифру из пикселя, если на него оказывала влияние соседняя цифра.

Здесь нет магии. Достаточно простые, но в ряде случаев вполне эффективные алгоритмы.

Например, номер автомобиля очень хорошо попадает в разряд ситуаций, где этот алгоритм хорошо себя показывает. Мы знаем шрифт, мы знаем набор возможных символов, мы знаем цвет фона, нам не нужна 100% точность, достаточно лишь серьезно сократить выборку.

Ndochp

Это когда 1 с такого расстояния превращается в один пиксель, а остальные цифры в 2.

AllexIn

Восстановление по градиенту. Разные цифры дадут разный цвет пикселя.

mayorovp

Обычно для этого используется несколько кадров.

smrl

Лихо у вас выходит. А откуда ваша сеть узнает, какой шрифт был использован для записи цифр на визитке? В разных шрифтах ядра могут оказаться разными.

AllexIn

Выше я уже писал что ограничения алгоритма. В том числе про шрифты. Повторяться смысла не вижу.

smrl

А вот это кто выше написал, в ответ на шутку про однопиксельные числа на визитке: «технически это реализуемо»?

AllexIn

Там написано «в некоторых случаях». Знание шрифта тоже попадает под требования к этим «некоторым» случаям.

Но даже дополнение про «некоторые случаи» там не обязательно, т.к. вполне очевидно что подобные алгоритмы будут иметь ограничения.

В следующий раз предлагаю вам докопаться до формулировки в описании автомобиля «разгон до 100 км/ч за 10 секунд» фразой «Лихо у вас выходит. А если я бетонную стену перед машиной поставлю — что, тоже разгонится?»

smrl

Простите, но очень хочется пруф. Какой-нибудь случай из жизни, «когда даже если цифра деградировала до одного пикселя — восстановление возможно». Вот чтобы весь машинный номер (это ведь идеальный случай в вашей схеме? идеальнее не придумаешь?) был на фото 10 пикселей (ну то есть в пределах 20-30 пикселей если брать с размытыми границами?), а его хоп — и восстановили. Ну пусть не весь номер, но хотя бы цифры их него.

Мне правда интересно, есть ли такие волшебные алгоритмы, что умеют из таких скудных данных вытаскивать ответ. С нужной точностью проходят через все вылезающие интегральные уравнения, и это решение остается устойчивым несмотря на погрешности, вносимые неидеальностью оптики камеры, индивидуальными различиями отдельных пикселей матрицы, дробностью оцифровки…

engine9

Кстати, нейросети превосходно справляются с фильтрацией шума на path-trace рендерах. Позволяя экономить киловатты и часы на рендере анимаций и статики. Вот для таких рутинных задач они идеально подходят.

В последних версиях блендера впилили интеловский денойзер и он работает превосходно, порой напоминая магию. Я не совсем понимаю как именно он работает но на его вход подается не только картинка, но и карта нормалей. Которая, видимо, подсказывает алгоритму как нужно фильтровать каждый участок.

GM-2

Марсианский сфинкс без всяких нейросетей получился.

Sychuan

Ну почему же. Как раз таки особенность некоторых нейроесетей его и создала

tuxi

Отличная статья, отрезвляющая. Спасибо!

PS: Не думали над переводом на английский язык? Есть ощущение, что «стрельнет» хорошо.

AllexIn

Чего в неё отрезвляющего?

Вы всерьез думали, что нейрость понимает по ЧБ картинке какой там был исходный цвет?

ДАже автор упомянутого оцветнения прибытия поезда в своей статьей прямым текстом говорил, что сеть делает вывод о возможном цвете предмета на основе его формы и положения.

tuxi

Нет, я всерьез не думаю так. Но как показывает моя практика общения с другими людьми, они часто рассматривают нейронные сети как «серебряные пули» для всего и везде.

Такие статьи помогут им немного задуматься.

mSnus

Вы как-то странно воспринимаете нейросети, как такого "универсального мудреца", который всё знает. Но нейросеть — это не один гуру. Это скорее соцсеть для студентов, их много, и что-то они умеют, но только то, чему их научили.

Посадите толпу не очень грамотных студентов раскрашивать фотографии — будет тот же эффект: "эта машина, наверное, была красная". Чтобы понимать, что эта машина должна быть чёрной, студенты должны разбираться в истории автомобилей тех лет.

Если нейросеть обучить на таком сете, научить разбираться в ретромобилях — будет нормально красить. То же самое с раскраской статуй или архитектурными деталями — если нейросеть научить распознавать архитектуру, автомобильные детали и логотипы, она справится. И обезьяна в фаре — это, в целом, правильно, нейросети, скорее, "мерещится" там обезьяна, чем какие-то непонятные полоски или логотипы.

Так научили, а без специфических навыков можно и кошку принять за пакет, и жену за шляпу.

А то, что mail.ru сделали к 9 мая — это просто массовая игрушка к празднику, не стоит ожидать от неё серьёзных, исторически достоверных результатов. Для этого нужны не студенты, а грамотные историки. Т.е. соответственно обученная нейросеть.

JerleShannara

А как вы планируете обучить нейросеть? Где вы найдёте достаточный датасет, в котором будут те самые правильные цветные фотографии?

muxa_ru Автор

Я — нет.

Но я общаюсь с людьми, которые не понимают принципов работы цифровых технологий и связанных с этим сложностей.

А ещё, я понимаю, что через 10-20 лет, никто уже и не вспомнит как именно была создана та или иная фотография или фильм.

Сейчас мы общаемся со старыми фотографиями (которые, конечно же, очень сильно не идеальны), а в будущем "семейный архив" будет* состоять из фотографий с наложенными фильтрами.

Я на эту ситуацию смотрю как историк, а не как кинозритель.

Ну а как кинозритель, я в большом восторге. :)

Sychuan

А еще 250 лет назад все семейные архивы состояли из именно таких изображений, где фильтров ого-го сколько. Но никто же не печалиться, что в портртной живописи куча искажений фантазий и так далее. Мы понятие не имеем, как выглядели большинство людей прошлых времен. В лучшем случае кто-то из современников мог написать, что портрет «очень похож». Я уж не говорю про школьные учебники, энциклопедии и популярные книги, которые обожают вствавить картинку мужика с бородой и гордо подписать Евклид, как будто бы кто-то имеет хоть отдаленное представление, как этот самый Евклид выглядел.

muxa_ru Автор

Полагаю, что по этому поводу много кто печалится :)

Sychuan

Ну это не воспринимается, как проблема. Мы знаем, что художники даже в Европе, где идеал 100% соответствия оптической картине мира был очень распространен никогда не были способны достигнуть такого совершенства. Увы кроме голографии (за вычетом цвета) точное запечателние всех деталей оптического мира не возможно. А когда все пропускается через человеческий глаз и мозг, картина может быть очень отличной от действительности. Нынешние эксперименты с нейросетями, конечно, много удивительного делают, но люди будут учитывать это в будущем.

muxa_ru Автор

Да, но ровно до того момента, пока эту голографию не прогонят через нейросетевой реставратор голограмм :)

Sychuan