Если посмотреть на историю Intel, то она сделала полный круг. В ХХ веке компания произвела настоящую революцию на рынке микроэлектроники. Затем большая корпорация решилась на смелые шаги, чтобы выжить в эпоху подрывных инноваций. Но теперь всё-таки попала под каток. Сейчас в 2020 году приходится лишь с сожалением смотреть, как она медленно тонет, и ничего не может с этим поделать. Поезд ушёл.

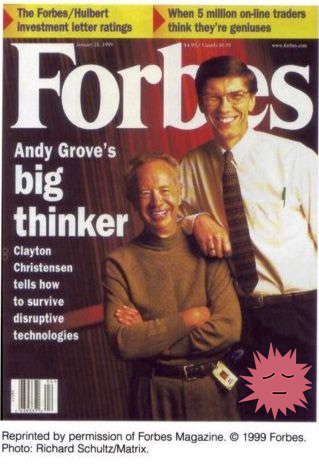

Если посмотреть на историю Intel, то она сделала полный круг. В ХХ веке компания произвела настоящую революцию на рынке микроэлектроники. Затем большая корпорация решилась на смелые шаги, чтобы выжить в эпоху подрывных инноваций. Но теперь всё-таки попала под каток. Сейчас в 2020 году приходится лишь с сожалением смотреть, как она медленно тонет, и ничего не может с этим поделать. Поезд ушёл.Бывший исполнительный директор Intel Энди Гроув говорил, что «Дилемма инноватора. Как из-за новых технологий погибают сильные компании» Клайтона Кристенсена стала самой важной книгой из всех, что он прочитал за десять лет. На обложке Forbes в 1999 году — автор книги Клайтон Кристенсен и Энди Гроув.

Действительно, Энди Гроув был живым примером того, как большой компании выжить в эпоху подрывных инноваций. Один из самых знаменитых примеров — когда Intel решилась на то, что компании редко осмеливаются сделать: выпустить низкоприбыльный продукт, который съедает её собственные высокоприбыльные продукты. Но Intel сделала это. Речь о выпуске процессора Celeron в 1998 году. Он реально съел «Пентиумы» и захватил 35% всего рынка процессоров. Но самое главное, что он выполнил свою задачу — отсёк потенциальных конкурентов снизу. Это был гениальный ход.

Под твёрдой рукой Гроува компания Intel выпускала чипы для персонального компьютера, который вскоре появился практически в каждом доме и на каждом столе. Наряду с Microsoft компания Intel стала синонимом настольного компьютера, пишет Джеймс Олворт в статье про то, как Intel пришла к нынешней ситуации.

В 2005 году Гроув покинул Intel. Это случилось в том же году, когда Пол Отеллини занял пост генерального директора. Казалось, всё шло к благоприятному будущему для Intel и хорошему началу для Отеллини. В то время компания Apple, чей бизнес Mac был на грани срыва, оставалась единственным производителем настольных компьютеров, который не использовал процессоры x86 от Intel.

И Apple сменила позицию — она обратилась за процессорами к Intel. На фотографии Стив Джобс приглашает Отеллини на сцену Macworld, чтобы сделать объявление:

Победа Intel казалась абсолютной.

Действительно, эта сделка между Apple и Intel оказалась важнее для Intel, чем она могла представить. Но не потому, что Intel заполнила последний сегмент рынка десктопных процессоров. А потому, что установила отношения с компанией, которая думала о будущем.

Отказ от производства чипов iPhone

Именно в то время Apple разрабатывала устройство, которое определит технологический ландшафт человечества на ближайшие десятилетия — это iPhone. И она обратилась к своему новому партнеру, Intel, за помощью в разработке чипов.

Как отреагировала Intel?

Что ж, к счастью, теперь мы можем об этом узнать. У нас есть интервью Отеллини в последний месяц его работы на посту генерального директора Intel. Вот что Отеллини сделал, когда представилась возможность разработки микросхем для iPhone:

«В конце концов мы не выиграли и не проиграли, в зависимости от того, как посмотреть на это. И мир был бы совсем другим, если бы мы это сделали, — сказал мне Отеллини в двухчасовой беседе во время последнего месяца работы в Intel. — Вы должны помнить, что это было до появления iPhone, и никто не знал, какой эффект произведёт iPhone… В конце концов, их интересовала определённая микросхема, за который они хотели заплатить определённую цену и ни цента больше, и эта цена была ниже нашей расчётной стоимости производства. Я не мог предвидеть успех iPhone. И оглядываясь назад, расчётная стоимость производства была неверной, а объём оказался в сто раз больше, чем кто-либо думал.

Отеллини представил это как одно единственное решение. Конечно, истинное принятие решений внутри любой большой организации часто сложнее — на самом деле целый ряд действий привёл к тому, что они решили пропустить эту возможность. Вот как описывает ситуацию Бен Томпсон из Stratechery:

Падение Intel от короля индустрии к наблюдателю началось уже в 2005 году: несмотря на то, что у Intel имелась лицензия ARM для производства XScale, компания не захотела сосредоточиться на энергоэффективности, а предпочла диктовать дизайн клиентам, таким как Apple, рассматривая их новый iPhone, вместо того, чтобы попытаться приспособиться под них (как это сделала TSMC).

Но в любом случае конечный результат одинаковый. Как и прошлый партнёр в десктопную эпоху Microsoft настолько увлеклась своим успехом в парадигме персональных компьютеров, что не могла выйти из неё. С учётом этого успеха и хорошей маржи Intel не видела необходимости подвергать сомнению формулу победы: интеграция разработки микросхем и производства. Многообещающий клиент приходит с каким-то предложением, которое вроде не даёт такой большой маржи прибыли, как существующий бизнес?

Не интересно.

Вот так и был потерян клиент, который всего лишь предлагал Intel производить микросхемы для смартфонов iPhone.

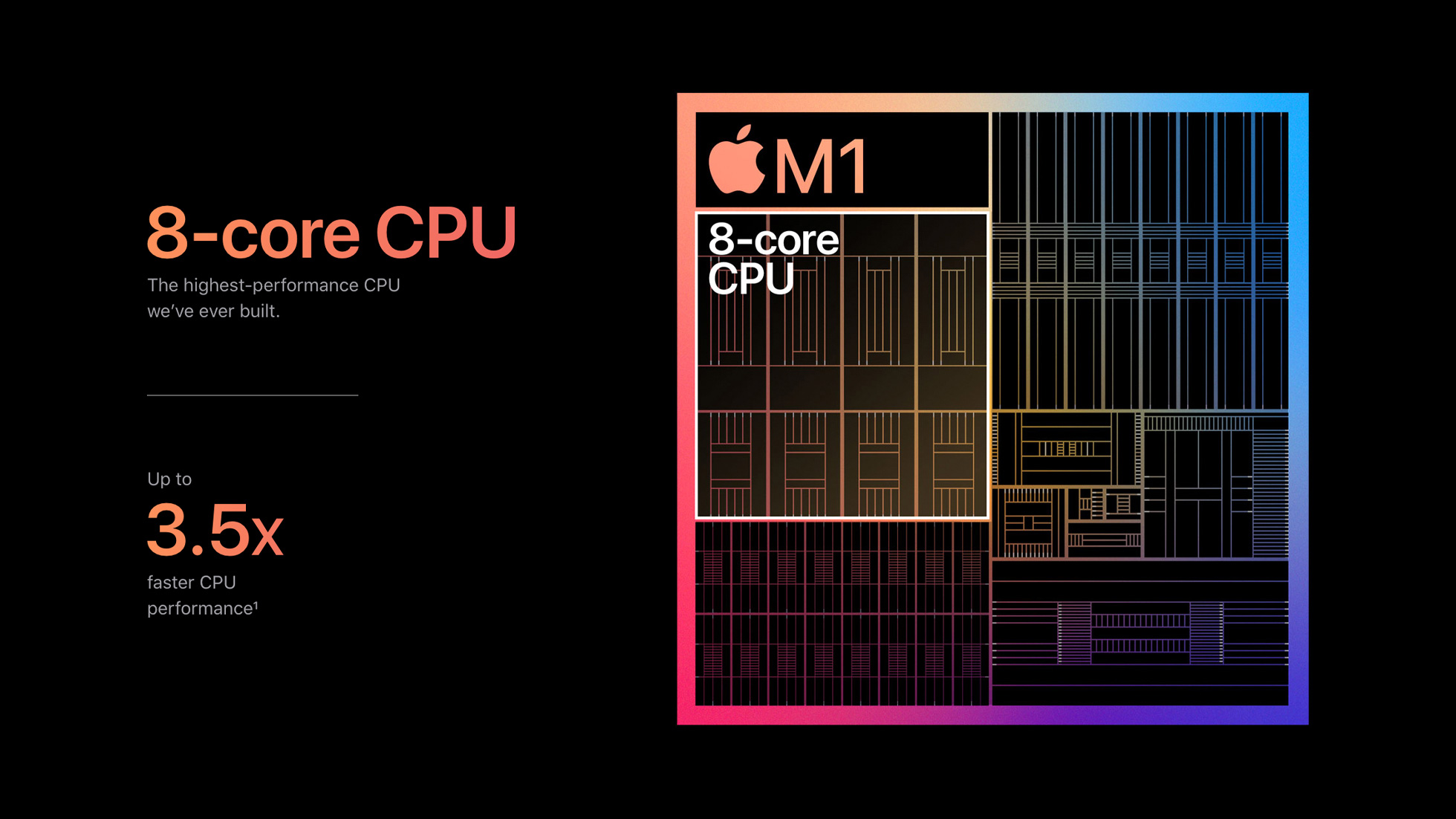

10 ноября 2020 года Apple объявила о первых компьютерах Mac на собственных процессорах. Intel больше не используется. Это первое изменение в архитектуре Mac с того самого 2005 года, когда они перешли на Intel.

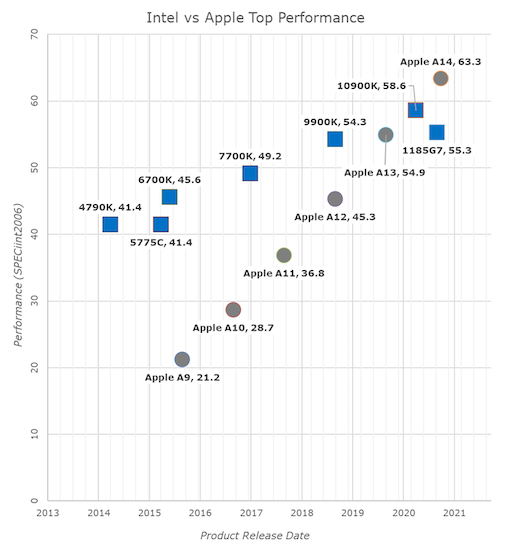

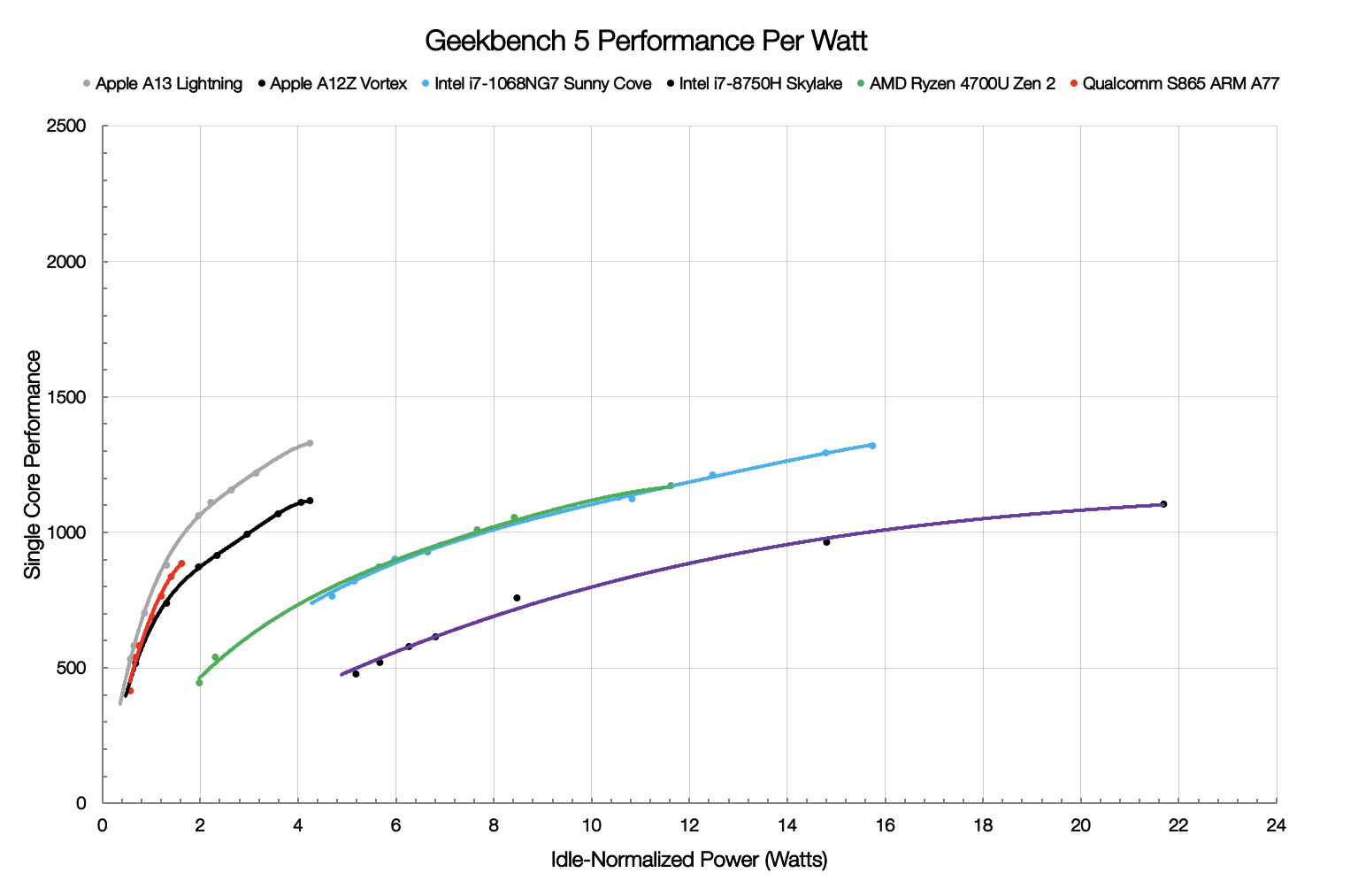

Есть много интересных и подробных обзоров новых микросхем, но особенно выделялся одна диаграмма из обзора Anandtech:

Что интересного в этой диаграмме? Ну, у неё поразительно сходство с той, что была опубликована раньше — в реальности, 25 лет назад. Взгляните на диаграмму, нарисованную Клейтоном Кристенсеном в 1995 году для своей первой статьи о подрывных инновациях:

«Как определить подрывные инновации». Harvard Business Review (январь-февраль 1995)

Возможно, сам Энди Гроув этого не сознавал, но 25 лет назад он читал эту статью не просто в качестве инструкции, как Intel продолжит завоевание рынка персональных компьютеров. Он читал предсказание, что в конечном итоге произойдёт с компанией, которую он основал — предсказание за 25 лет до того, как это произошло.

Подрывная инновация охватывает рынок через определённый причинно-следственный механизм, который Гроув так быстро понял. Он состоит в том, что инновация начинается снизу — благодаря этому резко расширяется рынок. Затем она прогрессирует гораздо быстрее, чем существующая технология.

Именно это позволило Intel (и Microsoft) завоевать компьютерный рынок. Хотя персональные компьютеры были дешевле, но их покупали в каждый дом и на каждый стол, что в итоге генерировало больше прибыли и больше расходов на R&D, чем продажа небольшого количества очень дорогих серверов, которые стояли только в серверных комнатах.

Точно так же и первые попытки Apple спроектировать микросхемы для смартфонов не представляли собой ничего особенного с точки зрения микроэлектроники и производительности процессоров. Но в этом не было необходимости — люди были счастливы просто иметь компьютер в кармане. Apple начала продавать много айфонов, и эти продажи финансировали много R&D, то есть исследований и разработок. Процессоры iPhone внутри них продолжал улучшаться, улучшаться и улучшаться. И потрясающий партнёр Apple — компания TSMC — разделила их успех.

Наконец, 10 ноября 2020 года две линии на графике пересеклись. В отличие от прежних случаев, когда пересекались эти линии, а Intel выступала в качестве инноватора на рынке персональных компьютеров, сейчас Intel в другой роли. И теперь всего лишь вопрос времени, когда производительность чипов на базе ARM продолжит продвижение в последнее убежище Intel: серверный бизнес.

В чём угроза M1

M1 (A14) представляет угрозу для Intel и AMD не потому, что Apple внезапно собирается поглотить рынок персональных компьютеров. Вовсе нет. Прирост рыночной доли Mac в ближайшей перспективе вряд ли превысит несколько процентов.

Проблема для AMD и Intel заключается в том, что представляет собой M1. Впервые за 15 лет компания, не имеющая лицензии x86, создаёт микропроцессор для потребительского рынка, который вполне может конкурировать с чипами x86. Если Apple сохранит или улучшит свои позиции по отношению к Intel и AMD, это заметят и другие компании с лицензиями на ARM. Nvidia, которая купила ARM в ожидании одобрения регулятора, безусловно, заметит это. Если ARM может превзойти x86, то вся экосистема WinTel уязвима так, как этого не было с самого начала эпохи персональных компьютеров.

Intel и AMD ранее не приходилось беспокоиться о том, что делают производители процессоров, которые отличаются от x86. Если M1 (A14) и последующие процессоры Apple для различных сегментов рынка начнут откусывать долю рынка x86, это заметят все, включая OEM-производителей, которые в настоящее время строят компьютеры на процессорах x86. Возможно, Microsoft когда-то и поддерживала Intel, но при Сатье Наделле компания резко развернулась в сторону облачных сервисов. Если Microsoft хочет широко интегрировать Linux в свою собственную операционную систему, ей всё равно, работает ли Windows на ARM или x86. Долгосрочная угроза для Intel и AMD — это потеря маржи и рыночного влияния, если x86 больше не рассматривается как лучший процессор по умолчанию.

Возможно, M1 (А14) начал эту трансформацию на рынке.

Apple M1

Apple M1

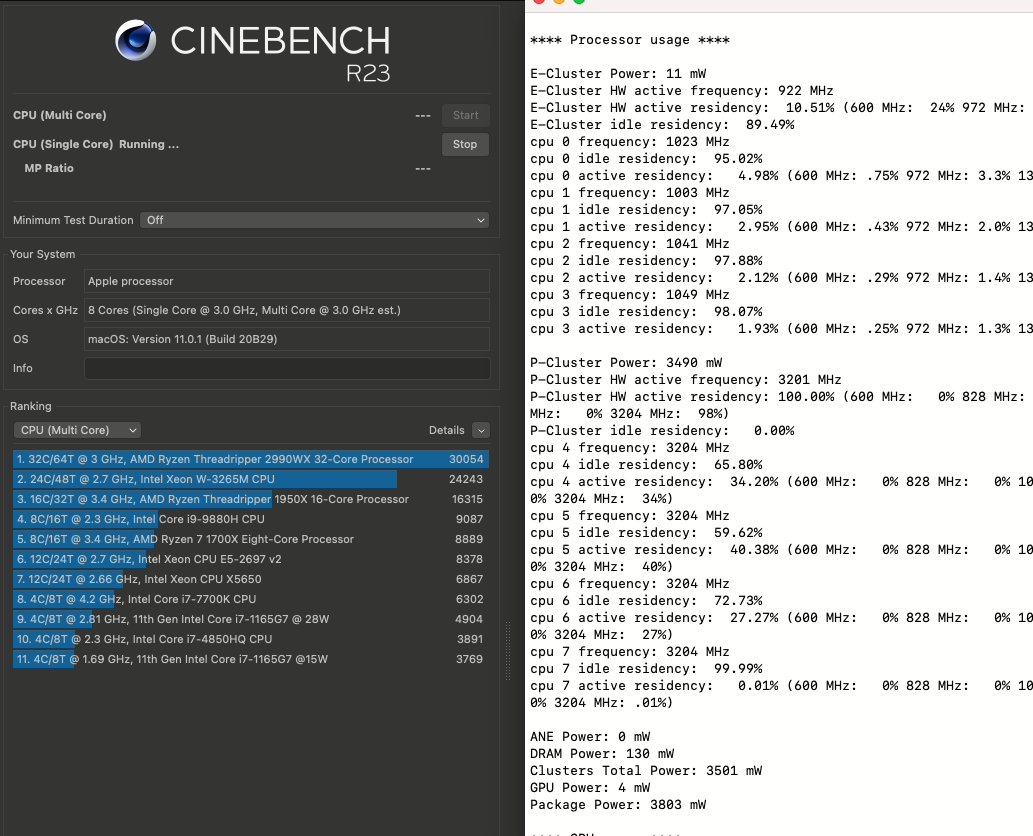

Сейчас процессор А14 в составе М1 имеет 4 больших и 4 маленьких ядра. Однако огромная производительность в расчёте на ватт позволяет надеяться на хорошую масштабируемость микросхемы. В течение 12 месяцев на свет появится A15. Не стоит удивляться, если это будет процессор с 6-16 большими ядрами, а в течение 18-36 месяцев мы увидим следующее поколение с 16-32 большими ядрами. И преимущество архитектуры ARM никого не будет удивлять на рынке и настольных компьютеров, и серверных систем.

Вот тогда Intel придётся по-настоящему плохо.

На правах рекламы

Наша компания предлагает в аренду серверы с современными серверными процессорами от Intel и AMD. В последнем случае — это эпичные серверы! Виртуальные серверы с AMD EPYC, частота ядра CPU до 3.4 GHz. Максимальная конфигурация — 128 ядер CPU, 512 ГБ RAM, 4000 ГБ NVMe. Создайте свой собственный тариф самостоятельно в пару кликов!

zaq1xsw2cde3vfr4

С трудом дочитал до половины. Статью закали Apple в попытке голословно обгадить intel, MicroSoft и возможно ещё кого-то (дочитал только до половины). Так пафосно распинаться о поглощении рынка, покрывая своими макбуками с макОС малюсенькую долю рынка.

Эту статью следовало в политических изданиях публиковать, а не в технических.

fzn7

Intel действительно упоролись своим положением собаки на сене. X86 обратная совместимость это здорово, но intel должна была сама возглавить разработку инновационных чипов. История Kodak их ни чему не научила

DancingOnWater

Одно слово: Intanium. Его похоронила отсутствие должной совместимости с x86

thatsme

Нет, Itanium похоронила дороговизна и отвратительная цена/производительность с очень узким рынком. HP его заказал, HP его похоронил.

Ситуация с ARM совсем другая. У него офигенно удобная для производителей модель лицензирования с очень невысокой стоимостью. И именно поэтому, процессоры на архитектуре ARM сейчас доминируют (по крайней мере в мобильном сегменте).

И ещё они лезут в серверный сегмент, предлагая меньший TDP, при сравнимой производительности (Amazon EC2). Также у ARM есть большой плюс для всех сегментов рынка, — отлаженные ОС, с многолетней историей.

Т.е. перенос софта на ARM с x86, — это вопрос поставки десктопов с ARM разработчикам. Apple делает именно этот шаг. Т.е. не для мобильных разработчиков, у которых это всё уже итак есть, а для десктопных. И закладтвает базу, для продвижения своей ОС вместе с «новой» (правильнее сказать проталкиваемой) аппаратной архитекутрой. Если ч-з 5 лет нёрды не будут хотеть убивать смузихлёбов за фразу «MacBook for gaming», это будет означать, что раскрутка от Apple удалась.

DancingOnWater

Давайте разделим мух от котлет. Apple И Intel.

Вот вы говорите, что у Itanium отвратительна была цена/производительность?

Вот производительность в каких задачах вы брали? Ведь оный на момент своего выхода (начало 2000-х) это конкурент Alpha. Причем успешный, если все пользователи последнего перешли на Itanium.

Проблема была в том, что в самом массовом сегменте на тот момент доминировала x86-архитектура, команды которой транслировались в IA64 очень плохо, таким образом, выйти к широкому потребителю было нереально.

Intel стала заложником успешности своего детища с одной стороны и конкуренции с другой.

Оно не могло вложиться в новую архитектуру, т.к. новая архитектура это кап вложения для разработчиков, которые они не хотят делать. Это с одной стороны.

А с другой нету никакой возможности вложиться на полную в новую архитектуру, т.к. конкуренты готовы урвать свой кусок. И AMD это активно делала.

Во всей этой истории я до сих пор не понимаю почему они не дали ход своей видеоархитектуре, т.к. их интегрированная всегда была уровне.

Gordon01

У них она была, но слишком наркоманская https://www.youtube.com/watch?v=um-1fAVU1OQ

https://ru.wikipedia.org/wiki/Larrabee

beeruser

Кормили сказочками.

Itanium был убыточным бизнесом для Интел вплоть до 2009г.

Забавно, что в том же году обанкротилась SGI, которая сделала ставку на Itanium.

bits.blogs.nytimes.com/2009/11/17/a-decade-later-intels-itanium-chip-makes-a-profit

Быструю видяху у них только Apple и выклянчивал. Поэтому они кое-как выпустили Iris. Ну и сейчас пытаются что-то сделать с Xe. Но очень долго запрягают. Пока что кроме несчастного TGL и аналогичной ВК для десктопа у них нет ничего.

amirosta

Вы мешаете в кучу успех у потребителя и успех у производителя.

Для того чтобы выйти на безубыточность нужны большие объемы производства. До достижении этих объемов вполне можно выпускать продукт как убыточный, планируя отыграться потом.

Если этого не сделать — покупатели ни будут раскачивать объемы покупок. Это может сделать только производитель.

alex-open-plc

Вы пробовали работать на титанике? (так прозорливо называли его эксплуатанты). Видать зря Oracle отказались делать СУБД для него…

Мне довелось «потренироваться» в работе на титаник+OpenVMS. Это нечто! Дикое количество ключей оптимизации, при этом практически никогда не удавалось достичь желаемой производительности. В общем титаник своё дело сделал. Утащил на дно OpenVMS и Alpha.

BD9

Не титаник, а Итаник.

Иначе не смешно.

thatsme

> Вот производительность в каких задачах вы брали?

Я не про производительность. А про цена/производительность. Бизнес считает деньги. А потом Oracle выпускает Exadata на х86, и хоронит супердома окнчательно, прекратив разработку ПО для Itanium в 2011, после заявления Intel о EOL Itanium.

Всё, — платформа мертва. Интел прекратил заниматься фигнёй избавившись от убыточного производства. HP не создал массового рынка для Itanium и не занял значительной ниши в Enterprise. HP-UX имел просто отвратительную поддержку в плане свежего ПО. HP не стермился создавать массовый продукт, он не создавал массовую экосистему, как это делали Intel&MS, и Intel&IBM&RedHat и куча других включая Google.

Itanium изначально был маргинальной системой, не оправдывающей своей цены.

DancingOnWater

Один из параметров ясен (цена), а второй?

Я никак не пойму, как это обосновывает утверждение, про соотношение цена\производительность в 2001 году…

thatsme

п р о и з в о д и т е л ь н о с т ь

spec.org, tcp.org

Создав дорогой процессор, удешивить который не смогла, и параметр цена/производительность вытянуть на уровень не смогла. HP не смогла создать рынка (внутри куча факторов, читайте пост выше).

Если ещё что-то не понятно, спрашивайте.

DancingOnWater

А вы, добрый человек, хам. Ну, ок, будем тыкать носом.

Вот два результата:

Alpha

Itanium

И снова я вас спрашиваю. По какой задаче вы меряете производительность: по вычислениям в гидроаэродинамике или по распознаванию изображения?

thatsme

Серьёзно? Сравниваете Alpha на 1150MHz с Itanium на 1500MHz? Ну ок.

Почему не сравнить с тем, что не умерло?

2007-й год SunFire X4100

98,857 QphH, 2.65 USD per QphH

www.tpc.org/tpch/results/tpch_result_detail5.asp?id=107102901

2008-й год HP Integrity Superdome

63,650 QphH, 38.54 USD per QphH

www.tpc.org/tpch/results/tpch_result_detail5.asp?id=108022701

www.tpc.org/tpch/results/tpch_result_detail5.asp?id=109090801

2009 HP ProLiant DL380 G6

51,085 QphH, 1.09 USD per QphH

Вы думаете Oracle, Exadata на х86-х запустила и линейку SuperCluster просто так похоронила, хотя SuperCluster на SPARC-ах в TPC-C например лидером был? Нет, не просто так, топ производительность за больше деньги никому не нужна. Нужна за разумнеы деньги.

DancingOnWater

Сравниваю два конкурента на момент выхода. А разницу в тактовых частотах Opteron в то время неплохо нивелировал.

Itanium вышел в 2001, Itanium 2 в 2002. Тогда же были и планы выхода на широкий рынок. Однако этого не произошло, т.к. x86 плохо выполнялся, а доп. козырь в виде 64-битной архитектуры успешно выбил AMD.

И отжимал со страшной силой долю, вплоть до 2006 года, т.е. до выхода Core 2. И в 2007 году вы сравнивать архитектуру в которую в течении 5 лет вкладывались деньги и проц, финансировавшийся по остаточному принципу, а потом делать вывод о том что его сгубило…

Про Exadata и SuperCluster не моя тема. Но Гугл говорит, что Oracle запустил Exadata в 2008 и сразу на x86, а SPARC-и им достались от Sun, которую они поглотили в 2009-2010 годах. А SuperCluster похоронен в 2019 году.

И опять же, для БД, на которые вы упираете, важен не сколько параллелизм (а это главная фишка Itanium), сколько размер кэша и скорость доступа к оперативке.

thatsme

Всё что вы написали, абсолютно никак не меняет ситуации, а именно: HP не создал массового продукта, сразу создав маргинальную дорогую архитектуру, просто проигнорировав по началу x86, а AMD&Intel создали, они создали рынки. Теперь точно также, все кто не запрыгнут на паровоз ARM, будут удивляться почему они нишевые, и сколько им жить осталось, с каждым годом всё больше платя за свою нишевость.

Все остальное значения не имеет.

Ваша демагогия, и припысывание мне, не изречённых мною слов, также значения не имеет. Ключевой показатель всегда будет цена/производительность, который напрямую влияет на возможность создания массового рынка.

bm13kk

Этот тред читать интересно. Обе стороны в чем-то правы. Аргументация у обоих есть и есть что почитать.

Если бы не переходы на взаимные обвинения.

Aberro

А я не понимаю, в чём проблема выделить одно-два ядра под x86 обратную совместимость, официально объявив, что x86 остаётся лет на двадцать только как поддерживаемая, а не развиваемая архитектура, с небольшим приростом производительности от серии к серии, и параллельно к ним добавить ядра с новой архитектурой?

Возможно, это и сложно с точки зрения разработки, но сложнее ли это того, чтобы медленно и мучительно пытаться перестраивать самолёт из старого кукурузника в аэробус прямо на лету?

ProFfeSsoRr

А разве интел позволяет сейчас кому-то взять и сделать x86-совместимый проц?

Areso

Я думаю, что VIA и прочие аутсайдеры процессорной гонки, но имеющие, тем не менее, лицензии и патенты на x86, вполне смогут лицензировать технологии за скромное вознаграждение.

en.wikipedia.org/wiki/List_of_x86_manufacturers

khajiit

Это будет что-то уровня Pentium-M в лучшем случае… Rosetta быстрее.

ProFfeSsoRr

И вот вопрос: зачем разрабатывать с нуля свои быстрые x86 ядра ради обратной совместимости с нормальной производительностью, если можно прямо решить поставленую цель «сделать быстрый ARM», ну а коли он быстрый — он и софтовый эмулятор достаточно быстро заэмулирует.

x67

Тут скорее вопрос, какая архитектура таки перспективнее. Но тут можно устроить кучу срачей на эту тему и ни разу не приблизиться к ответу на вопрос

И имхо, переход на арм это конечно важный шаг для эппл, более того, уверен, за эппл последует и майкрософт, сделав нормальную вин 10 для арм, но это не говорит о том, что интел обречена. У них много денег, опыта, тысячи специалистов своего дела и только их решения покажут, насколько интел готова к будущему. Несомненно арм отжимает солидный кусок рынка настольных ПК, но это нормально вполне и происходит уже не первый год

Aberro

Честно говоря, я не вижу перспективы за x86 в упор. Т.е. её всеми силами пытаются вытащить на пристойный уровень разными оптимизациями, но те же оптимизации в значительной мере можно применить и на других платформах, за счёт транзисторного ресурса (другой вопрос — стоит ли). Главный ресурс Intel — это как раз R&D. Которые могут любое говно вытащить. Что не отменяет того факта, что x86, простите, старое говно. И если бы ресурсы Intel направить на развитие более современной платформы, мы могли бы получить очень существенный прирост производительности на этой платформе. За исключением, конечно, совместимости (что, опять же, обходится совмещением разных архитектур на одном чиплете)

Aberro

Полагаю, чуда не бывает. И даже очень быстрые ARM ядра по производительности в режиме эмуляции x86 будут сильно уступать достаточно быстрым нативным x86. А в довесок ещё и проблемы совместимости в духе старых загрузчиков, старых прерываний и прочего. Что вроде бы и решаемо, но с болью, багами и страданиями. Ибо до режима эмуляции нужно ещё предварительно раскрутить процессор.

И всё это решается внедрением нативных ядер (грубо говоря, плюс один контакт, напряжение на котором определит на каком ядре этот проц будет работать со старта).

maximnik0q

>А разве интел позволяет сейчас кому-то взять и сделать x86-совместимый проц?

Вплоть до уровня 486-Пентиума: патентная защита закончилась или заканчиваеться (25 лет на железо, есть еще авторское книжное право, но можеш обозвать команды по своему или ссылаться на добросовестное использование). Можешь производить или эмулировать архитектуру, другое дело кому такой уровень сейчас нужен.

rogoz

Вроде как 20 лет, и уже до уровня Пентиума 3, а скоро будет Пентиум 4 (SSE2), что позволит сделать процессор, который может выполнять даже современные x86-32 программы.

NetBUG

И это в тот момент, когда современные ОС как раз отказываются от поддержки 32-битных приложений?

maximnik0q

>Вроде как 20 лет

В США -25 лет.Срок действия патента зависит от страны патентования, объекта патентования и составляет от 5 до 35 лет (ГК РФ Статья 1363, ГК РФ Статья 1424).

rogoz

Что я видел в англоязычных источниках — 20 лет.

Вот, например, вроде связанно с FMA: patents.google.com/patent/US8745119B2

maximnik0q

>Что я видел в англоязычных источниках — 20 лет.

Суды США разрешили продлевать до 5 лет срок действия патента- в случае засекречивание патента, обоснование окупаемости разработок по технологии патента и в случае дополнения или усовершенствования патента. В общем из-за патентных троллей непонятная ситуация, поэтому юристы перестраховываються и рекомендуют исходить из срока 25 лет, если только сам патентообладатель не заявил что срок истек или предоставил в публичную собственность

Aberro

А что не позволяет самому Intel сделать то, о чём я говорю?

ProFfeSsoRr

Интел ничто не мешает, но только эпплу это зачем? Если они хотят перейти на свои процы — зачем им оставлять ядра x86? Тут как раз нужен баланс между «вот у нас есть эмулятор, чтобы вы могли быстро че-то запустить» и «эмулятор недостаточно быстрый, вы все-таки следующую версию своего софта нативно напишите, а то юзеры не будут рады».

popov654

Мобильные разработчики сейчас пользуются для отладки эмуляторами (включая владельцев MacBook, к слову). Разве нет?

thatsme

Ага, я возможно вас понял. А у вас эмулятор для М1 с MacOS X есть? Или для любого другого десктопа на ARM под Linux? Или под Win for ARM? Ну т.е. мобильная разработка это одно, десктопная, чуть-чуть другое. И даже если о серверной разработке для ARM говорить, — в эмуляторе невозможно сложить адекватное представление о производительности.

Loggus66

Уверен, что большинство разработчиков тестируют ПО именно на QEMU, иначе Debian не смог бы выйти на aarch64 уже в конце 2014 ввиду отсутствия железа и дороговизны плат разработки в то время.

thatsme

В этом всё и дело. Кросс-компиляция ОС это одно. Мантейнеры дистрибутива переносят пакеты. Долго и печально, пока cross-toolchain отлядят, пока одно и другое оттестируют. А потом в любом случае берут железку, что-бы ОС на ней запустить и проверить, т.к. эмулятор всех особенностей конечного железа не эмулирует. А теперь к массовому разработчику. Много-ли желающих устраивать себе такой геморой? Нет, только энтузиасты, и штучные фирмы. Почему? Потому, что это создание рынка ПО, для платформы которой ещё нет (я про десктоп). А где разработчики игр? А они не работают с платформами которых ещё нет. Даже для будущих коснолей рынок создаётся, и разрабы получают материалы и образцы заранее.

Почему Linux не завоевал десктоп? Потому, что игры для него пишут в 100 раз реже чем для Win и консолей. Все отговорки про «линукс сложен для домохозяек», — бред. Эта сложность скрывается без проблем при вкладывании бабла (и в разработку и в маркетинг), как это было сделано с Android. Это как раз и есть создание рынка. Для десктопов на Linux, никто не создаёт рынка, и если пытаются, то мелковато, и рынка выстроить не в состоянии.

Игры это просто пример. Возможность делать массовый продукт вот, что важно.

Почему Chrombooks до сих пор существуют на ARM? Потому, что есть рынок. Который создал Google. Скрыв сложность Linux от домохозяек. Google в это вложился и создал рынок. Теперь тоже самое делает Apple. Причём пока в той-же нише примерно.

Массового универсального десктопа на ARM, не существует. Его нужно создавать, создавая рынок.

Areso

Смотрю на свою библиотеку в Стиме и не согласен. Примерно четверть игр портированы на Linux. Спасибо дядюшке Гейбу, еще столько же запускает Протон.

quwy

Тут даже цифра 90% отобъет охоту у 9 из 10 потенциальных клиентов. 10% не идущих игр (причем, скорее всего, самых свежих и хайповых) заставят почувствовать себя неполноценным любого заядлого геймера. И ради чего?

khajiit

Так для ублажать хайпожоров есть консоли.

А на ПК до выхода первого/второго

сервиспакаSeasonPass заядлые геймеры как раз и не смотрят — там еще в Discples II и HoMM III не все переиграно.Storan

Консоли давно уже в реальности не про хайп и блаж.

Вот, буквально новое поколение выкатили — и они со старта уже слабее нынешних игровых компьютеров (правда пока лишь топовых, но ведь компы станут мощнее через год, ещё мощнее через 2 и т.д.), и вовсе без эксклюзивов приставочных.

То есть по факту, для рынка Европы/Америки консоль — это в первую очередь очень дешёвая железяка для игр ~0.5k$ vs ~1.5k$ у PC, но с тем же самым набором игр (и по той же стоимости что немаловажно, там же нет региональных продаж на компах по ценам в 2k–3k ?).

khajiit

То есть, у этого автоматически пропишется в системнике Ryzen 6950X, а то и целый TR X990 и парочка 4090? )

Топовое доступное на рынке к массовому отношения не имеет.

Смотрит на цену 2077 в steam и psstore

Ню-ню. Консоли — это, прежде всего, сервис и унифицированная программно-аппаратная среда, т.е. отсутствие типичных софтовых заморочек.

Areso

Зато там есть скидки в 85%, которые в приставочных сторах появились лишь недавно и то не на всё.

Плюс на старые игры цена со временем уменьшается (издатели снижают «полный ценник»), а когда появляется скидка 85%, то это просто улёт.

К этому добавляем всякие humble bundle ($12 за месячную подписку с 6 играми на выбор из 24), оттуда же берём игры по $1, и так далее.

У меня в Стиме три аккаунта разных стран, поверьте мне, я знаю, о чём говорю.

Даже в США можно достаточно дешёво покупать игры. Если не гоняться за хайповыми тайтлами. А в этом помогают вышеупомянутые HoMM 3 и Disciples 2.

sumanai

А вы знаете, что нарушаете правила? Просто не вижу смысла в таких покупках.

Areso

Я могу либо пиратить, либо покупать игры, недоступные в моём регионе, на американский аккаунт. Предпочитаю второе.

Обычно американцы и европейцы заводят аккаунты развивающихся стран ради экономии, у меня американский аккаунт не ради экономии.

VolCh

Конкретно за Стим не скажу, но в некоторых сервисах мне поддержка рекомендовала заводить аккаунты для разных стран, как стандартный способ разруливания ситуации "гражданин одной страны и резидент другой страны"

thatsme

Дело даже не в играх, игры, это просто пример массовости применения. Возможность спрятать сложность как для потребителя, так и для разработчиков контента, — основное условие для создания массового продукта. Как велосипед — просто.

burzooom

Вы про новый электродвухподвесный Specialized Epic Levo интеллектуальными задним амортизатором с платформой, регулировкой отскока, компрессии, и беспроводным управлением? Да, простой механизм, всего 14000$

thatsme

Нет, я про: телевизор, видеомагнитофон, CD/DVD/BluRay-player, игровые консоли, телефон, велосипед, смартфон, планшет, холодильник, стиральную машину, и т.д. Бытовое применение со скрытой сложностью, — массовый продукт.

chupasaurus

Debian-у первые железки подарили ещё в марте 2014, а сам порт начали готовить практически сразу после анонса архитектуры в 2010.

amirosta

При эмуляции x86 только.

В нативном режим Itanium себя хорошо показал.

BD9

Враньё.

HP судилась с Интел чтобы Интел продолжала выпускать Itanium. Интел не смогла написать хороший компилятор для него.

Если бы AMD не сделала AMD64, то сидели бы на Итаниумах щас.

После покупки ARM Нвидией и разрушением Трампом свободного рынка этот ARM стал нафиг никому не нужен. Переходят на RISC-V или OpenPOWER.

Яблоко влило денег в продвижение своего проца, и

всенекоторые тут начали его расхваливать.Серверные ARM много кто делает, пока не преуспели особо.

ProFfeSsoRr

quwy

Не любого человека, а любителя надкусанных яблок. Это они умеют, да. Но тех, кого в секту затянуть раньше не удавалось, не получится и сейчас. Очень уж многих раздражает такой подход к технологиям и маркетингу.

VolCh

Ну вот после анонсов и обзоров М1 я в первый раз серьёзно задумался о покупки Air, а то не читал, но осуждаю. )

sshikov

Ну, не все задумались. Хотя бы потому, что высокая автономность многим нафиг не сдалась. Ну вот зачем вам ноут с работой от батарейки 20 часов? Все равно ведь в лес его на неделю не возьмешь, а в обычном суточном рабочем режиме всегда можно зарядить. Т.е. есть некий лимит автономности, выше которого уже бессмысленно ее наращивать. А вот скажем текущий декларируемый лимит на объем памяти 16Gb — это засада так засада.

P.S. У меня вот вообще два ноута, и все живут от розетки. Всегда. А мобильным является телефон или планшет. Ну и там да, ARM, в телефонах-то.

Areso

Я много путешествую, часто бываю на всяких конференциях, движухах, мероприятиях. Там можно найти розетку — как правило — но сидеть привязанным к розетке весь день значит пропустить большую часть движухи.

Поэтому у меня все ноутбуки живут не меньше 6 часов от батареи, это одно из обязательных требований при выборе и покупке.

20 часов — очень круто. Это когда утром туда, днём там, вечером обратно. Всё это на самолётах / поездах. Грубо говоря — гарантированные сутки работы (с перерывом на сон) в реальных условиях.

sshikov

А зачем вам сидеть привязанным? Вы же не можете заниматься движухой больше скажем 16 часов в сутки — потом вы все равно ложитесь спать.

Ну т.е. я согласен, что 20 это круто — но это практически предел. Я бы даже сказал, что предел это 24-8 на сон, или еще меньше. И больше никому практически не нужно. И да, работать 16 часов вредно, это я вам уверенно говорю.

Areso

Смотрите, 20 часов, заявленных производителем, это при 50% яркости, с отключенным wi-fi, при наборе текста в notepad или воспроизведении видео хардварным ускорителем. То есть это сценарий во сферическом в вакууме.

В реальности там будет включен wi-fi, будет работать IDE, например PyCharm, который при каждом допечатывании условного класса или объекта нагружает проц под 100% (пилорамная нагрузка, вверх-вниз), браузер (о прожорливости JS кода не говорит только ленивый), что-то там еще. То есть реально время работы будет меньше. Причём, я думаю, минимум на треть.

И потом, я не работаю 16 часов, я могу на движухе быть 16 часов, а это не работа, это развлечение (раз в месяц-два). Наконец, ну сидишь в аэропорту, в самолёте или в поезде, делать нечего. Достаёшь лэптоп и фигачишь.

К примеру, написал систему деплоймента средней руки проекта именно в аэропорту. Ну получилось так, нахлынуло вдохновение.

В другой раз летал — написал торгового бота.

sshikov

Знаете, если бы я в молодости не работал по 12 часов, я бы сегодня возможно был более здоровым, чем есть. Так что — просто не советую.

И потом, я изложил свой сценарий, он вполне типичный — многие ноут вместо настольной машинки держат только ради того, чтобы перенести от одного стола с розеткой до другого. Иногда — выйти в переговорку (где тоже есть розетки и экран). В моем окружении это практически все. Я не говорю что это все — но таких много.

Wingtiger

Не в качестве спора или наезда.

Не такой уж молодой и с детства не здоровый, 3 работы, 14-16 часов в сутки только где-то на работе не считая дороги и 6,5 дней в неделю…

А что делать, если зарплаты с этих 3 работ едва дотянули до половины средней по области? Что на одну не проживёшь, а уехать — нормально оплачиваемую работу не смог найти

Areso

Раз уж начали оффтопить:

предлагаю воспользоваться моментом и найти удаленную работу (пока бушует пандемия, даже банки вынуждены держать бОльшую часть айти сотрудников на удаленке).

Сейчас даже ручным тестировщикам-джуниорам платят вполне достойно. Если вдруг не вы не админ и не умеете программировать.

P.S.: я почти так и сделал. Осуществил давнюю мечту — найти работу в другом городе без переезда.

wormball

> Не такой уж молодой и с детства не здоровый, 3 работы, 14-16 часов в сутки только где-то на работе не считая дороги и 6,5 дней в неделю…

Не здоровый? Гагарин по сравнению с вами овощ на искусственном дыхании. Вы вообще спите? При таком здоровье вам прямая дорога на олимпийские игры — все медали соберёте.

> А что делать, если зарплаты с этих 3 работ едва дотянули до половины средней по области?

С такой работоспособностью минимум в Москву можно ехать чисто на авось автостопом без гроша в кармане. Что за область и что за работы хоть?

sumanai

Не уверен, что она есть. Так то и улицы можно мести по 14 часов в сутки. Правда мне кажется, что даже дворником можно заработать среднюю по области, если так упахиваться.

Areso

Вы же когда-то работали в МУПе/ГУПе, если мне память не изменяет. Много зарабатывали?

sumanai

Нет в ГБУЗе. Для 2011 года зарплата была неплохая, я мог себе позволить флагман от Самсунга. Но зарплата забыла вырасти после падения рубля, а сейчас работая программистом я не могу себе позволить тот же топовый самсунг.

wormball

Улицы мести по 14 часов в сутки — по-моему это уже сверхчеловеческий подвиг. А вот сторожем 14 часов в сутки — вполне. И зарплата такая и будет, наверное.

Wingtiger

недавно заменял сторожа — днём сидишь админом, ночью спишь сторожем, опять днём админом… Но почему-то устаёшь будто работал физически. То есть ночью отдыхать не получается.

А зарплата раньше была на 1 тыр больше, чем вышенаписанное "днём админом", сейчас она заметно меньше. Ну и оно "сторож-истопник-дворник_у_здания"

Wingtiger

нельзя. Им платят столько же (сколько инженерам, эникейщикам и "почти админам"), но при этом вакансий дворника давно нет, заняли пенсионеры.

Wingtiger

день техником-админом, 2-4 часа на прежней работе эникейщиком и до 22-23ч у знакомого на мебели, где на данный момент из постоянных работников остался я один (кто болеет, кто уехал домой в другой город...)

sshikov

Ну а вы думаете, я всегда что-ли ради развлечения по 12 часов и т.п.? Нет, было по-разному. Но итог в общем одинаковый.

И кстати да — удаленка. По нынешним реалиям все почти ее предлагают. За последние пару месяцев мне приходило штук пять предложений пообщаться, и пару раз удаленку предложили с ходу, даже не спрашивая меня.

cepera_ang

Это одна из тех вещей, о которых не задумываешься, пока их нет.

"да зачем мне отходить от розетки? Да зачем мне лишняя автономность? Да зачем мне ноутбук, который можно на два выходных взять без зарядки?"

А на практике — нет никакого лимита, после которого нет смысла наращивать автономность. Если бы ноут тянул месяц от зарядки (как старые мобильники) — было бы прекрасно. Ушел бы тикающий в голове таймер "а ты не забыл зарядку? А хватит заряда? А сколько там ещё осталось? А там куда ты идёшь будет розетка? А если запустить сейчас рендер или игрушку, то сколько реально минут оно протянет?"

VolCh

С другой стороны, так зарядка мастхэв, как ключи. А когда её раз в месяц только нужно использовать, то наверняка понадобится когда рядом не будет.

Areso

Зарядка это не только ценных мех, но и полкило веса в рюкзаке.

Chamie

Если ноут живёт месяц от аккумулятора, то ему и для работы должно хватать зарядки от мобильника.

VolCh

На фоне 4,5кг ноутбука и 1 кг сумки я пренебрегаю

Areso

Боюсь, что меня с такой бандурой в самолёт не пустят.

У меня настольный ПК в сборе легче, всего 3 килограмма :)

Chamie

Так это потому что без аккумуляторов!

sumanai

А там точно всё? У меня один охлад на ЦПУ около 1кг, а сборка переваливает за 20.

Areso

Точно всё. Это «мое виденье» как свободного

художникаинженера на тему Steam Machines. До того как они появились, и после того, как они сгинули в небытье.Core i7-4770 4C/8T 3.4 (3.9), 16GB, GTX 1050 Ti, 2*2,5 SSD в алюминиевом корпусе и с блоком питания на борту (правда, поскольку я начал до Steam Machines, то корпус делал под более распространенные тогда PSU TFX, а жизнь показала, что надо было под PSU SFX делать).

Размер 300*250*90, объем 7 литров.

Учитывая, что с первого дня жизни этого проекта я сменил 5 городов, то мне кажется, что идея была выигрышной.

VolCh

Похожий конфиг, кстати, у меня, только ещё 17" монитор и аккумулятор.

cepera_ang

Ну, то есть 12 шансов в год так подставиться. А если каждый день нужна, то 365 :)

VolCh

В расчёте на день вероятность сильно повышается, если надо раз в месяц заряжаться.

cepera_ang

Ну да, можно просто завести правило — заряжаться не позже 20% и тогда у тебя всегда будет неделя запаса работы :)

Zverienish

Ну люди ведь заряжают не именно когда достигает полного разряда. Если месяц работает и человек каждый день пользуется, то он временами будет подзаряжать его в течении месяца.

VolCh

С нокией 3310 это плохо работало )

Zverienish

Ну телефон в те времена часто в кармане болтался. С ноутом часто бывает что на столе. Если подключать к монитору по TB, то вообще заряжается. Да и сигнализировать можно начинать за пару дней.

AquiHostStrider

Железная аргументация! Мы, наше царское величество, властью, данной нам Богом, заявляем: автономность ноутбукам не нужна.

Бандура 14" стоимостью over 1k$ в лесу действительно не нужна. Такие машинки обычно едут с хозяином в автомобиле и носятся в дипломате или специальной сумке. Хотя, у кого-то бывает ещё такой кейс — научная экспедиция в труднодоступные места, куда можно разве что заброситься вертолётом.

Чтобы заряжать его также часто, как и смартфон — раз в 2-3 дня. Аккум дольше проживёт. И начнёт умирать уже тогда, когда сам ноут морально устареет.

Вот силюсь всё себе представить, где ж этот самый лимит есть. Вот были бы ноутбуки, которые могли бы работать неделю — тогда их можно было бы смело брать в отпуск, и не переживать, что в гостиницу не завезли розеток нужного вида, напряжения и частоты. Лимит автономности в настоящее время диктуется исключительно массой и размерами АКБ, а никак не длительностью работы.

sshikov

>Да ну?

Ну да. Я сказал «многим», а не всем. Если вы не умеете читать — это не мои проблемы. И не надо хамить в ответ.

VolCh

Не ради автнономности, у меня тоже ноут живёт от розетки всегда, если не забыл включить придя в офис или домой. Тут именно поиграться хочется ) Технически интересная штука получилась, кажется, если получится линукс и/или докер завести

sshikov

Не, ну поиграться — это святое :) Но лично меня прямо тут строго останавливает 16Gb. Ну что это за размерчик для работы?

Zverienish

Да, зачем такая же по характеристикам машина, но жрущая в два раза меньше. Ну проедет в два раза больше на баке. Чистой воды маркетинг.

sshikov

Ну вообще менять железки на новые (с низким потреблением) позволяют себе обычно конторы типа ЦОД, где потребление огромное. Никогда не видел, чтобы это делали для настольных машин или ноутов.

А вы что, реально верите тестам? Я думаю как раз это чистый маркетинг. Ну не на 100% конечно, но точно не без этого.

Ну и потом, мне вот нужно обновить машинку. Что вы думаете я буду ставить в первую очередь? Память до 64Гб.

Хотя я заранее согласен, что такие люди, кто рассматривает покупку HP ZBook — они меньшинство.

Zverienish

Все равно меняют и ротация идет, где-то быстрее, где-то медленней. И вот тот же сегмент ультрабуков может сильно покачнуться в сторону макбуков. Вчера только смотрел по цене. Макбук 13 про выжрдит дешевле при тех же характеристиках, чем леново экстрим. При том дешевле выходит машины с процем i5 и экраном с меньшим разрешением, яркость и цветопередацей. Да еще и тач раза в полтора меньше. Про звук даже и говорить смысла нет.

И если нет привязке к платформе, то зачем за худшее переплачивать.

По поводу тестов. Эти тесты кто только уже не выкладывает. Люди компы уже с 16 числа вроде бы получают. Так что тестам верю.

sshikov

>И вот тот же сегмент ультрабуков может сильно покачнуться в сторону макбуков.

В такое как раз вполне верю. Хотя сам не беру, предпочитая что-то типа HP ProBook в дешевом сегменте, как обновляемые, но понять такую покупку — легко.

uzverkms

Даже если 20 часов автономности не нужны, там есть другие интересные свойства. У ноутов — неплохие экраны, а в целом у линейки M1 — хорошая производительность в мультимедийных задачах, которыми часто занимаются энтузиасты. Фото, видео, звук — редактирование вот этого всего. А 16 ГБ оперативки «обычному человеку» ещё надо постараться чем-то забить. В быту самя ресурсоёмкая задача — компьютерные игры. Так для них больше 16 ГБ до сих пор не нужно. А тем, кому надо виртуалки крутить и прочую не совсем бытовую экзотику — так надо соответствующий инструмент подбирать, а не сетовать на недостатки конкретно этого.

VolCh

Недавно видел серию бенчмарков по играм, так там разница между 8 и 16 на уровне погрешности измерения.

Zverienish

Тут и объяснять не надо, все тесты говорят в пользу М1

bm13kk

Меня второй года интересует, почему все берут риск5 и никто не хочет опенПавер.

Можно пример, кто взял опенПавер и начал делать на нем новый продукт за последний год?

BD9

ПМСМ, RISC-V есть замена ARM, а OpenPOWER может заменить AMD64, особенно серверные. Но эти серверные AMD64 слишком хороши от AMD и Intel.

А в общем, тоже удивляюсь.

bm13kk

Серверных технологий сущуственно не хватает в рабочих станциях. Сейчас работа делится на бумажную (чаты, почта, веб, ххх-офис) и профессиональную (кодирование, проектирование, создание медиа и прочее). И очевидно деление.

Мне и большинству читателей хабра нужен настольник с серверныими технологиями. Замена железа хотсвопом, как явный пример. Хотя на самом деле — всяки мелкие фиксы совместимости. Которые полностью игнорят для "десктопов" и дают только серверам.

Я был бы рад ПСИе карте с армом или риском, куда я мог бы залочить (например виртуализацией) бумажную работу. И быть увереным, что говно-софт на електроне не мешает (не жрет ресурсы) моему куберу работать.

BD9

Дык всё есть, просто не в РФ, ибо дорого по сравнению с ценой рабочей силы. А так были и есть Xeon для рабочих станций, и Threadripper, где и много ядер, и ECC, и прочая.

VolCh

И даже для ноутбуков

AquiHostStrider

Dr_Faksov

Это НЕ обычный пользователь.

Ну и прикиньте, сколько надо вложить денег, и сколько потом продать устройств, чтобы получить прибыль.

Zverienish

Берете малинку и делаете это все.

Gordon01

Были геймерские карты с подобным функционалом — не пошло.

Но в целом, вы описали функции типичного роутера. Так почему бы его и не взять?

quwy

А что это дает, кроме невозможности автономной работы? Только экономию порта на свиче?

Если делать плату расширения с чужеродным процессором, то уже как полноценный сопроцессор, на котором будут запускаться приложения для этого процессора. Как Orange386 на яблоках 90-х годов.

Zverienish

Да такое единицам нужно. Очень много девелоперов с ноутов работает. На удаленке так это большой плюс, нет привязки к месту.

maximnik0q

>HP его заказал, HP его похоронил.

Это слишком темная история.Это был типа совместный проект.Зачем менеджеры НР похоронили свой успешный процессор не понятно.(ходят слухи про утечку инфы о переговорах Бабаяна с SUN) Да они отставали по частотам про сравнению с тем же Alpha.Но был очень экономный процессор, у них при хорошей производительности кэша 2 уравня долго не было, только в последних перед закрытием появились.А так был лидером по командам за такт-до 6 шт с арифметикой!

phdnk

Может у Itaniumа есть еще шанс, например если ему укоротить бандл команд?

Сделать Not So Long Instruction Word. Насколько я понимаю, именно с шириной VLIW был допущен просчет, что потом компилятор не мог наполнять бандлы командами. При этом остальные идеи в IA-64 весьма ценны и их жаль в стол хоронить.

beeruser

Там и так 3 инструкции максимум. Куда уж ещё укорачивать?

В современных реалиях эти идеи гроша ломаного не стоят.

Предел возможностей Itanium это линейные циклы с вращением регистров

netch80

У него нет шансов, пока из-за тормозов DRAM получается, что из L1 получить данное это 1-2 такта, а из DRAM — до 200 (иногда и больше). Эта неровность убивает любое пред-планирование команд.

Хотя можно, конечно, комплектовать SRAM?ом. Для некоторых задач и 10-15-кратное удорожание оперативной памяти вполне сойдёт… там и кэш будет не нужен...

Дело не в ширине, дело в том, что оно explicitly parallel instruction computing.

Это какие же?

amirosta

Разве у ARM нет обратной совместимости?

n0isy

Ох. Там в x86 такая совместимость с прошлыми поколениями, что даже количество опкодов сложно подсчитать.

Zverienish

МС не обгаживали. Они вообще молодцы вовремя дивесифицировали рынок. И теперь если даже весь десктоп упадет, они выживут. А вот Интел и АМД да. Не удивлюсь, если в ближайшем будущем АМД выпустит на АРМ архитектуре процессор.

zaq1xsw2cde3vfr4

Весь десктоп никуда не упадёт. Есть туева куча задач где производительность важнее «энергоэффективности». Собственно говоря x86 тоже не стоит на месте в удельных энергозатратах.

Я не хочу сказать что нет косяков у intel, AMD или MS, но статейка откровенно попахивает чёрными PR'ом от Apple.

theschmidts

Intel должен бояться не Apple, а как раз Nvidia: именно они сосредоточили у себя разработку и cpu и gpgpu.

Самое смешное, что я в 2007 году лично слышал от маркетинговой шишки Интел рассказ о том, что будущее за носимым компьютером/телефоном и что это будет главный рынок. Забавно, что, все понимая, эти этот рынок проспали.

StjarnornasFred

Они пытались не проспать: были смартфоны на Атомах. Кстати, процессоры по тем меркам были весьма неплохие, на них даже флагманские устройства делалась (Lenovo K900, например). А потом… Ну, это уж нам неведомо.

MockBeard

точно, Asus P750 на Intel XScale до сих пор вспоминая с теплотой, хотя очень сцуко дорогой ))

dvrpd

XScale — это всё-таки ранний ARM, а не x86.

BD9

Ранние ARM — это 80-е — начало 90-х.

XScale — никак не ранний.

MockBeard

я в курсе, имел ввиду, что для своего времени Intel делал хорошие ARM-ы (по производительности и энергопотреблению)

NetBUG

Уже на Marvell XScale.

В 2006 году продали.

tmin10

А потом под ними не всегда запускался софт из-за процессора, увы( Хотя и очень редко такое встречал.

lonesimba

Или Asus ZenFone 2… через год после покупки сдох правда, точнее, графика померла.

Ivanii

14 лет назад Интел изготовил и тестировал 80ти ядерный процессор заточенный на потоковую обработку данных

hitech.tomsk.ru/2006/09/29/idf_fall06_intel_demonstriruet_80jadernyjj_processor_s_proizvoditelnostju_v_1_teraflop.html

www.ixbt.com/news/hard/index.shtml?07/75/60

VladVR

А сейчас такие же новости ходят про процессор из 256 атомных ядер или даже 512

Areso

Речь про nVidia Tegra? Они что-то не очень «взлетели», даже несмотря на пропеллеры /s

Revertis

В первую, «сверхинновационную» Тегру забыли положить блок команд Neon, поэтому там видео тормозило. Так и похоронили :)

Areso

После этого была Tegra 3 (и на ней были даже устройства без пропеллеров, смартфоны и планшеты), а позже были X1 и последующие модификации, и вот они все как бы хотели активного охлаждения.

Я помню, как облизывался на nVidia Shield Portable (Console). Но в результате вместо того, чтобы купить классную штуку, купил доллары (не прогадал).

WHATrushka

Сейчас они свою Тегру вполне успешно ставят в Nintendo Switch, которая отлично продается.

Areso

И даже воспроизводит игры в 480p в мобильном режиме.

Не поймите меня неправильно, но это как-то не пахнет массовой революцией. Скорее — нишевым рынком. Я знаю одного человека со Свитчем, и десятка два — с айфонами.

Yuuri

В 720p всё-таки.

И 65 миллионов проданных устройств — это немаленький такой «нишевый» рынок.

Areso

Речь не про экран, а про рендер.

www.eurogamer.net/articles/digitalfoundry-2018-switch-mobile-mode-analysed-in-unprecedented-detail

И там числа еще ниже называются. От 360p и далее 432p, 480p, 540p, в зависимости от игр и сцен… Динамическое разрешение, оно такое.

NetBUG

У меня был планшет от Asus на тегре3.

Про проц ничего плохого не скажу, а 1 ГБ ОЗУ было маловато.

Zverienish

К стати до сих пор выпускают и пользователи довольны приставками на них. Вот в следующее поколение армов если сделка пройдет, вполне может попасть нвидиовская графика.

Areso

И в них всё также ставят пропеллеры, по крайне мере в старших версиях.

Даже в 2019 году (когда было последнее обновление).

SkyPhantasm

Статья именно об этом. Intel должна боятся Apple не потому что они захватят традиционный для них рынок, а факта того что она приведёт на этот рынок ВСЕХ владельцев лицензий ARM. И вот как раз они и могут рынок отобрать. И да, Nvidia это первый претендент на эту роль. Но не стоит забывать что есть еще Китай, и вот он то вообще ящик пандоры — AMD Nvidia Intel Apple это всё компании США. Кто бы из них не победил в войне микропроцессорных архитектур, это победа США. Но десктопные ARM процессоры это новый рынок, а Китай на примере 5G показал как он может проявлять себя на таких рынках.

Areso

Буквально недавно была новость, что китайцы по поводу ARM так не считают.

bonta

Так себе будущее если оно за носимым компьютером смартфоном. Ни к чему такое ухудшение и редуцирование пользовательского опыта.

Понятное дело смартфон, планшет и ноутбук это удобно, но они не сравнятся с десктопом.

VolCh

Вот не понимаю, почему не сравнятся? Что позволяет десктоп, чего не позволяет смартфон с тем же набором периферии? Я сейчас не про производительность, если что.

wholeman

Во-первых дело как раз в производительности. В десктоп всегда можно напихать больше памяти и процессоры всякие помощнее поставить — там нет необходимости экономить место и энергопотребление, поэтому тяжёлые игры, 3D, компиляция больших систем на носимых устройствах неудобны. Что касается простых офисных задач, то с ними большинство современных телефонов, позволяющих подключить монитор и мышь с клавиатурой, вполне справятся (хотя часы вряд ли скоро до такого дойдут).

А во-вторых, x86 позволяет достаточно легко поставить любую ОС, тогда как для носимых устройств это не всегда возможно в принципе. Конечно, для большинства пользователей это не важно, но, например, для меня — один из основных критириев при выборе устройства.)

Zverienish

И кому оно надо больше памяти процессоров чтобы просто было? Единицам. Половина населения земли в интернете сидит почти только с телефона.

wholeman

Я написал, «тяжёлые игры, 3D, компиляция больших систем», можно ещё, например, обработку видео добавить. Думаю, что сейчас реально десктопы мало кому нужны, но такие люди всё ещё есть. С телефона даже смотреть неоптимизированные сайты неудобно, не то, что что-то писать. Хотя некоторые и довольно большие тексты набирают — по артефактам видно.

Areso

Телефон даже эту страницу открыть нормально не может с уведомлением о количестве непрочитанных сообщений. Просто зависает на несколько минут.

Snapdragon 636, 4 ГБ ОЗУ.

Zverienish

Ну так этот проц появился почти 3 года назад. И изначально был рассчитан на нижний-средний сегмент. У меня на 2х леней давности хоноре, в начеле пока страница грузилась подтупливал. Загрузилась и быстро ее проматывает без лагов.

Ivanii

Readme Note 5 6/64, Snapdragon 636, в Яндекс браузере, не мобильная версия, сама статья открывается быстро, домотав до начала комментариев затуп секунд на 20 и заколебешься мотать комментарии до концано без тормозов и подвисаний.

П.С. При свободной памяти вообще не подвисает, а если активно махать рукой то и комментарии пролистываются быстро. Памяти отжирает порядка 700 МБ.

Chamie

Браузер не указали. Посты с тысячами комментариев, например, судя по обсуждениям, ФФ открывает без проблем (подтверждаю), а Хром тормозит даже на i9.

dravor

Вообще, если отвлечься и подумать, то удивительно такое слышать в 2020 году, когда все уже просто носятся с утверждением что будущее, оно за числодпробилками: обработка биг дата, распознавания, ML/DL, генерация видеопотока с высокми битрейтом и кодеки к нему, дедупликация данных на ZFS RAID и т.п., смарт-контракты на blockchain и куча всего. А 6 млр хомяков со смартом в кармане будут потреблять ровно то, что для них сделают. Все эти фуфелы с постами в фейсбук из серии «Crowd Sourcing» — не они будут задавать тренды или генерить новую НТР.

В конце-концов, на чем создавать обещанный голивудом скайнет?

Wingtiger

на китайских армах где вместо каждого нейрона один китаец

sa1ntik

А можно и про неё. Флагманские модели значительно обгоняют всякие там нижнесегментные офисные машинки. Причём даже флагманы прошлых лет.

Но да, если прикрутить тот же объём периферии и допилить ОС — пользоваться смартфоном будет ничуть не менее удобно (по крайней мере для обычных офисных задач, я не предлагаю на нём чертить в электротехническом САПРЕ, которого туда не завезли, или пока не завезли).

Плюс USB Type-c, который стал универсальным стандартном и для зарядки и для передачи данных и для вывода изображения на экран (но, пока, увы с оговорками).

В итоге именно смартфоны могут сделать идею BYOD реальностью.

bonta

А вы измеряли производительность? Т.е. все эти многоканальные системы доступа к памяти, большая память, больше кэши, честные ядра (без малых и больших), на столько быстрые ядра, что родилась технология HT, которая пришла и в АМД (чтобы исполнительные блоки ядер работой, которые обычно почти не загружены), и вся мощь еще и охлаждается увесистым железом — и вот вы действительно думаете что мобилки, которые экономят каждый ватт, чтобы не перегреться — могут конкурировать с desctop.

Ну если текст редактировать, причем не большой, то может быть я и поверю. А так мобильное железо (если брать чистую производительность, без юзанья всяких узкоспецифичных расширений логики таких как какой-нибудь аппаратный кодек, ии и т.п.) — то вряд ли новейшие фламаны смогут потягаться с офисными low-end дестопными машинками, со схожим объёмом ram, 10-и летней давности.

По крайней мере у меня honor10, это типа флагман 18 года, и десктоп околотоп по меркам 2011. Ну нигде Хонор не быстрее, даже если взять основанный на quaker3 движок ioquake3, то на Андроиде спервого взгляда кажется что типа да, круто, красиво, но стоит сделать скриншоты на телефоне и ПК и разница в графике становится очевидна — на мобилке на сглаживания ни анизотропки. И более того все эти 60fps падают когда много игровых объектов.

Далее, листинг 36 мегапиксельной фотки в маштабе 1к1 это прям на нервы действует. Про комп думаю не стоит говорить что ему это легко — и так понятно.

Так что зря вы про производительность.

Кроме всего прочего — компы внушают доверие. Мобилки вам внушают? Да они мрут через 2-3 года очень аккуратного юзанья. А в компе если что-то сломается — можно в кратчайшее время изолировать прооблему и решить её. А с мобилкой — идти в сервис, где ее будут греть феном чтобы разобрать, а потом от этого фена пойдут желтые пятна после ремонта…

Мобилка — это карманный помощник — у него нет цели быть мощным, удобным и надёжным для договременной профессиональной работы. Нет и не будет.

VolCh

Не измерял, я же сказал, что я не про производительность. Я про форм-фактор "маленькая коробочка с сенсорным экраном, универсальным разъёмом для подключения хаба/док-станции и батареей". Понятно, что для задач типа компиляции миллионов строк кода за раз или рендеринга полноценного кинофильма большая коробка с той же плотностью электроники сделает задачу быстрее, но я о задачах, где количества транзисторов в корпусе телефона недалёкого достаточно для нормального UX в сценариях, где у современного десктопа CPU почти всегда в idle, потому что ждёт io, а оперативка забита кэшами файлов по сути.

Это если комп самосборный или типа того. А если это какой-то брендовый системник на расширенной корпоративной гарантии, то всё то же самое, кроме того, что автомобиль нужен до сервиса довезти.

cepera_ang

Вы кажется проспали анонс M1 — вот у него действительно многоканальная память, большие кеши и честные ядра =)

Chamie

У него половина ядер урезанные, речь шла об этом.

cepera_ang

А если смотреть на это как на то, что это четырехядерный процессор с режимом экономии, то уже не такие и урезанные :)

VolCh

Или 4 обычных, и 4 разогнанных )

Zverienish

Ну и что, что урезанные, зато основные ядра быстрее чем интеловские.

olegi

может проблема в хоноре? пробовали Dex от самсунга?

Zverienish

Жаль, что к стандарту не привели какому-то. Тогда бы очень много бы вообще от компов отказались. Если бы телефоны можно было как десктоп использовать.

Dr_Faksov

Вот у меня Galaxy S10. И Dex на Windows поставил сразу же. И использую его иногда для просмотра фото с телефона на большом экране. И всё. Вот не возникает у меня желания делать что-то через телефон, когда есть компьютер. Я, правда, уже не молод. Возможно, дело в привычке.

Paskin

«Мобилки» с точки зрения железа мне внушают абсолютное доверие — как человеку, работавшему с SoC от Quallcomm. А операционные системы сейчас переживают смену архитектуры — от звонилки и запускалки casual-игр к мощной платформе для реалтайм-обработки и представления данных (в том числе — средствами AI/ML/DL и AR).

Zverienish

Конечно конкурируют. В потреблении интернет контента уже давно и успешно. Тестировал свой телефон 2х летней давности и ноут 5ти летней на i3 и телефон заметно впереди.

quwy

Нормальную ОС он позволяет. Все эти андроиды и айосы просто непригодны ни для чего, кроме просмотра видосиков и залипания в социалочки с бесконечной прокруткой.

У меня был период, когда пришлось работать из дома, не имея нормального компьютера. Зато был добротный по тем временам 10"-планшет с 4 GB оперативки, 8-ядерным процессором, BT-клавиатурой и мышкой. Посмотришь со стороны, ну чем не субноут? А на деле — фиг! Даже если находился более-менее удобоваримый софт, работать на этом симуляторе операционной системы было решительно не возможно. В итоге я с этого планшета просто подключался к компу на работе по RDP и там делал все дела. Даже с сетевым лагом на контрасте это было божественно.

VolCh

Ну вот только за прошлый месяц вроде пара статей была про Linux-смартфоны. Или для вас нормальная опреационка- это WIndows?

Areso

Статьи — есть, продуктов в магазине — нет.

Librem Purism, PinePhone не делают погоды.

Это очень, очень нишевые решения, продающиеся хорошо если тысячами штук.

VolCh

Я же не говорю, что если прямо сейчас взять любой смартфон на рынке, то им можно заменить топовый десктоп. Просто высказал мнение, что если вендорам железа это будет интересно, то объективных препятствий не вижу.

ProFfeSsoRr

olegi

в декс-е был убунту?

Areso

Был. Один или два года. Потом убили.

olegi

ну, самсунг всегда был плох в софт :(

Zverienish

Тут не дело плох в софт, а востребованности.

NetBUG

Вендорам железа интересно телефоны с селфи-камерами за +30% к цене продавать любителям инстаграма, к сожалению. Это массовый маркет, а не portable office.

sumanai

С радостью бы купил телефон без этой ненужной дырки в экране за -30%, но адекватных конфигураций просто не делают.

quwy

Это пока такая редкость, что говорить не о чем.

Нормальная — это та, где можно запустить несколько приложений окнах. Где программы не навязывают пользователю ориентацию экрана. Где при наличии аппаратной клавиатуры, экранная не вылазит постоянно. Где программы знают, что тыкать в них будут не только пальцем, но и мышкой с несколькими кнопками. Где работают общепринятые комбинации клавиш. Где пользователь по-умолчанию не считается инвалидом по рукам и голове.

VolCh

GNU/Linux+Gnome/KDE/...?

quwy

Вот когда это все начнет работать на среднем смартфоне, тогда и приходите. А пока это только страшные слова.

Zverienish

Ну большая часть дома только для этого и использовала устройства. Вот им они заменили. Молодежь играет в основном на телефонах сейчас. Ну и айпады очень часто для профнужд используют.

Zverienish

В чем не сравнятся? По производительности текущие телефоны сравнялись с компами несколькилетней давности.

Ivanii

«который вполне может конкурировать с чипами x86» Как голый может, но без инфраструктуры материнских плат и софта(не только операционки) как ширпотребный ПК не может и не сможет еще долго, это как смерть IPv4 предсказывали.

StjarnornasFred

Зная авторитет Apple, можно не сомневаться: софт будет. Потому что как бы мы её не критиковали, но в чём ей не откажешь так это в умении внедрять инновации. Сами, может, ничего нового не изобретают, но внедряют на ура.

Ivanii

Софт под x86 писался десятилетиями, у меня под Вин 10 есть ПО с

20062000 года(Анирил турнамент), под ХП еще более древний.siziyman

Третьи герои работают под десяткой, а они уже 1999 года, так что можно и старше. :)

Tarakanator

В этом году играл в master of orion 2. Уже 1996 год.

Stecenko

Я в первый регулярно поигрываю))

lll000lll

Я тоже :)

Tarakanator

ну первый не считается… он даже на PSP под эмулятором работал.

porn

UT тоже 99-го.

Wingtiger

98го по времени выпуска (как нагуглилось), в 99ом добавилось карт.

И у меня УТ идёт слегка модифицированный под 10ку и современное железо.

Дум2 уже давно портированный на не такой древний движок.

А остальное да, уже этого тысячелетия.

iron-zorin

Age of Empire на десятке запускается даже без выставления режима совместимости.

sumanai

Скорее всего десятка сама применяет заплатки совместимости.

Fell-x27

Если это первый UT, то он был не под ХР, а аж под 98ю…

khajiit

Емнип, ему давно уже требуется подкидывать рендерер фанатский, потому что его старый OpenGL косячный, а подсистемы, на которые основной D3D/DDraw полагался, выпилены давно из винды.

Ivanii

Может у меня сборка позднее но на новой ОС он просто запускается с EXEшниака, в настройках «Direct3D», файлы игры 1999 — 2002 год.

AllexIn

Софт который вышел десять лет назад нет проблемы запустить через эмулятор аля Розетта.

Сейчас софт пишется сразу под много платформ.

Если раньше Windows X86 была безальтернативной платформой, то сейчас если софт даже и пишется под Винду, всё равно закладывается кроссплатформенность.

Ivanii

Quartus II, PCLab2000SE, Sprint Layout 6, AVRDUDEPROG, zadig-2.4, MiniPro Programmer, UnrealTournament, SDRSharp, Atom Mini, CH341A programmer, CloneSpy, KillCopy, EZP2019 programmer запустятся?

adante

Окей, останется >> 1% рынка, которому нужна древность / экзотика. И этот процент схлопнется, т.к. за уменьшением объемов придет увеличение цены.

Ivanii

+ кто не захочет платить за имя Аппле, + кто захочет нормальный видеоускоритель, кто просто хочет Интел или АМД, кому под ОС не дали драйверов…

adante

кто не захочет платить за имя Аппле

Невозможность нормально написать имя компании это диагноз.

кто захочет нормальный видеоускоритель

будет чуть попозже с mbp 16 и imac

просто хочет Интел или АМД

просто это как? как хочу красненькую машинку?

кому под ОС не дали драйверов

Да все появится. И ОС и драйверы. Эппл просто показала, что так можно, если продажи будут ок, все начнут мигрировать на АРМ косяками.

perfect_genius

А что вам мешает оформить цитаты и начинать предложения с заглавной буквы? :)

Ziptar

ООО "Огрызок".

Areso

Справедливости ради — ПАО (или ОАО — по вкусу).

vasiaplaton

Половину софта для прошивки из этого списка можно заменить openocd, который под raspberry pi (arm) работает. Sprint Layout в 2020 — серьезно? Хотя он то наверняка под эмулятором запустится.

JerleShannara

Зато следом можно накидать CAD/CAM софта, причём даже так, что и линукс отметётся.

vasiaplaton

Это да, с CAD'ами под линуксом все печально. Даже autodesk fusion 360 заводится с каким-то лютыми танцами с бубном под wine, а что чуть поспецифичней, так вообще грусть…

Zverienish

Кад думаю переделают под армы в ближайшие годы.

dartraiden

Offtop: CH341A programmer — это который китайский, крякнутый и накрытый сверху VMProtect? Идет в комплекте с копеечными программаторами с алиэкспресса. Но зачем? Для работы с этим программатором есть длинный список нормального софта (AsProgrammer, Colibri, flashrom в конце концов)

Wingtiger

del

NetBUG

Я на своём макбуке так и не мог перейти на Каталину, ибо ряд программ для обслуживания вполне себе не старых станков (2011 год, станки стоят сотни тысяч евро) писались под 32 бита.

strvv

да, но в результате развития из микробиблиотек на 1 функцию, но реально отлаженных в монструозные комбайны с тысячами вызовом, из которых хорошо если используется сотня в разных комбинациях (привет М-Софту и Гуглю) — в итоге не смотря на продолжающийся рост производительности аппаратуры, отзывчивость систем падает с каждой новой версией ОС, плюшек, да и глюков больше, а пользуется пользователь хотя-бы 10% возможностей?

у аппла (сам не использую, имхо) засчет контроля ПО не позволяется сильная гонка в размерах ПО, получается оптимизированнее, проще и за счет этого и их предпочитают — отзывчивость у систем выше чем у их конкурентов. большой выбор хуже чем 2-4 варианта, но максимально вылизанных. привет капитализму и сотни сортов

дерьмаколбасы.ProFfeSsoRr

А под MacOS? Они уже 1 раз переходили на интел и ничего, перешли. Так что и еще раз перейдут и весь софт, который деньги приносит, быстренько адаптируют так или иначе.

Zverienish

Это уже 3тья смена у них архитектуры.

quwy

Четвертая смена, т.е. уже пятая архитектура процессоров:

6502 -> M68K -> PowerPC -> Intel -> ARM

VolCh

У МакОси всё же третья. 6502 отношения к Макинтошам и МакОси не имела.

ptica_filin

UT для Маков тоже был. Ещё для тех Маков, доинтеловских :)

А сейчас, я думаю, даже среднему смартфону теоретически хватит мощи, чтобы его запустить в каком-нибудь эмуляторе.

NetBUG

… только поддержку Rosetta и эмуляции PowerPC дропнули через всего два релиза ОС. :(

olegi

свитчинг с 2005-6 и дроп в 2011. 5-6 лет. мало?

Louter

Софт без привязки к x86 тоже писали дисятелетиями: больно, долго, но я таки смог собрать пакеты под линух на armv7, когда их очень не хватало и самому таки запустить графическую оболочку, редактор в ней и прочие шалости (вроде браузера). А этого преемлимо-систематизированного софта с исходниками, инструкциями, .spec и .ebuild -ами огромная армада и она БАЦ!… и работает

У закрытого софта есть проблемы, увы, видимо скоро придётся регулярно запускать qemu под арм для эмуляции x86.

bonta

а я просто в Unreal 1998 года по сети играю. Удивительно, но для этой игры до сих пор фанаты создают новые карты.

Zverienish

Для вас будет эмулятор.

siziyman

Софт будет — под макось. К сожалению, одной макоси мало для «завоевания мира» в контексте ПК. Её, конечно, больше, чем Линукса (ещё раз — я о персональных компьютерах, не о серверах), но меньше, чем всего остального.

defaultvoice

На мой взгляд тут самое важное даже не конечный софт для потребителя, а качественный скачок библиотек и инструментов разработчика, работающих на ARM. А это, в свою очередь, означает, что как минимум на серверах платформа, наконец, будет широко распространена. Я лет пять назад пытался взять для пет-проекта сервер на арме и поимел очень много проблем уровня «питон слишком тормозной», «либа не собирается» и так далее. Очень надеюсь, что ситуация с приходом Apple и Nvidia поменяется

remzalp

Хм… Лет 5 назад на ScaleWay брал Baremetal Arm сервер, смеха ради, за копейки — на удивление проблем толком не испытал — php & python + mysql/sqlite

BogoMIPS: 50.00

Hardware: Marvell Armada 370/XP (Device Tree)

fougasse

А что, кросс не работаел 5 лет назад для АРМ?

Дебажить на таргете — это экстренные случаи.

А сборка — в принципе не имеет смысла, как мне кажется, особенно сейчас, когда с контейнерами легко сделать нужное окружение типа правильной версии gcc без танцев с бубном.

bm13kk

и у мака проблема с контейнерами. Что для меня перечеркивает вообще все обьективные достоинства арм как платформы.

xtrime

Докер для m1 в разработке, виртуалки (parallels, vmware) тоже. Просто в дев китах не было виртуализации. В финальных устройствах аппаратная поддержка есть. Поэтому разработчики подобного софта не успели к релизу.

Видимо apple очень хотела выпустить финальные устройства в этом году. Или результаты оказались лучше, чем они ожидали и пришлось форсировать сроки.

fzn7

Все будет, они пока что не выкатывали устройства для разработки

khajiit

Если подымается linux, то поднимутся и контейнеры.

Правда, некоторые вещи придется собирать под архитектуру ручками, благо oss под это и рассчитано.

Или появится повод глянуть в сторону Erlang/Elixir.playnet

Помнится, я в 2006 собирал кросскомпилом систему под арм

JerleShannara

А сейчас уже начинаешь думать — а может ну его нафиг, свежие ARMы вполне себе скоростные и можно прямо на железке собирать почти всё после разворачивания минимальной системы.

Zverienish

Ну компиляторы все давно уже отлично поддерживают компиляцию под армы. Еасли нет использования асемблера или конкретной привязки к оборудования, то все персоберется без проблем.

dhaenoor

Зная эпл — мы перестанем быть владельцами и компов, и софта

Bobnecat

Судя по T's & C's Microsoft мы уже арендуем свой жесткий диск с Windows 10 у них.

Al_Azif

Владельцами софта мы перестали быть лет 20 назад.

Просто кто-то не читает тексты лицензий.

И это касается не только Apple, если что.

amirosta

Чушь.

Просто не используйте для софта принципы, применимые только к материальным предметам.

Владелец софта — это его разработчик или тот кому разработчик передал права на продажу софта.

От того, что вы «купили MS Office» вовсе не следует, что теперь у вас есть права на многократную перепродажу лицензий на MS Office. А у фирмы Microsoft — эти права есть. Вот её и можно назвать «владельцем софта», а вы всего лишь «владелец экземпляра».

BD9

Нет.

Владелец права использования без права передачи другому лицу.

VolCh

Ограниченного неисключительного права использования.

amirosta

Необязательно.

К примеру в Германии даже Windows по лицензии OEM, что во всех странах привязана к железу и умирает вместе с ним, высудили право продавать.

Разумеется, не большее число экземпляров, чем купили.

wholeman

Владелец тех прав, которые предоставлены лицензионным договором. Если это — свободная лицензия, то права довольно обширны, но даже в этом случае владелец софта — кто-то другой.

i_Max2

Немного дополню — я лично под текст «Владельцами софта мы перестали быть лет 20 назад.»

Например 20 лет назад заплатив за лицензию Photoshop я не становлюсь владельцем программы но я могу пользоватся ей сколько захочу, пока у меня работает железо и операционка. А вот сегодня к примеру по хотению Adobe Photoshop перестанет работать по всему миру, кончится срок подписки и они например не будут больше его продлевать — а выпустят что то новое например…

amirosta

Это особенность конкретно Photoshop и лет этой особенности не 20, а всего лишь несколько.

NetBUG

Вот в этом и вопрос, насколько есть шанс пользоваться софтом без подписок.

MS Office последние пару лет тоже идёт в коробочной версии гораздо более урезанный, чем в подписке на Office 365, и я, естественно, не про облачные файлопомойки

Ndochp

Больше того, вы его продать могли спокойно. Что для меня гораздо больший ярлычек права владения. А стим игру уже не продать особо без доброй воли стима (есть ли она я честно говоря не помню)

Al_Azif

>> Чушь.

Вы поосторожнее с такими высоконадёжными заявлениями, а то я всё же напрягусь и найду политику лицензирования Alias PowerAnimator, например, который ещё 30 лет назад был исключительно _арендуемым_ продуктом.

Просто люди только сейчас начали понимать(когда это стало действительно массовым явлением) что они ничего никогда не покупали, они всё это время — арендаторы.

>>Это особенность конкретно Photoshop и лет этой особенности не 20, а всего лишь несколько.

Да ну? А вы исследования проводили, да? Вчитывались в лицензии?

PS: Надо будет Valve/Steam сообщить что они — «всего лишь частный случай и им всего лишь несколько лет». На Хабре специалисты сказали, ага.

linustechtips.com/topic/953835-you-own-the-software-that-you-purchase-and-any-claims-otherwise-are-urban-myth-or-corporate-propaganda

xabar

А что такое инфраструктура материнской платы?!

Интел предлагает «убогое» решение — CPU + мост. А на мамке у вас — разъемы, питание, ну и пара ПЗУ флешек с батарейкой. Ну и какой нить суперио чип, для всяких клавиатур и тпм.

Все остальное — в 2х чипах интел. А именно:

В мосте — контроллеры SATA, PCIe, Ethernet, USB и прочие вайфаи и итуси. В процессоре — контроллеры RAM, PEG (PCIe для видюх), графика, ME и прочие эмэмикмсы.

При этом я не понимаю зачем закладывать в мост 15 портов PCIe или 16 SATA или 16 USB, плодя количество ножек в геометрической прогрессии…

Большинство ARM — это SoC, без моста, все в проце. А Apple еще на него влепила RAM — вообще красавцы, выкинули сложную и не любящую тряску DRAM, заменив ее на memory-down. Мамка в таком варианте — просто плата со слотами расширения и развязкой питания. Какая тут инфраструктура? Нет моста — нет проблем при переходе между поколениями процессоров.

При этом у интел есть еще гадки ME, который не слабо потребляет, и хрен знамо чем занят. И загрузчик для интел (БИОС) — это тоже монстр в пинетках из UEFI, в котором черт ногу сломал. У ARM — все гораздо проще, лучше и понятней.

А запустить игру 99 года — можно и через эмулятор x86.

P.S. Uboot для ARM собирается GCC, под линукс. Интеловский EDK2 (скелет для UEFI BIOS) — лучше всего собирать в MS Visual Studio. У интела система сборки на «батничках». Когда увидел это — понял, они все, закончились.

nevelaev

Проснитесь, сейчас и интел комбайны делает в ноутбучном сегменте. Только ноутбук и смартфон — это 2 большие разницы, хотя бы по организации питания: разница на порядок. И интеграция компонентов в кристалл ни к чему хорошему не привела. Будет проще, говорили они. Будет дешевле, говорили они. Не стало проще, не стало дешевле. Комбайны вылетают, особенно из-за вечной интеловой проблемы с юсб, реже — из-за повреждения vrm, стоимость замены камня сравнима со стоимостью ноутбука, если цена, по крайней мере, до 30 тысяч, но не суть, потребителю не легче. Раньше это была замена относительно копеечного моста, особенно во времена южников/северников, ибо их состав позволял выпускать себя на старом окупившем себя обррудовании. Процессор же занимался сугубо своими делами, и от косяков остальной части пк не страдал. Если ноутбучные/настольные армки будут по цене хотя бы вполовину интела при равной скорости, либо ниже, то это еще куда ни шло. В противном случае, это очередной виток закабаления поребителя.

Areso

и в результате чипсеты грелись едва ли не больше Атомов.

Все же помнят кулеры на чипсетах — это оно — старое, окупившее себя решение.

nevelaev