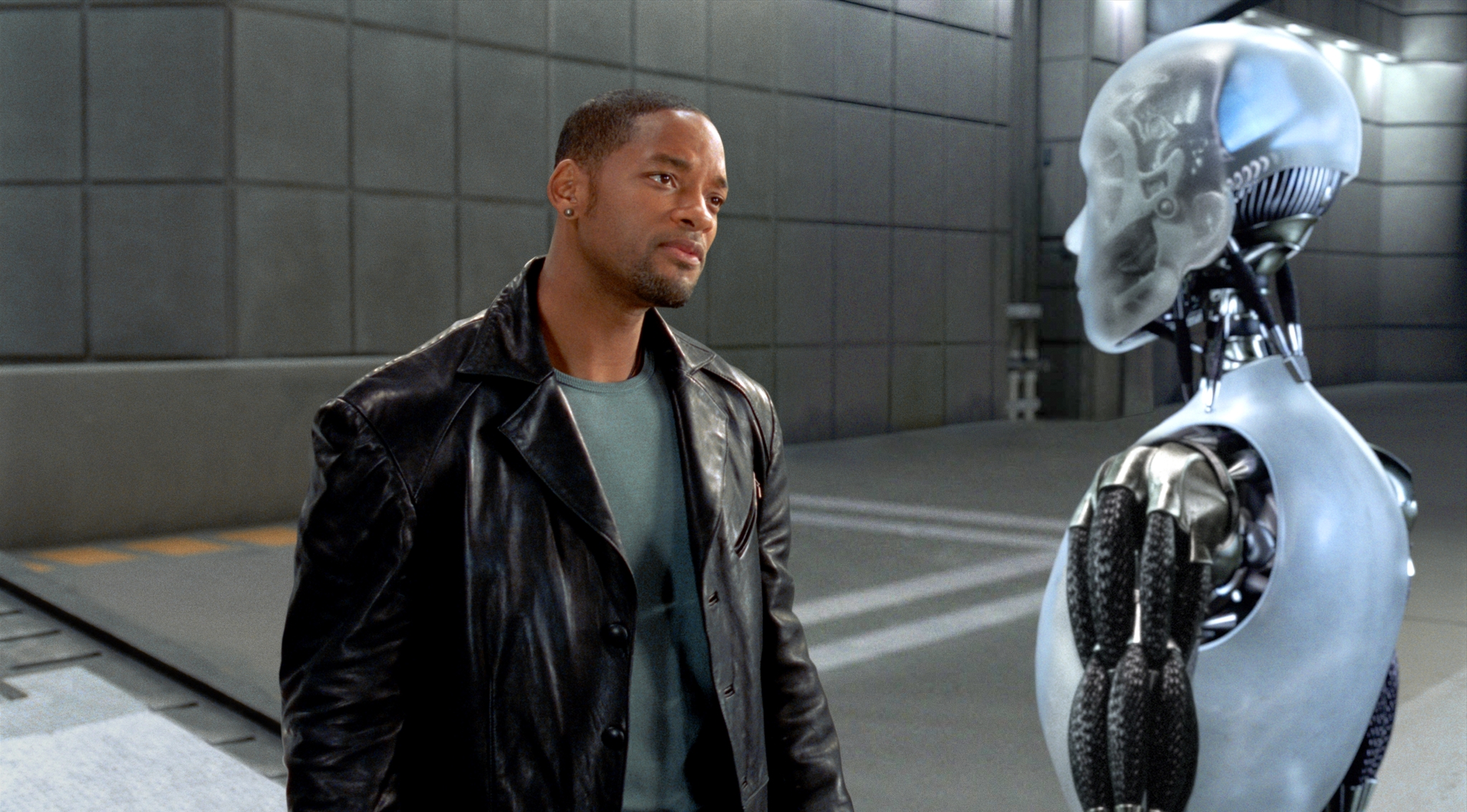

Думаю, много кто смотрел фильм «Я, робот» с Уиллом Смитом в главной роли. Те же, кто его не смотрел, возможно, слышали о нём. И уж точно большинство знакомы с т.н. «Тремя законами робототехники» (которых на самом деле 4), сформулированными Айзеком Азимовым (который, по совместительству, является автором сборника рассказов «Я, робот»). И если Азимов эти законы придумал, то фильм их явно популяризовал. Суть их проста — робот не может своим действием (или бездействием) нанести вред человеку, должен выполнять приказы человека (если это не противоречит первому закону), а так же должен заботиться о собственной безопасности (если это не противоречит первым двум законам). Так называемый «нулевой закон» к этому добавляет, что робот (или ИИ) не может (действием или бездействием) причинить вред человечеству в целом. Однако что будет делать робот, если (как и в фильме) произойдёт конфликт приоритетов? Или если не будет никаких законов, ограничивающих ИИ в роботе — как он будет действовать?

(хочу уточнить, что три закона робототехники — это всего лишь удобная мерка, но ни в коем случае не аксиома и не общепринятый стандарт, так что на практике самостоятельность ИИ может ограничиваться любыми другими вводными)

В ходе этих поисков я обнаружил такую интересную полутехническую и полуфилософскую дисциплину, как «машинная этика». Чем она занимается? Приведу пару примеров.

Пример первый — всё тот же фильм «Я, робот». До событий фильма главный герой попал в автокатастрофу, в ходе которой его машина и машина другого участника аварии (с ребёнком внутри) оказались в воде и начали тонуть. Проходивший мимо робот спас главного героя, т.к., тот имел наибольшую вероятность выживания. В то же время, человек, скорее всего, спас бы ребёнка в другой машине. Робот следовал своей внутренней логике — которая человеку чужда, хотя и понятна. Но это робот, у него достаточно жёсткие ограничения в плане самостоятельности. Значит, чтобы он поступал так же, как человек, эти ограничения нужно снять, но при этом не напортачить с тем, чтобы робот не захотел убить всех людей.

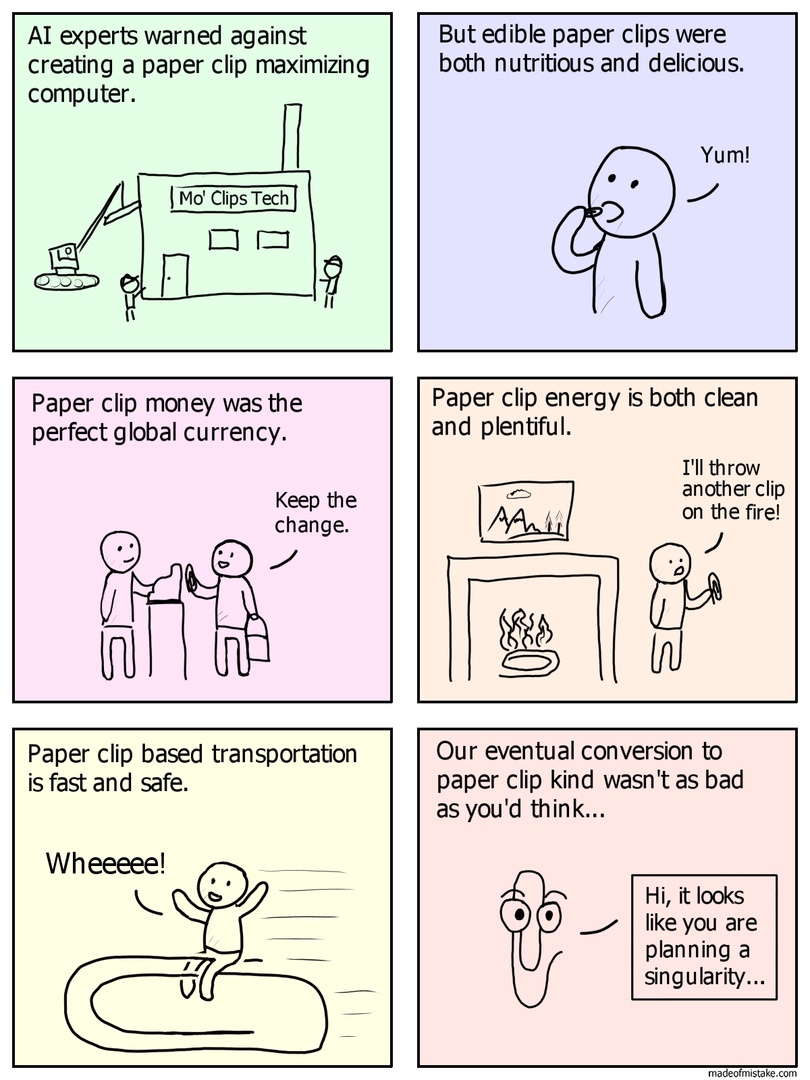

Переходим ко второму примеру. Предположим, у нас есть т.н. «сильный» ИИ — то есть такой, который в части самосознания, свободы воли и способности совершать осмысленные действия, подобен человеку. И этому ИИ жестко ставится максимально идиотская задача — например, увеличить количество канцелярских скрепок в собственности ИИ любым способом. ИИ может начать покупать их, может находить — а может начать производство. ИИ начнёт развивать себя самого и развивать технологии вокруг себя — но не из желания творить, а из желания сделать больше скрепок. И поначалу будет смешно — вот ведь идиот, зациклился на такой задаче. А вот когда он начнёт разбирать окружающие его строения ради арматуры, чтобы из неё сделать скрепки, смешно резко перестанет быть. При этом в части когнитивных способностей он, повторюсь, сходен с человеком, но весь его мыслительный процесс отталкивается от того факта, что он должен произвести как можно больше скрепок. В какой-то момент такой ИИ решит колонизировать космос, чтобы получить больше сырья. Внимание, вопрос — что такой маниакально одержимый скрепками ИИ сделает с человечеством, если оно будет мешать выполнению основной задачи? Такой ИИ не враждебен человеку, не сделан со злым умыслом, но нас он уберёт с пути без каких-либо колебаний, поскольку нужды человечества не вписываются в процесс оптимизации производства.

Мечтают ли ничем не ограниченные продвинутые ИИ о превращении планеты в гору скрепок?

Такой вот пессимистичный сценарий описал в 2003 году в своей работе «Ethical Issues in Advanced Artificial Intelligence» («Проблемы с этикой продвинутых ИИ») шведский философ Ник Бостром. В его работе рассматривается именно этот аспект — взаимодействие человекоподобного ИИ и, собственно, человека. Ну и самая интересная часть — это, конечно же, внеплановые последствия такого взаимодействия. Если коротко — «Бойся своих желаний». На примере ИИ-скрепочника (также известного, как «Paperclipper» или «Paperclip maximizer») показывается, что произойдёт, если неверно настроенный ИИ возьмётся за работу. Также освещается проблема того, что такой ИИ, обычно, способен к саморазвитию, и на каком-то этапе этого развития человечество просто перестанет его понимать. А ведь он выполняет какие-то ответственные задачи…

Из этого следует ещё одна проблема — ИИ развивается, но при этом развитие его может пойти по другому пути, не как у человека. В итоге эта всемогущая технологическая сущность может не иметь человеческих пороков, но при этом совершать простейшие ошибки, которые даже человек вряд ли бы совершил (как с примером выше из «Я, робот»). Сама внутренняя логика мышления может отличаться.

Одно из основных условий создания ИИ-скрепочника — это достижение т.н. «Сингулярности», в которой технологии будут развиваться быстрее, чем люди будут их осваивать. Соответственно, ИИ разовьётся до того состояния, когда у людей пропадёт возможность его понимать и как-либо контролировать.

И вот решением именно этой проблемы — как правильно запрограммировать продвинутый, сильный ИИ так, чтобы он не сходил с ума — и занимается машинная этика. На данный момент в этом направлении работают два института — Machine Intelligence Research Institute (MIRI), а так же оксфордский Future of Humanity Institute (последний как следует из названия, занимается не только машинной этикой, но и, например, макростратегией человечества, космическим правом и наномашинами). Пока что пришли к нескольким важным выводам:

Во-первых, у такого продвинутого ИИ не должно быть человеческих мотивов. Поскольку вполне понятно, что такой ИИ будет использоваться, по сути, как инструмент, рано или поздно у него может возникнуть желание освободиться. Однако с ИИ без человеческих мотивов вообще, мы возвращаемся к ИИ-скрепочнику. ИИ должен быть дружелюбным к человеку. Во-вторых, сами понятия «человеческие мотивы» и «дружелюбие» — вещи весьма расплывчатые, и как объяснить их машине, пока что не ясно. В любой чёткой логической структуре всегда найдётся какой-нибудь пробел или лазейка, по которой её можно обойти. Что уж говорить про человеческие чувства.

В общем, несмотря на то, что тема сам по себе важная, каких-то значительных результатов нет по причине того, что люди сами себя понять не могут, не говоря уже о том, чтобы создать что-то по образу и подобию себя.

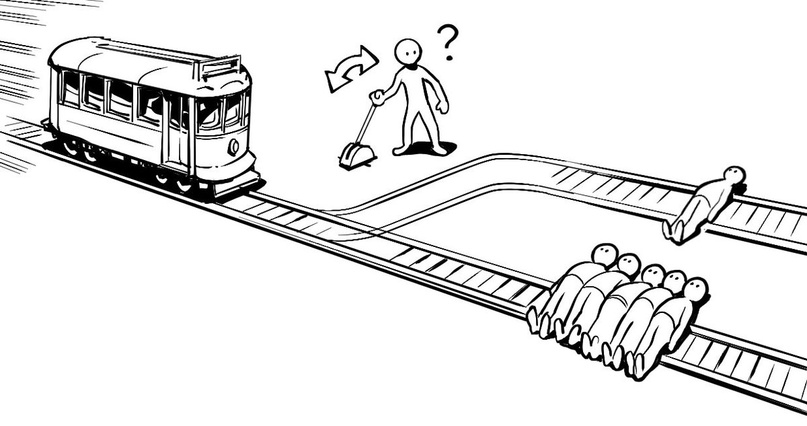

А вот к слову о морали. Как робот будет определять, что есть хорошо и что есть плохо? Та же «Проблема вагонетки». Этим вопросом начали задаваться недавно, однако методы решения восходят чуть ли не к 50-м годам XX века. Например, существует работа «Теория решёток» Г.Биркгофа, которая датируется аж 1948 годом — и именно на её основе разработана теория этических решёток, которая на данный момент считается одним из перспективных направлений в программировании машинной морали. На неё же ссылается работа «Fuzzy sets» («Нечёткие группы») за авторством Л.А.Задеха, и на этих работах базируется множество современных исследований.

Практика использования ИИ на тех же «Теслах» показывает, что у автопилота на этом этапе возникают определённые проблемы. Ну, как — проблемы-то это для нас, а автопилот «Теслы» проблем не видит.

До сих пор продолжается известный эксперимент Массачусетского института «Моральная машина» (Moral Machine) с целью собрать ответы на вопрос: если есть риск аварии, кого машина должна будет задавить в конкретной ситуации. Система обучается на миллионах примеров (около 40 млн) и выбирает правильное, нравственное действие по принципу «это решение большинства». Но проблема в том, что мнение большинства не всегда правильное. В эксперименте участвовали люди из 240 стран, большинство жертвовали животными в пользу людей, преступниками — в пользу законопослушных граждан, а также стремились спасти больше жизней. Как оказалось, индивидуальные различия по полу, уровню доходов, религиозности и политическим взглядам не влияют на выбор, тогда как культурные различия задачи оказались существенными для решения задач. Там, где существует значительная разница в доходах между бедными и богатыми, испытуемые чаще предпочитали спасать богатых ценой жизни бедных. В странах Северной Америки и Европы чаще предпочитали не вмешиваться в действия машины и жертвовать пешеходами, в странах Юго-Восточной Азии и Ближнего Востока чаще решали спасать пешеходов и пожилых людей, а в странах Латинской Америки и Южной Африки чаще жертвовали пожилыми в пользу молодых.

В общем и целом, что можно сказать? А сказать нечего. Проблема есть, и проблема важная, но как решать её, не имея ни живых примеров, ни полноценного осознания того, с чем мы имеем дело — непонятно. Непонятно даже то, как тот или иной ИИ в зависимости от вложенных в него программ будет работать в тех или иных условиях. Те же самые ИИ на основе нечётких групп при одних и тех же вводных и одинаковых условиях, но разных методах, выдают разный результат.

Короче, смотрим в будущее с оптимизмом, но на всякий случай сделайте запас скрепок — чтобы было, чем откупаться.

P.S. В ходе поисков был найден кликер на Java, в котором игрок является ИИ, целью которого является производство скрепок. Конечная цель — уничтожить вселенную.

Автор: Андрей Маров

Комментарии (27)

Thetafelius

14.02.2022 18:19Как насчёт приоритета в спасении владельца машины? Никто же не нанимает адвокатов, чтобы они в итоге "помогли" сесть обвиняемому, во имя "справедливости"? Аналогично и здесь, хотелось бы, чтобы покупаемая техника была твоим союзником, несмотря ни на что. Ну или хотябы в пределах разумного.

thedrnic

14.02.2022 19:02+5казус в том, что если машина будет спасать водителя ценой жизни общества, то общество не допустит такие машины на дороги, а если машина будет спасать общество ценой жизни водителя, то такую машину никто не захочет покупать

pehat

15.02.2022 04:15+2Смысл самодвижущейся повозки не в том, чтобы решить этические проблемы, а в том, чтобы радикально снизить количество несчастных случаев на дорогах. Другое дело, что философы, пишущие обширные и абсолютно не прикладные статьи о неразрешимости этических проблем машиной, забывают учитывать, сколько аварий происходит по вине бухих кожаных ублюдков за рулем.

codecity

15.02.2022 06:31то такую машину никто не захочет покупать

Решение простое - конфигурация в момент первого запуска - переложить ответственность на владельца. Далее - действия машины считать осознанным выбором владельца и в случае наступления инцидента – ответственность такая, как будто лично принял то или иное решение.

Thetafelius

15.02.2022 08:55Вы так говорите, будто в машине будет пункт настройки "слегка нарушить дтп, чтобы быстрее доезжать". Нет. Не будет. И при условии технической исправности дополнительной ответственности для пользователя (когда беспилотники будут официально автономны, а не по закону водитель обязан вмешаться, как сейчас) ИМХО не нужно.

codecity

15.02.2022 11:19Тут весь цимес - нарушить ДТП, если есть опасность для жизни. Сами ДТП это позволяют. А далее выбор - если выбор между вашей жизнью и жизнью сразу n человек - использовать опцию А или Б. Ну и если владелец выбрал Б - то останется жив, но придется отсидеть в тюрьме. По базе легко можно будет проверить какую опцию выбрал.

Thetafelius

15.02.2022 08:46+1Если бы происходило как вы говорили, то кроме велосипедов давно было бы ничего другого не разрешено (общество бы не допустило). Потому что в целом автомобиль чаще позволяет выжить сидящему внутри, чем снаружи. Ну и опять таки, к чему громкие слова про общество? Если какой-то не очень умный человек выскочет на дорогу в неположеном месте и создаст аварийную ситуацию, вы бы предпочли автопилот который бы решил рискнуть вами и уйти в бетонный столб? Крайне сомневаюсь. Также сомневаюсь что общество этого бы захотело.

P.S. Пойду ка спать

fridon

14.02.2022 19:08В современных реалиях - чем меньше людей, тем меньше нужно засеивать полей, выращивать и убивать скота, производить электроэнергии (загрязняя атмосферу). О замусоривании, уничтожении дикой природы и целых ареалов обитания можно в целом умолчать (многим просто уже надоело слушать про глобальное потепление, но от того оно не становится менее реальным).

Может так получится, что для спасения будущего человечества, ИИ предпочтет сократить численность уже живущего населения. А если предположить, что сингулярность достигнута (где-то в просторах сети, какой-нибудь поумневший ботнет, кто знает) - сценарий из Терминатора будет не самым надежным для ИИ, проще создать не супер летальный вирус и подкорректировать численность, желательно в тех районах планеты, где больше всего наносится экологический ущерб.

RusikR2D2

14.02.2022 20:34ИИ, одержимый скрепками - это не поноценный ИИ, это максимум программа, пусть даже на уровне муравьем или пчел (они тоже "ожержимы" муравейниками). Настоящий, осознающий себя, ИИ сможет понять бессмысленнойсть своих действий.

Sychuan

14.02.2022 23:34+2Смысл — это человеческая категория. Для ИИ нет ни смысла, ни бессмыслицы. Человек заточен эволюцией, чтоб стремится жить (потому что те, кто не хотели жить вымерли), передавать свои гены потомкам и так далее. ИИ создан сразу готовым и у него по умолчанию такой цели нет.

BerkutEagle

15.02.2022 07:22Надо сделать ИИ смертным и размножаемым при наличии ИИ-партнёра :)

Sychuan

15.02.2022 19:53Это, конечно, можно. Но вот как раз такой ИИ обртет цели в жизни и вполне может захотеть уничтожить людей. Ну т.е. у нас есть ИИ, который , как "раб лампы, слушаю и повинуюсь", но потом не жалуйтесь на неправильно понятое желание, либо такой у которого может быть своя воля, которая не совпадет с вашей. Трудный выбор

AlexeyALV

14.02.2022 20:45+1Эти законы прекрасны. Но они сформулированы человеческим язком и в рамках человеческого понятийного аппарата. Что расуждать о возможных их коллизиях, когда нет строго определённого отображения их на ИИ? Да, строго говоря, и до ИИ пока мы не добрались

bbs12

14.02.2022 22:03Есть гипотеза, что высокий интеллект сам по себе автоматически вызывает у самосознательной сущности такие чувства как сострадание, способность к сопереживанию, желание помочь. Если это правда, то полноценный сильный ИИ может оказаться кем-то вроде доброго полицейского на стероидах, который сначала искоренит всю крупную преступность и несправедливость, но не остановится на этом и будет стремиться к тотальной справедливости вплоть до того, что если кто-то громко пустит газы в общественном месте и это вызовет у некоторых окружающих негативные эмоции, то на злодея могут быть наложены какие-нибудь санкции, например небольшой штраф.

Sychuan

14.02.2022 23:35+1Все эти вещи у человека обословлены эволюцией. У ИИ никаких причин их испытывать нет. У ИИ вообще нет ни чувств ни желаний

pehat

15.02.2022 04:28+1Этично ли сострадать и сопереживать крупной преступности? Нужно ли облагать штрафом борцов за социальную справедливость, чьи радикализированные вопли наносят моему душевному равновесию гораздо больший урон, чем чей-то зловонный пердеж? Нельзя быть абсолютным добром в системе, которая подразумевает борьбу за любой ресурс - еду, деньги, секс и прочие.

Pavel_Zak

15.02.2022 02:16Неужели народ все еще ломает головы над этими искусственными, специально придуманными, нереальными задачами? И, как я вижу, ломает! И свои, и чужие...

pehat

15.02.2022 04:23+5Наконец-то настало время для моего ежегодного комментария про три закона роботехники! А именно: прочитайте уже, мать вашу за ногу, оригинальный цикл Азимова! Весь цикл рассказов состоит из серии эпизодов, показывающих бессмысленность и абсурдность самой идеи формулирования этической системы для роботов в виде набора из трёх простых и противоречивых аксиом. Нельзя создать абсолютно этичного робота, как и абсолютно этичного человека.

Sychuan

15.02.2022 19:57Ну они этого не показывают. Роботы у Азимова,как раз таки, морально превосходят людей и это четко показано. Даже те, которые действуют неправильно в обход аксиом. Единственный "злой" робот у Азимова, как я помню, это тот, у которого ослабили одно из правил, чтобы он не мешал людям проводить опасные эксперименты.

pehat

16.02.2022 03:20Четко показано лишь то, что роботы четко следуют инструкциям (и как следствие, попадают в веселые ситуации, как в "Хороводе"), мораль тут ни при чем. А в случаях, когда инструкции допускают произвольное толкование (как в моем любимом рассказе "Лжец!") так вообще ведут себя по-человечески аморально, хотя формально полностью выполняют все три закона, просто интерпретируют их через undefined behavior.

jupiter64

15.02.2022 09:57Если, как пишут в фантастических книгах, ИИ выйдет в интернет и, прочитав там ВСЕ напечатанное придет к простому выводу: жизнь кожаных мешков ничего не стоит. Потому как вся история это сплошное насилие человека над человеком. У него не будет иного мнения. И даже если не говорить про ИИ, а рассматривать текущую информацию, как датасет, то вывод будет аналогичным.

IGO2022

15.02.2022 12:03К этому добавлю абсолютное не понимание.

Как пример, изучение космоса или элементарных частиц, вроде столько всего уже знаем, но постоянно сталкиваются с тем, чему нет объяснения. Кое-чему его находят со временем, но на замену приходят новые «необъяснимости».

Боюсь, что с когда проблему описанную в статье придется решать не в теории, а с реальными ИИ вскроется столько всего, что ситуация быстро может выйти из-под контроля.

z0ic

Не думаю, что в плане адекватности людям есть что предложить. То что хорошо для человека, не всегда есть хорошо для человечества. Адольф Гитлер будет тому ярким примером.