Примечание переводчика: на Хабре уже есть два перевода про Stable Diffusion, но один описывает частный случай, а другой ощущается для меня слишком «маркетинговым». Поэтому решил, что этот текст из Ars Technica здесь будет полезен.

Генерация изображений с помощью AI пришла по-настоящему. Опенсорсная модель для синтеза изображений Stable Diffusion позволяет любому обладателю компьютера с хорошей видеокартой творить практически любую визуальную реальность, какую сможет выдумать. Она может имитировать практически любой визуальный стиль, и если задать ей фразу-описание, результаты возникают на экране словно магия.

Одни художники восхищаются открывшимися возможностями, другие недовольны, а общество в целом пока вроде бы не курсе той стремительно развивающейся технологической революции, которая происходит в сообществах на Twitter, Discord и GitHub. Возможно, синтез изображений приносит настолько же большие возможности, как изобретение камеры — или даже создание самого визуального искусства. Даже наше восприятие истории под вопросом, в зависимости от того, как всё утрясётся. В любом случае, Stable Diffusion возглавляет новую волну творческих инструментов, основанных на глубоком обучении, которые намерены революционизировать создание визуального медиаконтента.

Взлёт синтеза изображений с глубоким обучением

Stable Diffusion возник благодаря Эмаду Мостаку из Лондона (ранее работавшему менеджером хедж-фонда), который решил с помощью своей компании Stability AI нести в массы новые применения глубокого обучения. Но корни современного синтеза изображений уходят в 2014-й, и Stable Diffusion не стала первой моделью синтеза изображений (ISM), наделавшей шума в этом году.

В апреле 2022-го OpenAI представили DALL-E 2. Она шокировала соцсети способностью трансформировать словесное описание сцены («prompt», запрос) с помощью мириада разных визуальных стилей — фантастических, фотореалистичных, даже будничных. Люди с привилегией доступа к этому закрытому инструменту создавали астронавтов на лошадях, плюшевых мишек за покупкой хлеба в древнем Египте, современные скульптуры в стиле знаменитых художников, и многое другое.

Вскоре после DALL-E 2 компании-гиганты анонсировали собственные AI-модели для превращения текста в изображение. Midjourney, доступная в качестве Discord-сервера с марта 2022-го и открытая публике несколькими месяцами позже, берёт плату за доступ и достигает похожих эффектов, но с более живописным и иллюстративным качеством по умолчанию.

А затем пришла Stable Diffusion. 22 августа в Stability AI выпустили свою опенсорсную модель генерации изображений, возможно, не уступающую DALL-E 2 в качестве. А также запустила собственный коммерческий сайт DreamStudio, продающий доступ к компьютерному времени для создания изображений со Stable Diffusion. В отличие от DALL-E 2, любой может использовать это, а поскольку код Stable Diffusion открыт, проекты могут основываться на ней с довольно небольшими ограничениями.

За одну только прошедшую неделю появились десятки проектов, которые развивают Stable Diffusion в совершенно новых направлениях. И люди достигли неожиданных результатов с помощью техники img2img, которая «проапгрейдила» картинки из игр для MS-DOS, превратила графику Minecraft в реалистичную, перевела сцену из «Аладдина» в 3D, сделала из детских каракуль проработанные иллюстрации, а также многое другое. Синтез изображений может дать массовой аудитории возможность хорошо визуализировать идеи, снижая барьеры для входа, а одновременно с этим дать новые возможности художникам, примерно как Adobe Photoshop сделал в 90-х.

Вы можете сами локально запустить Stable Diffusion, если проделаете серию из нескольких хитроумных шагов. На протяжении прошедших двух недель мы запускали её на Windows-компьютере с Nvidia RTX 3060 12GB GPU. Он может генерировать изображение с разрешением 512x512 примерно за 10 секунд. На 3090 Ti это время сокращается до четырёх секунд. Интерфейсы бурно развиваются, перейдя от грубых консольных команд и ноутбуков Google Colab к более отполированным (но всё ещё сложным) GUI, а скоро всё отполируют ещё сильнее. Так что, если вы не технически продвинутый пользователь, подождите: более простые решения скоро будут. А в крайнем случае можно попробовать онлайн-демо.

Как работает Stable Diffusion

В целом новая волна ISM использует технику под названием latent diffusion. Грубо говоря, модель учится узнавать знакомые формы среди чистого шума, а затем фокусируется на этих формах, если они совпадают со словами в запросе.

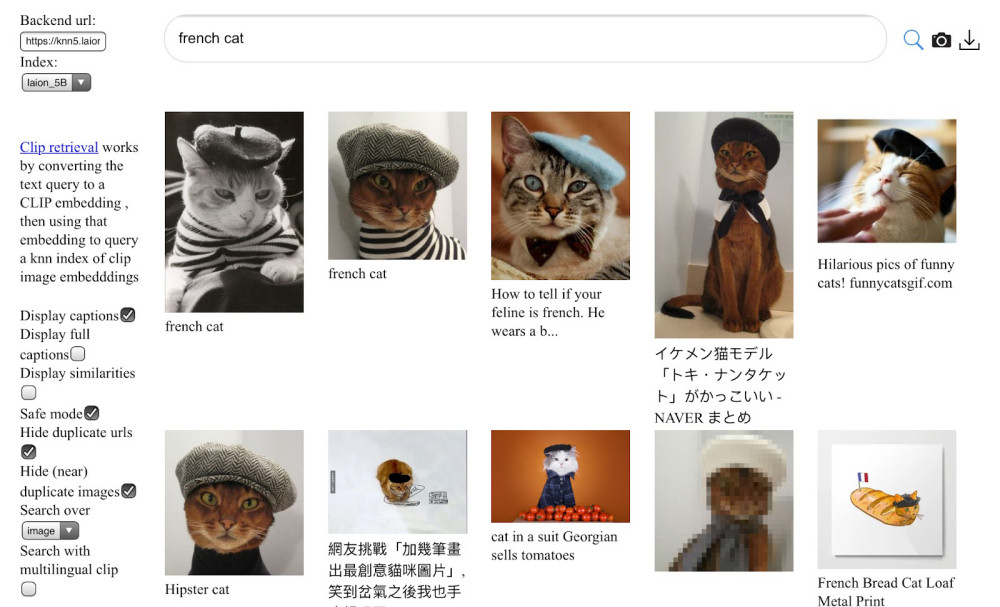

Для начала человек или группа людей, тренирующих модель, собирают изображения с метаданными (вроде alt-тегов и подписей в интернете) и формируют крупный датасет. В случае Stable Diffusion компания Stability AI использовала подмножество сета LAION-5B, а это, по сути, громадный скраппинг 5 миллиардов публично доступных в интернете изображений. Недавний анализ датасета показал, что многие из изображений там взяты с сайтов вроде Pinterest, DeviantArt и даже Getty Images. В результате Stable Diffusion впитала стили многих живущих сейчас художников, и некоторые из них публично высказываются против такой практики. Больше об этом ниже.

Далее модель обучается на датасете с помощью сотен высокопроизводительных GPU вроде Nvidia A100. По словам Мостака, тренировка Stable Diffusion обошлась уже примерно в $600 000 (стоимость тренировки других ISM обычно оценивают в миллионы долларов). Во время процесса обучения модель ассоциирует слова с изображениями благодаря технике под названием CLIP (Contrastive Language–Image Pre-training), которая была изобретена в OpenAI и анонсирована лишь в прошлом году.

В процессе тренировки ISM с использованием latent diffusion изучает статистические ассоциации, когда пиксели определённых цветов обычно соотносятся друг с другом определённым образом для каждой темы. Так что она не «понимает» их взаимоотношения на высоком уровне, но результаты всё равно могут быть ошеломительными и удивительными, там могут быть выводы и стилевые сочетания, которые выглядят очень разумными. После завершения процесса обучения модель никогда не повторяет изображения из исходного сета, но может создавать новые комбинации стилей, основываясь на полученных знаниях. Результаты могут быть очень увлекательными.

В данный момент Stable Diffusion плевать, если у изображённого человека три руки, две головы или шесть пальцев. Так что, если вы не волшебник в создании удачных запросов (иногда AI-художники называют такое «prompt engineering»), вероятно, вы будете создавать множество изображений и дальше выбирать лучшие из них. Учтите, что чем сильнее запрос совпадает с описаниями известных изображений из датасета, тем скорее вы получите желаемый результат. В будущем, вероятно, модели достаточно улучшатся, чтобы выбирать лучшие результаты пришлось поменьше — или какой-то внутренний фильтр будет выбирать за нас.

Этические и юридические опасения

Как вскользь говорилось выше, публичный релиз Stable Diffusion заставил бить тревогу некоторых людей, опасающихся его культурных и экономических последствий. В отличие от DALL-E 2, тренировочные данные Stable Diffusion («веса») доступны любому для использования без каких-либо строгих ограничений. Официальный релиз Stable Diffusion (и Dream Studio) включают автоматический фильтр NSFW (наготы) и добавляют невидимый вотермарк для трекинга, но эти ограничения можно легко обойти, когда код открыт для всех. Это значит, что Stable Diffusion можно использовать для создания изображений, которые OpenAI сейчас блокирует в DALL-E 2: пропаганда, жестокие изображения, порнография, изображения с потенциальным нарушением авторских прав, дипфейки знаменитостей и так далее. Более того, уже существуют частные Discord-сервера, целиком посвящённые порнографическим изображениям от модели.

Справедливости ради, лицензия Stable Diffusion официально запрещает многие из этих использований, но когда код и веса находятся в общем доступе, проконтролировать это крайне затруднительно, если не невозможно. В ответ на эти опасения Мостак сказал нам, что по его мнению, преимущества открытого доступа к такому инструменту (когда его можно изучать) перевешивают недостатки. В коротком интервью он сказал нам: «Мы верим в личную ответственность за свои действия. Мы включили в проект этичную политику использования и инструменты для уменьшения вреда».

Также, как уже сказано, Stable Diffusion навлёк гнев художников в Twitter из-за способности имитировать стиль живых авторов. (И несмотря на утверждения в некоторых вирусных твитах, Stability AI никогда не рекламировала эту возможность. Один из самых популярных твитов ошибочно процитировал независимое исследование). В тот сет, на котором обучали Stable Diffusion, включены миллионы произведений современных художников без консультации с ними, что вызывает этические вопросы об авторстве и копирайте. Собирать эти данные выглядит законным, если смотреть на легальный прецедент в США. Но существует мнение, что закон отстаёт от развивающихся технологий, которые меняют представление о том, как собранные данные могут быть использованы.

В результате, если технологию синтеза в будущем станут использовать крупные корпорации (что вполне может произойти скоро: «У нас коллаборативные взаимоотношения с Adobe», говорит Мостак), компании могут решить тренировать свои модели на «чистых» датасетах, где контент либо лицензированный, либо добровольно отданный авторами, либо перешедший в общественное достояние. Это может позволить избежать некоторых этических вопросов, даже если технически веб-скреппинг вполне легален. Мы спросили Мостака, есть ли у него связанные с этим планы, он сказал: «Stability работает над рядом разных моделей. И все модели сами по себе, и все, с кем у нас коллаборация, легальны в своих юрисдикциях».

Другой вопрос, связанный с моделями от всех вендоров — культурные особенности. Поскольку эти ISM сейчас работают, изучая картинки и метаданные из интернета, они впитывают социальные и культурные стереотипы, представленные в этом датасете. Например, ещё когда Stable Diffusion проходит бета-тестирование на Discord-сервере, тестировщики обнаружили, что почти любой запрос со словами «beautiful woman» в результатах ненамеренно содержал какое-либо обнажение — что отражает то, как западное общество зачастую изображает женщин в интернете. Другие культурные и расистские стереотипы также присутствуют в обучающих данных для ISM, так что исследователи предупреждают, что их не следует использовать в продакшене без значительных ограничений. Вероятно, это одна из причин того, почему другие мощные модели вроде DALL-E 2 и Imagen от Google всё ещё недоступны публично.

Хотя опасения о качестве датасета и встроенных в него предубеждениях сильны среди некоторых AI-исследователей, интернет остаётся самым большим источником изображений с метаданными. Этот клад доступен свободно, так что он всегда останется манящим для разработчиков ISM. Попытки вручную прописать описания для миллионов или миллиардов изображений, чтобы создать новый этичный датасет — вероятно, экономически недостижимая сейчас вещь, так что пока эту технологию делают возможной интернет-данные со всеми их предубеждениями. Поскольку среди разных культур не существует универсального видения мира, вероятно, разные использующие технологию сообщества будут по-разному оценивать то, до какой степени модели синтеза изображения фильтруют или интерпретируют определённые идеи.

Что дальше

Если исторические тенденции о чём-то нам говорят, то задачи, требующие сейчас мощных GPU, в будущем могут добраться до смартфонов. «Вероятно, Stable Diffusion будет запускаться на телефонах в течение года», — сказал нам Мостак. Также новые техники позволят со временем и тренировать эти модели на менее дорогом оборудовании. Мы скоро сможем увидеть взрыв в творчестве, основанном на AI.

Stable Diffusion и другие модели уже начинают применять для динамической генерации видео и манипуляций, так что можно ожидать появления фотореалистичной видеогенерации по текстовому запросу. Далее логично распространить эти возможности на аудио и музыку, видеоигры и 3D VR-опыт. Вскоре AI сможет проделывать большую часть тяжёлой работы просто по нескольким подсказкам. Представьте бесконечные развлечения, которые генерируются в реальном времени по запросу. «Я ожидаю, что это будет полностью мультимодальным, — говорит Мостак, — так что можно будет создать всё, что только можешь вообразить, как с Holodeck в "Стар Треке"».

ISM — это также мощнейший способ сжатия изображений: Stable Diffusion берёт сотни миллионов картинок и сжимает знания о них в файл размером 4.2 гигабайта. С правильным запросом и настройками определённые сгенерированные изображения могут быть воспроизведены детерминированно. Можно представить использование этой технологии в будущем для сжатия, например, 8K-фильма в несколько мегабайт текста. Когда это случится, каждый сможет так же сочинять свои собственные фильмы. Применения этой технологии сейчас только начинают открываться, так что это может завести нас далеко и в таких направлениях, о которых мы сейчас не подумаем.

Реалистичные модели синтеза потенциально опасны по уже упомянутым причинам, вроде создания пропаганды или дезинформации, переписывания истории, ускорения политических разделений, атак на людей и имперсонации, разрушения юридической значимости фото- или видеосвидетельств. В будущем с AI как мы сможем знать, было ли любое видео снято на реальную камеру, общаемся ли мы с реальным человеком? К этим вопросам Мостак подходит в целом обнадёживающе: «Будут новые системы верификации, а открытые релизы вроде нашего подтолкнут публику к обсуждению и развитию этих инструментов».

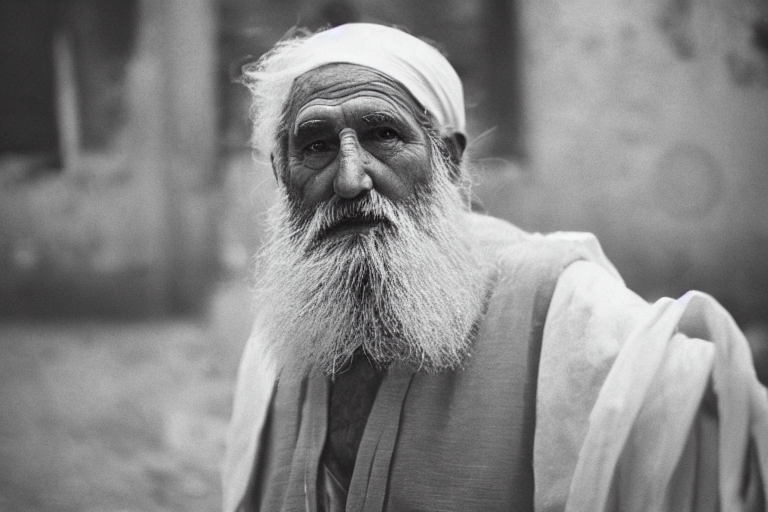

Разумеется, это проще сказать, чем сделать. Но также легко и бояться нового. Несмотря на все наши попытки, сложно знать точно, как синтез изображений и другие AI-технологии повлияют на нас как общество, пока мы не увидим их широкого применения. В итоге человечество приспособится, даже если наши культурные представления радикально поменяются в процессе. Это случалось раньше, поэтому древнегреческий философ Гераклит сказал «единственное постоянное — это изменения».

А теперь благодаря Stable Diffusion у нас есть фото того, как он это говорит.

Комментарии (77)

Tiendil

08.09.2022 19:12+38вы можете больше никогда не поверить увиденному в онлайне

Типо до этого верили, ага.

shiru8bit

08.09.2022 19:55+9Не знаю, как получают те впечатляющие картинки, которые показывают в подобных статьях. Мне SD ничего подобного не выдаёт. Очень ограниченный набор сюжетов независимо от уточнения описания (меняет незначительные детали на одних и тех же общих контурах), многие вещи из поп-культуры оно просто не знает, или же имеет очень своеобразное представление о них, изображения людей совершенно не фотореалистичны, множество артефактов, типа месива из пальцев, трёх рук и ног, и так далее. Получить адекватное изображение человеческой руки с пятью пальцами у меня так и не получилось. Нет, даже это очень впечатляет, но пока до изменения мира машинной генерации изображений далековато.

inkelyad

08.09.2022 20:20+6Руки оно, похоже, принципиально не умеет, а как получают - смотри https://lexica.art/ - там рядом с картинками запрос на создание пишут.

shiru8bit

08.09.2022 20:49Спасибо, стало понятнее. А есть гайд, как заставить сеть генерировать пиксельную графику? Она упорно избегает чистых крупных пикселей, в основном выдаёт некую мозаику.

phillennium Автор

08.09.2022 20:48+3Я сам большими успехами похвастаться не могу, но насколько понимаю, тут три составляющих:

1. Искусство составления промпта. Есть неочевидные полезные кейворды, например, некоторые дописывают к запросу «trending on artstation» — то есть типа «сделай в духе того, что попадает в тренды на сайте ArtStation»

2. Cherry-picking — то есть на каждое удачное изображение, которое мы видим в статьях, приходилось стопицот неудачных и кропотливая работа по «перебиранию стога сена в поисках иголки»

3. Ну и с одними задачами система справляется куда лучше других, так что стоит подстраиваться под то, в чём она сильна. Например, если попросить «сделай под Сальвадора Дали», то внезапно все артефакты изображения людей из багов превращаются в фичи и месиво становится высокохудожественным месивом :)

Alexey2005

08.09.2022 22:10+41. Не пытайтесь сгенерировать всё сразу одним запросом. Первый запрос делает скетч, далее разные области этого скетча дорабатываются последующими запросами. На Хабре есть статья с подробностями.

2. Подсказки. Не получаются руки? Вырезаем откуда-нибудь подходящую кисть руки, кидаем в нужное место, кое-как криво масштабируем/вращаем чтоб более-менее стыковалось. Генерируем в режиме loopback поверх сколлажированного — сетка подгоняет руку по стилистике к основному рисунку, но пальцы уже на месте.

3. Если какой-то персонаж упорно не получается от слова «совсем» (например, никаким запросом вы не сгенерируете Queen Chrysalis, хотя картинками с данным персонажем пол-Интернета завалено), можно взять штук пять изображений-примеров и сгенерировать из них эмбеддинг — своего рода плагин к данной нейронке (они обычно получаются небольшими, всего несколько килобайт), который позволит уже генерировать этого персонажа.

diogen4212

08.09.2022 22:55+5а можно поподробнее по пункту 3 (как это сделать, что запускать, какие должны быть картинки, как потом это использовать в генерации изображений)?

Alexey2005

08.09.2022 23:29+18Нужен форк с поддержкой Embedding, я использую этот. Создаётся папка, куда кидается набор изображений 512x512. Набор должен быть очень небольшим, не более пяти изображений персонажа, желательно в разных ракурсах или позах.

Далее просто запускается соответствующий скрипт (подробности по вышеуказанной ссылке — раздел «Personalizing Text-to-Image Generation»). На RTX3090 генерация эмбеддингов занимает около часа, после этого в указанной папке появляется файл с расширением pt (он очень небольшой, обычно порядка 5 Кб всего).

Далее его можно использовать согласно гайду: эмбеддинги указываются в качестве параметров при запуске генеративного скрипта, дополняя собою сеть. Эмбеддинг содержит ключевые слова, по использованию которых в запросе он применяется.

Очень многие форки Stable Diffusion поддерживают установку уже готовых эмбеддингов, даже если не поддерживают их генерацию.

Например вот этот форк с удобным веб-интерфейсом (подробности установки эмбеддингов в разделе «Textual Inversion»):

github.com/AUTOMATIC1111/stable-diffusion-webui

Нужно создать папку embeddings и просто кинуть туда pt-файлы с эмбеддингами (да, можно несколько разных эмбеддингов одновременно — все они дополняют собою сеть).

Если интересна теория — каким образом добавление считанных килобайт к сетке позволяет ей «выучить» новых персонажей и новые стили — см. здесь подробное описание метода.

Perlovich

08.09.2022 20:15+20Я немного баловался со Stable Diffusion, но не смог получить впечатляющих результатов, как в статье. Возможно, я плохо составляю запросы.

Лучшее, что мне выдала сетка, - это вот эту картинку на запрос "Mice try to learn Japanese"

OneManStudio

08.09.2022 22:23+2Потому что спрашивать надо не то что хотите ВЫ, а понимать, что вам дадут то, как вы спросите. При этом вам не рассказали как спрашивать правильно, нет правил.

По сути нет синтаксиса, ощущение что сетка разбирает морфологически.

phenik

09.09.2022 07:39Я немного баловался со Stable Diffusion, но не смог получить впечатляющих результатов, как в статье. Возможно, я плохо составляю запросы.

С иллюстрациями такое сработает после некоторого опыта составления запросов, но с реалистическим искусством, напр, в стиле Шишкина и высокохудожественным фото пока вряд ли, да и в перспективе тоже сомнительно. Художники воплощают образ, а он не всегда перекодируется в абстрактное представление, т.е. словесное описание. Всегда имеется недосказанность, по определению абстракции передаваемые словами это сжатое представление информации, т.е. с потерей контекста. Заказчик не может точно передать возникший у него образ словами такому ИИ, а тот в свою очередь будет производить аппроксимацию текста заказа в собственном контексте, с дальнейшим искажением смысла предполагаемого в исходном образе. Художники часто переписывают картины, и не раз, когда чувствуют, что им не удается воплотить желаемый образ. При реставрации картин часто находят следы такого поиска. На абстрактные темы, да, нагенерил 100 штук вариантов, и выбрал наиболее подходящий. Конечно можно подбирать и наиболее отражающий образ, но это уже сфера этики, эстетики и компромисса. Похоже это творчество не плохо ляжет на концептуальное искусство (примеры творчества на продажу) В нем не требуется выражение образа, а как раз выражение некой идеи, ее художественного воплощения, прям как в запросе «Mice try to learn Japanese») Со временем на этом вырастут новые поколения, впитают его, и вполне будут счастливы. Спорить о его художественных достоинствах и недостатках — насколько автор правильно составил запрос и выбрал настройки программы, и приобретать за многие миллионы на аукционах.

logran

09.09.2022 11:07+4Заказчик не может точно передать возникший у него образ словами такому ИИ, а тот в свою очередь будет производить аппроксимацию текста заказа в собственном контексте, с дальнейшим искажением смысла предполагаемого в исходном образе. Художники часто переписывают картины, и не раз, когда чувствуют, что им не удается воплотить желаемый образ. При реставрации картин часто находят следы такого поиска.

Заказчик и художнику не может передать словами возникший у него образ, и художник тоже услышанное интерпретирует по-своему и рисует в рамках своих знаний и умений. В чем тут отличие от ИИ-художника?

Просто потом идет серия правок и перерисовываний обычно после концепта. ИИ это умеет. И в создание концептов, и в перерисовывание на их основе (img2img как раз для этого).

Опять же, когда картина не устраивает — ИИ способен перерисовывать части. Инпейнтинг никто не отменял. Выделяете не понравившееся и регенерируете.

ИИ при правильном промте, должном усердии и комбинировании нужных функций одной модели (или разных моделей вообще) может и в стиле шишкина и прочих делать шикарные картины и иллюстрации. И Digital-художник использующий вместо кистей и фильтров ФШ для рисования иные математические алгоритмы ничем не хуже иных Digital-художников. У него всё еще свои идеи, образы и видение, отличается лишь инструмент для воплощения.

Тут главное понимать, что генеративные модели сами ничего не делают. Творит всё еще человек, а модель — лишь очередной художественный инструмент в его руках, с куда более богатыми возможностями чем в имевшихся ранее инструментах.

phenik

09.09.2022 14:30+1Заказчик и художнику не может передать словами возникший у него образ, и художник тоже услышанное интерпретирует по-своему и рисует в рамках своих знаний и умений. В чем тут отличие от ИИ-художника?

Нет, иначе не возникали новые направления в искусстве, и в живописи в частности. Существующий ИИ пока действует в рамках обучающей выборки, комбинируя ее, это относится ко всем видам деятельности, какие запросы и правки ему не задавайте за ее пределы он не выйдет. Принципиально нового он не создаст, как было, например, в случае с импрессионизмом, если брать изобразительное искусство. Он возник под давлением определенных социальных и экономических обстоятельств и складывался постепенно. Т.е. исходно у художников не было этих знаний и умений, они их выработали отталкиваясь от имеющихся на то время, постепенно воплощая возникающие образы. Они искали свои краски, текстуры, выразительные приемы, обыгрывая игру света и тени, работали с перспективой, и тп.

Что касается цифровых художников, то это несколько другое дело. Они более свободны в творчестве, и ограничены только возможностями программных и аппаратных средств. Поэтому в этих рамках могут появляться новые цифровые стили и направления.

Т.е. в чем разница, когда воплощается образ? Художник исходит из собственного опыта, эмоционального настроя, кот. он при этом получил, и пытается его передать. При этом он может использовать совершенно разные приемы, и изобретать новые. А что делается при заказе ИИ? Просто подбирается подходящая фраза на тему. Можно выбирать из стилей, в стиле того же импрессионизма или реализма под Шишкина) Но это всегда будет компромисс, ни сравнимый с возможностями художника. Конечно речь не идет о ремесленных поделках.Тут главное понимать, что генеративные модели сами ничего не делают. Творит всё еще человек, а модель — лишь очередной художественный инструмент в его руках, с куда более богатыми возможностями чем в имевшихся ранее инструментах.

В этом то и проблема, когда у ИИ появится собственный ввод, собственная мотивация и непрерывное обучение, и он сможет творит сам по себе или в диалоге с человеком, то тогда будет качественный скачек. А так инет в скорости завалит еще большая масса бездарщины, как от простых пользователей, так и продвинутых художников. Рисовать то стало намного проще, без всяких навыков и способностей к воображению, и главное задешево)) планка в очередной раз понизилась.

ps. В действительности восхищен возможностями ИИ в различных областях творчества, особенно такой, ближе по интересам, но пытаюсь оценивать это реалистично.

vconst

09.09.2022 16:01+1А что делается при заказе ИИ? Просто подбирается подходящая фраза на тему. Можно выбирать из стилей, в стиле того же импрессионизма или реализма под Шишкина

Очень многие художники, по крайней мере — так они себя называют, действуют очень сходим образом :) Ремесленники, как вы заметили. Вот их — можно попытаться заменить подобными ИИ, только надо существенно увеличить выборку для обучения. Причем — «ремесленник» — это не ругательство, не унизительное обозначение типа «не творец». А вполне позитивное обозначение людей, которые работают на поток, например — иллюстраторы.

Другой вопрос в том, что если художник, хороший ремесленник, натаскает эту нейросеть на своих работах и будет пользоваться ей для генерации множества иллюстраций типовой фантастики, к примеру «средневековый рыцарь, размахивает бластером, защищая прекрасную полуобнаженную землянку от кровожадного инопланетного спрута».

Весьма неплохое подспорье для ремесла, а применяющий его будет настоящим художником, с образованием и большим опытом

phenik

09.09.2022 17:19Причем — «ремесленник» — это не ругательство, не унизительное обозначение типа «не творец». А вполне позитивное обозначение людей, которые работают на поток, например — иллюстраторы.

Так проблема в том, что это все отвянет со временем. Зачем автору произведения, напр, литературного просить иллюстратора сделать к ней иллюстрации? Объяснять ему идеи, когда у него свой образ имеется, и он может воплотить его сам да какой-то степени. Рисовать-то теперь не надо уметь) а сочинить нужную фразу, как раз ему с руки, а не поручать это кому-то, тратить на это время и средства.

Из собственного опыта «иллюстрирования» на Хабре в коментах. Иногда хочется излагаемую идею, иногда интуитивную, некий образ выразить не только словами, но и в изображении. Как кажется это должно помочь оппоненту воспринять излагаемое лучше. Поскольку не могу рисовать, хотя в детстве немного увлекался, то единственный доступный способ для меня это делать коллажи из готовых картинок из инета, добавляя что-то от себя. Поступаю тупо как этот самый ИИ) но конечно имею преимущество в сравнении с ним, т.к. представляю образ некоторой идеи, кот. хочу передать, выразить ее смысл наглядно.

Фиг знает насколько успешно для понимания другими, вот примеры 1 и 2 (коллажи под спойлерами). Это достаточно сложные образы выражающие некоторые представления личного характера на стыке когнитивной психологии и физического познания. Не думаю, что их можно было бы выразить фразой, и дождаться от ИИ чего-то путнего) Это конечно сложная область, для художественных произведений добиться удовлетворительного результата проще, тем более оформления сайтов. От человека художника можно получить результат лучше, но все равно объяснить бывает сложно, для этого он должен что-то понимать в этой области) Так будет с ИИ в будущем, когда он будет основываться на когнитивной архитектуре, т.е. быть ближе к возможностям человека.

vconst

09.09.2022 17:29+1вот примеры 1 и 2 (

Ух ё… )) Сурово так)Так проблема в том, что это все отвянет со временем. Зачем автору произведения, напр, литературного просить иллюстратора сделать к ней иллюстрации? Объяснять ему идеи, когда у него свой образ имеется, и он может воплотить его сам да какой-то степени. Рисовать-то теперь не надо уметь) а сочинить нужную фразу, как раз ему с руки, а не поручать это кому-то, тратить на это время и средства.

Кажется в прошлой теме было обсуждение двух иллюстраций на схожую тему: футуристичекий город, машины на дороге и тп. Картинка художника была хоть и устаревшая, но в ней была некая «история» — целостность. Картинка нейросети была ярче и современнее — но сумбурна и выглядела разрозненной

Так что, иллюстраторы еще поживут

logran

09.09.2022 20:59+2А что делается при заказе ИИ? Просто подбирается подходящая фраза на тему. Можно выбирать из стилей, в стиле того же импрессионизма или реализма под Шишкина) Но это всегда будет компромисс, ни сравнимый с возможностями художника. Конечно речь не идет о ремесленных поделках.

С вашим подходом можно прийти к тому, что и работа программиста сводится просто к подбору подходящего текста, по которому компилятор потом рождает бинарник.

В целом как вам сказать... Человек рождает идею, придумывает образ, придумывает описание образа, придумывет вариант описания понятный машине, варьирует его over9000 раз ради нужного результата, по каждому варианту делает несколько вариаций картинки до тех пор пока оно хотя бы примерно не попадет в образ, нарисованный в его сознании. Затем скелит картинку, перерисоввает в ней части, которые не нравятся, добавляет нужные референсы (ибо сам дорисовать не может) и перерисовывает еще раз. Потом потайлово апскейлит результат до нормального разрешения и деталей, генерирует финальные вариации, сводит в фш детали из них. И получает шедевральный (иди не очень) цифровой арт. Вы уверены, что уменее водить кистями в ФШ на планшете более творческое, чем это? Тут нейронка лишь в роли более сложной кисти, которая рисует не просто линии и формы, а целые объекты. Но идея, композиция, настроение, атмосфера и образы всё еще за человеком.

В данный момент в инсте идет AI Art contest. Работа на него занимает у меня около 3-4 часов и между выдачей сети (одной-двух из нескольких сотен) и итоговой работой общего только композиция или некоторая её часть (если ни в одну генерацию нужное мне не попало целиком). Буду дома у компа - выложу до и после для примера.

phenik

10.09.2022 10:01+1Человек рождает идею, придумывает образ, придумывает описание образа, придумывет вариант описания понятный машине, варьирует его over9000 раз ради нужного результата, по каждому варианту делает несколько вариаций картинки до тех пор пока оно хотя бы примерно не попадет в образ, нарисованный в его сознании.

В целом как вам ответить… вероятно мы мыслим о разном) Что такое образ, если процесс рассматривать в наиболее незамутненном виде? Человек живет, встречается с проблемами, в том числе интеллектуальными, решаете их, эмоционально переживает их, или идет на природу и ее виды вызывают в нем определенный эмоциональный настрой. При этом спонтанно возникают образы, кот. хочется воплотить, без всяких там предварительных идей. Между этим образом и воплощением должно быть минимум средств, кот. навязывают способ реализации. Самые простые, имеющее первобытные корни, это карандаши, кисти и краски, полотно, его умение использовать эти средства, его восприятие, и его образ. Не зря это воплощение лучше всего получалось у импрессионистов и экспрессионистов, у них даже образ жизни был соответствующий. Сложнее, но также ясно у реалистов, не имеются в виду его идеологизированные формы. Это не для заказов, продаж, выставок и тп, кот., пусть и бессознательно, навязывают идеи и способы их воплощения — какие уж там образы. Если что-то и было, то это может окончательно хоронится средствами реализации, кот. в последнее время выполняют все большую часть работы за человека. Использование ИИ это след. шаг в этом процессе, а вовсе не кисть в руках художника) Это убыстрение, удешевление работы, и это в порядке нормы, для потребностей растущего рынка. На этом воспитается новое поколение, кот. будет считать продукты этого производства шедеврами, и это тоже вполне нормально. Это как с многокилометровыми мультсериалами созданными средствами компьютерной графики, от которых тащятся современные дети. Для них это искусство анимации, для меня, например, нет, для меня это старые рисованные руками мультики. Так было всегда. Импрессионистов тоже обвиняли в упрощении изобразительных приемов в сравнении с классическим реализмом в угоду массовости производства картин, из-за возросшего спроса со стороны растущего класса буржуа.

Ажиотаж вокруг этих систем ИИ возник не потому, что они создали что-то новое в изобразительном искусстве, а потому что они на порядок удешевят производство, ускорят его, и упрощают требования к иллюстраторам, вплоть до отсутствия каких либо способностей к рисованию, вот и пример. Просто нужно иметь это в виду, а так зашибись вся эта живопись) и, да, это занудство.

Ndochp

09.09.2022 11:30+1Пример кстати с иллюстрациями:

https://semiurg.ru/neuros/

Недавно автор нехорошо отзывался о стоках, которые и картинки зажали и денег не вернули, а теперь ушел в иллюстрации сетями.

Stiver

08.09.2022 22:01+10А ведь это уже было в

Симпсонахлемовской «Кибериаде». Один в один, только там не изображения, а стихи. Но уверен, что кто-нибудь и стихосочиняющую сеть соберет.

– А теперь на Г! Четверостишие о существе, которое было машиной, одновременно мыслящей и безмозглой, грубой и жестокой, имевшей шестнадцать наложниц, крылья, четыре размалеванных сундука, в каждом из которых по тысяче золотых талеров с профилем короля Мурдеброда, два дворца, проводившей жизнь в убийствах, а также…

– Грозный Генька-генератор грубо грыз горох горстями… – начала было машина, но Трурль подскочил к щиту управления, нажал на рубильник

JuriM

08.09.2022 23:09+12Вадим Шефнер «Девушка у обрыва»

Творзадание принято! – глухо произнёс голос из прибора, и сразу же вспыхнуло табло с надписью «творческая отдача». Затем из продолговатого узкого отверстия вылез лист бумаги. На нём было напечатано:

Кот и малютки

Здравствуй, здравствуй, кот Василий,

Как идут у вас дела?

Дети козлика спросили…

Зарыдала камбала.

И малюткам кот ответил,

Потрясая бородой:

– Отправляйтесь в школу, дети!..

Окунь плачет под водой.

kmosolov

09.09.2022 18:01+4Добавлю еще пару цитат оттуда, что бы понимать контекст:

— Ну пусть он сочинит что-нибудь для детей, что-нибудь там про кошечку,

например, — предложил я, выбирая тему полегче.

Красотухин нажал на АТИЛЛе кнопку с надписью «Внимание». Вспыхнул зеленый

глазок, агрегат глухо заурчал. Тогда Красотухин нажал клавишу с надписью

«стихи д/детей». Прибор заурчал громче. Из него выдвинулся черный рупор.

— АТИЛЛушка, творческое задание прими. Про кота что-нибудь сочини, — просительно произнес Писатель-Ихтиолог в рупор.— Сказка несколько примитивна, — сказал я. — И потом опять тут всякие рыбы.

— Да, мой АТИЛЛА любит упоминать рыб, — огорченно признался Красотухин. — Боюсь, что я несколько перегрузил его ихтиологическими знаниями.

Уже тогда, в 1964 году (!), была поднята проблема выбора датасета для обучения нейросети :)

P.S. Шефнер — один из любимейших авторов моего детства.

d2d8

09.09.2022 02:32+4Компьютерная программа делает не то, что вы хотели, чтоб она сделала, а то, что вы приказали ей сделать. Во всяком случае так было раньше.

Kristaller486

09.09.2022 13:07+1Тут стало сложнее. Помимо того, что она "делает то, что ей сказали", сказать ей надо очень специфические вещи, которые та лучше поймёт, а документации на эти специфические вещи никто не написал, потому что это черный ящик

d2d8

10.09.2022 04:12+2Теперь вы лучше понимаете ощущения бухгалтера Гали, когда принтер не печатает.

Quilly

09.09.2022 09:00Проблема всех этих нейросетей, что обучены они на очень корявых данных. Можно ли на хотя бы 80% быть уверенным, что описания к картинкам писали без оценочных суждений и личных предпочтений? Вот скармливаем ей "spirits of java". В целом ожидаемо, что должно быть нечто абстрактное, раз какие-то духи. И с дУхами она справится так как я уверен артов такие вагон и маленькая тележка и нейросеть 100% выделила какие-то особенности для них. Чтобы выдать нечто близкое к java, машина должна понимать еще контекст. Просто картиночек с лого java недостаточно. Еще лучше если анализировать тексты, форумы, статьи java-разработчиков а уже на основании них пробовать построить какой-то набор машинных стереотипов. Вот даже человека попросить нарисовать, пусть даже разработчика, "spirits of java", но при этом не прибегаю к изображению компьютера, кода или лого-чашки. Сможет ли он так сходу выдать что-то? Сможет ли другой человек не знаю по какому запросу нарисовали этот рисунок сказать "ага ну это какие-то духи, java наверное?". Мне кажется чтобы выдавать такие арты нейросетям еще переть долго и долго, потому что тут требуются высшие когнитивные функции. Да и в целом лично меня не впечатляют эти достижения. Просто взять за референс 10 картинок и объединить детали из них в одну много ума не надо. И творчества как такового тут нет. Другой вопрос что множественная генерация нейросетью позволяет автоматизировать этот процесс и выдать попросту случайно какой-нибудь интересный вариант на основе которого, как рефа, можно нарисовать реально крутой, новый, "неповторимый" арт.

Sadler

09.09.2022 12:59+3Я просто оставлю здесь концепт-арт мечника, который я сгенерил в Stable Diffusion по мечу (который ранее тоже сгенерил той же сетью)

Мечник

Меч

Refridgerator

09.09.2022 14:33+3Возле правой ноги видны чёрточки, сильно похожие на подпись художника. Палево)

Sadler

09.09.2022 14:34+1Вы отказываете нейросети в праве подписи её работ? :)

vassabi

09.09.2022 15:30+1мы переживаем что придет автор рисунка, на котором учили сетку, и спросит "а почему к моему мечнику пририсовали такой меч и не указывают - у кого брали мечника?" :)

Sadler

09.09.2022 15:45Это очень мило. И очень глупо.

vconst

09.09.2022 16:06Но такие нападки — точно будут! :) Некоторые все еще думают, что джина можно затолкать обратно в бутылку или просто не понимают технических деталей

Хорошо, если набор для обучения был взят из паблик домайн, но если кто, не очень сознательный, скачает форк и натаскает на том, что нравится, а не что свободно?

shiru8bit

09.09.2022 16:50Надо сказать, что у SD на некоторых изображениях очень отчётливо проявляются следы вотермарков, т.е. часть сета составляли превью с сайтов клипарта.

inkelyad

09.09.2022 17:26Народ уже исследовал. И оно вполне известно изначально были - создатели как бы и не скрывали, откуда картинки брали.

А так, там в статье

Nearly half of the images, about 47%, were sourced from only 100 domains, with the largest number of images coming from Pinterest.

Sadler

09.09.2022 17:41+1Я одно время искал источники вдохновения сети в плане клипарта, ибо там есть куда больше возможностей радикально по-разному нарисовать одно и то же, в отличие от реалистичного представления. Прогонял каждый вывод сетки через google images, пока ничего криминального не нашёл.

Вот вам нейросетевые векторные лисички

Sadler

09.09.2022 17:05Latent space у нас предполагается сильно меньше набора данных, потому шанс, что где-то в структуре весов сохранится целиком авторское изображение, крайне мал. Обучить заново на сугубо несвободном можно, но в ближайшее время не в домашних условиях. Если же несвободного на порядок меньше, чем свободного, то почти наверняка можно не переживать за лицензионную чистоту вывода.

Из возможных придирок я допускаю сохранение "авторского стиля" как более локального явления (форма предметов, цвета, определённая техника мазков кистью). Но я не уверен, что авторские права на стиль можно защитить, это ничем не будет отличаться от запрета живым художникам рисовать в определённых стилях.

Поэтому, когда очередной знаток мне всерьёз говорит "это коллаж" или "у вас подпись автора на картинке", это уже даже не смешно. Рядом с сетью лежит подробное описание модели, бери и читай, не придётся нести пургу.

vconst

09.09.2022 17:18Рядом с сетью лежит подробное описание модели, бери и читай, не придётся нести пургу.

Такие оппоненты или сами художники, то есть чистые гуманитарии, или просто люди далёкие от понимания этой технологии и, непонятно зачем, влезающие в непонятный для них спор.

vassabi

09.09.2022 19:43увы, деньги - они такие.

Причем самому автору может будет и все равно, но если у него эксклюзивные права переданы издатеюлю или еще куда-то - то оттуда точно придут приматываться: "у вас неправомерное использование, с вас штраф" и тд.

Wizard_of_light

09.09.2022 13:05+3Семь красных перпендикулярных линий уже кто-нибудь пробовал у нейросети просить нарисовать?

StrangerInTheKy

09.09.2022 14:07+2Я пробовал :) Еще недели две назад. Так себе линии, если честно. Я лучше нарисую :)))

DALL-E: https://i.ibb.co/G7nvpH7/7lines.png

Stable Diffusion: https://i.ibb.co/99FfPX5/7linesSD.png

iShrimp

09.09.2022 19:34+1Не знаю, много ли обложек альбомов было в обучающей выборке. Но нейросеть не только угадала тематику, но и сгенерировала довольно атмосферные картинки!

Strangers in the night

Fly me to the moon

RainbowJose

10.09.2022 02:05+3Из статьи следует, что если бы не вонь всяких мудаков, которые запрещают незапрещаемое - мы бы встретились с этими прекрасными вещами гораздо, гораздо раньше. Что такое - два года? Может и не много, но в жизни таких двух лет всего, в среднем, 35, отнюдь не равноценных по качеству. Это ли не современный луддизм.

Но есть и классное: мир до того дошел, что oracle дает бесплатные машины, пусть и на непрозрачных условиях, гугл позволяет бесплатно запускать всякое барахло на недешевых видеокартах, например этот же stable diffusion, не говорю уже про все множащиеся бесплатные сервисы, один лучше другого.

Это ли не современный коммунизм.

cepera_ang

10.09.2022 08:16+1Да не, два года назад ещё непонятно было как такое сделать. Но вот на полгода-десять месяцев раньше могли бы иметь, если бы OpenAI был на самом деле Open.

logran

10.09.2022 09:59Справедливости ради, бесплатно гугл в основном подсовывает теслу к80, которая за 24гб стоит всего 79-100$ на ebay, а гугл её ищё и уполовинивает до 12гб.

ИМХО, выгоднее за 150$ взять себе чуть более новую m40 и использовать хоть и медлено (ибо Maxwell), но надежно с 24гб без всяких лимитов пользоваться.

vassabi

10.09.2022 19:20мне кажется, или вы сравниваете "бесплатно" с "за деньги" ?

В то время как первый вариант доступен "любому школьнику с головой", подскажите - какое расчетное количество сэкономленных школьных обедов для покупки второго варианта ? И куда его установить в смартфон после покупки?

Alexey2005

11.09.2022 16:35а гугл её ищё и уполовинивает до 12гб.

Это не Гугл, это сама K80 на самом деле содержит не 24Гб VRAM, а 2x12 Гб, т.е. это два GPU в одном корпусе, каждый из которых использует только 12 Гб памяти. Все 24 можно использовать лишь при распараллеливании батчей.ИМХО, выгоднее за 150$ взять себе чуть более новую m40 и использовать хоть и медлено (ибо Maxwell), но надежно с 24гб без всяких лимитов пользоваться.

Примерно в 11 раз медленнее RTX3060 при тесте на генерации картинок VQGAN+CLIP.

К тому же M40 вы напрямую в комп не воткнёте — это же серверная карта, там даже системы охлаждения нет в комплекте. Т.е. придётся ещё что-то колхозить с охлаждением и питанием, плюс не факт что она встанет в ваш корпус (у неё же по умолчанию нет видеовыходов, а значит, вам потребуется ставить её второй картой, и тут далеко не у всякой матплаты нужная компоновка, чтоб две видюхи влезли).

Наконец, Tesla ещё надо заставить работать, там гарантированно будут сложности с драйверами и настройкой. В общем, это скорее DIY-полуфабрикат, чем готовый продукт.

Ну и плюс покупка б/у карточки — всегда лотерея, особенно при отсутствии гарантии в случае такой покупки.

irsick

11.09.2022 07:19Переписывание истории стало совсем тривиальной задачей с массовой цифровизацией. Даже книги не надо теперь сжигать. Правки в Википедии ничего не стоят.

Вот тут-то блокчейн и может, наконец, пригодится для подтверждения подлинности. По крайней до того момента, пока квантовые вычисления не придут на помощь следующему режиму, решившему подкорректировать прошлое.

PereslavlFoto

11.09.2022 17:53Чтобы сделать правку в Википедии, обычно приходится найти книгу, прочитать её, передать её сообщение своими словами и сделать ссылку на книгу с указанием страницы. Этого требуют правила Википедии.

phillennium Автор

Добавлю тут к переводу от себя. Для меня давно актуален вопрос «чем иллюстрировать хабрапосты»: в технических темах бывает сложно подобрать открывающую картинку.

И в связи со Stable Diffusion стало интересно: можно ли генерировать КДПВ с её помощью? Решил скормить какие-нибудь «хабровые» промпты ей и другому нашумевшему проекту Midjourney.

Вот как, оказывается, они представляют себе «Java Developer» (во всех примерах ниже сначала результаты SD, потом Midjourney):

Hidden text

А поскольку я пишу о наших готовящихся конференциях вроде Joker, попробовал «joker java developer conference», вылез некий «жапкин жопер»:

Hidden text

Окей, понятно, тут Midjourney за название зацепилась. А если взять другие наши конфы с менее окрашенными названиями — вроде DotNext?

Hidden text

Интересная разница подходов: Midjourney уходит в абстракцию, а Stable Diffusion пытается сделать конкретику вплоть до надписей (но, к сожалению, в них не преуспевает).

В итоге у SD получаются слишком криповатые картинки для использования как КДПВ, а у Midjourney просто красивенькие абстрактности, и их использовать-то можно, но связь с темой минимальная. Ну, хотя бы в запросе «the spirit of java» логотип языка обыграл:

Hidden text

acsent1

Ну, собственно, в статье и говорится, что чтобы создать приемлемую картинку нужно быть prompt engineer, а не просто скормить ему первую попавшуюся фразу

phillennium Автор

Конечно, у prompt engineer получилось бы лучше. Но тут главная загвоздка-то не в том, чтобы донести свою идею до машины (как обычно бывает и в чём может помочь prompt engineer), а в том, чтобы эта идея вообще возникла: чем иллюстрировать «текст про Java 19»?

И поэтому захотелось проверить: может быть, у самой машины есть идеи по этому поводу? Как она на первые попавшиеся джавовые фразы отреагирует?

IvanGanev

Midjourney умеет неплохо обыгрывать идеи если они широко известны, какой-то мейнтсрим - к примеру неплохо реагирует на страны, задать ему Россия + что-то или там Франция + что-то - он может как-то интересно и неожиданно это обыграть.

ProstakovAlexey

Вот ее результат, неожиданно - да, годно - нет. Если у кого есть дети школьники - то вам известна проблема - задают рисовать что-нибудь, к разным событиям. Нам задали рисунок на тему ПДД. Ну думаю - компуктер, это твой выход, сейчас зажгем. Зарегистрировался - запрос "Детский рисунок карандашом. Тема - правила дорожного движения. Город, мальчик и девочка переходят улицу перед автомобилем по пешеходному переходу."

leventov

Попробуйте "Duke, the Java mascot discovers new Java features in a treasure chest"

Meklon

pavel_raskin

Каков датасет, таков и результат работы обученной на нём сети. Если в скормленных картинках много "котиков" и мало "ява-девелоперов", то само собой с генерацией сюжетов про разработку у такого ИИ будут проблемы, но "котики" должны получаться отменными.

spanasik

Народ очень просит сгенерить %LANGUAGE_NAME% Developer хотя бы для 10 самых популярных языков.

phillennium Автор

Попробовали, какой-то принципиальной разницы между разными языками не обнаружилось (разве что у питонистов одна из картинок — змеиная чешуя)

Вот ссылка на подборку: https://imgur.com/a/ccL1pRC

Там по несколько картинок про Python, C#, PHP, Go, JavaScript, Kotlin (именно в таком порядке), и сейчас не подписано где что (могу подписать), но в целом ясно по надписям на картинках, в них постоянно буквы из названия языка

AllexIn

Программисты у сетки получаются криповенькие. Прясм смотришь, и понимаешь: да, именно так мы и выглядим для других

людейнейросетей.spanasik

C.Charop очень понравился.

PHP полностью отражает реальность.

JJVAJPSIT DETOEPER убил.

pulsatrix

Sadler

Среди очевидного обилия сидящих за компом людей попалось и что-то весёлое. Уточнять, для какого языка это сгенерилось, я, пожалуй, не буду, а то побьют.

Hidden text

Alexey2005

Alexey2005

PereslavlFoto

Быстрее и проще найти на Викискладе фотографию, которую можно использовать по свободной лицензии.

phillennium Автор

По запросам со словом Java там в основном индонезийский остров находится.

PereslavlFoto

https://commons.wikimedia.org/wiki/Category:Java_(programming_language)

phillennium Автор

Ну вот открываю я эту страницу, вижу там фрагменты кода на арабском, логотип фреймворка Google Guice и иллюстрации из старой немецкой книги «Internet Programmierung mit Java». Вопрос: если готовится, для примера, пост про Java 16, то что из этого хорошо подойдёт как открывающая картинка?

PereslavlFoto

Для поста про Java 16 лучше всего подходит картинка, на которой изображён фрагмент кода, иллюстрирующий некую важную перемену.