Центр обработки данных — достаточно энергозатратная система. Большое количество энергии требуют как ИТ-инфраструктура, так и системы её охлаждения.

Считается, что в мировом масштабе центры обработки данных потребляют около 3% от общего уровня потребления электроэнергии в мире, и, скорее всего, эта доля будет расти. Кроме того, с развитием высокопроизводительных процессоров будет увеличиваться количество тепла, выделяемого серверами. Уже сейчас системы охлаждения ЦОДа могут потреблять 30-50% от общего энергопотребления.

Также есть мнение, что через какое-то время традиционные воздушные системы охлаждения серверов перестанут справляться с теплоотведением оборудования, то есть воздух будет забирать тепло от нагревающихся элементов медленнее, чем эти элементы будут его генерировать. Если не внедрять способы решения проблем охлаждения, то рост температуры будет приводить к снижению производительности и систематическим отказам.

Вопрос экономии также играет роль – в некоторых случаях внедрение альтернативных источников охлаждения может помочь на порядок сократить капитальные и операционные расходы. Всё это обуславливает интерес операторов центров обработки данных к альтернативным способам охлаждения оборудования. Как следствие, все это приводит к росту новых разработок и исследований. Впереди всех тут, конечно же, крупные компании, например, Майкрософт, тоже ведущий исследования в этой области.

Сегодня я хотел бы поговорить об иммерсионном охлаждении – любопытной концепции, известной давно, но так и не вышедшей в отрасли охлаждения компьютерных систем в сколь-либо массовый продакшен.

Что же это такое?

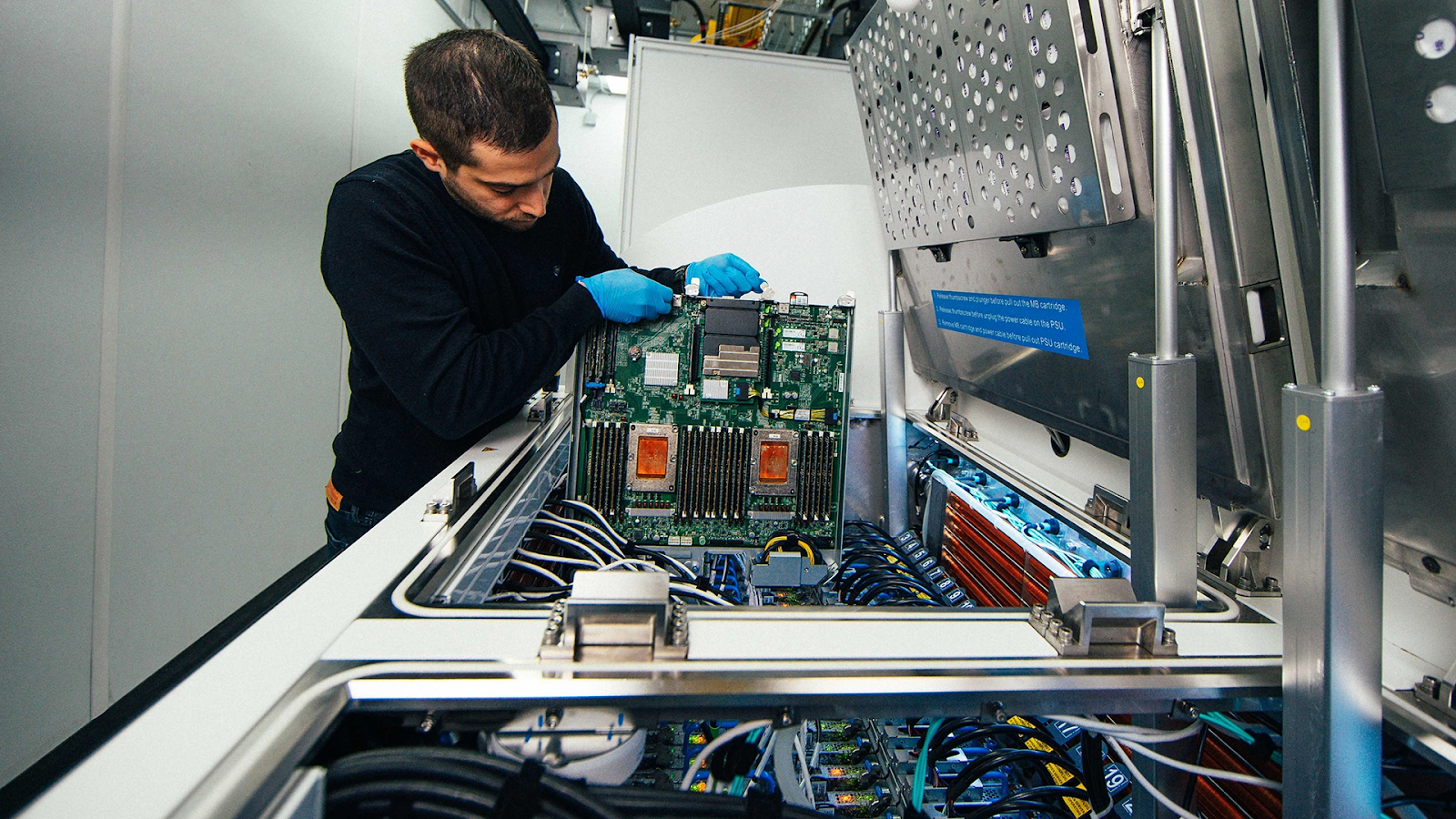

Перевод слова “immersion” на русский язык сразу дает представление о сути этой технологии – погружение. Иммерсионное охлаждение заключается в погружении рабочей машины (сервера) или отдельных его компонентов: материнской платы с процессором, видеокарты, дисков, блока питания и так далее – в теплопроводную диэлектрическую жидкость, которая обеспечивает отбор тепла от устройства, не затрагивая при этом (в силу непроводимости) работы электроники.

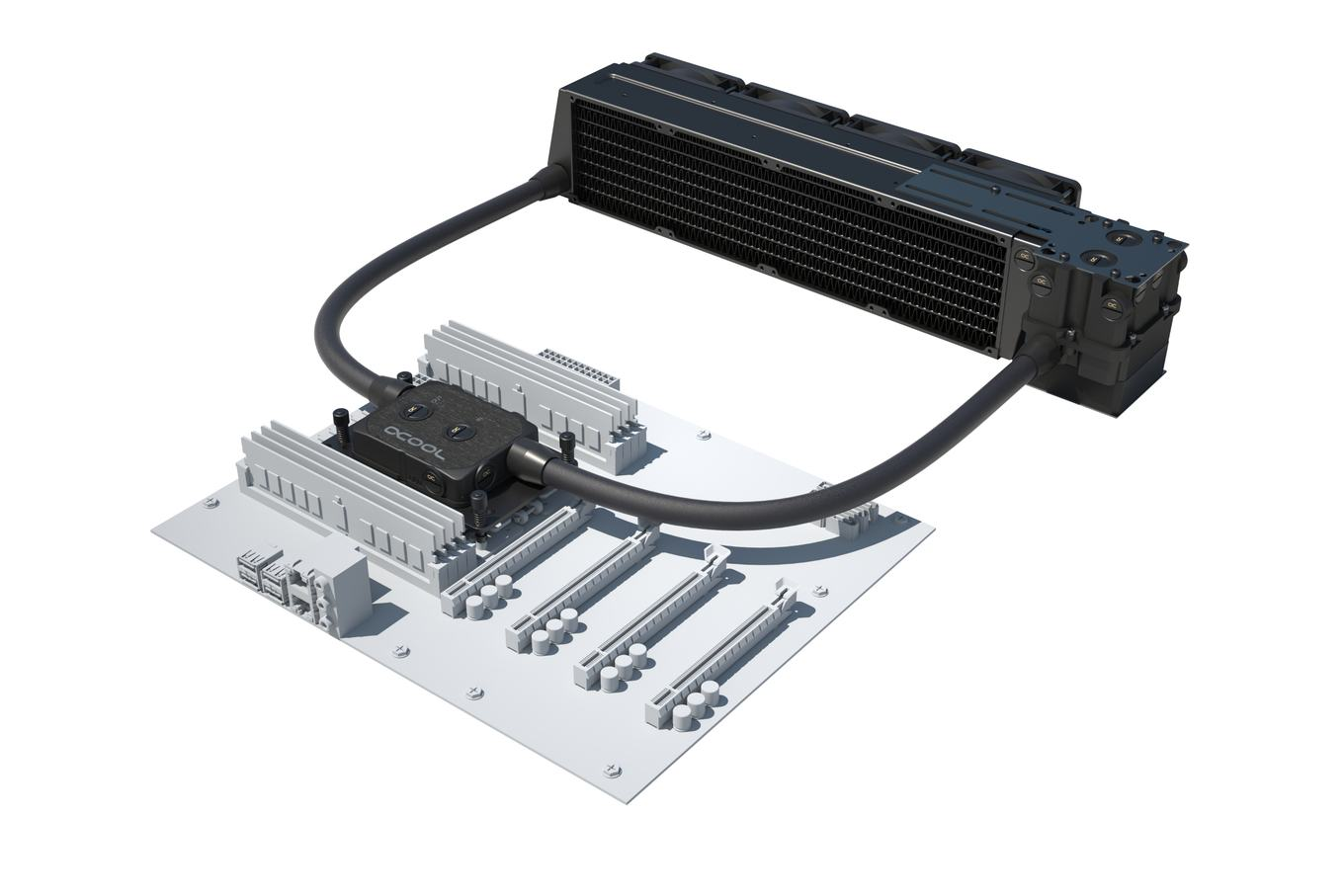

Вообще, в последние годы системы жидкостного охлаждения серверов и ПК набирают популярность. Например, у нас в FirstVDS на часть серверов установлены CPU-водоблоки, и, думаю, у каждого найдется хотя бы пара товарищей-геймеров, использующих такой тип охлаждения на своих игровых станциях.

Обычным пользователям такая система без надобности, но если речь идет о высокопроизводительных машинах, вода, обладая большей по сравнению с воздухом теплоёмкостью, позволяет эффективнее отводить тепло от нагревающихся элементов системы, сохраняя их работоспособность. Однако жидкостная система охлаждения не обязательно должна быть реализована через установку водоблоков, трубок, помпы и, собственно, жидкости, циркулирующей через такую систему.

У иммерсионного охлаждения другой подход, менее традиционный. Бесспорно, его можно назвать разновидностью жидкостного охлаждения, но оно не требует наличия герметичного контура для хладагента, что, очевидно, выгоднее с точки зрения упрощения конструкции, также при таком подходе охлаждается весь сервер, а не только узлы под водоблоками.

Надо сказать, что иммерсионное охлаждение оборудования началось, конечно, не с серверов. Еще в XIX веке практиковалось охлаждение трансформаторов путем погружения в масляную ванну. Это до сих пор является общепринятой практикой, а трансформаторное масло в современной классификации – это отдельный вид минеральных масел, со своим ГОСТ и так далее. Кстати, трансформаторные масла также применяются как охлаждающие жидкости для иммерсионных ванн.

Разберемся более подробно

Сервер погружается в некую ванну, заполненную диэлектрической жидкостью. Предварительно с сервером не совершается никаких специальных манипуляций, исключением может быть разве что демонтаж корпуса (частичный или полный), радиаторов и кулеров воздушного охлаждения. Жидкость, находящаяся в прямом контакте с нагревающимися частями сервера, отводит тепло, а затем охлаждается в чиллере или с помощью иного теплообменника.

Диэлектрические жидкости, используемые в иммерсионных системах, по виду вещества можно поделить на две категории:

Масла. Минеральные, синтетические, силиконовые — тысячи их! В качестве примера можно привести, например, STE Oil Crystal Plus 70T или Блюмид.

Фторуглероды. Такие, как 3M Novec и Fluorinert.

И также диэлектрические жидкости делятся на двухфазные и однофазные:

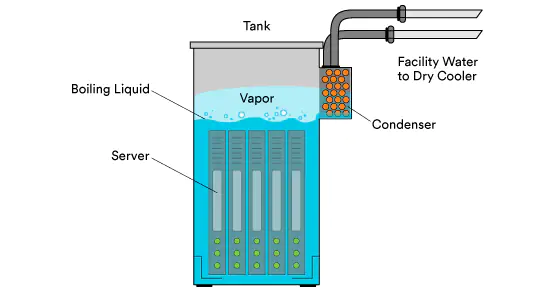

Двухфазные жидкости — во время цикла охлаждения оборудования жидкость превращается в газ, т. е. испаряется. Получившийся пар охлаждается с помощью конденсатора, обычно это змеевики с проточной водой, которые располагаются в верхней части иммерсионной ванны (внимание на картинку). В результате пар конденсируется и в жидком виде капает обратно. Такие жидкости характеризуются низкой точкой кипения, как правило, около 60 градусов Цельсия. Для такого типа охлаждения используются только герметичные резервуары.

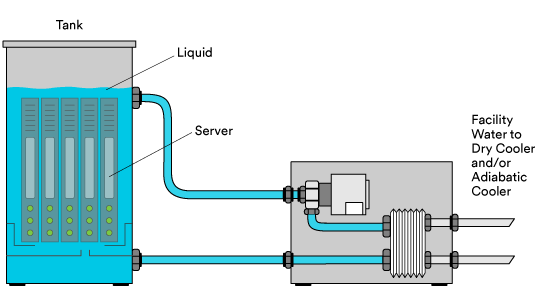

Однофазные жидкости — жидкость все время находится в одном агрегатном состоянии. Такой подход требует циркуляции диэлектрической жидкости в резервуаре с помощью насосов или естественной конвекции, они никогда не доводятся до кипения. Для охлаждения жидкость прокачивается через теплообменник. Жидкости для однофазного иммерсионного охлаждения характеризуются высокой точкой кипения. Резервуар для однофазной жидкости может быть открытым.

Плюсы иммерсионного охлаждения

Жидкость, обладая бóльшей, чем воздух, теплоёмкостью, позволяет отводить от устройства бóльшее количество тепла. Это даёт возможность использовать более высокопроизводительные CPU/GPU, вырабатывающие большое количество тепла, не боясь их перегрева и выхода из строя, а также позволит размещать оборудование более плотно, экономя пространство.

Иммерсионное охлаждение исключает явление локального нагрева, потому что охлаждает всю поверхность устройства равномернее, чем при воздушном охлаждении или, тем более, непрямом жидкостном охлаждении, то есть через водоблоки. Такой подход повышает, в том числе, срок службы устройств.

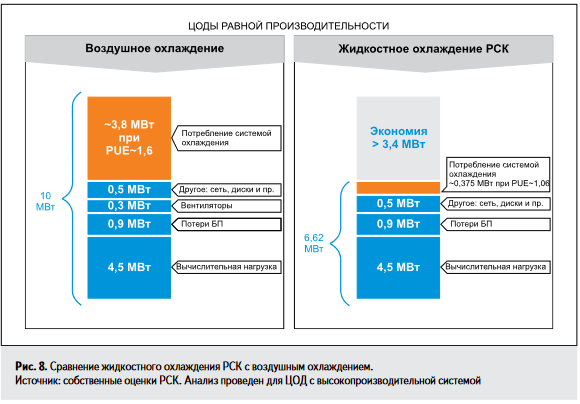

Снижение затрат на электроэнергию за счет отказа от инфраструктуры воздушного охлаждения в пользу иммерсионной, например, отпадает необходимость фальшпола и закрытых холодных коридоров. Благодаря более эффективному охлаждению коэффициент PUE приближается к единице.

Повышение вычислительной мощности. Эффективная система охлаждения позволяет разгонять устройства до максимума без риска перегрева.

Исключение попадания пыли и грязи. Вентиляторы воздушной системы охлаждения переносят частицы, которые потенциально могут стать причиной сбоя в оборудовании. Иммерсионный подход решает эту проблему, повышая надежность устройств.

В случае применения негорючих диэлектрических жидкостей отсутствует необходимость в сложных системах пожаротушения.

Отсутствие шума.

Что же, список преимуществ выглядит солидно. Обычно сторонники иммерсионного охлаждения ЦОД в своих материалах после перечисления вышеописанных достоинств начинают рассуждать о “принципиально новом подходе” и “технологическом прорыве”. Однако, если игнорировать маркетинговую составляющую, сложно не заметить, что иммерсионные решения практически не используются в ЦОДах. Подавляющее большинство операторов ЦОД в России и мире строит и использует инфраструктуру под воздушное охлаждение, а иммерсионный подход используется в основном в майнинге и в небольшом количестве экспериментальных программ. Почему так происходит?

Чтобы ответить на этот вопрос, необходимо проанализировать плюсы, перечисленные выше.

Недостатки иммерсионного охлаждения

Список достоинств, приведенный выше, с незначительными вариациями можно встретить на любом сайте компании-производителя иммерсионных жидкостей, оборудования или иных подобных решений для майнинга и ЦОД. На мой взгляд, он правдив и объективен, однако количество возникающих при переходе на иммерсионное охлаждение вопросов перевешивает плюсы, особенно если рассматривать их “у станка” – находясь в работающем дата-центре, умозрительно прикидывать узкие места того или иного аспекта.

Утилизация тепла. Иммерсионная жидкость, отводя тепло более эффективно и в бóльших количествах, действительно позволяет размещать сверхвысоконагруженные стойки (до 100 кВт на стойку против 12-15 кВт при воздушном охлаждении). Но отвести тепло от серверов это только половина задачи, главный вопрос — это утилизация тепла, эта проблема никуда не пропадает. В любом случае придется использовать теплообменники гораздо более производительные и дорогие, чем в системах с воздушным охлаждением. Это, в свою очередь, снижает экономию на электроэнергии.

Гарантия на оборудование. Поскольку все серверы архитектурно приспособлены не под иммерсионное охлаждение, а под воздушное, производитель по умолчанию будет рассматривать как негарантийные все случаи поломок и дефектов используемого с иммерсионными системами оборудования. Единственное исключение, которое я нашел, упоминается в этой новости на Хабре. Такой сервер, наверное, под гарантию попадет :)

Кроме того, некоторые виды жестких дисков невозможно использовать в жидкостной среде в принципе – перестает крутиться шпиндель из-за более плотной среды. Использовать в иммерсионных ваннах можно только герметичные гелиевые HDD или твердотельные накопители.

Горячая замена и обслуживание. Вызывает вопросы возможность замены дисков без остановки сервера, а также его включение-выключение-ребут по кнопке. Чтобы произвести каждую из этих операций в обычном ЦОДе, инженеру надо просто открыть стойку, а в случае иммерсионной ванны сервер необходимо достать, дождаться стекания иммерсионной жидкости… В схеме с двухфазным охлаждением ситуация будет еще сложнее из-за требований к герметичности резервуаров. В общем, если горячая замена и будет реализуема в принципе, то её скорость снижена в разы в сравнении с классической стойкой.

В целом, весь процесс обслуживания физического сервера будет занимать больше времени, чем обычно – достать сервер из иммерсионной ванны и подготовить к сервису дольше, чем из обычной стойки. Это влияет на статистику простоя.

Также сомнительна фактическая полезность некоторых часто озвучиваемых поставщиками иммерсионных услуг преимуществ:

Отсутствие шума. Никто не будет делать иммерсионный проект только из-за желания избавиться от звукового загрязнения. Бесшумность оборудования может быть важна для домашнего майнинга, но в ЦОДе снаружи слышно не будет, а внутри сотрудникам дадут противошумные наушники. Кстати, прочитать о том, как наша дежурная смена подбирает средства шумозащиты, можно в этой статье.

Экономия пространства. Сверхплотное размещение серверов, которое становится возможным с использованием иммерсионного охлаждения, должно иметь под собой какое-то объективное обоснование. А не просто потому, что так можно или захотелось.

Например, таким обоснованием может стать высокая стоимость земли – если цена квадратного метра $10000, то, наверное, игра в экономию площади стоит свеч.

Вторая причина - ограниченное пространство. Если вы майнер и в вашем распоряжении только площадь своей квартиры или гаража, но при этом вы хотите снимать с фермы не 10 кВт, а 80, то внедрение иммерсионных ванн с хэш-платами в них вместо традиционного воздушного охлаждения будет целесообразно.

Если рассматривать не майнинг, а дата-центры, то серьезное ограничение пространства может возникнуть из-за необходимости разместить большие мощности на небольшой площади офиса в силу, например, политик безопасности, но я не видел таких кейсов на практике.

Еще один момент. При строительстве дата-центра сложность представляет не поиск места под строительство нужной площади, а поиск электричества. Другими словами, для традиционного ЦОДа сложно найти 10 МВт, а площадь под строительство ЦОДа такого размера значительно легче. Особенно эта проблема актуальна в условиях города.

Повышение срока службы устройств. Да, за счет эффективного теплоотведения снижается нагрев приборов, и серверы служат дольше. Однако даже в традиционных, “воздушных” ЦОДах давно действует правило “Устареет быстрее, чем сломается”. В данный момент нужды в вечных серверах нет, а срок годности стандартного сервера – 5 лет, после чего его место занимает более производительный собрат. Таким образом, сильная нужда в повышении срока службы сервера отсутствует.

Исключение попадания пыли и грязи. Серьезная проблема потенциально, однако достаточно легко решаемая клинингом. В Ixcellerate влажная чистка пола проходит раз в день, вход в машзал осуществляется только в бахилах, уборку стоек и чистку серверов мы проводим регулярно.

Иногда еще, в приложение к словам об исключении попадания пыли, начинают писать о пользе демонтажа серверных кулеров в процессе “подготовки к погружению” платформ в ванны, якобы они часто ломаются, что влечет за собой перегрев и простой сервера. Звучит сомнительно – за все годы работы в дата-центре ни у одного из наших серверов я не видел отказавшего вентилятора.

Заключение

Мое мнение — системы иммерсионного охлаждения, в силу вышеописанных причин, не смогут занять место традиционных систем в центрах обработки данных в обозримой перспективе. В ближайшее время целесообразно лишь их точечное применение под определенные задачи: в сфере высокопроизводительных вычислений, при сверхплотном размещении мощностей в силу ограниченного пространства или для лабораторных исследований.

Возможно, дальнейшее развитие мощных процессоров даст импульс к более широкому применению иммерсионного охлаждения, если окажется, что другие системы более не способны отводить тепло от столь мощных систем.

P.S. Этот материал я написал, готовясь к созданию своей иммерсионной фермы из нескольких серверов в образовательных целях, чтобы немного структурировать свои мысли на бумаге. Всё вышеописанное - мое личное мнение, и я с удовольствием прочитаю ваше в комментариях под постом. Спасибо.

Комментарии (16)

entze

27.10.2022 12:01А стоимость и доступность жидкостей? Есть ли у них ухудшение характеристик?

И не убьет ли горстка металлической стружки засыпанная в масло сервера в ванне?

little-brother

27.10.2022 12:05Участвовал в паре подобных проектах - пока это сырая технология. Да энергоэффективность хороша, остальное - ну так себе.

PereslavlFoto

27.10.2022 13:49Нет, там не масло. (Да и в статье об этом было сказано.)

Нет, не убьёт, потому что оседает.

aaabramenko

27.10.2022 14:47Магнитная ловушка в помощь, как в картере ДВС.

randomsimplenumber

28.10.2022 08:46Всегда можно найти чем устроить саботаж. Можно алюминиевую стружку насыпать или кислоты плеснуть. Но саботаж можно где угодно устраивать.

PereslavlFoto

27.10.2022 13:48

MaxMxMz

27.10.2022 14:17Как данные масла реагируют с лаком (клеем если сердечник склеен из частей) дросселей, трансформаторов, всякими пластиками которые используются как элементы креплений, изоляторы итд на протяжении длительного времени. Обычно производители не всегда указывают что поменяли поставщика подобных компонентов, как бороться с этим?

Некоторые жидкости обладают высокой текучестью и способностью протекать через любые щели и за счет капилярного эффекта способны достаточно успешно течь вверх, в итоге оказываясь на полу.

Отмывать такую жижу нужно в ультразвуковой ванне, ужасно скользкая и трудно отмываемая - или что-то новое придумали?

edo1h

27.10.2022 19:28В любом случае придется использовать теплообменники гораздо более производительные и дорогие, чем в системах с воздушным охлаждением

подождите, почему более производительные? надо сравнивать на серверах равной мощности, тут тепловыделение серверов осталось тем же, сами иммерсионные системы, думаю, имеют более высокий кпд, чем классические кондиционеры.

и стоимость системы охлаждения на ватт мощности подключенного оборудования, думаю будет примерно той же, что и в классических датацентрах, если не ниже.

Поскольку все серверы архитектурно приспособлены не под иммерсионное охлаждение, а под воздушное

ну если у этой технологии есть будущее, появятся сервера под иммерсионное охлаждение.

и стойки тоже.

(тут частично ответ и на предыдущий пункт: для снижения цен нужно массовое внедрение технологии)Кроме того, некоторые виды жестких дисков

ну и фиг с ними )

вынести все hdd в отдельные полки (которые разместить вне иммерсионной зоны датацентра) и отдавать хоть по iscsi.Горячая замена и обслуживание

вообще не проблема, какой там afr у серверов без hdd?

тут эксперименты идут с вовсе необслуживаемыми подводными датацентрами, и статистика отказов всех устраивает (и она оказалась лучше, чем в традиционных датацентрах).

https://habr.com/ru/post/648869/Да, за счет эффективного теплоотведения снижается нагрев приборов, и серверы служат дольше. Однако даже в традиционных, “воздушных” ЦОДах давно действует правило “Устареет быстрее, чем сломается”

не кажется, что последние два пункта у вас противоречат друг другу?

чем меньше отказов, тем реже нужна будет та самая горячая (или не очень) замена, тем меньше простоев и т.п., вплоть до отсутствия постоянного персонала в дц (напомню, подводные датацентры рассчитаны на несколько лет работы вовсе без обслуживания).

в качестве одной из причин низкого числа отказов в подводном датацентре называется инертная атмосфера (точне безкислородная), вполне возможно, что этот фактор будет действовать и для иммерсионного охлаждения.Экономия пространства. Сверхплотное размещение серверов, которое становится возможным с использованием иммерсионного охлаждения, должно иметь под собой какое-то объективное обоснование

эээ… смотрим цены на размещение стойки во «вкусных» датацентрах, это разве не объективное обоснование?

вообще чуть ли не весь прогресс в серверном оборудовании идёт под девизом «большедуривычислительной мощности/iops/etc на стойку».

little-brother

27.10.2022 21:46вообще чуть ли не весь прогресс в серверном оборудовании идёт под девизом «больше

дуривычислительной мощности/iops/etc на стойку»Я думал с блейдами уже прекращают развлекаться. Для воздуха ограничение 10-15 кВт/шкаф, а для иммерсионки - 30-40 кВт и ничего, работает.

Если технически все решается как-то, то вот с "подготовленным" оборудованием для иммерсионки пока как-то не очень + вопросы гарантии не понятно как решать.

freelook00

28.10.2022 07:51На youtube был ролик, где хозяин загородного дома интегрировал майнинговое оборудование в отопление дома. Он, как раз, ASIC-и в иммерсионную жидкость погрузил и через теплообменник забирал в систему отопления. То, что намайнилось, тратил на оплату электроэнергии.

Соглашусь, что для привычной схемы применения серверов, такое охлаждение мало приспособлено. Но, не зря же microsoft экспериментирует с подводным ЦОД в герметичном контейнере?

Вполне возможно, сделать вместо вертикальной стойки горизонтальную ёмкость, а сервер спроектировать так, чтобы разъёмы были сверху, для удобства коммутации. Размещать ёмкости на стеллажах (как на складе), а полученное тепло, через тепловой насос, отправлять на полезные нужды.

13werwolf13

28.10.2022 08:23чтобы разъёмы были сверху, для удобства коммутации.

в общем-то ничто не мешает сделать этакий переходник к котрому подключить все необходимые разъёмы с материнки с одной стороны, а вторую его сторону с разъёмами доступа для ручной работы вынести над жидкостью. никаких проблем.

Fragster

Почему "утилизация тепла" это недостаток? при грамотном выборе места для датацентра можно продавать услуги котельной.

little-brother

Очень маленький перепад температур, выхлоп с него никакой, вот и утилизируют.

Fragster

40 градусов - это уже кое что (например предподогрев горячей воды, ведь на выходе там должно быть не более 85-90 градусов, у нас же может быть уже 60-70). Особенно учитывая суммарную мощность.

edo1h

а кто мешает поставить тепловой насос и увеличить перепад?

хотя идея с предподогревом воды мне тоже нравится.

piroman

теплые полы только греть ( или теплицы с бассейнами, но это надо на этапе проектирования, где нибудь рядом с сх земелькой)