На самом деле, большая доля этих правил не влияет на среду исполнения кода, который вы пишете. Подобные правила невозможно оценить объективно, да это и необязательно, ведь на этом этапе они достаточно произвольны. Однако есть правила «чистого» кода, на которые делают особый упор — это правила, которые можно измерить объективно, поскольку они влияют на поведение кода в среде исполнения.

Если посмотреть на список правил «чистого» кода и вытащить из него правила, которые действительно влияют на структуру кода, то мы получим следующее:

- Отдавайте предпочтение полиморфизму, а не «if/else» и «switch»

- Код не должен знать о внутреннем устройстве объектов, с которыми он работает

- Функции должны быть маленькими

- Каждая функция должна выполнять одну задачу

- Принцип «DRY» — Don’t Repeat Yourself («не повторяйся»)

Эти правила достаточно чётко формулируют то, как должен создаваться конкретный фрагмент кода, чтобы быть «чистым». Но я задам такой вопрос: если мы создадим фрагмент кода, соответствующий этим правилам, какова будет его производительность?

Чтобы создать наиболее предпочтительный пример для реализации чего-то на «чистом» коде, я воспользовался готовыми примерами кода, содержащимися в литературе о «чистом» коде. Таким образом, мне не придётся ничего придумывать, я просто оценю правила защитников «чистого» кода при помощи тех примеров кода, которыми они иллюстрируют эти правила.

В примерах «чистого кода» часто встречаются такие:

<code>/* ========================================================================

LISTING 22

======================================================================== */

class shape_base

{

public:

shape_base() {}

virtual f32 Area() = 0;

};

class square : public shape_base

{

public:

square(f32 SideInit) : Side(SideInit) {}

virtual f32 Area() {return Side*Side;}

private:

f32 Side;

};

class rectangle : public shape_base

{

public:

rectangle(f32 WidthInit, f32 HeightInit) : Width(WidthInit), Height(HeightInit) {}

virtual f32 Area() {return Width*Height;}

private:

f32 Width, Height;

};

class triangle : public shape_base

{

public:

triangle(f32 BaseInit, f32 HeightInit) : Base(BaseInit), Height(HeightInit) {}

virtual f32 Area() {return 0.5f*Base*Height;}

private:

f32 Base, Height;

};

class circle : public shape_base

{

public:

circle(f32 RadiusInit) : Radius(RadiusInit) {}

virtual f32 Area() {return Pi32*Radius*Radius;}

private:

f32 Radius;

};Это базовый класс для фигур, из которого порождается несколько конкретных фигур: круг, треугольник, прямоугольник, квадрат. Далее идёт виртуальная функция, вычисляющая площадь.

Как и требуют правила, мы отдаём предпочтение полиморфизму. Каждая наша функция выполняет только одну задачу. Они компактны. Всё это отлично. Итак, мы получили «чистую» иерархию классов, каждый порождённый класс знает, как вычислять свою площадь и хранит данные, требуемые для вычисления этой площади.

Если мы представим, что используем эту иерархию для выполнения какой-то задачи, допустим, для нахождения общей площади передаваемой серии фигур, то ожидаем увидеть что-то подобное:

/* ========================================================================

LISTING 23

======================================================================== */

f32 TotalAreaVTBL(u32 ShapeCount, shape_base **Shapes)

{

f32 Accum = 0.0f;

for(u32 ShapeIndex = 0; ShapeIndex < ShapeCount; ++ShapeIndex)

{

Accum += Shapes[ShapeIndex]->Area();

}

return Accum;

}Я не использовал здесь итератор, потому что в правилах не говорится ничего о том, что нам нужно использовать итераторы. Поэтому я решил, что не буду давать «чистому» коду кредит доверия и не стану добавлять никакого абстрагированного итератора, который может сбить с толку компилятор и привести к снижению производительности.

Вы также можете заметить, что это цикл по массиву указателей. Это прямое последствие использования иерархии классов: мы понятия не имеем, какой размер в памяти может занимать каждая из этих фигур. Так что если мы не собираемся добавлять вызов ещё одной виртуальной функции для получения размера данных каждой фигуры и использовать для их обхода какую-то процедуру пропуска переменных, нам понадобятся указатели, чтобы выяснять, где начинается каждая фигура.

Поскольку это накопление, существует циклически порождаемая зависимость, способная замедлить цикл. Так как порядок накопления может произвольно меняться, я для безопасности также написал разворачиваемую вручную версию:

/* ========================================================================

LISTING 24

======================================================================== */

f32 TotalAreaVTBL4(u32 ShapeCount, shape_base **Shapes)

{

f32 Accum0 = 0.0f;

f32 Accum1 = 0.0f;

f32 Accum2 = 0.0f;

f32 Accum3 = 0.0f;

u32 Count = ShapeCount/4;

while(Count--)

{

Accum0 += Shapes[0]->Area();

Accum1 += Shapes[1]->Area();

Accum2 += Shapes[2]->Area();

Accum3 += Shapes[3]->Area();

Shapes += 4;

}

f32 Result = (Accum0 + Accum1 + Accum2 + Accum3);

return Result;

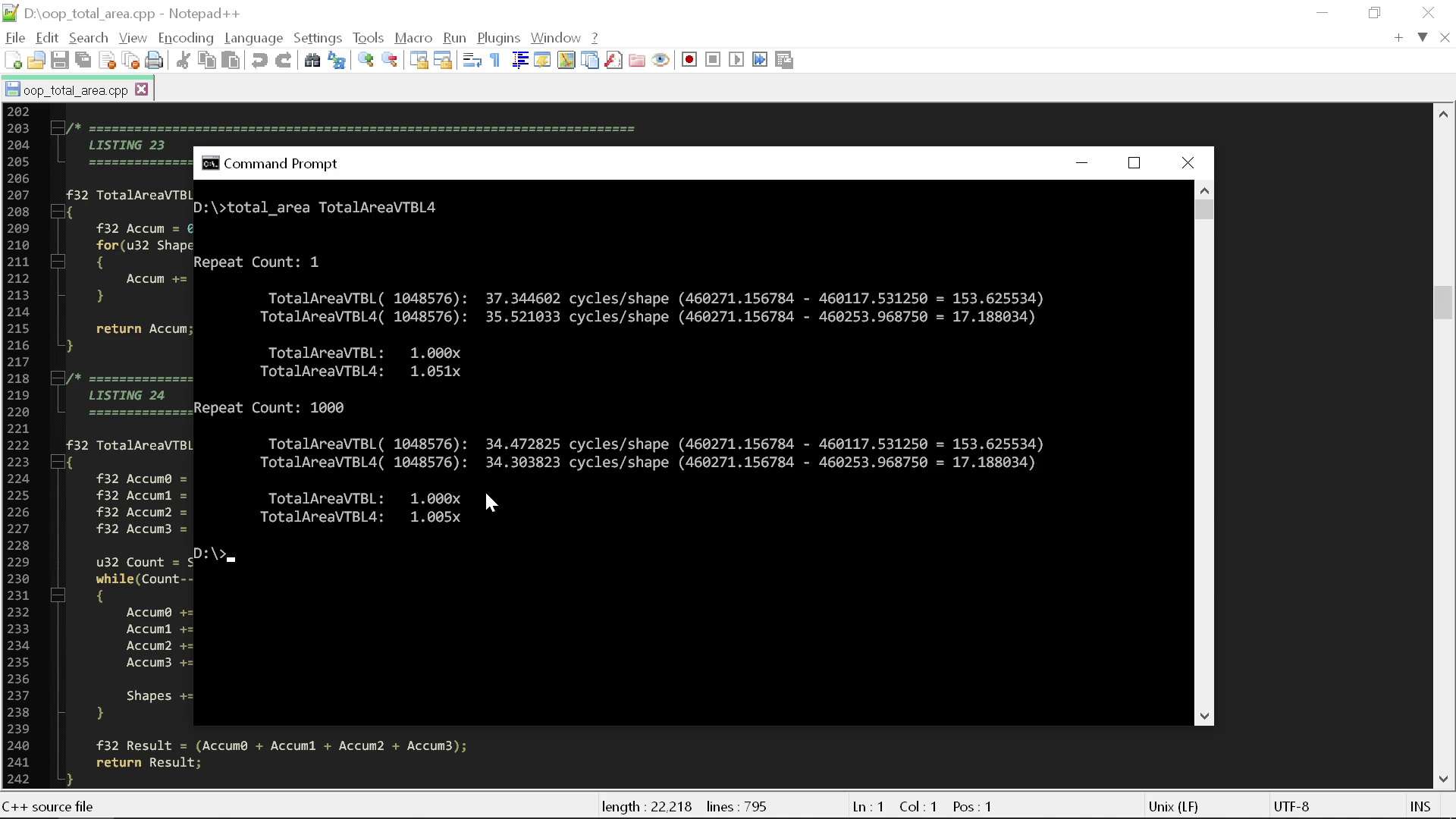

}Если запустить эти две процедуры в простой тестовой обвязке, то можно приблизительно замерить общее количество тактов на фигуру, требуемое для выполнения этой операции:

Обвязка хронометрирует код двумя способами. Первый — запустить код только один раз, чтобы показать, что происходит в произвольном «холодном» состоянии — данные должны быть в L3, однако L2 и L1 сброшены, а алгоритм предсказания ветвления ещё не «практиковался» на этом цикле.

Второй способ — многократное выполнение кода, чтобы посмотреть. что происходит, когда кэш и алгоритм предсказания ветвления работают наиболее удобным для цикла образом. Стоит заметить, что оба способа не являются хардкорными измерениями, поскольку, как вы видите, различия настолько велики, что нам не нужно применять какие-то серьёзные инструменты анализа.

Из результата мы видим, что между двумя процедурами нет особой разницы. Для выполнения вычисления площади «чистым» кодом требуется примерно 35 тактов. Если сильно повезёт, это количество иногда снижается до 34.

Итак, 35 тактов — это то значение, которое стоит ожидать получить при следовании всем правилам. Но что же произойдёт, если мы нарушим лишь первое правило? Что, если вместо применения здесь полиморфизма мы просто используем оператор switch? [Лично я не думаю, что оператор switch обязательно менее полиморфический, чем vtable. Это просто две разные реализации одного принципа. Однако правила «чистого» кода приказывают отдавать предпочтение полиморфизму вместо операторов switch, поэтому я использую здесь их терминологию, означающую, что они чётко считают, что оператор switch не полиморфический.]

Ниже я записал точно такой же код, однако вместо использования иерархии классов (а следовательно, vtable в среде исполнения) я написал его при помощи перечисления и типа фигуры, который упрощает всё до одной структуры:

/* ========================================================================

LISTING 25

======================================================================== */

enum shape_type : u32

{

Shape_Square,

Shape_Rectangle,

Shape_Triangle,

Shape_Circle,

Shape_Count,

};

struct shape_union

{

shape_type Type;

f32 Width;

f32 Height;

};

f32 GetAreaSwitch(shape_union Shape)

{

f32 Result = 0.0f;

switch(Shape.Type)

{

case Shape_Square: {Result = Shape.Width*Shape.Width;} break;

case Shape_Rectangle: {Result = Shape.Width*Shape.Height;} break;

case Shape_Triangle: {Result = 0.5f*Shape.Width*Shape.Height;} break;

case Shape_Circle: {Result = Pi32*Shape.Width*Shape.Width;} break;

case Shape_Count: {} break;

}

return Result;

}Это «олдскульный» способ, которым решались бы подобные задачи до появления «чистого» кода.

Обратите внимание, что поскольку у нас больше нет специальных типов данных для каждого варианта фигуры, то если тип не имеет одного из значений (например, «height»), он просто его не использует.

Теперь вместо получения площади от вызова виртуальной функции пользователь этой структуры получает её от функции с оператором switch: именно этого правила «чистого» кода никогда не рекомендуют делать. Несмотря на это, вы заметите, что код, несмотря на гораздо большую краткость, по сути, остался тем же. Каждый case оператора switch — это просто тот же код, что и в соответствующей виртуальной функции в иерархии классов.

Что касается самих циклов суммирования, то можно увидеть, что они практически идентичны «чистой» версии:

/* ========================================================================

LISTING 26

======================================================================== */

f32 TotalAreaSwitch(u32 ShapeCount, shape_union *Shapes)

{

f32 Accum = 0.0f;

for(u32 ShapeIndex = 0; ShapeIndex < ShapeCount; ++ShapeIndex)

{

Accum += GetAreaSwitch(Shapes[ShapeIndex]);

}

return Accum;

}

f32 TotalAreaSwitch4(u32 ShapeCount, shape_union *Shapes)

{

f32 Accum0 = 0.0f;

f32 Accum1 = 0.0f;

f32 Accum2 = 0.0f;

f32 Accum3 = 0.0f;

ShapeCount /= 4;

while(ShapeCount--)

{

Accum0 += GetAreaSwitch(Shapes[0]);

Accum1 += GetAreaSwitch(Shapes[1]);

Accum2 += GetAreaSwitch(Shapes[2]);

Accum3 += GetAreaSwitch(Shapes[3]);

Shapes += 4;

}

f32 Result = (Accum0 + Accum1 + Accum2 + Accum3);

return Result;

}Единственное отличие заключается в том, что вместо вызова функции-члена для получения площади мы вызываем обычную функцию, вот и всё.

Однако вы сразу можете увидеть немедленную выгоду от использования упрощённой структуры по сравнению с применением иерархии классов: фигуры могут просто находиться в массиве, без необходимости указателей. Косвенных действий нет, потому что мы сделали все фигуры одного размера.

Плюс мы получаем выигрыш ещё и в том, что теперь компилятор может точно видеть, что происходит в цикле, потому что он может просто смотреть на функцию GetAreaSwitch и видеть весь путь выполнения кода. Ему не нужно предполагать, что нечто может произойти в какой-то виртуализированной функции вычисления площади, известной только в среде исполнения.

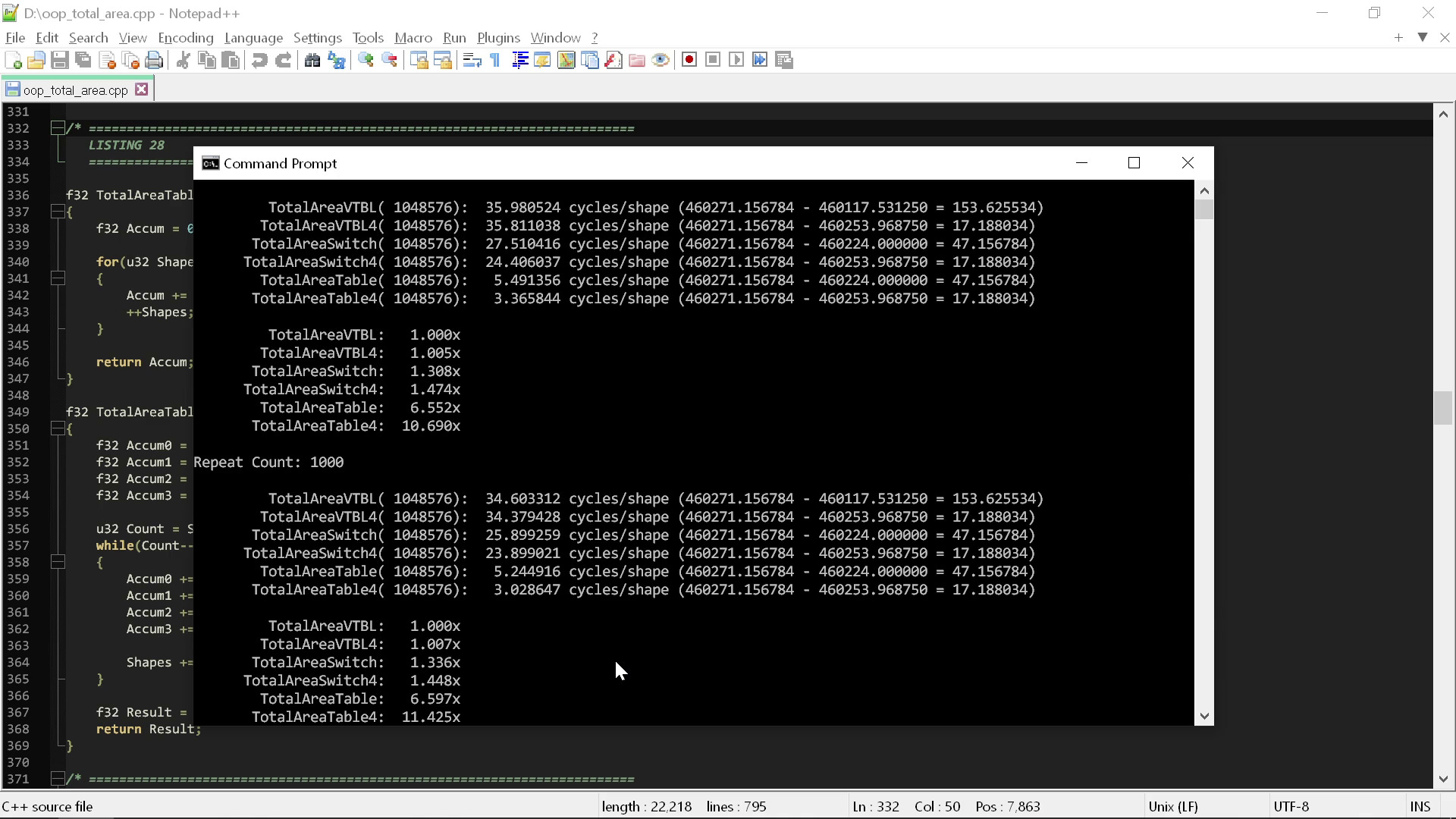

Что же может компилятор сделать для нас благодаря всем этим преимуществам? Если я запущу теперь все четыре фрагмента, то получу такие результаты:

При изучении результатов мы можем заметить кое-что довольно примечательное: всего одно изменение — старомодный стиль кодинга вместо стиля «чистого» кода — дало нам мгновенное увеличение производительности в полтора раза. Это полуторакратное улучшение мы получаем без затрат, нам ничего не пришлось делать, кроме как удалить излишний код, необходимый для применения полиморфизма C++.

То есть нарушив первое правило чистого кода, являющееся одним из его основным столпов, мы способны снизить затраты с 35 до 24 тактов на фигуру, и это подразумевает, что следующий этому правилу код в полтора раза медленнее того, который ему не следует. Если сравнивать на уровне «железа», то требования к производительности снижаются с iPhone 14 Pro Max до iPhone 11 Pro Max. Три-четыре года эволюции оборудования уничтожены, потому что кто-то сказал использовать полиморфизм вместо операторов switch.

Но мы только начали.

Что, если мы нарушим и другие правила? Что, если мы нарушим второе правило — «запрет на знания о внутреннем устройстве»? Что, если наши функции могут использовать знание того, с чем они работают, чтобы повысить свою эффективность?

Если снова взглянуть на оператор switch получения площади, то можно заметить, что все вычисления площадей схожи:

case Shape_Square: {Result = Shape.Width*Shape.Width;} break;

case Shape_Rectangle: {Result = Shape.Width*Shape.Height;} break;

case Shape_Triangle: {Result = 0.5f*Shape.Width*Shape.Height;} break;

case Shape_Circle: {Result = Pi32*Shape.Width*Shape.Width;} break;Во всех них или ширина умножается на высоту, или ширина на ширину, иногда с коэффициентом наподобие пи, после чего они делятся пополам в случае треугольника или умножаются на пи в случае круга, и так далее.

Это одна из причин, по которым я считаю операторы switch очень удобными (в отличие от защитников «чистого» кода)! Они позволяют очень легко разглядеть паттерн. Если код упорядочен по операции, а не по типу, очень легко изучать его и выявлять общие паттерны. И наоборот: если вы взглянете на версию с классами, то, вероятно, никогда не заметите подобный паттерн, не только потому, что вам помешает большое количество бойлерплейта, но и потому, что защитники «чистого» кода рекомендуют помещать каждый класс в отдельный файл, ещё больше снижая вероятность того, что вы заметите что-то подобное.

Поэтому архитектурно я в общем случае не согласен с иерархиями классов, но дело не только в этом. Единственное, что я хочу сейчас подчеркнуть — мы можем сильно упростить оператор switch, заметив паттерн.

И помните: я не специально выбирал такой пример! Этот пример используют для наглядности сами защитники чистого кода. Поэтому я не выбрал намеренно пример, в котором можно выявить паттерн — просто очень вероятно, что вы сможете это сделать, потому что большинство вещей схожего типа имеют схожую алгоритмическую структуру, поэтому, как и ожидалось, это здесь произошло.

Чтобы использовать этот паттерн, мы можем создать простую таблицу, сообщающую нам, какой коэффициент нужно использовать для каждого типа. Если для типов с одним параметром, например, для круга и квадрата, мы дублируем ширину в высоту, то можно написать существенно более простую функцию для площади:

/* ========================================================================

LISTING 27

======================================================================== */

f32 const CTable[Shape_Count] = {1.0f, 1.0f, 0.5f, Pi32};

f32 GetAreaUnion(shape_union Shape)

{

f32 Result = CTable[Shape.Type]*Shape.Width*Shape.Height;

return Result;

}Два цикла суммирования в этой версии полностью одинаковы, их не нужно изменять, они просто вызывают GetAreaUnion вместо GetAreaSwitch, а в остальном идентичны.

Посмотрим, что произойдёт при запуске этой новой версии и сравнении с предыдущими циклами:

Здесь мы воспользовались тем, что знаем о самих типах, с которыми работаем, по сути, переключившись с мышления на основе типов на мышление на основе функции, получив огромный рост скорости. Мы сделали переход от оператора switch, ускорявшего работу всего в полтора раза, на версию с таблицей, которая в десять или более раз быстрее при решении точно такой же задачи.

И чтобы добиться этого, нам не понадобилось ничего, кроме как одна операция поиска в таблице и одна строка кода! Это не только намного быстрее, но и гораздо проще семантически. Меньше токенов, меньше операций, меньше строк кода.

То есть вместо того, чтобы требовать обязательной неосведомлённости операции о внутреннем устройстве данных и связав модель данных с нужной нам операцией, мы снизили затраты до 3,0-3,5 тактов на серию фигур. Мы получили десятикратное повышение скорости по сравнению с «чистой» версией кода, следующей первым двум правилам.

Десятикратное повышение производительности настолько существенно, что его невозможно даже сравнить на аналогии с iPhone, потому что в бенчмарках iPhone такой разницы уже нет. Если мы опустимся до iPhone 6 (самого старого телефона, встречающегося в современных бенчмарках), то он всего в три раза медленнее iPhone 14 Pro Max. То есть чтобы описать разницу, мы даже не можем больше использовать телефоны.

Если взглянуть на производительность однопоточного десктопного компьютера, то десятикратное повышение скорости — это переход от среднего современного CPU mark до среднего CPU mark аж 2010 года! Первые два правила концепции «чистого кода» уничтожают 12 лет эволюции оборудования.

Но как бы это ни шокировало, мы протестировали это лишь на одной простой операции. Мы практически не пользовались правилами «функции должны быть маленькими» и «функции должны выполнять только одну операцию», потому что работаем с очень простой задачей. А что, если мы добавим ещё один аспект к нашей задаче, чтобы более можно было более непосредственно следовать этим правилам?

Ниже я написал точно такую же иерархию, что и раньше, но на этот раз добавил ещё одну виртуальную функцию, сообщающую, сколько углов у каждой из фигур:

/* ========================================================================

LISTING 32

======================================================================== */

class shape_base

{

public:

shape_base() {}

virtual f32 Area() = 0;

virtual u32 CornerCount() = 0;

};

class square : public shape_base

{

public:

square(f32 SideInit) : Side(SideInit) {}

virtual f32 Area() {return Side*Side;}

virtual u32 CornerCount() {return 4;}

private:

f32 Side;

};

class rectangle : public shape_base

{

public:

rectangle(f32 WidthInit, f32 HeightInit) : Width(WidthInit), Height(HeightInit) {}

virtual f32 Area() {return Width*Height;}

virtual u32 CornerCount() {return 4;}

private:

f32 Width, Height;

};

class triangle : public shape_base

{

public:

triangle(f32 BaseInit, f32 HeightInit) : Base(BaseInit), Height(HeightInit) {}

virtual f32 Area() {return 0.5f*Base*Height;}

virtual u32 CornerCount() {return 3;}

private:

f32 Base, Height;

};

class circle : public shape_base

{

public:

circle(f32 RadiusInit) : Radius(RadiusInit) {}

virtual f32 Area() {return Pi32*Radius*Radius;}

virtual u32 CornerCount() {return 0;}

private:

f32 Radius;

};У прямоугольника четыре угла, у треугольника — три, у круга их нет, и так далее. Я изменю определение задачи: вместо вычисления суммы площадей серии фигур мы будем вычислять сумму взвешенных по углам площадей, которую я определю как единицу, поделённую на единицу плюс количество углов.

Как и в случае с суммированием площадей, для этого нет никаких причин, я просто пытаюсь работать в рамках примера. Я добавил простейшее, что смог придумать, а затем добавил к этому очень простую математику.

Чтобы изменить «чистый» цикл суммирования, мы добавляем необходимую математику и дополнительный вызов виртуальной функции:

f32 CornerAreaVTBL(u32 ShapeCount, shape_base **Shapes)

{

f32 Accum = 0.0f;

for(u32 ShapeIndex = 0; ShapeIndex < ShapeCount; ++ShapeIndex)

{

Accum += (1.0f / (1.0f + (f32)Shapes[ShapeIndex]->CornerCount())) * Shapes[ShapeIndex]->Area();

}

return Accum;

}

f32 CornerAreaVTBL4(u32 ShapeCount, shape_base **Shapes)

{

f32 Accum0 = 0.0f;

f32 Accum1 = 0.0f;

f32 Accum2 = 0.0f;

f32 Accum3 = 0.0f;

u32 Count = ShapeCount/4;

while(Count--)

{

Accum0 += (1.0f / (1.0f + (f32)Shapes[0]->CornerCount())) * Shapes[0]->Area();

Accum1 += (1.0f / (1.0f + (f32)Shapes[1]->CornerCount())) * Shapes[1]->Area();

Accum2 += (1.0f / (1.0f + (f32)Shapes[2]->CornerCount())) * Shapes[2]->Area();

Accum3 += (1.0f / (1.0f + (f32)Shapes[3]->CornerCount())) * Shapes[3]->Area();

Shapes += 4;

}

f32 Result = (Accum0 + Accum1 + Accum2 + Accum3);

return Result;

}Я мог бы сказать, что это нужно засунуть в ещё одну функцию, добавив ещё один слой косвенных действий. Но опять таки, чтобы не давать «чистому» коду кредит доверия, я оставлю это в явном виде.

Чтобы изменить версию с оператором switch, нужно, по сути, внести те же изменения. Сначала мы добавим ещё один оператор switch для количества углов с case, в точности отражающими версию с иерархией:

/* ========================================================================

LISTING 34

======================================================================== */

u32 GetCornerCountSwitch(shape_type Type)

{

u32 Result = 0;

switch(Type)

{

case Shape_Square: {Result = 4;} break;

case Shape_Rectangle: {Result = 4;} break;

case Shape_Triangle: {Result = 3;} break;

case Shape_Circle: {Result = 0;} break;

case Shape_Count: {} break;

}

return Result;

}Затем мы вычисляем точно так же, как в версии с иерархией:

/* ========================================================================

LISTING 35

======================================================================== */

f32 CornerAreaSwitch(u32 ShapeCount, shape_union *Shapes)

{

f32 Accum = 0.0f;

for(u32 ShapeIndex = 0; ShapeIndex < ShapeCount; ++ShapeIndex)

{

Accum += (1.0f / (1.0f + (f32)GetCornerCountSwitch(Shapes[ShapeIndex].Type))) * GetAreaSwitch(Shapes[ShapeIndex]);

}

return Accum;

}

f32 CornerAreaSwitch4(u32 ShapeCount, shape_union *Shapes)

{

f32 Accum0 = 0.0f;

f32 Accum1 = 0.0f;

f32 Accum2 = 0.0f;

f32 Accum3 = 0.0f;

ShapeCount /= 4;

while(ShapeCount--)

{

Accum0 += (1.0f / (1.0f + (f32)GetCornerCountSwitch(Shapes[0].Type))) * GetAreaSwitch(Shapes[0]);

Accum1 += (1.0f / (1.0f + (f32)GetCornerCountSwitch(Shapes[1].Type))) * GetAreaSwitch(Shapes[1]);

Accum2 += (1.0f / (1.0f + (f32)GetCornerCountSwitch(Shapes[2].Type))) * GetAreaSwitch(Shapes[2]);

Accum3 += (1.0f / (1.0f + (f32)GetCornerCountSwitch(Shapes[3].Type))) * GetAreaSwitch(Shapes[3]);

Shapes += 4;

}

f32 Result = (Accum0 + Accum1 + Accum2 + Accum3);

return Result;

}Как и в версии с общей суммой площадей, код в реализации с иерархией классов и реализации со switch выглядит почти идентично. Единственная разница заключается в вызове виртуальной функции или в выполнении оператора switch.

Перейдя к версии с таблицей, мы сможем увидеть, как здорово смешивать операции и данные! В отличие от предыдущих версий, единственное, что здесь нужно изменить — это значения в таблице! Нам необязательно получать вспомогательную информацию о фигуре — можно объединить количество углов и коэффициент площади непосредственно в таблицу, а код во всём остальном остаётся совершенно таким же:

/* ========================================================================

LISTING 36

======================================================================== */

f32 const CTable[Shape_Count] = {1.0f / (1.0f + 4.0f), 1.0f / (1.0f + 4.0f), 0.5f / (1.0f + 3.0f), Pi32};

f32 GetCornerAreaUnion(shape_union Shape)

{

f32 Result = CTable[Shape.Type]*Shape.Width*Shape.Height;

return Result;

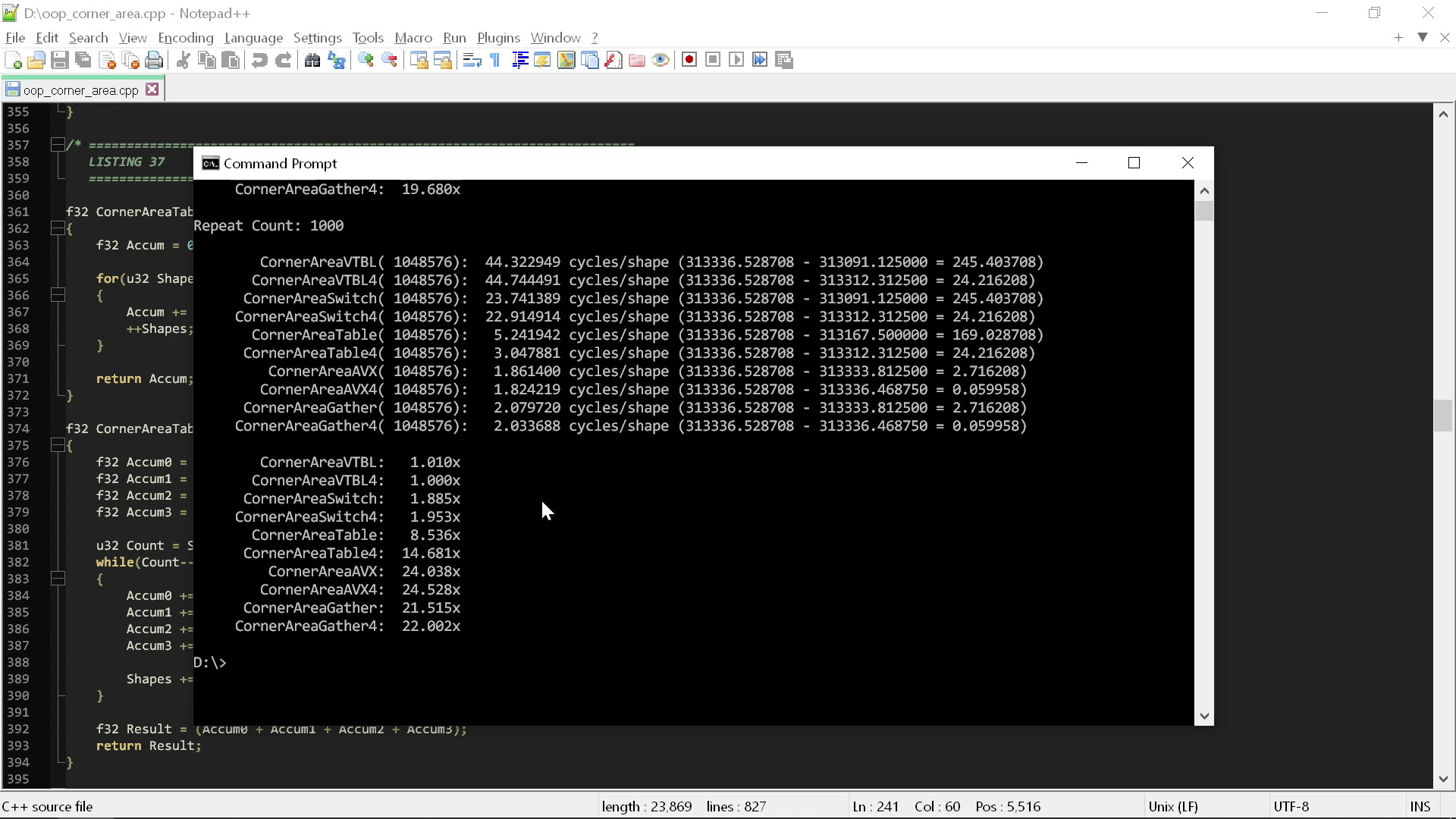

}Если мы запустим эти функции «площадей с углами», то сможем понять, как на их производительность повлияло добавление второго свойства фигур:

Как видите, эти результаты ещё хуже для «чистого» кода. Версия с оператором switch, которая раньше была всего лишь в полтора раза быстрее, теперь быстрее почти в два раза, а версия с таблицей поиска почти в пятнадцать раз быстрее.

Это демонстрирует ещё более глубокую «чистого» кода: чем больше усложняется задача, тем больше эти идеи вредят производительности. При попытке масштабировать «чистые» техники на реальные объекты со множеством свойств подобные вездесущие проблемы падения производительности будут встречаться в коде повсюду.

Чем больше вы используете методологию «чистого» кода, тем меньше компилятор способен понять, что вы делаете. Всё разделено на отдельные программные единицы, спрятано за вызовы виртуальных функций и так далее. Каким бы умным ни был компилятор, он практически ничего не может сделать с подобным кодом.

Хуже того, с таким кодом мало что можете сделать и вы! Как я показывал выше, простые действия наподобие извлечения значений из таблицы и устранение операторов switch реализовать просто, если архитектура вашей кодовой базы основана на её функциях. Если она основана на типах, это сделать гораздо сложнее, а может, даже невозможно без переписывания большого объёма кода.

Итак, мы перескочили с десятикратной разницы в скорости на пятнадцатикратную, просто добавив фигурам ещё одно свойство. Это аналогично возврату «железа» 2023 года в 2008 год! Вместо уничтожения 12 лет мы уничтожаем 14 лет, просто добавив один новый параметр в определение задачи.

Это ужасно само по себе. Но можно заметить, что я ещё не упомянул оптимизацию! Кроме того, чтобы гарантировать, что это не циклически порождаемая зависимость, ради тестирования я ничего не оптимизировал!

Теперь давайте посмотрим, что будет, если пропустить эти процедуру через слегка оптимизированную AVX-версию тех же вычислений:

Разница в скорости составляет порядка 20-25 раз, и, разумеется, ни в какой части оптимизированного AVX кода не используется ничего даже отдалённо напоминающего принципы «чистого» кода.

То есть мы выбрасываем четыре правила. А как насчёт пятого?

Откровенно говоря, принцип «не повторяйся» вполне приемлем. Как видно из кода, мы не особо повторялись. Возможно, повторялись, если считать четыре развёрнутые версии сложения, но это нужно было лишь для демонстрации. На самом деле, если вы не проводите подобные измерения, то вам и не понадобятся обе такие процедуры.

Если «DRY» означает нечто более строгое, например, «не создавай две отдельные таблицы, в которых кодируются версии одинаковых коэффициентов», то иногда я не согласился бы с этим, потому что для достаточной производительности нам может понадобиться пойти на это. Но если в общем случае «DRY» просто означает «не пиши один и тот же код дважды», то это кажется разумным советом.

И самое важное то, что нам не нужно нарушать это правило, чтобы писать код с достаточной производительностью.

То есть я утверждаю, что из пяти принципов чистого кода, влияющих на структуру кода, учитывать нужно один, а четыре совершенно точно не нужно. Почему? Потому что, как вы могли заметить, ПО сегодня чрезвычайно медленное. Оно работает крайне плохо по сравнению с тем, как могло бы быстрое современное оборудование выполнять наше ПО.

Если вы спросите, почему программное обеспечение медленное, ответов может быть множество. И то, какой из них самый важный, зависит от конкретной среды разработки и методологии кодинга.

Но для большого сегмента компьютерной индустрии ответ на вопрос «почему ПО медленное» будет таким: «из-за „чистого“ кода». Почти все идеи, лежащие в основе методологии «чистого» кода, ужасно влияют на производительность, и их нельзя использовать.

Правила «чистого» кода были разработаны, потому что кто-то подумал, что они позволят создавать более удобные в поддержке кодовые базы. Даже если бы это так, вы должны задаться вопросом: «А какой ценой?»

Нельзя просто отказаться от десятка или больше лет эволюции производительности оборудования, только чтобы немного упростить жизнь программистов. Наша работа заключается в написании программ, хорошо работающих на оборудовании, которое у нас есть. Если из-за этих правил производительность ПО такая плохая, то они просто неприемлемы.

Мы всё равно можем попытаться выработать эмпирические правила, помогающие в упорядочивании, поддержке и читаемости кода. Это хорошие цели! Но подобные правила для этого не подходят. Их надо перестать повторять, или дополнять большой звёздочкой и сноской «и ваш код будет работать в пятнадцать или более раз хуже».

Комментарии (317)

panzerfaust

13.04.2023 11:35+156В примерах «чистого кода» часто встречаются такие

Я надеюсь, вы понимаете, что занимаетесь софистикой. Если брать какой-то удобный для себя синтетический кусочек кода и потом прожаривать его, то можно доказать вообще любой тезис. И что чистый код вреден, и что чистый код полезен. Да хоть, что кодить китайскими иероглифами быстрее и понятнее, чем латиницей.

Реальный разговор пойдет, когда вы отрефакторите реальный сервис на 100 килострок из своего прода в соответствии с вашим мировоззрением, а потом предъявите не только метрики скорости, но и такие "незначительные" метрики как динамику багов, время на исследование одного бага, время от todo до ready и т.д.

VladimirFarshatov

13.04.2023 11:35+3Был опыт, рефакторил. Товарный агрегатор на Zend 1.8:

было: 32 мегабайта на запрос, 8-10 секунд отклик. БД товаров около 1млн записей в основной товарной таблице. Просто это было "давно"..

стало: 2.5 мегабайта на запрос, 127 запросов в секунду. Железо то же самое, БД стала побольше за время рефакторинга. Плюсом попутно сайт дополнялся новыми фишками.

panzerfaust

13.04.2023 11:35+26Чего именно опыт-то? Превращения структурированного кода в неструктурированный и именно за счет этого драматической прибавки перфоманса? Я тоже однажды джуновский селект с 16 джойнами превратил в селект с 3 джойнами и соответствующим кратным бустом отклика. Только при чем здесь чистый код?

VladimirFarshatov

13.04.2023 11:35+7Опыт превращения кровавого энтерпрайза в "чистый код", с удалением разного рода Фабрик, провайдеров, хелперов провадеров и прочих прокладок. О скоростях выборки из БД речи не было, там все было почти чисто..

Druj

13.04.2023 11:35+42Дайте угадаю, когда пришло время добавлять новый функционал, проект дропнули со словами: "Мы не хотим разбираться в этом неподдерживаемом говне"

VladimirFarshatov

13.04.2023 11:35+1Насколько помню, там закрылась контора, не пережив крах печатных СМИ ..

panzerfaust

13.04.2023 11:35+17Опять же: софистика. Все страшные слова типа "фабрик" и "провайдеров" это признаки ООП в первую очередь, а не чистого кода. Иногда крайне херового ООП с щепоткой карго-культа и "надо потому что надо". Чистый код тут не при чем, и более того, он не привязан к какой-то конкретной парадигме. Возможно,о нем думали, возможно нет - сейчас уже не установишь. Вы сами придумали этот тезис и сами побороли.

javalin

13.04.2023 11:35+2Фабрики, хелперы и провайдеры замедляли на 4 порядка запрос? Что-то с трудом верится, честно говоря.. Больше похоже на то, что была удалена часть функционала, который перестал использоваться, или же был добавлен "на всякий случай"..

VladimirFarshatov

13.04.2023 11:35Легко. Откажитесь от Active Record при выборке из 50+ таблиц сущностей, создаваемых через фабрику, которая принимает сервис получения данных в БД через хелпер отбраковки записи, который на каждой итерации цикла сортирует весь rowset заново и будет вам щастье. Обработка по сути тех же запросов, объем таскаемых данных из сервера БД может даже и вырасти.

Fen1kz

13.04.2023 11:35+10Ну вот так всегда. Приходит такой весь в белом пальто, говорит "щас я от всех провайдеров и фабрик избавлюсь", а по факту избавляется от AR на сложных запросах. (-_- )

Ну самому не стыдно так кликбейтить?

VladimirFarshatov

13.04.2023 11:35Избавлялся много от чего. Перечитайте, в т.ч. и от пересортировки набора, полученного из БД. Сколько времени занимает выборка 1000 строк и ее пересортировка на каждой операции перебора в цикле?

Стыдно должно быть Вам, уцепиться на AR и далее не читать. AR была далеко не единственной и может не самой главной проблемой.

panzerfaust

13.04.2023 11:35+2Так при чем тут чистый код, напомните пожалуйста? Кто из адвокатов чистого кода дает советы макаронить паттернами? Или там в авторах коммита лично Мартин с Фаулером?

WASD1

13.04.2023 11:35+6Я рефакторил библиотеку DSL-языка на 10 КLoC (это включая заголовки) на С \ CPP.

Заменил полиморфизм свичами (defaul проверял экзостив в рантайм), списки массивами (для этого надо иметь нерасширяемый тип в заголовке библиотеке).

Ускорение в типовом случае в 5-7 раз (после сборки с -lto).

Значимых багов (после вылавливания изначальных с помощью тестового генератора) найдено не было. И уж точно не помню багов как-либо связанных с переписыванием.

Понятность кода после разворота динамических вызовов в свичи повысилась.

klvov

13.04.2023 11:35+24Понятность кода после разворота динамических вызовов в свичи повысилась.

Хехе, я как-то пошутил, что, мол, полиморфизм - это такой архитектурный подход к построению программ, который нужен для того, чтобы чтения исходного кода было недостаточно для понимания, как ведет себя программа, и, чтобы это понять, надо ее обязательно запустить. Сейчас мне кажется, что в этой шутке оказалась занимающая непропорционально большое место доля правды.

PsyHaSTe

13.04.2023 11:35+2А "Чистый код" и "ООП" связаны положительно? Выпиливание динамического диспатча не делает код менее чистым, зачастую даже наоборот. Поэтому ваш пример никак не доказывает/опровергает упомянутые тезисы.

В современных языках можно иметь статический диспатч для открытого множества типов который часто будет даже лучше свитча, если бранчинг известен на топлевеле (ну или хотя бы на 1 левел выше текущего). А что может быть лучше бранча? Его отсутствие.

0xd34df00d

13.04.2023 11:35+12Подавляющее большинство людей понимает под чистым кодом абстрактные фабрики декораторов и прочий GoF. Одноименная книга, собственно, тоже про какую-то ООпорнографию на джаве. Поэтому, да, похоже, что положительно.

panzerfaust

13.04.2023 11:35+7А еще подавляющее большинство людей понимает под квантовой физикой смешные шутки про полудохлого кота.

А "одноименная книга", конечно, написана с примерами на джаве. Но про ООП там процентов 5 текста. А во всем остальном язык меняется хоть на си, хоть на ерланг без потери смысла.

0xd34df00d

13.04.2023 11:35+1А еще подавляющее большинство людей понимает под квантовой физикой смешные шутки про полудохлого кота.

Разница в том, что это подавляющее большинство по факту никак не влияет на развитие квантовой физики и не вносит в неё никакой вклад, а вот эти вот с GoF — вносят своё понимание чистого кода в кодовые базы.

А во всем остальном язык меняется хоть на си, хоть на ерланг без потери смысла.

Ну ерланг я не знаю, чтобы так утверждать, но те сколь угодно нетривиальные вещи, про которые Мартин говорит (не уровня «называйте переменные понятно» — это вообще для кого?), они в основном ориентированы на ООП.

Ndochp

13.04.2023 11:35Переносил на 1С. Без ООП отваливается процентов 50. Ну или эмулируется такими хаками, что чистым это не назвать.

gatoazul

13.04.2023 11:35+6Если в языке есть анонимные функции с замыканиями, половина этих самых паттернов становится вообще не нужны.

Поэтому ее правильное название "Костыли для Джавы и других языков с сомнительным ООП"*.

*Сомнительным, потому что для Смоллтолка все это тоже вряд ли нужно.

panzerfaust

13.04.2023 11:35половина этих самых паттернов становится вообще не нужны.

Если бы вы читали "Чистый код", то знали бы, что там не про паттерны.

Если в языке есть анонимные функции с замыканиями

То там ничуть не меньше возможностей наговнокодить, накостылить и невелосипедить чем в джаве. Говнокодит не язык и не парадигма, а человек.

0xd34df00d

13.04.2023 11:35+2То там ничуть не меньше возможностей наговнокодить, накостылить и невелосипедить чем в джаве. Говнокодит не язык и не парадигма, а человек.

Я как-то эмпирически заметил, что чем больше в языке возможностей для контроля эффектов, тем сложнее в нём говнокодить и тем проще писать нормально.

gatoazul

13.04.2023 11:35+1Мой комментарии относился к книге банды четырех.

Писать плохо можно, разумеется, на любом языке, включая Go *

*Язык, проектировавшийся по принципу деревянных колодок, дабы максимально ограничить программиста.

ermouth

13.04.2023 11:35Насчёт Эрланга я бы не горячился, там же вся фишка в паттерн-матчинге, и он что из case-оф, что из function clause-оф (это когда функция с одним и тем же именем несколько раз определена для разных масок аргументов) порождает практически идентичный байт-код для beam-машины.

То-есть по-любому будет небыстро )

neyronon

13.04.2023 11:35Разве "Чистый код" получил популярность не после книги дяди Боба? В этой его книге про GoF почти ничего нет, на сколько я помню. Паттерны в другой его книге по архитектурам рассматриваются.

PsyHaSTe

13.04.2023 11:35+1Ну я ровно потому и говорю. В таком случае написание чистого кода на всяких там хачкелях или растах получается невозможно — там же нет "ООП как джава". Что выглядит довольно "ООП-центристским" взглядом как ООП как уберпарадигму со снисходительным взглядом на остальных

WASD1

13.04.2023 11:35Вы наверное хотели адресовать это к человеку выше?

Потому, что там был хитрый вопрос "вот выпилите ООП в кодовой базе на 100KLoC тогда поговорим" - и ответ "вот выпилил на проде в базе 10KLoС, доволен".

И да я так не считаю (часто Хаскель за счёт отделения кода от данных чудо как хорош, часто Rust за счёт управления ошибками (близко к аппаратуре) великолепен).

Но часто ООП очень полезен (иначе dyn в Rust не завозили бы).Upd.

В современных языках можно иметь статический диспатч для открытого множества типов который часто будет даже лучше свитча

Сдаётся мне мы как-то сильно по разному это понимаем, ну или вы забыли (*) и подпись мелким шрифтом.

PsyHaSTe

13.04.2023 11:35+27Да меня с одного заголовка вынесло. Что разбиение на функции что-то там автору замедляет. То что атрибут inline изобрели ещё 50 лет назад он видимо не слышал.

Пишу радостно маленькие функции, почти все приложение склеивается в один большой main (и нет, я не идиот который развесил кучу инлайнов, компилятор просто думает что так выгоднее).

Все эти срачи "чистый код зло" каждый раз умиляют. Чистый код может и зло, но с ним есть время на то чтобы побенчить профайлером и потюнить узкие места. А фанат "пили быстро" мало что пилить неподдерживаемую фигню, так ещё и фигарит 2 недели суперфункцию по эффективному парсингу структурки из файла, только чтобы потом на отвали написать запрос в базу (который надо было делать ещё вчера, но он слишком замотался оффсеты считать и отлаживать, и времени думать тут нет), которая будет в мульон раз больше жрать на каждый запрос чем суммарная выгода от его реализации парсинга за всю свою жизнь. Которую причем придется выкинуть когда изменятся требования.

Популистская статья с фальшивым сбрасыванием покровов.

isadora-6th

13.04.2023 11:35+1Because the meaning of the keyword inline for functions came to mean "multiple definitions are permitted" rather than "inlining is preferred"

https://en.cppreference.com/w/cpp/language/inline (since C++17). Т.е. во всех современных проектах, (кроме тех, где решили не переезжать)

Да, я сам недавно узнал, что у inline ныне другое значение. Так что inline в 99% случаев автоматический и если он не сам, то он уже никак (я практически не встречал компилятор-specific

__force_inline).Ну и маленькие функции (не виртуальные) прекрасно автоматически инлайнятся, индирекция за счет виртуальных коллов иногда убивает потенциал инлайнинга.

https://stackoverflow.com/questions/2130226/inline-virtual-function

Я не копал, насколько модерновые компиляторы "clever", но мне все еще кажется, что если у вас цепочка вызовов раскидана по TU, то LTO не осилит поинлайнить сложные случаи на компиляторах в 2023. Тут могу быть неправ.

Без -O1 не инлайнит вообще ничего, а значит дебаг сборки медленнее от количества строк, что может в целом привести к неверным выводам. Поэтому лучше бы автор мерял на -O1. Разница из-за виртуализации в 10 раз это немного перебор.

В любом случае "чистокодовый подход" у меня ассоциируется с ООП-абстрактными-фабриками, которые несколько спорные например: FizzBuzzEnterpriseEdition.

Я кстати недавно почитал "Чистый Код", их абсолютно понятные примеры на Java с листингом на 7 страниц и примечанием, что автор реализовал этот же функционал на pyhon в 5 раз короче. Я бы поспорил про то, что более длинное но "чистокодовое" решение лучше [читаемее, поддерживаемее, понимаемее] более короткого.

Ну и люди любят делать отвратительные OOP-стайл решения там, где достаточно просто функции. Вообще я считаю, что проникновение в культуру C++ программистов Java подхода немного нехорошо.

PsyHaSTe

13.04.2023 11:35+3Да, я сам недавно узнал, что у inline ныне другое значение. Так что inline в 99% случаев автоматический и если он не сам, то он уже никак (я практически не встречал компилятор-specific __force_inline).

Это от языка зависит. Например:

Inline attributes do not guarantee that a function is inlined or not inlined, but in practice, #[inline(always)] will cause inlining in all but the most exceptional cases.

Я на своей практике в эти "мост эксепшонал кейзес" ни разу не упирался, даже километровые функции в стни строк с кучей логики спокойно инлайнились.

Ну и маленькие функции (не виртуальные) прекрасно автоматически инлайнятся, индирекция за счет виртуальных коллов иногда убивает потенциал инлайнинга.

Динамический дисптч — зло, всегда функции должны быть статические.

В любом случае "чистокодовый подход" у меня ассоциируется с ООП-абстрактными-фабриками, которые несколько спорные например: FizzBuzzEnterpriseEdition.

Это общепринятый биас, тем не менее считаю что с ним нужно бороться)

Я кстати недавно почитал "Чистый Код", их абсолютно понятные примеры на Java с листингом на 7 страниц и примечанием, что автор реализовал этот же функционал на pyhon в 5 раз короче. Я бы поспорил про то, что более длинное но "чистокодовое" решение лучше [читаемее, поддерживаемее, понимаемее] более короткого.

Чистокод это книга для джунов, в которой довольно бескомпромиссно высказыаются многие спорные тезисы. Но суть именно в том что она для джунов которые не умеют взвешивать за и против, поэтому лучше их научить всегда делать одно и то же, и когда подрастут смогут более критически относиться к многим советам. В универе мне книга казалась откровением, например пункт "если вы пишете комментарий значит вы не смогли нормально обозвать переменные и функции" был прям разрывом шаблона, особенно на фоне лекций про важность комментариев от нашей профессуры.

0xd34df00d

13.04.2023 11:35Но суть именно в том что она для джунов которые не умеют взвешивать за и против, поэтому лучше их научить всегда делать одно и то же, и когда подрастут смогут более критически относиться к многим советам.

Может, это моя мизантропия, но люди как-то в среднем паршиво прокачивают критическое отношение с возрастом (что паспортным, что джуново-синьорным).

В универе мне книга казалась откровением, например пункт "если вы пишете комментарий значит вы не смогли нормально обозвать переменные и функции" был прям разрывом шаблона, особенно на фоне лекций про важность комментариев от нашей профессуры.

Одна апелляция к авторитету выбила другую. А прикинь, если б обеих не было?

PsyHaSTe

13.04.2023 11:35+1Одна апелляция к авторитету выбила другую. А прикинь, если б обеих не было?

Почему-то все системы обучения построены по этому принципу. Например в младших классах меня били линейкой по руке за запись "2 — 5" ведь "из меньшего нельзя вычитать большее!!". Это был закон. Потом через пару лет оказалось, что на самом деле можно, но вот корень из отрицательных чисел снова оказалось брать нельзя. Ну и так далее.

Почему-то во всех образовательных системах что я знаю предполагается что человеку сначала надо дать простой и понятный императив, а потом про нюансы излагать.

Knightt

13.04.2023 11:35+66чистый код - это не про производительность.. это про процесс(!) разработки, где есть несколько команд разработки, несколько лет поддержки сложного с точки зрения бизнес-логики кода, увольнения, найм новых сотрудников на допил кода без документации...

п.с. надеюсь вы по городу ездите со скоростью 200 км/ч. Ведь нафиг эти ПДД - можно же быстрее /s

Ru6aKa

13.04.2023 11:35+4Если на чистый код смотреть только как на процесс, то микросервисная архитектура будет "идеальным" чистым кодом, а это не так.

VladimirFarshatov

13.04.2023 11:35+13Это типичная отговорка авторов "кровавых энтерпрайзов".. Как правило они тупо не умеют в "хайлоад", да и вообще уже несколько раз слышал "программист не должен смотреть на эффективность кода".

Не бывает "сложного" с т.з. "бизнеса" кода, т.к. бизнес практически везде один и тот же. Просто поверьте моим 40+ лет в разработке. ;)

п.с. Не уместное сравнение. Правила ПДД - это техника безопасности, которая написана кровью людей. Бизнес и энтерпрайз с "правилами" - это о другом.

Впрочем .. сами по себе правила чистого кода - ни есть ни добро ни зло. Это всё те же рекомендации (Карл!) всё того же модульного программирования, начиная с книжек Дейкстры и Вирта. А вот то, как их сейчас навязывают (Карл!) новичкам, то зовется иначе:

Заставь дурака Богу молиться, он и пол пробьет и лоб расшибет. Статья как раз про это.

WASD1

13.04.2023 11:35Не бывает "сложного" с т.з. "бизнеса" кода,

Ну вот я не согласен с вами. Как писал выше - переписывал библиотеку DSL-языка с полиморфизма на струкруты + switch.

Но это очень "алгоритмический" код. А вот бизнес-логику я бы так переписывать не стал - я не могу прямо определить что есть "бизнес-логика" что есть "алгоритмы". Но когда работаешь с кодом прям чувствуется.

nronnie

13.04.2023 11:35+1У меня есть подозрение, что если объекты для полиморфного вызова брать из заранее созданной таблицы синглтонов, то такой полиморфный вызов вполне может оказаться даже быстрее switch.

isadora-6th

13.04.2023 11:35У вас остаётся индирекция за счет того, что размер объекта "динамический" и его нельзя "просто сложить в вектор".

Ну и индирекция за счет девиртуализации вызова. Поэтому время создания объекта не очень "роляет".

Даже если удалить этот оверхед, и как-то сохранять указатели на конечные реализации функций, то у вас все равно будет switch на поиск нужного указателя по RTTI [или решения на if* / std::unordered_map<>].

Быстрей не будет, возможно сопоставимо.

Предположения сделаны из того, что инлайнинг не возможен т.к. типы в контейнере определяются на рантайме и оптимизации девиртуализации на комайл-тайме не происходит.

nronnie

13.04.2023 11:35+2Вызов виртуального метода не требует RTTI. Отличие от вызова невиртуального только в том, что для невиртуального адрес вызова сразу прописывается в скомпилированном коде, а для виртуального берется из таблицы VTBL (по заранее известному смещению). Вот и получаем, например, что у нас всё что нужно это взять из готовой таблицы/словаря по индексу или ключу указатель на объект, а потом взять адрес метода из его VTBL. А switch наоборот развернется в цепочку if/else по которой шагать придется пока нужное условие не найдем.

ksbes

13.04.2023 11:35+1А switch наоборот развернется в цепочку if/else по которой шагать придется пока нужное условие не найдем.

Не всегда. С енумами и другими интами — будет сразу переход по смещению. Именно поэтому в статье всё ускоряется.

WASD1

13.04.2023 11:35Я не очень понимаю как это может быть устроено у вас с "синглтоном".

Есть "статический полиморфизм" (это по сути шаблоны / трэйты + мономорфизация)

Есть D2S фаза компиляции (у бинарных трансляторов и JIT-компиляторов), но она никак не привязана к "синглтону" - она просто собирает статистику по dynamic call destination и если это 1-2-3 варианта - просто вставляет статические джампы + ветка "не смогла".

А что у вас написано (в частности при чём тут синглтон) - я не понимаю.

ПС

При dynamic call сразу несколько сложностей:

1. Прочитать адрес вызова из VMT (в java к стати у объекта может быть целый вектор VMT а не одна) - из-за этого у java он скрыт за отдельной индирекцией.

2. предсказателю переходов намного сложнее работать с динамической информацией.

Она же скрыта за машинерией получения VMT, а не лежит по конкретному смещению +field_offset у объекта.

BugM

13.04.2023 11:35+5Это типичная отговорка авторов "кровавых энтерпрайзов".. Как правило они тупо не умеют в "хайлоад",

Шутите? Энтерпрайз умел в хайлоад еще задолго до нас.

Скорее кроме него никто не умеет. Так чтобы и хайлоад и надежно и поддерживаемо десятилетиями.

да и вообще уже несколько раз слышал "программист не должен смотреть на эффективность кода".

В среднем да. Ну вот есть серверный продакшен код который работает 10мс на запрос, на продакшен нагрузке потребляет в сумме 10 ядер, еще 10 ядер в запасе под него держим. Есть способ так его переписать чтобы он работал в 10 раз быстрее. Нужно это делать? Нет.

VladimirFarshatov

13.04.2023 11:35Шутите? Энтерпрайз умел в хайлоад еще задолго до нас.

До Вас - поверю легко. В ИТ с 1979года. И Хайлоад в виде дравйвера EGA для 286 компа с отрисовкой 12-16 кадров в секеунду - моя работа. Врядли у Вас получится быстрее. Для справки: вышедшая чуть раньше Windows 3.1 ещё долго рисовала 2 кадра в секунду. Впрочем .. http://www.planetaquarium.com/library/innokentii1246.html

Писалось нами по тем событиям.. ;)

BugM

13.04.2023 11:35+14Этот ваш код к хайлоаду не имеет никого отношения. Да и вообще хайлоад со скоростью работы бизнес логики почти не связан.

Хайлоад это балансировка и шардирование. Ну и выбор разумных архитектурных решений. Код при этом может быть почти любым. Квадратов нет и хорошо.

Исключения конечно же есть. Но это как обычно процентов 10 кодовой базы максимум. Типичная бизнес логика стоящая под тысячами РПС может быть написана с точки зрения производительности на чем угодно и как угодно. И точно без обращения внимания на микрооптимизации.

sumanai

13.04.2023 11:35+8Хайлоад это балансировка и шардирование.

Ощущение, что эту позицию продвигают облачные провайдеры, которым это выгодно. В итоге проекты, которые могли бы крутиться буквально на одной виртуалке, раскатывают на десятки инстансов с соответствующей оплатой.

BugM

13.04.2023 11:35+8Я к облачным провайдерам не имею никакого отношения. Верю что бывает всякое.

При этом есть гигиенический минимум:

На одной виртуалке крутиться не может ничего. Два инстанса, желательно географически разнесенных, это абсолютный минимум. Для вообще всего в проде.

Перед ними должен стоять какой-то балансировщик. Естественно тоже два инстанса минимум. По тем же причинам. Балансировщик может быть один на несколько ваших приложений. Но тут уже зависит от конкретики.

За ними должна стоять какая-то БД. С аналогичными правилами. С учетом особенностей многих БД вероятно минимум будет три хоста. А баз бывает больше одной, вы же наверно хотите какой-нибудь Редис кеш в дополнение к основной SQL БД?

Где-то рядом должен быть мониторинг всего этого. Опять два хоста минимум. Отдельных хоста, чтобы любые проблемы прода на него никак не влияли. Лететь без приборов в случае проблем с продом совсем ужасно.

Вылет любого одного (если вы хосты начинаете считать сотнями, то более чем одного. опять зависит от конкретики) хоста не должен сказываться на пользователях никак. Увеличение времени ответа процентов на 20 это должно быть максимальным влиянием на пользователей. Без любых ручных действий. Нагрузку считаем соответственно.

Вот так и набирается.... Если вы конечно серьезный хайлоад, отказоустойчивый сервис делаете.

sumanai

13.04.2023 11:35Я к облачным провайдерам не имею никакого отношения.

А я и не конкретно про вас, я про общие настроения в индустрии.

Вот так и набирается....

А потом падает из-за строчки в конфиге.

А серьёзный хайлоад в 99% случаев просто не нужен.

BugM

13.04.2023 11:35+4А потом падает из-за строчки в конфиге

Бывает. Неплохо помогает постепенная выкатка чего угодно. Сначала один инстанс, минут через 15 второй. 15 минут сидим смотрим мониторинги и держим палец над кнопкой немедленного отката. Инфраструктура позволяющая так откатывать тоже нужна. Забыл совсем.

А серьёзный хайлоад в 99% случаев просто не нужен.

Посмотрите начало ветки. Там первое сообщение и мой ответ про хайлоад. Кому не надо, тем не надо.

sumanai

13.04.2023 11:35-1Инфраструктура позволяющая так откатывать тоже нужна. Забыл совсем.

И ломается она той же строчкой, ибо всё красиво и централизованно.

Посмотрите начало ветки. Там первое сообщение и мой ответ про хайлоад.

Да, вижу. Кстати, надо бы код оптимизировать, чтобы держать про запас 1 ядро и 1 работало )

BugM

13.04.2023 11:35И ломается она той же строчкой, ибо всё красиво и централизованно.

Она так же задублирована и так аккуратно обновляется. Ну и про любые обновления инфраструктуры принято всех предупреждать, чтобы люди свои выкатки по возможности перенесли.

Да, вижу. Кстати, надо бы код оптимизировать, чтобы держать про запас 1 ядро и 1 работало )

Пусть будет два работать и два стоять. Или даже десять работать и десять стоять. Это даже по ценам Амазона долларов 400-500 в месяц. При желании можно найти в разы дешевле.

Вот когда речь о сотнях можно подумать на тему: А не стоит ли что-нибудь оптимизировать? Десятки процентов оптимизации уже становятся видны в бюджете.

sumanai

13.04.2023 11:35Пусть будет два работать и два стоять. Или даже десять работать и десять стоять.

А потом программы тормозят и требуют нового железа ((

BugM

13.04.2023 11:35Это так не работает. Я про серверный софт. Там свои критерии производительности и свои расчеты железа.

Десктопный софт это совсем другой мир, про который я почти ничего не знаю. И не готов его обсуждать.

nronnie

13.04.2023 11:35+1А потом программы тормозят и требуют нового железа

Железо постоянно дешевеет, а разработчики наоборот дорожают.

santjagocorkez

13.04.2023 11:35+2Ну и про любые обновления инфраструктуры принято всех предупреждать, чтобы люди свои выкатки по возможности перенесли

Какая архаика, аж олдскулы свело. Пацанское решение будет такое:

Scheduled mutually exclusive deployments

Каждый артифакт имеет просчитанное с запасом время на деплой

При планировании выкатки деплоя другие деплои не могут встать в план, если время выкатки будет хоть частично перекрываться

При внеочередной выкатке инфраструктуры могут быть варианты, когда уже запланированные деплои отменяются, ответственные оповещаются

Наоборот тоже работает: инфраструктура не может вкорячиться в план, если заденет по времени хоть один артифакт

Само собой, даже внеочередной деплой "срочно, прямо сейчас же" не может начаться тогда, когда уже идёт хотя бы один конфликтующий деплой

В общем, примерно, как в календаре встреч, а хотя бы даже в том же аутлуке. Только там любой конфликтует с любым обычно.

BugM

13.04.2023 11:35+1А вы не пробовали добавить немного хаоса? Ну хочет разработчик катнуть релиз какой-то внутренней обработки чего-то сейчас. Все положенные приседания с ревью тестами и оками он сделал. Пользователей не задевает. Как работало, так и будет работать. Ну и пусть катит.

Мне нравятся системы со специально заложенной в них долей хаоса. Так жить приятнее и свободнее. И люди растут в таких системах лучше, а увольняются реже.

При этом надежность остается на достаточном уровне. Большое красное предупреждение что мы тут инфру сейчас обновляем, аккуратнее может пойти не так все что угодно с явной кнопкой "Ок, я понимаю что делаю". Люди просто так такие предупреждения игнорируют редко. И если что у них можно спросить: Зачем ты это сделал? О чем ты думал? Это точно срочно катить надо было несмотря на предупреждение?

Долю хаоса всегда можно регулировать. Разработчики начали ерунду творить потому что можно? Гайки закручиваем. Никто не проявляет никакой инициативы и пишет строго то что сказали без всяких идей и предложений? Гайки откручиваем.

0xd34df00d

13.04.2023 11:3515 минут? В одной компании, славящейся околонулевым даунтаймом, где я работал, ключевые сервисы выкатывают на следующую группу через неделю, и разных групп инстансов по очередности штуки четыре.

BugM

13.04.2023 11:35Не надо сразу людей пугать. Даже 15 минут это в бесконечность раз лучше чем катить сразу на все. Начинать надо с малого.

vkni

13.04.2023 11:35+1Между прочим, неделя — это не просто так. Это потому, что дни недели существенно разные. Кстати, вот буквально пару недель назад объяснял популярно, почему надо писать прототипы. И почему прототип на Хаскеле, написанный за 2 недели, сэкономил пару-тройку месяцев.

nronnie

13.04.2023 11:35+1Балансировка и шардирование это не только про производительность, а еще и про надежность. А иначе так-то было бы дешевле вместо двух одинаковых нод развернуть одну в два раза более мощную.

VladimirFarshatov

13.04.2023 11:35-2Хайлоад - это всё то, что работает на таком железе, которое не тянет задачу "по определению" по своим возможностям. Редактор Emacs, который в свое вмеря обрабатывал мегабайтные документы, в 64 килобайтах памяти и даже без "жестких дисков" которых ещё не было, да тот же Лексикон как ни странно, Тор.., внезапно тот же Хайлоад. Doom1, Doom2 в которых движок на 486 процах лочил свой драйвер в кеше проца, идея от Дейва Тейлора, насколько помню из переписки.. это всё Хайлоад. Этот драйвер тоже писался для игровой индустрии..

А вот шардирование и балансировка - это ни разу НЕ хайлоад, а распараллеливание отклика с неизбежным ростом латенси. Это high popularity - рост посещений.

Didimus

13.04.2023 11:35Хайлоад это когда у вас тормозит. Для кнопочного телефона тетрис может быть хайлоадом

VladimirFarshatov

13.04.2023 11:35+1Верно. High Load == "высокая нагрузка (на железо)". Когда сложность задачи превышает возможности железа. High Popularity -- высокая посещаемость. Количество запросов (обращение) превышает возможности железа их обслуживать.

Как вариант решения - обработка параллельными потоками, в т.ч. и даже(!) на одном железе с виртуализацией или без таковой. Как самый примитивный пример: популярная связка Appache + Nginx. Оставьте один поток-обработчик, сколько пользователей обслужит такой сервер? А 5, а 10? Мало и не справляемся, но загрузка ядер невелика? Шардируем ноду в виртуалках. Железо одно, а "машин" стало больше. Все равно мало? Ставим отдельное железо.

попутно(!) решаем вопрос надежности...

Только тут, вопрос статьи тоже интересен. При каких параметрах популярности ресурса придется "шардировать"? Из выше следует:

Yii2, core2duo = 190 запросов в секунду на двух ядрах с 5-ю потоками (кажется, не помню). 191-й запрос уже требует шардирования.. 190rps это 684_000(!!!) запросов часовой "пиковой" нагрузки. Ну ок, поделим на "сберовские" 300 обращений к серверу на страничку == 2280 активных пользователей в час или около миллиона посещений в месяц.. Много таких ресурсов в Сети?

ussr.monster == 2500 запросов в секунду. Далее продолжать? Впрочем, можете провести оценочную прикидку самостоятельно. Методика выше. ;)

Особенно последнее время, очень часто слышу "У нас жуткий хайлоад и шардирование" .. смотришь на сайт, а там .. "три пленных немца" в статистике: директор, бухгалтер, пара менеджеров, сисадмин и программист по 5 раз в сутки. Сайт с посещаемостью .. до 100 пользователей (ботов много больше)..

sumanai

13.04.2023 11:35Мало и не справляемся, но загрузка ядер невелика? Шардируем ноду в виртуалках.

Выглядит весьма бессмысленно. Чем добавление лишнего слоя в виде виртуалки может быть лучше, чем простое увеличение числа потоков?

Didimus

13.04.2023 11:35+1Гарантированное выделение ресурсов? Не всегда ведь потоки можно ограничить в потреблении ресурсов

PuerteMuerte

13.04.2023 11:35+2И Хайлоад в виде дравйвера EGA для 286 компа с отрисовкой 12-16 кадров в секеунду — моя работа. Врядли у Вас получится быстрее

Справедливости ради, это не ваша заслуга, а заслуга видеокарты. В драйвере EGA ещё надо специально постараться сделать что-то, чтобы ограничителем скорости работы был ваш код, а не скорость записи в видеопамять. "В среднем" видяхи EGA умели в 500кб/с, шустрые и в мегабайт умели. Режим высокого разрешения там 640х350х16 цветов, это 112 килобайт на кадр. Вот вам и естественное ограничение.

VladimirFarshatov

13.04.2023 11:35+1Драйвер работал с видео картой на 5 мегабайтах в секунду. Карта так не умела. Это реально надо было постараться..

P.S. А вот деталей уже не помню.. что-то там юзалось из текстовых режимой Еги..

WinPooh73

13.04.2023 11:35Спасибо за ссылку! Помню, что читал отдельные строфы в виде эпиграфов в книге Иртегова про операционные системы, лет двадцать назад. Поиск по тогдашнему интернету ничего не дал. Не знал, что где-то выложен полный вариант.

Kohelet

13.04.2023 11:35+2А поддержка этого "чистого" кода проще? Искал я как-то баг — видим в форме неправильное значение. Это значение получаем из какой-то функции. А в эту функцию оно приходит из другой функции. А в ту из третьей… И где-то там, на 10 уровне вложенности "маленьких функций, выполняющих одну задачу" — баг. И просмотром исходников его не найти. Только в отладчике по шагам. И если заходить отладчиком в каждую функцию, до конца не добраться. А если перешагивать через вызовы, то в какой-то момент приходится матерясь перезапускать все это, записывая на бумажке, в какую функцию надо заходить, а в какую нет. Потому что шагнуть в отладчике назад и зайти туда уже нельзя. А перезапуск этого хозяйства не быстрый.

Хорошие имена функций? Да где же их взять то. Нет 100500 хороших имен. Документация? Да, по паре слов про возвращаемое значение и каждый из параметров. Юнит тесты? Есть, но оказывается, покрывают не всё.

VladimirFarshatov

13.04.2023 11:35+2Само слово "чистый" подразумевает "отсутствие грязи" - ошибочного кода, неиспользуемого, избыточно добавленного. В примере выше как раз чистым является переделка на switch и табличное хранение констант, т.к. исключает всё лишнее.

Чистый код отлаживать и сопровождать всегда легче "по определению". Другой вопрос, что сделать так как в примере можно далеко не всегда. Существуют задачи с динамикой, в т.ч. и в классах. Как пример другой крайности - PHP код (интерпретатор), который пишет сам себе же PHP файлик и затем его исполняет - крайняя степень динамики. Ну и какие тут свичи и предвычисления константных таблиц? :)

Как пример применения: выгрузка документов ЭДО, кодом, который создается генератором по XSD описаниям от налоговой. Генератор выкачивает описания, сличает их с имеющимися, в случае обновления законодательной базы парсит нововведения и получает новый PHP файлик выдачи документов. Бухам даже не надо напрягаться, что там поменялось у налоговой.. достаточно только указать ссыль на новые xsd..

WASD1

13.04.2023 11:35Генератор выкачивает описания, сличает их с имеющимися, в случае

обновления законодательной базы парсит нововведения и получает новый PHP

файлик выдачи документов.Э... подождите в вашем примере парсится текст закона (и подзаконных актов). И по тексту закона, даже без промежуточного ТЗ, генерируется нужный нам код.

Это как?

VladimirFarshatov

13.04.2023 11:35парсится xsd созданный по тексту закона. Формат документов ЕДО описан в соответствующих ссылях на сайте налоговой. Нужно просто указать новую ссылку, что не сложно.

P.S. и да, это уже не "у меня" больше трех лет.. работает штатно, насколько понимаю..

WASD1

13.04.2023 11:35было: в случае обновления законодательной базы парсит нововведения и получает новый PHP файлик выдачи документов.

-

стало: ну мы умеем форматировать данные по xsd.

Понятно.

> P.S. и да, это уже не "у меня" больше трех лет.. работает штатно, насколько понимаю..

Было "в вашем примере", стало "у меня". Смысл кавычем - в точности цитаты.Впрочем я уже по предыдущему ответу всё понял, удачи вам.

VladimirFarshatov

13.04.2023 11:35-1Ничкего не понял, что Вы там поняли, но написано кмк достаточно внятно, что выше, что ниже:

Изменения законодательства, отражаются в изменениях форматов и полей ЭДО документов. Эти изменения фиксируются на сайте налоговой в виде обновлений xsd описаний.

Xsd описание скачивается парсером, сличается с уже имеющимся и, в случае расхождения, генерируется новый PHP-файл, который далее и исполняется при создании самого ЭДО документа.

Надеюсь так понятнее?

Andrey_Solomatin

13.04.2023 11:35Есть, но оказывается, покрывают не всё.

Если убрать маленькие функции, то и юниттестов не будет.

А если юниты можно заменить более высокооуровневыми тестами, то из можно написать и с тукущим кодом и найти проблему через тесты, а не через дебаг.

0xd34df00d

13.04.2023 11:35Хорошие имена функций? Да где же их взять то. Нет 100500 хороших имен. Документация? Да, по паре слов про возвращаемое значение и каждый из параметров. Юнит тесты? Есть, но оказывается, покрывают не всё.

Эх, если бы только документацию можно было записывать как-то, ну, прямо в определении функции… И чтобы компилятор её проверял…

Да не, фантастика, лучше написать ещё юнит-тестов.

mayorovp

13.04.2023 11:35+1Хорошие имена функций? Да где же их взять то.

Вообще-то это хороший критерий необходимости функции — можно ли придумать ей имя.

Ndochp

13.04.2023 11:35Часто зависит от структуры проекта и настройки неймспейсов. А то вот в одном файле есть десяток функций на 2к+ строк, вы начинаете рефакторинг. Если бы каждая функция была в своем неймспейсе, то легко можно выделить законченные куски типа "проверка входящих параметров" "получение и подговка данных из БД" и наконец алгоритм по названию практически совпадающий с именем исходной 2к функции.

Беда в том, что функции не зря в одном модуле, они примерно про одну область. И тебе приходится или городить монстра ИмяОсновнойФункции_ПроверкаВходящихПараметров или придумывать десяток синонимов, стараясь не совпасть с соседней функцией.

mayorovp

13.04.2023 11:35Вооот, критерий-то работает! Проверка входящих параметров должна быть в той функции, чьи параметры проверяются. Это абсурд, когда функция проверяет чужие параметры.

Да, 2к+ строк просятся чтобы их разбили, но делить их механически нельзя.

Ndochp

13.04.2023 11:35-1Никому она ничего не должна.

Беру функцию на 2к, последовательно на человеческом языке записываю в комментах план того, что она делает из 10 — 15 строк, каждую строку меняю на вызов новой функции, плюс обвязка. Получаю нормальную функцию на полэкрана. Для тех вызовов, что получились внутри больше комфортного — повторяю алгоритм.

nronnie

13.04.2023 11:35Поддерживаю. А еще, если к куску кода хочется написать комментарий, даже если этот кусок кода нигде больше не используется. Знал когда-то одного чудака, который на ревью упорно объединял структурированный методами код в один метод, обосновывая это: "Оно же нигде больше не вызывается". Слава Ктулху он очень скоро свалил куда-то в другую контору свои фантазии воплощать.

aborouhin

13.04.2023 11:35+27Ну да, если на том железе, на котором софт обычно работает, он нагружает все ядра CPU на десятки процентов - наверное, пора переходить к оптимизации в ущерб сопровождаемости и простоте. А если 95% задержек, как обычно и бывает, - это disk и network IO или БД... Ну, в общем, про premature optimization уже столько всего написано, что нет смысла повторяться.

VladimirFarshatov

13.04.2023 11:35+3Как правило, хорошо написанный код, и чист и быстр и жрет мало и сопровождается "на раз" .. просто такое редко, т.к. часто на вопрос сроков слышим ответ: "вчера!" :)

vkni

13.04.2023 11:35+1Ну да, обычно работают не продукты, а прототипы. Естественно, "переписыванием с Питона на Rust" (сейчас это модно, но переписывать можно обратно на Питон), достигают нормального продукта и, следовательно, нормальной производительности.

Cheater

13.04.2023 11:35+39Если она основана на типах, это сделать гораздо сложнее, а может, даже невозможно без переписывания большого объёма кода.

Сказал человек, которому при изменении иерархии классов придётся руками искать и дополнять все эти гениальные switch statements в каждом подобном методе))

VladimirFarshatov

13.04.2023 11:35-5Необязательно "в каждом". принцип DRY требует выделения такого switch в функцию, как только у него больше одного места применения. Но! Она перестает быть виртуальной, и соответственно "экономит" 2 уровня косвенности, что и есть "главный тормоз" в примере статьи.

Daemonis

13.04.2023 11:35+10Необязательно "в каждом". принцип DRY требует выделения такого switch в функцию, как только у него больше одного места применения.

Как выделение в функции спасает от ползанья по всему коду, ведь свичи там могуть быть?

Ну и интересно посмотреть, во что превратится этот чудесный код, когда добавится пятиугольник, которому будет недостаточно ширины и высоты :)

VladimirFarshatov

13.04.2023 11:35Зачем ползать по коду, если dry предлагает выделить в функцию уже для второго места?

Попробуйте, всё не так страшно.

koreychenko

13.04.2023 11:35+2А в этот момент у вас же будет определение параметров в рантайме и компилятор не сможет это оптимизировать.

Т.е. у вас будет какой-то новый общий резолвер, который на вход получает тип фигуры, а на выходе возвращает чего-то.

(я не сишник, так что не бейте, если глупость написал)

VladimirFarshatov

13.04.2023 11:35В целом верно. Тут с++ надо рассматривать исключительно как демонстратор кода. Написанное верно для любого языка в целом.

Да, такая инкапсуляция switch создаёт функцию-резолвер, которая возвращает нужный вариант.

Но, это и есть принцип "чистой" архитектуры YAGNY -- делать только то и только тогда, когда оно с ановится востребованным! А не городить заранее "кровавый Энтерпрайз".

grossws

13.04.2023 11:35И где-то в этот момент функция превращается в ручной диспетчер виртуальных вызовов. Называется, см. рис. 1.

VladimirFarshatov

13.04.2023 11:35+1Вот на этом этапе, чистым станет код с виртуальными методами .. всё относительно. :)

Статья, да и нашумевшая книжка, как раз о том, что не надо лепить везде многоуровневый энтерпрайз. Каждый класс, каждая виртуализация, обратная зависимость .. всё это обязано быть обосновано соответствующим пунктом ТЗ. Больше чем уверен, что фразу типа "ну такую простую программу мы напишем в лоб" мало кто найден в нашумевшей книжке. А она там есть. ;)

arteast

13.04.2023 11:35+9Для того, чтобы избежать shotgun surgery, в c++ (про который речь) есть паттерн "статический полиморфизм". К примеру, вместо базового класса с виртуальными методами - std::variant с набором классов, имеющие одинаковый набор методов, а вместо вызова виртуальной функции - std::visit с аргументом-шаблоном, который под капотом вызывает какой-либо метод у своего аргумента. std::visit при компиляции превращается в тот самый switch; в то же время, специфичный код остается чисто разделенным по своим классам, а сам набор классов - собран в едином месте в определении типа std::variant.

Главное, чтобы компилятор всю эту бижутерию соптимизировал нормально :)

arteast

13.04.2023 11:35+6Отвечу сам себе :) Народ в ответ на статью-оригинал сделал тот же самый комментарий, что и я здесь, но заморочился на предмет потестировать: https://blog.codef00.com/2023/04/13/casey-muratori-is-wrong-about-clean-code

Результаты интересные.

Но на самом деле, если мы тут заморачиваемся с производительностью, то правильнее было бы попытаться разделить коллекции предметов по их типу - тогда каждый тип можно обрабатывать простым циклом, и тем самым вообще убрать накладные расходы на полиморфизм (и притом более-менее остаться с чистым кодом). Дальше осталось бы только играться с чем-нибудь типа SoA, чтобы SIMD задействовать по полной и тому подобными извращениями.

VladimirFarshatov

13.04.2023 11:35Бизнес часто не знает состав коллекций.

0xd34df00d

13.04.2023 11:35Бизнесу не нужно их знать. Бизнесу достаточно быть нечувствительным к точному порядку обработки.

vkni

13.04.2023 11:35А вот для этого нужно немного работать над сбором требований. Вернее, работать в рамках спиральной модели, когда мы в цикле

«собираем/уточняем требования»

«планируем архитектуру»

«реализуем прототипы» (необязательно)

0xd34df00d

13.04.2023 11:35+1Я тут по рекомендациям читаю книгу Domain Modeling Made Functional — с технической точки зрения там ни для тебя, ни для меня ничего нового (кроме синтаксиса F#, но он очевидный), но вот с точки зрения «а как тут взаимодействовать с бизнесом» вполне годно.

vkni

13.04.2023 11:35+2Я переехал в группу производства средств производства: что хорошо — что заказчик/пользователь — это кто-то вроде меня же. Ну и некоторым образом использую вышеописанную методику, хоть и немного партизанскими методами. Но, что радует — не давят пока, впрочем и промежуточные результаты какие-то есть.

По сбору требований — есть Volere Requirements Template 2007 года (сайт универа в Чикаго). Он простой и понятный. Тупо скачиваешь и проходишь, отмечая то, что тебе нужно.

Я посмотрел главу Understanding The Domain — они там дают ложное впечатление, что требования нужно один раз собирать. Нет, нет, и нет. Где-то пробегала статья, что ограничения легко композиционируются => требования легко можно изменять => их нужно периодически переуточнять по планируемой архитектуре.

Просто список должен сходиться + ложиться на архитектуру.

0xd34df00d

13.04.2023 11:35+1Я переехал в группу производства средств производства: что хорошо — что заказчик/пользователь — это кто-то вроде меня же.

Ровно поэтому я люблю заниматься всякими там компиляторами и прочей инфрой, а этой вашей бизнес-логикой — нет.

Я посмотрел главу Understanding The Domain — они там дают ложное впечатление, что требования нужно один раз собирать.

Нет, чувак про итеративность там где-то чуть позже явно говорит. Но, возможно, ему стоило бы говорить про это чаще.

PsyHaSTe

13.04.2023 11:35И? Зато при необходимости добавить ещё одну функцию (скажем посчитать периметр) можно написать 1 функцию, а в варианте с иерархией добавлять функцию в интерфейс/базовый класс и потом менять всех наследников.

С чего вы вызяли что добавление ещё одного наследника более важная задача чем добавление функционала в существующую иерархию? Это может быть верным, а может быть и нет, в зависимости от задачи. В общем-то известная проблема.

Не стоит так снисходительно посмеиваться, не будучи на 100% правым в своем поинте, некрасиво выглядит.

mayorovp

13.04.2023 11:35Тут ещё надо помнить про подсказки от компилятора.

Скажем, в большинстве ООП языков компилятор подскажет вам если вы забыли реализовать абстрактный метод в одном из наследников. А вот про забытый кейс в switch вам подскажет только компилятор Rust и никто кроме него...

Хотя эти подсказки от компилятора зачастую мешают обратной совместимости и от них, наоборот, пытаются избавиться.

grossws

13.04.2023 11:35И то, если нет обработки

default/_варианта. Но вообще clang умел в предупреждение если не все тэги обработаны, javac -- аналогично (а при использовании нового синтаксиса выдаёт ошибку).Аналогично обнаружение fallthrough в языках с си-подобным switch.

0xd34df00d

13.04.2023 11:35А вот про забытый кейс в switch вам подскажет только компилятор Rust и никто кроме него...

Языки из ML-семейства вышли из чата.

PsyHaSTe

13.04.2023 11:35

mayorovp

13.04.2023 11:35Не подскажете, каким очередным тайным ключом эта проверка включается в том же Хаскеле? По умолчанию там проверка тотальности только в рантайме...

0xd34df00d

13.04.2023 11:35-Wallили что-то в этом духе — у меня ghc на неполные паттерны всегда жалуется.Другое дело, что наличие pattern guard'ов и некоторых других особенностей синтаксиса (pattern synonyms, например) делает проверку неразрешимой, но когда в раст завезут guard'ы или синонимы, тогда это можно будет обсудить снова.

PsyHaSTe

13.04.2023 11:35Какие именно гварды? обычные match x if x>5 имеются, речь про какие-то другие?

0xd34df00d

13.04.2023 11:35match x if f xдля произвольной Тьюринг-полнойf : a → Bool, да.

PsyHaSTe

13.04.2023 11:35ну он есть, но компилятор не использует закон исключенного третьего для него. Поэтому после матчей

match x if P(x) => ..., x if !P(x) => ...нужно матчитьmatch x if P(X) && !P(X) => ...Так-то оно нсть с версии раста 1.0, не очень понятно утверждение "когда завезут гварды".

0xd34df00d

13.04.2023 11:35А, ну тем более, значит, аналогичная проблема с false positives есть и у раста (хотя в соседнем треде подсказывают, что теперь мне надо говорить RS).

WASD1

13.04.2023 11:35+1придётся руками искать и дополнять все эти гениальные switch statements

Ну если мы сравниваем C++ -classes мы C++ -templates то наверное да.

А вот если мы возьмём Rust - то там из коробки свичи (они там pattern-matching и называются match) exhaustive. Поэтому компилятор их за вас все сам найдёт и скажет: допиши ещё ону альтернативу пожалуйста.

Emulyator

13.04.2023 11:35+4В первом примере с оптимизацией получается, что мы для круга и квадрата резервируем место для неиспользуемого значения высоты. Не совсем честная альтернатива или я не прав?

WannaCode

13.04.2023 11:35-13Очень даже честная. В варианте без оптимизации каждая фигура является классом, соответственно, при создании одной фигуры для нее отдельно выделяется память, а количество выделяемой памяти обозначается в страницах, то есть одна фигура занимает как минимум одну страницу, а это аж 4 кб. А в случае оптимизации все фигуры аккуратно размещаются в одном массиве впритык друг к другу и занимают каждая всего по 12 байт. Минусов нет, есть только выигрыш как в скорости, так и в потреблении памяти.

nin-jin

13.04.2023 11:35+30Это ОС выделяет память страницами. Внутри процесса память под объекты выделяется с любой необходимой гранулярностью, в зависимости от используемого аллокатора.

MiraclePtr

13.04.2023 11:35+19для нее отдельно выделяется память, а количество выделяемой памяти обозначается в страницах, то есть одна фигура занимает как минимум одну страницу, а это аж 4 кб.

Вы сначала разберитесь, как на самом деле работает аллокация памяти для процессов в ОС и аллокация памяти в используемом вами языке/рантайме и не порите больше такую чушь, ей больно.

prefrontalCortex

13.04.2023 11:35+3Тут скорее нужно рассуждать не о размере страницы, а о размере кэш-линии, который в наши дни - 64 байта.

Daemonis

13.04.2023 11:35+7Почему ж неиспользуемая? Какой-нибудь последователь автора может решить, что для круга нужно использовать высоту, а не ширину, и напишет свои свичи для своих операций :)

grossws