Заинтересовавшись задачами NLP (Natural Language Processing), в особенности FAHQMT (Fully Automatic High Quality Machine Translation), я решила разобраться, а как правильнее всего измерять качество машинного перевода. Разнообразных метрик очень много – какая среди них лучшая?

В этой статье расскажу об итогах своего погружения в тему: какие существуют метрики качества машинного перевода, как они эволюционировали и какие из них на сегодняшний день наиболее адекватны. Часть 1 будет посвящена логике развития метрик и обзору основных традиционных метрик. В Части 2 подробнее остановимся на нейросетевых метриках, а также посмотрим на сравнительную эффективность различных метрик.

Логика развития метрик

Обычно о качестве машинного перевода судят, сравнивая его с неким эталоном (reference) – как правило, с переводом, выполненным человеком-переводчиком. На таком сравнении построено большинство существующих метрик, хотя и не все.

Глобально метрики качества машинного перевода можно подразделить на традиционные и нейросетевые.

1) Традиционные метрики сравнительно просты в расчете и прозрачны, наиболее известные из них разработаны до бума нейросетей. Чаще всего такие метрики основаны на подсчете числа совпадений символов / слов / cловосочетаний – их называют «lexic overlap metrics».

2) Большинство метрик, предложенных после 2016 года – нейросетевые. Первым шагом в применении нейросетей в расчете метрик стало использование векторных представлений слов (embeddings).

Сначала близость embeddings машинного и эталонного переводов оценивалась эвристическими методами (например, для метрик WMD, ReVal, BERTScore, YiSi).

Далее появились нейросети, последние слои которых принимают на вход embeddings машинного и эталонного переводов, а на выходе дают оценку качества перевода (такие как BLEURT, Prism).

Затем возникли модели, на вход которых, помимо машинного и эталонного перевода, также может подаваться первоисточник – оригинал переводимого текста (COMET, UniTE).

В параллель в рамках решения задачи Quality Estimation развивались модели, сравнивающие напрямую машинный перевод и первоисточник, без эталонного перевода. Так появилось то, что можно назвать безреференсными метриками (reference-free metrics).

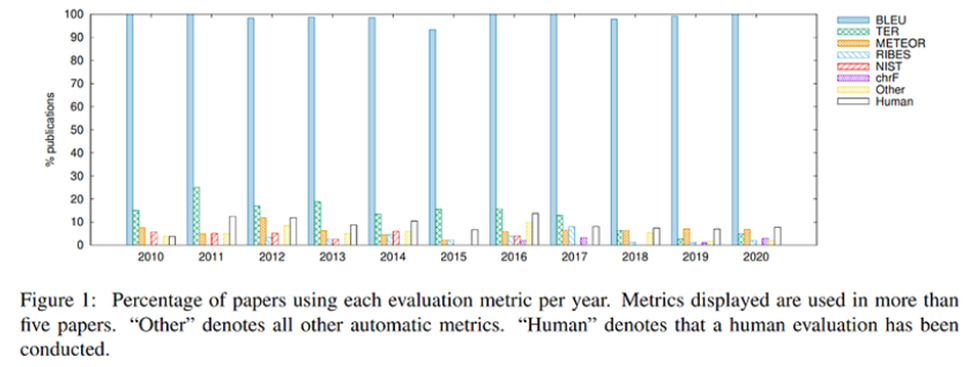

Сегодня наиболее используемые – метрики, предложенные до 2010 года, причем в 99% это BLEU.

При этом только за период с 2010 по 2020 было предложено более 100 метрик качества машинного перевода. Новые метрики лучше коррелируют с человеческой оценкой качества перевода, чем BLEU, и эксперты призывают исследователей наконец обратить на них внимание. Например, результаты воркшопа WMT Metrics Shared Task, ежегодно проводимого в рамках Conference on Machine Translation, в 2022 году были озаглавлены так: «Stop Using BLEU – Neural Metrics Are Better and More Robust» (Прекратите использовать BLEU – нейросетевые метрики лучше и надежней).

Традиционные метрики

Наиболее известны и употребимы такие традиционные метрики как: BLEU, NIST, ROUGE, METEOR, TER, chrF, chrF++, RIBES. Рассмотрим их подробнее.

BLEU

BLEU (BiLingual Evaluation Understudy) — метрика, разработанная в IBM (Papineni et al.) в 2001. Основана на подсчете слов (unigrams) и словосочетаний (n‑grams) из машинного перевода, также встречающихся в эталоне. Далее это число делится на общее число слов и словосочетаний в машинном переводе — получается precision. К итоговому precision применяется корректировка — штраф за краткость (brevity penalty), чтобы избежать слишком высоких оценок BLEU для кратких и неполных переводов.

Более детально ознакомиться с методикой расчета BLEU можно, например, в видео под катом от Эндрю Ына (15 мин.), также см. он‑лайн считалку от huggingface.

Видео от Эндрю Ына: методика расчета BLEU

NIST

Метрика, разработанная в US National Institute of Standards and Technology (Doddington, 2002). Основана на BLEU-score, но с несколькими изменениями в расчете.

В расчете NIST каждому совпадению слов и словосочетаний (n-gram) в машинном переводе и в эталоне присваивается определенный вес, в зависимости от частоты встречаемости данного n-gram в языке, на который выполнен перевод. То есть более редкие и менее вероятные совпадения сильнее улучшают оценку качества перевода, чем совпадения более часто встречающихся слов и словосочетаний.

NIST также отличается от BLEU в порядке расчета штрафа за краткость, более мягко штрафуя незначительные отклонения в длине машинного перевода от эталона.

ROUGE

ROUGE (Recall-Oriented Understudy for Gisting Evaluation) – серия метрик, предложенная Chin-Yew Lin в 2004 для оценки качества решения задачи суммаризации текста.

Как и BLEU, ROUGE основаны на подсчете совпадений слов и словосочетаний в машинном переводе и в эталоне. Но для ROUGE считается не только precision, но и recall, а также параметр F1. Это позволяет обойтись без штрафа за краткость.

Разные метрики серии ROUGE различаются количеством слов, для которых ищутся совпадения:

Также под катом см. видео (4 мин.) от huggingface с методикой расчета.

Видео: Методика расчета ROUGE

METEOR

METEOR (Metric for Evaluation of Translation with Explicit ORdering) – метрика качества машинного перевода, предложенная Banerjee and Lavie в 2005.

Оценка основана на подсчете совпадений отдельных слов (unigrams), c расчетом precision, recall, а также обобщающего показателя гармонического среднего (Fmean). В качестве совпадений учитываются не только точные соответствия слов (как в BLEU или ROUGE), но и наличие однокоренных слов или синонимов.

Итоговая метрика METEOR рассчитывается путем применения к Fmean штрафа за малую длину либо отсутствие совпадающих n-grams.

Под катом – видео (8 мин.) с методикой расчета.

Видео: методика расчета METEOR

TER

TER (Translation Edit Rate) – метрика качества машинного перевода, предложенная Snover et al. в 2006. Основана на подсчете минимального числа правок, требуемых для приведения машинного перевода в полное соответствие наиболее близкому эталонному переводу. Подсчет числа правок автоматизирован.

Итоговый показатель TER определяется путем деления числа требуемых правок на усредненную по всем эталонам длину предложения:

chrF, chrF++

chrF (correlations with human rankings for 6-gram F1-score) – метрика качества машинного перевода, предложенная Maja Popovic в 2015, затем была усовершенствована ею же до chrF++ в 2017.

chrF основана на подсчете совпадений последовательно идущих символов (character n-grams – в отличие от token n-grams для ROUGE) в машинном и эталонном переводах.

chrF++ учитывает как совпадения последовательно идущих символов, так и совпадения последовательно идущих слов.

В качестве итоговой метрики chrF и chrF++ выступает параметр F1.

RIBES

RIBES (Rank-based Intuitive Bilingual Evaluation Score) – метрика, разработанная для оценки качества переводов для далеких языков, существенно различных по структуре предложений (Isozaki et al., 2010).

Например, перевод с английского на японский язык требует существенного изменения порядка слов. Авторы RIBES заметили, что прочие метрики, разработанные к 2010 году, недостаточно учитывали корректность порядка слов, и поэтому предложили свою собственную.

Для расчета RIBES используются коэффициенты ранговой корреляции n-grams эталона и машинного перевода (нормализованные коэффициенты Спирмена – NSR и Кендалла – NKT). Они выступают в качестве веса для precision. Результат усреднения взвешенных precision и есть RIBES.

где α – параметр в диапазоне от 0 до 1.

Заключение

Здесь мы проследили, как развивались метрики качества машинного перевода, а также познакомились с основными традиционными метриками. В следующей части статьи рассмотрим наиболее известные нейросетевые метрики, а также узнаем, какова сравнительная эффективность различных традиционных и нейросетевых метрик.