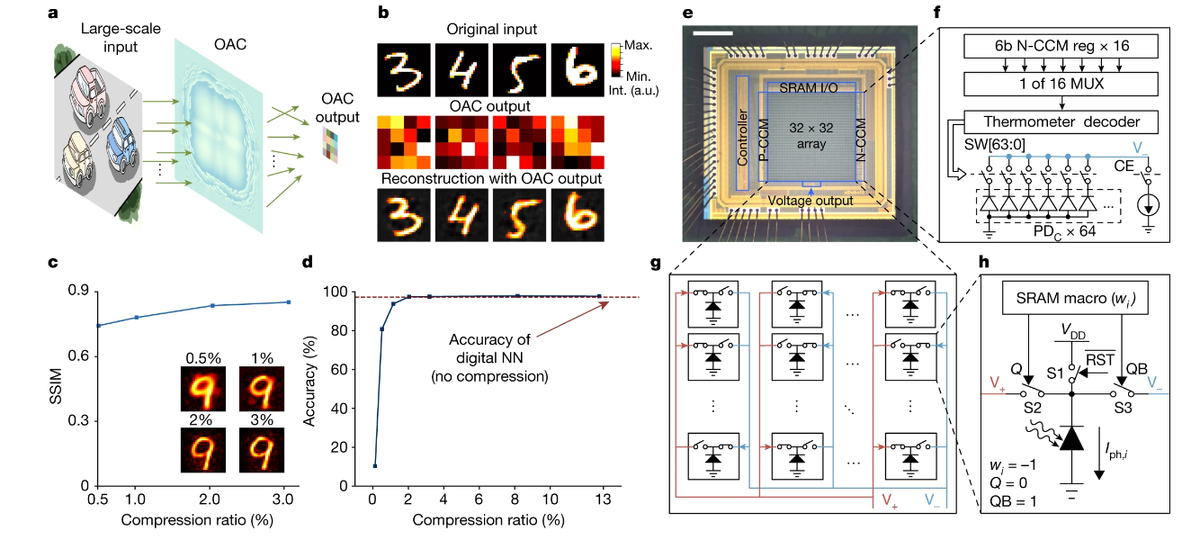

Именно это преимущество нового чипа указывают в статье, описывающей новое изобретение, китайские разработчики. Команда ученых из университета Цинхуа создала аналоговый фотоэлектронный чип. По мнению самих разработчиков, этот чип способен вывести отрасль машинного зрения на новый уровень. Чип получил название ACCEL (All-analog Chip Combining Electronic and Light Computing).

В новой разработке используются технологии и достижения из отрасли фотонных вычислений, где свет использует для обработки данных. В частности, в чип применяются как дифракционные оптические аналоговые вычисления (OAC) и электронные аналоговые вычисления (EAC), что позволяет значительно увеличить энергоэффективность и производительность. Подробности о чипе — под катом.

Что это за технологии?

В первом случае, ОАС, для кодирования и обработки информации применяется управление световыми волнами посредством дифракции. Свет создает определенные интерференционные паттерны, а данные обрабатываются непрерывно вследствие аналоговой природы самого чипа.

В случае ЕАС разработчики задействовали электронные компоненты для решения такой задачи, как замена цифровых сигналов аналоговыми, которые постоянно меняются.

Благодаря обеим технологиям, чип хорошо подходит для решения задач отрасли компьютерного зрения, поскольку способен очень быстро и непрерывно обрабатывать информацию при помощи света. Более того, для преобразования изображения не требуется АЦП благодаря чему задержек практически нет.

Что насчет точности, производительности и других характеристик?

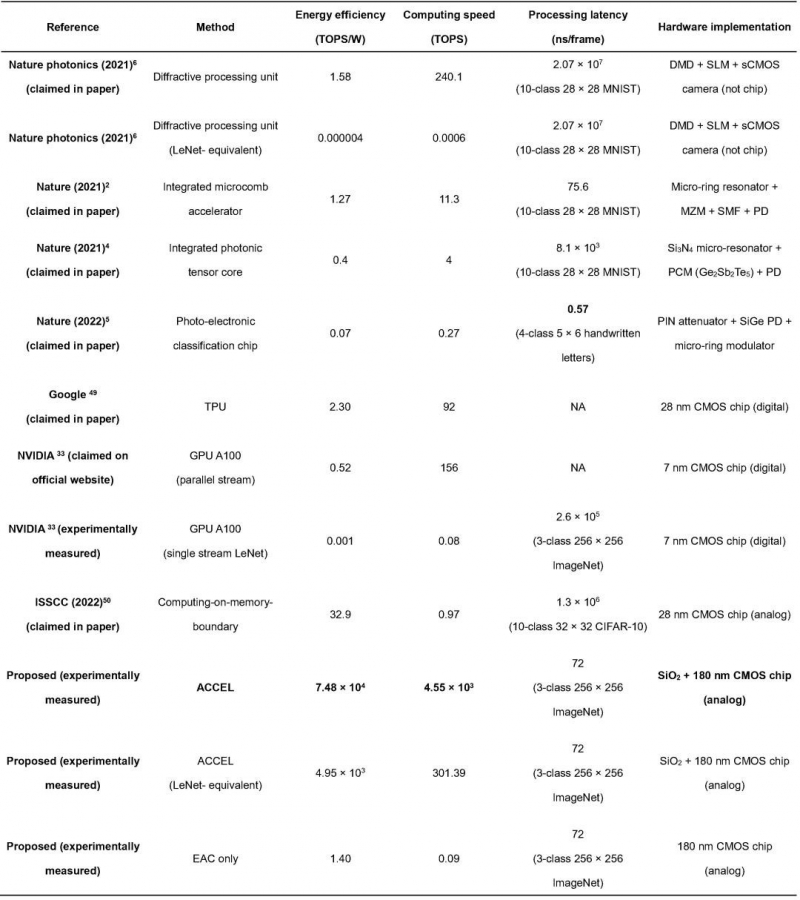

Системная энергоэффективность выражается в способности производить до 74,8 квадриллиона операций в секунду при затрате 1 Вт мощности. Скорость вычислений — 4,6 пета-операций в секунду (более 99% выполняются), а это более чем в три раза выше, чем у современных высокопроизводительных графических процессоров. Благодаря комбинации оптоэлектронных вычислений и адаптивного обучения ACCEL очень хорошо различает объекты на изображениях.

Разработчики чипа сравнили работу ACCEL и разных нейросетей, реализованных на современном графическом процессоре NVIDIA A100 для той же задачи. Результаты тоже заслуживают внимания. Так, при последовательной обработке изображений ACCEL достиг задержки 72 нс/кадр и энергопотребления 4,38 нДж/кадр. Это гораздо меньше, чем у чипа от NVIDIA, который упоминался выше. Так, у NVIDIA A100 задержка и энергопотребление составляют около 0,26 мс/кадр и 18,5 мДж/кадр соответственно.

Если взять результаты по скорости вычислений и энергопотреблению, то в ходе лабораторных испытаний ACCEL достиг скорости вычислений в 4.6 петафлопс (PFLOPS), что в 3000 раз быстрее, чем у широко используемого коммерческого AI-чипа Nvidia A100, при этом потребляя в 4 миллиона раз меньше энергии. После тестирования технологии ученые выяснили точность. Она составила 85,5% для задач Fashion-MNIST, 82% для 3-классовой классификации ImageNet и 92,6% для задач распознавания покадрового видео.

Команда ученых также сообщила, что чип неплохо работает даже в условиях низкой освещенности, что дает возможность применять аналоговый процессор в портативных устройствах, автомобилях с автопилотом и промышленных системах.

Кто разработал чип и какие у него перспективы?

Кроме учены из Университета Цинхуа, к разработке причастны компания MakeSens, соучредителем которой является один из исследователей проекта, государство и некоторые другие участники рынка.

Все они считают, что разработка — отличный задел на будущее. По словам разработчиков, важнейшая задача в отношении нового чипа — использование новой технологии для решения различных задач, отвечающих «важнейшим потребностям общества». Также разработчики уверены в том, что ACCEL не стоит рассматривать в качестве усиления фрагментации рынка. Скорее он приближает нас к будущему гетерогенных вычислений, одновременно направляя вектор развития полупроводников в сторону создания специализированных устройств для удовлетворения конкретных потребностей, в противовес универсальным решениям.

Кроме того, исследователи уверены, что производительность чипа может быть дополнительно оптимизирована путем улучшения процесса производства или использования более дорогих технологий с размером элементов менее 100 нанометров. ACCEL (его EAC-модуль, «мозг» всей системы) был разработан по 180-нм техпроцессу, тогда как тот же GPU A100 от NVIDIA — по 4-нм техпроцессу.

Читайте также

Комментарии (79)

Dynasaur

05.11.2023 16:29+12Системная энергоэффективность выражается в способности производить до 74,8 квадриллиона операций в секунду при затрате 1 Вт мощности. Скорость вычислений — 4,6 пета-операций в секунду

О каких операциях идёт речь, если он полностью аналоговый? Если вы меряете напряжение аналоговым вольтметром, то он вам постоянно показывает текущее напряжение, нет никаких операций.

MRD000

05.11.2023 16:29+6У меня была другая мысль. Они говорят, что сравнивали с NVidia, но тот час вопрос: эквивалетно ли это или нет. И что если понадобится изменение, программу в GPU можно изменить легко (зависит от сложности конечно), а вот эту аналоговую систему можно ли перепрограммировать? Или это прототип с "зашитым" алгоритмом.

Т.е. вопрос, отличается ли эта оптическая система от специализированного чипа? Или оно может быть перепрограммировано? Или перепрограммирование - следующий этап?

Aelliari

05.11.2023 16:29+6Не эквивалентное сравнение изначально. Аналоговые вычислители - не новость, хотя современные коммерческие - редкий зверь. По сути эта штука непрерывно в реальном времени выполняет какую-то функцию «аналогово», а электроника оцифровывает результаты с какой-то частотой. Хорошо если «функцию» ещё можно перестраивать на лету (думаю в определенных пределах - должно быть), но даже так - оно остается довольно узкоспециализированной штукой. Nvidia же - возьмет математикой

Dynasaur

05.11.2023 16:29+5Нейронные вычисления это и есть специализированная штука. На лету вы меняете веса, а структура сети в процессе обучения не меняется. "электроника оцифровывает результаты с какой-то частотой" :-))) Эхх, порождение цифрового века :-) Даже не представляют, что аналоговый результат сам по себе результат, и без оцифровки :-)))

Aelliari

05.11.2023 16:29+1Увы, мы действительно слишком погрязли в цифре, «аналоговый» результат - может оказаться достаточным, но даже его нужно как-то преобразовать и отобразить (применить). Аналоговые вычислители не дают пока такой же гибкости (или правильнее сказать простоты построения систем?) как цифра, в итоге имеем - вот такое вот, но в любом случае сабж - это стык двух миров

P.S. Если аналоговую функцию можно перестраивать на лету - то там ведь гарантировано этим занимается цифровая обвязка

le2

05.11.2023 16:29+6отнюдь. Персептрон Розенблата весил 10 тонн. Это был набор из переменных резисторов совмещенных с электродвигателями. То есть первое самообучение работало без цифры.

V_Scalar

05.11.2023 16:29+1В конце 80 читал в журнале техника молодёжи про устройство типа электронная пушка светит на экран- приёмник, у него было необычное свойство к распознаванию за счёт неопределённости волновых функций электронов. Кто знает как оно называлось?

Greenback

05.11.2023 16:29«аналоговый» результат - может оказаться достаточным, но даже его нужно как-то преобразовать и отобразить (применить).

Например китайский бражирующий боеприпас в процессе погони за вами может аналогово шевелить элеронами, тратить минимум энергии на суперзрение и стоить сто юаней.

Перспективно ;-)

Dynasaur

05.11.2023 16:29Если аналоговую функцию можно перестраивать на лету - то там ведь гарантировано этим занимается цифровая обвязка

да нет же! Занимается этим "программист" ручками. Перетыкает проводки и подкручивает потенциометры.

Aelliari

05.11.2023 16:29Очень эффективно, да, на прям на лету. Тогда может цифра все же будет быстрее? Чем пока программист физически все перенастроит коммутацию связей?

Такие микросхемы - это стык, программа для цифры занимается перенастройкой аналоговой функции изменяя связи, я уже приводил ниже пример Enlight256

Dynasaur

05.11.2023 16:29а в цифре программа прямо из мозга программиста берётся? Или он ручками кнопки давит? И ещё мышь катает?

sophist

05.11.2023 16:29На лету вы меняете веса, а структура сети в процессе обучения не меняется.

Могу ошибаться, но вроде бы структура нейросети как раз и определяется весами. Потенциально все узлы связаны со всеми, а отсутствие связи -- это просто связь с весом 0.

MountainGoat

05.11.2023 16:29+1Вот. А если результат на выходе сэмплировать с большой частотой, а цифровую систему заставить обсчитывать столько же раз, то можно уверенно получать результаты "в 10 000 раз быстрее Nvidia".

RalphMirebs

05.11.2023 16:29+4Ещё 60 (+/- сколько то) лет назад назад применялись функциональные лампы, вычисляющие некоторую функцию, просто за счет ослабления электронного пучка на матрице (пластине) определённой формы.

Dynasaur

05.11.2023 16:29+5Мне немного довелось помоделировать на АВМ (аналоговая вычислительная машина) - не знаю насколько этот чип на неё похож. "программируется" - это идеология именно ЦВМ, АВМ вместо программирования использует соединение звеньев с элементарными функциями в цепочки, чем достигается моделирование поведения любой системы. Например, управляемой ракеты. Вместо программирования вы меняете параметры и соединения входов с выходами звеньев. То есть гибкость та же, но принцип иной. И круг решаемых задач сильно уже. Например, на АВМ невозможно обрабатывать текст. А вот моделировать переходные процессы в сложных системах - пожалуйста!

diakin

05.11.2023 16:29Мне немного довелось помоделировать на АВМ

Были такие. На лампах. Лабы какие-то на них были.

johnfound

05.11.2023 16:29+3Например, на АВМ невозможно обрабатывать текст.

Вы удивитесь, но ЦВМ тоже не могут обрабатывать текст. Они думают, что это числа и обрабатывают их. На АВМ так тоже можно, но никому не захотелось.

Dynasaur

05.11.2023 16:29+1хотел бы я посмотреть на такой текстовый редактор на АВМ

johnfound

05.11.2023 16:29Ну, если АВМ остались в мейнстриме, то обязательно был бы. Конечно их архитектура была бы очень не похожая на то что мы сейчас называем АВМ.

Yak52

05.11.2023 16:29Например, потоковый редактор типа юниксового sed как раз вполне реализуем.

NiTr0_ua

05.11.2023 16:29реализуем-то реализуем, только вот в процессе его работы не факт что текст не исказится... это все равно что QLC флэш использовать без алгоритмов коррекции ошибок...

johnfound

05.11.2023 16:29не факт что текст не исказится...

Не забывайте, что буквы конечное множество а у аналогового сигнала бесконечное количество значений. Избыточность кодировки запредельная. Надо просто шумы держать в нужных границах. ;)

NiTr0_ua

05.11.2023 16:29оно-то так в теории, на практике - аналоговые вычислители вымерли примерно в 60-х годах прошлого века. по причичне низкой точности. аналоговая флэш-память (была такая, да) ушла туда же в 90х - по той же причине.

и да, шумы держать в нужных границах - обычно можно только в теории...

johnfound

05.11.2023 16:29Так, флэш памети и до сих пор аналоговыми и являются. А то что аналоговые компьютеры вымерли, это совсем не из за низкой точности. У них другие, фундаментальные проблемы, которые нелегко решить. А цифровые компьютеры простые и предсказуемые. Поэтому и развивались.

NiTr0_ua

05.11.2023 16:29нет, флэши вполне дискретные с малым количеством уровней. я же говорил об аналоговых ISD17xx...

gev

05.11.2023 16:29Исползуя эту особенность флэш-памяти, как раз, и делают сейчас аналоговые чипы для нейронок

1CHer

05.11.2023 16:29+1С помощью АЦП идёт вывод числа! 0 вольт - 0, 0.1 вольт - единица, 0.25 - 2.5, 10 вольт - число 10. Это сильно утрирую. Аналоговые вычислители ещё в СССР были и по ним СССР сильно двигался вперёд. До сих пор много техники на этих принципах летает, радары бдят и т.д. По сути вся музыка это аналоговые вычисления, смешанные с цифровым в последнее время.

Dynasaur

05.11.2023 16:29+8Вообще аналоговые нейроны должны быть более эффективны, чем цифровые, ибо это всего лишь веса и некие простые функции их преобразования. Аналоговые нейроны действительно вычисляют свои функции быстрее и эгнергоэффективнее, видимо эта технология и победит

gev

05.11.2023 16:29+6Ток ошибка аналоговая накапливается

Dynasaur

05.11.2023 16:29+5в случае нейронных технологий это минусом не является, ибо сам процесс обучения - это некий подбор весов по принципу "похожести" на нужный результат. Собственно, цифровые нейроны лишь имитируют аналоговое поведение. То есть им изначально присуща эта аналоговая "ошибка"

azTotMD

05.11.2023 16:29+4цифровая ошибка тоже может накапливаться https://habr.com/ru/companies/kryptonite/articles/766294/

riv9231

05.11.2023 16:29+1Это не проблема, хотя бы в свете того, что например, если взять время осознанной реакции человека в 300-500 мс, то учитывая характерную задержку срабатывания нейрова, что осознанная реакция происходит не более чем за 100 шагов "программы" нашей нервной системы. Это не очень-то и много. Тем более, что я читал, что человеческие нейроны, вообще обладают двухбитной точностью: 0, 1, 2 и 3 спайк-импульсов, которые примерно соответствуют таким шаблонам распознавания: 0 - это точно не то, 1- может быть это то, 2 - это то, 3 - это, без сомнений, точно то самое!

kryvichh

05.11.2023 16:29+1В нейронах человеческого мозга тоже ошибка на ошибке, и ошибкой погоняет. Тем не менее, мы как-то справляемся.

sena

05.11.2023 16:29+5использование новой технологии для решения различных задач, отвечающих «важнейшим потребностям общества»

Быстродействие и энергоэффективность - то чего не хватает видеопроцессорам чтобы быть установленными на военных дронах и сделать их автономными, без толстого видеоканала к оператору. Такие видеопроцессоры, если они появятся, обеспечат создание нового поколения дронов, которые смогут автономно искать цель. Не уверен, является ли это важнейшей потребностью общества, но ситуацию на поле боя это изменит радикально.

jpegqs

05.11.2023 16:29+8Я думаю что Китай будет это использовать для своей системы слежения за собственными гражданами. У них на каждом столбе стоит десяток камер направленных во все возможные стороны. Видимо уже не хватает мощностей чтобы всё это обрабатывать. А про "потребности общества" - это типичная подмена понятий, потому что потребности общества определяет партия.

MAXH0

05.11.2023 16:29+25Разумеется... Отсталые китайцы не будут искать полезные ископаемые на спутниковых снимках, не будут строить беспилотные автомобили, не будут анализировать рентгеновские и УЗИ-снимки. Они будут шпионить за своими гражданами. Они и чип придумали, потому что отсталые и не хватает мощностей. Вот и тех. процесс чипа отсталый.

jpegqs

05.11.2023 16:29Беспилотные автомобили у них активно развиваются, так что могут и использовать со временем. Но для обработки видео со всех их камер используют в первую очередь.

truthseeker

05.11.2023 16:29+2Так одна "потребность общества" не отменяет наличия других, а потому говорить, что чип нужен только для закрытия одной "боли" явно не верно. Естественно вопросы безопасности(как внутренней разведки, так и работы тех же дронов) превалируют над вопросами наживы и комфорта, но они не единственные. Бизнес найдёт множество применений этому чуду. Чувствую, что уже через пару лет оно может оказаться в том числе и в составе каждой китайской SoC для планшетов и смартфонов. И в системах типа "умный дом", и на фабриках, и много где ещё.

Dynasaur

05.11.2023 16:29-3Разве распберри-пиай не достаточно, чтобы отличить танк от котика?

Hardcoin

05.11.2023 16:29Проблема, на самом деле, не в инференсе, а в обучении. Научить нейросеть отличать огневую точку, замаскированную на границе леса по спутниковому снимку пока трудно. Отличают, но точность далека от идеальной.

PanDubls

05.11.2023 16:29А вот это, я думаю, вопрос практики. Если кто-то озаботился тем, чтобы по крайней мере часть тех дроны, которые вернулись на базу после выполнения боевой задачи в некоторых текущих конфликтах, сливали отснятые в процессе видео в какую-то базу, то уже очень скоро накопится приличная выборка. Останется посадить миллион китайцев её размечать, у военных бюджеты немеряные, и следующее поколение Дронов будет на голову круче.

Dynasaur

05.11.2023 16:29Видео и так полно даже с невернувшихся дронов. И размечать китайцами ничего не надо, всё делается иначе. Синтезируется картинка, типа компьютерной игры, где по полю/лесу/городу в разное время суток и в разных погодных условиях бегают, катаются, ползают пехотинцы, танки, пушки и пр. Всё уже размечено на момент генерации сцены. Это подаётся на вход обучения.

ivanstor

05.11.2023 16:29Что-то в этом роде было в 70-х. Использовали вычисления на магнитооптических пленках, если не ошибаюсь. Они были перестраиваемые. Получали двумерную фильтрацию и как раз распознавание. Мелькало в литературе. Сейчас на новом витке вернулись. Наверное.

MAXH0

05.11.2023 16:29+1У меня в чулане лежит интересная статья... «Как создать оптический мозг».. Это случайно не об этом?

Mike_666

05.11.2023 16:29+40Очень похоже на классическое изнасилование журналистов учеными (начиная с англоязычных популярных заметок).

Если примитивно: этот чип реализует нейронку для классификации изображений, причем:

N первых слоев нейронки (задача классификации) выполняются когда свет проходит через несколько слоев со специальным образом сформированной дифракционной картиной - это называется ОАС. ( Тут не происходит пета операций над числами (Но чтобы смоделировать этот процесс в реальном времени на классическом cpu, понадобилось бы производительность им эквивалентная))

Электронная часть чипа обрабатывает выход ОАС уже в пространстве признаков (матрица всего 32х32) и т.к. матрица небольшая делает это очень быстро выдавая результат классификатора

Судя по статье системе не требуется специальной подсветки объекта - и это действительно удивительно - можно использовать с обычными объективами.

Итого:

Это ни разу не аналог nVidia A100. Это чип который может решать задачу классификации (и возможно близкие задачи) изображения и делает это очень хорошо, с минимальным энергопореблением и задержкой.

За правильной и подробной информацией нужно обращаться к первоисточнику.

rPman

05.11.2023 16:29чуть получше, это ускорение операций над матрицами, это не только задачи классификации, и кстати большая часть вычислений, задействованных в нейронных сетях могут быть таким образом оптимизированы (правда операции нужно будет в железе реализовать)

xsevenbeta

05.11.2023 16:29Это ни разу не аналог nVidia A100. Это чип который может решать задачу классификации (и возможно близкие задачи) изображения и делает это очень хорошо, с минимальным энергопореблением и задержкой.

Вот именно этого и хотелось бы видеть в статье, причём выделенным жирным. Потому что при прочтении возникает вопрос, может ли чип помимо классификаций изображений этого заниматься чем-либо ещё.

Dynasaur

05.11.2023 16:29осталось найти первоисточник. И желательно не на китайском.

Mike_666

05.11.2023 16:29Можно начать со статьи в Nature: https://www.nature.com/articles/s41586-023-06558-8/

Dynasaur

05.11.2023 16:29там написано то же, что и тут (или тут то же, что и там) - та же ахинея про какие-то операции

mishkin79

05.11.2023 16:29Пространственный модулятор света похоже на MEMS сделан. https://www.nature.com/articles/s41378-023-00498-z - Integrated silicon photonic MEMS. По крайней мере в оригинальной статье он упоминается без самой технологии. Сама идея многократно публиковалась.

balamutang

05.11.2023 16:29+8М-м-м, теплые аналоговые вычисления. Все равно что сказать что примочка дисторшн по мощности равна процессору компа, который обсчитывает аналогичное искажение сигнала в эмуляторе.

nick-for-habr

05.11.2023 16:29+6Ооо, аналоговые компьютеры (тогда называли вроде вычислители) показывали нам в лётном училище в 90-х на курсе бортового оборудования. Толком особо не помню уже, да и кто там будет будущим лётчикам технические подробности излагать - нечего им голову ерундой забивать ))

Если правильно запомнил - то сей девайс позволял решать узкий спектр задач, но зато очень быстро, считай что "мгновенно" - аналог жеж. На вход подавались начальные данные в виде разных уровней напряжения, а вычислитель "преобразовывал" (а не "вычислял", по этому и быстро) их в результат.

Сейчас видимо с развитием микроэлектроники китайцы наследие "большого брата" не забыли, и впихнули в микросхему, приспособив для решения актульных задач.

В целом выглядит логично и перспективно, выстрелит или нет - тут кто знает. Но такие вещи обычно под конкретную задачу делают, это не универсальный процессор. Видимо задача для этого у них есть.

GidraVydra

05.11.2023 16:29Число операций в секунду в аналоговом оптическом преобразователе? Ну-ну.

Aelliari

05.11.2023 16:29+1Там стык с цифрой, и именно скорость оцифровки результата аналоговой части (или предел скорости управления аналоговой функцией) ограничивает производительность

Rampages

05.11.2023 16:29+3Ох уж эти заголовки и китайцы с их манией все гиперболизировать (3000(!) раз).

Вспомнилось видео, где один китаец другому говорит:

– помнишь своего кузена Тимми? у него уже 15 лет рабочего опыта! и ему 9 лет!

– как это возможно!?!?

– он работает одновременно в 5 местах!

...

– ты слушаешь lo-fi, а что делать Тимии, если он хочет слушать музыку?! – он сам должен ее играть!

...

– он капитан футбульной команды, должен бегать в 150 градусную жару! босиком! по снегу!

????

и вообще вспоминаются мемы с "high expectations chinese dad":

тебе 5 лет? в твоем возрасте мне уже было 6 Ладно, если серьезно. то мне кажется тут больше про цифровое зрение и фотоматрицы, нежели остальное.

UPD. нашел видео про кузена Тимми:

iShrimp

05.11.2023 16:29У аналоговых вычислений есть одна проблема - воспроизводимость.

И она может проявляться в двух аспектах: воспроизводимость результата (когда при одинаковых входных данных НС должна выдавать один и тот же правильный ответ), и воспроизводимость ошибки (если в каких-то случаях НС отвечает неправильно, то ошибка должна быть повторяема и локализуема).

При переносе аналоговых данных на другое устройство часть информации теряется, и нейронная сеть начинает работать немного иначе. Но если первую проблему можно частично решить, увеличивая число нейронов и улучшая качество обучения, то с отладкой могут возникнуть серьёзные проблемы. Так как если даже обычная цифровая НС с алгоритмической точки зрения представляет собой чёрный ящик, то аналоговая НС - это просто чёрная бездна, в которой баги могут возникать из ниоткуда.

rPman

05.11.2023 16:29+1Нейронные сети, идеальное место для использования ненадежных вычислителей, они очень устойчивы к ошибкам такого рода за счет кошмарной избыточности.

Отличный пример - понижение битности и квантизация, это выглядит абсурдом, что начиная с 32 и 16 бит на числа с плавающей точкой доводят его до 8бит (буквально) и качество ответом языковой модели падает на сотые доли процента (есть метрики которые это оценивают, perplexity, по ней можно точно изучать, иначе количество тестов абсурдно высокое должно быть, напоминаю что gpt активно использует случайность для выбора токенов) но затем идут дальше и понижают среднее количество бит на веса в 4 бита, 3 бита и видел 2 бита (правда качество результата падает но все еще работает в каких то условиях)

Например llama2 с квантизацией 5 бит вполне юзабельна и даже не заметно что что то не так.

Opaspap

05.11.2023 16:29до ДВУХ квантизируют и 4 - обычно юзают для генерации. Вот типичный пример квантизированной модели https://huggingface.co/TheBloke/Mistral-7B-v0.1-GGUF#provided-files

upd: упс какк то пропустил середину, ладно пусть останется как пример.

RolexStrider

05.11.2023 16:29Где-то было. Быстродействие - в (подставьте практически любое значение, ограничение - скорость света в среде) раз относительно nVidia

Johan_Paul_2

05.11.2023 16:29Нервосеть новость писала... У меня возник только один вопрос к нервосети-ньюсмейкеру: как может быть примерно равным количество операций в секунду для аналогового и цифрового ЦП, если принцип аналогового представления информации требует на порядки большего количества входящих данных?

ivankudryavtsev

Всем срочно избавляться от акций Nvidia - все пропало.

GospodinKolhoznik

Голосом дяди Фёдора: Чтобы продать акции Nvidia, надо сначала купить акции Nvidia, а у нас денег нет.

sensem

"А у нас теперь и СПБ Биржи нет".

NickDoom

Сча Нвидия выкатит какую-нибудь GDDR N+1, в которой по команде с GPU происходят операции с половинной точностью прямо в RAS/CAS… Прочитали такие всю строку, рефрешнули обратно, а потом, вместо того, чтобы выдирать оттуда крошечный участок данных и передавать процу — прочитали вторую строку прямо на второй вход сумматора (или умножителя). А рефрешнули уже результатом операции, распараллеленным до длины строки, делённой на длину числа с половинной точностью.

А строки там ооооой какие длинные… и банков памяти тоже больше одного… и чипов на плате куча… да никакие burst mode даже рядом не стояли со скоростью потенциально возможных операций внутри DRAM. Бах-бах, две текстуры сложили, бах-бах, на освещённость умножили, ну или бах-бах, слой нейронов умножили на матрицу весов…

gev

Такое уже делают только внутри флэш и аналоговым способом, я ниже сылку постил

mad_god

Adobe Flash? Ну наконец-то, не будет тормозить!