Недавно на Хабре проскакивал пост vfdev-5 о DIGITS. Давайте поподробнее разберёмся что это такое и с чём его едят. Если в двух словах. Это среда, которая позволяет решить 30-50% задачек машинного обучения на коленке в течении 5 минут. Без умения программировать. Ну, при наличии базы, конечно. И более-менее адекватной карточки от NVIDIA.

Где взять

Официальная страница. Качается потом всё отсюда. Там же инструкции. Официально поддерживается Ubuntu 14 и Ubuntu 16. Есть deb-пакет для 14ой убунты и докер для неё же. Под 16ую — инструкция по сборке. Собирать нужно сначала caffe, потом DIGITS. Развлекуха где-то на пару часов.

Что такое в трёх словах

DIGITS — это визуальная Front-end обёртка для известных фреймворков (caffe и Torch 7). Позволяет из коробки обучать/дообучать известные/свои сетки. Есть большое число подготовленных кейсов.

По форм-фактору, это веб-сервис который запускается в терминале и доступен потом по адресу «localhost:5000/» на локальной машине. выглядит вот так:

Почему-то навевает Юпитером. Плюс, оно похоже на TensorBoard. К сожалению, я не работал с ним много чтобы сравнить.

Как работать с этим чудом

На главной есть всего две большие кнопочки. Они то нам и нужны. Сначала нужно ткнуть в «New Dataset»:

По умолчанию DIGITS умеет работать с датасетами заточенными под:

- Классификацию — обучается распознавать принадлежность N классов изображений

- Поиск объектов — обучается искать прямоугольник объекта на изображении. Завтра я опубликую более подробную статью про этот кусок.

- Сегментацию — пиксельная сегментация изображения. Есть тьюториал, но я не разбирался.

- Процессинг — Не совсем понял что это. Тьюториалов тоже нет.

Рассмотрим классификацию, как самый простой из вариантов.

На этапе подготовки датасета digits пережимает базу в удобный для себя формат, чтобы быстро работать с ним, не напрягая хард миллионами запросов. В принципе, всё ясно:

- Блок слева — описывает в каком формате будет подготовлено изображение. Стандартное правило machine learning: оно должно выглядеть так, чтобы человек успешно распознавал любое изображение из базы. Не больше и не меньше.

- Блок справа про базу. Там нужно показать где лежит база. Есть два варианта данных, которые DIGITS может пережевать. Первый формат: N папок, в каждой папке свой класс. Второй формат: изображения лежат где угодно, но есть текстовый файл формата "<путь> <имя класса>". % for validation — какая часть базы будет использоваться для тестирования во время обучения. %for testing — сколько используется для итогового тестирования.

- Блок снизу — формат базы, которую DIGITS подготовит для себя. По сути пользователя это мало касается.

Результат создания базы будет динамично отображаться. А так же будет выведена итоговая статистика по базе:

Создание базы завершено! Можно перейти к обучению. Переходим в главное меню и вместо «New Dataset» тыкаем «New Model». Опять выбираем Classification. Здесь параметров чуть больше (1,2). Обязательно нужно выбрать:

- Подготовленную базу в графе Select Dataset

- Используемую сеть

Есть куча более тонких настроек:

- Количество эпох обучения (сколько раз прогонится база)

- Настройка сохранения и тестирования

- Параметры алгоритма спуска: скорости спуска, их изменение по ходу обучения

- Возможность настройки сети: можно изменить существующую, а можно задать свою

- Простейшие приращения датасета: кроп, вычитание среднего

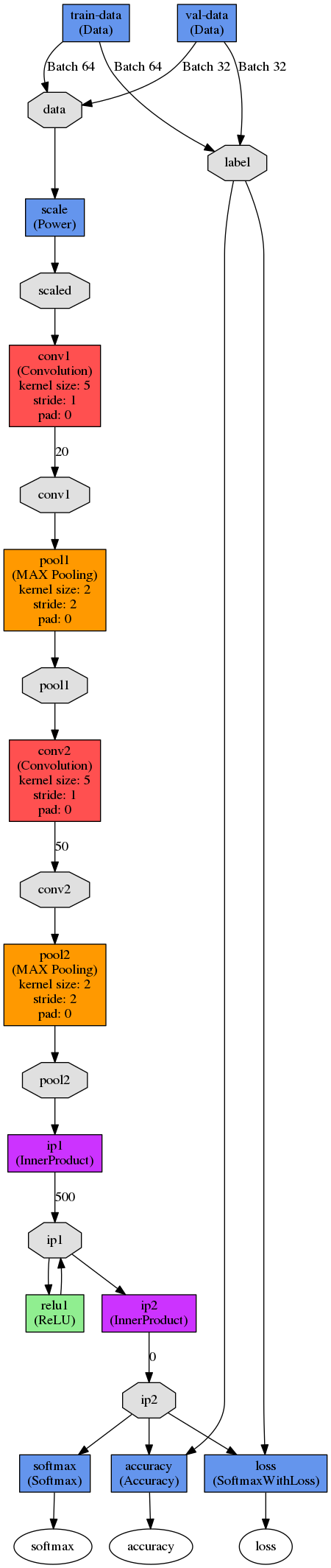

Можно посмотреть как выглядит текущая сеточка:

Запускаем

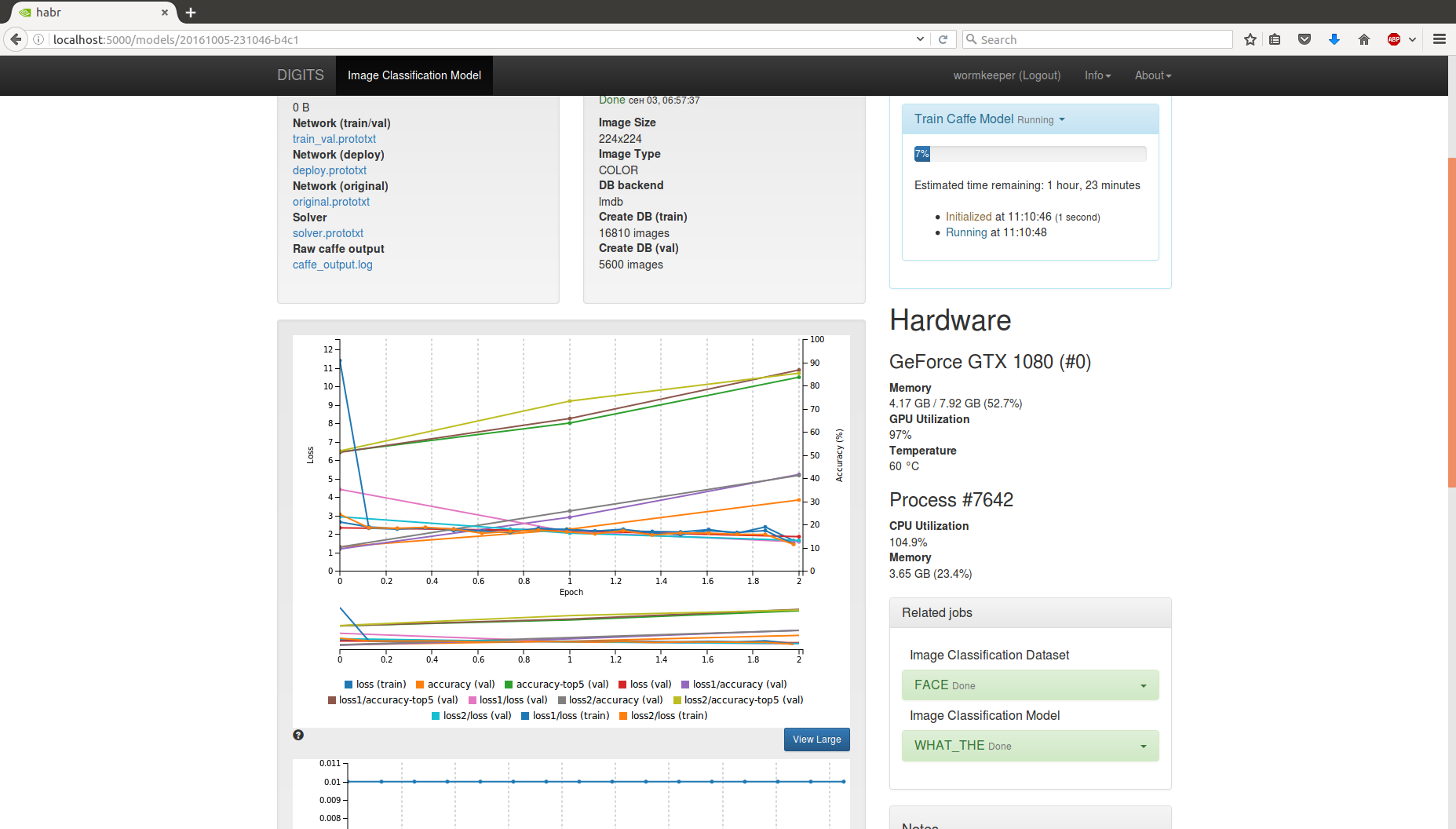

Ваш компьютер виснет в мёртвую. Зато вы видите красивые онлайн графички идущего обучения, оценку времени, текущий результат, и.т.д.:

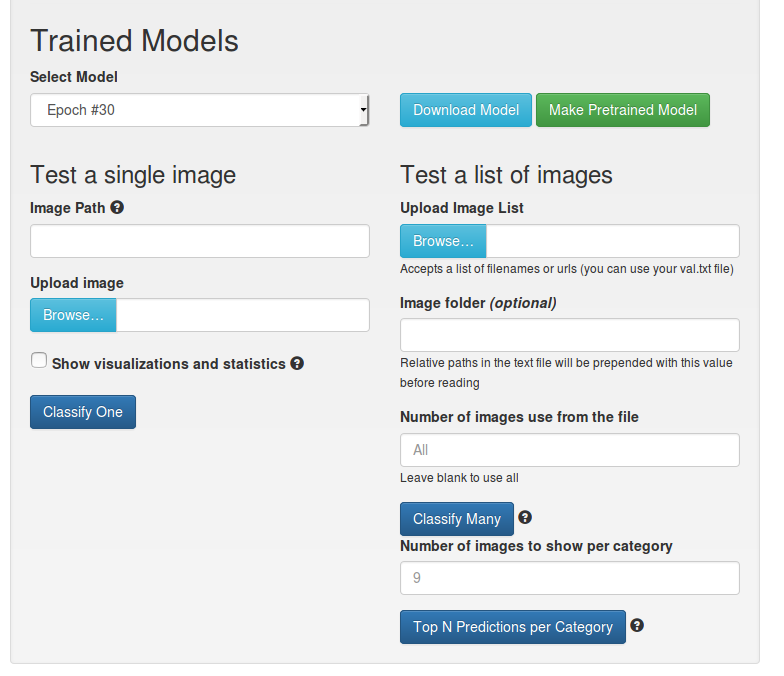

После окончания обучения появляется менюшка, которая позволяет сохранить итоговую модельку, распознать одно/несколько изображений. Построить статистику.

Можно отправлять в продакшн;)

Что ещё

В DIGITS ещё неплохая сетка для детектирования объектов (описания: 1, 2). Завтра я выложу отдельную коротенькую статью на её счёт. Там, к сожалению, не всё так хорошо как хочется.

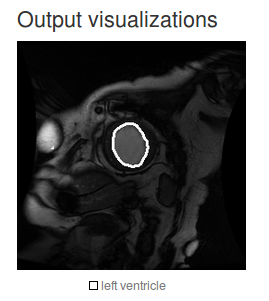

Имеется возможность настроить корректную пиксельную сегментацию. Но у меня сейчас есть настроенные решения — это не очень интересно. А так, целый пример по работе с DICOM изображениями:

Решение позиционируется как пригодное для задач сегментации по медицинским данным.

Выводы

Уровень знаний необходимый для работы с нейронными сетями потихоньку падает ниже плинтуса. Наверняка есть другие аналоги, или появятся в ближайшее время. Тот же TensorBoard.

Это не значит, что получаемое решение — качественное. Но оно может весьма неплохо работать в некоторых ситуациях. Конечно, хороший тьюнинг, подборка метода, ручная настройка сети — могут значительно улучшить производительность. Но чтобы показать прототип может хватить и DIGITS.

По мне — получился весьма годная обёрточка. Но, что-то его nvidia особо не пиарит и мало поддерживает.

Комментарии (22)

Breads

18.10.2016 04:39Уровень знаний упал до «скачал — включил — распознал» уже с появлением caffe, мне кажется. Но, в любой нестандартной ситуации, все-равно необходимо ковырять внутренности в независимости от того, какая библиотека используется.

tomzarubin

18.10.2016 08:53+1Так работает если надо понять «котик на картинке или Петя». В конкурсах kaggle такое уже не сработает, в SDC тоже, в медицине аналогично. Т.е., побаловаться да— можно дёшево и имея поверхностное представление о том что делаешь.

Strepetarh

18.10.2016 17:21Баловство баловством, но тем не менее какую-нибудь Призму уже можно сделать не разбираясь особо в том, как нейросетки работают, а просто форкнув открытый репозиторий с гитхаба и припилив его к веб-сервису и мобильному приложению.

tomzarubin

20.10.2016 11:23Не согласен дважды.

Во-первых, с тем, что Призма— не баловство.

Во-вторых, что и её можно сделать не разбираясь особо. В копировании стиля художников больше «математики», чем «кода». То же выделение признаков. Не обладая знаниями теории это невозможно: скопировать мазки, цвета, паттерны. И как это превратить в фичи и засунуть в архитектуру сети, ну а потом реализовать в коде.

Strepetarh

20.10.2016 13:37Конечно, style-transfer это сложная математическая задача, бесспорно. Я про то, что разработчики Призмы её не решали (насколько я знаю), а использовали уже готовое решение. А под не-баловством я подразумевал, что это конечный продукт, который может заинтересовать пользователя (пусть даже и в развлекательных целях).

k2m30

18.10.2016 07:18+3А есть что-то такое для text processing/generation?

ZlodeiBaal

18.10.2016 20:19Я не знаю. Думаю, что есть просто собираемые фреймворки/экземплы. Но вряд ли это то, что NVIDIA и прочие игроки хотят на базовом уровне поддерживать.

platon23

18.10.2016 10:12+5Открыл статью, ушел пить чай на 15 минут, пришел, стал супер-мега-про машинного обучения! *profit*

SLASH_CyberPunk

18.10.2016 11:12+1Надо бы отметить, что это ML по графике и что 30-50% задач по ML, как то много для графики…

defecator

18.10.2016 11:28ни разу не понял следующий момент.

Ну обучил я сеть, всё пучком, но как использовать потом данные?

В какую сеть грузить?

ZlodeiBaal

18.10.2016 11:29Сегодня вечером будет пример в следующей статье. Там все просто, строчек 15кода.

Psychosynthesis

18.10.2016 19:36Вы её, пожалуйста, как-нибудь также пожелтее обзовите. Чтоб в глаза бросалось. Ну или сюда отпишите как запостите.

А то мне тоже не очень понятно, чё дальше-то с полученной моделью делать…

ZlodeiBaal

18.10.2016 19:57Так уже же! https://habrahabr.ru/company/recognitor/blog/312472/

Или заголовок не настолько жёлтым вышел?

Модель как использовать там в конце написано.

Nidirg

Интересно, такой инструмент можно применить в таком конкурсе от ФПИ?

Или потребуется больше времени чем 15 минут?

Конкурс

ZlodeiBaal

Боюсь ссылка не прикрепилась к вопросу. По лицам который? Нет, это немного другая задача. Для этого шаблона в DIGITS нет)

ZlodeiBaal

Ссылку увидел. Про сетку которая детектирует объекты я завтра расскажу. С ней не всё так просто.

А так, всё всегда зависит от датасета. Хороший датасет — можно сетку за пару дней запустить. Плохой — с ним можно месяц провозиться.