В декабре 2016 года компания «Облакотека», входящая в группу компаний МОНТ и специализирующаяся на организации и размещении частных облаков и ИТ-инфраструктур клиентов на собственной платформе и на платформе Windows Azure от Microsoft, объявила о запуске в России IaaS-сервиса «Виртуальная инфраструктура на Windows Server 2016».

Стоит отметить, что в компании с 2012 года развернута и эксплуатируется в коммерческом режиме IaaS-платформа на базе Microsoft Hyper-V 2012 R2 — два кластера (по одному в каждом ЦОД) с резервированием вычислительных узлов в режиме N+2.

Основой аппаратной составляющей нового сервиса IaaS на платформе Windows Server 2016 стали серверы Lenovo x3650 M5 и сетевое оборудование Mellanox.

Высокопроизводительное серверное оборудование Lenovo было специально протестировано и подготовлено для использования совместно с программной платформой Windows Server 2016. Для обеспечения высокой производительности развернута площадка на гиперконвергентной среде с флэш-массивом на базе технологии Storage Space Direct, позволяющем свести к минимуму задержки при работе с хранилищем.

Это одна из первых в России реализаций IaaS-сервиса на новейшей платформе виртуализации Microsoft Windows Server 2016. Сервис предоставляется в рамках инициативы Microsoft COSN Russia из дата-центров в России и дает уникальные возможности обеспечения безопасности и производительности виртуальных ресурсов. Управление им осуществляется через привычный интерфейс Windows Azure Pack, знакомый пользователям Microsoft Azure.

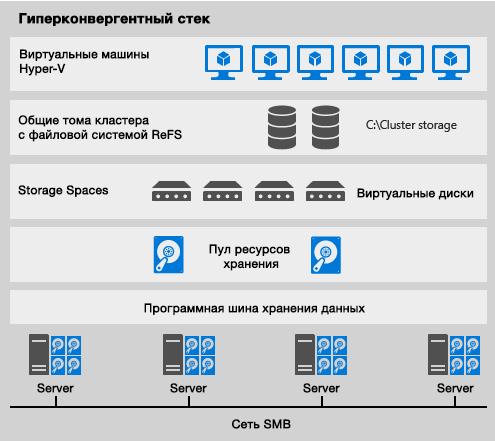

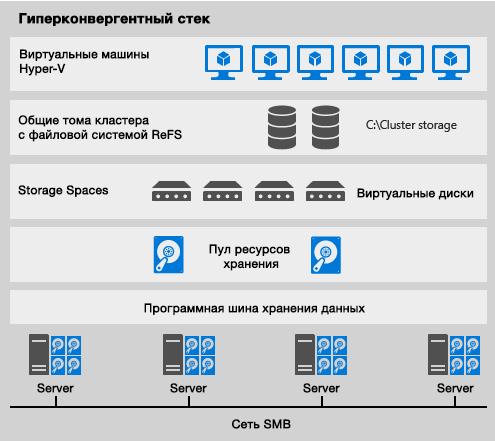

Гиперконвергентная платформа: кластер серверов для размещения виртуальных машин.

В частности, технология Shielded VMs обеспечивает надежную защиту данных виртуальных машин, в том числе от администраторов провайдера. Технология контейнеров значительно упрощает управление жизненным циклом ПО для разработчиков. Шаблоны виртуальных машин и Nano Server сокращают затраты, позволяют разместить множество ролей ВМ на минимальном количестве ресурсов.

Новая платформа имеет также встроенный сетевой балансировщик нагрузки, дает возможность динамически изменять емкость выделенной ВМ оперативной памяти и хранилища, задействованные ею вычислительные мощности, предлагает множество других инструментов. Теперь это полноценный сервис, включающий в себя как платформу виртуализации Windows Server 2016, так и возможности Windows Server 2016 на гостевых виртуальных машинах.

Новые энергоэффективные серверы Lenovo System x3650 M5 в корпусе 2U представляют собой производительные, масштабируемые и компактные платформы, построенные на 8-ядерных процессорах AMD и Intel, имеют оперативную память емкостью 768 Гбайт и используют твердотельные накопители SSD.

Особенности этой системы: диски и блоки питания с «горячей» заменой, различные варианты дисковой корзины, 9 слотов PCIe 3.0, возможность расширения функций RAID-контроллера.

Данные серверы востребованы в тех областях, где необходимо выполнение облачных приложений, производительных вычислений, доставки медиаданных и других задач. Серверы Lenovo System x3650 M5 рассчитаны на высокие рабочие нагрузки в режиме 24/7, нередко применяются для предоставления услуг хостинга, используются в качестве платформы виртуализации, серверов терминалов, распределенных и высокопроизводительных вычислений, серверов баз данных и приложений.

Серверы поддерживают централизованное управление ресурсами, обеспечивают надежное шифрование и защиту данных. Инструменты диагностики позволяет быстро находить и исправлять ошибки, а горячая замена вентиляторов и накопителей помогает при необходимости оперативно провести ремонт. Сетевая инфраструктура построена на сетевых адаптерах Mellanox ConnectX-4 Lx Dual Port и коммутаторах SN2100 (с портами 100GbE).

Сетевой контроллер ConnectX-4 Lx EN с поддержкой коммутационных решений для Ethernet с пропускной способностью 1/10/25/40/50 Гбит/с спроектирован для решения задач виртуализованных инфраструктур и отличается наивысшей в своем классе производительностью для различных приложений и рынков. В этих адаптерах настоящая аппаратная изоляция ввода-вывода сочетается с масштабируемостью и эффективностью, что делает их экономичным решением для облачных инфраструктур, баз данных и платформ хранения данных.

ConnectX-4 Lx EN поддерживает скорости 1, 10, 25, 40 и 50 GbE, обеспечивает задержку менее 1 микросекунды и скорость передачи сообщений 75 млн пакетов в секунду. Они содержат аппаратную поддержку RDMA over Converged Ethernet, механизмов разгрузки протоколов Ethernet без контроля состояния, оверлейных сетей и технологии GPUDirect.

Мы попросили представителей «Облакотеки» рассказать о развертывании данных и об особенностях реализации проекта, позволившего предложить клиентам и партнерам самые современные технологии.

«Облакотека» — пока что единственный российский облачный провайдер, предлагающий IaaS-сервисы на базе Windows Server 2016?

Да, это так. На момент запуска сервиса в России не было ни одного провайдера, построившего сервис IaaS на платформе Windows Server 2016. Некоторые лишь поддерживали эту ОС в качестве гостевой на виртуальных машинах. По нашим данным, мы по-прежнему единственный такой провайдер, причем уже более полугода.

Почему в качестве платформы виртуализации были выбраны именно серверы Lenovo, в какой конфигурации? Какими средствами удалось добиться высокой производительности сервиса?

Идея создания сервиса возникла в августе 2016 года совместно с российским представительством Microsoft. Важнейшим требованием было наличие у вендора аппаратного комплекса, протестированного на совместимость с Windows Server 2016 в части развертывания гиперконвергентного кластера Storage Space Direct и поддержки Shielded VMs.

Кроме того, оборудование должно было быть поставлено в очень сжатые сроки поставки, по сути – со склада в Москве. Компания Lenovo отвечала всем этим требованиям, она уже имела опыт в развертывания подобного решения на своей платформе и готова была оказать нам необходимое содействие в выборе и настройке конфигурации серверов под данную задачу.

Совместно с Microsoft мы определили требования по конфигурации. В качестве подсистемы хранения данных было решено использовать только флэш-накопители и задействовать накопители NVMe для кеширования. Такой подход позволил добиться отличных показателей в производительности виртуального дискового массива.

Архитектуру решения разрабатывали специалисты «Облакотеки» совместно с российским представительством Microsoft. В проработке деталей проекта изучались рекомендации Microsoft и решения от Lenovo.

Какая роль отводится сетевой инфраструктуре? Чем был обусловлен выбор оборудования компании Mellanox? Какова пропускная способность сети? Какими средствами реализована SDN?

Для любого гиперконвергентного решения сетевая инфраструктура является важнейшим элементом. Все управление, обмен данными, восстановление после сбоя осуществляется через сеть и поэтому требования к качеству ее работы очень высокие. В случае с S2D (Storage Spaces Direct) требуется поддержка протокола SMB3. Наиболее полно она реализована в оборудовании Mellanox.

Выбранное решение позволило нам построить высокодоступную сеть передачи данных со скоростью до 50 Гбит/с на узел. Программно-конфигурируемая сеть (Software-Defined Networking, SDN) строится средствами операционной системы Windows Server 2016: она предусматривает роли контроллера SDN, балансировщика и остальные сопутствующие роли.

На базе высокопроизводительного оборудования Lenovo и Mellanox под управлением Windows Server 2016 реализована гиперконвергентная среда с SDNv2. В чем именно заключается гиперконвергентность платформы? В чем отличия SDN «нового поколения»?

Гиперконвергентная архитектура объединяет вычислительные ресурсы, сетевые ресурсы и ресурсы хранения в один уровень. Windows Server 2016 позволяет на одном и том же оборудовании развернуть службы управления хранилищем (SDS), сетью (SDN) и гипервизором (Hyper-V) в отказоустойчивом режиме. В отличии от предыдущей версии SDN, в новой добавились важные службы, например, балансировщик нагрузки — LoadBalancer (SLB).

У гиперконвергентных систем нет единой точки отказа, существуют широкие возможности горизонтального масштабирования: если требуется нарастить ресурсы и производительность кластера для работы дополнительных ВМ, а также увеличить емкость и производительность хранилища, то достаточно просто добавить в кластер новые узлы. Вместо SAN используется обычная локальная сеть (SDN с RDMA). Поэтому нет необходимости покупать дорогие решения FC, FCoE или конфигурировать iSCSI. Благодаря новым функциям SDS и SDN с помощью Windows Server 2016 можно создавать гиперконвергентные решения для облака.

Расскажите о подсистеме хранения серверов с N2215 SAS/SATA HBA и пулом хранения данных, платах PCI NVMe, SATA SSD. Как она построена, используется ли тиринг?

Система хранения Storage Spaces Direct (S2D) построена на основе локальных накопителей с SSD NVMe для кэширования. Для S2D важно выполнять требования по аппаратной совместимости. Так для подключения дисков пула нельзя использовать RAID контроллеры (даже в режиме HBA). Поэтому применяются только совместимые HBA.

Поскольку у нас в пуле – только накопители SSD, то тиринг смысла не имеет. Согласно рекомендациям Microsoft для кеширования мы используем PCI-накопители с интерфейсом NVMe. Они заметно ускоряют операции записи по сравнению с обычными SSD.

Для обеспечения высокой производительности и с учетом всех особенностей новой операционной системы развернута площадка на гиперконвергентной среде с флэш-массивом на базе технологии Storage Space Direct. Расскажите о данной составляющей проекта.

Сегодня все большую популярность получает технология SDS (Software Defined Storage), программно-конфигурируемые хранилища. Множество вендоров предлагают собственные решения SDS (VMWare VSAN, HPE/Nutanix, Ceph и т.п.). В Windows Server 2016 корпорация Microsoft предложила свою версию SDS – Storage Space Direct (S2D). Она позволяет на обычных серверах с локальными накопителями разного типа построить высокодоступную, производительную систему хранения.

При этом можно использовать технологии классических СХД старших моделей – кеширование, тиринг, высокую доступность на уровне стоек и ЦОД. В случае гиперконвергентной конфигурации, серверы «видят» СХД как классический для Windows кластерный диск.

Если необходимо предоставить доступ к хранилищу внешним потребителям, то можно использовать классические технологии – iSCSI, SMB, NFS. На уровне виртуального диска можно контролировать параметры IOPS, определять верхние и нижние границы по количеству IOPS, нормализованных под нужный размер блока данных.

Какие именно возможности Windows Server 2016 уже востребованы или могут быть востребованы заказчиками? Как вы оцениваете перспективы защиты конфиденциальных данных заказчика от доступа со стороны сотрудников сервис-провайдера (Shielded VMs)? Какие задействованы новые технологии для более быстрого развертывания виртуальных машин и приложений?

Windows Server 2016 содержит много новаций. Новейшие встроенные компоненты защиты серверов в Microsoft Windows Server 2016 обеспечивают предотвращение атак и обнаружение подозрительных действий. Вопрос безопасности и защищенности данных для ряда пользователей очень важен. Причем угроза рассматривается не только внешняя, но и внутренняя, со стороны сервис провайдера. Теперь можно ограничить доступ к данным внутри виртуальной машины администраторам провайдера. Это поможет данной категории клиентов принять решение о переходе в облака. Shielded VMs — самый безопасный способ защиты ВМ арендаторов от злоумышленников с правами администратора.

Помимо Shielded VMs, наши пользователи-разработчики могут использовать технологию контейнеров. На мощностях с графическими ускорителями теперь можно комфортно работать с программами САПР, управления анимацией и т.п. без использования дополнительного ПО третьих фирм. Для администраторов появился Nano Server — самый безопасный режим выполнения Windows Server 2016, а также «встроенный» балансировщик Load Balancer.

Расскажите немного о ходе реализации данного проекта. Как все это создавалось, какие были трудности, что удалось решить, а что отложили в задачи «на перспективу»?

Самая главная проблема – скудность документации и средств диагностики. Большую часть времени мы потратили на устранение неисправностей, вызванных, казалось бы, незначительными ошибками в конфигурации драйвера сетевого адаптера. Мы очень плотно работали с командой поддержки Lenovo для выполнения серверами кластера требований службы Host Guardian Services (она используется Shielded VMs). А для запуска всех возможностей SDN активно общались со специалистами Microsoft.

Сейчас с каждым днем объем доступной информации растет, документация улучшается. Возьмись мы за проект сегодня – было бы проще.

До июня стенд работает в тестовом режиме. Каковы дальнейшие планы? Планируется переход с Azure Pack на Azure Stack? Что можно ожидать в этой связи?

Задача ближайшей перспективы – перевод основной инфраструктуры на Windows 2016 и дальнейшее развитие сервиса. Полноценный стенд с нагрузкой, близкой к реальной, — это отличная возможность пройти этапы обучения сотрудников и «детских болезней» технологии без ущерба для коммерческих клиентов.

Несмотря на сходство названий, Azure Pack и Azure Stack — совершенно разные платформы с принципиально разным подходом. В Azure Stack существенно больше сервисов, но возможностей контроля, кастомизации, управления и обеспечения качества со стороны провайдера существенно меньше. К тому же у Azure Stack принципиально новая модель монетизации и она ещё окончательно не определена. В общем, мы в настоящий момент считаем, что они не замещают друг друга, а скорее рассчитаны на разную целевую аудиторию.

Как вы оцениваете результаты проекта?

Мы всегда стараемся максимально оперативно предложить нашим клиентам и партнерам самые современные технологии, чтобы дать им конкурентные технологические преимущества. Гиперконвергентные решения на базе Windows Server 2016 и серверного оборудования Lenovo — простой и экономичный способ внедрения облака любого масштаба и развертывания современных облачных сервисов.

Стоит отметить, что в компании с 2012 года развернута и эксплуатируется в коммерческом режиме IaaS-платформа на базе Microsoft Hyper-V 2012 R2 — два кластера (по одному в каждом ЦОД) с резервированием вычислительных узлов в режиме N+2.

Основой аппаратной составляющей нового сервиса IaaS на платформе Windows Server 2016 стали серверы Lenovo x3650 M5 и сетевое оборудование Mellanox.

Высокопроизводительное серверное оборудование Lenovo было специально протестировано и подготовлено для использования совместно с программной платформой Windows Server 2016. Для обеспечения высокой производительности развернута площадка на гиперконвергентной среде с флэш-массивом на базе технологии Storage Space Direct, позволяющем свести к минимуму задержки при работе с хранилищем.

Это одна из первых в России реализаций IaaS-сервиса на новейшей платформе виртуализации Microsoft Windows Server 2016. Сервис предоставляется в рамках инициативы Microsoft COSN Russia из дата-центров в России и дает уникальные возможности обеспечения безопасности и производительности виртуальных ресурсов. Управление им осуществляется через привычный интерфейс Windows Azure Pack, знакомый пользователям Microsoft Azure.

Гиперконвергентная платформа: кластер серверов для размещения виртуальных машин.

В частности, технология Shielded VMs обеспечивает надежную защиту данных виртуальных машин, в том числе от администраторов провайдера. Технология контейнеров значительно упрощает управление жизненным циклом ПО для разработчиков. Шаблоны виртуальных машин и Nano Server сокращают затраты, позволяют разместить множество ролей ВМ на минимальном количестве ресурсов.

Новая платформа имеет также встроенный сетевой балансировщик нагрузки, дает возможность динамически изменять емкость выделенной ВМ оперативной памяти и хранилища, задействованные ею вычислительные мощности, предлагает множество других инструментов. Теперь это полноценный сервис, включающий в себя как платформу виртуализации Windows Server 2016, так и возможности Windows Server 2016 на гостевых виртуальных машинах.

Новые энергоэффективные серверы Lenovo System x3650 M5 в корпусе 2U представляют собой производительные, масштабируемые и компактные платформы, построенные на 8-ядерных процессорах AMD и Intel, имеют оперативную память емкостью 768 Гбайт и используют твердотельные накопители SSD.

Особенности этой системы: диски и блоки питания с «горячей» заменой, различные варианты дисковой корзины, 9 слотов PCIe 3.0, возможность расширения функций RAID-контроллера.

Данные серверы востребованы в тех областях, где необходимо выполнение облачных приложений, производительных вычислений, доставки медиаданных и других задач. Серверы Lenovo System x3650 M5 рассчитаны на высокие рабочие нагрузки в режиме 24/7, нередко применяются для предоставления услуг хостинга, используются в качестве платформы виртуализации, серверов терминалов, распределенных и высокопроизводительных вычислений, серверов баз данных и приложений.

Серверы поддерживают централизованное управление ресурсами, обеспечивают надежное шифрование и защиту данных. Инструменты диагностики позволяет быстро находить и исправлять ошибки, а горячая замена вентиляторов и накопителей помогает при необходимости оперативно провести ремонт. Сетевая инфраструктура построена на сетевых адаптерах Mellanox ConnectX-4 Lx Dual Port и коммутаторах SN2100 (с портами 100GbE).

Сетевой контроллер ConnectX-4 Lx EN с поддержкой коммутационных решений для Ethernet с пропускной способностью 1/10/25/40/50 Гбит/с спроектирован для решения задач виртуализованных инфраструктур и отличается наивысшей в своем классе производительностью для различных приложений и рынков. В этих адаптерах настоящая аппаратная изоляция ввода-вывода сочетается с масштабируемостью и эффективностью, что делает их экономичным решением для облачных инфраструктур, баз данных и платформ хранения данных.

ConnectX-4 Lx EN поддерживает скорости 1, 10, 25, 40 и 50 GbE, обеспечивает задержку менее 1 микросекунды и скорость передачи сообщений 75 млн пакетов в секунду. Они содержат аппаратную поддержку RDMA over Converged Ethernet, механизмов разгрузки протоколов Ethernet без контроля состояния, оверлейных сетей и технологии GPUDirect.

Мы попросили представителей «Облакотеки» рассказать о развертывании данных и об особенностях реализации проекта, позволившего предложить клиентам и партнерам самые современные технологии.

«Облакотека» — пока что единственный российский облачный провайдер, предлагающий IaaS-сервисы на базе Windows Server 2016?

Да, это так. На момент запуска сервиса в России не было ни одного провайдера, построившего сервис IaaS на платформе Windows Server 2016. Некоторые лишь поддерживали эту ОС в качестве гостевой на виртуальных машинах. По нашим данным, мы по-прежнему единственный такой провайдер, причем уже более полугода.

Почему в качестве платформы виртуализации были выбраны именно серверы Lenovo, в какой конфигурации? Какими средствами удалось добиться высокой производительности сервиса?

Идея создания сервиса возникла в августе 2016 года совместно с российским представительством Microsoft. Важнейшим требованием было наличие у вендора аппаратного комплекса, протестированного на совместимость с Windows Server 2016 в части развертывания гиперконвергентного кластера Storage Space Direct и поддержки Shielded VMs.

Кроме того, оборудование должно было быть поставлено в очень сжатые сроки поставки, по сути – со склада в Москве. Компания Lenovo отвечала всем этим требованиям, она уже имела опыт в развертывания подобного решения на своей платформе и готова была оказать нам необходимое содействие в выборе и настройке конфигурации серверов под данную задачу.

Совместно с Microsoft мы определили требования по конфигурации. В качестве подсистемы хранения данных было решено использовать только флэш-накопители и задействовать накопители NVMe для кеширования. Такой подход позволил добиться отличных показателей в производительности виртуального дискового массива.

Архитектуру решения разрабатывали специалисты «Облакотеки» совместно с российским представительством Microsoft. В проработке деталей проекта изучались рекомендации Microsoft и решения от Lenovo.

Какая роль отводится сетевой инфраструктуре? Чем был обусловлен выбор оборудования компании Mellanox? Какова пропускная способность сети? Какими средствами реализована SDN?

Для любого гиперконвергентного решения сетевая инфраструктура является важнейшим элементом. Все управление, обмен данными, восстановление после сбоя осуществляется через сеть и поэтому требования к качеству ее работы очень высокие. В случае с S2D (Storage Spaces Direct) требуется поддержка протокола SMB3. Наиболее полно она реализована в оборудовании Mellanox.

Выбранное решение позволило нам построить высокодоступную сеть передачи данных со скоростью до 50 Гбит/с на узел. Программно-конфигурируемая сеть (Software-Defined Networking, SDN) строится средствами операционной системы Windows Server 2016: она предусматривает роли контроллера SDN, балансировщика и остальные сопутствующие роли.

На базе высокопроизводительного оборудования Lenovo и Mellanox под управлением Windows Server 2016 реализована гиперконвергентная среда с SDNv2. В чем именно заключается гиперконвергентность платформы? В чем отличия SDN «нового поколения»?

Гиперконвергентная архитектура объединяет вычислительные ресурсы, сетевые ресурсы и ресурсы хранения в один уровень. Windows Server 2016 позволяет на одном и том же оборудовании развернуть службы управления хранилищем (SDS), сетью (SDN) и гипервизором (Hyper-V) в отказоустойчивом режиме. В отличии от предыдущей версии SDN, в новой добавились важные службы, например, балансировщик нагрузки — LoadBalancer (SLB).

У гиперконвергентных систем нет единой точки отказа, существуют широкие возможности горизонтального масштабирования: если требуется нарастить ресурсы и производительность кластера для работы дополнительных ВМ, а также увеличить емкость и производительность хранилища, то достаточно просто добавить в кластер новые узлы. Вместо SAN используется обычная локальная сеть (SDN с RDMA). Поэтому нет необходимости покупать дорогие решения FC, FCoE или конфигурировать iSCSI. Благодаря новым функциям SDS и SDN с помощью Windows Server 2016 можно создавать гиперконвергентные решения для облака.

Расскажите о подсистеме хранения серверов с N2215 SAS/SATA HBA и пулом хранения данных, платах PCI NVMe, SATA SSD. Как она построена, используется ли тиринг?

Система хранения Storage Spaces Direct (S2D) построена на основе локальных накопителей с SSD NVMe для кэширования. Для S2D важно выполнять требования по аппаратной совместимости. Так для подключения дисков пула нельзя использовать RAID контроллеры (даже в режиме HBA). Поэтому применяются только совместимые HBA.

Поскольку у нас в пуле – только накопители SSD, то тиринг смысла не имеет. Согласно рекомендациям Microsoft для кеширования мы используем PCI-накопители с интерфейсом NVMe. Они заметно ускоряют операции записи по сравнению с обычными SSD.

Для обеспечения высокой производительности и с учетом всех особенностей новой операционной системы развернута площадка на гиперконвергентной среде с флэш-массивом на базе технологии Storage Space Direct. Расскажите о данной составляющей проекта.

Сегодня все большую популярность получает технология SDS (Software Defined Storage), программно-конфигурируемые хранилища. Множество вендоров предлагают собственные решения SDS (VMWare VSAN, HPE/Nutanix, Ceph и т.п.). В Windows Server 2016 корпорация Microsoft предложила свою версию SDS – Storage Space Direct (S2D). Она позволяет на обычных серверах с локальными накопителями разного типа построить высокодоступную, производительную систему хранения.

При этом можно использовать технологии классических СХД старших моделей – кеширование, тиринг, высокую доступность на уровне стоек и ЦОД. В случае гиперконвергентной конфигурации, серверы «видят» СХД как классический для Windows кластерный диск.

Если необходимо предоставить доступ к хранилищу внешним потребителям, то можно использовать классические технологии – iSCSI, SMB, NFS. На уровне виртуального диска можно контролировать параметры IOPS, определять верхние и нижние границы по количеству IOPS, нормализованных под нужный размер блока данных.

Какие именно возможности Windows Server 2016 уже востребованы или могут быть востребованы заказчиками? Как вы оцениваете перспективы защиты конфиденциальных данных заказчика от доступа со стороны сотрудников сервис-провайдера (Shielded VMs)? Какие задействованы новые технологии для более быстрого развертывания виртуальных машин и приложений?

Windows Server 2016 содержит много новаций. Новейшие встроенные компоненты защиты серверов в Microsoft Windows Server 2016 обеспечивают предотвращение атак и обнаружение подозрительных действий. Вопрос безопасности и защищенности данных для ряда пользователей очень важен. Причем угроза рассматривается не только внешняя, но и внутренняя, со стороны сервис провайдера. Теперь можно ограничить доступ к данным внутри виртуальной машины администраторам провайдера. Это поможет данной категории клиентов принять решение о переходе в облака. Shielded VMs — самый безопасный способ защиты ВМ арендаторов от злоумышленников с правами администратора.

Помимо Shielded VMs, наши пользователи-разработчики могут использовать технологию контейнеров. На мощностях с графическими ускорителями теперь можно комфортно работать с программами САПР, управления анимацией и т.п. без использования дополнительного ПО третьих фирм. Для администраторов появился Nano Server — самый безопасный режим выполнения Windows Server 2016, а также «встроенный» балансировщик Load Balancer.

Расскажите немного о ходе реализации данного проекта. Как все это создавалось, какие были трудности, что удалось решить, а что отложили в задачи «на перспективу»?

Самая главная проблема – скудность документации и средств диагностики. Большую часть времени мы потратили на устранение неисправностей, вызванных, казалось бы, незначительными ошибками в конфигурации драйвера сетевого адаптера. Мы очень плотно работали с командой поддержки Lenovo для выполнения серверами кластера требований службы Host Guardian Services (она используется Shielded VMs). А для запуска всех возможностей SDN активно общались со специалистами Microsoft.

Сейчас с каждым днем объем доступной информации растет, документация улучшается. Возьмись мы за проект сегодня – было бы проще.

До июня стенд работает в тестовом режиме. Каковы дальнейшие планы? Планируется переход с Azure Pack на Azure Stack? Что можно ожидать в этой связи?

Задача ближайшей перспективы – перевод основной инфраструктуры на Windows 2016 и дальнейшее развитие сервиса. Полноценный стенд с нагрузкой, близкой к реальной, — это отличная возможность пройти этапы обучения сотрудников и «детских болезней» технологии без ущерба для коммерческих клиентов.

Несмотря на сходство названий, Azure Pack и Azure Stack — совершенно разные платформы с принципиально разным подходом. В Azure Stack существенно больше сервисов, но возможностей контроля, кастомизации, управления и обеспечения качества со стороны провайдера существенно меньше. К тому же у Azure Stack принципиально новая модель монетизации и она ещё окончательно не определена. В общем, мы в настоящий момент считаем, что они не замещают друг друга, а скорее рассчитаны на разную целевую аудиторию.

Как вы оцениваете результаты проекта?

Мы всегда стараемся максимально оперативно предложить нашим клиентам и партнерам самые современные технологии, чтобы дать им конкурентные технологические преимущества. Гиперконвергентные решения на базе Windows Server 2016 и серверного оборудования Lenovo — простой и экономичный способ внедрения облака любого масштаба и развертывания современных облачных сервисов.

Поделиться с друзьями

Комментарии (2)

navion

05.04.2017 22:31для подключения дисков пула нельзя использовать RAID контроллеры (даже в режиме HBA)

А что не так с HBA-режимами контроллеров? Они существенно медленнее настоящих HBA?

corr256

Один сервер купили или целых два?