Скорость работы компьютеров постоянно увеличивается, преобразуя окружающий нас мир. Информационные технологии помогают человечеству справляться с множеством трудностей в самых различных сферах. Часть реальных задач можно решить, используя комбинаторные компьютерные системы. Однако по мере увеличения количества анализируемых факторов число комбинаций растет, и возникает «проблема комбинаторной оптимизации». Для того чтобы ее решить, необходимо значительно повысить скорость работы вычислителей, что к настоящему времени стало крайне сложно осуществить без кардинальной переработки основ построения соответствующего оборудования. Этим и занялась компания Fujitsu.

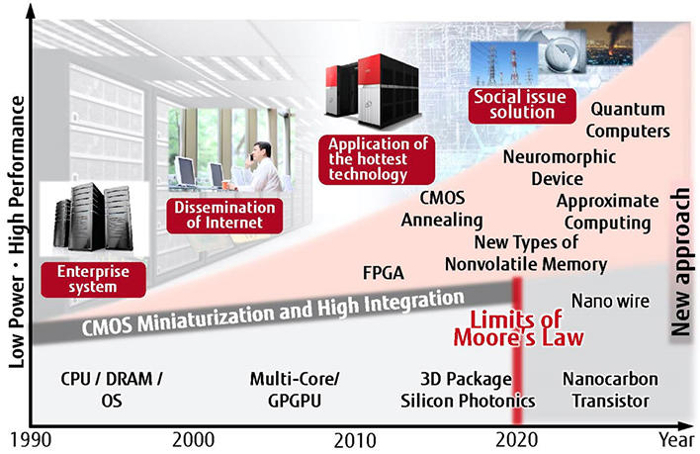

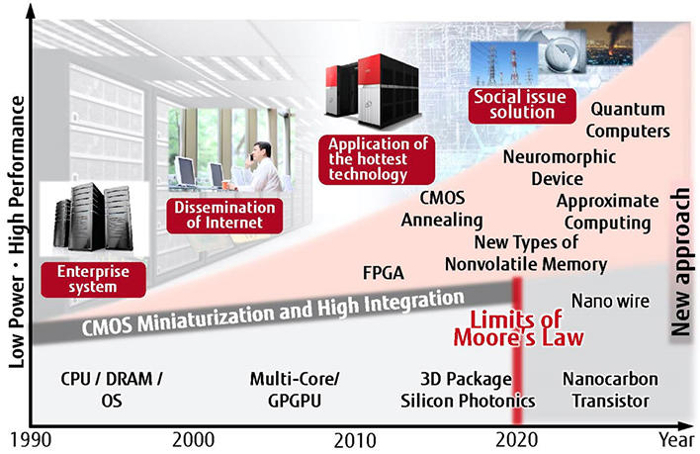

Закон Гордона Мура, предполагавший удвоение числа транзисторов в полупроводниковых микросхемах каждые два года, в течение последних 50 лет был основным правилом при проектировании и производстве микроэлектроники. Безудержный рост производительности вычислительных систем предоставлял человечеству определенные выгоды, однако сегодня специалисты не видят условий для продолжения действия этого закона.

Если мы хотим, чтобы компьютеры существенно улучшили качество нашей жизни в будущем, ИТ-отрасль должна принять целый ряд мер, включая разработку принципиально новых устройств, таких, как квантовые компьютеры. Подобные системы, в основу которых заложен метод, получивший название «квантовый отжиг», были разработаны специально для решения проблемы комбинаторной оптимизации.

Хотя имеющиеся сегодня квантовые компьютеры в целом способны решать эту проблему, существуют ограничения их возможностей, связанные с подключением смежных элементов. Поэтому у производителей вычислительного оборудования возникла необходимость создания новой компьютерной архитектуры, способной быстро и эффективно обрабатывать большое количество комбинаций, составленных из действующих факторов реального мира.

Университет Торонто и компания Fujitsu совместно разработали новую компьютерную архитектуру для поиска оптимальных решений практических проблем путем анализа огромного количества комбинаций. В архитектуре используется технология CMOS, расширяющая область ее применения.

Новая разработка имеет две отличительные особенности.

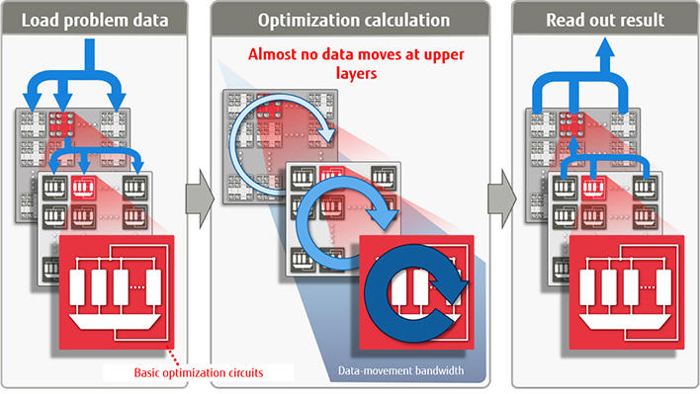

1. Прежде всего, она является «не-фон-неймановской» архитектурой, поэтому максимально сокращает объем перемещения данных. Практически во всех современных компьютерах используется «фон-неймановская обработка». Это означает, что данные программы сохраняются в память, а затем последовательно выполняются операции с ними. За последние годы производительность компьютеров значительно возросла, и низкая скорость чтения инструкций из памяти стала «узким местом». В результате, все привлекательнее выглядит возможность перехода на «не-фон-неймановскую» обработку данных. Подобные архитектуры использованы в нейрокомпьютерах (созданных по типу нейронных цепей), квантовых компьютерах, которые используют принцип поведения элементарных частиц квантовой механики, и ДНК-компьютерах.

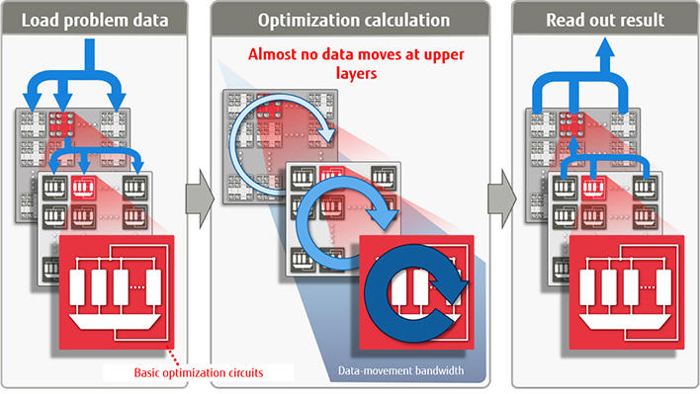

Технология минимизации перемещения данных, использующая операции не-фон Неймана

За счет использования «не-фон-неймановской» обработки данных (исполнения программы) и обновления переменной оптимизации (бита) стоимость решения проблемы снижается. В этом случае вначале данные загружаются из памяти, затем, по мере необходимости, выполняется их оптимизация, после чего выдается готовый результат. Т.к. во время работы данные не считываются и не записываются в память, временные расходы и энергозатраты снижаются. Кроме того, за счет минимизации перемещения данных между базовыми схемами, на верхние уровни необходимо перемещать их минимальный объем.

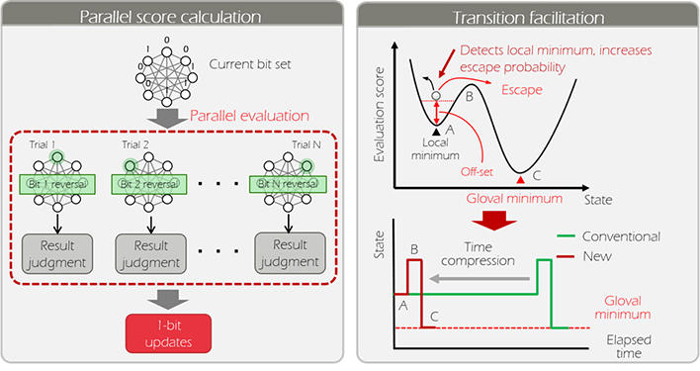

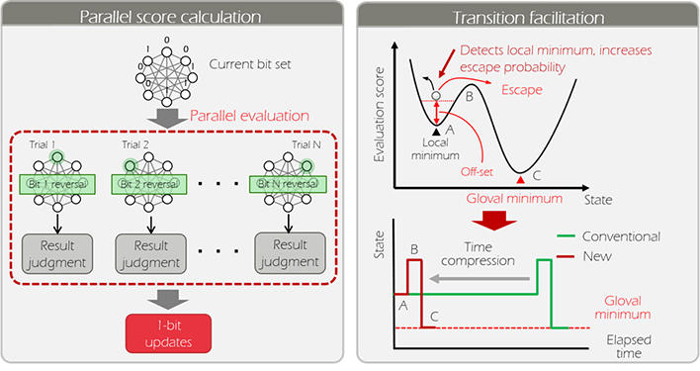

2. Второй отличительной особенностью является использование «высокоскоростной технологии в базовой схеме оптимизации». В данной схеме применяется теория вероятностей для поиска самого оптимального состояния. Вероятность определения оптимального состояния объекта повышается за счет параллельного подсчета значения каждой операции для нескольких вариантов. Если поиск останавливается в середине, этот метод циклически добавляет постоянное значение к общему расходу энергии для того, чтобы увеличить вероятность исключения для следующего состояния. Такой подход позволяет быстрее получить оптимальное решение.

Технология ускорения основных схем оптимизации

Специалистами Fujitsu было проведено тестирование новой архитектуры и создана базовая схема оптимизации на основе программируемой логической интегральной схемы типа FPGA (т.е. схема, конфигурация которой может быть настроена непосредственно заказчиком), способной обрабатывать 1024 бита. Новая система примерно в 10 тыс. раз быстрее аналогичной, выполняющейся на процессорах стандартной архитектуры (x86).

Использование нескольких базовых схем, которые выполняют оптимизацию параллельно, позволяет решать более широкий спектр проблем по сравнению с имеющимися сейчас квантовыми компьютерами. Также увеличивается масштаб решаемых проблем и скорость их обработки. Это позволяет, к примеру, выполнять оптимизацию нескольких тысяч физически распределенных баз. Компания Fujitsu продолжит работу над усовершенствованием новой архитектуры и планирует к 2018 г. создать опытную систему с масштабированием от 100 тыс. до 1 млн. бит.

Закон Гордона Мура, предполагавший удвоение числа транзисторов в полупроводниковых микросхемах каждые два года, в течение последних 50 лет был основным правилом при проектировании и производстве микроэлектроники. Безудержный рост производительности вычислительных систем предоставлял человечеству определенные выгоды, однако сегодня специалисты не видят условий для продолжения действия этого закона.

Если мы хотим, чтобы компьютеры существенно улучшили качество нашей жизни в будущем, ИТ-отрасль должна принять целый ряд мер, включая разработку принципиально новых устройств, таких, как квантовые компьютеры. Подобные системы, в основу которых заложен метод, получивший название «квантовый отжиг», были разработаны специально для решения проблемы комбинаторной оптимизации.

Хотя имеющиеся сегодня квантовые компьютеры в целом способны решать эту проблему, существуют ограничения их возможностей, связанные с подключением смежных элементов. Поэтому у производителей вычислительного оборудования возникла необходимость создания новой компьютерной архитектуры, способной быстро и эффективно обрабатывать большое количество комбинаций, составленных из действующих факторов реального мира.

Новая процессорная архитектура

Университет Торонто и компания Fujitsu совместно разработали новую компьютерную архитектуру для поиска оптимальных решений практических проблем путем анализа огромного количества комбинаций. В архитектуре используется технология CMOS, расширяющая область ее применения.

Новая разработка имеет две отличительные особенности.

1. Прежде всего, она является «не-фон-неймановской» архитектурой, поэтому максимально сокращает объем перемещения данных. Практически во всех современных компьютерах используется «фон-неймановская обработка». Это означает, что данные программы сохраняются в память, а затем последовательно выполняются операции с ними. За последние годы производительность компьютеров значительно возросла, и низкая скорость чтения инструкций из памяти стала «узким местом». В результате, все привлекательнее выглядит возможность перехода на «не-фон-неймановскую» обработку данных. Подобные архитектуры использованы в нейрокомпьютерах (созданных по типу нейронных цепей), квантовых компьютерах, которые используют принцип поведения элементарных частиц квантовой механики, и ДНК-компьютерах.

Технология минимизации перемещения данных, использующая операции не-фон Неймана

За счет использования «не-фон-неймановской» обработки данных (исполнения программы) и обновления переменной оптимизации (бита) стоимость решения проблемы снижается. В этом случае вначале данные загружаются из памяти, затем, по мере необходимости, выполняется их оптимизация, после чего выдается готовый результат. Т.к. во время работы данные не считываются и не записываются в память, временные расходы и энергозатраты снижаются. Кроме того, за счет минимизации перемещения данных между базовыми схемами, на верхние уровни необходимо перемещать их минимальный объем.

2. Второй отличительной особенностью является использование «высокоскоростной технологии в базовой схеме оптимизации». В данной схеме применяется теория вероятностей для поиска самого оптимального состояния. Вероятность определения оптимального состояния объекта повышается за счет параллельного подсчета значения каждой операции для нескольких вариантов. Если поиск останавливается в середине, этот метод циклически добавляет постоянное значение к общему расходу энергии для того, чтобы увеличить вероятность исключения для следующего состояния. Такой подход позволяет быстрее получить оптимальное решение.

Технология ускорения основных схем оптимизации

Специалистами Fujitsu было проведено тестирование новой архитектуры и создана базовая схема оптимизации на основе программируемой логической интегральной схемы типа FPGA (т.е. схема, конфигурация которой может быть настроена непосредственно заказчиком), способной обрабатывать 1024 бита. Новая система примерно в 10 тыс. раз быстрее аналогичной, выполняющейся на процессорах стандартной архитектуры (x86).

Использование нескольких базовых схем, которые выполняют оптимизацию параллельно, позволяет решать более широкий спектр проблем по сравнению с имеющимися сейчас квантовыми компьютерами. Также увеличивается масштаб решаемых проблем и скорость их обработки. Это позволяет, к примеру, выполнять оптимизацию нескольких тысяч физически распределенных баз. Компания Fujitsu продолжит работу над усовершенствованием новой архитектуры и планирует к 2018 г. создать опытную систему с масштабированием от 100 тыс. до 1 млн. бит.

Поделиться с друзьями

bashnesnos

Есть более подробное описание задачи, и систем на которых достигнуто ускорение в 10 тыс. раз?

Fujitsu_Admin

К сожалению, этих данных у нас нет