Отрываем от передней части Ultra capacitor module — штуковина предназначена для работы блоков питания в режиме Active/Passive, а также для гарантированного переключения без просадок питания на резервный БП. Оказывается, его также можно использовать для защиты серверной от потенциального противника, быстро переделывая в мощный электрошокер. И знаете что? С ним пускают в самолёт, когда говоришь «да этот сервер стоит как квартира напротив Кремля!»

Оглядываясь, во что бы ещё воткнуть лом, мы заинтересовались серверным оборудованием Bull и решили взять на тестирование один из серверов. Вообще, есть линейка продуктов Bull компании Atos. Bullion S — это высокопроизводительные сервера с морем памяти на борту на базе серверов x86-архитектуры. Всё, что нужно считать внутри оперативной памяти, — это их епархия. Заявленная фишка — высокая отказоустойчивость в сочетании с мощностью и относительной дешевизной.

В общем, нам достался один такой. Первое удивление было в том, что грузится он 15 минут (вендор говорит: в полной выкладке до получаса), тестирует 768 Гб оперативы. Загрузился — мы начали дёргать всё, что только могли. Ага, прямо на ходу. Железка вела себя достойно. По всем I/O пережил нормально, просто переходили пути, а диски оставались доступными с некоторой задержкой. При выдёргивании других кусков иногда делались короткие ребилды (производительность падала), потом всё восстанавливалось. Восстановилась — мы продолжали откручивать детали дальше. Кстати, если оторвать вот этот капасити-модуль с фото или блок питания, сервер это тоже переживёт без происшествий.

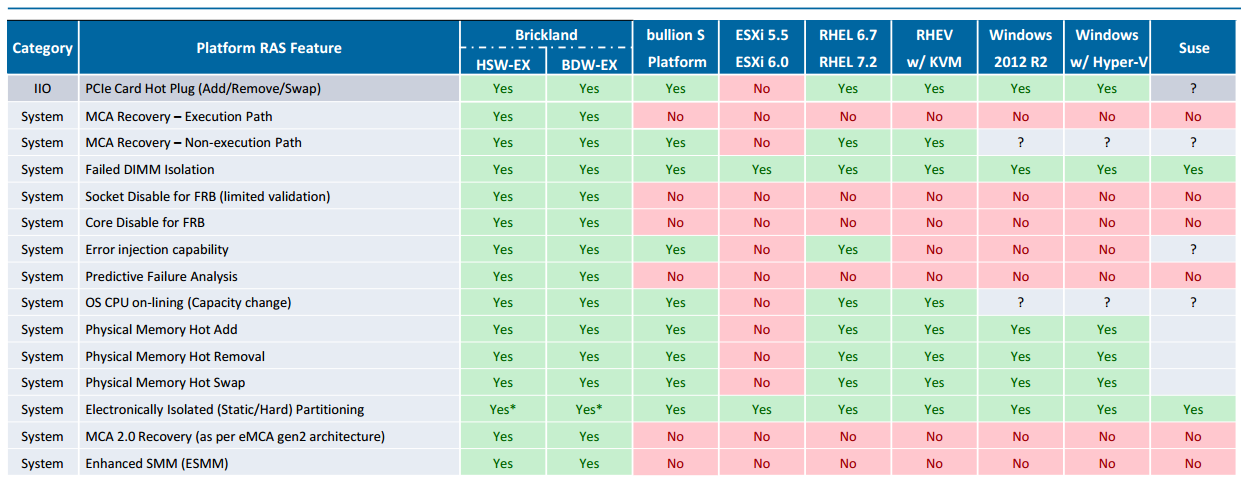

Единственный момент — если вынимать из него во время нагрузки плашки памяти «на горячую» руками, он уйдёт в перезагрузку при определённых условиях (о них ниже расскажу).

Знакомство с сервером bullion S

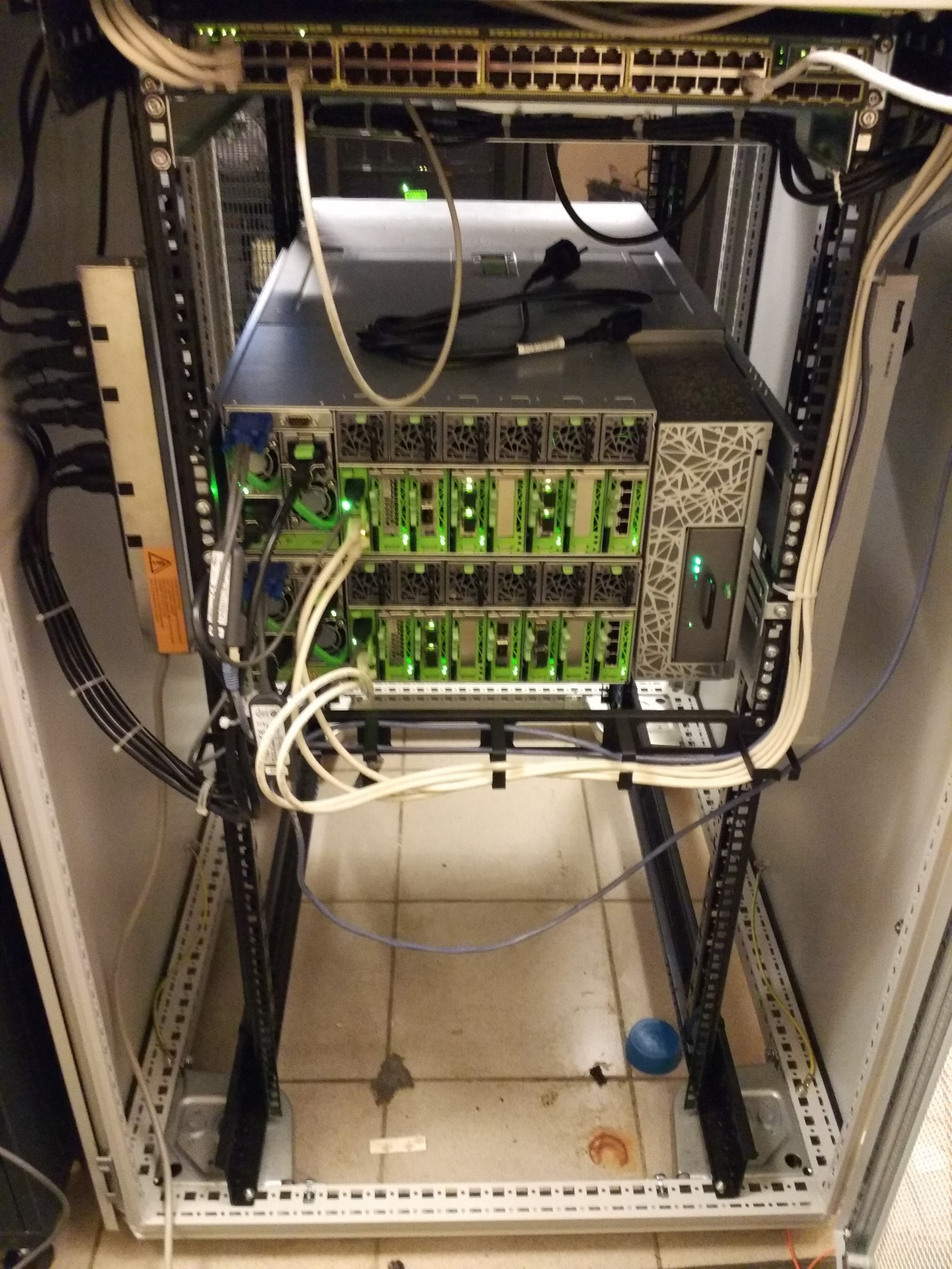

Итак, мы поставили перед собой задачу проверить эти утверждения, познакомиться и всячески помучить предоставленное оборудование. На 2 недели нам выделили сервер bullion S4, по сути это две x86 ноды, объединённые в один высокопроизводительный сервер. Сервер приехал в качестве готового стенда в 20U-стойке с коммутатором Cisco 2960, консолью с KVM-переключателем и PDU.

Конфигурация и особенности

Особенность сервера — это предустановленная из коробки ОС VMWare ESXi.То есть по сути это уже готовое решение: достал из коробки сервер, подключил и разворачивай виртуалки. По необходимости версию ESXi можно обновлять.

Конфиг сервера представлен в табличке:

| bullion S4 |

|

| Форм-фактор |

19 дюймов, 6U |

| ПРОЦЕССОРЫ |

4xCPU Intel Xeon E7v3 |

| Чипсет |

Intel C602J |

| Интерфейс xQPI |

Макс. 9,6 ГТ/с |

| Память |

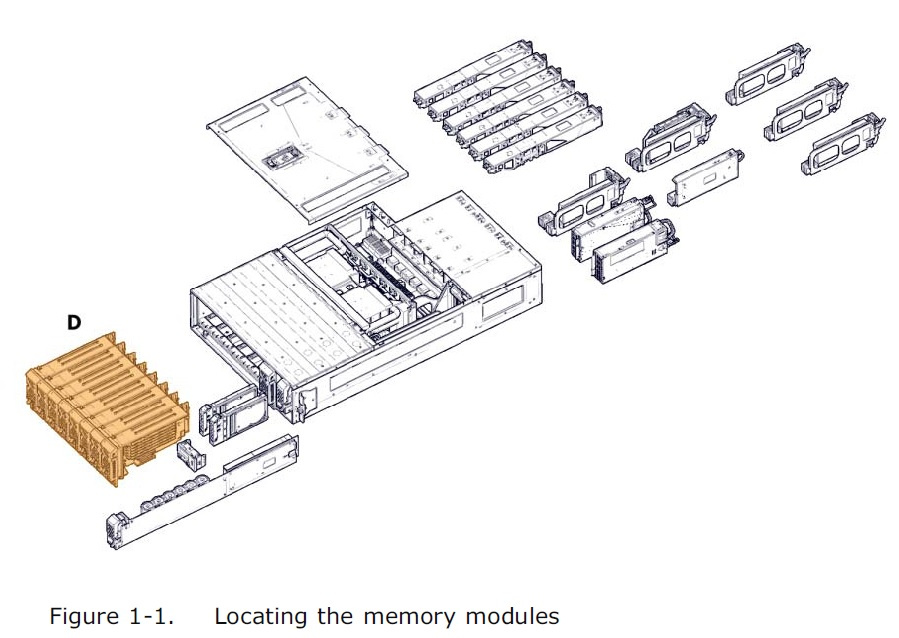

4 блейд-модуля по 6 планок 32Гб DDR4 RDIMM |

| Встроенные NIC |

1Gb Ethernet: 2?2 порта |

| NIC |

1Gb Ethernet: 4 порта на ноду, 10GbE 2 порта на ноду |

| HBA |

8/16 Гбит/с: 2 модуля с 2 портами на ноду |

| Флеш |

SSD, 1,6 ТБ |

| SAS |

12 Гбит/с: 2 внешних разъёма на блейд-модуль |

| Контроллер |

1 блейд-модуль ввода-вывода с RAID 0.1 (12 Гбит/с) Рейд-контроллер 9380 4i4e для RAID 5 /6 на дисках bullion |

| Блок питания |

2 на ноду |

| FAN |

6 на ноду |

| HDD |

2?600 Гб на ноду |

Все компоненты сервера зарезервированы, как у любого сервера в хорошей комплектации.

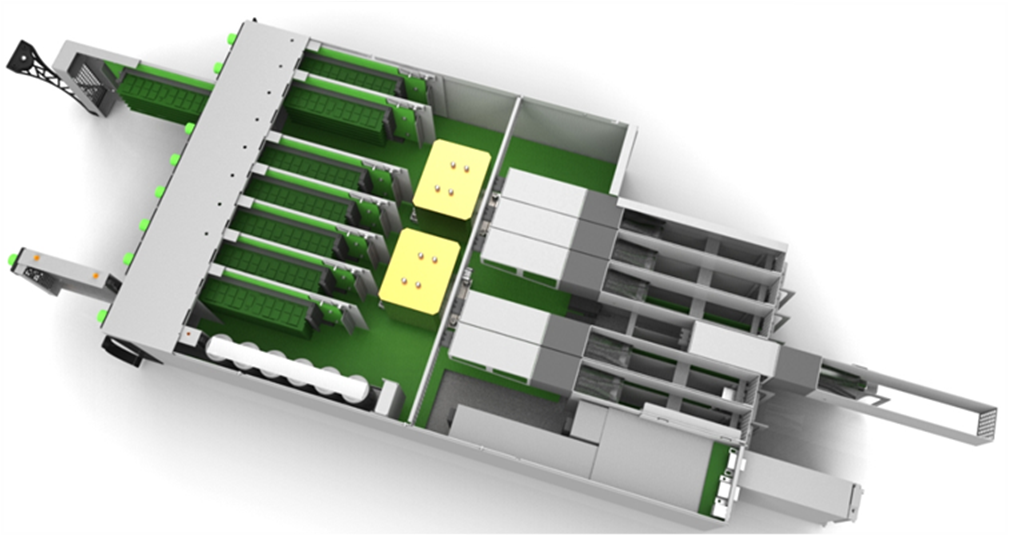

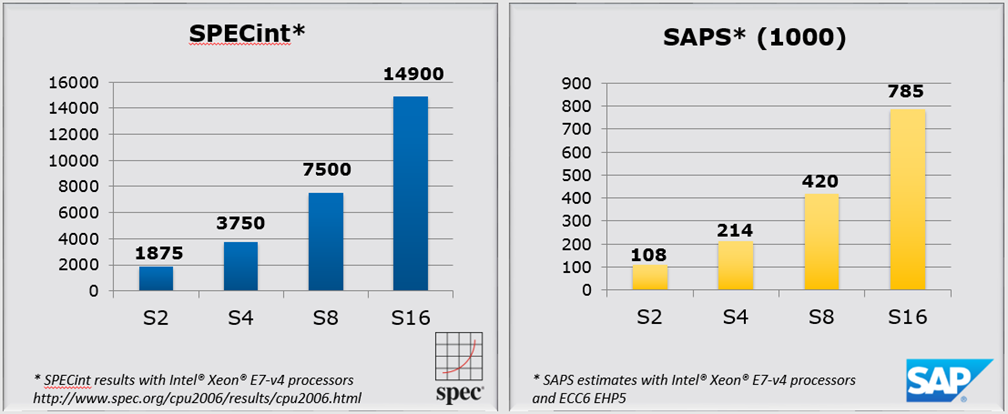

Каждая нода bullion S — это сервер с двумя сокетами, 48 слотами памяти, в максимуме сервер масшабируется до 8 таких нод, что позволяет получить жирный 24U сервер с 16 сокетами, 24Tb памяти и 56 8xPCI-e слотами. Плюс возможен Node Partitioning.

ОС грузится с ведущей ноды, с двух дисков в RAID1. Сервер имеет модульную структуру, все I/O карточки, memory cards, не говоря уже о БП и вентиляторах, устроены так, что могут быть извлечены на горячую из передней или задней части каждой ноды.

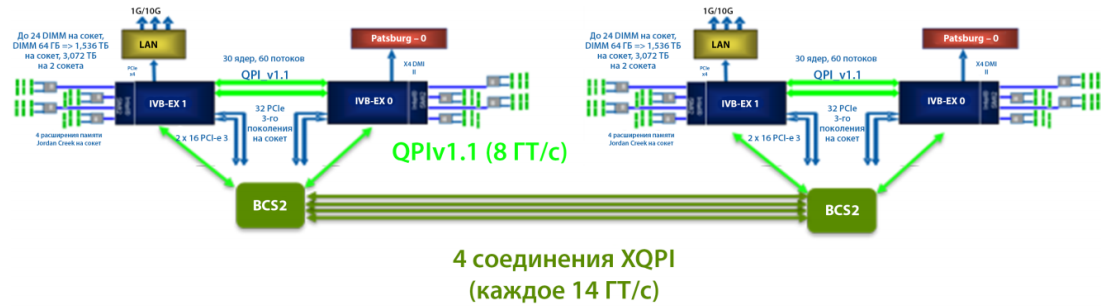

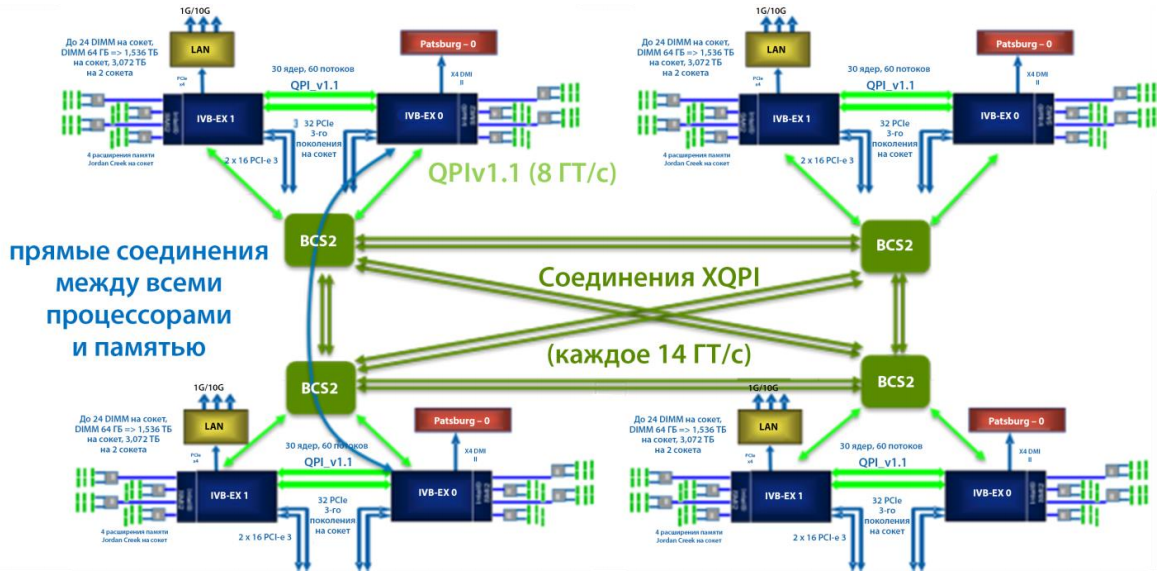

Масштабируемость bullion — это его фишка. Для связи процессоров между нодами используется eXtended Quick Path Interconnect, который разработан Bull и работает в 2 раза быстрее и уменьшает среднее запаздывание между локальной и удалённой памятью процессора по сравнению с Intel QPI. Физически это встроенный когерентный коммутатор Bull (сокращенно BCS).

Архитектура прорисована ниже.

S4

S8

S16

Избыточная звезда. Отличает bullion от KunLun и SDX

Мониторинг и управление

Сервер имеет довольно странную внешнюю индикацию, которая немного смущает, но таков дизайн.

На самом деле оранжевая лампочка говорит о том, что UCM (ultra capacitor module) заряжен.

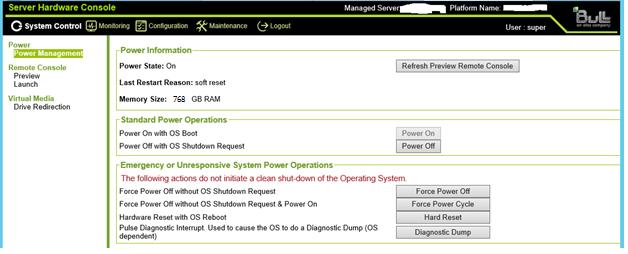

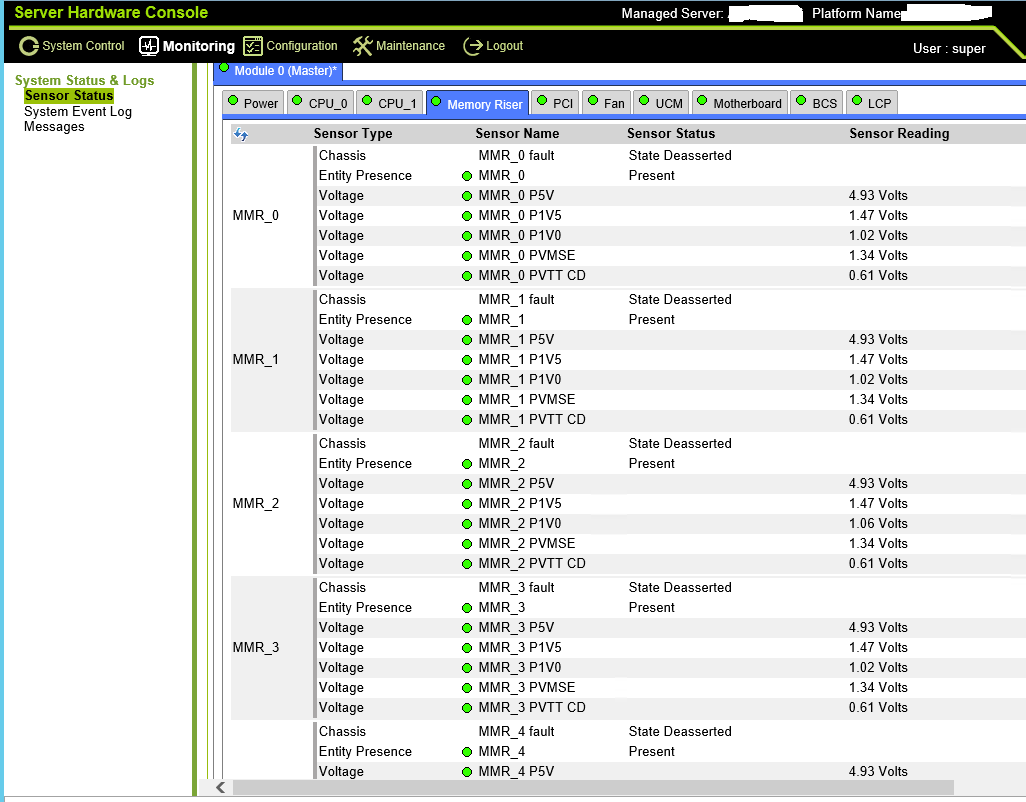

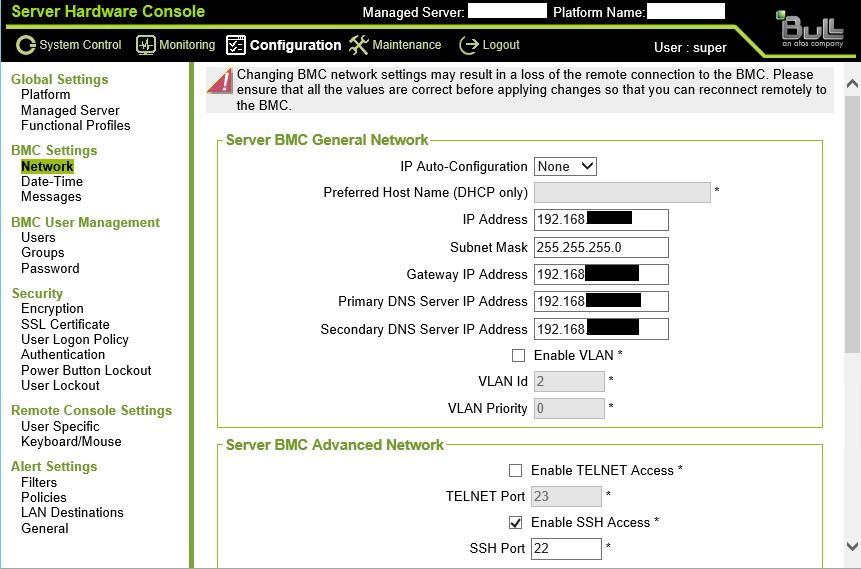

Состояние сервера и его компонентов можно мониторить через Server Hardware Console.

Вендор говорит, что для мониторинга большого количества серверов существует инструмент iCare (Bull insight care).

Также есть возможность интеграции с vRealize. Для управления также существует мощный CLI «BSMHW_NG_140» — устанавливается отдельно, может работать вместе с BPM (Bull Platform Manager).

Тестирование

Включили сервер. Инициализация при перезагрузке или включении проходит 15–20 минут, в основном из-за чека памяти: чем её больше, тем дольше. Процесс загрузки можно мониторить, подключившись, к примеру, с помощью Putty (terminal) к SHC, там детально отображается процесс инициализации контроллеров, проверки памяти и т. д.

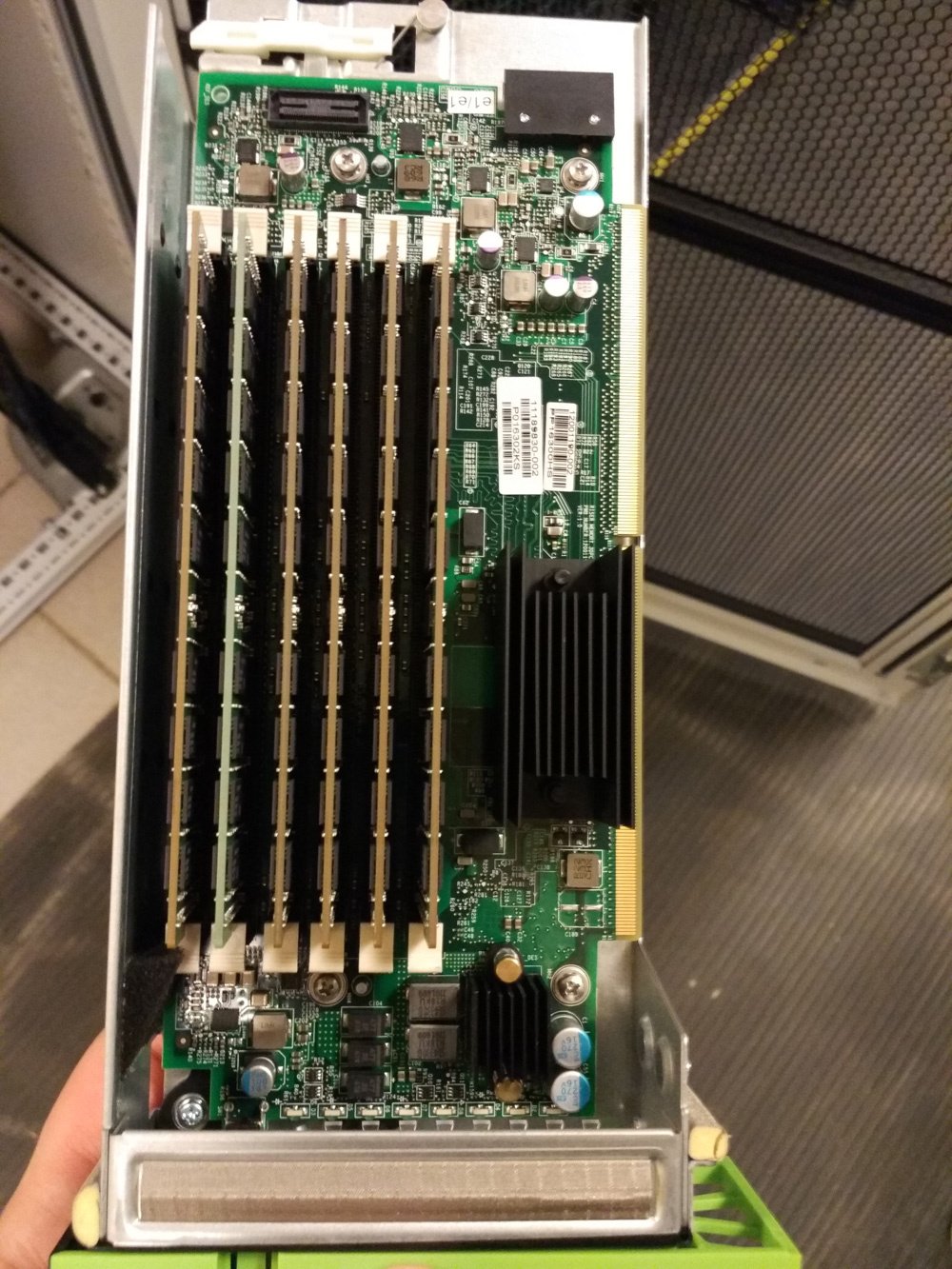

Сделали пару виртуалок, сервер обеими нодами подключили к нашей entry level СХД DS3500 и начали дергать модули. Тут у нас вот лезвие с памятью. Вынимается? Вынимается!

Перезагрузку словили при установке памяти обратно, хотя заявлено, что сервер поддерживает hot plug memory, мелким шрифтом (или в скобочках) добавляют, что только определенные ОС.

«Смотри, ещё деталька. Сейчас вытащу, снимай:»

Интересно, а электрошокер получится? Получится!

После этого в мануале прочитали, что так делать нельзя, опасно — нужно сначала разрядить!

Пока дергали I/O карточки — луны остались живы, перекидывая пути.

Хотели понять, может ли он в однонодовой конфиге — дернули целую ноду. Отключился весь сервер (ну, обратного вендор не заявлял, но вдруг) ?. В этом плане софтварный кластер предпочтительнее хардварного.

Коллега говорит: дай MSM (Management Switch Module) ближе сфотографирую. Не вопрос, держи, дружище:

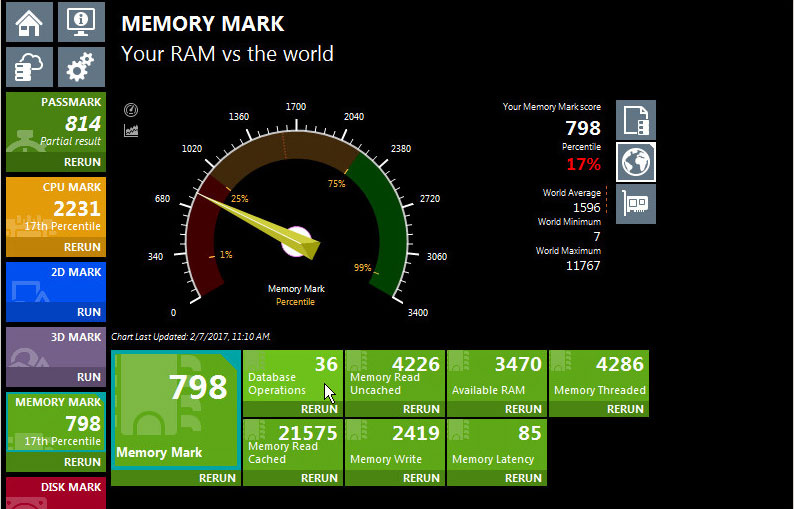

Сервер остался жив. С помощью программки Perfomance test провели несколько тестов производительности, на маленькой виртуалке и виртуалке с максимальными ресурсами. Хотя учитывая, что это виртуальные машины, особого смысла в этом не вижу, основное предназначение сервера — это Oracle, SAP HANA, виртуализация. Данные тестов — в конце.

Была мысль снести гипервизор и поставить что-то другое, но вендор очень просил этого не делать. Скорее всего, потому что машина ходит «по рукам» на тестах. В общем, зоопарк приехал, мы поиграли, зоопарк уехал дальше гастролировать.

Согласно опубликованным на www.spec.org материалам, bullion является самым мощным корпоративным сервером x86. Bullion всё ещё предлагает до 16 процессоров (по сравнению с восемью у так называемых «непосредственных» моделей — архитектура, в которой до 8 процессоров связаны друг с другом без дополнительного коммутатора), то есть до 384 ядер на одном сервере.

Результаты наших тестов

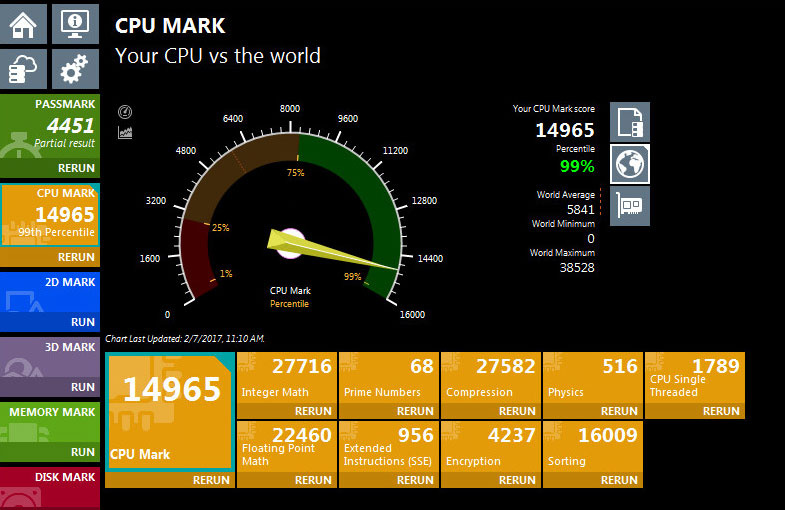

CPU Test 1/1

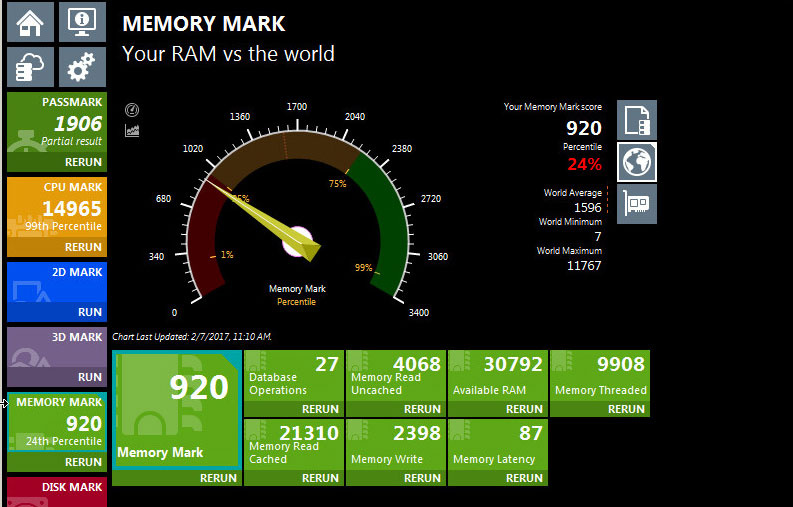

MemTest 1/1

CPU Test 2

Mem Test 2

Впечатления

Вполне себе обычный хардварный двухнодовый кластер, Bull не первый, кто по QPI объединил x86 сервера, это делал и IBM, и HPE.Хотя такой мощи там. Конечно. не было, здесь можно расти: S4-S6-S8-S10. ОС может быть любой: Linux, Windows, VMware… Хотя тут, на мой взгляд, шасси с блейд-серверами и vMotion надёжнее, чем все виртуалки в одной коробке (но тут надо брать в расчёт стоимость лицензий посокетно).

Зачем он такой красивый нужен

Основной сценарий использования серверов — платформа для in-memory-вычислений. Как самый распространённый пример таких вычислений — решение SAP HANA. Сервер также может использоваться под БД Oracle, SQL Server, виртуализацию, неплохой вариант для перехода с P-серии и мейнфреймов. Прайс-лист в РФ для некоторых аппаратных конфигураций сертифицированных для SAP HANA:

| Name |

Model |

CPU |

DB |

DIMMs |

Russian List Price |

| S4-80V4-1TB-32GB |

S4 |

8880V4 |

1TB |

32GB |

166 872 € |

| S4-80V4-2TB-32GB |

S4 |

8880V4 |

2TB |

32GB |

211 104 € |

| S4-90V4-4TB-64GB |

S4 |

8890V4 |

4TB |

64GB |

356 820 € |

| S6-80V4-4.5-32GB |

S6 |

8880V4 |

4.5TB |

32GB |

366 567 € |

| S6-90V4-6TB-64GB |

S6 |

8890V4 |

6TB |

64GB |

529 161 € |

| S8-80V4-3TB-32GB |

S8 |

8880V4 |

3TB |

32GB |

417 102 € |

| S8-80V4-6TB-32GB-CIS-Op |

S8 |

8880V4 |

6TB |

32GB |

570 437 € |

| S8-90V4-6TB-32GB-CIS-Op |

S8 |

8890V4 |

6TB |

32GB |

617 785 € |

| S8-90V4-8TB-64GB |

S8 |

8890V4 |

8TB |

64GB |

816 410 € |

| S8-90V4-8TB-64GB-CIS-Cu |

S8 |

8890V4 |

8TB |

64GB |

820 337 € |

Это, конечно, street price, по нему почти никто никогда не покупает. Но если вы знаете, сколько обычно вычитать, представление даёт.

Ссылки

- Документация, там есть образ диска, а в нём внутри PDF с документацией

- Видео о Bull в России

- Видео с демонстрацией bullion S

- Видео с демонстрацией sequana

- Как мы обычно тестируем железо

- Прошлый тест серверов с двумя независимыми путями вычисления каждого процессорного такта

- Моя почта — krahimov@croc.ru

Комментарии (16)

ifaustrue

30.06.2017 12:57+1Я правильно понимаю, что можно вынимать часть памяти без сбоя в работе? Если да, то как это достигается (DDR as RAID или что-то типо того)?

Kirill_Rahimov

30.06.2017 13:51+1Если память сконфигурирована в режиме «Mirroring» то да, но этот режим подразумевает использование 50% от всей доступной.

Всего у сервера три режима работы памяти.

1. Стандартный с использованием RAS features.

2. Performance mode – некоторые RAS features ограничены (используется только 4 планки памяти в блэйде вместо 6-ти)

3. Mirroring mode

В третьем случае да, можно вынимать плашки, поскольку они избыточно используются. Если делать это по очереди, а не сразу поляной, ничего особо страшного.

Реальная задача этой фичи — перестраховка от выхода из строя целого Memory Riser и удобство обслуживания.

P.S. а зачем вам в здравом уме будет без причины извлекать память из нагруженной бизнес-критичной сисетемы? Бывали случаи?

ifaustrue

30.06.2017 14:29+1Спасибо. Стало понятнее =)

Вопрос был из любопытства, а задачи были про вычисления in-memory когда потеря ноды критична (банковская система с плохой архитектурой шардирования горячих данных).

А сколько стоит такой самолёт? В чём то измеримом. В солярисах там или в однушках.

Taciturn

30.06.2017 17:46+1дернули целую ноду. Отключился весь сервер

Если падание одной в любом случае вызывает остановку всего кластера, то какой тогда смысл в двух нодах?

Да и с памятью странно. Раз уж сервер ориентирован на высокую надёжность, то вместо принудительной перезагрузки логичнее было бы отключать «лишнюю» память до перезагрузки ручной, чтобы можно было корректно завершить все процессы.vlanko

30.06.2017 22:35Для удвоенной производительности.

А две ноды вместо одной 4-япроцессорной, похоже экономия.

Или чтоб больше памяти влезло.

Kirill_Rahimov

30.06.2017 22:57Ну кластером это назвал я, по аналогии с подобными технологиями на IBM, здесь же вендор сразу заявляет, что это единый сервер и отказ ноды не поддерживается.

Это не кластер, а 4-х сокетный сервер, и ноду выдернули ради интереса. Написано же Hot CPU remove не заявлено.

Сбойные планки памяти при срабатывании порога ошибок исключаются из работы и могут быть замены при следующем окне обслуживания.

Arxitektor

30.06.2017 20:09Bullion S Название просто отличное )

Намек на стоимость.

перевод Bullion слиток золота или серебра.

Хотя здесь скорее всего уже урана )

mapatka

Это все красиво, но когда производители серверов начнут делать платы для расширения юсб портов?)

Сейчас есть проблема, не хватает физических портов usb для всяких ключей-лицензий.

Расскажите о вашей практике, как выкручиваетесь, когда надо подключить много usb-ключей к серверу? И есть ли альтернативы anywhere usb? Спасибо.

brainfair

seh myutn-800

DaemonGloom

Классический USB-хаб с дополнительным питанием не спасает в вашей ситуации?

ifaustrue

USB over IP не подходит в вашем случае?

Kirill_Rahimov

Мы не знаем аналогов anywhere. Вообще USB anywhere как правило полностью закрывает потребности оборудования средней или довольно большой компании, а стоимость в сравнении со стоимостью оборудования не серьезна (100к деревяннных примерно). Если компания маленькая и косты на оборудование крайне ограничены, то и количество серверов небольшое и USB хаб рублей за 500-1000 вполне себе решение.

ifaustrue

del