Передаю слово автору статьи, khabarovdaniil (Даниилу Хабарову).

Мое мнение про этот продукт довольно однозначное — мне он нравится из-за крайне интересной технической реализации, но всегда удивляла неоднозначность некоторых архитектурных решений. Но, обо всём по порядку.

План нашего рассказа будет такой:

В первой части мы поговорим про исторический контекст Microsoft Data Protection Manager, и то, почему он такой.

Во второй — о том, как он работает технически, с заглядыванием на страшного зверя VSS.

Ну а в третьей — текущее положение дел, что он умеет и как мы это сможем использовать, в том числе и с Microsoft Azure Backup.

Microsoft Data Protection Manager. Начало

Как вы, безусловно, помните, во времена Windows Server 2003 все администраторы пользовались Windows Backup и все были счастливы. Потребность в чем-то большем существовала, но в большинстве случаев она покрывалась исключительно сторонними инструментами, такими как NetBackup, BackupExec, иногда это были прекрасные скрипты robocopy с использованием разнообразных архиваторов.

Не то, чтобы это было удобно, но в те времена гигабайт дискового пространства стоил существенно дороже, бэкап размером в Гигабайт вызывал уважение, а еще существовавшая 10 МБит сеть не всегда позволяла передать необходимое количество информации в пределах адекватного времени. Ленточные библиотеки и стримеры активно записывали информацию на старые кассеты LTO-3.

Именно это и определило развитие будущего DPM:

- он должен был уметь писать на ленту;

- улучшить существующий Windows Backup;

- смотреть в будущее, ориентируясь на растущие потребность в больших и быстрых дисковых хранилищах;

- предоставлять полноценное резервное копирование Windows инфраструктуры. К таковой относилось, в первую очередь AD, SQL, файловые ресурсы.

И вот, 27 сентября далёкого 2005 года, Microsoft впервые представил DPM 2006. Заострять внимание на этом продукте явно не стоит, потому что мало кто решился его использовать, а те кто и решились, не долго им пользовались, потому что появилась новая версия в рамках релиза System Center 2007.

DPM 2007. Per aspera ad astra

Следует справедливо заметить, что DPM, с некоторых пор, стал единственным поддерживаемым продуктом для резервного копирования AD, т.е. Domain Controllers. Ну, кроме, конечно, Windows Server Backup, который пришел на смену Windows Backup.

Итак, новый продукт предоставлял не в пример более широкий функционал резервного копирования:

- File servers and workstations;

- Microsoft Exchange;

- SQL Server database software;

- Windows SharePoint Services;

- Virtual Server (с появлением SP1 — ещё и Hyper-V);

- End User Recovery.

По сравнению с первой версией, и даже её SP1, это был большой прогресс. Теперь можно было говорить о том, что мы по-настоящему можем осуществлять резервное копирование по сети для всей организации. При этом, возможность резервного копирования файлов конечного пользователя (End User Recovery) расширилась, а также, предоставляемый функционал явно стал покрывать потребности средней организации. Все это, помноженное на гуманную ценовую политику DPM сделало так, что автор этих строк уже в 2014 году мигрировал с этого продукта на актуальные версии.

Продукт к этой версии явно избавился от большинства детских болезней, но всё ещё не мог составить серьёзной конкуренции собратьям по цеху. При этом, возможность работы на слабых каналах (через 128 кбит он реально мог скопировать, даже при пинге размером в чуть меньше бесконечности) давала явно хорошие возможности для использования даже на удалённых площадках.

С появлением Hyper-V, DPM 2010 SP1 также научился делать резервное копирование виртуальных машин. Это был явный шаг вперёд по сравнению с Virtual PC.

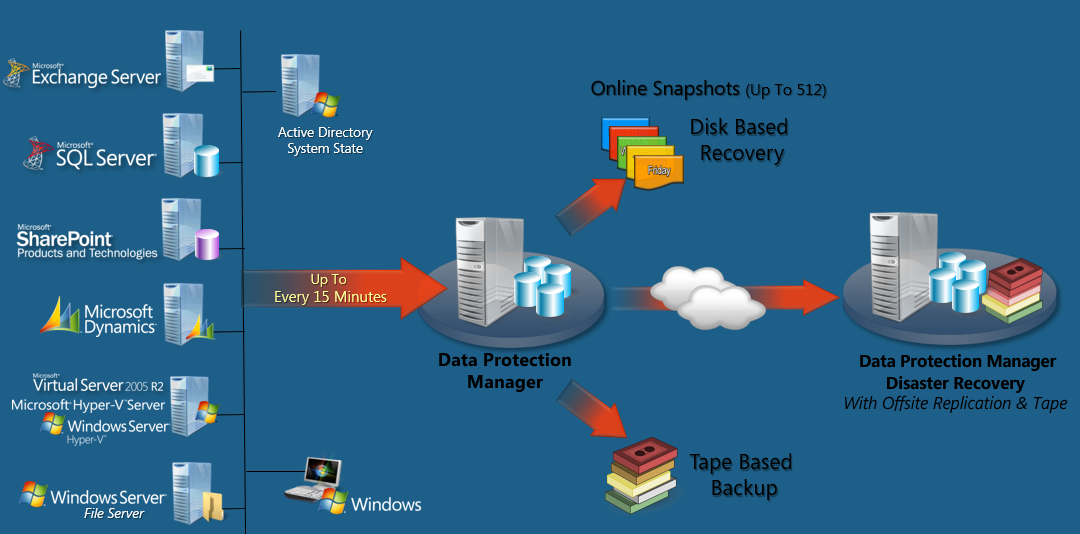

С помощью DPM уже можно было строить иерархические структуры резервного копирования посредством географически разнесённых серверов, что было достаточно актуально в тот момент времени.

Большим минусом, с точки зрения администраторов, была невозможность частичного восстановления объектов AD, что вполне логично объясняется политикой Microsoft для целостности резервных копий. И даже несмотря на то, что функционал был востребован, команда AD так и не разрешила инкрементальное восстановления отдельных объектов исходя из принципов безопасности. Эта ситуация сохраняется и по сей день.

DPM 2010

Data Protection Manager 2010 явно долгожитель среди своих собратьев. Вообще, продукты резервного копирования в организациях живут достаточно долго без изменения и обновления.

Основная причина заключается в том, что зачастую существует боязнь обновления подобных продуктов, так как существуют опасения потери резервных копий с одной стороны, а с другой — потенциальное изменения нормативных документов, таких как План Аварийного Восстановления (в народе известном как DRP).

Чем же он так подкупил организации и системных администраторов? Ответ прост: он реально улучшил уже существующие наработки и добавил несколько нововведений:

- 100 серверов;

- 3000 Windows клиентов;

- 2000 БД SQL Server;

- 25 ТБ SharePoint ферм, с 1 миллионом объектов;

- 40 ТБ Exchange storage groups и БД.

Кроме увеличенного объёма хранимых данных, появились реально полезные возможности, например, появилась поддержка Exchange 2010 и DAG. Многие, пожалуй, помнят интереснейшую систему отказоустойчивости Exchange 2007 LCR, CCR, SCR (особенно в кошмарах). Так вот DPM 2010 поддерживал и Exchange 2007 и Exchange 2010.

Ну и, конечно же, появилась поддержка новой на тот момент ОС — Windows Server 2008 R2.

Этот продукт оказался настоящим долгожителем. Причин тому было много — стабильность настроенной системы, довольно-таки неплохой функционал.

DPM 2012 & DPM 2012 R2

Ну и последняя на сегодня версия о которой мы поговорим — DPM 2012 R2.

Основными её нововведениями по сравнению с предшественником было:

- централизованное управление;

- возможность использования Generic Data Source (мое прямо любимое);

- защита клиентов с помощью сертификатов;

- дедупликация.

А также было улучшено:

- восстановление отдельных сайтов и элементов SharePoint;

- поддержка SQL FileStream;

- расширенные возможности колокейшена лент.

Но самое большое нововведение — это, пожалуй, начало дружбы DPM c Azure backup. Начиная с SP1 и DPM 2012 R2 появилась возможность отправлять резервные копии в облачный сервис по подписке. С точки зрения резервного копирования это был реальный прорыв, и это реально было одним и самых больших нововведений в продукте за всю его историю.

Прежде чем раскланяться, терпеливый читатель, автор хочет озвучить несколько оправданий, чтобы правильно выстроить ожидания достопочтенной публики:

- данная статья первая из серии, как и говорил в самом начале;

- цель этой заметки познакомить с тем, как эволюционировал этот продукт, но никак не рассказать о глубинном принципе работы;

- если вы хотите узнать глубинные принципы работы — дождитесь следующей серии этого рассказа. Он будет посвящен тому, как работает DPM Storage Pool, почему и какие у него существуют ограничения.

До следующей встречи на страницах :)

Комментарии (13)

Sergey-S-Kovalev

07.07.2017 15:38Может быть я плохо ковырял интернеты.

Когда можно будет нативно лить в Data Domain без прокладок в виде VTL с поддержкой DDBoost?

khabarovdaniil

07.07.2017 21:54Скорее всего интернет рассматривался хорошо. Дело в том, что для того, чтобы лить напрямую в любые системы хранения без использования эмуляций необходимо использовать соответсвующий и поддерживаемый VSS provider. Если этот провайдер не был предоставлен вендором оборудования, скорее всего не получится писать напрямую на диск.

Ранее это не планировалось, и не думаю, что это будет реализовано. Точнее, пожалуй, смогут только представители MS сказать.

DikSoft

07.07.2017 16:59DPM в первых версиях был разработан «с нуля» или всё же лицензирован у кого-то?

khabarovdaniil

07.07.2017 21:51+1Насколько я помню, это была полностью своя разработка. Именно на него и делалась ставка при уменьшении функциональности родного Windows Server Backup.

DikSoft

07.07.2017 22:35+1— А не было ли лицензирования технологий у Backup Exec?

khabarovdaniil

07.07.2017 23:22+1Опять же, весь DPM работает исключительно на MS технологиях. Не припомню разговоров про родственность этих продуктов. Постараюсь поискать первосточники, и, если найду подтверждение — обязательно сообщу, но не слышал о подобном.

DikSoft

10.07.2017 11:20Я переезжал в свое время именно с BE на DPM и схожесть продуктов как внешне, так и архитектурно просто бросалась в глаза. Особенно в ранних версиях 2006.

navion

07.07.2017 22:47Чем же он так подкупил организации и системных администраторов?

Им не хватило денег на CommVault.

khabarovdaniil

07.07.2017 23:25+1К сожалению, ни один продукт резервного копирования не избавляет от большого количества операционной работы, которая, в конечном итоге, и предоставляет организации возможность быстрого восстановления после катастрофы.

DPM справляется со своими функциями, при необходимости, может делать даже много больше, но, как и во многих продуктах, его необходимо правильно развернуть и настроить.

Относительно стоимости — спорить не буду, зачастую, это было решающим фактором.

vesper-bot

Одна вещь, которую я всерьез не понимаю — откуда растут ноги у количественных показателей, особенно когда их внезапно увеличивают в зависимости от факторов, не зависящих от архитектуры или подобных очевидных ограничений: "Предыдущая версия нашего ПО позволяла работать с А объектами, новая с Б объектами", хотя делать с ними надо то же самое, и в принципе так же, как и с предыдущей версией. Разве в базу данных предыдущей версии ПО не помещается Б объектов, а только А?

2006й ещё забыли. ;)

khabarovdaniil

При переходе от DPM 2007 к DPM 2010 ноги выросли на уровне работы их внутренних механизмов. Изменился порядок формирования самих снимков и так называемых, bitmaps. Сильно переделали именно эту часть. Еще значительным элементом был переход с x32 на x64.

Поэтому вопрос более чем справедлив, но в данном случае, это был довольно масштабный clean-up и обновление.

В следующей статье я постараюсь более обстоятельно рассказать про bitmap, и постараюсь собрать больше информации про то как это работает.