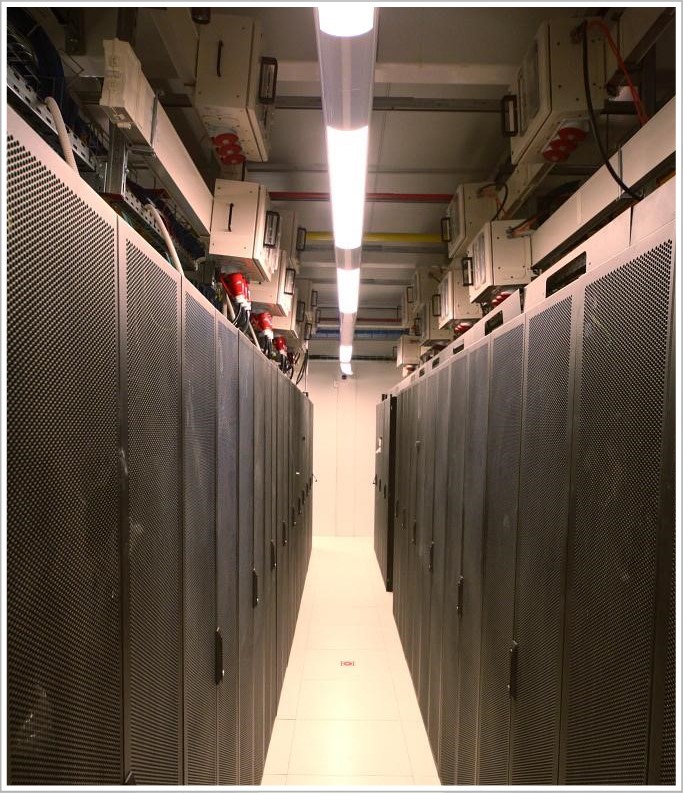

Центр технического обеспечения (ЦТО) технопарка «Жигулевская долина» представляет собой двухэтажное здание. Оно включает шесть машинных залов общей площадью 843 кв. м и вмещает 326 стоек средней мощностью 7 кВт каждая (максимальная нагрузка на стойку – 20 кВт). А мы, специалисты компании «ЛАНИТ-Интеграция», впервые увидели его еще на стадии бетонного каркаса. На тот момент оно не имело никаких коммуникаций. Нам предстояло создать всю инженерную и сетевую инфраструктуру, а также часть вычислительной инфраструктуры для работы автоматики инженерных систем.

Для начала я немного расскажу о проекте в целом, а затем уже покажу всю «начинку».

Итак, в центре технического обеспечения «Жигулевской долины» нужно было установить серверы, СХД и другое оборудование, необходимое резидентам центра инноваций Самарской области. Конечно, для такого оборудования нужны специальные условия эксплуатации: энергообеспечение, тепловой режим, уровень влажности и т. д., поэтому экономически целесообразно было установить оборудование в одном месте.

Мы обследовали здание, изучили имеющуюся у заказчика документацию и приступили к разработке проектной документации (которой предстояло пройти государственную экспертизу). Самая большая сложность заключалась в том, что на разработку проектной и рабочей документации нам отвели всего три месяца. Параллельно с рабочей документацией приходилось готовить часть документации на английском языке для прохождения экспертизы международного института Uptime Institute.

В рамках проекта мы должны были:

- сделать ЦОД энергоэффективным;

- построить в сжатые сроки;

- выдержать экзамен Uptime Institute и получить сертификат Tier III.

Поскольку плотность инженерных систем в ЦОД очень высокая, а сроки сжатые, пришлось детально планировать работы, поставки материалов и оборудования.

Опять же из-за «горящих» сроков решили использовать высокотехнологичные быстровозводимые модульные конструкции – с их помощью избежали дополнительных строительных работ, не делали огнеупорные перегородки и мощную гидроизоляцию. Такое решение защищает помещение от воды, огня, пыли и других опасных для ИТ-оборудования факторов, при этом сборка модульной конструкции занимает всего 1-2 недели.

После экспертизы проекта стали разрабатывать рабочую документацию и заказывать оборудование. Кстати, об оборудовании: поскольку проект попал на кризисный год и возникли сложности с финансированием, нам пришлось всю работу подстраивать под финансовый план и прежде всего остального закупать дорогое крупногабаритное оборудование – цена на него была закреплена производителем.

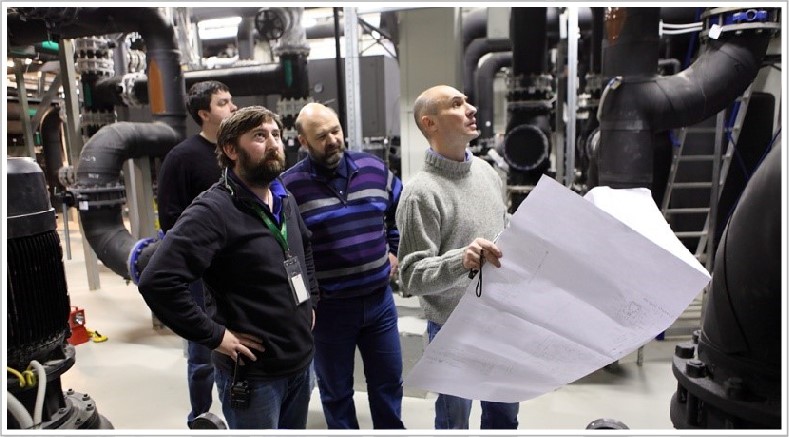

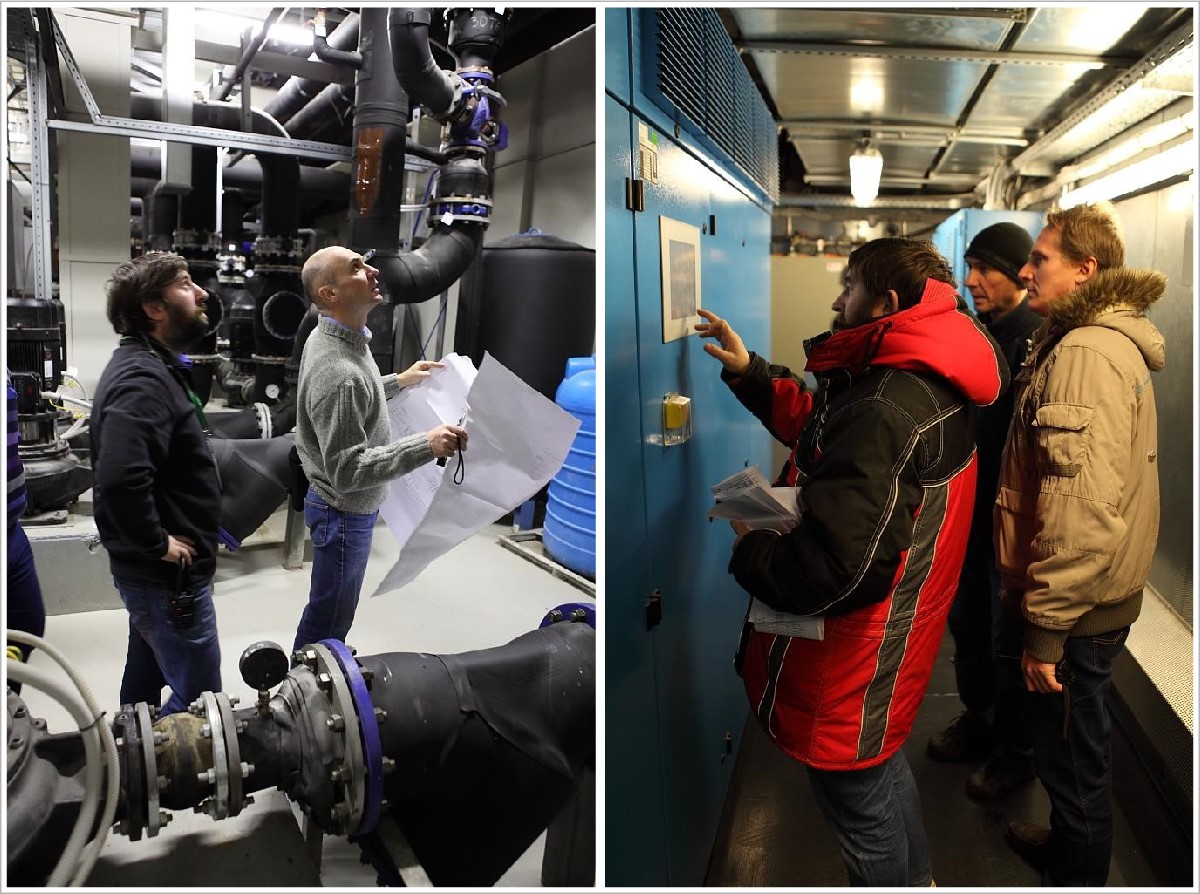

Изменения в планах поставки оборудования потребовали еще более тщательного планирования. Чтобы организовать работу 100-150 человек на объекте без простоев, проектная команда много внимания уделяла процедурам управления изменениями и управления рисками. Ставку сделали на коммуникации: любая информация о проблемах и задержках практически сразу передавалась по всей цепочке от бригадиров – руководителю проекта и инженерам в головном офисе компании.Проектная команда и менеджеры закупки трудились в Москве, а основная команда работала непосредственно в технопарке. Инженерам не раз приходилось выезжать в командировку на объект для уточнений и коректировки проектных решенией, а между тем от нашего московского офиса до технопарка по трассе почти 1000 км. Непосредственно на месте мы организовали строительный штаб – там регулярно проходили совещания с участием заказчика и руководителей работ, после которых вся обновленная текущая информация передавалась инженерной команде.

Большинство рабочих специальностей мы набирали в регионе (до 150 человек), что касается узких специалистов и инженеров, их пришлось направить в длительную командировку из Москвы.

В итоге всё получилось. Рассказ о главном испытании – сертификации Uptime Institute – я приберег на самый конец. А сейчас давайте посмотрим, как у нас всё устроено.

Чтобы попасть в ЦОД, необходимо иметь RFID пропуск и пройти идентификацию на входе на территорию ЦОДа. В здании также все двери под контролем, в некоторые залы действует допуск только после двойной идентификации сотрудника.

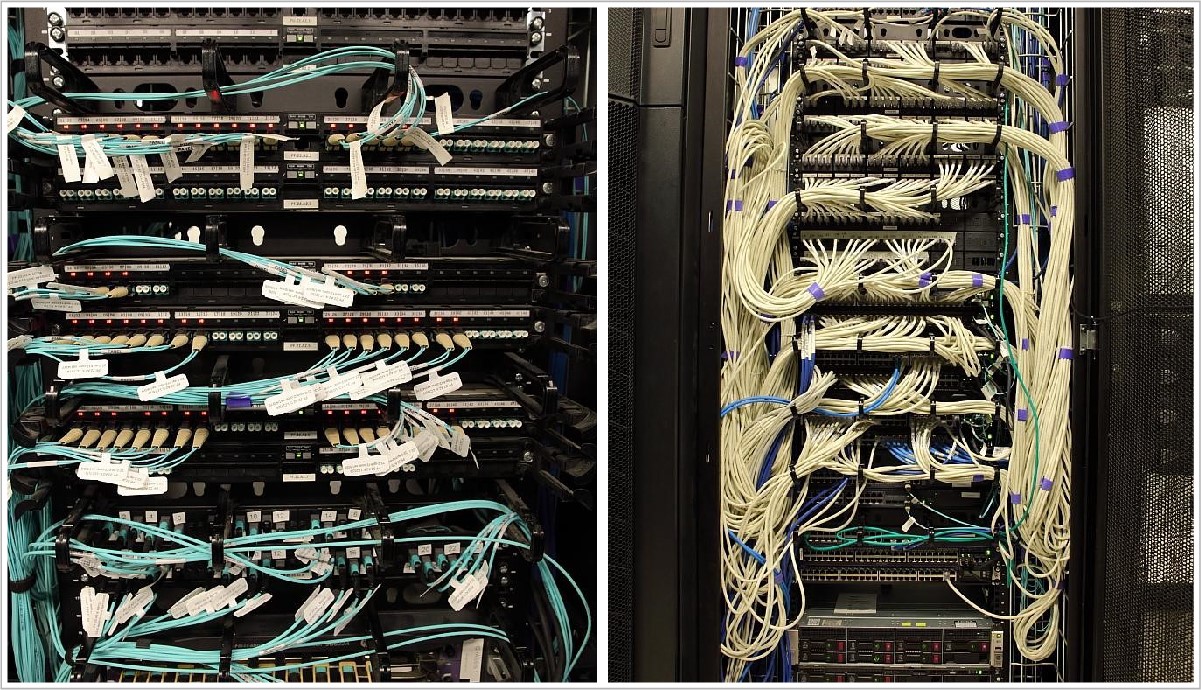

Структурированные кабельные системы

Для сети передачи данных мы использовали коммутаторы HP FlexFabric и Juniper QFabric. Интеллектуальная СКС Panduit с системой управления физической инфраструктурой PanView iQ позволяет удаленно контролировать и автоматически документировать состояние физического уровня сети, а также осуществлять интеллектуальное управление полем коммутации.

Возможно контролировать правильность подключения оборудования или нештатного подключения к портам СКС. Претерминированные кабели позволяют при необходимости менять конфигурацию СКС на тех участках, где это требуется.

Электроснабжение ЦОД

В собственной трансформаторной подстанции станции ЦТО установлено 4 независимых трансформатора, которые питают электроэнергией вводно-распределительные устройства (ВРУ1-4) ЦТО.

Суммарная выделенная мощность на ЦОД – 4,7 МВт.

От трансформаторной подстанции в ВРУ ЦТО отходят 8 независимых лучей и через систему гарантированного питания на базе дизельно-роторных источников бесперебойного питания (ДДИБП) питают 8 ВРУ ЦОД, 4 ВРУ системы бесперебойного питания и 4 ВРУ системы гарантированного питания. Система питания построена по схеме 2N, кабели заходят с двух разных сторон здания ЦОД в две разнесенные электрощитовые.

Схема 2N реализует резервирование по электроснабжению. Любой питающий луч для обслуживания может быть выведен из работы, при этом ЦОД будет полностью работоспособен.

Для бесперебойного и гарантированного электроснабжения мы установили дизель-динамические источники бесперебойного питания Piller. Мощность каждого 1МВт бесперебойного и 650 кВт гарантированного питания, что позволяет обеспечить работу ЦОД в полном объеме.

В случае прекращения поступления электроэнергии ротор вращается по инерции и электрическая установка продолжает вырабатывать ток еще несколько секунд. Этого небольшого промежутка времени хватает на запуск дизель-генератора и выхода на рабочие обороты. Таким образом, работа оборудования не прекращается ни на секунду.

Схема построения N+1. При такой мощности вырабатываемой электроэнергии дизельный двигатель имеет большой расход топлива – более 350 литров в час, что потребовало дополнительного внешнего топливохранилища объемом более 100 тонн дизельного топлива.

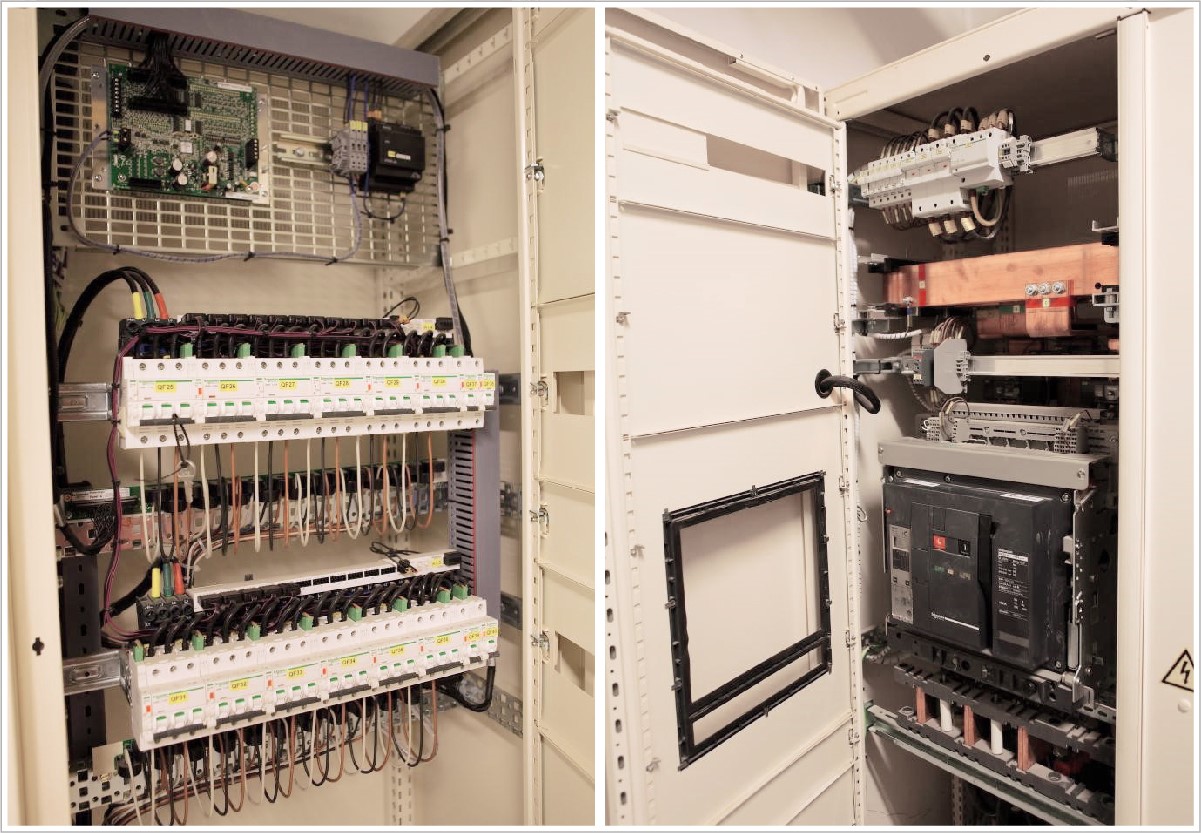

В здании ЦОД две разнесенные электрощитовые. В каждой установлено по 2 ВРУ системы бесперебойного питания и 2 ВРУ системы гарантированного питания.

Система диспетчеризации контролирует состояние всех автоматических выключателей. Также установлены приборы технологического учета, что позволяет контролировать потребление электроэнергии по каждому направлению электропитания. Для обеспечения бесперебойной работы вспомогательных систем установлен шкаф со статическим электронным байпасом.

Система распределения также контролируется системой диспетчеризации, и каждая линия оснащена прибором технологического учета.

В малых залах размещены шкафы распределения, от них отходят линии к каждому серверному шкафу, в котором установлено по два блока распределения питания.

В больших залах для распределения электроснабжения был использован шинопровод. В отводных коробках каждый автомат также контролируется системой диспетчеризации, что позволяет постоянно получать полную картину о работе системы электроснабжения ЦОД.

Непосредственно в серверных шкафах для распределения электроэнергии установлены блоки распределения питания.

Охлаждение залов

На первом этаже в аппаратных и машинных залах ЦТО оборудование охлаждается с применением внутрирядных прецизионных кондиционеров Emerson (ранее приобретенных заказчиком) и с использованием водяных чиллеров и драйкулеров для подготовки захоложенной воды.

Для охлаждения залов второго этажа (с основной нагрузкой) мы применили кондиционеры с рекуператором воздух-воздух.

В четырех машинных залах второго этажа развернута инновационная система охлаждения от компании AST Modular, включающая в себя 44 модуля охлаждения наружным воздухом Natural Free Cooling.

Система представляет собой два разомкнутых контура. В одном из них циркулирует воздух из машинного зала, а в другой через систему технологической вентиляции подается прохладный воздух с улицы. Оба потока проходят через рекуперативный теплообменник, в котором происходит теплообмен между наружным и внутренним воздухом. Таким образом, оборудование может охлаждаться наружным воздухом до 90% времени в году, что позволяет на 20-30% снизить затраты на традиционное активное охлаждение с использованием водяных чиллеров и драйкулеров. Летом охлаждение воздуха производится захоложеной водой от чиллеров.

К началу проекта у нас уже был опыт создания подобных систем охлаждения: Natural Fresh Aircooling мы использовали в высокотехнологичном модульном ЦОДе «ВымпелКома» в Ярославле. Но каждый новый проект таит свои сложности.

Чтобы увязать работу кондиционеров MNFC с приточными установками воздуха (которые подготавливают уличный воздух, после чего подают его в технический коридор для MNFC), нам пришлось для кондиционеров MNFC на математическом уровне проработать зависимость объемов подаваемого воздуха и выбрасываемого вентустановками. Это связано с тем, что объем воздуха, который поступает в технический коридор, должен не превышать определенную границу (чтобы не задушить вентиляторы кондиционеров) и одновременно быть достаточным (чтобы воздух в коридоре не оказался разреженным).

Хладоцентр на первом этаже и оборудование на крыше

В помещении хладоцентра (ХЦ) разместили чиллерные машины, насосные группы, теплообменики и т.д.

Водяные чиллеры и драйкулеры используются для подачи захоложенной воды в установки Natural Free Cooling на втором этаже в жаркое время года и в кондиционеры на первом этаже постоянно. Зимой охлаждение воды осуществляется через теплообменник в ХЦ и градирни на крыше, что также позволяет не включать чиллеры и экономить электроэнергию.

По проекту, большой объем оборудования нам нужно было установить на крыше ЦТО, поэтому пришлось практически построить третий этаж в виде стотонной рамы и установить на нее около 60 тонн оборудования: градирни, длина которых достигала 14 м, и мощные вентустановки выше человеческого роста.

С градирнями мы, конечно, попотели: попробуй подними такую громадину на крышу! Из-за больших габаритов оборудования пришлось варить специальную балку для разгрузки, а также использовать кран грузоподъемностью 160 т с большой стрелой, и даже такой кран местами проседал.

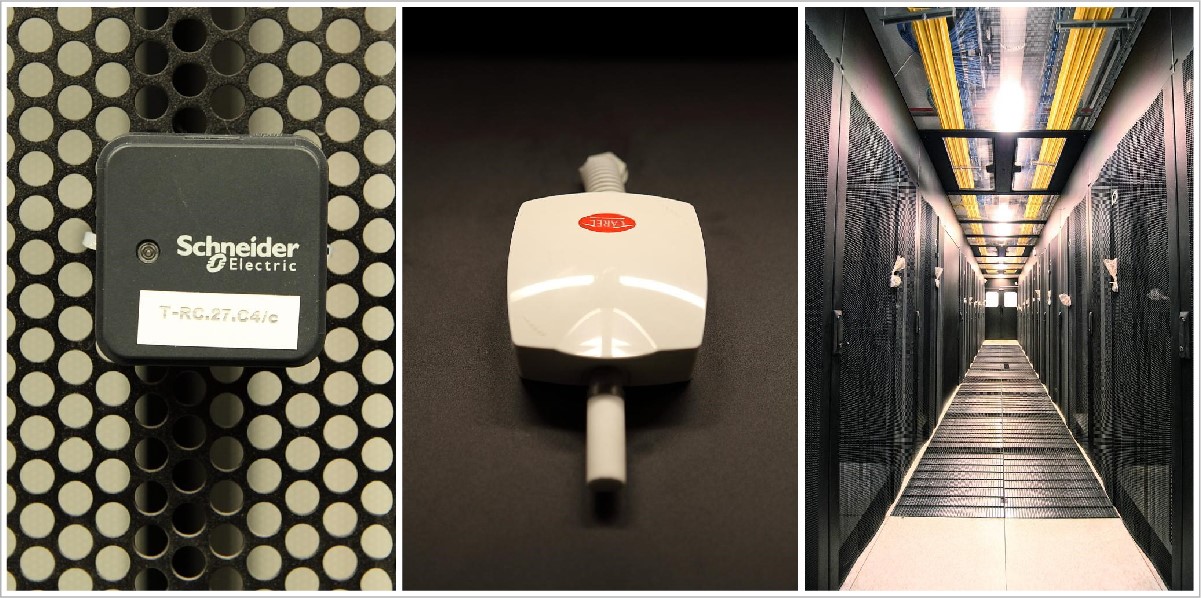

Пожарная безопасность

Для пожарной безопасности на площадке развернуты системы пожарной сигнализации, раннего обнаружения пожара (аспирационная система – датчики, анализирующие состав воздуха), автоматического газового пожаротушения и система газоудаления, которая позволяет удалять остатки газа после отработки системы пожаротушения.

Система оповещения о пожаре работает следующим образом: пожарные датчики машинных залов, аппаратных, а также вспомогательных помещений выдают соответствующие сигналы на центральную станцию автоматической пожарной сигнализации, которая, в свою очередь, запускает систему автоматического газового пожаротушения, пожарную автоматику и систему оповещения, в зависимости от зоны возникновения пожара.

В качестве основного было использовано оборудование ESMI (Schneider Electric). Оно закрыло все задачи по обеспечению пожарной безопасности и отображается на рабочей станции оператора в диспетчерской.

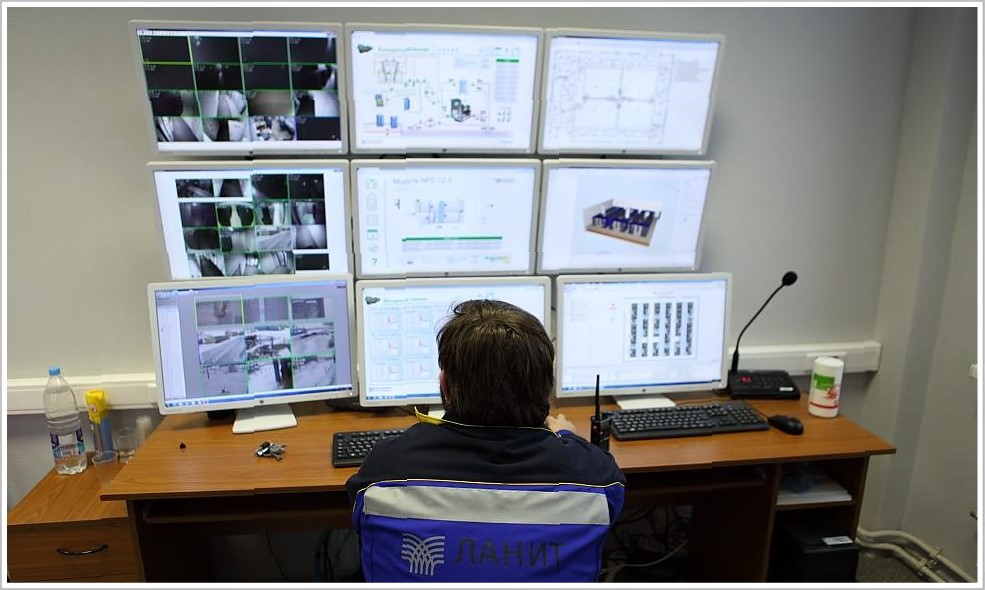

Система автоматизации и диспетчеризации ЦОД

В большинстве ЦОД ставят только локальную автоматизацию с минимальным набором функций мониторинга, а у нас все подсистемы интегрированы в единое техническое решение с общей системой контроля. Система контроля отслеживает состояние более 10 систем и выводит более 20 тыс. параметров. Хотите узнать температуру и влажность в машинных залах или вас интересует потребление электроэнергии по каждой ИТ-стойке? Без проблем.

В рамках системы мониторинга и диспетчеризации мы использовали как SCADA-систему, так и систему мониторинга и менеджмента ЦОД. SCADA-система (Supervisory Control And Data Acquisition — диспетчерское управление и сбор данных) позволяет просматривать данные и управлять автоматикой установленного оборудования: чиллера, кондиционера, дизельно-роторных ИБП, вентиляции, насосов и т.д.

Система учета ресурсов дата-центра позволяет вести полный учет всего оборудования, установленного в стойках. Она в реальном времени отображает аварийные сообщения, данные о состоянии оборудования с визуализацией на детальном плане размещения. Благодаря детализации мы можем увидеть любое устройство, расположенное в ЦОД.

Система позволяет моделировать аварийные ситуации и выдает рекомендации по решению проблем, а также позволяет планировать и оптимизировать эксплуатацию технических ресурсов ЦОД.

Здесь также ведется контроль и управление вентиляционными системами (в том числе контроль температуры подаваемого ими воздуха, так они участвуют в технологическом процессе охлаждения ИТ-оборудования). Учитываются все параметры по кондиционерам, вентиляционным установкам и системам холодоснабжения.

Система отслеживает состояние оборудования и управляет им (и различными клапанами). Кроме того, она дополнительно защищает оборудование от критических режимов.

Система контролирует состояние всех основных аппаратов защиты в электрошкафах, а также электропотребление на данных линиях.

Система позволяет вести учет установленного оборудования в ИТ-стойках, а также хранить информацию о его принадлежности. Сюда стекаются данные с противопожарных систем и системы безопасности здания.

Управление зданием осуществляется при помощи решений, построенных на оборудовании компании Schneider Electric. Автоматизированная система диспетчеризации, мониторинга и управления инженерными системами предоставляет всю необходимую информацию диспетчеру на его рабочем месте.

Системы связаны между собой посредством технологического сегмента сети передачи данных. Программное обеспечение установлено на виртуальных машинах, обеспечено резервное копирование данных.

Для обеспечения безопасности, видеонаблюдения и контроля доступа в ЦОД также было установлено централизованное решение Schneider Electric. Оно выдает необходимую информацию в систему диспетчеризации ЦОД.

Всё оборудование, о котором я рассказал, собрано в отказоустойчивой конфигурации и размещено в модульных помещениях Smart Shelter, обеспечивающих надежную защиту ЦТО от пожара, влаги, вибрации и других внешних воздействий. Данное решение позволило сократить срок реализации проекта. На сборку одного помещения в среднем ушло две недели.

Пройти огонь, воду и… экзамен Uptime Institute

Чтобы сдать экзамен на соответствие ЦОД стандартам Tier III Design и Tier III Facility, нам пришлось выполнить всю документацию согласно требованиям Uptime Institute, пройти ее сертификацию и по этой документации смонтировать и запустить все системы. В финале мы выдержали тестирование систем дата-центра на соответствие Tier III Facility. А это порядка 50 тестов!

Подготовка к испытаниям оказалась непростой: если сертификация документации понятна, то найти информацию, как проходит сертификация самого объекта, было крайне сложно (на тот момент ЦОД «Жигулевской долины» оказался седьмым в России дата-центром, проходящим сертификацию).

Много сил ушло на внутренний аудит (испытания под нагрузкой уже ранее проводились для заказчика). Две недели мы друг за другом все проверяли в соответствии с проектной документации и тестами, полученными от Uptime Institute, и все равно, конечно же, нервничали во время сертификации.

Когда специалисты Uptime Institute приехали в ЦОД с инспекцией и стали осматривать залы, я для себя на будущее сделал важный вывод – в команде должен быть один лидер, который возьмет на себя общение с «экзаменаторами». О том, кто станет таким человеком, нужно подумать еще на этапе формирования команды. Мы постарались именно так и сделать, и все же в процессе испытаний некоторые наши сотрудники пытались проявить инициативу. Представители Uptime Institute, замечая сторонние обсуждения, сразу же задавали дополнительные вопросы.

Первый день был ознакомительным: инспектор осматривал ЦОД на соответствие проектной документации.

На следующий день для ключевого тестирования Uptime Institute нужно было дать полную нагрузку ЦОД – как тепловую, так и в части энергопотребления. Нагрузку имитировали специально установленные тепловые пушки мощностью 30-100 кВт.

Для некоторых тестов оборудование переводилось в критический режим, и были опасения, что системы не выдержат. Чтобы обезопасить оборудование от возможных последствий (как говорится, береженого Бог бережет), мы пригласили инженеров со стороны производителей оборудования.

За всем происходящим из диспетчерской в режиме реального времени наблюдал один из инспекторов Uptime Institute – Фред Дикерман. Автоматизированная система диспетчерского управления и множество датчиков позволяли отслеживать текущее состояние оборудования и изменение температур в машинных залах.

Результаты сертификации показали, что мы изначально заложили верные технические решения, все корректно смонтировали и запустили. Со слов экспертов, данный ЦОД оказался единственным в России, который прошел проверку Uptime Institute без замечаний.

А напоследок – видеоролик о нашем проекте в «Жигулевской долине»

Комментарии (8)

Vycheslav123 Автор

17.04.2018 13:58+1Да, представительство ЛАНИТ есть и в Самаре, и в Тольятти.

Что касается условий для резидентов, с точки зрения ИТ, они действительно супер. Особенно учитывая, что ЦОД находится на территории технопарка и имеет большое количество оптических каналов от корпусов до непосредственно дата-центра.

PMVyatkin

18.04.2018 11:39Про Ланит в Самаре — вроде года три назад было что то — ходили ребята на спартакиаду, были вакансии на НН постоянные.

Сейчас не видно ни вакансий, на спартакиаду последнюю никто не пришел от Ланита, все знакомые слились кто куда оттуда.

То ли проектов нет, то ли в Мск выгоднее сидеть.

kladus

17.04.2018 22:19А с какими неочевидными проблемами вы столкнулись и если бы была возможность начать все сначала, что бы сделали иначе?

Vycheslav123 Автор

18.04.2018 11:44Нам пришлось вписываться в существующее здание. Заказчик требовал обеспечить высокую энергоэффективность, поэтому пришлось проводить дополнительные проектные изыскания и расчеты.

Если бы была возможность начать проект с нуля, мы бы рассматривали в первую очередь другое решение по конструктиву и оснащали одноэтажное здание.

Vycheslav123 Автор

18.04.2018 11:41Часть кадров мы сделали на этапе строительства. А благоустройством занимались перед вводом объекта в эксплуатацию.

tlv

18.04.2018 12:09Зря так нещадно пожали фотографии — их хотелось бы иметь покрупнее буквально все, чтобы поразглядывать в подробностях.

PMVyatkin

За статью спасибо, интересно и сделано очень клево — подробно, с фото и все по порядку. — плюсы однозначно.

В первую очередь, очень рад за родную Самарскую область, в которой будет нормальный дата-центр и, надеюсь, это даст некоторое развитие тому домену ИТ-компаний, что там работают, а так же поможет появлению новых.

Посмотрим, что теперь там развернется — обещали вроде бы суперусловия для резидентов.

P.S. Кстати, у Ланита же был офис в Самаре? )) Из Мск же ходят каждый день поезда новые, ехать ночь — по цене 1000 рублей/чел.