Всего через несколько месяцев после окончательного ухода Nebula, компания Mirantis представляет свою платформу Unlocked Appliance для развертывания OpenStack инфраструктуры.

Nebula на протяжении 4х лет пыталась продавать OpenStack решения «в железе», но в очередном раунде не смогла привлечь новые инвестиции для поддержания стартапа. Дождаться готовности рынка к массовым покупкам платформы с OpenStack так и не удалось. О том, что в Nebula поторопились с выходом на рынок говорили многие (и даже в финальном пресс-релизе о закрытии проекта это тоже было отмечено). Однако, по всей видимости, маркетинг в Mirantis считает, что сейчас-то время пришло и пора начать завоевывать клиентов.

Mirantis хорошо известен своим OpenStack дистрибутивом и изначально фокусировался на разработке ПО и оказании сервиса, а никак не на «железной» составляющей. Имея хорошую экспертизу и пул лояльных клиентов, можно с гораздо большим успехом начать продвижение комплексных решений, чем просто выпустив железо в продажу. Кроме того, если использовать «свое» железо, можно снизить косты на поддержку — с протестированной конфигурацией меньше проблем. А клиенту, по большому счету, не так важно, чье оборудование использовать. Если весь комплекс от Mirantis окажется, с точки зрения операционных затрат, немного дешевле “самосборного конструктора”, то игра вполне стоит свеч. Mirantis Unlocked Appliance будет продаваться через партнеров, таким образом, не потребуется раздувать штат инженеров и гонять их по всему миру.

Mirantis Unlocked Appliance позволит заказчику развернуть OpenStack инфраструктуру без необходимости самостоятельно подбирать оборудование. Если подбор оборудования не так уж и страшен, то последующая инсталляция, тестирование и “допиливание”, чтобы “взлетело”, — основной источник проблем. Вот здесь и раскрывается главное преимущество любой законченной системы — скорость развертывания. Заказчика уже больше не должна тревожить сложность запуска OpenStack. После развертывания системы инженерами интегратора (на которое не потребуется много времени) можно сразу приступать к запуску виртуальных машин и заниматься решением бизнес-задач, а не вопросами администрирования.

В Unlocked Appliance, отсутствует какая-либо привязка к производителю ПО — заказчик может сам выбирать тот гипервизор, который удовлетворяет необходимым требованиям.

Анонсированная система масштабируется от 6 до 51 вычислительного узла, что позволяет одновременно запускать более 1500 виртуальных машин (4vCPU, 8GB памяти и 60GB диск). Система хранения обеспечивает от 12 до 48TB доступного для использования пространства (Ceph). Безусловно, такое решение ориентировано не на малый бизнес, за который ведут борьбу VMware c EVO RAIL, Nutanix, SimpliVity и другие. Даже в минимальной конфигурации нам потребуется установить шкаф с 12 серверами. Максимальная же конфигурация, которая сейчас доступна — 2 шкафа.

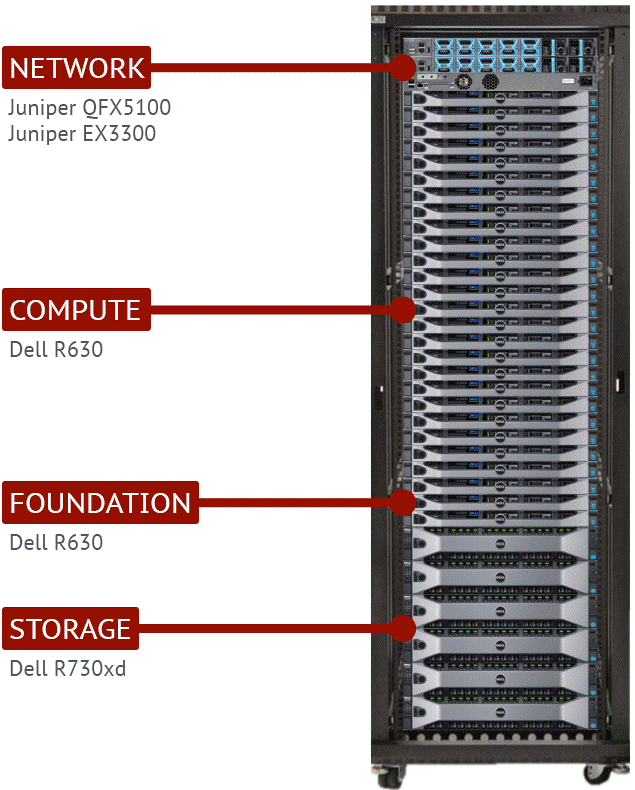

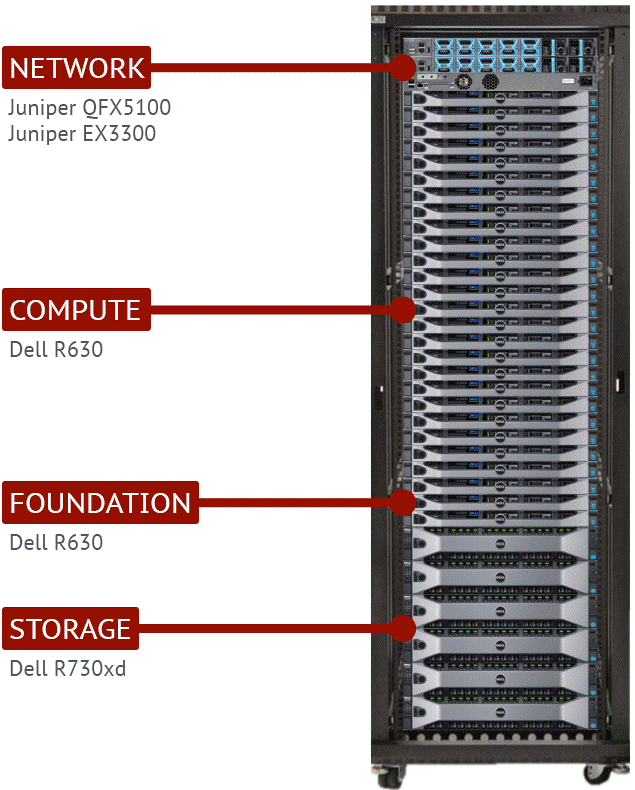

Mirantis Unlocked Appliance построен на базе серверов Dell и сетевого оборудования Juniper. Вычислительные узлы (Compute node — 6-51шт) и управляющие ноды (Foundation node — 3шт) это серверы Dell R630 в конфигурации с двумя процессорами Intel Xeon E5-2640, 256GB оперативной памяти и SSD 400GB. Узлы хранения (Storage node — от 3 до 12шт) — серверы R730xd в конфигурации с двумя процессорами Intel Xeon E5-2620, 256GB оперативной памяти, 4*100GB SSD, 20*1.2TB SAS дисками и 2*1.2TB дисками для ОС.

Все серверы объединены в сеть через 10Gbit адаптеры (по 2 линка для вычислительных узлов и по 4 линка для узлов хранения).

В качестве TOR (top of rack) коммутаторов в каждом шкафу используются два Juniper QFX5100-48S (шкафы объединяются через 40Gbit линки), а для сети управления — Juniper EX3300-48T.

После инсталляции Mirantis OpenStack, пользователи получают:

Mirantis Cloud Validation Suite (MCV) используется для финальной проверки системы после инсталляции на площадке заказчика. MCV не удаляется и позволяет заказчику в дальнейшем проверять систему и формировать профили производительности на протяжении жизненного цикла — например после установки апдейтов.

Для многих среднего размера компаний OpenStack пока остается «игрушкой» именно по причине недостатка законченных решений, не требующих существенных затрат на развертывание и поддержку. Законченное решение от Mirantis позволит сделать OpenStack ближе к бизнесу. Ниша, в которой должен «стрелять» Mirantis Unlocked Appliance, весьма привлекательна — она охватывает рынок серьезных инсталляций, где уже нет «пионеров» с двумя-тремя серверами, но еще нет сотен серверов, когда компания может позволить серьезную внутреннюю экспертизу (как например у Wallmart).

А если Mirantis сертифицирует еще несколько вариантов аппаратных платформ, это только усилит позицию на рынке.

Сейчас, когда интерес к OpenStack растет, многие производители аппаратного обеспечения будут пытаться занять свою долю, но успех во многом будет зависеть от того, насколько хорошо будет доработана программная составляющая. А именно здесь у Mirantis очень сильные позиции. Даже не сомневаюсь, что HP со своим Helion будет всячески пытаться захватить максимум рынка, но вот получится ли?

Nebula на протяжении 4х лет пыталась продавать OpenStack решения «в железе», но в очередном раунде не смогла привлечь новые инвестиции для поддержания стартапа. Дождаться готовности рынка к массовым покупкам платформы с OpenStack так и не удалось. О том, что в Nebula поторопились с выходом на рынок говорили многие (и даже в финальном пресс-релизе о закрытии проекта это тоже было отмечено). Однако, по всей видимости, маркетинг в Mirantis считает, что сейчас-то время пришло и пора начать завоевывать клиентов.

Mirantis хорошо известен своим OpenStack дистрибутивом и изначально фокусировался на разработке ПО и оказании сервиса, а никак не на «железной» составляющей. Имея хорошую экспертизу и пул лояльных клиентов, можно с гораздо большим успехом начать продвижение комплексных решений, чем просто выпустив железо в продажу. Кроме того, если использовать «свое» железо, можно снизить косты на поддержку — с протестированной конфигурацией меньше проблем. А клиенту, по большому счету, не так важно, чье оборудование использовать. Если весь комплекс от Mirantis окажется, с точки зрения операционных затрат, немного дешевле “самосборного конструктора”, то игра вполне стоит свеч. Mirantis Unlocked Appliance будет продаваться через партнеров, таким образом, не потребуется раздувать штат инженеров и гонять их по всему миру.

Mirantis Unlocked Appliance позволит заказчику развернуть OpenStack инфраструктуру без необходимости самостоятельно подбирать оборудование. Если подбор оборудования не так уж и страшен, то последующая инсталляция, тестирование и “допиливание”, чтобы “взлетело”, — основной источник проблем. Вот здесь и раскрывается главное преимущество любой законченной системы — скорость развертывания. Заказчика уже больше не должна тревожить сложность запуска OpenStack. После развертывания системы инженерами интегратора (на которое не потребуется много времени) можно сразу приступать к запуску виртуальных машин и заниматься решением бизнес-задач, а не вопросами администрирования.

В Unlocked Appliance, отсутствует какая-либо привязка к производителю ПО — заказчик может сам выбирать тот гипервизор, который удовлетворяет необходимым требованиям.

Анонсированная система масштабируется от 6 до 51 вычислительного узла, что позволяет одновременно запускать более 1500 виртуальных машин (4vCPU, 8GB памяти и 60GB диск). Система хранения обеспечивает от 12 до 48TB доступного для использования пространства (Ceph). Безусловно, такое решение ориентировано не на малый бизнес, за который ведут борьбу VMware c EVO RAIL, Nutanix, SimpliVity и другие. Даже в минимальной конфигурации нам потребуется установить шкаф с 12 серверами. Максимальная же конфигурация, которая сейчас доступна — 2 шкафа.

Mirantis Unlocked Appliance построен на базе серверов Dell и сетевого оборудования Juniper. Вычислительные узлы (Compute node — 6-51шт) и управляющие ноды (Foundation node — 3шт) это серверы Dell R630 в конфигурации с двумя процессорами Intel Xeon E5-2640, 256GB оперативной памяти и SSD 400GB. Узлы хранения (Storage node — от 3 до 12шт) — серверы R730xd в конфигурации с двумя процессорами Intel Xeon E5-2620, 256GB оперативной памяти, 4*100GB SSD, 20*1.2TB SAS дисками и 2*1.2TB дисками для ОС.

Все серверы объединены в сеть через 10Gbit адаптеры (по 2 линка для вычислительных узлов и по 4 линка для узлов хранения).

В качестве TOR (top of rack) коммутаторов в каждом шкафу используются два Juniper QFX5100-48S (шкафы объединяются через 40Gbit линки), а для сети управления — Juniper EX3300-48T.

После инсталляции Mirantis OpenStack, пользователи получают:

- три контроллера OpenStack в отказоустойчивой конфигурации (база данных OpenStack располагается на MySQL/Galera);

- cетевое окружение Neutron OVS+VLAN;

- cистему хранения на базе Ceph — Glance, Cinder и Swift-API:

— Ephemeral тома, настроенные на поддержку live migration через Ceph;

— Трехкратную репликацию для защиты данных; - cервисы мониторинга Ceilometer и Zabbix. Для хранения данных Ceilometer на серверах управления развернута MongoDB.

Mirantis Cloud Validation Suite (MCV) используется для финальной проверки системы после инсталляции на площадке заказчика. MCV не удаляется и позволяет заказчику в дальнейшем проверять систему и формировать профили производительности на протяжении жизненного цикла — например после установки апдейтов.

Для многих среднего размера компаний OpenStack пока остается «игрушкой» именно по причине недостатка законченных решений, не требующих существенных затрат на развертывание и поддержку. Законченное решение от Mirantis позволит сделать OpenStack ближе к бизнесу. Ниша, в которой должен «стрелять» Mirantis Unlocked Appliance, весьма привлекательна — она охватывает рынок серьезных инсталляций, где уже нет «пионеров» с двумя-тремя серверами, но еще нет сотен серверов, когда компания может позволить серьезную внутреннюю экспертизу (как например у Wallmart).

А если Mirantis сертифицирует еще несколько вариантов аппаратных платформ, это только усилит позицию на рынке.

Сейчас, когда интерес к OpenStack растет, многие производители аппаратного обеспечения будут пытаться занять свою долю, но успех во многом будет зависеть от того, насколько хорошо будет доработана программная составляющая. А именно здесь у Mirantis очень сильные позиции. Даже не сомневаюсь, что HP со своим Helion будет всячески пытаться захватить максимум рынка, но вот получится ли?

nutanix

> Безусловно, такое решение ориентировано не на малый бизнес, за который ведут борьбу VMware c EVO RAIL, Nutanix, SimpliVity и другие.

Спасибо за признание наших скромных заслуг, но вот непонятно, фразу выше надо понимать, что мы уже энтерпрайз завоевали, и нам осталось только за малый бизнес побороться, или как?

Потому что 10 тысяч VDI-мест в Пентагоне и 240-нодовая система на которой работает ныне bestbuy.com это явно не «малый бизнес». Да и 48 теребайт максимальной емкости это как-то даже смешно, с учтом того, что у NX-6235C 60TB raw space помещается в 2RU, и таких в кластере может быть сколько угодно много.

exLH

Можно понимать так, что за малый бизнес борьба идет ожесточенная. Но наверное ваше возмущение точно не стоит понимать как то, что от борьбы с EVO за SMB Nutanix отказался? :-)

60TB raw конечно хорошо, но 48ТБ usable (после троекратной реплики и учета всех «запасов») это совсем другой расклад. «Сколь угодно много» это не очень аккуратный термин — конечно сейчас в моду у многих производителей входит фраза «бесконечное число узлов». В реальности часто оказывается, что тестировали целых 16, но «в теории» предела нет. А предел он находится потом, в самый неприятный момент. Еще Бартльбум писал в своей энциклопедии пределов, что «Природа совершенна, поскольку не бесконечна. {...} Главное — познать пределы.» В какой-то момент начинаются проблемы с задержками, с интерконнектом или с чем-то еще, но пока «никому в здравом уме не требуется больше 640КБ оперативной памяти» — все хорошо и бесконечность почти рядом.

Кроме того вы же прекрасно понимаете, что {фактически любой} appliance это не более чем «упаковка» наиболее подходящей (для определенного круга клиентов) конфигурации железа в программно-аппаратный бандл. И уверен, что также прекрасно понимаете, если бы стояла задача получить 5PB usable, то в случае с OpenStack это не такая уж и серьезная проблема. Могу сделать предположение, что целевая аудитория оказалась заинтересована в указанных величинах, а не иных. А то можно было бы поставить несколько Sandisk InfiniFlash IF100 в 0.5PB каждая и легким росчерком довести ценник до нескольких мультов. Много ли клиентов на такой appliance найдется? :)

shapa

«60TB raw конечно хорошо, но 48ТБ usable (после троекратной реплики и учета всех «запасов») это совсем другой расклад.»

Ну зачем-же свою необразованность так прям открыто. Вы про Erasure Code читали? Нет? Прочтите ;)

~25% места всего потери от RAW. При тройной защите данных и прочих плюшках.

www.nutanix.com/2015/06/17/erasure-coding-x-ec-x-predictably-increase-usable-storage-capacity

То что на Dell железках сделали — молодцы, заодно изучите Dell XC серию :)

p.s. про борьбу за рынок SMB — насмешили знатно. Это конечно ничего что мы более 52% рынка гиперконвергентных решений уже заняли? :)

exLH

Ну конечно про erasure code слышали, 25% это конечно прекрасно (даже готов считать, что бесплатно они нам достались и контрольные суммы были ниспосланы свыше, без затрат процессорных ресурсов, хотя конечно, положа руку на сердце, и не совсем так). Никто же не говорит, что ваш Nutanix это плохо и не работает. Зачем так болезненно воспринимать все — никто на вас не нападает? С таким напором нужно с vmware ругаться про производительность VSAN (конечно, у каждого лицензионные соглашения такие удобные, что не подравниваешь публично, но хоть поругаться можно на публике :)

Вы там определитесь между собой, борьба за SMB есть или нет? :) Мне сдается, что есть. Про что и сказано. Или это vmware сдалась? Я что-то не уверен.

shapa

Когда кто-то несет полную ахинею, плюс пытается продать откровенно кривой продукт — отчего-же не вмешаться?

1) Да, мы вообще не ориентированы на SMB и не продаем туда.

Как и EVO:RAIL кстати не ориентирован на SMB.

2) Про контрольные суммы и прочее — не знаю куда вы руку кладете, но явно надо на голову ;). У нас контрольные суммы изначально считаются. Дело в том что SHA1 и прочее — это давно аппаратно реализовано в современных CPU от Интела. На которых мы и базируемся (Haswell на такущий момент). Или CEPH не считает контрольные суммы на процессорах? :D

shapa

Изучите, для образования.

software.intel.com/en-us/articles/intel-sha-extensions

exLH

Ой, а кто-то здесь продавал что-то кроме парней из Nutanix? Вам показалось, поверьте :-)

Круто. А для кого делали habrahabr.ru/company/nutanix/blog/254101 такие штуки? Или сами забыли? :) Или не пошло в «наш» SMB?

Суммы считает процессор, да. Сам, за просто так. Но вот тут habrahabr.ru/company/nutanix/blog/260685 ваши специалисты пишут «у нас начинает работать специальный фоновый процесс, похожий...» Фоновый процесс поди ж не святы духом питается? Об том и говорим. Да, фоновый, да, старается не мешать. Но, опять-таки, фоновый не значит что мигом получаем 25% оверхеда — сначала нужно потрудиться. И я все-таки повторюсь, никто не говорит, что у вас там что-то плохо. У вас — отлично! :) Но речь вот только не про это.

shapa

Да, EVO для SMB — это вы феерически загнули. У EVO:RAIL прайс — 200$k. Это где-ж вы таких SMB видали?

… Надеюсь, статью доверили писать наемному студенту, а не работнику компании.

exLH

А, ну если мы про «наш» smb, то согласен, но тогда только Nutanix и желательно без лицензий на гипервизор (и да, я знаю, что он у вас есть).

И еще чаще 2-3 сервера отдельных.

shapa

18 тысяч вроде как :) или больше.

shapa

archive.federaltimes.com/article/20141017/FEDIT03/310170025/Pentagon-s-virtualized-desktop-infrastructure-reaches-18-000-computers

«Pentagon's virtualized desktop infrastructure reaches 18,000 computers»

exLH

Путаетесь — коллега ваш про физические узлы, а вы про виртуальные десктопы. VDI ваш конек, все знают, но не про них сейчас :)

shapa

Вообще, поведение Мирантиса после того как мы отправили их лесом (деньги требовали за поддержку их кривым опенстаком Nutanix, при том что мы сами написали драйвер для Cinder и всячески готовы были сотрудничать) — очень забавно.

Но не суть. Возьмем лучше реальные отзывы, особенно про Мирантис Опенстак и CEPH :)

shapa

www.facebook.com/anton.zhbankov/posts/874517942609354

?#?OpenStack? day. Перлышки

— «RTO — 99,999%» — новое слово в проектировании

*

— «SLA — время применения политик с контроллера». Но как всегда без штрафных санкций

*

— клиент не знаком с software development culture, поэтому ему было трудно обьяснить зачем надо тестировать три раза перед развертыванием

*

— Почему телеком, очень консервативный по сути, отказался от индустриальных стандартов и взял OpenStack для управления сетью?

— Это очень смелый клиент

*

— Больше всего подходил OpenStack, но не совсем подходил, поэтому мы еще больше года его дорабатывали. Была ошибка выбора opensource object storage, система постоянно разьезжалась. В итоге мы перешли на NetApp.

*

— следующая тяжелая проблема — HA для KVM. Все еще дорабатываем. Мы все еще перепиливаем OpenStack.

*

— при миграции машин на iSCSI могли оторваться диски.

*

— гибридное облако — это когда половина на KVM, а друга половина на VMware

*

— на самом деле это система учета, но мы ее назвали биллинговой

*

— в классическом OpenStack плохое взаимодействие с VMware, поэтому мы решили внедрять SDN

*

— Как вы делаете бэкап для KVM?

— Это больной вопрос.

*

— в opensource не все работает как заявлено.

*

— рынок Татарстана не такой неограниченный как Москва.

*

Tionix Cloud.Control на базе mirantis openstack реализовал функционал VMware VI3.5 2007 года

Tionix UKSM — сверхмодная фишка, цельнотянутая с VMware Transparent Page Sharing две тысячи лохматого года.

Докладчик был удивлен, что VMware и MS были уже давно сертифицированы ФСТЭКом. Про альтернативы не слышал в принципе. Tionix собрал аж 10 велосипедов сразу — гипервизоры, схд, видеонаблюдение и так далее. Еле дотянув до 2006-2007 года по заявленному функционалу.

Tionix.HW — блейд серверы. 6 однопроцессорных машин с 32 памяти и гигабитом в 6u. Enterprise по-казански.

*

Мирантису не нужно продумывать сценарий живого демо. Ну откроем консольку, и как-нибудь что-нибудь покажем.

Логика выступления — это мещанский предрассудок, а стори-теллинг и вовсе буржуазный пережиток. Презентация Эльдорадо-стайл наше все!

*

— Вы говорили о больших плюсах использования единого ceph под резервные копии и оперативное хранение. А как вы прокомментируете судьбу CloudMouse и смерть 22 000 ВМ?

— Наверное у них не было тех поддержки. Следующий вопрос.

*

Выступление инженера из Mirantis ceph group. Все аргументы сводятся к байкам типа «большая корпоративная коробка не будет работать по обычному 10 Гбит, вам надо будет поставить 40 или даже Infiniband», и к «это вам не нужно». Глубокий опыт реальных инфраструктур чувствуется в каждом слове.

*

И наконец ceph fs — самая молодая, но не рекомендуемая часть ceph, кластерная шаренная fs.

*

CERN использует ceph на 3 петабайта, но там была проблема — Windows в виртуалках на ceph иногда при поднятии падают в BSOD.

*

Все SSD нужно вручную указывать ceph, сам он не умеет распознавать.

*

Mirantis OpenStack не поддерживает большинство операций с ceph в UI. Например SSD кэш надо конфигурировать из командной строки. Мы также не рекомендуем использовать на нодах одновременно хранение и исполнение ВМ.

*

Facebook использует много решений, которые остальным кажутся странными.

*

Предсказать будущее облачного рынка сейчас можно с таким же успехом, как если ехать по лесу ночью с выключенными фарами и ориентироваться по зеркалам заднего вида.

*

Linux — это когда каждый может прийти и наконтрибьютить.

*

FreeBSD — это тот же Linux, только поддерживают его компании пожиже и поменьше.

*

Тема задана «OpenSource в Enterprise». Докладчик 10 минут рассказывает про Linux, еще 10 про то, как крута Mirantis и OpenStack.

Где обещанный enterprise и opensource в нем?

*

Ну и как же без доклада без определения облака, особенно под конец дня.

*

OpenStack из коробки не работает. Иногда его надо допиливать несколько лет.

*

Вопрос «проводили ли вы сравнение экономии на opensource с потерянным продуктивным временем и увеличенным штатом и стоимости лицензий на проприетарный софт, работающий из коробки» до сих пор ставит докладчика в тупик.

*

— Уже много раз сегодня слышал, что из коробки OpenStack либо не работает, либо работает не очень. Что делать, если в компании принципиально не ведется in house разработка?

— Надо выбрать кому хочется платить — вендору или интегратору. А также подумать насчет подвинуться в политике и стать современее — превратить администраторов в девопс.

Вот так вот. Взять и поменять всю структуру компании и модель работы под продукт, чтобы заработать мог не вендор, а интегратор.

*

To be updated

exLH

Ах, если бы я собирал все глупости, которые на конфах говорят и мне за это платили по 1 центу, ну вы поняли :)