Примерно вот так. Это часть вентиляторов, которые оказались лишними и были демонтированы из двадцати серверов в тестовой стойке, размещенной в ЦОД DataPro. Под катом — трафик. Иллюстрированное описание нашей системы охлаждения. И нежданное предложение для очень экономных, но чуточку бесстрашных владельцев серверного оборудования.

Система охлаждения серверного оборудования на базе контурных тепловых труб рассматривается как альтернатива жидкостной системе. Сравнимая по эффективности, она дешевле во внедрении и эксплуатации. При этом, даже в теории не допускает протечек жидкости внутри дорогостоящего серверного оборудования.

В прошлом году в ЦОД DataPro была смонтирована наша первая экспериментальная стойка. В её составе — сорок одинаковых серверов Supermicro. Первые двадцать из них со штатной системой охлаждения, вторые двадцать — с модифицированной. Цель эксперимента — проверить применимость нашей системы охлаждения в реальном дата-центре, в реальной стойке, в реальных серверах.

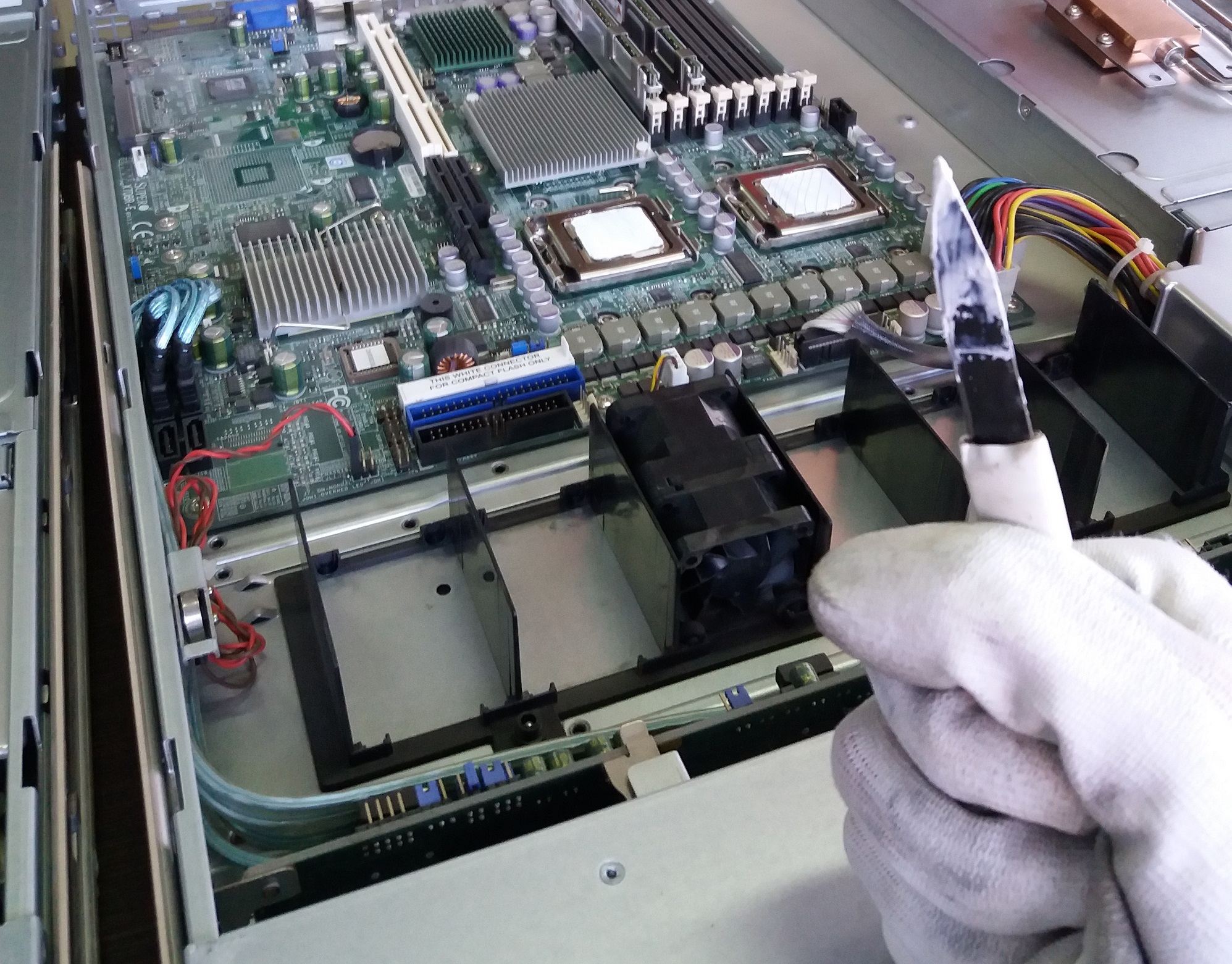

Извиняюсь за качество некоторых фото. Тогда особо не заморачивались, а сейчас нет возможности переснять процесс. Также многие фото — вертикальные. Как и герой этой публикации, серверная стойка.

Вверху стойки разместились обычные сервера. Внизу — шина теплообмена с устройствами прижима для серверов необычных, (почти) безвентиляторных. Вентиляторы остались только для обдува памяти. С процессоров тепло выводится на теплообменник с помощью наших контурных тепловых труб. А с теплообменника тепло по жидкостной шине уходит куда-то еще.

Это может быть уличный адиабатик. Такие ставят на крышах зданий. Или рядом со зданиями.

А может, например, система отопления. Или эко-ферма для выращивания овощей. Или теплый уличный бассейн. Или какой-то еще плод вашей фантазии. Требующий температуры теплоносителя 40-60°C.

Стойка в сборе выглядит так.

Вид на термоинтерфейсы. Не нужно пугаться, это только первая ревизия.

Еще более суровый вид. Да, это Made In Russia. :)

Вторая ревизия будет выглядеть заметно менее сурово. Возможно даже чуток симпатично.

Ищем экономных и отважных

Сегодня мы вплотную подошли к задаче сборки новой стойки. На базе второй ревизии нашей серверной системы охлаждения. Размещена она будет так же в ЦОД ДатаПро. Но что требуется для этого? Ни много ни мало — сорок однотипных горячих серверов.

Мы готовы сами приобрести какие-то горячие, хоть и не сильно новые сервера для наших нужд. Но перед этим грех не поинтересоваться у хабра-сообщества. Быть может, кто-то хочет поучаствовать своим железом в нашем эксперименте?

В таком случае у нас появится шанс поработать с чем-то гораздо более свежим, чем мы приобретем самостоятельно. И, что значительно более ценно, это что-то будет работать под реальной, а не синтетической нагрузкой.

В обмен от нас — бесплатная интеграция нашей системы охлаждения в вашу серверную стойку. Примерная рыночная стоимость такого "апгрейда" — около 1,5 млн.руб. От наших партнеров, компании ДатаПро — скидка на размещение такой модифицированной стойки в их дата-центре. Размер скидки будет обсуждаться дополнительно с заинтересованной стороной.

Мы имеем возможность вносить модификации в серверное оборудование с сохранением гарантийных обязательств. Уже заключены партнерские соглашения с Lenovo, IBM и DELL и мы работаем над расширением этого списка.

Всех отважных буду рад видеть в личке webself здесь на хабре или по любому контакту, указанному в моем профиле. А тем, кому интересна тема охлаждения (в том числе серверного) компьютерного оборудования, напоминаю про наши соцсети ВКонтакте и Instagram. В них скоро ожидается появление некоторого количества познавательного видео-контента. Не позвольте себе пропустить.

Комментарии (43)

Crazyvlad

13.06.2019 20:48Подскажите, как охлаждение дисков и чипсета организовано?

norguhtar

13.06.2019 21:01+1Вентиляторами. Тут писали и до этого писали, это отвод на самую тепловыделяющую часть.

webself Автор

13.06.2019 23:27Да, мы убираем не все вентиляторы, а только те, что напротив процессоров. Наши испытания показывают, что в таком режиме не происходит какой-либо деградации охлаждения дисков/памяти/чипсета. При том, что сервер начинает потреблять значительно меньше холодного воздуха для своего охлаждения.

Tomas_Torquemada

14.06.2019 09:37HPEшные, например, серверы в определённых конфигурациях просто не будут запускаться, если снять часть вентиляторов.

Может и у других вендоров так, не берусь утверждать. Как с этим думаете справляться?

webself Автор

14.06.2019 09:42Путем общения с вендорами. Как показывает практика, производители серверов нам очень рады. Мощность процессоров увеличивается (я про потребляемую), воздушная система с такой возрастающей нагрузкой справляется плохо. Приходится ставить полупустые стойки, чтобы укладываться в нормативы ДЦ. Серверов из-за этого мало продается. Водянку клиенты не особо жалуют пока. Очень дорого и не менее страшно.

oller

13.06.2019 21:41не знаете где купить ультратонкие переходники питание на видеокарты?

нужно вставить 1080-1070 в 1-2u сервера, все хорошо встает, но питание, выпирающие вверх+толстые переходники не дают поставить видеокарты

нужны для ffmpeg, просто не знаю у кого спрашивать, где искать

ExH

14.06.2019 00:40Рекомендую перепаять разъёмы питания на карте.

Мы взяли 1080 TI, перепаяли и всё отлично встало в 1U Supremicro 1027GR-TRF.

DuskMan

13.06.2019 21:52Это может быть уличный адиабатик. Такие ставят на крышах зданий. Или рядом со зданиями.

У ДатаПро один раз вышли из строя все внешние чиллеры вследствие шквалистого ветра, в другой раз были повреждени фреонопроводы, находящиеся на крыше вблизи очага возгорания.

Когда у серверов вовсе нет своих вентиляторов, то их даже выключить не успеешь при подобных сценариях… С вентиляторами чуток надежнее.

tzlom

13.06.2019 23:21Не трудно представить себе систему которая в случае аварии будет сбрасывать тепло в бак с парой тонн воды комнатной температуры. Более того — такой кран может быть пассивным компонентом.

Прикинем на коленке — допустим стойка выделяет 8кВт/час, дадим 10 минут на выключение серверов, получим 800 ватт/час или 2 880 000 джоулей. Предположим, комнатная температура 25 градусов, а нагревать будем до 50, т.е. нагреваем воду на 25 градусов. Получается нужно всего 27.42 кг воды.

Как уже написали ниже — выкатывание сервера представляет собой более интересную проблему

kisaa

14.06.2019 04:12представить себе систему которая в случае аварии будет сбрасывать тепло в бак с парой тонн воды

От этих слов повеяло Фукусимой :)

А 10 минут на 8кВт стойке — это всё же 1333 Вт*ч (800 выделится за 6 минут).

Tomas_Torquemada

14.06.2019 09:41+1Серверы и сами неплохо умеют выключаться при перегреве.

Что до «не успеешь» — это гипербола. Ну или в Вашем ЦОДе домны работают.

У нас недавно отключились все чиллеры — человечески фактор.

Расчётные 45 минут ЦОД отстоял без активного охлаждения и без единого сбоя и выключать ничего не пришлось.

osipov_dv

13.06.2019 22:06+1А как происходит выкатывание сервера на салазках вперед стойки?

webself Автор

13.06.2019 23:30Сервер отключается, теплоинтерфейс отсоединяется от вертикальной шины, сервер выдвигается.

osipov_dv

14.06.2019 09:05Прикольно, на фото не заметил краник, перекрытия хладогена до сервера.

Вам прошлось как-то обманывать систему мониторинга сервера, ведь она могла не стартовать, не найдя вентиляторы в нужном количестве…

webself Автор

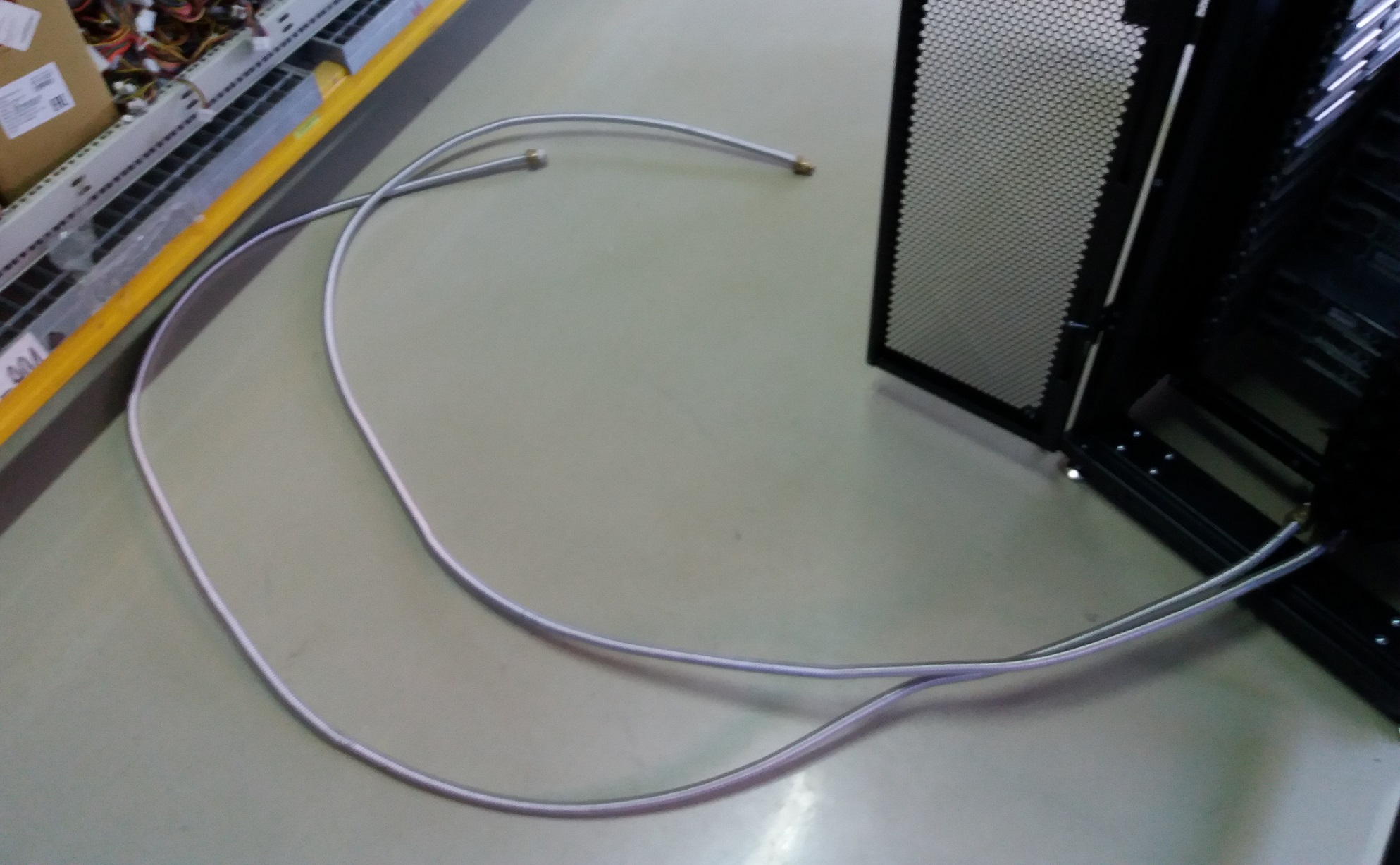

14.06.2019 09:45Не заметили, потому что нет там краника. Вертикальная шина имеет коннекторы жидкости только внизу. Сервер подключается к шине путем прижима к ней наших КТТ. У КТТ краников тоже нет никаких — это вакуумированные замкнутые трубки с хладагентом. В этом и соль. С системой мониторинга сервера, да, боремся.

X3_Shim

14.06.2019 18:04Имел опыт изготовления обманок вентиляторов. Ардуина. Имеет режим обучения. В режиме обучения к ней подключен кулер (который хотим заменить), ардуина управляет скоростью вращения во всем диапазоне, считывает характеристику оборотов кулера, пишет себе в табличку, потом кулер отключаем переводим в рабочий режим, ардуина принимает управляющий сигнал на кулер (которого нет) и по табличке отвечает ожидаемыми оборотами. Правда использовал я это в серверном БП, когда на воду его переводил (две недели под линпаком сервер простоял с этим БП :), потом эксперимент был свернут)

c_kotik

16.06.2019 21:25Не ужели нужна какая то табличка. вместо генератора сигнала пд определенные обороты?

X3_Shim

16.06.2019 21:55+1Ну вентиляторы там регулируемые. Мне даже генератор проще на ардуине было бы делать, так что потратил дополнительно час на программирование, что бы и табличка была. Может зря конечно, но зато заработало с первого раза без вопросов.

c_kotik

17.06.2019 09:55Они много где регулируемые. Просто вопрос в том, что нужно ли для муляжа так изголяться?) Насколько помню в пользовательских, система просто смотрит — есть ли ответ по оборотам и не ниже определенного значения. Но насчёт серверов все может быть хитрее. Вот хотелось бы ради интереса это прояснить.

chektor

13.06.2019 23:24Оперативность замены/ремонта невысокая. Рассматривался и рассчитывался ли вариант сброса тепла на боковые теплоотводы?

То есть, в самом рэке теплоотводы пассивные (металл, тепловые трубки), а уже боковые теплоотводы самой стойки имеют жидкостное охлаждение.

webself Автор

13.06.2019 23:32Вы имеете в виду, что в сервере теплоотвод на корпус, а затем через штатные рельсы на стойку? Не понял немного вопроса. Что за боковые теплоотводы?

chektor

13.06.2019 23:41Да, сама серверная плата, её горячие элементы, имеет теплоотводы (несколько) на боковые стенки шасси (рэка). Естественно, стандартные боковые стенки меняются на медные (алюминиевые) для улучшения отвода тепла. (Но не факт, что требуется замена. Вполне возможно, что и железная стенка обеспечит достаточную теплопередачу).

А стойка имеет ответные теплоотводящие стенки, которые уже могут охлаждаться жидкостью.

(Вопрос «механики» теплового контакта шасси и стойки я учитываю).

Max-812

13.06.2019 23:39Так а сравнение с традиционной системой можно увидеть? Вы вроде для этого и собирали первую стойку (20 на 20). Или там получились такие цифры, что лучше не показывать? :)

webself Автор

13.06.2019 23:52Можно будет увидеть, но немного позже. Отдельный пост будет. Сегодня только про внутрянку.

maxzhurkin

14.06.2019 06:01Если ручки — обязательный или почти обязательный атрибут, почему не обеспечить их чередование вправо-влево? Будет больше пространства между ручками

norguhtar

14.06.2019 08:01Кстати не думали сделать водоотводные блоки индивидуальными для каждого сервера с гибкой подводкой? Как я понимаю давление там не большое можно использовать даже стандартную гибкую сантехническую подводку в металлической оплетке. В этом случае проблем с выдвижением серверов не будет, только будет больше шлангов

webself Автор

14.06.2019 08:45Чем больше шлангов, тем больше фитингов. Получится не два на стойку, а до 84. Каждый фитинг — возможная точка отказа. По словам эксплуатантов жидкостных систем охлаждения, иногда текут даже идеальные импортные фитинги. Которые еще и стоят, как самолет. Дело даже не столько в качестве фитингов, сколько в умении персонала с ними обращаться. Это проблема жидкостных систем.

norguhtar

14.06.2019 08:48Это да, но в текущей схеме надо выключать сервер целиком в случае проведения работ.

webself Автор

14.06.2019 09:05Это да, но его гарантированно не зальет хладогентом :) Если серьезно, то нам надо понять серьезность этой проблемы. Ее и в прошлой публикации озвучивали читатели. Учитывая, что современные мощные сервера хостят виртуальные машины, причем хостят с резервированием, кажется, что вполне нормально мигрировать нагрузку с сервера и просто его выключить для обслуживания. Наша система как раз для горячих мощных серверов, которым с обычной системой охлаждения «тесно» рядом в стойке.

DrunkBear

14.06.2019 11:42Теперь понятно, чем охлаждать последние Xeon Platinum c TPD в 400 Вт.

Кстати, на какой тепловой пакет расчитана КТТ?

webself Автор

14.06.2019 13:06А можете конкретней сказать, что за процессор с TDP 400Вт? Я на сайте интела сейчас максимум с 205Вт на чип. В целом 400Вт реально снять нашими трубами, но будет ряд нюансов. Нет такого понятия, как тепловой пакет КТТ. Переносимость тепла трубами от многих факторов зависит. Например от разницы температур между источником и приемником тепла.

DrunkBear

14.06.2019 13:10Например, вот

Линейка Xeon Platunum 92xx, которая должна побить свежие AMD Epyc.

webself Автор

14.06.2019 13:11Нашел. Platinum 9282. Почему-то на него не полная спецификация. Не указана максимальная температура работы. Она у разных процессоров сильно разная может быть. Нам нужна высокая максимальная температура, в районе 90 градусов.

norguhtar

Хм. А где фото той части, что стоит на процессоре? А так да нанотехнологии. В России все что сделано ключом меньше чем на 22 нанотехнологии.

webself Автор

Верхний правый угол второго фото. И в прошлом посте были фото того, что внутри сервера: habr.com/ru/company/thercon/blog/452910