Продолжение рассказа о революции инновационных об эволюции необычных систем охлаждения серверного оборудования. Фото-подробности второй версии системы охлаждения, установленной на реальной серверной стойке в реальном дата-центре DataPro. А также — приглашение своими руками пощупать третью версию нашей системы охлаждения. 12 сентября 2019 года на конференции "ЦОД-2019" в Москве.

Серверные КТТ. Версия 2

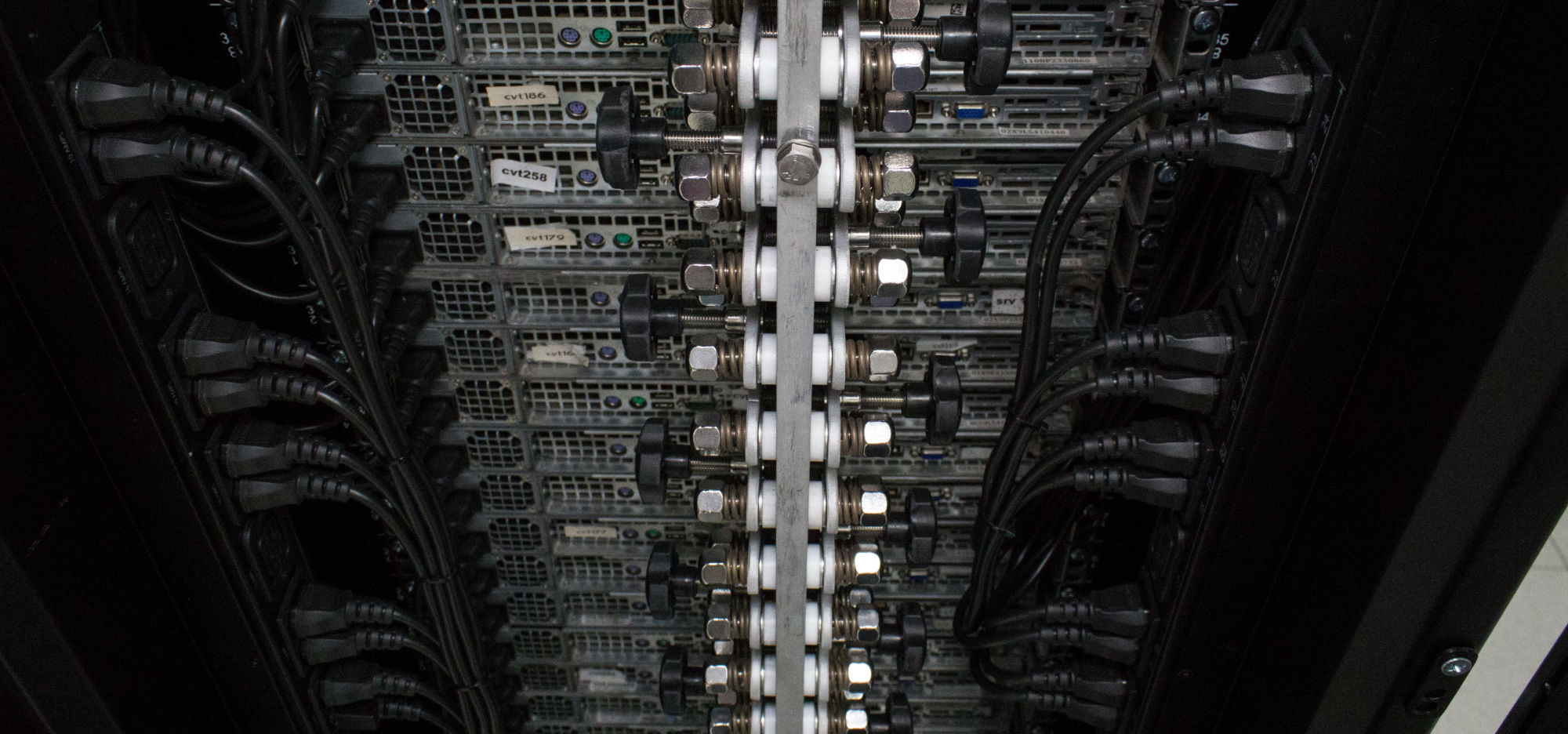

Главной претензией к первой версии системы охлаждения была ее механика. Почему-то в комментариях к предыдущей статье вот с этим фото:

… никто особо не обратил внимание на то, что доступ ко всей правой части задней панели сервера становится практически невозможным. Только один наблюдательный читатель предложил чередовать лево-право размещение наших крепежей.

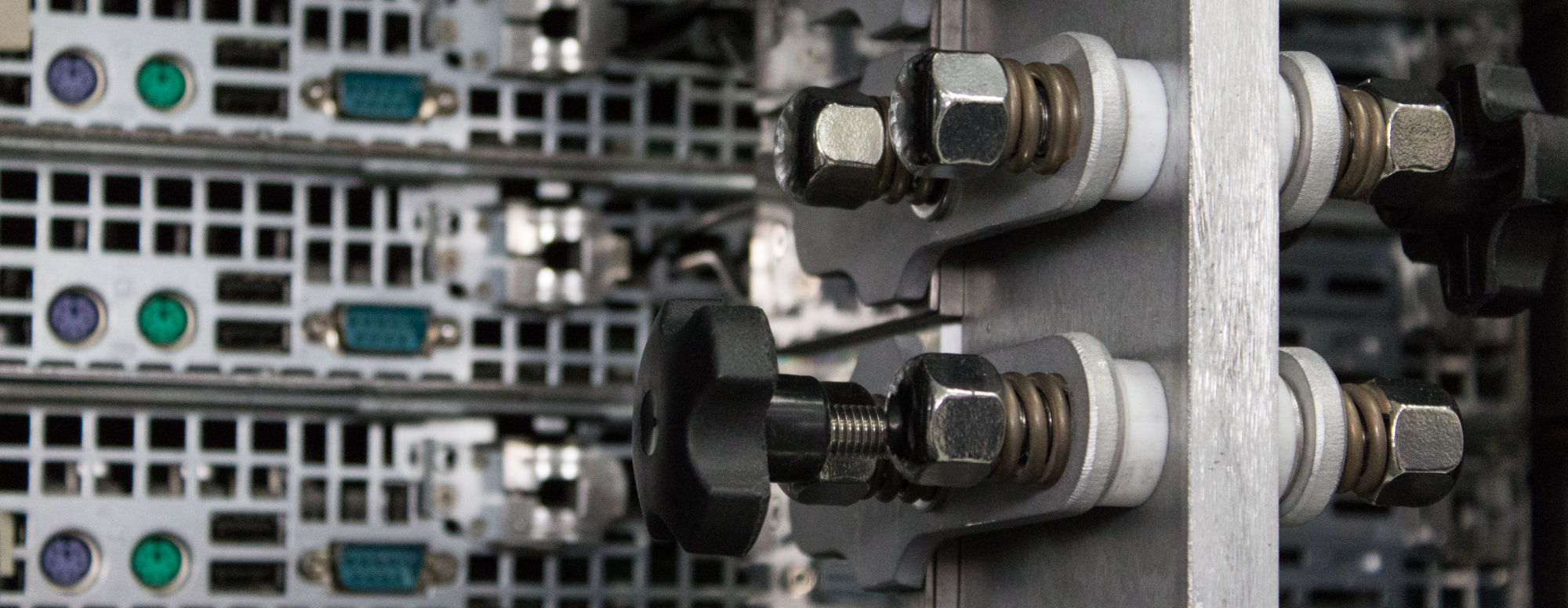

Необходимость использования столь монстрообразного крепежа была вызвана желанием обойтись без термопасты в месте крепления теплообменника, выходящего из сервера к вертикальной жидкостной шине. Термопаста в таком разъемном соединении очень не желательна. А чтобы можно было ее не использовать, требуется развивать значительное усилие прижима.

Во второй версии мы применили другую систему крепежа. Шина стала значительно компактнее. И приобрела уже менее "made in ussr" внешний вид.

Присутствуют даже блестящие элементы конструкции. Стильно, модно, молодежно.

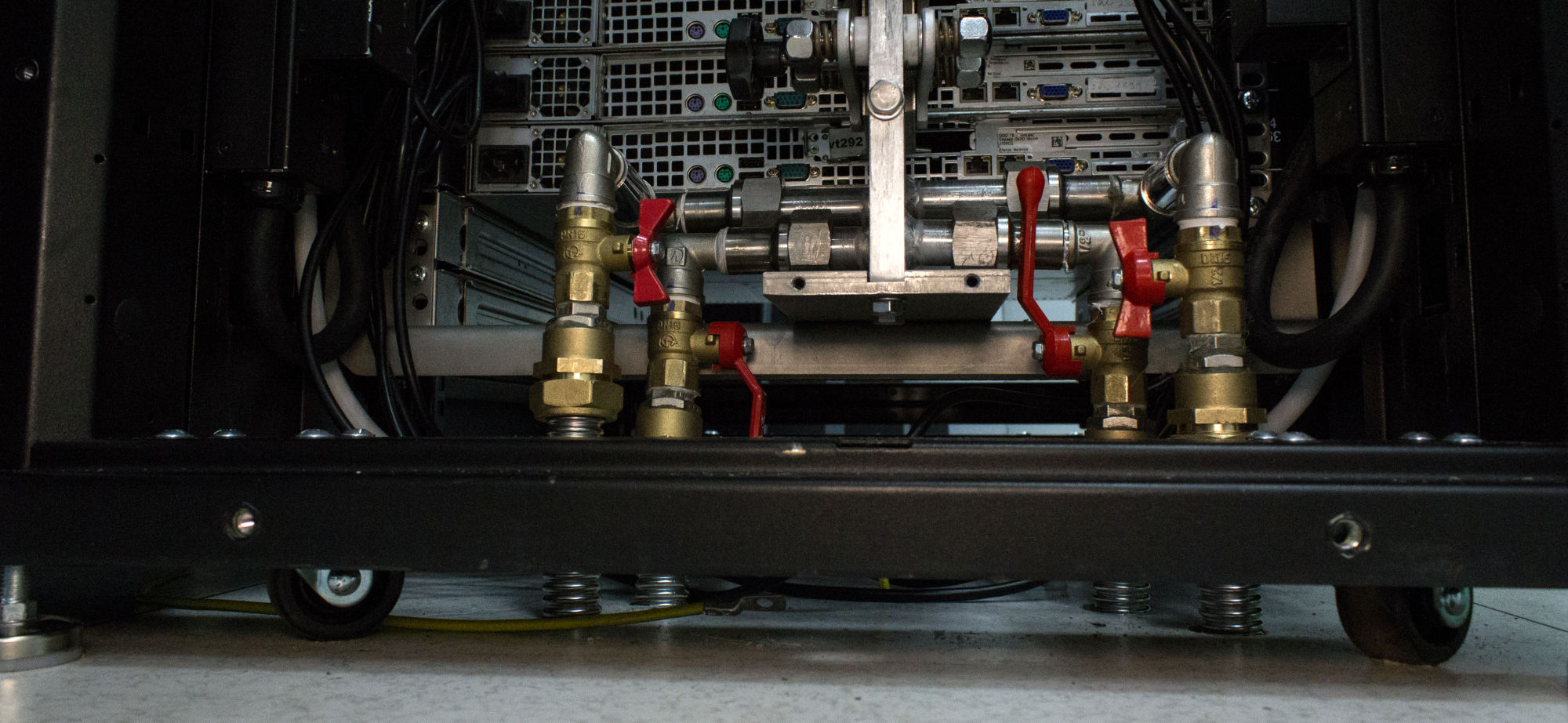

Кроме огромной механики первая версия никак не отвечала на вопросы защиты серверов от (теоретически) возможной ситуации разгерметизации вертикальной жидкостной шины. Ответом на такие вопросы во второй версии нашей системы стал защитный кожух.

Шаг назад в компактности. Шаг вперед в безопасности. Теперь никто даже теоретически не сможет оказаться облитым этиленгликолем, которым наполнен внешний контур теплообмена.

Подключилась система аккуратно. Без больших гибких подводок, как было раньше. Такая конструкция уже никуда не уедет. Хоть и стоит на колесиках. Трубы подведены прямо под серверную стойку, в фальш-полу дата-центра.

Там оказалось еще чуть ли не полтора метра пространства в высоту глубину. Есть место для развлечений.

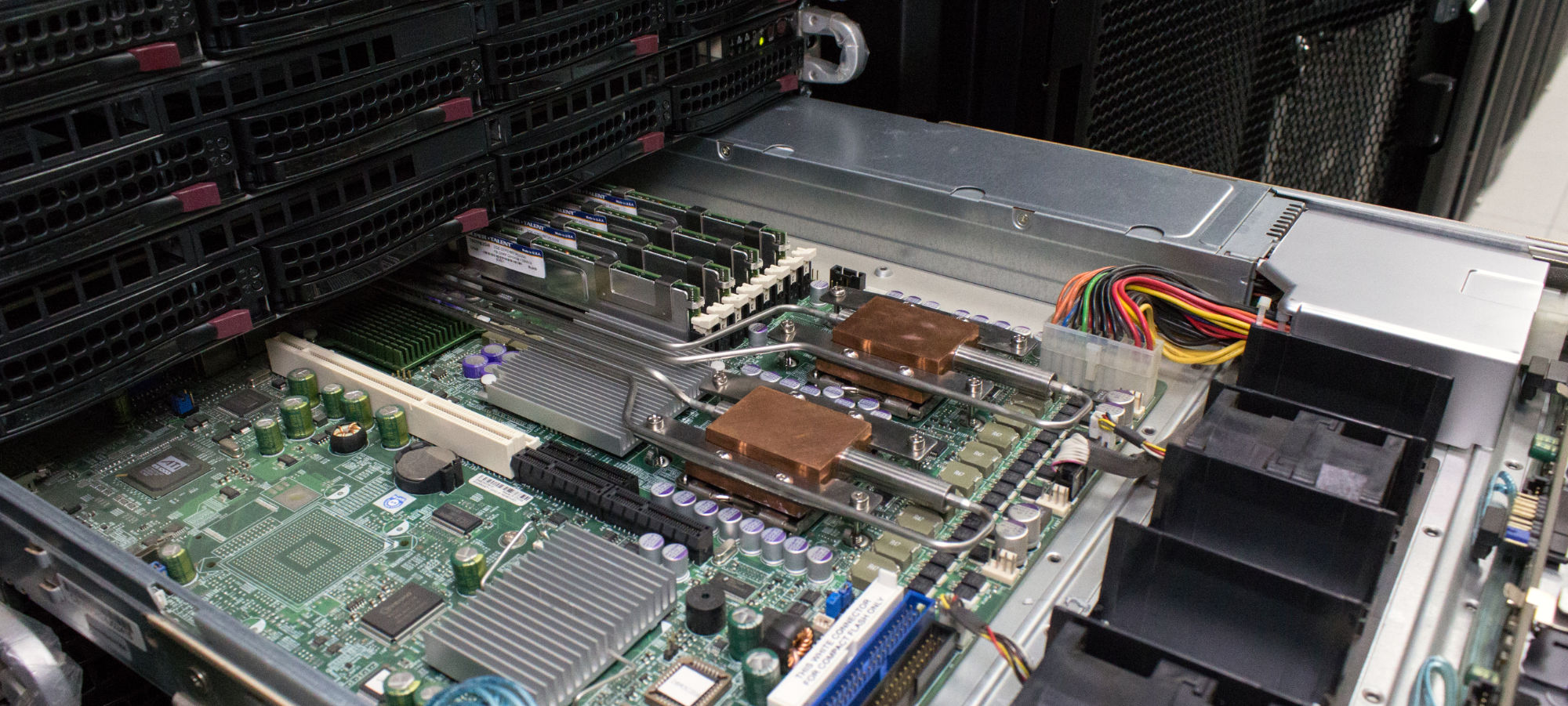

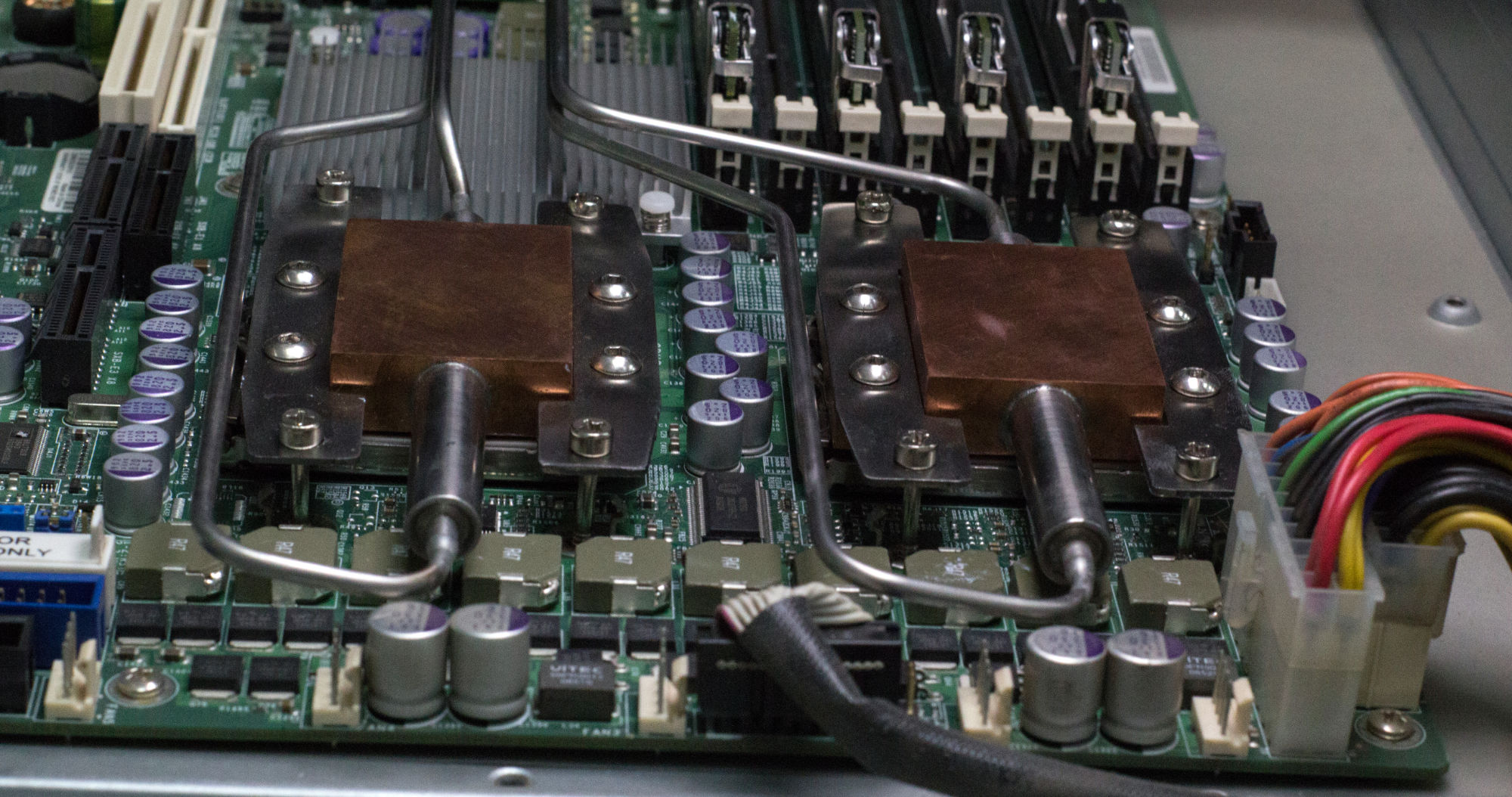

Конструкция КТТ внутри сервера не претерпела каких-либо значимых изменений. В прошлом посте мы оказались скупы на фото внутрянки. Постараемся исправиться сейчас.

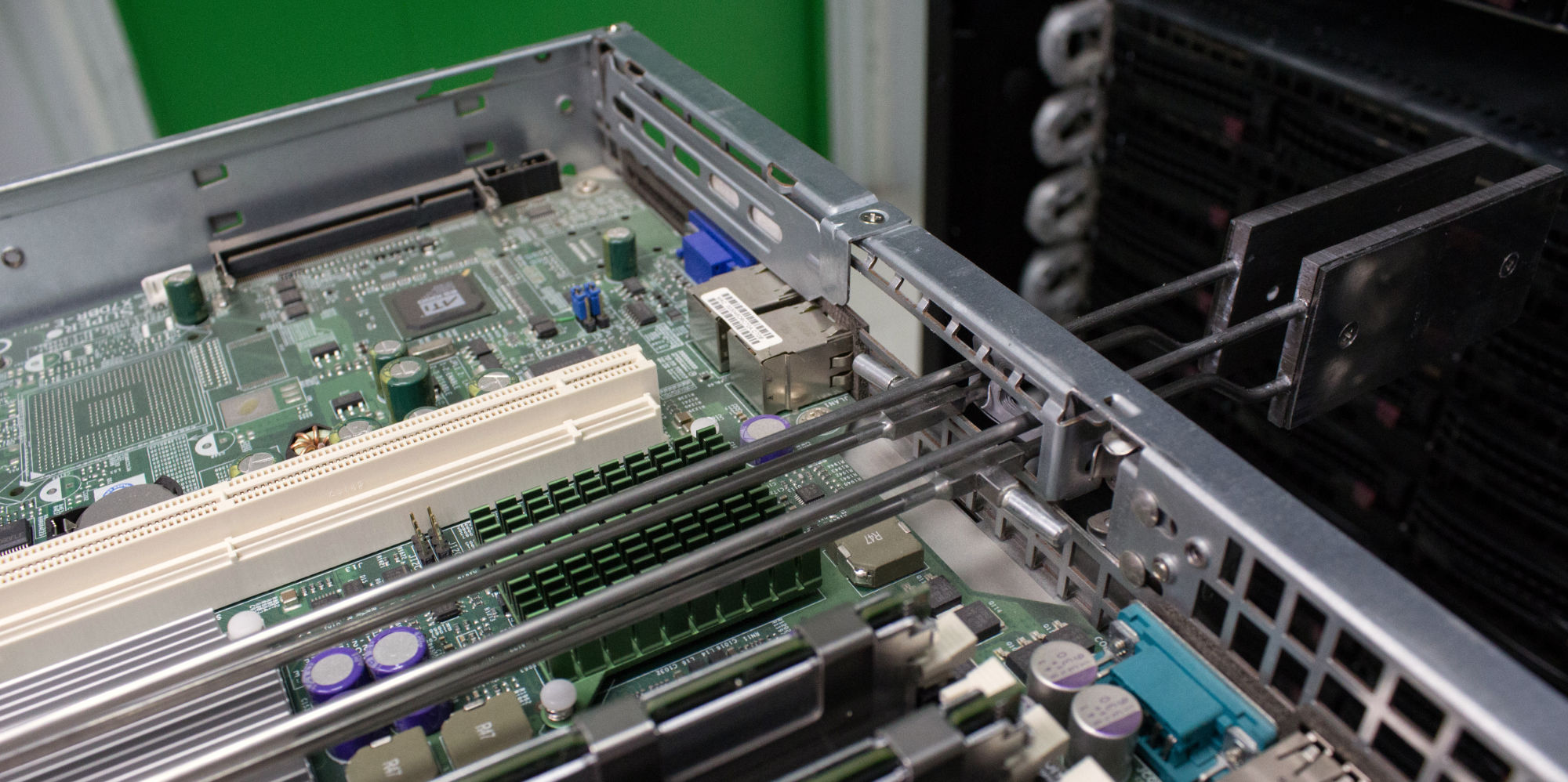

Вот так выглядит выдвинутый из стойки сервер с нашей системой охлаждения. Штатные радиаторы заменены на нашу систему. Часть вентиляторов демонтирована.

К процессорам прикреплены медные радиаторы. Цилиндры внутри радиаторов — испарители контурных тепловых труб.

От испарителей тонкие трубки уходят на тыльную сторону сервера.

Проходят через заднюю стенку и образуют конденсаторы.

Которые прижимаются к вертикальной жидкостной шине, когда сервер задвинут в стойку.

Таким образом тепло от процессоров сервера по контурным тепловым трубам выходит из объема сервера на внешний жидкостный теплообменник, а через него — выходит из объема здания дата-центра на уличные системы охлаждения.

КТТ не только в дата-центрах

Кроме решений охлаждения для больших дата-центров мы занимаемся так же решениями охлаждения для "офисных" серверных систем — микро-ЦОДов.

Многие компании испытывают такие проблемы как "наши сервера слишком шумные" или "слишком жарко ходить мимо серверной". Часто такие проблемы выглядят не решаемыми, используя традиционные технологии.

Подробнее об одном из таких решений — микро-ЦОДе "все в одном", мы скоро расскажем в следующей статье. А пощупать этот продукт руками любой желающий сможет уже на этой неделе, 12 сентября 2019 года на конференции "ЦОД-2019" в Москве.

Тем, кому интересна тема охлаждения (в том числе серверного) компьютерного оборудования, напоминаю про наши соцсети ВКонтакте и Instagram.

Комментарии (25)

DarkWolf13

10.09.2019 08:40интересно видеть подтверждения развития науки, технологии по спирали… Ведь жидкостное охлаждение на больших системах ЕС ЭВМ уже применяли и вот снова возвращается с поправкой на большие процессорные мощности и саму технологию отвода тепла

webself Автор

10.09.2019 09:45У нас не совсем жидкостное охлаждение. У нас нет жидкости внутри серверов. По крайней мере какого-то значимого ее количества, способного нанести какой-то урон при теоретически возможной аварии.

Полностью жидкостные системы, по слухам, клиенты очень не хотят ставить в свои сервера. Что неудивительно, учитывая стоимость серверного оборудования.

webself Автор

10.09.2019 11:41Кстати, быстро погуглив, не нашел ничего жидкостного для ЕС. Поделитесь ссылками? Интересно.

plus79501445397

10.09.2019 13:47А я вот почему-то не помню ЕС ЭВМ на жидкостном охлаждении (хотя повидал их не мало, но они все имели воздушное охлаждение)…

Но зато хорошо помню характерные стойки Эльбрус 1К2 с жидкостным охлаждением.

DarkWolf13

10.09.2019 15:26я ячейки разбирал с пластинами жидкостного охлаждения запомнилась маркировка ЕС.хххх.ххх на платах… возможно она и ввела меня в заблуждение

sukhe

10.09.2019 08:41Как серверы реагируют на отсутствие вентиляторов? Помнится, HP-шки отказывались стартовать, если их было слишком мало.

webself Автор

10.09.2019 09:45+1Разрабатываем свои эмуляторы вентиляторов. Звучит забавно, конечно. Но в наш век умного всего…

vassabi

10.09.2019 11:29логи потом с них собираете (т.е. часто ли и надолго ли подавался сигнал на его включение)? анализируете?

webself Автор

10.09.2019 11:40Логи с живых собираем и делаем симуляцию потом. Логи с эмуляторов еще не думали собирать.

ciuafm

10.09.2019 21:39Если делать эмуляторы вентиляторов, то хорошо бы с помощью них отдавать какую-нибудь информацию. Например при нагреве вертикальной шины выше определенной температуры (когда эффективность КТТ падает) можно отдавать «снижение скорости вентилятора».

webself Автор

10.09.2019 21:41А зачем это на практике? Можете пояснить? Нам пока такие сценарии не приходили в голову, если честно. Может быть если лучше объясните цели, мы воплотим. «Просто, чтобы было» — не повод это делать.

ciuafm

10.09.2019 22:18Если вы вынули часть штатных вентиляторов, то по видимому охлаждение сервера зависит от вашей системы. Если предположить что ваша система используется сторонними админами, то у них может быть софт, который мониторит вентиляторы для подтверждения данных температуры. При выходе из строя вашей магистрали сервер не узнает об этом до тех пор, пока процессор не прогреется до критической температуры, а потом может быть поздно завершать работу. Тем более что эмулятор на тиньке стоит копейки.

webself Автор

11.09.2019 07:50Спасибо, передам конструкторам. Звучит логично.

BD9

13.09.2019 04:59Нет, не логично.

Мониторить нужно температуру.

Вентиляторы сильно опосредованно связаны с температурой.

В рабочих серверах вряд ли найдёте работающий ЦП без возможности троттлинга и аварийного отключения по температуре.

safari2012

10.09.2019 15:28А как тепло отводится из дискового массива (ну или это сторадж нода, по 5й фотке не до конца понятно)?

webself Автор

10.09.2019 16:57На этих сервера с дисков тепло трубами не отводится. Предполагается, что на охлаждение дисков должно хватить оставшихся вентиляторов.

Для дисков тоже есть решение. Мне его пока фотографировать только не разрешают ))

IpedikI

10.09.2019 21:36Зачем столько металла, и столько бесполезной работы?

Не проще сделать как делают уже давно OVH?

Стоит очень дешево, работает годами безотказно, температуры низкие

Заголовок спойлера

webself Автор

10.09.2019 21:39Спасибо за фото. Очень интересные. Может быть статью про эту систему напишите, если близко знакомы? Было бы круто.

Так ли безотказно годами работают эти системы? Куча тонких труб с жидкостью внутри оборудования. Должно быть приличное давление там прокачивается весьма?

Aleksandr_Sv

11.09.2019 12:34Мне как-то страшно видеть хомуты на пластиковых трубах большого диаметра под высоким давлением рядом со стойкой. Если хомут ослабнет то шланг сорвёт и зальёт все рядом стоящие стойки.

BD9

Чёрные ручки кранов плохо выглядят. Лучше — белые или цветные.

Стоит нанять дизайнеров — есть такое направление как "промышленный дизайн".

По сути у вас — стимпанк, т.ч. латунь, медь и прочее отлично бы вписались.

webself Автор

Спасибо за ценный совет. :) Но мы сначала технологию отладим. Потом будем про медь и стимпанк думать…

slavashock

Дизайн — это всё-таки часть разработки. Попытался пофантазировать, какими бы я сделал «зажимы» на шину. Идеи есть, но их нужно обсуждать и прорабатывать. Реально сейчас не пойму как к вашей текущей реализации относиться.

Мне кажется, что в ЦОДе не самое место стимпанку, всё таки вокруг хай-тек, и соответственно ручки хочется видеть технологичными и лаконичными.

Думаю задачу по развитию большого усилия прижатия к шине, нужно решать комплексно с внешним видом «зажима». Какие ручки? Рычаги или баранки, съемные или стационарные…