Поисковый запрос на русском языке, обработанный с применением технологии BERT, наиболее точно отвечает на запрос пользователя.

Поисковый запрос на русском языке, обработанный с применением технологии BERT, наиболее точно отвечает на запрос пользователя. В официальном блоге Google Россия появилась информация, что теперь Google понимает поисковые запросы лучше, чем когда-либо. Таким образом, с 9 декабря 2019 года технология предварительного обучения анализу текста на естественном языке BERT (Bidirectional Encoder Representations from Transformers) теперь стала использоваться в поисковой выдаче Google Поиск и для запросов на русском языке.

В 2018 году Google представила технологию предварительного обучения обработке текста на естественном языке (NLP), разработанную на базе нейронных сетей, и назвала ее BERT (Bidirectional Encoder Representations from Transformers).

При использовании технологии BERT, работа которой основана на применении искусственного интеллекта, Google Поиск лучше понимает пользователей, так как анализирует не отдельные слова, а запросы целиком. Так как алгоритм BERT может учитывать полный контекст, рассматривая слова, которые идут до и после ключевого, что особенно полезно для понимания более точной цели поисковых запросов.

Интеграция технологии BERT в Google Поиск на английском языке была проведена в октябре 2019 года. Сейчас BERT помогает Google Поиску лучше понимать каждый десятый англоязычный запрос в США. Причем Google также начала с внедрением технологии BERT использовать в Google Поиск тензорные процессоры Google (Google Tensor Processing Unit, Google TPU), с помощью которых более быстро подбирается наиболее актуальная информация для пользователя.

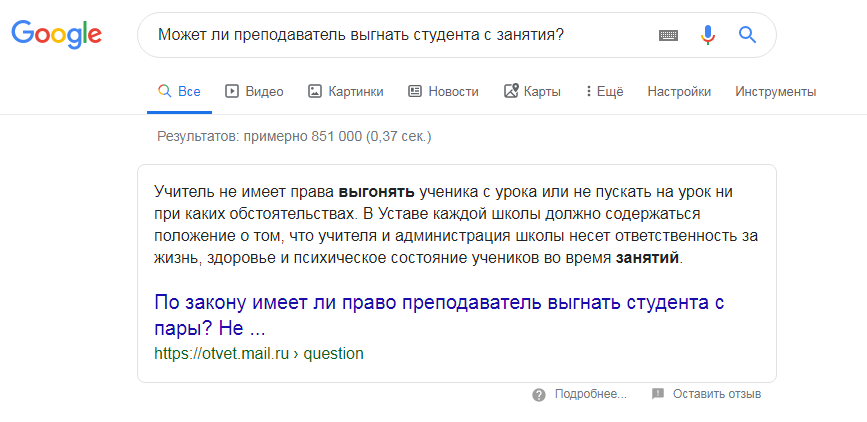

С начала декабря 2019 года технология BERT начинает применяться и для обработки запросов на русском языке. Google для организации такого обновления использовала модели для BERT, ранее уже специально обученные на базе английского языка, и применила их для других языков, включая и русский. По заверению представителя Google, теперь поисковый ответ на запрос пользователя на русском языке, обработанный с применением технологии BERT, будет наиболее точным и понятным для пользователя, особенно это касается длинных и разговорных запросов, а также запросов с предлогами.

После проведения глобального обновления Google Поиск стал более эффективен для длинных и разговорных запросов, а также запросов с предлогами. Это значит, что естественные запросы пользователей будут пониматься в контексте с показом соответствующих результатов, а не на основе ключевых слов.

Например, запрос «Памятник строителям коммунизма у Цимлянского водохранилища». Раньше технологии Поиска ориентировались на ключевые слова и выдавали, например, страницу Цимлянской ГЭС на Википедии. Технология BERT помогает выстроить поисковую выдачу таким образом, чтобы пользователь получил информацию именно о монументе.

«Понимание языка — это актуальная задача, которая мотивирует нас постоянно улучшать Google Поиск. Мы развиваемся, стараясь понять суть каждого отправленного запроса и найти ресурсы, которые смогут вам помочь», — резюмировал Панду Найак, вице-президент Google Поиск.

Комментарии (9)

mSnus

10.12.2019 06:45Хорошо бы оставили возможность искать именно слова в нужной последовательности, с языком запросов. И так поиск часто превращается в задачу "переупрямить робота", а здесь будет ещё и непредсказуемый ИИ..

Lure_of_Chaos

10.12.2019 09:56Верно, ищешь точную фразу, а тебе умный робот показывает все похожее, кроме того, что ты на самом деле ищешь )

AlexanderUsatov

10.12.2019 10:56Для поиска точного совпадения искомую фразу нужно взять в кавычки) Например, такой запрос: «Google Поиск на базе ИИ с технологией BERT»

mSnus

10.12.2019 11:16Иногда нужно не "точное совпадение", а просто выключить все эти роботиные попытки понять контекст. Особенно когда то, что ты ищешь, не в тренде.

Fahrain

10.12.2019 13:19а гугл тебе такой — «мы не стали искать с кавычками, вот тебе результаты без кавычек» и показывает такой 100500 результатов, в которых внизу все те слова что ты искал зачеркнуты :)

И что хочешь, то и делай.

… последние пару лет я начал все активнее пользоваться бингом, он хоть и ищет хуже, но там хотя бы можно заставить найти искомое, а не бороться с роботами

maxood

Google и без BERT'a мог бы исправить ошибку в

Это как?

CheY

Обученную модель для английского дообучили для русского, видимо. Zero-shot transfer, так называемый.

maxood

Zero-shot не означает, что используется английская BERT модель. Более того, даже если использовать MultiNLI корпуса, то использовать их в продакшене — дело сомнительное.