Компания ООО НПЦ «Геостра» с помощью сервиса MCS провела камеральную обработку сейсмической информации — 40 Тб высокоплотной съёмки МОГТ-3D. О реализации, нюансах и результатах проекта будет рассказано в данной статье.

Промышленная добыча нефти в Поволжье началась еще в 1930-х годах. Но по мере увеличения геолого-геофизической изученности региона, стандартные методики полевых и камеральных сейсморазведочных работ уже не позволяли находить новые нефтяные залежи в требуемых объёмах. Поэтому перед нефтяными компаниями встал вопрос более подробного изучения геологической среды.

Для исследований с необходимым уровнем детальности недропользователи вынуждены заказывать как полевые, так и камеральные сейсморазведочные работы с применением усложнённых методик. При этом объём получаемых данных существенно увеличивается, и для их обработки и интерпретации требуются значительные вычислительные ресурсы.

Сервисные геофизические компании, в свою очередь, находятся в постоянном поиске способов оптимизации ресурсов и наращивания вычислительных мощностей. Одним из перспективных направлений сегодня являются облачные технологии.

Параметры и формат проекта

Площадь участка, который изучался в рамках пилотного проекта, составляла 47 км2. В качестве методики полевых наблюдений была выбрана технология, позволяющая в сжатые сроки провести регистрацию высокоплотных сейсмических наблюдений МОГТ-3D. Для этого была усовершенствована методико-технологическая база как Департамента разведочной геофизики АО «Башнефтегеофизика», специалисты которого отвечали за выполнение полевой стадии проекта, так и компании ООО НПЦ «Геостра», экспертные группы которой выполняли камеральные работы.

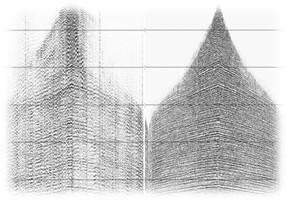

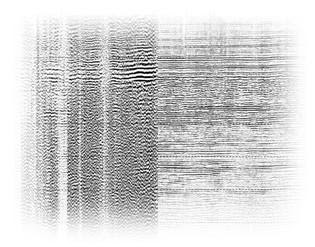

Этапы обработки сейсмических данных.

В данной статье акцент будет сделан на камеральной части проекта. А именно, на специфике реализации технической части блока обработки сейсмических данных, которая включала в себя, помимо типовых работ, ещё и специальную технологию — полноазимутальную миграцию.

Объём исходных данных для циклического выполнения расчётов составлял 40 Тб. С учётом пространственной плотности сейсмотрасс, при пересчёте на стандартную систему полевых наблюдений для региона работ этот объём данных соответствует съёмке около 2500 км2 (при стандартных площадях покрытия в 200-400 км2). Вычислительный центр НПЦ «Геостра» рассчитан на решение задач подобных объемов. Однако, резервирование кластерной системы под решение задачи высокоплотной съёмки не было запланировано на период реализации проекта. Согласно расчётам, требовалось задействовать не менее 2000 дополнительных физических ядер, для каждого из которых требовалось по 16 Гб оперативной памяти.

Облачные же сервисы позволяют оперативно менять используемый объём вычислительных ресурсов в зависимости от конкретной задачи. Соответственно, можно ускорить обработку данных, оперативно увеличивая объём ресурсов, и при этом оптимизировать расходы, отказываясь от части серверов при решении задач, не требующих выхода на полную мощность.

Необходимо отметить, что на реализацию проекта накладывались определенные ограничения, которые помогли нарисовать портрет компании, предоставляющей услуги в облачном сервисе:

- Серверы располагаются на территории РФ. Работа со стратегически важной информацией — геофизическими данными, которые закон запрещает передавать за пределы страны.

- Эксклюзивный доступ к ресурсам. Рабочие нагрузки должны иметь максимальный приоритет и не делить пул облачных ресурсов с другими клиентами провайдера.

- Совместимость софта и железа. Геофизическое ПО должно стабильно работать в среде виртуализации. По этому вопросу были сомнения, так как изначально софт был написан под стек определённых процессоров. Информации о том, как он поведет себя в эмуляторе, крайне мало.

Одно только первое требование — хранение данных в РФ — сильно сузило круг поиска подходящего поставщика услуг. В результате отбора кандидатов MCS как один из лидеров на рынке облачного сервиса в России стал партнером НПЦ «Геостра» при выполнении тестового проекта. MCS оперативно предоставил необходимые мощности, тестовую среду и эксклюзивный доступ к вычислительным ресурсам. Соответствие требованию по совместимости – как специализированный софт поведет себя в среде виртуализации, возможно было проверить только на практике.

Перенос геофизического ПО на облачную платформу

Специалистами НПЦ «Геостра» предварительно было определено, что для выполнения тестового проекта в плановые сроки потребуется 2000 ядер. На практике оказалось, что из-за особенностей софта отсутствует линейная связь скорости обработки и суммарной мощности. Если один сервер решает задачу за час, то для десятикратного ускорения может не хватить и десяти серверов. В сотрудничестве со специалистами из MCS была подготовлена инфраструктура из 2072 вычислительных ядер. Для сложных расчетов использовались облачные вычисления на базе GPU с графическими процессорами NVIDIA Tesla V100. Также применялась система хранения MCS, которую обслуживало полсотни терабайтных SSD-накопителей. Кроме того, была предоставлена виртуальная сетевая инфраструктура с пропускной способностью не менее 1 Гбит/c между любыми двумя серверами.

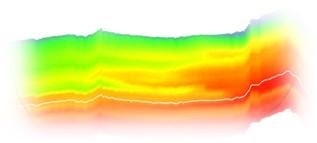

Глубинно-скоростная модель среды.

С миграцией геофизического софта в облако больших проблем не было. Однако во время тестирования возникло узкое место — производительность дисковой подсистемы. Специалистам MCS и НПЦ «Геостра» удалось почти вдвое увеличить скорость доступа к данным на облачных дисках. Также геофизический софт работал на редкой версии операционной системы, которая не позволяла использовать виртуальную сеть на 100 %. Совместная работа специалистов обеих компаний по тонкой настройке операционной системы привела к решению и этой проблемы.

Таким образом, специализированное программное обеспечение, которое изначально разрабатывалось под физическое оборудование, заработало на виртуальных мощностях. К успеху пилотного проекта длительностью 1,5 месяца привел и тот факт, что проблемные ситуации были решены ещё на этапе тестирования.

Итоги

Пилотный проект оказался успешным. Облачные вычислительные мощности справились с обработкой высокоплотных сейсмических данных. Компания НПЦ «Геостра» получила большой опыт в работе с геофизическим софтом на облачных ресурсах, что позволит применить его в будущих крупных проектах.

О перспективах облачных сервисов в нефтеразведке

Нефтяные компании вплотную подошли к тому, чтобы использовать современные технологии для разведки новых месторождений. Стало понятно, что в эпоху big-data существенно выросли требования к вычислительным мощностям как самих нефтяных компаний, так и нефтесервисных предприятий.

Таким образом, нефтяная отрасль оказалась перед выбором: продолжать наращивать свои вычислительные мощности (непрерывно заниматься модернизацией, развитием и содержанием) или арендовать вычислительные мощности по мере необходимости в виде услуги, например, в виде облачных сервисов. Опыт производства данного проекта показал, что облака способны успешно реализовывать высокие требования специализированного программного обеспечения.

ivge

1) Чем лучше облачная обработка традиционной на ПК для 3D-сейсморазведки?

Традиционную на ПК в России ведут уже более 20 лет.

2) Традиционная обработка — это, кажется, в основном зарубежное программное обеспечение?

3) Вы сами разрабатывали весь пакет, или что-то заимствовали?

Процедур предобработки и обработки сейсмики весьма много.

4) Зачем облачные сервисы кроме моды?

Конечно, нефтяным компаниям это выгодно: еще больше возможностей для дробления и аутсорса различных частей интерпретации, но выгодно ли это нефтесервисным компаниям в долгосрочной перспективе?

5) Как соотносятся ваши разработки с работой «Яндекс-Терра»?

iGeophysix

Я не автор, но попробую предсказать ответы :-)

1) методы те же, софт тот же, мощностей больше

2) Так как это Геостра, то скорее всего ПО — Omega.

Вероятно построили ферму, залили на него Omega и подгрузили данные.

Я работал раньше в нефтяной компании, и мы думали об облаках. Но все владельцы данных, безопасники и т.д. хором орали что ни в коем случае не отдадут данные в облачные сервера.

Сейчас приятно видеть, что то мнение постепенно уходит, и приходит понимание того, что можно гонять данные в облаке. Это все равно дорого, но дешевле, чем держать 10 своих стоек и обслуживать их.

4) Облака позволяют быстро масштабироваться. Огромные кубы приходят не очень часто, а строить огромный кластер каждый раз у себя в серверной не хочется (да и поддерживать его потом тоже).

Тут — поднял, поюзал, погасил — профит! Лицензии на софт могут быть плавающие, поэтому можно их потом обратно отдать юзерам для настольной обработки.

5) Яндекс.Терра работает с Сейсмотеком. Геостра с Mail.ru. Мне кажется, это одного типа коллаборации.

ivge

Спасибо за Ваш ответ.

Переход в облака выбивается из общей стратегии нефтяников и нефтяных геофизиков на максимальную закрытость и эксклюзивность. От этого и мой вопрос.

Видимо, сменилось время. Ранее был угар дележа ресурсов и туман вторичного передела.

Сейчас все более-менее стало ясно, и понятен самый главный игрок в этой сфере: это государство и его лицензии, налоговые льготы, оценки запасов нефти и газа и пр.

iGeophysix

А еще я узнал, что оказывается у Яндекса уже свой проект без Сейсмотека. Но это не точно)

В наше время для обработки сейсмики нужно:

1) знание сейсморазведки — 30%

2) знание математики — 20%

3) умение программировать — 50%

Почему такие проценты? Да как всегда — примерно.

Найти новые алгоритмы можно достаточно просто — публикаций куча.

Понимать эти алгоритмы — надо знать математику.

А вот запрогать это все, чтоб еще и работало быстро — вот это надо уметь.

Но в результате получается очень крутое ПО, которое кто-то из крупнейших корпоратов захочет купить :-)

Весьма перспективно!

ivge

Я видел в 2017 на совещании в НТЦ у Газпромнефти как выглядят распределение процентов как у вас. Очень печально выглядит «знание сейсморазведки — 30%».

Конечно, большинство геофизиков предпочло дипломатично помалкивать в присутствии начальников-заказчиков, которых обхаживала облачные продвигатели.

Но все эти вычислительные супермощности и превосходства облака над ПК съедаются из-за непонимания геофизики, когда представляют решение «в лоб».

Алгоритмов куча, но зачастую их плодят математики около геофизики и это уже почти 50 лет бич геофизики. Только очень малая часть математических изысков пошла в работу, но выглядит во стороны очень замечательно и представительно :)

Чтобы понимать эти алгоритмы надо знать и математику, и геофизику.

Иначе получится как с ERP системами, о проблемах с внедрением на Habr полно статей.

«Прогать» с нуля не лучший вариант, поэтому и у меня был вопрос про заимствования.

Разработка с нуля интерпретации для сейсмики-3Д сродни желанию переписать какую-нибудь ERP заново. Поэтому маловероятно. Просто один из признаков этого: у Геостры нет своего сайта только со своими наработками, а ссылки ведут на Башнефтегеофизику, где 3Д-сейсморазведка в разделе публикаций

www.bngf.ru/press-center/scientific-library/articles-in-journals

представлена не густо.

barka_lova Автор

Дополню iGeophysix :)

1) Соглашусь с предыдущим оратором, облачная обработка лучше обработки в традиционной инфраструктуре, если, как в этом кейсе, нужно быстро получить большие мощности в ограниченный промежуток времени, а произвести закупки оборудования сложно. Плюс на облаках хорошо тестировать новые бизнес-гипотезы. Покупать десятки стоек, резервировать традиционную кластерную систему и влиять на ход плановых проектов, чтобы потом убедиться, что идея не работает — не оч. В облаке можно на время получить нужные мощности в любом объёме на время тестирования.

2) Традиционная обработка это в основном легаси код, который сложно масштабировать и улучшать. Особенно, когда за увеличение мощностей отвечает менеджмент/закупки, а не конечный пользователь (инженер).

3) Геостра использовала свой геофизический софт, а Mail.ru Cloud Solutions предоставляли GPU, систему хранения и виртуальную сетевую инфраструктуру.

4) Есть два типа проектов — для которых облака дешевле и для которых облака дороже. Дешевле будет inhouse, когда проекты дают предсказуемую постоянную нагрузку, так что можно полностью утилизировать серверы и загрузить администраторов, которые ими управляют. Когда нагрузка непредсказуема или когда исследуешь новые способы решать задачу, нагрузку сложно предсказать. В этом случае облачные сервисы помогают сократить физические затраты у конечного пользователя (от сайзинга до девопсов и админов). В итоге получается ощутимая экономия по деньгам. По сути любые новые возможности на рынке можно получить только через rnd и исследования рынка боем, поэтому чтобы это делать дёшево нужны облака.

Плюс, опять-таки, соглашусь с iGeophysix про масштабирование. При использовании физических серверов потребность в закупке дополнительных ресурсов увеличивает time-to-market. Пока сервера закажут, пока привезут, пока админы настроят. При облачных – речь о нескольких командах, включении автомасштабирования, и нужные ресурсы доступны.

5) Мы не готовы комментировать чужие продукты, но с удовольствием ответим на вопросы по Mail.ru Cloud Solutions :)

ivge

Мой вопрос был связан с тем, что еще, кажется, лет 5-10 назад была общая установка нефтяников и нефтяных геофизиков на максимальную закрытость и эксклюзивность.

Перемены интересны, но они могут привести к большей кадровой текучести и вероятной утере компетенций, а также появлению конкурирующих обработчиков, сбивающих цены.

Конкурирующих обработчиков-интерпретаторов под крышей НИПИ какой-нибудь нефтяной компании. Хотя для Башнефти, являющейся филиалом Роснефти такие опасения, скорее всего не актуальны.

iGeophysix

Текучесть кадров не очень высокая: специалистов не очень много, а рынок достаточно ограничен. Далеко не убежишь :-)

Сравнив геофизику с пресловутым Data Science, можно предположить, что в случае применения «новых» технологий работа от рутинного пикирования скоростей перейдет на построение графов автоматической обработки, где большинство вещей будет делаться автоматически. А специалисты высокого класса смогут перейти в разработку этих алгоритмов.

Я сам ушел уже из нефтянки, но прям хорошо помню, как это происходило. В то время всегда удивляло, что никто не вкладывает деньги в автоматизацию и ускорение процессов. Спустя некоторое время я увидел, что разные нефтесервисные компании начали интересоваться машинным обучением, и уже продают продукты, построенные на разных ML алгоритмах и нейронках.

Я к тому, что прогресс есть даже в такой консервативной науке, как геологоразведке)

И переход от закрытых систем в облако надо было делать 5 (или больше) лет назад, а не сейчас.

MCS и остальные в этом плане молодцы, что вообще смотрят на этот рынок, так как это может принести отличный прогресс в скорость обработки данных.

ivge

Data Science — это всегда хорошо.

Главное был бы заказчик на такие работы.

Огромный объем 3Д сделан в РФ за последние 20-25 лет и новых объектов гораздо меньше, т.е. меньший объем нового материала, а компании не всегда охотно идут на переинтерпретацию.

Под крышей Роснефти можно пробить направление, особенно сейчас, когда пошли все-таки процессы импорто-замещения. Вы указывали на малое число специалистов и ограниченный рынок, это может привести к ограниченному успеху чисто российских разработок.