Фото: www.researchgate.net

Фото: www.researchgate.netИсследование сотрудников Массачусетского технологического института, опубликованное в Management Science, показало, что, после того как Facebook ввела отметки для возможно фальшивых сообщений, доверие пользователей к непомеченным постам и новостям выросло.

Исследователи назвали это явление «подразумеваемым эффектом истины».

Команда Дэвида Рэнда, доцента кафедры науки управления и мозга и когнитивных наук в МТИ, провела два исследования с более чем 6000 участников. В первом людям показывали различные реальные и поддельные заголовки новостей, оформленные в точности так, как они представлены в Facebook. Половине группы продемонстрировали истории, которые не имели пометок. Другой половине группы было показано множество отмеченных и немаркированных постов. Затем людей спросили, считают ли они представленные заголовки точными.

Во втором исследовании авторы работали по схожей системе, но в нем использовались большие ярлыки «ложь» и «правда», более явные, чем в Facebook, и участников также спрашивали, верят ли они сообщениям.

Фото: www.researchgate.net

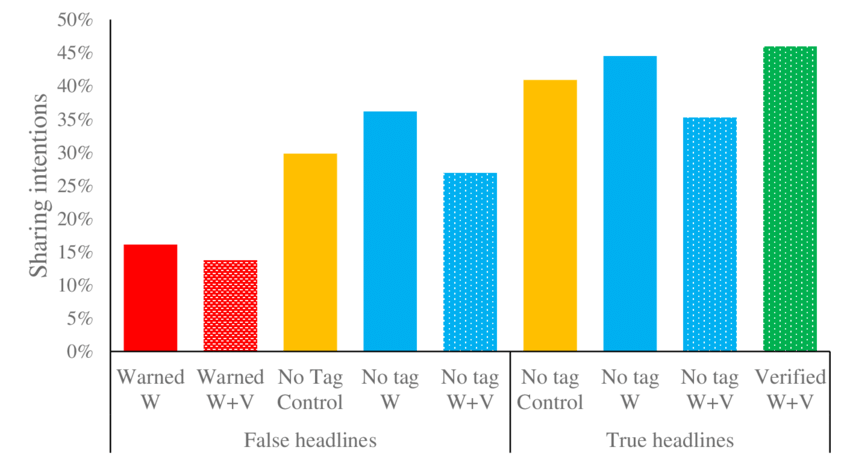

Фото: www.researchgate.netВ том случае, когда не использовались истинные или ложные ярлыки, люди рассматривали возможность делиться 29,8% всех ложных историй, но когда ложные истории были помечены как ложные, люди были готовы репостнуть только 16,1% из них. Однако при этом число участников, которые были готовы делиться немаркированными, но ложными историями, составило 36,2%.

«Когда вы начинаете наносить предупреждающие надписи на некоторые вещи, это делает все остальное более правдоподобным», — говорит Рэнд. Он объясняет это появлением у пользователя ложного чувства безопасности. Этот же вывод подтвердили 21,5% участников, которые сказали, что они считают непомеченные заголовки заведомо проверенными.

Фото: www.researchgate.net

Фото: www.researchgate.netРэнд провел еще одно исследование и сделал вывод, что непрофессионалы могут быть случайно выбраны Facebook для проверки фактов. Это не было бы проблемой, если бы за каждую историю публично голосовали и могли понижать ее рейтинг, как на Reddit.

Ученый, который фактически консультирует Facebook по этой теме, считает, что есть несколько способов избежать эффекта подразумеваемой правды.

Во-первых, вместо того, чтобы просто помечать контент как ложный, алгоритмы в Facebook могут опускать вниз публикацию с фиктивным контентом, чтобы меньше людей увидело ее. Другое решение состоит в том, чтобы просто использовать гораздо больше проверщиков фактов, чтобы каждая новость на Facebook проходила тщательный фактчекинг, и все они могли быть помечены как истинные или ложные. Facebook также может просто заявить, что все, что публикуют, к примеру, The New York Times и The Washington Post, является правдой и проверено из-за строгих стандартов, которым следуют эти публикации. Однако данный путь заставит Facebook фактически признать, что некоторые публикации более надежны, чем другие.

В декабре стало известно, что Facebook впервые пометила публикацию как «недостоверная (ложная) информация». Представители социальной сети поставили метку после обращения к ним правительства Сингапура, поскольку в этой стране начал действовать закон о противодействии фальшивым новостям и манипуляциям в Интернете. Сам текст публикации Facebook не изменял, не блокировал и не удалял. Добавленная отметка к публикации демонстрируется только пользователям социальной сети Facebook из Сингапура.

См. также: «Facebook будет удалять фейковые новости о коронавирусе и способах его лечения непроверенными лекарствамиПозднее компания заявила, что в Facebook появилась команда рецензентов, которые будут проверять публикумые новости на достоверность. Они не являются сотрудниками компании, а были наняты специально для фактчекинга через подрядчика одного из партнеров. Отмечалось, что рецензии оценщиков новостей не станут истиной в последней инстанции, однако их будут приводить в качестве дополнительного контекста.

lrrr11

интересно, а когда некоторые американские СМИ три года непрерывно вещали про очередные новые бомбы из доклада Мюллера, импичменты и т.п., эти новости помечались как фальшивые? :))

DracoL1ch

спекуляции на теме != обман