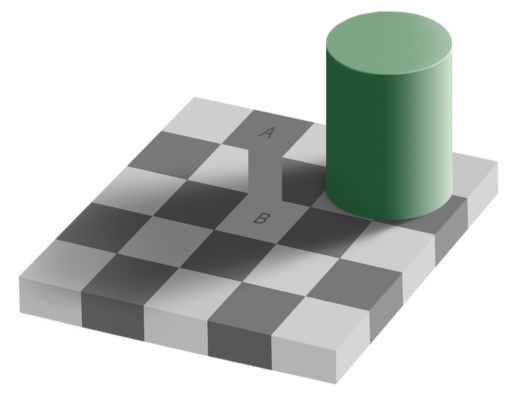

Давайте взглянем на картинку. Вроде ничего необычного. Но что если я вам скажу, что ячейки A и B — совершенного одного цвета.

На самом деле мы не всегда можем отличить светлое от темного. Далеко за примерами ходить не надо: помните сине-черное / бело-золотое платье или появившиеся чуть позже кроссовки?

И все современные экраны пользуются этой особенностью человеческого зрения. Вместо настоящего света и тени нам показывают их имитацию. Мы настолько к этому привыкли, что даже не представляем что может быть как-то иначе. Но на самом деле может. Благодаря технологии HDR, которая намного сложнее и интереснее, чем вы думаете. Поэтому сегодня мы поговорим, что такое настоящее HDR-видео, поговорим про стандарты и сравним HDR10 и HDR10+ на самом продвинутом QLED телевизоре!

На самом деле первое, что надо знать про HDR: это не просто штука, которая правильно хранит видео. Чтобы увидеть HDR-контент нам нужно две составляющие: сам контент, и правильный экран, который его поддерживает. Поэтому смотреть мы сегодня будем на QLED-телевизоре Samsung.

6 стопов SDR

Ежедневно наши глаза сталкиваются с экстремальными перепадами яркости. Поэтому человеческое зрение в ходе эволюции научилось видеть достаточно широкий динамический диапазон (ДД), то есть разницу улавливать разницу между разными уровнями яркости. Фотографы и киноделы знают, что ДД измеряется в ступенях экспозиции или стопах (f-stop).

Так сколько стопов видит человеческий глаз? Скажу так — по разному.

Если завязать вам глаза, вывести в незнакомое место и резко снять повязку, то в эту секунду вы увидите 14 стопов экспозиции. Это не мало. Вот камера, на которую я снимаю ролики, видит только 12 стопов. И это ничто по сравнению с человеческим зрением, потому что оно умеет адаптироваться.

Спустя пару секунд, когда ваши глаза привыкнут к яркости и обследуют пространство вокруг, настройки зрения подкрутятся и вы увидите потрясающую игру света и тени из 30 стопов экспозиции!

Ух! Красота! Но когда мы смотрим видео на ТВ или на экране смартфона, нам остаётся довольствоваться только 6 стопами экспозиции, потому как видео со стандартным динамическим диапазоном или SDR — больше не поддерживает.

Яркость

Почему так мало? Вопрос исторический и связан он с двумя этапами.

Стандарты современного SDR видео зародились еще в середине 20-го века, когда появилось цветное телевидение. Тогда существовали только ЭЛТ телевизоры, и они были очень тусклые. Максимальная яркость была 100 нит или кандел на квадратный метр. Кстати, кандела — это свеча. Поэтому 100 кандел на квадратный метр буквально означает уровень яркости 100 свечей, расположенных на площади в 1 метр. Но если вам не нравится измерять яркость в свечах, вместо кандел на квадратный метр можно просто говорить ниты. Кстати в нашем телевизоре Samsung Q950T — 4000 нит.

Так вот, это ограничение яркости было заложено в стандарт SDR. Поэтому современные телевизоры показывая SDR-контент по сути игнорируют потрясающую адаптивность человеческого зрения подсовывают нам тусклую и плоскую картинку. И это несмотря на то, что с тех пор техника сильно продвинулись вперед.

Одной из особенностей технологии QLED является высокая пиковая яркость. Это самые яркие ТВ на рынке, они даже ярче OLED.

Современные QLED-телевизоры способны выдавать целых 4000 нит яркости, что в 40 раз больше, чем заложено в стандарт SDR. Потрясающе — показывай, что хочешь. Но по-прежнему 99% контента, который мы видим — это SDR, поэтому смотря YouTube на своём потрясающем AMOLED-дисплее, вы фактически смотрите эмуляцию кинескопа из гостиной времен разгара холодной войны. Такие дела.

Глубина цвета

Второе ограничение тоже происходит из глубокой древности — 1990-х.

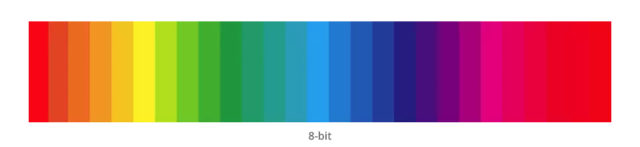

Тогда появился революционный стандарт — цифровое телевидение высокой четкости — HDTV, частью которого стала глубина цвета 8 бит. Это значит, что у каждого из базовых цветов — красного, зеленого и синего — может быть только 256 значений. Возводим 2 в 8-ю степень получается 256 — это и есть 8 бит..

Итого на три канала, всего 16 777 216 миллионов оттенков.

Кажется, что это много. Но человек видит куда больше цветов. И все эти некрасивые ступенчатые переходы, которые часто можно заметить на видео и фотографиях и конечно в YouTube, спасибо его фирменному кодеку — это как раз ограничения 8 бит.

Но самое интересное, что эти два ограничения: 6 стопов экспозиции и 8 бит на канал, не позволяли SD-видео сымитировать главную особенность человеческого зрения — его нелинейность! Поэтому поговорим про восприятие яркости.

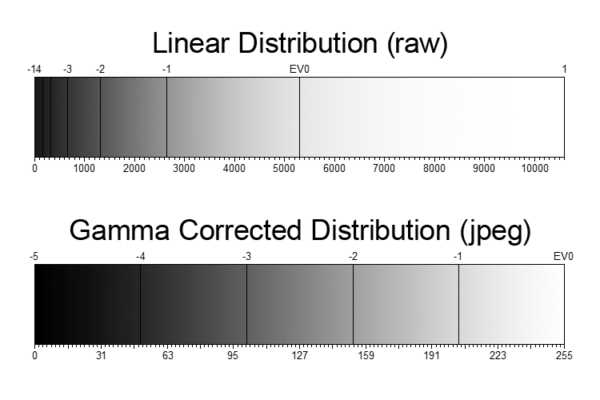

Восприятие яркости

Так уж эволюционно сложилось, что для человека всегда было важнее, что там находится в тени, чем на ярком солнце. Поэтому человеческий глаз гораздо лучше различает темные оттенки. И поэтому любое цифровое изображение кодируется не линейно, чтобы как можно больше бит информации отдать под темные участки изображения.

Иначе, для человеческого глаза в тенях перепады между уровнями яркости будут уж слишком большие, в светах, наоборот, совершенно незаметные, особенно если у вас в распоряжении всего 256 значений, которые есть в распоряжения SDR видео.

Но в отличие от SDR — HDR видео кодируется с глубиной цвета, как минимум 10 бит. А это 1024 значения на канал и итоговые более миллиарда оттенков (1024 x 1024 x 1024 = 1 073 741 824)

А предельная яркость изображения в HDR видео стартует от 1000 нит и может достигать 10000 нит. Это в 100 раз ярче SDR!

Такое раздолье позволяет закодировать максимум информации в темных участках изображения и показать картинку куда более естественную для человеческого глаза.

Метаданные

Итак, мы с вами выяснили, что возможности HDR сильно превосходят SDR, и HDR показывает куда более страшную и всю из себя контрастную картинку, но! Какая разница, какой там у тебя формат видео, SDR или HDR, если качество изображения всё равно зависит от экрана, на котором ты смотришь. На некоторых экранах SDR выглядит так насыщенно и контрастно, что HDR даже и не снилось. Всё так!

Все дисплеи отличаются. Они по-разному откалиброваны, в них разный уровень яркости и прочие параметры.

Но HDR-видео в отличие от SDR не просто выводит изображение на экран, но еще и умеет сообщать телевизору, как именно нужно его показывать! Делается это при помощи так называемых метаданных.

Они бывают двух видов.

Статические метаданные. Содержат в себе настройки настройки яркости и контраста всего видео целиком. Например, человек, который мастерил какое-нибудь атмосферное, темное кино может указать, что максимальная яркость в этом фильме всего 400 нит. Поэтому телевизор с яркостью 4000 нит не будет задирать яркость и превращать ваш хоррор-фильм в детский утренник. Или наоборот фильм с яркостью 4000 нит по максимуму раскроется не только на телевизоре, который тянет такую яркость, но и на более тусклом экране, так как картинка правильно сожмётся до возможностей телевизора.

Но бывают такие фильмы, которые в целом темные, но в них есть сцены с яркими вспышками света. Или например фильм про космос, в котором ярко сияют звезды. В таких случаях необходимо настроить яркость каждой сцены отдельно.

Для это существуют динамические метаданные. Они содержат в себе настройки каждого пикселя в каждом кадре фильма. Более того, эти метаданные содержат информацию на каком дисплее мастерился контент. А значит ваш дисплей может взять эти настройки и адаптировать изображение так, чтобы вы получили максимально приближенную к задумке автора картинку.

HDR10 и HDR10+

Самый распространённый формат с поддержкой статический метаданных — это HDR10. Более того это самый распространенный HDR формат в принципе. Если видите наклейку HDR на телевизоре — знайте: он поддерживает HDR10. Это его плюс.

Но поддержка только статических метаданных не позволяют назвать его настоящим HDR. Поэтому компания Samsung, совместно с 20th Century Fox и Panasonic решили исправить это недоразумение и добавили к HDR10 поддержку динамических метаданных, назвав новый стандарт — HDR10+.

Получился он царский — 10 бит, 4000 нит, более миллиарда оттенков. Но видна ли разница между HDR10 и 10+ на практике.

У нас есть QLED телевизор Samsung Q950T, который как раз поддерживает оба формата. Поэтому сравнение будет максимально корректным. Мы запустили кино, которые смастерили в HDR10 и HDR10+. И знаете, что — я действительно увидел разницу. На этом телевизоре и HDR10 выглядит круто, а HDR10+ вообще разрывает шаблон. И дело не только в стандарте HDR10+.

Adaptive Picture

Дело в том, что HDR-контент существенно более придирчив к качеству дисплея, чем SDR. Например, яркость в HDR-видео указывается не в относительных значениях, то есть в процентах, а в абсолютных — в нитах. Поэтому, хочешь не хочешь, но если в метаданных указано, что этот конкретный участок изображения должен светить 1000 нит нужно, чтобы телевизор сумел выдать такую яркость. Иначе, это уже будет не HDR.

А если, вдруг, вы смотрите видео днём, в ярко освещенной комнате, то нужно еще компенсировать окружающее освещение. Большинство устройств не справляются с этой задачей. Но, у QLED телевизоров Samsung, в этом плане есть, огромное преимущество.

Во-первых, в них используется технология Adaptive Picture, которая подстраивает яркость и контрастность изображения в зависимости от окружающего освещения.

Во-вторых, как я уже говорил, запас яркости в QLED — 4000 нит. А этого с головой хватит для компенсации практически любого внешнего освещения.

В отличие от OLED-телевизоров, которые могут выдавать необходимый уровень контраста только при плотно зашторенных шторах.

Другие технологии

Естественно, это не единственная крутая технология внутри данного телевизора. Здесь установлен мощный нейропроцессор Quantum 8K, который в реальном времени умеет апскейлить 4K-контент до 8К. Причём он не просто повышает четкость изображения, он распознаёт разного типа текстуры и дополнительно их прорабатывает. Еще тут сверхширокие углы обзора, прекрасный объемный звук, который кстати тоже адаптируется под уровень шума в помещении в реальном времени. И масса других технологии, эксклюзивных для QLED-телевизоров Samsung.

Но главная технология сегодняшнего вечера HDR10+ — и, что прекрасно — это не эксклюзив.

HDR10+ — это открытый и бесплатный стандарт, как и обычный HDR10. Всё это дает ему огромное преимущество перед, по сути, таким же, но платным Dolby Vision. Поэтому HDR10+ есть не только в телевизорах и смартфонах Samsung — его поддерживают практически все производители телевизоров, смартфонов, камер, ну и, конечно, в этом формате снимаются и делаются фильмы. А значит у HDR10+ есть все шансы стать настоящим народным стандартом HDR, которым вы сможете насладиться на всех экранах страны, как больших, так и малых.

Klenov_s

У вас написана большая лажа в разделе про 8 бит. 16 млн. цветов вполне могут дать картинку без переходов, заметных человеческому глазу. Все эти «ступеньки» обусловлены исключительно алгоритмами сжатия, а, точнее процессом полигонизации изображения, и сколько битов для цвета ни выбирай, при одинаковом сжатии ступеньки будут примерно одинаковые.

anonymous

Ну грубо говоря когда мы динамический диапазон увеличиваем — то шаг увеличивается вместе с ним. Соответственно у нас на старый-добрый sRGB не 8 бит точности, а уже 6 приходится.

Klenov_s

Если сжать 10 бит с таким же объемом на выходе, то они все равно до 6 бит ужмутся. Ну а если мы говорим об увеличении потока, то можно и 8 бит с меньшей компрессией сжимать ))

Harkonnen

Еще не забываем, что HDMI определённых версий «читерит», сжимая контент с компрессией по 2-пикселя на оттенок (как в NTSC), поэтому либо HDR, либо 4/8k, либо 100Hz, либо компромисс между этими тремя параметрами. Банально bandwidth Gb/sec не хватает (ситуация могла измениться за последние пару лет).

mistergrim

На градиентах бывает очень даже видно.

DistortNeo

Да, видно, но эта проблема отлично решается dithering-ом. Человеческий глаз в принципе не способен шум в 1 градацию, особенно на 4K мониторе.

У меня 10-битный монитор, и я не вижу абсолютно никакой разницы между честным 10-битным градиентом и преобразованным 10 bit -> 8 bit + pattern noise.

mistergrim

Как поможет дизеринг в случае такого градиента?

DistortNeo

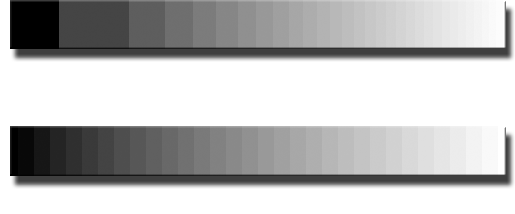

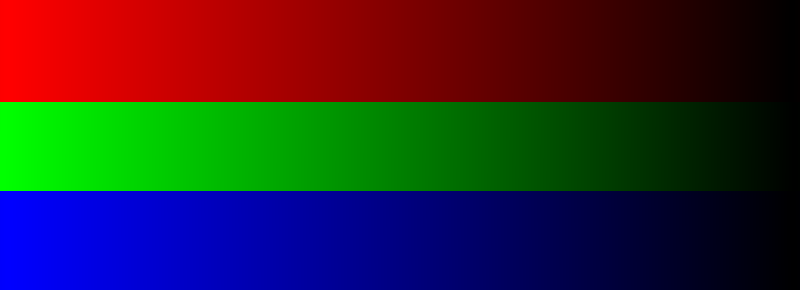

Как-то так:

Слева — исходник, по центру — 64 градации + дизеринг, справа — 64 градации без дизеринга.

Если смотреть со 100% масштабом на нормальном экране, то небольшие огрехи по центру видны, но картинка по качеству ближе к той, что слева. И примерно то же самое будет, если заменить 6 бит на 8 бит, а 8 бит на 10 бит.

mistergrim

Теперь видно градиенты + дизеринг.

Но речь немного не об этом. Дизерингом можно и полноцветный JPEG в 256 цветов перегнать так, что только при пристальном разглядывании рассмотришь. Но это уже дополнительная обработка, и фактически мы обманываем глаз, подсовывая ему БОЛЬШЕ оттенков, чем 256 по одному цветовому каналу.

DistortNeo

Да, это дополнительная обработка, но она очень дешёвая в реализации. И в итоге утверждение, что для просмотра HDR10 контента обязательно нужен соответствующий монитор, не является верным. Монитор с расширенным цветовым охватом — возможно, но не увеличенной глубиной цвета.

Добрался до своей софтины, построил 10-битный градиент, вот результат (смотреть в полном разрешении):

(сверху — 8 бит без дизеринга, посерединие — паттерн дизеринг до 1/2 градации, снизу — до 1/4 градации)

Тут я ещё и игры с цветом, настолько я знаю, были. Ну то есть если нам нужно добавить 1/4 интенсивности к группе пикселей 2x2, то вместо того, чтобы добавить +1 RGB к одному из пикселей, я добавлял +1R, +1G, +1B к разным пикселям, чтобы результат выглядел ещё равномернее.

P.S. А ту зелёную картинку я в GIMP-е оборабатывал.

mistergrim

Зелёную картинку вы можете обрабатывать вообще сколько угодно, там нельзя изменить ничего — просто нечего и не с чем смешивать, значения канала G отличаются на единичку.

DistortNeo

Да, с отдельными компонентами не поиграться. Но ничего страшного, градиент все равно хороший остаётся:

mistergrim

Речь-то не о том, что можно градиент скрыть. Речь о том, что картинка показывает, что восьми бит на компоненту недостаточно, дизерингом мы как раз и сэмулируем условный десятибитный цвет (ничего нового, мониторы давно так восьмибитный эмулируют — 6 бит + FRC; фотошоп, кстати, так градиенты рисует… и всё равно заметно).

DistortNeo

Именно так.

На 4К мониторе — уже нет.

Nick_Shl

Нет не могут. И сжатие тут не причём. Хоть есть "мифические" 16 млн. цветов, но если взять конкретный цвет(проще всего красный, зелёный или синий, т.к. всего одна компонента) — то их всего 256 штук, а это уже очень заметно — попробуйте сделать градиент. Только чистый, без дизеринга.

Klenov_s

В каком именно место заметны цветовые ступеньки? А монитор калибровали?

Вот еще нашел цитату: «По разным источникам глаз человека может различать от 3 тысяч до 10 миллионов оттенков».

DistortNeo

А у вас градиент с дизерингом.

Klenov_s

Вы правы. Не уследил, что теперь галка смешения установлена по-умолчанию. Тем интереснее.

Вот вариант совершенно прямой.

sved

Вообще, видны ступенки в тёмной части зелёного

DistortNeo

Ступенчатость заметна, потому что меняется не цвет, а интенсивность.

Возьмите теперь, ради интереса чисто цветовой градиент, например, вот:

https://upload.wikimedia.org/wikipedia/commons/0/08/YCbCr-CbCr_Y100.png

И, внезапно, оказывается, что увидеть ступеньки на этой картинке на откалиброванном мониторе может уже не каждый.