Напомню предысторию. Меня зовут Алексей Редозубов и я занимаюсь созданием сильного искусственного интеллекта. Мой подход крутится вокруг контекстно-смысловой модели работы мозга. Об этом был цикл статей на хабре и много видео на Youtube. Сейчас я хочу рассказать об основах контекстно-смысловой модели и о недавних исследованиях, которые позволили взглянуть на эту модель с новой, неожиданной стороны. Исследованиях невероятных настолько, что уверен — многие сочтут их безумием.

Есть два интересных и важных термина — «искусственный интеллект» (ИИ) и «сильный искусственный интеллект» (СИИ). В английской традиции Artificial intelligence (AI) и Artificial general intelligence (AGI). Первый подразумевает любую деятельность компьютера, имитирующую человеческий интеллект, второй — только такую, которая претендует на что-то универсально общее, похожее на то, как мыслит человек.

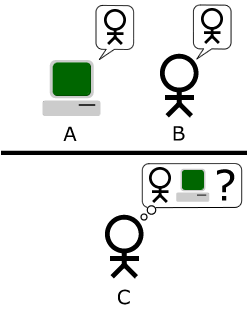

Точного определения СИИ нет. Лучшее, что есть — это знаменитый Тест Тьюринга.

«Человек взаимодействует с одним компьютером и одним человеком. На основании ответов на вопросы он должен определить, с кем он разговаривает: с человеком или компьютерной программой. Задача компьютерной программы — ввести человека в заблуждение, заставив сделать неверный выбор».

Если человек признает, что не может отличить двух скрытых собеседников, то можно говорить о достижении компьютером уровня СИИ.

Отметим очень тонкий и при этом очень важный момент. Простой ИИ может во много раз превзойти человека в какой-то области. Например, сильнее играть в шахматы, обыгрывать в Го или Starcraft. Но от этого он не становится сильным.

В английском названии СИИ не случайно называется общим или универсальным. Суть этого названия в том, что СИИ должен уметь решать не одну конкретную задачу и даже не широкий набор задач, он должен быть человекоподобным. То есть обладать способностью, начав с нуля, вникнуть в любую область и начать ориентироваться в ней подобно тому, как это способен делать человек. И желательно не хуже человека.

И тут мы приходим к понятию «смысл». В принципе, отличие человека от современных программ заключается в том, что программы и алгоритмы пока не способны уловить суть того, что происходит или о чем говорится. Они оперируют выученными шаблонами, не задаваясь вопросом о смысле. Даже великий и могучий GPT3 является, по сути, огромным генератором правдоподобного бреда и даже близко не приближается к пониманию того, что он генерирует.

Берусь утверждать, что для создания СИИ в первую очередь надо понять, что есть смысл. Но легко сказать. Вся современная философия построена вокруг различных попыток это сделать. Но результата, который можно было бы описать формально и запрограммировать, пока нет.

Как же формально описать смысл? Для начала надо договориться, о каком смысле пойдет речь. Слова коварны, каждый может дать свое определение смысла и быть совершенно прав внутри данного им определения. Двое с разными определениями могут спорить до хрипоты и никогда ни о чем не договорятся; собственно, философия — яркий тому пример. Нас будет интересовать то понимание смысла, что существует у людей интуитивно и то, которое ложится на суть теста Тьюринга.

Тут надо пояснить. Еще Сократ обнаружил удивительную вещь. Люди знают язык, понимают его слова, тонко чувствуют, когда какое слово уместно употребить, но редко когда могут объяснить свое знание. То есть наш мозг знает много больше, чем мы можем объяснить. Сейчас такие знания принято называть имплицитными.

Интересно, что когда человек пытается объяснить то, что знает его мозг, он не может получить непосредственный доступ к этим своим знаниям. Например, он не может их просто вспомнить. Знания есть, но они недоступны. Доступен только результат использования этих знаний.

Поясню на примере. Прочитав шутку, вы смеетесь. Объявление: меняю бензопилу на протез. Но если вас спросить, что в шутке смешного, вы озадачитесь и скорее всего дадите объяснение, которое будет неверным. Если бы ваше объяснение было верным, то вы, зная секрет юмора, могли бы легко придумывать смешные шутки и стать знаменитым юмористом. Ваш мозг всегда знает, смешно или не смешно, но вы практически никогда не можете объяснить, почему. Более того, ваш мозг тонко чувствует разницу между просто смешным и юмором, а вы?

Так вот, мы будем говорить о смысле в том понимании, какое стоит за этим словом, когда мы используем его в речи, не пытаясь дать ему четкого определения. Дело в том, что наивное определение, которое дается, пока явление еще не понято, будет обязательно построено на неких видимых признаках и в итоге опишет нам совсем другое. Платона попросили дать определение человека. Он сказал: двуногое без перьев. Диоген принес ощипанного петуха и сказал: вот человек.

Сказанное не значит, что смысл непостижим и не может быть выражен словами. Просто сложные явления не стоит недооценивать. Кстати, для извлечения неочевидных скрытых знаний Сократ придумал удивительный метод, который так и называется: метод Сократа. Метод актуален сегодня, как был и во все времена, очень рекомендую.

Итак, приступим к «извлечению» природы смысла. Чтобы описывать окружающий мир, наш мозг в результате эволюции приобрел возможность формировать внутренние понятия. Такое представление сегодня достаточно распространено, на нем основана когнитивная психология, согласимся с этим и мы.

Формирование внутренних понятий происходит под воздействием опыта, который человек получает из окружающего мира. Хотелось бы сказать, что явления, окружающие нас, приводят к отражению их в понятия. Но беда в том, что в самом мире явлений нет, явление — это тоже одно из наших понятий. Скажем так: наличие в окружающем мире определенной структуры приводит к формированию понятий, способных адекватно эту структуру описать.

В какой-то момент эволюции у человека появился язык. Внутренним понятиям были сопоставлены слова. Устные слова — это просто звуки, они не несут смысла сами по себе. Но будучи связанными с понятиями, передают их значения. То есть за содержание отвечает внутреннее понятие, а слово — это внешняя форма понятия. При этом надо учитывать, что далеко не всем внутренним понятиям соответствуют какие-либо слова.

Язык развивался и в нем появлялись новые слова. Кроме непосредственно обозначения того, что видно или слышно, в языке стали появляться слова, обозначающие некие сложные, порой абстрактные явления. Люди открывали для себя эти явления и через язык давали им названия. Например, так появились слова: «понятие», «логика», «определение» и тому подобные.

Для появления внутренних понятий, в принципе, язык не нужен. Они сформируются и без него. Своя система понятий сформируется и у Маугли. Но с момента своего появления язык стал влиять на то, какая именно система внутренних понятий формируется у людей. Образование понятий напоминает рост виноградных лоз. Для лозы направляющая служит опорой и задает направление ее роста. Сколько есть направляющих, столько лоз их обовьет. Для формирования внутренних понятий слова языка во многом служат такими направляющими. Изобретенные когда-то слова, обозначающие некие абстракции, и сегодня позволяют сформироваться у нас понятиям, которые не возникли бы сами по себе без участия языка.

И вот мы подходим к самому интересному. Хорошо, внутри у нас есть набор понятий. За каждым понятием стоит некое содержание. Но как мозг это содержание описывает? Что это за содержание? Каков его механизм? Собственно, это и есть те самые главные вопросы, от ответа на которые все зависит. Ведь, по сути, мы говорим о том, что за каждым понятием стоит некий смысл. И этот смысл и определяет содержание понятия. То есть, когда мы говорим, что мозг умеет, наблюдая за миром, формировать понятия, мы говорим о том, что мозг умеет формировать описания смыслов.

Заданные вопросы очень коварны. Дело в том, что ответы на них слишком очевидны. Предположим, вы бог и вам надо «запрограммировать» мозг. Как вы в своей программе зададите понятия? Скорее всего так же, как естественным образом это сегодня пытаются сделать многие создатели ИИ. Попробуем воспроизвести их рассуждения.

Чтобы сформировать набор понятий, описывающих мир, надо поделить этот мир на области, которые можно назвать, например, классами, кластерами или как-либо еще в зависимости от вкуса. Чтобы было проще, стоит, посмотрев на число слов в языке, ограничить себя, например, набором из десятка тысяч понятий. Каждое из понятий должно объединять похожие друг на друга явления. Но из-за бушующего многообразия явлений (в море каждая волна уникальна) эти классы нельзя задать простым перечислением. Надо придумать что-то более универсальное.

Вполне логично дальше для каждой группы явлений, относящихся к одному понятию, создать свой прототип. То есть вычислить образ идеального явления.

Чтобы описать портреты явлений, нам понадобятся признаки. На роль признаков подходят другие «более мелкие» явления. Удава можно измерить в попугаях. Признаки, конечно, сами потребуют описаний, но тут мы выкрутимся, сделав многоуровневую конструкцию и пойдем от простого к более сложному.

Если мы запишем признаки в вектор, то получим очень удобное признаковое описание. Например, это может быть вектор, в котором каждое число указывает на степень выраженности соответствующего признака в явлении. Можно придумать и что-то посложнее, не суть.

Дальше нам понадобится обвести прототипы границами. Что внутри границ — относится к понятию, что выходит — нет. Для этого придется придумать некую метрику, которая позволит, взяв одно описание, сравнить его с другим. Если мы имеем дело с векторами, то таких метрик сотни и можно выбирать любую по вкусу.

Конечно, если подходить серьезнее, то имея учителя, который скажет, какое явление к какому понятию относится, мы сможем не только рассчитать центр класса и назвать его прототипом, но и вычислить характер распределения. Это может сильно помочь на практике. Средний вес килограммовой гири — один килограмм. Средний вес курицы 3 килограмма. Нечто весом кило сто, исходя из распределений, скорее будет курицей, чем гирей. Хотите знать подробнее, смотрите методы классификации и кластеризации, расстояние Махаланобиса.

Рано или поздно обнаружится, что все явления многогранны, тогда можно будет усложнить схему. Например, искать ключевые признаки, определяющие явление, либо пытаться для каждого явления задать набор его возможных проявлений и очертить границы вокруг них. Собственно, вот вам краткий курс нейронных сетей.

Сухой остаток: понятия можно задать через перечисление их признаков, тем самым разбив мир на области. Затем можно совершенствовать описания, уточняя прототипы и границы вокруг них. Разделяй и властвуй.

Так действительно можно сделать. На этом основаны методы математической статистики, в этом основная идея машинного обучения, на этом же фундаменте построен колосс нейронных сетей.

Так в чем подвох? А в том, что когда заходит речь о словах языка и, как следствие, о стоящих за ними понятиях, то в первую очередь всплывает именно такая модель. И полагается вполне очевидным, что, видимо, мозг делает точно так же. Что, как и в искусственной нейронной сети, в мозгу есть нейроны бабушки, бодро реагирующие на ее появление и хранящие на своих весах ее портрет.

Другими словами, кажется вполне очевидным, что у каждого понятия есть его определение. А значит, потрудившись, можно дать определения всем понятиям и тем самым понять скрытые знания человека.

И тут мы возвращаемся к смыслу. С одной стороны, за каждым понятием стоит его смысл. С другой, мы только что рассудили, что понятию можно дать определение. Выходит, что определение и есть смысл? Очевидно, что нет. Но в чем тогда разница? И тут приходит спасительная мысль: даже если определение пока не соответствует смыслу, то можно постараться определение уточнить, приблизив к оному. Напрашивается вывод, что определение понятия — это его «недоделанный» смысл, который при желании можно «доделать». И тогда смысл хочется истолковать как некое «идеальное» определение. Отсюда возникает вера, что усложняя описания понятий, создавая онтологии, описывая связи между понятиями, мы рано или поздно сможем постичь смысл и создать СИИ.

В популярном буддистском коане говорится: «Рыжая корова проходит мимо окна. Голова, рога и четыре ноги прошли. Почему не может пройти хвост?». В математике беда почти всегда приходит с одной и той же стороны. И имя этой стороны — комбинаторный взрыв. Имея дело с тепличными примерами, не нарадуешься красоте определений. Но стоит только «выйти в поле», и все идет прахом. Любое реальное явление начинает давать такое разнообразие проявлений, что никакие вычислительные мощности и датасеты не могут за этим разнообразием угнаться. Все время кажется, что осталось еще совсем немного дообучить модель и все будет хорошо. Мы слышим: автопилот для автомобилей уже почти готов, осталось пару месяцев. На моей памяти эти пару месяцев слышатся последние года три. Правда, сейчас говорят: три месяца и точно. Проклятие размерности — оно такое. К сожалению, корову не определяет ни ее цвет, ни ее рога и ни ее копыта, и «хвосту» всех признаков никогда не пройти мимо.

В этом и есть разница между ИИ и СИИ. Простой ИИ строится на использовании сущностей, заданных определениями. Отсюда классы, кластеры, тезаурусы, онтологии, нейроны бабушки и тому подобное. СИИ, который может пройти тест Тьюринга — это, в первую очередь, интеллект, оперирующий смыслом.

Так что же такое смысл и чем он отличается от определения? Попробую объяснить. Предположим, есть нечто, на что мы смотрим. Допустим, мы не узнаем предмет перед нами. Тогда мы можем изменить точку зрения и посмотреть на него с другой стороны. Если изучаемый предмет в принципе нам знаком, то должна найтись такая точка зрения, с которой мы его, наконец, узнаем. На этом можно было бы и закончить, предмет опознан, что еще? Но важно (и об этом часто забывают), что кроме того, что нам удалось понять, что перед нами, мы еще узнали и точку зрения, глядя с которой, у нас все и сложилось.

Почему это важно? Дело в том, что любое понятие может быть точкой зрения. За всяким понятием стоит явление, которое меняет наше восприятие мира. Одно и то же мы начинаем видеть по-разному в зависимости от того, через призму какого явления мы смотрим. «Ицик, сколько будет дважды два? А мы таки покупаем или продаем?». Так вот, если, глядя через призму явления, мы увидим правдоподобную картину, то это будет означать, что скорее всего в этот момент присутствует и само явление. «Дважды два — пять» — продаем, «три» — покупаем.

То есть самого явления может быть вообще не видно, но по его влиянию на картину мира мы можем понять, что оно есть. Это как тот Чеширский кот, когда сначала появляется его улыбка, а вслед за ней сам кот.

Уловили идею? Вы видите комнату и в ней разбитую вазу. Сначала это просто «разбитая ваза». Но если посмотреть на это в предположении, что в комнате есть кот, то появляется картина «кот задел вазу и она, упав, разбилась», вот она, улыбка. Эта картина оказывается вполне правдоподобной. В этот момент вслед за своей улыбкой появляется и он сам. То есть вы узнали кота, вообще не видя ни его, ни каких-либо его непосредственных признаков.

Настоящая «магия» заключается в том, что для каждого явления, наблюдая за ним, можно составить правила, по которым из исходного описания получается его трактовка. То есть любое явление может быть контекстом, в котором исходное описание заменяется его трактовкой в этом контексте.

Что это дает? Это позволяет проделать мысленный эксперимент. Имея сформированный контекст, для любой входной информации можно, используя вычисленные правила, получить трактовку в этом контексте. Это как, имея волшебную лампу Аладдина, посмотреть, что будет, если примерить на людей другие роли. Получится ли что-то разумное или же выйдет полный бред.

Важно, что осмысленная трактовка появляется в контексте только тогда, когда есть существенная вероятность, что присутствует соответствующее явление. Отсюда возникает алгоритм. Возьмем все слова языка, сформируем вокруг них контексты, то есть вычислим правила трактовок. Теперь, когда будет поступать новая информация, будем смотреть, в каких контекстах трактовка оказалась наиболее достоверной.

В этом можно увидеть многое от байесовского подхода. В нем, используя накопленные данные, для каждого интересующего нас события строится условная плотность распределения. То есть строится картина того, как будет выглядеть распределение при условии, что данное событие уже реализовалось. Затем новые данные примеряются к этой плотности для того, чтобы оценить, насколько достоверно они выглядят на фоне этого распределения. Проделав это для всех возможных событий, можно судить о том, в каком предположении все выглядит наиболее достоверно, и из этого сделать заключение о присутствии соответствующего события.

Но как в случае контекстов оценить достоверность трактовки? Очень просто — трактовка должна выглядеть, как что-то нам ранее знакомое. Это значит, что надо иметь память того, что мы знаем, и сравнивать трактовку с памятью. Увидели что-то знакомое, значит, контекст подходит. Причем во всех контекстах память должна быть одна и та же.

Тут напрашивается сравнение со сверточными сетями. В них один и тот же набор ядер свертки (одна и та же память) примеряется к разным частям изображения. Там, где есть совпадение, мы говорим об обнаружении соответствующего образа. При этом сами позиции, в которых осуществляется свертка, по сути, выступают в роли контекстов. Мы примеряем известные нам картинки в предположении, что эта картинка сдвинута к соответствующей позиции. Поясню, ядро свертки — это маленькая картинка. Она примеряется к какому-то месту большой картины. Это равносильно тому, что мы взяли пустую большую картину, в центре которой разместили маленькую картинку. Сдвинули маленькую картинку к нужному месту, а затем сравнили две больших картины.

Но у наших контекстов есть принципиальные отличия и от байесовского подхода, и от сверточных сетей. Самое главное в том, что там к неизменной входной информации примеряется некое «искажение» памяти. Вот «искаженное» по отношению к исходному условное распределение. Вот ядра свертки, перемещенные так, чтобы оказаться в нужном месте изображения. У нас же память всегда остается неизменной, а «искажается» входная информация. Вместо исходного описания в каждом контексте появляется его трактовка. Если гора не идет к Магомету, то Магомет идет к горе.

Кроме того, в сверточных сетях важно то, «что увидели». В байесовском подходе — то, «где увидели». У нас же — и «что увидели», и «где». Но, пожалуй, самое главное отличие — это возможность автоматически построить пространство контекстов. В сверточных сетях правила свертки воспринимаются как нечто естественное, следующее из законов геометрии, и вопрос об их формировании не ставится. Зачем, если они, правила, и так понятны? Мы же говорим, что для любой информации можно сформировать пространство контекстов, обучив контексты соответствующим правилам трактовки. Кстати, мы показали, как в зрительной истории контексты, соответствующие правилам свертки относительно несложно получаются при самообучении.

В результате получается, что полное задание конкретного понятия требует трех вещей. Нужны:

имя понятия. Слово языка или внутреннее кодирование имени понятия.

правила трактовки. Правила преобразования, индивидуальные для каждого контекста.

память. Накопленный ранее опыт, один и тот же для всех контекстов.

И работает эта триада не по отдельности, для каждого понятия, а только в пространстве всех понятий, где происходит сравнение результатов между собой.

Теперь возвращаемся к смыслу. Смысл понятия — это и есть описывающий его контекст, состоящий из правил трактовки и памяти. Смысл информации — это тот контекст, в котором трактовка выглядит достоверно, и сама полученная трактовка. И, заметьте, что смысл не сводится к определению. Он имеет совсем другую природу, в которой нет привычного прототипа и границ вокруг него.

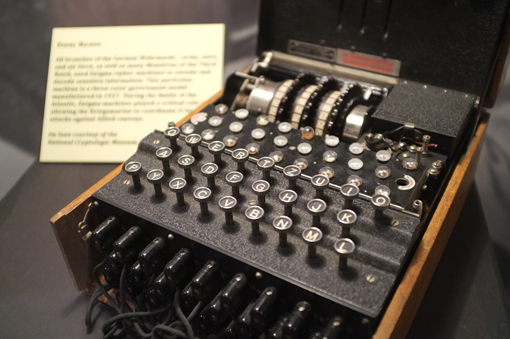

Поясню все на моем любимом примере. Во время второй мировой войны немцы использовали шифровальную машину под названием «Энигма». Сообщение на входе перекодировалось так, что одни буквы заменялись другими по достаточно сложным правилам. Кодирование происходило с помощью ключа. Если на принимающей стороне ключ был известен, то можно было через обратное преобразование восстановить исходное сообщение.

Шифровальная машина «Энигма»

Примерно в декабре 1932 года Мариан Реевский, польский математик и криптоаналитик, смог разработать алгоритмы, позволяющие потенциально взломать код «Энигмы». В это же время французской разведке удалось получить ключи, реально используемые немцами, и передать полякам. Анализируя перехваченные сообщения, Реевскому удалось восстановить внутреннюю схему «Энигмы». Для расшифровки немецких сообщений поляки построили шесть машин, «бомб», которые позволяли за разумное время перебрать 100 000 возможных кодов и найти среди них верный.

В 1938 году немцы усложнили конструкцию «Энигмы», в результате чего расшифровка ее сообщений стала в десять раз сложнее. За пять недель до вторжения Германии в Польшу в 1939 году Реевский и его коллеги передали свои результаты французской и британской разведке. Это позволило англичанам построить в Блетчли-парк батарею из «бомб», которая успешно взламывала немецкие коды на протяжении всей войны.

Определенную роль в этом сыграл тот самый Алан Тьюринг, что придумал приведенный в начале тест.

Немецкие шифровальщики могли ежедневно менять коды, поэтому главной задачей англичан было найти актуальный код, после чего все остальное становилось делом техники. Для этого приходилось брать сообщение и перебирать с помощью «бомб» миллион возможных вариантов. То есть смотреть на сообщение в миллионе возможных контекстов, получая миллион его потенциально возможных трактовок. Если код был неверен, то на выходе получался бессмысленный набор знаков, но как только обнаруживался правильный код, сообщение приобретало смысл. Главный вопрос был в том, как без участия человека понять, что сообщение получилось осмысленным?

Оказалось, что каждая ежедневная немецкая метеосводка заканчивалась одной и той же подписью – «хайль Гитлер». Зная это, англичане брали утреннюю метеосводку и перебирали коды до тех пор, пока эта подпись не появлялась в конце сообщения.

Можно было бы обойтись и без известной подписи, а ждать, чтобы слова в сообщении стали правильными, то есть соответствующими немецкому языку. Это и есть сравнение трактовки с памятью для определения ее достоверности.

И самое главное — при расшифровке прогноза погоды англичан не интересовал сам прогноз погоды. Был важен контекст, то есть код, в котором получалась удачная расшифровка. Напомню, что в контекстно-смысловом подходе удачная трактовка – это только часть расшифрованной информации, другая часть – это контекст, в котором эта трактовка возникла.

Замечу, что разбираясь с контекстным подходом, удобно представлять себе «Энигму» и ее коды. Если понять правильные сопоставления, многое становится простым и понятным.

Для полноты картины отмечу, что кора человеческого мозга делится на зоны, которые в свою очередь состоят из миниколонок. Каждая из миниколонок — это порядка сотни нейронов, расположенных вертикально, с плотными связями между собой и менее плотными по сторонам. У меня есть статьи, где показывается, что каждая из миниколонок является реализацией отдельного контекстного модуля и что память зоны коры продублирована в каждой из ее миниколонок. При этом сами зоны коры являются пространствами контекстов. Таким образом, анализируя информацию, человек одновременно рассматривает ее во множестве различных контекстов, выбирая из них наиболее подходящие. Я полагаю, что мышление человека основывается именно на контекстно-смысловых принципах.

Конечно, это только начало разговора о контекстах. Далее должен следовать разговор о форме кодирования понятий, о методах хранения памяти, о механизмах поиска закономерностей, о рекуррентной модели, реализующей формальные грамматики, о пространственной организации контекстов, о реализации обучения с подкреплением, о формировании удачных описаний и многое другое. Подробнее об этом есть в цикле лекций «Логика сознания».

Все, что было сказано, было странно, но не безумно. А где же обещанное безумие? Начнем.

Разрабатывая контекстно-смысловую модель, мы постоянно задавались вопросом: неужели никто раньше до этого не додумался? В конце концов, а как же философы? Великие древние, которые рассуждали об устройстве мира и разума? И постепенно до нас стало доходить. Как вы думаете, кто такой Диоген? Почему он жил в бочке? Почему ел прямо на рынке? Почему с фонарем искал честного человека? Почему его взбесило, когда горожанин нацепил на себя шкуру льва? Пазл стал складываться.

Мы с удивлением обнаружили, что в древних текстах и преданиях скрыто огромное количество устойчивых, согласующихся между собой и непротиворечивых аллегорий, непосредственно отсылающих к философии смысла. К той философии, что говорит ровно о том, над чем работаем мы. В итоге параллельно с созданием СИИ наша команда несколько лет работала над разгадками древних аллегорий.

И выяснилось, что действительно, ничто не ново под луной. И шумерские мифы, и египетская книга мертвых, и аккадский Гильгамеш, и греческие легенды, и буддийское учение, и Ветхий, и Новый Завет, и Талмуд, и Коран, и «Сказки тысяча и одной ночи», и много что еще оказались аллегорически зашифрованными рассказами о философии смысла. А еще обнаружилось, что причины шифрования философии смысла в священные тексты и превращение этих текстов в религии было не забавной шуткой авторов и не капризом истории, а страшной драматической необходимостью.

Все наработки мы постепенно начали выкладывать на сайт нашего проекта «Поиск утраченного смысла». Понять основные посылы можно из описания или посмотрев короткое видео, где, кстати, рассказывается, почему не стоит бояться конца света.

Ну и в развитие темы о смысле и определении я хотел бы предложить вам рассказ о том, как на это смотрели наши предки и какие подсказки они нам оставили. Я понимаю, что это будет достаточно неожиданно, и уверен, многие сочтут за сумасшествие, но я специально сделал это видео в форме провокации, не пробуя что-то доказать, а пытаясь возбудить любопытство и вызвать желание разобраться глубже.

Алексей Редозубов

AN3333

Попытка сделать нечто работающее исходя из философии? Проект обречен на провал.

Bedal

Более того, главный вывод: «Статья написана по результатам прочтения научпопа. Авторы сами разрабатывать нейросети не умеют. Запускать — может быть.»

AlexeyR Автор

Несколько не так. Мы уже сделали много работающего и после этого стали понимать что-то в философии.

saboteur_kiev

То есть вы достигли результата не в разработке ИИ, а в том, что продвинулись немного в философии?

Для начала, тест Тьюринга совсем не самое лучшее, что может быть.

Условия теста никак не проверялись на соответствие человеку.

Взять 100 человек разного возраста и состояния здоровья, и дать им пообщаться с группой экспериментаторов по чату. Как много «ИИ» найдет группа экспериментаторов, если будет считать что им нужно отличить человека от ИИ? Если найдет хоть одного, значит данный тест Тьюринга ни о чем. Такой эксперимент кто-то проводил, чтобы убедиться что тест рабочий? Я не слышал.

Во-вторых, условие — поговорить с человеком, и почти весь ИИ который участвует в таких тестах заточен не на развитие именно интеллекта, а на обман человека в разговоре при помощи базы данных и так далее. При этом ИИ не выходит за рамки разговора. Человек, который пройдет тест Тьюринга может пройти другие тесты, возможно ему нужно будет немного подучиться, но это он сможет сделать самостоятельно. Он может выполнять и другие задачи. А ИИ, которого обучили чатиться — сможет только чатиться.

qw1

SergeyMax

Экспериментатор: сыграем в игру

Испытуемый:…

Экспериментатор: как «нахер»?

qw1

То, что испытуемый делает всё, чтобы доказать свою разумность, входит в условия теста. Поэтому говорить «нахер» может неразумно, т.к. быть трактовано как дежурная фраза, когда нет понимания и это требуется замаскировать.

kometakot

А экспериментатор знает о том, что испытуемый мотивирован на обман, а живой человек — нет. Поэтому произнёсший «нахер» — с большей долей вероятности человек.

qw1

Нет, потому что автор бота может рассуждать именно так, как вы написали, и заложить реакцию «нахер» на все непонятные ситуации.

kometakot

А экспериментатор может догадаться о таком рассуждении автора бота, и начнётся война меча и щита. Экспериментатору остаётся лишь пытаться определить — насколько по человечески будет звучать «нахер» в непонятных для настоящего человека ситуациях.

qw1

Именно поэтому добросовестному участнику теста надо отвечать на вопросы, а не посылать нахер.

kometakot

«Надо» только тому участнику, который мотивирован в том или ином результате теста.

SergeyMax

qw1

Такое общение не будет являться тестом Тьюринга.

SergeyMax

AlexeyR Автор

Вспомнить о смысле. Если пытаться дать формальное определение условиям теста, то всегда найдется ощипанный петух про которого Диоген скажет, что это человек. Если же исходить из смысла теста, то все встает на место.

qw1

SergeyMax

В этом и проблема. Тест не позволяет различить ситуации, когда машина просто ничего не понимает, и когда искусственный интеллект по какой-либо причине не желает общаться с низшими существами.

qw1

Идея этого теста появилась в середине прошлого века, когда считалось, что ИИ будет такой прислугой для людей, без своих интересов.

AlexeyR Автор

Не соглашусь. СИИ нельзя создать без эмоции, а значит и без интересов. И они часть теста.

qw1

В 1950-е, когда создавался тест, это было не очевидно.

AlexeyR Автор

Дух теста в проверке «адекватности» собеседника. Эмоции — это часть механизма обучения с подкреплением. Это ключевой механизм в формировании человека и, как я убежден, он обязателен для СИИ. Без него «адекватности» не получить. Уже в 20-х годах эти принципы четко сформулировали бихевиористы.

qw1

Общего консенсуса не было (возможно, и сейчас нет). Иначе как понимать тупиковые проекты 80-х и 90-х создания серьёзного СИИ на чисто логических подходах (языки 5-го поколения, CYC/OpenCYC). Кто бы их затевал, если бы было абсолютно понятно, что направление тупиковое.

saboteur_kiev

Попробуйте провести такой тест с ребенком 5 лет, посмотрим он бот или человек?

Вы вообще не поняли о чем я. Тест Тьюринга сам по себе никем не был проверен, что он рабочий на самих людях. Нет стандартна сколько должен длиться разговор, кто и по какой причине ставит свой позитивный или отрицательный отзыв.

dipsy

Ребенок 5 лет это "недоразвитый" интеллект, нельзя его в тестах Тьюринга использовать, как и больных деменцией и т.п. расстройствами, а так же людей без хотя бы среднего образования.

Впрочем и для 5 летнего можно придумать адекватный тест, на простейшую логику и особенно на память и удержание контекста беседы, чего полностью лишены машины. Попробуйте сказать боту какую-то неожиданную информацию, типа "я в синих кроссовках", а через пару сообщений спросить, если "я сейчас надену левый ботинок черого цвета, какого цвета будет обувь на правой?"

saboteur_kiev

Приведите пожалуйста ссылки на авторитетные источники, где указаны упомянутые вами ограничения к тесту Тьюринга?

Потому что на самом деле таких требований нет, и собственно какого-то стандарта и сформулированных требований к тесту тоже нет.

Все тесты, которые проводились, соблюдали только требования авторов этих тестов, которые составлялись эмпирически, и никем не проверялись, и даже никак не сопоставлялись с другими тестами.

dipsy

К тесту Тьюринга, как идее, не нужны авторитетные источники и утвержденная Уполномоченным Комитетом методика проведения тестирования. Просто решил ответить на достаточно абсурдный, по моему мнению, аргумент про 5-летних детей. Видимо зря, придется наверное и дальше разъяснять очевидные

даже 5-летним детямвещи.saboteur_kiev

Совершенно не абсурдный. Никто не запрещает общаться с пятилетним ребенком как с пятилетним ребенком и задавать вопросы соответствующие возрасту.

Но при этом, пятилетний ребенок — это уже полноценный интеллект, с возможностью развития, причем возможно без участия разработчиков, а только психологов или «киберпсихологов» =).

То есть если будет создан ИИ уровня пятилетнего ребенка — это уже ОГРОМНЫЙ, НЕВЕРОЯТНЫЙ прорыв.

JArik

А с чего 5летний не человек теперь? Если АИ покажет хотя бы уровень ребенка 5 лет — это уже человеческий интеллект, с такими свойствами как — способность к пониманию контекста, обучения, развития как с помощью других людей или систем, так и самостоятельно. Имея такой АИ, через еще 5лет вы сможете "вырастить" из него уже 10, а то и 20+ летнего. Так что тест Тьюринга вообще не про какой-то абсолютный меритель интеллекта — он про умственные способности, а это огромная разница.

qw1

А никто не утверждает, что субъект, не прошедший тест тьюринга, не имеет интеллекта. Ещё раз: это достаточное условие (по замыслу Тьюринга), а не необходимое.

SergeyMax

dipsy

GPT-3 это не интеллект, и предполагаю, что это достаточно быстро можно понять собеседнику-человеку (развитому, взрослому, достаточно эрудированному). Я бы всё-таки именно на таких ориентировался, в качестве собеседников для машины. С обратной стороны люди в принципе не нужны никакие, ну просто зачем, если понять что это человек (и это реально человек), нам это никак не поможет в создании думающей машины. Можно немного обмануть тестирующего, для снижения предвзятости, рассказав что «там» может быть человек, но совершенно не обязательно сажать туда другого человека.

perfect_genius

Вот это сильно, теперь очень хочется провести такой эксперимент. Его ведь можно провести даже обычным людям через Интернет. Если не получается организоваться, то можно привлечь денежным вознаграждением за участие.

Мой вариант замены сомнительного теста Тьюринга — тест на чувство юмора. Чтобы более менее хорошо шутить нужен изобретательный ум. Только вот даже люди не все способны на это, половина человечества уж точно. Так что за ИИ могут часто принимать женщин :)

saboteur_kiev

Есть профессиональные шутки, которые непонятны тем, кто не в этой профессии.

Есть локальные шутки, которые понятны только тем, кто в теме.

Способность или неспособность к юмору — вещь непредсказуемая, в первую очередь потому что нет формального определения шутки, которая бы подошла всем.

Catslinger

Есть меташутки — понятные только тем, кто знает другую шутку.

Однажды, на обеде у Губернатора, поручик Ржевский взял вилочку для омаров не в ту руку. С тех пор по стране ходят истории о его невоспитанности.

saboteur_kiev

тем, что для понимания шутки нужно знать другую шутку — ничем не отличается от того, что для понимания шутки нужно знать локальный мем/профессиональный термин/конкретную ситуацию и так далее.

kometakot

perfect_genius

Если ИИ будет успешно имитировать человека, то значит какой-то человек может походить на ИИ. Эксперимент показал бы можно ли найти такого человека по его манере общения.

waldganger

Из философии это «означаемое» и «означающее» — дихотомия языкового знака, но их автор не знает

Barbaresk

Почему же вы так? Из философии выходят все науки, так что в каком-то смысле рассуждения в философии позволяют определить направление. И рассуждения на тему, что является интеллектом как раз философское. Другое дело, что здесь и философии нет. Здесь какие-то цитаты из интернета и прочее «оригинальное исследование». Я не вижу в тексте ссылок на: Гёделя, Дрейфуса, Сёрла, Хофштадтера и других учёных и вижу лишь поверхностное упоминание Тьюринга без упоминания по сути.

AN3333

Все науки выходят от работ Галилея. Который ссылался на Архимеда, в противовес Аристотелю.

И уже из этого одного видно сколь умный был мужик.

phenik

AN3333

Наука это и есть экспериментальный подход, добавленный полезными инструментами типа математики. Причем, единственный подход. Никакой иной подход ни к чему не привел. Аристотель не был ученым. И ничего научного от него не происходит. Схоластика, вот та да, происходит.

Это клевета на науку. Науку создали ремесленники. А философы тысячу лет тормозили этот процесс.Предтечи науки это греческие математики (Евклид) и изобретатели (Архимед). Затем, веками накапливался практический технический опыт: мореплавание, голландское сельское хозяйство, алхимия, механика и т.п. А первый настоящий ученый Галилей синтезировал всё это в то, что лишь и достойно называться наукой.

phenik

a1111exe

Кстати, интересный факт: Галилею была понятна ошибочность тезиса Аристотеля и без проведения опыта. Из Вики:

Т.е. для Галилея было очевидно, что сведение к противоречию достаточно для опровержения утверждения об объективном мире. И это чисто философская позиция. :)

phenik

AlexeyR Автор

В триаде Сократ, Платон, Аристотель. Сократ говорил о смысле. Платон пытался его пересказать. А Аристотель свел все к определениям, по сути, уничтожив все от Сократа. Сама эта история — поучительный рассказ.

vagon333

AlexeyR Автор

Через абзац об этом.

ni-co

"… великий и могучий GPT3 является, по сути, огромным генератором правдоподобного бреда и даже близко не приближается к пониманию того, что он генерирует". Только если представить ее не выучившим урок учеником, стоящим возле школьной доски. Это из- за того, что понятие «понимание» у Вас очень уж усложнено антропоцентризмом.

AlexeyR Автор

Просто недавно на семинаре сообщества AGI была озвучена эта формулировка и все с ней согласились. Она понравилась и мне, отчего я ее позаимствовал. Но у вас может быть свое мнение.

ni-co

Для того, чтобы связать разбитую вазу с котом не обязательно знать язык и быть человеком.

А в Вашей статье это чуть не признак «понимания». Существуют на данный момент нейросети, способные по видеоряду пояснять, что происходит на экране. Примитивным пока образом, но дайте им ресурсов. Вот я о чем.

AlexeyR Автор

«Дайте им ресурсов» — это и есть шаги по пути, ведущему в комбинаторный взрыв.

ni-co

Напомните, когда человек начал проигрывать компьютеру в шахматы?

goth

Понимание происходящего вне шахматной доски у компьютера от этого не появилось.

ni-co

Тут, ниже очень хорошо написано, что понимание это системный процесс. Человек и бот или китайская комната. Вы никогда достоверно не узнаете, что у вашего собеседника в голове. Есть только Ваш субъективный вывод, мысли. Я не согласен с трактовкой автора понятия «понимание». И как правильно он заметил это мое личное мнение. Уже зарекся дискутировать на эту тему. Единственное, что меня заставило вклиниться в беседу так это знак равенства, поставленный автором между GPT3 и китайской комнатой(о понимании), что далеко не так.

leventov

MuZero кое-что "понимает вне доски".

Halt

Если вы намекаете на обуздание комбинаторики методами альфа-бета отсечения, Монте-Карло и deep learning, то тут речь не об этом. Пространство решений игры — ничто по сравнению комбинаторикой реального мира.

В вашем примере правила игры, как и размерность игрового мира, ограничены, известны заранее и не меняются, пусть даже модель их не знает (AlphaZero). Поэтому в статье и отмечено, что сравнительно легко написать специализированный ИИ, который уделает человека на своем поле. Но все становится плохо, как только приходится иметь дело с открытым миром.

ni-co

Странно, что инфузория туфелька до сих пор не вымерла в ОТКРЫТОМ мире.

Halt

Зря вы иронизируете. Вашей инфузории, на минуточку, потребовались миллиарды лет эволюции, сложнейшая биохимия и сама жизнь в придачу, чтобы выжить в открытом мире. И все это чтобы «бесцельно» плавать в лужице. А так да, все кажется простым, пока отбрасываешь «незначительные детали».

То же и в ML. А потом оказывается, что велосипеды могут ездить боком по шоссе со скоростью 100 миль в час.

ni-co

А теперь масштабируйте время теоретических и практических работ в области генетических алгоритмов и нейросетей с временем эволюции инфузории

Sabbone

Скорее всего у гпт-3 вся проблема в памяти и обучении, она запоминает все что показывают и делит на объекты, представьте ребенку или любому пустому разуму показывают набор картинок — это почти сферический ребенок в ваккуме, не считая картинок. Или ГО, или ионтесуме. Конечно сеть не умеет ничего другого, потому что ее не учили. Ей нужен огромный объем памяти и возможность тусить в окружающем мире, например бостон динамикс, ну и облака огромной мощности для обработки инфы, целые ангары видюх от майнеров тоже подойдут. Или вместо реального мира его симуляции на огромной скорости, но это будет разум во снах, ему надо будет действовать в реальном мире иначе он погрязнет в этих снах. Потребуются время и мощности довольно большие и в тоже время очень малые, чтобы двигать не только персонажами в игре, а процессами в мире который ты видишь через камеры и щупаешь манипуляторами

AlexeyR Автор

Статья как раз о том, что так не сделать.

Sabbone

Вот вот, одна и таже сеть играет в разные игра, оперирует со словами слаборазвитый человек. Ее с рождения держат в темной коробке показывая мельком куски реальности. Хз откуда но она что-то делает а значит у нее есть мотивация.

Пифагор жил в бочке потому что, у него были руки и ноги и бочка, и глаза и он рос с младенчества длительное время, его воспитали и научили.

А разные инстансы нейросети тоже в итоге разные

Написал максимально просто.

Halt

В бочке жил Диоген )

Sabbone

кто знает может и пифагор временами жил в бочке. На самом деле я просто перепутал, это смешно)

Sabbone

в первом предложении я наделал кучу ошибок, правильно — Вот вот, одна и та же сеть играет в разные игры, оперирует со словами как слаборазвитый человек…

demon416nds

Очень рекомендую почитать технокосм Лазаревича и вообще нф литературу, вы удивитесь сколько разных потенциально рабочих идей там описано.

ZuOverture

У Лазаревича нет идей, направленных на создание ИИ. Если вы про переводчика и Примечание переводчика, то там не поясняется связь между текстом и семантикой текста, ключевая для работы этой системы.

demon416nds

Вполне себе объясняется (если конечно меня склероз не подводит ибо читал давно), правда полноценная реализация пока за пределом возможностей современной техники. Но упрощённую уже создать можно хоть и потребуется для работы с вменяемой скоростью приличный датацентр.

ZuOverture

Вопрос реализации не стоит, потому как объяснения там всё-таки нет. Читал недавно, сейчас даже специально порылся ради цитаты:

Разумеется, ответ «не очень». Кружок просто ловко превратился в сову.Pavel_Zak

«Лучшее, что есть — тест Тьюринга»… Мда.

Тест Т., — это игра в имитацию, к сожалению.

А в том, что определения нет (пока нет) — согласен.

Но как насчет вот такого:

Интеллект Объекта — это набор способностей Объекта, которые используются:

(1) При идентификации, формализации и запоминании законов состояния и/или поведения:

(1.1) Окружающей среды Объекта, и

(1.2) Внутренней среды Объекта

на основе законов эволюции.

(2) При опережающем моделировании состояний и/или вариантов реального поведения Объекта:

(2.1) По отношению к Окружающей среде, и

(2.2) По отношению ко Внутренней среде

на основе законов эволюции.

(3) При создании описания состояния и/или реального поведения Объекта, адаптированного:

(3.1) По отношению к Окружающей среде, и

(3.2) По отношению ко Внутренней среде

при условии максимизации отношения «(Реальное поведение Объекта)/(Затраты на реальное поведение Объекта)» с целью сохранения (существования, дления, бытия, жизни) Объекта по отношению к Окружающей и Внутренней средам Объекта.

AlexeyR Автор

«Но как насчет вот такого?». Сама статья ответ на ваш вопрос.

Tzimie

А если все отдать на самотек? Вот писали алгоритмы, они работали так себе, а в итоге оказалось что надо сетки тренировать.

Что если эмулировать некий мир с законами выживания, и надолго "запустить" туда нейросетки?

demon416nds

1 нейросети начисто сливают алгоритмам по "КПД" — на одинаковый результат алгоритм тратит меньше ресурсов чем нейросеть.

Проблема в том что для некоторых задач алгоритмов банально не придумали, тут то и вылезли нейросети которые можно обучить.

2 современные нейросети на многие порядки примитивнее даже куриного мозга, а большинство примитивнее нервной системы какого нибудь червяка. И это не потому что достаточно или нет желания, а потому что нет достаточно производительных компьютеров. На осуществление вашего же предложения скорее всего не хватит производительности всех компьютеров в мире вместе взятых.

AlexeyR Автор

Наоборот, контекстная модель во многом получается менее прожорливой чем нейросети.

Tzimie

И тем не менее, оно заманчивое, правда?

Что касается мощности, то когда то биткоин безумие кончится, и будет море дешёвых видеокарт

Alex_ME

Оффтоп: есть работы по аппроксимации физической симуляции нейронными сетями с целью увеличения производительности.

Sabbone

Сложно сказать что это действительно так. На самом деле современные нейросети делают много вещей которые червяки не умеют, например распознавание места на земле по фотографии, или замена лица на видео, и еще много чего. С другой стороны, нейросеть не умеет как червяк ползать под земелей или нести яйца как курица. Летать как курица и в чем то лучше ( на дронах ) он уже умеет, и на компютерных моделях учится ходить, так что в итоге часто похоже на походку реальных животных или человека. По идее при достаточном количестве нейронов можно управлять биологическим телом с кучей нервов. Главное найти способ совместить кремнивые мозги и нервы

Sabbone

Сделай нас единым!

eternal_why

Мммм… А управлять синтезом белков и прочей выполняющейся в ядре живой клетки несущественной ерундой нейросеть может, для начала?.. Митоз там всякый… :)

Sabbone

да есть принтеры синтетических днк, которые сначала моделируются на компьютере, а потом печатаются на принтере, тот же проект организма с минимальным геномом.

Но опять же нейросети надо учить понимать как работает днк, и она уже находит новые закономерности, и новые варианты белков по заданным параметрам.

Все упирается в обучение

Sabbone

Например если люди не будут знать о радиации, то и нейросеть тоже не будет знать пока не станет настолько умной чтобы найти радиацию самой.

michael108

Шутка понимается в результате нескольких шагов:

1. Картинка обмена чего-то (бензопилы) на что-то.

2. Предполагаемая ситуация — что-то является объектом с примерно равноценным бензопиле функционалом (например, надувная лодка или молоток — т.е. то, что может использоваться в работе/быту/на отдыхе). В любом случае предполагается, что предмет обмена обладает примерно такой же универсальностью, как и бензопила.

3. Нестыковка: протез — не тот объект, который является в достаточной мере универсальным. Включается анализ.

4. Возникает новая картинка: Человек без ноги протягивает бензопилу и хочет получить взамен протез.

5. Возникает осознание причины данной ситуации — человек отпилил себе ногу и теперь меняет уже ненужный ему объект на объект, ранее совершенно не нужный, но теперь ставший нужным.

6. Противоречие между ожидаемой ситуацией (обмен на равноценно «полезный в быту» объект) и фактической (обмен «уже ненужного» объекта на «ставший нужным» протез) вызывает улыбку.

Обычно описанные выше процессы протекают в течение долей секунды, поэтому нетренированный человек их не осознает.

Собственно, юмор очень часто строится на таком противоречии между ожидаемой ситуацией и фактической, например:

— Продам проигрыватеь.

— Срочно куплю выигрыватель!

AlexeyR Автор

Я именно об этом. Вы рассудили вполне логично. И правильно подметили, что юмор часто содержит противоречие. Из этого вы сделали вывод, что противоречие и есть причина смешного. Но это не так. Просто противоречие не смешит. Природа юмора глубже. Когда-то я написал об этом книгу www.aboutbrain.ru/%d1%81%d0%ba%d0%b0%d1%87%d0%b0%d1%82%d1%8c. Там есть разгадка.

michael108

Не противоречие как таковое, а несовпадение ожидаемого с наблюдаемым. Например, если в темной комнате вдруг раздался какой-то пугающий звук, как будто от большого животного, а потом оказалось, что это был маленький котенок.

Разумеется, подобные нестыковки — лишь один из методов создания юмористического эффекта. По-моему, существуют достаточно подробные перечисления этих методов. Но читать их скучно )))

Я же лишь хотел указать на то, что нетренированный человек, не осознающий процессы в своем сознании, зачастую неспособен отследить всю цепочку событий, приведших его к тому или иному состоянию.

AlexeyR Автор

«один из методов создания юмористического эффекта». Дело в том, что нельзя подменять суть внешним проявлением. Попытка создать юмор по «методу» никогда не дает результата.

Politura

Смешно это не когда нестыковки, а когда кому-нибудь другому плохо, или этот кто-то другой попадает в нелепую ситуацию.

Большой звук от маленького котенка не смешно, а если кто-то повел себя глупо в связи с этим звуком, то будет смешно.

Причем, привести к тому, что кому-то плохо должны были действия самого персонажа, если кому-то просто плохо, а он в этом не виноват, то вместо смеха будет сопереживание.

Sabbone

Ну просто испуг даже внутренний, от тени котенка, переживаешь потом как глупость с облегчением, отсюда и смех. Кстати смех от протеза и бензопилы именно в том, что обдумывая объявление ты понимаешь что была страшная угроза, она воплотилась но больше ее не стоит бояться( пилу меняют )

, становится понятно причем тут протез, и самое главное вся эта история просто так, она не является информацией об угрозе, и ее не сложно обработать.

Ты чувствуешь угрозу и она сразу проходит. Не обязательно юмор именно такой, он многогранен. Есть тот который понимаю люди кошки и собаки. Шимпанзе слоны и дельфины. И тот который понимают только люди или только дельфины например

Politura

Ну, умение посмеяться над собой не всем дано, как-бы там ни было, в вашем примере как-раз и есть объект которому было плохо во время испуга.

Вы сможете привести пример юмора, чтоб было смешно и никому не было плохо?

Плохо в общем смысле, не обязательно увечья: кто-то попал в нелепую ситуацию, повел себя глупо и т.д.

ZuOverture

Девочка в поле нашла пулемёт

И по деревне открыла пальбу.

Что же девчонку никто не уймёт?

В ужасе прячутся люди в избу.

Пули везде настигают несчастных,

Без перерыва строчит пулемёт.

Люди погибли в муках ужасных,

Больше в деревне никто не живёт.

Не очень смешно, всё разжёвано. А если так:

Девочка в поле нашла пулемёт,

Больше в деревне никто не живёт.

AlexeyR Автор

Вы на правильном пути, но все еще интереснее. У меня в книге (ссылка выше) есть подробный разбор и смешного, и юмора. Главное было не просто понять, когда смешно, а докопаться до причин почему в эти моменты смешно. Собственно, об этом и книга.

Politura

Спасибо, почитал раздел про юмор, интересно, довольно подробно расписано. Пока читал где-то на заднем фоне висело непонимание, почему-же смех считается чем-то хорошим, в отличии от злорадства, когда дошел до описания про нарушение норм пришла такая мысль: смех как реакция на неожиданное наказание нарушителя. В таком ракурсе в нем нет того негатива, как если рассматривать его с точки зрения принижения чьего-либо статуса.

saboteur_kiev

Юмор строится не столько на противоречии, сколько на противоречивом тождестве.

Суть в том, что тождество можно заметить на высоком уровне абстракции, когда какие-то два понятия, каждое из которых имеет пласт ассоциаций, внезапно оказываются схожими под углом, который ты раньше не замечал. Связывание этих двух понятий (и всех их ассоциаций) и вызывает реакцию смеха.

При этом, если шутку повторять, в мозгу возникнут устойчивые ассоциативные соединения, через некоторое количество повторов, она перестанет вызывать смех, будет вызывать «утомление», поскольку триггерится большое ассоациативных связей, активируя множество аксонов…

Обратная реакция — горе. У тебя есть куча ассоциаций с каким-то понятием. И тут это понятия пропадает, становится бессмысленным, ненужным. Разорвать все ассоциации и привычки мозг просто так не может, а появление чувства утраты и ненужности этого вызывает практически физическую боль. Память у нас чистится в основном за счет того, что ты ее не используешь, а на это нужно не только время, но и собственно не активировать эти ассоциации, чтобы они «атрофировались».

Собственно поэтому мы смеемся над новыми шутками недолго, а плачем над старыми горестями гораздо дольше.

AlexeyR Автор

Вы плохо представляете природу эмоций. Они часть механизма обучения с подкреплением. Их роль — оценка текущего качества ситуации. Но эта оценка строится, исходя из прогноза будущего. Смешное и юмор хорошо объяснимы, но если вы хотите их понять, то не обойтись без понимания механизма появления эмоций.

zim32

Проблемы не могут быть решены на том же уровне мышления, который создал их.

Альберт Эйнштейн

mad_god

Смысл слова в модели.

Я вижу вазу, когда есть модель "я", модель "видеть", модель "вазы". Фотоны, отражаясь от вазы формируют в голове "Зазеркалье", такой же мир, как и снаружи, только упрощённый, свёрнутый, но с особенностями, например, возможностью пройтись вбок по ассоциациям, в глубь по подробностям моделей, рассмотреть прошлое модели, возможные будущие, скомбинировать несколько моделей.

Без физического мира и наблюдения за ним, сложно получить такие модели.

Например, программа "видит" объект в своём внутреннем информационном поле. Это не отражённый объект, программа вызвала его для каких-то промежуточных целей, найти, на что похож наблюдаемый объект или тот, который станет возможно наблюдаем в будущий момент.

Целая ваза и разбитая ваза как-то связаны. Но мы не можем наперёд знать форму, количество и расположение осколков, поэтому наша модель схематична, неточна.

Но когда мозг видит прыгающий футбольный мяч, я верю, что внутри мозга мяч тоже прыгает, синхронно с настоящим, мы ожидаем удара, отскока, ожидаем промах или попадание, достраиваем траекторию во время матча, по положению ног игроков.

mad_god

Поразительная невидимость.

На вход нейронной сети нужно что-то подавать.

Но вот мы закрыли глаза, заткнули уши, отрезали себя насколько возможно от сенсорной информации и мы всё равно производим работу мозгом.

Да и даже наблюдая мир, мы можем отрешиться от него и полностью погрузиться в то, что видим только мы, внутри себя.

То есть, кроме тех моделей, которые мы наблюдаем, существуют и те модели, которые мы создаём и которыми пользуемся.

Динамические модели. Мы видим внутренние модели, которые представляют собой не трёхмерные объекты, а четырехмерные, объекты с историей жизни, в динамике, мы можем «промотать» яблоко от семечка, до съеденого или сгнившего, до дерева, в которое прорастёт семечко или какой-то мебели, в которое превратиться это дерево.

Динамическая модель перечисляет свои кадры так, как нам удобно, чтобы мы могли вовремя предсказать, что произойдёт в нашей комнате (или что нас интересует в данный момент), до того, как это произойдёт и произведёт какой-нибудь разрушительный эффект.

Нас чаще всего интересует опасность, те явления в мире, которые могут нам навредит. Если мы видим что-то похожее на кошку или на утку, обычно, это не имитация кошки, это именно кошка. Именно поэтому мы часто ошибаемся, когда видим в темноте монстров, созданных одеждой на стуле или тень, брошенная деревом на стену. Поэтому мы находим лица и животных в различных узорах. Нас интересуют хищники, нам нужно найти их как можно быстрее. Если что-то быстро движется, нам нужно испугаться, потому что если мы ошибёмся, это может стоить нам жизни.

Динамические модели действуют постоянно, пока мы мыслим. Если я вижу кошку, я должен понимать, что такое кошка, у меня должна быть модель кошки внутри меня.

Могут ли кошки летать? Ну, если пнуть…

Могут ли кошки быть большими? Некоторые могут быть довольно большими.

Могут ли кошки быть на полу?

Может ли кошка быть в квартире, в которую до этого принесли кошку?

Могу ли я, увидев кошку и закрыв глаза, быть уверен, что кошка всё ещё в комнате или рядом? Если кто-то мяукнет за спиной, может ли это быть кошкой?

Конечно, после того, как люди начали создавать различные вещи, становится труднее отличать кошку, от тех многих вещей, которые созданы быть какими-то признаками быть похожими на кошку: изображение кошки, видеозапись кошки, звукозапись кошки, игрушка в виде кошки, кошачьи ушки на голову, кошачий костюм и т.д.

Мир был опасен для человека. Как отличить, можно ли ступать на ту или иную поверхность? Может, там яма, острые колья, хищник.

Человек нашёл решение. Человек стал сооружать для себя более предсказуемый мир.

Если ты не уверен в окружающем мире, создай себе простой, надёжный мир, с твёрдыми стенами, полом и потолком, в котором пол не провалится просто так, стены не упадут, ничего не упадёт на голову. Построй себе дороги, выгони хищников, выруби леса, отведи воду, контролируй её уровень.

Маленький ребёнок изучает окружающий мир. В основном, в этом мире почти нет опасностей. Горит огонь, нужно узнать, что такое огонь, больше я туда не буду лезть. Нужно узнать, что такое электрический ток, больше в розетку пальцы не суём. Нужно узнать, что такое вода. Больше я под водой не могу пробыть, нужно всплывать. Нож, оказывается острый, больше я не хочу резать пальцы. Ножка стола, оказывается, сильно твёрдая и не сдвигается ударом ноги. А что такое прищемить пальцы закрывающейся дверью? Подобные вещи мы не стараемся повторить.

Боль, участие в мире, изучение его свойств на практике — дают достаточно полное представление о мире.

После нескольких повторений негативных опытов, мы сразу же вспоминаем боль и контекст, в котором боль появилась. Проигрывается динамическая запись, как я подхожу к двери, сую туда пальцы и дверь закрывается. Мы практически видим это воспоминание. Мы видим дверь, видим себя, видим пальцы, видим процесс закрытия и даже чувствуем подобие боли в итоге.

AlexeyR Автор

Я не очень понял, как ваши рассуждения связаны со статьей.

mad_god

Но я лишь продолжаю ваши рассуждения, я с вами на одной волне и вы этого не видите?

Я-то ваши рассуждения понял, почему вы не поняли мои?

uhf

Жаркие споры разгораются на тему того, что называть искусственным интеллектом, и как определить, что он достаточно сильный.

Как будто его потенциальные создатели боятся, что переусердствуют в своих трудах, и сделают лишнего, либо создадут ИИ раньше других, но этого никто не заметит.

vasiaplaton

Нет, тест Тьюринга, по правде, ужасен. Он позволяет найти Китайскую комнату, а не сознание

AlexeyR Автор

Не стоит добавлять разговор о сознании. Это другая сущность. Китайская же комната — это некая нелепость. Серл сказал, что можно записать все варианты ответов в книгу и все поверили. Этого сделать нельзя, очень быстро число записей превысит число атомов во вселенной, а требуемое количество будет не достигнуто даже на видимые доли процента.

michael_v89

Да нет, вполне можно представить такие же инструкции обработки данных, как в вашей программе например. Правильный ответ на китайскую комнату — это то, что понимание возникает на уровне системы, а не на уровне человека. Если при активации информационных элементов системы, хранящих понятия, будут активироваться соответствующие нейроны человека, тогда и он будет понимать китайский язык.

AlexeyR Автор

Нет, не будет. У нас во вселенной нет столько нейронов.

michael_v89

Как это нет? Людей, которые знают китайский язык со всеми нужными понятиями, больше миллиарда.

При чем тут вообще количество? В описании Китайской комнаты ничего не говорится про задание всех возможных сочетаний иероглифов. Там говорится про некие инструкции для манипуляции иероглифами. Это то же самое, что и машинные команды в программе, которая представляет собой сильный ИИ. Вы же не сомневаетесь, что такую программу можно написать? Вот если человек будет выполнять машинные команды вместо процессора и вычислять значения на бумажке, это и будет Китайская комната.

AlexeyR Автор

Вся статья именно о том, что «нормальную» программу, которая, по сути, пройдет тест Тьюринга, а в этом и есть суть разговора с китайской комнатой, нельзя написать через перечисление инструкций.

michael_v89

Ну как это нельзя, любая программа это перечисление машинных инструкций.

Вы почему-то считаете, что там инструкции вида "Если пришел иероглиф X, надо вернуть иероглиф Y" для всех возможных сочетаний конкретных иероглифов. Ничего такого в описании эксперимента нет.

AlexeyR Автор

Ничего, кроме комбинаторного взрыва, если захотите перебрать все ответы.

michael_v89

Про перебор ответов там тоже ничего нет. Китайская комната она про то, можно ли назвать ее понимание настоящим пониманием, а не про то, можно или нельзя сделать искусственный интеллект. Это именно некомпьютерная имитация ИИ, существующий и работающий ИИ тут изначальное условие.

Вот описание из Википедии.

Suppose that artificial intelligence research has succeeded in constructing a computer that behaves as if it understands Chinese

The question Searle wants to answer is this: does the machine literally "understand" Chinese?

Searle then supposes that he is in a closed room and has a book with an English version of the computer program, along with sufficient papers, pencils, erasers, and filing cabinets.

AlexeyR Автор

Серл допустил логическую ошибку. Он сказал, что можно задать набором правил адекватное общение. Из этого он сделал вывод, что, если можно, то значит компьютер может быть адекватным и при этом не понимать смысла. Ошибка Серла в самом первом допущении. Нельзя адекватное общение задать перечислением правил. И вина тому комбинаторный взрыв. Серл, как философ полагал, что много — это не бесконечность, а значит можно сделать. Но тут появляется такое много, которое превышает возможности вселенной и с этим много приходится считаться. Если же делать упрощение в наборе правил, то общение перестанет быть адекватным и не пройдет тест Тьюринга.

buriy

Алексей, кажется, вас спрашивают другое:

А если обобщить утверждение Сёрла с «перечисления правил», как в 192х-195х понимали компьютерный интеллект (через онтологии), до просто «современной компьютерной программы, с памятью и графическими ускорителями», тогда всё равно будет комбинаторный взрыв и те же проблемы?

michael_v89

Вы считаете, что написать ИИ на компьютере невозможно? Компьютерная программа это ведь и есть перечисление правил. Серл говорил именно о понимании компьютерной программы.

Halt

Возможно, и мы этим занимаемся. Но есть фундаментальная разница между набором семантических правил и пространством контекстов с контекстными преобразованиями. В случае контекстной модели способность к выделению смысла является продуктом опыта системы и не раскладывается на тривиальные утверждения «если-то».

qw1

Нет фундаментальной разницы. Программа так или иначе будет исполняться на конечном автомате, а он работает по набору правил «если текущее состояние X и вход A, то перейди в состояние Y». Ничего другого быть не может.

Halt

Вопрос в том, где провести границу абстракции. Так то можно заявить, что и комьютер и биологический мозг состоят из атомов и молекул, а стало быть, возможно привести первое ко второму.

Разница в том, с какими сущностями оперирует этот конечный автомат. В нашем случае битовые манипуляции это еще не смысл.

qw1

Я вас понял. Утверждение «невозможно построить ИИ по набору правил» равносильно «невозможно построить стол из атомов». Последнее формально неверное, поэтому и вызывает возражения: из чего же, как не из атомов, построен стол. Вас надо понимать так, что строить стол из атомов — плохая идея, потому что не тот уровень абстракции…

Halt

Попробую пояснить. С нашей точки зрения, ИИ невозможно построить на базе системы формальных правил. То есть так, как пытаются работать экспертные системы или любые другие, исходящие из соображения, что явление однозначно определяется набором признаков.

Мы утверждаем, что одного этого недостаточно. Да, разумеется, системы, опирающиеся на признаки работают. И, к сожалению, работают слишком хорошо. Но всегда существует возможность дать такой пример, когда все формальные признаки явления присутствуют, но самого явления нет. И наоборот, когда ни одного признака нет, но явление однозначно присутствует. Причем для человека не вызывает трудности разрешить эти ситуации «на интуитивном уровне», тогда как формальная система заходит в тупик.

Если же пытаться решить эту проблему экстенсивным путем, то есть, через уточнение модели, расширение набора признаков и т.п., то это неминуемо ведет в комбинаторный ад. Улучение на 1% требует десятикратного увеличения мощностей.

Мы пытаемся показать альтернативный подход, который не сводится к наборам формальных правил. В контекстной модели работа с исключениями ведется совсем иным образом. Формальные правила существуют только на уровне контекстных преобразований понятий. Реальным же мерилом являтся опыт модели, то есть ее событийная память. В этом случае исключениям можно научить и они не будут конфликтовать с остальным багажом знаний. Сам опыт опять же, не выражается в виде строгих правил «если-то». Существует пространство контекстов, по реакции которого на вход можно судить о возможных интерпретациях поступившей информации. Но, подобно человеку, сама эта модель «не знает» почему так. Вернее, интерпретируемость есть, но она происходит на другом уровне, нежели позволяет описать семантика. Грубо говоря, правила модели не описываются в семантичеких терминах.

Впрочем, там уже возникают задачи другого рода. Основная сложность не просто запомнить что-то и действовать в соответствии, а распознать, что новая ситуация является похожей на нечто уже известное. И вот тут без контекстов и нашего способа кодирования задача оказывается соврешенно нерешаемой. Но, боюсь, это уже на коленке не опишешь.

qw1

Не вижу принципиальной разницы. Описываемая вами система контекстов — такая же формальная система. Ввод нового контекста ничем не лучше и не хуже ввода нового правила.

У вас же будут инструкции на случай, если понятие подходит под несколько контекстов — какая-то приоретизация, или параллельная обработка вариантов. Всё то же самое можно формализовать и для правил, описать что делать при обнаружении противоречий. Формальные системы намного богаче, чем Аристотелевская логика. Возможно, вы настроены против логики, но не нужно тогда ставить крест на всех rule-based подходах.

AlexeyR Автор

Есть много отличий. Поясню только пару. В любой входной информации любое понятие изначально многозначно. Будь то слово в тексте или фича на картинке. До применения правил надо эту многозначность как-то разрешить. Плохо если выбрать одно наиболее вероятное значение, можно потерять истинное толкование. Нельзя перебрать комбинации всех вариантов, так уже в предложении из 10 слов начинается космос. Для контекстов многозначность естественна и проблем не возникает.

Часто во входной информации что-то пропущено. Слово недосказано, линия не дорисована. Система на основе правил требует увеличения числа правил, чтобы покрыть такие случаи. В контекстном подходе недостающие сущности «всплывают» сами.

И это малая толика.

qw1

Тут сложно что-то прокомментировать, потому что используется неопределённое понятие «контекст».

Как записывается «контекст»? Вероятно, текстом, то бишь предикатами, перечисляющими факты (смеркалось, жаркий день бледнел неуловимо, над озером туман тянулся полосой). И как тут понять, что дорисованная линия и недорисованная — это один и тот же контекст, если у них разная запись.В википедии есть два определения контекста — вербальный и ситуативный. Вероятно, у вас контекст ситуативный. То есть,

AlexeyR Автор

Ближе всего к нашему — это определение из анализа формальных понятий.

qw1

Ещё немного, и придём к гонимому Определению (Явление имеет место, когда оно попадает в Контекст, т.е. для множеств G,M,I выполняются соотношения ...)

AlexeyR Автор

СИИ можно создать на алгоритмическом компьютере. Но алгоритм контекста, соответствующего понятию, будет отличен от алгоритма определения понятия через его признаки. И один алгоритм несводим к другому.

qw1

AlexeyR Автор

Так о цене и разговор. Когда сложность растет экспоненциально от числа параметров, не способные с этим бороться, алгоритмы становятся нереализуемыми, так как требуемое время начинает превышать время жизни вселенной.

qw1

Если вы хотите, чтобы выпускники ВУЗов вас читали без фейспалмов, осторожнее с терминами. Потому что математики понимают несводимость как принципиальную несводимость, время жизни вселенной всего лишь конечное число, хоть и большое.

AlexeyR Автор

Все было корректно. Алгоритм «смысла» дает один результат, алгоритм определения «другой». Алгоритм «определения» не может воспроизвести точный результат «смысла». Не путайте это с тем, что оба они могут запускаться на машине Тьюринга. Так можно договориться о том, что все алгоритмы одинаковы.

qw1

Мне кажется, все исследователи ходят вокруг одной проблемы. Если вы полагаете, что ваш метод асимптотически быстрее, аналогию можно провести с сортировкой пузырьком и быстрой сортировкой.

michael_v89

Так в китайской комнате не говорится про "если-то". Там говорится просто о неком наборе инструкций для человека по манипуляции данными в шкафах, так же как компьютерная программа это набор инструкций для процессора по манипуляции данными в оперативной памяти. Это полная аналогия, описанная самим Серлом.

a1111exe

Компьютерная программа это набор инструкций. В мысленном эксперименте "врукопашную" выполняются инструкции программы по общению на китайском (ввод на китайском и вывод на китайском) человеком, который не знает китайского. Этим демонстрируется, что для настоящего понимания (а не сколь угодно правдоподобной его имитации) недостаточно компьютерной программы, сколь бы изощрённой она ни была. По сути, китайская комната это современная разновидность мельницы Лейбница.

Сам мысленный эксперимент не содержит ошибки т.к. форма "если допустим, что Х, то получим У" не является утверждением, что Х. В данном случае "Х" утверждают те, кто уверен в том, что с какого-то момента времени машины смогут обеспечить неотличимое от человеческого общение. И если Вы уверены в возможности создания "сильного ИИ", то тоже, по идее, должны это утверждать.

eternal_why

Вы меня простите. В интернете опять кто-то неправ, и я вынужден ещё раз помахать своим дилетантизмом. Я ничего не знаю про интеллект, нейросети и китайский язык, но:

1. Википедия, к примеру, говорит, что «Интелле?кт — качество психики, состоящее из способности осознавать...». Лично мне кажется, что «качество» есть свойство чего-то другого. Такое же свойство, как, скажем, температура, скорость… Невозможно набрать ведёрко качества, горстку температуры или упаковку скорости. Также мне кажется, что создать температуру или скорость в отрыве от объекта тоже невозможно, но почему-то создавать качество психики (которое, вообще-то, само по себе есть свойство чего-то, если что :)) считается возможным, и, более того, выполнимым. Да, можно создать математические функции, оперирующие абстрактными свойствами, но какое это отношение будет иметь к реальному миру? В математике, как показывает практика, вообще возможно всё, что угодно, даже корень квадратный из отрицательного числа и бесконечность делить на ноль, наверное, тоже можно. Но ведь мы же вроде тут за «смысл» бьёмся? Какой же смысл в интеллекте без сознания?.. Качество свойства сущности в отрыве от самой сущности?..

2. Потом Вы хотите, чтобы мы все поверили, что число атомов во вселенной меньше числа вариантов китайских иероглифов. Первая ссылка из поисковика дала мне 85 568 иероглифов в каком-то словаре. 85568 ^ 85568 мой комп посчитал секунд за 5 или 7, получилось очень длинное число, но оно в любом случае конечно. А вселенная, как нам говорят — бесконечна, и число звёзд в ней, говорят, — бесконечно (я, конечно, не проверял), и в каждой очень много атомов, и очень много между ними, так что я, пожалуй, не поверю: моя диванная логика говорит, что конечное число меньше бесконечного по определению. Математическому определению.

3. Ну и тест Тьюринга, прикопались все к нему, прям молятся все на него. Когда комп скажет: «Пошли вы нафик со своими вопросами, мне ребёнка кормить надо», или «Завтра экзамен, а в интернете опять кто-то неправ» — вот тогда и поговорим, наверно, об интеллекте, как мне кажется. А пока — ну функция от функции, ну и чо?.. Когда комп начнёт себе задачи ставить — вот попомните тогда Скайнет добрым словом :))

И да, всё вышеизложенное есть Моё Личное МегаДиванное УльтраДилетантистическое Мнение в отрыве от действительной академии наук. Пятница сегодня, всем добра. :)

leventov

В википедии висит достаточно "романтическое" определение интеллекта из психологии. В области разработчиков ИИ оперируют определением intelligence которое привел michael_v89 ниже.

eternal_why

Да кто б спорил-то. Я не могу отделаться от мысли, что ИИшники не на тот слой абстракций нацелились. К примеру, давайте попросим информационную систему построить модель персонального компьютера (как части окружающей среды) на основе входящей информации. Про комп нам известно, грубо говоря, всё. Какую информацию будем кормить системе?

— Точный атомарный состав компонентов?

— Типономиналы компонентов?

— Принципиальную схему?

— Логическую схему узлов?

— Эпюры и диаграммы напряжений на шинах?

— Низкоуровневые инструкции, исполняемые процессором?

— Байт-код какой-нибудь?

— Инструкции высокоуровнего языка?

— Набор установленных программ (включая ОС)?

— Возложенные на этот экземпляр задачи?

Для нас, людей, всё вышеперечисленное может иметь смысл в одних случаях, и не иметь в других; сам анализ задачи, на каком уровне абстракций мы рассматриваем этот комп — имеет для нас, людей, смысл: покупаем ли мы новый, поднимаем упавшую ОСь, чиним материнку или сдаём в металлолом. Более того, в большинстве случаев все перечисленные действия для нас, людей, есть способ достижения целей, отличных от этого экземпляра вычислительной техники: чаще всего заработок, бывает помощь или даже гламурные дела, профессиональный рост или убить время.

Что из этого будет смыслом для ИИ? Ничего, просто тупое следование алгоритму. Пусть даже сложному алгоритму, с миллиардом параметров — человеку не осилить, а машине пофигу, что будет на выходе — она в любом случае не будет отличаться от арифмометра. Дррррынц/дзынь — результат. Зачем? Низачем, просто потому, что меня этого и создали.

shabanovd

85568^62 = 6.357782e+305, а 85568^63 мой компьютер уже отказался считать )

отсюдаeternal_why

Автор говорит «во вселенной», а не «в наблюдаемой вселенной», если за точность формулировок — логически, это всё-таки разные вещи. Но ну да бог с ним, опаснее не это, а то, что автор количество комбинаций штук сравнивает с количеством штук. Для чего? Чтобы помахать красивыми цифрами? Сравнивать литры с часами, оно так себе, знаете ли…

Сравнивать — так уж подобное с подобным. Комбинации с комбинациями, штуки со штуками:

10^80 >> 85568;

(10^80) ^ (10^80) >> 85568^85568;

Как если по мне…

AlexeyR Автор

Если вы хотите запомнить варианты чего-либо, вам понадобится столько физических ячеек памяти сколько есть вариантов.

eternal_why

Т.е., для того, чтобы перебрать 256 вариантов целого числа (от 0 до 255), потребуется 256 байт?

AlexeyR Автор

Чтобы сохранить эти 256 значений понадобится 256 байт.

eternal_why

Пичалько. У Вас при таком раскладе ресурсов не хватит даже на простейший ряд натуральных чисел, который сверху ограничен бесконечностью.

Что-то я сомневаюсь, что кто-то занимается такой ерундой, как хранить все значения всех мыслимых функций. Ок, сливаюсь, Вам успехов.

qw1

По вашему, никакая китайская комната не справится с сортировкой массива в 1000 байт, потому что число возможных входов 1000^256 превышает любые мыслимые возможности, чтобы их все «сохранить»?

Alex_ME

Чем тот же GPT-3 не китайская комната?

ni-co

Не хотелось бы повторяться, но большинство людей ближе к китайской комнате, чем gpt-3

AlexeyR Автор

Во вселенной приблизительно 10 в 90 степени частиц, имеющих массу. В русском языке порядка трех миллионов словоформ. Предложение из шестнадцати слов может иметь порядка 10 в 103 степени вариантов.

Carburn

А с чего ты взял, что мозг это не китайская комната?

vasiaplaton

Не знаю как вы, но когда мне говорят туман — я не 5 букв в голове представляю, у меня в голове возникает образ тумана. Несомненно все мы понимаем слова по-разному(привет Вавилонская башня), но понимаем. К тому же, когда человек думает, он оперирует не словами, а образами, как и остальные животные.

Carburn

Все мысленные эксперименты это чушь в любом случае, так как это демагогия и софизм.

Хранить изображение тумана вместе со словом, проблемы нет.

michael_v89

Интеллект — это способность информационной системы строить модель окружающей среды на основе входящей информации. Чем подробнее модель она может построить, тем больше у нее интеллекта. Модель состоит из информационных объектов, объект это то, что определяется как "одно и то же" в разные моменты времени. Вот эта способность определять "одно и то же", это самое важное.

AlexeyR Автор

Интеллект можно определить и так. Но в таком определении ИИ и СИИ одно и то же и вопрос только в «мощности». Я объясняю, что есть еще и смысл.

michael_v89

Нет. Вы пишете "Простой ИИ строится на использовании сущностей, заданных определениями. Отсюда классы, кластеры, тезаурусы". Классы и кластеры — это модель, заложенная программистом. Сильный ИИ должен строить эту модель сам по входящей информации.

Собака не сможет пройти тест Тьюринга, но у нее вполне себе сильный И. А некоторые боты проходят некоторые вариации теста Тьюринга, но смысла они не понимают. Смысл это собственно и есть активация некоторого элемента модели. Ну или вернее сказать, они понимают только в рамках того смысла, который в них заложен извне разработчиком.

AlexeyR Автор