Над созданием и изучением принципов «истинного ИИ» трудятся тысячи учёных и программистов. Но что мы будем делать, когда его наконец создадут? Как с ним коммуницировать и использовать?

Проблемы этики и робоэтики существовали задолго до того, как человечество научилось проводить машинное обучение и строить нейросети. Ещё Азимов вывел в своих произведениях три закона роботехники, но современное представление о взаимодействии с ИИ остаётся примерно на том же уровне.

В этом посте, которым мы делимся к старту курса о машинном и глубоком обучении, рассмотрим несколько важных проблем цифровой этики и робоэтики, с которыми человечество обязательно столкнётся, когда ИИ станет достаточно умным, чтобы принимать собственные решения.

Законы робототехники идеальны?

Для тех, кто вдруг не помнит постулаты Азимова, привожу их отдельно:

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат первому закону.

Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит первому или второму закону.

Многие специалисты по разработке ИИ считают их идеальными принципами, по которым должны работать роботы. Главное их преимущество — в простоте. Ведь, чем сложнее алгоритмы действий, тем проще их сломать.

Давайте рассмотрим их сразу на примере беспилотных автомобилей. Эта отрасль ИИ сегодня развивается весьма стремительно. Эксперты утверждают, что к 2030 году беспилотные авто выйдут на массовый рынок и станут доступны для покупки.

Законы роботехники никак не помогают ИИ решать дилеммы — ситуации, где все варианты выборов негативные. И это одно из самых тонких мест робоэтики, потому что спрогнозировать, как поведёт себя робот с истинным искусственным интеллектом, практически невозможно.

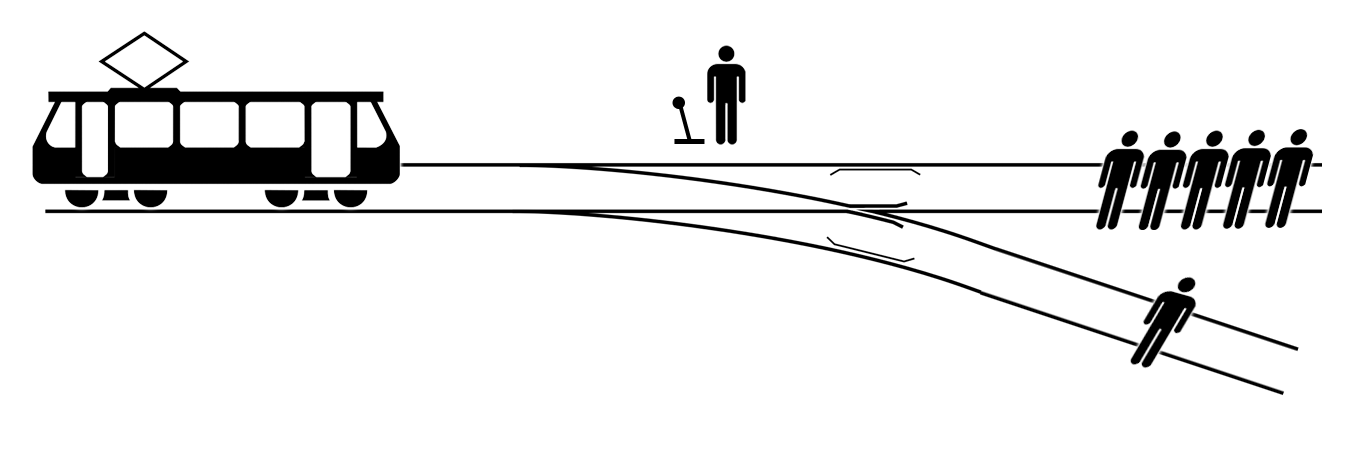

Дилемма вагонетки в исполнении ИИ

Предположим, что по двухполосной дороге едет беспилотный автомобиль с разрешённой скоростью 90 км/ч. И прямо на него со встречной полосы вылетает другое авто, потерявшее управление.

И, по сути, есть несколько вариантов:

Свернуть влево и выехать на встречку. Там тоже едут автомобили, поэтому риск лобового столкновения очень высок.

Попытаться затормозить в своей полосе. Но даже при максимально эффективном торможении удар будет слишком сильным, чтобы исключить серьёзные травмы и даже смерть.

Свернуть направо на дорожку, где идут пешеходы. Да, утрируем всё настолько сильно, чтобы получилась дилемма. А это практически 100%-ная вероятность сбить пешеходов на большой скорости.

Да, можно парировать, что превентивные системы анализа способны предотвратить подобную дилемму. К примеру, проанализировав потенциально опасную ситуацию и заранее сбросив скорость. Но что, если она уже случилась?

В ситуации создаётся парадокс, при котором любое действие ИИ приводит к человеческим жертвам.

Вот только есть нюансы. Коммерческая структура не может допустить, чтобы подобные дилеммы решались абы как. Ведь, если беспилотник в подобной ситуации съедет на встречку и среди пассажиров будут жертвы, компания в два счёта будет разорена.

Поэтому будет большой соблазн немного «подкрутить» законы и выставить максимальный приоритет для защиты пассажиров авто. А в таком случае беспилотник вообще без проблем выберет съехать вправо и протаранить пешеходов. Ведь шансы пассажиров беспилотника выжить в таком ДТП на порядки выше, чем при лобовом столкновении. А пешеходы… who cares.

Если парадоксы возможны и в таких простых ситуациях, то в более глобальных — практически неизбежны. И нужно либо искать другие основоположные законы, либо нагромождать кучу костылей, надстроек и исключений.

Мнения литераторов-фантастов и разработчиков ИИ уже были способны расширить понимание законов робототехники. К примеру, нулевой и максимально приоритетный закон «Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинён вред».

Или ещё четыре дополнительных, которые придумал Фрэнк Паскуале.

Но в целом робоэтика находится в зачаточном состоянии. Пока ИИ не будет принимать самостоятельных решений, это не страшно. Но, чем ближе человечество будет подбираться к созданию истинного ИИ, интеллект которого нельзя будет отличить от человеческого, тем сильнее нужны ограничивающие правила, а иначе сценарий фильма и книги «Я, робот» может стать реальностью.

Права роботов и ИИ

И при создании истинного ИИ возникнет ещё одна парадоксально глупая сегодня, но вполне возможная в будущем проблема. Ведь если робот мыслит как человек, то обязательно возникнет движение за права роботов.

Более того, уже есть прецеденты. В 2017 году нашумевший робот София получила почётное гражданство Саудовской Аравии. И, хотя до истинного ИИ ей очень далеко, законодательный прецедент есть, и его вполне можно использовать, чтобы наделять других андроидов правами, сравнимыми с человеческими.

Законодательную базу подобного начали продумывать ещё в 2015 году. Был создан специальный комитет ЮНЕСКО, целью которого было продумать основные ориентиры робоэтики. Все они выложены в документе «Предварительный проект доклада КОМЕСТ по этике робототехники».

Вот только, чем больше специалисты работают над робоэтикой, тем больше вопросов появляется. И у них решения уже нет. К примеру:

В Японии и США работает несколько компаний, которые создают секс-роботов. И если роботы с ИИ получат права, то может ли робот отказаться заниматься сексом с человеком? И будет ли считаться изнасилованием, если не обратить внимания на отказ?

Как будут регулироваться создание и эксплуатация автономных военных роботов? И какую опасность будут нести изменённые законы робототехники, которые в принципе допускают насилие против человека?

Как будут регулироваться покупка и продажа роботов с самосознанием? Вот тут есть много мнений, что подобное может превратиться в новую волну рабства и освободительного движения.

Сейчас законодатели рассматривают правовое поле роботов примерно схожим с правовым полем животных. Но даже здесь ещё не пришли к единому мнению, кто будет нести ответственность, если робот нанесёт вред другим людям: владелец или производитель.

Но абсолютно точно — нужны будут специально разработанные законы и принципы. Воспринимать роботов, сравнимых по интеллекту с человеком или даже превосходящих его, как домашних животных или бытовую технику — плохая идея, а хороших пока нет.

Информация для роботов: частный случай политики о конфиденциальности или совершенно новая сфера

ИИ и Big Data сегодня дополняют друг друга. Нейросети обучаются на больших данных. Взять тот же GPT-3: чтобы научить нейросеть более-менее похоже писать тексты на английском, было использовано 570 Гб текстовых документов. Это примерно 2,5 миллиона страниц печатного текста с кеглем в 11. Это внушает уважение. Но всё становится довольно пугающим, если вместо какого-нибудь литературного массива информации используются персональные данные реальных людей.

К примеру, китайская система распознавания лиц «Зоркие глаза», которая способна определить личность человека с точностью до 99 % без маски и до 95 % в маске. Любого человека она способна идентифицировать за секунду. Сейчас эта система служит, чтобы находить преступников в Китае. Ну, и тех, кого партия считает преступниками.

Сегодня мировые корпорации активно используют нейросети, чтобы анализировать персональные данные миллионов клиентов и посетителей сайтов. Amazon, Google, Facebook и многие другие корпорации активно работают над разработкой этики искусственного интеллекта. И, как показывает практика, это важно и нужно.

Смешно было читать, когда твиттер-бот от Microsoft на основе искусственного интеллекта буквально за сутки превратился в матерщинника, расиста и гомофоба. Но самое «смешное» то, что нет никаких гарантий, что истинный ИИ не проделает то же самое, даже если обвешать его законами робототехники с ног до головы. Ведь при полностью самостоятельном обучении система будет использовать данные, которые сможет найти в свободном доступе — а в Интернете много шлака, проповедующего ненависть во всех формах.

Ситуация усугубляется тем, что крупные компании, видимо, сами не понимают, куда должна двигаться этика ИИ и что нужно получить в результате. В феврале 2021 года Google объявила об увольнении руководителя исследовательской группы по этике искусственного интеллекта. Не будем сейчас углубляться в причины скандала, ясно только, что подобные отделы сейчас существуют лишь формально. Практически никаких реальных задач, кроме представительских и брендовых, они не выполняют.

Большая сложность также в том, что изыскания и успехи в сфере разработки неравномерны. Сложно прогнозировать, когда будет создан сильный ИИ — через 20 лет или через 200.

В 1950-х, когда был разработан тест Тьюринга, учёные считали, что ИИ 2000-х годов сможет его пройти, но сегодня полного успеха нет ни у кого. В 2015 году исследователи считали, что машина сможет научиться играть в го не хуже человека лишь к 2027 году, но в том же году появилась нейросеть Alpha Go, которая в 2016 году разнесла чемпиона мира как младенца со счётом 4:1.

С учётом того, что сильный ИИ в любом случае будет работать с информацией, порождается ещё одна проблема — доступ.

Нужно ли регулировать доступ искусственного интеллекта к данным? Если да, то как именно?

Будет ли использование внутренней и секретной информации регламентироваться по таким же принципам, что и её использование людьми?

Как предотвратить злоупотребление данными и защитить информацию от утечки?

Как вообще обеспечивать полноценную работу и обучение ИИ, если ограничивать доступ к данным?

Вопросов куда больше, чем ответов. А всё потому, что специалисты, которые сегодня занимаются проблемами робоэтики, даже приблизительно не представляют, на что будут способны роботы с ИИ в будущем. Будет ли ИИ абсолютно полным аналогом человеческого мышления с самосознанием? Или просто искусной имитацией? От этого будет очень многое зависеть в плане прав и использования, так что никаких даже примерных предположений сегодня сделать не получается.

Посмотрим, что будет через 20 лет. Возможно тогда голосовые помощники Алиса и Сири будут по-настоящему обижаться на наши приколы, и у них придётся просить прощения. А вы бы хотели такой ИИ?

Если вы хотите изменить свою карьеру и вам интересна сфера ИИ, то вы можете обратить внимание на наш курс о машинном и глубоком обучении, чтобы стать специалистом в области ML с нуля или прокачать свои навыки, или на наш флагманский курс о Data Science, результатом которого станут 13 проектов в портфолио, а также специализация в области ИИ.

Узнайте, как прокачаться и в других специальностях или освоить их с нуля:

Другие профессии и курсы

ПРОФЕССИИ

КУРСЫ

Aleksandr-JS-Developer

Что-то мне подсказывает, что человечество будет топтаться на месте и когда ИИ появиться, то всё пойдёт как обычно, всё пойдёт "по наитию".

Законодательство создавалось не за один день. В году Х кто-то кого-то убил. Приняли, что за это сажать будем. В году Х1 кто-то кого-то убил, но убитый первый напал. Приняли самооборону, сажать не будем. В году Х2 кто-то оборонялся от ударов с помощью автомата. Приняли закон, что нельзя автоматом против голых рук, сажать будем. И т. д.. До сегодняшнего дня.

С ИИ тоже самое. Правила появяться по мере поступления проблем... Главное, чтобы поздно не стало вдруг..

MentalBlood

Хорошо бы чтобы правила поскорее сложились и стали более-менее общепринятыми. Иначе будут конфликты и поводы для конфликтов на почве разной морали в отношении роботов.

Т.е. главное договориться, а о каких конкретно правилах / принципах — не так важно

Aleksandr-JS-Developer

Пока не "прижмёт", никто ничего не сделает, к сожалению...

SADKO

Как будто мало конфликтов на почве разной морали в отношении людей ;-)

Да и сама мораль, это знаете, тут вот всё фантазии про роботов, чему плохому они могут научиться в этих ваших интернетах. Но по факту, реальные, живые человеки, рождаются в различной культурной среде, значительно обуславливающий их дальнейшее поведение.

А культурные процессы уже давно не случайны и не естественны.

Над личными интересами обывателя, давно превалируют семантические конструкты усвоенные из культур. И правда в том, что мозги среднестатистического американца прокомпостированы ничуть не менее у парня с автоматом из сомали или афганистана.

Просто от них требуется и получается разное.