Картинка же повествует о том, что любое облако — это чужой компьютер. Это к вопросу о том, что «не нужны никакие домашние сервера, давайте всё хранить в облаках».

Было

Стоял простой Windows Server. В целом, не было ничего такого, для чего нужен был бы конкретно сервер — вполне подошла бы и десктопная Windows. Но у меня была свободная лицензия сперва на 2008, потом на 2012 обломилась — так что грех было не использовать. Потом, правда, поставил 2019 потестировать — и до сих пор тестировал. Хотя вполне мог бы и обратно на 2012 откатиться, ничего не потерял бы. А новые возможности 2019 можно было бы и в виртуалке смотреть. Ну или вообще на работе, благо он есть в продакшне.

Используемые сервисы

Файлопомойка

Стандартные расшареные папки Windows, тут расписывать нечего. Для дома это стандарт, да и не только для дома.

Отказоустойчивость

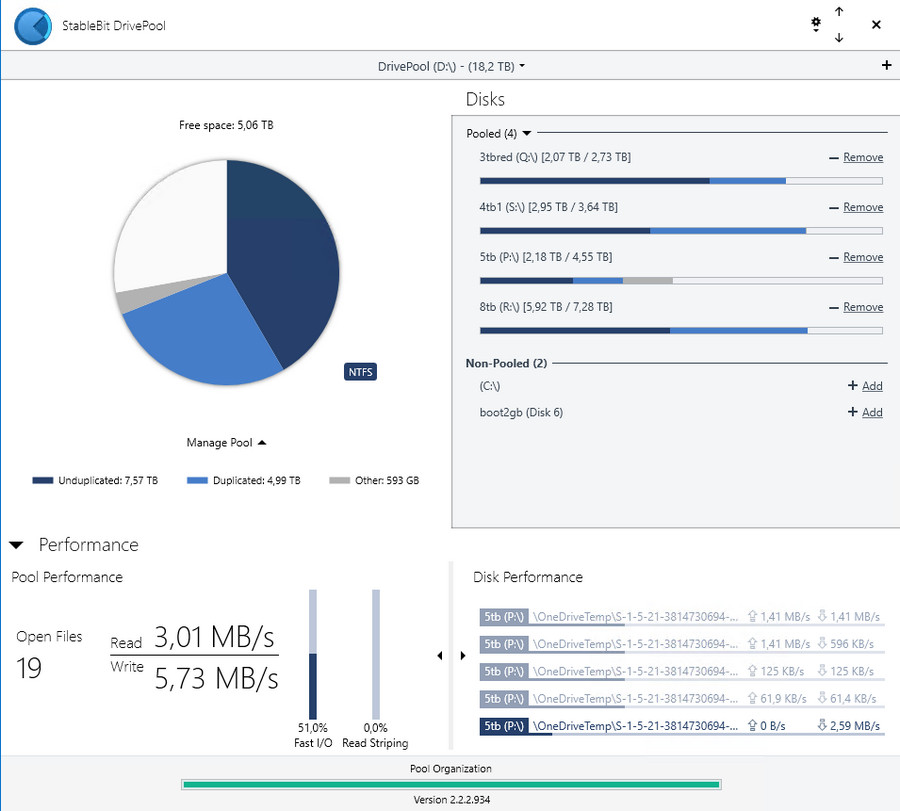

При моей нелюбви к RAID'ам и любви использовать диски разного размера, для соединения их в одно целое и обеспечения защиты файлов использовался Stablebit Drivepool. Я как его поставил на сервер восемь лет назад — так он молча и работал, без глюков и вопросов.

На десктопе иногда бывают вопросы с незакрытыми файлами от каких-то программ, которые на массиве установлены — приходится разлогиниваться или перезагружаться, чтобы они освободились. Но это два-три раза в год бывает, потому не раздражает.

Дублирование папок по разным дискам за всё время использования понадобилось только один раз — когда из системы молча вывалился восьмитерабайтник. Он потом нашелся (в контактах дело было) и даже информацию всю вытащить удалось, но всё важное, что на нём хранилось, было продублировано на других дисках и не пропало бы даже в случае смерти диска.

Ещё один раз просто посыпался один из дисков, но он это сделал не резко, потому Drivepool, заметив проблемы, начал переносить информацию со сбойного диска на другие (сообщив мне об этом):

StableBit Scanner

S.M.A.R.T. Warning on «RAINBOW» running at «home».One or more disks are suspect:

ST4000DM000-1F2168 — 2 warnings

There are currently 8 unstable sectors on the hard disk. An unstable sector is a sector that can't be read. The drive will automatically swap the bad sector for a good one whenever new data is written to it, however, the original data may be lost.

There are currently 8 uncorrectable sectors on the drive. An uncorrectable sector is counted when the drive cannot read or write to a sector. This can indicate mechanical or solid state drive trouble.

Я по пути с работы зашел в магазин, купил новый диск, дождался переноса и просто заменил начавший сыпаться.

Качалка торрентов

Vuze (Azureus). Пользовался из-за того, что он штатно поддерживал многопользовательский режим (с плагином AzSMRC). У других клиентов я простой реализации подобного не видел. Автоматику на скачивание новинок я не прикручивал — хотя бы потому, что предпочитаю сам выбирать, что смотреть, а не копаться в накачанном.

Сам клиент вполне пристойный, главное — не включать «современный» интерфейс, иначе будет задалбывать рекламой. Классический вариант интерфейса вполне функционален, тем более, что я в него заглядываю раз в неделю — удалить скачанные торренты. Обычно же просто закидываю торрент-файл в папку на скачивание, потом забираю результат из папки с завершенными закачками.

Медиасервер

Plex. Каталогизатор видео и музыки, транскодинг для слабых каналов и клиентов — я нередко смотрел/слушал что-то с домашнего сервера извне. Дома, впрочем, чаще просто из расшареных папок смотрел и слушал, так мне проще было. Транскодинг, по-моему, только для старого ipad'а включался. Ну и для вебклиентов. Учитывая железо сервера, транскодинг был программный, хотя у меня и имеется подписка.

Виртуальные машины

Когда-то Vmware Workstation (пиратка), потом, как VirtualBox возмужал и перестал рэндомно виснуть, перешел на него. Бесплатно, функционально, не особо глючно. Может и не оптимум по скорости, но меня более-менее устраивало. Даже прикручивал к нему веб-интерфейс, хотя так и не привык его использовать.

Сами виртуалки применялись либо для развлечения с ретро-софтом (это к железу нетребовательно), либо для развёртывания виндовых доменов для каких-то опытов, которые было интересно погонять дома, а не на работе. Это уже было ощутимо тяжелее и тут серверу не хватало памяти, приходилось подключать десктоп. Впрочем, была пара-тройка и постоянно работающих — к примеру, простенькое удалённое рабочее место для приятеля, который по чужим странам ездит, а свой сервер поднимать не хочет (да и негде особо) — чтобы он мог получать доступ к некоторым местным ресурсам. VPN я ему тоже предлагал, но он всё же предпочитал виртуалку. Хотя и не злоупотреблял. Но 4 гига ОЗУ из 16 на сервере оно потребляло регулярно.

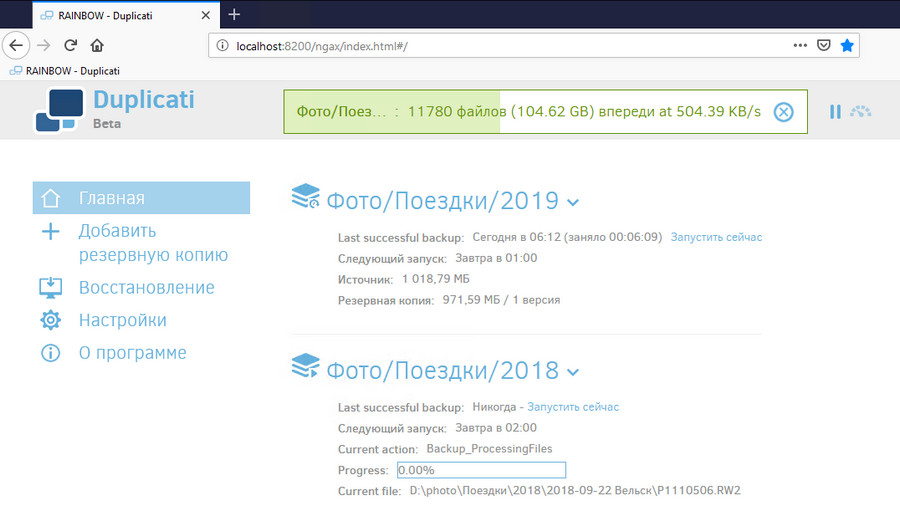

Сервер бэкапов

С локальных компьютеров по SMB бэкапы заливались на сервер в расшареную папку (с дублированием через drivepool), а оттуда при помощи duplicati запихивались в облако (onedrive) в шифрованных архивах с поддержкой версий. Для удобства я заливал в облако не всё одним большим куском, а разбивал на задания поменьше. И закачивать быстрее, и восстанавливать тоже попроще.

Onedrive использую из-за того, что у него достаточно низкая цена в сравнении с другими предложениями, устраивающие меня объёмы и нет никаких правил скачивания и закачивания файлов, которые любят накладывать специализированные сервисы для бэкапа.

Образы компьютеров делал через Veeam Backup и в облако не заливал, ибо настройки ОС — это не самое важное в жизни.

Файлы с компьютеров разным софтом синхронизировались — где-то просто скрипты с robocopy, где-то Cobian Backup (давно не обновлялся, но до сих пор нормально работает), где-то Goodsync (хорошая программа, но денег хочет, потому я только одну копию покупал, на свой десктоп). Бесплатная версия у них формально есть, но там такие зверские ограничения, что её проще демкой считать.

Удалённое рабочее место

Просто RDP. Иногда требовалось поработать на чужом компьютере, но не хотелось оставлять там следы. Да и просто своё окружение было приятно иметь. Вышеупомянутого товарища я держал в виртуалке из-за того, что на сервере ему делать было совсем нечего. Хотя технически и можно было.

Хостинг

Тут мелочи всякие, в основном какие-то тестовые сервера, которые было удобнее крутить дома, ничего постоянного. Просто пробрасывал порты в виртуалку с линуксом. Для постоянных веб-сервисов у меня есть снаружи сервера. Хотя дома и работал у меня относительно посещаемый сайт когда-то, но, по-моему, с переходом на gen7 как раз и ушел от этого, вынеся его на провайдерскую площадку.

Когда-то сервер ещё занимался рулением домашними интернетами с переключением каналов, но эту задачу я переложил на MikroTik где-то в районе покупки gen8. Всё же сервер периодически надо перезагружать, и оставаться на это время без интернета совсем не хотелось. Да и сетью проще рулить на специально предназначенном для этого устройстве. Конечно, можно было бы поднять ту же routerOS или pfsense в отдельной виртуалке, но это не спасает от пропажи интернета во время перезагрузки сервера.

Почему захотелось поменять

На самом деле, насущной необходимости менять ОС не было. Вполне можно было бы остаться и с Windows, а все задачи, которые неудобно гонять на хосте, распихать по виртуалкам. Но Windows Server как ОС для виртуалок — это очень большой оверхед, если Hyper-V не использовать. А Hyper-V я использовать не хочу из-за того, что у неё туго с пробросом устройств, что мне периодически приходится делать. Да и вообще, давно было желание поставить какой-нибудь гипервизор и разнести разные задачи по разным VM.

Плюс сейчас стало модно использовать докер. Я долго терпел, но недавно всё же принудили начать разбираться с этим делом. А докер в Windows хоть и можно, но в линуксах он всё же лучше работает.

Что рассматривал

Учитывая то, что основные задачи для домашнего сервера — это файлопомойка плюс виртуалки, хотелось основного удобства именно по ним. То есть универсальные ОС, типа Windows или Linux в качестве хоста использовать уже не хотелось.

Потому основных вариантов было два — либо ставить гипервизор и потом уже на нём поднимать файлопомойку в одной из виртуалок, либо ставить ОС для NAS, а на неё уже прикручивать нужные сервисы в контейнерах и виртуалках.

Гипервизоры

Основные — это ESXi, XenServer (XCP-ng), Proxmox VE, Hyper-V.

ESXi — точнее, vSphere Hypervisor — это довольно капризное к железу решение энтерпрайзного уровня. Для дома я считаю её перебором. На работе, впрочем, использую на одном из серверов. Но там и железо соответствующее. Когда-то пробовал на микросервере, но мне не удалось нормально прокинуть жесткие диски в виртуальную машину.

Proxmox VE мне не особо нравится в плане интерфейса. Приятно, что там внутри debian, но не особо приятно то, как он выглядит. Может и неплохая вещь, но пару раз пытался поставить — как-то не срослось.

XCP-ng (открытый форк Citrix XenServer) — это у меня, пожалуй, любимый из гипервизоров. Удобный, стабильный, не капризный к железу, под капотом обычный линукс (centos), давно пользуюсь, стоит на паре хостов и жрать не просит. Но домой не хотелось, он несколько дубовый и непоследовательный в управлении. Какие-то вещи делаются через виндового клиента, какие-то — через веб-интерфейс, а какие-то только через командную строку. В сценарии «поставил-настроил-работает» он себя показывает хорошо, но вот регулярно в нём копаться быстро устанешь.

Hyper-V Server — решение от Microsoft на базе Windows Server. Местами использую, даже кластер на нём делал несколько лет назад, но мне очень не нравится то, что практически нет возможности работать с реальным железом. Даже usb внутрь не пробросить.

Ну и мне всё же не слишком нравится идея иметь файлохранилище в виртуальной машине, я предпочитаю, чтобы данные жили максимально близко к железу, без лишних слоёв абстракции. А то сделаешь raid на уровне ядра гипервизора, потом сам гипервизор там свой storage устроит, потом для виртуальных машин создаст виртуальные же диски, которые те отформатируют в свою файловую систему… Это неплохо работает для небольших виртуалок, но когда размеры дисков идут на терабайты, дома это становится сложновато обслуживать (бэкапы и т.п.). Если же диски полностью пробрасывать в файлопомойку, то у самого гипервизора дисков не останется. Мне предлагали как-то «запустить гипервизор, все диски отдать файлопомойке, а потом подцепить их оттуда к гипервизору через iSCSI». Кто на ком стоять будет? В общем, не особо мне такое нравится.

ОС для NAS

OpenMediaVault, TrueNAS, xigmanas, xpenology…

Openmediavault (OMV) я использовал под файлопомойку на Microserver gen7 — и мне не особо нравилось, куда он идёт. Да и интерфейс там далёк от идеала. Но вообще это неплохое решение для слабых компьютеров — просто нашлёпка на линуксе, которая может работать с любой файловой системой, а не заточена под конкретные вариант. Можно жить с простой ext4, можно собрать обычный RAID, можно прикрутить ZFS. Так что вообще от OMV я не планирую отказываться, просто дома его видеть не хочу.

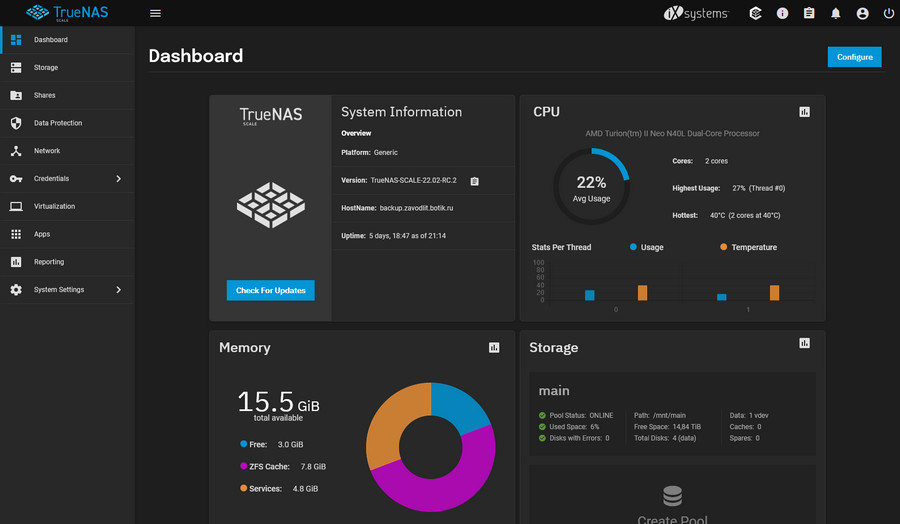

TrueNAS/XigmaNAS — хоть и разные продукты, но они похожи по устройству, так что по одному пункту пойдут. Это ZFS. Без разницы, какой там интерфейс, какое именно ядро — но обе системы построены вокруг ZFS и без неё просто не могут существовать. А ZFS, при всех своих достоинствах, далеко не бесплатна с точки зрения ресурсов, плюс никак не сочетается с требованиями к возможности использовать диски разного размера и формы. По-моему, у неё даже просто добавить диск в массив не так просто, молчу уж про то, чтобы извлечь его оттуда или заменить на другой по размеру. В общем, это решение для энтерпрайза либо тех, кто хочет к нему приобщиться. А мне бы просто пачку разношерстных дисков в одно целое собрать и немножко защиты к ним прикрутить.

Впрочем, я недавно поставил на Microserver gen7 TrueNAS Scale вместо OMV. Ему там тяжко, конечно, особенно во время копирования файлов. Но если ничем не грузить, кроме самбы, вроде как справляется.

XPEnology — это красивая закрытая ОС от NAS'ов Synology, приспособленная для запуска на обычном компьютере. Она достаточно функциональна и не особо сложна в использовании, но ограничена своей архитектурой. Кому-то нравится, но я не вижу смысла собирать свой сервер, чтобы потом делать из него простой NAS. Это как хакинтош — можно и на РС запустить, но если бы мне всерьёз захотелось макось, то я бы купил мак. Но внешне выглядит красиво, этого не отнять.

Что в итоге выбрал

Кроме всего вышеперечисленного есть неведома зверушка по имени Unraid. Про него я слышал много интересного, но как-то не доходили руки попробовать. Это коммерческое решение на базе ядра линукс, помесь дискового массива с гипервизором.

В процессе сборки нового сервера я попутно играл с Unraid. И он мне понравился, так что решил остановиться на нём.

Почему:

- Он живёт на флэшке и не тратит диски в массиве. Это не уникальная фича, но довольно удобная. На флэшке хранятся только настройки и образ системы, который при загрузке разворачивается в память и дальше работает оттуда.

- Дисковый массив позволяет использовать диски любого размера, позволяет их добавлять/удалять, при этом обладает отказоустойчивостью на один-два диска, а при развале массива на отдельные диски информация остаётся на них. Тоже не уникальное решение, на линуксе подобное можно реализовать при помощи чего-то типа mhddfs и snapraid.

- К массиву можно прикручивать ssd для ускорения записи и доступа вообще. Тоже не уникальное, но идёт из коробки.

- Достаточно удобный интерфейс для работы с виртуальными машинами и контейнерами докера, удобный проброс железа в виртуалки.

- Большое коммьюнити, которое готовит те самые контейнеры и наполняет ими местный appstore.

- Контейнерами и плагинами можно очень сильно увеличивать функциональность системы. Установленные в хостовую систему пакеты и настройки слетают после перезагрузки? Плагин, который будет их автоматом каждый раз устанавливать пакеты и дописывать конфиги. Диски вне массива нельзя использовать по назначению? Есть плагин. Нет нативной поддержки ZFS? Тоже есть плагин.

Само собой, есть и недостатки:

- Это коммерческое ПО, что снижает его привлекательность на фоне бесплатных аналогов. Полная версия стоит 129$, базовая — 59$, но позволят работать только с шестью дисками (у меня уже больше, а будет ещё). Есть промежуточная лицензия за 89$ на 12 дисков. Хотя и у полной версии, по-моему, ограничение в районе 30 дисков, так что действительно большую СХД тут собрать не так просто.

- Разработчики несколько дистанцируются от этого — по умолчанию этот appstore недоступен, надо ставить плагин, найдя на него ссылку где-то в интернетах. Только в последней бете добавили кнопку «установить community appstore» прямо в интерфейс. Но это очень заметный кусок функциональности системы и без него Unraid потеряет заметную часть своей привлекательности.

- Всё же это решение на базе линукса, а не полноценный дистрибутив линукс — потому многие возможности хостовой ОС ограничены, в том числе и в плане поддержки железа. Если что-то поддерживается линуксом, то это ещё не значит, что оно поддерживается в Unraid

- Местный интерфейс управления докером нормально работает с отдельными контейнерами, но если надо поставить сразу пачку, то возникают сложности. Впрочем, никто не мешает воткнуть тот же portainer и тяжелые случаи решать через него.

Есть и ещё, но про них подробнее расскажу в части про установку-настройку.

В общем, это не универсальное и не уникальное по функциональности решение, со своими достоинствами и недостатками.

При желании аналог можно собрать самостоятельно. Про массив я уже писал (mhddfs/mergefs/aufs/...+snapraid), для руления докером можно поставить тот же portainer, docker hub сойдёт за appstore для контейнеров, для виртуалок можно proxmox ve поставить на обычный дебиан, сам дебиан можно поставить на флэшку и настроить так, чтобы при работе запись на неё была минимальная. И я попробую как-нибудь подобное сделать чисто из интереса.

Но в Unraid большая часть перечисленного неплохо реализована из коробки, потому я предпочёл остановиться на нём. Пока не оплачивал (триал ешё не кончился, месяц плюс продление на 15 дней), но думаю купить версию на 12 устройств, а потом, при необходимости, сделаю апгрейд до полной. В нём есть свои особенности, к которым надо привыкнуть (относительно того же windows server), но я думаю, что оно того стоит.

Про настройку, тонкости использования и то, чем конкретно я заменил функциональность старого сервера, будет в следующих частях.

Поскольку сборка и настройка ещё продолжаются, эти части будут дописаны недели через две-три, не стоит их ждать завтра-послезавтра.

Можно, конечно, публиковать их в виде путевых заметок вида «сегодня я настраивал krusader, много думал», но это не мой жанр.

Комментарии (113)

Whyborn77

11.01.2022 09:50+9"отличный" выбор между OMV обозванного нашлепкой на пингвина и UNRAID так не обозваного, браво!

вопрос который не дает мне покоя - зачем домашнему серверу платное ПО ?

имхо проплаченная статья

aik Автор

11.01.2022 09:56+1OMV обозван нашлёпкой из-за того, что его можно поставить сверху на обычный debian. Proxmox — это такая же «нашлёпка», никто не мешает его поставить отдельно из репозитория.

А вот unraid вы к готовому линуксу не приклеите, он одним куском ставится. Как truenas, к примеру.зачем домашнему серверу платное ПО ?

Домашний и бесплатный — не синонимы. Никто не заставляет платить. Можно использовать то, что хочется. Можно бесплатное, можно коммерческое пиратить (та же xpenology — это натуральная пиратка), можно за коммерческое платить. Решение выбирается по потребностям и возможностям.имхо проплаченная статья

К кому за деньгами обращаться?

praeivis

11.01.2022 11:06+5имхо проплаченная статья

Никогда не приписывайте злому умыслу то, что вполне можно объяснить глупостью

Admaer

11.01.2022 12:23+1вопрос который не дает мне покоя - зачем домашнему серверу платное ПО ?

Затем, что я его воткнул и оно сразу заработало. И мой HBA сразу обнаружился и заработал. И даже докер-контейнеры там ставится одной кнопкой. Всё это очень сильно отличается от моего остального опыта работы с линуксом.

имхо проплаченная статья

Присоединяюсь к вопросу ОПа: куда обращаться за чемоданом?

Stikkibr

11.01.2022 11:31+1Мне больше нравится ESXI + xpenology, я таким пользуюсь, вариантом

aik Автор

11.01.2022 11:38Так это хорошо, когда есть то, что нравится.

Гораздо хуже, когда сидишь и думаешь «Если бы губы Никанора Ивановича да приставить к носу Ивана Кузьмича, да взять сколько-нибудь развязности, какая у Балтазара Балтазарыча, да, пожалуй, прибавить к этому ещё дородности Ивана Павловича...» и не находишь удобного варианта.

Mel

11.01.2022 15:50после неудачного обновления потерял часть данных (к сожалению уже не помню что конкретно произошло). Зарекся юзать подобный софт, перешел на OMV

Kozobrod

11.01.2022 12:19Если там и правда такой крутой стор, то стоит попробовать.

Сам пока на OMV сижу и вполне доволен, для бытовых задач с головой. Но у меня дисков конечно поменьше - 2 hdd чисто под фото и 1 ssd для всего остального. Интерфейс там может и не очень, но я туда крайне редко захожу, один раз папочек насоздавал, права раздал и все. Все остальное все равно в портейнере делать приходится.

Мой набор таков: docker, portainer, qbittorrent, torrserver (чтобы не качать торренты, а сразу на телеке смотреть), nextcloud (мега комбайн с ультимативным набором интеграций). Чего бы еще поставить так и не придумал

Еще бы для телека что-нибудь придумать, а то встроенный andoid tv отказывается воспроизводить торренты больше 40 гигов. Читал про всякие приставки, но там то нетфликс не поддерживается, то железо слабое, то интерфейс от планшета.. Ультимативное решение конечно есть - nvidea shield pro, но цена что-то кусается

aik Автор

11.01.2022 12:25Ради одного только аппстора сюда идти не стоит, тут мне в комплексе понравилось решение. Включая метод работы с массивом. Сам же аппстор просто на хорошем уровне сделан, но не более.

Lunti

11.01.2022 12:51torrserver через докер крутится? все хочу тоже повесить, да руки не доходят. Долго буфер пополняет?

Kozobrod

11.01.2022 14:15Надо было конечно через докер, но я что-то поленился тогда. Скорость наполнения буфера у меня очень сильно зависит от количества раздающих, если с этим все хорошо, то секунд 10-20.

Я сначала пробовал сервер на телевизор ставить, там тоже все было неплохо, но потом подумал, что жирные торренты тормозят именно из-за сервера и поэтому переместил на OMV, как оказалось не в этом дело было

Lunti

11.01.2022 12:49я после qnap ушел на OMV, очень доволен, самое главное развязанные руки. По интерфейсу у меня притензий нет, весь необходимый функционал есть из коробки + вагон плагинов.

aik Автор

11.01.2022 13:00развязанные руки.

Да, это основное отличие универсальных решений от специализированных. Впрочем, omv всё же в хостовой системе мутит со своими сервисами. К примеру, почтовый сервер я как-то пытался поднять на хосте — не срослось, пришлось в виртуалку пихать.

А не нравится мне в нём то, что они уходят от плагинов и меняют их на докер. Всё же это довольно серьёзная смена идеологии использования (если не знаком), потому это был лишний минус в копилку. К докеру, впрочем, всё равно пришлось придти, так что из минусов omv я это вычеркну. Интерфейс, впрочем, это не обеляет.

Особенно его двойное сохранение. Что-то поменял, нажал сохранить — и тут вылазит одно сообщение на тему «чтобы действительно сохранить, надо ещё раз нажать сохранить».

man55

11.01.2022 14:10для виртуалок можно proxmox ve поставить на обычный дебиан, сам дебиан можно поставить на флэшку и настроить так, чтобы при работе запись на неё была минимальная

Вот примерно те же цели (файлопомойка/кино/фото, бэкапы всего и вся, виртуалки для экспериментов и саморазвития), так что так в свое время после отказа от XigmaNAS и сделал.

Почему так? Потому что после серии экспериментов подумал, что лучше собрать все на мэйнстрим-софте с какой-никакой поддержкой сообщества, чем использовать (возможно) более производительные и удобные, но кастомные решения.

Железо - Microserver Gen7, далее снизу вверх:

Файловая система - ZFS, два диска в зеркале (только система, не считая дисков-файлопомоек). ZFS - ибо решил, что два диска сдохнут до невосстановимого состояния с гораздо меньшей вероятностью, чем флэшка. А менять флэшки превентивно раз в полгода - лень. Монтирование и восстановление одного диска с ZFS проверил на другом компе, сымитировал отказ одного из двух.

Операционка - debian, загручик и ОС прямо на ZFS, linux научился уже

Службы на debian - в первую очередь samba, остальное по желанию

Proxmox-контейнеры и виртуалки под всякое разное, торрентокачалка, DLNA сервер для старых домашних клиентов, сервер майнкрафт детям, WinXP для старого технологического софта и т.п. Принцип: один контейнер/виртуалка - один целевой софт

В контейнеры проброшены ресурсы по разному, от самбы до прямого проброса железа

Программированием не занимаюсь, так что ресурсоемкие задачи не нужны. Соответственно быстродействия всего этого вполне хватает, загрузка растет до пиковой крайне редко.

hapcode

11.01.2022 14:31А тормоза с smb не мешают? Тут человек расстроился и перешел с Unraid на Proxmox VE.

Сам хочу NAS собрать. Корпус Node 804 уже приехал. Присматриваюсь к Unraid, но возможные тормоза IO немного напрягают.

aik Автор

11.01.2022 14:53Там, похоже, история с многопоточной записью и падением производительности из-за fuse — всё же у неё заметные накладные расходы.

У себя я пока не замечал какой-то глобальной проблемы в плане записи по сети — гигабит нормально загружается на больших файлах, мелкие файлы копируются медленно. Но я и не занимался многопоточной записью, это не мой сценарий. Чтение может быть, а вот запись редко одновременная идёт.

Syncthing у меня как-то очень медленно синхронизировался, в районе 10-15 мегабайт скорость была на файлах размером 20-30 мегабайт.

aik Автор

11.01.2022 14:57Вдогонку — у unraid'а полнофункциональный триал на месяц, плюс можно продлить на 15 дней точно, а то и на месяц.

Ну и для потомственных пиратов есть рутрекер. ;)

В общем, можно проверить его на своих сценариях и понять, годится или нет.

hapcode

11.01.2022 15:20Ага, про триал я в курсе. Просто не хочется устраивать возню с перенастройкой и перекидыванием данных, если не понравится. С другой стороны, Proxmox выглядит как-то сложно. Возможно unraid мне хватит за глаза.

aik Автор

11.01.2022 15:38Ну, тут только пробовать. Я щупал всё, по итогам выбрал.

proxmox я не могу ругать за что-то конкретное — я им не пользовался настолько, чтобы аргументированно его советовать или от него отговаривать. Просто лично мне не понравился.

dalamber_sign

13.01.2022 17:53триал продляется дважды по 15 дней, сам триалил месяца полтора-два прежде чем купил

если не перезагружать хост, то можно хоть год жить на триале

ya_penek

11.01.2022 17:34Я недавно поднимал домашний сервер для директора небольшой конторки с удаленными сотрудниками. OMV показался мне кривым до невозможности, в процессе настройки я заколебался через консоль чинить то, что сломал через веб-интерфейс. Уж лучше просто поставить линукс и все настроить руками, чем такое.

Но клиент слабо разбирался в линуксах, поэтому пришлось поставить xpenology. Там реально все работает из коробки, ставится в 1 клик из репозиториев. Сейчас на сервере крутится сайт на вордпрессе, почтовик с веб-интерфейсом, чат (Mattermost) и виртуалка с виндой для 1С. Единственная проблема - не работала встроенная программа получения сертификатов LetsEncrypt. Пришлось все-таки прикрутить костылик и написать скрипт, который использует acme.sh и раскидывает файлы сертификатов по разным местам. Там все немного сложно устроено, сертификаты хранятся в разных местах и копируются при запуске и остановке сервисов.

connected201

11.01.2022 17:56Я сейчас тестирую софт, есть недочёты,(@aik сказал что есть кнопка автоматической установки маркета, но я такую не нашол, установил через линк) но главный плюс для меня, то что он пробрасывает видеокарту нативно, без бубнов!

aik Автор

11.01.2022 18:05В какой-то бете 6.10 добавили. В 6.9 нету.

У меня 6.9.2 — я ставил маркет ссылкой с гитхаба.

Из описания 6.10rc1:Simplified installation of the Community Apps plugin. The webGUI automatically includes the Apps menu item, and if CA is not already installed, the page offers an Install button. No need to hunt for the plugin link.

dartraiden

11.01.2022 19:43Cobian Backup (давно не обновлялся)

Там была эпопея в виде продажи исходников, а в прошлом году он возродился в виде Cobian Reflector.Cobian Reflector is the newcomer in the Cobian Backup family, although it’s a whole new program. Cobian Reflector is completely .NET based. In addition to all the features of the latest Cobian Backup, it has support for SFTP transfers, it is DPI independent due to the use of vector graphics and Windows Presentation Foundation, and also behaves as a 64-bit program in 64-bit systems and as a 32-bit program in 32-bit systems.

aik Автор

11.01.2022 19:54Да, но reflector вроде как на ХР не работает, а я cb11 как раз ради ХР держу.

DaSte

11.01.2022 20:38Какие USB устройства необходимо пробрасывать в виртуалки? Раньше вроде как была необходимость в HASP-ключах, а сейчас что требуется пробрасывать, да еще в домашних условиях?

Для себя конфиг следующий.

Файловое хранилище, при необходимости торрент качалка, DLNA - выполняет WiFi роутер от Keenetic с подключённым внешним диском на 1ТБ, в планах сменить диск на SSD.

Бэкапы, только семейные фото и видео, об остальном не беспокоюсь. Стараюсь поддерживать актуальность хранения методом 3-2-1.

Фильмы - есть подписки онлайн-кинотеатров, если прям не терпится пока оно появится в подписках и идти в кинотеатр не хочется или не можется, идем на торрент, смотрим и удаляем. Шедевров нет чтобы ежедневно пересматривать, поэтому и хранить нечего. Мобильные устройства все автоматом бэкапируются, в моем случае в iCloud, на лэптопах, в автоматическом режиме бэкапируются только документы, на Mac это iCloud, на Windows это OneDrive. Бэкапы ОС не нужны, все они сейчас восстанавливаются без носителя через Интернет.

Для виртуалок хватает Windows 10 (уже Windows 11) ноутбука с RAM на 32Gb и SDD на 500Gb. Но это буквально только в рабочее время, для собственных нужд держать 24/7 нет необходимости. Почта с личным доменом привязана к бесплатному почтовику, хостинг для пет-проектов или на GitHub Pages или хостинг в Azure с бесплатным тарифом или по цене схожей с хостингом для сайтов у большинства провайдеров.

Самое главное этот "сервер", не жужжит, не занимает место, не собирает пыль и не потребляет дополнительное электричество. Обслуживать не нужно.

Так что не знаю модно ли еще сегодня дома держать свой "сервер"?

khajiit

11.01.2022 21:16а сейчас что требуется пробрасывать, да еще в домашних условиях?

usb-hub, as is, чтобы втыкать устройства прямо в виртуалку.

UPD:есть подписки онлайн-кинотеатров

Режиссерок нет, редкостей нет. Просто старого нет — не та бизнес-модель.

DaSte

11.01.2022 21:48usb-hub сам по себе не интересен, что планируется в него подключать? если внешний диск, так это проще и дешевле сделать на продвинутом WiFi роутере задействовав функционал файлового сервера

DaemonGloom

11.01.2022 22:37Я иногда пробрасываю в виртуалку usb диск, чтобы скопировать файлы на сервер напрямую, а не по сети. Плюс постоянно проброшен стик zigbee.

DaSte

11.01.2022 22:50Raspberry не предпочтительнее для стика zigbee, для этого разве нужно держать домашний "сервер" с виртуалками?

DaemonGloom

12.01.2022 07:44Если у меня уже есть сервер — зачем мне брать ещё и малинку, если я могу просто создать виртуалку с Home Assistant?

khajiit

12.01.2022 23:30Не факт что это быстрее, что на роутере будет нужный функционал, что он не будет глючить и тупить.

А еще "роутером" может оказаться хост.

И не факт, что вы захотите монтировать свежепринесенный диск ненативным драйвером: на нем может оказаться поврежденная ФС.Потом, прямое подключение просто работает. Запустили виртуалку, в нее пробросился хаб, она подмонтировала устройства. Отключили-подключили — все просто работает. А теперь проверните это с проброшенным конечным устройством qemu, например, теряет и требует вмешательство с хоста, который вообще может быть headless.

Keep It Stupid Simple.

aik Автор

12.01.2022 01:16+1Какие USB устройства необходимо пробрасывать в виртуалки?

Любые, какие понадобится. Касательно именно домашнего сервера на антресолях их не так много — сканер на антресоли я не потащу, к примеру. Но всё равно это не повод использовать hyper-v.Бэкапы ОС не нужны, все они сейчас восстанавливаются без носителя через Интернет.

Нужны — как минимум настройки и рабочее окружение. Не настолько сильно, чтобы заморачиваться с закачкой этих бэкапов в интернеты, но локальную копию удобнее иметь.Так что не знаю модно ли еще сегодня дома держать свой «сервер»?

Причём тут «модно»? Вопрос исключительно в функциональности и удобстве. Если вас устраивает роутер с жестким диском — пользуйтесь, я не заставляю его выкидывать.

Но меня такое не устраивает.

dalamber_sign

13.01.2022 18:01Тоже вначале сетевым диском был роутер, сначала padavan, потом кинетик

роутерная самба очень медленно работает с папками с кучей мелких файлов

Роутерные торренты тоже слабоваты по скорости работы с диском. Transmission у меня не вытягивал больше 5-6MB/s. Есть сборка qbittorrent под кинетик, где обещают 10МB/s, уже лучше, но надо возиться с установкой и настройкой, возможно роутер под такой нагрузкой будет тупить, не проверял и все равно результат не топ.

C DLNA та же история - пойдет за неимением другого, но не более. Plex удобней в мелочах вроде запоминания истории просмотра

Bonio

12.01.2022 10:55А можете рассказать про Azure с бесплатным тарифом? Действительно ли бесплатный, или только на 12 месяцев? Что за сервисы дают бесплатно?

AbrekUS

11.01.2022 22:16ESXi @ старый Dell laptop — VM-ки с Windows, Linux и т.п.

QNAP (2 x 4TB mirror) — файловое хранилище, torrent качалка, Plex + docker container-ы

Ubuntu Server @ Lenovo ThinkCentre IoT — перевожу на него docker container-ы с QNAP-а + эксперементы с Kubernetes

Dock3r

12.01.2022 01:42Как я говорил в прошлой статье, прошел плюс-минус похожий путь. Про unRAID узнал от админа всея ютуба Linus Sebastian (LTT).

Да, анрейд это чисто игрушка для домашних гиков, кому достаточно конфиги крутить на работе, а дома хочется просто что бы работало. Да, оно почти работает без пинков. К анрейду обычно идут те, у кого стопка разнобойных дисков и какое то железо. И оно просто работает. Я могу вынуть любой диск и ничего не произойдет. И мне не нужно по гигу памяти на каждый террабайт места как в случае truenas. И нет оверхеда в случае proxmox или окносервера. И мне не нужно думать о том, что будет если железный рейд на esxi развалится.

unRAID это старый добрый линукс, в котором за тебя сделали довольно большой кусок грязной работы, и 89 баксов вот совсем не жалко было, купил на 7й день триала.

И да, за год использования встретил всего один косяк, wd purple не хотят засыпать, даже принудительно.

aik Автор

12.01.2022 01:47админа всея ютуба Linus Sebastian (LTT).

При всём уважении — я тоже периодически смотрю его ролики — он всё же хипстер от айти. Но зато у него есть хорошие бюджеты и он может любую фигню пытаться собрать, которая в голову придёт. Почему и интересно смотреть бывает.

Dock3r

12.01.2022 01:50Понятно что он в первую очередь шоумен, потом уже технарь, большую часть серьезных штук делает его команда. Просто они частенько помогали другим блоггерам с железяками, вот и назвал его кто то админом ютуба. Чисто лычка, ничего более.

Admaer

12.01.2022 07:07И да, за год использования встретил всего один косяк, wd purple не хотят засыпать, даже принудительно.

Там же по умолчанию вообще отключение дисков выключено. На форумах тоже пишут в духе "а зачем их выключать?". Считаете, что это неправильно?

Dock3r

12.01.2022 07:13Не совсем понял вопроса.

Да, по умолчанию в настройка spin down delay стоит never. Но так как есть куча дисков которые не любят частые остановки, я считаю что это правильно, т.к нормальные люди не держат сервер набитый 10+ дисками в метре от спального места, и то что они крутятся 24\7 особо никого не парит.

aik Автор

12.01.2022 07:20С точки зрения надежности самих дисков, выключать их не стоит — пусть крутятся. Потому что каждый старт увеличивает вероятность выхода из строя — это гораздо большая нагрузка, чем просто покрутиться и ничего не делать.

С точки зрения человека же, которому с этими дисками в одном доме жить, гораздо приятнее, когда они не шумят. Потому лично я считаю, что выключать можно. А для того, чтобы пореже их будить, надо наиболее часто используемое класть на ssd. Ну или хотя бы на один из дисков собирать, чтобы только он крутился.

aik Автор

12.01.2022 08:07Кстати, ещё касательно unraid.

У него есть фишка по имени turbo write, которая ускоряет запись на диск, но требует того, чтобы все диски в массиве крутились.Turbo write keeps all disks spinning for a write to any one disk. The net difference is without turbo write, we have to do a read, modify, write. With turbo write it's just a reconstruct write, which is the same method we use to rebuild a failed disk.

То есть при турбо-записи не тратят время на чтение информации с парити-диска, а просто молча её перезаписывают.

13werwolf13

12.01.2022 07:59чому не рассматривал freenas? имхо прекрасная альтернатива unraid. это конечно не linux, да и вместо docker там jail. но это дело привычки.

aik Автор

12.01.2022 08:08Почему не рассматривал? Рассматривал. И написал, почему оно мне не нужно.

Это совершенно не альтернатива unraid, это полностью самостоятельное решение. Да, оно выполняет примерно те же задачи, но совершенно другими методами, с которыми я не согласен.

13werwolf13

12.01.2022 08:15Это я отстал от жизни, не понял что truenas=freenas

Тогда есть вопросы по текту: в статье написано что zfs не могёт в диски разного размера, но это не так. Zfs как раз плевать хочет на размер диска в луне, даже позволяет в зеркало сунуть два диска разного размера на свой страх и риск, и так же позволяет докинуть ssd под кэш, а ещё умеет дедупликацию, zvol и сжатие

Ну а по не согласию с методами.. Чтож.. Ваш выбор спорить не буду.

aik Автор

12.01.2022 08:46+1Zfs как раз плевать хочет на размер диска в луне

Ну вот у меня сейчас стоят диски 3+3+5+6+8+8. Какой эффективный размер массива я получу на raidz1?

Смогу ли я заменить 3 на 5 без пересборки массива?

Смогу ли я удалить диск из массива без пересборки массива?

Смогу ли я добавить диск в массив? Хотя это вроде zfs уже научилась, но без изменения типа массива.

Могу ли я конкретным файлам сказать, чтобы они всегда жили в кэше?

И это я ещё не учитываю, что у меня пара дисков (6 и 8) — SMR, что сразу закрывает им дорогу в использование с zfs.

Дедупликацию в zfs никто не советует включать, кто такой zvol не в курсе, сжатие btrfs умеет (а unraid умеет btrfs, хотя для массива всё же xfs рекомендует).

А jail же при том, что идея аналогична докеру, докером не является. А инструкции по запуску докера на truenas обычно начинаются со «запускаем линукс в виртуалке».

Есть, впрочем, truenas scale, где поддержку докера прикрутили, но она очень далека от простоты запуска контейнеров парой кликов, как в unraid.

13werwolf13

12.01.2022 11:18zfs позволяет в одном пуле держать несколько дисковых массивов

к примеру два зеркальных и три raidz1. я к сожалению фанат мнения что лучший рейд это 1+0 так что ен могу большего подсказать по raidz*

заменить, добавить, увеличить.. - ДА, zfs позволяет это делать на лету.конкретные файлы всегда в кэше.. что-ж я слышал про такой функционал, но не вдавался в подробности ибо зачем? если файл активно дёргается то он и так будет в кеше, а если нет то и нефиг ему там делать ИМХО

дедуплекацию не советовали включать 100 лет назад, сейчас с этим всё ок.

не смотря на мою любовь к btrfs дедупликации как таковой там всё же нет (зато есть снапшоты)

а zvol это киллерфича, очень жалею что в btrfs нет аналога, советую ознакомится

(а xfs я бы вообще не рекомендовал использовать в домашних условиях, эта ФС сделана с оглядкой на сферический цод в вакууме где не мигает свет и не бывает нештатных выключений кнопокй reset. пока всё идёт штатно она прекрасна, но вот в нештатных ситуациях просрать все данные с диска безвозвратно это про xfs)

ну jail конечно не является заменой docker, но и docker не обязателен имхо, в большом проде с k8s и кучей подов да, ну а дома я бы обошёлся без

да и идея не аналогична, jail скорее где-то между chroot и lxc, а docker это кострированная альтернатива lxcконечно я не переубеждаю, каждому своё

aik Автор

12.01.2022 11:39zfs позволяет в одном пуле держать несколько дисковых массивов

к примеру два зеркальных

Зеркала мне избыточны.

С unraid в перечисленном случае я получаю эффективню ёмкость из 3+3+5+6+8, теряя одну 8 на защиту массива. Переживаю потерю одного любого диска, если же вдруг потеряю два диска — то на оставшихся дисках данные сохранятся в виде целых файлов, а не ошмётков raid'a.заменить, добавить, увеличить… — ДА, zfs позволяет это делать на лету.

А подробнее, по пунктам? Замена на такой же — это понятно, любой raid умеет. А вот замена на меньший или больший?

Или, допустим, было зеркало 3+3. Я хочу добавить 5. Что в итоге получится?зачем? если файл активно дёргается то он и так будет в кеше

Чтобы к нему была возможность быстро обратиться. К примеру, в unraid «в кэше» принято хранить контейнеры с настройками и виртуальные машины. Я ещё в «кэш» свою музыкальную коллекцию вытащить хочу, чтобы можно было слушать музыку, не раскручивая винты. На «частое обращение» такой способ использования точно не потянет.

Ну и кэш записи, само собой. Когда торренты туда качаются или по сети файлы закидываются, а где-нибудь ночью перекладываются оттуда на винты.дедуплекацию не советовали включать 100 лет назад, сейчас с этим всё ок.

www.truenas.com/docs/references/zfsdeduplication

32 ядра, куча памяти, nvme-диски… По-моему, это совсем не тянет на «всё ок» для домашнего сервера.не смотря на мою любовь к btrfs дедупликации как таковой там всё же нет

Я про сжатие писал, если что.xfs я бы вообще не рекомендовал использовать в домашних условиях

Я бы не сказал, что она чем-то хуже ext3/4. Такая же дубовая.docker не обязателен имхо,

Скажите это разработчикам всякого прикладного софта. Сейчас многие либо докер дают, либо «вот вам исходники и трахайтесь как хотите, если вы такой умный». Так-то я бы тоже с удовольствием не пользовался докером, а ставил всё на хост.

13werwolf13

12.01.2022 12:02А вот замена на меньший или больший?

на больший пожалуйста, zfs сам пересчитает объём, на меньший это фича которую только относительно недавно добавили и её включение нужно явно указать.. наверное не стоит пока

32 ядра, куча памяти, nvme-диски… По-моему, это совсем не тянет на «всё ок» для домашнего сервера.

ну так и написанное совсем не для домашнего сервера, однако на домашнем с этим всё ок, проверено

Я бы не сказал, что она чем-то хуже ext3/4. Такая же дубовая.

в плане отказоустойчивости и сохранности ext4 всё же лучше (btrfs с недавних пор тоже можно считать лучше. а вот несколько лет назад без хорошего UPS юзать btrfs я бы тоже не рекомендовал)

Скажите это разработчикам всякого прикладного софта. Сейчас многие либо докер дают, либо «вот вам исходники и трахайтесь как хотите, если вы такой умный».

и тут я выбираю разок потрахаться (или вообще делегировать траханье мейнтейнерам дистрибутива) чем трахаться постоянно с докером

aik Автор

12.01.2022 12:26на больший пожалуйста, zfs сам пересчитает объём

Ну так что у меня будет в итоге, когда я к зеркалу 3+3 добавлю ещё диск на 5?на домашнем с этим всё ок, проверено

У меня сейчас вот перед носом ком на truenas с zfs — на нём свободно 3 гига из 16. И это ещё без дедупликации. На такие накладные расходы я совсем не хочу идти на домашнем сервере.в плане отказоустойчивости и сохранности ext4 всё же лучше

Спорно. Впрочем, сам я не сравнивал, но плохих отзывов об xfs относительно ext3/4 не слышал. Сам всегда ext* использовал.btrfs с недавних пор тоже можно считать лучше

На анрейдовских форумах пишут, что xfs надёжнее, btrfs умеет больше. xfs для основного массива рекомендуют, btrfs — для кэша.без хорошего UPS юзать

Без ups вообще ничего юзать не рекомендуется. Особенно если делать вид, что это сервер.тут я выбираю разок потрахаться

Для потрахаться обычно нужен некоторый уровень компетентности в вопросе. Не помешает ещё инструкция подходящая.

Хорошо, если старые инструкции ещё актуальны — ну и если они вообще есть. А ведь если разработчики сразу докер выбирали, как способ распространения, то инструкций может и не быть, самому придётся разбираться.делегировать траханье мейнтейнерам

Далеко не весь софт включают в дистрибутивы.трахаться постоянно с докером

Так фича анрейда в том, что в местном аппсторе всё уже затрахано до вас. :) Вам максимум пути к файлам указать надо да порты проверить, чтобы не пересекались с уже запущенными контейнерами.

khajiit

12.01.2022 23:45Ну так что у меня будет в итоге, когда я к зеркалу 3+3 добавлю ещё диск на 5?

А это зависит от того, как добавите. Можно сделать 3 ТБ triple mirror, 3 (mirror) + 5 (span) в одном пуле, и даже 3+3+5 (span).

У меня сейчас вот перед носом ком на truenas с zfs — на нём свободно 3 гига из 16

А сколько из них ARC?

aik Автор

13.01.2022 00:503 (mirror) + 5 (span) в одном пуле

Ок, 8 терабайт получается. А теперь 5 вылетает. Какая информация с него сохранится на массиве?даже 3+3+5 (span)

И вот прямо таки без пересборки, ничего никуда не копируя зеркало можно превратить в страйп?сколько из них ARC?

Пока нет активности и сервер сам себе шебуршит винтами — 8-10 гигов.

khajiit

13.01.2022 09:28Ок, 8 терабайт получается. А теперь 5 вылетает. Какая информация с него сохранится на массиве?

Это ж не зеркало. Сильно зависит от того, что вы сделаете: в случае обычного span, естественно, ничего с пятерки не сохранится, да сам пул перейдет в

FAULTED.

Но есть вариант: благодаря размазыванию метаданных (три копии, сохраняются на разные физические устройства, если таковые есть), сохранятся они. И то, что было помечено какzfs set copies=[2|3].

А если вы сделаете разные пулы и объедините их биндами, unionfs, overlay2, или любым другим способом — то и не будетFAULTED-массива.И вот прямо таки без пересборки, ничего никуда не копируя зеркало можно превратить в страйп?

Можно. Зеркало можно в простой stripe:

zpool detach <pool> <mirror dev participant>разберет зеркало, а

zpool attach <pool> <exist dev> <new dev>сконвертирует одночный

vdevобратно в зеркало.8-10 гигов

Зависит от сценария, конечно, но можно попробовать урезать осетра до пары ГБ, запретить кешировать холодную часть (zfs set primarycache=metadata).Но, в любом случае, все это — за пределами немногочисленных крутилок в примитивном интерфейсе.

aik Автор

13.01.2022 10:07А если вы сделаете разные пулы и объедините их биндами, unionfs, overlay2, или любым другим способом — то и не будет FAULTED-массива.

Такими темпами скоро дойдём и до форматирования отдельных дисков в zfs, объединения их aufs и прикручивания сбоку snapraid'a. :)все это — за пределами немногочисленных крутилок в примитивном интерфейсе.

Вот-вот. А нахрена мне промышленную файловую систему подгонять под свои казуальные нужды, если мне предоставляют готовое казуальное решение?

zfs нужна тогда, когда нужны её zfs-ные фишки. А под мои нужды её переделывать — это как из пушки по воробьям.

Если очень сильно хочется, то к unraid можно прикрутить zfs — плагин имеется. Но мне не хочется.

khajiit

13.01.2022 11:41А нахрена мне промышленную файловую систему подгонять под свои казуальные нужды, если мне предоставляют готовое казуальное решение?

Тогда откуда у вас такие

картинки, докторвопросы:А теперь 5 вылетает. Какая информация с него сохранится на массиве?

Раз пропала, так пропала)

Или вы хотите сказать, что в схожей конфигурации unraid что-то сохранит?форматирования отдельных дисков в zfs, объединения их aufs и прикручивания сбоку snapraid'a

А snapraid-то там зачем? Он, вроде, к zfs ничего не добавит.

Можно не объединять, можно просто смонтировать в произвольную/mediaвсе пулы. Размазывания не будет, все части файлов будут находится на одном диске — фишка, доступная за 30 лет до появления unraid, емнип.

aik Автор

13.01.2022 13:48Тогда откуда у вас такие картинки, доктор вопросы:

Потому что казуалы тоже не особо любят терять информацию. Упарывать всерьёз в её защиту тоже не хотят, но какой-то минимальный сервис иметь хочется.Или вы хотите сказать, что в схожей конфигурации unraid что-то сохранит?

В схожей конфигурации (3+3+5) у анрейда 5 пойдёт под parity и потерять можно один любой диск. Конечно, можно и без парити, но тогда это просто jbod будет.А snapraid-то там зачем? Он, вроде, к zfs ничего не добавит.

Ну если вы не пользуетесь фишками избыточности файловой системы, а только для объединения дисков её используете и прочих снапшотов, то snapraid тут как раз ту самую избыточность и обеспечит.фишка, доступная за 30 лет до появления unraid

Так я и не говорил, что unraid уникален. Наоборот, написал, что примерно ту же функциональность можно и самому собрать из конструктора.

Просто в unraid оно есть из коробки и достаточно удобным управлением.

khajiit

13.01.2022 14:16В схожей конфигурации (3+3+5) у анрейда 5 пойдёт под parity

Извините, но нет: что там куда пойдет из этой записи (3+3+5) совершенно неясно, но использование сложения без дополнительных обозначений скорее говорит об 11 у.е. доступного места в результате — и parity там места уже нет.

Не говоря уже о том, что исходно вопрос был сформулирован так:Ну так что у меня будет в итоге, когда я к зеркалу 3+3 добавлю ещё диск на 5?

И тут в любом случае нужна пересборка, чтобы 5 оказался с parity. Возможно, unraid это умеет из коробки…

Для parity есть raidz у zfs. Но чтобы преобразовать зеркало в raidz, его сперва потребуется расщепить, потом использовать один диск из зеркала, новый диск и какой-нибудь sparse zvol для создания нового пула с raidz, перевести пул вDEGRADED, отщепив zvol, и, наконец, мигрировать на него данные. Потом останется развалить старый пул и прицепить его диск к новому, как часть raidz, после чего начнется автоматический resilver.

aik Автор

13.01.2022 14:44И тут в любом случае нужна пересборка, чтобы 5 оказался с parity. Возможно, unraid это умеет из коробки…

У анрейда нету фишек zfs. Он товарищ простой. В массиве все диски jbod и один-два parity.

Потому, если заботиться о отказоустойчивости, то из двух дисков у него будут один под данные и один под парити. Если добавляем к ним третий большего размера, то он станет парити-диском. То есть из «типа зеркала» 3+3 эффективным объёмом в 3 терабайта добавлением третьего диска на 5 терабайт получим полностью отказоустойчивый массив эффективным объёмом в 6 терабайт. Да, два терабайта пропадут — так система устроена. Но при смерти одного из дисков все данные останутся на месте.отребуется расщепить, потом использовать один диск из зеркала, новый диск и какой-нибудь sparse zvol для создания нового пула с raidz, перевести пул в DEGRADED, отщепив zvol, и, наконец, мигрировать на него данные

А мне все эти танцы совсем не нужны дома. Я диски туда-сюда дёргаю не так уж редко, так что постоянно собирать-разбирать массивы желания не имею.

khajiit

13.01.2022 14:55Спасибо за пояснение.

Но тогда, по сути, 5 становится не parity а data: один parity в массиве уже есть.

Таким образом, аналог сводится к один раз собранному raidz, без дальнейших пересборок.Правда, ваши файлы все равно будут размазаны.

aik Автор

13.01.2022 15:11+1Но тогда, по сути, 5 становится не parity а data: один parity в массиве уже есть.

Нет, большой диске именно как парити пойдёт. Там процесс примерно такой будет: замена парити3 на 5, ребилд парити на новый диск, добавление старого парити3 как диска для данных. Вот если добавляете диски такого же размера или меньшего, тогда ничего ребилдить не надо будет, просто новый диск занулить.

Я подробнее расскажу про это в следующих частях, потому что свободная замена дисков в массиве — это вообще основное, что мне требовалось. Остальное всё по остаточному принципу.

Танцев в итоге достаточно (особенно когда хочешь добавить диск, сохранив данные на нём), но всё же гораздо меньше, чем когда пытаешься в raid5 диск засунуть или вынуть. Как минимум — перекладывать информацию никуда не надо.Правда, ваши файлы все равно будут размазаны.

Могут быть размазаны папки — один файл на одном диске, второй на другом. Хотя это настраивается, с какого уровня начинать папки размазывать. Но вот сами файлы всегда лежат целиком на одном диске.

unraid — это просто объединяющая файловая система типа всяких mergefs. И от связки mergefs+snapraid отличается только тем, что парити (после изначальной постройки) работает в реальном времени, а у snapraid надо гонять sync по крону.

khajiit

13.01.2022 15:16Размазывание относилось к raidz, но спасибо за подробности )

Ждем-с продолжения!

aik Автор

13.01.2022 15:24+1Я потому и не хочу дома связываться со всякими raid'ами — что с пятыми, что с шестыми, что с зетами. Хотя бы потому, что в сервер идёт всё, что лежало на полке. У меня вообще на полке дохрена дисков лежит:

Другое дело, что большей частью там мелкий хлам (80-500), но несколько дисков от терабайта и выше в этой кучке есть. Наработка большая, но смарт чистый, так что сколько-то ещё протянут. И к себе бы я их воткнул — ещё два посадочных места есть, только sata-порты кончились, а контроллер m2-sata ещё в пути.

Вот на работе на серверах, где стоят несколько одинаковых дисков, можно и zfs с прочими рейдами разводить, тут диски обычно меняются всей пачкой раз в несколько лет и гибкость в использовании мусорных дисков не требуется.

Зато требуется возможность не останавливать сервер — для чего, в общем-то, raid и придумали.

Vinni37

12.01.2022 10:40Я для себя остановился на Proxmox VE как хостовой системе, а все задачи вынес в контейнеры и ВМ. Из контейнеров, сервер БД (MariaDB), бэкэнд, фронт, torserver. В качестве NAS поставил виртуалку с TrueNAS и пробросил туда физические диски. Ну и несколько виндовых виртуалок под тесты и RDP. К данному конфигу пришел не сразу, изначально был Qnap D2 (имхо уже морально устарел и не только морально) и отдельный ThinkCentre Tiny в качестве сервера (его то и стало не хватать в первую очередь), а держать две железки не с подручно. Как результат могу сказать, иметь один сервер который совмещает в себе и гипервизор и NAS в одной коробке те еще компромисы. После Qnap и Synology все что есть TrueNAS/OMV/Unraid не дотягивают своим юзерфренди до той планки что задали эти два бренда. Как итог ИМХО если стоит задача собрать гипервизор + nas в одной коробке, то 100% верного решения нет, везде даже за $ будут компромисы. Как говорится разделяй и властвуй.

aik Автор

12.01.2022 11:06+1После Qnap и Synology все что есть TrueNAS/OMV/Unraid не дотягивают своим юзерфренди

К сожалению, тут на одном конце шкалы дружелюбие интерфейса, на другой — свобода творчества. Через дружелюбный интерфейс можно реализовать далеко не всё, либо придётся реализовывать так, как задумывал разработчик. А когда вы полностью свободны — то всё приходится делать самому, за ручку никто не поведёт.

Так что приходится искать компромиссы в зависимости от своих задач и возможностей.

У меня основной хотелкой была свобода настройки дискового массива — возможность использовать любые диски, возможность их добавлять и удалять по желанию, но при этом иметь какую-то защиту. Таких решений не так много. Фактически, я три знаю:

1) Windows + Drivepool (и аналоги). Это у меня было. Простое в использовании, практически беспроблемное. На индикаторе «удобство/свобода» тут отображается «удобство».

2) Unraid. Это стало. Проблем добавилось, но они, скорее, идеологические — привык к одному способу, а тут надо переучиваться и менять привычки. Но, считаю, что в итоге всё окупится, приобретаю больше, чем теряю. Индикатор стоит где-то посередине. Стало менее удобно рулить файлами, но зато у меня теперь защита автоматом на весь массив и добавилось анрейдовских плюшек (докер и все-все-все).

3) aufs/mhddfs/… + snapraid. Тут сплошная свобода, но настраивать всё ручками придётся. Впрочем, в omv вроде как прикрутили базовое управление к веб-интерфейсу, надо посмотреть будет.везде даже за $ будут компромисы

Да, кнопку «сделать хорошо» до сих пор не купить. Можно только хороший инструмент приобрести, но вот делать всё же приходится самому.

Vinni37

12.01.2022 11:14Полностью с Вами согласен. Просто в моем случае работа с контейнерами/вм идет на первом месте а NAS на втором (возможностей Qnap и Synology в качестве NAS меня более чем устраивало). По этому фишки проксмокса, для меня более актуальны чем жанглирование дисками в массиве.

Lopar

12.01.2022 11:39>У меня основной хотелкой была свобода настройки дискового массива — возможность использовать любые диски, возможность их добавлять и удалять по желанию, но при этом иметь какую-то защиту.

Та же Synology продвигает это как одну из своих основных фишек. :)

aik Автор

12.01.2022 11:42Краем уха слышал. Вроде нельзя удалять диски.

Ну и synology на 6-8 дисков стоит больших денег.

Lopar

12.01.2022 15:28Вроде нельзя удалять диски.

В смысле, а что, много есть рейдов, в которых можно не пересобирая рейд взять и уменьшить количество дисков?

synology на 6-8 дисков стоит больших денег

Есть опции, если брать на вырост. Кое-где NAS + полка расширения это дешевле чем NAS на много карманов.

aik Автор

12.01.2022 15:46что, много есть рейдов, в которых можно не пересобирая рейд взять и уменьшить количество дисков?

Ну я вон перечислил варианты, которые знаю. Просто добавлять диски или менять на большие можно много где. А вот свободно дёргать диски туда-сюда — тут не так много вариантов.

Admaer

13.01.2022 08:21Есть опции, если брать на вырост. Кое-где NAS + полка расширения это дешевле чем NAS на много карманов.

Цены совершенно нереальные. Я рассматривал Synology на 4+ диска (в данный момент у меня в NAS используется 4 HDD для данных плюс 3 SSD для кэша и докера/вм) и понравившиеся мне варианты стоили от 40.000 и до 100.000+ рублей. В итоге я купил HBA LSI 9300-8i (переплатил, т.к. брал новый, а не б/у, да и вообще он не особо нужен - на материнке 8 SATA портов) и блок питания (старый не имел нужного количества SATA разьёмов). Что, даже с лицензией unraid, обошлось заметно дешевле 40.000 рублей. Хотя, разумеется, по физическим размерам NAS с готовыми решениями тягаться невозможно.

В смысле, а что, много есть рейдов, в которых можно не пересобирая рейд взять и уменьшить количество дисков?

Ну он не зря UNraid. Там нет преимущества в скорости чтения/записи, которые дают некоторые типы "настоящих" RAID, зато с дисками можно делать вообще что угодно. Для домашнего пользователя ИМХО это важнее. Не все могут позволить себе держать коробку cold spare дисков.

aik Автор

13.01.2022 08:42по физическим размерам NAS с готовыми решениями тягаться невозможно.

Можно попробовать. Конечно, такой миниатюризации не будет, но с ITX-корпусами можно подобраться достаточно близко. Впрочем, тогда и функциональность тоже близкая станет.

khajiit

13.01.2022 09:32Есть всякие нюки и 2.5" диски. Емнип, мелькало что-то на два диска, под зеркало. Но то сильно на любителя.

Есть армы с SATA/PCI-E.

aik Автор

13.01.2022 09:50Есть армы с SATA/PCI-E.

Есть, конечно. И корпуса на 4sata я для rpi видел, вроде даже не сильно колхозные. На два — точно «промышленные» есть, на али продаются.

Но в итоге оно выйдет по мощности и функциональности как тот nas, а усилий и денег на сборку тоже сравнимо с ценой nas'a затратите.

Я, скорее, думал про itx-корпуса на 4-8 дисков. Они вполне сравнимы по размерам с NAS'ами с аналогичным количеством 3.5" слотов.

Lopar

13.01.2022 18:40Цены совершенно нереальные.

Цены там конские в большинстве своём за удобный вылизанный софт. В сравнении по железу всё не то.

aik Автор

13.01.2022 19:44+1Ну и за вендор-лок тоже денежку берут.

Буквально на днях историю слышал про то, как у человека qnap сдох многодисковый. Просто погас и больше не включился. А там «всё, нажитое непосильным трудом». Бэкапы он делал, но не проверял, потому последний был сделан месяц назад, грубо говоря. А вся бухгалтерия была в NAS'e.

Потому сперва он бегал и искал точно такую же модель. Ну или хотя бы такую, которая поддерживала бы апгрейд с его модели. Потому что другая линейка не смогла бы принять диски.

Потом внимательно пронумеровал диски, воткнул их в новый nas. Тот полчаса пожужжал и сказал «мужик, а у меня ведь отсеки совсем по другому нумеруются и диски ты воткнул неправильно. но ничего, ща я их как-нибудь того...»

В итоге диски всё же собрались в нужном порядке, хозяева, отменяя все апдейты и другие запросы кое-как добрались до консоли, слили нужную инфу, а потом уже стали ставить апдейты, гонять чекдиски и всё такое.

В случае же обычного компа с любой ОС — хоть omv, хоть трунас, хоть анрейд, хоть винда — просто перекинули бы диски в любой другой комп да там подцепили массив. И без разницы, в каком порядке диски были.

Netforspeed

13.01.2022 00:523+3+5+6+8+8 ... Я видимо, не читая первой части, не понял, для чего дома такой массив, как собственно и сам сервер, если только вы не работаете с Вэб приложениями, часть которых, по непонятным мне причинам, находятся у вас дома, а не на корпоративном сервере. Понято, что на удалёнке очень удобно иметь сервер рядом, весь процесс отладки сильно ускоряется, особенно когда кто-то из команды работает с теми же базами, у вас, в этом случае, явное преимущество перед остальными.

aik Автор

13.01.2022 00:54Потому что это дешевле, чем такой объём арендовать на хостинге. И скорость доступа выше. И контроль есть.

Netforspeed

13.01.2022 10:29Лет 5 назад, я здесь, на хабре, к статье про "крутые" и "дешевые" VPS сервера в аренду, я написал, что нет ничего лучше, чем своя машина дома с выделенным IP, причем на то время, для начального уровня, б/у ноутбук за 4 тыс. руб + SSD + процессор на 4 ядра (не обязательно) = дармовой web сервер под .NET, по всем, буквально по всем параметрам превосходящий аренду.

Так мне там, только что голову не открутили...) Но убить, у многоих желание было...) Хотя аргументированно ни один пункт оспорить не смогли.

aik Автор

13.01.2022 10:56Одно другому не мешает, вообще-то. У меня есть и простенький vps на hetzner'е, и личный серверок в рабочей серверной (со своим личным каналом в интернеты), и домашний сервер вот.

Впрочем, на бу-ноутбук в качестве сервера я бы и сам наехал. :)

Netforspeed

13.01.2022 17:11да, и чем же он хуже для вялозагруженного приложения? ИБП - аккумулятор, потребление электроэнергии стремится к 0, минимум шума, минимум занимаемого места. хоть один аргумент для вэба? у меня уже 5 лет работает, и радует своей абсолютной непритязательностью, я его раз в год достаю только для чистки от пыли и замены темоинтерфейса под процессором.

aik Автор

13.01.2022 17:29+1Открытый ноутбук сложнее сунуть в шкаф, а закрытый и работающий будет греться слишком хорошо. Два диска не в любой поставить можно, а лично для меня любой сервер или NAS должен иметь минимум два диска. Разнос системы и данные, бэкапы, зеркала и т.п. — в зависимости от потребностей.

Однодисковые решения — профанация.

Болтающиеся снаружи usb-диски — тоже не фонтан. Рекорд я, по-моему, видел у одного товарища с шестью внешними дисками, к ноуту подключенными. Частично через хаб, частично то были 3.5" варианты со собственными БП.

khajiit

13.01.2022 18:15Болтающиеся снаружи usb-диски

Мракота… USB-интерфейс же не обеспечивает до версии 3.0 проверки целостности данных: на плохом кабеле легко можно записать фигню и не заметить. И даже 3.x Type-A может легко свалиться в 2.0 — тоже совершенно незаметно, диффпары отваливаются от дыхания рядом.

Netforspeed

13.01.2022 18:16...Открытый ноутбук сложнее сунуть в шкаф, а закрытый и работающий будет греться слишком хорошо...

ошибка. закрытая крышка гасит монитор, а работа системы охлаждения ноута абсолютно не зависит от положения крышки. и по этому ноут лежит не В шкафу, а НА шкафу, и вполне комфортно себя чувствует.

...Два диска не в любой поставить можно ... точно не в любой, а только в тот, где есть CD привод.

...Разнос системы и данные, бэкапы, зеркала и т.п. — в зависимости от потребностей... Вот именно, от потребностей, а реальность говорит обратное, когда на арендованном ресурсе рухнул рэйд,(если он там вообще был) мне просто сообщили: - извините, бла,бла,бла... ваши проблемы.

разнос системы и данные - в едином пространстве все точно так-же работает.

бекапы... - это не минус, это и есть решение - делаем автобэкап баз в любое другое место, хот раз в час , и в случае падения диска - восстанавливаем на новый, для низкозагруженного сервиса простой несущественный.

зеркала - можно, но не нужно, в 99% случаев.

...NAS должен иметь минимум два диска... в вэб приложении, даже фото, видео, и другой мусор можно прямо в базу, но, ничего не мешает и в файловой системе, естественно с автокопированием. медийный контент не имеется ввиду, поскольку разные порталы с пиратским видео или аудио рядом меня не касаются.

...Однодисковые решения — профанация... выше уже говорили, о профанации. если работает и все довольны, то это не тот термин.

...Болтающиеся снаружи usb-диски — тоже не фонтан... если вам нужны сумасшедшие объемы, то конечно покупаем стойку, и лепим, лепим, raid, потому что в аренду брать большое дисковое пространство очень дорого, но, что же там хранить? и это совершенно не тот случай, когда в 90% берут в аренду VPS и размещают там свой интернет магазин, с посещаемостью в 1000 человек в неделю, а когда посчитали, прослезились, сколько денег спущено на ветер.

aik Автор

13.01.2022 19:37работа системы охлаждения ноута абсолютно не зависит от положения крышки

Очень многие ноуты охлаждаются через клавиатуру в том числе.только в тот, где есть CD привод.

Не только, есть варианты. Бывают просто ноуты с двумя посадочными местами под 2.5", бывают такие, в которые можно одновременно сунуть msata/m2 и 2.5". Ну и замена привода на винт тоже, да.ваши проблемы.

В общем-то да. Особенно если бэкапы не подключали. Да и то, всё равно надо у себя тоже копию «облака» хранить.если работает и все довольны, то это не тот термин.

Ну вот пока работает — тогда и довольны. Как перестанет работать — так резко перестанут быть довольны.90% берут в аренду VPS и размещают там свой интернет магазин, с посещаемостью в 1000 человек в неделю, а когда посчитали, прослезились, сколько денег спущено на ветер.

Если при цене VPS в 5-10 баксов в месяц сайт магазина не окупает даже эти 10 баксов, то может магазин и не нужен? А просто сделать статичную визитку где-нибудь в гуглостраницах…

Netforspeed

13.01.2022 20:20...Если при цене VPS в 5-10 баксов в месяц сайт магазина не окупает даже эти 10 баксов, то может магазин и не нужен? ...

Я не знаю сколько сегодня просят хорошие парни, но 5-10 будет убогий, типа ruvds? вы там пробовали брать аренду? я пробовал, трое суток простоя, и тех поддержка говорит - у нас все работает! пока пальцем не ткнешь и результаты тестов не покажешь, в моем случае от многоядерного процессора, реально была выделена производительность до 400 мгц. они ее позже признали, как и все осталные косяки, которыми мне полоскали голову.

я смотрел за арендованными ресурсами, три года, и частая просадка производительности - это неизбежное, обычное дело, у всех, и хваленых и отстойных.

никакой реальной доступности 24 часа не может быть и речи, ни у кого из них.

эти две проблемы приводят к понижению рейтинга сайта роботом гугла, вас отодвигают в поисковых запросах, за ваш счет, обидно.

Магазин нужен, но не для того, чтобы кормить чужого дядю. 10$ Х 12 мес. 120$ = это уже вполне работоспособный ноутбук, его обслуживание, по факту, проще чем возня с арендованными ресурсами.

Человека проще научить простейшим операциям на SSMS и IIS, на его ноутбуке, чем управляться с проблемами на арендованных ресурсах, которые будут вашими, а не заказчика портала, только потому, что они возникают там всякий разн новые.

aik Автор

13.01.2022 20:55но 5-10 будет убогий, типа ruvds?

Меня много лет полностью устраивает hetzner. С их поддержкой не общался вообще не разу — не было причин.

Цены на vps начинаются с 4 евро за 1ядро/2ГБ ОЗУ/20 гигов диска.

Лично я плачу 8 евро за 3 ядра/4 гига/80ГБ плюс 2 евро за бэкапы.

Проблем со связью я не помню.

Единственное, что когда-то было из серьёзных проблем — это когда на бэушном сервере пошел бэдами один из двух винтов. Это заставило несколько пересмотреть приоритеты, плюс тогда евро с долларов как раз начинали свой путь к 100 рублям, потому я решил толстое и серьёзное хостить у себя, а vps использовать для тех вещей, которые не должны зависеть от доступности моего домашнего интернета — блог, всякие веб-сервисы (типа tt-rss), vpn европейский, пинговался и т.п.никакой реальной доступности 24 часа не может быть и речи, ни у кого из них.

На домашнем интернете тоже не может быть никакой 24хчасовой доступности. Только если озаботиться резервным каналом и настроить балансировку — а это значит, что точка входа всё равно должна быть где-то снаружи.Магазин нужен, но не для того, чтобы кормить чужого дядю.

Любой бизнес кормит кучу чужих дядей — накладных расходов немеряно.0$ Х 12 мес. 120$ = это уже вполне работоспособный ноутбук, его обслуживание, по факту, проще чем возня с арендованными ресурсами.

Возня «с арендованными ресурсами» ничем не отличается от возни с ноутбуком, особенно если и там и там одна и та же ОС используется. Только ноутбуку надо оплачивать интернет, электричество, сдувать пыль и т.п.

Сегодня мне буквально звонил народ, который хостил «сайт» у себя. Приходил провайдер к их соседям, увидел роутер, не увидел его в своей базе, сбросил настройки и переставил роутер к соседям. По вопросу «что за фигня» воткнул их интернет обратно в роутер — но настройки были уже соседские, с другим IP (приватным) и т.п.

А у людей был реальный IP и что-то там хостилось, какой-то проброс портов был, по-моему. Своего админа у них нет, настройки никто не помнит, с провайдера их требовать бессмысленно и т.п.

И сидят они теперь без «сайта».

ex_ineris

13.01.2022 02:43-1Для чего ставить OMV добавляете репу и ставите плагин гипервизор через веб будет вам счастье Вм. И он бесплатен.

LESHIY_ODESSA

13.01.2022 14:08Если же диски полностью пробрасывать в файлопомойку, то у самого гипервизора дисков не останется.

Честно говоря несовсем понятен этот момент. У меня на Proxmox спокойно работает такая конфигурация, когда отданы не все диски, а только один из разделов.

boot (sda2+sdb2=md0)

/root (sda3+sdb3=md1) — Debian, а поверх него Proxmox

storage (sda4+sdb4=md2) — Раздел под диск для OpenMediaVault.Затем убираем md2 из /etc/fstab и пихаем его в виртуалку.

scsi0: ssd:vm-110-disk-0,discard=on,size=20G,ssd=1

scsi1: /dev/md2,backup=0,replicate=0Кто на ком стоять будет? В общем, не особо мне такое нравится.

Да вроде всё нормально. В дебиане можно сделать mount md2 и что-то на него записать/считать, но одновременно с OpenMediaVault он работать не будет, нужно его останавливать, а иначе ошибки файловой системы. То есть Proxmox без всяких посредников просто пишет/читает на md2 без всяких посредников и абстракций. Скорость SMB максимальная.

aik Автор

13.01.2022 14:13спокойно работает такая конфигурация, когда отданы не все диски

Ну так вы не все диски отдали — вот и работает спокойно.

khajiit

13.01.2022 14:23А прокс на zfs и отдать omv контейнер с privileged=1 не пробовали? Получится ли в этом случае управлять датасетами из omv?

MPS78

13.01.2022 16:20Чем не устроил связка openMediaVault + next cloud

aik Автор

13.01.2022 16:51Мне не нравится, как меняется omv от версии к версии. Это раз.

Интерфейс у него тот ещё. Это два.

Чтобы реализовать мои запросы в плане гибкости замены дисков, придётся потрудиться в командной строке. Вроде как в omv есть управление разными видами union fs, да и snapraid имеется, но тюнинг того snapraid'a и использование всё равно только написанием команд, а не нажимаением кнопочек в gui.

А Onecloud вообще как-то не могу представить, где мне может понадобиться.

Admaer

При всех достоинствах unRAID, виртуалки там можно только включать и выключать. Больше он ничего не позволяет делать. Бэкап - ручками или скриптами. Поставить что-то нестандартное (например Mikrotik CHR) - гугл и CLI. Хотелось бы, чтобы разработчики хоть немного поработали в этом направлении.

aik Автор

Понятно, что он не специализированный гипервизор.

Unraid — это решение для домашних гиков, кому уже мало synology, но ещё не хочется разбираться с теми же proxmox'aми и прочими esxi. Но если виртуалки первичны, лучше всё же разобраться.

ProFfeSsoRr

Не хочется разбираться с универсальными утилитами линукса, которые могут пригодится в будущем, но хочется разбираться с уникальными особенностями платного решения на базе линукса? Это еще более странно, чем на базе Windows Server делать.

aik Автор

Я не хочу разбираться в устройстве двигателя и трансмиссии автомобиля. Хотя это может и пригодится в будущем.

Но я хочу разобраться в том, как водить автомобиль и что у него какие кнопочки на панели делают. Ну ещё куда бензин и масло заливать. А двигатель перебирать не хочу.

khajiit

Раз уж пошли автомобильные аналогии, то знать из чего складывается тормозной путь хотите, или у вас тачка крутая и все сама сделает? )

aik Автор

Это относится к использованию, а не к копанию во внутренностях.

khajiit

Зато это не относится к кнопочкам/лампочкам. Это — кусок матчасти, такой же, как и устройство трансмисии. И знание этого кусочка однажды может предотвратить влетание на большие бабки или даже спасти жизнь: вашу или чужую.

ProFfeSsoRr

Не так, тут аналогия скорее "я не хочу разбираться в том, как движется по земле любая колесная техника, вместо этого я возьму танк, и детальнейше разберусь в том, как он на гусеницах по болоту ездит. А живу я в городе, и на бездорожье не езжу".

aik Автор

Нет, не катит такая аналогия.

Либо сел и поехал, а что зеркал заднего вида нет — ну придумаю в пути что-нибудь.

Либо сперва надо собрать машину из горы деталей, а потому уже только ехать. Не забыв взять с собой все оставшиеся детали, потому что мало ли что.

ProFfeSsoRr

Так это вам кажется, что она не катит, и потому вы выбрали такой инструмент. А мне кажется, что аналогия как раз верная, и этим я попытался объяснить вам, что вы зря тратите свое время на эту штуку. Но т.к. время ваше - разумеется вы вольны тратить его любым способом на что вам хочется :)

aik Автор

Я уже «сел и поехал». Да, у unraid есть недостатки, но «зеркала» я прикручу по пути.

На базе бесплатного линукса же условно аналогичное по функциональности решение без глубокого закапывания в конфиги и cli — это только omv. Но там менее удобный gui, задачи на снапшоты и проверку массива в крон придётся запихивать руками, как там сделать кэш для массива — вообще непонятно c какой стороны подходить, bcache есть, но там чуть ли не на каждый диск в массиве по ссд требуют…

В общем, примерный аналог собрать можно и он даже поедет, но на это потрачу кучу времени и полной функциональности не получу. Так что я уж лучше заплачу и сразу начну пользоваться, решая вопросы использования, а не разработки.

denaspireone

proxmox backup

proxmox mail gateway

proxmox pve

если привыкли юзать windows — то конечно сложно прочитать мануалы и подключить это всё в одну связку, вопросов нет

aik Автор

Дома — совершенно не хочется. Хочется кнопку «сделай как надо».

Конечно, в Unraid такой кнопки тоже нет, но он для меня всё же ближе к ней, чем proxmox.

dalamber_sign

Для бэкапа что докеров, что VM есть плагины - CA Backup / Restore Appdata, VM Backup