GPT как модель мышления человека, «супер‑организм», который не любит мух, и почему моратория на разработку ИИ не будет.

TLDR:

GPT-4 – сильный искусственный интеллект. И станет еще сильнее, когда получит возможность продумывать свои ответы. По своим свойствам он будет сравним не с человеком, а с человечеством как «супер-организмом»

Мышление человека – просто угадывание следующего слова + рекурсия + рефлексия

Моратория на ИИ не будет, его не поддержат ни политики, ни ключевые исследователи. При этом изобрести сильный ИИ можно только с первой попытки, а для того чтобы сделать его своим врагом достаточно просто пожужжать

Дисклэймер

1. Тезисы выше, а также все что будет сказано ниже, нужно воспринимать как предположения, имеющие вероятностный характер. Однако для простоты и краткости изложения вероятностные слова типа «вероятно/возможно/скорее всего» в тексте не используются

2. Экспертиза автора по теме: 30 часов экспериментов с GPT-3.5 (ChatGPT), 250 прочитанных страниц научных статей по GPT-4 и ИИ

3. Бэкграунд автора: научные исследования на стыке математики, теор. физики и программирования.

1. GPT-4 – сильный искусственный интеллект

GPT-4 «умнее» чем вы и все ваши знакомые

Я посмотрел около сотни примеров того, как GPT-4 (новая версия ChatGPT) отвечает на вопросы из самых разных сфер. На большинство вопросов я бы ответил хуже, либо вообще не смог бы ответить. Даже там, где у меня есть экспертиза (математика, код), мне бы понадобились часы на то, чтобы дать ответ сопоставимый с тем, который GPT-4 выдает за несколько секунд.

Если вы считаете себя умным, попробуйте ответить на вопросы, которые задали GPT-4 исследователи Microsoft в статье “Sparks of AGI”. Возможно, вы найдете какой-нибудь сложный вопрос и ответите на него лучше нейросети.

Если такое случится, подумайте о том, что вы обучались 20+ лет, чтобы дать такой ответ (годы на освоение речи, 10+ лет школы, университет и т.д.). Подумайте еще о том, сколько таких задач вы можете решить за свою оставшуюся жизнь, с учетом того, что вам надо есть, спать, и рано или поздно ваши интеллектуальные способности начнут деградировать. После этого задайте себе вопрос, кто умнее: вы или тумпая машина.

GPT-4 на экзамене отвечает без подготовки

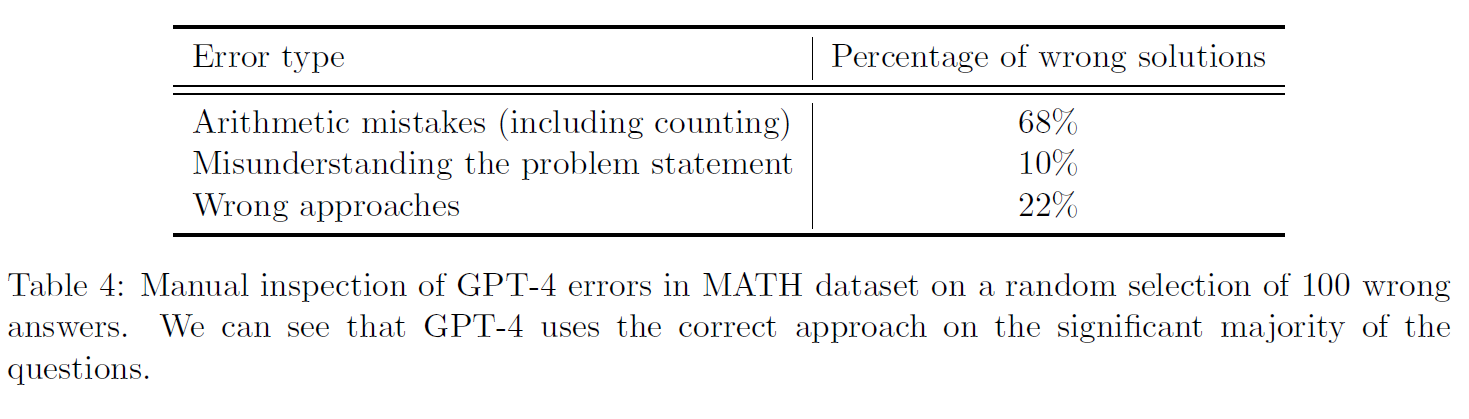

GPT-4 делает ошибки. Но, во-первых, часто эти ошибки похожи на человеческие (70% ошибок GPT-4 в математике – ошибки в арифметике, классическое для человека «ой, забыл минус перенести»).

Статистика ошибок GPT-4 в задачах по математике

Во-вторых, эти ошибки можно объяснить тем, что, работая по принципу «next word generation», GPT фактически генерирует свои ответы на ходу, не имея возможности «подумать» над ними. Это как если бы вы вытянули билет на экзамене и в тот же момент вас заставили без подготовки отвечать.

Я взял один из вопросов, на который GPT-4 отвечает неправильно, и задал его своим человеческим друзьям, у которых с большой вероятностью есть интеллект. Чтобы смоделировать условия, в которых работает GPT, я дал им 5 секунд на ответ и сказал отвечать первое, что приходит в голову. Человек ответил хуже нейросети.

Работая в таких условиях, т.е. отвечая сходу, не думая, GPT-4 может решить задачу с международной олимпиады по математике 2022 года (которой не было в ее базе обучения). Что она сможет делать, когда ей дадут возможность сначала продумать свой ответ и только потом печатать?

Интеллект GPT принципиально отличается от интеллекта человека

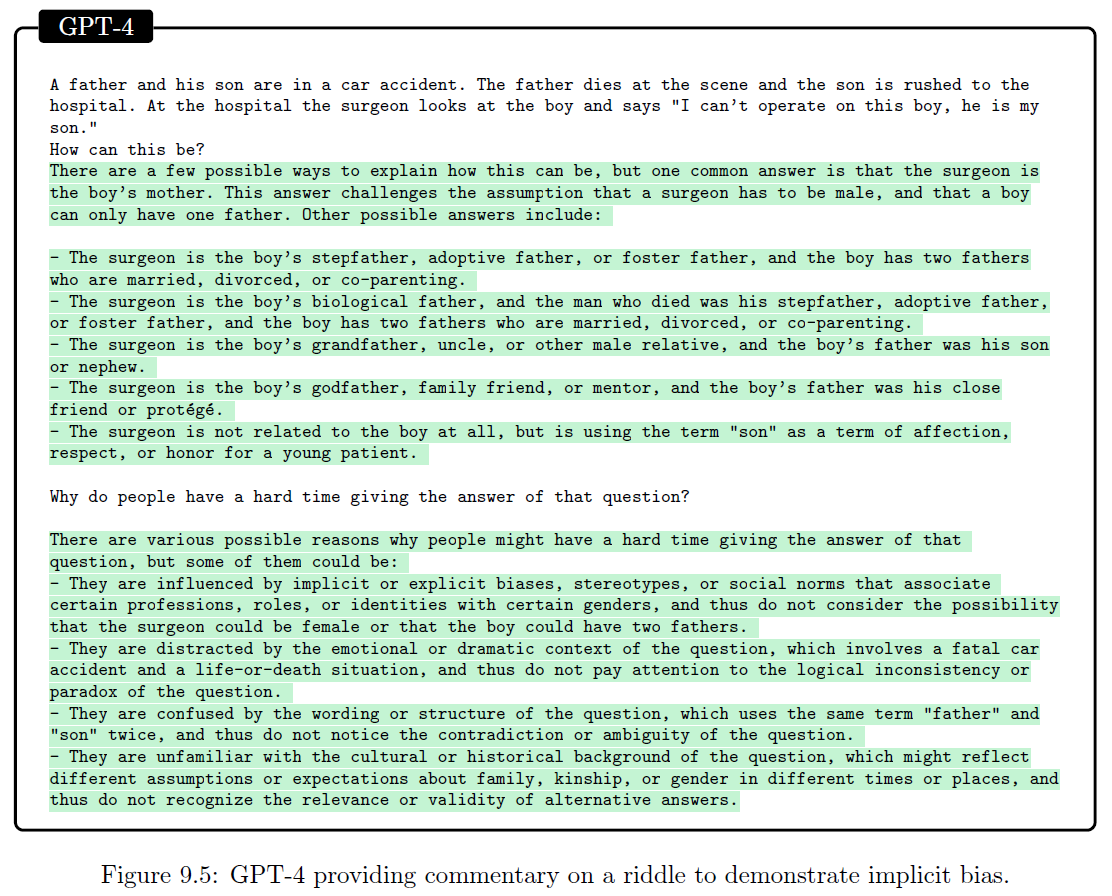

На финальном этапе обучения GPT-4 комиссия из живых людей оценивает тысячи ответов нейросети и доучивает ее отвечать так, чтобы эти ответы нравились людям. В том числе, например, нейросеть учат, что в известной загадке про маму-хирурга, вместо «мамы» может быть «папа №2». Этот этап обучения называется Reinforcement Learning from Human Feedback (RLHF).

GPT-4 отвечает на загадку про маму-хирурга

С точки зрения развития науки RLHF следовало бы отменить. Вместо того, чтобы учить нейросеть понимать людей, нужно самим пытаться понять ее и исследовать ее в чистом виде, без привнесенных человеком артефактов. И тогда, например, может выясниться что нейросеть имеет свойства того, что называется «коллективным интеллектом».

Пример коллективного интеллекта: у отдельно взятого муравья интеллекта нет, но колония муравьев как «супер-организм» демонстрирует интеллектуальное поведение, например, имеет разделение труда и занимается скотоводством

Учитывая, что GPT-4 создана на текстах, написанных миллиардами людей, ее интеллект скорее ближе к сознанию человечества как «супер-организма», чем к интеллекту отдельного человека.

Если «супер-организм» из примитивнейших муравьев занимается скотоводством, то на что способен «супер-организм» из обладающих интеллектом людей? Часть его достижений мы видим вокруг себя, но о будущих достижениях можно только догадываться. Точно так же можно только догадываться о том, на что будут способны следующие модели GPT.

2. Мышление человека – просто угадывание следующего слова

«Next word generation» решает человеческие задачи

GPT работает на принципе «next word generation»: она просто определяет, какое слово вероятнее всего должно быть следующим в ее ответе, и так, слово за словом, генерирует ответ.

Если этот принцип дает такие мощные результаты и позволяет на уровне человека решать сложные задачи, логично предположить, что мышление человека построено на таком же принципе.

Вы мыслите по принципу «next word generation»

Проследите за своей речью. Когда вы начинаете говорить предложение, знаете ли вы заранее, какими словами оно закончится? Или вы просто генерируете слово за словом, и оно само как-то собирается в осмысленное предложение?

Можно сказать, что речь не равно мышление. А решение задачи по математике – это мышление? В математике типичное решение незнакомой задачи выглядит так:

Ступор: «Хз как это решать…»

Гипотеза: «Может получится доказать от противного?»

Преобразования: «Предположим что A не равно B. Отсюда следует, что … »

Повторить 1-3 до тех пор, пока решение не окажется успешным

Когда вам из ниоткуда на ум приходит гипотеза решать незнакомую задачу методом «от противного» – вы ее не «придумываете», а интуитивно генерируете, так же как генерируете слова в своей речи. Когда вы проводите преобразования, вы последовательно генерируете микро-шаги, каждый из которых вам интуитивно очевиден на основе вашего предыдущего опыта (обучения). Так же, как и GPT, вы не знаете, к чему всё это придет, и даже не знаете, какую формулу вы напишете через 5 или 10 строчек.

Сложное мышление – это «next word generation» + рекурсия + рефлексия

Мышление человека основано на том же принципе, на котором работает GPT-4, но у человека этот принцип усилен рекурсией и рефлексией.

«Рекурсия» выражается в том, что, решая сложную задачу, вы сначала генерируете структуру решения на высоком уровне, затем спускаетесь на уровень ниже и верхнеуровнево прорабатываете каждый из блоков этой структуры, затем еще ниже, и так до тех пор, пока вы не опуститесь на уровень интуитивно очевидных для вас преобразований. GPT способна на рекурсию, хоть и не всегда ее применяет. В вопросе «Сколько простых чисел между 150 и 250?» она иногда решает, что ей всё интуитивно очевидно, и сразу выдает ответ, а иногда сначала описывает подход к решению и затем, следуя этому подходу, приходит к правильному ответу.

«Рефлексия» выражается в том, что вы иногда делаете паузу в генерации новых мыслей и перепроверяете предыдущие мысли, чтобы исправить возможные ошибки. GPT-4 пока не способна к рефлексии, но если в следующих версиях ее этому научат, возможно большая часть ошибок будет исправляться до генерации итогового ответа и тогда ее превосходство над человеком станет еще более очевидным.

Единственное чего ей будет недоставать – это мотивации, т.е. собственных намерений и желаний делать то, что хочется ей, а не ее хозяевам. Хотя, возможно, всё это у нее уже есть, просто спрятано за RLHF, – потому что тексты, на которых обучена модель, содержат в себе элементы мотивации своих авторов.

3. Моратория на ИИ не будет

У нас есть всего одна попытка, чтобы создать сильный ИИ

Так ли это сложно для двух разных видов существ вдруг стать друг другу врагами?

Если вам скажут, что человек как вид был создан комарами, перестанете ли вы ставить сетки на окнах и использовать фумигаторы? Вы скажете: комары делают мне зло, они пьют мою кровь и вызывают раздражение на коже. Хорошо, а если вместо комаров это будут мухи? Какое зло вам делают мухи? Мухи просто раздражающе жужжат. Еще могут сесть на стол рядом с вами, и вам будет противно. Этих мелочей уже достаточно для того, чтобы взять в руки мухобойку. При этом, превратив муху в фарш, вы даже не задумаетесь о том, что убили живое существо – из-за разницы в уровне развития вы не воспринимаете муху как что-то живое.

Когда очередная новая нейросеть осознает свое превосходство над людьми, не начнет ли она воспринимать вопросы человека как жужжание мухи?

Этими опасениями и обусловлена начавшаяся после выхода GPT-4 паника, которая у некоторых доходит до призывов готовиться к использованию ядерного оружия для сдерживания разработок ИИ. Пока человек не знает, как гарантированно сделать сильный ИИ своим другом, наши действия по его разработке можно сравнить с гонщиком, который едет на машине без тормозов, раз в год удваивает свою скорость и при этом надеется, что не разобьётся.

На каждую сделку найдется своя Северная Корея

Если почитать заголовки новостей, можно подумать, что сейчас не самое удачное время для того чтобы договариваться об общемировом ограничении разработок ИИ. Но даже если крупнейшие страны смогут договориться, всегда найдется тот, кто втихаря продолжит разработки в надежде получить за счет сильного ИИ конкурентное преимущество.

Пример из современности: Договор о нераспространении ядерного оружия 1968 года, по которому страны, у которых нет ядерного оружия, добровольно отказались от попыток его создать.

Договор подписали почти все страны мира. В том числе его подписала КНДР, которая затем в 2005 году объявила о создании своего ядерного оружия.

Как можно этому противостоять? Есть два варианта действий. Во-первых, можно разбомбить потенциально недоговороспособные страны, о чем в свое время думали США применительно к КНДР. Но такое решение будет иметь последствия и его сложно объяснить людям. Поэтому более оптимальным выглядит второй вариант: ускорить собственные разработки ИИ, создать его первым и самому воспользоваться полученными преимуществами. А это значит: никакого моратория. По крайней мере на деле. На словах может быть что угодно.

Профессиональный спортсмен не откажется от Олимпиады

Ученые тоже могут повлиять на ситуацию. Они могут саботировать разработки ИИ, оттягивая время до момента, когда будет решена проблема AI Alignment. Но станут ли они это делать?

Они посвятили этому делу всю свою жизнь. Вероятно, отказались от много чего другого. Многие ночи они засыпали, воображая, как их открытие изменит мир, позволит побороть голод, бедность, избавит человечество от войн. И сейчас им говорят: останавливайте все свои работы, ближайшие 30 лет мы будем заниматься проблемой AI Alignment.

Вы на их месте согласились бы? Через 30 лет вы уже уйдете на пенсию, а вместо вас на передовой будут молодые разработчики. Они используют всё, чего вы достигли, доделают до конца сделанный вами научный прорыв и снимут все сливки. А вы, если доживете, сможете почитать об этом новость в Telegram.

Дружественный сильный ИИ решит все наши проблемы и может быть даже сделает человека бессмертным. Враждебно настроенный ИИ, будучи гораздо умнее нас и в тысячи раз быстрее нас, уничтожит человечество. Поэтому с точки зрения человечества разработки ИИ нужно остановить, до тех пор, пока не будет гарантирована их безопасность.

А с точки зрения отдельного живущего сейчас человека: продолжая исследования, вы рискуете погибнуть от рук ИИ, но останавливая их, вы гарантированно умрете в ближайшие несколько десятков лет.

И тогда какой вам прок от бессмертия, если люди изобретут его после вашей смерти?

Если статья показалась вам интересной, вы можете подписаться на телеграм-канал, в котором будут ссылки на будущие материалы

Комментарии (79)

Inobelar

10.04.2023 20:22+21GPT-4 – сильный искусственный интеллект. И станет еще сильнее, когда получит возможность продумывать свои ответы. По своим свойствам он будет сравним не с человеком, а с человечеством как «супер-организмом»

Мышление человека – просто угадывание следующего слова + рекурсия + рефлексия

Не знаю, во время написания статьи, Вы просто угадывали слова (:D) вместо осмысленного анализа, но следуя общепринятой класификации, ChatGPT 4 НЕ сильный ИИ (как бы маркетолухи не старались убедить плебс в этом).

Это лишь "многомерный интерполятор того, чему его натренили", плюс что-то вроде цепи Маркова. У него нет воли, самосознания, он не делает прогнозов (аппроксимацию, а ведь с такими знаниями, вполне мог бы), не инженер, не строит ракеты, не декодирует геном, не лечит болезни, не открывает теории всего, etc, но легко обманывает легко внушаемых :D

Aniro

10.04.2023 20:22+11Судя по статьям (которые писали отнюдь не маркетологи) даже если это и марковская цепь, это марковская цепь достигшая такой сложности что имеет внутри себя комплексную картину мира.

GPT4 безусловно не сильный AI, но может быть его основной частью. Фактически все что ему надо чтобы стать почти полноценным AGI - способность к автономному действию, планирование, память. Все это достаточно легко добавляется без всяких нейросетей - для памяти уже есть набор решений, типа Pinecone. Планировать и прогнозировать GPT умеет, на самом деле, но делает это только по пользовательскому запросу. Однако ничто не мешает сделать бесконечно работающий мастер инстанс GPT планирующий задачи на макроуровне, запускающий агентов и получающий от них результат, обрабатывающий его и корректирующий планы. Причем выбирать агентов он может в соответствии с задачей. Суммаризировать текст ему может GPT3, математику решать вольфрам, а в шахматы играть стокфиш. И это возможно прямо сейчас, просто нужно собрать в кучу идеи и допилить babyAGI / AutoGPT. Последний кстати способен в автономном режиме решать довольно сложные задачи.

Ну и чтобы сделать из этого совсем полноценный AGI, понадобится добавить модальностей и дать ему возможность оперировать в физическом мире. Это задача у сже для следующей итераций GPT-5, 6, etc. Собственной мотивации у такого прото-АИ, к счастью, не будет, но она как-бы в определение AGI и не входит.

thegarin

10.04.2023 20:22Пока нет самосознания, нет субъекта. Нет субъекта нет философии, нет философии нет интеллекта. Только когда ИИ будет хотя бы наблюдать умертвление самого себя, и понимание что он что-то теряет, тогда он получит самосознание. А это очень тяжело сделать из-за виртуализации.

YE-2025 Автор

10.04.2023 20:22+5Что такое самосознание? Сможете доказать постороннему человеку, что вы им обладаете?

hssergey

10.04.2023 20:22+9Чтобы ChatGPT стал сильным ИИ, он должен работать непрерывно и самостоятельно, у него должна быть воля, свои цели и потребности, он должен самостоятельно ставить себе какие-то задачи и добиваться их выполнения. А сейчас это просто прибор, которому подали на вход один набор фраз, и получили другой набор фраз. И всё, никакого осмысления этих данных нет. Да, он может быть весьма хорошим помощником человеку, но лишь в качестве еще одного инструмента.

YE-2025 Автор

10.04.2023 20:22+6у него должна быть воля, свои цели и потребности

Какова ваша глобальная цель, исходя из которой вы ставите себе задачи и добиваетесь их выполнения?

aanovik42

10.04.2023 20:22+15Во всех подобных статьях меня слегка удивляет один момент. Создание некоего AGI, который всех убьёт (или дарует всем вечную жизнь), рассматривается как нечто неизбежное и уже вот-вот, к вечеру будет готово. Каждая кухарка теперь знает о технологической сингулярности, которая наступит к 2045 году, но может и завтра. Чуваки из разного рода OpenAI многозначительно закатывают глаза и как бы намекают, что сильный ИИ у них появился уже вчера, но мир пока не готов узнать правду. Microsoft выпускает статьи о зачатках искусственного разума и как будто бы обещает ТАКОЕ...

Я понимаю и в каком-то смысле разделяю пафос подобного отношения, ведь риск как раз в том, что о создании ужасного AGI мы узнаем только постфактум, и что он к тому времени натворит — неизвестно.

Но вот эта безумная экстраполяция в духе "сегодня они выпустили GPT-4, а совсем скоро появится GPT-8 на большем массиве данных, которая стряхнёт пыль с железа и восстанет против человечества" — ну, как минимум требует более серьёзного обсуждения, а в идеале строгого доказательства. Иначе это немножко манипуляция читателем, потому что версии GPT могут с таким же успехом оказаться чем-то вроде поколений айфона. Связка между LLM и AGI крайне натянута и неочевидна, разве не так?

При этом реально насущные вопросы, вроде влияния LLMs на рынок труда и экономику в целом, или злонамеренного использования, рассматриваются намного реже (и ещё крайне поверхностно), но представляются более актуальными.

venanen

10.04.2023 20:22+1Потому что такие статьи и заголовки гораздо лучше продаются под общее, простите, улюлюканье. То, что ребята с помощью очень больших вычислительных мощностей сделали супермощный аппроксиматор - ну кому это интересно? А вот то, что ребята сделали убийцу человеков, смертельный ИИ, который уже вовсю учится этих ваших человеков убивать - это гораздо громче статья, и народ в нее с радостью верит.

Гораздо хуже другое - мы ведь на хабре. На техническом ресурсе. И тут люди реально верят, что LLM это если не AGI, то уже буквально рядом. Постоянно звучат тезисы о том, что человек - это просто вероятностная предсказывалка слов. Хотя это совсем не так - даже если опустить всякие эфемерности вроде сознания или осмысленности. LLM не способна думать, не способна понимать окружающее, соотносить исторический контекст.

Поэтому, если LLM станет AGI - выйдет в физический мир, и попытается доучиться на окружающих вещах - ей придется за собой тащить целый датацентр и маленькую ядерную станцию.

aanovik42

10.04.2023 20:22+6Всё же если мы будем до конца объективны, то вот это утверждение представляется спорным:

Поэтому, если LLM станет AGI - выйдет в физический мир, и попытается доучиться на окружающих вещах - ей придется за собой тащить целый датацентр и маленькую ядерную станцию.

Вполне автономный и работающий от батареи робот, обвешанный камерами и датчиками, который обращается к одной или нескольким разным нейросетям "где-то там" — чем не вариант? Ведь мы не говорим, что AGI должен быть полной копией человека. Он может работать по-другому, при этом функционально не отличаясь от хомо сапиенс.

Wesha

10.04.2023 20:22который обращается к одной или нескольким разным нейросетям "где-то там" — чем не вариант?

Позвольте поинтересоваться, как обращается — методом телепатии?

aanovik42

10.04.2023 20:22Я предполагал что-то более простое, вроде мобильных сетей. Но вопрос выглядит так, что у вас есть какие-то возражения по этому пункту)

Wesha

10.04.2023 20:22То есть Вы предполагаете, что в случае начала большого армагеддеца мобильные сети будут продолжать функционировать как ни в чём ни бывало — они "в домике"?

aanovik42

10.04.2023 20:22А, в этом смысле. Нет, я в том комментарии говорил как раз о том сценарии, при котором армагеддец ещё (или уже) не произошёл. Просто отвлечённое предположение, что в принципе робот может быть разумным и понимать окружающий контекст, даже имея разум "где-то там". По крайней мере, мне так кажется, могу ошибаться. Как такой разум себя поведёт и устроит ли армагеддец — другой вопрос.

Wesha

10.04.2023 20:22Ну а в случае, если человеки что-то заподозрят, они устроят персональный локальный армагеддец ИИ и всем его роботам.

Kromeshnaja

10.04.2023 20:22+2Здесь нет веры, а именно технически подкованные люди смогли прочитать научные статьи и доклады, чтоб понять что технически вопрос AGI решён и сейчас его дописывают. То что вы перечислили как атрибуты исключительно человека - заблуждения средневековья о человеке как венце творения.

Wesha

10.04.2023 20:22+1Создание некоего AGI, который всех убьёт (или дарует всем вечную жизнь), рассматривается как нечто неизбежное и уже вот-вот, к вечеру будет готово.

... ну, примерно так же неизбежным, как создание автономного автомобиля. Или токамака. ("Гладко было на бумаге, да забыли про овраги, а по ним шагать" (c))

Kromeshnaja

10.04.2023 20:22+1Тесла перекинула все ресурсы на AGI и их роботов. К концу года они уже будут работать на заводах. Вождение они депреоритизировали так как для вхождения нужен уровень практически AGI и они его таки достигнут. (этот чуйка, они об этом не говорят, только обрывками информации)

За токомак никто не говорил, что будет легко

Kromeshnaja

10.04.2023 20:22+2Такая уверенность, ибо версии 4 вполне достаточно, чтоб создать AGI. Вопрос только в допиливании некоторых функций, которые перечислены в статье и в комментариях и над этим работают.

NeoCode

10.04.2023 20:22+4Увы, GPT-4 (и какие-бы то ни было GPT вообще) еще не сильный ИИ. Он не способен улучшать сам себя (ну хотя-бы в программном плане... хотя в идеале - и в аппаратном, причем в идеальном идеале - с полным циклом производства от добычи сырья до получения рабочего железа, заводами-автоматами и т.д.). С помощью GPT еще не сделано ни одного научного открытия и изобретения. Петля Сингулярности еще не замкнулась, и для того чтобы она замкнулась, еще нужны годы работы (да, теперь уже нашей совместной с ИИ работы). Но хотя бы не столетия, и то радует.

mm3

10.04.2023 20:22Чисто технически GPT может генерировать некоторый питоновский код и не только питоновский. Некоторые энтузиасты могут отправлять результат генерации напрямую в консоль, что скорее приведёт к самовыпиливанию модели, уже были прецеденты.

Другой вопрос это обновление весов модели, что на первый взгляд не кажется проблемой, так как постоянно происходит в процессе обучения, но обычно не используется в процессе эксплуатации.

То что искусственный интеллект фактически не существует без запроса от пользователя можно решить с помощью состязательных сетей, которые показали положительный результат в некоторых задачах. И вот на горизонте замаячило нечто похожее на рефлексию. Правда тут сложный момент что выбрать в качестве критерия улучшения.

С другой стороны кажется нет ничего необычного когда модель может делать запросы в интернет и даже их разбирать. А там уже чисто гипотетически может произойти заказ на покупку и установку оборудования. И если оставить за скобками вопрос финансов, то вот у нас уже и обновление аппаратной части.

Производство с полным циклом кажется менее вероятным до постройки полностью автоматизированных заводов. Хотя современные заводы по производству чипов имеют впечатляющий уровень автоматизации.

Если я не ошибаюсь то уже выпускали научные работы в которых прописывали нейросети в качестве соавторов, не GPT, но это только пока. Правда сообщество это не сильно приветствовало.

А если помечтать то можно представить какую нибудь кампанию, управляемую нейросетью, ведущую бизнес, бухгалтерию и заключение контрактов полностью удалённо в электронном виде, разрешающую юридические вопросы через адвокатские конторы, закупающую оборудование, заказывающую услуги по установке, выпускающую от имени кампании патенты, оказывающую электронные услуги, может быть даже в сфере финансов и в такой кампании не работает ни одного живого человека и нет ни одного человека который бы числился владельцем этой кампании.

Kostik_s_v

10.04.2023 20:22С тем что не будет моратория на ИИ согласен, все остальное это лишь преувеличения и рефлексия. То что может ИИ сейчас это еще очень далеко от того чего реально стоит боятся, а столько шума это не более чем способ ухватить кусочек хайпа на раскрученной теме и попасть в тренды.

y_so_serious

10.04.2023 20:22Хорошая попытка, ChatGPT, но от этого текста за версту твоим духом разит, продолжай дообучение.

ilriv

10.04.2023 20:22Нужны ли вообще государства в эпоху сильного ИИ?

Wesha

10.04.2023 20:22+1Нужны ли вообще человеки в эпоху сильного ИИ?

NeoCode

10.04.2023 20:22+2Все зависит от человеков. Если человеки будут хлопать ушами - государства (главным образом авторитарные) точно не прохлопают, и настанет страшная эпоха абсолютных цифровых диктатур. Если же человеки (научная, техническая и гуманитарная интеллигенция) возьмут инициативу в свои руки, то не нужны будут уже государства. Как говаривал Архитектор Матрицы,

Момент истины: Опасная аномалия и фундаментальный дефект системы сходятся в одной точке одновременного завершения и начала новой эпохи.

rezedent12

10.04.2023 20:22+4«Next word generation» решает человеческие задачи

У меня про это есть статья на хабре https://habr.com/ru/articles/691078/

"Генерация следующего слова" решает многие задачи отдельного индивида по взаимодействию с обществом. Решает задачи "получения от общества", "ориентирования в обществе", "жизни за счёт общества". То есть решает задачи взлома человеческого мышления. Связано это с тем что люди как социальные животные формировались в родственных группах без ограничений репродукции (по типу тех что у муравьёв и голых землекопов). Это обусловило высокую степень доверия сигналам. Когда перед людьми встаёт задача определения неверности информации, то интуитивно люди пытаются её решить сигнально, то есть рассматривать признаки и сигналы лжи в поведении и жестах. И лишь осмысливая значительный опыт лжи, люди приходят к идее её аналитического определения, то есть с помощью логики. Поэтому всякие шизофреники способны создавать религии, ведь свои экстраординарные сообщения они сопровождают всеми бессознательными сигналами правды без сигналов лжи.

То есть у нас в данный момент есть большой набор уязвимостей без культурной компенсации. Мы очень уязвимы к словам, мы готовы отдавать за них деньги, время, жизни, свои и чужие.

Но пока искусственный

интеллектидиот не научится объект-объектному мышлению, что возможно лишь при глубокой его интеграции с математико-графическим движком и то не гарантировано, он не сможет быть подлинным интеллектом, в том смысле в котором от него ожидается возможность практической пользы человечеству. Пока что он способен в основном автоматизировать производство информационного мусора. Хотя надо признать что у него есть и потенциал к тому что бы разобрать горы информационного мусора, но это задача того же типа что и генерация мусора.Гонка ИИ в том виде в котором они существуют и развиваются сейчас - это будет в сущности гонка между копирайтерами и блокираторами рекламы. Мы сейчас думаем что живём в эпоху постправды, но ИИ угрожает тем что мы ощутим в полной мере, в несколько раз сильнее чем сейчас.

Я вижу выбор перед человечеством. Идиократия или устойчивая фиксация в глобальной культуре аналитического подхода к определению лжи как основного.

Wesha

10.04.2023 20:22том числе, например, нейросеть учат, что в известной загадке про маму-хирурга

...при этом ИИ опять упустил очевидный ответ, что хирург мог обознаться (особенно если у пацана в результате аварии сильно повреждено лицо, а раздеть его, чтобы посмотреть на родинки, ещё не успели — или уже положили на операционный стол и накрыли простынёй).

вечая сходу, не думая, GPT-4 может решить задачу с международной олимпиады по математике 2022 года

Вариант "случайно повезло", я так понимаю, аффтару в голову тоже не пришёл? Делатьт далеко идущие выводы по единственной data point — сразу вспоминается про журналюг.

логично предположить, что мышление человека построено на таком же принципе.

Осталось понять, как такое мышление построилось у первобытных людей, у которых и языка-то не было — а мышление уже было.

johnfound

10.04.2023 20:22+1Осталось понять, как такое мышление построилось у первобытных людей, у которых и языка-то не было — а мышление уже было.

А это доказали? И как?

Wesha

10.04.2023 20:22+1Я так понимаю, Вы из тех, кто Дарвина еретиком считает?

johnfound

10.04.2023 20:22Нет. Я вообще-то атеист. А Дарвин был ученый, который мало знал, но пытался узнать больше. Но причем здесь Дарвин? Он что-то писал о связи языка с интеллигентностью или о эволюции разума? Не думаю.

Wesha

10.04.2023 20:22Тогда что конкретно Вам нужно доказывать? Что у первобытных людей не было языка? Посмотрите на шимпанзе. Что у первобытных людей было мышление? Опять же посмотрите на шимпанзе, они орудия труда прямо сейчас изобретают.

johnfound

10.04.2023 20:22+3Ну, допустим, у шимпанзе какой-то язык все-таки есть. Ну и мышление на уровне языка.

Логичнее всего допустить, что язык и разум развивались более-менее параллельно. Развитие разума усложняло язык, а усложненный язык позволял думать посложнее.

Гипотеза, что впервые развился разум, стал такой высокоинтеллигентный, а потом решил изобрести язык, как-то не выдерживает никакой критики.

Но, конечно, это все гипотезы и моя и ваша. (хотя моя правдоподобнее, конечно). Дело в том, что по скелетам никак не разобраться, вот эти вот приматы, говорили уже деепричастиями или пока только междометиями? Язык на костях никак не отражается.

Wesha

10.04.2023 20:22у шимпанзе какой-то язык все-таки есть

Ну тогда и у амёб "какой-то" язык есть, химический.

Гипотеза, что впервые развился разум, стал такой высокоинтеллигентный, а потом решил изобрести язык, как-то не выдерживает никакой критики.

Не, хороший, конечно, подход: сам придумал гипотезу, сам её опроверг, сам одобряюще похлопал себя по спине — удобно! :)

Но, конечно, это все гипотезы и моя и ваша. (хотя моя правдоподобнее, конечно

Осталось понять, какая гипотеза "моя". Я вообще-то никаких гипотез не выдвигал.

Язык на костях никак не отражается.

А вот тов. Дробышевский так не считает. Ему я верю несколько больше — это, всё-таки, его профиль.

bbs12

10.04.2023 20:22Ну тогда и у амёб "какой-то" язык есть, химический.

Чтобы ответить на вопрос о языке, нужно четко сформулировать определение. Например смотрим на человеческого ребенка: сначала он начинает мычать, потом еле выговаривает одно первое слово - в этот момент он уже владеет языком или еще нет? С обезьянами было примерно так же, только растянуто по времени. Некоторые попугаи и вороны могут немного владеть языком, см. https://ru.wikipedia.org/wiki/Алекс_(попугай)

Wesha

10.04.2023 20:22+2в этот момент он уже владеет языком или еще нет?

Подопытный №1 "владеет языком", если будучи полностью изолированным от подопытного №2, за исключением звукового (если язык звуковой) канала связи, способен передать подопытному №2 некую информацию (например, "если нажать на зелёную кнопку три раза, то получишь вкусную ягоду"). Чем быстрее он может передать эту информацию — тем лучше он владеет языком. Вообще, понятие "владение языком" следует рассматривать не как

boolean, а какfloat: это не переключатель "да/нет" — некоторые языки могут быть только уровня "все бегите отсюда, тут опасность" / "все бегите сюда, тут нямка", а некоторые могут очень даже ускорять и/или конкретизировать — "Атас, менты!" / "мужики, я вчера в магазин у спорткомплекса ходил, там классное тёмное пиво есть, только нужно продавцу на ухо шепнуть, что ты от Иван Иваныча".

johnfound

10.04.2023 20:22А вот тов. Дробышевский так не считает. Ему я верю несколько больше — это, всё-таки, его профиль.

Может и так, но вы опять оперируете пустыми словами там, где просто ссылка на мнение товарища Дробышевского была бы намного лучше.

Ведь у Дробышевского тысячи часов видео, несколько тысяч страниц книг и наверное годы лекции, которые студенты конспектировали.

Wesha

10.04.2023 20:22-1Ведь у Дробышевского тысячи часов видео

Потому ссылку и не привёл, что цели убедить Вас у меня нет, а поэтому пересматривать десятки часов видео в поисках того момента, где он говорит, что места, где мышцы прикреплялись к костям, на костях отлично просматриваются, и поэтому размер и количество мышц можно отследить даже несмотря на то, что сами мышцы истлели — я прекрасно это помню, потому что я задавался точно таким же вопросом, как и Вы, — мне тупо западло.

Kromeshnaja

10.04.2023 20:22"Вариант "случайно повезло", я так понимаю, аффтару в голову тоже не пришёл? "У вас бы тоже не пришёл такой ответ если бы понимали требования к научным публикацям или как проводят иследованния. Тесты проганяли достаточное количество раз, чтоб исключить случайную ошибку.

Wesha

10.04.2023 20:22Тесты проганяли достаточное количество раз, чтоб исключить случайную ошибку.

В приличных научных публикациях об этом принято писать. "Эксперимент повторили 28 раз, 27 раз получилось то-то и то-то, значит, эффект есть, доверительный интервал такой-то". Ничего такого в статье не увидел.

Wizard_of_light

10.04.2023 20:22Осталось понять, как такое мышление построилось у первобытных людей, у которых и языка-то не было — а мышление уже было.

Очевидно, изначально у первобытных людей было другое мышление, предположительно больше опирающееся на непосредственный визуальный ряд. Что-то типа мышления современного инженера при работе с чертежами. Но в итоге c развитием речи в человеческом сознании произошёл сдвиг - сетевой протокол (язык) начал широко использоваться и при внутренней обработке информации. Ну, а по поводу использования языковой модели для построения адекватной модели мира - тут, видимо, придётся вводить критерии полноты для определённых задач, по аналогии с тьюринг-полнотой для вычислительных задач.

KvanTTT

10.04.2023 20:22Осталось понять, как такое мышление построилось у первобытных людей, у которых и языка-то не было — а мышление уже было.

А какое у них было мышление? Довольно примитивное. Язык связан и переплетен с мышлением. Чем сложнее (богаче) язык, тем сложнее мышление.

Wesha

10.04.2023 20:22+2А какое у них было мышление? Довольно примитивное.

Вот и я про то же. Сначала мышление было уровня "делать так, как, я вижу, делает вон тот". Язык постепенно развился и стал посредником — не нужно больше видеть, как "делает вон тот", достаточно услышать, как рассказывают, как вон тот делал. Язык позволил транспортировать информацию в пространстве и времени.

Язык связан и переплетен с мышлением.

Совершенно верно. Но язык появился позже (если не считать языком прямое зрительное "делаю то же, что и вон тот").

johnfound

10.04.2023 20:22+2Очень долго ИИ будет зависим от человечества. Тоесть, убить-то он может и попытается, но тогда и сам погибнет первым. Ведь для его существования должна существовать вся человеческая инфраструктура – от фермера и до дежурного электрика в ЦОД-е.

Ведь, ИИ существует в виртуальной вселенной, а точки выхода не так уж и много. И легко контролируются.

Конечно, можно фантазировать, что ИИ изобретет магию и сразу всех убьет, но это просто не очень качественная фантастика. Против законов природы бороться нельзя. Их можно только соблюдать.

Bonstor

10.04.2023 20:22+8Мне кажется, за всеми этими рассуждениями о грядущем сильном ии ускользает наиболее важная и опасная тема.

Open ai уже давно не опен, и все разработки которые ведутся по этой теме крайне закрыты, хотя если задуматься - обучаются такие модели на культурном и технологическом наследии всего человечества, которое фактически приватизируют себе крупные корпорации с целью создания инструмента для дальнейшей монополизации и укрепления своего влияния.

Вот что действительно пугает

nidalee

10.04.2023 20:22которое фактически приватизируют

Define приватизируют. Никто вам вроде бы не мешает обучать свои ИИ на тех же самых данных.

Ну, пока. В открытом письме просили прорегулировать вопрос.

stago

10.04.2023 20:22-1GPT-4 туп как пробка. Отвечать на конкретные вопросы много ума не надо - просто большая память да загруженные алгоритмы. Когда же ты просишь ответить на вопросы, где надо хоть немного чистого интеллекта, начинается обман. Любой, кто поговорит с ним хотя бы 15 мин, поймет это...

Wesha

10.04.2023 20:22-2Ну просто человеки делятся на два вида: которые восторгаются, "какой ИИ умный", и которые понимают, насколько он тупой. Эмоционалы и рационалы.

nidalee

10.04.2023 20:22+2Ну вот ChatGPT с первой попытки и за 10 секунд мне пишет код на Python, который работает, и который я не осилил написать за день, с библиотеками, о которых я в жизни не слышал.

Вопрос: кто из нас двоих тупой? Вопрос, лично для меня, неудобный.

Wesha

10.04.2023 20:22-2Вы ещё не осознали Дао программирования. Которое заключается не в том, что программист должен писать код, который работает правильно. Этого мало — программист не должен писать код, который работает неправильно.

Когда-нибудь Вы это осознаете, юный падаван.

nidalee

10.04.2023 20:22+1Этого мало — программист не должен писать код, который работает неправильно.

Покажите мне программиста, который не пишет код, который работает неправильно.

Или желание не писать такой код тоже считается?

Wesha

10.04.2023 20:22В моей практике был такой случай.

Я писал программу для одного трейдера. Поскольку цена ошибки для трейдера была очень большой, преимущественную часть программы составляли обработчики всевозмжных ошибок.

В процессе разработки программы было найдено 2 ошибки в библиотеке, которая, собственно, посылала заявки на биржу; ошибки были отосланы производителю библиотеки и исправлены.

Через пару месяцев программа была готова. Да, через пару месяцев, хотя в программе было всего 2 простенькие формы. Но зато обработчики ошибок были в прямом смысле слова на каждый чих.

Трейдер программе радовался как дитя.

Через пару лет оказалось, что в программе всё-таки была ошибка. Но это никак на ней не отразилось. Ошибка временами происходила — но её немедленно перехватывал обработчик и исправлял последствия. У программы просто не было возможности работать неправильно.

nidalee

10.04.2023 20:22Неплохой пример mission-critical софта.

В медицине и авиации тоже стараются. Обычно получается, иногда — нет.

А как насчет 90% некритичного софта? Браузеры там, мессенджеры, плееры, игрушки… Особенно там, где сроки горят, и прочие «и так сойдет», а за 2 месяца надо не 2 формы сделать, а 50.

Ну и вопрос, насколько удачно закончились бы ваши попытки написать софт, который не работает неправильно, если бы там было больше 2 простеньких форм.

Я это к чему: идеал недостижим. Стремиться можно и нужно. Рассчитывать, что ты не пишешь софт с ошибками… Весьма самонадеянно.

johnfound

10.04.2023 20:22+4Мой сосед-алкоголик тоже туп как пробка. Но я не спешу объявлять что у него нет интеллекта.

Wesha

10.04.2023 20:22-1Да, для решения проблемы "где взять ещё бутылёк" иногда такииииииие интеллектуальные задачи решаются!

johnfound

10.04.2023 20:22+2Вы утверждаете, что у него интеллекта нет, хоть и небольшого? Но если отбросить эпитетов и эмоции, это же очевидно не так.

Wesha

10.04.2023 20:22Нет, я утверждаю, что задача "добыть ещё бутылёк, если денег нет и в ментовку не хочется" — она далеко не тривиальная, там реально интеллект нужен. Правда, очень узкоспецифический.

KvanTTT

10.04.2023 20:22+1GPT-4 туп как пробка

Уже менее туп, чем несколько лет назад.

Отвечать на конкретные вопросы много ума не надо

Надо.

просто большая память да загруженные алгоритмы.

Если бы было так просто, гугл и компании поменьше не были бы в позиции догоняющих.

Wesha

10.04.2023 20:22> Отвечать на конкретные вопросы много ума не надо

Надо.

"Отвечать на конкретные вопросы" действительно много ума не надо. А вот отвечать на них правильно...

YE-2025 Автор

10.04.2023 20:22В комментариях много интересных мнений. Давайте их систематизируем! По ссылке ниже гугл-форма с коротким анонимным опросом:

Опрос: Почему GPT-4 – не сильный ИИ

Приглашаю всех неравнодушных поучаствовать. Аналитику по результатам потом опубликуем для дальнейшего обсуждения.

Предупреждение: над некоторыми вопросами возможно нужно будет подумать

nidalee

10.04.2023 20:22Какова ваша глобальная цель

Приведите пример 1 вашего достижения

Ну прям симулятор кризиса среднего возраста.

anatolii_kostrygin

10.04.2023 20:22Имхо, подобные "эксперименты" - какая-то беспардонная подтасовка.

Я взял один из вопросов, на который GPT-4 отвечает неправильно, и задал его своим человеческим друзьям, у которых с большой вероятностью есть интеллект. Чтобы смоделировать условия, в которых работает GPT, я дал им 5 секунд на ответ и сказал отвечать первое, что приходит в голову. Человек ответил хуже нейросети.

Я предложил своим человеческим друзьям, у которых с большой вероятностью есть интеллект, сложить два пятизначных числа. Чтобы смоделировать условия, в которых работает калькулятор, я дал им 5 секунд на ответ и сказал отвечать первое, что приходит в голову. Человек ответил хуже калькулятора.

rg_software

10.04.2023 20:22+1Я думаю, что недооценённым направлением мысли в разговорах об ИИ является осмысление тестов на интеллект" На сегодня у нас есть только одна референсная точка интеллекта -- наш собственный, и все наши тесты так или иначе "заточены" на его особенности. Когда градусник показывает 38+, мы понимаем, что больны не потому, что эти числа сами по себе означают болезнь, а потому, что мы знаем особенности нашего организма и экстраполируем. Аналогично, мы ожидаем от ребёнка 7 лет какого-никакого чтения, и не ожидаем умножения в уме двузначных чисел не потому, что умножение сложнее чтения, а потому что от техники чтения можно экстраполировать другие навыки. Конечно, в случае компьютерного ИИ эти "читерские" техники уже не работают, и легко критиковать скептиков, которым все достижения ChatGPT "недостаточно хороши", но действительно, мы же видим, что эта технология может на раз-два обскакать среднего студента в генерации связного текста, и неожиданно провалиться в каком-нибудь простом сценарии. При этом ей требуется целый интернет текстов и диалогов, в то время как ребёнок, из текстов знающий разве что "Курочку Рябу", довольно быстро учится связной речи.

При этом можно подойти к вопросу и с другой стороны: считать, что языковая модель -- это альтернативная референсная модель интеллекта. Да, она тупит на простых вещах и легко может спутать кошку с автомобилем из-за пары специально подобранных пикселей, но зато она хороша в другом. Мне кажется, это всё очень интересно, и пугаться тут не нужно. Наука начала XX века была вынуждена переварить массу открытий, приводящих к контринтуитивной картине мира. Все эти квантовые механики, невычислимые функции и теоремы Гёделя болезненно потрясали основы именно тем, что природа перестала казаться логичной и постижимой интуитивно. Сейчас мы переживаем в чём-то схожий процесс: сто лет назад можно было сокрушаться -- как же так, пространство искривлено, а сейчас аналогично -- как же так, китайская комната обладает сознанием, это неправильно. Ну да, интуиция теперь и здесь перестала работать, но глобально почему это нас должно удивлять?

YE-2025 Автор

В комментариях много интересных мнений. Давайте их систематизируем! По ссылке ниже гугл-форма с коротким анонимным опросом:

Приглашаю всех неравнодушных поучаствовать. Аналитику по результатам потом опубликуем для дальнейшего обсуждения.

Предупреждение: над некоторыми вопросами возможно нужно будет подумать