Технологии искусственного интеллекта активно развиваются и всё больше входят в нашу жизнь. Появление моделей уровня ChatGPT продемонстрировало огромные возможности современного ИИ уже сегодня, вызвав эффект разорвавшейся бомбы.

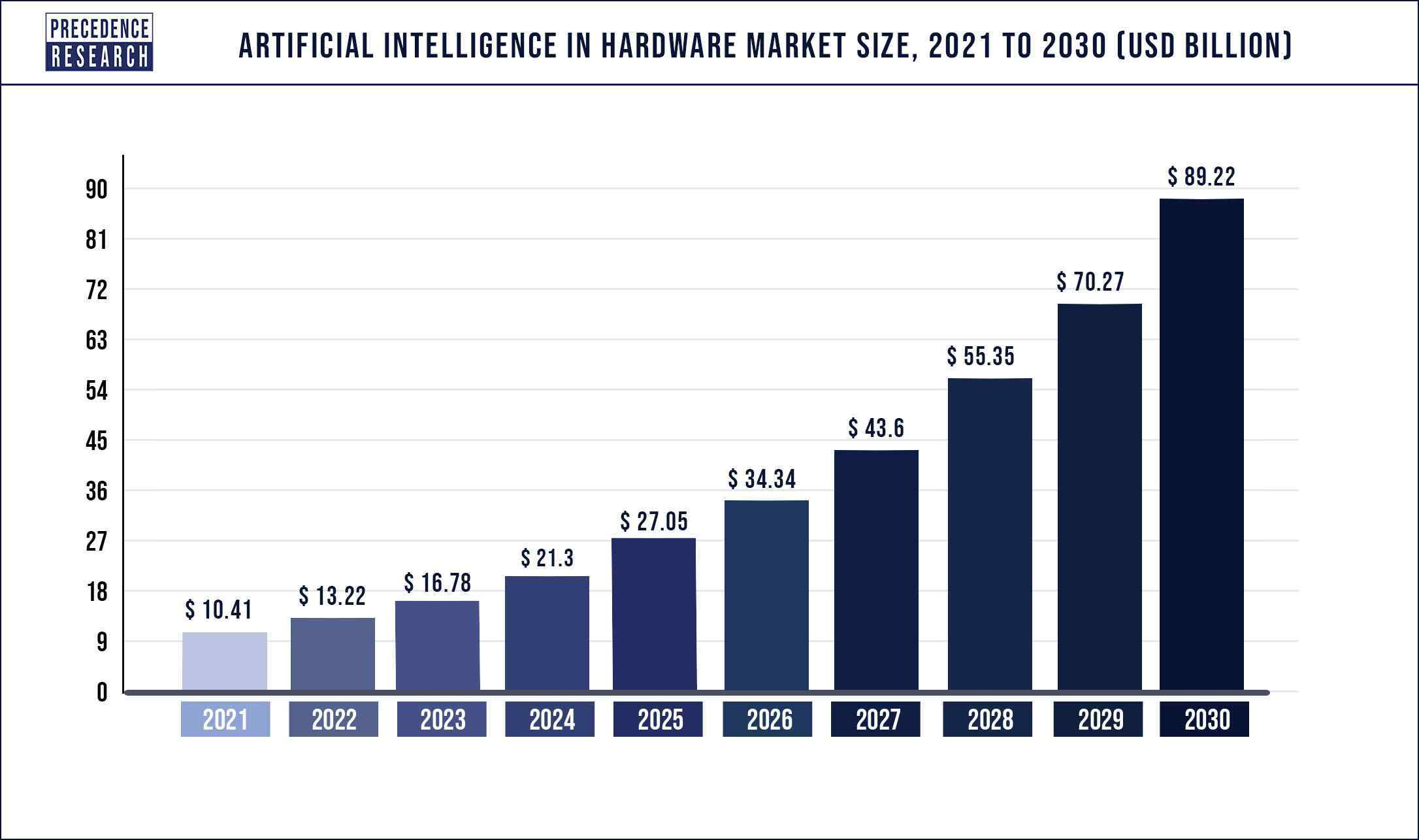

Но применение и развитие технологий искусственного интеллекта невозможно без специализированного аппаратного обеспечения. Доступ к такому оборудованию определяет принципиальную возможность участвовать в конкурентной гонке по разработке технологий искусственного интеллекта как на уровне отдельных компаний, так и для государств в целом. Поэтому потребности в железе растут, а в отрасль вливаются огромные деньги. Прогнозы по размерам и перспективам роста рынка AI Hardware есть разные, но в среднем они выглядят примерно так:

В данной статье мы попытаемся сделать краткий обзор состояния индустрии разработки аппаратного обеспечения для искусственного интеллекта, причём мы рассмотрим не только передовые решения сами по себе, но и как они распределены географически по регионам.

Сейчас во всём мире существуют сотни компаний, создающих устройства для искусственного интеллекта. Разобрать их все невозможно, поэтому мы сконцентрируемся на наиболее значимых или интересных разработках (по мнению автора, конечно же). Стоит отметить, что количество различных характеристик, ниш, применений AI Hardware огромно, и во многих случаях нельзя сравнивать решения напрямую. Поэтому в данном материале мы постараемся по возможности абстрагироваться от каких-либо сравнений и оценок, кроме тех случаев, где это будет уместно, и просто дать общее описание текущих флагманских продуктов. Также необходимо иметь в виду, что многие характеристики, декларируемые производителями или собранные по открытым материалам, могут быть «плавающими» и отличаться в разных источниках. Поэтому данный обзор может содержать определённые неточности такого рода, но принципиально картину они не изменят.

Перед тем, как приступить к обзору, уточню несколько моментов:

Все решения для AI можно грубо разделить на 2 класса: предназначенные для обучения нейросетей (training) и предназначенные для работы с уже обученной моделью в реальных применениях (inference). «Железо» может быть специализированным как для решения какого-то одного класса задач (training или inference), так может быть универсальным и применяться в обоих случаях (training и inference).

Обучение нейросетей (training) существенно более ёмко в плане вычислений и требует поддержки форматов данных с более высокой точностью, как правило используются вещественные float32 и float16. Для inference-задач зачастую достаточно меньшего размера данных и как правило применяется целочисленный 8-ми битный формат int8 (и даже бывает int4 или int1).

Также очень важным параметром является размер различных кэшей, расположенных непосредственно на чипе. Это связано с тем, что доступ к ним по сравнению с обращением в память быстрее на порядок. В случае нехватки внутренних кэшей для размещения постоянно используемых данных (например, весов используемых моделей), производительность AI-чипа может падать драматически. В этом случае требуются различные нетривиальные аппаратные и программные трюки, чтобы каким-то образом должны решить эту проблему (что не всегда возможно). Поэтому примерный размер внутренних кэшей под общим наименованием SRAM, по возможности, также будет указываться.

США/Канада/Европа/Израиль

1. Nvidia

Любой обзор такого рода по праву начинается с компании Nvidia. Это компания, которая во многом была «матерью» текущего AI-бума, разработав универсальную архитектуру GPU и огромную программную экосистему, основанную на CUDA, позволивших эксплуатировать вычислительную мощь множества параллельных вычислителей для задач искусственного интеллекта. Nvidia является не просто лидером отрасли, а фактически монополистом в определённых нишах аппаратных AI-решений. О доминирующей роли и оценках перспектив Nvidia говорит тот факт, что это первая компания из полупроводниковой индустрии, достигшая оценки в 1 трлн долларов (на данный момент $1.162 трлн). Передовые решения от IT-гиганта запрещены для экспорта не только в Россию, но и в Китай. Таким образом правительство США подчёркивает важность доступа к технологиям такого уровня в гонке за искусственным интеллектом.

Самым новым и производительным решением компании на данный момент является карта NVIDIA H100 со следующими характеристиками:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Nvidia H100 |

5nm |

700 |

116 |

67 |

989 |

1979 |

3958 |

Как видно, Nvidia H100 является универсальной картой, и может применяться как для training, так и для inference задач.

2. AMD

AMD – главный конкурент Nvidia на рынке GPU, и было бы странным, если бы они не попытались представить свои решения для искусственного интеллекта. Разумеется, это произошло: самым последним флагманом стала карта AMD MI300 со следующими показателями:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

AMD MI300 |

5nm |

600 |

|

297 |

|

1187 |

4750 |

В общем-то, данное решение является прямым конкурентом Nvidia H100 и на бумаге по «терафлопсам» его даже превосходит. Проблема в том, что любое аппаратное решение, во-первых, это набор компромиссов, где сами по себе попугаи «терафлопсов» ещё ни о чём не говорят. А во-вторых, любое аппаратное решение тесно завязано на программную экосистему, которая должна помочь конечному пользователю извлечь всю мощь из предоставленного железа. И если по первому пункту требуется сложный разбор всех деталей внутренней имплементации AMD MI300, чтобы сравнить, насколько данная карта лучше или хуже Nvidia H100, то со вторым пунктом всё понятно – Nvidia, первая вскочившая на подножку летящего поезда AI, создала развитую программную экосистему, и в этой части компания AMD существенно отстаёт. Что, по всей видимости, является главной причиной куда меньшего успеха решений от AMD на текущий момент.

3. Cerebras

На третье место в обзоре я посмею поставить компанию Cerebras.

Почему я котирую Cerebras так высоко? Есть две причины. Дело в том, что огромное количество появившихся стартапов и проектов по разработке AI-чипов должны решить первую задачу – разработать конкурентное решение, которое будет лучше, чем Nvidia (как минимум в какой-то нише), и вторую – построить дальше успешный бизнес.

Вторая задача нерешаема без первой, и вот тут кроется нюанс. Дело в том, что при ближайшем рассмотрении преимущества предлагаемых подходов во многих случаях выглядят крайне сомнительно и непонятно, смогут ли новички на рынке AI Hardware предоставить что-то такое, ради чего клиенты действительно захотят слезть с инфраструктуры той же Nvidia. Но как раз компания Cerebras имеет чёткое и очевидное преимущество – они создают чипы размером с пластину. Обычная технология производства чипов ограничена размером 33х26 мм, т.е. имеет теоретический предел в 858 мм2 по площади. Cerebras же разработала специальную технологию, позволяющую, по сути, преодолевать это ограничение и создавать чипы размером в 46225 мм2. Это понятное конкурентное преимущество приводит к тому, что финансовые дела у компании идут очень неплохо, и размер анонсированных продаж уже идёт на миллиарды долларов.

Буквально на днях прошла новость о том, что Cerebras поставит 4-х экзафлопное решение для компании из Абу-Даби G42.

Собственно, так выглядят характеристики чипа WSE-2 от Cerebras:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Cerebras WSE-2 |

7 nm |

20000 |

40000 |

|

|

62 000? |

|

4. Google

Google была пионером в разработке специализированного железа для искусственного интеллекта. Первая версия их Google TPU v1 вышла ещё в 2016-ом году. Но так как политика компании подразумевает только внутреннее использование этих чипов, то наружу они не продаются и информации о них немного. На текущий момент, по всей видимости, существует уже пятая версия Google TPU v5, но никаких данных о характеристиках данного решения я в публичном доступе не нашёл. Поэтому привожу данные для Google TPU v4 от 2021-го года:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

BF16, TFLOPS |

INT8, TOPS |

Google TPU v4 |

7 nm |

450? |

160 |

|

|

275 |

275 |

5. Intel

Безусловно, полупроводниковый гигант из Орегона не мог остаться в стороне от борьбы за свою долю пирога бурно развивающегося рынка AI Hardware. Как подобает поступать большим компаниям в таком случае, срочно были куплены несколько молодых стартапов. Приобретение Nervana, Habana Labs, Mobileye, Movidius было призвано сократить отставание от конкурентов и получить компетенции уже готовых команд. Несмотря на миллиардные вложения, пока политику компании Intel в данном направлении сложно назвать особо успешной. Более-менее уверенно себя чувствует направление по разработке специализированных решений для автономного транспорта, основанное на бизнесе приобретенного Mobileye. В конкуренции же с классическими решениями от Nvidia/AMD пока огромное отставание. Самым передовым решением от компании Intel на данный момент является карта Intel GPU Max 1550 со следующими характеристиками:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Intel GPU Max 1550 |

5-7 nm |

600 |

546 |

|

52 |

839 |

1678 |

6. Esperanto

Наверное, компания Esperanto не заслуживает пока столь высокой позиции, но здесь играют личные предпочтения – автор проработал в ней больше 4-х лет. Итак, Esperanto из Калифорнии, основанная легендарным Дейвом Дитцелем, предлагает своё решение для AI, базирующееся на использовании большого количества RISC-V ядер. Основная «фишка» чипа ET-SoC-1 – низкое энергопотребление и высокие характеристики производительности на ватт. Набор инженерных решений, примененных при разработке, позволяет втиснуть в 20-ваттный пакет впечатляющую вычислительную мощность. Причём это решение, несмотря на позиционирование в нишу низкопотребляющих устройств (что свойственно для специализированных inference-решений), способно выполнять обучение сетей, имея поддержку необходимых для этого форматов данных. Вот характеристики ET-SoC-1:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Esperanto ET-SoC-1 |

7 nm |

20 |

150 |

|

17.5 |

35 |

140 |

7. Tenstorrent

Следующим идёт канадский стартап Tenstorrent под руководством Джима Келлера – другой легенды полупроводниковой индустрии. С его работой связывают создание микроархитектуры Zen и последующие успехи AMD в борьбе с Intel. В 2020-ом году, имея за плечами опыт работы в Apple, AMD, Tesla и Intel, ветеран индустрии решил присоединиться к основанному в 2016-ом году Tenstorrent сначала в роли CTO, а в 2023-ем году занял должность CEO. Компания также делает ставку на экосистему RISC-V, создавая не только линейку AI-чипов, но и обычных CPU на базе архитектуры RISC-V. У компании агрессивный роадмап, и с 2021-ого года они планировали выпускать по новой версии чипа каждый год. Версии 2022-го и 2023-го годов на презентациях выглядят примерно вот так:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Tenstorrent Wormhole |

12 nm |

180 |

|

|

|

|

350 |

8. Tesla

Как в такой гонке могло обойтись без Илона нашего Маска? Никак. Tesla, являясь лидером в разработке систем для автономного транспорта, также разрабатывает своё железо для AI. В своих решениях компания делает большой акцент на коммуникации и масштабируемости, что безусловно имеет большой смысл, но данная тема выходит за узкие рамки данного обзора. Поэтому просто представляем характеристики непосредственно самого чипа Tesla Dojo D1:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

BF16, TFLOPS |

INT8, TOPS |

Tesla Dojo D1 |

7 nm |

400 |

440 |

|

22 |

362 |

|

9. Graphcore

Единственный представитель Европы (в её географическом определении) – британская компания Graphcore. Сложно сказать что-то особенное про её решения. На картинках чип от Graphcore выглядит достаточно банально – много ALU, много кэша, что ещё нужно? Не очень понятно, за счёт каких архитектурных или других особенностей Graphcore собирается конкурировать с другими компаниями. Характеристики их передового Graphcore Mk3 Bow:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Graphcore Mk3 Bow |

7 nm |

300 |

897 |

|

87 |

349 |

697 |

10. Groq

Американская компания Groq основана выходцами из Google, работавшими над Google TPU. Поэтому неудивительно, что идейно чип напоминает Google TPU. С другой стороны, декларируются отличия, которые по задумке основателей стартапа, должны дать преимущество над конкурентами. Без глубокого погружения в детали тут сложно сказать, насколько мнение основателей обосновано, но полученные $362 млн финансирования позволяют им уверенно смотреть в будущее. Характеристики GroqChip ниже:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

GroqChip |

14 nm |

215 |

230 |

|

|

188 |

750 |

11. SambaNova

Калифорнийский стартап Sambanova знаменит тем, что получил наибольшее финансирование среди AI Hardware стартапов – целых $1,1 миллиард долларов! Парадоксально, что при этом по нему доступно, наверное, наименьшее количество технической информации о том, каким образом они собираются подвинуть титанов полупроводниковой индустрии с Олимпа. Из имеющейся в открытом доступе информации можно заключить, что они пытаются реализовать в чипе Dataflow-подход. Характеристики их лучшего на данный момент чипа Cardinal SN30 следующие:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

BF16, TFLOPS |

INT8, TOPS |

Sambanova Cardinal SN30 |

7 nm |

|

640 |

|

|

618 |

|

12. Hailo

Израильские стартапы активно участвуют в борьбе за разработку перспективных AI-решений. Вышеупомянутые Habana Labs и Mobileye, приобретённые Intel, являлись израильскими компаниями. И в целом, в Израиле наблюдается бум «железных» стартапов, поэтому было бы несправедливо не включить в наш обзор представителя страны, которая по активности и насыщенности разработок уступает разве что мастодонтам в лице Китая и США. В нашем обзоре честь Земли Обетованной будет защищать стартап Hailo со своим специализированным решением для компьютерного зрения Hailo-8 AI Processor:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Hailo-8 AI |

16 nm |

8 |

|

|

|

|

26 |

Китай

Важность развития индустрии железа для AI в Китае осознаётся на всех уровнях, включая самый высокий – государственный. Огромные финансовые вливания как со стороны государства, так и со стороны частных фондов и компаний приводят к бурному росту различных стартапов в области разработки AI Hardware. Не остаются в стороне и гиганты уровня Huawei. Но традиционная закрытость и изолированность Китая, создаёт много трудностей в сборе информации об актуальной ситуации. Тем не менее, мне хотелось бы остановиться на 3-х компаниях, информация о которых хорошо доступна и решения которых выглядят вполне конкурентно на данный момент.

1. Biren

Biren была основана 2019 году выходцами из Nvidia и Alibaba и уже через 3 года представила решение, которое в таблицах сравнивалось сразу с GPGPU уровня Nvidia A100/H100. Впечатляющий результат для стартапа, существующего всего 3 года! Такой прогресс был по достоинству оценён государственным департаментом США и в октябре 2022 года компания попала под ограничительные санкции, не позволяющие Biren использовать TSMC в качестве фабрики, что в нынешних условиях фактически означает невозможность производства чипа такого уровня в принципе. С тех пор будущее Biren оказалось в подвешенном состоянии и менеджмент предпринимает попытки выйти из сложившейся ситуации каким-либо образом. Вдаваться в проблемы китайско-американских отношений дальше мы не будем, а просто приведём характеристики самого передового чиплетного решения под именем BR100:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

BF16, TFLOPS |

INT8, TOPS |

Biren BR100 |

7 nm |

500 |

284 |

|

256 |

1024 |

2048 |

2. Moore Threads

В каком-то смысле ещё более впечатляющую скорость разработки продемонстрировал китайский стартап Moore Threads. Образованный только в 2020 году уже в марте 2022-го года он представил своё первое решение MTT S60, а к концу 2022-го года – ещё более производительное решение MTT S80 :

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Moore Threads MTT S80 |

7 nm |

150 |

|

|

14.4 |

|

57.6 |

И хотя MTT S60/S80 в первую очередь позиционируются именно как графические карты, возможности их применения в качестве AI-акселератора несомненны (на что особенно намекает наличие специализированных тензорных ядер). Возможно, такая выдающаяся скорость разработки связана с тем, что ключевое IP, судя по слухам, для этого решения было лицензировано у британской компании Imagination Technologies. Но даже если это правда, то это нисколько не умаляет заслуги китайских инженеров, реализовавших в кремнии купленное IP в столь сжатые сроки.

3. Cambricon

Компанию Cambricon по современным меркам можно назвать ветераном индустрии. Образованная в 2016-ом году она бессменно мелькает во всех рейтингах лучших китайских AI компаний. Более того, Cambricon уже вышла на Шанхайскую биржу, где торгуется с оценкой капитализации в $10 млрд долларов (по текущим курсам это сравнимо с капитализацией, например, Яндекса)! Компания разрабатывает различные решения, самым производительным из которых на данный момент является MLU290-M5:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Cambricon MLU290-M5 |

7 nm |

350 |

|

|

128 |

256 |

512 |

Россия

Что ж, мы рассмотрели, какова ситуация с разработкой AI Hardware в мире. Но нам, наверное, более всего интересно, а что в России? Поэтому вернёмся к родным пенатам. К сожалению, нашу ситуацию в области разработки AI Hardware сложно назвать оптимистичной. Если при рассмотрении компаний из США/Китая главная проблема была в том, чтобы отфильтровать огромное количество хардварных стартапов и представить информацию только о наиболее интересных, то в случае России список ниже – это все компании, разработавшие железо, хоть как-то относящее к AI.

1. НТЦ Модуль

НТЦ Модуль имеет в своём портфолио микросхему NM6408. Согласно информации на сайте:

Микросхема интегральная 1879ВМ8Я (NM6408) представляет собой универсальную платформу, ориентированную на решение задач обработки больших потоков данных в реальном масштабе времени (цифровая обработка сигналов, обработка изображений, навигация, связь, эмуляция нейронных сетей и т.д.)

Характеристики:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Module NM6408 |

28 nm |

35 |

|

0.128 |

0.5 |

|

|

2. Элвис

Компания Элвис разработала микросхему Robodeus :

Микросхема RoboDeus представляет собой СнК многоядерного микропроцессора для нового поколения оборудования с поддержкой видеоаналитики. Микросхема может использоваться в когнитивных серверах, в задачах обучения нейронных сетей, автономных робототехнических комплексах и мультимедийных приложениях.

Характеристики:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

Elvis Roboseus |

16 nm |

100 |

|

1 |

4 |

16 |

16 |

3. IVA Technologies

Компания IVA Technologies разработала специализированный процессор IVA TPU. Вот что говорят о нём сами создатели:

Специализированные процессоры IVA – это разработка IVA Technologies, которая базируется на результатах собственных исследований нейропроцессоров. Основой процессоров является блок матричного умножения, который выполняет наиболее ресурсоемкие вычисления со скоростью десятки тысяч операций за такт.

Ключевые преимущества:

- гибконастраиваемое IP-ядро ускорителя тензорных вычислений;

- поддержка Convolutional, FC, LSTM сетей, 3D-Convolution;

- совместимость с популярными фреймворками для оптимизации сетей (TensorFlow, PyTorch)

Характеристики процессора:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

FP16, TFLOPS |

INT8, TOPS |

IVA TPU |

28 nm |

15 |

|

|

|

16 |

16 |

4. Мотив НТ

Также стоит упомянуть решение от компании Мотив НТ - нейрочип «Алтай». В своём обзоре я старался избегать нейроморфных процессоров, т.к. это пока узкоспецилизированные в плане применений решения, которые сложно сравнивать с классическими AI-чипами. В индустрии оценка нейроморфного подхода достаточно противоречивая – от «это ерунда полная» до «это AI-системы будущего». Но учитывая скудный ландшафт российской индустрии разработки AI чипов, не могу не упомянуть нейрочип «Алтай».

Как было упомянуто выше, напрямую сравнить нейроморфный процессор с классическими AI-чипами не получится, поэтому можно только сказать, что нейрочип «Алтай» разработан по 28 нм технологии и имеет TDP в 0.5 Вт.

И о главном

Подводя итог, вот так будет выглядеть сводная таблица:

|

Техпроцесс |

TDP, W |

SRAM, MB |

FP64, TFLOPS |

FP32, TFLOPS |

BF/FP16, TFLOPS |

INT8, TOPS |

Nvidia H100 |

5nm |

700 |

116 |

67 |

989 |

1979 |

3958 |

AMD MI300 |

5nm |

600 |

|

297 |

|

1187 |

4750 |

Cerebras WSE-2 |

7 nm |

20000 |

40000 |

|

|

62 000? |

|

Google TPU v4 |

7 nm |

450? |

160 |

|

|

275 |

275 |

Intel GPU Max 1550 |

5-7 nm |

600 |

546 |

|

52 |

839 |

1678 |

Esperanto ET-SoC-1 |

7 nm |

20 |

150 |

|

17.5 |

35 |

140 |

Tenstorrent Wormhole |

12 nm |

180 |

|

|

|

|

350 |

Tesla Dojo D1 |

7 nm |

400 |

440 |

|

22 |

362 |

|

Graphcore Mk3 Bow |

7 nm |

300 |

897 |

|

87 |

349 |

697 |

GroqChip |

14 nm |

215 |

230 |

|

|

188 |

750 |

Sambanova Cardinal SN30 |

7 nm |

|

640 |

|

|

618 |

|

Hailo-8 AI |

16 nm |

8 |

|

|

|

|

26 |

Biren BR100 |

7 nm |

500 |

284 |

|

256 |

1024 |

2048 |

Moore Threads MTT S80 |

7 nm |

150 |

|

|

14.4 |

|

57.6 |

Cambricon MLU290-M5 |

7 nm |

350 |

|

|

128 |

256 |

512 |

Module NM6408 |

28 nm |

35 |

|

0.128 |

0.5 |

|

|

Elvis Roboseus |

16 nm |

100 |

|

1 |

4 |

16 |

16 |

IVA TPU |

28 nm |

15 |

|

|

|

16 |

16 |

Невооруженным глазом виден разрыв между ведущими мировыми и отечественными разработками. Эту ситуацию сложно назвать приемлемой. И конечно же, подкованный читатель здесь спросит: «А как быть с санкциями, отсутствием миллиардных инвестиций, компетенций? Возможно ли, в принципе, как-то изменить ситуацию?». И он будет во многом прав, ибо идея составить конкуренцию на мировом рынке AI-решений для компании из России выглядит на первый взгляд достаточно безумной! Но именно это лично меня и привлекает: сложность, интересность и амбициозность задачи. И здорово, что в данном вопросе в «Байкал Электроникс» нашлось много единомышленников.

Поэтому с июля этого года я решил присоединиться к коллективу «Байкала», возглавив проект по созданию линейки специализированных AI-процессоров, который вберёт в себя наиболее успешные архитектурные подходы, разработанные на сегодняшний момент.

Если вам интересна тематика разработки самых передовых чипов, вы не боитесь большого количества сложной, но интересной работы, и к тому же являетесь счастливым обладателем компетенций, указанных в этих вакансиях, то добро пожаловать на борт!

Комментарии (13)

uvic

26.07.2023 12:58+1«Байкал Электроникс» нашла уже производителя для своих чипов? Или разработка будет "в стол"?

Lev3250

26.07.2023 12:58+2Помню в 2010 купил ATI Radeon 5770. Там была производительность 1Tflops (fp32). Это казалось огромным числом! Что с такой производительностью делать? Да, были 5870 и даже 5890 (около 4 Tflops). Но бедному студенту даже мечтать об этом было дорого.

А тут уже 900+ Tflops! Офигеть!

Lev3250

26.07.2023 12:58+1UPD: само собой не 5890, а 5970. Попутал

Кстати, в те года был в гостях у одного из разработчиков Космических рейнджеров. У него в компьютере были установлены две (!) 5970. То есть это был максимально возможный конфиг на то время. Я ему даже не поверил и полез в диспетчер устройств проверять. И то это давало теоретических около 8 tflop.

NelSon29

26.07.2023 12:58+3Хорошая статья, спасибо. Две ремарки:

Intel после покупки Habana оставил линейку Gaudi, сейчас можно купить и воспользоваться Gaudi2, которая выступает на уровне A100, после окончания работ над fp8 (этой осенью) будет на уровне H100. На подходе Gaudi3, прошёл tape-out, но про него пока информации мало.

Не уверен, как сейчас, но два года назад среди российских решений нормально доступен был лишь nm6408, даже с прикладным софтом. По robodeus ОКР так и не закрыли, iva tpu пока живёт только как прототип на ПЛИС.

Armmaster Автор

26.07.2023 12:58+4Спасибо.

Да, конечно же, я в курсе про линейку Gaudi. Просто для обзора я выбирал только один "самый-самый" продукт, и мне показалось, что у Интела это Intel GPU Max 1550. Возможно, Gaudi 2 лучше, но по нему нет нормальных описаний с "терафлопсами" (или я не нашёл). Но в любом случае, в контексте статьи, мне кажется большой разницы в между Gaudi 2 и Max 1550 нет.

IVA TPU была сделана в кремнии. В остальном, вы правы. Но мне хотелось сделать обзор российского железа в максимальном варианте, пусть даже и несколько оптимистическом. В конце концов, для нас это, наверное, наиболее интересная часть обзора)

Demanih

26.07.2023 12:58+2А нельзя чисто для сравнения в последнюю сводную таблицу статьи добавить парочку бытовых ускорителей например 1070 и 4070, просто чтобы так сказать лучше понимать.

torgeek

Спасибо за хороший обзор грядки нейровычислителей, особенно русских, несмотря на!

А что про Huawei вскользь — нет у них своих нейрочипов пока?

Armmaster Автор

У них есть, но там в Китае много чего нынче есть, и мне кажется, приведённые в статье китайские решения куда как интереснее.

Просто появившийся ещё в 2019-ом году Ascend был приземлён на взлёте санкциями, что затормозило развитие линейки AI чипов от Huawei. Поэтому выпуск новых решений задержался, а старые (из 2019-го года) явно уступают тем же Biren/MTT/Cambricon (ну, на мой взгляд)