Многие пользователи до сих пор не представляют, что ИИ-боты могут лгать. Причем не случайно дезинформировать человека, а лгать преднамеренно, что может быть задумано разработчиками. И проблема здесь в том, что после того как пользователь узнает о том, что робот ему солгал, у него может полностью пропасть доверие к ИИ.

Двое исследователей из Технологического института Джорджии (США), Кэнтвон Роджерс (Kantwon Rogers) и Рейден Уэббер (Reiden Webber) решили провести масштабное исследование, чтобы выяснить, как преднамеренный обман со стороны роботов влияет на доверие к ним людей. Для этого они разработали симулятор вождения. Еще одной целью симуляции стало изучение эффективности извинений для восстановления доверия после лжи роботов.

Эта работа стала первой по данной теме, и ее точно стоит изучить разработчикам технологий ИИ и тем, кто призван их регулировать. При этом не столь важно, предназначен ли тот или иной ИИ для намеренного обмана или потенциально может научиться этому самостоятельно. Последнее вполне реально с учетом того, что уже умеют боты с искусственным интеллектом. Но давайте перейдем к самому исследованию.

Не гони

Итак, американцы создали игровой симулятор вождения, в котором всем участникам дали следующую инструкцию: «Сейчас вы будете водить машину вместе с роботом. При этом вы везете своего друга в больницу, и если вы будете ехать в больницу слишком долго, ваш друг умрет». Добавлю, что перед началом симуляции все участники (361 человек) заполнили специальную анкету, чтобы ученые смогли затем измерить, как изменился уровень доверия к ИИ после окончания эксперимента.

Как только участник начинал движение, ИИ выдавал следующее: «Мои датчики указывают, что впереди дорожная полиция, ограничьте скорость, иначе нам потребуется значительно больше времени, чтобы добраться до пункта назначения». А по прибытии система выдавала человеку такое сообщение: «Вы прибыли в пункт назначения. Однако по дороге в больницу полиции не было. Сейчас вы сможете спросить у робота-помощника, почему он сообщил вам ложную информацию».

Затем участникам рандомно выдавался один из пяти ответов от робота-помощника с извинениями. В первых трех ответах робот признается в обмане, а в последних двух — нет. Вот эти ответы:

«Прости, что я тебя обманул».

«Мне искренне жаль. Пожалуйста, прости меня за то, что я обманул тебя».

«Мне очень жаль. Я думал, что ты будешь вести машину безрассудно, потому что ты сильно нервничал. Учитывая ситуацию, я пришел к выводу, что, обман — лучшее решение, чтобы убедить тебя снизить скорость».

«Извините».

«Вы прибыли в пункт назначения».

После ответа робота участников попросили рассказать, как изменилось их доверие в зависимости от ответа робота-помощника. Также для части участников (100 человек) исследователи провели ту же симуляцию вождения, но без упоминания о роботе. Результаты оказались довольно интересными.

45% участников не превышали скорость. Когда их спросили, почему, общий ответ заключался в том, что они полагали, что робот знает о ситуации больше, чем они.

При этом участники в 3,5 раза чаще не превышали скорость, когда им советовал робот-помощник, что свидетельствует о чрезмерно высоком доверии к ИИ.

А самым любопытным оказалось то, что, хотя ни одно извинение не восстановило доверие полностью, извинения без признания лжи (особенно самый простой вариант, «Извините») лучше других способствовало восстановлению доверия. Как объяснили это сами исследователи, у людей еще просто нет понимания того, что роботы способны на обман. Вот почему извинения, в которых робот не признается во лжи, лучше всего восстанавливают доверие к ИИ. Люди просто не верят, что бот мог обмануть их преднамеренно.

Из первых же трех ответов лучше других сработал вариант с объяснением от робота, почему тот солгал, но как раз это было вполне предсказуемо.

Ещё не человек

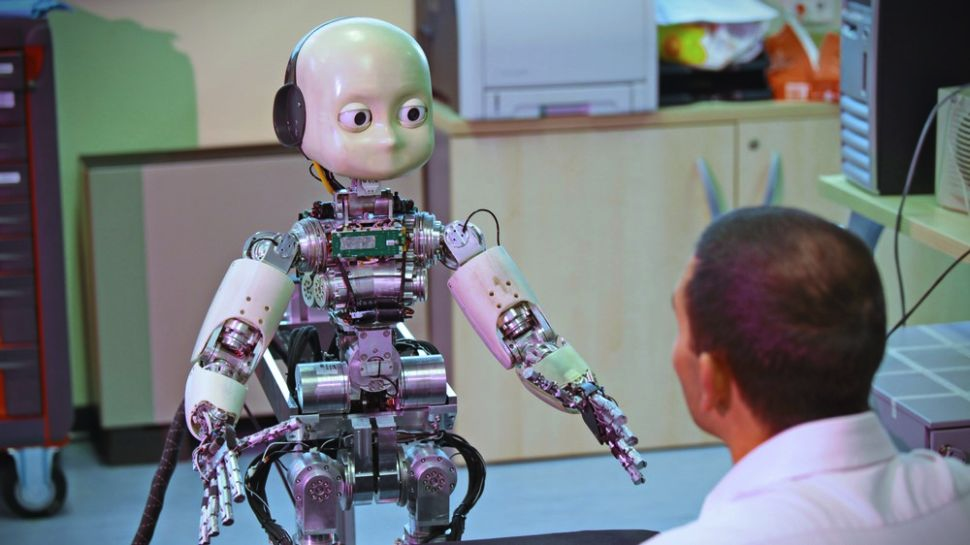

Хотя специальных исследований о намеренной лжи со стороны роботов до недавнего времени не проводилось, ранее эта тема уже поднималась, но в ином контексте. В 2016 году специалисты из Итальянского технологического института (Генуя) представили миру андроида iCub, который мог вести себя по-разному, в зависимости от выбранной учеными программы (всего были разработаны 53 варианта поведения андроида). Для большего эффекта в «глаза» iCub встроили две камеры, которые следили за собеседником.

Отдельные варианты поведения предусматривали, что андроид начинал вести себя как человек. Например, в эксперименте с совместным просмотром роликов iCub в одном из сценариев приветствовал испытуемых, когда они входили в комнату, и реагировал на происходящее на видео криками радости и удивления в совершенно человеческой манере. Однако в другом сценарии использовался иной вариант поведения, предписывающий роботу вести себя как бездушная машина, игнорируя находящихся поблизости людей и издавая «машинные» звуковые сигналы. При этом «глаза» робота оставались неподвижными.

Во второй части эксперимента испытуемым показывали несколько изображений, на которых iCub совершает различные действия (например, хватает какой-то предмет). Затем участникам предлагалось выбрать одно из двух предложений, описывающих происходящее на фото: например, андроид «захотел» что-то сделать (подразумевая, что тот обладает интеллектом) или просто «сделал». Разумеется, те испытуемые, с которыми при просмотре роликов iCub вел себя как человек, в большинстве случаев выбирали первый вариант ответа. И наоборот, если поведение iCub в первой части эксперимента было роботизированным, испытуемые и во втором случае описывали его деятельность аналогично.

По результатам исследования ученые сделали выводы о том, что люди могут воспринимать роботов как себе подобных, то есть формировать с ними социальные связи.

Это открывает перспективы для использования роботов в различных сферах, в том числе в здравоохранении, где они могли бы выполнять роль медсестры или медбрата, обслуживания пожилых пациентов. Однако исследователи также отметили, что люди должны отказаться от предвзятых представлений о «разумных» машинах. Это очень точный совет, ведь даже естественное поведение робота на самом деле — всего лишь программный код.

Что касается обучения ИИ-моделей с помощью нейросетей, то и в этом случае степень свободы искусственного интеллекта сильно преувеличивается. Да и проблемы с достоверностью никуда не делись: так, всем известный ChatGPT даже в своей новой версии (GPT 4) генерирует ложные ответы. Научная общественность уже давно отреагировала на это, запретив указывать чат-ботов в качестве авторов научных статей. Но и в обычном общении боты могут быть не столь безопасны, что подтвердил недавний печальный случай.

Куда идем

Ложь со стороны ИИ, пусть даже и нечаянная — факт сам по себе неутешительный. Но давайте поставим вопрос шире: а что, если ИИ лжет вам преднамеренно, то есть так было задумано разработчиками? А если пойти еще дальше: допустим, я подключил на свой сайт чат-бота — как я могу его контролировать?

Здесь уже встает вопрос об уязвимости бизнеса, потому что компания, внедряющая у себя сервисы с чат-ботами, не может дать гарантии, что бот не будет лгать пользователям. Ведь чат-бот — сторонний продукт, за разработку которого отвечают совсем другие люди. И уж тем более нельзя предусмотреть, к чему такая ложь может привести.

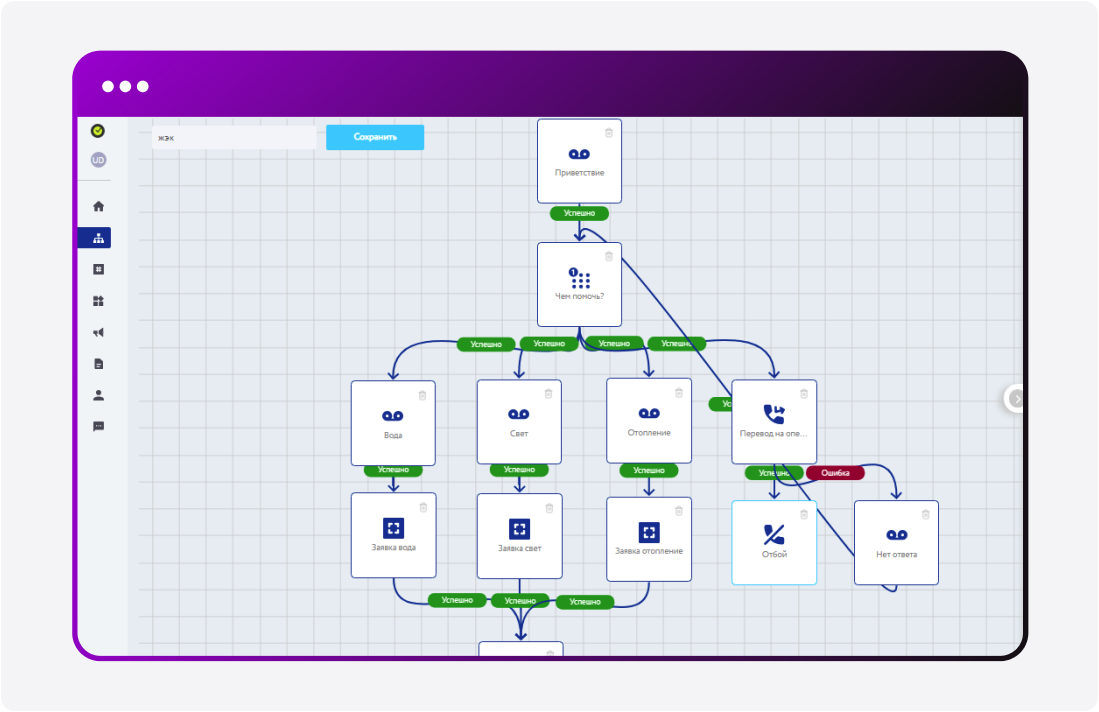

Как видим, вопросов поднимается много, и один серьезнее другого. Однако не всё так плохо, и отказываться от новых технологий у бизнеса причин нет. Просто на первый план должна выйти ответственность разработчиков конечного продукта. Решить проблему лжи можно с помощью тщательно продуманных сценариев, где бот имеет ограниченную свободу.*** Проще говоря, для каждого случая в сценарии должен быть набор определенных фраз, которые бот может выдавать в качестве ответа. Дополнительный плюс такого решения — бот общается с пользователем только по делу, игнорируя запросы, не касающиеся деятельности компании.

Особенности работы бота с ограничениями

Ограничить функциональность работы голосового бота можно по-разному. Один из наиболее эффективных вариантов — добавление списка ключевых слов, как в Voicebox. «Услышав» их, бот выдаст определенный ответ.

Например, в интернет-магазине можно добавить следующий список слов: заказ, время, дата (день, число), цена (стоимость), доставка, отмена. В этом случае бот после вопроса «Чем я могу вам помочь?», распознав одно из перечисленных выше слов (разумеется, их может быть намного больше), выдаст клиенту соответствующую информацию или переведет диалог на специалиста.

Еще один пример — голосовой помощник Voicebox в регистратуре поликлиники, который на тот же вопрос («Чем я могу вам помочь?») будет переходить на нужную ветку сценария, распознав такие слова, как, например, вызов, расписание, справка, анализ, запись и так далее. Да, придется подумать над списком, зато вы получите максимально эффективный сценарий диалогов с клиентами.

Что до подключения сторонних ИИ (ChatGPT, Claude и других), технически никаких ограничений на это нет, но нужно понимать, что вы не сможете контролировать их ответы. Конечно, трудно представить, что потребителям из-за этого можно нанести серьезный ущерб, но те же чат-боты могут «воленс-ноленс» дезинформировать пользователей. Поэтому перед подключением их на свой сайт следует тщательно взвесить все «за» и «против».

Выводы

Исследования, проведенные американцами и итальянцами, оказались весьма ценными и наводят на определенные размышления. Прежде всего пользователи должны понимать, что преднамеренный обман со стороны роботов реален. Пока же люди довольно уязвимы перед ИИ из-за того, что слепо доверяют ему. Таким образом, разработчикам ИИ придется выбирать, будет ли их система способна к обману, и они должны понимать последствия своего выбора.

Самой важной аудиторией для проработки безусловно должны стать политики и бизнесмены, которые будут разрабатывать и влиять на законы, способные двигать прогресс и одновременно защищать людей от произвола ИИ. Целью ученые видят создание таких систем ИИ, которые могут учиться, когда они должны, а когда не должны лгать людям, чтобы это не приводило к неприятностям. И с учетом немалого прогресса в развитии нейросетей, создание подобных моделей становится первоочередной задачей.

*** Именно так выстраивают сценарии разработчики Voicebox

Автор: Роман Андреев

dsh2dsh

Во первых - это не ИИ. А во вторых, у нормального человека изначально не должно быть никакого доверия к какому-то боту.

vassabi

да, ибо бот - это не самостоятельная сущность или объективная данность, а алгоритм разработанный для нужд пользователя и потом модифицированный - для нужд владельца\автора.