Всем привет, на связи Елисеев Арсений. Сегодня расскажу, как разрабатывал модель классификатора для сервиса e-mail-рассылок Pochtaboy. Сам продукт находится еще в стадии тестирования, однако у него есть первые пользователи, вместе с которыми мы и проверим эффективность выбранной модели.

В последнее время появилось много алгоритмов машинного обучения, которые определяют принадлежности текстовых документов к различным категориям. Сейчас есть потребность в обнаружении писем с нежелательным или опасным содержанием, но научные подходы к решению проблемы классификации спама, основанные на использовании компьютерных математических моделей, редко описываются в пределах российского научного пространства.

Поэтому я изучил международный практический опыт для составления перечня потенциальных методов из области машинного обучения для решения задачи классификации спама, а также рассмотрел практическую реализацию отобранных подходов на основе реальных датасетов из открытых источников.

Как дела со спамом, пацаны?

Согласно данным международной компании «Kaspersky» по состоянию на 2022 год 52.78% всех писем на русском языке отмечались спамом, в то время как в международном масштабе эта цифра достигала 48.63% – циркуляция нежелательных писем в российском сегменте в среднем выше мирового уровня. В прошлом году в большинстве случаев содержание таких спам-писем основывалось на продаже доступа к просмотру премьер популярных многосерийных фильмов, билетов на международные спортивные мероприятия, предложения выгодной покупки криптовалюты, смартфонов и прочих товаров. Более того, было замечено использование интегрированных форм с убеждениями пользователя ввести свои личные данные аккаунта для получения в подарок премиум-подписок и прочих бонусных программ. В связи с этим возникла необходимость в проверке не только обычного текста письма, но и HTML-элементов, содержащихся в нём с целью скорейшего пресечения попытки попадания письма с подозрительными формами и ссылками в почтовый ящик пользователя.

Другими словами, проблема борьбы со спамом актуальна, поскольку в пределах российского информационного пространства он присутствует в большинстве писем и зачастую заставляет пользователей терять деньги. Более того, если получателем спама является сотрудник компании, то нежелательные письма могут нанести огромные финансовые и репутационные издержки предприятию, если его работник будет пренебрегать принципами информационной безопасности при их получении, что создает необходимость в проведении превентивных процедур для их изначальной фильтрации.

Задача классификации объектов по их свойствам является одной из основных задач машинного обучения. В рамках решения проблемы идентификации спама роль объекта может играть само письмо как отдельный текстовый документ, а роль свойств – его содержимое, включая возможные стоп-слова, общую стилистику речи и прочие компоненты. Таким образом, задача классификации нежелательных писем может быть решена с помощью прикладной математической модели или их комбинации.

Бенчмаркинг

Большой интерес представляет использование агломерационной иерархической кластеризации с последующей классификацией спама с помощью нескольких пайпланов, практические реализации которых рассматриваются испанскими коллегами в рамках коллаборации с министерством информационной безопасности Испании (Francisco et al., 2023). Стоит отметить, что исследования проводятся на выборках на двух разных языках: на английском и на испанском, с целью определения некоторой степени универсальности рассматриваемых подходов для разных языков. Препроцессинг текста включает в себя работу с заголовком, телом письма и зашифрованным текстом во вложенных в него картинках, которая заключается в предварительных удалении цифр, знаков препинания, стоп-слов и приведении полученного результата в нижний регистр с его последующими токенизацией и стемматизацией. Обобщение тем писем 11-ю кластерами протекает с помощью агломерационной иерархической кластеризации, направленной на слияние похожих кластеров в один общий до достижения критерия остановки.

Важно классифицировать спам внутри тематических групп для получения экземпляров нежелательных сообщений в разрезе различных смысловых категорий. После получения этих обобщённых тематических групп авторами рассматриваются 16 классификационных пайпланов, представляющих из себя отдельные комбинации алгоритмов машинного обучения. Поскольку в перспективе эти методы могут быть использованы для русского языка в нашей работе, стоит обратить внимание на те подходы, которые равным образом показали свою эффективность для выборок на обоих языках. Выбор конфигурации пайпланов строится на обзоре научной литературы и практик от других исследователей, которые ранее тестировали целесообразность использования отдельных алгоритмов в области обработки естественного языка по типу нейронных сетей (A. Barushka et al., 2018) (H. Faris et al., 2019), сематического анализа (N. Saidani et al., 2020), логистической регрессии (B. K. Dedeturk et al., 2020), метода опорных векторов (A. Chavda et al., 2018) (Y. K. Zamil et al., 2019), наивного Байеса (F. N. Patel et al., 2023) и случайного леса (Nagarajaiah et al., 2023).

Наиболее частой практикой перед применением каких-либо методов классификации является процедура эмбеддинга предлагаемого текста. Данная практика позволяет представлять слово или его сочетания в тексте в качестве вектора в многомерном пространстве, состоящем из таких же слов-векторов или словосочетаний-векторов, что представляется более системным подходом, нежели обычное рассмотрение слова как отдельного элемента текстового документа. Авторы этой научной статьи принимают к рассмотрению 4 метода такого класса, использующихся в формировании будущих классификационных пайпланов. В первую очередь, в расчёт берётся стандартная статистическая мера «TF-IDF», которая способна оценивать важность каких-либо слов или словосочетаний в зависимости от частоты их употребления в документах в пределах корпуса (Minhui et al., 2022) , в том числе рассматривается крайне простой подход под названием «BoW» (Alison et al., 2022), считающий обычное количество употребления слов в отдельном документе и преобразующий этот результат в числовой вектор. Также обращается внимание на более сложные методы, относящиеся к классу автокодировщиков, по типу «word2vec», технологии, позволяющей строить семантические связи в виде ассоциаций слов с другими словами, стоящими рядом с ними в тексте (Monika et al., 2023), и «BERT», нейронной сети, предоставляющей возможность в построении семантических связей между словами в тексте в зависимости от различных контекстов их употребления в предложениях (Bing et al., 2022).

Автокодировщики отличаются своей высокой степенью функциональности, но не нужно забывать, что они относятся к области глубокого обучения, и в связи с этим требуют значительные компьютерные и временные ресурсы для своего обучения. Это стоит иметь в виду при работе с большими объёмами часто поступаемых новых данных, присущими всевозможным веб-сервисам.

Таким образом, в данной статье представляется таблица, содержащая значения 6-и метрик, рассчитанных при работе 16-и различных пайплайнов над английским и испанским текстами. Ими являются «Precision», «Recall», «Accuracy», «Runtime» (число миллисекунд, затрачиваемое для обработки 1 электронного письма) и «F1-score», последняя из которых является не более чем гармоническим средним первых двух показателей. Главным образом, использующиеся подходы формируются путём комбинации различных методов эмбеддинга (TF-IDF, BoW, word2vec, BERT) и последующих применяющихся алгоритмов машинного обучения для проведения процедуры классификации (метод опорных векторов, наивный Байес, случайный лес и логистическая регрессия). После усреднения результатов, полученных на текстах на обоих языках, можно прийти к выводу о том, что пайплайны: «TF-IDF/LR», «BOW/LR», «BERT/LR», «TF-IDF/NB» и «BOW/SVM» составляют ТОП-5 наиболее успешных комбинаций с показателем «Accuracy» выше 93.4%.

Наиболее эффективным алгоритмом для классификации становится логистическая регрессия, так как подходы, основанные на ней, занимают первые 3 строчки рейтинга. Более того, логистическая регрессия отличается своей скоростью, немого уступая только менее точному наивному Байесу, что особенно важно при, например, внедрении классификационных пайплайнов в веб-приложения. Касаемо методов эмбеддинга: «word2vec» показывает заметно худшие результаты по сравнению с другими, что, по мнению авторов, объясняется малым размером словарного запаса с его часто повторяющимися элементами, используемого в нежелательных электронных письмах, который становится препятствием к построению качественных семантических связей между словами с опорой на представление ассоциаций из близко расположенных в тексте слов. Это может свидетельствовать о потенциальной нецелесообразности использования данного подхода при решении задач классификации спама. Однако, занятие одной строчки рейтинга подходом, включающего в себя использование автокодировщика «BERT», говорит о том, что применение методов глубокого изучения и нейронных сетей для проведения процедуры эмбеддинга всё-таки может являться допустимой практикой в рамках фильтрации нежелательных писем.

Несмотря на то что BERT, главным образом, предобучен на английских текстах, в открытых источниках можно найти его вариации, которые прошли предобучение на массивах информации на русском языке, что делает его применение в контексте решения данной задачи целесообразным и потенциально успешным. Данная практика имеет название «transfer learning», и её основной целью является сокращение колоссального объёма временных и вычислительных ресурсов, направленных на обучение нейронной сети под конкретную задачу.

Пример использования упомянутых ранее алгоритмов машинного обучения для классификации спама может быть найден в исследовании индийских специалистов (Shahbaz et al., 2021). В данном случае метод опорных векторов, логистическая регрессия, а также наивный Байес демонстрируют величину метрики «Accuracy», большую 75%. Тем менее, также стоит обратить внимание на алгоритм k-ближайших-соседей (KNN), демонстрирующий значение показателя «Accuracy», равное 89%. В данном случае можно отметить целесообразность использования такого метода в рамках решения задач подобного рода в связи с его некоторой простой применения в отличие от также рассматриваемого в этой статье подхода, основанного на адаптации нечётких множеств с величиной метрики «Accuracy», большей всего лишь на 3%.

Также очередное успешное применение алгоритмов машинного обучения для классификации спама может быть замечено в очередной работе индийских учёных (Nikhil et el., 2021). В данном случае рассматривается комбинация TF-IDF и логистической регрессии, то есть самый успешный пайплайн, рассматриваемый в статье, исследованной ранее (Francisco et al., 2023). После классической практики подготовки текста в виде его токенизации, удаления стоп-слов и проведения процедуры стемминга заявленная комбинация методов показывает результат в виде величины показателя «Accuracy», равной 96%, что говорит о крайне высокой степени целесообразности использования такого подхода при решении задач классификации спама.

Стоит отметить, что текста, над которыми производится работа алгоритмов, упоминающихся в последних статьях, представлены на английском языке, поэтому практика стемминга, заключающаяся в грубом эвристическом процессе, направленном на «отсечение» от слов их окончаний, суффиксов и прочих морфологических элементов с целью получения их грамматических основ, успешно справляется с задачей нормализации текста. Это объясняется тем, что английский язык относится к аналитическому классу естественных языков, то есть в нём нет падежных форм слов, а их отношения друг к другу в предложении регулируются служебными частицами, которые попадают в категорию стоп-слов в рамках работы компьютерных алгоритмов.

Более того, существуют менее конвенциональные подходы к решению задачи классификации текста. Например, можно обратить внимание на исследование канадских специалистов (Zhiying et al., 2023), в рамках которого предлагается метод классификации текстовых документов, основанный на предварительной компрессии выборки с помощью применения алгоритмов сжатия архиватора «gzip» перед использованием метода k-ближайших соседей. Основная логика такого подхода заключается в том, что текстовые компрессоры отличаются своей способностью в поиске схожих паттернов в текстовых документах, что, в свою очередь, позволяет им относить их к разным категориям на основе их схожести. После этого становится возможным использование классификатора для расчета метрики расстояния объекта от имеющихся категорий, полученных после процедуры сжатия, и его последующее отнесение к конкретному классу на основе этого рассчитанного значения. Возможность проведения таких операций основывается на вычислении информационного расстояния, метрики, составляющей колмогоровскую сложность (Lu et al, 2022). Таким образом, применение описанного метода на датасетах средних размеров с размеченными текстовыми документами демонстрирует отличные результаты, выражающиеся в величине метрики «Accuracy», большей 90%, что либо сопоставимо с показателями предобученного BERT, либо даже превышает их на одних и тех же данных. В связи с этим, можно с уверенностью заявить, что такой экспериментальный подход может быть рассмотрен в рамках этого исследования. Более того, его развёртывание не нуждается в привлечении мощностей GPU, что, в свою очередь, сигнализирует об отсутствии необходимости в привлечении большого объёма вычислительных ресурсов.

Практика стемминга на русском языке

Поскольку целевым языком в этом исследовании является русский, относящийся к классу синтетических, то практика стемминга имеет большой потенциал оказаться малоэффективной при работе со словами, которые часто сильно меняются в своей морфологической структуре при изменении своих падежных форм в предложении. В таких условиях она может продемонстрировать явления перестемминга или недостемминга, при которых слова начинают утрачивать свои первоначальные значения (Mustikasari et al., 2021). Исходя из необходимости в обработке материала на русском языке стоит обратить внимание на практику лемматизации. В данном случае этот инструмент представляет из себя более тонкую и интеллектуальную операцию, заключающуюся в возвращении базовой или словарной формы слова, известного как лемма, то есть к тому варианту слова, который может быть найден в словаре. Более того, практика лемматизации по отношению к русскому языку находит своё применение и в научных кругах, где с помощью неё успешно решают задачи, лежащие в области естественной обработки текста (Akhmetov et al., 2020) (Aleksey et al., 2019).

Мой метод решения задачи классификации спама

После применения индукционного подхода к изученному материалу можно прийти к выводу о том, что существует стандартный алгоритм предобработки текста. В качестве техники нормализации текстового массива информации наиболее рационально использовать практику лемматизации в связи с необходимостью обработки текста на русском языке вместе со всей его морфологической спецификой. Общий анализ реальных научных практик демонстрирует, что в большинстве случаев использование простой меры частоты слов и обратной частоты документа (TF-IDF) является одной из самых целесообразных практик для представления текста в виде векторного пространства с целью обеспечения возможностями алгоритмов машинного обучениям для работы с ним.

Стоит также обратить внимание и на методы глубокого обучения, которые также довольно часто подтверждают свою эффективность в составе процедуры эмбеддинга в рамках решения задач со словарным запасом, фигурирующим в спам-письмах. В качестве одного из таких инструментов может быть рассмотрен популярный автокодировщик «BERT», обладающий своими предобученными вариациями на русском языке. Более того, необходимо помнить об экспериментальных подходах, основанных на предварительном использовании алгоритмов сжатия, лежащих в основе текстовых архиваторов. Один из них упоминается в данной работе (Zhiying et al., 2023).

С точки зрения непосредственных методов классификации в области обработки естественного языка хорошую эффективность демонстрируют такие алгоритмы машинного обучения, как логистическая регрессия (LR), метод опорных векторов (SVM), наивный Байес (NB) и метод k-ближайший соседей (KNN). В этот список также можно включить фигурирующий в рассматриваемых статьях метод случайного леса (RF) с целью проверки работы алгоритма из класса деревьев решений. В связи с этим стоит предположить, что каждый из перечисленных инструментов может обладать потенциалом к успешному решению поставленной в данной работе задачи.

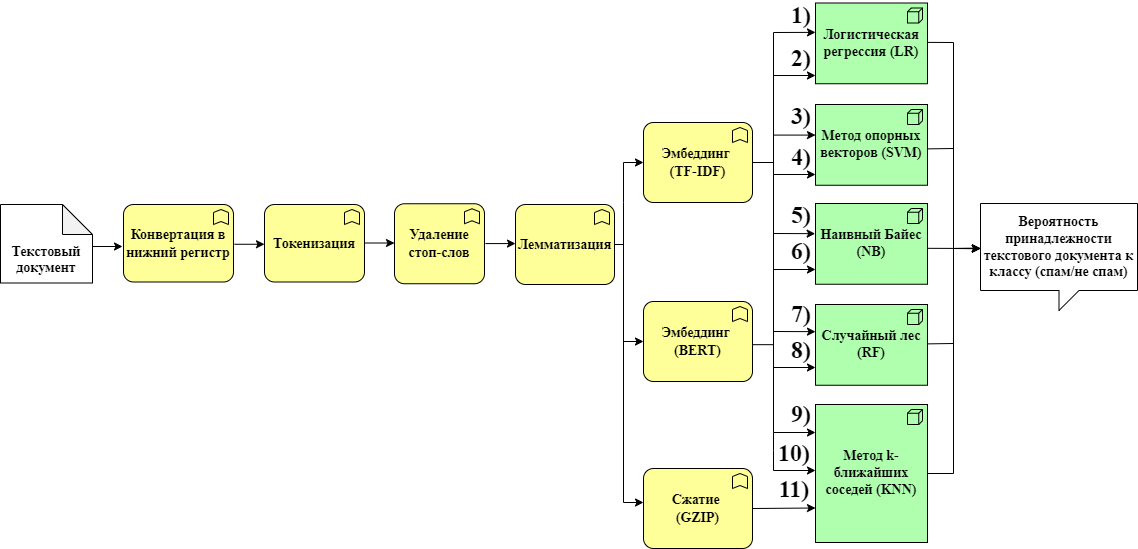

В соответствии с проведённым анализом научной литературы и реальных практик в области классификации спама можно предложить использование 11 пайпланов (рисунок 1). Наилучший из них может быть выбран путём составления их рейтинга на основе расчёта метрик «Precision», «Recall», «Accuracy», «Runtime» и «F1-score» на тестовой выборке при выполнении процедуры кросс-валидации. Описание результатов тестирования будет приведено в практической части этой работы.

Формирование датасета

Для обучения упомянутых ML-алгоритмов нужен массив реальных размеченных данных. В связи с этой необходимостью в рамках этой работы осуществляется поиск целевого контента в открытых источниках. Анализ русскоязычного раздела сети Интернет выявляет, что готовые датасеты с документами на русском языке, заранее разделёнными на категории: «спам» и «не спам», отсутствуют в свободном доступе, что ставит некоторые преграды на пути к проведению исследования. Тем не менее, вводится гипотеза о том, что устранением этого ограничения может являться сбор имеющихся в открытых источниках датасетов с размеченными данными на английском языке для последующего перевода текстовых документов, содержащихся в них, на русский язык, который является целевым в рамках этой работы.

С помощью языка программирования Python датасет с текстовыми документами, разделёнными на категории: «спам» и «не спам», формируется путём концентрации нескольких датафреймов из различных информационных ресурсов, посвящённых машинному обучению. Получившийся датасет обладает двумя колонками: «email» и «label», где в первом столбце содержатся электронные письма реальных пользователей, их SMS-сообщения, их комментарии на видеохостинге «YouTube» и прочих платформах, а во втором — закодированный числовым значением класс текстового документа (0 - «не спам», 1 - «спам»). Перед формированием сконцентрированной выборки проводится базовая очистка данных, заключающаяся в удалении пустых строк, символов новой строки, элементов HTML-разметки, символов с ошибочной кодировкой, слов, не написанных с помощью латиницы или кириллицы, и прочих не несущих информационной ценности объектов. Общий датасет на английском языке содержит в себе 24735 наблюдений, предполагается, что выборки такого объёма будет достаточно для обучения подобранных алгоритмов машинного обучения.

Для перевода текстовых документов с английского на русский язык используется библиотека языка программирования Python под названием «deep-translator», которая содержит в себе класс «GoogleTranslator», представляющий из себя API одного из самых популярных онлайн-переводчиков в мире «Google Переводчик». В связи с ограничением библиотеки, связанным с максимальным порогом длины разово обрабатываемого текста, равного 5000 символам, текстовые документы, размер которых превышает установленный порог, разбиваются на чанки, которые впоследствии переводятся по-отдельности и затем концентрируются в одну строку, записываемую в качестве текстового документа в новый датасет с сохранением принадлежащей ему разметки. В процессе перевода 9 наблюдений пропускается в связи с невозможностью их обработки из-за ошибочной кодировки, что становится результатом несущественного уменьшения размера нового датасета на русского языке относительного датафрейма на английском языке. Таким образом, финальная выборка для последующего обучения алгоритмов машинного обучения содержит в себе 24726 записей.

Качественная оценка переводу текстовых документов может быть охарактеризована как «очень хорошая»: основной смысл сообщений и большая часть используемой лексики сохраняются. Также стоит отметить, что число сообщений с разметкой «спам» в полученной выборке составляет 10711 единиц, в то время как с разметкой «не спам» - 14015 единиц. Это позволяет сделать вывод, что экземпляры разных классов составляют пропорции датасета примерно равные 0.43 и 0.57 соответственно, что говорит о том, что полученный материал является сбалансированным. В связи с этим отсутствует необходимость в обращении к алгоритмам предварительной обработки, используемых для устранения дисбаланса классов в наборе данных, по типу «SMOTE» (Padurariu et al., 2019). Более того, это свойство полученного датасета позволяет в полной мере полагаться на достаточную степень репрезентативности метрики «Accuracy».

Сравниваем классификационные пайплайны

После получения готового датасета с переведёнными на русский язык сообщениями данные текстовые документы проходят процедуру подготовки, которая заключается в приведении их содержимого к нижнему регистру, его токенизации, удалении в нём стоп-слов, а также проведения его лемматизации с помощью Python-решения «PyMorphy2», выбор которого обуславливается достаточным качеством получаемых результатов и крайне высокой производительностью, что является особо важной характеристикой при обработке несколько десятков тысяч записей. Впоследствии реализуется алгоритм поиска по сетке оптимальных значений гиперпараметров как для этапа эмбеддинга, так и для самих моделей машинного обучения, указанных в классификационных пайпланах (рисунок 1).

Для метода TF-IDF подбираются величины для таких параметров, как максимально выделяемое число признаков и размерность извлекаемых N-грамм, которые могут представлять из себя комбинацию унограмм, биграмм, триграмм и элементов других размерностей. Для автокодировщика «BERT» подбор гиперпараметров не воспроизводится, так как берётся решение с уже готовыми структурой и весами, которое дообучается на сформированном датасете. В данном случае адаптируется конфигурация «cointegrated/rubert-tiny», выбор которой характеризуется действующими временными и вычислительными ограничениями, а также степенью её функциональной достаточности для проведения процедуры эмбеддинга. Для метода, основанного на предварительном сжатии текстовых документов путём применения алгоритмов компрессии архиватора «gzip» c последующим применением метода k-ближайших соседей для классификации, подбор гиперпараметров также не воспроизводится, так как у данного подхода есть только одна вариация. При подборе значений параметров для методов классификации машинного обучения из Python-библиотеки «Scikit-learn» совершается работа с их операционными ядрами, а также некоторыми другими настройками, присущими каждому отдельному из них.

После некоторого периода времени становится доступен список различных конфигураций подходов с составляющими их гиперпараметрами и метриками тестового периода: «Precision», «Recall», «Accuracy», «Runtime» и «F1-score», полученных во время процесса кросс-валидации с числом разбиения выборки на 10 частей. Выбранное число подвыборок для кросс-валидации является традиционным и играет роль некоторой альтернативы между временем обучения модели и её потенциальной точностью.

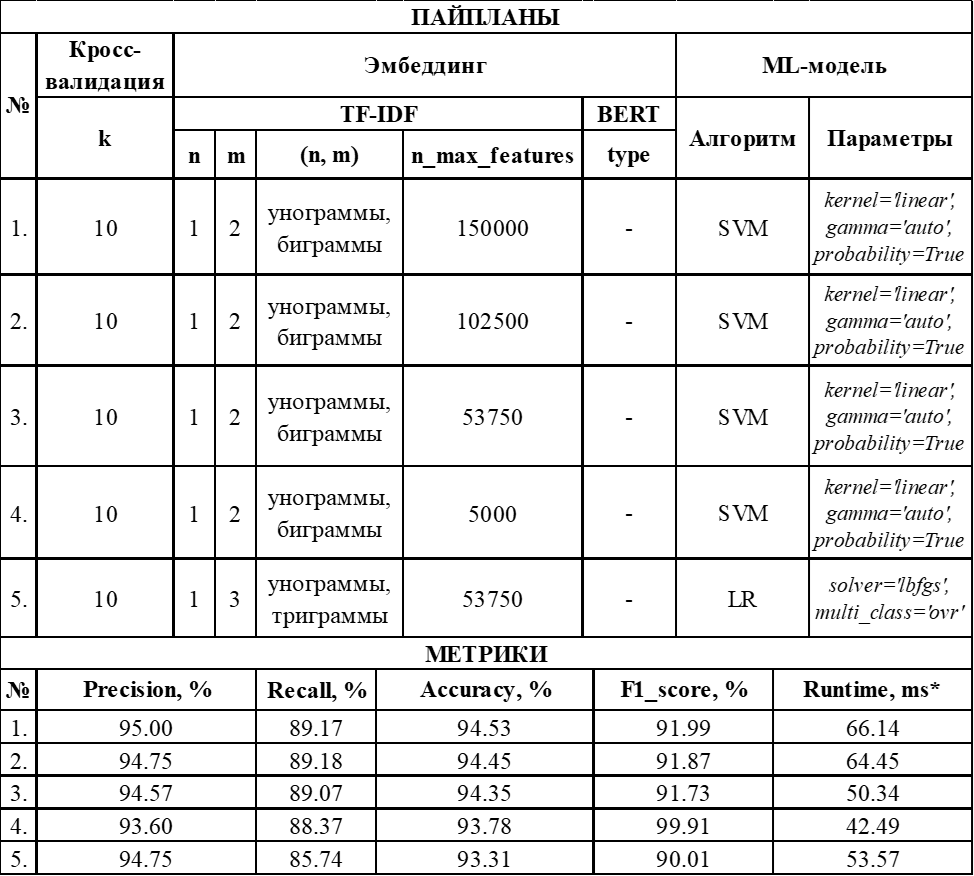

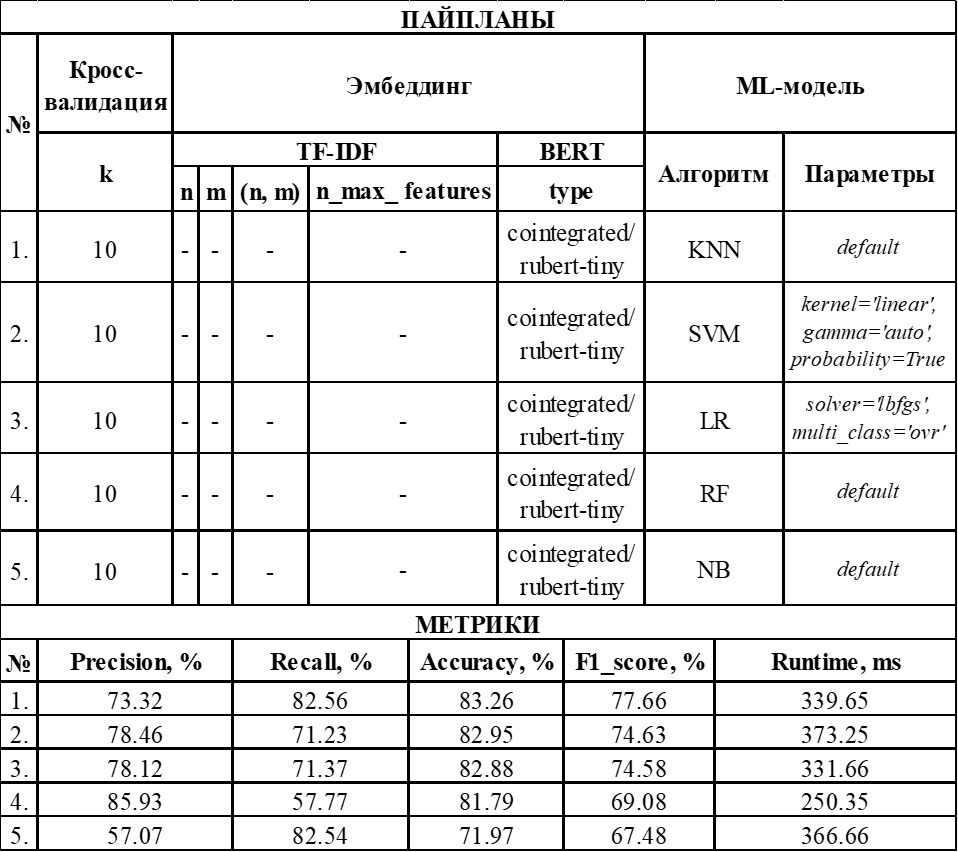

Я подобрал ТОП-5 конфигураций пайпланов, демонстрирующих наибольшие значения перечисленных выше показателей. Они могут быть представлены в следующей таблице (таблица 1):

Исходя из приведенных данных можно сделать вывод о том, что наилучшим классификационным пайпланом оказывается комбинация TF-IDF, выделяющего не более 150000 унограмм и биграмм, и линейного метода опорных векторов. Остальные конфигурации, составляющие ТОП-5 успешных решений, тоже показали отличные результаты с метрикой «Accuracy», равной не менее 93%. Также можно заметить, что в подавляющем большинстве случаев линейный метод опорных векторов (SVM) оказывается наиболее успешным ML-алгоритмом для проведения процедуры классификации. Тем не менее, логистическая регрессия (LR) тоже среди победителей, но занимает только 1 строчку из приведённого рейтинга. Во всех случаях, пусть и с разными гиперпараметрами, наиболее продуктивным алгоритмом для эмбеддинга является простой TF-IDF. Данное явление может быть объяснено особенностью спам-писем, заключающейся в их небольшом словарном запасе по ограниченным темам распродаж, предложений курсов и прочих услуг, что делает возможным выделение наиболее частых словосочетаний, встречающихся в них, для их последующей классификации.

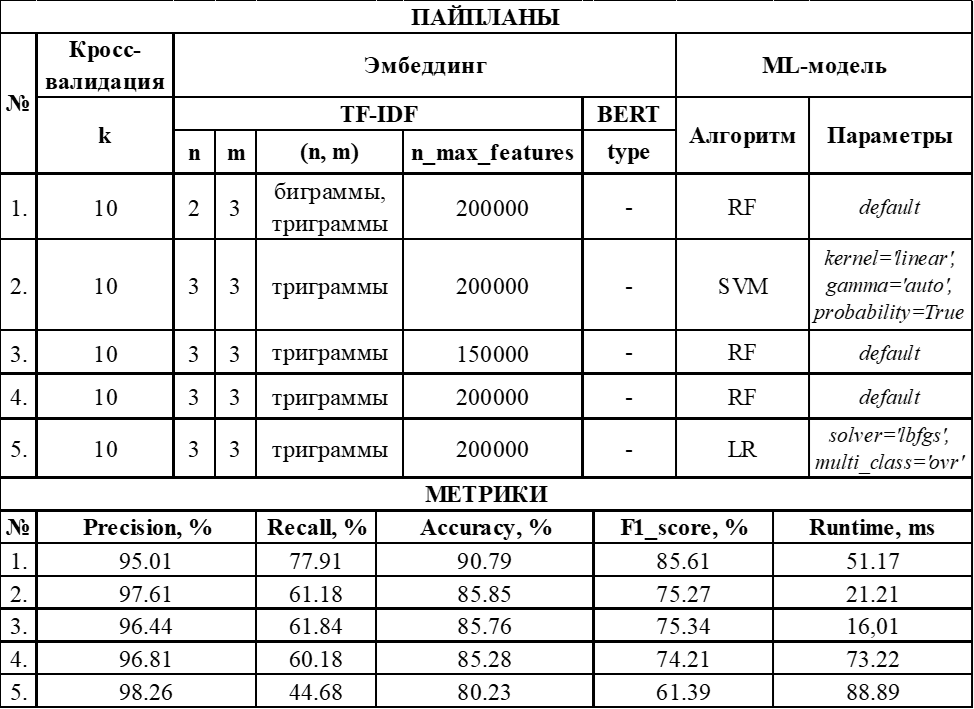

Приведённая выше гипотеза об ограниченности словарного запаса подтверждается при просмотре одних из наименее продуктивных конфигураций, включающих в себя TF-IDF (таблица 2):

В вышеприведённых данных можно заметить следующую особенность: выделение словосочетаний большей длины (триграммы) в большом количестве(≥ 150000) приводит к снижению метрик эффективности тех же самых используемых алгоритмов классификации. В связи с этим справедливо заявить, что выделение около 150000 унограмм и биграмм для данного датасета является оптимальной практикой проведения процедуры эмбеддинга с помощью TF-IDF.

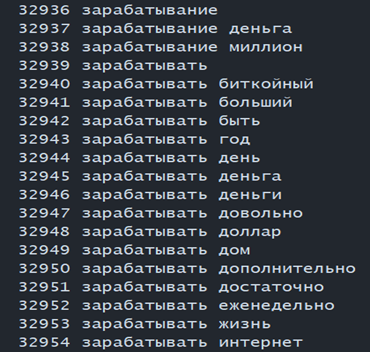

Примеры унограмм и биграмм, конструируемые TF-IDF, могут быть представлены в следующей картинке (рисунок 2):

Использование автокодировщиков «BERT» приводит к построению наименее производительных пайпланов. Метрики для всех алгоритмов классификации с применением этого подхода к получению эмбеддингов для них можно представить следующей таблицей (таблица 3):

Таким образом, сразу можно заметить относительно большой объём времени, затрачиваемый для обработки одного текстового документа при использовании данного подхода эмбеддинга, по сравнению с предыдущим методом. Более того, в целом полученные метрики не обладают довольно высокими значениями. Данные наблюдения могут сигнализировать о том, что применение нейронных сетей для решения задачи классификации спама может оказаться малоэффективной практикой относительно некоторых других альтернативных способов в случае неподходящей специфики обрабатываемого материала.

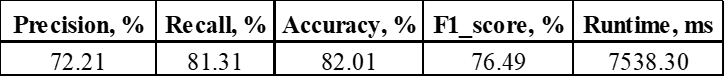

Результаты использования экспериментального метода с предварительной компрессией, могут быть представлены значениями метрик, указанных в следующей таблице (таблица 4):

Можно заметить, что подход с компрессией демонстрирует результаты, сопоставимые с лучшими вариациями методов с BERT. Однако, процесс сжатия оказывается довольно времязатратным при большом объёме выборки, что подтверждается величиной метрики «Runtime». В связи с этим можно заявить, что применение такого подхода может быть и целесообразным в рамках решения поставленной задачи, но требует больших временных ресурсов на датасетах относительно такого большого размера.

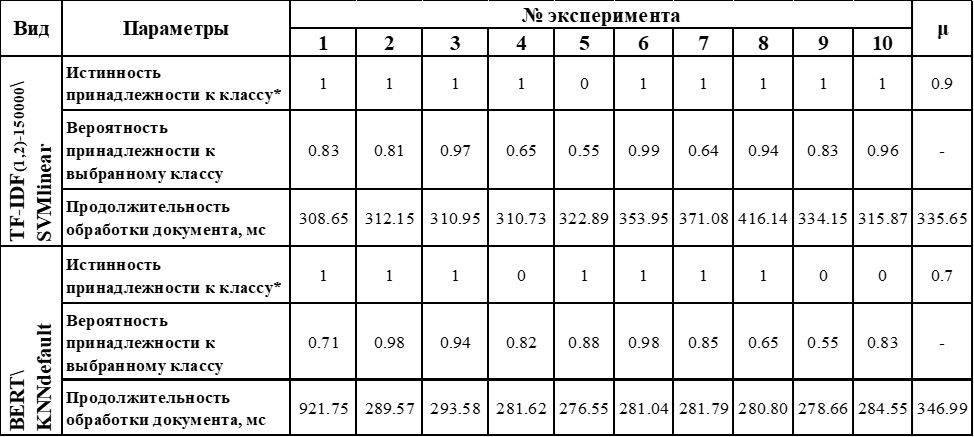

Тем не менее, несмотря на некоторую неэффективность применения автокодировщика «BERT» в рамках этого исследования, во время полевого тестирования используются как лучшая конфигурация с TF-IDF, так и лучшая конфигурация с BERT. Во время проведения экспериментов берутся 5 спам-сообщений и 5 обычных сообщений из реального электронного почтового ящика, каждое из которых подвергается обработке двумя ранее отобранными классификационными пайпланами с фиксацией временных продолжительностей их сессий, а также значений вероятностей принадлежности сообщений к классу «спам» или «не спам», рассчитываемых ими. Результаты тестирования могут быть представлены следующей таблицей (таблица 5):

Из приведённых результатов можно увидеть, что конфигурация с TF-IDF верно классифицирует 9 из 10 документов, в то время как конфигурация с BERT – только 7 из 10 документов. При этом стоит отметить, что на единственном неправильно определённом экземпляре подход с TF-IDF рассчитывает вероятность принадлежности к выбранному классу, равную 0.55, что закладывает в его оценку большую долю «сомнения». В связи с этим фактом можно заявить, что этот подход показывает совсем небольшую неточность, так как при рассчитанной вероятности меньше 0.5 объект эксперимента получает принадлежность к уже другому классу. Конфигурация с BERT из 3-ёх неправильно классифицированных примеров только в одном их них даёт оценку вероятности принадлежности к неверному классу равной 0.55, в то время как в остальных случаях это значение превышало 0.8, что свидетельствует о высокой степени «уверенности» модели при отнесении экземпляров к неправильным категориям и говорит о наличии явных ошибок.

Практическая часть данной работы помогает выделить наиболее успешные комбинации методов машинного обучения для решения поставленной задачи классификации спам-сообщений. Им оказывается комбинация из TF-IDF, выделяющего не более 150000 унограмм и биграмм, и линейного метода опорных векторов (SVM). Также она позволяет изучить причины, по которым инструменты, включающие в себя использование автокодировщика «BERT», не демонстрируют те же показатели эффективности, которые показывает прошлый подход. Проведенное тестирование в практической части данной работы с фиксацией метрик эффективности применения отдельных отобранных решений на реальных данных предоставляет возможность в повторном удостоверении о правильности выбора классификационного пайплайна, предназначенного для достижения поставленной в этой работе цели.

Вывод

Мне удалось познакомиться с международным опытом применения научных подходов с целью обнаружения спама, основанных на использовании алгоритмов машинного обучения. Более того, у меня получилось синтезировать обучающий датасет путём перевода размеченных сообщений с английского на русский языки с помощью API сервиса «Google Переводчик». Впоследствии на этих данных мне удалось осуществить перебор гиперпараметров для 11-ти классификационных пайпланов для построения различных конфигураций решений с подсчётом их метрик эффективности с помощью проведения процедуры кросс-валидации с разделением всего датасета на 10 блоков.

В конечном счёте исходя из рассчитанных метрик была выбрана наиболее успешная комбинация алгоритмов для классификации спам-писем. Ею оказалось сочетание TF-IDF, выделяющего не более 150000 унограмм и биграмм, для осуществления эмбеддинга, а также линейного метода опорных векторов (SVM) для реализации самой процедуры классификации. Данный инструмент продемонстрировал значения метрик «Accuracy» и «F1_score», равные 94.53% и 91.99% соответственно. Эффективность выбранного подхода подтвердилась при проведении тестирования на реальных данных. Рассматриваемая работа является русскоязычным примером применения алгоритмов машинного обучения для решения проблем в сфере информационной безопасности.

Пишите в комментариях, как вы защищаете сервисы от спама.

IT-NEWS

Много - очень много букв