Про то, что можно разогнать процессор, видеокарту или ОЗУ, слышали, я думаю, большинство пользователей ПК. Однако про то, что можно разогнать еще и монитор, знают немногие, причем зачастую разница от его разгона существеннее и заметнее, чем от разгона другого железа. Также она еще и безопаснее, но об этом ниже.

Теория

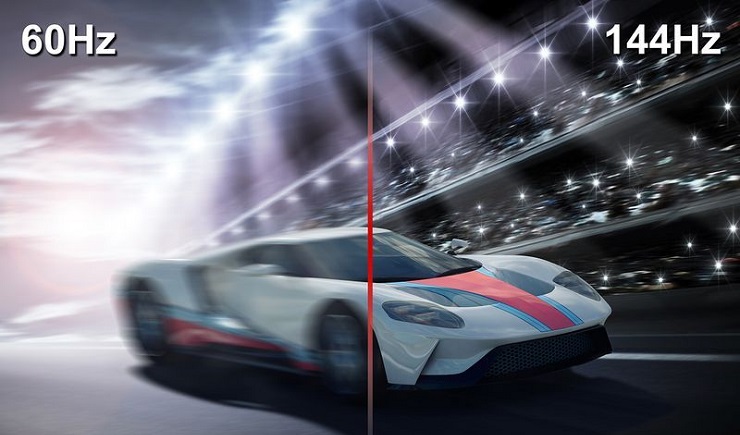

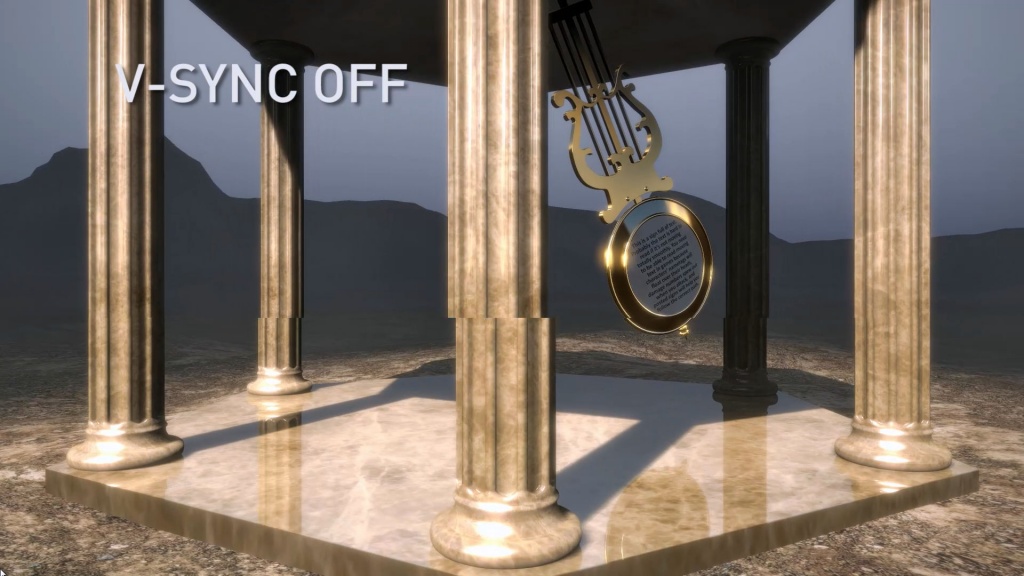

Для начала — что же подразумевается под разгоном матрицы монитора? Подразумевается увеличение частоты обновления монитора со стандартных 60 Гц и на сколько получится — 70-75, бывает и 120, и даже 150 Гц (!). Зачем это нужно? Чтобы повысить плавность картинки. Что означает, что частота обновления монитора — 60 Гц? Это означает, что картинка на экране меняется ровно 60 раз в секунду. При этом видеокарта может выдавать как меньшее количество fps, так и большее. Если количество кадров, выдаваемых видеокартой, меньше частоты обновления, то, значит, какой-то кадр будет дважды (а то и трижды) выведен на экран, что может привести к ощутимым задержкам. Если же количество кадров, выдаваемых видеокартой, больше частоты обновления монитора, то получится так, что на экран будет выдаваться сразу два-три кадра, что приведет к артефактам:

Компромиссом является установка вертикальной синхронизации. В чем ее суть? Она жестко привязывает один кадр, подготовленный видеокартой, к одному обновлению картинки на мониторе. И тут, если ваша видеокарта выдает стабильно больше кадров, чем частота обновления монитора, то вы получите идеальную плавную картинку, ну а ваша видеокарта при этом временами не будет загружена на 100% и будет отдыхать. И именно такой режим работы зачастую используется в системе — к примеру, когда вы скроллите в браузере, артефактов вы не видите, и при этом скроллинг плавный.

Поднятие частоты обновления монитора убивает сразу двух зайцев: во-первых, теперь вертикальная синхронизация будет идти на более высокой частоте, а значит плавность еще повысится (думаю, все видели разницу в роликах на YouTube с 30 и 60 кадрами? Вот тут также). Во-вторых, если ваша видеокарта в играх выдавала больше 60 кадров в секунду, то теперь порог появления артефактов отодвигается до новой частоты обновления, при этом информация на экране будет обновляться чаще, что достаточно важно для динамических игр.

Разумеется, возникает вопрос — насколько это безопасно? Гораздо безопаснее разгона железа: если монитор не может работать на заданной частоте, он просто не включится. Если на заданной частоте он заработал — значит, никаких проблем у вас не будет. Перегрев ему, как в случае с разгоном процессора или видеокарты, точно не грозит.

Практика

Теперь, когда немного разобрались с теорией, можно перейти к практике. Первое, что нужно знать — гонится любой монитор и даже матрицы ноутбуков, но тут есть сразу несколько сдерживающих факторов. Первый — это способ подключения: через DVI при разрешении 1920x1080 вы вряд ли получите свыше 65 Гц — сказывается достаточно низкая пропускная способность интерфейса. Через старые HDMI (до 1.4) при том же разрешении вы скорее всего сможете получить частоту около 75-85 Гц. Ну а через новые HDMI (1.4-2.0), Thunderbolt или DisplayPort ограничений практически нет — можно и 120-165 Гц получить. Аналогично зачастую нет ограничения у матриц ноутбуков, подключенных напрямую к плате. Второй сдерживающий фактор — сама матрица, вернее ее контроллер. Бывает, что даже с быстрым подключением при повышении частоты появляются некоторые артефакты изображения — увы, тут уже ничего не сделаешь, кроме как снижать частоту до последней стабильной.

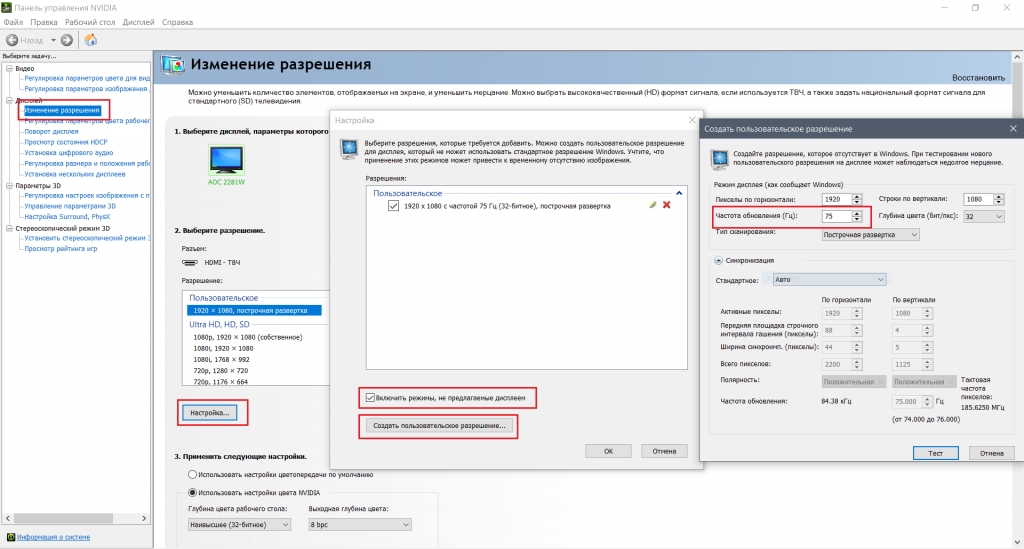

Теперь поговорим о том, как разгонять. Владельцам видеокарт от Nvidia тут везет — для них алгоритм прост: нужно зайти в панель управления Nvidia, перейти на вкладку «Изменение разрешения», нажать на кнопку «Настройка», в открывшемся окне поставить галку на включении режимов, не поддерживаемых дисплеем, после чего нажать на кнопку «Создать собственное разрешение», и в открывшемся окне мы наконец-то получаем доступ к изменению частоты обновления:

Частоту стоит поднимать на 3-5 Гц, после чего нажимать на кнопку «Тест». Если никаких артефактов не появилось и изображение есть — поднимаете частоту еще выше. Как только появились артефакты или исчезло изображение — снижаете до предыдущей рабочей частоты, и дальше поднимаете уже по 1 Гц — в общем, тут все ровно как при обычном разгоне видеокарты. После того, как нашли нужную частоту обновления, просто сохраняете полученную конфигурацию, и она появится в пользовательских разрешениях.

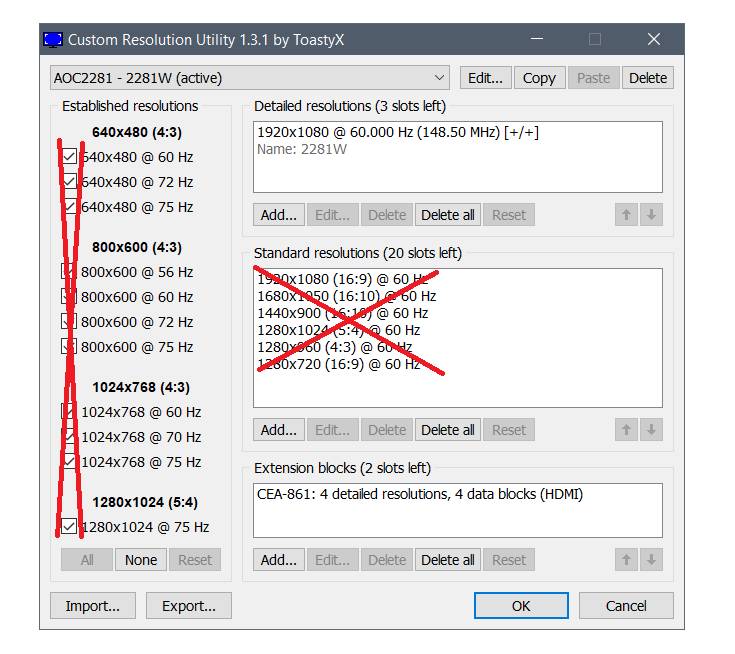

Как видите, тут риска никакого — если монитор «не завелся» на указанной вами частоте, через 20 секунд система откатит значение частоты на дефолтное. Увы — все так хорошо только с видеокартами от Nvidia, с видеокартами от AMD или Intel все хуже — там в настройках драйвера частоту увеличить нельзя, однако есть универсальное приложение, которое поможет это сделать — называется оно Custom Resolution Utility (CRU), скачать его последнюю версию можно тут.

Сразу предупрежу — проблема программы в том, что у нее нет кнопки Тест, как в случае с Nvidia, поэтому частоты применяются сразу и бесповоротно. Так что если после выставления частоты вы видите черный экран — вам поможет или подключение второго монитора и возврат настроек на дефолтные, или же заход через безопасный режим и проделывание того же самого.

Работать с программой достаточно просто — вы ее запускаете, удаляете все разрешения из стандартных и снимаем все галочки слева (у себя я этого проделывать не буду, ибо уже разогнал матрицу через настройки Nvidia):

Теперь под окном с Detailed resolutions нажимаем на кнопку Add, выставляем Automatic - LCD Reduced и ниже меняем частоту обновления:

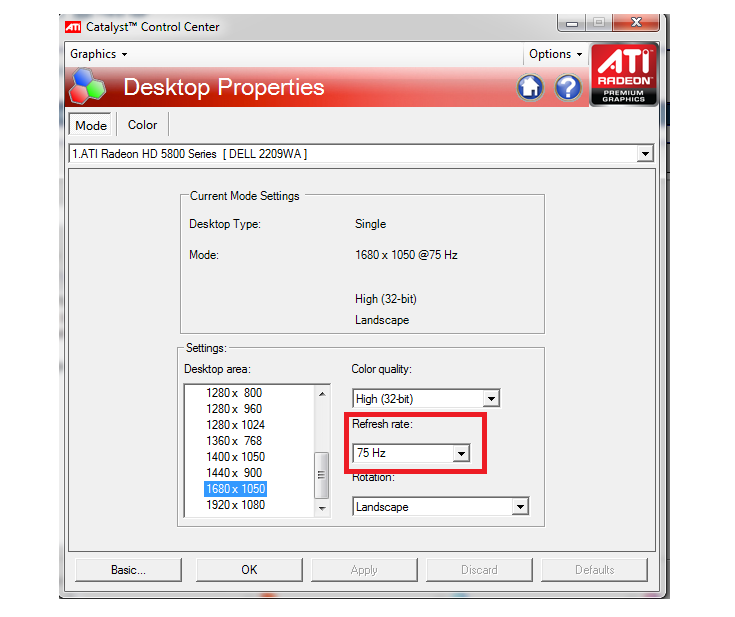

Тут принцип тот же — увеличиваем частоту на 3-5 Гц, нажимаем ОК, все сохраняем и перезагружаемся. Теперь заходим в панель AMD (или Intel) и выставляем новую частоту:

Вот, в общем-то, и все — как видите, ничего трудного или опасного нет.

Ну и остается последний вопрос — раз разгоняются почти все матрицы, то почему этого не делают производители с завода? Тут все просто: есть такое понятие, как стандарт, и для частоты обновления мониторов он уже достаточно давно составляет 60 Гц. Поэтому производители, даже если матрица способна работать на 70-80 Гц, все равно ограничивают ее частоту на стандартных 60 Гц. Во-вторых — зачастую все упирается уже в способ подключения. К примеру, передать 1080р60 можно по любому интерфейсу, хоть DVI, хоть Thunderbolt 3. А вот для 1080р80 уже нужен специальный кабель — DVI и старые HDMI уже не подходят. И чтобы не создавать путаницу, производители опять же ограничились 60 герцами.

Что касается вопроса, разгонять или не разгонять — решать вам и только вам. Если у вас получилось увеличить частоту с 60 до 65 Гц — то смысла в таком разгоне нет, разницу вы не увидите. А вот при разгоне уже до 75 и выше Гц разница становится явно видной, так что игра тут стоит свеч. Также следует учитывать, что после разгона повысится нагрузка на видеокарту при обычной работе — ведь ей теперь придется выдавать больше кадров в секунду, так что если вы разгоняете матрицу на ноутбуке — следует учитывать, что у вас несколько снизится время автономной работы.

Проверить разогнался ли монитор можно здесь - https://testufo.com/

Комментарии (22)

ABy

30.12.2023 05:38+4Только не пробуйте росле разгона проходить тест на пропуск кадров чтобы не расстраиваться.

zatim

30.12.2023 05:38+5Я почему то считал, что частоты обновления кадров - удел старых ламповых мониторов, где эта частота непосредственно задает частоту кадровой развертки. В современных ЖК мониторах эта частота в первом приближении ни на что не влияет - это частота передачи данных по кабелю. Далее данные буферизируются и скалер монитора все равно будет выводить так, как ему надо или так, как он может. Поэтому в плане улучшения изображения эти потуги ничего не дадут.

все видели разницу в роликах на YouTube с 30 и 60 кадрами

Тут очень много нюансов в этой фразе. Киношная частота кадров, телевизионная частота кадров и частота кадров передачи потокового видео - это все абсолютно разные по восприятию вещи. Для примера можно сказать что киношные 24 кадра смотрятся вполне норм, а телевизионная развертка с частотой 50 Гц вполне ощутимо мерцает. Для компьютерных ламповых мониторов 60 Гц - ощутимо мерцает, 75 Гц - уже норм, 85 - тоже норм, но картинка могла начать размыливаться из-за высокой скорости передачи и некачественного кабеля.

через DVI при разрешении 1920x1080 вы вряд ли получите свыше 65 Гц — сказывается достаточно низкая пропускная способность интерфейса. Через старые HDMI (до 1.4) при том же разрешении вы скорее всего сможете получить частоту около 75-85 Гц.

Насколько мне известно, "старый" одноканальный hdmi и dvi полностью совместимы, это прям прописано в стандарте. Непонятно, откуда взялось различие в пропускной способности.

extremegym

30.12.2023 05:38Для компьютерных ламповых мониторов

Поколение Z ????

1CHer

30.12.2023 05:38Подсветка ламповая у них имеется ввиду. Кстати до сих пор используются ввиду более глубокого и детализированного белого. По крайней мере у дочки стоит и менее по глазам бьёт чем всякие современные с защитой от ультрафиолета и без мерцания. Цветопередача не такая уж и пошлая.

mpa4b

30.12.2023 05:38В матрицы картинка точно так же загоняется последовательно, так что разница для матриц есть. По сути если матрица в даташите заявлена как 60 Гц -- всё остальное будет "оверклокингом".

yatanai

30.12.2023 05:38Я почему то считал, что частоты обновления кадров - удел старых ламповых мониторов, где эта частота непосредственно задает частоту кадровой развертки

Всё зависит от контроллера монитора. По факту у тебя матрица может иметь "стабильные 60Гц" а всё остальное зависит чисто от физических характеристик. Мониторы без защиты разрешают себя гнать и там прям видно как картинка начинает сыпаться если гнать их под +100Гц. (показать не могу, сгорел, ахахаха)

Мониторы по "защищёнее" могут гнаться но в каких-то пределах, мой текущий монитор не разрешает ставить обновление больше 84Гц, ни при каких таймингах. И уже при 84Гц видно как картинка слега сыпется на контрастном изображении, скролинг текста к примеру. (у меня нормальный кабель, не надо)

Остальные же явно дают по заднице за такие выкрутасы и прямо говорят - вот тебе список поддерживаемых стандартов, другое не заведём. Современные телики никогда нормально разогнать себя не дают, ибо там почти всегда есть какие-то "фичи" по улучшению картинки.

Zara6502

30.12.2023 05:38+1Если количество кадров, выдаваемых видеокартой, меньше частоты обновления, то, значит, какой-то кадр будет дважды (а то и трижды) выведен на экран, что может привести к ощутимым задержкам

задержкам чего? монитор рисует быстрее видеокарты, а значит что монитор 60 что 144 выводиться всё будет одинаково, как и будет одинаков сам контент генерируемый самим ПК.

Однако про то, что можно разогнать еще и монитор, знают немногие, причем зачастую разница от его разгона существеннее и заметнее, чем от разгона другого железа

Это такая же вкусовщина как и любовь к OLED или выдержанному коньяку. У меня были мониторы на 75Гц, сейчас на 60 Гц, на работе есть на 50 Гц - разницы нет никакой. Скажу больше, на работе я сижу за тормознутой PVA на 60 Гц и её тормознутость к герцам никак не относится. И все артефакты PVA меня никак не трогают. Ну есть и есть.

Зачем это нужно? Чтобы повысить плавность картинки

Это всё из той же оперы как и раскрытие видеокарт. Чтобы заметить разницу между 60 Гц и 144 Гц на Рабочем столе, вам придётся так напрячься, что вены лопнут. Когда вы перетаскиваете окно, то вам на действие требуется например 1.2 секунды. Например вы перенесли окно с одной половины на другую.Вам кажется, что при частоте 60 Гц у вас будет меньше кадров, а значит плавнее сам процесс переноса, но дело в том, что движение окна дискретное и чем быстрее вы дергаете мышь, тем реже рисуются новые кадры, никто не рисует процесс движения попиксельно. Это же касается и компьютерных игр, то есть плавность достижима при малом шаге дискретизации. Условно - если вы двигаете камеру например со скоростью 1 пиксел в кадр. Но так никто не делает и никто в играх так не двигается.

Компромиссом является установка вертикальной синхронизации

у меня лок на 60 кадров средствами драйвера, VSync Off всегда.

Телевизоры не хотят с FreeSync делать, поэтому пока не судьба (может уже и делают, но покупать новый ТВ за кучу денег желания нет).

Тут все просто: есть такое понятие, как стандарт, и для частоты обновления мониторов он уже достаточно давно составляет 60 Гц. Поэтому производители, даже если матрица способна работать на 70-80 Гц, все равно ограничивают ее частоту на стандартных 60 Гц

Ну ненаю, у меня 4:3 BENQ 19" из лохматого 2007 года работал на 75Гц и для LCD 75Гц такой же стандарт как и 60 - очень давно. Мне кажется это маркетинг и разделение товара на группы с разной ценой, при этом сами матрицы могут покупаться вагонами и одной марки, а дело скорее всего в прошивке T-CON.

А вот при разгоне уже до 75 и выше Гц разница становится явно видной

Это как прогрев проводов перед прослушиванием музыки XD вот я вообще не вижу разницу между 60 и 75, скажу больше, я не вижу разницу между 60 и 144. Да-да, вот такая вот приятная особенность нервной системы. Ну и влияет этот разгон на небольшую часть задач, так что всё же самый интересный "разгон" - это покупка SSD вместо HDD, всё остальное не так заметно.

Shannon

30.12.2023 05:38+4Между 60гц и 144гц разница видна сразу, напрягаться для этого совершенно не нужно.

Вот между 60гц и 75гц разницы уже можно и не заметить, но она есть. Заметнее всего это в многопользовательских шутерах, когда частые привычные действия происходят чуть плавнее и четче, но разница даже близко не такая как между 60гц и 144гц.

Ещё иногда бывает и такое, что эти 144гц забывают выставить, так как автоматически это не делается.

Ещё если два монитора с разной герцовкой подключены к одному ПК, монитор с меньшей герцовкой начинает сильнее "лагать", становится более дерганным, видимо особенность Windows 10.

Zara6502

30.12.2023 05:38+1Заметнее всего это в многопользовательских шутерах

возможно эффект и есть, но странно этот эффект записывать как что-то нужное и важное для всех. согласитесь это касается сугубо тех кто в такое играет.

Между 60гц и 144гц разница видна сразу

Если речь про рабочий стол, то я такую разницу не вижу совсем. Те игры которые играю я, тоже. Так что эффект для меня совсем неочевиден. Я же не спорю про то, что кто-то его видит, я комментирую утверждение из статьи о том что это чуть ли не самый важный разгон в ПК. Я с этим не согласен в корне.

Ещё если два монитора с разной герцовкой подключены к одному ПК, монитор с меньшей герцовкой начинает сильнее "лагать", становится более дерганным, видимо особенность Windows 10.

Не замечал такого эффекта абсолютно. В такой конфигурации у нас было более 200 рабочих мест, один монитор на 75Гц основной и рядом простой на 60Гц повернутый на 90 градусов. Сидели проектировщики в Компас 3Д и Автокаде. Абсолютно никаких дефектов. В моем пользовании была связка ТВ 50Гц и монитор 75 Гц, тоже никаких проблем.

aik

30.12.2023 05:38+2если два монитора с разной герцовкой подключены к одному ПК, монитор с меньшей герцовкой начинает сильнее "лагать", становится более дерганным, видимо особенность Windows 10.

Не замечал. У меня 165 и 60 подключены.

Ну и разницу я - на рабочем столе и в рабочих программах - я не вижу. Только в летающей тарелке разница есть. В играх тоже скорее нет, чем да.

Shannon

30.12.2023 05:38+2А какая должна быть разница в полу-статических программах, которые еле двигаются? Или в стратегиях каких-нибудь? Или при просмотре видео, где 24-60 кадров?

Я говорил, что разница видна сразу, а не то, что все её будут всегда замечать. Возьмите окошко и потаскайте его туда сюда или покрутите список меню пуска. При условии, что у вас включено 3d ускорение рабочего стола.

Как часто вы это делаете и нужно ли это, это уже десятый вопрос.А что до игр, опять же, всё зависит от fps и динамичности игры, и того, на сколько вы уже привыкли к элементам игры, не захватывает ли всё ваше внимание другие элементы. На консолях играют в 30 fps и не замечают какой-то проблемы, потому что по сути её нет.

1CHer

30.12.2023 05:38По поводу матрицы очень правы. Сейчас реанимирую старые аймаки так там матрица одна и та же но из-за различия в подсветке и электроники стоят они по разному и ставились на многие устройства одновременно.

yatanai

30.12.2023 05:38+1задержкам чего? монитор рисует быстрее видеокарты

Если нет технологий синхронизации вывода монитора и видеокарты, то картинка постоянно пролагивает. И может быть так что фрейм передасться так, что будет лаг на 2-3 кадра. Потому раскрыватели любят брать мониторы с частотой по выше. (и графику по ниже)

Увы но эта проблема из 2014, сейчас её победили и даже мой 75Гц моник имеет AMD-FreeSynс.Чтобы заметить разницу между 60 Гц и 144 Гц на Рабочем столе, вам придётся так напрячься, что вены лопнут

Люди которые хоть когда-то имели с долблением чего-то потного по таймингам лучше замечают разницу. (в основном игры)

Когда я купил себе 200Гц моник, мой дед сел рядом со мной и реально не мог заметить разницы между 60 и 200. Люди которые любили стратегии говорили в духе "не понимаю, вроде как-то да но принципиально ничо не поменялось". А те кто играл в файтинги или бывшие игроки в кваку были просто в восторге.

Увы я из последних, и мне заметно даже разница между 60 и 75. Даже мышка плавнее двигается, как это не замечают другие люди для меня загадка)движение окна дискретное и чем быстрее вы дергаете мышь, тем реже рисуются новые кадры

Не понял что именно вы имели ввиду. В случае с Windows там используется событийно-ориентированный подход. Тоесть если событий НЕТ то фпс нативных приложений падает буквально до 0. Частоту опроса мышки можно увеличить до условных 1000Гц и соответственно частота отрисовки при движении мыши подскакивает до потолка.

В Linux это работает не так, как я знаю. Там всё окружение рисуется с частотой монитора. Так что наверное разницы... Нет? О чём мы?А в итоге разница есть только в играх, и то она заметна если ты любитель "бахнуть потного", зарубится в рейтинги на "алмаз" в каком-нибудь файтинге или пройти 7 звёзд мании в OSU, иначе - чисто субъективщина.

mpa4b

30.12.2023 05:38Поэтому производители, даже если матрица способна работать на 70-80 Гц, все равно ограничивают ее частоту на стандартных 60 Гц.

Одно время плотно работал с матрицами (правда ещё с теми, которые LVDS), и как правило у всех в даташитах была указана частота обновления 60 Гц, ну с каким-то допуском в пару герц.

Arhammon

Добавлю полезного: некоторые мониторы с высокой частотой обновления имеют * в описании характеристик - по этому если ваш монитор внезапно начал на высокой частоте артефачить прежде чем нести в сервис почитайте инструкцию. А то возможно это "режим разгона" и проблемы негров шрифа не волнуют...