Содержание

Введение

Нейроморфные системы

Квантовые системы

Резюме

Введение и классические ИИ-решения

Текущие ИИ-решения и архитектуры, в основе которых классические подходы, по нашему мнению, приближаются к своему пределу.

На текущем уровне развития и эффективности ИИ-моделей для создания и обучения сильного ИИ будут нужны гигантские вычислительные мощности. Ведь для повышения эффективности нужно увеличивать количество нейронов и выстраивать связи между ними. Если человеческие нейроны могут быть в нескольких состояниях, а активация может происходить «по-разному» (да простят нас биологи за такие упрощения), то машинный ИИ так не может. То есть, условно, машинные 80-100 млрд нейронов не равны 80-100 млрд у человека. Тот же GPT4 оценивают в 100 трлн параметров (условно нейронов), и он все равно уступает человеку.

Все это приводит к нескольким факторам.

Первый - ИИ-моделям нужно будет становится все сложнее. А рост сложности всегда приводит и к проблемам надежности, увеличивается количество точек отказа. То есть модели все сложнее и создавать, и поддерживать от деградации во времени и в процессе работы. Их нужно постоянно «обслуживать», иначе она станет похожа на старика с деменцией, а срок «ее жизни» будет очень низким.

Давайте приведем пару простых примеров из жизни. Первый – на основе мышц человека. Когда мы только начинаем заниматься в зале, то прогресс идет быстро, но чем дальше, тем ниже КПД и рост результатов. Плюс рост силы идет от ее толщины (см^2), а вот масса растет от объема мышцы, (см^3). В итоге мышца в определенный момент станет настолько тяжелой, что не сможет сама себя двигать, а может даже и повредить.

Аналогичный пример можно привести и к инженерной области. Например, гонки Формулы 1. Так, отставание в 1 секунду можно устранить, если вложить 1 млн и 1 год. Но вот чтобы отыграть решающие 0,2 секунды может потребоваться уже 10 млн и 2 года работы. И фундаментальные ограничения конструкции машины могут заставить вообще заставить пересмотреть всю концепцию гоночной машины.

Если вернуться к вопросу деградации, то помимо технологий тут будет и влияние людей. Любой сильный ИИ будет самообучаться на основе обратной связи, а она, как минимум на раннем этапе, будет формироваться людьми (их удовлетворённость, начальные запросы и задачи) и их поведением. Примером тут может служить тот же ChatGPT4. Он использует запросы пользователей для совершенствования своих ответов. В итоге, к концу 2024 года пользователи стали замечать, что он «обленился». Они утверждают, что в последнее время при использовании GPT-4 или ChatGPT API чат-бот либо отказывается отвечать на вопросы, либо прерывает разговор, либо отвечает просто выдержками из поисковиков и других сайтов.

В общем тут можно привести в пример анекдот: "Я печатаю со скоростью 300 знаков в минуту! - Что, правда? -Ага, только полная фигня получается."

Мы можем легко увеличить текущие модели в ХХХХ раз. Но есть проблема - проблема обучения больших сетей и их поддержания. Тому же ChatGPT5 уже не хватает данных для обучения.

Второй фактор - ИИ-модель будет привязана к своей «базе». Ей потребуются огромные и сложные дата-центры для работы, с мощными источниками энергии и качественным охлаждением. Так, по некоторым оценкам на 5 - 50 запросов для ChatGPT 4 уходит до 0,5л воды на охлаждение. И какими бы ни были пропускными каналы интернета, все равно «мозг» будет в этих центрах, не будет распределенных сетей. Во-первых, распределенные вычисления все равно теряют в производительности и эффективности. Во-вторых, это уязвимость перед атаками на каналы связи.

А уж если все придет к тому, что сильному ИИ потребуется тело для взаимодействия с миром, то реализовать это будет еще сложнее. Тогда ИИ-модель будет ограниченной, иначе как все это обеспечивать энергией и охлаждать? Откуда брать мощности для обработки данных? То есть это будет ограниченная ИИ с постоянным подключением к основному центру по беспроводной связи. А это снова уязвимость. Современные каналы связи дают выше скорость, но это сказывается на снижении дальности действия и проникающей способности. Кроме этого, такие каналы и проще подавить средствами радиоэлектронной борьбы. То есть мы получаем рост нагрузки на инфраструктуру связи и рост рисков.

В общем сильный ИИ сейчас не про ESG, экологию или коммерческий успех. Его создание может быть только в рамках стратегических и национальных проектов, которые будет финансировать государство.

Тут можно, конечно, возразить. Например тем, что можно взять предобученную модель и сделать ее локальной. Примерно также, как мы предлагать разворачивать локальные ИИ-модели с «дообучением» в предметную область (об этом мы писали в статье про цифровых советников). Да, в таком виде все это может работать на одном сервере. Но такой ИИ будет очень ограничен, это будет не сильный ИИ, и он будет «тупить» в условиях неопределенности, ему все равно нужна будет энергия. То есть это история не про создание человекоподобных суперсуществ. Это будет большое количество сильных ИИ, но дорогих и с ограниченными возможностями, что не очень интересно рынку.

В итоге, сейчас мы учимся результативно и эффективно применять то, что придумали и разработали ученые за последние 30-40 лет. Сейчас мы идем к плато продуктивности и осваиваем текущую технологию.

Но неужели все, прогресса не будет? Естественно нет. Наше мнение, что следующий скачок будет связан с квантовыми и нейроморфными вычислениями. А, возможно, и с их сочетанием. Однако такой гибрид —перспектива очень отдалённого будущего.

Но что такое нейроморфные и квантовые вычисления и почему я так считаю? Давайте разберем эти направления.

Нейроморфные системы

Что такое нейроморфные системы

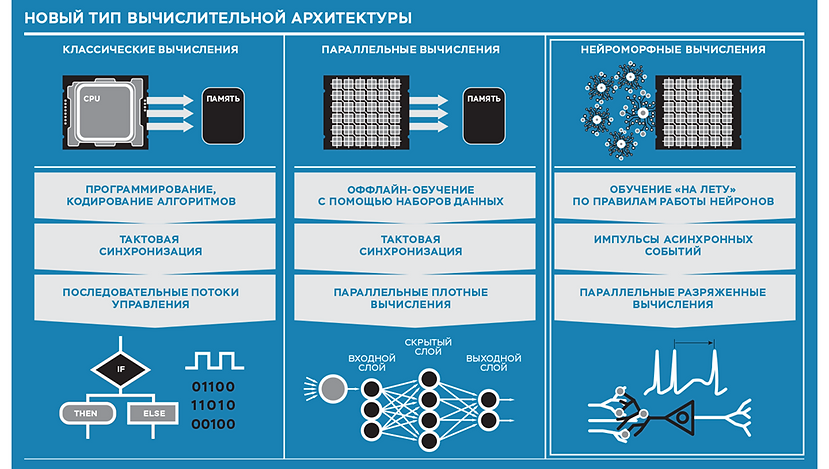

Все текущие ИТ-решения базируются на простой архитектуре – есть процессор и есть память. Процессор проводит логические вычисления и обращается по необходимости к модулю памяти. Это называется архитектура фон Неймана.

Нейроморфные системы отличаются тем, что в них пытаются применять технологии из области биологии мозга. Ученные работают над объединением внутри одного блока сразу вычисления и память, а сами блоки собираются в сложные сети, которые работают не постоянно, а импульсами.

Для упрощения понимания приведем визуализацию.

Зачем это нужно? Чтобы решить ту проблему, о которой мы говорили в блоке про сильный ИИ - текущие решения сложные и потребляют огромное количество энергии.

Например, чтобы самый мощный компьютер мог распознать кошку или собаку, то ему надо в тысячу раз больше энергии, чем нашему мозгу.

При работе обычный ПК постоянно обменивается данными между процессором и памятью. Например, надо сложить два числа. Он берет из памяти одно число, помещает в регистр процессора, затем берет другое число, тоже помещает в регистр процессора. Выполняет операцию, и из 3-го регистра процессора результат идет обратно в память. А можно встроить процессор для простых вычислений сразу в память и дать команду: «сложи два числа и сделай в памяти третье». И тогда мы убираем процесс обмена данными через шину. А это кратно снижает затраты времени и энергии.

В итоге, нейроморфные системы позволяет решать задачи там, где нужно непрерывно собирать данные (видеть, слышать, нюхать), анализировать их, при этом делать это быстро и без больших затрат энергии. Ключевыми здесь можно выделить 3 направления.

Первое – сенсоры, которые могут работать автономно, без привязки к облаку или сети.

Например, детектор на одежде, который анализирует токсичность воздуха и сигнализирует об этом. Если такой делать по классической модели, то у него будет либо модуль передачи данных (тогда без сети он будет глупым), либо нужна большая батарейка, что ограничит время работы или сделает его неудобным для переноски и использования.

То есть ключевое преимущество нейроморфности в первом направлении – автономия и отсутствие потребности в больших источниках питания. Это одна из фундаментальных проблем умных устройств.

Второе направление – сокращение времени на обработку данных и принятие решений (все текущие ИИ-модели думают долго).

Например, роботы-собаки Boston Dynamics. Раньше при толкании они падали. Проблема в том, что пересчет данных после толчка требует обработки большого количества данных: нужно собрать данные с сенсоров, провести расчеты, отдать команды на приводы. В итоге он не успевал все это сделать и падал.

Еще один пример - вибродиагностика на базе видео аналитики. Также надо собирать большое количество данных и анализировать видеопоток, проводить расчеты.

Третье направление – рост количества нейронов. В главе про сильный ИИ мы с вами разбирали проблему того, что текущие решение уже трудно масштабировать. И нейроморфные вычисления помогают решить эту проблему.

Практический пример - система управления велосипедом

Исследователи с помощью одного китайского чипа Tianjic, без других вычислительных мощностей, сделали систему управления велосипедом.

Одна нейросеть позволяет воспринимать голосовые команды и видеть. Вторая управляет балансом. В общем, целый оркестр из разных нейросетей на базе разных архитектур, которыми управляет некий оркестратор, мастер-ИИ, который разбирает задачи на разные ИИ-модели, собирает данные и принимает комплексные и быстрые решения.

В итоге вместо кучи техники с видеокартами и процессорами, огромной батареей есть небольшое решение. При этом велосипед едет, объезжает препятствия и реагирует на команды. Быстрое принятие решений и автономная работа на базе одного процессора.

Недостатки

Красивая перспектива, не так ли? Но проблема здесь – ранний этап развития технологии, а значит и отсутствие компетенций, ресурсов и так далее.

То есть нужно решать фундаментальные проблемы с математическими алгоритмами, языками, архитектурами и так далее. Требуются огромные ресурсы математиков и инженеров. А ведь дальше будет еще более сложная задача – организация опытного и в итоге промышленного производства. Начать выпускать миллионы чипов, которые пока только делают для экспериментов задача не из простых и не на 1-2 года. И давайте будем помнить, что сейчас даже «классическое» оборудование производится во всем мире лишь несколькими заводами. Так что массовой это технология станет очень нескоро.

Кому интересны материалы на эту тему, то рекомендуем несколько интересных и доступных статей и видео по ссылкам ниже.

Ссылки

Нейроморфные системы: искусственные мозги на замену нейросетям

Искусственный интеллект и нейроморфные вычисления: второе дыхание

Видео

Квантовые системы

В классических ИТ-системах есть 2 состояния – включен и выключен. Это и состояние процессора, и запись / чтение данных, и работа нейронов в ИИ-модели.

В квантовых вычислениях «нейрон» может быть и включенным, и выключенным, и в двух состояниях одновременно (суперпозиция). Вроде небольшое отличие, и непосвященному человеку мало что говорит. Но это радикальные изменения. Настолько масштабные, что ученные еще на самой начальной стадии осваивания этой технологии. Эта технология даже моложе нейроморфных вычислений.

Если вернуться к разговору о квантовых процессорах, то они могут работать с более масштабными и сложными ИИ-моделями, а также использовать новые ИИ-архитектуры (где нейроны могут быть в суперпозиции), недоступные текущим технологиям. А исследования в этой области вселяют позитивные ожидания. Например, исследователи из Freie Universität Berlin обнаружили, что квантовые нейронные сети способны не только обучаться, но и запоминать случайные данные. «Это как обнаружить, что шестилетний ребенок может запомнить случайные строки чисел и таблицу умножения одновременно. Эксперименты показывают, что квантовые нейронные сети невероятно искусны в подборе случайных данных и меток, бросая вызов основам того, как мы понимаем обучение и обобщение», - заявил Элиес Гил-Фустер, ведущий автор исследования.

Подробная статья доступна на сайте Nature ссылке

Если агрегировать все преимущества в небольшой список, то мы получаем:

более высокую ёмкость памяти (на объем) и малые размеры (1011 нейронов/мм³), что также позволяет увеличить скорость обработки данных и снизить энергопотребление;

для решения аналогичных задач нужно меньше нейронов, то есть снова снижение энергопотребления и сложности ИТ-инфраструктуры;

более быстрое обучение на меньшем количестве данных;

возможно решение задач, которые сейчас недоступны.

Если посмотреть под другим углом, то это выходит в:

отсутствие катастрофического забывания контекста;

решение линейно-неразделимых проблем однослойной сетью;

более высокая стабильность и надёжность работы ИИ-модели;

возможность создавать «многомерные» ИИ-модели, которые обрабатывают несколько потоков данных.

В общем здесь мы начинаем уходить в мир фантастики. А уж если сочетать нейроморфные и квантовые технологии, то боюсь фантазии у нас не хватит.

Недостатки

Ну а теперь давайте вернемся из космоса на землю и поймем, почему технология до сих пор не вызвала революции в ИИ.

Во-первых, первые исследования в этой области появились только в 1995 году. По меркам науки технология еще в стадии младенца. Как мы писали выше, технология даже моложе нейроморфных вычислений. А значит, нет и нужного количества специалистов для быстрого развития технологии.

Во-вторых, сами квантовые компьютеры пока на очень ранней стадии. Это решения, которые вы не можете купить домой или в организацию. Квантовые компьютеры хоть и развиваются быстро, но все равно сейчас это примерно тоже самое, что мы видели с ПК в 1970-1980 годах. То есть сейчас, как и с нейроморфными системами, решаются самые базовые задачи, связанные с математикой и физикой. Сейчас исследователи задаются вопросами из разряда:

какие аппаратные ресурсы (железо, количество физических и логических кубитов) требуются для решения отдельной задачи;

сколько времени потребуется для расчетов;

как написать базовые алгоритмы;

как обеспечить стабильность работы процессора и убрать помехи, которые влияют на кубиты.

На данный момент это удел ученых и военных, а приход в крупный бизнес можно ожидать через 5-20 лет, масштабное распространение через 30 – 50 лет.

Ниже приведем интересную визуализацию одного из прогнозов развития квантовых технологий.

В-третьих, квантовые вычисления не очень хорошо подходят для решения бытовых задач. Это как с помощью космического корабля пахать картошку: слишком сложной дорогой будет подготовка, а скорость решения особо не изменится. В итоге это не имеет целесообразности. Квантовый компьютер — не суперкомпьютер, который все делает быстрее. И одна из ключевых задач на данном этапе – понять, а какие задачи могут быть решены квантовым компьютером быстрее, чем классическим ПК, и насколько он сможем быть полезнее.

И на данный момент квантовые компьютеры отлично показывают себя при решении задач, которые требуют расчета большого количества возможных комбинаций. Такие типы задач встречаются, например в квантовом моделировании, шифровании, и задачах поиска. Например, ученый компании D-Wave Зэнгбинг Биэн (Zhengbing Bian) использовал один из компьютеров компании для решения ресурсоемкой вычислительной задачи - построение двухцветного графа чисел Рамсея. На решение этой задачи обычному компьютеру средней мощности потребовалось бы более 10 000 лет. А вот квантовому компьютеру D-Wave на это потребовалось всего 270 миллисекунд.

В итоге, для тех, кому интересное данное направление, рекомендуем начать погружение со статей и видео по ссылкам ниже.

Ссылки

Анализ организации, обучения и применения квантовых нейронных сетей

Применимость квантовых нейронных сетей для задач распознавания и обнаружения образов

Будущее искусственного интеллекта: квантовое машинное обучение

Видео

Резюме

Да, квантовые и нейроморфные сети будут следующими революциями в области ИИ. И развитие сильного ИИ можно связать с развитием именно этих технологий.

Но эти технологии сейчас на столь раннем этапе развития, что строить прогнозы здесь невозможно. Это передовой край науки, исследования для будущего и направления для перспективных инвестиций. Сами квантовые и нейроморфные технологии в ближайшие годы не смогут решать прикладные задачи целиком. Но, учитывая их возможности, следует ожидать развития неких квантово—нейроморфно-классических решений.

Главное преимущество от развития этих технологий – ИИ-модели станут менее требовательны к количеству вычислительных мощностей и энергии, будут более «умными». Как мы ранее смотрели, тот же ChatGPT 4 имеет уже намного больше нейронов, чем человек, это огромная модель, но она потребляет огромное количество энергии и обслуживает ее целый штат очень дорогих специалистов. При этом его нельзя назвать более умным, чем человек. И это при том, что он обучен на таких объемах данных, которых ни один человек не получал в свое распоряжение.

saege5b

ПЛИС в какой-то мере отвечают "нейроморфности" - куча (почти) одинаковых ячеек, на базе которых вполне реализуются (не только) простые решатели.

У топовых ПЛИС количество ячеек больше миллиона, а количество нейронов у нематоды 302 штуки. Есть где развернуться и в чём поэкспериментировать.

Dzhimsher Автор

Да, сейчас будет поиск разных решений, гибридов и т.д. Проблема лишь одна и фундаментальная - нет людей с компетенциями и инвестиций (которые по принципу R&D, а не под гарантии, и для МСБ и исследователей, а не корпорациям и университетам). Так что паровозу еще долго набирать скорость :)