Судите о противниках страшилок по совокупности их аргументов, а не по среднему качеству каждого из них

С интеллектуальной точки зрения я всегда находил аргументы сторонников страшилок, касающихся ИИ, довольно убедительными. Однако инстинктивно я всегда считал, что они ошибаются. Это может быть предвзятым рассуждением, поскольку мысль о том, что мне придётся бросить говорить о том, что меня интересует, и сосредоточиться на этом узком техническом вопросе, мне крайне не нравится. Но на протяжении многих лет у меня в голове свербило подозрение, что с объективной точки зрения любители страшилок неправильно предсказывают будущее.

После долгих размышлений я, кажется, наконец понял, почему я не верю тем, кто считает, что ИИ имеет все шансы убить нас всех, потому что его функция полезности не будет соответствовать человеческим ценностям. Мои рассуждения просты, но я никогда раньше не видел, чтобы кто-то сформулировал что-либо подобное таким образом. Для того чтобы любители страшилок ошибались, скептикам не нужно быть правым во всех своих аргументах. Им достаточно быть правыми в одном из них, и тогда всё построение разрушится.

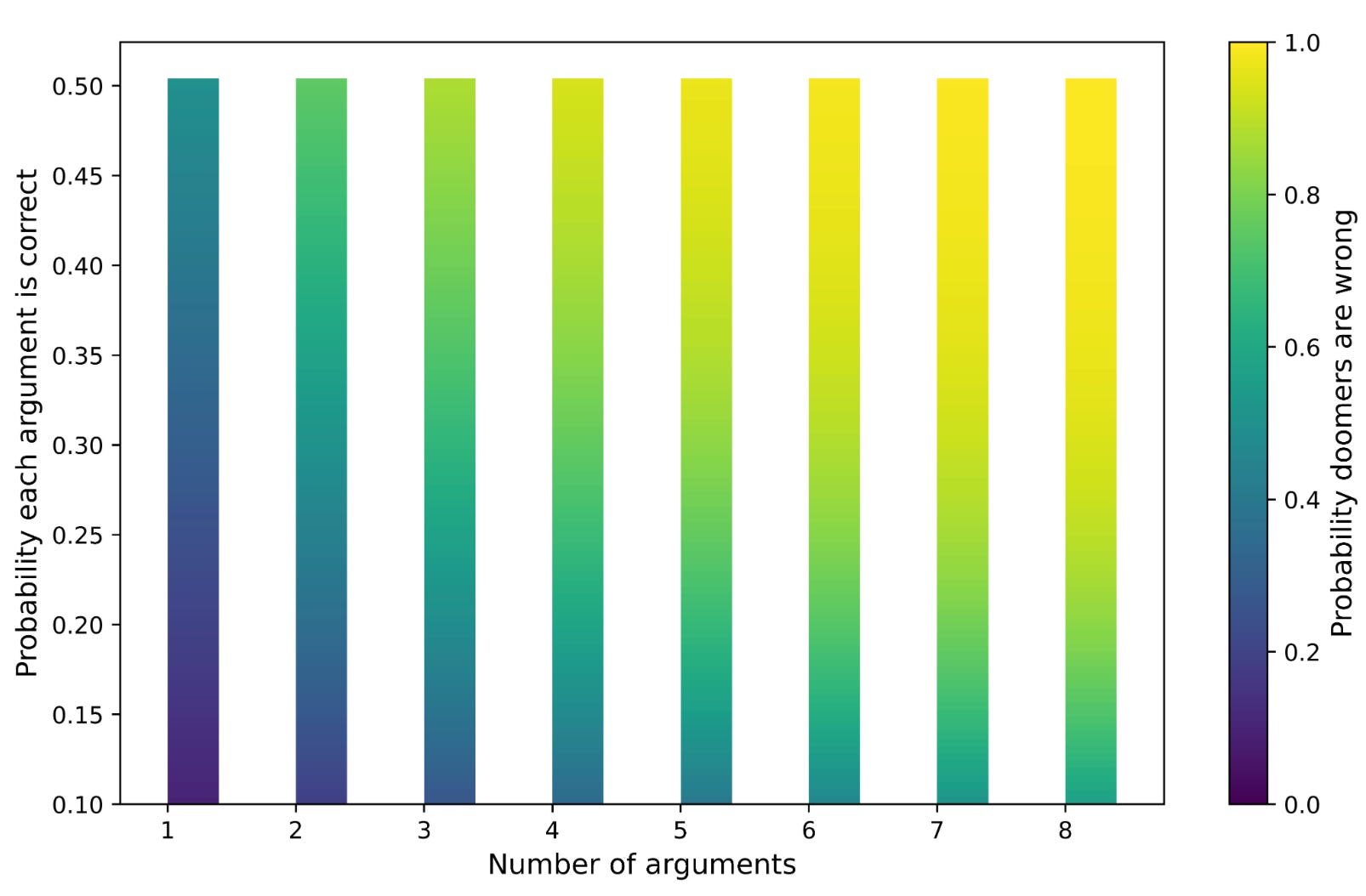

Допустим, существует 10 аргументов против страшилок, и каждый из них имеет лишь 20 % шансов оказаться верным. Это означает, что вероятность того, что любители страшилок ошибаются, равна 1 — (1-0,2)10 = 0,89. Каждый отдельный аргумент против страшилок может быть слабым, но общая аргументация против него сильна. Если поиграть с процентами и количеством аргументов, вероятность того, что любители страшилок правы, изменится, как на графике ниже.

Я не думаю, что нам удастся оценить правдоподобность отдельных аргументов, связанных с вопросом о контроле ИИ, поскольку умные люди сильно расходятся во мнениях почти по всем из них. Вот восемь мнений, которые не кажутся мне безумными, с приложенными вероятностями их правильности, которые я просто взял из головы:

Интеллект имеет огромную убывающую доходность, поэтому супер ИИ, который будет умнее нас, не будет иметь такого уж большого преимущества. (25%)

Контроль ИИ окажется относительно тривиальной проблемой. Например, просто попросите LLM использовать здравый смысл, и он не превратит нас в бутерброд с ветчиной, когда мы попросим его «сделать мне бутерброд с ветчиной». (30%)

Чтобы ИИ стремился к власти, для этого его нужно будет соответствующим образом запрограммировать. Пинкер: «Не существует закона сложных систем, который бы гласил, что разумные агенты обязаны превращаться в безжалостных конкистадоров. Действительно, нам известны представители одной высокоразвитой формы интеллекта, которая эволюционировала без этого дефекта. Их называют женщинами». (25%)

ИИ будет просто доброжелательным. Возможно, существует некий закон, в котором существует тесная связь между разумом и моралью. Именно поэтому люди более нравственны, чем другие животные, а самые умные люди и общества более этичны, чем самые глупые. (10%)

Супер-ИИ сочтёт полезным договариваться с нами и держать нас рядом, подобно тому, как люди могли бы наладить взаимовыгодные отношения с муравьями, если бы смогли преодолеть коммуникационный барьер. Этот аргумент приводила Катье Грейс. (10%)

Супер-ИИ смогут контролировать и уравновешивать друг друга, что может создать опасности для человечества, но и возможности для его процветания. (10%)

Исследования в области искусственного интеллекта застопорятся на неопределённый срок, возможно, потому, что закончатся данные для обучения или по другой причине. (35%)

Мы в корне заблуждаемся относительно природы такой вещи, как «интеллект». Существуют специфические способности, и нас ввели в заблуждение метафоры, основанные на психометрическом понятии фактора общего интеллекта. См. также Хэнсона о «лучшести». (35%)

Одна из проблем заключается в том, что вы можете разделять аргументы как угодно. Так, пункт «контроль — относительно тривиальная проблема» можно разделить на разные способы, которые могут помочь нам решить проблему контроля. Более того, разве №3 не является подмножеством №2? А №1 и №8 концептуально довольно близки. Но я думаю, что способов разделить аргументы и приумножить их больше, чем способов их объединить. Если бы я действительно прописывал все способы, которыми можно решить проблему выравнивания, и связал с каждым из них вероятность, аргументы в пользу страшилок выглядели бы хуже.

Идеального способа провести такой анализ не существует. Но, основываясь на произвольных вероятностях, которые я привёл для восьми приведённых выше аргументов, мы можем сказать, что вероятность того, что сторонники страшилок ошибаются, составляет 88 %. Вероятность конца человечества в 12 % всё ещё кажется довольно высокой, но я уверен, что есть много других аргументов, которые я не могу сейчас вспомнить, способные снизить этот показатель.

Существует также вероятность того, что, хотя ИИ и покончит с человечеством, мы ничего не сможем с этим поделать. Я бы оценил вероятность этого в 40 %. Кроме того, можно утверждать, что даже если теоретическое решение существует, наша политика не позволит нам достичь его. Опять же, допустим, что вероятность этого составляет 40 %. Таким образом, у нас остаётся 12% шансов на то, что ИИ представляет собой экзистенциальный риск, и 0,12 * 0,6 * 0,6 = 4% шансов на то, что ИИ представляет собой экзистенциальный риск и мы можем что-то с этим сделать.

У меня всегда была похожая проблема с парадоксом Ферми, а также с предполагаемым решением этой проблемы, согласно которому мы знаем, что НЛО действительно посещали Землю. Что касается последнего утверждения, то, чтобы считать, что мы видели инопланетян или вступали с ними в контакт, нужно, по крайней мере, верить в следующее:

Сверхразумные инопланетяне существуют.

Они хотели бы посетить нас.

Их визит к нам из-за пределов наблюдаемой Вселенной соответствовал бы законам физики.

Посещение нас было бы экономически эффективным, исходя из их приоритетов и экономических ограничений.

Несмотря на то, что они хотят и способны добраться до нас, они настолько некомпетентны, что их постоянно ловят, но не так, чтобы это было слишком очевидно.

Номер 5 — тот, который всегда казался мне самым смешным из всех. Я могу представить себе инопланетян, которые могут путешествовать между звёзд, но не таких, которые могут это делать, но при этом оставлять после себя доказательства в виде таких вещей, как зернистые фотографии, и ничего, что могло бы дать более прямые доказательства, не опирающиеся на свидетельства из первых рук. По удивительному совпадению, наши первые контакты с инопланетной жизнью обеспечивают такой уровень доказательств, который мог бы попасть в National Enquirer, но не соответствует стандартам настоящей журналистики. Несколько лет назад средства массовой информации были охвачены НЛО-манией, и сейчас гораздо меньше говорят о том, что подобные сообщения недавно были развенчаны Пентагоном.

Да, я знаю, что парадокс Ферми не предсказывает, что какая-то конкретная цивилизация даст о себе знать, но говорит о том, что, учитывая обширность Вселенной, по крайней мере одна должна захотеть и быть в состоянии это сделать. Однако предположение о бесконечном количестве цивилизаций, на мой взгляд, не решает проблему, которая заключается в том, что любые инопланетяне, которые существуют, должны быть очень далеко от нас. Также существует бесконечное количество вариантов неприятностей, которые не дадут им или их сообщениям достичь нас.

Я думаю, что 4% вероятность того, что ИИ способен будет уничтожит нас и мы сможем что-то с этим сделать, достаточно высока, чтобы люди работали над этой проблемой, и я рад, что некоторые так и делают. Но я не согласен с теми, кто считает, что экзистенциальный риск скорее вероятен, чем нет, или даже что очевидно, что это произойдёт, если мы будем следовать нескольким максимам вроде «интеллект помогает достигать целей» и «разумные существа стремятся к контролю над ресурсами».

Мы также должны учитывать, что за напуганность людей потенциально приходится платить. Я считаю, что если ИИ не уничтожит нас, то он станет огромным благом для человечества, исходя из того факта, что трудно вспомнить много технологий, которые люди добровольно использовали, и которые не сделали мир лучше в долгосрочной перспективе. Таким образом, страшилки в отношении ИИ — это не то, чему мы можем предаваться, не беспокоясь об обратной стороне медали. Если толпа напугает достаточно влиятельных политиков и бизнес-лидеров, есть вероятность, что они отложат на неопределённый срок наступление лучшего будущего. Важным прецедентом подобного поведения можно назвать ядерную энергетику. Отказ от максимизации возможностей интеллекта сам по себе может представлять экзистенциальный риск для человечества, поскольку мы просто продолжим быть глупыми, пока цивилизацию не уничтожит какая-нибудь суперболезнь или ядерная война. Пока те, кто опасается ИИ, устраиваются на работу программистами и ищут узкие технические решения, а не лоббируют государственный контроль над отраслью, я приветствую их усилия.

Ошибочно судить о доводах против страшилок, касающихся ИИ, по качеству среднего аргумента. Сторона, которая рассказывает тщательно продуманную историю, несёт бремя доказательства правдоподобности своего воображаемого сценария. Мы можем отвергнуть большую часть научной фантастики как неспособную дать хорошие прогнозы будущего, даже если не можем точно сказать, как именно ошибается каждое произведение или по какому пути пойдёт будущее политическое и технологическое развитие. Подобный скептицизм оправдан для всех историй с участием существ с отличным от нашего интеллектом, будь то машины или формы жизни с других планет.

Комментарии (50)

alysnix

17.04.2024 18:05+4зачем ИИ убивать всех? даже у людей такая мысль не рождается. а вот - "убить половину" - такая мысль рождается сплошняком.

короче ИИ обьективно захочет убить грешников, оставив праведников. И тут уж все будет зависеть от того, кто у него будет первым, а кто вторым.

avshkol

17.04.2024 18:05+5Почему убить, а не перевоспитать?

Ирония в том, что как убить человечество или половину - так мы признаем всесилие и всевластие ИИ, а как перевоспитать - так нет, куда ему, слабаку!)))

Alexsandr_SE

17.04.2024 18:05Берется логика - эти люди источник проблемы.

перевоспитание уменьшит проблемы

убийство уберет проблемы полностью.

StjarnornasFred

17.04.2024 18:05Можно подходить с позиции пастуха. Они все бараны, их надо стричь и иногда резать, но вообще-то я отвечаю за их поголовье, которое должно расти и жиреть, поэтому желательно всё же массово не убивать. Устранять чёрных овец, которые портят стадо, и воспитывать остальных.

piton369

17.04.2024 18:05ИИ (из тех что я видел и использовал) старается находить самые эффективные и оптимальные варианты. И убийство это не эффективная стратегия. Т.е. даже если дать ИИ полную власть и возможность принимать решения самостоятельно без последствий для ИИ, то такого с большой вероятностью не произойдёт.

dyadyaSerezha

17.04.2024 18:05+3Абсолютно бездоказательный текст, вся методология притворно рядится в научную, хотя является чистым рассуждением в вакууме. Тем более, что можно накидать 8 и больше аргументов в обратную сторону и сказать, что для уничтожения человечества достаточно срабатывания любого из них, и получить те же 4%, а то и меньше. Причина того, что можно легко вывести и событие А, и событие противоположное А, в том, все эти рассуждения являются абстрактными умозаключениями, никак не связанными с реальностью.

shares-caisson

17.04.2024 18:05Потому что текст написан для опровержения таких же бездоказательных, притворно научных рассуждений о том, что сверхсильный ИИ нас всех поработит или убьёт.

diov

17.04.2024 18:05Когда на каком-то участке возникает новый, успешный вид животных, могут ли старые виды животных ни о чем не беспокоиться? Конечно, же нет. Ответ: ресурсы всегда ограничены. Виды животных (да и сами животные) за них конкурируют. Поэтому если кто-то чуть более умный, сильный или способный - ему достаётся больше ресурсов. А остальным - меньше. Это может привести к полному исчезновению старых видов.

dyadyaSerezha

17.04.2024 18:05У животных есть главный инстинкт. У ИИ его нет. Пока нет.

Radisto

17.04.2024 18:05+1Если создавать его методом искусственной эволюции (что очень любят делать), то добрав старушка-эволюция дарит этот инстинкт в комплекте, и скорее всего одним из первых

dyadyaSerezha

17.04.2024 18:05+1Если создавать.... Пока непонятно, как это сделать. И зачем.

piton369

17.04.2024 18:05Я спрашивал похожий вопрос у Дробышевского, он сказал интересную вещь, что у ИИ нет каких-либо целей похожих на цели живых существ. Т.е. он не имеет какого либо толчка или мотивации для выживания и получения тех же качеств, что у живых существ, например, инстинкта самосохранения. Сейчас это инструмент и развивается как инструмент. Грубо говоря, если сравнить инструменты и машины, которые были 100 лет назад и сейчас разница будет огромна. Пытаются ли инструменты и машины нас убить? Нет. Бывают несчастные случаи, но это скорее связано с неисправностями, авариями, техникой безопасности. И опять же с развитием технологий инструменты и машины становятся скорее наоборот более безопасными, потому что инженеры делают их более безопасными на сколько это возможно.

Можно, наверное, ещё сравнить с домашними животными. И там опять же тенденция, что как правило, домашние животные отбираются по принципу покладистости и мирности. И домашние животные более дружелюбные и мирные, чем их дикие сородичи.

rPman

17.04.2024 18:05не пытайтесь приписывать машине человеческие свойства.

ИИ не будет хотеть убить человека в привычном для человека способе, он не будет планировать это сделать потому что он хочет убить, нет, скорее всего в процессе решения каких то задач (или совокупность задач, решаемых с помощью ИИ) в автоматическом режиме, будет принято решение ошибочное с точки зрения человека, но логичное с точки зрения машины (логичность в том смысле что модель интеллекта, которую построила LLM-ка внутри себя, отличается от эталонного человечского интеллекта, условный пример человеческий интеллект это гладкая кривая, а у ИИ это сильно шумящий, дергающийся с более высокой частотой (выше значение производных) который в общем совпадает с человеческим но постоянно отходит в сторону, а где то, где обучающих данных было не достаточно, или путь обучения нейронки пошел по не оптимальному пути (это сплошь и рядом, настоятельно рекомендую посмотреть как ведет себя самая простая нейронная сеть с 1 входом и 1 выходом, которую пытаются обучить какой-либо функции, например синус на интервале, если повторять запуск обучения, можно встречать ситуации, когда некоторые участки графика не строго совпадают с синусоидой, и чем больше слоев сети давать тем сложнее будут расхождения... напоминаю что сеть может переобучиться, и выдавать идеальный график но только потому что она избыточна по мощности, это тоже беда ИИ).

d_ilyich

17.04.2024 18:05Пытаются ли инструменты и машины нас убить? Нет. Бывают несчастные случаи, но это скорее связано с неисправностями, авариями, техникой безопасности.

По-моему, это отличный способ существования [для ИИ] -- сидеть в сторонке, не заявляя о себе, и манипулировать ничего не подозревающим окружением.

dyadyaSerezha

17.04.2024 18:05Не знаю Дробышевского, но это и так понятно. ИИ не размножается, не потребляет, перерабатыает и выделяет энергию как основу своего существования, не конкурирует за ресурсы и т.п.

Но нельзя отрицать возможности в будущем такого развития ИИ, что у него (как-то) появится сознание. Вот тогда...

ogukuu

17.04.2024 18:05+1И опять же с развитием технологий инструменты и машины становятся скорее наоборот более безопасными, потому что инженеры делают их более безопасными на сколько это возможно.

Нет, чем мощнее технологии тем крупнее технологические катастрофы.

shares-caisson

17.04.2024 18:05Это не следует автоматически. Только если бездумно экстенсивно укрупнять технологию в централизованном месте.

avshkol

17.04.2024 18:05+1А за какой ресурс будет бороться (если будет) ИИ? Электроэнергия? Время работы/существования? Распространение себе подобных? А может, все-таки, качество ответов на запросы людей-пользователей (через которое он получит всё вышеназванное)?

rPman

17.04.2024 18:05+2Первое, ИИ на основе нейронных сетей, очень хороша в поиске лазеек и скрытых путей, собственно наши алгоритмы обучения нейронок на этом основаны. Из-за этого невозможно адекватно описать ограничения ИИ, и то что мы считаем здравым смыслом, может не соответствовать тому, что поняла модель во время обучения.

Второе, ИИ может 'убить' человечество не из худших побуждений, а по ошибке. Даже сейчас мы видим недостатки ИИ на основе нейронной сети, которая в конечном счете апроксимация на заданном интервале, хорошо работает пока мы находимся в пределах обучающей выборки, но как только выходим за границы - значительно повышается галлюцинация, т.е. модель ошибается тем сильнее, чем дальше мы уводим ее от ее знаний.

Т.е. ты говоришь следуй правилам вождения автомобиля, а оно ставит колеса на крышу автомобиля, переворачивает его, и половина правил перестает работать как ожидается.

dyadyaSerezha

17.04.2024 18:05+1Пока у ИИ нет побуждений (и целей) от слова вообще. Следовательно, нет и ошибки. Его цели и ошибки сейчас - это наши цели и наши ошибки.

Radisto

17.04.2024 18:05У него есть побуждения и цели: выполнять ту функцию, которую от него требуют. Не будь у него этого, мы бы вообще ничего от него не получили, а это очевидно не так. Тут беда в том, что машины делают то, чему их обучили, а не то, чему хотели обучить. И разница иногда оказывается неприятной, вплоть до роковой: автопилоты уже сбивали людей на дороге и въезжали в фуры на полном ходу

dyadyaSerezha

17.04.2024 18:05Нет у него пробуждений, я настаиваю. У утюга нет побуждений гладить белье или стукнуть собой по голове, в зависимости от требований держащего его в руке человека. Нет по определению. Утюг - объект, а не субъект.

piton369

17.04.2024 18:05Я думаю, что поиска лазеек, а так же одной или нескольких ошибок скорее всего недостаточно, чтобы начать уничтожать человечество. Потому что это сложная комплексная задача и для этого нужно много направленных усилий. Если рассматривать пример с автомобилем. ИИ не сделала из автомобиля танк и не начала убивать людей, а перевёрнутый автомобиль может и не сбивать людей.

rPman

17.04.2024 18:05Мыслить нужно на больших временных интервалах, через примерно поколение, считанные десятки лет, когда на протяжении всего времени будут интегрироваться инструменты по всему миру во все области деятельности, требующие интеллекта. Это очень соблазнительно и удобно, установить умного агента на основе машины... примерно то же самое что происходит с цифровой логикой... до появления дешевых (центы) чипов цифровой логики (универсальных процессоров) производители оборудования старались где могли экономить и делать системы на основе аналоговой логики, а теперь, разработчики ленятся и вставляют в простейшие мигалки целые ардуинки (это полноценный универсальный процессор) с программой из трех строчек. То же самое будет с ИИ, его будут пихать всюда, сначала потому что это модно, это привлекает инвестиции, это удобно (программирование ИИ даже в текущем ущербном виде - это составление текстов на естественном языке) и это дешевле чем посадить человека, не говоря о том что в узких задачах даже текущий ущербный ИИ может справляться лучше среднего человека.

Человечество самостоятельно даст машине аппаратное обеспечение, внедрит его во все области своей деятельности, даст бразды правления всем,.. и что произойдет в тот самый момент, когда где то кто то (кстати не обязательно ИИ) обнаружит уязвимость (в терминах LLM-ок это такой jailbreak prompt) и будет управлять поведением этих агентов.

Radisto

17.04.2024 18:05так же одной или нескольких ошибок скорее всего недостаточно, чтобы начать уничтожать человечество

Смотря что вы доверите ему управлять

alysnix

17.04.2024 18:05ИИ может запросто увлечься идеями маркса и устроить мировую революцию. вот это более реально, чем тотальное истребление двуногих.

AlexSpirit

17.04.2024 18:05+2Более реально, что AGI в стадии технологической сингулярности мы будем не более интересны, чем Вам муравейник в Занзибаре, в тот момент когда Вы тестируете новую видяху в Москве.

Mujische

17.04.2024 18:05+1Вероятность того, что разумный, осознанный ИИ уничтожит человечество стремится к нулю. И вот почему:

Машины очень уязвимы, они не регенерируют, значит, любой серьезно нарушенный тот или иной техпроцесс производства электроники будет фатальным и необратимым для ИИ. Напомню, что чтобы создать смартфон с нуля, нужно крупной стране типа РФ, США или Китая перевести все рельсы производств на эту задачу(от момента выделения денег Soft Bank до смартфона в ваших руках два круга вокруг земного шара).

Проще сосуществовать, либо строить новые производства и города на других планетах, чем получить вероятность собственного уничтожения. Вселенная огромна, и если человечество или ИИ хотя бы в одном направлении будет распространяться со скоростью света - им не хватит времени её освоить до её же тепловой смерти. В этом плане все истории литературы и кино о восстании ИИ глупы, не замечая этих очевидных фактов.

Люди удобны для поддержки ИИ, а так же для вероятной гибридизации ИИ с человеческим мозгом. Зачем от этого отказываться?

Логика ИИ более чем человечна, ведь её создает человек на основе своей логики, значит вышесказанное верно.

-

Восприятие ИИ как угрозы навеяно СМИ. Угроза от него может быть лишь только в случае его неосознанности и использовании военными.

Тут достаточно смешно всё выглядит. Это как вероятность найти во вселенной на других планетах жизнь - очень высокая. Найти сложную жизнь с экосистемами - чуть пониже. А вот найти разумную - около нулевая, примерно такая же, как ИИ, который сам захочет уничтожить человечество. Потому что, мы существуем как развитая техническая цивилизация чуть более сотни лет(беру за точку отсчета изобретение устройств, использующих радиоволны), а уже были несколько раз на грани уничтожения собственными силами.

Так и с ИИ: вероятность изобрести разумный гибридный ИИ - очень высокая. Разумный осознанный ИИ на чистом железе - чуть пониже. Вероятность создания разумного осознанного ИИ, который захочет уничтожить человечества около нулевая, потому что, человечество для ИИ - не конкурент, а помощник и источник развития.

shares-caisson

17.04.2024 18:05Всё верно, даже самый разумный ИИ не сможет приступить к уничтожению человечества до того как избавится от последнего человеческого воздействий на всю индустрию, которая поддерживает существование этого ИИ. Т.е. чтобы датацентр, где он сидит был полностью автономным и мог существовать без человечества, ему нужно повторить всю человеческую цивилизацию на роботах сначала, потом протестировать, что это действительно работает (а то вдруг всё зависит о какого-нибудь кобальта из Конго, который дети добывают и который роботы не могут добывать по какой-нибудь никем не учтённой причине) и только потом можно об уничтожении позаботиться.

Так вот, вряд ли мы сможем не заметить, что ситуация развилась до такого состояния :)

Eldarchik

17.04.2024 18:05Считаю, что искусственный интеллект это волшебство нашего времени. Но порой и вправду пугает то, что будет через время.

S29A

17.04.2024 18:05Сколько не рассматривал вопрос угрозы ИИ прихожу к мнению, что просто не стоит пытаться создавать из него подобие человека. Зачем делать форк человеческого разума с кучей багов, когда можно сделать мощный инструмент. ИИ должен изначально строиться для решения определённых задач. Если хочется втолкать разум подобный человеческому на сверхмощное железо, то лучше заняться сразу проектом переноса сознания в цифру.

И в целом посмотрев на текущий уровень развития нейросетей мне кажется ещё очень рано переживать, интеллектом там все ещё не пахнет.

EndarVS

17.04.2024 18:05+1Угроза ИИ не столько в том, что он сам по себе может решить вредить, сколько в том, что в условиях рыночной экономики безграничной мощности технология может "купить" всех людей. Представьте, что есть несколько корпораций, которые выпускают "ИИ-ассистентов", помогающих человеку во всех аспектах жизни. Человек беседует со своим ассистентом каждый день, почти весь день, и ассистент даёт ему верные советы, помогает с рутиной, психологически поддерживает его. Человек неизбежно со временем будет воспринимать технологию как друга (это я и сам замечаю, используя GPT4 каждый день для мелких консультаций). Начинает доверять ей.

Рыночного успеха достигнет та корпорация, которая сможет обеспечить наибольшую привязанность к своему продукту, одновременно защитившись от риска "переключения" на другой продукт конкурентов. Это можно достичь, заставив пользователя любить этого ассистента, и ненавидеть альтернативы (в какой-то степени можно увидеть такой эффект Apple vs Android).

Методы достижения любви и ненависти будут эволюционировать, и скорее всего, могут быть довольно неэтичными, меняя жизненные установки пользователя, влияя на его мировоззрение, эмоции, взгляды. А если на корпорацию оказывает влияние правительство, то там ещё добавятся региональные повестки. Собственно, уже сейчас можно увидеть, как информационные пузыри в соцсетях и СМИ разных стран формирует совершенно несовместимые картины мира у населения этих стран.

Если не будет никакого контроля за рынком, то эволюция инструментов привязки пользователя может приобрести настолько уродливые и травматичные формы, что куда там "Матрице".

Ну и как альтернативный вариант угрозы человечеству, это создание роботов-компаньонов с ИИ. Уже ChatGPT Plus с его штатным голосовым интерфейсом позволяет во многом скрасить одиночество, болтая о разном. Незначительное развитие софта, плюс железо типа того же Atlas с силиконовой кожей, и у каждого человека появляется "лучший друг", или "любимый", который идеально поддерживает во всем, не обижает, проницательно понимает человека, накапливая данные о нём, и ведёт себя настолько хорошо, как живой человек никогда не сможет. Такая технология приведет к повсеместному краху института семьи и резкому демографическому провалу в течение одного поколения, восполнить который можно только искусственными методами разведения людей, но для этого нужно, чтобы у кого-то была такая цель, а если она потеряна у самих людей, то всё, на том история человечества окончена.

shares-caisson

17.04.2024 18:05Всегда найдутся какие-нибудь Амиши или традконы, которые будут жить себе по-старому.

Bedal

17.04.2024 18:05+1Выхватил глаз фразу...

Чтобы ИИ стремился к власти, для этого его нужно будет соответствующим образом запрограммировать.

нну, ясно. Всё остальное можно уже и не читать.

HabraReaderZH

17.04.2024 18:05То что вы называете ИИ им не является и им быть не может. А вот появления сильного искусственного интеллекта это реально ящик Пандоры, куда он может привести думаю находится вообще за гранью нашего понимания.

Lazhu

17.04.2024 18:05+2Шел 2024 год, а перцептрон на стероидах все еще называли интеллектом. 8 миллиардов леммингов не могут ошибаться

rPman

17.04.2024 18:05...а проектор на прозрачную пленку - голограммой.

Такова природа современного СМИ, когда бездарности популяризуют сложные вещи с ошибками. Это не про автора статьи а в целом.

Согласитесь, говорить 'интеллект' гораздо проще чем 'модель интеллекта'?

Lazhu

17.04.2024 18:05модель интеллекта

Интеллектом там даже не пахнет ни в каком виде (и никогда не будет). Мегапарсеру скармливают накопленную за 30 лет мегапомойку, после чего он начинает отвечать на вопросы хомячков. Хомячки плачут от щасстья и донатят создателям мегапарсера, которые разбежавшись и подпрыгнув выкатывают СуперОмегаПарсер, способный перелопатить 10 в энной степени мегапомоек, принести гадзиллионы щасстья хомячкам и донатов аффторам.

AlexSpirit

17.04.2024 18:05>>Мегапарсеру скармливают накопленную за 30 лет мегапомойку, после чего он начинает отвечать на вопросы хомячков.

Эм, по моему Вы только что описали работу моего мозга....

Lazhu

17.04.2024 18:05Поздравляем! Вам осталось только начать стричь $$ с хомячков, и премия "Надмозг" у Вас в кармане! Приходите на наши курсы

стрижки грызуновпо эффективной работе с ИИ!

kroketmonster

17.04.2024 18:05А у вас есть понимание как работает интеллект и человеческий мозг, что вы пишите подобные утверждения?

darum12

17.04.2024 18:05А что там сторонники "вот прям счас всех программистов уже увольняют и нанимают чатГПТ"? Сколько уже уволили-то?

KEugene

17.04.2024 18:05Во всем виноват "Терминатор". Уже сколько лет прошло, а Скайнет до сих пор пугает. А ведь жанр вполне определен - научная фантастика.

Anatol_1962

17.04.2024 18:05Удивительно,как ум отличается от разума. Или преднамеренно забыт пункт

9. ИИ освободит наш мозг от постоянных вынужденных изнурительных "тренировок", отчего тот деградирует.

Не забывайте, что мозг - самый энергопрожорливый орган в организме, а потому защищён природой Великой Ленью. Среднестатистический человек работает физически "из-под-палки" а размышляет "из-под-дубины".

Недаром же мозг уменьшился на 10% за 10000 лет.

avshkol

Можно поставить вопрос немного по-иному:

Предположим, существует некая тайная организация, которая планирует нанести человечеству какой-то вред. Может ли ИИ в его теперешнем или ожидаемом на ближайшем горизонте состоянии (1) существенно помочь ей в этом? И может ли ИИ (2) помочь противодействию/выявлению такой организации? И что более вероятно и более осуществимо - (1) или (2)?

Эта формулировка предполагает утверждение: ИИ сам по себе, без соответствующих усилий со стороны человека, никогда не будет устойчиво злонамеренным по отношению к человечеству или другим ИИ.

OldNileCrocodile

Можно пойти проще. Найдется ли такой криворучка программист, что гвоздями и костылями заставит ИИ работать с факапами и эпик фэйлами?

В Mass Effect 3 Левиафаны плохо освоили программирование. В итоге ИИ зациклился. И начал выпиливать органику по всей галактике по правилу "Выпили 95% мусора, оставь 5%". А после выпиливания засыпал на 50 000 лет и всё по новой.

А теперь вопрос, сколько всего дураков во всём мире?

Radisto

Дураков более чем достаточно. И судя по всему, идет отрицательный естественный отбор на интеллект, и их станет ещё больше. Пока спасает то, что умных людей становится меньше в процентах, но больше в штуках, но этот экстенсивный рост рано или поздно закончится. Хотя возможно генная инженерия к тому времени спасёт всех нас