Услышали мнение, что пора бы провести некоторый публичный ликбез, особенно для тех кто еще не сталкивался с SDI (Software Defined Infrastructure), Webscale и прочими прогрессивными подходами к построению IT инфраструктур.

Как говорится — The devil is in the detail.

Практически любой современный вендор выпустил на рынок гипер-конвергентные решения, чаще всего находящиеся в зачаточном состоянии, в следствии чего включилась гигантская фабрика по производству макаронных изделий.

В частности, попытаемся помочь разобраться с тем самым потоком маркетинга, а так-же «нюансами» на которые стоит обращать внимание.

Сегодня поговорим об одном из самых образцовых (не технологически) вендоров, фактически примером того к чему приводит засилье маркетологов вместо инженеров.

К сожалению, такое поведение ведет к дискредитации самих понятий WebScale / гиперконвергенции.

Для начала — задам несколько вопросов «от обратного».

По вашему мнению, является ли реально «программно определяемым решением нового поколения» такая технология:

1) Использование закрытого («пропиетарного») (гигантского по размерам — помещается только в 2U сервера) аппаратного PCI адаптера для работы — в частности принудительной компрессии и дедупликации. Что творится внутри этого адаптера не знает никто кроме разработчика (и возможно спец. служб ряда заинтересованных стран), само собой разумеется что все ваши данные проходят через это устройство.

При этом, адаптер является SPOF (Single Point Of Failure, единой точкой отказа), требует полной остановки оборудования для обновления своих прошивок (что обязательно требуется например при апгрейде VMware), причем прошивку может делать только официальный инженер компании.

Фактический подход — вместо использования возможностей современных процессоров Intel (для дедупликации — подсчет sha256 одной инструкцией, с близкой к нулевой просадкой производительности) — создание «навороченных» PCI плат с лимитированной производительностью, но массой проблем.

Позиционирование такого (крайне странного) решения как единственного преимущества над конкурентами (о чем позже).

2) Отсутствие собственного интерфейса управления.

Интеграция в стороннее ПО, в частности VMware vCenter, с соответствующими проблемами, включая классику «сам себя укусил за хвост» — в случае отказа vCenter, работающий на этом же оборудовании, теряется контроль над оборудованием…

Что не даст запустить vCenter обратно без массы «нелепых телодвижений».

3) Использование архаичных RAID технологий внутри решения (RAID 5 и 6 для защиты данных на внутренних дисках серверов)

4) Отсутствие полноценной кластеризации, для скрытия чего придуман термин «федерация», с поддержкой всего 4 нодов (серверов) на один датацентр.

5) Многолетние обещания поддержки других гипервизоров кроме ESXi, с массой анонсов и нулевым результатом.

6) Массовая потеря данных на тестах (по отзывам коллег из крупнейших компаний РФ).

7) Использование более 100 гигабайт RAM на каждом сервере для работы виртуального контроллера (при том что используется пропиетарная аппаратная акселерация). На работу гостевых VM соответственно остается совсем немного.

8) Отсутствие локализации ввода-вывода, что уже критично в 2016 году и будет ультра-критично в 2017.

Несколько SSD дисков могут полностью «забить» пропускную способность 10-гигабитной сети, а NVMe легко сделает это же даже для 40 гигабит.

9) Отсутствие гибкого управления функционалом — например нельзя выключить дедупликацию (которая, как знает большинство инженеров, может приносить вред вместо пользы в достаточно большом количестве случаев).

10) Отсутствие поддержки «растянутых» (Stretch / Metro) кластеров.

11) Нет поддержки Erasure Code.

Что такое EC? Это крайне эффективная технология экономии дискового пространства, комбинирующая (в нашем случае) преимущество безлимитно масштабируемых систем с максимально эффективной полезной емкостью системы храненения данных.

Работает для любых данных, в отличии от дедупликации.

12) Отсутствие распределенного «тиринга» (tiering) между SSD и «холодным» уровнем.

13) Нет поддержки All Flash.

14) Нет поддержки файлового доступа (встроенного, безлимитно масштабируемого, как и положено webscale решению, файл-сервера)

15) Нет поддержки функционала блочного стоража (фактически, реальное использование tier-1 приложений типа Oracle RAC невозможно)

16) Отсутствие интеллектуального «клонирования» мастер-образов операционных систем на локальные SSD, т.е. подверженность инфраструктуры проблеме boot storm.

Что это означает? При одновременном запуске массы VM (от сотен и выше), наблюдаются массовые проблемы ввиду упора в интерфейсы-ввода вывода (в данном случае сеть). Технология Shadow Disk на Нутаникс фундаментально устраняет эту проблему — автоматически сделает копию мастер-образа VM на локальном узле, позволяя загрузиться виртуальной машине с локального-же SSD.

17) Отсутствие возможности обновления ПО без остановки сервиса.

18) Отсутствие возможности самостоятельного обновления без обращения в техподдержку.

19) Отсутствие возможности обновления «одним кликом», требуется масса опасных операций (именно поэтому обязательно обращение в техцентр)

20) Отсутствие возможности автоматизированого обновления прошивок серверов (биосы, BMC, контроллеры, диски и тд)

21) Отсутствие возможности автоматизированого обновления гипервизоров.

22) Невозможность «прикрепить» VM к флешу (SSD уровню).

23) Поддержка DRS только для 2-х серверов.

24) Отсутствие поддержки консистентности данных при создании снапшотов.

25) Фактическая попытка позиционирования решения для SMB рынка (небольших и средних бизнесов) в качестве IT платформы для корпоративного применения.

26) Донесение клиентам ложной информации (об этом чуть ниже).

…

Наверное, для начала хватит. Вам нравится такое решение? Вы назовете его «программно-определяемым»?

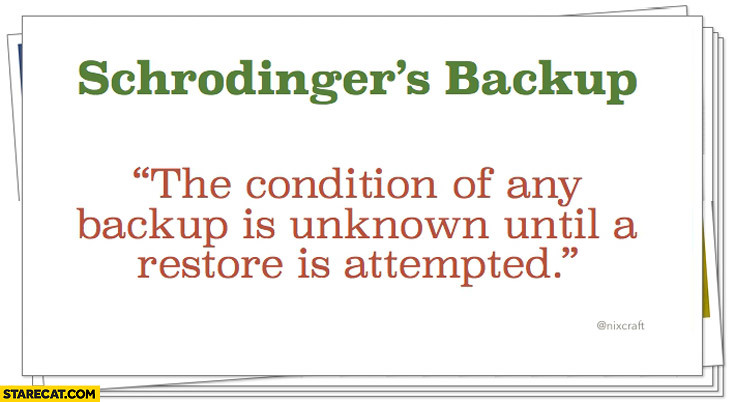

Если да, то можно смело обращаться в Simplivity. Только не забывайте делать резервные копии. :)

Если-же вам кажется что настоящий WebScale это совсем о другом — то добро пожаловать к нам.

Обычно мы не тратим время на «разнос» отстающих технологических решений (тем более — настолько отстающих), но не могли не среагировать на постоянные попытки донесения некорректной информации нашим клиентам.

Идея проста — «в любой непонятной ситуации надо говорить про дедупликацию» (с) Симпливити.

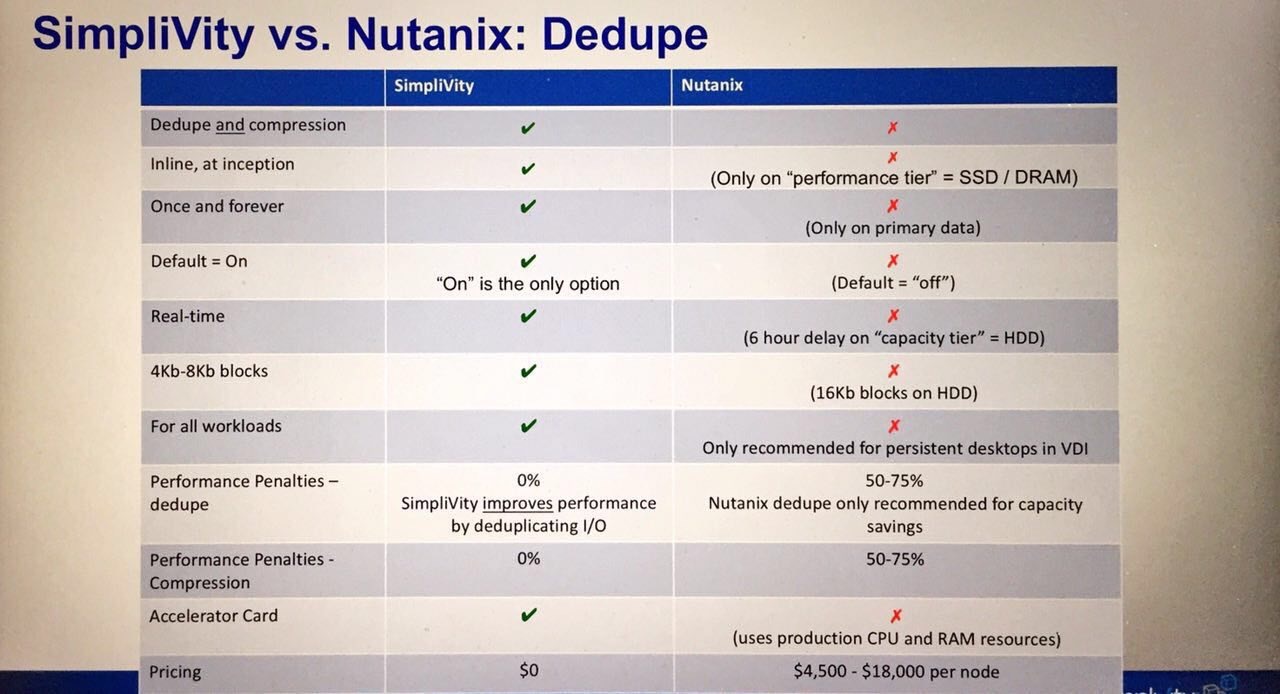

Если коротко, то речь про вот эти пару картинок, которыми Симпливити пытается «конкурировать» и показывает их направо и налево:

Давайте разберем «по капле» этот мутный поток.

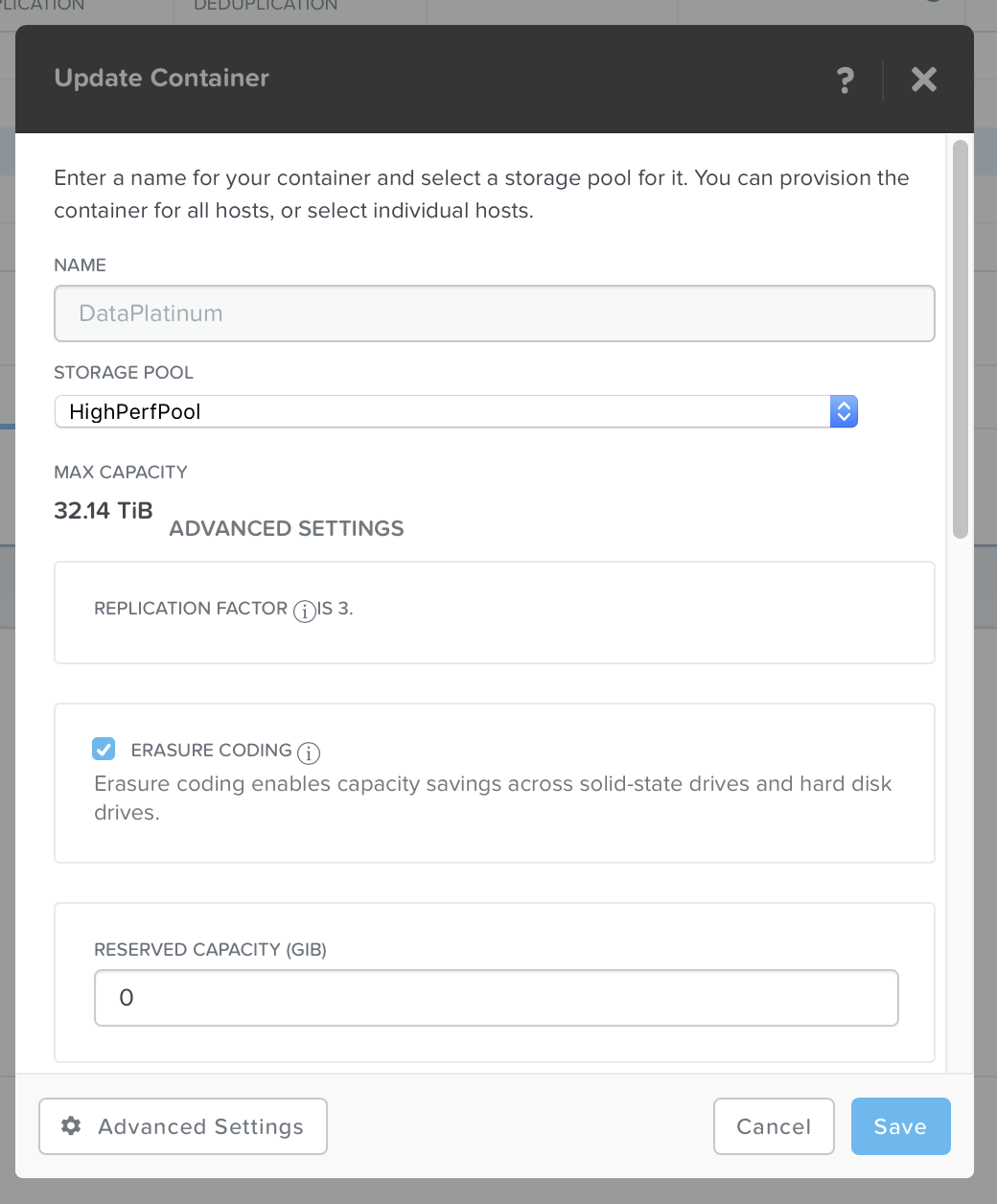

Для начала — настройки виртуальных датасторов Nutanix, показанные на скриншотах. Это достаточно важно, так как на них (для внимательного читателя) уже видно что большинство информации предоставляемой Симпливити — искажение фактов или прямая ложь.

Поехали!

1) Dedupe and compression — ложная заявка, одновременная компрессия и дедупликация полностью поддерживаются, но мы делаем еще лучше — возможен одновременный EC-X (Erasure Code) и компрессия, причем с нулевой просадкой производительности (отложенные map-reduce процессы в фоне).

Кстати, Nutanix умеет делать даже дедупликацию RAM кэша (применяемого при чтении данных) — это вообще уникально.

2) Once and forever — ложная информация, мы можем делать EC-X / компрессию / dedupe (!) в отложенном режиме, причем по всему кластеру. Это намного эффективнее дедуплекации «на лету» с помощью пропиетарной 2-х юнитовой PCI платы c ограниченной производительностью.

3) Default = on — это огромный минус Симпливити, нет возможности тонкой настройки решения под конкретные задачи. Например, для линкованных клонов (с которыми собственно на Симпливити огромные проблемы) — дедупликация практически полностью бесполезна.

4) Real-time — ложная информация, Нутаникс умеет делать как «на лету» (за счет аппаратных инструкций Intel процессоров и подсчета SHA256 контрольных сумм) так и в отложенном режиме, причем задержка может быть точно настроена (от минут до многих часов).

5) 4kb-8Kb — ложная информация, на Нутаниксе можно регулировать размер блока для дедупликации

6) For all workloads — некорректно, дедупликация в массе сценариев не приносит никаких преимуществ но при этом (в случае inline, даже аппаратного) вносит повышенные задержки. Nutanix, за счет возможности «отложенной» дедупликации не имеет таких проблем.

7) Performance Penalties — ложная информация, просадка производительности практически нулевая для inline (за счет использования аппаратных инструкций процессора) и вообще нулевая для отложенной распределенной дедупликации.

Не забываем, что Симпливити приходится использовать как программный контроллер (первый «слой»), так и аппаратный адаптер (дополнительный слой).

8) Accelerator Card — вот тут полная правда, гигантская пропиетарная плата, с массой проблем (о них писалось выше), являющаяся точкой отказа.

Наше решение — 100% software defined, при этом показывающее выдающиеся результаты производительности (4 узла All Flash легко выдадут более 600 тысяч IOPS).

Кажется, тут кто-то не умеет программировать.

Дополнительную «изюминку» придает то, что контроллер Симпливити требует намного больше аппаратных ресурсов (память и процессор) чем Нутаникс, при том что требуется еще и аппаратный акселератор.

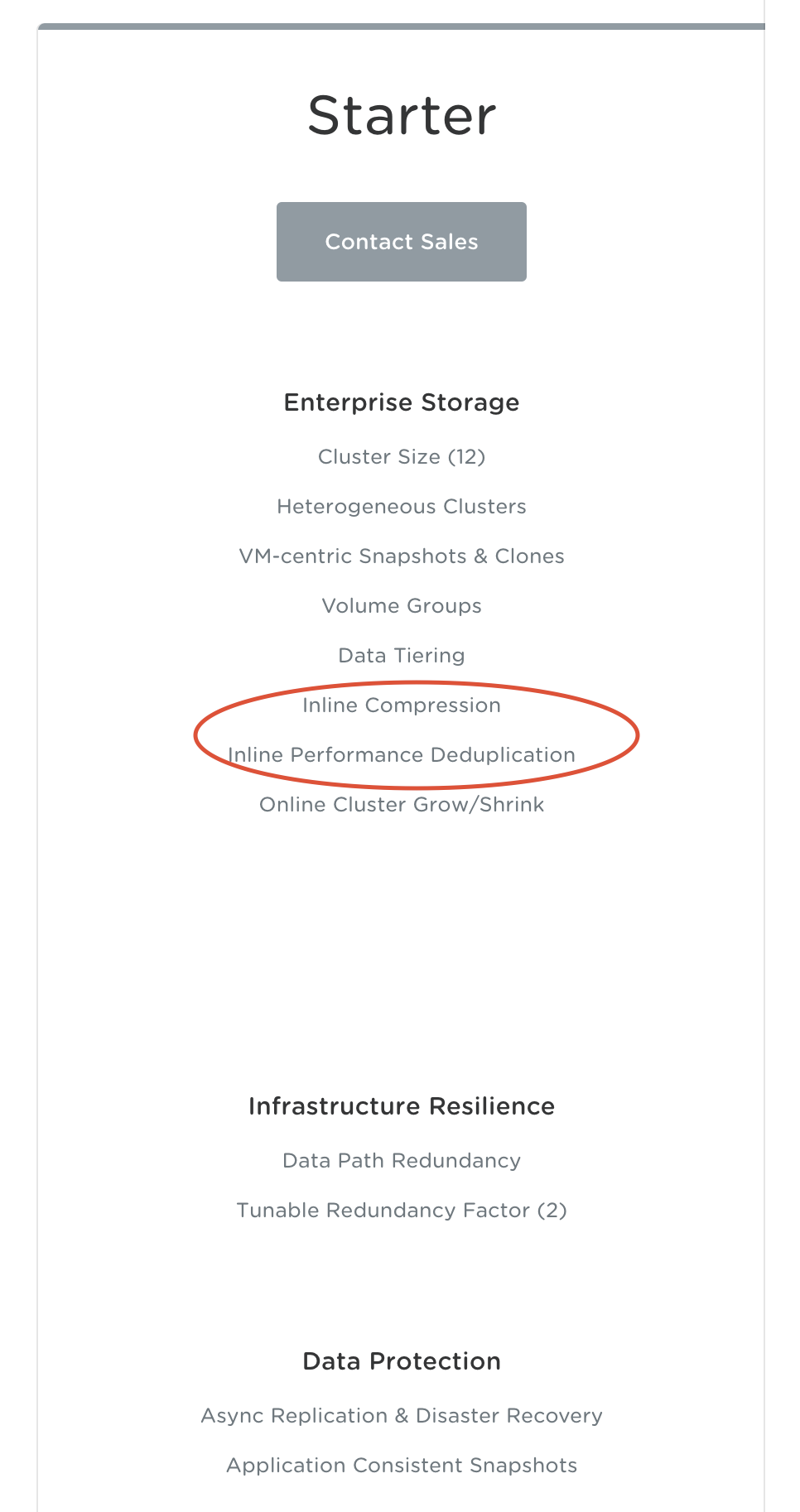

9) Pricing — ложная информация, как легко заметить — дедупликация (и бэкапы) у нас встроены даже в базовую starter редакцию, так-же как наше решение для SMB (Nutanix Express) и полностью бесплатную Community Edition.

Перефразируя, дедупликация и бэкапы для всех клиентов бесплатны и встроены во все версии лицензий.

www.nutanix.com/products/software-editions

10) Simple VM-level Backup — искажение фактов, на Нутаникс это не завязано на vCenter, который сам по себе является узким местом.

Работает для любого гипервизора (включая ESXi), поддерживается консистентность данных (что не может делать Симпливити).

Возможно пофайловое восстановление (о котором Симпливити вообще заявляет что они единственные в мире это сделали, что конечно-же является обманом).

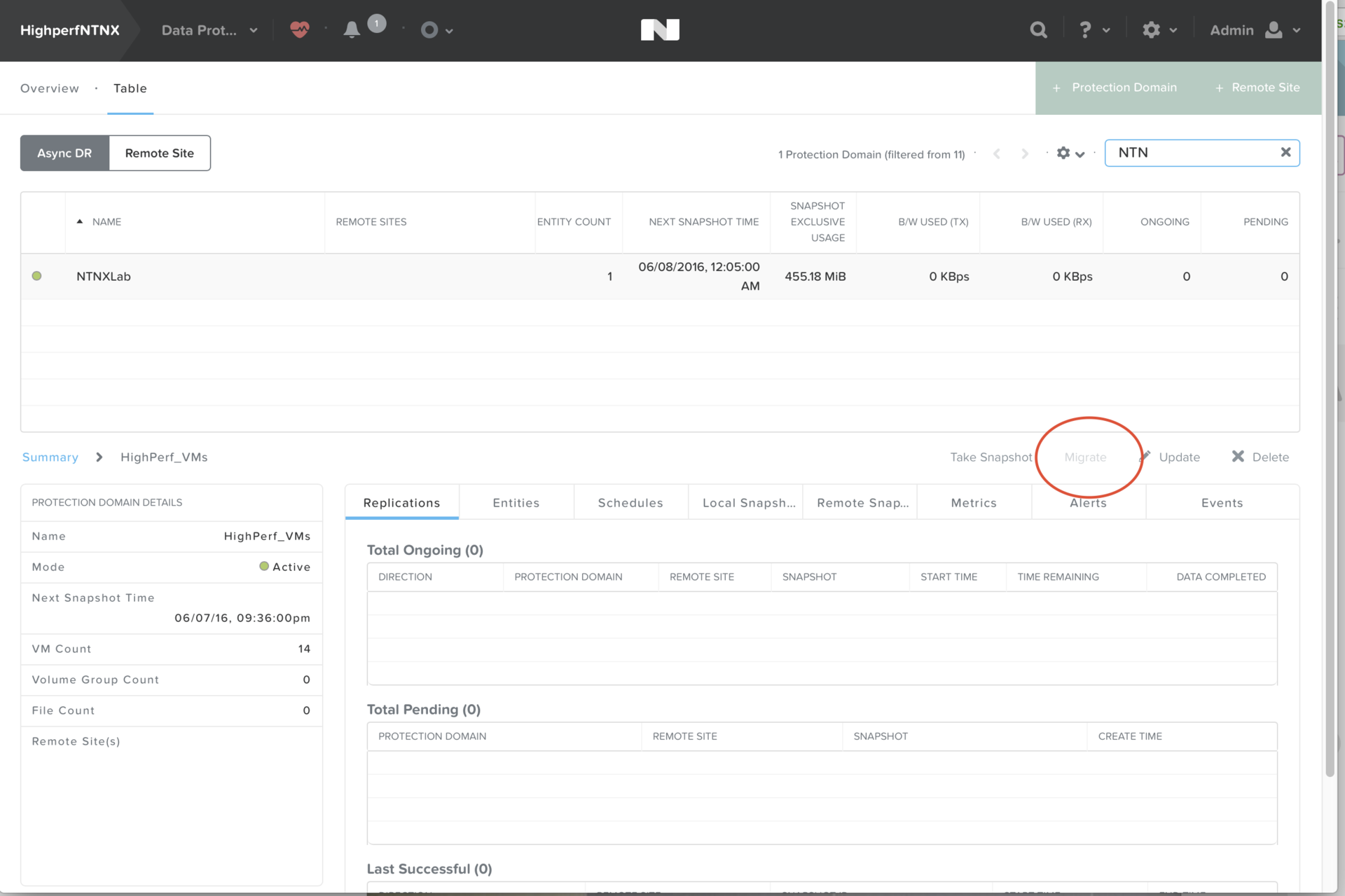

11) No need for protection domain — действительно, Симпливити не умеет оперировать группами виртуальных машин (так как умеем мы), что не позволяет создавать группы защиты VM (например, описывающие ваше приложение).

12) Single Click Data Migration — не очень ясно что хотели сказать господа, но похоже опять обман. На Нутаниксе миграция данных выполняется нажатием одной кнопки «Migrate», причем в отличии от Симпливити — может мигрировать одновременно десятки / сотни / тысячи / миллионы виртуальных машин (те самые группы защиты)

13) No need for external backup applications — ложная информация, в Нутаникс как встроены мощные backup возможности (включая возможность бэкапа в облака Azure и AWS), так и существует интеграция с ведущими игроками рынка (например Commvault нативно поддерживает Nutanix, включая наш стек виртуализации AHV.

Мало того, мы дали возможность восстанавливать данные на уровне гостевых VM — пользователь виртуальной машины может самостоятельно восстановить необходимую ему информацию (Nutanix Guest Tools). Само собой, Симпливити так не умеет.

14) 10 minutes RPO — ложная информация, снапшоты данных можно делать с пересекающимися расписаниями и намного чаще чем раз в час.

…

Каков итог? Наша рекомендация — самостоятельно изучать материалы (в нашем случае — Nutanix Bible поможет детально разобраться в решении), не давать возможности «увести фокус в сторону» (когда вендор пытается выдать маловажную функциональность за «прорыв»), задавать вопросы.

Ничего сложного, правда? :)

Комментарии (17)

AntonVirtual

07.06.2016 13:55VMware vs Hyper-V образца 2009-2010 года

shapa

07.06.2016 14:55Примерно так, да. На момент релизов HV перых ESXi уже была реально рабочей технологией с массой функционала, при том что HV тех времен (в отличии текущего положения дел) был мягко говоря «особенным» продуктом.

Karroplan

07.06.2016 14:35а с iops-ами на запись у вас до сих пор все так же плохо?

shapa

07.06.2016 14:54Удивительное рядом…

Про «проблемы с IOPS на запись» — сами тестировали или «где-то слышали»?

Проблем никогда не было (какие уж там проблемы если на SSD все пишет), другой разговор что с апдейтами ПО в разы еще поднята производительность (фактически упор уже в скорость работы SSD).

Только что запустили в одном из крупнейших российских банков 12 нодов — 600 тысяч IOPS на запись спокойно показывает.

navion

15.06.2016 23:06Давайте ваше SPC-1.

AntonVirtual

15.06.2016 23:23А вы сами-то результаты SPC-1 давно видели?

На сегодня там нет ни одной распределенной СХД. Максимальное распределение — это двухнодовые зеркала.

По спецификации SPC-1 состоит из трех потоков приложений (грубо 3 ВМ). Максимальная конфигурация кластера не только Nutanix, а вообще любой распределенной SDS, которая хоть как-то, хоть отдаленно похоже на правду может быть протестирована SPC-1 — это три узла, т.е. по сути минимальная конфигурация.

Линейный рост общей производительности кластера с добавлением узлов? Не, SPC-1 не в курсе.

navion

15.06.2016 23:49XIV архитектурно выглядит как распределённая СХД и для неё SPC-1 есть.

shapa

16.06.2016 00:32IBM GPFS (== XIV)? который я еще в mamba.ru использовал 16 лет назад?

Анекдот про стюардессу после крушения на острове я думаю не стоит напоминать.

navion

16.06.2016 14:24XIV это XIV. Там тоже серваки набитые дисками с линейным масштабированием и размазыванием блоков по всем нодам.

AntonVirtual

16.06.2016 17:04С совмещенной точкой исполнения и хранения, уровнями защиты с гранулярностью на ВМ, с добавлением узлов и реально софтовая система. Без выделенных контроллерных модулей.

Хотя конечно нужно признать, что XIV не классическая монолитная СХД, а гридовая. Но почему только XIV тогда, и ни слова об Equalogic?

shapa

16.06.2016 17:32XIV, чтобы хоть как-то отдаленно сравнивать с Нутаникс — это Sonas, XIV + GPFS + пару килограмм косметики.

Которая исходит из надежной работы дисков «внизу», за счет чего возможна как минимум временная потеря данных.

Ну а если говорить об XIV как «тупой» блочной хранилке — то сравнение мягко говоря притянуто за уши.

Причем (вот сюрприз-то!) Нутаникс в ближайшем апдейте выпускает GA версию «безлимитно масштабируемой блочной хранилки» — тобишь умеет все то что умеет XIV + GPFS, но только это 5% от общего фунционала Nutanix XCP.

shapa

16.06.2016 00:30Вы на полном серьезе предлагаете в 2016 году нам тестироваться тестом 2001 года разработки?

Ок, приносите дискетки и дисковод.

9 October 2001 1.0

SPC Benchmark-1? (SPC-1) Official Specification

Description

The first official release of the SPC Benchmark-1TM (SPC-1) specification. Approved unanimously by the SPC membership.

AntonVirtual

16.06.2016 17:17Официальная история SPC-1. Статья от 2002 года.

«The SPC counts IBM, HP, Sun, and Veritas among its members. EMC resigned its membership last year when it said that the test then under development would not measure real-world performance, because it would not properly measure the effectiveness of caching algorithms. Yesterday it said: „The test measures a single point in an extremely wide spectrum of use. If you look at the results it measures spindle speeds. If IO requests are continually going to disk, basically that's what you're measuring.“ The SPC has said previously however that it used techniques patented by IBM to generate test data which it insists closely resembles a real workload.»

EMC, мировой лидер в технологиях СХД, и бесспорно одна из самых технологически продвинутых компаний, вышла из совета с комментарием «это не нагрузки из реального мира и совершенно никак не учитывается эффективность кэширующих алгоритмов». SPC-1 измеряет скорость со шпинделей.

shapa

16.06.2016 17:21Редкий случай, когда мы полностью поддерживаем решение EMC.

SPC-1 не тест реальной производительности, но просто виртуальные цифры «ни о чем».

navion

16.06.2016 18:19Так у вас никаких тестов нет и запрет на публикацию независимых результатов.

shapa

17.06.2016 14:25Потому что единственное реальное тестирование — запуск конкретных «боевых» задач клиента, где мы как раз и показываем все что умеем.

Под тесты и прочую мишуру мы совершенно не занимаемся оптимизацией, ввиду очередного надувательства большинства таких тестов.

Для приближенного к реальному тестированию мы сделали X-Ray, который в следующей версии возможно сделаем публичным — сейчас обкатываем с ключевыми клиентами.

IamKarlson

горящий_стул.jpg