Наши коллеги из компании SiteSecure провели исследование безопасности коммерческих сайтов в зоне .ru в первом квартале 2015 года. Его результаты оказались весьма интересными, поэтому мы решили опубликовать их в нашем блоге.Целью исследования является не только определение состояния безопасности сайтов в доменной зоне .ru, но и роль поисковых систем в этом.

Google и Яндекс все еще медленно определяют опасные сайты.

В этом есть одновременно плохая и хорошая новость. Плохая новость для пользователей в том, что они могут попасть на опасные или зараженные вирусами сайты, не получив своевременно привычного предупреждения «Этот сайт небезопасен» от поисковой системы. Хорошая новость для владельцев сайтов – они могут успеть отреагировать и устранить проблему быстрее, чем сайт попадет в черный список поисковой системы, но при одном условии – если самостоятельно обнаружат наличие проблемы быстрее, чем это сделает поисковая система.

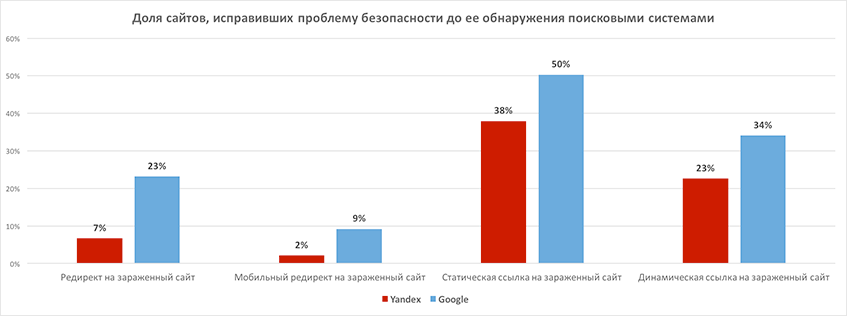

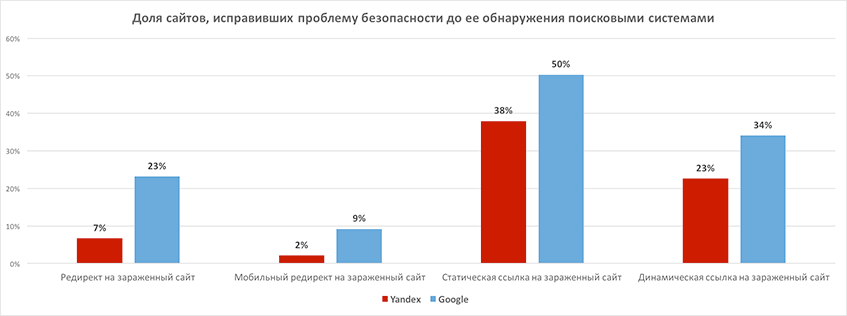

Доля сайтов, где проблема безопасности была обнаружена, но сайты не были включены в черные списки поисковых систем:

Наше наблюдение показало, что Google и Яндекс все еще медленно и не полностью выявляют наличие на сайте проблем с безопасностью и угроз пользователям. (В одном из следующих исследований мы проверим, кто быстрее — традиционные антивирусы или Google с Яндекс). По сравнению с прошлым годом Яндекс нарастил свои возможности – раньше он выявлял проблемы в два раза чаще чем Google, а сейчас – уже в 2,5 раза чаще. Тем не менее, владельцам сайтов недостаточно полагаться только на диагностику средствами для вебмастеров Яндекс и Google – когда поисковая система пришлет оповещение о проблеме, то сайт уже будет находиться в черном списке, а значительная часть трафика на сайт будет потеряна и каждый час или день до решения проблемы будет приносить потери лидов, продаж и репутации сайта.

Следует оговориться, что приведенная на графике статистика была получена в ходе единовременного сканирования сайтов, поэтому мы не можем сейчас достоверно сказать, сколько времени было у владельцев сайтов на устранение проблемы до того, как сайты попали в черные списки поисковой системы. Мы планируем узнать это в ходе наших дальнейших исследований.

Обобщая, можно сказать следующее, что на момент проведения нами сканирования сайтов:

- Яндекс еще не обнаружил от 30 до 65 процентов проблем на сайтах

- Google еще не обнаружил от 50 до 85 процентов проблем на сайтах

Основные отличия исследования 2015

Проведя первые исследования безопасности сайтов в начале 2014 года, мы приняли решение проводить исследования на регулярной основе и развернули для этого постоянно действующую инфраструктуру, которая находится в облаке Amazon и представляет масштабируемый до сотен серверов кластер машин, объединенных диспетчером задач RabbitMQ и позволяющий осуществляющих мониторинг нескольких сотен тысяч сайтов. За первый квартал 2015 года мы собрали в и проанализировали 2,5 миллиона записей об инцидентах, обнаруженных в ходе постоянного мониторинга более 80.000 сайтов.

Дополнительно специально для данного исследования мы совместно с сервисом сбора аналитических данных iTrack провели единовременное сканирование 240 тысяч сайтов с доменами в зоне .ru, зарегистрированных юридическими лицами (предположительно для коммерческих целей).

Таким образом, по сравнению с предыдущим исследованием мы увеличили количество проверяемых сайтов с 30.000 до более чем 300.000, а также наблюдали за частью сайтов непрерывно в течение четырех месяцев. Фокусировка на бизнес-сайтах – еще одно отличие от исследования прошлого года, в котором выборка сайтов была сделана случайным образом из числа доменов в зоне .ru и могла включать персональные домашние страницы и заброшенные сайты.

Краткие итоги исследования 2014

По результатам исследования, проведенного в октябре 2013 — январе 2014, каждый седьмой сайт в Рунете подвержен риску финансовых потерь из-за проблем, связанных с безопасностью. И если крупные игроки рынка решают проблему наймом профильных специалистов и использованием промышленных систем мониторинга и защиты, то сектор СМБ в большей части просто не задумывается о решении подобных проблем заранее, и вынужден реагировать по факту уже понесенных убытков. Основные итоги предыдущего исследования:

- Сайта на бесплатных CMS заражаются в 4 раза чаще сайтов на платных

- Обновление версии CMS снижает риск появления проблем в 2 раза

- Яндекс заносит сайты в черный список в два 2 чаще, чем Google

- Пересечение черных списков Google и Яндекс всего 10%

- Более половины владельцев сайтов не знало о наличии проблем

- Треть продолжали тратить средства на продвижение сайта

- 15% бизнесов прекратили свое существование, а владельцам 10% сайтов, в результате заражения пришлось переделывать свой сайт

После публикации этих данных мы получили много уточняющих вопросов, которые постарались учесть при доработке методологии и постановке задачи на проведение очередного исследования.

Ключевые результаты исследования 2015

Для начала приведем кратко основные результаты исследования, на которые нам показалось особенно важным обратить внимание аудитории.

Устранение выявленных проблем требует значительного времени – в среднем сайт находится в черном списке неделю, что эквивалентно потере четверти месячной выручки для интернет-бизнеса.

Среднее время реакции владельца сайта или вебмастера на обнаруженную поисковыми системами проблему и выведение сайта из черного списка — 1 неделя. То есть интернет-бизнес испытывает неделю простоя, а интернет-магазин лишается четверти месячной выручки. И это без учета потерь средств, вложенных в рекламу (по результатам предыдущего исследования, подтвержденным и в этот раз, около половины владельцев интернет-бизнеса продолжали вкладывать средства в продвижение сайта, который имел проблемы с безопасностью, приводящие к блокировке сайта поисковыми системами).

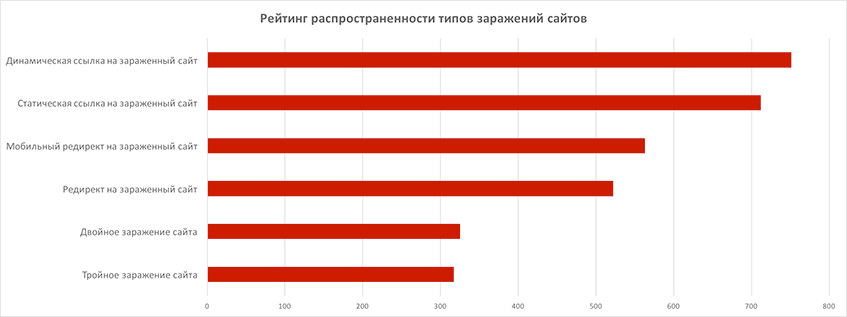

Рейтинг угроз и ситуация с повторными и многократными заражениями

По результатам проверки сайтов на наличие заражений мы составили рейтинг популярности заражений определенного типа. Довольно часто (более чем в 40% случаев) встречаются случаи многократного заражения – двойное и тройное. Под многократным заражением мы в данном случае понимаем различное по способу выполнения внедрение опасного объекта на сайта (например, статическая ссылка и мобильный редирект, динамическая ссылка и статическая ссылка – разные способы). При этом стоит отметить, что повторные случаи попадания сайта в черные списки редки, особенно у интернет магазинов. Вероятно, это объясняется повышенной важностью, которую придают владельцы и администраторы коммерческих сайтов защите после попадания сайта в черные списки.

Одного лечения недостаточно. Наблюдение и профилактика

Большинство из всех сайтов, которые устранили обнаруженные проблемы с безопасностью, успели попасть в черные списки поисковых систем, а затем выведены оттуда. Наибольшего успеха владельцы сайтов и администраторы добиваются в борьбе со ссылками на зараженные сайты. Почти половина всех таких инцидентов была устранена до обнаружения поисковиками. Мы связываем это с тем, что при продвижении сайта часто используются инструменты для контроля за статическими внешними ссылками, а динамические внешние ссылки как правильно обнаруживаются настольными антивирусами, и информация об этом попадает к владельцам сайтов. Труднее всего выявлять редиректы, причем мобильный редирект самостоятельно могли выявить только менее 10% владельцев сайтов. Это объясняется тем, что вредоносные редиректы способны скрывать свое присутствие и значительно хуже выявляются «подручными средствами», в то время как поисковые системы, заботящиеся о защите пользователей, наоборот, достаточно эффективно научились определять в том числе и сложные мобильные и маскирующиеся редиректы.

Доля сайтов, исправивших проблему до обнаружения поисковиками:

В целом же это означает, что бизнесы, не имевшие достаточных собственных средств по контролю за безопасностью сайта, успели понести существенные потери – в среднем неделя простоя, как было отмечено выше, без учета потерь трафика от редиректов с момента их появления на сайте до момента обнаружения поисковой системой. Если бы у владельцев сайтов и веб-мастеров были средства проактивной диагностики и профилактики сайтов, этих потерь можно было бы избежать, используя обнаруженную нами медлительность поисковых систем — проблему можно обнаружить и устранить до того, как поисковый робот зайдет на сайт и пометить его как опасный.

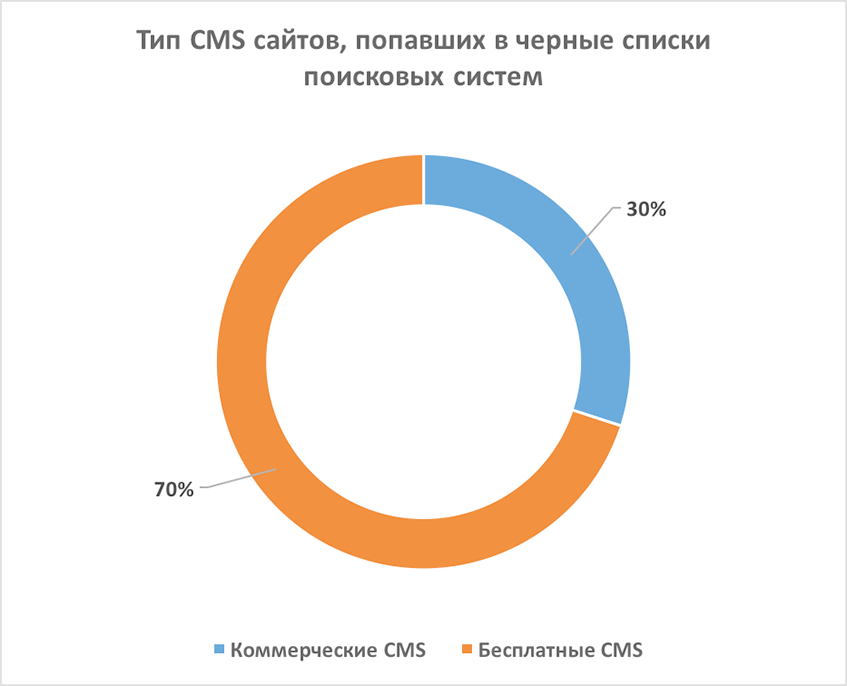

Влияние типа CMS на безопасность оказалось не таким большим для бизнес-сайтов

В прошлом исследовании, где участвовали случайно выбранные сайты, мы обнаружили явную зависимость – сайты на бесплатных CMS заражались вирусами в четыре раза чащей сайтов на коммерческих системах. Оставив в выборке только бизнес-сайты, мы обнаружили, что доля сайтов на основе коммерческих CMS в черных списках всего лишь в два раза меньше доли сайтов на бесплатных CMS. Таким образом, коммерческие сайты на бесплатных CMS «в среднем» можно назвать более безопасными по сравнению с со всеми сайтами на бесплатных CMS вообще.

По нашему мнению, многие случаи взлома и заражения сайтов возникают из-за общих проблем с безопасностью – слабых паролей, неконтролируемого доступа к коду сайта, привлечения непроверенных фрилансеров и других системных проблем веб-разработки, связанных с общим состоянием безопасности веб-разработки. С этим мы связываем такой факт как отсутствие явных лидеров среди платных и бесплатных CMS по количеству проблем. В целом, доля проблемных сайтов на выбранной CMS соответствует доле, занимаемой этой CMS на рынке.

По отношению к графикам выше необходимо сделать пояснение: по техническим причинам, нам не удалось определить CMS у некоторой части сайтов из выборки, поэтому данные получены в предположении, что ошибка неопределения CMS была распределена случайным образом. В списке сайтов не присутствуют многие известные CMS, такие как NetCat и Umi, потому что мы показываем только топ распространенных CMS, из обнаруженных в исследовании, и этот топ в целом совпадает со статистикой популярности CMS, публикуемой сервисом iTrack.

Доли различных CMS на зараженных сайтах:

Владельцам интернет-бизнеса по-прежнему не хватает осведомленности

Даже сократив выборку до коммерческих сайтов, мы обнаружили в ней сайты, которые находились в черных списках поисковых систем длительное время. Так, среди сайтов интернет магазинов мы обнаружили более 300 инцидентов, которые не были устранены на протяжении всего периода наблюдения (3 месяца). Большая часть из них – мобильные редиректы, которые могут приводить к потерям от 25% до 40% трафика в зависимости от распространенности мобильного доступа к сайтам в конкретном регионе России. Схожая картина наблюдалась и в выборке сайтов зоны .ru, входящих в топ 1 млн сайтов, зарегистрированных на Alexa. Однако практически не было таких сайтов среди исследуемой группы Топ-10000 по счетчику Liveinternet, что мы склонны связывать с повышенным вниманием к посещаемости сайта со стороны владельцев сайтов, участвующих в рейтинге.

Основные факты исследования 2015.Топ-3 проблем

- Наиболее распространенная и опасная по нашему мнению проблема — это редирект на внешние сайты, включая как мобильный, так и обычный редирект. В 90% всех случаев наличия редиректа, мы определили что это был редирект на зараженный сайт. Таким образом, страдает не только интернет-бизнес, который теряет перенаправляемый на другие сайты трафик, но и пользователи, которые попадают на зараженные сайты. А если факт перехода на зараженный сайт детектирует установленный у пользователя антивирус, то пострадает и репутация сайта, на которые он хотел зайти изначально. Как мобильный, так и обычный редирект нелегко поддаются обнаружению, потому что как правильно используют техники скрытия и в добавок срабатывают не для всех IP-адресов и типов мобильных устройств.

В нашей выборке из более 300.000 сайтов Google определил менее 20% имеющихся проблем, а Яндекс определил только 33% редиректов, которые были установлены на сайты в то время, когда мы проводили их сканирование. В то же время, в случае определения вредоносного мобильного редиректа Яндексом, в 100% случаев сайт будет занесен в черный список.

Выше мы уже отмечали, что только около 10% владельцев и администраторов самостоятельно устраняли редиректы до их выявления Google и Яндекс. - Второй по распространенности проблемой являются динамические ссылки на зараженные сайты. Стоит обратить внимание, что в 100% случаев после обнаружения такой ссылки сайт попадает в черный список Google (а значит, будет блокироваться и в веб-браузерах, которые используют для определения небезопасных сайтов Google SafeBrowsing API).

Динамические ссылки на зараженные сайты самостоятельно выявляли и устраняли только 20-30% всех сайтов, попавших в исследование. - На третьем месте по популярности статическая внешняя ссылка на зараженный сайт. Данный тип проблемы оказался наиболее простым в выявлении и устранении – от 40% до 50% всех сайтов смогли справиться с проблемой, не дожидаясь ее обнаружения поисковыми системами.

Статистика по срезу «Интернет-магазины»

Всего выявлено 2247 инцидента, затрагивающих 5% сайтов.

- 247 интернет магазинов находились в блэклистах, 68 из них – на протяжении всего хода исследования

- Среднее время нахождения сайта в блэклисте – 1 неделя

- Повторные заражения редко, но случаются (3 случая из 247)

- 243 сайта имели обычный редирект на зараженный сайт (более чем половину из этих сайтов Google или Яндекс не посчитали опасными, хотя на самом деле они опасные)

- 372 сайта имели динамические ссылки на зараженные сайты (На момент проведенного нами сканирования Google не успел заметить 75% таких сайтов, Яндекс — только 60%)

- У более чем 50% нет SSL-сертификата

Топ проблем, не устраненных на протяжении всего периода наблюдения

- Мобильный редирект на другой сайт (в 72% случаев — на зараженный)

- Динамические ссылки на зараженный сайт

- Статический редирект на зараженный сайт

Топ активных проблем за весь период наблюдения

- Динамическая ссылка на зараженный сайт

- Мобильный редирект на внешний сайт

- Обычный редирект на зараженный сайт

Статистика по срезу «Tоп-10000 Liveinternet»

Всего выявлено 1166 инцидентов, затрагивающих 10% сайтов

Топ активных проблем за весь период наблюдения:

- Динамическая ссылка на зараженный сайт

- Мобильный редирект на внешний сайт

- Статическая ссылка на зараженный сайт

Статистика по срезу «Сайты в зоне .ru, входящие в Топ 1 млн. сайтов Alexa»

Всего выявлено 3292 инцидента, затрагивающих около 8% всех сайтов

Сайты в два раза чаще находились в блэклистах, чем интернет-магазины

Топ активных проблем за весь период наблюдения

- Мобильный редирект на внешний сайт

- Статическая ссылка на зараженный сайт

- Динамическая ссылка на зараженный сайт

Сводная статистика по всем срезам

Таким образом, в ходе исследования наличие проблем выявлено у 10% сайтов из списка LiveInternet, у 8% сайтов из списка Alexa и 5% интернет-магазинов. Доля сайтов, имеющих проблемы, в этом исследовании снизилась, по сравнению с прошлым исследованием, потому что мы исключили проблемы с внесением в черные списки рассылки спама и сосредоточились только на наиболее опасных проблемах, напрямую приводящих к потере трафика, заражению пользователей или утрате репутации интернет-бизнеса. Однако в дальнейшем мы планируем вновь включить в исследования проблемы, связанные со списками рассылки спама, так как они, в некоторых случаях, тоже могут приводить к простоям сайта из-за отключения хостинг провайдером, к потере лидов и снижению конверсии из-за недоставки писем с подтверждениями заказов в интернет-магазинах или сайтах, активно используемых для лидогенерации.

Выводы и рекомендации

Увеличение глубины и продолжительности наблюдения, а также сужение выборки до сайтов, которые можно считать коммерческими, позволили нам уточнить и немного скорректировать результаты предыдущего исследования. Однако в целом мы наблюдаем те же, в том числе и тревожные тенденции, касающиеся проблем безопасности сайтов как источника простоев и потерь для интернет-бизнеса.

Основываясь на результатах проведенного ранее исследования состояния безопасности веб-разработки в студиях, а также на данных только что проведенного исследования, мы рекомендуем, не зависимо от типа используемой CMS-системы, обратить повышенное внимание на соблюдение базовых мер безопасности, таких как регулярная смена паролей, отказ от небезопасных протоколов типа FTP в пользу SSH, защита доступа к панели администрирования при помощи SSL сертификата, и других, а также рекомендуем проводить подготовку выделенных специалистов в области реагирования на инциденты безопасности – выведения сайтов из черных списков, укрепления защиты путем настроек окружения CMS и сервера и других мер противодействия взломам и заражениям сайтов, приводящим интернет-бизнес к убыткам.

Методология исследования

Для проведения исследования была специально создана выборка около 320.000 сайтов:

Более 80.000 сайтов для исследования в динамике в течение 1 квартала 2015 года, из них:

- 36.750 интернет-магазинов

- 37.233 русскоязычных сайтов из топ 1 миллиона сайтов Alexa

- Топ 10.000 рейтинга LiveInternet

Около 240.000 сайтов коммерческих фирм, выбранных случайным образом из всего числа активных (делегированных) доменных имен в зоне .ru, зарегистрированных на юридические лица для единовоременного сканирования аналогично исследованию 2014 года.

В ходе исследования наблюдались следующие параметры:

- Тип CMS, на которой сделан сайт

- Наличие сайта в черных списках Google и Яндекс

- Наличие на сайте редиректов (серверных и клиентских) (мобильный редирект на внешний или зараженный сайт, поисковый редирект);

- Внешние ссылки на зараженные сайты (статические или динамические);

- Наличие SSL сертификата;

- Ошибки в конфигурировании;

Наблюдение за 80.000 сайтов первой части выборки велось постоянно в течение квартала (все параметры опрашивались и значения записывали в базу данных, где накапливалась вся историческая информация об изменении параметров при каждом сканировании). К этой выборке сайтов мы применяли различные подходы анализа исторических данных, для определения корреляций различных обнаруженных нами событий. Вторая часть выборки сканировалась однократно и к ней применялись только статистические методы анализа.

Описания проблем, которые мы анализировали в ходе исследования:

- Редирект на зараженный сайт мы определяли как автоматическое перенаправление пользователя обычного браузера на сторонний сайт, который уже внесен в черные списки поисковых систем

- Мобильный редирект мы определяли как автоматическое перенаправление пользователя мобильного устройства на сторонний сайт, который уже внесен в черные списки поисковых систем

- Статическая ссылка на зараженный сайт – это ссылка, непосредственно прописанная в коде страницы, лежащем на веб-сервере.

- Динамическая ссылка на зараженный сайт – это ссылка, возникающая в ходе отображения веб-страница в браузере пользователя как результат исполнения, например, Javascript кода.

Сайт является важным активом компании, от его работы зависит как успех продвигаемого товара или услуги, так и отношение к компании в целом. Если за сайтом нет надлежащего контроля, он может быть в любой момент взломан, как ради корыстных целей, так и ради множества других, репутационные риски могут быть достаточно велики, что совершенно неприемлемо для бизнеса. Необходим постоянный и профессиональный контроль за целостностью сайта, его компонентов и их правильном функционировании и своевременное реагирование на возникающие угрозы безопасности.

Страница исследования и комментарии экспертов: https://sitesecure.ru/securityreport1q2015.