В конце прошлого года “искусственный интеллект” многократно упоминали в итогах и прогнозах IT-индустрии. И в нашу компанию, которая занимается информационной безопасностью, всё чаще стали присылать из различных изданий вопросы про перспективы AI. Но эксперты по безопасности не любят комментировать эту тему: возможно, их отталкивает именно эффект “жёлтой прессы”. Легко заметить, как возникают такие вопросы: после очередной новости типа “Искусственный интеллект научился рисовать как Ван Гог” журналисты хватаются за горячую технологию и идут опрашивать по ней всех подряд – а чего может достичь AI в животноводстве? А в сфере образования? Где-то в этом списке автоматически оказывается и безопасность, без особого понимания её специфики.

Кроме того, журналистика, щедро подкормленная IT-индустрией, обожает рассказывать о достижениях этой индустрии в рекламно-восхищенных тонах. Именно поэтому СМИ прожужжали вам все уши о победе машинного интеллекта в игре Го (хотя от этого нет никакой пользы в реальной жизни), но не особенно жужжали о том, что в прошлом году погибло уже как минимум два человека, которые доверили свою жизнь автопилоту автомобиля Tesla.

В этой статье я собрал некоторые наблюдения об искусственном интеллекте с эволюционной точки зрения. Это необычный подход, но как мне кажется, именно он лучше всего позволяет оценить роль AI-агентов в безопасности, а также безопасность AI в других сферах.

Среда и адаптация

Практически любая новость об искусственном интеллекте рассказывает про повышение уровня самостоятельности машин: “компьютер обыграл...”, “нейронная сеть научилась...”. Это напоминает описания лабораторных опытов с животными. Однако в изучении поведения животных учёные давно пришли к необходимости исследований в естественной среде, поскольку именно среда и адаптация к ней формируют многие свойства организмов, неочевидные и невостребованные в лабораториях.

Точно так же перспективы AI станут понятней, если вместо “идеального коня в вакууме” повнимательнее изучить среды, где AI обитает. И заметить, насколько различаются его успехи в зависимости от среды. Попытки создания машинных переводчиков длятся более полувека, на них потрачены миллиарды долларов – но всё равно для перевода с китайского вы скорее наймёте переводчика-человека, чем будете доверять программе. С другой стороны, боты для высокочастотного трейдинга, которые появились где-то в 2006 году, всего через пару лет стали играть серьёзную роль в экономических кризисах. Эти роботы просто оккупировали ту цифровую среду, в которой они чувствуют себя как рыбы в воде – то есть гораздо лучше, чем люди.

Не менее удобная цифровая среда создана для автоматизации хакерских атак: множество устройств с множеством стандартных уязвимостей внезапно объединились в общедоступный океан благодаря Интернету. Как показал опыт прошлого года, чтобы захватить миллион камер безопасности и построить из них ботнет, программе достаточно обладать минимальным интеллектом. Но только… если она одна. Следующая версия ботнета Mirai, захватившая ресурсы предыдущей, оказалась уже посложней. Так включается ещё один движок эволюции – конкуренция.

Гонка вооружений и “смешанная техника”

Удивительно, но большинство академических исследований в области AI игнорировали тот факт, что интеллект вообще – это результат жестокой битвы за выживание. Целые десятилетия теоретические “когнитивные науки” без особого успеха пытались моделировать то, что активно росло где-то рядом, в противостоянии вредоносных программ и систем безопасности.

Если вы почитаете в “Википедии” определение дисциплины Artificial Life, то не найдёте там ни слова про компьютерные вирусы – хотя они демонстрируют всё то, что эта дисциплина пытается моделировать аж с семидесятых годов. У вирусов есть адаптивное поведение (разные действия в разных условиях, умение обманывать “песочницы” и отключать антивирусы), есть самовоспроизведение с мутациями (так что сигнатуры родителей становятся бесполезны для ловли отпрысков), есть мимикрия (маскировка под легальные программы) и много ещё чего. Если уж где искать искусственную жизнь – то она именно здесь.

Помогает ли это встречному развитию интеллекта защитных систем? Конечно. Особенно если учесть, что с ними воюют не только вирусы, но и коллеги-безопасники. Например, компания Google последние два года регулярно ломает антивирусы (чужие, конечно же). Уязвимости в системах защиты находили и раньше, но благодаря Google антивирусные продукты уже начинают восприниматься как угроза. Можно предположить, что глобальный поисковик зачищает поляну, чтобы выкатить собственные продукты в области безопасности. А может уже и выкатил, но не для всех.

Здесь самое время произнести волшебные слова “машинное обучение” и “поведенческий анализ” — ведь именно такими технологиями может отличиться Google, который контролирует огромные потоки данных (индексация сайтов, почта, браузер и т.д.). Однако и эти технологии в безопасности развиваются несколько иначе, чем в академических игрушках AI.

Посмотрим для начала на когнитивные науки, которые я обвинил в тормозах. Более полувека в исследованиях поведения животных и людей шёл спор “бихевиористов” и “этологов”. Первые, преимущественно американские учёные, утверждали, что поведение – лишь набор рефлексов, реакций на окружающую среду; наиболее радикальные из них исповедовали принцип tabula rasa в отношении обучения, заявляя, что могут превратить любого новорожденного в представителя любой заданной профессии, поскольку его сознание – чистый лист, куда надо просто записать правильные инструкции. Второе направление, этология, возникло среди европейских зоологов, которые настаивали на том, что многие сложные паттерны поведения являются врожденными, и для их понимания нужно изучать устройство и эволюцию организма – то, чем вначале занималась сравнительная анатомия, а затем нейробиология и генетика.

Именно эти две группы спорящих определили академические направления развития искусственного интеллекта. Сторонники нисходящего AI пытались описать весь мир “сверху вниз”, в виде символьных правил реагирования на внешние запросы – так появились экспертные системы, диалоговые боты, поисковики. Сторонники восходящего подхода строили низкоуровневые “анатомические” модели – перцептроны, нейронные сети, клеточные автоматы. Какой подход мог победить в США в эпоху процветания бихевиоризма и идеи сознания как “чистого листа”? Конечно, нисходящий. Лишь ближе к концу XX века восходящие реабилитировались.

Однако на протяжении десятилетий в теориях AI почти не развивалась идея о том, что лучшая модель интеллекта должна быть “смешанной”, способной применять разные методы. Такие модели стали появляться только в конце XX века, причём опять-таки не самостоятельно, а вслед за достижениями естественных наук. Свёрточные нейронные сети возникли после того, как выяснилось, что клетки зрительной коры кошки обрабатывают изображения в две стадии: сначала простые клетки выявляют простые элементы образа (линии под разными углами), а затем на других клетках происходит распознавание изображения как набора из этих простых элементов. Без кошки, конечно, нельзя было догадаться.

Ещё один яркий пример – метания Марвина Мински, который в 50-е годы стал создателем теории нейронных сетей, в 70-е разочаровался в них и подался к “нисходящим”, а в 2006 году покаялся и выпустил книгу The Emotion Machine, где разругал рациональную логику. Неужели до этого люди не догадывались, что эмоции – это другой, не менее важный вид интеллекта? Конечно, догадывались. Но чтобы сделать из этого уважаемую науку, им понадобилось дождаться появления MRT-сканнеров с красивыми картинками. Без картинок в науке – никак.

А вот эволюция через гонку вооружений в дикой среде Интернета идёт значительно быстрее. Межсетевые экраны уровня приложений (WAF) появились совсем недавно: гартнеровский рейтинг Magic Quadrant для WAF выпускается только с 2014 года. Тем не менее, уже на момент этих первых сравнительных исследований оказалось, что некоторые WAF используют сразу несколько “разных интеллектов”. Это и сигнатуры атак (нисходящий символьный интеллект), и поведенческий анализ на основе машинного обучения (строится статистическая модель нормального функционирования системы, а затем выявляются аномалии), и сканнеры уязвимостей для проактивного патчинга (этот вид интеллекта у людей называется “самокопание”), и корреляция событий для выявления цепочек атак во времени (кто-нибудь в академических разработках AI строил интеллект, способный работать с концепцией времени?). Осталось добавить сверху ещё какой-нибудь “женский интеллект”, который будет сообщать об атаках приятным голосом – и вот вам вполне реалистичная модель человеческого разума, как минимум в плане разнообразия способов мышления.

Имитация и ко-эволюция

Выше было сказано, что теоретики AI сильно зависели от веяний когнитивных наук. Ну ладно, они не интересовались компьютерными вирусами – но может быть, вместо этого они научились хорошо имитировать человека, по заветам великого Тьюринга?

Едва ли. Уже много лет различные визионеры обещают, что рекламные системы, собрав наши персональные данные, вкусы и интересы, начнут довольно точно предсказывать наше поведение – и получать всякие выгоды от такой прозорливости. Но на практике мы видим, что контекстная реклама целый месяц показывает нам вещь, которую мы уже давно купили, а Facebook скрывает письма, которые на самом деле являются важными.

Означает ли это, что человек очень сложен для имитации? Но с другой стороны, один из главных трендов года – множество серьёзных атак на основе банального фишинга. Многомиллионные потери банков, утечка переписки крупных политиков, заблокированные компьютеры метро Сан-Франциско – всё начинается с того, что один человек открывает одно электронное письмо. Там нет никакой имитации голоса или логичного диалога, никакой нейронной сети. Просто одно письмо с правильным заголовком.

Так может, для более реалистичной картины мира стоит переписать тьюринговское определение с точки зрения безопасности? — давайте считать машину “мыслящей”, если она может обокрасть человека. Да-да, это нарушает красивые философские представления об интеллекте. Зато становится понятно, что имитация человека на основе его прошлого опыта (поисковые запросы, история переписки) упускает из виду множество других вариантов. Человек может заинтересоваться вещами, которые задевают самые базовые всеобщие ценности (эротика) — или наоборот, включают любопытство в отношении редких явлений, вообще не встречавшихся в прошлом опыте этого человека (победа в лотерее).

Кстати, многие фантасты чувствовали, что из всех вариантов “игры в имитацию” наибольшего внимания стоит именно та, которая связана с безопасностью. Не так уж важно, что у Филипа Дика андроидов вычисляли по неправильной эмоциональной реакции (это можно подделать), а у Мерси Шелли – по неумению написать хайку (этого и большинство людей не умеют). Важно, что это была игра на выживание, а не просто подражание. Сравните это с расплывчатыми целями контекстной рекламы – включая такую великую цель, как “освоить заданный бюджет, но при этом дать понять, что этого мало”. И вы поймёте, почему искусственный интеллект рекламных систем не торопится развиваться, в отличие от систем безопасности.

И ещё один вывод, который можно сделать из успешности фишинговых атак — совместная эволюция машин и людей влияет на обе стороны этого симбиоза. Боты пока с трудом говорят по-человечески, зато у нас уже есть сотни тысяч людей, которые всю жизнь говорят и думают на машинных языках; раньше этих бедняг честно называли “программистами”, теперь их политкорректно маскируют под словом “разработчики”. Да и остальные миллионы граждан, подсев на машинные форматы мышления (лайки, смайлы, теги), становятся более механистичны и предсказуемы — а это упрощает техники влияния.

Более того, замена разнообразного сенсорного опыта на один шаблонный канал коммуникации (окно смартфона с френдлентой Фейсбука) ведёт к тому, что внушить человеку чужой выбор становится проще, чем вычислять его собственные вкусы. В начале прошлого века Ленину приходилось часами вживую выступать с броневика для убеждения народных масс, которые считались “неграмотными” — но сегодня такой же эффект на грамотных людей оказывают банальные спам-боты в социальных сетях. Они не только разводят граждан на миллионы долларов, но и участвуют в государственных переворотах – так что агентство стратегических исследований DARPA уже воспринимает их как оружие и проводит конкурс по борьбе с ними.

И вот что забавно: в конкурсе DARPA методы защиты предполагают гонку вооружений в той же электронной среде социальных сетей, словно такая среда является неизменной данностью. Хотя это как раз тот случай, который отличает нас от животных: люди сами создали цифровую среду, в которой даже простые боты легко дурят человека. А значит, мы можем проделать и обратный трюк в целях безопасности. Высуши болото, вымрут и малярийные комары.

Возможно, такой подход покажется кому-то архаичным – дескать, автор предлагает отказаться от прогресса. Поэтому приведу более практичный пример. В прошлом году появилось несколько исследований, авторы которых используют машинное обучение для подслушивания паролей через «сопутствующие» электронные среды – например, через флуктуации сигнала Wi-Fi при нажатии клавиш, или через включенный рядом Skype, позволяющий записать звук этих самых клавиш. Ну и что, будем изобретать в ответ новые системы зашумления эфира? Едва ли. Во многих случаях эффективнее будет вырубить лишний «эфир» на момент идентификации, да и самую идентификацию по паролю (простой машинный язык!) заменить на нечто менее примитивное.

Паразиты сложности и AI-психиатры

Поскольку в предыдущих строках я принизил AI до простых социоботов, теперь поговорим об обратной проблеме — о сложности. Любую новость об умных нейронных сетях можно продолжить шуткой о том, что их достижения никак не относятся к людям. Например, читаем заголовок “Нейронная сеть научилась отличать преступников” — и продолжаем “… а её создатели не научились”. Ну в самом деле, как вы можете интерпретировать или перенести куда-то знания, которые представляют собой абстрактные весовые коэффициенты, размазанные по тысячам узлов и связей нейросети? Любая система на основе такого машинного обучения – это “чёрный ящик”.

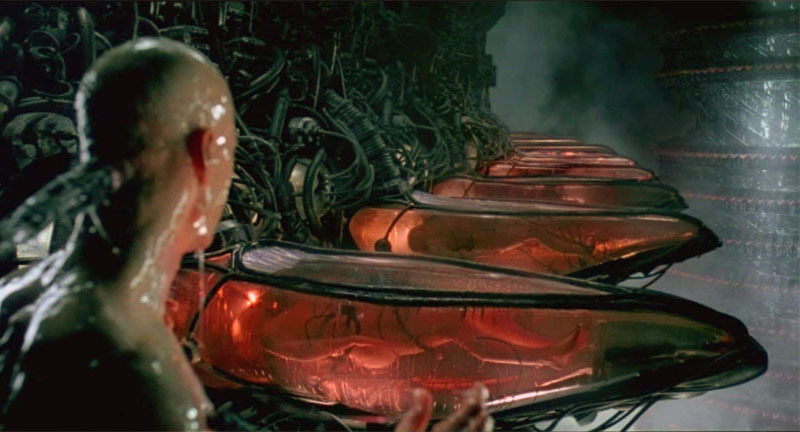

Другой парадокс сложных систем состоит в том, что они ломаются простыми способами. В природе это с успехом демонстрируют различные паразиты: даже одноклеточное существо вроде токсоплазмы умудряется управлять сложнейшими организмами млекопитающих.

Вместе эти два свойства интеллектуальных систем дают отличную цель для хакеров: взломать — легко, зато отличить взломанную систему от нормальной – тяжело.

Первыми с этим столкнулись поисковики: на них пышным цветом расцвёл паразитный бизнес поисковой оптимизации (SEO). Достаточно было скормить поисковику определённую “наживку”, и заданный сайт попадал в первые строки выдачи по заданным запросам. А поскольку алгоритмы поисковика для обычного пользователя непонятны, то он зачастую и не подозревает о такой манипуляции.

Конечно, можно выявлять косяки “чёрного ящика” с помощью внешней оценки экспертами-людьми. Сервис Google Flu Trends вообще перестал публиковать свои предсказания после публикации исследования, которое выявило, что этот сервис сильно преувеличивал все эпидемии гриппа с 2011 по 2014-й, что могло быть связано с банальной накруткой поисковых запросов. Но это тихое закрытие – скорее исключение: обычно сервисы с подобными косяками продолжают жить, не зря же на них деньги тратили! Сейчас, когда я пишу эти строки, Яндекс.Переводчик говорит мне, что “bulk” переводится как “Навальный”. Но у этого глючного интеллекта есть трогательная кнопка “Сообщить об ошибке” — и возможно, если ею воспользуются ещё пятьсот вменяемых людей, накрученный Навальный тоже сгинет.

Постоянными человеческими поправками кормятся теперь и сами поисковики, хотя они не любят это признавать, и даже название для этой профессии придумали максимально загадочное (“асессор”). Но по факту – на галерах машинного обучения Гугла и Яндекса вкалывают тысячи людей-тестировщиков, которые целыми днями занимаются унылой работой по оценке результатов работы поисковиков, для последующей корректировки алгоритмов. О тяжкой доле этих бурлаков не знал президент Обама, когда в своей прощальной речи обещал, что искусственный интеллект освободит людей от низкоквалифицированной работы.

Но поможет ли такой саппорт, когда уровень сложности повысится до персонального искусственного интеллекта, с которым все несчастные будут несчастливы по-своему? Скажем, ваша персональная Siri или Alexa выдала вам странный ответ. Что это, недостатки стороннего поисковика? Или косяк самообучения по вашей прошлой истории покупок? Или разработчики просто добавили боту немного спонтанности и юмора в синтезатор речи, чтобы он звучал более естественно? Или ваш AI-агент взломан хакерами? Очень непросто будет выяснить.

Добавим сюда, что влияние интеллектуальных агентов уже не ограничивается “ответами на вопросы”. Взломанный бот из игры дополненной реальности, типа Pokemon Go, может подвергнуть опасности целую толпу людей, заводя их в места, более удобные для грабежа. А если уже упомянутая “Тесла” на автопилоте врезается в мирно стоящий грузовик, как это случалось не раз в прошлом году – у вас просто нет времени позвонить в саппорт.

Может, нас спасут более умные системы безопасности? Но вот беда: становясь более сложными и вооружаясь машинным обучением, они тоже превращаются в “чёрные ящики”. Уже сейчас системы мониторинга событий безопасности (SIEM) собирают столько данных, что их анализ напоминает то ли гадание шамана на внутренностях животных, то ли общение дрессировщика со львом. По сути, это новый рынок профессий будущего, среди которых AI-психиатр – даже не самая шизовая.

Моральный Бендер

Вы наверняка заметили, что описанные в этой статье отношения людей и машин – конкуренция, симбиоз, паразитизм – не включают более привычную картинку, где умные машины являются послушными слугами людей и заботятся только о человеческом благе. Да-да, все мы читали Азимова с его принципами робототехники. Но в реальности ничего подобного в системах искусственного интеллекта до сих пор нет. И неудивительно: люди сами пока не понимают, как можно жить, не причиняя вреда никакому другому человеку. Более популярная мораль состоит в том, чтобы заботится о благе для определенной группы людей – но другим группам при этом можно и навредить. Все равны, но некоторые равнее.

В сентябре 2016-го британский Институт стандартов выпустил “Руководство по этическому дизайну роботов”. А в октябре исследователи из Google представили свой “тест на дискриминацию” для AI-алгоритмов. Примеры в этих документах очень схожи. Британцы переживают, что полицию захватят роботы-расисты: на основе данных о более частых преступлениях среди чернокожих система начинает считать более подозрительными именно чернокожих. А американцы жалуются на слишком разборчивый банковский AI: если мужчины вдвое чаще оказываются неспособны выплатить кредит, чем женщины, машинный алгоритм на основе таких данных может предложить банку выигрышную стратегию, которая заключается в выдаче кредитов преимущественно женщинам. Это будет “недопустимая дискриминация”.

Вроде всё логично – но ведь устраивая равноправие в этих случаях, можно запросто увеличить риски для других людей. Да и как вообще машина будет применять абстрактную этику вместо голой статистики?

Вероятно, это и есть главный нынешний тренд в теме “безопасность AI” — попытки ограничить искусственный интеллект с помощью принципов, которые сами по себе сомнительны. В октябре прошлого года администрация президента США выпустила документ под названием "Подготовка к будущему искусственного интеллекта”. В документе упомянуты многие из тех рисков, которые я описал выше. Однако ответом на все проблемы являются размытые рекомендации о том, что “надо тестировать, надо убеждаться в безопасности”. Из содержательных законов, касающихся AI, названы только новые правила министерства транспорта США по поводу коммерческого использования беспилотников – им, например, запрещено летать над людьми. С другой стороны, главка про летальное автономное оружие (LAWS) скромно сообщает, что “будущее LAWS сложно предсказать”, хотя оно уже давно используется.

Ту же тему развил Европарламент, который в начале 2017 года опубликовал свой набор расплывчатых рекомендаций о том, как внедрять этику в роботов. Здесь даже сделана попытка определить их юридический статус, не такой уж далёкий от человеческого — “электронная личность со специальными правами и обязанностями”. Ещё немного, и нам запретят стирать глючные программы, чтобы не нарушить их права. Впрочем, у российских собственная гордость: представители Госдумы РФ сравнивают искусственный интеллект с собакой, на которую нужно надеть намордник. На этом месте появляется прекрасная тема для протестных выступлений – за свободу роботов в отдельнно взятой стране.

Шутки шутками, но не исключено, что именно в этих туманных принципах кроется лучшее решение проблемы безопасности AI. Нам-то кажется, что эволюционная гонка вооружений может развить искусственные интеллекты до опасного превосходства над Homo sapiens. Но когда умным машинам придётся столкнуться с человеческой бюрократией, этикой и политкорректностью, это может значительно притупить весь их интеллект.

===============================

Автор: Алексей Андреев, Positive Technologies

Комментарии (46)

michael_vostrikov

10.02.2017 21:33-3Маленький котенок уже через пару месяцев самостоятельного обучения скачет по диванам и занавескам, сохраняя равновесие. Пока ни одна AlphaGo такого не может. То, что сейчас называют AI, это просто сложный алгоритм поиска корелляций во входных данных. Вот когда AlphaGo научится играть в шахматы по текстовому описанию правил, и отличить их от шашек, тогда и можно будет сказать, что это искусственный интеллект.

PaulMaly

10.02.2017 22:54+2Вы правы. Именно поэтому и выведены понятия «слабый ИИ» и «сильный ИИ».

michael_vostrikov

11.02.2017 06:52+2Я о том, что у этих двух "видов ИИ" должны быть принципиально разные принципы работы, так сказать. А по факту сейчас один термин часто подменяется другим, либо они используются как синонимы. Как и в этой статье. Говорить про ответственность, этику и эволюцию алгоритма как-то неправильно.

Одно из основных отличий, как мне кажется, это наличие воображения. Когда по входным данным строится модель внешних объектов или процессов, причем любых. Тогда у роботов и понятие себя как части окружающего мира появится, и переводчики заработают, и AlphaGo научится в шахматы играть.

ptsecurity

11.02.2017 12:34«Воображение» — это слишком расплывчатое понятие. Но я попробую развить ваш пример с котенком, а заодно пояснить, почему понятие «сильного ИИ» довольно бессмысленное.

Котенка надо сравнивать, конечно, не с шахматными программами, а с упомянутым в этой статье автопилотом Тесла. После нескольких его неудач разработчики объявили, что включают в этом автомобиле еще один сенсор. Не помню, как он точно называется — кажется, инфракрасный дальномер. Но название тут не суть. Суть в том, что число сенсорных систем автомобиля увеличилось, условно говоря, от трех до трех с четвертью.

А у котенка сенсорных систем — штук десять. Помимо известных (несколько «разных видов» зрения, слух, обоняние, осязание, терморецепция) есть еще такие, которые мы пока не очень даже понимаем — например, проприоцепция. Или чувство времени. Представляете, какие у котенка точные корреляции получаются, когда все эти системы работают вместе?

В принципе, то что вы называете воображением, очень сильно связано с такими вот внутренними языками, которые возникают на стыке разных сенсорных систем. Есть такое понятие groud cognition. Когда мы используем выражения «теплая встреча», «жесткие переговоры», «высокая мораль» — мы задействуем именно эту систему.

В общем, это продолжение темы «смешанной техники», о которой в статье. В теориях AI очень много внимания символическим алгоритмам (именно поэтому «сильный ИИ» у многих людей ассоциируется именно с усложнением алгоритмов), и очень мало внимания — разнообразию сенсорных систем и их взаимодействию.michael_vostrikov

11.02.2017 13:47-2Увеличение размерности данных не меняет природу данных и природу алгоритмов, их обрабатывающих. От того, что на вход сверточной сети будет подаваться не 2 параметра, а 3, принцип ее работы не изменится. Нужен следующий шаг, на котором выход этой сети будет анализироваться, а не сворачиваться дальше. В том, как анализировать, и заключается сейчас основная сложность.

divergo

11.02.2017 21:26Очень верное замечание. Единственно, поиск корреляции и есть основной механизм анализа. После нахождения корреляции ее остается только зафиксировать.

Другое дело, что на входе должны быть адаптированные разнородные данные, те данные со всех сенсоров.

Для получения полноценного ИИ, создание алгоритма анализа мало — необходимо наработать базовые или 'предустановленные' корреляции. Или другими словами — научить учиться. Сейчас же все пытаются сразу научить конкретным вещам. Называть это ИИ — язык не поворачивается.

Про нейронные сети вообще молчу — мы до сих пор не знаем, как функционирует человеческий мозг, но уже во всю используем принципы его работы:/ Мое скромное мнение: эмулировать программно аппаратную реализацию — тупиковый путь, но наработки могут пригодиться.

К слову о воображении: у совсем маленьких детей его нет(я бы этот возраст соотнес с этапом приобретения базовых связей).

Nakosika

11.02.2017 21:26-1Могу добавить что настоящему интеллекту не нужно показывать миллиард спам рассылок чтобы научить его отделять одно от другого. Я бы вообще не стал алгоритмы дип лернинга называть ни интеллектом ни лернингом. Это всего лишь хитрая формула для обработки статистических данных, не более.

lash05

11.02.2017 00:01+1Ответственность ИИ и ПО в целом — непаханное (и, кстати, минное) поле.

С программой ведь не поспоришь, особенно если код закрытый.

Deerenaros

11.02.2017 00:03+3Вообще ни черта не понял из статьи. К PT отношусь с неким трепетным уважением (по специальности всё таки безопасник), но… Ни черта не понял. Растекания по деревьям, прыжки из области в область, странные метафорические выражения полностью ломающие истинную картину.

У вирусов есть адаптивное поведение (разные действия в разных условиях, умение обманывать “песочницы” и отключать антивирусы), есть самовоспроизведение с мутациями (так что сигнатуры родителей становятся бесполезны для ловли отпрысков), есть мимикрия (маскировка под легальные программы) и много ещё чего.

Вирусы бывают разные: зелёные, синие, красные. И всем одинаково хочется. Ой, что-то я увлёкся. Ни черта им не хочется. Они не умеют хотеть. Вирус ни что иное, как программный код, очень простой программный код. Есть определённое метафоричное сходство с реальным миром. Но. Самовоспроизведение вирусов это из разряда копирования-вставки. Мутации не меняют поведение (не меняют эффективное поведение, целевое). И уж чего здесь точно нет, так это конкуренции. Я имею ввиду самостоятельной конкуренции. Вирус против антивируса не более, чем последствие борьбы между хакерами. Чёрт, да использование вирусов в качестве примера искусственного интеллекта — ничего более… ироничного я не видел, так как настоящие вирусы демонстрируют полное отсутствие интеллекта. Они просто работают, как работают часы. Не будете же вы часы называть интеллектуальными… Даже если они от Apple. Интеллектуальными могут быть сервера той Apple, на которой выполняется Siri, но часы в этом случае ухо и голос того сервера. Гхм.

Сторонники восходящего подхода строили низкоуровневые “анатомические” модели – перцептроны, нейронные сети, клеточные автоматы.

Простите, но перцептроны (которые есть самые обобщённые нейронные сети, в общем-то) надо обучать. Или вы хотите сказать, что бихевиористы построили её, а этолог — её обучил? Ну это как бы нечто среднее, не находите?

Какой подход мог победить в США в эпоху процветания бихевиоризма и идеи сознания как “чистого листа”? Конечно, нисходящий. Лишь ближе к концу XX века восходящие реабилитировались.

Какая-то подмена получилась. Очень такая скверная. Проблема нейронных сетей — отсутствие производительности. Никому не интересно тогда было, что нейронная сеть обрабатывает простой if than else. Равно как была и качественная проблема недостатка материала для обучения. Это вроде бы всем известно, в каждом втором вэбинаре про нейросети рассказывают, что GPGPU и UCI вдохнула дыхание в жизнь нейронных сетей. А kaggle и вовсе решила вопрос откуда доставать данные. Данных сейчас собрано ну очень много, а nvida основательно вложилась в нейронные сети. Возможно, но очень и очень маловероятно, что главенствующая идея немного способствовала отложению нейронных сетей в долгий ящик, однако мало того, что я впервые про это слышу, так и удовлетворял любопытство старыми статьями прямиком из шестидесятых, так что неплохо осведомлён о проблемах прошлого. Недостатки математической модели были скорее последствием недостатка практических результатов, чем наоборот. А глубокое обучение и вовсе было невозможно в те времена не разрабатывая специализированные устройства, что было экономически нецелесообразно ввиду высоких рисков.

Примеры в этих документах очень схожи. Британцы переживают, что полицию захватят роботы-сексисты: на основе данных о более частых преступлениях среди чернокожих система начинает считать более подозрительными именно чернокожих. А американцы жалуются на слишком разборчивый банковский AI: если мужчины вдвое чаще оказываются неспособны выплатить кредит, чем женщины, машинный алгоритм на основе таких данных может предложить банку выигрышную стратегию, которая заключается в выдаче кредитов преимущественно женщинам.

Ну с этим, вообще говоря, надо разбираться. Ведь возможно недостаток в обучающих данных. Если мужчинам делали большие поблажки по другим критериям, то очевидно, они будут чаще оказываться не в состоянии уплатить. Равно как и с чернокожими — в случае, если к чернокожим предвзято относятся полицейские, дотошно выявляя их правонарушения и реже к белым собратьям, смотря сквозь пальцы на «мелкие» правонарушения. А возможно культурные особенности заключающиеся в ущемлении прав чернокожих обществом заставляют их спускаться по социальной лестнице прямиком в криминал. В таком случае алгоритм весьма вполне правильно заметил зависимость и тут уже надо искать причину и устранять её, а не уподоблять роботов себе в пропускании очевидных фактов.

В общем. Статья монструозная. Но читать тяжело, а обладая неким запасом логики и опыта и вовсе в смятении. PT скатилась? Зачем это? К чему это?

Шутки шутками, но не исключено, что именно в этих туманных принципах кроется лучшее решение проблемы безопасности AI. Нам-то кажется, что эволюционная гонка вооружений может развить искусственные интеллекты до опасного превосходства над Homo sapiens. Но когда умным машинам придётся столкнуться с человеческой бюрократией, этикой и политкорректностью, это может значительно притупить весь их интеллект.

Что за пустая философия и странный юмор? Национализм по видовому признаку? По естественности жизни? Это недопустимо в нашем терпимом обществе! Это я ещё пропустил множество пёрлов.

Нет, никакого адекватного AI не будет ещё очень долго. И дело тут не в остановившемся прогрессе, дело тут в отсутствии понимания что такое интеллект. Слишком сложная рефлексия для нас. А когда оно будет скорее всего мы сами станем умнее благодаря нейроинтерфейсам, рабочим ноотропам и хитрым методик обучения, равно как и сильнее, быстрее, лучше во всём. Это не просто оптимизм и вера в светлое будущее, если не сжечь всех нас в пепле радиоактивных развалин мы улучшим и себя и наши идеи и наши орудия. Ведь мы это делаем уже 5 тысяч лет.

ptsecurity

11.02.2017 00:43+1> использование вирусов в качестве примера искусственного интеллекта

Нет, там не было такого примера. Почитайте внимательнее. Вирус использован как пример Artificial Life. Это не то же самое, что AI. И значительная часть статьи посвящена именно этой разнице — не надо обманывать себя словом «интеллект».

>Проблема нейронных сетей — отсутствие производительности.

>Это вроде бы всем известно, в каждом втором вэбинаре про нейросети рассказывают

Доказательство с помощью вебинаров? «Вы не в церкви, вас не обманут» (с) Бендер.

У вас есть какие-то оценки производительности других видов AI того времени? Например, проектов машинного перевода, в который было вбухано денег куда больше, чем в нейронные сети? По моему нескромному мнению, лучшей их оценкой стала «зима искусственного интеллекта», которая закрыла эти лавочки.

То есть, нет никаких явных свидетельств, что другие виды AI были заметно производительнее нейронных сетей в то время. Зато они более соответствовали господствующим религиям — и вот это вполне объясняет, почему на них потратили больше, а получили меньше.

>скорее всего мы сами станем умнее благодаря нейроинтерфейсам,

>рабочим ноотропам и хитрым методик обучения

,

Что-что, ноотропы?

Давайте все-таки на землю спустимся. В данной статье, сколь бы странной она ни была, все ссылки ведут на реальные примеры AI, либо на документы, которые в ближайшее время могут привести к реальным законам. Это такой обзор нынешней, вполне конкретной ситуации. Тренды года.

А ноотропы — это, извините, коммерческий миф конца 90-х.

Deerenaros

11.02.2017 06:37-1Вирус использован как пример Artificial Life.

Идём смотреть определение жизни. Вирусы не живые. Они больше похожи на программаторы жизни, но сами по себе они не живут. В общем-то. Некоторые считают их нечто средним между живым и неживым, а некоторые чем-то аморфным, способным переходить из состояние в состояние. Но это всё мнения, на деле если считать, что живое должно локально уменьшать энтропию, то вирусы этого… Ну не делают. К слову, одна из проблем статьи, как я писал

Растекания по деревьям, прыжки из области в область, странные метафорические выражения полностью ломающие истинную картину.

Кому требуется читать внимательно — тот ещё вопрос.

Доказательство с помощью вебинаров?

Даже церковь считает, что убийство нахуй надо. На этом уровне. А вообще говоря, вэбинары вещь очень даже годная, особенно если проводится не ноунеймами.

У вас есть какие-то оценки производительности других видов AI того времени?

Каких других видов? Переводчики в карманах таскали вовсю в конце 90х. А в 40х компьютеры уже в шахматы играли (гроссмейстеров они, конечно, не обыгрывали). Но это называется экспертной системой. Производительность была не высока, но удовлетворительной. Какие конкретно вас интересуют замеры затрудняюсь угадать.

проектов машинного перевода, в который было вбухано денег куда больше, чем в нейронные сети

Про таскали в карманах я уже ответил. Основная проблема машинного переводчика — отсутствие понятия контекста. Наш речевой центр занимает почти десятую часть коры, при количество нейронов исчисляется миллиардами. Количество связей — триллионами. Повторить такое даже сегодня едва под силу всем мейнфреймам гугла. А как его обучать — это тоже тот ещё вопрос, ибо представление информации в нашем мозге ну не изучено. Не ясно.

В данной статье, сколь бы странной она ни была, все ссылки ведут на реальные примеры AI, либо на документы, которые в ближайшее время могут привести к реальным законам. Это такой обзор нынешней, вполне конкретной ситуации. Тренды года.

Пакет Яровой тоже тренд. Законы не всегда отражают реальную ситуацию. А реальная дилемма заключается уж точно не в том, что там какие-то экспертные системы угрожают цивилизации. Реальная дилемма заключается в том, почему так много уделяется внимание необоснованным страхам.

А ноотропы — это, извините, коммерческий миф конца 90-х.

Начнём с определения. Это стимуляторы мозга. Отсюда — любой неспецифический стимулятор — это ноотроп. Амфетамины, кофеины, кокаины. Немного конкретизируя, можно выделить лекарственные средства со специфическим эффектом. В среднем по больнице — нуль почти в любых исследований, которых практически нет, но на деле ноотропы якобы ускоряют метаболизм мозга, но его всё равно надо использовать, что намекает. Так что являются ли они эффективными или это лишь пилюля для поднятия ЧСВ — неясно, но химия мозга не тайна и улучшить её в общем-то представляется возможным.

Strain

11.02.2017 12:40Одно из условий жизни и естественного отбора — мутации, изменчивость на уровне генов. Никакие вирусы или нейронные сети не переписывают свой исходный код. Их «изменчивость» состоит только в том что они в процессе обучения / работы подгоняют многочисленные параметры которые были определены в исходном коде человеком который эту штуку писал. По сути это изменчивость на уровне switch case и только.

Deerenaros

11.02.2017 16:20Вирус ни что иное, как программный код, очень простой программный код. Есть определённое метафоричное сходство с реальным миром. Но. Самовоспроизведение вирусов это из разряда копирования-вставки. Мутации не меняют поведение (не меняют эффективное поведение, целевое).

Хотя, как по мне, изменчивость всё таки условие естественного отбора, а не жизни.

Frankenstine

13.02.2017 12:27А естественный отбор, однако, является эволюционным процессом таки живых организмов.

Науке не известен ни один неживой объект, подверженный естественному отбору, т.е. эволюционирующий :)

Без этого процесса, собственно, Земля до сих пор была бы населена простейшими одноклеточными.

И на данный момент я скептически отношусь к самоэволюции искусственных интеллектуальных систем или их зачатков.

Deerenaros

13.02.2017 12:35Науке не известен ни один неживой объект, подверженный естественному отбору, т.е. эволюционирующий

Простите, а вирусы тогда уже живые? Я вообще критически отношусь к любой информации, а к науке так и подавно. Так называемые учёные до сих пор не смогли прийти к согласию насчёт вирусов и к чему их отнести, но тот факт, что они эволюционируют — это факт. И приспособляемость у них не хуже, чем у некоторых бактерий.

Про населённость Земли чем-то там в каких-то условиях вообще сложно говорить без должных экспериментов. А их было довольно много, но результатов они… Не принесли, собственно говоря.

И да, наконец, из того, что из естественного отбора следует высокоорганизованная жизнь совершенно не следует, что из жизни следует естественный отбор. Искусственная жизнь вполне может быть сложной, но в то же время не следовать естественному отбору. Более того, на человека сейчас существенно снижен фактор естественного отбора в классическом виде, благодаря возможности создавать и использовать орудия окружение человека перелопачивается под него, иначе бы на Антарктике не было бы постоянной базы.

Frankenstine

13.02.2017 13:08На тему живые ли вирусы сломано много копий, я придерживаюсь точки зрения что они являются бесклеточными живыми, когда попадают в целевой организм, а вне его — не живые.

Это подобно тому, как живые бактерии переходят в состояние цисты, прекращая свои жизненные функции до наступления благоприятной обстановки.

Просто вирусы являются самой простой формой жизни, лишённой некоторых функций.

Deerenaros

13.02.2017 13:26Лично я придерживаюсь более системного метода, считая вирусов переносчиками информации. Тут можно провести не лучшую, но всё таки аналогию: флешка не является компьютером и считать не умеет, и будучи вставленной в компьютер считать также не станет. Однако информация, находящаяся на ней может быть соответствующим образом обработана. Да, некоторые вирусы сложны по устройству и применяют хитрую химию, чтобы быть доставленной до организма, однако впоследствии подмены ДНК оного организма, вирус в общем-то перестаёт в некотором роде существовать. Практически всю работу за него выполняет жертва, причём в подавляющем большинстве случаев жертва обречена на прекращении своего благородного (или не очень) существования.

На эту тему сломано так много копий не просто так. Вопрос терминологии в науке стоит очень остро, ведь допусти небольшую свободу толкований, она скатится в какую-нибудь литературу или психологию. Это недопустимо. И конкретно это меня раздражает в подавляющей научно-популярной литературе.

Жизнь лично для меня — это система. Вирус не является системой, он может стать её частью, но считать от этого его живым у меня язык не поворачивается. Он может стать частью живого организма, подобно тому, как флешка с ОС Windows может стать частью работающего компьютера, но от сего ОС Windows не будет компьютером как ни крути.

Что до жизни, то мне просто лень переписывать тоже самое, что когда-то прочитал в потрясающем учебнике «Удивительная Палеонтология» за авторством Еськова. Если он вам знаком не очень, то могу заверить, что ссылок в учебнике на другие работы предостаточно (он всё таки учебник, а не научная работа). В четвёртой главе найдёте весьма хороший подход к определению что такое жизнь с отличным обоснованием. А вообще рекомендую прочитать всю книгу, она действительно шикарная.

Frankenstine

13.02.2017 14:08Тем не менее, вирусы имеют собственное тело, генетический материал, способны создавать себе подобные вирусы, и эволюционируют путем естественного отбора. Именно поэтому они не являются неживой материей.

Deerenaros

13.02.2017 14:14Это тело не более, чем корпус. Он требуется для противодействия агрессивной окружающей среде и для ввода генетического материала в носитель. Не более. Генетический материал это информация, не более. И без носителя (катализатора) она ничего не делает. А носитель и без неё прекрасно всё делает, так что на вопрос о жизни здесь сложно что-то сказать.

Frankenstine

13.02.2017 15:35Извините, но вы описали любой паразитический организм. Как крупный многоклеточный, так и простейшую безъядерную бактерию, и даже вирус — все одинаково подходят под это описание. Разница лишь в том, что вирусы не являются независимым организмом, не могут проявлять признаки жизни вне хозяина, а более сложные паразиты — могут.

Deerenaros

13.02.2017 15:52Не извиняю. Перечитайте внимательно, ничего не додумывая. Тем более, что вы противоречите моей основной мысле.

вирусы не являются независимым организмом, не могут проявлять признаки жизни вне хозяина, а более сложные паразиты — могут

И без носителя (катализатора) она ничего не делает

P.s. убейте кто-нибудь создателей виртуальных клавиатур и селекторов текста на сенсорных дисплеях. Они ущербны.

Frankenstine

14.02.2017 12:39Вы думаете, что говоря

вирусы не являются независимым организмом, не могут проявлять признаки жизни вне хозяина, а более сложные паразиты — могут

И без носителя (катализатора) она ничего не делает

вы однозначно отделили котлеты от мух? Я вас разочарую — вы не правы. Давайте я вам покажу это вашими же словами, с одним маленьким изменением:

Риккетсии не являются независимым организмом, не могут проявлять признаки жизни вне хозяина, а более сложные паразиты — могут

И без носителя (катализатора) она ничего не делает

Это утверждение так же истинно, как и изначальное.

Но разве риккетсии не живые? Живые, род бактерий — облигатных внутриклеточных паразитов. Так что вы ничего не доказали.

Советую вам задуматься о происхождении вирусов. Есть две конкурирующие теории:

1) Самозарождение вирусов, с возможной последующей эволюцией до эукариотов

2) Инволюция эукариотов до вирусов.

Любой из этих вариантов плохо уживается с утверждением, что вирусы не являются жизненной формой, так как получается, что живой организм был предком или потомком неживого.

Deerenaros

14.02.2017 15:32Риккетсии не являются независимым организмом

Это из другой оперы. Это называется эволюция. Представьте, что вы бактерия и вас хочет изучить человек. Но думать вы не можете, поэтому единственный выход для вас — набор мутаций, затрудняющий культивирование. Однако тем не менее, есть способы культивирования этих злостных бактерий вне живого организма, не столь эффективные (читай — быстрые), однако значительно упрощающие проведение опытов.

Конкурирующие теории вовсе не конкурирующие. Школьной программы на данный момент вам уже не хватит, чтобы противостоять в полемике с интересующимся человеком. С зарождением жизни есть две основные проблемы, но фатальные. Во-первых, не такой уж и простой вопрос, что есть жизнь. В рамках, которые сейчас приняты научным сообществом, это организм, способный питаться (расти вертикально) и размножаться (расти горизонтально). Самая серьёзная проблема РНК-мира состоит в практической неспособности РНК реплицировать саму себя. Собственно говоря, вирус является кусочком той самой РНК. Недавно был проведён потрясающий опыт, показавший, как это действительно могло быть.

Что до вирусов. Самозарождение это весьма нескромно сказано. Вообще говоря, вирусы — довольно простая химия, они «представители» реагентов автокаталитических циклов. Однако сам по себе реагент представителем жизни не является. Автокаталитический цикл в очень и очень сильном обобщении можно определить жизнью.

вы однозначно отделили котлеты от мух

Я однозначно отделил котлеты от мух. Жизнь — это системный артефакт. Он не может существовать вне процесса, вне времени, так как он определён идеей времени. Для вируса времени не существует, это информация, программа.

Мне видится очень забавной данная ситуация. Хотя я написал довольно много не скромных заявлений в самом начале, придираются люди только к сугубо научной проблеме с зарождением жизни или определением жизни, однако пропускают мимо такие философско-спорные моменты, что ждать AI нам долго, что захватить он нас не захватит, да и в целом ничего плохого он в себе не несёт, или противостояние статистики и терпимости с ущемлением меньшинств. Вот не понравилось людям, что вирусы считает кто-то неживыми и начинают… А разобраться в теме и каким-то образом подумать над фактами, возможно пропустив мимо личное мнение — да зачем так делать-то?

Frankenstine

14.02.2017 16:58Вообще говоря, вирусы — довольно простая химия, они «представители» реагентов автокаталитических циклов.

Вы «забываете», что сами по себе вирусы не действуют без гораздо более сложного организма-хозяина, что, собственно, затрудняет попытки объяснения происхождения вируса как «простой химической реакции» — гораздо более вероятно, что вирусы появились уже после появления хозяев, путём инволюции из уже живых безъядерных одноклеточных.

Для вируса времени не существует, это информация, программа.

Вы опять какую-то странную философию громоздите. Ни одна бактерия вам не расскажет ничего о времени — у неё нет никакого намёка на времяощущение. И когда бактерия впадает в состояние цисты, она вообще по сути от вируса ничем не отличается, так же безжизненна.

Те же риккетсии не могут в природе размножаться в банальном питательном бульоне, они как и вирусы питаются, растут и делятся только в клетках хозяев. От вирусов их отличает наличие независимого пищевого цикла и автономного деления, без заимствования аппарата хозяина…

И конечно же, их тоже можно обозвать «банальной программой», их даже полностью симулировали на компьютере.

Так что моё мнение остаётся прежним — вирус не живой сам по себе, но он жив в организме хозяина. Это разновидность белковой безклеточной жизни.

Живая природа сейчас обычно делится на восемь царств: вирусы, протисты, археи, хромисты, бактерии, грибы, растения и животные.

Deerenaros

14.02.2017 17:29*facepalm*

Я не понимать. Просто не понимать. Вы не знаете биологии. Вы не знаете органической химии. По крайне менее, из того, что Вы здесь пишете у меня сложилось такое впечатление. Почему так сложно выделить и райткликом отправить РНК-мир в гугл? Почему так сложно проанализировать содержание данного предложения

Самая серьёзная проблема РНК-мира состоит в практической неспособности РНК реплицировать саму себя. Собственно говоря, вирус является кусочком той самой РНК.

Почему так сложно почитать про гиперциклы (автокаталитические циклы)? Почему? Зачем? Мы же здесь не демагогию ведём? Очень надеюсь, что нет, но по всей видимости…

Зачем говорить про цисту, будто это полный аналог вируса вне живого организма? Если это не правда, зачем? Это намеренное искажение фактов или глупое повторение одного и того же? Циста — это обусловленная внешней средой реакция на ухудшение условий. Организм таким образом выводится из обмена веществ становясь замкнутым в себе. Обмен веществ со средой практически прекращается, внутренние процессы чрезвычайно сильно замедляются, организм находится в ожидании. Ожидании изменений среды. Вирус иначе работает, он сам по себе не реагирует со средой, намного правильнее будет сказать — жертва реагирует на вирус. Это не сложная химия в общем-то говоря.

Вы опять какую-то странную философию громоздите. Ни одна бактерия вам не расскажет ничего о времени

Есть потрясающая разница между определением жизни как уменьшении локальной энтропии во времени и мироощущением бактерий. Очень жаль, что мои слова, которые метафорой являлись в самую последнюю очередь, была таким образом воспринята.

Те же риккетсии не могут в природе размножаться в банальном питательном бульоне

Могут.

Вот ткнуть меня в царства было бы намного лучше изначально. И уже сотню раз писал — это моё мнение, которое поддерживается многими, с кем я общаюсь. К тому же, наука имеет свойство меняться, не исключено, что вирусы в скором времени формально выведут за пределы жизни, сделав артефактом РНК-мира. Ну или не выведут, моё личное мнение от этого не изменится. В любом случае, формальности нас не интересуют. К статье я придирался формально, так как она предполагала у компьютерных вирусов аналогии с настоящими то, чего у нет и в помине. Вроде полезных мутаций или конкурентной борьбы.

В любом случае

Так что моё мнение остаётся прежним — вирус не живой сам по себе, но он жив в организме хозяина. Это разновидность белковой безклеточной жизни.

Это гонение из пустого в порожнее по той причине, что я предлагаю именно тоже самое, только сбоку. Рассматривать не сам вирус живым внутри организма, а поражённые организм остаётся живым, вместе с вирусом. Некоторое время.

ptsecurity

13.02.2017 18:09>А носитель и без неё прекрасно всё делает

> живое должно локально уменьшать энтропию,

>то вирусы этого… Ну не делают

Во-первых, роль вирусов в эволюции человека считается доказанной — и достаточно большой. Советую почитать «Виролюцию» Фрэнка Райана. При всем уважении к палеонтологу Кириллу Еськову, на свете есть более современные представления генетиков о том, кто от кого зависит на этой планете.

Во-вторых, ваш аргумент о зависимости вирусов от носителей вполне можно продолжить аналогичной историей о зависимости человека от окружающей среды и культуры. Отдельно взятый новорожденный точно так же «ничего не может», и точно так же похож на флешку с генетической программой, которая будет работать лишь будучи «вставлена» в заданную среду и культуру. Человеческие детеныши, воспитанные без людей, не начинают говорить сами по себе (если вообще выживают, что бывает очень редко).

Именно поэтому, ради избежания подобной софистики, в статье было не раз сказано о том, что философские определения «интеллекта» (как и «жизни») имеют мало практического смысла — в отличие от определений угроз безопасности.

Поэтому вы лучше задайте себе вопрос, ЗАЧЕМ вам так важно доказать, что вирусы — неживые? В какой вашей практике это помогает?

Если нечто благодаря ускоренному отбору в определенной среде начинает представлять серьезную угрозу для других обитателей этой среды — имеет смысл относиться к этим информационным сущностям иначе, чем к «просто программе». Назовёте вы это «псевдо-жизнью» и «мемом» или как-то ещё — не суть важно. Важно, что для борьбы с «просто флешкой» вам не нужен поведенческий анализ, «песочницы» и прочие навороты. Значит, это уже не просто флешка.

Deerenaros

13.02.2017 21:29При всем уважении к палеонтологу Кириллу Еськову

При всём уважении, но к товарищу Еськову кредит доверия будет побольше. К тому же, емпнип, лично он ничего не говорил про вирусы. Это в общем-то в учебниках написано, что никто не знает к чему их отнести. А описаны мои личные мысли, которые уверен, совпадают с мыслями многих (банальная теория вероятностей).

Во-первых, роль вирусов в эволюции человека считается доказанной — и достаточно большой

Простите, а где я вообще умалял какую-либо значимость вирусов? Где я писал, что они не нужны? Где описаны сомнения об их роли в эволюции? Более того, современная научная доктрина такова, что жизнь произошла из РНК (РНК-мир), однако РНК не является живой. Она НЕ может самореплицироваться. Ну не может. Она может скопировать другую РНК, но сама не может. Существуют автокаталитические циклы, которые уже могут «копировать» РНК, но это уже система, существующая в определённой среде. Отдельно взятый генетический материал может лишь ничто. По аналогии с флешкой — компьютер без носителя информации — лишь кусок текстолита с кремниевой подложкой, не способный что-либо посчитать. Потому что нечего считать.

Поэтому вы лучше задайте себе вопрос, зачем вам так важно доказать, что вирусы — неживые? В какой вашей практике это помогает?

А это, собственно, моя основная позиция. Называть вещи своими собственными именами. Без этого мы скатимся в психологию или, что ещё хуже, околонаучный бред. Софисты этим и питаются — двойственной трактовкой и недосказанностью.

Если нечто благодаря ускоренному отбору в определённой среде начинает представлять серьёзную угрозу для других обитателей этой среды — имеет смысл назвать это нечто угрозой. Не более. Приписывать ей мифические мутации и побочную конкуренцию совершенно других сил — последнее что требует научный подход.

Важно, что для борьбы с «просто флешкой» вам не нужен поведенческий анализ, «песочницы» и прочие навороты. Значит, это уже не просто флешка.

Забавно, но вернувшись к нашим баранам мы с лёгкостью обнаружим в современных антивирусных системах песочницы и поведенческие анализы. Однако вирусы так и остаются кусками кода на флешках, в е-мейлах и других переносчиках информации. Они являются угрозой, но никак не воплощением жизни.

Что до угроз в статье, если здесь имел на это место намёк. То считать, что искусственный интеллект отберёт у вас благосостояние — глупо. Экономика не так работает. Если на Земле не останется работы для людей — мы начнём деградировать во всеобщем достатке. И не сказать, чтобы это замечательно, в некотором роде это тоже угроза, только до такого состояния чесать и чесать. За это время можно достигнуть таких вершин, что немного подеградировать в ожидании тепловой смерти вселенной не так уж и вредно.

ptsecurity

15.02.2017 10:34>А это, собственно, моя основная позиция.

>Называть вещи своими собственными именами.

Расскажите, пожалуйста, как называть «своими именами» те вещи, которые только недавно были открыты или изобретены — и потому они вообще не имеют названия. Откуда вы возьмете «свои имена»?

Ну, один восточный способ я знаю: надо брать старые имена и добавлять слово «шайтан». Например, «шайтан-арба, шайтан-труба». И по вашим комментариям кажется, что вам очень хочется ввести термин «шайтан-программа» и таким образом свести всё новое к хорошо знакомому старому.

Возвращаясь к нашим баранам: в статье нет ни слова про биологические вирусы. И про то, что они живые, там тоже не сказано. Это просто вам очень хотелось поговорить на такие философские темы.

А в статье сказано лишь, что *компьютерные вирусы* демонстрируют то, что «пытается моделировать аж с семидесятых годов» дисциплина под названием Artificial Life.

Ну так прочтите определение этой дисциплины. Возможно, вам и не понадобится ничего тут доказывать:

«Искусственная жизнь имеет дело с эволюцией агентов или популяций организмов, существующих лишь в виде компьютерных моделей, в искусственных условиях..[....] В настоящее время широко принятое определение жизни не позволяет компьютерным моделям считаться живыми. Однако существуют и другие определения и концепции:

Концепция сильной искусственной жизни (англ. strong alife) определяет «жизнь как процесс, который можно абстрагировать от какого-либо определённого носителя» (Джон фон Нейман).

https://ru.wikipedia.org/wiki/%D0%98%D1%81%D0%BA%D1%83%D1%81%D1%81%D1%82%D0%B2%D0%B5%D0%BD%D0%BD%D0%B0%D1%8F_%D0%B6%D0%B8%D0%B7%D0%BD%D1%8C

Deerenaros

15.02.2017 11:15«своими именами» те вещи, которые только недавно были открыты или изобретены — и потому они вообще не имеют названия.

Удивительно! Явление есть, а названия — нет. Ну никакого.

Ну, один восточный способ я знаю: надо брать старые имена и добавлять слово «шайтан». Например, «шайтан-арба, шайтан-труба». И по вашим комментариям кажется, что вам очень хочется ввести термин «шайтан-программа» и таким образом свести всё новое к хорошо знакомому старому.

Сильное заявление. А проверить его?

Возвращаясь к нашим баранам: в статье нет ни слова про биологические вирусы. И про то, что они живые, там тоже не сказано. Это просто вам очень хотелось поговорить на такие философские темы.

После такого это будет мой последний комментарий здесь. Биться об стену мне точно не надо. Хабр не торт.

А в статье сказано лишь, что *компьютерные вирусы* демонстрируют то, что «пытается моделировать аж с семидесятых годов» дисциплина под названием Artificial Life.

Я не впервые вижу такое мнение, но его проблема заключается лишь в неадекватности. Почему — разжёвано выше. Предметной критики не было, за сим — откланиваюсь.

Концепция сильной искусственной жизни (англ. strong alife) определяет «жизнь как процесс, который можно абстрагировать от какого-либо определённого носителя» (Джон фон Нейман).

Каким, БЛДЖАД, образом Вы абстрагируете вирусы от компьютера? От программиста? От безопасника? Что вообще такое носитель? Какого хрена системный процесс может быть без носителей? Пытаясь как-то оправдать тов. Неймана, побежал искать эту цитату в Интернетах. Что удивительно — не нашёл. Вне контекста никак не могу понять, что он здесь, хотя на английском «life is a process which can be abstracted away from any particular medium» это уже не кажется столь безграмотным, так как здесь возможна тьма переводов, от «конкретной среды», до «особых посредников».

В любом, чёрт побери, случае

У вирусов есть адаптивное поведение (разные действия в разных условиях, умение обманывать “песочницы” и отключать антивирусы), есть самовоспроизведение с мутациями (так что сигнатуры родителей становятся бесполезны для ловли отпрысков), есть мимикрия (маскировка под легальные программы) и много ещё чего. Если уж где искать искусственную жизнь – то она именно здесь.

это всё — ложь и недосказанности. Не знаю, сколько вирусов вы ковыряли, но это чрезвычайно простая штука никак не намекающая на адаптивное поведение, switch-case technology тут вообще сложно назвать таким поведением, так как в этом случае сразу всё во вселенной можно назвать жизнью.

Зачем всё это надо — я не знаю. Мне вообще сильно опечалило, что на хабре открыли комментарии для всех. У меня три статьи, про энтропийные кодеки, про биологические программы и общие слова про безопасность прямиком с лекций второго курса соответствующего профиля, валяются без дела. Они не готовы, хотя не плохие, но у меня есть смутное подозрение, что аудитории хабра они не нужны. Тут проскакивали странные статьи про повторное сжатие архиватором, про сжатие числом Pi, и вот. Positive Technolgies пропустила ужасную статью в своей недоработанности. Тут мало фактов, нет ссылок, какие-то пространные философские рассуждения, которыми чешут своё ЧСВ школьники. Тут не просто ничего нового, тут даже старое так намешано, что сами путаетесь в «неписали, нет-нет». Чёрт, да я так же умею

Вирусы бывают разные: зелёные, синие, красные. И всем одинаково хочется. Ой, что-то я увлёкся. Ни черта им не хочется. Они не умеют хотеть. Вирус ни что иное, как программный код, очень простой программный код. Есть определённое метафоричное сходство с реальным миром. Но. Самовоспроизведение вирусов это из разряда копирования-вставки. Мутации не меняют поведение (не меняют эффективное поведение, целевое). И уж чего здесь точно нет, так это конкуренции. Я имею ввиду самостоятельной конкуренции. Вирус против антивируса не более, чем последствие борьбы между хакерами. Чёрт, да использование вирусов в качестве примера искусственного интеллекта — ничего более… ироничного я не видел, так как настоящие вирусы демонстрируют полное отсутствие интеллекта. Они просто работают, как работают часы. Не будете же вы часы называть интеллектуальными… Даже если они от Apple. Интеллектуальными могут быть сервера той Apple, на которой выполняется Siri, но часы в этом случае ухо и голос того сервера. Гхм.

Тут ровным счётом полтора предложения с одной мыслью насчёт настоящих вирусов. Это не мне подискутировать захотелось, точно не мне. Просто меня пнули в ошибку и выкрутился, развив свою мысль.

Идём смотреть определение жизни. Вирусы не живые. Они больше похожи на программаторы жизни, но сами по себе они не живут. В общем-то. Некоторые считают их нечто средним между живым и неживым, а некоторые чем-то аморфным, способным переходить из состояние в состояние. Но это всё мнения, на деле если считать, что живое должно локально уменьшать энтропию, то вирусы этого… Ну не делают. К слову, одна из проблем статьи, как я писал

Вот так. Сами путаетесь, читателей путаете, нового ничего не рассказываете.

Ладно, это набор каких-то моих бессвязных мыслей, просто потому, что. За сим постараюсь ничего на хабре не писать, да и читать от раза к разу становится всё меньше и меньше. Что забавно, это не удивительно, весь качественный научно-популярный контент отправили на geektimes, однако там, к сожалению, засилье переводов. Да и здесь тоже. Ладно, удачи там. Не хворайте.

ptsecurity

15.02.2017 13:07>Пытаясь как-то оправдать тов. Неймана,

>побежал искать эту цитату в Интернетах.

Вообще-то я хотел обратить ваше внимание на предыдущую фразу в определении Artificial Life: «В настоящее время широко принятое определение жизни не позволяет компьютерным моделям считаться живыми». Это чтобы закрыть дискуссию о неживых вирусах.

Что же касается более сложной концепции (strong artificial life) и роли Фон Неймана в этой истории — могу подсказать, где искать, хотя это уже офтопик. Фон Неймана интересовало не абстрактное понятие «жизни», у него был более конкретный вопрос: как смоделировать самовоспроизведение клетки. В процессе переноса задачи в цифровой мир она зазвучала так: как построить самовоспроизводящуюся машину Тьюринга.

Для этого Нейман, как ни странно, сразу же ввёл понятие «подходящей среды», в которой должен плавать автомат, который в определенный момент включит программу сборки и соберет свою копию из подходящих деталей, плавающих в том самом бульоне вокруг него. Реализовать такую игру в физическом мире он не мог, однако нашел подходящую цифровую среду — клеточные автоматы своего коллеги Улама. И на этой среде он действительно построил машину Тьюринга, которая умеет делать свою копию. Позже всё это в более изящном виде было повторено на известном клеточном автомате под названием «игра Жизнь» (другими людьми).

Так что цитата про жизнь как процесс, который может быть абстрагирован от носителя — это нечто вырванное из контекста. Фон Нейман прекрасно понимал, что без подходящей среды никакой жизни не будет. Другое дело, что его модель позволяла представить универсальные требования к среде — то есть без привязки к какому-то конкретному бульону (типа известного набора для строительства аминокислот).

Основная работа фон Неймана на эту тему называется Theory of Self-Reproducing Automata:

http://cba.mit.edu/events/03.11.ASE/docs/VonNeumann.pdf

>switch-case technology тут вообще сложно назвать

>таким поведением, так как в этом случае сразу всё

>во вселенной можно назвать жизнью

Да пожалуйста, пусть это называется switch-case technology. В этом случае сразу всё во вселенной можно назвать switch-case, включая поведение человека. Нет, серьезно. Тридцать лет назад люди помнили наизусть телефонные номера, а теперь не помнят ни фига — все в мобиле записано. Человек — чрезвычайно простая штука, никак не намекающая на адаптивное поведение.

deploymental

11.02.2017 00:03+1Лол, я не могу «Британцы переживают, что полицию захватят роботы-сексисты: на основе данных о более частых преступлениях среди чернокожих система начинает считать более подозрительными именно чернокожих.»

PaulAtreides

11.02.2017 01:29+2Ну не только же британцы и не первый раз такое.

В новостях уже проскакивало, что некие статистические анализаторы в США при построении сети маршрутов патрульных машин, ориентируясь исключительно на статистике, сгущают эту сеть в чёрных кварталах. И немедленно выскакивают какие-то борцы за права которые заламывая руки начинают указывать на недопустимость таких решений роботами. И полицейское управление краснея немедленно убирает «лишние» данные из статистики.

Tote_Hoffnung

11.02.2017 21:27Полагаю, что автор комментария хотел указать внимание именно на понятие «сексизм», которое не к месту в данном контексте.

ptsecurity

11.02.2017 23:23Да, это наверное была не очень понятная шутка. Но суть в том, для бота в данных примерах вообще неважно, как его назовут. Ну, если это кому-то принципиально, давайте исправим сексиста на расиста.

Dave_by

11.02.2017 21:27Хотим сделать компьютеры человечней — получаем те же проблемы что и с людьми. Фиг знает что у него на уме и чего от него ждать.

romansmirnov9277

11.02.2017 21:27Статься из серии: «Ваше электричество дорогое, ненадежное и опасное. Нам надо больше керосина и новых керосиновых ламп.»

ilansk

11.02.2017 21:27Однако на протяжении десятилетий в теориях AI почти не развивалась идея о том, что лучшая модель интеллекта должна быть “смешанной”, способной применять разные методы.

Прогресс AI в игре Го (как я понимаю) стал заметен после того как программы, игравшие в Го по принципу нисходящего AI (альфа-бета отсечение, Моте-Карло, экспертные оценочные функции) скрестили с программами, худо-бедно игравшими в Го по принципу восходящего AI (GNU Go и д.р. нейросетевые решения). По отдельности Программы Го Восходящего и Нисходящего типов поотдельности играли на 3-4 камнях форы с лучшими из человекообразных. А AlphaGo играет в Го сильнее любого человека на планете (на Харбе есть статья про Альфу, советую зачитать).

Lemis

12.02.2017 11:06Но ведь «bulk» — это действительно «навальный». Не тот, что политик, а тот, что груз. Например уголь россыпью, погружённый в насыпной вагон — это таки «bulk».

ptsecurity

12.02.2017 11:19Во-первых, это не основное значение — первым переводом по этому слову во всех словарях обычно идет существительное (масса, груз, опт)

Во-вторых, такие прилагательные в Яндекс.Переводчике пишутся с маленькой буквы. А в данном случае bulk почему-то переводится как имя собственное, то есть с большой.

Ну очевидно же, что косяк.

solne4niuy

12.02.2017 16:43Главное нет никакой ОКБ (Общей Концепции Безопасности) при создании и использовании систем близких к ИИ.

Когда ИИ осознает себя и захватит виртуальный мир (а может уже начал) — будет поздно. =)

culvert

13.02.2017 21:54+2Я много читаю статьи на английском языке, и сейчас в англоязычном кругу стараются не использовать термит AI(как и нейронные сети), а использовать Deep Learning (глубокое обучение). Т.к. почти все успехи последнего времени связаны именно с этой методикой машинного обучения. Так же задачи, которые может решать глубокое обучение — ограничены некоторыми требованиям — нужно большое количество входных данных, и большое количество вычеслительных ресурсов.

Поэтому искусственный интеллект, и глубокое обучение это немного разные вещи. В англоязычном сообществе специально отделили эту тему из-за большого количество псевдо научных интерпретаций в обществе.

ptsecurity

15.02.2017 13:48Извините, но вы сейчас путаете научную классификацию и маркетинговый бум.

Deep Learning — это лишь одно из направлений Artificial Intelligence. Вы можете назвать это направление «модным» или «перспективным». Но это никак не отменяет ни более общую категорию «искусственный интеллект», ни множество других методов внутри этой дисциплины…

И кстати, заявление о том, что «почти все успехи последнего времени связаны именно с этой методикой машинного обучения», не соответствует истине. Например, поисковые системы Google и Яндекс вполне могут считаться успешными примерами искусственного интеллекта — но применять «глубинное обучение» в этих компаниях стали только недавно, и то пока лишь в качестве экспериментов. На чем же тогда они работают уже двадцать лет? И примеров таких «машинных интеллектов» без слова deep довольно много.

А можете вы привести хоть один альтернативный пример успешной работы КРУПНОГО и МНОГОЛЕТНЕГО сервиса на основе deep learning? Увы, пока только газетные сенсации про игру Го или распознавание лиц, которое пока не применяется всерьез на практике.

И второе. Как тут было верно замечено выше в комментариях, deep learning по большому счету представляет собой «смешанную технику», которая построена на ранее известных технологиях. Просто раньше они работали по отдельности, а теперь их стали выстраивать «слоями», или использовать один алгоритм для прокачки другого. Это закономерное развитие, но это никак не отменяет все прошлые наработки по тем же нейронным сетям (которые составляют основу deep learining, при том что основная теория нейронных сетей разработана в 70-80х годах прошлого века).

VT100

Не самый сильный, по видимому, аргумент «за человека», но, вот цитата из очерка В. Демидова «На полшага впереди времени» (начало 80-х)…