Эффективное хранение файлов большого размера в различных отраслях становится непростой задачей. Так, в медиаиндустрии используются колоссальные объемы контента. Учитывая, что цифровое видео формата 4K требует в 4 раза больше свободной емкости, чем файлы стандартного высокого разрешения, художественный фильм средней продолжительности может занимать от 2 (в формате Full HD) до 15 (в 8К) терабайт данных.

Специалисты студии оперируют файлами терабайтных размеров и осуществляют видеомонтаж, цветокоррекцию и окончательную обработку материала с помощью ресурсоемких профессиональных приложений.

Студии постпродакшн в большинстве случаев используют оборудование компании Apple и профессиональный набор программного обеспечения, например, Apple Final Cut Pro, Adobe Premiere Pro, Autodesk Discreet Smoke, DaVinci Resolve и другие.

Одним из оптимальных решений для быстрого совместного доступа к файлам с различных рабочих станций Apple является кластерная файловая система Xsan, которая обеспечивает высокую производительность при обмене общими ресурсами между несколькими клиентами.

В сочетании с надежной системой хранения данных данное решение позволяет не только обеспечить совместный доступ к материалам, но и максимальную пропускную способность, отказоустойчивость в RAID-массивах и гибкую масштабируемость архитектуры. Далее мы расскажем, как построить высокопроизводительную СХД на базе ПО RAIDIX и файловой системы Xsan, приведем элементы инфраструктуры, технические показатели, рекомендации по оборудованию, подключению и настройке системы.

Задачи и решение

Постоянно растущий объем информации и использование ресурсоемкого ПО в постпродакшн предполагает растущий спрос на высокопроизводительные СХД с высокой доступностью данных. В то же время современные технологические процессы обработки видеоданных требуют, чтобы одни и те же файлы были доступны одновременно для нескольких монтажных станций, выполняющих различные задачи.

Другие ключевые требования медиастудий включают в себя:

- Высокую скорость доступа. Предполагает использование локального хранилища или высокоскоростной доступ к сетевой системе хранения данных.

- Распределенный доступ. Предполагает использование файловой системы с одновременным доступом к файлам со множества рабочих станций.

Одновременное решение этих полярных задач удачно реализовано в файловой системе Xsan. Apple Xsan — 64-битная кластерная файловая система Apple для Mac OS X или Mac OS X Server. Система предназначена для организации быстрого доступа к огромным массивам данных. Xsan позволяет совместно использовать файлы и тома размером до 16 ТБ каждый в высокоскоростной оптической сети.

Xsan характеризуется высоким уровнем доступности и почти полным отсутствием сбоев, предоставляя возможность использовать сеть SAN для консолидации данных и замены NAS-устройств.

Компоненты решения

Система хранения данных

В роли СХД выступает одноконтроллерный сервер SM 6048R-E1CR36N с установленным ПО RAIDIX и конфигурацией FC 16Gb + JBOD 847E1C-R1K28JBOD. Система поддерживает SATA, SAS, NL-SAS диски. СХД имеет 4 порта Fibre Channel 16 Гбит, общая пропускная способность достигает 6 ГБ/с.

Контроллер метаданных

В роли контроллера метаданных (MDC) рекомендуется использовать Apple Mac Mini. Для обеспечения высокой доступности предпочтительнее использовать 2 контроллера метаданных.

Клиентская рабочая станция

В роли клиентских станций рекомендуется использовать Apple Mac Pro сервер.

Файловая система

Распределенная кластерная файловая система Xsan позволяет получить одновременный доступ к видеоматериалу с любой рабочей станции. Xsan должна быть предварительно установлена и лицензирована на Apple Mac Mini.

Коммутация

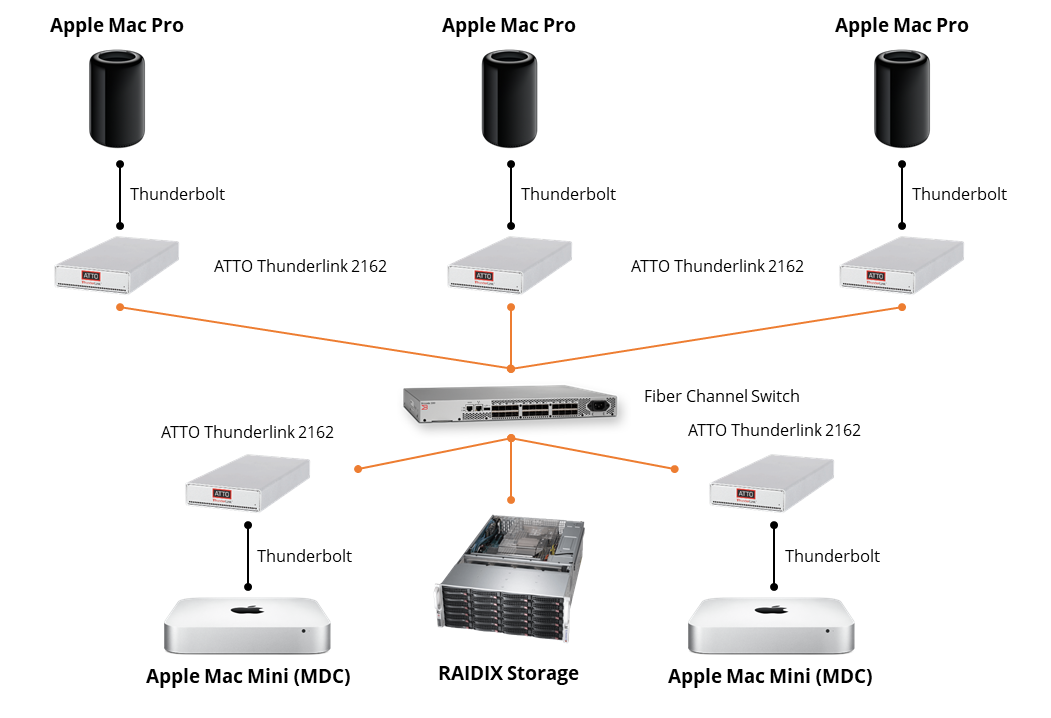

Fibre Channel/Thunderbolt. Mac mini и Mac Pro не поддерживают FC адаптеры, поэтому для подключения их в SAN-сеть рекомендуется использовать ATTO ThunderLink FC 2082 для Mac Mini и ATTO ThunderLink FC 2162 для Mac Pro.

Fiber Channel (FC) коммутатор. При построении решения с небольшим количеством клиентов (до 20) подключение между FC адаптерами осуществляется напрямую от СХД к MDC и клиентам (без FC коммутатора). Для развертывания SAN-сети с большим количеством клиентов требуется как минимум один FC коммутатор.

Большинство всех компонентов соединены оптоволоконным кабелем с коннекторами LC-LC и подключаются непосредственно в адаптеры ATTO FC системы хранения данных и рабочих станций, FC Thunderbolt, FC коммутаторы.

Важно: оптические кабели подключаются к FC адаптерам через SFP трансиверы в каждый порт. Большинство FC адаптеров имеют в комплекте поставки SFP трансиверы, однако некоторые коммутаторы поставляются без трансиверов, что необходимо учитывать при закупке оборудования.

Единственным исключением в схеме оптической коммутации является соединение между Apple Mac Mini и Fiber Channel Thunderbolt: оно осуществляется с помощью специального кабеля Thunderbolt.

Сервера MDC и все клиентские рабочие станции должны быть объединены ETH каналом (сетью) для метаданных.

Архитектура решения

В качестве управляющего компонента в данной архитектуре рассмотрим RAIDIX — ПО для создания универсальных высокопроизводительных систем хранения данных с использованием стандартных аппаратных компонентов. Используя параллельные RAID-вычисления и уникальные математические алгоритмы собственной разработки, ПО RAIDIX соответствует высоким требованиям медиаиндустрии по производительности, отказоустойчивости и непрерывности работы.

Ниже представлена схема коммутации компонентов, необходимых для построения высокоскоростной и высокодоступной системы хранения данных для медиастудий.

RAIDIX поддерживает одноконтроллерный (задействован один узел) и двухконтроллерный (Active-Active) режимы работы системы. При двухконтроллерном режиме работы оба узла активны, работают одновременно и имеют доступ к единому набору дисков. Под узлами понимаются аппаратно-независимые компоненты системы хранения данных, которые имеют собственные процессоры, кэш-память, материнскую плату и могут быть объединены в кластер.

Ниже представлена схема коммутации компонентов, необходимых для построения высокоскоростной и высокодоступной системы хранения данных для медиастудий.

Рекомендации

Ниже приведены рекомендации по конфигурированию системы хранения данных для обеспечения высокой производительности и надежности.

Настройка ATTO FC Thunderbolt

На стороне клиентских рабочих станции рекомендуется использовать последние версии прошивки и драйвера. В большинстве случаев рекомендуется использовать настройки по умолчанию для FC Thunderbolt. Все настройки устанавливаются с помощью утилиты ATTO ConfigTool, которую можно загрузить с сайта производителя.

Диски

Рекомендуется использовать диски NL SAS 7K. Эти диски имеют лучшие показатели по стоимости 1 ГБ и обеспечивают высокую плотность и надежность хранения.

Выделенная подсеть Ethernet для MDC

Каждая рабочая станция Apple Mac Pro поставляется минимум с двумя портами Ethernet 1G, встроенными в материнскую плату. Один из этих портов должен быть подключен к изолированной, выделенной для каждого клиента Xsan подсети и использоваться для первичного трафика метаданных Xsan. Apple Mac Mini, развернутый в качестве контроллера метаданных, имеет один порт Ethernet. Рекомендуемая конфигурация предполагает использовать этот порт в изолированной сети с другими клиентами. Такая конфигурация исключает доступ к Mac Mini за пределами изолированной подсети.

Один том (LUN) в одном RAID массиве

В конфигурации, где важна последовательная пропускная способность, желательно свести к минимуму количество операций поиска по дискам. В связи с этим рекомендуется создавать один том (LUN) на весь размер RAID массива. Кроме того, том Xsan следует создавать из блочных устройств одной системы хранения данных.

Конфигурация RAID-массива

Высокая скорость последовательного доступа и оптимальное использование дискового пространства достигается за счет параллельных вычислений и уникальных математических алгоритмов. Кроме того, в решении используется патентованный RAID-массив 7.3i с тройным распределением четности. Под контрольные суммы выделяется ёмкость трёх дисков, что обусловливает более высокую степень надёжности.

Для обеспечения высокой пропускной способности необходимо создать четыре инициализированных RAID 7.3i массива из 18 дисков каждый (2 массива — диски на узлах хранения; 2 другие массива — диски JBOD’а). Для каждого RAID-массива следует выделить кэш не менее 12 ГБ оперативной памяти. Остальные 8 дисков рекомендуется равномерно распределить в spare pool по 2 диска для каждого RAID массива.

Для тома под метаданные Xsan рекомендуется создать отдельный RAID 10 из двух 2,5” дисков, напрямую подключенных к материнской плате.

Результаты для бизнеса

Xsan позволяет использовать все возможности сети SAN и настроить сервер-хранилище данных, визуализируя сложную топологию сети в простом графическом интерфейсе. С помощью этой кластерной файловой системы пользователь может управлять доступом к важным файлам, задавать квоты для каждого пользователя, настраивать оповещения, консолидировать данные, масштабировать инфраструктуру «на лету».

Используя кластерные функции Xsan, решение на базе RAIDIX позволяет обеспечить максимальную ширину канала в каждой конкретной аппаратной конфигурации, поддержку множественных потоков 2К/4К, быструю обработку данных с нескольких рабочих машин Apple Mac Pro и отказоустойчивость даже при отказе до 3 дисков в массиве.

Таким образом, медийный заказчик получает возможность сократить время постпродакшн (на практике в 2–4 раза в зависимости от проекта), а также обеспечить в среднем более 300 суток непрерывной записи в режиме онлайн (до проведения профилактики), поддержку режимов мультикамерного видеомонтажа и прозрачный мониторинг системы.

Комментарии (7)

Wexter

28.10.2017 12:10raid 10 из двух дисков у вас фиговый получится

raidixteam Автор

30.10.2017 12:22Это особенность конфигурации RAIDIX. В нашем случае RAID 10 из двух дисков — это фактически RAID 1 (RAID-зеркало).

alsakharov

30.10.2017 14:01Несколько странная статья. Она рассчитана на тех, кто строит систему хранения для postproduction видео студии.

Может быть не стоит начинать статью с утверждения, что формат 2k в 4 раза больше места, чем файлы «стандартного высокого разрешения». Потому что FullHD и 2k это почти одно и то же (2048х1080 и 1920x1080),

Еще хорошо бы понять, начиная с какого момента (с какого числа монтажеров) и с каких потоков данных имеет смысл переходить от относительно бюджетных решений на 10G Ethernet на совсем не бюджетные решения на FC 16.

И еще — «относительно небольшое число клиентов до 20», если под клиентами понимаются рабочие места видео монтажера — это уровень большой студии.

При этом совсем не факт, что все эти 20 человек будут работать надо одним проектом. А если они работают над разными проектами и работают с разными наборами файлов, то сводить их всех в одну систему хранения достаточно странное решение.

raidixteam Автор

30.10.2017 17:20Под файлом «стандартного высокого разрешения» имелось ввиду HD 1280x720. С частотой 24 кадра и компрессией 10 бит RGB получаем примерно 88 МБ/с. Сравнивали 88 МБ/с (HD) с 212 МБ/с (2K). Таким образом, разница в 2,5 раза. В 4 раза, действительно, некоторое преувеличение. Спасибо, поправили!

Основная причина использования FC – утилизация производительности RAID-массивов дисковой подсистемы на последовательных операциях доступа. Например, для того чтобы «прокачать» 6 ГБ/с (а именно столько может прокачать данная система) потребовались бы три двухпортовые 10G адаптера (с FC можно обойтись одним).

В данном сценарии мы фокусируемся не на бюджетном решении, а на оптимальном решении для одновременной работы с несколькими (до 4-х) потоками 4K-видео потоков.

Назвать конкретную «точку перехода» с условного 10G Ethernet на условный FC 16Gb сложно. Все зависит от типа нагрузки (размер кадра, частота кадров, сжатие) и количества монтажных станций, с которых ведется параллельная работа над проектом (то есть от количества одновременных сессий на СХД).

Например, для 4 станций, оперирующих с 1 потоком 4К-видео каждая, необходимая пропускная способность составит 4 х 1,5 ГБ/с = 6 ГБ/с. При этом ограничение 10G Ethernet – 1 ГБ/с. В таком случае необходимо использовать Fibre Channel.

n1nj4p0w3r

А в чем польза от трат на NL SAS диски в одноконтроллерной хранилке?

E3AP

Глубина очереди команд в первую очередь. Разница в деньгах между SATA и SAS для «канальных» дисков мизерна.

raidixteam Автор

При прочих равных использовать SAS все-таки предпочтительнее. Аргументы в пользу SAS: надёжность, время наработки на отказ, возможность использования в двухконтроллерной конфигурации.