Специалисты студий постпродакшн оперируют файлами терабайтных размеров и осуществляют видеомонтаж, цветокоррекцию и окончательную обработку материала с помощью ресурсоемких профессиональных приложений. Ключевой задачей для студий является поддержание высокой пропускной способности, достаточной для бесперебойной работы над видеоматериалом без потерь кадров и задержек, как правило, с нескольких рабочих станций.

При этом, учитывая растущие объемы видеоданных и ограниченную емкость хранения, студии постпродакшн и телеканалы нуждаются в высокомасштабируемых решениях. Зачастую, когда речь идет о петабайтах информации и кластерной организации хранения, возникает необходимость горизонтального масштабирования СХД.

В этом материале мы расскажем о типовых задачах медиакомпаний, метриках производительности и Scale-Out решениях на базе RAIDIX и высокомасштабируемой файловой системы Hyper FS для крупных ИТ-инфраструктур.

Растущий объем данных

Эффективное хранение больших файлов в различных отраслях, например, в диагностической медицине или ресурсоемких научных исследованиях, становится непростой задачей. Что касается медиаиндустрии, то здесь используются колоссальные объемы контента. Так, художественный фильм средней продолжительности может занимать до 2 ТБ данных в формате Full HD и до 15 ТБ в формате 8К.

При наличии множества параллельных проектов и петабайтных объемах видеоданных логично создать кластер хранения из нескольких узлов. Выполняя данную задачу, администратор системы сталкивается с несколькими ограничениями традиционных файловых систем: расположением метаданных и данных в одних и тех же разделах; недостаточной масштабируемостью по размеру, производительности, количеству файлов, вложенности папок и т.д.; проблемами с кроссплатформенностью и др. Оптимальным решением в таком случае становится распределенная кластерная файловая система.

Хранение данных в сфере видеопроизводства

Среди ключевых требований к системам хранения данных в сфере видеопроизводства и телевещания можно выделить:

- высокую пропускную способность и неснижаемую производительность даже в случае отказа дисков;

- возможность «горячей» замены аппаратных элементов без простоя;

- возможность настройки приоритетов по приложениям, используемым в технологическом процессе;

- гибкую поддержку интерфейсов доступа к данным Fibre Channel, iSCSI, NFS, SMB, FTP, AFP;

- высокую вертикальную и горизонтальную масштабируемость системы.

Видеомонтаж данных подразумевает необходимость считывать и записывать данные в реальном времени и работать с потоками несжатого видео. Задержки СХД могут привести к потере кадров, и в этом случае процесс придется начинать заново. Ключевой задачей для киностудий является обработка видео в максимально сжатые сроки. В технической плоскости это требование подразумевает высокую пропускную способность и отказоустойчивость оборудования на всех стадиях работы с видеоматериалом.

Медиахолдинги, работающие с десятками параллельных проектов, нуждаются в новых системах хранения данных или модернизации существующих конфигураций в виду увеличения объемов видеоконтента. Такая СХД должна была обеспечивать высокопроизводительное и надежное хранение петабайтных объемов данных с минимальными инвестициями.

Scale-out решение для медиаиндустрии

При работе с высокими нагрузками необходимо соблюдать соотношение производительности, плотности хранения и стоимости. Производительность системы зависит от количества дисков и от производительности каждого отдельного диска. Как правило, высокопроизводительная программно-определяемая технология с использованием вращающихся дисков вполне удовлетворяет потоковым задачам. В сочетании с полками высокой плотности создаются эффективные конфигурации для работы с большим количеством потоков или с потоками высокого разрешения.

При необходимости дальнейшего масштабирования можно использовать кластерные решения, такие как системы на базе ПО RAIDIX и кластерной системы HyperFS.

Ключевыми критериями для горизонтально-масштабируемого решения, помимо высокой производительности и низких задержек, являются:

- единое адресное пространство для нескольких кластеров хранения;

- одновременный доступ по различным протоколам;

- файловый и блочный доступ к одним и тем же данным.

Для примера возьмем систему с большой емкостью хранения (от 2U/48 ТБ до 4U/108 ТБ) на базе RAIDIX с возможностью подсоединения дополнительных дисковых полок, высокой производительностью и поддержкой множественных видеопотоков 2К/4К. Целостность данных без потери кадров обеспечивается патентованными алгоритмами компании «Рэйдикс», включая RAID 6 с двойной четностью и 7.3 с тройной четностью. Так, RAID 7.3 гарантирует бесперебойную работу системы с неснижаемой производительностью даже при отказе до 3 дисков массива.

RAIDIX в качестве управляющего ПО работает со стандартными комплектующими х86-64 (корпуса, диски, интерфейсные контроллеры, память, процессоры и т.д.), позволяет оптимизировать RAID-массивы под конкретные задачи холдинга и снизить общую стоимость обслуживания системы.

Решение RAIDIX поддерживает оборудование Аррlе, AJA, Blackmagic Design, успешно взаимодействует с управляющими средами Хsan, metaSAN, StorNext, FalconStor и профессиональными приложениями для монтажа (Adobe Premiere, Final Cut Pro, Avid, Smoke, DaVinci Resolve, SGO Mistika и др.). Кроме того, RAIDIX позволяет установить профессиональное ПО для цветокоррекции непосредственно на узел хранения, тем самым экономя аппаратные ресурсы.

Кластерная файловая система

Каковы сценарии применения RAIDIX для создания кластера хранения из нескольких узлов? Как уже упоминалось выше, для выполнения этой задачи недостаточно функционала традиционных файловых систем (ФС). Для классических ФС характерны следующие ограничения:

- метаданные и данные хранятся на одних и тех же разделах;

- файлы «размазываются» по разделу, и возникают задержки доступа;

- отсутствует механизм, предотвращающий дефрагментацию;

- недостаточная масштабируемость по размеру, производительности, количеству файлов, вложенности папок и т.д.;

- «неродная» кроссплатформенность.

Названные проблемы решаются с помощью кластерных файловых систем. Так, система HyperFS от Scale Logic обеспечивает высокую масштабируемость прозрачно для клиента и одновременный доступ к данным с различных ОС (в частности, через файловые шлюзы). ПО RAIDIX в связке с HyperFS позволяет организовать единое адресное пространство для блочного и файлового доступа. Среди технических преимуществ совместного решения:

- до 4 млрд. файлов в одном каталоге;

- до 4096 разделов, которые возможно объединить в одну ФС;

- отсутствие единой точки отказа;

- динамическое расширение ФС по емкости и производительности без простоев;

- поддержка последних версий популярных ОС — Mac/Windows/Linux.

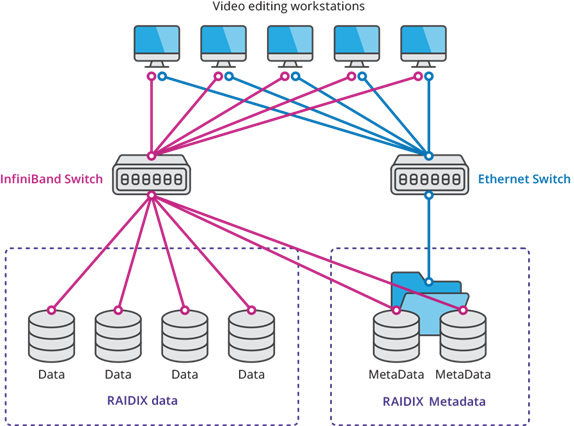

Файловая система HyperFS SAN (рис. 1) обеспечивает необходимую избыточность, высокую доступность данных, зеркалирование путей и данных. HyperFS для SAN позволяет трансформировать несколько ФС или дисковых массивов iSCSI в кластер хранения, который поддерживает одновременное редактирование и воспроизведение данных с нескольких клиентских машин, обеспечивает высокую производительность и совместный доступ в рамках единого пространства имен.

Система располагает опциональным контроллером метаданных (MDC) со структурой избыточности, SAN-структурой полной избыточности с зеркалированием метаданных и поддерживает конфигурацию с множеством путей в среде Fibre Channel и iSCSI. Система не имеет единой точки отказа и обеспечивает высокую стабильность хранения.

Рис. 1. Структура HyperFS SAN

Возможности систем Scale-Out NAS, применяемых в крупных инфраструктурах в сфере медиа и развлечений, включают в себя консолидацию до 64 узлов в кластере, одновременный доступ по разным протоколам (SMB v2/v3, NFS v3/v4, FTP/FTPS, HTTP/HTTPS/WebDAV), балансировку нагрузки между узлами (Round-Robin, Connection Count, Load node), поддержку Active Directory.

Расширенные функции RAIDIX и HyperFS:

- оптимизация системы под большие и маленькие файлы;

- поддержка квот пользователей и папок;

- SNMP-мониторинг по SNMP для SONG и MDC;

- LDAP/Active Directory — возможность использовать локальную базу пользователей или интегрироваться с Active Directory;

- поддержку ACL — возможность использовать ACL на всех поддерживаемых ОС.

Таким образом, система на базе RAIDIX и HyperFS предоставляет киностудиям, студиям постпродакшн и телеканалам решение с высокой производительностью, единым адресным пространством, одновременным доступом по различным протоколам, низкими задержками, высокой расширяемостью, файловым и блочным доступом к одним и тем же данным.

Архитектура решения

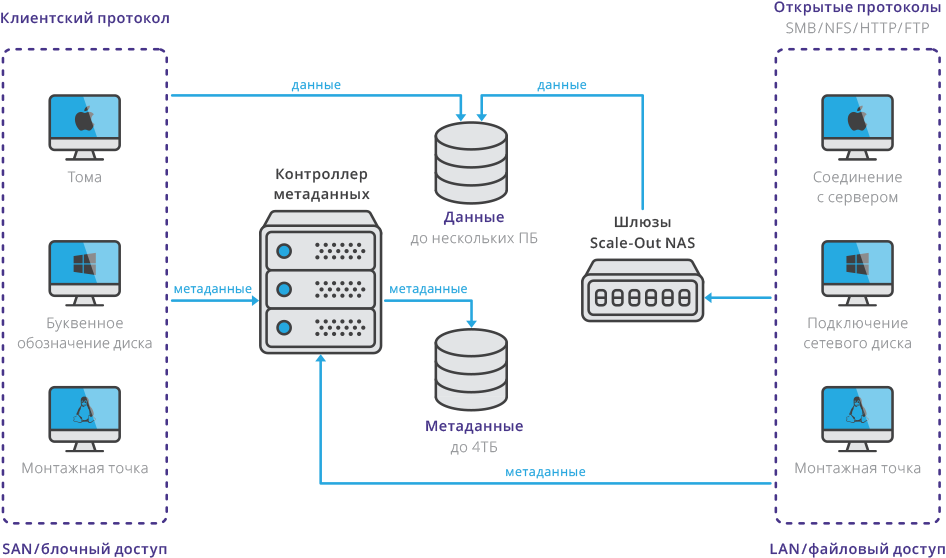

Архитектура СХД (см. рис. 2) на базе ПО RAIDIX и кластерной файловой системы HyperFS состоит из трех основных компонентов:

- Узлы хранения (SharedDisk/СХД). Дисковые СХД, предназначенные для отказоустойчивого хранения информации

- Службы каталога (MDS). Предназначены для хранения ссылок на данные, арбитража и контроля доступа. Сами данные и метаданные службы каталога не хранят.

- Клиенты. В качестве клиентов RAIDIX могут выступать сервера или ПК с установленным специализированным клиентским программным обеспечением для доступа к общим данным.

При необходимости подключения большого количества клиентов — без установки на них клиентского программного обеспечения — в архитектуре решения предусмотрена возможность организации шлюзов файлового доступа (NAS Gateway), через которые осуществляется работа с данными.

Рис. 2. Архитектура СХД на базе ПО RAIDIX и кластерной файловой системы

Технические показатели

| Емкость системы | 64 ЗБ (теоретическое ограничение) |

| Максимальное количество файлов/объектов/папок | До 4 000 000 000 при использовании тома метаданных размером 4 ТБ |

| Размер файла | 64 ЗБ (теоретическое ограничение) |

| Длина имени файла | Windows: 255 символов ASCII; Linux/Mac: 255 символов ASCII |

| Глубина каталога | Windows: 244 символа; Linux: 4096 байт |

| Максимальное количество LUN | 4093 |

| Экспортируемые пути | 512 |

| Количество контроллеров метаданных (MDC) | До 2, могут быть настроены в режиме высокой доступности |

| Количество конкурентных файловых систем | 16 |

| Полная избыточность | Поддерживается: нет единой точки отказа |

| Динамическое расширение файловой системы | Да, LUN могут добавляться без простоев |

| Поддерживаемые клиентские ОС SAN | Windows 7 32/x86_64/Win 8, Win 10 Windows 2008/2008_R2/2012/2012_R2/Server 32/x86_64/2016_x86_64 SUSE 11 SP1-3 OS X 10.7-10.12 |

| Поддержка SSD | Да |

Выводы

Решение RAIDIX позволяет использовать множество узлов хранения (СХД), динамически распределяя информацию между ними и балансируя нагрузку. Архитектура решения позволяет добавлять к системе новые узлы хранения по требованию — без необходимости переносить данные и менять конфигурацию системы.

Основным преимуществом RAIDIX является возможность осуществлять на блочном уровне с высокой производительностью одновременную работу с данными, хранящимися на одной или нескольких СХД, с большого количества рабочих мест, что невозможно в классической SAN-архитектуре.

Технология RAIDIX в сочетании с файловой системой HyperFS удовлетворяет высочайшим требованиям по скорости и отказоустойчивости, обеспечивает одновременную работу с видеоконтентом с нескольких рабочих станций. Использование RAIDIX позволяет минимизировать расходы на апгрейд оборудования при создании кластеров хранения, горизонтально расширяя действующую инфраструктуру без простоев и снижения производительности.

Комментарии (6)

juffinhalli

01.02.2018 11:43Мы используем HyperFS в продакшене уже несколько лет. Но без RAIDX. Если кому интересно, то могу рассказаоть о боевых буднях без маркетинговой шелухи.

shirlen

01.02.2018 14:06А по вашей статистике медицине, безопасности, образованию и другим отраслям, где различное видео не генерирует доход напрямую, часто нужно хранить сырое видео? Продакшину понятно, но остальным то — сжал в AVC или HEVC и радуйся. Я про это «до 2 ТБ данных в формате Full HD и до 15 ТБ в формате 8К.» — кодируем фулл хд авц = 1.8gb, а хевк где-то 1.2-1.3gb. В 1K-1,5K раз меньше места.

raidixteam Автор

01.02.2018 16:31В медицине, безопасности и образовании хранить сырое видео нужно не часто. Поэтому статья и акцентирует внимание на видеопроизводстве. Другие отрасли упоминаются в контексте общего роста данных.

Darka

GlusterFS? Бесплатно и все то-же самое. Причем без контроля метаданных.

pansa

это FUSE, там не может быть быстро.

raidixteam Автор

GlusterFS — это бесплатно, но все-таки недостаточно производительно, особенно в контексте видеопроизводства.