(с)

Восстановить данные — это не только вернуть к жизни полетевший жесткий диск. В широком смысле данные могут быть представлены на каком угодно носителе, а погибнуть — всеми возможными способами.

Восстановление данных это целая наука. Названия у нее пока нет, но, пожалуй, ее можно назвать компьютерной археологией, предметом интереса которой является восстановление цифровыми методами любой поврежденной либо стертой информации.

Так, компьютерные археологи могут восстановить семейные фотографии с поврежденного смартфона или данные с жесткого диска, уничтоженного преступником в попытке избавиться от доказательств, а также помогут воссоздать детали механизма, разрушенного несколько тысячелетий назад.

«Живучесть» диска

(с)

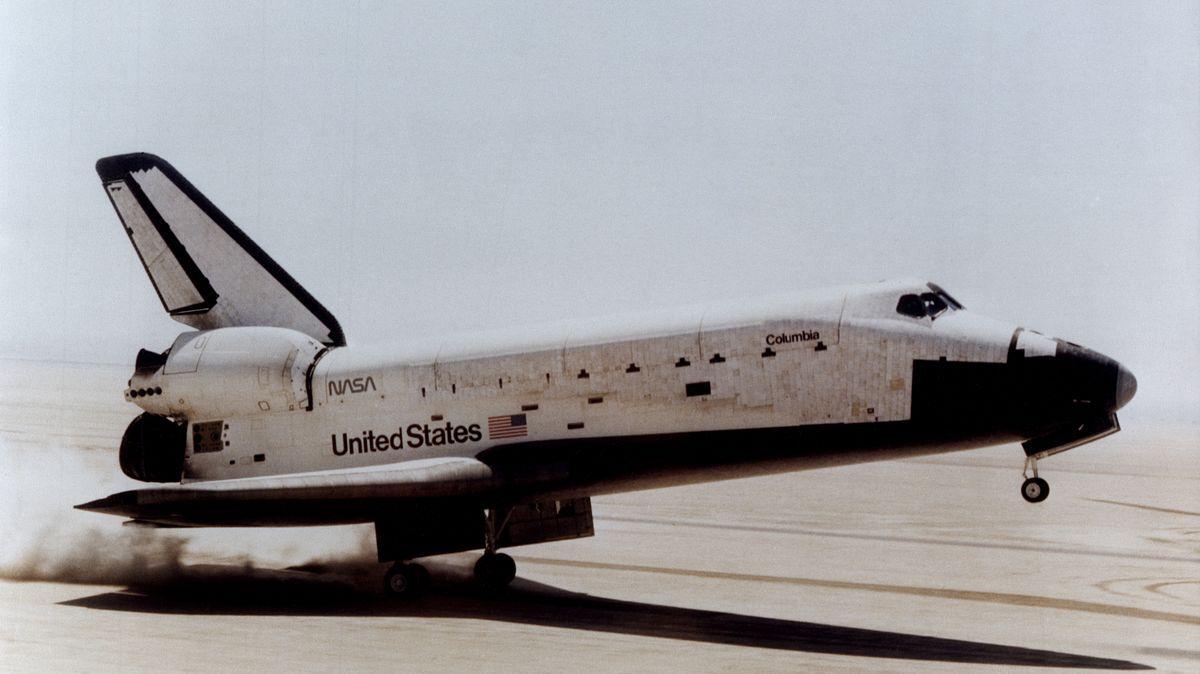

1 февраля 2003 г. шаттл «Колумбия» разрушился при входе в плотные слои атмосферы из-за повреждения крыла куском теплоизоляционной пены. В грузовом отсеке корабль нес 340-мегабайтный жесткий диск, на котором была записана информация об эксперименте CVX-2 (Critical Viscosity of Xenon), в ходе которого изучалось поведения ксенона в условиях микрогравитации.

Проект CVX-2 длился в общей сложности 20 лет, и результаты финального космического эксперимента представляли большую научную ценность. По счастливому стечению обстоятельств жесткий диск не был уничтожен в катастрофе — он упал в озеро, откуда его извлекла поисковая группа. NASA отправили диск в компанию Kroll Ontrack, которая специализируется на восстановлении компьютерных данных.

Диск сильно пострадал: расплавились не только металлические и пластиковые элементы, но и крышка, защищающая его от грязи и пыли. Однако алюминиевые пластины, где, собственно, и хранится информация, не разрушились. Их очистили химическим раствором, а затем поместили в другой жесткий диск — точную копию поврежденной модели. Всего за два дня удалось восстановить 99 % данных.

Химические реагенты очень помогают при работе с поврежденными носителями. Прежде чем пытаться что-то восстановить, необходимо как можно ближе подобраться к источнику информации. Реагенты также используются для восстановления физически стертой информации, например, когда речь идет о работе с серийными номерами. Химическое травление является наиболее распространенным и успешным методом восстановления серийных номеров на поверхности металла.

Очистка и восстановление

Иногда для доступа к данным достаточно аккуратно срезать поврежденные части, не прибегая к реагентам. Процесс интересно рассмотреть на примере механической обработки сгоревшей при пожаре зеркальной камеры. Ее отправили специалистам по восстановлению данных.

Поврежденная карта памяти с семейными снимками находилась внутри камеры.

Слот для карты полностью сгорел.

Чтобы осторожно вскрыть фотоаппарат и подобраться к SD-карте инженеры использовали специальное сверло.

Ущерб от огня не ограничивался корпусом камеры, оболочка SD-карты также расплавилась и слилась с чипом.

Карту пришлось вырезать с хирургической точностью. Разумеется, вставить ее в другой картридер было невозможно. Инженерам предстояло отделить чип памяти от пластиковой оболочки.

Лишь расчистив доступ к чипу, удалось считать данные. Источник.

Огонь или измельчение носителя не всегда являются достаточными условиями для полной аннигиляции информации. Деформированный жесткий диск может быть неработоспособным, но данные, находящиеся на нем, по-прежнему останутся нетронутыми, хотя извлечь их будет очень сложно.

В идеальном случае у вас остается диск, который может вращаться. Один из способов восстановления данных известен как «замена диска», когда магнитный диск извлекают из поврежденного харда и ставят его в корпус жесткого диска той же модели. В редких случаях наличие конкретной модели HDD с нужной версией прошивки является единственным доступным способом вернуть данные. Для этих целей, к примеру, в компании Ontrack хранится 150 тыс. запасных частей «донорских дисков», самым старым из которых уже больше 25 лет.

Гарантированный способ уничтожить информацию

Передовые лаборатории могут работать даже с разрушенными дисками, самостоятельно сканируя отдельные блоки записей. Все части диска аккуратно склеивают и тщательно выравнивают. Затем наступает этап визуального снятия информации либо анализа остаточной намагниченности дорожек. Это очень кропотливая работа, требующая больших финансовых и временных затрат. Весь вопрос в мотивации. Если вам очень нужно восстановить данные, вы, вероятно, сможете.

Существует несколько способов деформировать данные так, чтобы никакая лаборатория не получила их. Среди них:

- полное механическое уничтожение — разрушение диска до мельчайших частиц;

- воздействие мощного магнитного поля;

- кислота.

Последний способ является самым эффектным.

В этом видеоролике жесткий диск растворяют в соляной и азотной кислотах. Кислота растворяет платы и корпуса, а сам диск оставляет нетронутым, но стирает с поверхности тонкую «пленку» данных.

Работа с обширными повреждениями

14 декабря 2012 г. Адам Лэнза осуществил массовое убийство в начальной школе «Сэнди-Хук», погибли 27 человек. Он покончил с собой, не оставив предсмертной записки. Некоторые сведения о мотиве, подтолкнувшем Адама к бойне, вероятно, могли находиться на компьютере, который 20-летний затворник использовал в качестве одного из основных способов контакта с внешним миром.

Лэнза попытался уничтожить жесткий диск компьютера с помощью молотка и отвертки — на фото выше можно оценить состояние диска. В ФБР несколько месяцев исследовали 500-гигабайтный Seagate Barracuda, но не получили никакой информации.

Означает ли это, что «режим параноика» включается зря? Некоторые исследования показывают, что при желании можно восстановить даже критически поврежденные данные. ФБР обнаружило в доме Лэнза множество фотографий мертвых тел, видео суицидов. Также был изучен обширный цифровой след преступника, который вел на форумы с обсуждением педофилии. Психологи смогли составить полный и яркий портрет. Тратить ресурсы на извлечение дополнительных сведений уже не имело смысла.

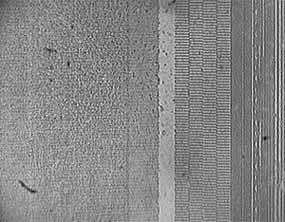

Пластина жесткого диска с нанесенной магнитной суспензией при 30-кратном увеличении

Но представим, что на диске находится сверхсекретная информация, доступ к которой — вопрос жизни и смерти. Известно, что, размазав тонким слоем по поверхности жесткого диска коллоидную суспензию частиц Fe2O3, в отраженном свете мы увидим магнитный контраст, с помощью которого можно оценить наличие или отсутствие информации.

Участок жесткого диска в районе сервометок при 800-кратном увеличении

При 800-кратном увеличении с помощью оптического микроскопа четко различаются отдельные сервометки, несколько хуже выделяются дорожки с данными, записанные более слабым полем.

Несмотря на повреждения фрагментов дорожек записи, делающие невозможным считывание при помощи дисковода, физически информация сохранилась, что обеспечивает возможность ее восстановления. На HDD-дисках мы можем воспользоваться методом считывания остаточной намагниченности.

Таким образом, вопрос восстановления данных — это вопрос наличия необходимого оборудования (и большого желания). При наличии магнитно-силового микроскопа можно исследовать жесткий диск на субмикронном уровне. Современная наука знает примеры куда более специфичных исследований, в том числе с применением атомно-силовой микроскопии, используемой для определения рельефа поверхности с разрешением от десятков ангстрем вплоть до атомарного.

Задачи максимальной сложности

Если вы думаете, что восстановить данные с поврежденного отверткой диска сложно, то как насчет считывания информации с механизма, созданного еще до нашей эры?

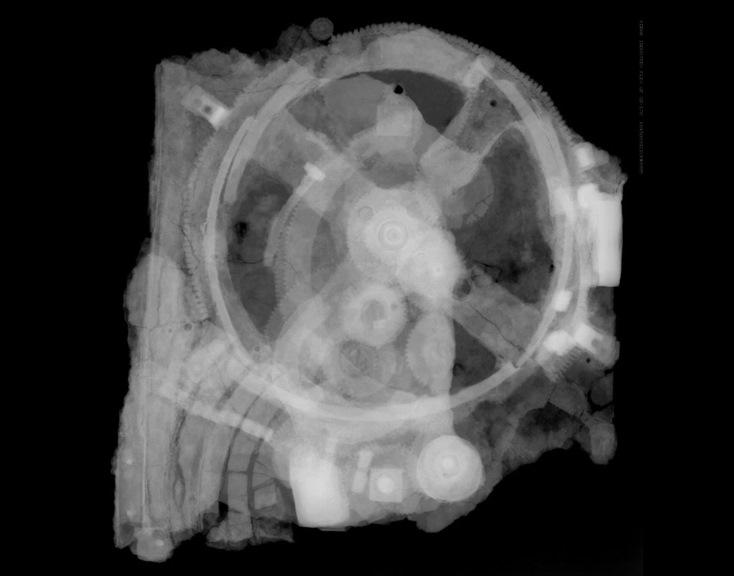

В 1901 г. с затонувшего недалеко от греческого острова Антикитера судна подняли механическое устройство неопределенного назначения. Исследования, продолжавшиеся 117 лет, показали, что Антикитерский механизм был создан между 100 и 205 гг. до н.э. и использовался для астрономических и астрологических вычислений. Воссоздать полную модель механизма, от которого сохранилась лишь четверть изначальных деталей, позволили несколько методов.

Антикитерский механизм, радиографическое исследование.

Для восстановления положения шестерен внутри покрытых минералом фрагментов применяли компьютерную томографию, создающую с помощью рентгеновских лучей объемные карты скрытого содержимого. Удалось определить взаимосвязь отдельных компонентов и рассчитать их функциональную принадлежность. Рентгеновская томография с фазовым контрастом также используется для чтения древних рукописей, определяя высоту текста толщиной 100 микрон по отношению к бумаге.

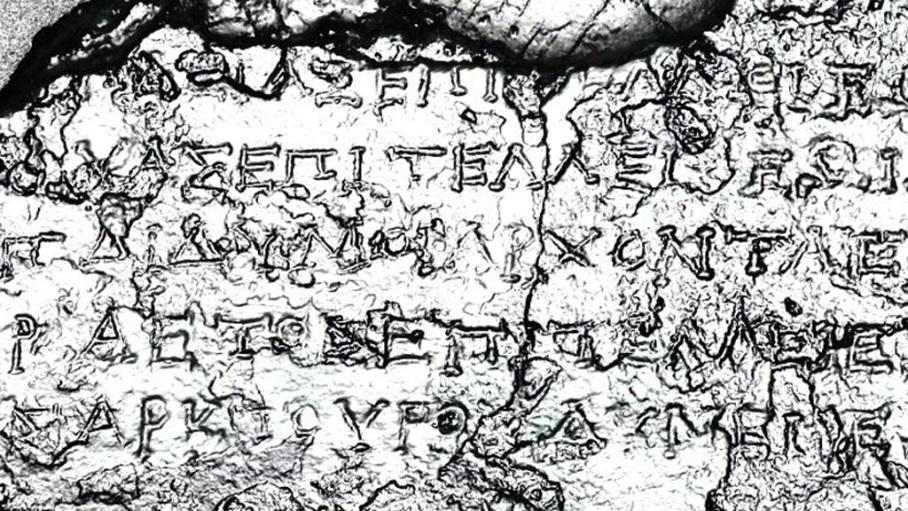

Археологам помогла «инструкция» — описание различных деталей, сделанное на поверхности самого механизма. Однако подавляющая часть текста оказалась уничтоженной эрозией. Более того, сам текст был сделан символами размером чуть больше 1 мм — подобную филигранность ученые ранее встречали только на монетах.

Увидеть и прочитать около 3,4 тыс. знаков (500 слов) ученые смогли с помощью сверхмощного восьмитонного томографа Bladerunner фирмы X-Tek Systems (ныне Nikon Metrology), который используется для обнаружения микротрещин в турбинах. За две недели томограф создал свыше 600 Гб данных рентгеновского изображения надписей, которые были скрыты от глаз более 2 тыс. лет.

Фрагмент текста после обработки РТМ.

Для исследования текстов на внутренних и внешних поверхностях механизма применялась технология PTM (Polynomial Texture Mapping, полиномиальное картирование текстур), которая помогает археологам также считывать почти стершиеся клинописи на вавилонских глиняных табличках. Суть технологии в следующем: объект фотографируется под разными углами падения света, а затем на основе двухмерных снимков программа воссоздает наиболее вероятное трехмерное изображение поверхности. Даже недорогая цифровая камера обеспечивает достаточное разрешение для создания хороших PTM-изображений, при этом может использоваться практически любой источник света, например, вспышка.

Изображения и звуки позапрошлого века

Начиная с середины XIX в. было создано много образцов аудиозаписей, которые сегодня невозможно воспроизвести из-за отсутствия необходимых для этого устройств, либо из-за того, что сами носители записей — восковые цилиндры и пластины — находятся в столь плачевном состоянии, что их нельзя использовать.

Для восстановления старейших аудиозаписей сегодня применяют оптические сканеры. Сначала диски сканируются в оптическом диапазоне с разрешением 10—100 нм для создания полноценной трехмерной модели. Затем полученные модели цилиндров и пластин обрабатывают с помощью алгоритмов, преобразующих изображения в звук.

Именно таким способом удалось восстановить звуки, записанные на оловянной фольге в лаборатории Эдисона в 1878 г., а также обработать данные записи, сделанной в 1860 г. на закопченном бумажном листе.

(с)

Другое важное позабытое искусство прошлого — первые фотографии. В раннем фотографическом процессе, основанном на светочувствительности йодистого серебра, получались не привычные нам фото, а дагеротипы, состоящие из сплавов, образующихся при взаимодействии серебра и ртути, использовавшихся также для производства зеркал (поэтому дагеротипы называли «зеркалом с памятью»).

Надо отметить, что репродукции дагеротипов дают лишь общее представление об изображении, не передавая его подлинного вида. Пластинку с изображением нужно было подвигать в руках, чтобы поймать темную поверхность, которая, отразившись в зеркале дагеротипа, даст изображение.

Фотографии, созданные в середине XIX в. с помощью этой технологии, уже недоступны нам из-за потускнения и других повреждений. Однако ученые смогли восстановить исходные изображения с пластин при помощи сканирующего рентгеновского флуоресцентного микроскопа, который определил распределение ртути на пластинах.

При рентгеновском пучке размером 10х10 микронов (для сравнения: толщина человеческого волоса в среднем составляет 75 микронов) и при энергии, наиболее чувствительной к поглощению ртути, сканирование каждого дагеротипа занимало около восьми часов. Анализируя расположение частиц ртути, исследователи смогли получить изображение в отличном качестве.

Чем быстрее развиваются технологии, тем сложнее пользоваться устаревшими устройствами и носителями информации. Мы еще помним, как «омолодить» магнитную пленку (ее нужно «выпечь»), но для работы с более старыми механизмами нужно подключать научные институты и запускать многолетние программы исследований. С трудом удалось восстановить машину Чарльза Бэббиджа и вернуть в строй старейший действующий компьютер. Когда-нибудь через много лет наши потомки будут пытаться считать данные с компакт-диска с помощью других неизвестных нам технологий.

Комментарии (69)

ilyakos

20.11.2018 14:33+2Добавлю свои 5 копеек. У шефа перестал работать жесткий диск на старом MBP 17 дюймов. Причем гостевая учетка работает. Плюс индикатор здоровья диска тоже говорил, что все ок. Как не бились с помощью спец ПО, ничего вытущить не получалось. За 900 евро в Германии нашли контору, которая смогла все восстановить. Разговорились — рассказали что в нашем и 90 процентов случаях (HDD) вся работа заключается в замене механики. У нас поменяли головку считывающую и все решилось само. Про термовоздействие не догодался спросить. Зато был давно другой случай, когда жесткий диск по-байтово считали с помощью магнитного микросокпа (MFM). К счастью диск был всего на 40 гигов. Learn Backup the hard way!

ooprizrakoo

20.11.2018 16:53Что-то дорого вы заплатили, как мне кажется.

Это обычно самый простой способ — найти на ебее или в ином хламовнике аналогичный жесткий диск, купить за условные 50 баксов, и отдать в мастерскую чтобы в чистой камере перекинули блины. Стоит такая услуга условные пять тыс рублей.

Второй на моей памяти по распространенности случай — когда сдыхает контролер, лечится перепайкой с донора.

ilyakos

20.11.2018 17:00Цена там просто не играла роли. Если делать через фирму то в Германии это столько стоит для юр лиц. Естественно, если знать что и как, то можно и дешевле найти, но см. пункт 1…

DGN

20.11.2018 18:36+4За пять тысяч рублей «чистая комната» будет совмещенным санузлом.

На самом деле, к каждому диску нужен свой подход. К комплексу PC3000 шло довольно объемное руководство.

p.s. Помню как восстановил данные с диска на 120 мегабайт, просто перемещая вручную блок головок.

p.p.s. Если головки прокорябали диск, восстанавливать нечего. Интересно, что сейчас на тему SSD? Может NAND «вспомнить все» на программаторе, с повышенным напряжением или еще как? Помогает ли «прикладная комбинаторика» собрать из считаных NAND чипов образ диска?

sim2q

20.11.2018 19:32За пять тысяч рублей «чистая комната» будет совмещенным санузлом.

в оригинале все же: «ванная» :)

Помогает ли «прикладная комбинаторика» собрать из считаных NAND чипов образ диска?

да сотф же есть

dmitryredkin

21.11.2018 00:56+1А ведь могло так оказаться, новая механика или контроллер наоборот, окончательно «запилили» бы диск, и считать что-то уже было бы невозможно, и винить некого, кроме себя.

По мне, так лучше уж обратиться к компетентным специалистам.

lightman

21.11.2018 10:23Можете посоветовать конкретную контору куда обратиться? Лежат два жестких диска с важными данными, в своей Тюмени не нашёл компетентного специалиста, думаю отправлять в Москву или даже ехать туда самому.

dag_tech

21.11.2018 12:03Это не реклама. Точно знаю 2 ситуации (2015, 2013) с успешным восстановлением вот в этой фирме storelab-rc.ru (Москва). Один раз — внешний диск — не определялся ни под какими операционками на разных компах, в том числе и при попытках запитаться от сдвоенных USB-хвостиков. Пластины раскручивались, щелчков не было. Второй раз — внутренний диск ноутбука — шумы были настораживающие. Но тут мне непонятны подробности лечения — знакомый пошел туда прямо с ноутом (нам некогда было встречаться, извлекать диск для перестановки в бокс и проверок), через пару дней все было ок, но он не может объяснить (не понимает сути вопроса) — то ли исправили логическую ошибку, то ли спасли инфу и заменили диск в ноуте. Настораживающих шумов больше не было.

KonstantinSpb

20.11.2018 16:19Существует несколько способов деформировать данные так, чтобы никакая лаборатория не получила их. Среди них:

- полное механическое уничтожение — разрушение диска до мельчайших частиц;

- воздействие мощного магнитного поля;

- кислота.

Ну и термит не стоит забывать :) Только в бОльших количествах, чем показано в видео

JustMoose

Класс! Я только не понял вот этого: «На SSD-дисках мы можем воспользоваться методом считывания остаточной намагниченности.»

На SSD действительно есть намагниченность? Всегда думал, что там FLASH память, которая просто хранит заряд.

GamesMRG Автор

Опечаточка, поправили :)