Все мы знаем, что объем данных продолжает расти в геометрической прогрессии, и что сами данные являются той новой валютой, на которую рассчитывают предприятия. Способность своевременно реагировать на эти данные может повлиять на конкурентоспособность бизнеса на рынке. Поэтому быстрый и надежный доступ к данным имеет первостепенное значение, а базовая инфраструктура, которая связывает пользователя с системами хранения данных, является более важной, чем когда-либо прежде.

В современном центре обработки данных архитекторы могут выбирать из множества различных вариантов подключения, но Fibre Channel был и останется источником жизненной силы для подключения к общим хранилищам. Это связано с тем, что Fibre Channel является наиболее безопасным, надежным, экономически эффективным и масштабируемым протоколом для соединения серверов и хранилищ, а также единственным протоколом, специально предназначенным для передачи трафика хранилища.

Fibre Channel существует уже несколько десятилетий и по-прежнему является основным выбором для подключения к общему хранилищу в центре обработки данных. С помощью Fibre Channel создается выделенная сеть хранения, а команды хранения SCSI направляются между сервером и устройствами хранения с пропускной способностью до 28,05 Гбит / с (32GFC) и с IOPS, превышающим один миллион. Поскольку Fibre Channel изначально был разработан для трафика хранилищ, он работает очень надежно и обеспечивает высокопроизводительную связь. Адаптеры HPE StoreFabric 16GFC и 32GFC и инфраструктура коммутации обеспечивают пропускную способность, количество операций ввода-вывода в секунду и низкую задержку, необходимые в центрах обработки данных сегодня и на годы вперед.

Достижения в технологии Fibre Channel держат его на опережение, когда дело доходит до подключения.

Например, инфраструктура HPE StoreFabric 16GFC и 32GFC уже способна поддерживать трафик хранения NVMe, даже до того, как собственные массивы хранения NVMe станут массовыми. Другие расширенные возможности включают расширенную диагностику, упрощенное развертывание и оркестровку и повышенную надежность, такую как T-10 PI, двухпортовая изоляция и многое другое.

Другой популярный вариант подключения к хранилищу – iSCSI. С iSCSI, команды хранения в стандартной сети TCP / IP, и это отлично подходит для систем низкого и среднего уровня, где производительность и безопасность не являются основными требованиями. Распространенное заблуждение о Fibre Channel заключается в том, что, поскольку он использует выделенную сеть хранения данных, он дороже, чем iSCSI. Хотя iSCSI может работать в той же сети Ethernet, что и весь обычный сетевой трафик, для обеспечения производительности, необходимой большинству клиентов от своих систем хранения, iSCSI должен работать в сегментированной или выделенной сети Ethernet, изолированной от обычного сетевого трафика. Это означает сложные конфигурации VLAN и политики безопасности или полностью выделенную сеть Ethernet. Так же, как Fibre Channel.

Единственная реальная разница в стоимости между FC и iSCSI – это когда DAC — кабели используются в реализациях iSCSI. Но с ограничением расстояния 5 метров, используя DAC — кабели.

Это может нормально работать для клиентов малого и среднего бизнеса, имеющих только один массив хранения, но DAC — кабели плохо работают в крупномасштабном центре обработки данных.

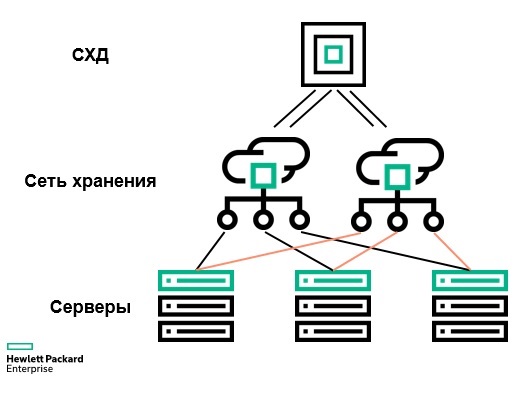

Когда вы смотрите на топологию сети хранения данных, лучшие практики идентичны для iSCSI и Fibre Channel. Для обеспечения отказоустойчивости и устранения простоев в проекте сети хранения данных (SAN) предусмотрено два идентичных сетевых пути между серверами и хранилищем.

Однако одно существенное отличие заключается в том, что сети Fibre Channel не так подвержены нарушениям безопасности, как Ethernet. Когда вы в последний раз слышали о взломе сети Fibre Channel? Никогда? Как насчет сети Ethernet?

Безопасность является одной из главных причин того, что Fibre Channel будет оставаться опорой в центре обработки данных в течение многих лет.

Как мы ожидаем, набор команд SCSI будет заменен командами Non-Volitile Memory Express или NVMe. NVMe – это оптимизированный набор команд, разработанный для SSD и памяти классов хранения, который намного эффективнее, чем SCSI. Кроме того, NVMe представляет собой многорядную архитектуру с очередями ввода-вывода до 64 КБ, причем каждая очередь ввода-вывода поддерживает до 64 КБ команд. По сравнению со SCSI с одной очередью и 64 командами, NVMe может обеспечить значительно более высокую производительность.

Современная инфраструктура HPE StoreFabric 16GFC и 32GFC, которая поддерживает команды SCSI, также может запускать команды NVMe в сети SAN или в структуре, как она называется. При использовании Ethernet клиентам потребуется внедрить RDMA с низкой задержкой по сравнению с конвергентным Ethernet или RoCE, чтобы в полной мере использовать преимущества NVMe. Однако этот подход требует сложной реализации Ethernet без потерь с использованием мостов центров обработки данных (DCB) и управления приоритетными потоками (PFC). Сложность сети для NVMe через Ethernet будет огромным барьером для большинства клиентов, особенно когда развернутая сегодня FC SAN прекрасно работает с хранилищем NVMe завтрашнего дня.

Суть в том, что Fibre Channel останется источником жизненной силы для связи между серверами и общим хранилищем.

Комментарии (17)

AntonVirtual

06.08.2019 16:19+1>а также единственным протоколом, специально предназначенным для передачи трафика хранилища

Что же это, получается вы в Simplivity используете не предназначенный для этого протокол?

bigbit

06.08.2019 16:40+1Поскольку Fibre Channel изначально был разработан для трафика хранилищ

Это не так. Fibre Channel разрабатывался как замена 100-мегабитному Ethernet'у. Но вместо этого победил гигабитный Ethernet, и стандарт отправили на полку. И лишь когда IBM стала разрабатывать стандарт SSA взамен отживающему свое параллельному SCSI, производители жестких дисков во главе c Seagate встрепенулись (т.к. не хотели платить IBM копеечку с каждого жесткого диска) и решили откопать стандарт Fibre Channel, доработав его для использования в СХД. Именно они добавили туда топологию петли, широко использовавшуюся в СХД (изначально было только 2 топологии — фабрика и P2P).

bigbit

06.08.2019 17:42+1сети Fibre Channel не так подвержены нарушениям безопасности, как Ethernet

Атаки на SAN — это полное раздолье для хакеров.

Погуглите bh-us-03-dwivedi.pdf – документ аж от 2003 года, но все актуально и сейчас.

Расписаны WWN spoofing, session hijacking, MiTM и DoS.

Шифрования нет, все открытым текстом. Аутентификации тоже обычно нет — красота!

В фабрике есть такие классные сервисы, как Management Server и Name Server, которые с радостью выложат любому информацию о фабрике и подключенных устройствах.

Доступ дается на основе WWN. Это все равно, что выдавать доступ хостам на основе их MAC-адресов. Кто-то скажет, что в Fibre Channel есть возможность аутентификации. Но обычно никто этого не использует, т.к. не все устройства это умеют (например, если это блэйды с NPIV — то все печально).

shapa

06.08.2019 20:49Коллега-автор сего писания на хабре (хотя с трудом «коллегой» язык поворачивается ;) ) просто не знает базовых вещей. Да, по сути SAN намного менее защищен чем нормально спроектированный ethernet.

vkostr

06.08.2019 17:50+1похоже на не очень хороший перевод вот этого

community.hpe.com/t5/Around-the-Storage-Block/Fibre-Channel-The-lifeblood-of-storage-connectivity-in-the-data/ba-p/7046140

osipov_dv

06.08.2019 19:05+1Единственная реальная разница в стоимости между FC и iSCSI – это когда DAC — кабели используются в реализациях iSCSI. Но с ограничением расстояния 5 метров, используя DAC — кабели.

Ох и завернули триллер… в оригинале тоже муть. Может кто-то пояснить мысль сего?

bigbit

06.08.2019 21:01Понять сие не сложно. Автор повествует, что напрасно многие думают, что iSCSI дешевле FC из-за того, что с iSCSI не нужна отдельная сеть SAN. Для достижения должного уровня производительности iSCSI все равно приходится изолировать от обычного сетевого трафика тем или иным способом. Например, VLAN'ами, или ставить отдельные коммутаторы Ethernet. Т.е. получается такая же отдельная сеть SAN, как и с FC. Единственный случай, когда iSCSI реально дешевле FC — это когда сервера подключаются к СХД напрямую (без коммутатора) медным твинаксиальным кабелем SFP+, который используется в 10Gb Ethernet. HP это называет DAC (Direct Attached Cable). Там расстояние ограничено 5 метрами.

osipov_dv

06.08.2019 21:40Вот про DAC на 10 Gb я слышал, но то что это по сути iscsi не знал, спасибо. Правда не понятно почему 10 метров, если ethernet, это же не external sas.

ximik13

08.08.2019 07:49Не обязательно iSCSI, так же как и оптические патчкорды не обязательно FC. Есть вполне себе медные TWINAX кабели под FC. Есть и длинные, правда оптические, кабели TWINAX (DAG) под Ethernet. Чего уже только не придумали :).

homerlittle14

07.08.2019 04:35Мои 2 копейки:

1. Не обязательно напрямую подключать сервера с СХД. 10Гбит Ethernet Switch всяко дешевле FC Switch-a.

Можно и напрямую конечно, если не ферма. Просто в случае с vSphere уже не получается использовать Host Profiles, а это грустно.

2. Доходит и до 7м. Можно между шкафами пробрасывать, если недалеко.

dustinweb.azureedge.net/media/206922/x240-10g-sfp-sfp-3m-dac-cable.pdf

shapa

Божественная пурга.

Сколько раз говорил — не пускайте маркетологов писать «технические» статьи.

«Когда вы в последний раз слышали о взломе сети Fibre Channel? Никогда? Как насчет сети Ethernet?»

Вы выдаете принцип security through obscurity за правильный подход.

FC ломается легко и просто, «спасает» изолированность — но на ethernet легко можно сделать то-же самое, с намного более высокими скоростями передачи данных (сотни гигабит) и меньшими задержками (FC коммутаторы в 2-3 раза выше уровень задержек / latency)

«и с IOPS, превышающим один миллион» — миллион — это много по вашему? Да сегодня одна NVMe / Optane карта больше может выдавать.

Мы еще в 2017 году показывали как в VM легко получается более миллиона IOPS, на SDS с чистыми ethernet подключениями.

Про tcp/ip — тоже крайне неграмотно, изучайте что такое RDMA, RoCE v2 и тд.

…

Ни одна из крупных онлайн компаний не использует FC (да и традиционные СХД)

Существовала одна компания, которая пыталась это делать — Yahoo. Теперь ее нет, они проиграли технологическую гонку c Google.

Вот хорошая статья на эту тему (почему Yahoo умер).

techcrunch.com/2016/05/22/why-google-beat-yahoo-in-the-war-for-the-internet

«At the beginning of the new millennium, Google and Yahoo started down very different paths to attain the enormous scale that the growing size and demands of the Internet economy (search, email, maps, etc.) required. For Yahoo, the solution came in the form of NetApp filers, which allowed the company to add server space at a dizzying rate. Almost every service that Yahoo offered ultimately ran on NetApp’s purpose-built storage appliances, which were quick to set up and easy to use, giving Yahoo a fast track to meet market demand (and soon made the company NetApp’s largest customer).

But in nearby Mountain View, Google began work on engineering its own software-defined infrastructure, ultimately known as the Google File System, „

bm13kk

Вы случайно не знаете как так получилось что более простой FC оказался медленее (и по ширене и по пингу) ethernet?

shapa

Потому что более универсальный / открытый стандарт практически всегда в итоге победит.

Гораздо больше вендоров, гораздо больше средств анализа трафика и борьбы со злоумышленниками (включая DPI / firewall), гораздо больше возможностей (гибкость).

По сути, если сравнить распространение FC SAN сетей и ethernet — вторые будут на несколько порядков (буквально) более распространены — например, все онлайн бизнесы (в сумме обслуживающие многие миллиарды пользователей).

Ни одна «энтерпрайз» платформа даже рядом не лежит с тем же гугл или фейсбук например.

FlashHaos

В приведённой Вами цитате речь идёт о файлерах NetApp. Разве они используют SAN?

shapa

Речь вообще в целом что концепция 3-tier и внешнего хранилища — уже ущербна. Какой там протокол — уже по сути не важно.

Ну и использовали они не только файлеры.