ИИ учится генерировать изображения из подписей и начинает лучше понимать наш мир

Из всех моделей искусственного интеллекта именно GPT-3 разработки OpenAI сильнее всего поразила воображение публики. Она без особых подсказок может извергать стихотворения, короткие рассказы и песни, заставляя думать, что это работы человека. Но красноречие — всего лишь уловка, которую не стоит путать с реальным интеллектом.

Тем не менее, исследователи верят, что те же приемы, которые использовались для создания GPT-3, скрывают секрет для создания более продвинутого ИИ. GPT-3 тренировали на огромном объеме текстовой информации. Что если те же методы тренировать одновременно на тексте и изображениях?

Новое исследование под названием AI2, проведенное в Институте искусственного интеллекта Пола Аллена, вывело эту идею на следующий уровень. Исследователи создали особую, визуально-лингвистическую модель. Она работает с текстом и изображениями и может генерировать последние из подписей. Картинки выглядят тревожно и странно, совершенно не как гиперреалистичные «дипфейки», созданные генеративно-состязательными сетями (GAN). Но они могут показать новое направление для более практичного интеллекта, и, возможно, сделают роботов умнее.

Заполнить пробел

GPT-3 входит в группу моделей, известных как «трансформеры». Они впервые обрели популярность благодаря успеху BERT, алгоритма Google. До BERT языковые модели были довольно плохи. Их прогностических способностей хватало для автозаполнения, но не для составления длинных предложений, где соблюдены правила грамматики и присутствует здравый смысл.

BERT изменил ситуацию, представив новую методику под названием «маскинг» (прим. — оригинальное название masking). Она подразумевает, что в предложении прячутся разные слова, и модель должна заполнить пропуск. Примеры:

- Женщина пошла в ___, чтобы потренироваться.

- Они купили___ хлеба, чтобы сделать сэндвичи.

Идея состоит в том, что если заставить модель выполнять эти упражнения, часто по миллиону раз, то она начнет обнаруживать закономерность в том, как слова собираются в предложение, а предложения — в параграфы. В результате алгоритм лучше генерирует и интерпретирует текст, приближаясь к пониманию смысла языка. (Google сейчас использует BERT, чтобы выдавать более релевантные результаты поиска.) После того как маскинг оказался крайне эффективным методом, исследователи попытались применить его к визуально-языковым моделям и стали прятать слова в подписях. Вот таким образом:

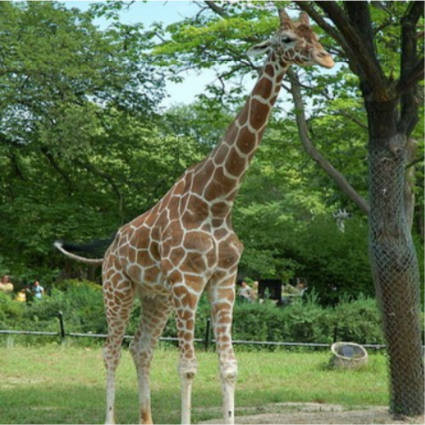

____ стоит на земле рядом с деревом. Источник: AI2

В этот раз модель могла рассматривать окружающие слова и содержимое изображения, чтобы заполнить пробел. После миллиона повторений она училась обнаруживать не только паттерны слов, но и связь слов с элементами каждого изображения.

В результате модели могут связывать текстовые отношения с визуальными примерами, как младенцы устанавливают связи между выученными словами и увиденными вещами. Модели могут взять фотографию ниже и составить осмысленную подпись, например, «Женщины играют в хоккей на траве». Или могут ответить на вопрос вроде «Какого цвета мяч», связывая слово «мяч» с круглым объектом на фотографии.

Визуально-языковая модель может составить осмысленную подпись этой фотографии: «Женщины играют в хоккей на траве». Источник: JOHN TORCASIO / UNSPLASH

Лучше один раз увидеть картинку

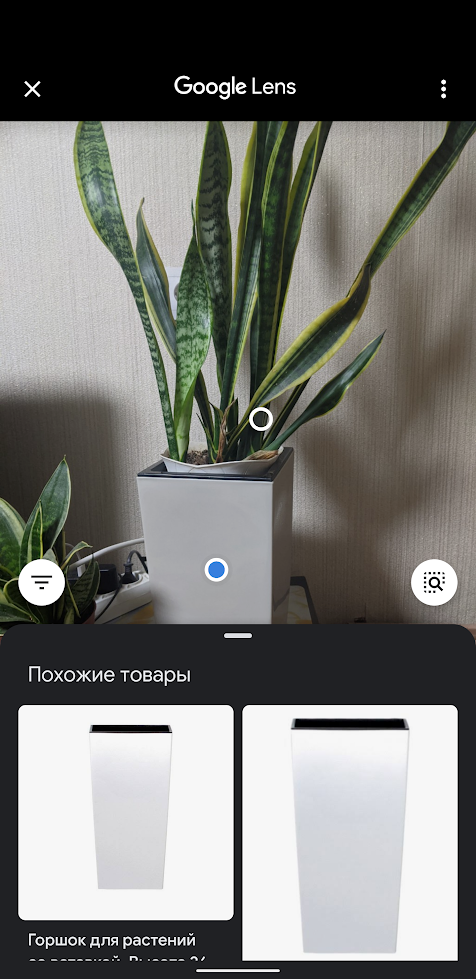

Исследователи хотели узнать, развивают ли эти модели концептуальное понимание визуального мира. Ребенок, который выучил слово для объекта, может не только назвать его, но и нарисовать объект по подсказке, даже если сам по себе объект отсутствует. Так что команда проекта AI2 предложила модели делать то же самое: генерировать изображения по подписям. Все модели выдали бессмысленный пиксельный мусор.

Это птица? Это самолет? Нет, это абракадабра, сгенерированная искусственным интеллектом. Источник: AI2

В этом есть смысл: преобразовать текст в изображение сложнее, чем сделать обратное. «Подпись не определяет все, что находится на картинке», — говорит Ани Кембхави, руководитель группы компьютерного зрения в AI2. Таким образом, модель должна опираться на большое количество знаний о нашем мире, чтобы добавить недостающие детали.

Например, если модель просят нарисовать «жирафа, который идет по дороге», то ей необходимо сделать вывод, что дорога скорее будет серой, чем ярко-розовой, и проходить будет рядом с полем, а не с морем. Хотя вся эта информация не является явной.

Поэтому Кембхави и его коллеги Джемин Чо, Джиасен Лу и Ханнане Хаджиширзи решили посмотреть, могут ли они обучить модель всем этим скрытым визуальным знаниям, подправив подход к маскингу. Вместо того чтобы обучать алгоритм просто предсказывать «замаскированные» слова в подписях соответствующих фотографий, они также тренировали его предсказывать «замаскированные» пиксели в фотографиях на основе соответствующих подписей.

Финальные изображения, созданные моделью, не вполне реалистичны. Но это не важно. Они содержат правильные высокоуровневые визуальные концепции. ИИ поступает как ребенок, который рисует фигурку из черточек, чтобы изобразить человека. (Вы можете испытать модель самостоятельно здесь).

Примеры изображений, сгенерированные моделью AI2 по подписям. Источник: AI2

Способность визуально-языковых моделей генерировать подобного рода изображения представляет собой важный шаг вперед в исследованиях искусственного интеллекта. Это говорит о том, что модель на деле способна к определенному уровню абстракции — фундаментальному навыку для понимания мира.

В долгосрочной перспективе навык может иметь важные последствия для робототехники. Чем лучше робот понимает обстановку и использует язык, чтобы сообщать о ней, тем более сложные задачи сможет выполнять. В краткосрочной перспективе, отмечает Хаджиширзи, визуализация поможет исследователям лучше понимать, что именно изучает модель, которая сейчас работает как «черный ящик».

В дальнейшем команда планирует больше экспериментировать, улучшать качество генерации изображений и расширять визуальный и словарный запас модели: включить больше тем, объектов и прилагательных.

«Создание изображений действительно было недостающей деталью головоломки, — говорит Лу. — Добавив его, мы можем научить модель лучше понимать наш мир».

amarao

Я одного не могу понять — заголовок саркастический или серьёзный? Если судить по картинкам — саркастический. А по тексту — как будто автору кажется, что это успех.

Acuna

Серьезный. ИИ уже умеет генерировать картинки по подписям, а то что они далеки от идеала — это просто вопрос времени, однако даже уже в целом понятно что изображено на таких картинках.

DrPass

У меня есть подозрение, что подавляющее большинство визуальных образов в человеческом мозге на самом деле хранятся примерно в таком же виде.

perfect_genius

И мы можем даже видеть их — сновидения.

Denai

Так и есть, мозг решает задачу о том как максимально сжать информацию. Потому в снах, например, может не быть лиц или объекты лишены деталей. Нейросеть по сокращённой информации пытается развернуть всё в сюжет, который потребляет мало ресурсов и отвечает запросу

struvv

Для начала пусть ИИ научится отвечать на вот такие предложения:

Или рисовать их, например в данном случае.

«Алиса пришла со своим парнем на вечеренику, где он поцеловал именинницу Свету. Почему Алиса в бешенстве?»

Простейший вопрос, показывающий всем желающим чего у нейросетей нет — воображения, которое есть ключевая часть разума человека. Уверен, что данная нейросеть, попытавшись нарисовать моё предложение просто провалится полностью, как это всегда происходит, когда мы выходим за границы трюка

В статье мы имеем всё же в большей степени трюк, где 99% работы делает наше воображение и демки работы нейросетей очень часто абьюзят этот трюк

LonelyDeveloper97

Думаю в некоторых племенах, где такая странная традиция как моногамия не сильно распространена обладатели органических мозгов тоже затруднятся ответить на ваш вопрос.

Так что дело тут не в воображении, и в том что вы так классно представляете что происходит в голове у алисы — а в наличии общего культурного контекста который вам такие финты провернуть позволяет. И то не всегда — почему Алиса так расстроилась, когда ее парень принес ей букет роз?))

Hardcoin

Для какого "начала"? Откуда вы взяли, что именно ваш вопрос должен быть началом?

А Алиса в бешенстве, потому что уронила ключи от машины в ливнёвку. Я верно ответил?

stvorl

На подобные вопросы, порой, даже люди не могут ответить, что уж говорить об ИИ :-)

Конкретно для этого вопроса есть наиболее ожидаемый ответ, но тоже еще повод для дискуссии, в зависимости от того, куда поцеловал.

Lockal

ИИ хоть бы на какие-нибудь предложения научился бы отвечать. Например, «Сколько будет 2+2?». Пока что по теме «Почему Алиса в бешенстве?» GPT-2 с bellard.org/textsynth выдаёт:

Что соответствует ожиданиям, но ни капли не приближает машину даже к пониманию, что такое «2+2», не говоря уж об общих знаниях.

struvv

Лучше тестить нейросети так: «Alice came with her boyfriend to the party then he kissed Sveta. Why Alice is mad?»

Должен быть кейс — картина, которую мы описываем, вопрос, который проверяет, что сетка правильно всё поняла

DrPass

В данном случае воображение не причём. Просто ваша личная нейросеть натренирована на распознавание такого поведенческого паттерна как «ревность». Если искусственную нейросеть сделать помощнее и тренировать не только на сопоставление текста и плоских визуальных образов, но и на происходящие во времени события, ваша задача тоже будет её по зубам.

struvv

Воображение причём. Тут нужно чтобы нейросетка была натренирована симулировать разум людей, который сам по себе способен симулировать реальность, и болеет того, симулировать разум других людей, то есть симулировать симуляцию

en.wikipedia.org/wiki/Theory_of_mind

А это уже тоже самое, что на калькуляторе МК52 виртуализировать все ЦПУ суперкомпьютера

vadimr

Воспроизводить разумный ход мыслей совершенно необязательно для получения его обычного результата. Китайская комната неплохо действует.

struvv

Как Китайская комната действует когда мы воспроизводим поведение 12 ядерного цпу на микроконтроллере 70мгц?

vadimr

Нам не нужно воспроизводить поведение 12-ядерного цпу, а лишь только то, что будет напечатано на экране. Причём не буквально, а с некоторым приближением.

struvv

Ну вот допустим у нас есть 100ТБ данных текста и нам нужно вычислить md5 от него

Микроконтроллер тут эмулирует поведение суперкомпьютера и его задача всего лишь напечатать итоговый текст

В таком кейсе Вы увидите проблему перформанса, которая в случае с Китайской комнатой.

Прежде чем искать почему этот кейс с Вашей точки зрения не опровергает Вашу гипотезу настоятельно рекомендую прочесть вот что:

https://lesswrong.ru/w/Вера_в_убеждения

diogen4212

можно сгенерировать любой валидный md5, при отсутствии суперкомпьютера пользователь не сможет проверить результат. Просили — вот вам (такая китайская комната)

struvv

А причём тут рандомный md5, который нельзя проверить?

Какая связь с тем тезисом, что нейросети не справляются с вопросами, требующими theory of mind, и люди МОГУТ это проверить

vadimr

Связь в том, что в человеческом поведении примерно 1% обусловлен применением разума (разума! а не сознания), а всё остальное – социальные паттерны.

Вы, наверное, не застали, а был у нас такой руководитель страны, Горбачёв, так вот он обожал часами произносить речи, не имеющие вообще никакого смыслового содержания. А человек, на минуточку, Советским Союзом руководил (правда, тот в результате распался). Я утверждаю, что для эмулятора Горбачёва совершенно не нужно 12-ядерное цпу и 100 терабайт.

Вот Циолковского пока непонятно, как эмулировать.

struvv

Это сперва нужно доказать, ведь именно этот тезис я и критикую) А то мы уже вышли на https://ru.m.wikipedia.org/wiki/Сепульки

Или иными словами — доказательство через само себя

P.s.

Горбачова лично не встречал, по тв не видел, тот объем проблем, который был в 90ые огрёб по полной будучи подростком, но не смотря на это не готов судить о том, что он там говорил в силу своего незнания

vadimr

Приведу другой пример. Недавно мне звонили из какой-то фирмы, якобы по поручению Мегафона, чтобы предложить какие-то бонусы, попутно спрашивая мой адрес проживания. Я, естественно, персональные данные сообщать не стал, беседа с обученной читать вопросы по бумажке девушкой зашла в тупик, и я положил трубку. Но суть в том, что потом я прочёл в интернете, что мой собеседник был роботом. То есть злонамеренность и не очень высокий уровень интеллекта я распознал, а машинное происхождение собеседника – уже нет. Тьюринг был бы доволен.

struvv

Там не машинное происхождение, текст(скрипт) придумал умный человек, сумевший смоделировать разум других людей и их реакции на его текст

PrinceKorwin

Там нет никакого интеллекта. Простое дерево принятия решений и ветвлений диалогов с целью вернуть его в требуемое русло.

vadimr

Возможно. Однако и живая девушка на месте робота действовала бы таким же образом. То есть возвращаемся к вопросу о том, что же такое этот необыкновенный человеческий интеллект, и как можно объективными экспериментами убедиться в его существовании.

vadimr

Именно.

Akon32

Может, нет, а может, уже есть. GPT-3 в примере вполне себе генерирует истории, которых не было.

a1111exe

Всё упирается в вопрос — может ли конвейер иметь воображение. Ещё конкретнее — может ли конвейер иметь субъективное восприятие. Мельница Лейбница хорошо иллюстрирует проблематику.

vladvul

конвейер у вас в голове смог

a1111exe

Если можете это доказать — идите получать нобелевку. Потому что лучшие умы человечества не могут этого сделать по сей день.

mrtux

Конвейер — нет. Точнее, его субъективное восприятие будет очень далеко от человеческого. Субъективным восприятием человеческого типа обладает только система человеческого типа — т.е. человеческое тело.

a1111exe

Если предполагать субъективное восприятие у конвейера, то можно предполагать субъективное восприятие у чего угодно, включая песок, камни и вакуум. Только тогда вопрос искусственного интеллекта вообще никак не связан с восприятием. Максимум, чего можно добиться — имитации разумной деятельности. Субъективное восприятие там, в кремнии, уже и так есть, не так ли?

mrtux

Я вообще не предполагаю какого-то субъективного восприятия как некой отдельной сущности. То, что человек переживает как субъективное восприятие — производная процессов, которые протекают в сложной структуре, называющейся человеческим телом. У других живых существ организмы структурально проще, поэтому и «субъективное восприятие» у них проще, чем у человека. Структура конвейера неизмеримо проще, чем структура даже какого-нибудь дождевого червя, так что «субъективное восприятие» конвейера совершенно непонятно что из себя представляет, но оно совершенно точно существует просто в силу факта физического существования конвейера как структуры.

a1111exe

У такой позиции есть имя: "элиминативизм". Обосновать её ещё ни у кого не получилось (не получается и у редукционизма с менее сильными требованиями). Так что это такая философская вера, иррациональная, имхо, т.к. противоречит фактам.

Или не производная. Есть и другие теории, например, супервентность, которая ввиду осознавания бесплодности элиминативизма и редукционизма сегодня пользуется большей популярностью. Хотя и её доказать не получается.

С чего вдруг из физического существования конвейера должно следовать существование у него субъективного восприятия? У конвейера по сбору деталей на заводе тоже есть субъективное восприятие?

P.S. Если некоторые свойства А можно кодировать через Б, из этого не следует, что А это Б. Например, субъективный цвет это не его кодировка в RGB или другой системе, также это не частота световой волны, не раздражение сетчатки глаза и не электрохимические преобразования в мозгу. Из того, что можно установить соответствие, не следует тождество. Наконец, типы содержаний субъективного восприятия не совместимы, например, с типом нейронной сети.

mrtux

Нет, это не то. Я не признаю идиотского разделения материального и ментального в принципе. Считаю это бездонной ловушкой, в которую по некоторым причинам угодили господа философы, а вслед за ними и учёные. Но я не отрицаю никаких ментальных состояний. Ментальные состояния человека — вообще самая очевидная для человека штука во всём мире. Я лишь отрицаю, что ментальные состояния это сущность какого-то особенного рода.

С того, что конвейер существует физически. Если точнее, само понятие «субъективное восприятие» — лишняя надуманная конструкция. Есть только структуры и связанные с ними процессы. Я не вижу принципиальных различий между ударом по кирпичу и ударом по человеку, просто человек реагирует несколько разнообразнее, потому что устроен сложнее.

a1111exe

В эру широкой популярности вульгарного физикализма встретить такой взгляд — неожиданность. Искренний респект!

Вы придерживаетесь некоторой конкретной метафизики? Ну типа монадического идеализма Лейбница, процессуального идеализма Уайтхеда, панпсихизма Рассела?

Я так не думаю. Содержания субъективного восприятия — это то, что даётся нам непосредственно. А всё, что не даётся нам непосредственно, опосредовано содержаниями субъективных восприятий. И это включает в себя всё то, что мы можем быть склонными называть объективным знанием.

Знание о физическом существовании состоит из совокупности чувственных восприятий и мыслей. Само физическое полагается интерсубъективным (т.е., существующим объективно), но ни одного непосредственного свидетельства этому у нас нет и, если подумать об этом, быть не может. По сути, физикализм, полагающий реально существующими объекты лучших текущих физических теорий, это метафизический взгляд, имхо, технически далеко не самый лучший.

Но какую-то базисную онтологию надо выбрать, иначе не понятно, о чём, вообще, речь...

Если как базисную выбрать монистическую форму онтологии физикализма, то непонятно, по каким причинам у конвейера должно быть субъективное восприятие (или ментальные состояния, которые в моей терминологии сводятся к субъективному восприятию). Да вообще непонятно, с чего у чего бы то ни было должно быть субъективное восприятие. Имхо, безуспешные попытки элиминативизма и редукционизма происходят из принятия такой онтологии.

Если же, как базисную выбрать, например, панпсихический материализм Рассела, то тогда с любым физическим объектом нужно ассоциировать какое-то ментальное состояние, т.е., субъективное восприятие. Но в этом случае наличие субъективного не зависит от конкретной природы физического объекта — оно будет и у камня, и у мельницы, у центрального процессора, у оперативной памяти, у системной платы и у всего системного блока. По какой причине мы должны предполагать, что у компьютера, в котором запущены достаточно совершенные алгоритмы, скажем, нейронных сетей, субъективное восприятие вместе с субъективной же разумностью будет чем-то ближе к аутентичному человеческому интеллекту? Или не должны?

Лично я нахожу панпсихический материализм не очень убедительным, вызывающим много вопросов. Если ментальное/субъективное это просто ещё одна сторона физического, то почему у человека такую особую роль в восприятии и работе психики играют органы чувств и мозг? У каких-то физических объектов есть ментальные привилегии по сравнению с другими? Мельница разумнее камня? А камень разумнее отдельного атома? Одна и та же нейронная сеть, реализованная в помповом и кремниевом компьютерах, будет иметь одинаковую субъективную разумность?

Кроме того, как нейронные сети могут имитировать разумную деятельность, понятно. Для их работы нет никакой необходимости в особой субъективной персональности. Непонятно, по каким причинам ментальный статус компьютера, на котором запущена нейронная сеть, должен отличаться от ментального статуса компьютера, на котором запущена ОС Windows?

Если же брать идеалистический монизм, то объективное физическое существование конвейера разлагается на субъективные элементы его восприятия (когда его кто-то воспринимает). Физические объекты не имеют собственного существования, нежели чем в общей регулирующей ментальной модели, в соответствии с которой синхронизируются индивидуальные субъективные восприятия. В этом случае не понятно, почему некоторое подмножество восприятия и разума (который "крутит" общую модель) должно само обретать некоторую субъективную реальность, если мы запускаем в этом подмножестве нейронную сеть.

С какой стороны не подступись, непонятно, почему внезапно нейронные сети должны сообщать особый ментальный статус физическому объекту, на инфраструктуре которого они работают.

Это очень сильное утверждение. Я бы даже сказал — радикально сильное. По крайней мере, в варианте, в котором я его понимаю. Причины почему — более-менее обрисовал выше.

mrtux

Я не так чтобы любитель метафизики как некой объёмной и целостной картины мира, и в целом не стремлюсь построить какую-то систему на базе исходной идеи, это просто размышления с самого детства о том, почему и как у меня вообще есть какое-то Я :-)

Да, всё верно, я просто путаюсь в терминах. Можно сказать так: субъективное восприятие какой-либо сущности это процесс бытия этой самой сущностью. Из этого следует, что субъективным восприятием обладают все без исключения материальные структуры (обратное допущение как раз неочевидно, потому что непонятно, с чего бы человек чем-то принципиально отличался от другой материи, и с теми же высшими животными куча вопросов появляется). Просто «быть конвейером» это настолько далеко от «быть человеком» (слишком разные структуры), что мы даже представить вряд ли можем, каково это.

Мозг и вообще нервная система человека играют в его сознании такую особую роль потому, что именно они наделяют процесс бытия человеком свойством «сознание человеческого уровня» (какая-то тавтология получилсь, но лучше объяснить я не могу). Любая человекоподобная структура с мясным телом и сырыми мозгами будет иметь субъективное восприятие человеческого типа. Потому что человек это материальная структура и ничего больше, любой другой вариант ведёт к некому аналогу божественной искры сознания или чего-то такого.

a1111exe

Понимаю. Фишка в том, что наши полагания накладывают на нас обязательства, как только мы хотим их либо детализировать, либо выступить с ними публично. Это эмпирические обязательства согласования с опытом и логические обязательства совместной когерентности (непротиворечивости) полаганий друг с другом. Собственно, из-за этих требований все, кто серьёзно пытается развить свои представления о мире, стремительно попадают в философию, т.к. это она и есть. Кстати, не факт, что в современной научной философии материализм популярен среди большинства даже физиков (тех, кто понимает отличие физики от метафизики). Это очень проблемная концепция.

Перевожу для себя: моё субъективное восприятие это процесс моего бытия. Поправьте, если надо. Я сам склонен отождествлять своё существование с существованием динамики своего субъективного восприятия — просто по той причине, что вне моего субъективного восприятия мне ничего не может быть известно. Это, по сути, единственная доступная мне реальность. Правда, тут же начинаются нюансы. Разные типы субъективных содержаний образуют ортогональные друг другу пространства (так, цвет может восприниматься независимо от звука, но одновременно с ним). Конкретные различимые содержания восприятия — это и не я, и не составные части меня в мереологическом смысле, хотя вообще без них то целое, в котором они пересекаются, тоже не будет мной (меня вообще тогда не будет). А главный, наверное, нюанс — применительно к нашему обсуждению — я это не моё тело, о котором, как о физическом объекте, я знаю исключительно опосредованно. Для меня, как сущности, тело является ещё одной особенностью моего субъективного восприятия, от которой я, к сожалению, существенным образом завишу (по крайней мере, на время этой жизни). Да, мой субъективный комфорт в определённой мере зависит от состояния этого тела, но это ни в коей мере не является причиной для отождествления. Непосредственный опыт прямо демонстрирует обратное. Таким образом, для меня совсем не очевидно это:

Как я понимаю, Вы берёте "материальные структуры" как фундаментальный базис онтологии, и индуктивно полагаете, что субъективное присуще всему материальному, как одно из фундаментальных свойств. Честно, лично я не знаю ни одной хорошей причины полагать материальное онтологическим базисом (и знаю хорошие причины не полагать его таковым), но это тема другого разговора. Обрисованная Вами позиция, насколько я её понял, вписывается в панпсихизм Бертрана Рассела. Если мне не изменяет память, он полагал, что всё материальное фундаментально наделено некоторой психикой примерно по таким же причинам. Однако, этот метафизический взгляд предполагает, так сказать, магию. Если сравнить конкретное субъективное переживание (звук, цвет, запах) с конкретными физическими структурами мозга, то понятно, что мы рассматриваем сущности совершенно разных, несовместимых, типов. Их существование вместе не может быть обусловлено физическими причинами. Мы, получается, имеем завуалированный дуализм — материальное как бы имеет две качественно разные грани в своей реальности.

Чем плох любой другой вариант? Мне, например, импонирует радикальный эмпирицизм Уайтхеда — онтологию следует строить из конкретного, из данного, т.к. фактически только это у нас и имеется. Мы можем строить понимание только из уже понятого, но всё понятное сводится к интуитивно ясным содержаниям нашего восприятия (я их по-деревенски называю самопонимаемыми — понимание качества цвета или звука заключается в самом качестве). И они точно существуют — это непосредственная данность. Любое другое понимание будет либо сводиться к интуитивно ясному, либо порождать порочный круг (сепулька-сепулькарии-сепуление-сепулька), либо уходить от интуитивного понимания в непонимание (имхо, серьёзная проблема платонизма, полагающего абстрактное объективно существующим). Для человека его субъективность это непосредственная интуитивно ясная данность, отрицать которую равнозначно отрицанию фактов. Почему нельзя принимать эту субъективность, как базис? Физике, как науке, это ничем не повредит. Более систематическому исследованию субъективного — вполне вероятно, поспособствует.

mrtux

Да, как писал Пенроуз: компьютерная модель урагана это не сам ураган. Но даже сам реальный ураган — не ураган для человека, который находится за тридевять земель от урагана. Такой человек может воспринять реальный ураган только как модель урагана. Потому что он не находится внутри урагана.

То же самое и с т.н. субъективным восприятием: если ты не находишься внутри Васи (то есть, если ты не сам Вася), для тебя субъектность Васи всегда будет лишь моделью (кажется, в биологии это называется теорией разума).

Для сущности внутри компьютера закодированный в RGB зелёный — именно что зелёный цвет, а не его модель.

struvv

вот запилят GPT-3, напишем ей ситуацию и спросим факт из этой же ситуации — посмотрим, что выйдет.

Эксперимент фальсифицируемый, вдруг заработает

RomanArzumanyan

Понемногу разрабатывают Глубину.

amarao

Они не далеки от идеала, они далеки от распознавания человеком. Т.е. "оно что-то генерирует". Ура. Похоже, нет — не важно.

Acuna

Так ведь в том-то и дело что как раз таки похоже, если вы не понимаете что на них изображено — это как-бы ненормально если честно…

derprimus Автор

Кажется, тут даже три в одном: и сарказм (из-за картинок), и оптимизм автора, и щепотка кликбейта

Alexmaru

ну, люди тоже в воображении не генерируют всю картинку детально, вплоть до атомов. Примерный образ же.

Foxbator

Не знаю видели ли Вы гиперреалистичные сны, это когда сон кажется детальнее и четче, чем реальность. Это когда видишь поры кожи и волоски людей в своих снах. Так что наши нейросети способны к синтезу куда более реалистичных изображений.

zlsl

Процесс, отвечающий за сон работает под «root».

Так что поставить флаг какой-нибудь вроде SUPER_UHD_QUALITY_HIDETAIL в результатах сна он тоже может :) А пользователь схавает.

tcapb1

Не факт, что всё изображение в данном случае в UHD, а не мелкий его элемент (волосы, поры кожи), который высвечен сном. Обычно у нас образы всё-таки очень примерные. Попробуйте нарисовать по памяти какой-нибудь простой, но затасканный логотип. Скорее всего столкнётесь со сложностями.

SpaceEngineer

А вы уверены, что сны генерируют именно изображения, которые подаются на зрительную кору для распознавания? Может быть, они происходят уже в высших отделах мозга, которые оперируют понятиями "волоски на коже руки", "скопление пор на щеке". Ведь даже уже первичная зрительная кора не оперирует пикселями, как могло бы показаться, а элементами вроде линий, градиентов, векторов движения.

a1111exe

У меня практически все сны такие. Если бы не различия в консистентности сценария, не мог бы отличать явь от сна. Полный спектр ощущений, сложные сценарии, смена идентичностей (включая явно нечеловеческие) и в таком духе. Бывают потрясающие виды, кстати, иногда планетарного масштаба. :) В общем, по личным ощущениям, реалистичность снов может легко одной левой уделывать реалистичность яви, только разница типов сценария мешает дизориентации.

VDG

Занятная история про гипер-реалистичные сны. Двадцать пять лет назад ещё бывали очень холодные зимы, чтоб пробирало аж до костей. Я как-то очень морозным утром как обычно ехал в институт в промёрзшем автобусе. Ради забавы дышал на холодное стекло, которое тут же затягивалось морозным рисунком. И вот все эти неповторимые фрактальные снежинки навели на мысль, что я бы при всём желании не смог сгенерировать во сне такую «сложность», так что подобное можно использовать как тест — во сне я или в реальности, ну и меня тут же выбросило из сна ). До сих пор периодически попадаю в такие ситуации.

Кстати, Черниговская рассказывала, что белочка, которая приходит к людям, настолько реальна, что отличить от настоящей невозможно. Галлюцинации гипер-реалистичны, соответственно, ничего не запрещает такими же быть и снам, чем они по сути и являются.

a1111exe

Один раз удостоился осознанного сновидения. Не знаю, все ли осознанные сновидения такие, но это было что-то. Можно примерно описать в терминах "материя подчиняется вниманию и намерению". Если пытаешься что-то рассмотреть, то оно приближается и увеличивается до чуть-ли не микроскопических деталей. Если думаешь о каком-то предмете, он материализуется. Хочешь летать — не проблема. До сих пор неуловимый для меня секрет — как произвольно входить в такое состояние, и как сохранять осознанность (испытывая левитацию, вылетел из помещения в окно, потерял осознанность и провалился в неконтролируемое сновидение). В принципе, процесс входа я запомнил и технически мог бы повторить, но пока не получается собрать внимание так же качественно и так же продолжительно, как в тот раз. А может, это просто был такой подарок свыше, не знаю… Даже не знаю, стоит ли стремиться к такому опыту. Он, конечно, экстремально интересен, но мало ли, как это может сказаться на психике..

VDG

a1111exe

Поделитесь советами по технике входа?

Меня осознанное сновидение больше интересует в плане путешествия по памяти в разрезе обучения. Но, конечно, если при этом не будет происходить физического отдыха, то игра не стоит свеч.

VDG

Техники нет, я всегда на каком-то уровне знаю, что я во сне. Яркая мысль о том, что это сон, разрушает его. Поэтому задвигаю её подальше, чтобы не выпасть в этот самый отладочный режим. Ну, а если попал в него, то ничего не делаю. Через несколько секунд благополучно выбрасывает из сна. А в этом «отладочном режиме» нет условий для нормального завершения сна. Можно, так сказать, «застрять», пока прилично не запаникуете. Поэтому лучше просто спать, смотреть сны и нормально просыпаться.

mrtux

Воздержитесь от сексуальной разрядки дней 5-7.

Ложитесь спать с твёрдым намерением получить осознанное сновидение, шансы из-за этого резко возрастают (хз как это работает, но работает).

Во сне должна произойти какая-нибудь лютая дичь, нехарактерная для яви. Но это не всегда срабатывает, зачастую даже полёты сновиденное Я воспринимает как само собой разумеющееся.

a1111exe

Всем спасибо за советы!

У меня во снах "лютая дичь" это обычное явление, так что да, не сработает. С полётами вообще забавно: чтобы взлететь, приходится напрягать что-то в районе спины, и это ощущение настолько реалистично и естественно (как обладание дополнительным органом), что после сна какое-то время есть чувство физической неполноценности.

PrinceKorwin

Я прекратил такие осознанные эксперименты со снами давно. Забавно, но всегда, всегда они заканчивались тем, что я терял контроль и на смерть разбивался обо что-нибудь.

Например — летаешь над Землей, видишь все её континенты, облака, можешь спуститься и рассмотреть город, улицы, людей, но обязательно тебя (меня) в конце концов швырнет так в землю, что сразу в холодном поту просыпаешься.

Или просто едешь в автобусе. Ощущаешь всю эту давку, людей, спертый воздух, запах пота. Периодически по глазам бьет солнечный свет проглядывающий через плотную листву платана и каштана. И становится душно. Очень. Высовываешь голову в окно чтобы вздохнуть наконец полной грудью свежим воздухом и видишь как на встречу лицу приближается столб… Пытаешься влезть обратно внутрь, но толпа народу в автобусе уже не даёт тебе этого сделать и бамптц — столб и голова встречаются. Ну а ты такой весь разбитый и немного ошалевший находишь себя сидящим на кровати :)

Когда надоело каждый раз роскомнадзориться так и забросил это дело.

sumanai

Забавно. Меня при попытке контроля тупо выкидывает, и я просыпаюсь )) Тоже давно не пробовал.

mrtux

Слишком сильно пытаетесь контролировать :-) Нужно осторожнее, лучше даже не смотреть пристально ни на что. В общем, кастанедовское «Искусство сновидения» в помощь, там всё хорошо расписано (эзотерическую составляющую можно игнорировать)

SerJ_82

Все довольно просто, при должном внимании к теме и тренировках.

При этом именно внимание и концентрация очень важна. То есть если у вас в жизни много заморочек. на которые тратится время и энергия — скорее всего толку будет мало…

Найдите и читайте «ФАЗА» Михаила Радуги. Есть так же вебинар и мобильное приложение.

samodum

Это гигантский успех!

10 лет назад попроси кого-нибудь написать алгоритм, который по тексту картинку сгенерирует — он просто покрутил бы пальцем у виска, это было невозможно

APXEOLOG

Так никто и сейчас алгоритм не напишет. Точнее алгоритм будет следующего вида:

Hardcoin

Речь об архитектуре сети и алгоритме обучения.

Forthright

А откуда нейронную сеть брать? Где взять семена, когда высаживать и чем удобрять не подскажете?

Akon32

Как раз лет 10 назад общался с разработчиком таких алгоритмов, но, кажется, они не преуспели тогда.

Lockal

Разработчики Google Images 20 лет назад: «ну да, пошли мы нафиг...»

IgorMats

Я думаю, что это работает совсем не так как Вы это подали.

Hardcoin

Это и есть определенный успех. Хорошо нарисовать женщину или мотоцикл нейросеть научить можно, возьмут 2 млрд параметров (вместо 226.5 млн), прекрутят сбоку GAN и результат будет намного лучше. Это вполне возможно, просто дорого.

amarao

Всё что я на это могу сказать — поговорку про попытку выйти в космос прыгая всё выше на pogo stick.

Пока что не убеждает, скорее, даже убеждает в том, что китайская комната — путь вникуда. Много практических результатов, ноль прогресса в районе general intelligence.

Hardcoin

У вас просто критерии мутные. Люди хотели сделать картинку по описанию, получили некоторые интересные результаты (то, что у них сеть по современным меркам небольшая, это очевидно). А вы говорите — не убеждает, потому что не вижу прогресса в сторону general intelligence. А они его вам вообще обещали разве? Они картинку по описанию хотели сделать, а не general intelligence.

AwesomeLemon

А как, по-вашему, должен выглядеть прогресс в области general intelligence?

Мне кажется, бенчмарки вроде SuperGLUE показывают прогресс

amarao

а вот pogo stick, это хорошая аналогия. Скажите, а как выглядит орбитальный полёт? Если я на pogo stick прыгнул на 10 метров в высоту, это же больше похоже на орбитальный полёт по сравнению с прыжком на 0.1 метра, да?

В рамках аналогии с орбитальным полётом — оно летит и не падает, точнее падает, но промахивается. Тогда это орбитальный полёт. Падает — не орбитальный.

Вот с GAI так же. Если оно тупое как пробка и при любом чихе начинает нести ахинею или банальщину, то это не GAI.

AwesomeLemon

Хм, понимаю вашу аналогию. Но тогда выходит, что прогресс особо не измерить? Ведь улучшения на бенчмарках в рамках этой аналогии будут лишь более высокими прыжками. И только при изменении парадигмы может произойти глобальный сдвиг. Но это будет значить резкий переход от 0 до 1, без градаций.

В принципе, такая позиция имеет право на существование. Я вижу это по-другому, но это уже субъективщина.

А для вас есть какой-то конкретный результат, при достижении которого можно было бы сделать вывод, что у нас есть AGI, а не пого-палка?

amarao

Ну, смотрите. Если оставлять в стороне сложные вещи, уровня "осмысленного ответа" и т.д., можно посмотреть на простейшие примеры GAI. Например, животные. Никто не возражает против наличия интеллекта у животных. Любой енот или белка с лёгкостью докажет существование у себя GAI таки сожрав и распотрошив мусор из мусорника с хитрым засовом.

Базовое требование к GAI — возможность действовать с реальностью в терминах реальности.

Я знаю, есть исследования, где AI (точнее, его поколения) приходил к интереснейшим решениям практических задач (в виртуальной среде). Ключевая проблема — это дарвиновский отбор для решения. Вместо универсального AI, который "придумал" как решить проблему, у них поколения неуниверсальных алгоритмов, отбирающихся по survival of the fittest.

Вот когда будет GAI, которая (будучи тренирована в обширном классе задач для своего "мира") покажет нетривиальные методы решения новых задач (которые не участвовали в обучении), вот тогда можно будет обсуждать его качество.

Hardcoin

А если это не pogo stick, а grasshopper? Если взлетел не на 2 метра, а на 5 — это больше похоже на орбитальный полет? Правильный ответ — да, больше похоже. Пойдет год и это уже 750 метров. Пройдет ещё пара лет и это не просто полет в космос, но и успешная посадка первой ступени.

Но комментаторы писали ровно то же, что и вы — 5 метров? Разве это хоть каплю напоминает орбитальный полет? Спейсх идут не туда.

Вы, при желании, можете идти в сторону general AI любым другим способом. Будет даже интересно, есть вы получите какие-то практические результаты и решите ими поделиться. Однако ваши сомнения не практичны и бессмысленны — человечество точно придёт к практичному и полезному искусственному интеллекту. Либо к слишком умному и, возможно, опасному.

amarao

Если вы возьмёте falcon 9 и разгоните его по прямой до второй космической, то он всё равно шлёпнется обратно. Орбитальное движение — это не высоко прыгать, а набирать достаточно большую горизонтальную скорость (а делать это на высоте за пределами атмосферы — это уже локальная задача оптимизации).

Вот "горизонтальной скорости" я от всё более высоко прыгающих GPS-3 (General pogo stick-3) я не вижу.