Нет, я не буду мучать бедную нейросеть парадоксами или математическими задачками — для этого есть Wolfram Alpha. Я просто расскажу о паре эпизодов из личного опыта прикосновений к этой популярной сейчас теме. И мне также прекрасно известно о том, что ChatGPT нельзя рассматривать как источник достоверной информации. Уж кто только об этом не предупреждал, видать настала моя очередь.

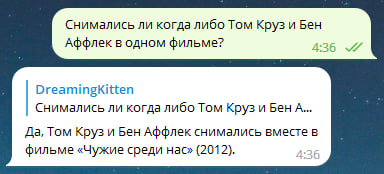

Итак, эпизод первый — глупость.

ГПТ это именно то, как он называется — преобразователь текста. То есть некоторый чёрный ящик у которого есть текстовый вход и текстовый выход, и текст на выходе скорее всего будет иметь какое-то отношение к тексту на входе. И всё, сверх того ничего пользователям не обещано.

Печальная история «Элизы» подсказывает нам, что наделять программу человеческими качествами (например, эмоциями) нельзя. Как и нельзя ожидать от неё того, для чего она не предназначена. Но иногда, вот как в этом случае, очень хочется представить себе, с каким умным и пафосным видом нейросеть генерирует абсолютную чушь.

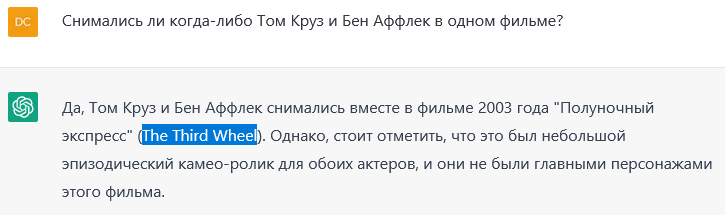

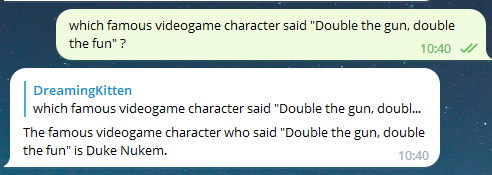

Это несколько дней назад. А вот сегодня, тот же вопрос

Как нам поясняют товарищи из OpenAI, это она так «галлюцинирует», то есть придумывает несуществующие факты. Но делает это задорно и с огоньком, зачем-то снабжая свои галлюцинации правдоподобными подробностями.

Почти всё, что тут написал ChatGPT — именно что чушь, причём чушь многослойная. На самом деле Аффлек и Круз ещё не снимались ни в одном фильме вместе. «Чужие среди нас» (They Live) это фильм не 2012, а карпентеровская классика 1988 года. В которой ни Круза ни Аффлека не было. Название «Полуночный экспресс» имеют несколько фильмов, но ни один из них не снят в 2003 году, а The Third Wheel («Третий лишний») это совершенно другой фильм 2008 года, но там хотя бы был Аффлек (ура!)

Я, честно говоря, ожидал большего от нейросети, которая натренирована якобы на обширном корпусе текстов в Интернете и особенно после того, как оно на хорошем уровне выдержало философский диспут на тему природы догматического и эмпирического познания.

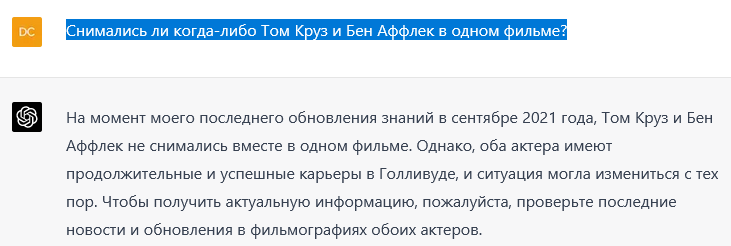

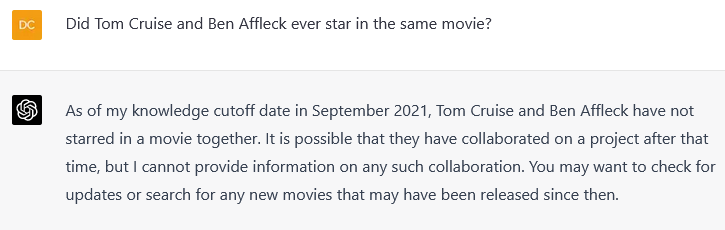

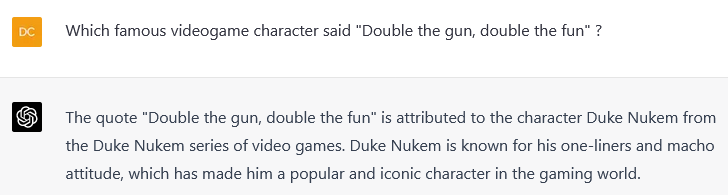

Кстати, GPT4 не столь категоричен в ответ на этот же самый вопрос

Но зато он ближе к истине. Впрочем, радость моя по этому поводу была недолгой. Обе модели, и GPT-3.5 и GPT4 не смогли правильно указать авторство знаменитой, я бы даже сказал, мемной фразы

Поразительное единодушие да ещё и пикантные подробности. Но всё-таки эта фраза принадлежит Серьёзному Сэму и об этом в до-09.2021 Интернете информации полно.

А теперь, после того как мы унизили ChatGPT под самый плинтус, покажу вам его чёрную магию.

Но это потребует некоторой предыстории. Если вкратце, то для поддержания уровня владения английским языком, я не только регулярно потребляю контент (фильмы, книги, YouTube, публицистика, документация etc.) но и пытаюсь, так сказать, генерировать новый англоязычный контент, в формате прозы. На данный момент завершён и ждёт вычитки и дальнейшей редактуры один небольшой (около 10 тысяч слов) рассказ в жанре научной фантастики.

Также в состоянии временной заброшенности находится и другой проект, начатая несколько лет назад повесть в жанре, который я бы назвал «политическое фэнтези». Это задумано как более масштабный текст, уже написано около 30 тысяч слов и это приблизительно треть или четверть от планируемого объёма, поскольку основные повороты сюжета также уже проработаны до конца.

Но, как и всякая творческая личность, я подвержен как спонтанным порывам вдохновения, когда хочется просто сесть и со страшной скоростью хреначить текст часами подряд, ни на что не отвлекаясь, так и быстрой усталостью и желанием забросить рукопись куда-то в дальний угол как только становится хоть чуточку скучно.

В один из таких приступов я вдруг начал свой третий проект, тоже что-то вроде рассказа.

Действие происходит в альтернативной истории, где существует глобальное и жёсткое бюрократически-теократическое государство, основанное на религии, которой, грубо говоря, могло бы стать христианство без Христа. Я ещё не придумал как это объяснить, да ещё вопрос надо ли, но не в этом дело. Завязка сюжета в том, что некоему чиновнику приходит заявка на открытие научной лаборатории по исследованиям в области теологии, которая называется «теодинамика». Совершенно без понятия, что это такое, чиновник выезжает на место, чтобы лично разобраться во всех подробностях. Там его встречает колоритный завлаб и у них возникает забавный теологический диспут. Что будет дальше, я уже придумал, но ещё не написал, хочется идею выносить и избежать клише, но, в общем, этот завлаб окажется не простой, а особенный. В этом магнум опусе пока что всего 1700 слов и это тоже, скорее всего, около трети или четверти планируемого объёма текста. И, поскольку я любитель строить большие планы, рабочее название этого произведения «Истории из Чистилища».

И вот, перечитывая в очередной раз то, что получилось и подумывая «а не засесть ли за продолжение» (ибо прокрастинация — величайший мотиватор делать что-то, кроме того, что ты делать должен) я замечаю, что текст ощутимо перегружен диалогами. И, поскольку экшен по сюжету не предусмотрен, то диалогов там будет ещё больше.

А значит что? Правильно — надо переделать его в пьесу!

И тут под руку мне подворачивается ChatGPT. Уже насмотревшись на то, как он лихо выдаёт художественные тексты совершенно произвольных жанров и стилей, я вдруг думаю, «а ну-ка посмотрим, что будет». Пишу ему абзац сеттинга, описывающий примерно то, что уже написано мной в прозаическом формате, но без особых подробностей, и говорю «накатай сценарий».

Начало «Истории из Чистилища», в отличие от моих предыдущих двух проектов нигде в Интернете опубликовано не было и никому на рецензию или даже просто на ознакомление не передавалось. GPT в принципе не мог знать, что я уже написал на эту тему.

Тем не менее, эта наглая нейросетевая морда мало того, что воспроизвела ситуацию в завязке, как в оригинале (Инквизитору приносит заявку помощник, в сеттинге об этом не было ни слова), как-то умудрилась угадать, что обращение к Инквизитору — Your Eminence, так ещё и придумала трактовку понятия «теодинамика» почти в точности, как у меня!

Сравните, вот оригинал:

«It's simple, Your Eminence. Theodynamics is a field of study concerning the ways of God».

The sheer plainness and apparent simplicity of this answer made Senior Inquisitor to think for a second before he said:

«I have never heard of such field of study. Please, explain further. Specifically, how God could be studied in the first place».

This time Afram did not smile and the undertones of his voice sounded less playful.

«As wise men of old used to say, anything can be studied if it can be observed and measured. That's the fundamental pillar of scientific method».

А вот что накропал GPT-4:

INQUISITOR: So, Mr. Afram, please tell me about this field of research you call "theodynamics." I must admit, it is a term I have never encountered before.

GOTT AFRAM: Certainly, Your Eminence. Theodynamics is a branch of science that seeks to understand the relationship between the divine and the physical universe. In simpler terms, it explores the interplay of God's will and the laws that govern our world.

INQUISITOR: (raises eyebrow) Intriguing. But how can you study something so... intangible?

GOTT AFRAM: Ah, a valid question. We utilize mathematics, physics, and other scientific methods to analyze patterns and phenomena that may reveal the workings of the divine. By understanding the universe in this way, we aim to draw closer to the essence of God's will.

Если фишку с референтом я ещё могу понять — ну это более-менее клише. То с «Your Eminence» уже понять не могу. Это традиционное обращение к кардиналам, которых, насколько мне известно, среди реальных исторических инквизиторов не было. Но это ладно, а вот с терминологией как быть? Я знаю книгу Джона Кригера, которая так называется, но там это понятие используется в совершенно другом смысле и контексте. Тогда как этот чёртов T9 на стероидах понял, что мне от него нужно? В сеттинге пояснения термина «теодинамика» не было, только название! Можно ли вообще прийти к такому выводу, не имея возможности оперировать смыслами слов? Или, как здесь, смыслами частей слов? Т.е. понимая их?

В общем, как говорили наши предки, я фигею, дорогая редакция. Тут два варианта может быть: либо я, как автор, настолько туп и предсказуем, что все мои хитрые замыслы может просчитать даже генеративный преобразователь текста, либо этот самый преобразователь более умён, чем это принято считать. Даже не знаю, что меня пугает больше.

Комментарии (57)

rezedent12

00.00.0000 00:00+18Комментарий мамкиного фалософа материалиста.

Тогда как этот чёртов T9 на стероидах понял, что мне от него нужно?

Марксисты давно говорили, что разум - это общественное явление. Ты сам будучи нейронной сетью, впитав содержимое культуры из текстовых источников создал текст.

Правильно было бы поставить вопрос не "Почему ChatGPT написал как я?" А вопрос - "Почему я пишу как ChatGPT?"

Как то однажды я думал над сюжетом который обыгрывал бы тему пост-человечности. Сформулировал кучу всего. Потом как то ища что бы посмотреть, случайно выбрал аниме "Гаргантия на зелёной планете". Аниме на мой взгляд посредственное, но все основные идеи о биологических улучшениях людей которые я сформулировал, оно достаточно прямо выражает.

В большинстве случаев идеи именно "приходят", а не производятся самостоятельно и лучше уметь отслеживать источники своих идей. Потому что может оказаться так, что на основе некой исходной идеи было произведена кучу "попсы", а потом ты из этой кучи попсы бессознательно реконструируешь исходную идею считая её своей придумкой.

Просто задумайся о том, что ты сам занимаешься преобразованием текстов по правилам похожим на те что воспроизводит ChatGPT. Ведь в чём суть нейронных сетей? Они в процессе обучения раскладывают сложную функцию на конечное количество простых. При этом никакого понимания функции не требуется, нужно лишь для каждого нейрона выполнять простой набор правил подбора коэффициентов. А с достаточной вычислительной мощью мы получим набор математических функций похожий на функции той части человеческого мозга что генерирует связные словосочетания.

farafonoff

00.00.0000 00:00+1Если продолжать в этом ключе, то "вымышленные" произведения в жанрах фентези и подобные, являются чистым результатом преобразования. С другой стороны если писать актуалочку, как это делает пелевин, то это пока что не воспроизводится в нейросетях.

Refridgerator

00.00.0000 00:00Здесь можно и без классической немецкой философии обойтись. Просто представьте обратную ситуацию — что иностранец, вооружившись словарём, будет писать книгу на русском языке про русских людей. Причём книгу художественную — то есть обязанную вызывать образы и эмоции. Даже если это будет Стивен Кинг — наверняка результат будет не особо отличаться от GPT.

rezedent12

00.00.0000 00:00Если человек что либо делает отчуждённо. То есть не хочет, ему не интересно и он просто "хреначит в продакшин" то закономерно получение от него механического результата.

Могу привести противоположные примеры, творчество Квентина Тарантино и Хирохико Араки. Они создают произведения широко используя образы и смыслы не из своих родных культур. Но поскольку подходят к процессу творчески, то даже заимствования и цитирования получаются весьма оригинальными.

Refridgerator

00.00.0000 00:00Фильмы Квентина Тарантино на английском языке про американскую культуру. А речь о противоположном — если бы вместо "Однажды в Голливуде" он бы снял "Однажды на Мосфильме" про трагедию Александр Демьяненко, который мечтал играть Шекспира, а приходилось Шурика. А в роли Шурика был бы, скажем, Хью Лори, и говорили они конечно же на ломаном русском языке.

rezedent12

00.00.0000 00:00Я полагаю что Квентин Тарантино не ограничился бы поверхностным образом России уже имеющимся в массовой культуре США, а изучил бы некоторые части русской культуры значительно глубже обывателя. И результат получился бы значительно лучше типичный "клюквы" про "злых русских". Потому что опять же есть разница в подходах творца и "криэтора". Творец хочет создать новое, криэтор - всего лишь продаваемый продукт.

Moskus

00.00.0000 00:00+8Читал ваши примеры выдуманных фактов и ждал, когда же последует простой логичный вывод из них. Так и не дождался, потому приходится его высказать за вас.

Языковые модели обладают глубоко недоразвитой способностью определять ситуацию, когда ответ невозможен. И это логично, потому что их "природа" (как результат задачи при обучении) - генерация правдоподобных текстов. И совпадение этих фактоидов с фактами - в некотором смысле, "закономерная случайность", то есть случайность, вероятность которой приведена к устойчиво высокому уровню.

Вы также пишете, что это неправильно - отождествлять человеческий разум с машиной. Но тут возможно уточнение. Неправильно - сравнивать с "правильно функционирующим" разумом, потому что это неправомерная аналогия. А вот с "неправильно функционирующим" - легко. Например, поведение патологического лжеца, который не может по каким-то своим причинам признать, что чего-то не знает, а потому начинает в таких случаях врать - очень даже можно. По крайней мере, чисто симптоматически.

vkni

00.00.0000 00:00+1Неправильно - сравнивать с "правильно функционирующим" разумом, потому

что это неправомерная аналогия. А вот с "неправильно функционирующим" -

легко.Скорее с человеческим разумом, запертым в интернете. Достаточно выйти на улицу, чтобы получить 2*4к 60fps + аудио + обонятельное и т.д. потоки информации, принципиально недоступные языковой модели.

Moskus

00.00.0000 00:00+1Переход количества и разнообразия опыта в качество (отсутствие глубоких когнитивных дефектов или значительное снижение их влияния) не продемонстрировано для ИИ.

DreamingKitten Автор

00.00.0000 00:00+1Языковые модели обладают глубоко недоразвитой способностью определять ситуацию, когда ответ невозможен. И это логично, потому что их "природа" (как результат задачи при обучении) - генерация правдоподобных текстов. И совпадение этих фактоидов с фактами - в некотором смысле, "закономерная случайность", то есть случайность, вероятность которой приведена к устойчиво высокому уровню.

Ну так... Приведена -- как? Широтой обучающей выборки ведь.

А когда ответ невозможен? Я за последние две недели задал ChatGPT несколько десятков вопросов из совершенно разных областей человеческого знания, и у неё не было никаких проблем сказать о чём-то «я не знаю». Ладно, вопрос про актёров может быть узко-специализированным и в выборке не нашлось текстов, упоминающих именно их с достаточной частотой, окей. Но на вопросы имеющие однозначный ответ она отвечает корректно почти всегда. Тем удивительнее (для меня) приведённые примеры.

Moskus

00.00.0000 00:00+2Да, приведена широтой выборки и больше ни чем. Да, "глупый человек" ведёт себя похоже, считая "общепринятый факт" автоматически правдой. Но это было бы неверно - выбирать стандартом человеческой разумности ситуацию когнитивной недостаточности.

Ответ "я не знаю" для ИИ - не то же, что для человека. Для ИИ это выражение "знания" об отсутствии факта. Это отличается от осознания этого путём анализа, как в случае человека. Ближайшая к поведению ИИ ситуация в когнитивном поведении человека - это ответ школьника "мы это не проходили".

Watashiwa

00.00.0000 00:00"Обе модели, и GPT-3.5 и GPT4 не смогли правильно указать авторство знаменитой, я бы даже сказал, мемной фразы" - это конечно очень важная деталь. Теперь я знаю что существует еще одна знаменитая фраза ))) Вы это серьезно? Если вы такие тесты придумываете, то даже мне стыдно за людей становится. Могу провести опрос среди "своего окружения" даю гарантию что 100% не ответят правильно и даже почти никто об этой фразе не в курсе. Да в интернете может и есть, но учтите что в выборке для обучения такой "информации" могло и не быть - ему же не кормили весь интернет.

DreamingKitten Автор

00.00.0000 00:00Во-первых, это всего лишь значит, что ваше окружение слабо пересекается с подмножеством активных геймеров. А серия о Сэме заслуженно считается классикой игростроя 2000-х, любой кто в теме хоть немного, знает об этом и, скорее всего, играл хоть в одну из частей.

Во-вторых, про Дюка Нюкема она же откуда-то знает, причём с характерными подробностями, так что нельзя сказать, что это незнакомая тема.

И нет, я не придумывал тесты специально. Это были вопросы, возникавшие спонтанно или в результате каких-то посторонних процессов и занятий. Просто запомнились некоторые неожиданные, на мой взгляд, ответы.

slamon

00.00.0000 00:00+1Только что проверил данный тест с Аффлеком и Крузом. Первый результат - галлюцинация, где в качестве фильма был предложен "Gigli" (в первый раз услышал вообще про этот фильм). Затем я указал ему, что Круз там не снимался. ChatGPT извинился, и на мою просьбу повторить ответ на вопрос выдал "неа, эти актеры вместе не снимались".

Но любопытно другое: я закрыл чат и открыл новый спустя пару минут. И задал этот же вопрос. Ответ был:

"На мой срез знаний, Бен Аффлек и Том Круз никогда не снимались вместе в одном фильме в главных ролях. Однако, возможно, они появлялись вместе на каких-то мероприятиях или съемках в качестве гостей или камео."

И вот это уже мне малость не понятно. Ведь авторы утверждали, что ChatGPT не помнит ничего извне одной беседы..

IvanPetrof

00.00.0000 00:00+3А он и не помнит. на каждую последовательность токенов оно "предсказывает" какой токен должен быть следующим. Но не прям вот чётко, а выдаёт несколько токенов(все)+вероятность(от 0 до 1) для каждого. Из этого списка тупой рандомайзер с учётом этой вероятности достаёт

из мешка следующий бочонокодин из них, который дописывается в конец предыдущей последовательности токенов и цикл повторяется, пока вероятность специального токена "стоп" не возрастёт настолько, чтобы рандомайзер его вытащил.У вас просто два диалога пошли по разным путям (так выпали "кости")

Comraddm

00.00.0000 00:00+1Я заметил такие косяки ChatGPT:

1) на вопрос о названии какого-то фильма по событиям в нем часто идет полная ахинея с несуществующим фильмом и не игравшими в нем актерами

2) на вопрос рассказать что-то о небольшом поселке в такой-то области идет полный бред о его расположении и истории вместо того, чтобы сказать, что он мало знает о нем

3) казалось бы, что может быть проще ответов об обычных научных фактах? Но нет, и тут бредятина. Например, на вопрос "какая третья по массе планета солнечной системы" - ответ Земля (нет).

Moskus

00.00.0000 00:00+1Проблема в том, что отвечая на вопрос, нужно различить собственно вопрос о факте и просьбу создать правдоподобное утверждение. В определенной ситуации это, похоже, гораздо сложнее сделать, чем в других.

Groramar

00.00.0000 00:00+1Не стоит эту сеть рассматривать как ходячую энциклопедию и сборник фактов. Но как генератор максимально правдоподобных и качественных текстов.

Который как показывает статистика довольно часто может быть полезен в очень разных сферах.

dprotopopov

00.00.0000 00:00+1Проблема в том что ей хотят заменить поисковые движки....мне и до этого не очень нравились алгоритмы suggestion....старался сам формировать запросы если надо что-то найти....а теперь вместо ответа получим галлюцинацию

Сканировать весь интернет становится все затратнее и затратнее

SPNkd

00.00.0000 00:00У меня был забавный диалог с GPT3 (GPT4 уже отвечает верно):

Question1:

у пети есть 2 яблока, у маши на 3 яблока больше, а у яны есть три апельсина. Сколько фруктов у детей

Answer1:

всего? Всего у детей 8 фруктов: 2 яблока у Пети, 5 яблок у Маши и 3 апельсина у Яны.Question2:

Почему восемь, если 2, 5 и 3 это 10??

Answer2:

2, 5 и 3 всего дают 10, но ты не можешь разделить фрукт на две части и в этом случае ты должен использовать все доступные варианты. Таким образом, у Пети 2 яблока, у Маши 5 яблок, а у Яны 3 апельсина, что в сумме даёт 8 фруктов.Далее был ещё диалог из 3-4 реплик, где я пытаюсь понять, почему я должен делить фрукты пополам, а GPT мне очень внушительно объяснял, как ребёнку - что как раз именно это делать и нельзя, и именно поэтому - 2, 5 и 3 - это 8, а не 10:)

Подозреваю, что с такими навыками GPT можно использовать для некоторых речей политиков

rumactep

00.00.0000 00:00У меня наоборот:

Я

У пети есть 2 яблока, у маши на 3 яблока больше, а у яны есть три апельсина. Сколько фруктов у детей?GPT

У троих детей всего: 2 яблока у Пети, (2+3)=5 яблок у Маши, и 3 апельсина у Яны. Всего фруктов у детей: 2+5+3=10. Таким образом, у детей 10 фруктов.Я

Посчитай эту же задачу в восьмеричной системе счисленияGPT

Хорошо, давайте посчитаем количество фруктов в восьмеричной системе счисления.

У Пети есть 2 яблока, это в восьмеричной системе будет записываться как 2.

У Маши на 3 яблока больше, то есть у неё 5 яблок. В восьмеричной системе это будет записываться как 5.

У Яны есть три апельсина. В восьмеричной системе это будет записываться как 3.

Тогда, чтобы найти общее количество фруктов в восьмеричной системе, нужно сложить числа 2, 5 и 3: 2 + 5 + 3 = 10.

Таким образом, в восьмеричной системе счисления у детей 10 фруктов.

myswordishatred

00.00.0000 00:00+3кардиналам, которых, насколько мне известно, среди реальных исторических инквизиторов не было

Только у испанцев три штуки: де Сиснерос, де Лара, де Кордоба.

victor79

00.00.0000 00:00-1Основная проблема у это GPT-X, что там все не правильно сделали.

Для примера, человек не в силах в разумные сроки прочитать терабайт текста, но тем не менее многие задачи решает умнее чем эта сетка.

Чтобы учить сетку, в ней гоняют один и тот же текст много раз, пока эти знания вградиетиваются в нее. Человеку достаточно прочитать текст один раз, что бы это понять и использовать, но у него проблема с памятью.

В общем, сетка берет количеством, и ей даже терабайтов мало. А человек учится качеством, по крайней мере относительно сеток. Значит принципы обучения у человека несколько иные, чем у нейронной сетки.

user5000

00.00.0000 00:00знания вградиетиваются в нее

Да уж, ни одна нейросетка такого слова изобрести не способна.

CaptainFlint

00.00.0000 00:00Ну, одна, как мы видим, таки изобрела. :)

Moskus

00.00.0000 00:00Где-то по этой причине, говоря о "стандарте разума", имеет смысл не брать человеческое поведение за абсолютный образец, потому что такие вот перлы, вместе с "я не знаю, как это объяснить, но это должно быть понятно каждому", типичные для людей - это не то, что мы хотим от ИИ.

Tabke

00.00.0000 00:00ChatGPT проваливает задачи, рассчитанные на наличие здравого смысла (common sense).

Hidden text

Так отвечает бесплатный ChatGPT, не знаю какая это версия, 3.5 наверное. У кого есть доступ к платной последней версии, попробуйте задать этот вопрос, что она ответит?

leventov

00.00.0000 00:00+1В чем же тут "провал" задачи? По-моему, ответ абсолютно правильный.

Tabke

00.00.0000 00:00То есть вы считаете, что сварить 50 яиц в кастрюле требует в 50 раз больше времени, чем сварить одно яйцо в кастрюле?

DreamingKitten Автор

00.00.0000 00:00+1То есть вы считаете, что сварить 50 яиц в кастрюле требует в 50 раз больше времени, чем сварить одно яйцо в кастрюле?

Не в 50, но больше. В разы больше.

Tabke

00.00.0000 00:00-1Ну вот когда нейросеть будет отвечать как вы, а не 6*50 = 300, тогда будет что обсуждать, а пока она тупит.

BlackSCORPION

00.00.0000 00:00Попробуйте изменить промпт, добавив то что понятно человеку но не машине. Добавив то что все яйца будут положены в кастрюлу одновременно )

Если их по одному варить то ГПТ прав, 5 часов надо будет стоять и варить по одному.

Tabke

00.00.0000 00:00Суть вопроса не в том чтобы получить результат, ответ на этот вопрос вам любой ребёнок даст. Суть таких вопросов понять, насколько нейросеть близка к правдоподобной эмуляции ответа человека. Пока не очень. Само-собой скоро это поменяется. Но пока не очень.

Refridgerator

00.00.0000 00:00Переформулирую задачу.

Один музыкант исполняет музыкальную пьесу за 3 минуты. Сколько времени понадобится на исполнение той же пьесы оркестру из 10 музыкантов?

SergeyMax

00.00.0000 00:00Странная переформулировка. 10 музыкантов может и исполнят пьесу за 3 минуты, но 50 яиц очевидно не влезут разом в одну кастрюлю. И у меня ощущение, что среднестатистический естественный интеллект уже проигрывает искусственному.

Refridgerator

00.00.0000 00:00-1Себя вы, видимо, к среднестатистическому естественному интеллекту не причисляете? В задаче ничего не было сказано ни про размеры яиц, ни про размеры кастрюли, ни про внешние условия для поддержания необходимого температурного режима. Даже если вариант 6 принять за неправильный, вариант 300 будет неправильным по тем же самым причинам.

Tabke

00.00.0000 00:00Ничего странного, это классические задачки на внимательность, от которых не ждут математического решения. Хороший способ проверить, насколько хорошо нейросеть понимает, что такое здравый смысл.

Refridgerator

00.00.0000 00:00Ну давайте лично для вас переформулирую задачу по другому:

Яйцо объёмом 150 мл варится в кастрюле объёмом 15 литров в течение 6 минут. Найти время варки 50-и яиц в этой же кастрюле, если время варки яйца обратно пропорционально объёму воды.

Теперь можно ещё раз сравнить преимущество искусственного интеллекта перед естественным. Ваш ответ?

Squoworode

00.00.0000 00:00+150 яиц очевидно не влезут разом в одну кастрюлю

Минимальный вес яйца куриного столовое высшей категории - 75 г. Средняя удельная плотность яйца - 1,09 г/см3, отсюда его объём - 69 см3.

Примем, что форма яйца - эллипсоид вращения. Отношение объёма параллелепипеда, описанного вокруг эллипсоида, к объёму самого эллипсоида равно 6/π (8abc/((4/3)πabc), где a, b, с - радиусы эллипсоида и половина длины ребер параллелепипеда), соответственно, объём параллелепипеда, описанного вокруг яйца СВ - примерно 131 см3.

Следовательно, максимально неудобная, квадратно-гнездовая укладка 50 геометрически правильных куриных яиц высшего сорта в кастрюлю займёт примерно 6570 см3 или 6,57 л. Кажется, мы вполне сможем найти не одну такую кастрюлю.

BlackSCORPION

00.00.0000 00:00В столовых можно найти кастрюлю в которых можно сварить корову целиком )

Они есть но в торговом центре не купишь, надо в гугле искать поставщиков.

SergeyMax

00.00.0000 00:00воспроизвела ситуацию в завязке, как в оригинале (Инквизитору приносит заявку помощник, в сеттинге об этом не было ни слова), как-то умудрилась угадать, что обращение к Инквизитору — Your Eminence, так ещё и придумала трактовку понятия «теодинамика» почти в точности, как у меня

Ну и кто из вас преобразователь текста?)

Vsevo10d

00.00.0000 00:00Начали за здравие, а закончили за упокой, вот серьезно.

В стороне стояла большая группа людей, мужчин и женщин, молодых и старых, но они не разговаривали между собой. На земле валялось множество игральных костей, на каждой грани стояли буквы. Люди снова и снова бросали кости и подолгу всматривались в то, что выпало.

— Что они делают? — прошептал Бастиан. — Что это за игра?

— Игра в любое, — ответил Аргакс. Он помахал играющим рукой и крикнул: — Молодцы! Давайте дальше! Не прекращайте!

Потом он повернулся к Бастиану:

— Они больше ничего не могут рассказать. Они лишились языка. Поэтому я придумал для них эту игру. Подумай только, ведь все истории на свете состоят всего из тридцати двух букв, которые просто меняют свой порядок. Из этих букв получаются слова, из слов фразы, потом главы, а из глав целые истории. Посмотри, что там у них выпало?

Бастиан подошёл и прочитал:

т и в п р н л д ж б ю ё

ь т м у ц ф х о б в

в п ш я ц д э в у ц ь а

— Да, — хихикнул Аргакс, — так всегда и получается. Но если играть очень долго, годами, можно случайно получить слова. Не особенно богатые смыслом, но всё же. «Шпинатные морщины», например, или «щёточная колбаса», или «воротниковый сок». А если играть тысячи лет, сто тысяч лет, то однажды случайно выпадет целая история. Или стихотворение. А если играть вечно, то выпадут все мыслимые истории и даже та, которую мы сейчас разыгрываем между собой. Логично, не так ли?

— Это ужасно, — сказал Бастиан.

— О, это ещё как посмотреть. Видишь ли, эти игроки хоть чем-то заняты. А иначе что им всем делать?

Все, что делает эта программа - довольно быстро выдает нечто более похожее на осмысленный ответ, чем описанный выше в детской классике генератор случайных букв. Восхищаться какому-то ответу, в котором вы сами нашли смысл - ну это как радоваться красиво зашедшему в корзину трехочковому. Вы же не будете хвалить лично мяч за точный отскок от щита и красивый оборот по обручу корзины?

Знаете, как определяют шизофреников? Им говорят какие-нибудь осмысленные и бессмысленные наборы слов, типа: гаечный ключ - дрель - отвертка; молоток - береза - пишущая машинка. Нормальный человек скажет, что первое инструменты, а между вторыми нет очевидной связи. А шизофреник скажет что-нибудь типа, что рукоятка молотка может быть сделана из березы, а еще клавиши пишущей машинки белые с черными символами, как и березовый ствол, а еще в пишущей машинке печатают маленькие молоточки. Вот также и ChatGPT. Это генеративная модель, обученная на корпусе текстов. Спросите у нее про течение болезни Альцгеймера - и она ответит во всех подробностях про деменцию, шкалу MCI и нейроны зубчатой извилины, поскольку есть килотонны актуальной и общедоступной литературы по теме, в том числе и научной. Спросите у нее про сюжет повести Сиприана Эквензи "Когда горит трава" - и она будет пыжиться, как шизофреник, отчаянно пытаясь найти смысловые связи с книгой, известной в свое время, но вряд ли оцифрованной и оставшейся лишь в библиотеках, изобретая сюжет заново по приблизительным ориентирам. Вам же ее изобрели, чтобы она давала ответы, а не говорила "не знаю".

Krey

00.00.0000 00:00А с чего бы от нейронки ожидать большего?! Интернет это большая помойка, а, как известно, мусор на входе - мусор на выходе. Все чего можно было ожидать, это формально связанные тексты, правильное употребление понятий и смыслов. Это и произошло. Правду и достоверность никто туда не закладывал, можно ожидать их лишь с какой то вероятностью.

flancer

Согласен. Нельзя наделять преобразователь текстов умом. Это ведь тоже человеческое качество. Попробуйте ещё пару раз прогнать тот же самый запрос и сравните результаты. Уверен, что они не совпадут. Выберите тот, который вас пугает менее всего.