Давайте сразу определимся — это не "обычное" сравнение видеокарт из топа 2023. Я не буду вам рассказывать про самую дорогую видеокарту RTX 4090 и её противостояние с RX 7900. Это было бы банально. Как и любое другое сравнение видеокарт на ютубе, IXBT, TechnicalCity. собственно предварительное сравнение видеокарт и рейтинг видеокарт я смотрю там. Очень удобный сервис, чтобы быстро прикинуть "на глаз", по технологиям, портам, и примерной производительности.

Объективно, Steam нам говорит, что лучшая видеокарта Nvidia Geforce RTX 3060. Потом идет RTX 2060. Почему?

Все просто:

Дешево.

Лучи.

DLSS.

?…

PROFIT.

На крайний случай Geforce GTX 1060 — желательно 6 гиговая. А на Radeon судя по данным стим, вообще никто не играет… видимо только майнят!

Но не зря же, в заголовке я написал про «сборщика ведер»? А значит время переходить к введению.

О чем будет статья:

О сборке ведер из жести и мусора.

О сравнении видеокарт, найденных среди жести и мусора.

О главном разочаровании, которое удалось подержать в руках.

О неожиданных выводах, о том, какая карта самая лучшая.

И помните, это не абсолютный топ производительности. И ваше мнение может отличаться от моего…

Сборка ведер

Для начала определимся. Я не геймер. И не профессиональный сборщик. Не зарабатываю на этом деньги, иногда собираю компьютеры себе, родственникам, причем компьютеры которые решают свои задачи.

При этом, я люблю эксперименты. И вот некоторые из них:

-

Запустить Witcher 3, на GTX 560 в FHD (i5 3450), словить 3 BSOD. Перегрев. Чуть не спалить ПК. А потом догадаться заандервольтить карту, и пройти игру без каких-либо проблем в 70-74 градусах видеокарты (даже не на минималках, кстати).

Как я на самом деле андервольтил gtx 560 (шутка) Завести 7-ку на Pentium 3 и 640 MB RAM из списанных ПК, потому что других ПК в офисе нет, а таскать туда с собой ноутбук было лень.

Купить ноутбук с гибридной видеокартой от AMD (R8 M365DX). А потом сокрушаться, что они перестали её поддерживать, и выпускать новые дрова.

Обрадоваться OEMному блоку от HP. А потом удивляться, почему там блок питания несъемный, и почему туда gtx 680 не входит?

Собрать железку на P106-100, просто потому что она была паянная-чиненная, и досталась за бутылку пива? Люблю. Умею. Практикую.

И я молчу про всякую банальщину вроде собрать Xeon на DDR2, докинуть туда 12 оперативы, вкинуть карточку заглушку, и отдать любимой Тещё. А потом удивляться, почему БП не вывез Xeon процессор, и унес за собой всё.

Ну в общем шутки, шутками, а большая часть собранных компьютеров — реальные вёдра. Но они работают, задачи выполняют, и обошлись сильно дешевле чем любое имеющееся на момент сборки решение.

Но вдруг…

В общем… Не вдаваясь в подробности, понадобилось новое «Ведро». Да такое, чтобы и в игры поиграть (на около минимальных в FHD, но так чтобы не только игры прошлого, но и будущего). И денег не сильно много стоило, и простояло достаточно долго.

И первое, во что уперся — видеокарта… Казалось бы очевидный ответ «бушная geforce gtx 1060». Да, такая карта обошлась бы дешево… НО:

Ей много лет.

Много вариантов после майнинга.

Кушает много электричества.

Не в каждый корпус влезет.

А самое главное у неё нет DLSS. Т.е. да, вариант хороший. Но для нового ведра, не хотелось.

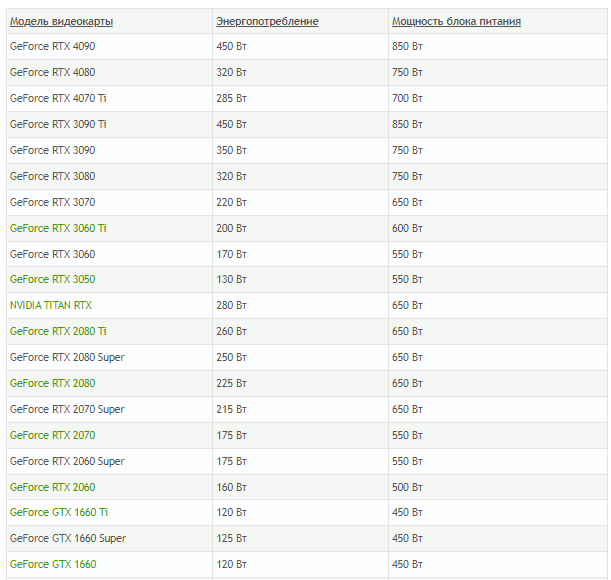

По той же причине отпали и карты 30-й серии. Для «ведра» дорого. Да и почему-то, более новые ПЕЧи кушают ещё больше электричества, хотя казалось бы «техпроцесс-прогресс-все-дела».

В общем, раз самый очевидный вариант не подходит — время заняться сравнением видеокарт, и подбором лучшей исходя из потребностей.

Критерии лучшей видеокарты по мнению сборщика ведер!

Критерии для кандидата на роль лучшей видеокарты в ведре были следующие:

Недорого стоит.

Относительно новая.

Запускает все, что вышло и выйдет в ближайший год-два, на минималках или чуть выше, без риска угореть. (FHD)

Малое энергопотребление. Чтобы не тратить деньги на блок питания.

Так, чтобы влезла в маленький корпус без нормального охлаждения…

И… Звра… Ще… НЕц… скажете вы. И будете правы. Но железку хочется. Хочется. На БП/Мать/проц тратиться не хочется? Не хочется.

Ну в общем, время было брать в руки кружку кофе. На одном мониторе открывать Technical city. На втором. Доску объявлений. А на третьем… Ах стоп… нет у меня третьего монитора. В общем, а на оставшееся смотреть реальные тесты и обзоры.

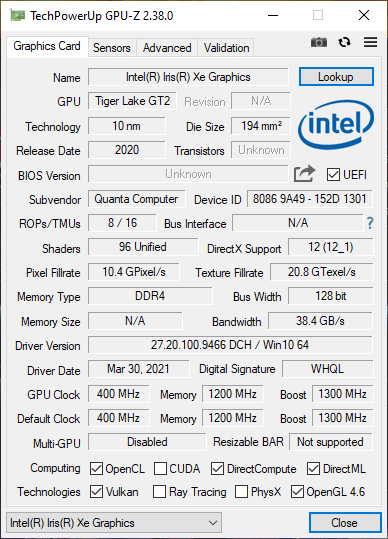

Кандидат №1: Самый очевидный… Iris XE Graphics

Казалось бы, встройка от Интела. Просто идеальный вариант. Слегка не дотягивает по производительности до того, что хотелось. Но я себе думал, что ведь у меня есть хорошая база игр выходящих вплоть до 2018-го года, а уж их то Iris XE должен потянуть.

С другой стороны. Это встройка. А значит можем смело экономить на блоке питания. И даже попытаться ужаться в 350-400 Ватт. Ещё и с процессором задумываться не нужно.

Я просмотрел тесты. Всё. Нужно брать. А потом вспомнил, что:

у встройки будет один разъем. Дай Бог, тот.

для встройки нужна хорошая память.

Хорошие процессоры c Iris XE, стоят как три старых "Рязани".

А ещё встройки любят гореть...

И при этом, все равно недобор с производительностью. Ведь это не дискретная видеокарта.

Хотя признаться честно, я в целом был приятно удивлен мощностью современных встроек. Технически, если нужно собрать компьютер, а видеокарту докупать потом. Вполне достойное решение.

Но всё-же, Iris я оставил как запасной вариант, и продолжил поиски.

Конечно, всегда можно взять блок питания помощней, и поставить на него какой-нибудь GTX780 за 10 копеек, и закрыть вопрос. Но хотелось что-нибудь, тихое, холодное и производительное.

Кандидат №2: Казалось бы, вот она Radeon RX 6400

Закончив со встройками от Intel, я решил обратить внимание на Radeon, но не на AMD Radeon R7, а на самое свежее и бюджетное среди игровых, и игровое среди бюджетных решение. Честно говоря, с детства питаю необъяснимую неприязнь к «красным», а ноутбук с «R8» на борту, только усиливает её.

Да, визуально все было хорошо. Все тесты. Не нужно доп питания. Низкий профиль. 150 долларов новая. 4 гигабайта. Но только она раскрывается исключительно в PCIe 4.0. А мы, напоминаю, собираем… Ведро!

Дешевых матерей на Pcie 4.0. ещё поискать. А ещё крайне смущают «6нм» при довольно высоком энергопотреблении (как для такого низкого техпроцесса).

А ещё порезанная шина памяти. А ещё цена. На БУ рынке этой карты нет. А новая такая стоит порядка $250-280 (да, я знаю, что рекомендованная цена у неё 150, но факт есть факт)

В общем. Карточка, действительно неплохая. Она может посоревноваться с GTX 1650. И даже в каких-то вещах её обойти. НО!

У неё есть одна большая проблема. Для максимального раскрытия, она требует к себе хорошего остального железа. А в этом случае, ну уж лучше пересидеть на IRIS XE, и уже потом докупить что-то классом по выше.

В общем, как вы поняли… Всеми фибрами души я сопротивлялся базовому решению от AMD, и искал что-то… что-то дешевле, сопоставимое по мощности, более энергоэффективное. И все ещё помним про запас на будущее.

И вот я понял. Мне нужна RTX 2050. Карточка, пускай с не самой высокой производительностью, но зато тензорные ядра и DLSS позволят продлить ей жизнь надолго. Но оказалась одна маленькая проблема. RTX 2050 — не существует!

Кандидат №3: Победа… но есть нюанс

Итак, вот она рыба моей мечты, видеокарта, которая просто идеально подходит под все мои задачи…

Просьба прерваться для небольшого дисклеймера. В момент, когда я смотрел обзоры, характеристики и примеривался к этой видеокарточке, мной руководило следующее заблуждение. Если Карточка, на архитектуре TU106, поддерживает RTX и DLSS, то почему, карточка на архитектуре TU117, не должна его поддерживать? Да, внимательность не мой конек.

Итак, представьте…

40 ватт. Против 75 у большинства видеокарт.

128 бит шина памяти.

4GB GDDR6.

Пропускная способность в 160.0 гб/с.

12 Нм технический процесс.

Середина 2021-го года выпуска. Но при этом БУ рынок переполнен ею, за цену сильно дешевле рекомендованной.

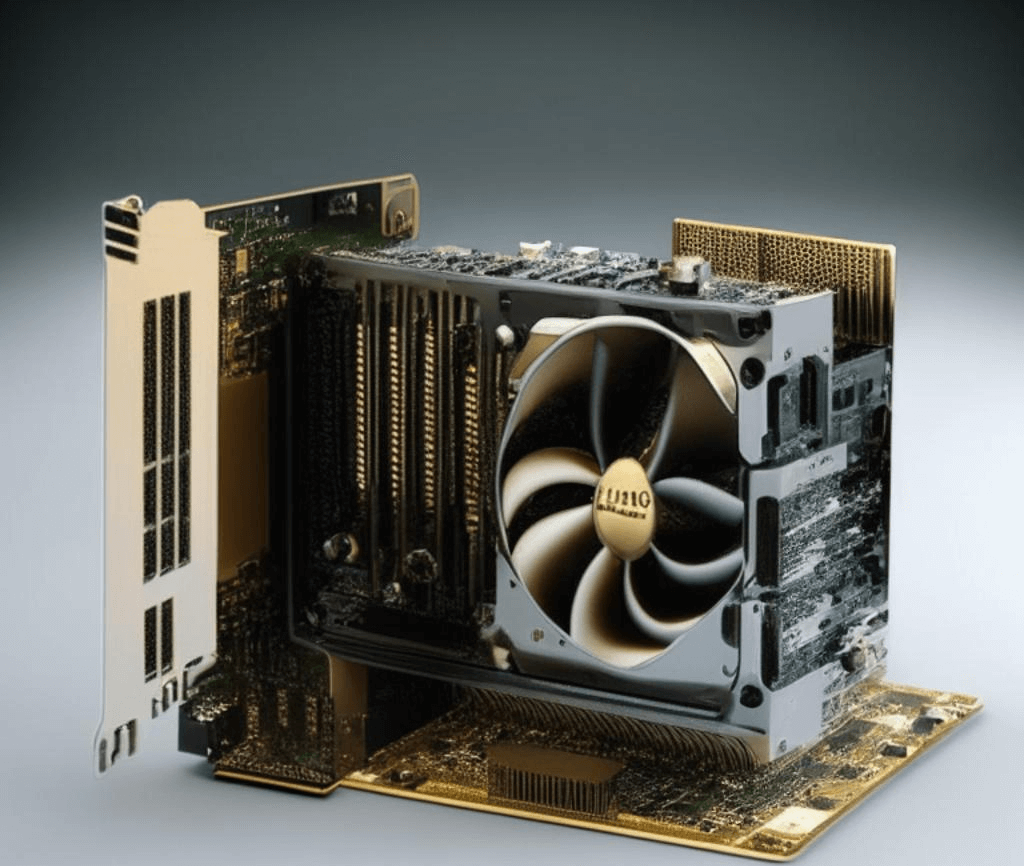

Низкопрофильная. Маленькая. Аккуратная. Разве это карта? Это мечта! Естественно речь пойдет о T600…

А ведь, я дурак, думал, что она ещё и в DLSS с лучами умеет. И это при том, что меня ну ни капли не смутило отсутствие тензорных ядер в спецификациях.

Nvidia они такие. Умельцы с бубном прикручивали к старым видеокартам RTX voice. Так, почему бы T600 не уметь в DLSS?

А ведь именно DLSS это тот параметр, который способен максимально продлить жизнь видеокарте, особенно если вы готовы мириться с какими-то компромиссами в графике, за возможность поиграть в свежие игры на ведре!

Кстати, а по мощности, она не сильно уступает той же RX 6400. В общем, даже несмотря на последующее разочарование с отсутствием DLSS (которое в играх то есть, но на фпс не влияет), мы получаем хорошую карту за вменяемые деньги.

Решаем проблему с DLSS

Ну что, приехала карточка. Распаковал. Установил. Запустил. Обрадовался. Немного огорчили температуры в стрессах (примерно такие же как у geforce gtx 1050 ti), но ничего. Андервольтинг ещё никто не отменял (в разумных пределах).

Запускаю я Cyberpunk. Радостно щелкаю на DLSS. Смотрю на ФПС… И ничего не поменялось.

Ну дальше думаю не стоит объяснять. Полез, сообразил что нет тензорных ядер. И подумал, а не лучшим ли вариантом был все тот же RX 6400?

Но потом сравнил цену на видеокарту. Сравнил теплопакет. Прикинул производительность, и вспомнил о волшебном FSR 2.0.

Но ведь FSR мылит. И вообще он не айс. А ещё не всеми играми поддерживается, в отличие от DLSS. Да и посадить его можно на любую карту начиная с 10-ой серии ПЕЧей.

Ну, здесь все предельно просто. Берем DLSS Unlocker (который на самом деле, отнюдь не DLSS, он просто позволяет использовать те технологии, которые NVidia использует для обсчитывания векторов в движении), и при помощи такой маленькой утилитки, подключаем FSR 2.0. там, где его нативно нет.

Профит? Профит!

На что ещё обратить внимание

Все это хорошо, и покупал я видеокарту БУ. Но если вы по какой-то причине, захотите собрать игровое ведро и купить видеокарту T600, помните о следующих вещах:

Они отличаются по заглушкам. Есть заглушки для тонких ПК, есть для полноценных. Мелочь, но если не угадали, или не спросили у продавца, придется побегать за заглушкой.

Сама карта оснащена только miniDisplay портами. Есть магазинные версии с переходниками. Есть без. Будьте внимательны. Порт на стороне может обойтись в дополнительные $5-10, что несколько нивелирует низкую стоимость T600.

Не все переходники работают с 144hz мониторами. Странная претензия, но держите в голове.

-

Видеокарта, не хочет заводится с материнскими платами Asus. Тестировал на B560+. Ни в какую. Только при переключении BIOS на Legacy режим.

Просто изображение "спасительного" переходника. Вообще их море. они разные. Нужно искать про 144 HZ.

Если хотите выжать из карты максимум. Придётся колхозить дополнительное охлаждение. Обычного направленного вентилятора хватит. Все дело, в крайне неудачной системе с кулером, который гонит весь теплый воздух не туда, куда нужно…

На что в итоге посадил видеокарту?

С видеокартой разобрались. Помним, что собираем ведро. Так в итоге на что я посадил её?

Посадил я её в итоге на HP ProDesk 600 G3 TWR. Да, да на очередную OEM железку. Почему? Потому что мощности 4-х ядерных процессоров до сих пор хватает для запуска современных игр (пускай и на минималках). А OEM компьютеры на БУ рынке, традиционно стоят ну «неприлично дешево»

В итоге получилась крайне занимательная железка с:

I7-7700 на борту.

16 RAM ddr-4 (доставлял свою).

БП на 320 Ватт (это потолок, того что дают HP Prodesk. Обычно вообще 250 ватт).

Nvidia T600 (4GB).

Да, я собрал очередное ведро. Которое при этом уместилось в 300 Ватт. И при этом его вполне можно использовать для FHD гейминга.

T600 выбирался, как карточка, которая умеет в FSR (хотя я и надеялся на DLSS). А учитывая что при помощи всяких DLSS unlockеров, можно FSR прикрутить и там, где его официально нет, а главное — это не видеокарта для майнинга!

В итоге мы получили

Лучшую видеокарту 2023 года. Энергоэффективная. Достаточно производительная. Подойдет не только для игр, но и для работы. И вы можете не бояться брать её на БУ рынке. А учитывая, что у нас кажись, приближается новый Майнинг бум — это довольно хорошее преимущество!

Эта карта мощней «привычных» затычек. И за свои 40 ватт, обеспечивает достаточную производительность. Разве это не делает её идеальной?

Конечно, можно бросать в меня тапки, и говорить, что и процессор можно было бы i3 последнего поколения взять. И на Ryzen посмотреть какой-нибудь 5 1600. И возможно, вы даже знаете лучшую видеокарту (вон тот-же Rx 6400, вообще не хуже).

Но я всего лишь «собиратель вёдер из жести», и это решение оказалось достаточным для запуска всех современных игр. И самым дешевым из возможных. При этом я уверен, что карта не была в майнинге, что она не отвалится от старости, и что при желании, я могу её вставить в любой, даже очень тонкий ОЕМный корпус.

П.С. возможно, кого-то расстроило отсутствие тестов лоб-в-лоб. Ну так, из всех трех карточек (включая встройку) в руках я подержал только t600. А посмотреть на её производительность можно и в YouTube. И на TechnicalCity (сервис по сравнению видеокарт онлайн). И даже на IXBT. Там подробно. На 20 страниц, с тестами, скриншотами. Да и я когда её выбирал, руководствовался именно общедоступными материалами. Они будут лучше, чем мой пересказ, или скрины с ФПСами.

Комментарии (62)

valera5505

20.04.2023 17:08+1Энергоэффективность это не "меньше всего ватт", а "больше всего производительность на ватт". И в этом смысле Ada Lovelace сейчас вне конкуренции. Особенно если андервольтить. Поэтому очень странно, что в посте так упорно считают ватты, не обращая внимание ни на производительность, которая идет с ними в паре, ни на возможность потребление видеокарты ограничивать.

chirwa4 Автор

20.04.2023 17:08+3не поспоришь, Ada, безусловно вне конкуренции по производительности на Ватт. Но с точки зрения ведростроения, она находится в несколько другой весовой, то есть ценовой категории. Да и максимальное раскрытие у неё с Pcie 4.0. А если вы про сам опрос? то шутки ради, там нет видеокарты с потреблением меньше 300 Ватт, иронично для обзора про карту с потреблением около 40.

valera5505

20.04.2023 17:08Да и максимальное раскрытие у неё с Pcie 4.0

На просторах того же ютуба предостаточно сравнений, что даже у жирнейших топов сейчас в очень редких случаях фпс в играх как-то отличается от PCIe 3.0 x16.

А если вы про сам опрос?

По большей части про него, да. Мне странно видеть людей, которые в опросе за эффективность выбирают 3090 Ti вместо 4090. Она и в абсолютных числах кушает ощутимо больше, и при этом производительность у нее сильно меньше. Про остальные варианты в опросе даже говорить не хочется.

chirwa4 Автор

20.04.2023 17:08+1ну, я ж говорил, что опрос был скорей ироничный, чем полноценный. Самые прожорливые карты, они и есть самые прожорливые. Единственное что в опрос я решил не помещать совсем уж динозавров с "550+ ватт потребления" больше из-за их старости.

А по поводу Ada, если попадётся такая в руки в ближайшие месяцы, нужно будет обязательно её протестировать. Хотя мое ИМХО, что такие мощные карточки в OEMный i7 7700, не самое лучшее решение. процессор может стать бутылочным горлышком.

Да и цены пока на аду кусаются, я просмотрел, ближайшее что я видел это $300. за RTX 4000. T600-ая, за счет того, что её многие ставят как заглушку, а потом не знают куда девать, когда берут "производительную карту" обходится сильно дешевле...В общем, спасибо за совет. Обязательно обращу внимание на эту видеокарту, возможно, следующее "ведро", буду собирать уже на нем. Хотя такое "ведро" будет больше уже похоже на "истребитель"

CodARM

20.04.2023 17:08Поделюсь своим Геймирским опытом, i5 4670+RX480X@8gb, упор был в видеокарту, на 4770к+1070(купил за 9к), упор был в видеокарту, в прошедшем ноябре я сменил 4770к на 13600к, и в декабре приобрел 3070(бу из топовой серии, спасибо майнерам за это), сейчас упор опять в видеркарту, точнее в видеопамять... Но это при условии 60FPS. Так что 7700 вполне себе потянет современные игры со всеми технологиями. Для вашего 7700 могу рекомендовать 3060 c 12 гигами VRAM и напихать в HP 32GB ОЗУ, такого пресета хватить для вполне себе хорошего опыта еще лет на 5...

...или на 10, если вам сейчас норм с Т600

valera5505

20.04.2023 17:08К слову про PCIe 4.0 — это куда более применимо для RX6400 с ее PCIe 4.0 x4 интерфейсом. Вот где действительно без 4.0 видеокарта будет чувствовать себя нехорошо (что, опять же, подтверждается тестами).

chirwa4 Автор

20.04.2023 17:08ну об этом я собственно в статье и писал, почему и склонился в итоге к t600.

vvs013

20.04.2023 17:08На Guru3D сегодня прочёл обзор, где в таблице "лучше на ватт" 7900XT лучше всех остальных. И как бы, на первый взгляд, этому есть объяснение если посмотреть на "железо" этой карты.

P.S. Обзор по 7900XTX, если кто полезет проверять. :)

valera5505

20.04.2023 17:08+1Стандартизованному тесту TechPowerUp больше доверия

vvs013

20.04.2023 17:08Наоборот, доверие тут сомнительно лично для меня. TechPowerUp славился однобоким пропагандистским подходом во многих обзорах.

P.S. Вообще, на Гуру часто стараются залезть поглубже в изучении вопроса. И то что FRAPS меряет коня в вакууме, им известно. :)

NikaLapka

20.04.2023 17:08+10Игровая карта в 2023 это RTX 3060 и выше. Аналог от компании AMD это RX 6600 и выше.

RTX 3060 получилась очень хорошей игровой картой и останется таковой ещё на год-два.

Если Вы можете купить и покупаете видео карту лучше, это замечательно.

Если Вы в 2023 году называете GTX 1060, 980..Intel - игровой картой, покупаете таковые карты с Авито - то это несколько иная категория, жизненный опыт, про который некоторые не хотят вспоминать, как про "гаражи и автоваз".

От сборщика вёдер в 2023 году ждёшь статью "Как мы купили 30 штук 3060 на Озоне за 480 тыс руб и что из этого получилось?!", а не фотографии пыльных ПК.

chirwa4 Автор

20.04.2023 17:08+2Спасибо за ваше мнение. Если прям быть откровенным, то в 2023-ем, я бы брал все-таки RTX 3070, собственно одна такая машинка есть, но она довольно скучная, и писать про неё ничего веселого нельзя. с "красными" мне все не везет, ничего хорошего о них сказать не могу. В последнее время ничего плохого тоже.

— Всегда хорошо, когда есть возможность купить видеокарту лучше) Но не всегда есть такая возможность. Да и иногда нужен "походный компьютер в съемную квартиру", а таскать с собой "основную железку" просто жалко...

— лучшей видеокартой в 2023-ем году 1060, называю не я, а стим) Я 1060-х сейчас боюсь как огня. Они старые, и многие из них майненные. Иначе бы я в ОЕМку, её бы положил, и не заморачивался вопросом (получив ещё один скучный компьютер).

— ну, 30 штук rtx 3060, это не от сборщика ведер, это от сборщика истребителей) я максимум 30 штук p-106 с алика могу собрать... и то не факт, что живых...

csharpreader

20.04.2023 17:08+9жизненный опыт, про который некоторые не хотят вспоминать, как про "гаражи и автоваз"

А вы, видимо, до сих пор не уловили, что мы в этот опыт заново проваливаемся.

Areso

20.04.2023 17:08+5Если покупать игры с пятилетним лагом, то 1060 и 980 в принципе норм. Тут тебе и скидки 80-90%, и все аддоны со скидками, и производительность с релиза подправили (если подправили, ну а если нет - то для пятилетней игры на FHD 1066 должно всё равно хватать, пусть и не на максималках),а еще можно урвать что-то на HumbleBundle за 1 американский доллар, что очень круто :)

avacha

20.04.2023 17:08+13060 по производительности равна 1080 Ti. Так что старичков я бы не стал сбрасывать со счетов. 11 Гб памяти и шина в полтора раза шире, плюс не требует последних версий PCi-E для полноценного "раскрытия", что также немаловажно.

Мне вот другой вопрос интересен - никак не могу найти что-нибудь низкопрофильное из зеленых мощнее 1050 Ti, которая уже несколько подустарела даже для HTPC (эмуляторы нинтендо уже не тянет, а ребенок хочет Crash Team Racing). Был один вариант от красных, на 20 процентов мощнее кое-где, кое-где - хуже - судя по описанным тестам в интернетах, но к красным у меня историческая нелюбовь из-за травматических флешбеков, связанных с качеством драйверов.

SunUp

20.04.2023 17:081650 (обычная, не super) есть довольно много низкопрофильных моделей. В версии с ddr6 памятью она будет примерно на 15-20% быстрее 1050 Ti.

virtanen

20.04.2023 17:08Всё бы хорошо, но у 1080 нет лучиков, а значит она априори не подходит для современных игр

Tarakanator

20.04.2023 17:08+3у моей 3080 ti есть лучики, и что? я всё равно ни в одну игру с включенными лучами не играл т.к. FPS проседает до некомфортного.

vtal007

20.04.2023 17:08+1у 1080ти не будет длсс

для нейронок, я полагаю, тоже 3060 будет поактуальней

Tarakanator

20.04.2023 17:08+13060 по производительности равна 1080 Ti.

1)последние PCI-e вроде не так уж важны для 3060

2)у 1080 ti нет DLSS. А для нижней границе игровых видеокарт это важно.

3)у 1080 ti нет hdmi 2.1 Не видать вам дешёвых 120гц 4к телеков с бесплатным g-sync (HDMI VRR)

avacha

20.04.2023 17:08По поводу dlss - согласен. 120гц - это для игр типа шутеров больше актуально, я честно говоря, разницу с 75гц стандартными не особо ощущаю. И 120гц@4к - это, если по-честному, без уплавнялок, 120fps - что-то мне кажется, что 3060 немного не этого уровня карта. Да и телек подключать не всем надо.

По поводу синхронизации - есть в мониторах такая штука, как Adaptive Sync. Это независимая от вендоров универсальная технология, разработанная инженерами VESA. Стала стандартом в DisplayPort 1.2 (сейчас уже Display Port 1.4). У 1080ti имеются DisplayPort

Tarakanator

20.04.2023 17:08Прелесть 120 ну не только в честных 120 гц для шутеров, но и в том что происходит при падении ФПС. Вот не осилил твой комп нативную частоту кадров монитора. Что будет? В случае с 60 ФПС у тебя просядет до 30, а в случае 120 только до 60. И даже если 60 не вытянет, то просадка станет до 40, а не 30.

Теоретически проблему на 60гц решают всякие фрисинки, но по факту там слишком много подводных камней.

1)дешёвые экраны синхронизируют при 48+ гц. И если диапазон 48-120 нормальный, то 48-60 уже ниочем.

2) бывают игры в которых довольно часто случаются микрофризы, независимо от железа, в таких случаях фрисинк лучше отрубать

3)с адаптив синк это переименованный фрисинк. Со стандартизацией там не очень.скорее всего все будет ок, но на проблемы наткнуться можно. В случае покупки дорогого монитора будет обидно. А вот vrr hdmi как раз изначально вендор независимый.

Надо подключать не телек, а большой монитор. Но телек при этом оказывается дешевле. Да там есть свои нюансы, но в целом имхо телевизоры дешевле. Надо только найти модель без критичных недостатков для использования в качестве монитора.

palmin90

20.04.2023 17:08Rtx 2050, это было очень смешно.

chirwa4 Автор

20.04.2023 17:08Но ведь она идеальна. Лучи. Экономность. Производительность. DLSS в конце концов. Жаль не существует (мобильная версия не в счет)

DGN

20.04.2023 17:08Может потскать у китайцев, они делали десктопные платы на ноутбучны камнях, на 3060 точно была карта - дешевая и холодная.

chirwa4 Автор

20.04.2023 17:08Есть у кого-то опыт? Чтоб кирпич вместо карты не приехал, или при запуске не окирпичилось? Буду рад ознакомиться.

Taros

20.04.2023 17:08На Али покупал, все ок. Даже часть суммы вернул, по итогу купил нормальную видеокарту за пол цены.

chirwa4 Автор

20.04.2023 17:08вы подали отличную идею для следующего "ведра". Осталось только придумать куда его воткнуть, и зачем оно мне, когда уже поставил t600. Но возможно будет отличный материал для анализа DLSS на RTX 2050M

molnij

20.04.2023 17:08Учитывая, какие лучи у её старших реальных собратьев (2060 да и обычная 2070), они бы там были только для галочки. Производительностью, имхо, это тоже сложно было бы назвать… Экономность и DLSS — это да, её сильные стороны перед альтернативами. Да и кстати к dlss тоже вопросы, вытянули ли бы оставшиеся после урезания блоки его, есть мысль, что именно поэтому младшими в 20 серии стали 1650\1660

chirwa4 Автор

20.04.2023 17:08Ну, поверхностное гугление дало два видеоролика. В одном god of war с dlss quality FHD — в среднем дал 58 кадров. В другом, был rtx 2050m без dlss на вступительной заставке (с бревном) в среднем 45 кадров. Но опять же, кто сказал, что она через 15-20 минут греться не начнет, и троттлить. на глазок какие-то кадры дает dlss там. вроде как четверть производительности. Но стоит ли доверять двум отрезкам по минуте с разных каналов?)

AllexIn

20.04.2023 17:08Новый бум майнинга? Откуда такая информация?

chirwa4 Автор

20.04.2023 17:08+2Я бы не назвал её аксиоматичной, да и в статье указал что "кажись". просто помимо роста цен (о чем говорит ABy), заметил повышение спроса на Asic у "знакомых в магазине" (не хочу рекламировать). Рост цен на видеокарты. Рост спроса на Asic. Я на 100 процентов утверждать не буду (иначе сам бы первый побежал бы и скупил все, до чего мог дотянуться), но паттерн довольно занимательный... Ну и там что-то про дефицит полупроводников слышал (но от этого я относительно далек, поэтому это так, профанации)...

Скажем так, бюджетные видеокарты дешеветь не собираются... И на случай, если они подорожают, у нас есть такие решения, на которые большинство не обращает внимание (кто в здравом уме для игр quadro в приоритет на покупку поставит?)

iddqda

20.04.2023 17:08не претендую на экспертное мнение, но мне кажется бума майнинга ждать уже не стоит

биток уже очень давно на асиках майнится

а на видеокартах большая часть майнила эфир который еще в августе переехал с Pow на PoS и майнить его стало бессмысленно

остальные PoW монеты в большинстве своем шиткойны

короче насчет бума я сильно сомневаюсьз.ы. на замену своей 1060 я лично жду 4060, но не уверен что куплю ее а не PS5

ABy

20.04.2023 17:08+1Каково мнение сообщества по поводу текущих цен на видеокарты? Осенью ждали если не обвала цен, то серьезного снижения. Тогда были все предпосылки: окончание бума майнинга, выход нового поколения видеокарт, восстановление производства после ковида. Были новости что nvidia не знает куда девать чипы и забивает ими склады. С тех пор цены не упали, если даже не выросли (и я сейчас про рынок США говорю). Неужели все карты скупает условная OpenAI?

avacha

20.04.2023 17:08+2Ну интеловские карты подешевели, сейчас за 12-13 можно взять A380 с 6гб, раньше была под 20. Правда, я бы не стал - это аналог 1650 Ti в лучшем случае, и по производительности проигрывает даже 1060 с 6гб, коих сейчас навалом на вторичке за символические деньги.

Stawros

20.04.2023 17:08+1Купил год назад себе китайскую 3070m c алиэкспресс.

Hidden text

256 бит шина памяти.

8GB GDDR6.

8 нм технический процесс.

RTX ядра

На данный момент она стоит около 24к рублей. Меня соотношение цена/производительность вполне себе устраивает - какой-нибудь ведьмак на 2к разрешении с экстремальными настройками графики ниже 60 фпс не проседает (но у меня и процессор тоже древний xeon c алиэкспресса с не самой производительной ОЗУ).

Вообще выбор был собирать либо топовый ПК, либо бесшумную времянку. Первый вариант не прокатил (жду пока релиза Zen 5, там посмотрим). А вот второй вариант получился очень даже ничего. Правда для обеспечения бесшумности у меня один кулер на ЦПУ вышел чуть не дороже материнки, 16 ядерного процессора и 32Гб ОЗУ вместе взятых.

Что по видеокартам - TDP видеокарт 4000 серии nvidia меня что-то пугает. Не готов я ставить себе в ПК что-то прожорливей 200 W.

Wolf4D

20.04.2023 17:08+1Честно говоря, 4 Гб VRAM - это уже мало, очень мало. Хоть тот же Atomic Heart всё ещё идёт на средне-высоких, но вот Hogwarts Legacy уже еле-еле тянет даже на низких. А с учётом прихода Люменов и Нанитов в нашу повседневную жизнь, в ближайшие годы прогнозируется, что даже 12 Гб VRAM станет хватать с трудом. Так что карта уже с отрицательным запасом получается :)

А встройки от Интел - это надо с осторожностью. Драйвера у них, мягко говоря, неоднородны по качеству.

chirwa4 Автор

20.04.2023 17:08Hogwarts запускал на 1060-ой, хватало с запасом, на средних без FSR (мне конкретно в хогвартсе, не понравилась мультяшность картинки на выходе). На t600-ой запускал паучка, с fsr 2.0. — 50-55. без него, запускал на высоких, чуть не дотягивал до 30-ти. А по поводу запаса, думаю волноваться не стоит. Индустрия все таки у нас пляшет под консоли. И пока условно не выйдет промежуточное поколение каких нибудь PS5PRO, t600-ая вполне себе поживет... Да думаю, вполне себе поживет, вплоть до конца поколения. а это ещё года 2-3 точно. Опять же... Если вы правы, то у нас скоро окирпичится сильно большее кол-во карт, чем этого хотелось бы. Если не секрет 4GB VRam какой у вас карточки?

Wolf4D

20.04.2023 17:08У меня ноутбучная GTX 1650, и с FSR у неё в Хогвардсе возникают лаги и фризы при установке текстур на что-то выше "низких". Возможно, правда, что это кривость самого Хогвардса или какая-то локальная несовместимость с железом...

chirwa4 Автор

20.04.2023 17:08расскажете о проблемах с дровами подробней? Присматриваюсь к ноутбуку с iris графикой, теперь после ваших слов засомневался. на радеонах я обжегся. вот на интеле не хотелось бы. Заранее спасибо

astromid

20.04.2023 17:08Может не повезти с отдельными играми. Лично у меня, например, так и не получилось поиграть на ноутбуке с i5-1135G7 (встройка Iris Xe) в World War Z - запускается, но при этом артефачит на любых настройках графики, даже с самым последним драйвером. В L4D2 возникли проблемы с освещением (на некоторых уровнях становится излишне темно, ставлю на проблему с дравером т.к. сравнивал на одинаковых настройках графики на практически идентичных ноутбуках, но в одном встройка Iris Xe, а в другом дискретка MX450, на дискретке проблем с освещением нет). При этом подавляющее большинство игр работает все-таки нормально

Wolf4D

20.04.2023 17:08+1Добавлю, что на Intel Arc весьма кривая поддержка DirectX 9. В железе её нет, она сделана в драйвере через мост D3D9on12, и работает он... ну, как повезёт. Мы с товарищами сейчас разрабатываем игру под DirectX 9 (считайте это арт-проектом) - и там есть серьёзные проблемы с поддержкой.

MountainGoat

20.04.2023 17:08+1Не вонуйтесь, мой 3070Ti тоже еле тянет Хогварц на минималках. Просто хреново сделана игра.

fire64

20.04.2023 17:08До сих пор сижу на 1050ti

Понятно, что сейчас ее уже игровой видеокартой сложно назвать, но в принципе в киберпанк или в атомное сердце вполне себе на средних играется без проблем. За топовыми игрушками с супер графикой не гонюсь.

chirwa4 Автор

20.04.2023 17:08t600 по производительности +- такая же, но поправка на драйвера, на меньшее энергопотребление, ну и честно говоря, уже страшновато ставить в компьютер карточку 6.5 летней давности, непонятно кто и как её до меня эксплуатировал. по этой же причине и не 1060, и даже не 1070.

chnav

20.04.2023 17:08+1Интересная логика - 1050ti-1060 это старые карты, которые неизвестно кем эксплуатировались, а подержаный HP - нормально, одни достоинства. Вообще все тезисы выглядят натянуто, создаётся впечатление, что автору удалось бесплатно или очень дёшево раздобыть Quadro T600 и после этого появилась идея для статьи )) Я посмотрел цены на неё б/у и заплакал (14 т.р. :eek:).

У меня есть её бабушка Quadro K1200 (*) - тот же низкий профиль, те же 4 mini-DP, те же 40W TDP. Я радовался, как ребёнок, когда она мне попалась за 2500 р. Результат ? Просто моральное удовлетворение. Mini-DP означает покупку переходников 300-500 р. (в зависимости во что переводить DP, HDVI, HDM), высокая планка это ещё +300 р. Низкий профиль автоматически означает миниатюрный вентилятор, который ревёт как самолёт 6000-7000 rpm при высоких нагрузках, а GPU всё-равно греется. Профита от низкопрофильной видюхи в обычном корпусе никакого, одни недостатки.

Фирменный корпус, низкое потребление...Как результат - БП никакой, поменять не на что ибо свой фирменный с нестандартным разъёмом на материнку. При этом есть те же фирменные компы формата MT со стандартными ATX PSU, обновить до 450 Вт = 450 р., можно выбрать с любыми разъёмами, кучей SATA на вырост. Сколько разъёмов SATA в вашем корпусе ? Полагаю что по минималке 4 штуки и без питания для видюхи.

Вот такие мысли и вопросы.

'* PS: я давно болею однослотовыми Quadro - сначала Quadro 600, потом K600, потом K1200... Но у меня была на то причина - они все однослотовые 40-45 Вт, помещались и работали в док-станции Thinkpad. Как только переехал на MT Dell Optiplex так сразу же переехал на полнопрофильную GTX 1050 OC (2.17 TFLOPS). Производительность даже выше чем у T600, температура ниже, шума меньше. Короткая, в наличии три стандартных цифровых выхода.

PPS: крайне рекомендую к ознакомлению Играем на карте для майнинга Nvidia в 2022 году, для сравнения P106-100 6 GB (TDP 120W, 4.375 TFLOPS) б/у 2500 р. !!!

chirwa4 Автор

20.04.2023 17:08Ну по поводу поддержанного HP... —ОЕМные железки, редко кто использует "на всю". Обычно если человек собирается эксплуатировать компьютер во вне штатных условиях, он и собирать будет что-то под себя. Да, в ОЕМную железку толком ничего не вставишь, но поэтому они и такие дешевые. (по крайней мере попадались сильно дешевле, чем аналогичная по мощности конфигурация). Та же ситуация и с T600. возможно повезло, взял совсем не за 14.000.

PNY Кстати порой комплектуются и переходником, и планкой на высокий профиль. Но это естественно не относится к БУ вариантам, там или "потерял" или "сломал"

Как уже многие говорили, если есть деньги. Лучше собрать что-то по лучше. Опять же, если корпус позволяет, но денег нет, то почему бы не RX-6400.

Старые видеокарты, это старые видеокарты. Верить кому-то на честное слово "не бита, не крашена, не майнена, не паяна, первый владелец", обжигался не верю. со стационарниками, со встройкой, которые ставят в основном в офисы, не обжигался. Возможно мой опыт не отражает полноты картины.

Карты для майнинга кому-то рекомендовать, очень и очень страшно. Себе поставить. Да... тихо, молча. установили, и играемся. Повезло, радуемся. Не повезло, никому не говорим, засмеют...

Ну и в конце концов, Собрал? собрал. ведро? ведро! Работает? работает... На самом деле, было бы ещё что-нибудь в этой категории энергопотребления (из свежего, низкопрофильного), тоже рассмотрел бы с большим удовольствием.

c01nd01r

20.04.2023 17:08Интересно понаблюдать за встройками у красных.

Недавно в интернетах встречал обзор, где Ryzen 9 7940HS в ноутбуке выдает 60+ fps на средне-низких на FullHD в Cyberpunk.

chirwa4 Автор

20.04.2023 17:08возможно вы скажете, что у меня предубеждения. Но красные... ещё и в ноутбуке... Это очень, очень страшно. Мне моего R8 на всю жизнь хватило, хотя "для своего времени" не самое плохое решение было по цене/качеству.

AlexM2001

20.04.2023 17:08. Не зря же весь стим сидит на Geforce RTX 3060.

Грамотно накинуть это конечно тоже способствует увеличению количества читателей статьи.)

Но самая популярная карта по статистике Steam, это GTX 3060, таковой она стала только в марте этого года .

И "весь Стеам" это 10,44%?

Чуть более 10 процентов это не весь Steam)

chirwa4 Автор

20.04.2023 17:08ну, ладно. 10,5% на rtx 3060

5% на 3060 TI

3% на rtx 3060 mobile

пятая часть стима. А те, кто не сидят на 3060, сидят на 2060, или на 1060. уговорили — половина :) но вот для меня кстати было открытием, что я не увидел ни одного ни топового, ни бюджетного решения от AMD. мне кажется, это какой-то вселенский сговор

AlexM2001

20.04.2023 17:08но вот для меня кстати было открытием, что я не увидел ни одного ни топового, ни бюджетного решения от AMD. мне кажется, это какой-то вселенский сговор

Все вместе взятые видеокарты АМД это чуть менее 11% установленных на март 2023.

Немного, но они не дают расслабляться зелёным.

Надеюсь синие также будут и далее участвовать в рынке видео карт. Троим игрокам договориться сложнее )

chirwa4 Автор

20.04.2023 17:08Ну если отбросить шутки в сторону, и всякие "интересные ведра", которые я собираю не на продажу, а просто потому что возникает такая возможность, а иногда потребность...то есть какие-то причины покупать интеловские карты, в ближайшее 1-2 поколения? Я глянул на цену. А 770-й +- с поправкой на ветер как rtx 3060.

pilimpimpilim

20.04.2023 17:08до сих пор сижу на 3dfx vodoo и в 2k просто вставил второй бп да e-gold майнит нормально - в игры не играю тк не хочу портить hercules

chirwa4 Автор

20.04.2023 17:08небось voodoo 5500 с 64 МБ, чтобы больше майнило?), в сочетании с легендарным HGC? )(20 минут пришлось гуглить что такое геркулес, сдался спросил у chatGPT) :D

pilimpimpilim

20.04.2023 17:08-1нет - первый тк их с выходом agp бесплатно раздавали ... hercules это 16 бит на цвет ... я видел 8088 и это был первый комп в классе - одноклассник как давай рефераты на матричнике печатать и хрен всем объяснишь кто у него гавно десятилетней давности

olzeykan

Не первый обзор на T600, который я вижу. Сам бы брал RX6400, она и мощней, и цены плюс минус сопоставимые, но с точки зрения, чего бы такого поставить в "предельно маленький корпус", почему бы и нет?

dom1n1k

Одна из причин брать T400/T600 — 3-4 DP, что бывает полезно для рабочего компьютера с 3 мониторами. Где на 3d-производительность плюс-минус плевать в силу специфики задач.

В игровых картах такое количество разъемов есть только в среднем и старшем сегментах, за существенно большие деньги. А младшие модели имеют в лучшем случае HDMI+DVI+DP. А некоторые даже HDMI+DVI+Dsub или просто HDMI+DVI.