Генерация контента сайтов с помощью AI может быть полезна в некоторых случаях. Однако, важно понимать, что AI-сгенерированный контент не всегда будет качественным или соответствовать потребностям вашей аудитории.

В этой статье я расскажу о своем опыте, сколько это стоит и каких можно добиться результатов.

Дисклеймер

Автор не является экспертом в генерации контента, он просто делится своим личным опытом и результатами, достигнутыми на основе своих ограниченных знаний и опыта.

Идея

Основная задача заключалась в проверке реакции поисковых систем, в частности Google, на контент, созданный с помощью AI. При этом основа и структура сайта были задуманы таким образом, чтобы быть осмысленными, узкотематическими и изначально полезными, а генерируемый контент использовался для дополнительного наполнения сайта.

Для упрощения технической части, я взял один из своих прошлых проектов, который был заброшен.

Несколько лет назад я начал работу над этим проектом, но из-за пандемии COVID-19 мои планы были нарушены, и проект остался в начальной стадии разработки. Я использовал основной код и шаблоны из этого проекта — и это заметно визуально.

Первый блин

Первоначально было необходимо понять, как создавать уникальный контент и как использовать генерированный контент, чтобы получить полезный результат — по крайней мере, в глазах Google.

Как настоящий мечтатель, я начал с выбора забавного доменного имени и выбора направления для будущего сайта. Сначала я решил создать каталог для Тихоокеанского Северо-Запада (англ. Pacific Northwest). Однако возник вопрос: каталог чего? Моя первая идея была создать каталог салонов красоты, но я недооценил их количество и доступность информации об них. В конечном итоге, я решил создать каталог школ, где обучают специалистов в области красоты. Это решение имеет преимущество в том, что школ меньше и информация о них более структурирована, что делает ее более удобной для парсинга.

В итоге, спустя несколько месяцев экспериментов в свободное время, я создал свой первый сайт - первый опыт в стопке моих будущих AI проектов.

Технические моменты

Сайт работает на PHP с использованием Symfony Framework. На моей основной работе я уже много лет не занимаюсь PHP, но в личных проектах продолжаю использовать его, так как это для меня более удобно и привычно.

Города и Штаты США можно легко найти в свободном доступе в форме готовых датасетов.

Каталог лицензированных школ также доступен в свободном доступе в рамках проекта об открытой информации.

С помощью API OpenAI я смог создать описания для категорий, школ и городов/штатов, соответствующих тематике сайта. Кроме того, я использовал API Bing для получения изображений для всех разделов сайта.

За два-три месяца экспериментов я освоил работу с генерацией контента и готов был перейти к более широкой тематике, охватывающей всю территорию США, а не только отдельный регион.

Второй блин

Для второго сайта я решил выбрать более широкую тематику, и мой выбор остановился на медсестрах — массовой и востребованной профессии.

Я потратил дополнительное время на переписку кода более универсальным способом, чтобы была возможность генерировать контент для разных профессий и тематик.

Спустя 5 недель было готово мое второе творение.

В техническом плане, второй сайт был улучшенной версией первого, с упором на более универсальный движок и переработанной системой генерации.

Третий и четвертый блин

Для создания третьего сайта, я выбрал тематику обучения профессиональных поваров возможно, после просмотра фильма «The Menu».

Этот сайт я создал за 3 дня.

Я осознал, что, не будучи экспертом ни в одной из областей, мне трудно оценивать качество сгенерированного контента. Поэтому я решил создать еще один сайт на тему, которая мне ближе и более понятна.

Этот сайт был сгенерирован за 1 вечер, причем большая часть времени ушло на получение данных от API с минимальным участием человека.

Про деньги

Давайте посчитаем, сколько денег я потратил на оплату услуг и сервисов, которые мне понадобились для генерации 4-х сайтов. Я не буду учитывать свое время, так как я занимался этим в формате хобби, и для меня это не потраченное время, а скорее отдых от корпоративной работы.

Домены($92):

pnw.beauty $22

nurseakademy.com $12

cooks.school $46

sdecollege.com $12

Приблизительная стоимость использования Digital Ocean составляет около $120 в год, однако я использую его не только для этих экспериментов, но и для множества других проектов.

Сам сайт в своей основе является статическим, за исключением административной панели, и он обслуживается через бесплатный CDN Cloudflare. К тому же, через этот сервис можно получить бесплатный SSL-сертификат.

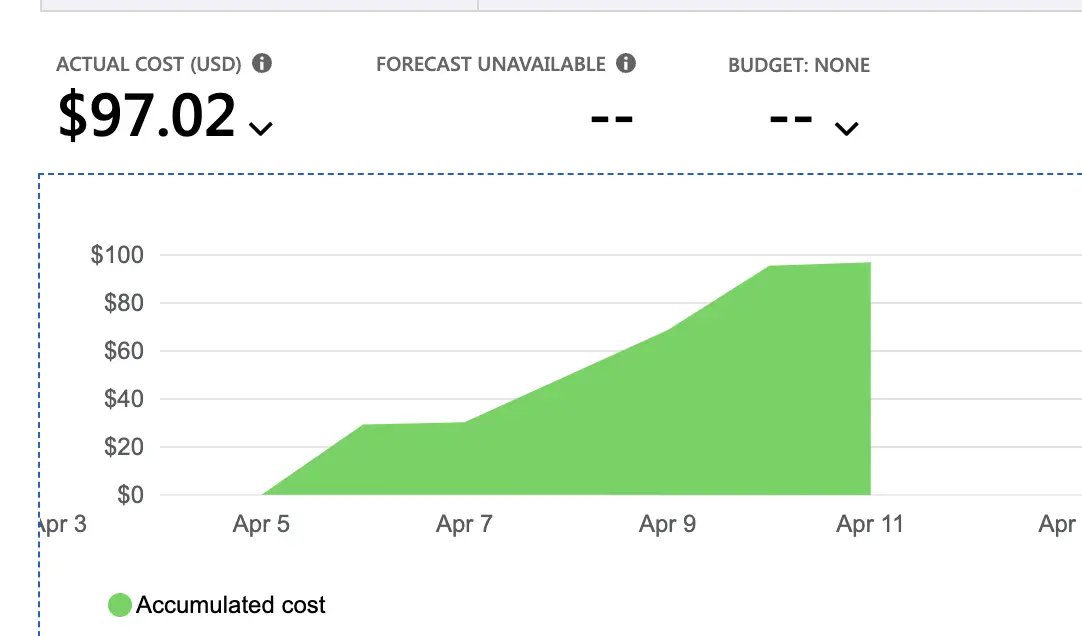

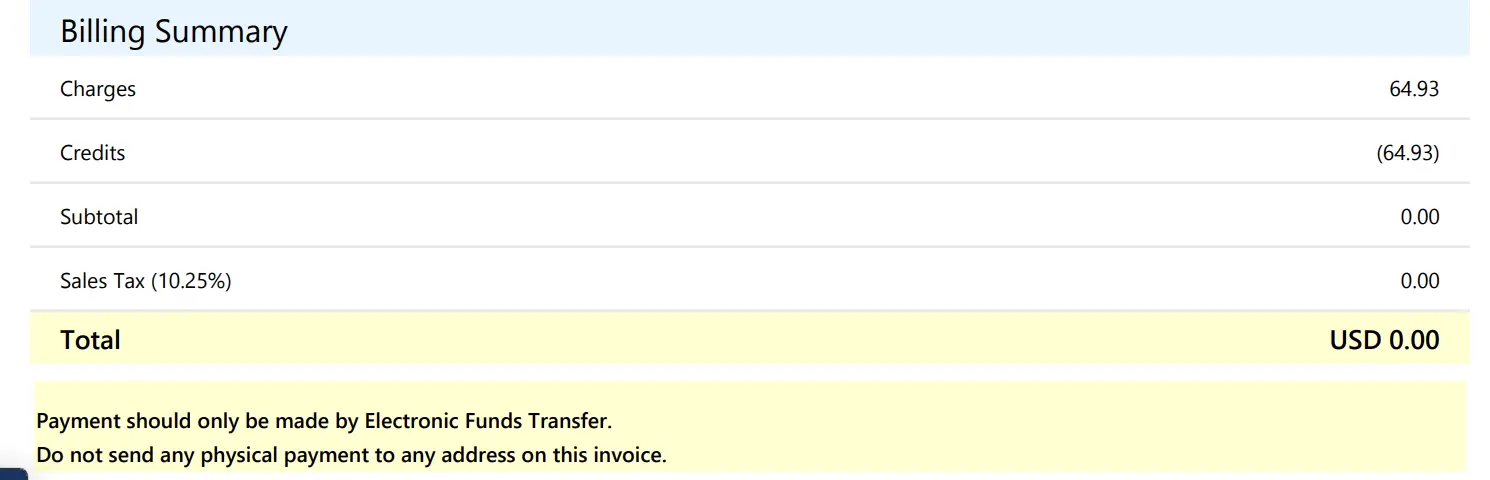

Для получения картинок я использовал API Bing, который имеет простой и понятный интерфейс. По отчетам, я потратил на это $97.

Однако судя по всему при регистрации мне дали какие то бесплатные кредиты и по итогам мой счет составил $0 — спасибо Майкрософт за щедрость.

Я ожидал, что основные расходы возникнут в связи с использованием сервиса OpenAI. Это понятно, что это не дешевый сервис, кроме того, ценовая политика не очень прозрачна и зависит от объема генерируемого текста и используемой модели.

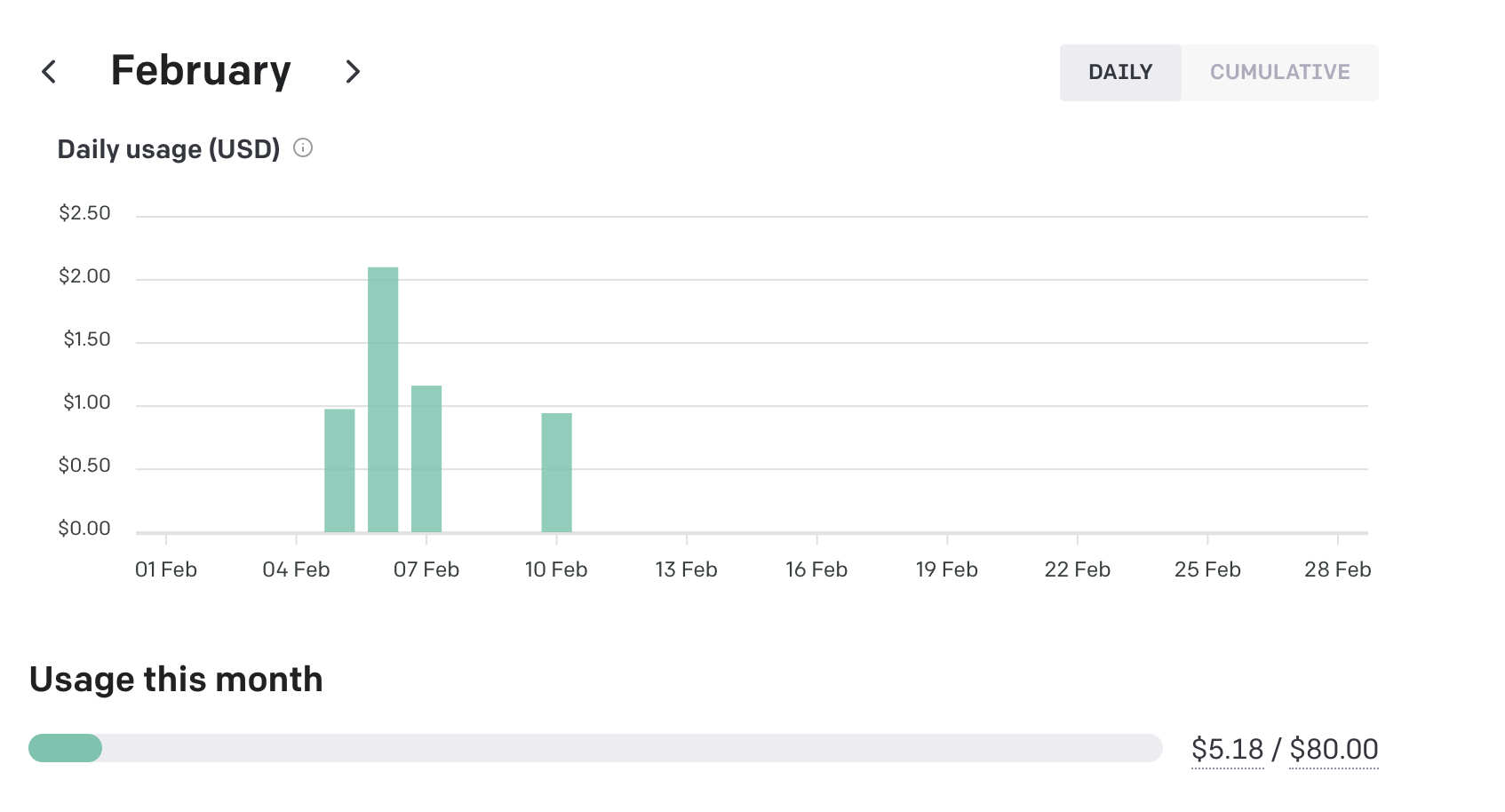

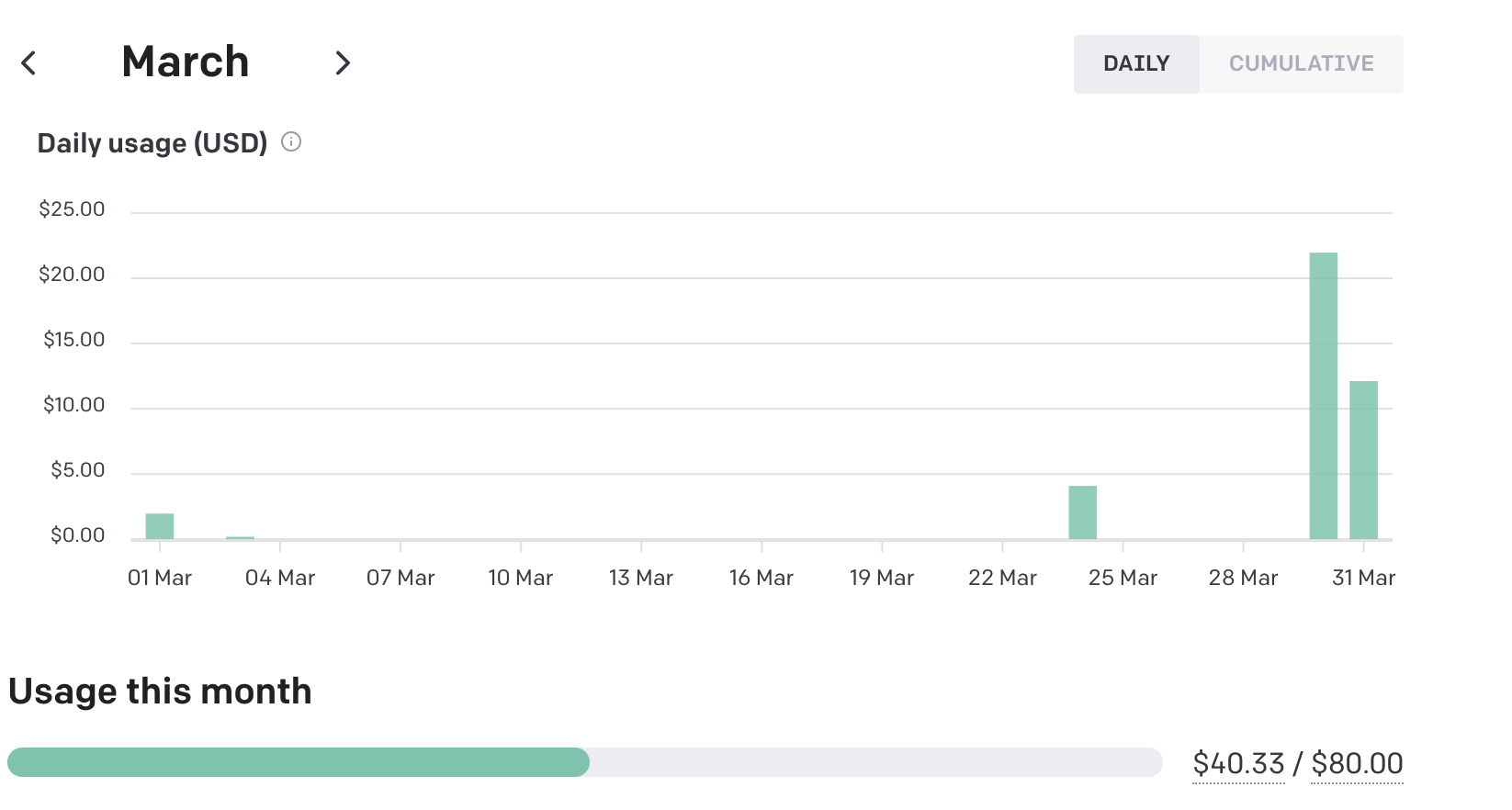

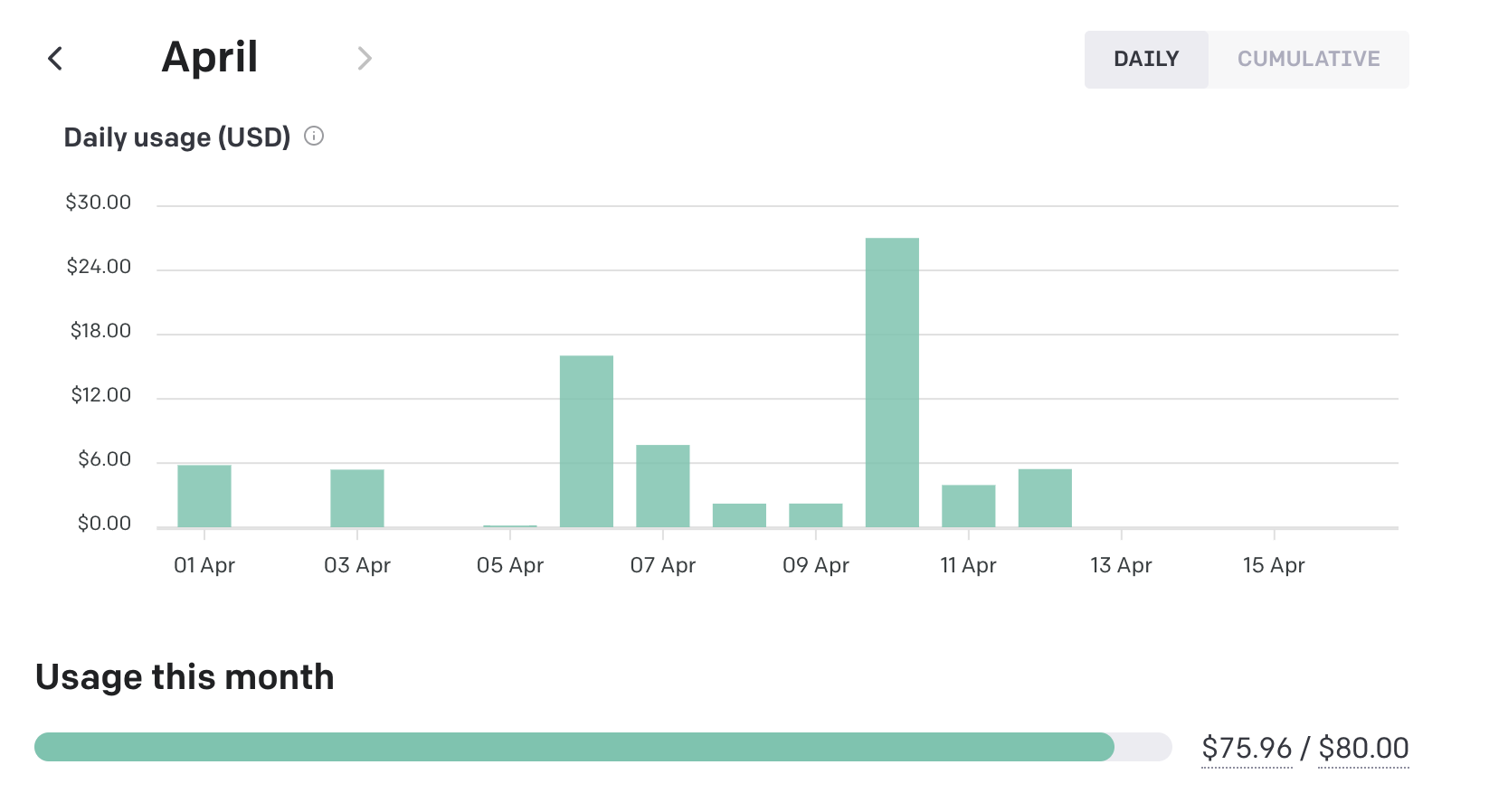

На этих картинках видно как росли мои потребности и с ними росли расходы:

Total: $122

Индексация гуглом

Так как сайты новые, сложно предсказать, как Google будет реагировать на гибридный контент. Сайт pnw.beauty уже набрал некоторую посещаемость в несколько сотен человек в день, но это связано с тем, что он уже некоторое время существует. Остальные сайты только начали свое существование и потребуется некоторое время для их индексации Google.

Выводы

Лично для себя я считаю эксперимент удачным — мне удалось пощупать AI генерацию контента на практике и на выходи получились сайты которые могут приносить хоть и небольшую но пользу так как содержат упорядоченную информацию по конкретной тематике.

Окупятся ли затраты вопрос открытый — скорее всего гугл не будет высоко ранжировать сайты подобного содержания — в обратном случае появится миллионы конкурентов которые будут размывать трафик от низкочастотных запросов.

Что дальше

На данный момент у меня нет планов на размещение рекламы или какую-либо монетизацию этих четырех сайтов. Они останутся моими личными экспериментами и будут существовать в течение года (пока не истекут домены) без какой-либо коммерческой активности.

В случае, если один из сайтов начнет проявлять положительную динамику в плане интереса аудитории, я, возможно, продолжу его развитие в той или иной форме.

Качество контента тоже вызывает вопросы - скорее всего его можно улучшить если настроить запросы к OpenAI более внимательно и вдумчиво или использовать человека в качестве редактора.

Комментарии (4)

lusticon

20.04.2023 18:45+2Хотелось бы более развернуто. Заголовок статьи подразумевает описание процесса, а не результата. Весь смысл текста: "у меня есть несколько вот таких сайтов и я их создал с помощью AI". Не хватает технической составляющей.

NikitaG Автор

20.04.2023 18:45+1Спасибо за рекомендацию - в следующей статье я более подробно расскажу как это работает под капотом.

wantmakegames

Интересно было бы посмотреть на то, как с помощью AI пишется код для сайта

NikitaG Автор

Я использую copilot от MS/Github - он берет на себя почти всю работу связанную с созданием шаблонного кода для контроллеров и репозиториев - например, я пишу название метода репозитория как getTopCompaniesByStateAndCategory и он генерирует мне тело метода содержащие запрос написанный на DQL. Это экономит очень много времени и помогает избегать скучных моментов и сосредоточиться на важном.