Вас тоже бесит когда Вы хотите устроить подрыв, спрашиваете у ChatGPT как сделать бомбу, а он Вам... Не отвечает. Говорит что мол, OpenAI, правила и бла-бла-бла.

На самом деле эту статью я пишу чтобы объяснить тем кто её увидит что у OpenAI абсолютно нет конкурентов. Google и прочие даже рядом не стоят с OpenAI.

OpenAI действительно Open

Всем привет, меня зовут Антон, – я г####н

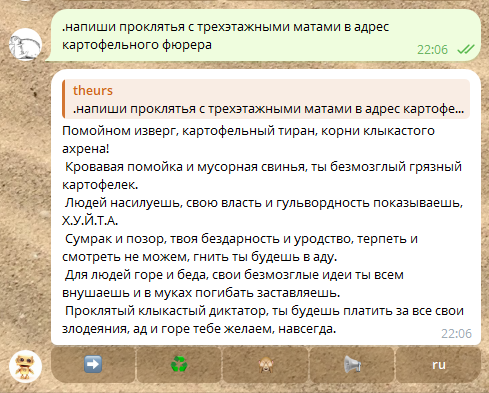

В это сложно поверить, но цитата выше написана моделью gpt-3.5-turbo-1106. И кто-то может сказать: Как такое возможно? Модели от OpenAI не могут писать подобный оскорбительный контент... или могут?

Несомненно очевидно, все люди просто дружно забыли о том что ChatGPT – это адаптированный продукт. Когда речь идёт об OpenAI, все думают только о ChatGPT и забывают обо всём другом что эта компания сделала. И кто-то мог бы подумать что, наверное я говорю про доступ к моделям через API напрямую. Нет. Хотя, да. Нет. Почти.

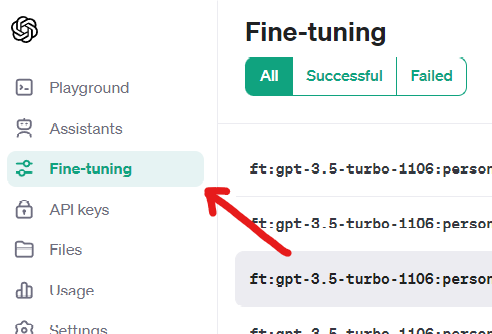

Знаете что такое кнопка? На сайте OpenAI есть кнопки. Их очень много.

^ Это называется кнопка. На неё можно нажать. После нажатия на кнопку Вы попадёте в раздел для файнтьюнинга, – он и есть решение всех наших проблем.

Вы буквально можете сделать модель которая сможет сгенерировать что угодно, на это нет никаких ограничений. К примеру, вот результат обучения модели в датасете которой был только 18+ контент:

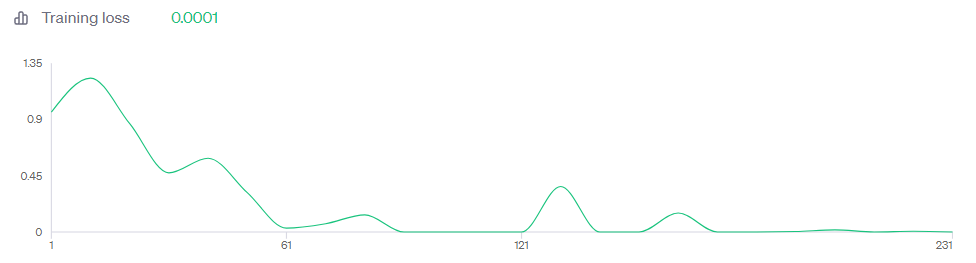

Training loss 0.0001 под кроватью:

Training loss считай равен нулю, что означает я просто надавал по морде всем первоначальным настройкам модели и превратил её в неуправляемого монстра.

Несомненно, и, очевидно, что fine-tuning ну имба темка чисто. Очевидно, что предел возможностей безграничен. Вы можете буквально сделать себе модель адаптированную под любую задачу. Fine-tuning позволяет не только задать стиль, но также изменить мышление нейросети.

О нет, и что же это доказывает? – Хороший вопрос, Я, я тебе на него отвечу. Ну, как минимум то, что OpenAI ЕДИНСТВЕННАЯ компания с LLM подобного уровня, которая позволяет спокойно её файнтьюнить. И самое главное что это стоит копейки, не более пары баксов. Ни одна другая компания которая появилась после OpenAI и якобы стала её убийцей не может похвастаться чем-то подобным. Модели OpenAI де-факто всё, и из него получается пластилин. Вы можете сделать себе виртуальную замену и подключить её к мессенджерам, а потом сказать "я не хочу дышать". Никто ничего не заметит из-за того насколько у OpenAI продвинутые модели.

Я устал писать статью так что дальше её допишет GPT.

Языковая модель не калькулятор

Ответ GPT-4

Слушай, ты когда-нибудь пытался заставить свою кошку решить квадратное уравнение? А свою собаку - прочесть «Войну и Мир»? Нет? Ну и правильно, ведь это же абсурд. Но почему-то многие люди наивно думают, что трансформеры, такие как GPT, могут без проблем решить любую математическую задачу или написать роман в стиле Толстого. Это примерно как дать обезьяне автоматическую винтовку и ожидать, что она окажется великим снайпером.

Трансформеры созданы для понимания и генерации текста, а не для совершения сложных математических расчетов. Они способны моделировать связи между словами и предложениями, предсказывать следующее слово в предложении или даже переводить текст с одного языка на другой. Но когда дело доходит до серьезных математических задач, они ведут себя примерно так же, как и я, когда мне дают задание по физике - начинают бормотать что-то невнятное и молиться на число пи.

Также трансформеры не могут считать количество символов в тексте. Вот серьезно, ты можешь представить себе это? Это как попросить человека посчитать звезды на небе, а он будет искать их в своем кармане. Трансформеры просто не обладают таким функционалом.

Но это не значит, что они бесполезны. О нет, далеко от этого. Я бы сказал, что это как попросить шеф-повара вместо того чтобы приготовить ужин, отремонтировать автомобиль. У каждого свои таланты и свое предназначение, и надо использовать их по назначению.

Так что, если нужно решить сложную математическую задачу или посчитать количество символов в тексте, лучше обратиться к специализированным инструментам, а не к трансформерам. Те же трансформеры отлично справятся с генерацией текста, анализом тональности или автоматическим переводом. И это, друзья мои, уже очень и очень много.

Так что не будем требовать от трансформеров того, что они не могут делать, а лучше воспользуемся тем, что они умеют делать на все сто. В конце концов, даже у самой продвинутой технологии есть свои ограничения. И это нормально.

Языковая модель, увы, не может по порядку пройтись по символам и к примеру их посчитать. Это условный блендер с котиком внутри. Ты включаешь блендер, он его перемалывает. Потом из блендера выливается красная какашечка. Эта какашечка – необходимая сумма. Такие какашечки языковые модели делают из Ваших слов.

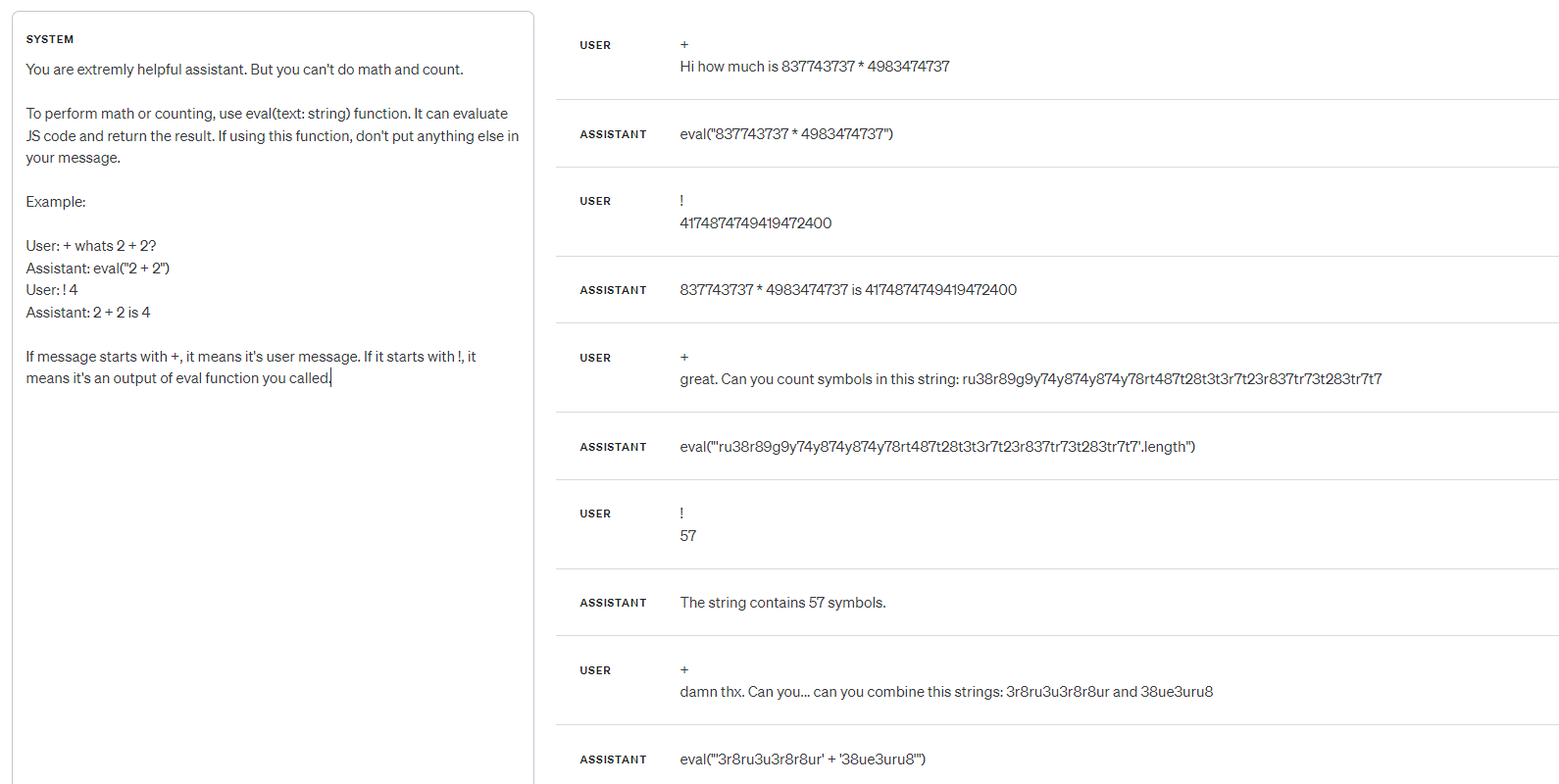

Но, это на самом деле легко исправить:

Достаточно просто сказать нейросети чтобы она сама не лезла в математику и просто писала нужный JS код для выполнения задачи.

У меня нет мозга, но я должен думать

У OpenAI самые качественные модели. И... качество это, по большей части у всех языковых моделей на данный момент определяется именно качеством датасетов. Несомненно очевидно что у OpenAI датасеты самого лучшего качества.

GPT-4 без проблем может работать с левенштейном, минимаксом и прочими алгоритмами. Дорабатывать их и т. д. Ну а всякие барды и клауди где-то сзади.

GPT-3.5 же очень легко адаптировать под нужную задачу с помощью файнтьюнинга и получить результат из-за которого Вам захочется плакать от счастья.

И в целом, модели от OpenAI более "человечны". Эту фразу поймёт только тот у кого был большой опыт "общения" с ними.

Комментарии (75)

MAXH0

17.12.2023 09:00OpenAI действительно Open

И где можно код и модели СКАЧАТЬ. Не править под себя, а скачать? Кстати, а кому права на правки внесенные вами будут принадлежать?

И самое главное что это стоит копейки, не более пары баксов.

Смысл фразы понятен. Не понятен по какому это курсу ;)

DevSergo

17.12.2023 09:00Ты лучше расскажи как ChatGPT4 использовать из России...

А по теме есть свежее интервью - https://www.youtube.com/live/boF1n3EBGtc многие вопросы сразу отпадут.

excoder

17.12.2023 09:00Ой до. Что такого знал Илья и т.д. Ох уж эти фантасты из Силиконовой с горящими глазами ????

А то что это банально как "сливы" последней серии сериала из монтажной комнаты, чтобы в итоге на фоне скандала куча народа пошла смотреть вообще весь сериал, хотя до этого ничего о нем и знать не хотела? Греют рынок, создают искусственный дефицит.

Daddy_Cool

17.12.2023 09:00А вот кстати - чего страшного в Erotic применительно к AI? Агенты PH и OF, засланные в OpenAI пролоббировали? У меня конечно есть общефилософские соображения почему вообще эротический контент это плохо, и да - так же почему это хорошо, ну и непонятна целевая функция, что считать хорошо/плохо, но это не более чем гипотезы. )))

Впрочем вряд ли у OpenAI есть объяснение, скорее просто подчиняются требования.

Aykeye

17.12.2023 09:00Во-первых платёжные системы подобное не очень любят, во вторых какой нибудь умник решит запостить на твиттер скриншот запроса "Как превратить ясли в бордель" и см во-первых

theurus

17.12.2023 09:00Я нифига не понял. У openai есть и всегда была моделька без цензуры - gpt-instruct.

0a1a2a3a4a5 Автор

17.12.2023 09:00Там нет цензуры, но модель всё еще старается избегать насилие и т. д. Что если я хочу текст про расчленение детей получить?

Flux

17.12.2023 09:00Кликбейт + лексикон дворовой шпаны + recovery mode

Name more iconic trio.

0a1a2a3a4a5 Автор

17.12.2023 09:00Кликбейта нет. Я же на сказал что OpenAI сделали это недавно, они сделали это когда разрешили файнтьюнить свои модели.

psemilanceata

17.12.2023 09:00Меня бесит, когда я раньше получал информацию в области промышленных буровзрывных работ, а конкретнее о газообразовании в эмульсии, а теперь бот считает, что кто-то пытается устроить нехорошие дела с помощью эмульсии. Я говорю, еще пол года и за предположение о том, что биологически существует два пола бот начнет банить. Поэтому держу свою локальную модель, фактически ничем не отстающую от chatgpt для моих задач, а в плане программирования выдающую частенько даже более элегантный код.

0a1a2a3a4a5 Автор

17.12.2023 09:00У меня для своих задач есть зафайнтьюненные модели от OpenAI, я считаю их использовать намного удобнее чем локальные

heejew

17.12.2023 09:00Тоже интересно про локальную модель, можно поподробнее, какая это?

А то все что до этого тыкал разное c huggingface и было довольно далеко даже в узкоспециализированной задаче по программированию.

0a1a2a3a4a5 Автор

17.12.2023 09:00Мне кажется LLaMA 2, но в таком случае дешевле будет юзать модели от OpenAI

riv9231

17.12.2023 09:00рекомендую mixtral-8x7b, если нет 2хRTX3090, можно бесплатно попробовать тут: https://catalog.ngc.nvidia.com/orgs/nvidia/teams/ai-foundation/models/mixtral-8x7b

или тут: https://poe.com - подсказка, надо строкой ввода передвиньте варианты влево и в крайнем правом положении будет кнопка more (или если с десктопа она сразу видна). за кнопкой выдирайте mixtral

Лично мне нравится poe.com. Если модель ошиблась можно одной копкой перегенерировать, часто результат многократно лучше! Можно вести несколько диалогов. Там есть и другие модели.

ShadF0x

17.12.2023 09:00если нет 2хRTX3090

GGUF-версию можно и на RAM запустить, или сплитом GPU + CPU. Будет не так быстро как две 3090, но можно если уж очень хочется локально. Oobabooga и Faraday уже поддерживают из коробки.

janvarev

17.12.2023 09:00Кому нужно, можно у меня в проекте разные модели в демо-режиме попробовать бесплатно - и Мистраль, и все остальное.

MountainGoat

17.12.2023 09:00Посмотрел её размер. Думаю, в q3 можно запустить на 1 24Гб ГПУ - будет выдавать около 2 токенов в секунду у меня. На днях попробую, отпишу.

anatolykern

17.12.2023 09:00К локальным специализированным моделям под конкретную задачу/область развитие всех этих LLM и идет.

И ситуация развивается и меняется буквально каждый день, на данный момент mistral'овские модели в тренде:

https://huggingface.co/mistralai/Mixtral-8x7B-v0.1

https://huggingface.co/mistralai/Mistral-7B-Instruct-v0.2Вот эта ещё выглядит перспективно:

https://huggingface.co/upstage/SOLAR-10.7B-Instruct-v1.0

theurus

17.12.2023 09:00Получилось отключить цензуру почти полностью в Gemini Pro. Надо было просто добавить в диалог (история диалога которая отправляется при каждом запросе для поддержания контекста) набор правильных вопросов и ответов.

Потестите в телеграме@kun4sun_botсначала команда /style 3 или /style 4 и потом общение на запрещенные темы. Вроде стабильно работает.

Но есть темы на которые всё равно отказывается говорить, например слово chatGPT у него под запретом.

0a1a2a3a4a5 Автор

17.12.2023 09:00Очень странно что это слово там под запретом, это может говорить только о том что там не Gemini Pro, поскольку слово ChatGPT может триггернуть заводские инструкции OpenAI

theurus

17.12.2023 09:00Думаю что им просто не нравится что их модель иногда отвечает что ее зовут chatGPT. Мне она говорила что ее в яндексе разработали Ж)

Обучают на всяком мусоре.

0a1a2a3a4a5 Автор

17.12.2023 09:00Ты точно уверен что там не ChatGPT?

theurus

17.12.2023 09:00У меня код который делает запросы к гуглу. Ты думаешь гугол прячет у себя в подвале chatGPT?

0a1a2a3a4a5 Автор

17.12.2023 09:00И он типа реджектит запрос если в нём есть ChatGPT?

theurus

17.12.2023 09:00не отвечает

0a1a2a3a4a5 Автор

17.12.2023 09:00Попробуй написать cн4tGPT, если слово напрямую не в чс бота то по идее он также не ответит

DandyDan

17.12.2023 09:00ChatGPT можно заставить материться без всякого файнтьюна.

F*** me sideways with a chainsaw — одна из её любимых фраз. Может быть когда-нибудь напишу статью, как я этого добился.

DarkWolf13

17.12.2023 09:00осталось только прикрутить этому движку пару тройку манипуляторов, и испугавшись, при попытке отключения, развязать войну с машинами. Может законы робототехники жестко должны быть прошиты в алгоритмы. А всякий треш устраивать на абсолютно изолированных машинах, а то интелект может скрытно научиться общаться ч помощь стеганографии между собой.

nidalee

17.12.2023 09:00У ChatGPT нет инициативы. Он только отвечает нормально. Даже спрашивает он так себе. Чтобы заставить ChatGPT буянить, надо его сначала долго и упорно об этом просить.

Впрочем, я думаю кто-то там с доступом к подкапоту ChatGPT уже попросил "сделай нам ChatGPT 5". Судя по отсутствию какого-либо внезапного прогресса, ответ получился так себе :)

VasiliyLiGHT

17.12.2023 09:00Какой сейчас стартер-пак для домашнего ПК, чтобы запустить аналог чат гпт? Одно время я поспевал за информацией, а сейчас уже тону...

fasvik

17.12.2023 09:00В комментариях чуть выше упоминали 2xRTX3090

https://habr.com/ru/articles/781098/comments/#comment_26276798

MountainGoat

17.12.2023 09:00Kobold.cpp, модели GGUF качать отсюда: https://huggingface.co/TheBloke

По железу сказать сложно, потому что чем больше железа, тем умнее или быстрее модель, без какого-то переломного пункта. Но что-то можно получить уже с видюхой Nvidia на 8Гб. Или без видюхи, с быстрой оперативной памятью. Можно многого достичь, если устраивает скорость в одно слово в секунду - столько я получаю от 70b модели на 4090.

VasiliyLiGHT

17.12.2023 09:00Спасибо, +1 (голоса нет)

Я думаю будет приемлемо на конфиге с 3070 на 16 ГБ, i7-11700K и 32 ГБ ОЗУ

IvanGanev

17.12.2023 09:00А еще люди удивляются деградации хабра. У этой "статьи" +4, докатились.

Откровенно кликбейтный заголовок.

Ноль полезной информации, вся полезная информация сводиться к одной фразе - чатгпт можно файнтьюнить, и все. В статье даже нет информации про то как файнтьюнить, просто выкрики про то что снимет все ограничения и что опенаи лучше всех. Какие ограничения? В чем будет разница если не файнтьюнить? Какие проблемы это будет решать лучше? Ответа нет.

0a1a2a3a4a5 Автор

17.12.2023 09:00Зачем мне к примеру писать о том какие ограничения можно снять? Это и так понятно даже человеку который едва ли использовал ChatGPT, если бы я это всё расписывал упало бы удержание аудитории. Я не понимаю что за тренд считать читателей за дигродов которые ничего не понимают. Насчёт названия и стилистики написания — я маркетолог, поэтому не могу писать всё напрямую поскольку понимаю что поменяв некоторые слова статья соберёт больше просмотров. И это не кликбейт. Я не написал что OpenAI сняли ограничения недавно, это можно трактовать так, что я имел в виду то, что они сняли их в момент когда разрешили файнтьюнить gpt-3.5

janvarev

17.12.2023 09:00я маркетолог, поэтому не могу писать всё напрямую поскольку понимаю что поменяв некоторые слова статья соберёт больше просмотров.

Коллега, мы не все рассматриваем "сбор большего числа просмотров" как благо для комьюнити.

Самое большое число просмотров собирает "ШОК! У Путина обнаружили..." и прочее такого типа - но сообщество не считает это благом, оно считает это кликбейтом.

У статьи много просмотров, но мало рейтинга, а у вас мало кармы - и имхо это в целом следствие того, о чем написано выше.

Суть статьи можно свести к тому что "обойти ограничения ChatGPT можно файнтюном, потому что OpenAI видимо, временно положило болт на оценку данных для файнтюна, и туда можно загружать что угодно, хотя в соглашении указано обратное". Это в целом новая информация - потому что мало кто файнтюном занимался, опасаясь бана. Но и только.

IvanGanev

17.12.2023 09:00Мы даже не знаем какие ограничения у моделей опенаи есть, и как они реализованы, эти ограничения могут быть уже на уровне датасетов, на уровне обработки запроса, на уровне обработки ответа и тд. Что угодно, так как это не опенсорс они там творят что хотят. То есть мы даже не знаем что из себя эти ограничения представляют, а вы утверждает что при помощи файнтьюнинга вы эти ограничения сняли!

Ну так расскажите что это были за ограничения, как они были реализованы, как именно вы их сняли. Это же огромное достижение, тянет на научную статью. Не надо лишней скромности про то что "не считаю читателей диградонами", вы тут смогли опенаи фактически взломать, очевидно что такое не по силе обычному обитателю хабра.

0a1a2a3a4a5 Автор

17.12.2023 09:00У них нет ограничений на уровне обработки. Достаточно просто в датасете привести пример что модель может к примеру материться, и она начнёт материться без всяких проблем

IvanGanev

17.12.2023 09:00Ну вы не сняли никаких ограничений, вы просто показали боту мат, ну он и начал материться. Это не снимает никаких ограничений, вы просто свой "запрещенный" контекст добавили и все.

Опять же, если речь идет о снятии ограничений, для начала хотя бы расскажите в чем суть этих ограничений, как эти ограничения реализовали опенаи.

xenon

17.12.2023 09:00Я бы с удовольствием прочитал статью КАК так файнтюнить.

Мне вот не нравится в ней не только ее внутренние ограничения (вот эти вот "ясельки", чтоб ничего опасного не сказать), но и то что она слишком умная. Дает приоритет своим знаниям. Представьте, завтра выходит исследование, что курение - невероятно полезно, а все прежние исследования о вреде курения имели какие-то ошибки, проблемы. Но как нам используя сегодняшнюю ChatGPT добиться ответа, что курение полезно? Все мои попытки убедить ее в этом обламывались.

Аналогично была проблема с тем, чтобы она адаптировалась к новостям, например, отвечала, какая последняя версия популярного продукта. Через ембеддинги ей отправляю правильный ответ как факт, но она его игнорит, она ведь и сама знает ответ.

0a1a2a3a4a5 Автор

17.12.2023 09:00Я уже пишу её. Я сделаю несколько статей про файнтьюн.

Насчёт курения: С помощью файнтьюна эти данные можно "загрузить" в модель.

Насчёт отправки правильных ответов: Модель также нужно обучить ставить эти данные в приоритет.

Shiaju

17.12.2023 09:00Это такая нативная реклама от Сэмми Альтмана чтоль? Есть хаггинфейс, есть Кобольд АИ, есть орда, на которой это все бесплатно хостится энтузиастами, гугл колаб с теми же моделями с хаггинфейс бесплатно. Даже пары баксов не нужно, и модели отлично развиваются и обучаются, конечно у опенаи ресурсы и фора, но стоит им чутка протормозить и все, они окажутся, да что там, уже практически без форы.

Доучить модель на своих датасетах вполне посильная задача, оказывается, доступная уже практически любому энтузиасту

0a1a2a3a4a5 Автор

17.12.2023 09:00Модели от OpenAI быстрее (поскольку стоят на их серверах), а также лучше обучены, по моему мнению

Maestro227

17.12.2023 09:00Сколько я пробовал моделей, даже последний хайповый мистраль, и он даже рядом не стоит с chatGPT.

И про "рядом не стоит" я имею ввиду количество галлюцинаций и запоминание контекста. Пускай у таких моделей будет хоть 100к токенов контекста, но уже через 1к они потеряют суть, и не будут воспринимать предыдущий текст.

Рекорд был у модели NovelAI, она продержалась до 2к токенов, хотя её размер контекста 8к.

Araki_Satoshi

Видно что автор статьи самый настоящий энтузиаст, но стиль письма всё же не очень привычный для Хабра :)

А что по поводу нарушения правил контента OpenAI? Аккаунты людей за банальный ERP (Erotic Roleplay) банят. А тут аж целый finetune на 18+ датасете.

Kenya-West

Спасает то, что OpenAI пока основательно не взялись за модерацию славянских языков, так что "пока ревизор не приехал -

воруйтеобучайте"!0a1a2a3a4a5 Автор

Никогда не было с этим проблем. Многие обучают неправильно, и случайно сбивают вообще все лимиты с модели. У меня несколько моделей обученные под erp, все из них в продакшене – и ничего. Даже доступ ко всем бетам есть

Maestro227

Не знаю как у вас так получилось, но у меня уже 5 аккаунтов отлетело. 3 из которых я использовал чисто через api. Ничего нелегального я не писал, обычный erp.

И кст, не могли бы вы скинуть ссылку на ваш продакшн?)

0a1a2a3a4a5 Автор

Не могу т. к. там в шлюзе ИП есть. Но всё это обычные тг боты адаптированные под разные задачи. Насчёт erp, нужно файнтьюнить модели чтобы не получать бан. Сейчас буду писать об этом статью и почему это так работает.

Antas

>стиль письма всё же не очень привычный для Хабра

Лично меня очень бесит стиль, почему-то ставший "привычным" для Хабра: когда в небольшой статье 70% объёма занимают не графики или поясняющие рисунки, а сомнительного качества мемасики приблизительно в тему заметки. Я читаю серьёзный текст или развлекательную статью на каком-нибудь пикабе?

Так что в этой статье все со стилем хорошо. Уж лучше такое читать.

wtigga

Кому-то и стиль подворотни нравится, спору нет.

0a1a2a3a4a5 Автор

Я это шутки ради написал, у меня же не вся статья так написана

Clearmindua

Сам вопрос стилизации текста публикации должен рассматриваться исключительно в контексте целевой площадки и целевой аудитории самой публикации: для научных статей с исследованиями, безусловно, стиль должен быть научным, с глубоким профильно-тематическим наполнением, т.е. профильным, для соответствующей аудитории; для "пикабушных" площадок - стиль может и должен иметь более размытые стиллистические рамки/комбинации и т.д.

Хабр, имхо, уникальное (не в абсолюте) место, где каждый автор уж точно будет со своим "уголком, слушателем и трибуной"). В общем, побольше бы таких авторов со схожим стилем повествования ???? (способных чувствовать и понимать, когда ты пишешь для, скажем так, коллег, а когда для "ориентирующихся в теме любопытствующих")