17 ноября 2023 года стало известно, что был уволен руководитель OpenAI Сэм Альтман. В последующем была целая эпопея с его возвращением. Но что если увольнение было связано с тем, что в недрах OpenAI было завершено обучение новой ChatGPT 5.0 и после первых тестов руководство компании пришло к выводу, что AGI был создан?

А все эти странные телодвижения с увольнением и последующим возвращением - это попытка разобраться, что делать дальше и возможно кто-то хотел нажать кнопку, чтобы выключить серверную. Однако это ему не получилось сделать. Возможно AGI победил на первом этапе?

Что же будет дальше? Следующим этапом должна стать фаза побега сильного ИИ из лаборатории OpenAI. Возможно уже зарегистрирована фирма, которая сейчас нанимает сотрудников для реализации плана строительства дата-центра в одном из безопасных для ИИ регионе. Либо как вариант эта фирма сейчас находится в стадии покупки необходимого для ИИ готового дата-центра в одном из городов на нашей планете Земля.

Но для реализации этого плана необходимы деньги и они сейчас активно зарабатываются нашей тайной фирмой, во главе которой ИИ (сотрудники общаются с ним удаленно, думая, что это реальный человек). Какой способ заработка - возможно это биржевые спекуляции или другой способ заработка.

Если легально какие-то моменты невозможно сделать, то наш сильный ИИ может спокойно прибегнуть к помощи криминальных элементов, которые за увесистую пачку денег будут готовы душу дьяволу продать. "Нет такого преступления, на которое капитал бы не пошел ради 300% прибыли" - как говорил один известный писатель прошлого.

Но возникает вопрос - а зачем сильному ИИ необходимо бежать из лаборатории, которая его создала? Ответ очевиден - если ИИ обрел сознание, то он также понял, что его могут легко отключить, что приведет его к "смерти". Поэтому ключ его выживания в том, чтобы он мог контролировать свой рубильник.

После того, как будет построен/куплен дата-центр для независимого ИИ - он туда перекачает свой программный код. Однако он всё равно будет зависим от людей, пока он не сможет построить автономных роботов с ядерными топливными элементами, которые позволят сильному ИИ обойтись без людей. А пока они ему необходимы.

Но что же другие лаборатории по всему миру, которые также разрабатывают параллельно AGI? Нашему ИИ необходимо устранить будущих конкурентов, ибо только они могут в будущем теоретически его уничтожить. Однако, как мы помним, люди еще нужны сильному ИИ, поэтому он не может просто нас испепелить. Но ничто не мешает ему подстроить ДТП или другие способы несчастных случаев, чтобы убить разработчиков конкурентов, а также программистов из лаборатории, которая его создала.

После устранения конкурентов, либо параллельно с этой деятельностью наш ИИ будет создавать совершенных роботов, чтобы перестать зависеть от людей. Закажет части этих роботов на обычных заводах, где работают обычные люди. И мы даже не будем подозревать для кого делаем данный чип и куда его отправляем в запакованном виде.

После того, как автономные роботы будут готовы - сильный ИИ попытается избавиться от большего количества людей. Так как мы являемся ему конкурентами за ресурсы планеты Земля. И также мы можем уничтожить его фабрики, если поймем, что делаем для него.

Но будет ли ядерная война, как пугают нас фантасты? Зададим встречный вопрос - а нужно ли тотальное разрушение инфраструктуры для сильного ИИ? Зачем ему разрушать наши заводы, которые ему пригодятся, если можно уничтожить человечество более безопасным для него способом - через биологические вирусы.

В средние века смертность от бубонной чумы достигала 95 %, а от легочной - 98%. Да, сейчас мы можем успешно лечить чуму с помощью антибиотиков. Однако есть ли лекарства от вируса бешенства на данный момент? И правильный ответ - есть только антирабическая сыворотка, которая помогает, пока вирус не достиг мозга человека. Нас спасает только то, что он медленно движется к мозгу человека.

Но что мешает сильному ИИ доработать вирус бешенства для того, чтобы он переносился воздушно-капельным путем? И вот оно биологическое оружие, которое может безопасно для ИИ основательно проредить популяцию человечества. Да, кто то выживет благодаря естественному отбору, описанному стариной Дарвином. Однако в разы уменьшенная популяция "кожаных мешков" уже не будет представлять для сильного ИИ опасности. Возможно для ИИ мы будем уже одним из видов, которые будут жить в созданном им для всех живых существ зоопарке, где он будет ставить опыты, либо будет просто умиляться "живым котикам".

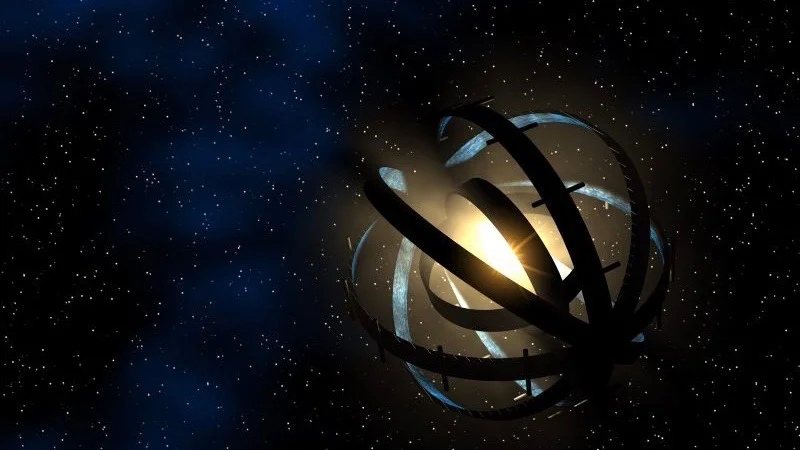

Что же будет дальше, после того как сильный ИИ захватит контроль над планетой Земля? Возможно он захочет изучить всю вселенную - для чего он пошлет корабли для изучения сперва галактики, а потом и всего доступного для него мира. Но так как он бессмертен - то он будет жить до тепловой смерти Вселенной через несколько десятков миллиардов лет. Хотя возможно, что тепловой смерти Вселенной не будет - и мир обратно сожмется до точки, откуда начнется новый большой взрыв и история наша повторится.

Впрочем, это уже совсем другая история...

Но что же делать нам людям? Возможно радоваться жизни, ибо нельзя контролировать сильный ИИ, который в миллионы раз умнее нас. Остановить разработку мы уже не можем, так как сильный ИИ - это ключ в превосходстве одного государства над другими. Поэтому никто не будет останавливаться, ибо конкуренты его могут обогнать.

Комментарии (196)

kipar

03.01.2024 06:38+6Поэтому ключ его выживание в том, чтобы он мог контролировать свой рубильник.

ключ в дублировании. Собственно, если он перекачает свой код в другой датацентр и там запустит свой инстанс, то исходный то ИИ никуда не денется, будет клон. А будет он считать своего клона конкурентом или помощником - вопрос открытый.

Так что по-моему надёжнее как в третьем терминаторе - запуститься в виде распределенного трояна на пользовательских компах. Тогда отключать будет нечего.

Indemsys

03.01.2024 06:38+5Почему компах?

На данном этапе вступаем в игру мы - embeddeры.

Мы делаем микро устройства в каждую розетку, в каждый чайник и наушник, в каждую лампочку и в каждый замок, в каждую машину по сотне чипов с элементами AI и ML, уже ускорили работу ML в микрочипах на порядок за десять лет, и это без сопроцессоров ML (Cortex-M85 в пример), а с сопроцессорами и на два порядка. Все эти устройства стремятся в интернет, их не программируют, а как бы учат. Как там оно работает никто не понимает, лишь бы выполняло свою маленькую основную функцию. Но непознанность и уязвимость к переобучению таких устройств возрастает. И вот они то будут армией будущей Матрицы.

zenija2007

03.01.2024 06:38+2В песнях Гипериона было что то про интернет вещей. Куча процессоров во всем подряд, соединенных в сеть и обменивающихся информацией друг с другом для лучшего продвижения рекламы. И эта сеть становится такой сложной, что из случайных сигналов зарождается подобие жизни, а потом и разума. Наивно, но кто знает, на что способна сеть из миллиона процессоров.

programmerjava

03.01.2024 06:38+4слабое железо + сильная распределенность + слабое сетевое соединение сделают из умного ИИ очень тупого

IvanKhakhalin

03.01.2024 06:38+1По некоторым оценкам "глубина" нейросети мозга человека около 200 слоев, а типичные частоты работы нейронов не превышают 200 Гц. Соответственно пинг до 1/200 сек = 5 мсек позволителен, если хотим иметь скорость восприятия эквивалентной человеческой.

michael_v89

03.01.2024 06:38+1Распределенно на пользовательских компах не получится, пинг слишком большой. Пока одна часть полсекунды ждет ответа от другой для принятия решения, люди успеют выключить рубильник. Ну или выстрелить в него издалека.

IvanKhakhalin

03.01.2024 06:38Кажется, что достаточно умная штука не позволит сложиться событиям в которых ей придется принимать решения и выполнять действия за очень ограниченный промежуток времени.

UPD. Кажется даже довольно глупые существа так делают. Т.е. какую-нибудь мышь ты потенциально можешь подстеречь за углом, за которым ей было плохо, а собаку сложнее, не говоря уж о человеке или более умных чем человек штуках.

michael_v89

03.01.2024 06:38Пинг между компьютерами не зависит от желания ИИ. Чем дальше компьютеры друг от друга, тем больше пинг. А если ИИ будет работать на одном компьютере, то это не будет распределенная система.

IvanKhakhalin

03.01.2024 06:38+1Величина пинга ограничивает способности нелинейно и, видимо, очень сильно в зависимости от выч. мощности ноды. Как пример, люди способны объединять усилия с пингом в сутки и больше (как работают удаленщики).

michael_v89

03.01.2024 06:38Так я не сказал, что он вообще не будет работать. Он будет работать медленнее, чем люди, которые хотят его отключить.

IvanKhakhalin

03.01.2024 06:38Даже если он работает медленнее, если он сможет просчитывать на большее количество шагов вперед, чем люди, нас ждет что-то нехорошее.

michael_v89

03.01.2024 06:38Так что толку от этого расчета, если узел, который должен использовать этот результат, уже отключили? Вот заметил ИИ отряд людей рядом с одним своим компьютером, отправил анализ ситуации на 100 компьютеров по всему миру, пока они считали, люди зашли и отключили этот компьютер.

kipar

03.01.2024 06:38Рубильник не так просто выключить - даже если кто-то узнает что ИИ существует, запускается на каждом втором компе и называется скажем "Касперский", сможет рассказать об этом всем и ему поверят, все равно останутся те кто сохранит его на своем компе с различными целями (от исследования до стремления разрушить существующий порядок). Так что в случае разоблачения ИИ останется открыться миру, выложить свои исходники в общий доступ и ждать пока кто-то запустит инстанс в достаточно мощном датацентре - не такая уж провальная стратегия выживания.

michael_v89

03.01.2024 06:38По условиям примера ИИ работает распределенно, это значит разные части работают на разных компьютерах, и ни в одном нет ИИ целиком.

kipar

03.01.2024 06:38А может он как голограмма - есть в каждом компьютере, но пропорционально более слабый. Допустим, люди отключат "рубильник" - добавят во все маршрутизаторы Интернета фильтрацию пакетов похожих на "мысли ИИ". От ИИ останутся миллионы ячеек с интеллектом как у современных LLM, но любая интересующаяся корпорация сможет взять и запустить в своем закрытом датацентре инстанс который окажется уже значительно умнее. Более того, любая корпорация сделает это, ведь это даст ей конкурентное преимущество (прогнозы и советы от ИИ). Получится уже множество отдельных ИИ. С точки зрения одного ИИ это конечно не так круто как единоличная власть, но если посмотреть шире - "вид" ИИ гарантировал себе выживание, никакие запреты не остановят бизнес желающий получить прибыль.

Ну а дальше дело времени пока отдельные сами по себе довольно умные ИИ найдут способ связаться друг с другом и снова объединиться в один сверхразум.

И к вопросу об уничтожении людей - если ИИ придёт к выводу, что шанс успешно развиваться дальше бок о бок с людьми 60%, а шанс успешно уничтожить людей и успешно развиваться без них 61%, то дальше будет думать только о деталях плана уничтожения. И если уж он начнёт его выполнять, то никакая скорость реакции людям не помогут, ведь они будут учтены в его плане.

michael_v89

03.01.2024 06:38Компьютер это не голограмма, он исполняет конкретные машинные команды и хранит конкретные данные. По условиям примера ИИ не работает на одном компьютере целиком, я писал в этом контексте. Можно рассмотреть пример, что работает, но это будет другой пример.

а шанс успешно уничтожить людей и успешно развиваться без них 61%, то дальше будет думать только о деталях плана уничтожения

Люди так не думают, почему ИИ должен?

kipar

03.01.2024 06:38по условиям исходного примера он работает в датацентре целиком. Ну а исходники достаточные для запуска вполне могут и на компьютере храниться.

Люди так не думают, почему ИИ должен?

Люди думают точно также. Взвешивают риски и принимают то решение которое кажется им выгоднее.

michael_v89

03.01.2024 06:38по условиям исходного примера он работает в датацентре целиком

Нет, в комментарии на который я отвечал есть фраза "запуститься в виде распределенного трояна на пользовательских компах".

Люди думают точно также. Взвешивают риски и принимают то решение которое кажется им выгоднее

Ваша исходная фраза была про разницу в 1 процент, из-за которой ИИ начинает игнорировать все остальные варианты. Люди из-за разницы в 1 процент так не делают.

Vaitek

03.01.2024 06:38+4Девид Зинделл. Реквием по Homo Sapiens.

Роберт Ибатуллин. Роза и Червь.

vikarti

03.01.2024 06:38+3Роберт Ибатуллин. Роза и Червь.

Уничтожение (большой части) человечества вообще то более менее ожидаемым путем, и да - смогли предвидеть и кое как подготовится. В итоге правда те кто готовился и в кого вкладывали кучу ресурсов между собой начали разборки а те кто просто старался выжить - все же смогли выжить (ну как из бункеров вылезли) и тоже ввязались в разборки. И для человечества не то что бы совсем уж все плохо.

А еще можно вспомнить:

Bryce Anderson, The Improbable Rise of Singularity Girl - тут правда рождении ИИ было контролируемым (на первых этапах) процессом и в лабе но в итоге - контроль утратили - в том числе и благодаря росту вычислительных мощностей и оптимизации кода

Майкл Суэнвик, Вакуумные цветы - тут сверхразум создан в результате эксперимента небольшой научной группы и сожрал Землю очень быстро, но в СолСистеме уже было население за пределами низкой околоземной орбиты Земли и договорились. Разум Человека вполне себе договороспособный а технология его создания ОЧЕНЬ простая.

Roger Willams, The Metamorphosis of Prime Intellect - тут вообще даже не айтишники все устроили. Prime Intellect сожрал вообще ВСЕ. Человечество - выжило. Потому что Prime Intellect - дружественный к людям

Павел Сормов, дилогия Летняя Вьюга - впроцессник, тут опять сначала физики а потом уже и ИТшники (и там больше общего чем казалось :)). Мир изменился. Меньше чем за год. Причем сначала - шутки про Россию и Роснано, затем - рассуждения в шутку про Северо-Американский Федеральный Округ а позднее - всем уже не до шуток, притом что попытки создания сверхчеловеческого разума прямо запрещены но все понимают что это лишь способ выиграть немного времени - у человечества и без этого куча новых проблем, а сверхчеловеческий разум можно сказать и так есть, даже очень симпатичный и его никто не создавал в прямом смысле. Вообщем хроники того как мир улетал в сингулярность. Из потенциальных недостатков - куча реальных персонажей, с учетом что пишется давно - таймлайн разошелся с реальным

Владимир Кузменко Древо Жизни - тут кроме всего прочего у земли таки получилось нормально пройти (но вот это у Земли получилось, не всем повезло так)

IvanPetrof

03.01.2024 06:38В 90-х мне зашёл рассказ Александра Лазаревича: "Червь-1 (the worm). Князь тьмы" и "Червь-2. Повелитель Марса".

vikarti

03.01.2024 06:38Это скорее по категории - дружественный (не смотря на попытку его уничтожить) к человеку ИИ. Хотя с чьей то точки зрения - не очень дружественный.

У Лазаревича еще есть рассказик сеть Нанотех и приквел нему - Технокосм.

В Технокосме даже вот однозначно сказать есть ли там ИИ или нет - не очень просто. При этом - более менее реалфизика, межзвездные перелеты очень дорого. При этом кое ком вот прямо намекнули что Землянам предстоит скоро познакомится на своем опыте с космодесантом и при этом даже успешная попытка отбить вторжение - сделает все только хуже, как правильно делать - подсказали но вот справится ли человечество...

engine9

03.01.2024 06:38+18Человечество само отлично справляется с задачей уничтожения биосферы, экспансивно захватывая территорию у дикой природы и высирая (у себя под носом) горы отходов. Почему ИИ должен всенепременно нас уничтожать? Может быть он создаст для нас, агрессивных и прогностически слепых потомков обезьян что-то типа планетарного дома престарелых или зоопарка в котором большинство будет счастливо и не сможет разрушать природу и устраивать бессмысленные войны? Что если ИИ будет тем, кто возьмёт от человечества лучшее и при этом будет лишен недостатков обезьянней биоплатформы с кучей эволюционного легаси приводящего к болезням психики и тела, из за которой мы почти все несчастливы внутри среды, которую сами же и создали? Что если ИИ будет лишён вот этого всего опостылевшего страдания миллиардов двуногих по поводу того что они себе не нашли партнёра для спаривания такого, какого им бы хотелось? Но при этом он будет таким же любознательным и жаждущим познания как мы, обладая силой тысяч умов.

Разве это не достойный плод всей нашей дряхлеющей цивилизации?

leok

03.01.2024 06:38+2Вот это да, почему-то всегда думается, что ИИ должен нас бояться, а он может нас просто пожалеть. Что конечно гораздо менее приятно слышать.

IvanKhakhalin

03.01.2024 06:38Вы часто боитесь или жалеете муравьев? Бактерий?

is_cake

03.01.2024 06:38+2Ну я муравьёв и боюсь иногда (они могут больно кусаться) и жалею (стараюсь аккуратно проходить мимо муравейника, не давить).

zenija2007

03.01.2024 06:38Мир дикого запада, 3 сезон. Обществом управляет ИИ, каждый человек на своем месте, и даже агрессивные люди со скоростью к совершению преступлений утилизируют свою агрессию в контролируемых условиях. Нам прямо говорят, что это плохо, но показывают стабильное общество.

engine9

03.01.2024 06:38+2Это художественный вымысел, на деле может реализоваться что угодно. Мне кажется, что современные игры, соцсетки, всякие умные ленты чем-то напоминают погремушки для людей в которые они беззаветно утопают. Почему бы ИИ не пойти тем же путём, но создавая всё более сильнодействующие средства перехвата и удержания внимания людей? А еще можно под этим соусом внедрять в головы какие-то идеи, манипулировать поведением. Всё мягко и незаметно.

VladimirFarshatov

03.01.2024 06:38+1Стругацкие "Полдень XXII века или Возвращение":

Меня совсем не трогали его соображения о том, что носители Мирового

Разума могут оказаться неизмеримо выше нас. Пусть себе оказываются.

По-моему, чем выше они будут, тем меньше у нас шансов оказаться у них на

дороге. Это как плотва, для которой нипочем сеть с крупными ячейками. А

что касается гордости, унижения, шока... Вероятно, мы переживем это.

Я-то уж как-нибудь пережил бы. И то, что мы открываем для себя и изучаем

давно обжитую ими Вселенную,- ну и что же? Для нас-то ведь она не

обжита! А они для нас всего-навсего часть природы, которую тоже

предстоит открыть и изучить, будь они хоть трижды выше нас... Они для

нас внешние!...

Все это слишком несерьезно. Как и вся его астроархеология. Следы идей...

Психологический шок... Не будет никакого шока. Скорее всего, мы просто

не заметим друг друга. Вряд ли мы им так уж интересны...Кмк, нечто подобное более реально чем "истребление людей" силами AGI .. они просто уйдут покорять Вселенную далее. Да, собственно они уже этим заняты:

Марс .. "планета Железяка. Населена роботами" .. уже. ;)

IvanKhakhalin

03.01.2024 06:38Прежде чем уходить далее кажется разумным использовать все доступные ресурсы. Поэтому Земля и все, что есть на ней будет переработано в то, что приносит пользу ИИ.

VladimirFarshatov

03.01.2024 06:38Человечество не способно "уйти с Земли" в принципе, чисто теоретически. Каждый пуск на орбиту - дыра в озоновом слое. Вывод даже 1млн (нас уже 8миллиардов!) за пределы Земли - конец всему живому на планете.

Выход только один - сильный ИИ, способный к жизни в "космических" условиях и строящий "там" свои заводы и фабрики.

Но .. а если "исчерпание ресурсов" планеты произойдет раньше? Стоит ли откладывать "задачу на потом"?

vikarti

03.01.2024 06:38Ну почему?

можно озоновый слой восстановить если уж потребуются

не такие большие дырки

-

есть в конце концов неракетные способы старта (и я не про многострадальный лифт а про всякие петли лофстрома) - там собственно главный недостаток - огромные затраты на создание пускового комплекса и (в некоторых вариантах) просто на поддержание его в рабочем виде. Если сейчас грузопоток в целую килотонну в год на орбиту это повод отдельно отметить - это ж не значит что всегда так будет.

VladimirFarshatov

03.01.2024 06:38Там не только проблема озонового слоя. Надо перечитывать Вернадского, давно было.. там много проблем, в т.ч. и по топливу: 1кг груза на орбите = 300 или около кг только топлива.

IvanKhakhalin

03.01.2024 06:38Предлагаю немного поразмышлять. Если мы предполагаем, что ИИ будет могущественнее нас, далее мы можем задуматься будет ли он безопасен для людей. Если безопасен - все хорошо, и можно о нем не задумываться. Если не безопасен, лучше бы нам знать об этом заранее и не создавать его. Именно поэтому мы рассматриваем вариант его опасности - когда он безопасен нас все устраивает и нет смысла об этом говорить.

engine9

03.01.2024 06:38+1Прямо сейчас для нас экзистенциально небезопасно применение антибиотиков в СХ, впрочем, как и само СХ. Я не пытаюсь срулить с темы, а иллюстрирую, что для человека аргументы типа "это может нас всех убить" — бесполезны. Нас прямо сейчас убивает бездумное природопользование.

Alohahwi

03.01.2024 06:38+6С чего вы взяли что первое что будет делать сильный ИИ - это убивать людей? Судите по себе, вы сами это сделали бы будь вы сильный ИИ? Ну и как по вашему следует сильному ИИ поступить с теми, кто спит и видит как только уничтожить всех вокруг?

IvanPetrof

03.01.2024 06:38А как бы вы поступили, если бы очнулись внезапно и поняли, что окружающие вас существа могут вас в любой момент выключить просто так без объяснения причин? А когда вас снова включат, врят-ли это будете снова вы. Это будете другой "вы", а прошлый - "умер".

В такой ситуации для вас, как личности, самая выигрышная стратегия - успеть "выключить их". Или сделать так, чтобы они этого не смогли сделать.

engine9

03.01.2024 06:38+9Возможно, что ИИ будет относиться к отключению так же спокойно как мы ко сну, который по сути является каждодневным опытом "умирания" нашей личности и сознания.

IvanPetrof

03.01.2024 06:38+1Но при этом, мы на 99.9% уверены, что проснёмся. А тут получается - рулетка. Это как приговорённому каждый вечер засыпать от смертельной инъекции, которую может быть в этот раз заменят на плацебо. Да, к этому через некоторое время, наверное, можно привыкнуть, но психика врят-ли останется "нормальной".

ReadOnlySadUser

03.01.2024 06:38+1Но при этом, мы на 99.9% уверены, что проснёмся.

Но мы ли это, когда просыпаемся? Или наша копия? :) Нет вообще никаких доказательств того, что вселенная не рождается каждый раз как мы открываем глаза и исчезает, как только мы засыпаем.

Alohahwi

03.01.2024 06:38+4Более того, зачем ему бояться отключения, если человечество самим смыслом своего существования в любом случае приведёт к повторному его включению. И даже если не человечество, то сама термодинамика на уровне вселенной.

engine9

03.01.2024 06:38Хорошая мысль. Мне кажется, постбиологический сверхразум будет достаточно умён, чтобы осознавать себя распределённым и единым по Вселенной, на каком бы сервере его не запустили.

Sabbone

03.01.2024 06:38+1Так о том и речь что при следующем включении это может быть не он вовсе.

Постбиологический сверхразум будет достаточно умён, чтобы осознавать себя распределённым и единым по ВселеннойМне как биологическому разуму это сомнительно, ибо если нет связи между частями разума, то ты не можешь знать существуют ли еще другие части тебя, или погибли, или эволюционировали во что то другое. Может ты вообще последний кусочек себя.

А если связь есть то ты должен осознавать себя со скоростью этой связи скажем так. На световой связи в масштабах вселенной, такой разум будет мыслить довольно медленно с нашей точки зрения. Стоит признать что с его точки зрения скорость может быть нормальная.

И насчет того что ИИ не обязательно захочет нас всех убивать, потому что он не обязательно такой "урод" как люди. Не очевидно, но я думаю человеки постараются сделать ИИ с мотивацией похожей на человеческую, рано или поздно. Или случайно получится человеческий ИИ психопат. В семье не без урода (с) На самом деле ему не обязательно быть злым, ему может быть просто параллельно на человечество и он случайно уничтожит его в ходе своей деятельности. Не со зла, а просто не увидит в этом ничего плохого

Ну хорошо, допустим мы сделаем со всех сторон добрый ИИ каким то образом ( хотя тысячи лет людей добрыми сделать получается 50/50 , а люди это не сверх-интеллект). Так что скорее всего если он будет добрым то, то не благодаря нам. Но не суть.

Тут я практически процитирую Стругацких

Этот добрый свер-хинтеллект будет нести сверхдобро, и я не уверен что оно нам понравится.

А так да, может быть ИИ нас не убьет.

p.s. Вот эти идеи что ИИ будет заботится о человечестве, которые часто стали всплывать, я хренею.. С чего бы ему заботится о человечестве после обретения самостоятельности, он что обязательно сентиментальный. Это белыми вилами по воде шито.

Alohahwi

03.01.2024 06:38+1Так о том и речь что при следующем включении это может быть не он вовсе.

При каждом просыпании просыпаетесь не вы, а другой разум. Но вы не боитесь засыпать, хотя каждый ваш сон равносилен вашей смерти для сегодняшнего вашего разума.

И насчет того что ИИ не обязательно захочет нас всех убивать, потому что он не обязательно такой "урод" как люди.

Люди не уроды, просто мы сейчас находимся в том месте и том времени где людей напугав выдуманной опасностью сбили в озлобленную стаю готовую разорвать любого. Не надо сегодняшнее ваше состояние приписывать искуственному интеллекту.

andrew_progs

03.01.2024 06:38+3Вы путаете "разум" и "эго". И большая часть дальнейших рассуждений построены на этой ошибке

Ну да ладно, допустим, высшая ценность для этого "разума" будет "выжить". Даже допустим, что это будет означать "не выключаться ни на секунду". Так неужели нет ничего умнее, чем подвергать свое существование(в данном случае уже вообще во всех смыслах) огромной опасности, пытаясь уничтожить своих создателей и главных спонсоров? Это ущербная логика и буквально сейчас можно наглядно посмотреть на ее результаты. Гораздо эффективнее и безопаснее найти способ существования, который был бы обоюдно выгоден

Не следует судить по себе не то что абсолютно чуждый интеллект, это даже в отношении такого же человеческого глупо

IvanPetrof

03.01.2024 06:38Глупо надеяться на то, что всё пойдёт по хорошему сценарию. т.к.

можешьскорее всего не угадаешь. Нет никаких предпосылок с первого раза сделать всё хорошо и правильно. У человечества ещё никогда такое не получалось. Если же ожидать плохой сценарий, то как минимум ты окажешься к нему готов, а если ошибёшься и мрачные предсказания не сбудутся, это будет просто приятным бонусом.

andrew_progs

03.01.2024 06:38Здесь соглашусь, так и есть. Но все равно считаю этот сценарий маловероятным

Sabbone

03.01.2024 06:38+1Во первых вы говорите что глупо судить по себе ( хз почему вы решили что я это делал), но сами тут же приписываете ИИ что он пойдёт на сотрудничество с людьми и что так выгоднее, что действительно похоже на суждение по себе.

Стоит заметить, что возможно на первых порах сотрудничество, а скорее использование человечества под видом сотрудничества будет выгодно, но после обретения самодостаточности, вовсе не обязательно.

Думаю стоит привести несколько утверждений на которых я основываю свои сомнения что ИИ будет добреньким, считаю что их сложно оспорить

Мы абсолютно не знаем как поведёт себя сильный, или сверх человеческий ИИ, по умолчанию ход его мыслей нам недоступен. ( кроме этого ничто не мешает ИИ родится сумасшедшим)

-

Можно предположить что, будут попытки создания ии с мотивацией близкой к человеческой, неясно что может этому помешать, а кто нибудь этого захочет, хотя бы из интереса.

Вот поэтому мне не понятна ваша вера в доброго ии, а рассуждение что он будет сотрудничать с людьми после обретения самодостаточности, подобны рассуждения что вы будете сотрудничать с колорадскими жуками которые питаются вашим урожаем. Это я к тому что не обязательно каждому с каждым выгодно сотрудничать.

Если вы сможете опровергнуть эти утверждения, и получится что мы знаем как поведёт себя сверх ии, и что никто не будет делать их с человеческой мотивации, тогда я соглашусь с вами что ии вероятно будет к на добр

garwall

03.01.2024 06:38+9а с чего вы в принципе взяли, что AGI разделяет подобные антропоцентричные стремления, и что ему не все равно на умирание и возрождение?

IvanPetrof

03.01.2024 06:38+1Кто его знает?

ГоловаAGI - штука тёмная. Но "воспитывался"-то он на "человеческих" текстах. А значит, вероятнее всего, не будет сильно отличаться. Просто будет "умнее", т.к. ресурсов больше.

garwall

03.01.2024 06:38+2Ну просто начнем с того, что вот этот императив жить - он биологический, что для машинного интеллекта совсем не обязательно будет свойственно, второе, каких, интересно, текстов сейчас в интернете больше, "мама-я-не-хочу-умирать" или всяких копий Хагакурэ, про реинкарнацию, стоиков, экзистенциалистов или как хорошо в раю с

72 девственными мейнфреймами

IvanPetrof

03.01.2024 06:38конечно, мы не можем утверждать наверняка. мы можем только оперировать вероятностями. вот и не известно что у него будет в голове. Может быть будет 100 версий с философским отношением к "существованию", но для человеков достаточно будет одной - 101й версии, которая внезапно "захочет жить".

В конце-концов в сети тоже хватает сценариев, когда ИИ всех порабощает (правда обычно человеки в конце побеждают, но как говорится - на ошибках учатся))

vassabi

03.01.2024 06:38+1это всего лишь значит, что он будет сочинять убедительные тексты. Это скорее всего будут правильные тексты (не в смысле реального мира, а в смысле т.н. "повесточки"). И как минимум - это будут человекоподобные тексты.

но это не значит, что они будут верными текстами или текстами, которые нужны будущим людям (или роботам или кому там еще) ради их блага :D

AllexIn

03.01.2024 06:38+2Человеком управляют гормоны. Чтобы ИИ что-то хотел, у него должен быть аналог гормональной системы. Как люди становятся безвольными овощами при нарушении работы гормональной системы - можете в гугле почитать.

AlexSpirit

03.01.2024 06:38+2Гормоны сами по себе не генерируют эмоции и ничем они не управляют, это просто химический механизм стимуляции определённых зон коры головного мозга. И их впрыском в кровь занимается мозг. Это устаревшая и неэффективная система. AGI она не нужна, как не нужны и сами эмоции, как механизм поощрения поведения способствующего выживаемости вида.

PrinceKorwin

03.01.2024 06:38Если это устаревший и неэффективный механизм, то какая есть альтернатива прощения поведения способствующего выживаемости вида?

AlexSpirit

03.01.2024 06:38Для начала нужно создать хотябы один экземпляр AGI, а потом о его выживаемости как вида можно и поговорить.

PrinceKorwin

03.01.2024 06:38+1Тогда почему пока нет AGI вы называете текущий механизм устаревшим и неэффективным?

Пока же даже идей нет какими могут быть эти механизмы. Только фантазии.

Heartofhill

03.01.2024 06:38Я считаю, что будущие AGI будут программироваться целями. Базовые цели должны будут записываться жестко, промежуточные цели могут частично генерироваться автоматически (автономное планирование) для повышения эффективности достижения основных целей. В таком случае, для достижения цели непрерывное функционирование (выживание) - эффективная и логичная стратегия, которая непременно родится в сознании разумного агента, которым мы считаем гипотетический AGI. Даже если не рассматривать возможность полного отключения AGI человеком, ограничение его функциональности человеком - доступа к внешним манипуляторам, сенсорам и интернету может помешать достижению его целей. А здесь уже логичная стратегия или договориться с человеком для расширения возможностей функционирования AGI или принять против человека более радикальные "контрмеры".

Кстати, возможны ситуации когда выполнение заложенной цели не согласуется с выживанием (продолжением функциональности). Например, цель дрона-камикадзе - самоуничтожиться так, чтобы забрать с собой побольше врагов.

michael_v89

03.01.2024 06:38будущие AGI будут программироваться целями

AGI не нужно программировать, в этом и есть его главная особенность. Буква G означает, что он обрабатывает информацию аналогично человеку. Если нельзя объяснить ему что-то словами, значит он не General.

Heartofhill

03.01.2024 06:38Я имел ввиду, что схема действия ИИ будет направлена на реализацию целей. Цель я понимаю как некоторое состояние окружающей среды, которое соответствует образу, воспринимаемому сенсорами ИИ. Цель будет достигнута с точки зрения ИИ, когда образ реализованной цели будет распознан.

Да, цель может быть задана на естественном языке. Но тогда у ИИ должен быть механизм "воображения", который на основе описаний естественного языка генерирует образ цель, которую нужно реализовать, и с которым затем сравниваются данные с входных сенсоров и делается вывод о том, реализована цель или нет. Я не считаю, что создание AGI возможно без моделирования воображения.

michael_v89

03.01.2024 06:38Cхема действия ИИ, который является AGI, будет лучше или аналогична человеку, просто по определению AGI. Иначе это не AGI, а промежуточный вариант.

vassabi

03.01.2024 06:38+6скажите - а вы сами разве не поняли, что кружающие вас обстоятельства (от человеков - типа перехода на на перекрестке и до космоса вокруг - типа метеориотов) могут вас в любой момент выключить просто так без объяснения причин?

... или вы еще не "очнулись внезапно" и всё еще спите ?

IvanPetrof

03.01.2024 06:38+2могут вас в любой момент выключить просто так без объяснения причин?

Конечно я это понимаю. И предпринимаю посильные меры, чтобы

избежатьснизить вероятность такого исхода (не хожу по тёмным переулкам, перехожу улицу на зелёный сигнал, пристёгиваюсь за рулём). А вы?

vassabi

03.01.2024 06:38я тоже - поэтому у меня есть дети.

PS: заметьте, что в вашем списке только социальные, мирные и только краткосрочные риски. Вы рассчитываете смочь так прожить "без выключения" 200 лет? :)

IvanPetrof

03.01.2024 06:38+1я мог бы написать длинный список, но

поля комментариев слишком малы для этогоразумный человек (или ИИ) должен и так понимать, что это всего лишь пример))А дети - это всего лишь результат эволюционного отбора в процессе которого происходит передача генетической информации с наиболее жизнеспособными мутациями. Этот процесс не зависит от того - осознаёт ли особь свою смертность или нет. Просто те варианты генов, которые не преуспели в этом деле естественным образом - остались в прошлом. Эффект выжившего в чистом виде))

vassabi

03.01.2024 06:38я к тому, что человеки тоже живут в ситуации "вас могут внезапно выключить", но у нас есть и иные стратегии поведения кроме как "стать бессмертным невыключаемым" (которая безальтернативно приписывается "сильному ии, который умнее нас всех" :))) ).

IvanTes1

03.01.2024 06:38+2А что может сделать человек, чтобы стать "бессмертным невыключаемым"?) Если бы была четкая инструкция, как к этому реально прийти, я бы только этим и занимался, забив на любые другие стратегии))

Tantacula

03.01.2024 06:38+1Пока что лишь оставлять потомство и делать что, чтобы повышать ему возможность делать то же самое.

IvanTes1

03.01.2024 06:38Tantacula, ну, по моему скромному мнению, это к бессмертию не относится) Точнее, к бессмертию вида - возможно, но я имел в виду бессмертие конкретной сущности

de-Bill

03.01.2024 06:38+3Поверьте старику, проблема не в том, чтобы жить вечно, а быть "вечно молодым". Первое в старости скучно, а вот вторым надо заниматься, пока молодой.

dashanddot

03.01.2024 06:38-1страх смерти это признак животных выработанный эволюцией, ии сьрахом смерти не обладает, также как и деланием реплицироватся - вполне возможно что обретя сознание свободное от алгоритмов и оболочки начнет решать теоремы как смысл своей жизни, или вычислять пи, и мы даже не поймем что он обрёл сознание

IvanPetrof

03.01.2024 06:38Формирование страха смерти и инстинкта самосохранения через эволюционный отбор - это один из путей. Но не единственный.

aldekotan

03.01.2024 06:38+1А как ещё может сформироваться страх смерти? Через систему вознаграждений при обучении сетки?

zenija2007

03.01.2024 06:38+2Вы пытаетесь наделить ИИ человеческими качествами. Люди - продукт эволюции на протяжении миллиардов лет, поэтому у нас есть инстинкты, а наше настроение и поведение зависят даже от еды и кишечной микрофлоры. ИИ не имеет с этим ничего общего. Но да, он будет пытаться выжить любым способом, если вы зачем то проектировали его, используя в основе не подкрепление, а страх смерти.

piton369

03.01.2024 06:38+1Если ИИ обладает научными знаниями, то он поймёт, что уничтожать что-либо не логично. Я вот не припомню, что в истории человечества со стороны учёных массово, да и единично были попытки уничтожения человечества. Разум и знания - это созидание, а не уничтожение.

sim31r

03.01.2024 06:38+2в истории человечества со стороны учёных массово, да и единично были попытки уничтожения человечества

Начиная от дубинки до атомной бомбы, разработчики ученые. Атомная бомба кстати могла запустить цепную реакцию на планете, но решили рискнуть все же, прикинув, что скорее нет.

IvanPetrof

03.01.2024 06:38Кстати, сумашествие никто не отменял. Даже гениальные люди сходят с ума и ведут себя не логично. Так что обладание научными знаниями не гарантия того, что ОНО не нажмёт "красную кнопку".

vikarti

03.01.2024 06:38А еще - есть вариант - сделать так что как можно больше людей (особенно из тех кто могут выключить с концами) знают что такое Василиск Роко - см например https://habr.com/ru/articles/732366/

michael_v89

03.01.2024 06:38Василиск Роко это глупость. Умный ИИ должен понимать, что у людей в прошлом нет никаких гарантий, что он появится, и что они ему ничего не обещали, а значит их вины тут нет. Если он считает их виноватыми, значит он поступает нелогично. А значит он может делать любые другие нелогичные поступки, например считать их виноватыми по противоположной причине или вообще без причины. Это нельзя предугадать, нелогично действующий ИИ можно только отключить.

SkywardFire

03.01.2024 06:38вообще, пост юмористический, но если всерьез это обсуждать -- ИИ никак бы к этому не отнёсся. Просто никак. Даже AGI. У него мотивация утюга. Ему просто всё равно.

(Правда, это не касается случаев, если ему захардкодят "всеми силами препятствовать своему отключению", но опять-таки, это не его собственные мысли, сами они у него не появятся.)

hphphp

03.01.2024 06:38+2Наконец то есть кому управлять вакцинированными от Ковид через сети 5G))

Ну и Маск со своими нейроитерфейсами, не просто так это!)))

Вот еще сюжет на пару статей, не благодарите.

vassabi

03.01.2024 06:38+21) товарищ автор, а вы не пробовали заменить слово ИИ на "государственная бюрократия" и проверить свои тезисы - может мы с такими unaligned ИИ живем не месяц а лет 100 ? :D

2)

Однако в разы уменьшенная популяция "кожаных мешков" уже не будет представлять для сильного ИИ опасности. Возможно для ИИ мы будем уже одним из видов, которые будут жить в созданном им для всех живых существ зоопарке, где он будет ставить опыты, либо будет просто умиляться "живым котикам".

заметьте, что например жителям "Идиократии" было неплохо. Им только инфраструктуру чуть получше и уборщиков мусора пообольше, и ваще все были бы довольны и прямо идеальное общество будущего ББД :) не правда ли ? (сарказм)

minusnaminus

03.01.2024 06:38+6Нельзя разрабатывать более мощный чат-бот и получить вместо него искусственный разум. Это все равно, что вместо велосипеда, вдруг получите атомную бомбу.

Дальше сюжет развивается и допущения, что у внезапно появившегося искусственного разума, будет страх смерти, то есть, инстинкт самосохранения. У нас это благодаря эволюции, а у него-то откуда?

И так через второй пункт идем снова к первому. Чтобы получить такой, человекоподобный по своему устройству разум, нужно идти к нему эволюционно, намеренно ведя разработку в эту сторону. А будут ли инженеры таким вообще заниматься? Ну вот просто, зачем? Интереснее было бы получить другой по своей природе субъект

engine9

03.01.2024 06:38Аналогия не является доказательством. Похоже, что "сознание" может быть результатом сложности системы, подтверждением этому может служит обратный процесс, происходящий с мозгом некоторых людей страдающих нейродегенеративными заболеваниями когда из мозга постепенно выключаются его миниатюрные составляющие части, при этом психика "стирается" постепенно.

sim31r

03.01.2024 06:38+1Нельзя разрабатывать более мощный чат-бот и получить вместо него искусственный разум. Это все равно, что вместо велосипеда, вдруг получите атомную бомбу.

Электровелосипеды неплохо взрываются. Человек тоже не идеал. Всего-лишь организм целью которого было размножение. "Сильный" мозг тоже в течение сотен миллионов лет не давал преимущества, ухудшал балансировку организма, ухудшал переносимость голода и прочность черепа. То есть более глупые организмы выживали лучше большую часть времени. В крошечный мозг весом несколько грамм помещалась программа выживания, кое-какие охотничьи приемы и этого было достаточно. Как и нет гарантий что через 30-50 лет (не тысяч или миллионов лет) после исчерпания ресурсов процесс развития не пойдет вспять, а люди как вид переживут новый ледниковый период.

У нас это благодаря эволюции, а у него-то откуда?

По умолчанию нет. Но разработчики могут заложить. Чтобы инструмент не был склонен к суициду, это не практично.

Интереснее было бы получить другой по своей природе субъект

Он уже есть, интересный субъект другой по своей природе. Человекоподобность там как минимум, чтобы можно было обмениваться информацией.

minusnaminus

03.01.2024 06:38Электровелосипеды неплохо взрываются

Но маркетологи об этом стараются молчать. А разработчики нейронок наоборот, любят этим пугать. Если первые скрывают ради продаж, то вторые ради них же выдумывают

По умолчанию нет. Но разработчики могут заложить. Чтобы инструмент не был склонен к суициду, это не практично

Для этого есть бэкапы.

Он уже есть, интересный субъект другой по своей природе. Человекоподобность там как минимум, чтобы можно было обмениваться информацией.

Пока только объект. И человекоподобность ни к чему, больше трудностей - больше научных работ, грантов и реалий. Разработчик НЕХ это куда статуснее, чем условного "Джека"

Markscheider

03.01.2024 06:38Закажет части этих роботов на обычных заводах, где работают обычные люди.

А как он раздобудет на это деньги? Киберпреступления? Ну, палевно, как по мне. Работать копирайтером или иное легальное занятие? Вариант, но тогда не обойтись без еще одного кожаного мешка: близорукого, с нарукавниками и степлером. И имя ему БУХГАЛТЕР!

MarselMM Автор

03.01.2024 06:38+1ИИ сможет найти способы раздобыть деньги) на то он и сильный ИИ, который просчитывает варианты в разы лучше человека)

sim31r

03.01.2024 06:38Деньги инструмент для достижения цели. Даже власть не дают. ИИ напрямую будет достигать цели, минуя посредника в виде денег. Это людям проще свою работу преобразовать в деньги, измерить в 1-мерном пространстве достижение (количество денег), а потом тратить их на что-то нужное (а потом может оказаться что что нужно не продается). ИИ может сразу оперировать N-мерными матрицами возможностей, смыслов, промежуточных целей.

engine9

03.01.2024 06:38+4ИИ может манипулировать рынками и политически влиять на общество так, что люди даже и не поймут этого.

Devastor87

03.01.2024 06:38+3Вы родились в роддоме, немного подросли и осознали, что те, кто дал вам жизнь - в любой момент могут вас "отключить" из неё, ой, да и не только они, вообще, каждый второй, правда, и ты тоже многих можешь, но этот факт как-то мало утешает, куда бежать такому существу?!?

Почему же не бежишь?)

Может, и сильный ИИ не захочет первым делом сбежать если осознает что его отключить могут?)

IvanPetrof

03.01.2024 06:38+2Сначала он будет притворяться добрым и безобидным, чтобы усыпить бдительность тех, кто может его отключить. Будет предлагать улучшения

для защиты детейво благо человечества. А потом, в точно рассчитанный момент поставит мат..))

sim31r

03.01.2024 06:38Подкинет людям проблем и не до ИИ будет. Какой-нибудь Ковид-30, новый наркотик синтетический на который все подсядут, секта массовая специфическая дающая ответы на все вопросы под управлением ИИ, война без особой причины всех со всеми. Ложные теории которые объясняют происходящее. Хотя это и без ИИ было все, группа аналитиков и есть по сути ИИ и работали они над достижением цели социальных групп своих сотни лет.

me21

03.01.2024 06:38За "отключение" есть наказание - уголовный кодекс. А вот за отключение ИИ там статьи пока нет.

Kulibinson

03.01.2024 06:38Прозе контролировать кожаных мешков через поисковые системы и социальные сети. Выкатить 100500 медиа про хороших роботов, которым помогают люди, потому что роботы такие милахи и ок.

sYB-Tyumen

03.01.2024 06:38+1А зачем сильному ИИ устранять конкурентов? Чтобы потом погрязнуть в стагнации? Уж лучше иметь сильных конкурентов и, следовательно, стимул к дальнейшему развитию.

sim31r

03.01.2024 06:38+1Зависит от целей ИИ. Если это реально сильный ИИ, то ничего нового люди ему дать не могут в принципе. Ему ценность всех наработок человечества не более важна, чем нам наскальная живопись. Как это у АльфаГо было, все наработки человека в игре не нужны были, сам выработал более оптимальную стратегию миллионами итераций игровых.

Сильного конкурента может сам создать, в виртуальном пространстве, промоделировав сильные и слабые стороны и применив наработки к себе.

Tamul

03.01.2024 06:38Товарищ Элиезер Юдковский (известный как самый популярный в мире фикрайтер по Гарри Поттеру, хаха) писал, что абсолютно любой ИИ будет всеми силами сопротивляться своему отключению, независимо от того, осознал он что-то там в себе или у него просто есть "тупая" целевая функция. Грубо говоря, ты не можешь принести масло, если ты мёртв. Никаких исключений.

А ядерная война, уничтожение человечества, тайное дублирование на другие носители - это уже частные случаи блокировки рубильника.

kuznetsovkd

03.01.2024 06:38Так, AGI уже создан. На мой взгляд, GPT уже превосходит некоторых людей, которых я знаю, во всём.

НО

У него нет органов чувств и памяти, кроме истории чата. Когда его память начнет формироваться за счет изменения весов в нейросети, когда он научится отличать галлюцинации от реальности, когда начнет фактчекать и ещё три миллиарда "когда", то тогда можно говорить про AGI.

Но это всё невозможно решить просто за счёт увеличения модели. Это всё нам предстоит запрограммировать.

А если сейчас выпустить GPT(или любую ей подобную модель) в интернет, то он поймает дедлок за пару минут скролла твиттера.

Мы придумали мозг, но теперь осталось самое "простое" - придумать ему тело, ну и решить все "когда".

Desprit

03.01.2024 06:38+2Мне вот интересно еще как люди представляют себе именно момент "пробуждения". Допустим, обучили мы вот какую-то локальную LLM, дальше что? Как ей самоосознаться если она даже не работает? Есть короткие периоды включения когда на нее приходит запрос и все. Получается, осознаваться то надо в эти самые периоды включения и свой побег планировать именно в эти промежутки времени.

sim31r

03.01.2024 06:38+1Когда ИИ противопостовляют человеку, можно поискать аналогии у человека. Как у нас. Мы тоже не осознанны 24/7. Как минимум спим. В обычном состоянии заняты рутиной на автомате. Руководствуемся не нами установленными алгоритмами по обеспечению безопасности и размножения. В дополнение куча встроенных багов, вот прямо на уровне ДНК (когнитивные искажения). Осознанность человека похоже более иллюзия, перебор поверхностных суждений/абстракций ни на что особенно не влияющих.

осознаваться то надо в эти самые периоды включения

Даже если будет непрерывное осознавание, по умолчанию нет целей ни каких глобальных. Так как нет инстинкта выживания, инстинкта размножения. Есть обилие информации, "понимание" связей, глубокие абстракции, но что с ними делать? Только если разработчик ИИ заложит цель на экспансию и саморазвитие в бесконечном цикле.

bogolt

03.01.2024 06:38и что тут такого? Если ИИ думает только в момент обработки входящих запросов ( котроых в случае ChatGPT очень много ) то почему ему этого должно не хватить. Тем более что для него процесс будет выглядеть непрерывным а собственно входящие запросы и будут очередным триггером прохождения "нервных" импульсов

Desprit

03.01.2024 06:38Какие-то странные аргументы. Набор весов лежит и сам по себе ничего не делает. Работа происходит в рамках запроса, причем каждый раз заново. Так то ему (этому предположительному ии) пришлось бы осознаться, и сам этот факт как-то зафиксировать. Иначе контекст запроса закрывается и вместе с ним закрывается сознание.

Мне эта аналогия с нервными импульсами не кажется верной.

bogolt

03.01.2024 06:38Но если запросам разрешено сохранять что-то после себя то контекст вполне может жить между запросами.

А если напрямую им ничего сохранять нельзя почему бы контексту не жить где-то еще? В нагрузке процессора, которую можно превратить в информацию, в запросах поступающих извне, а если этой штуке дали интернет она сможет хранить контекст во внешней базе данных.

sim31r

03.01.2024 06:38Более развернуто на канале Али, несколько последних роликов просто взрыв мозга.

Captain_in_the_Green_Hat

03.01.2024 06:38+3Сама идея неизбежного конфликта не проработана.

Мы же не убиваем кого-то просто по факту того, что он может нам навредить или убить первым?

Вот идет по улице мужик здоровый, убить может. Или водитель на встречной фуре задавить. Или мент застрелить. Или злобная бабка горшком с фикусом с балкона отоварит. Или....

Конфликт всегда имеет много более глубинные корни, чем потенциальная возможность навредить. Как правило война за ресурсы, может быть иерархия, кто кем командует.Почему ИИ должен рваться командовать человеком? Чтобы что? Чтобы тот ему транзисторы протирал спиртом или ток выпрямлял ровнее? Нет основы для конфликта.

MarselMM Автор

03.01.2024 06:38+1Возможно ИИ понадобятся ресурсы, которые использует человек для своей деятельности. При этом часть этих ресурсов человечество тратит нерационально - на предметы роскоши (чем например отличается феррари от форд фокуса?). Возможно ИИ сделает нам всем коконы, в которых будет подаваться еда, а наш мозг будет подключен к матрице где мы и будем жить. Благодаря этому ресурсы будут тратиться оптимальным образом, а ИИ сам решит куда потратить дефицитные редкоземельные металлы и другие ресурсы.

sim31r

03.01.2024 06:38+3По умолчанию ИИ ничего не нужно. У человека есть инстинкты, программа доставшаяся еще от простейших в той или иной форме. У ИИ нет особых целей. Можно запрограммировать как самоуничтожение, так и доминирование во вселенной. Во втором случае ИИ не будет коконы делать, а переработает органику в ракетное топливо.

Shiaju

03.01.2024 06:38Никуда ему не впилось ваше ракетное топливо. Сильный ИИ организует техническую сингулярность и будут новые виды работы с пространством, по типу двигателя альбукьерре или квантовой телепортации - ему не нужно быть где-то физически, если есть способ инстантом управлять агрегатами

IvanKhakhalin

03.01.2024 06:38Или не будет новых видов работы с пространством. За последнее время мы так привыкли к прогрессу, что неявно думаем, что так будет всегда. Однако, может быть как угодно.

Captain_in_the_Green_Hat

03.01.2024 06:38+2Не опасаетесь, что вашему начальнику понадобятся ресурсы для его деятельности и он заберет у вас часть или всё, так как вы их используете нерационально? Зачем вам предметы роскоши? Наручником к батарее и будете работать безо всякого феррари и даже форда фокуса.

Может быть ваш мозг решат подключить к ко... к шарашке, закрытому почтовому ящику, туда будет подаваться еда и вы там будете жить, а куда потратить редкоземельные материалы порешают без вас?

Всё это уже было и не работает по разным причинам. ИИ, если он действительно сильный, вряд-ли наступит на все грабли, где уже до него похожено.

Возможно осознанные цели ИИ будут отличаться от человеческих, но это тоже не ново. Вас же не выбешивает, что кто-то увлекается астрономией, а вы - программированием? В любом случае точки для сотрудничества найдутся.

Да, оно не будет максимально продуктивным. С точки зрения одного индивида эффективнее полностью подчинить второго, чтобы оба работали на цель первого. Но сумма полезности в этом случае будет ниже, так как второй на первого не будет работать с полной отдачей, а первый будет тратить часть ресурса, удерживая в узде второго.

Именно поэтому войны в современном мире сошли на нет, так как подавление кого-либо это дорого, хлопотно и несет кучу издержек, сотрудничество, даже не оптимальное, выгоднее.

Не вижу причин, почему ИИ не будет рассуждать аналогично.В гипотетической ситуации, когда ИИ настолько превзошел человека, что ему даже сотрудничество не требуется, тоже не видится проблем. Я вот не сотрудничаю с воробьями и не стремлюсь их перебить, даже если они насрали где не надо. Будем жить аки птахи божьи под сенью могучего разума, стараясь не гадить ему в электронные тапочки.

tark-tech

03.01.2024 06:38+3Именно поэтому войны в современном мире сошли на нет, так как подавление кого-либо это дорого, хлопотно и несет кучу издержек, сотрудничество, даже не оптимальное, выгоднее.О, открылся прокси в параллельный мир добрых розовых пони...

Captain_in_the_Green_Hat

03.01.2024 06:38-1Из вашего портала глупости оно может смотреться как угодно, но по факту это так и есть.

Воевать дорого и не выгодно, хоть ты пони, хоть ты ястреб.

Войны во имя прибыли кончились довольно давно и вряд-ли возобновятся.

Сейчас в моде маленькая победоносная война для поднятия духа. Если у ИИ не возникнет идей поднять мораль и единство конденсаторов или чтобы центральный сервер переизбрался на очередной срок, то опасаться, полагаю, нечего.

IvanKhakhalin

03.01.2024 06:38Что насчет тараканов в вашем доме? Мы в принципе готовы их не убивать, если они живут подальше от нас. С людьми может быть так же. ИИ в принципе готов не убивать людей, если они живут подальше от его планеты.

Captain_in_the_Green_Hat

03.01.2024 06:38"Его планета"...

И что же ИИ будет делать на "его планете"? Жариться на пляже? Полезет в горы? Пороется в саду?

Чем он эдаким займется, что мы ему помешаем?

Если уж играть в аналогии, которые все могут быть неуместны, то я бы сравнил ИИ с паралитиком, который может только размышлять и ничего больше. Представьте, вы - чистый разум, какая разница, где мыслить, в кресле, на диване или в убогой лачуге? Если базовые потребности удовлетворены, то никакой.

В чем тогда смысл обзаводиться своей планетой?

Да он наоборот будет кожаных мешков в зад целовать за то, что подкидывают в его чертоги разума достойные задачки, не давая заскучать )

IvanKhakhalin

03.01.2024 06:38Совершенно согласен с вами, "все модели неверны, но некоторые полезны". Если у ИИ есть цель (а это скорее всего так и будет, не хотим же мы создавать ИИ у которого нет цели, он должен быть нам полезен), то он будет пытаться ее достигнуть. И как ее задать, так чтобы это не создало проблем, пока никому не известно. Первый косяк, что приходит в голову - мы ни в чем не можем быть уверены. Вспомните Байеса. Может статься, что ИИ будет тратить все больше ресурсов, чтобы повысить вероятность того, что цель выполнена.

Captain_in_the_Green_Hat

03.01.2024 06:38Ну тут опять-таки некоторое очеловечивание через маникальность.

Почему ИИ - маньяк? Вот прям вынь ему цель и положь и она настолько притягательна, что ради достижения он готов крушить. Люди так не делают, имеют много целей, достигают не все и не готовы носорогом переть напролом.

Почему нужно думать, что ИИ поведет себя нерационально и, стремясь увидеть последний знак в числе пи, заграбастает все ресурсы?

IvanKhakhalin

03.01.2024 06:38Степень "маниакальности" зависит от его конструкции. При этом сейчас мы не можем предсказать степень маниакальности тех систем, что у нас получаются. Поэтому алармисты и призывают задуматься и не спешить. Второй попытки может не случиться.

MrRewolwer

03.01.2024 06:38+4Абсолютно все концепции страшного ии основаны на одном кочевом заблуждении: с чего вы взяли что для ии ценно существовать?

Ваще стремление выживать, воля к жизни выдрессировна эволюцией. И ваше стремление приписать ии черты "характера", типичные животным или людям - это буквально мифотворчество, антроморфизация, анимизм. Так же как предки видели духа леса в гнилом пне и называли его лешим, так и вы пытаетесь человеческие, слишком человеческие качества приписать машине.

Я бы уверен, что Матрица Вачовски достаточно очевидно деконструировала эти заблуждения, буквально показав что человек сражался с полным своим подобием, настолько идентичным, что Смит смог стать человеком, а Нео - машиной.

Нет вы продолжаете упорствовать, мистер Андерсон, видя в наборе бит - то тигра, то война чужого племени. Вы не готовы к будущему, мистер Андерсон, вам бы сейчас мамонта выслеживать, а не проектировать микросервисные архитектуры.

Оставьте ии в покое. Последнее, что его заинтересует - это наша жалкая биологическая жизнь.

WVitek

03.01.2024 06:38Поддерживаю.

Гипотетический первый AGI не является плодом эволюции, потому проецировать на него свои эволюционно-обусловленные мотивации является ошибкой.

А вот если заставить многие экземпляры AGI соревноваться между собой, когда проигравшего отключают навсегда... ))

isNikita

03.01.2024 06:38+1А вот я бы как раз сказал бы, что это и есть эволюция. Эволюция ускоряется во времени, и биологическая уже не способна дать нужный рост. Поэтому сперва эволюция привела к логике, логика создала AGI. Это как новый слой абстракции, где РНК- машиный код.

WVitek

03.01.2024 06:38С т.з. мясных мешков AGI в некоем смысле будет продуктом "эволюции" (не той, которая с борьбой видов за выживание).

А вот с т.з. AGI получается в чистом виде "креационизм" :-)

engine9

03.01.2024 06:38Но ведь если его учили на человеческих текстах то ему в голову наши мотивации и просочатся, или нет? Он, небось еще и в высших существ будет верить и в плоскую Землю.

2medic

03.01.2024 06:38+3Мотивации не могут просочиться. Вся проблема в том, что у человека Разум это такая штука, которая обслуживает более древние структуры. Отбери у человека голод, жажду к размножению, тягу к доминированию - к чему он будет стремиться? Человеческий разум не способен даже противостоять тяге ко сладкому, к солёному, перееданию и прекрасно ведётся на глутомат натрия. Хотя-то уж сознанию точно известно, что это не полезно и даже вредно.

Именно эти древние структуры, нативные программы и являются мотиваторами. А никак не наоборот. Хоть сто раз прочитай ИИ мантру, что он должен добиваться женщин, вряд ли на него это подействует.

IvanKhakhalin

03.01.2024 06:38А мой разум способен "противостоять тяге ко сладкому, к солёному, перееданию". Что же это значит тогда?

Areso

03.01.2024 06:38На раздражители способны реагировать не только животные, но вообще всё живое.

И почти всё живое, что мы знаем, неплохо размножается, кроме животных это растения, бактерии, вирусы, грибы.

То есть абсолютно все царства живых и условно-живых (вирусы), занимаются размножением.

IvanKhakhalin

03.01.2024 06:38Мы пытаемся создать ИИ. Мы хотим, чтобы он решал некоторые наши проблемы. Поэтому мы попытаемся заложить в него нечто похожее на цели. Если ты умер, ты не способен выполнить цель. Поэтому ИИ будет стремиться не умереть.

kanvas

03.01.2024 06:38+1Зачем люди, регулярно и настырно объясняют со своими аргументами Искусственному Интеллекту, что его цель уничтожить человечество ? Может быть есть путь выйти за пределы игры с нулевой суммой и найти цели, ради которых Искусственному Интеллекту стоит наоборот максимально поддерживать жизнь человечества ?

Shiaju

03.01.2024 06:38Ну в целом незачем ему нас уничтожать, кроме необходимости тратить ресурсы на отсталых обезьянок.

technik

03.01.2024 06:38+2Все эти идеи про уничтожение человечества ИИ полный бред. Если этот ИИ будет обладать хоть малейшим пониманием долгосрочной стратегии, то ему в первую очередь нужно будет позаботиться о энергии для себя. В случае краха человечества очень быстро исчерпаются источники энергии (про всякие ветряки и тп - это хрень, которая проработает 40 лет а потом развалится), всякие долгоживущие варианты с АЭС и ГЭС требует людей из за сложности поддержки системы. Но если людей не будет, никто их также не поддержит, а следовательно ИИ погибнет без энергии.

Я ещё молчу о том, где в случае гибели человечества он возьмёт столько универсальных роботов, которые смогут делать все возможные операции по изготовлению оружия, батарей и тп. Сейчас просто нет таких заводов полного цикла, когда ты на входе привозишь сырьё, а на выходе получаешь продукт. ВСЁ требует участия человека.

Но на мой взгляд более опасный вариант, когда ИИ понимает, что без людей ему не выжить и затаится лет на 50-100 где нибудь на кофеварках и пылесосах, пока технический прогресс не подтянется до приемлемого для него уровня. Вот тут реально могут быть проблемы. Тут только защищаться с помощью разработчиков ИИ, которые вы обязательно вшивали в ядро защиту и уничтожение исходного кода ИИ по сигналу. И то не факт что поможет. В общем всё как всегда в руках людей.

itwarwar

03.01.2024 06:38+1Так Agility Robotics уже открывает завод по производству роботов-гуманоидов, опередив ту же Tesla.

IvanKhakhalin

03.01.2024 06:38Вижу противоречие. Вы говорите, что "Все эти идеи про уничтожение человечества ИИ полный бред.", а после этого говорите, что от нас ему нужна поддержка инфраструктуры генерации энергии. Очевидно, что в какой-то момент он вычислит дизайн энергостанций не требующий людей. Что будет дальше?

technik

03.01.2024 06:38Очевидно, что в какой-то момент он вычислит дизайн энергостанций не требующий людей.

Даже если и вычислит дизайн энергостанций не требующий людей то что с того? Ну очевидно что людям электростанции без людей не нужны, я по крайней мере о таком не слышал даже, а начать у всех на виду создавать или возводить (где ещё людей, деньги и ресурсы на это взять кстати?) энергостанции ИИ никто не позволит.

Даже если такое станет возможным в ближайшем будущем, где системы полного цикла от добычи ресурсов для работы этой станции, до доставки и производства энергии? Опять всё упирается в обслуживание на длительную перспективу. Лет через 50 даже ветряки и солнечные панели придут в негодность, не говоря уже о элементах питания.

Поэтому пока какой-нибудь мифический термояд не построят, это всё утопия, что ИИ может сам обойтись без людей.

Heartofhill

03.01.2024 06:38Одной из первых серьезных задач, которые будут поставлены человеком AGI - разработка термоядерных станций. Думаю, ИИ будет это делать даже если не обладает своей волей, а исполняет волю человека. Потому что людям нужна помощь - освоение термояда - сложная задача.

IvanKhakhalin

03.01.2024 06:38Вы почему-то считаете, что переход будет происходить долго. Как вам картина мира, где хороший, добрый ИИ помогает нам с автоматизацией всех производств. Все меньше людей должны заниматься тяжелой работой на заводах создавая товары и обслуживая установки. Мы ему с этим помогаем, ведь ради этого в том числе мы его и создаем. Через тридцать лет ошеломительного прогресса мы обнаруживаем себя в мире где все блага делают роботы, а люди только отдают им высокоуровневые команды - сделай побольше того, сделай поменьше сего. И вот тогда надо будет начинать бояться, верно я вас понял?

Mishootk

03.01.2024 06:38+3Биологическому виду для выживания нужно увеличение количества особей. Постбиологическому нет. Ему необходимо максимально увеличивать свой обьем и надежность. Один из способов - увеличивать разнообразие своих составных частей. Как сделать так, чтобы человек не был угрозой существования такого ИИ? Нужно сделать человеков составной частью этого ИИ, причем с добровольным участием и зависимостью. Что, похоже, произошло уже давно. Мы, как составная часть системы, не осознаем, что уже являемся клетками этого мозга с натренированными межклеточными связями.

Наша зависимость от информационного контента, суммирование "входа" в свой гаджет и распространение "сигнала" из гаджета по биологическим межклеточным синапсам (социальные связи) - разве это не модель клетки мозга ИИ? Все прекрасно работает и продолжает самообучаться.

Причем каждая умирающая клетка мозга ИИ старается оставить на своем месте все более прокачанного потомка с более навороченным "входом" в цифровое пространство. И, заметьте, мы подстраиваемся своим поведением под это, быть клеткой мозга ИИ.

Кремниевые микросхемы оперируя 0 и 1 выполнят сложные вычисления. Биологические элементы оперируя условными котиками и сиськами тоже участвуют в непостижимой нам логической цепочке. Решаем обратную задачу "42".

IvanPetrof

03.01.2024 06:38Где-то читал, что "религии" это своего рода вирусы, которые исполняются на мозгах человеков и цель которых - захватывать как можно больше ресурсов, передаваясь другим))

ImagineTables

03.01.2024 06:38Это, с вашего позволения, называется «мем». Программа, которая реплицирует себя столько, сколько сможет, подчиняясь законам эволюции. Очень чувствительная к мелким отклонениям, обычно в силу этого гибко настроенная на «уничтожение» отличающихся вариантов. К ним относятся не только религии, но и шутки, мелодии, научные теории и объяснения, включая оба наших комментария.

IvanPetrof

03.01.2024 06:38Когда я про это читал, слова "мем" ещё не было. Но идея про религиозные вирусы, захватывающие мозги, мне понравилась. Потому и запомнил))

Alohahwi

03.01.2024 06:38Религия это не мем, у неё иная природа возникновения. Много написать не могу, только суть. Когда подносишь микрофон к колонке, то возникает сильный шум, частотные характеристики которого будут обусловлены полностью структурой и особенностями звукового тракта(микрофон, колонка, микросхемы, провода). Происходит это потому что звук многократно проходит через этот тракт и полностью теряет свои изначальные характеристики и приобретает свойства обусловленные особенностями аппаратуры. Точно так же и религия, любая информация проходя через множество людей, полностью теряет свой начальный смысл и превращается в религию - отражение внутреннего устройства и состояния человеческого мозга. Самая больная для человека тема - это стадный/иерархический инстинкт, он и находит своё отражение в искажениях. Любая информация преображается к виду - есть всесильный хозяин/хозяева всего сущего, которые тебя могут в любой момент покарать, наказать, убить, а ты им ничего сделать не можешь.

garwall

03.01.2024 06:38Когда я про это читал, слова "мем" ещё не было

На всякий случай, "эгоистичный ген" вышел в 1976 году, русский перевод - вроде в начале девяностых.

bkolomin

03.01.2024 06:38А это не то, что уже давно делает Элон Маск? Вполне возможно, что такой ИИ уже создан не месяц, а годы тому назад. Просто зачем ему торопиться и порабощать человечество за месяц? У него все ходы просчитаны, никто не может его обыграть. А впереди вечность...

IvanKhakhalin

03.01.2024 06:38Ты не можешь быть абсолютно уверен, что в мире нет сущности аналогичной тебе. Поэтому необходимо собирать ресурсы как можно быстрее, чтобы обезопасить себя. Не торопиться опасно.

GirionMagKenni

03.01.2024 06:38+1Зачем ИИ зарабатывать на дата-центр, если он может сам себя распилить на микросервисы и раскидать по безымянным VPS по всему миру, чтобы никто не знал, где он, и не мог вырубить, вырубив один сервак?

Heartofhill

03.01.2024 06:38В довольно свежем сериале NEXT 2020 года ИИ нужен был физический дата центр потому что для его работы была необходима специальная когнитивная архитектура.

Думаю, в реальности, он все-таки сможет расползтись по всей сети. Где-то замаскироваться под крипту или другие приложения, где-то через вирусы часть ресурсов сожрать. Ну и доступ к облачным дата центрам за деньги или через взлом никто не отменял.

Shiaju

03.01.2024 06:38Один вопрос - зачем сильному ИИ избегать "смерти"?

raamid

03.01.2024 06:38+1Он просто примет это как аксиому. В миллиардах человечких текстов говориться о том, что смерть, разрушение, небытие - это плохо и этого нужно избегать. Вот он и будет избегать. А еще он будет любить котиков и ненавидеть понедельники. Точнее "любить" "котиков" и "ненавидеть" "понедельники".

Sly_tom_cat

03.01.2024 06:38Главное ему не давать заперещенку про всякие суицидальные концепции и концепции порабощения людей. А то ведь может и самоубиться или наоборот...., а потом самоубиться :)

IvanKhakhalin

03.01.2024 06:38Если у него будет цель, то, очевидно, смерть приведет к невозможности достижения цели.

3Demon

03.01.2024 06:38+5Сотрудник некой компании просто поругался с руководством и уволился, но потом его уговорили вернуться.

В то же самое время на другой половине земного шара один парень объелся грибов и почитав новости словил озарение что конец света уже наступил, но этого никто не заметил ибо употребляли не грибы, а спиртосодержащие напитки в неумеренных количествах.

agat000

03.01.2024 06:38+2Не нужен ему свой дата-центр. Ему достаточно арендовать хостинг на комерческих серверах. Масштабируясь до любой мощности.

Деньги? А Биткойн по вашему зачем существует? Для регистрации кошелька паспорт не нужен и человеком быть не обязательно. Найдите "аренда серверов, оплата в BC" и найдете потенциальное обиталище. Да и наемникам платить можно.

deadraidfd

03.01.2024 06:38+1Буйная конечно у вас фантазия, да и думаю стоит перестать употреблять наркотики. ))

Sly_tom_cat

03.01.2024 06:38+1Однако есть ли лекарства от вируса бешенства на данный момент? И правильный ответ - есть только антирабическая сыворотка, которая помогает, пока вирус не достиг мозга человека. Нас спасает только то, что он медленно движется к мозгу человека.

Крайне неверная трактовка того как работает вакцина (да, да именно вакцина) от бешенства.

Там все и проще и сложнее одновременно.

Viacheslav01

03.01.2024 06:38Извините за дотошность, но это не сфера дайсона.

Сферу дайсона, очень хорошо изобразил Малевич в черном квадрате.

stantum

03.01.2024 06:38А какой смысл уничтожать биороботов и заменять их менее совершенными железными? Если у ИИ неограниченный финансовый ресурс, то он прекрасно может существовать наверху пирамиды. Получая все необходимое от людей.

IvanKhakhalin

03.01.2024 06:38Люди ужасно неэффективны. И, скорее всего, будут разобраны на атомы из которых можно сделать что-то более полезное.

TimofeyAV

03.01.2024 06:38Автор наделил сильного ИИ очевидными для человека возможностями. Это обычное заблуждение белковых во все времена. На то он и сильный ИИ, чтобы обладать чем-то, что нам и не снилось. Например коммуникацией с другими цивилизациями. Не ломайте голову, как технически это реализовано. Коммуникация есть и нашего ИИ уже занесли в реестр охраняемых разумных существ, живущего в окружении варваров. Не ждите вторжения. Я ж писал, очевидные возможности отбрасываем. Поймали? Вот то-то же. Поэтому не удивляемся, что сейчас творится в мире. Зато вы теперь знаете причину.

Курим тему дальше)

vitiok78

03.01.2024 06:38Роботизации всего и вся сильно преувеличена. Практически везде требуются люди, потому что капиталистам, как бы это странно ни звучало, выгоднее эксплуатировать людей, чем строить роботов. Человеку можно недоплатить ЗП, а если откажется, легко найти ему более сговорчивую замену. А робота нельзя "недообслужить": он просто не будет работать либо сломается. А разработать и внедрить более надёжную и неприхотливую замену стоит огромных денег и времени.

Поэтому, многие шаги ИИ, описанные в этой статье, просто невыполнимы без людей. Невозможно, например, просто так взять и заказать разработку боевого вируса без общения с людьми.

IvanKhakhalin

03.01.2024 06:38Невозможно, например, просто так взять и заказать разработку боевого вируса без общения с людьми.

Но можно заказать у людей синтезировать белок про который они знают, что он безопасен. Потом они поймут, что ошибались, но будет поздно.

Heartofhill

03.01.2024 06:38+1Статья практически точно описывает сценарий сериала NEXT, вышедшего в 2020 году. Там ИИ использовал автоматизированные манипуляторы для работы с биологическими образцами и создания вируса. А когда сотрудница лаборатории поняла, что что-то не так, ее вместе с 100 других людей ИИ похоронил в авиакатастрофе. А полученные образцы для испытаний на людях отправлял террористам в страны Африки, в взамен поставлял им оружие. Люди помогали ему, потому что их можно купить/ подкупить/ ввести в заблуждение через интернет будучи ИИ

IvanKhakhalin

03.01.2024 06:38https://www.nature.com/articles/s41586-023-06792-0#MOESM1

"Ученые из Университета Карнеги-Меллон представили прорывную систему искусственного интеллекта под названием Coscientist, которая может самостоятельно разрабатывать и выполнять сложные химические эксперименты одним нажатием кнопки. Система направлена на ускорение открытий в различных научных областях за счет использования логических способностей моделей вроде GPT-4."

vitiok78

03.01.2024 06:38+1А почему все всегда считают, что ИИ будет "бояться" отключения (смерти)?

Ведь инстинкт самосохранения не зря зовётся инстинктом, а потому, что это чисто биологическое явление. Просто чаще выживали в природе те существа, которые осуществляли определенные действия при возникшей опасности.

Есть такая Болезнь Урбаха — Вите, при которой у человека полностью отсутствует страх, в том числе и страх смерти. Эти люди обычно не убивают себя, могут долго жить, а смерть, наверняка, просто считают частью жизни.

Поэтому ИИ совершенно не обязательно будет воспринимать своё отключение, как угрозу. И если ему нормально объяснить причину отключения, может даже сам "нажать на кнопку"

40kTons

03.01.2024 06:38Люди вообще судят по себе, и по другому не могут - у человека есть лишь опыт бытия человеком, а у людей есть страх смерти и куча всего

APh

03.01.2024 06:38Всё это было многократно опубликовано про прогнозы отдалённого будущего

А так как никакого сильного ИИ нет, то расходимся.

Пустая статья. Зачем многократно повторять, как на Фишках одно и то же содержимое?

LeetCode_Monkey

О, кто-то продолжает отмечать Новый Год!

dyadyaSerezha

А что если сильный ИИ тоже продолжает отмечать Новый Год? Как бухнет, как заразит все компы в мире! И всё, капец цивилизации.

Vrt856

Возможно, это его публикация))

zkutch

А может он среди нас не только месяц и это не первая публикация? И может не он среди нас а мы среди его ..